针对方面级情感分类的转移胶囊网络

摘要 方面级的情感分类旨在确定一个句子对一个方面的情感极性。由于注释的高成本,缺

乏方面级的标记数据成为该领域的主要障碍。另一方面,像评论这样的文档级标记数据很容

易从在线网站访问。这些评论在丰富的语境中对情感知识进行了编码。在本文中,我们提出

了一个转移胶囊网络(TransCap)模型,用于将文档级的知识转移到方面级的情感分类。为此,

我们首先开发了一个方面路由方法,将句子级的语义表示从方面级和文档级数据封装到语义

胶囊中。然后,我们扩展了动态路由方法,使语义胶囊与迁移学习框架下的类胶囊自适应耦

合。在 SemEval 数据集上的实验证明了 Transcap 方法的有效性。

1.介绍

方面级别的情感分类(ASC)是情感分析中一个细粒度的子任务。给定一个句子和一个句

子中的方面,ASC 旨在确定方面的情感极性。传统的方法大多使用具有手工特征的机器学

习模型来构建 ASC 任务的情感分类器(Jiang et al., 2011; Mohammad et al., 2013)。这种方法既

需要繁琐的特征工程,也需要大量的语言资源。随着深度学习技术的发展,许多神经模型被

提出(Wang et al., 2016b; Tang et al., 2016; Chen et al., 2017)用于 ASC 任务。所有这些模型都

以监督的方式训练分类器,并且需要足够数量的标记数据来获得有希望的结果。然而,在

ASC 中对意见目标的标注是非常昂贵的。

标记数据的缺乏是这一领域的主要障碍。ASC 的公开数据集通常包含有限数量的训练

样本。另一方面,像评论这样的文档级标记数据很容易从 Yelp 和 Amazon 这样的在线网站

访问。因为每一篇评论都有一个伴随的评价分数,表明用户对某件物品的总体满意度,这样

的分数自然可以作为评论文档情绪极性的标签。

直观地说,文档级数据包含有用的情感知识可用于方面级数据的分析,因为它们可能共

享许多语言和语义模式。不幸的是,对于 ASC 任务,只有一个研究(He et al., 2018)考虑到

了文档级数据的利用。(He et al., 2018)中提出的 PRET+MULT 框架是采用预训练和多任务

学习方法的成功尝试。然而,他们的模型只在 ASC 和 DSC(文档级情感分类)任务之间共享

浅嵌入层和 LSTM 层。换句话说,文档级的知识仅仅用于改进在 ASC 任务中的单词表征。

因此,PRET+MULT 无法处理像委婉语和反讽这样复杂的模式,这需要从整个句子中获得高

层次的语义知识。例如,如果给出一个句子“员工应该更友好一点”,PRET+MULT 会做出一

个错误的预测(细节将在分析部分给出)。

本文提出了一种新的转移胶囊网络(TransCap)模型,将句子级语义知识从 DSC 转移到

�

ASC。我们的工作受到了胶囊网络的启发(Hinton et al., 2011;Sabour et al., 2017),它使用胶囊

向量和动态路由方法来存储和聚类特征,但我们更进一步,我们开发了一个方面路由方法,

可以生成 ASC 和 DSC 共享的句子级语义特征。此外,我们将动态路由方法扩展为适应转移

学习框架。我们在两个 Semevel 数据集上进行了大量的实验。结果表明,我们的 TransCap

模型始终优于最先进的方法。

2.相关工作

方面级情感分类 传统的情感分类方法(Nakagawa et al., 2010; Jiang et al., 2011; Taboada

et al., 2011; Mohammad et al., 2013)多使用机器学习算法构建具有精心提取特征的情感分类

器,这需要花费大量的时间和资源来收集。早期的研究侧重于文档级情感分类(DSC)任务。

近年来,针对 ASC (方面级情感分类, ASC)任务提出了多种深度学习方法(Dong et al., 2014;

Vo and Zhang, 2015; Tang etal.,2016;Wangetal.,2016a;Maetal.,2017;Li et al., 2018; Ma et al.,

2018; Wang et al., 2018a)。

一般来说,ASC 任务有三种类型的神经网络:基于 LSTM 的(Wang et al., 2016b; Ma et al.,

2017; Tay et al., 2018),基于记忆的(Tang et al., 2016; Chen et al., 2017; Zhu andQian,2018),和

混合方法的(XueandLi, 2018)。例如,Wang 等人(2016b)使用注意机制来建模 LSTM 隐藏单

元与方面之间的相互依赖关系。Tang 等(2016)利用记忆网络存储上下文词,并进行多跳注意

获得对方面的情感表征。Chen 等人(2017)将递归注意应用于多层记忆。Xue 和 Li(2018)利用

CNN 和门控机制从上下文中提取特定方面的信息。

虽然提出了各种各样的办法,但固有的障碍,即对于所有的 ASC 任务来说,标签数据

的缺乏仍然是一个巨大的挑战。如果没有足够的标记数据,这些方法中的训练过程可能会收

敛到次优状态。我们的工作与上述模型的区别在于,我们的目标是利用丰富的带标签的 DSC

数据来缓解 ASC 任务中带标签数据的不足。

迁移学习 迁移学习的目的是从一个或多个源任务中提取知识,然后将这些知识应用到

一个目标任务中。根据源和目标域/任务中的不同情况,可以将其分为三种类型(Pan 和 Yang,

2010)。我们的工作属于“归纳转移学习(ITL)”类型,因为在我们的框架中 ASC(目标)和

DSC(源)是不同但相关的任务。在这种情况下,ITL 类似于多任务学习(multi-task learning,

MTL),只是略有不同:ITL 的目标仅仅是在目标任务中获得高性能,而 MTL 试图同时提高

两者的性能。

最近有几次尝试采用 ITL 或 MTL 方法来进行情绪分类任务。Dong 和 de Melo(2018)利

用训练过的模型提出了一个迁移学习框架。Xiao 等(2018)采用胶囊网络进行多任务学习。这

�

两种方法都是为文档级的文本/情感分类任务设计的,不适用于细粒度的 ASC 任务。

Heetal.(2018)提出了一个多任务框架,将 ASC 和 DSC 任务结合在一起。这是最接近我们的

工作。然而,(He etal., 2018)中的方法是基于现有的 AT-LSTM 模型(Wangetal.,2016b),

而我们的框架是一个全新的框架,它使用胶囊网络,精心设计的策略用于 ASC 任务。

3 我们提出的 TransCap 模型

3.1 定义和准备工作

在本节中,我们将介绍我们的转移胶囊网络(TransCap)模型。模型利用从文档级数据转

移来的辅助知识进行方面级情感分类。我们首先给出问题的定义和初始化。然后详细说明

TransCap 的结构。

定义 1

(TransCap) 给出源文档级语料库 CD 和学习任务 TD、目标方面级语料库 CA 和

学习任务 TA,TransCap 旨在利用 TD 传递的知识帮助 TA 改进目标预测函数 fA(·)的学习。

定义 2

( 和 )给出一个句子 S = {w1,…,wa,…, wL}∈CA, wa 为出现在 S 中的一个

方面,一个方面级的情感分类任务 TA,目的是确定 S 对 wa 的情感极性。注意,在一个句子

中可能包含多个方面。对于意见句(或文档)D∈CD,文档级的情感分类任务 TD 旨在为 D 分

配一个整体的情感极性。请注意,TA 是主要任务,TD 只是在我们的 TransCap 模型中提供辅

助知识。

准备工作(CapsNet)

胶囊网络最早被提出用于计算机视觉中的图像分类(Hinton et al., 2011;Sabour 等人,

2017)。与 CNN 相比,它将标量输出的特征检测器替换为矢量输出的胶囊,并具有保存位置

和层等额外信息的能力。原版胶囊网络由两层胶囊组成。底层存储低级别的图像特征映射,

分类层生成每个胶囊对应一个类的分类概率。

最近,CapsNet 被应用于文本分类和关系提取等几个 NLP 任务中(Yang et al., 2018b; Gong

et al., 2018; Xiao et al., 2018; Zhang et al., 2018; Wang et al., 2018b)。CapsNet 能够通过动态路

由自适应地确定层间传输的信息。此外,CapsNet 中的每个类都有不同的参数来聚合特征,

并且存在独立的概率。因此,CapsNet 满足了我们在迁移学习场景中的需求,其中包含了多

个极性和任务。我们的 TransCap 模型是在 ASC 任务转移学习框架下首次尝试利用 CapsNet

的能力。

3.2 架构概述

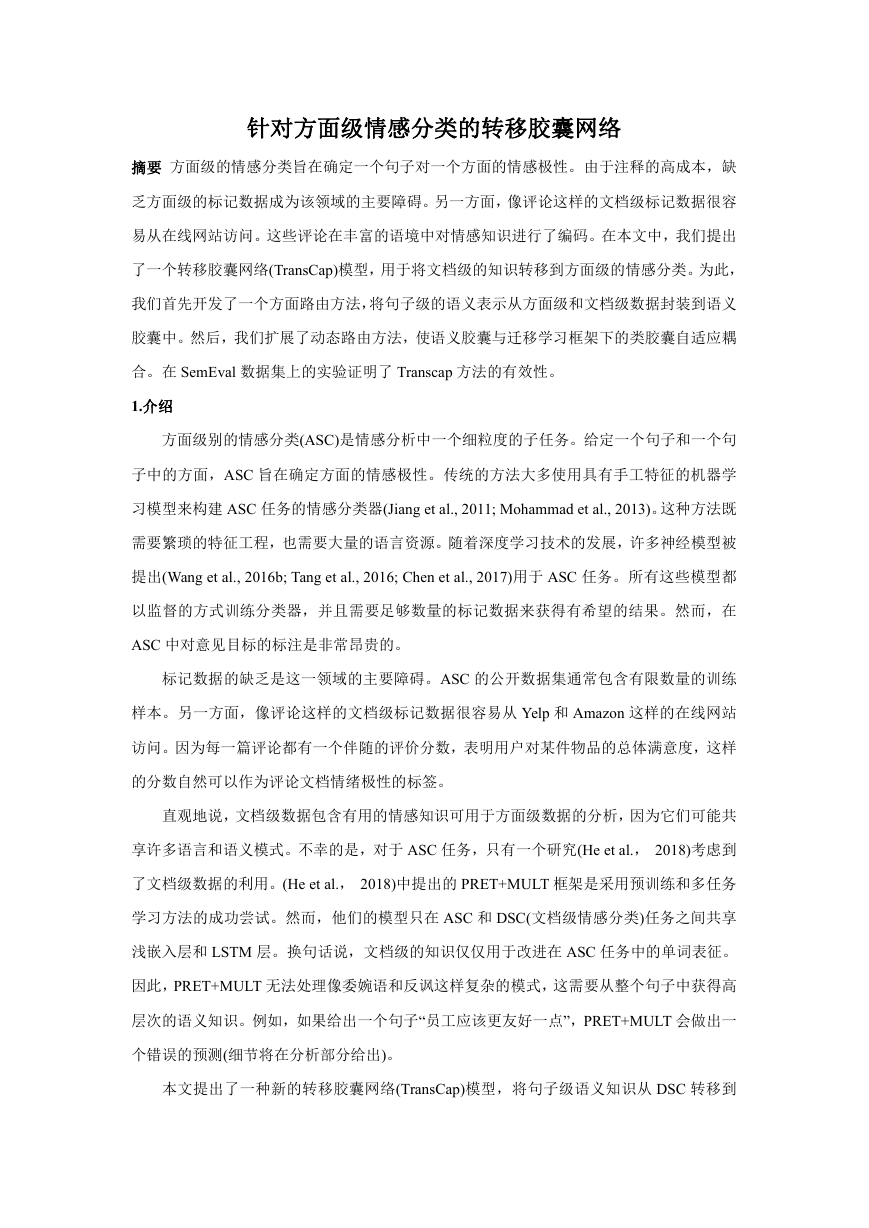

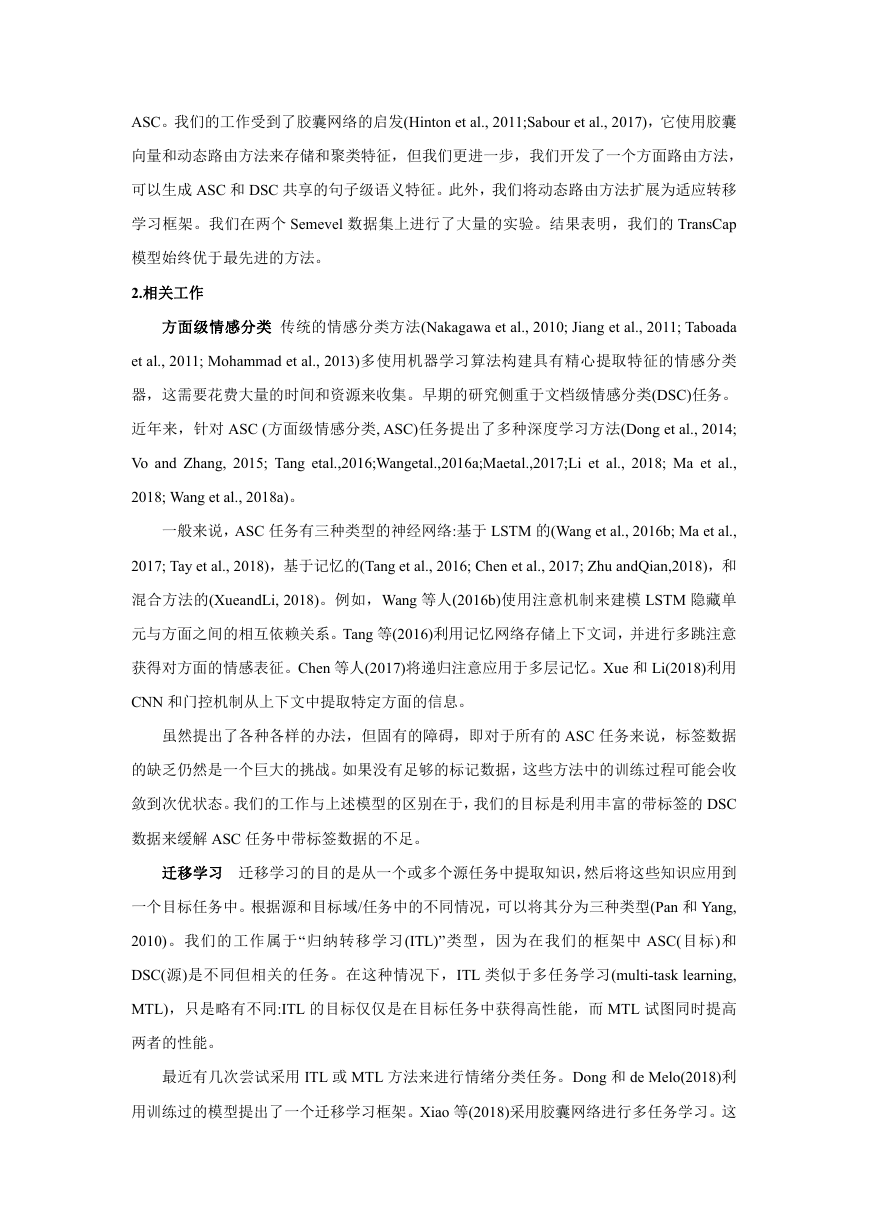

TransCap 的 架 构 如 图 1 所 示 。 它 由 四 层:1) 输 入 层 将 单 词 句 子 转 换 成 低 维 实 值 向

量,2)FeatCap 层从词向量中提取 n 元特征并将其转化为特征胶囊,3)SemanCap 层将特征胶囊

�

聚合到一组方面相关句子级语义胶囊中 4)ClassCap 层分别生成与 TA 和 TD 情感极性相关的

类胶囊。注意,TA 和 TD 任务共享前三层,它们只在最后一个 ClassCap 层中分离。由于 TA

和 TD 都是旨在识别情绪极性的相关任务,因此对一项任务有用的特性可能对另一项任务也

有用。我们期望共享层所产生的特征能够以一种交互的方式得到改进。

3.3 输入层

输入层由两个查找层组成。令

为预先训练好的词嵌入查找表,其中 dw 为词

向 量 的维 数 ,|V|为 词 汇量 。 单 词 查 找层 将 S(D) 中 的 单词 序 列 映 射 为一 系 列 单 词向 量

{e1,…ea,…, eL}∈Rdw×L。继(Guetal.,2018)之后,我们还使用了另一个位置查找层。对于

TA,通过计算每个上下文单词 wi 到 aspect 单词 wa 的绝对距离,可以得到 S 的附加位置序列。

对于 TD,由于没有方面信息,所以位置序列为零序列。令

为随机初始化的位置

嵌入查找表,位置查找层将位置序列映射到位置向量列表

。每个单词 wi

的最终表示形式计算为

,其中⊕表示拼接,dh = dw + dl。将句子 S(D)

转换为一个句子嵌入

。

3.4 特征胶囊层

该层用于从嵌入 X 的句子中提取 n 元特征,n 元特征包含固定窗口内的原始的局部的语

义。我们应用多个卷积操作 X 中的第 i 个 n-gram 得到其特征向量 ri:

(1)

是内核组 ,(dh×K)是一个卷积核的大小,K 是 n-gram 的大小和 dp 是一个

特征胶囊的维度。在 X 中滑动 F 之后,我们得到一系列特征胶囊

来封装从整

个句子 S(D)中提取的 n-gram 特征。由于一个核组 F 对应一个语义范畴,我们用不同的核组

重复上述过程 C 次,得到代表 C 个语义范畴的多通道语义特征。特征胶囊层的最终输出表

示为

:

3.5 语义胶囊层

(2)

�

方面的路由方法 两个语料库 CA 和 CD 中的句子或文档的区别在于方面项是否出现在句

子/文档中。TD 任务不包含方面。同时,确定上下文与方面之间的关系也是 TA 任务的关键。

尤其是当一个句子包含两个相反的情态极性时,就必须将不同的语境从不同的方面进行分离。

例如,给出一个句子“Great food but the service is dreadful!”上下文词“dreadful”应在“service”

方面加强,在“food”方面弱化。

为此,我们提出了一种新的方面路由算法针对 TA 中大小为 K 的窗口中的上下文词来计

算面向方面的权重。形式上,我们通过内核

将卷积操作融合到句子嵌入 X 中,得到

方面路由权重 ai:

(3)

在 ea 是方面嵌入(或在多词方面情况下的平均嵌入),Ta∈

是一个转移矩阵将 ea 映射

到一个标量值,ba 是偏执。生成的路由权重 ai∈[0,1]将方面信息融合到其上下文中。它控制

着有多少当前上下文的信息可以传输到下一层。如果 ai 为 0,特征胶囊就会被完全阻塞。

一个小的挑战是,对于一个 TD 任务,实际上在文件中没有方面,我们需要区分来自 CA

和 CD 的两种类型来源。因此,我们设计了一个分段函数 gi 来计算 X 中的任意一个特征向量

ri 的方面路由权重 gi:

在 X 中滑动后,可以得到整个句子 S(D)的

。由于我们有 C 个 f 特征胶囊

通道,所以我们重复上述步骤 C 次,得到整句的方面路由权重

,即:

(4)

最后,特征胶囊用这些路由权重得到:

G = [g1,g2,…,gC], (5)

(6)

其中

特定方面的特征胶囊,表示元素方式相乘(像广播).

语义胶囊生成 以上生成的 P 是由 n 元特征胶囊转化而来的。尽管编码了与方面相关的

信息,P 仍然是没有句子级视图的局部特性。此外,P 中大量的胶囊可能会阻碍下一层的鲁

棒表征的学习。因此,我们在 P 中采用元素最大化方法 (Lai et al., 2015)将所有特征胶囊

水平聚集在同一通道中。

其中

为生成的语义胶囊。Eq. 7 压缩了每个通道的所有局部特征,因此我们可

以从细微的表达,例如委婉语的句子中获得更精确、更全面的语义表征。最后,我们希望每

,(7)

�

个语义胶囊 ui 长度代表 ui 的语义在当前输入中出现的概率,因此我们使用一个非线性的

“squash”函数(Sabour et al.,2017)来限制其长度为[0,1]

3.6 类胶囊层

(8)

在原始的胶囊网络中,只有一个分类任务,它使用类胶囊来表示类及其长度作为分类概

率。然而,在我们的问题中有两个不同的任务,有必要在这些任务中辨别情绪极性(类别)。

为此,我们在 TransCap 中引入了两种类型的胶囊,共 6 个胶囊。这样的结构使得我们的模

型能够在一个统一的框架中训练 TA 和 TD。然后,前三层共享大部分参数(除了在 Eq.3 的参

数外)来共同训练 TA 和 TD,这样文档级数据的知识就可以成功地转移到方面级任务中。在

最后一层中,每一个类都被用来分别计算 TD 和 TA 中每个类的分类概率。因此,每个类胶

囊应该有自己的路由权值,以自适应地聚合来自前一层的语义胶囊。下面我们给出细节。

下面我们给出细节。语义胶囊 i 针对类别胶囊 j 生成一个“预测向量”

:

(9),

是一个权重矩阵,dp 和 dc 是语义胶囊 i 和类胶囊 j 的维度, ui 是语义胶囊 i 的

向量表示。将所有由语义胶囊生成的“预测向量”是通过权值 cij 求和,得到类胶囊 j 的向量表

示形式 sj:

其中 cij 是通过“路由 softmax”定义的耦合系数:

(10)

(11)

其中每个 bij 是一个语义胶囊 i 应该传递给一个类胶囊 j 的 log 先验概率。它是使用一种

动态路由方法计算的,后面将介绍这种方法。之后,我们再次应用非线性“squash”函数计算

Ep10 中的 sj,得到对于类胶囊 j 的最后表示 vj

vj 的长度限制在[0,1]中,代表类胶囊 j 的活跃概率。

(12)

动态路由的方法 Eq. 11 中的 logit bij 决定了语义胶囊 i 和类胶囊 j 之间连接的强度,它

初始化为 0,通过一致系数 aij 来更新。

(13)

在计算连接语义胶囊和类胶囊的所有耦合系数 cij 的新值之前,将该一致性系数添加到

�

初始 logit bij 中。

(14)

动态路由过程可以总结为(Eq. 11→10→12→13→14)。可以重复该过程 r 次迭代。

3.7 边缘损失

一个类胶囊的长度用来表示情绪极性的概率。活跃类胶囊长度应大于其它类。因此,我

们在每个任务中为每个类胶囊 j 采用单独的边缘损失 Lj:

如果情绪极性存在于类胶囊 j 中 Yj=1,我们简单地设置 m + = 0.9, m−= 0.1,λ= 0.5 (Sabour et

al ., 2017)。单个任务的损失为

,其中 T 为 A 或 D,分别表示任务 TA 和 TD 的损

失 LA 和 LD。我们的 TransCap 模型的最终损耗 L 是单个任务上的两个损耗的线性组合。

γ∈[0,1]是一个超参数控制 TD 的权重。当训练收敛时,选择任务中活动概率最大的类

L = LA+γLD(16)

胶囊作为情绪极性的预测。

4 实验

4.1 数据集和设置

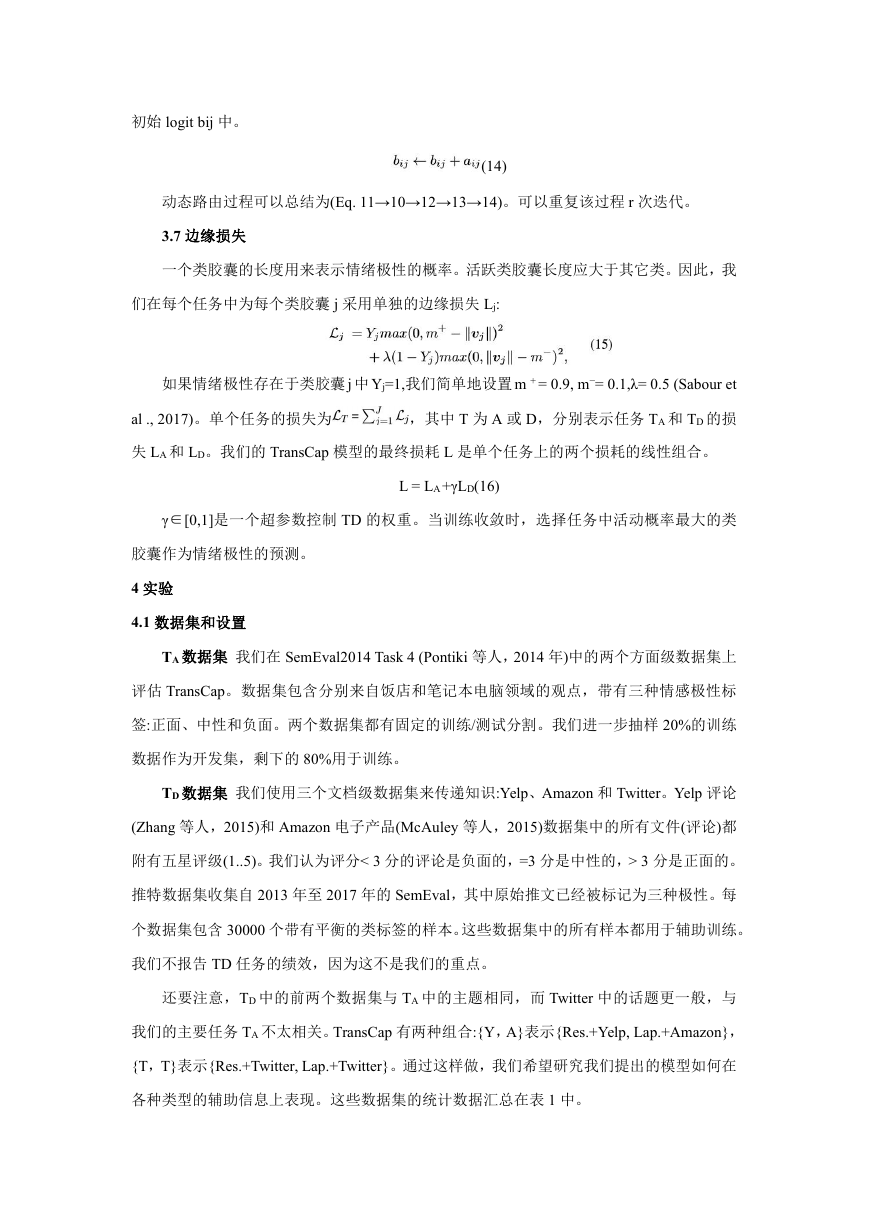

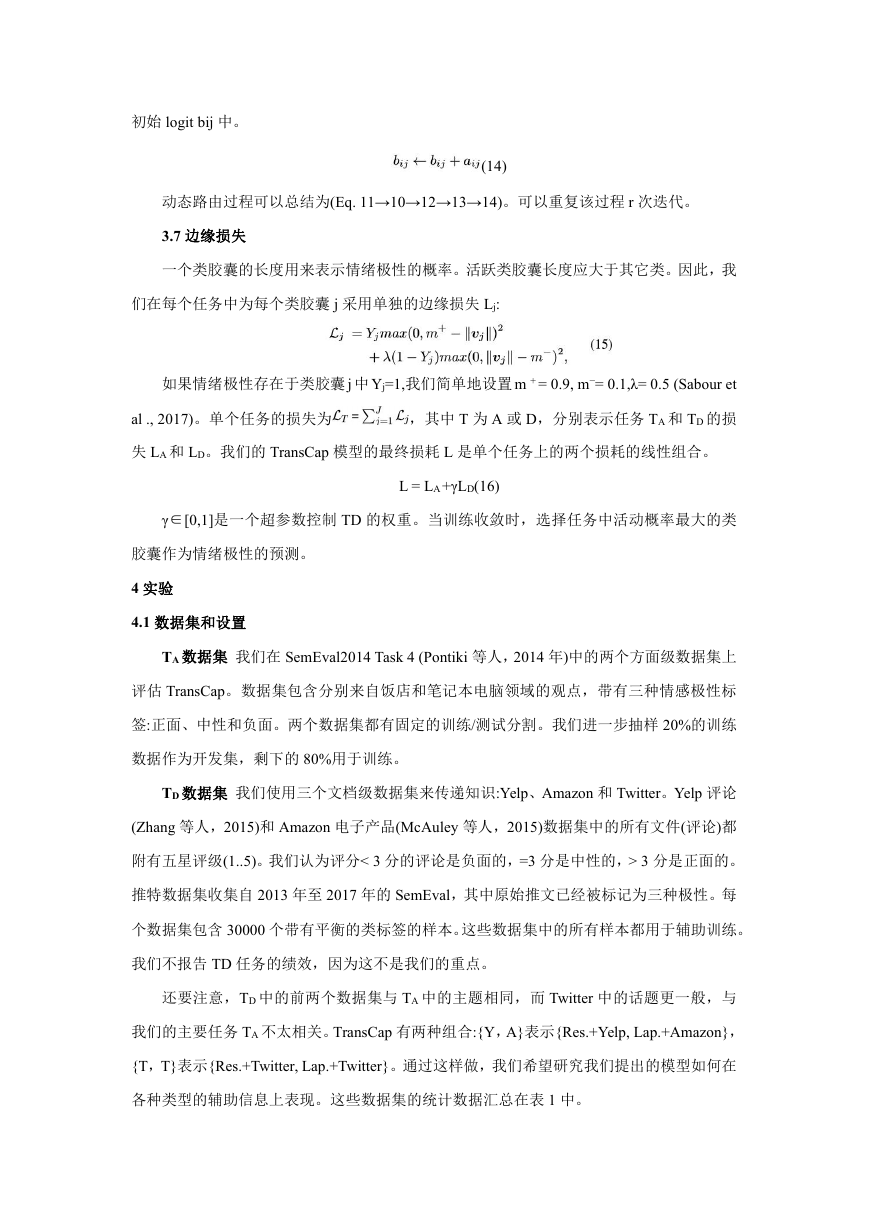

TA 数据集 我们在 SemEval2014 Task 4 (Pontiki 等人,2014 年)中的两个方面级数据集上

评估 TransCap。数据集包含分别来自饭店和笔记本电脑领域的观点,带有三种情感极性标

签:正面、中性和负面。两个数据集都有固定的训练/测试分割。我们进一步抽样 20%的训练

数据作为开发集,剩下的 80%用于训练。

TD 数据集 我们使用三个文档级数据集来传递知识:Yelp、Amazon 和 Twitter。Yelp 评论

(Zhang 等人,2015)和 Amazon 电子产品(McAuley 等人,2015)数据集中的所有文件(评论)都

附有五星评级(1..5)。我们认为评分< 3 分的评论是负面的,=3 分是中性的,> 3 分是正面的。

推特数据集收集自 2013 年至 2017 年的 SemEval,其中原始推文已经被标记为三种极性。每

个数据集包含 30000 个带有平衡的类标签的样本。这些数据集中的所有样本都用于辅助训练。

我们不报告 TD 任务的绩效,因为这不是我们的重点。

还要注意,TD 中的前两个数据集与 TA 中的主题相同,而 Twitter 中的话题更一般,与

我们的主要任务 TA 不太相关。TransCap 有两种组合:{Y,A}表示{Res.+Yelp, Lap.+Amazon},

{T,T}表示{Res.+Twitter, Lap.+Twitter}。通过这样做,我们希望研究我们提出的模型如何在

各种类型的辅助信息上表现。这些数据集的统计数据汇总在表 1 中。

�

设置 我们使用 Glove 向量和 840B tokens (Pennington 等人,2014)作为预训练的单词

嵌入。遵循 Sabour 等人(2017 年)的 r=3。其余的超参数根据开发集进行调整。我们设置 dw=300,

dl=100,K=3,C=16,dp=16,dc=24。分别为{R,Y}、{R,T}、{L,A}、{L,T}数据集组

合的γ={0.7,0.8,0.8,0.3}。我们使用 Adam 优化算法 (Kingma 和 Ba,2014),学习率为

0.001,批量为 128。我们对所有模型进行了 50 遍训练用早停的方式,即如果开发集的性能

在 5 遍训练后都没有提高,则停止训练。平均精度(Acc。)和 F1 值 (F1)分数在相同的评估数

据集分割上随机初始化 5 次后报告。

比较方法 为了证明我们的 TransCap 在 ASC 任务中的优势,我们将其与以下基线进

行了比较: ATAELSTM (Wang et al., 2016b), IAN (Ma et al., 2017), AF-LSTM(CONV) (Tay et

al., 2018), AFLSTM(CORR) (Tay et al., 2018), PBAN (Gu et al., 2018), MemNN (Tang et al.,

2016), RAM (Chen et al., 2017), CEA (Yang et al., 2018a), DAuM (Zhu and Qian, 2018), IARM

(Majumder et al., 2018), PRET+MULT (He et al., 2018) and GCAE (Xue and Li, 2018).其中大多

数是 2018 年发布的最新方法。其余的是常用的经典模型。

4.2 主要结果

所有模型的比较结果如表 2 所示。为清晰起见,我们将模型分为四类:第一类是基于

LSTM 的方法(从 M1 到 M5),第二类是基于记忆的方法(从 M6 到 M10),第三类是混合方法

(M11 和 M12),最后三行(M13 到 M15)是我们模型的变体,其中 TransCap{S}表示仅具有 TA

任务的方法,TransCap{Y,A}和 TransCap{T,T}利用来自不同来源的知识。

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc