粒子群算法(1)----粒子群算法简介

一、粒子群算法的历史

粒子群算法源于复杂适应系统(Complex Adaptive System,CAS)。CAS 理论于 1994 年正式提出,CAS 中的

成员称为主体。比如研究鸟群系统,每个鸟在这个系统中就称为主体。主体有适应性,它能够与环境及其他的主体进

行交流,并且根据交流的过程“学习”或“积累经验”改变自身结构与行为。整个系统的演变或进化包括:新层次的产生(小

鸟的出生);分化和多样性的出现(鸟群中的鸟分成许多小的群);新的主题的出现(鸟寻找食物过程中,不断发现

新的食物)。

所以 CAS 系统中的主体具有 4 个基本特点(这些特点是粒子群算法发展变化的依据):

首先,主体是主动的、活动的。

主体与环境及其他主体是相互影响、相互作用的,这种影响是系统发展变化的主要动力。

环境的影响是宏观的,主体之间的影响是微观的,宏观与微观要有机结合。

最后,整个系统可能还要受一些随机因素的影响。

粒子群算法就是对一个 CAS 系统---鸟群社会系统的研究得出的。

粒子群算法( Particle Swarm Optimization, PSO)最早是由 Eberhart 和 Kennedy 于 1995 年提出,它的基本概

念源于对鸟群觅食行为的研究。设想这样一个场景:一群鸟在随机搜寻食物,在这个区域里只有一块食物,所有的鸟都

不知道食物在哪里,但是它们知道当前的位置离食物还有多远。那么找到食物的最优策略是什么呢?最简单有效的就是

搜寻目前离食物最近的鸟的周围区域。

PSO 算法就从这种生物种群行为特性中得到启发并用于求解优化问题。在 PSO 中,每个优化问题的潜在解都可

以想象成 d 维搜索空间上的一个点,我们称之为“粒子”(Particle),所有的粒子都有一个被目标函数决定的适应值

(Fitness Value ),每个粒子还有一个速度决定他们飞翔的方向和距离,然后粒子们就追随当前的最优粒子在解空间中

搜索。Reynolds 对鸟群飞行的研究发现。鸟仅仅是追踪它有限数量的邻居但最终的整体结果是整个鸟群好像在一个中

心的控制之下.即复杂的全局行为是由简单规则的相互作用引起的。

二、粒子群算法的具体表述

上面罗嗦了半天,那些都是科研工作者写论文的语气,不过,PSO 的历史就像上面说的那样。下面通俗的解释

PSO 算法。

PSO 算法就是模拟一群鸟寻找食物的过程,每个鸟就是 PSO 中的粒子,也就是我们需要求解问题的可能解,这

些鸟在寻找食物的过程中,不停改变自己在空中飞行的位置与速度。大家也可以观察一下,鸟群在寻找食物的过程中,

开始鸟群比较分散,逐渐这些鸟就会聚成一群,这个群忽高忽低、忽左忽右,直到最后找到食物。这个过程我们转化

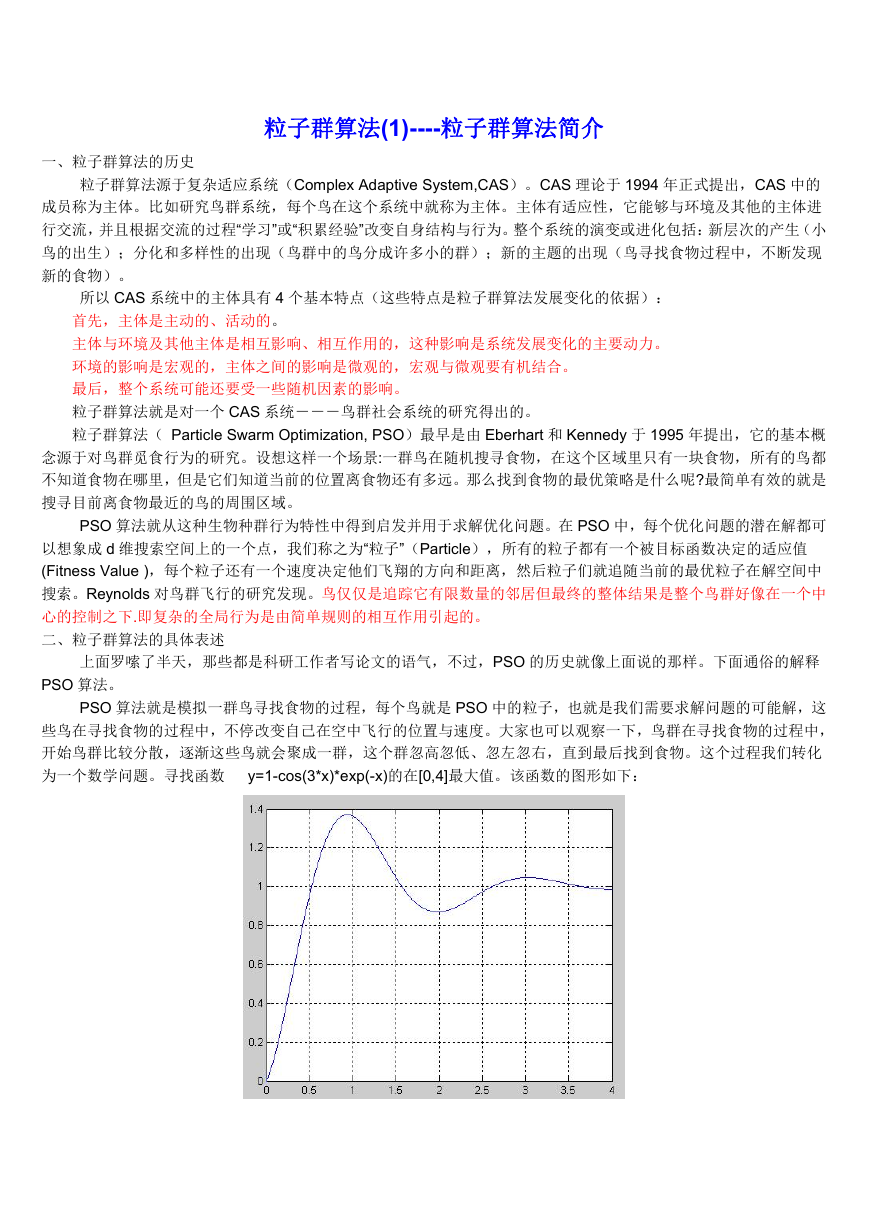

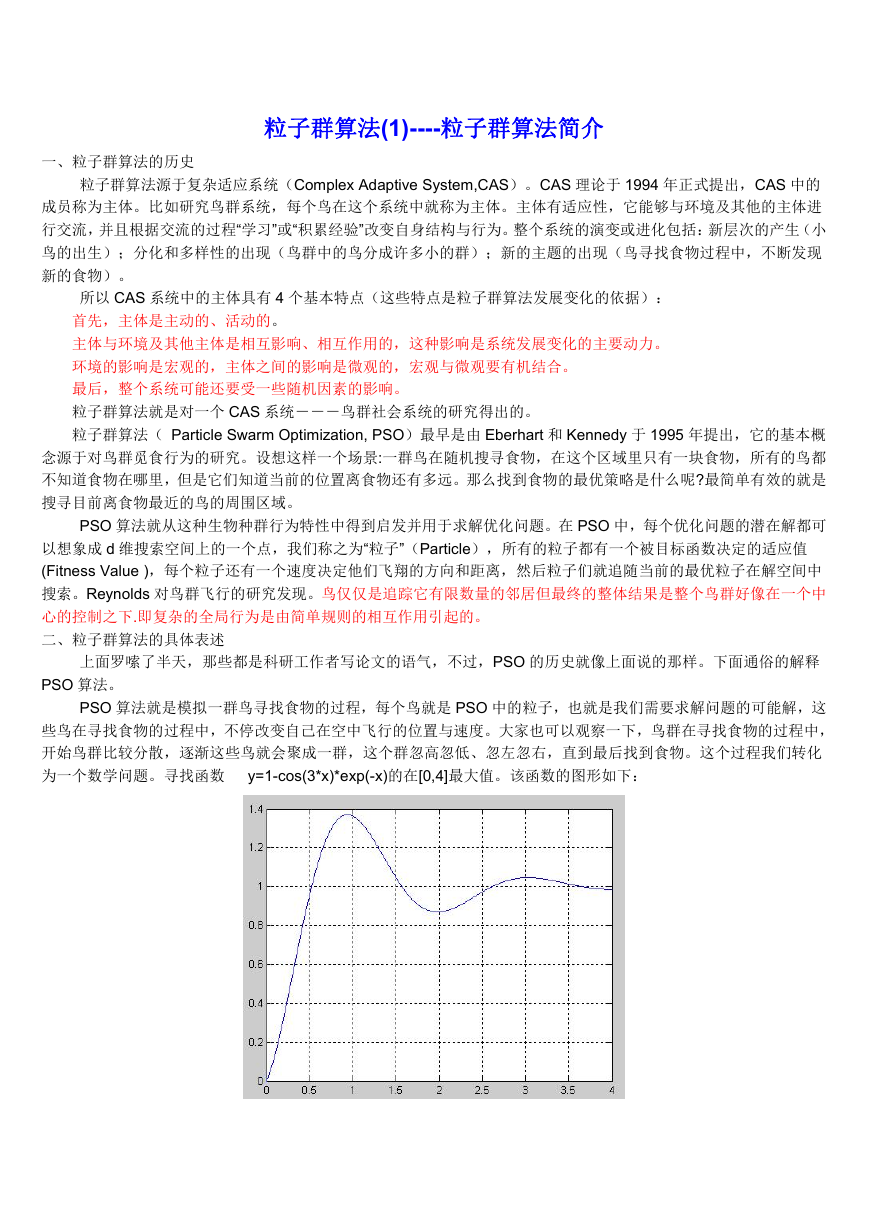

为一个数学问题。寻找函数 y=1-cos(3*x)*exp(-x)的在[0,4]最大值。该函数的图形如下:

�

当 x=0.9350-0.9450,达到最大值 y=1.3706。为了得到该函数的最大值,我们在[0,4]之间随机的洒一些点,为

了演示,我们放置两个点,并且计算这两个点的函数值,同时给这两个点设置在[0,4]之间的一个速度。下面这些点就

会按照一定的公式更改自己的位置,到达新位置后,再计算这两个点的值,然后再按照一定的公式更新自己的位置。

直到最后在 y=1.3706 这个点停止自己的更新。这个过程与粒子群算法作为对照如下:

这两个点就是粒子群算法中的粒子。

该函数的最大值就是鸟群中的食物

计算两个点函数值就是粒子群算法中的适应值,计算用的函数 y=1-cos(3*x)*exp(-x)就是粒子群算法中的适应度函

数。

更新自己位置的一定公式就是粒子群算法中的位置速度更新公式(下一节讲)。

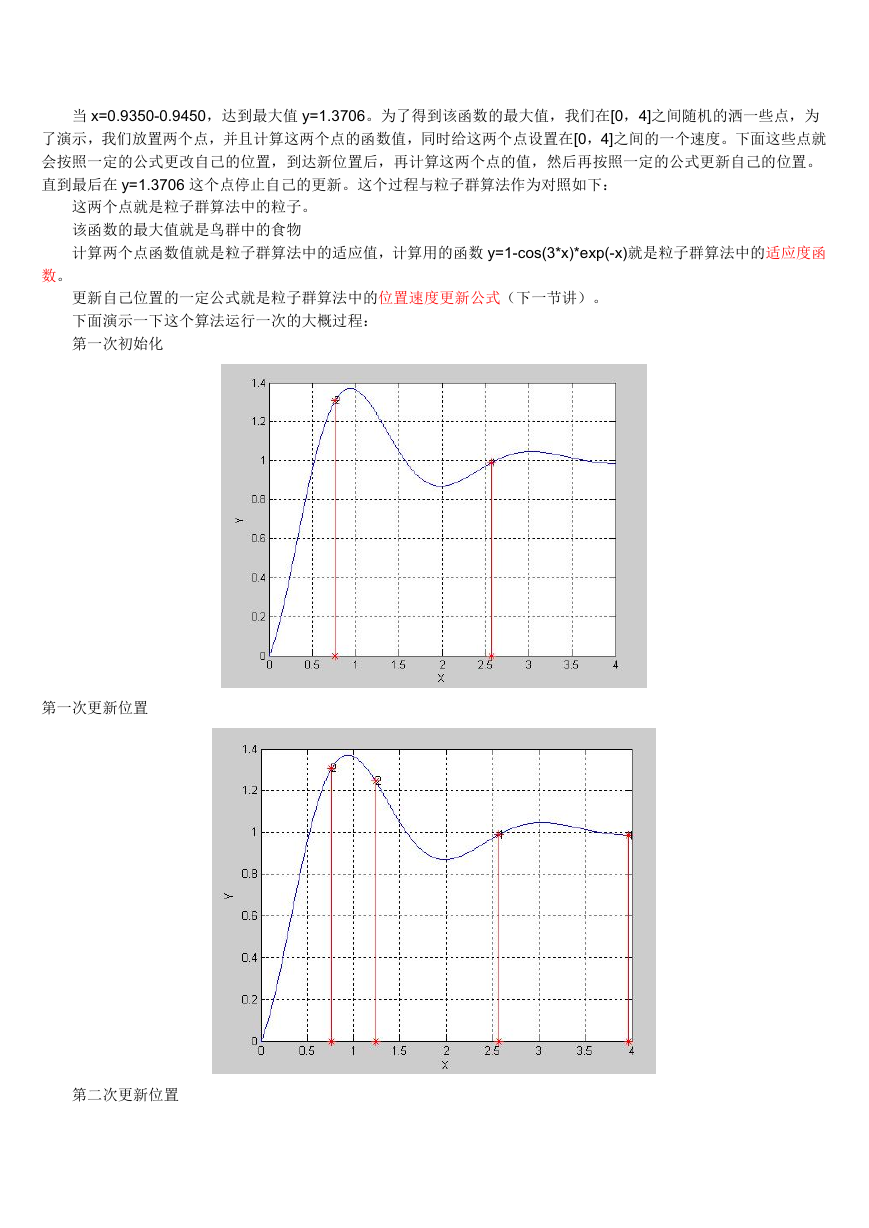

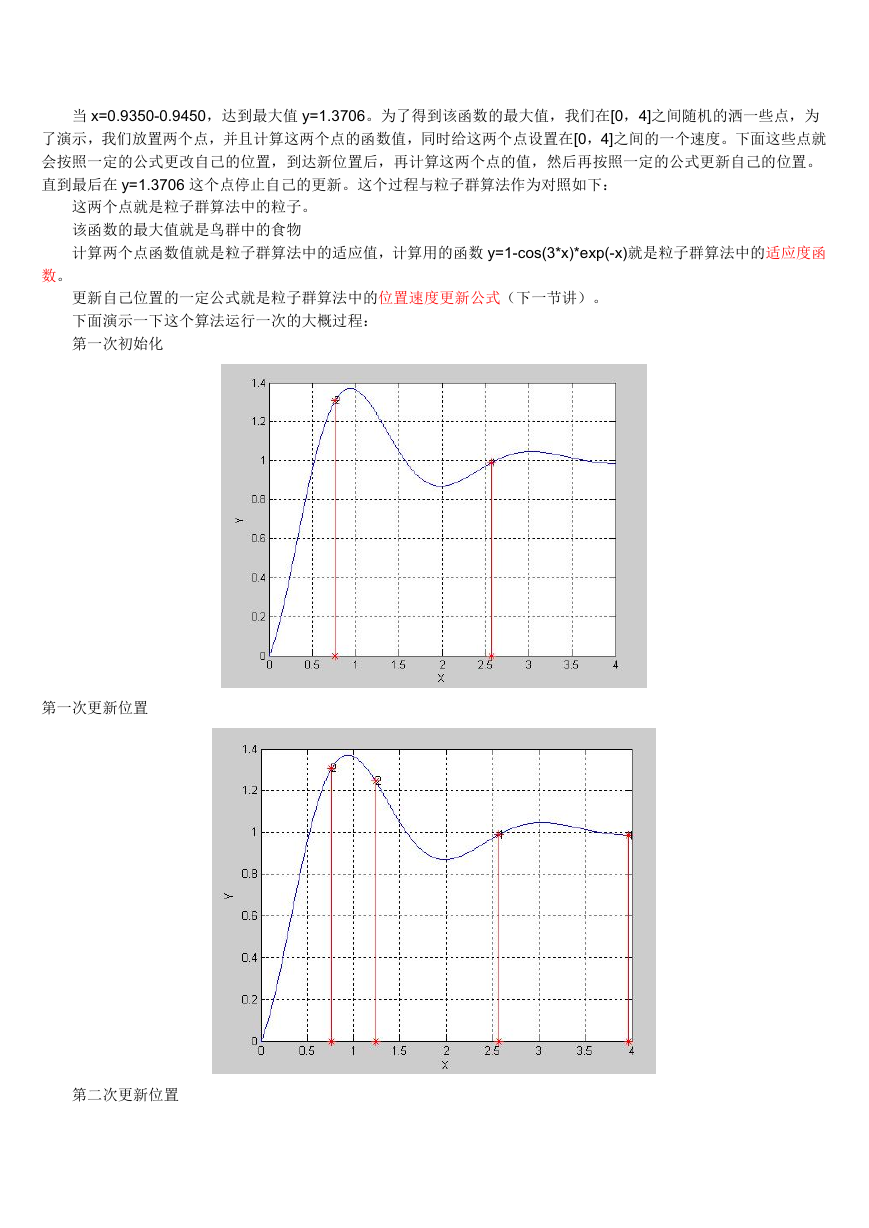

下面演示一下这个算法运行一次的大概过程:

第一次初始化

第一次更新位置

第二次更新位置

�

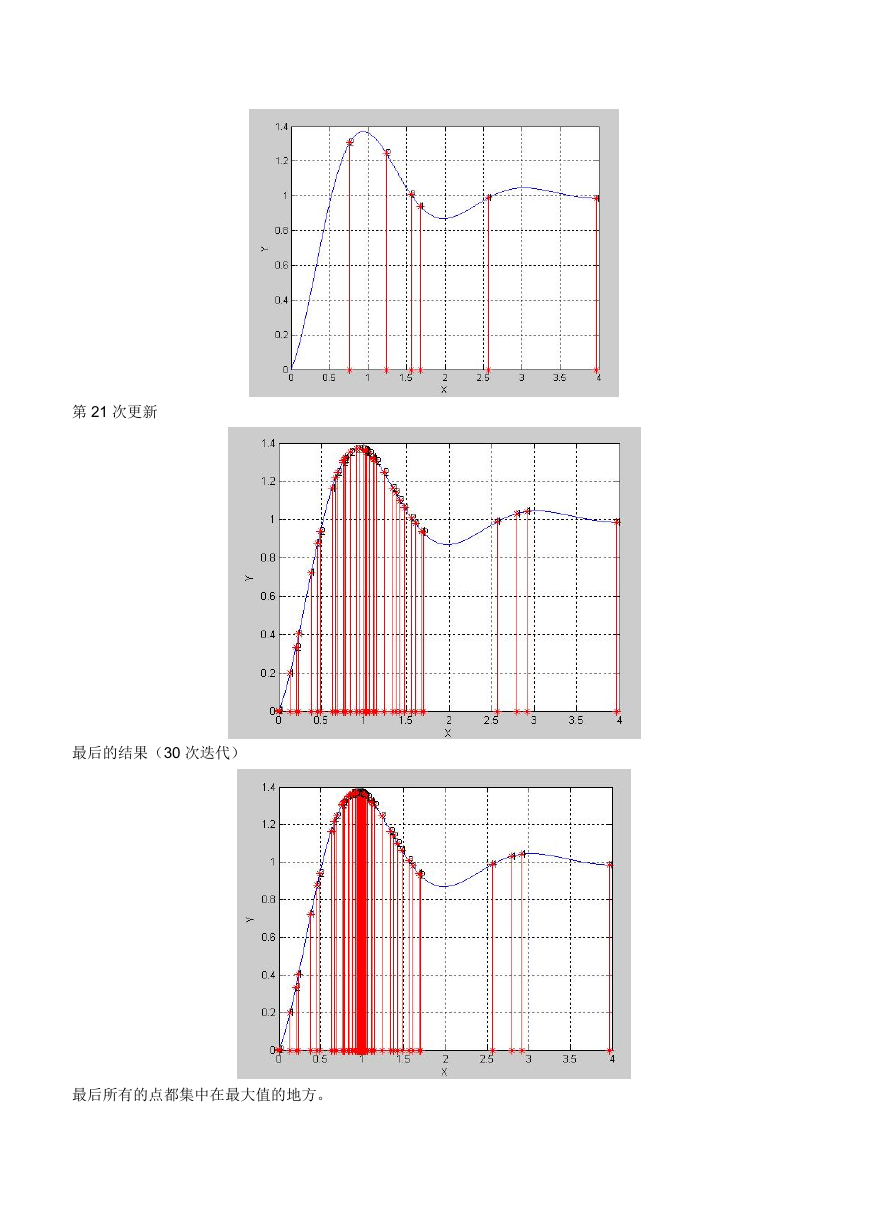

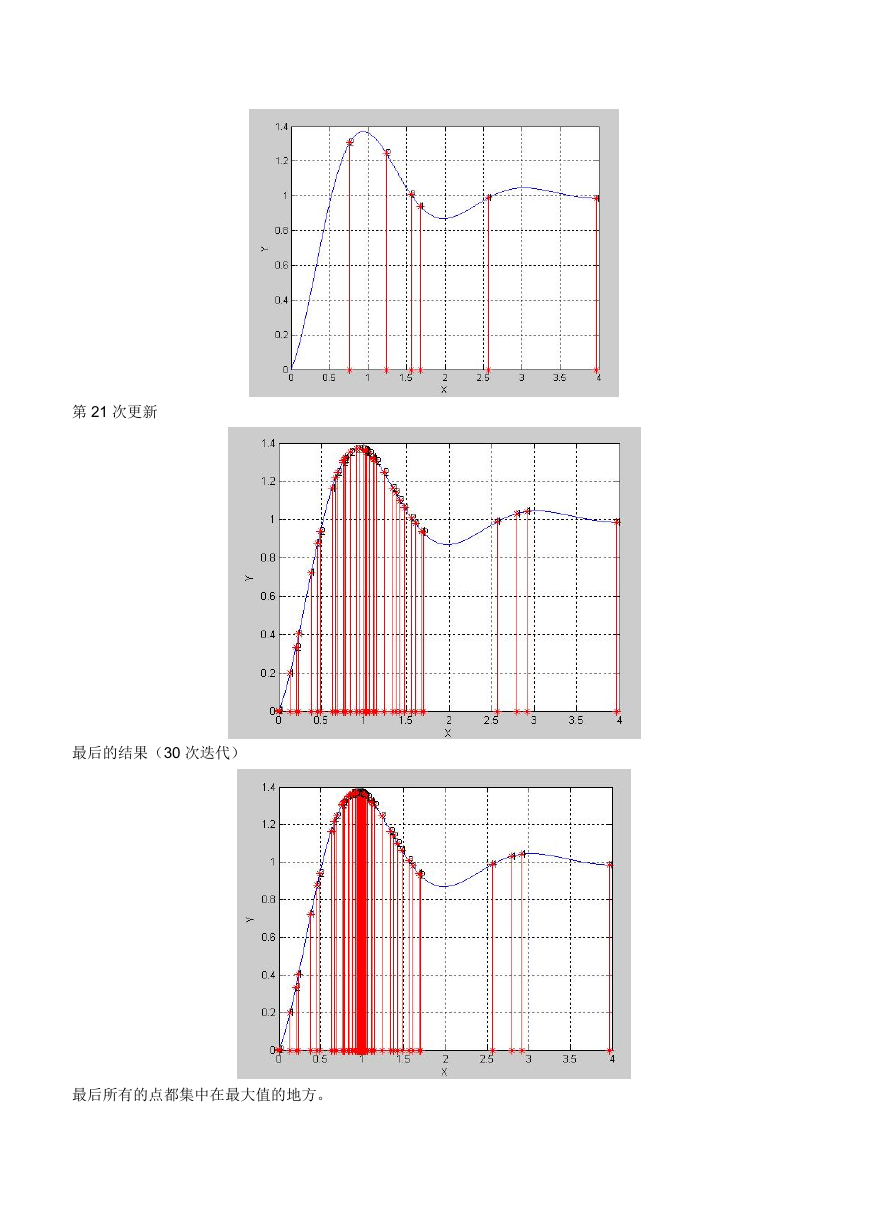

第 21 次更新

最后的结果(30 次迭代)

最后所有的点都集中在最大值的地方。

�

粒子群算法(2)----标准的粒子群算法

在上一节的叙述中,唯一没有给大家介绍的就是函数的这些随机的点(粒子)是如何运动的,只是说按照一定的公式

更新。这个公式就是粒子群算法中的位置速度更新公式。下面就介绍这个公式是什么。在上一节中我们求取函数

y=1-cos(3*x)*exp(-x)的在[0,4]最大值。并在[0,4]之间放置了两个随机的点,这些点的坐标假设为 x1=1.5; x2=2.5;

这里的点是一个标量,但是我们经常遇到的问题可能是更一般的情况--x 为一个矢量的情况,比如二维的情况

z=2*x1+3*x22 的情况。这个时候我们的每个粒子为二维,记粒子 P1=

(x11,x12),P2=(x21,x22),P3=(x31,x32),......Pn=(xn1,xn2)。这里 n 为粒子群群体的规模,也就是这个群中粒子的个数,

每个粒子的维数为 2。更一般的是粒子的维数为 q,这样在这个种群中有 n 个粒子,每个粒子为 q 维。

由 n 个粒子组成的群体对 Q 维(就是每个粒子的维数)空间进行搜索。每个粒子表示为:xi=(xi1,xi2,xi3,...,xiQ),

每个粒子对应的速度可以表示为 vi=(vi1,vi2,vi3,....,viQ),每个粒子在搜索时要考虑两个因素:

1。自己搜索到的历史最优值 pi ,pi=(pi1,pi2,....,piQ),i=1,2,3,....,n。

2。全部粒子搜索到的最优值 pg,pg=(pg1,pg2,....,pgQ),注意这里的 pg 只有一个。

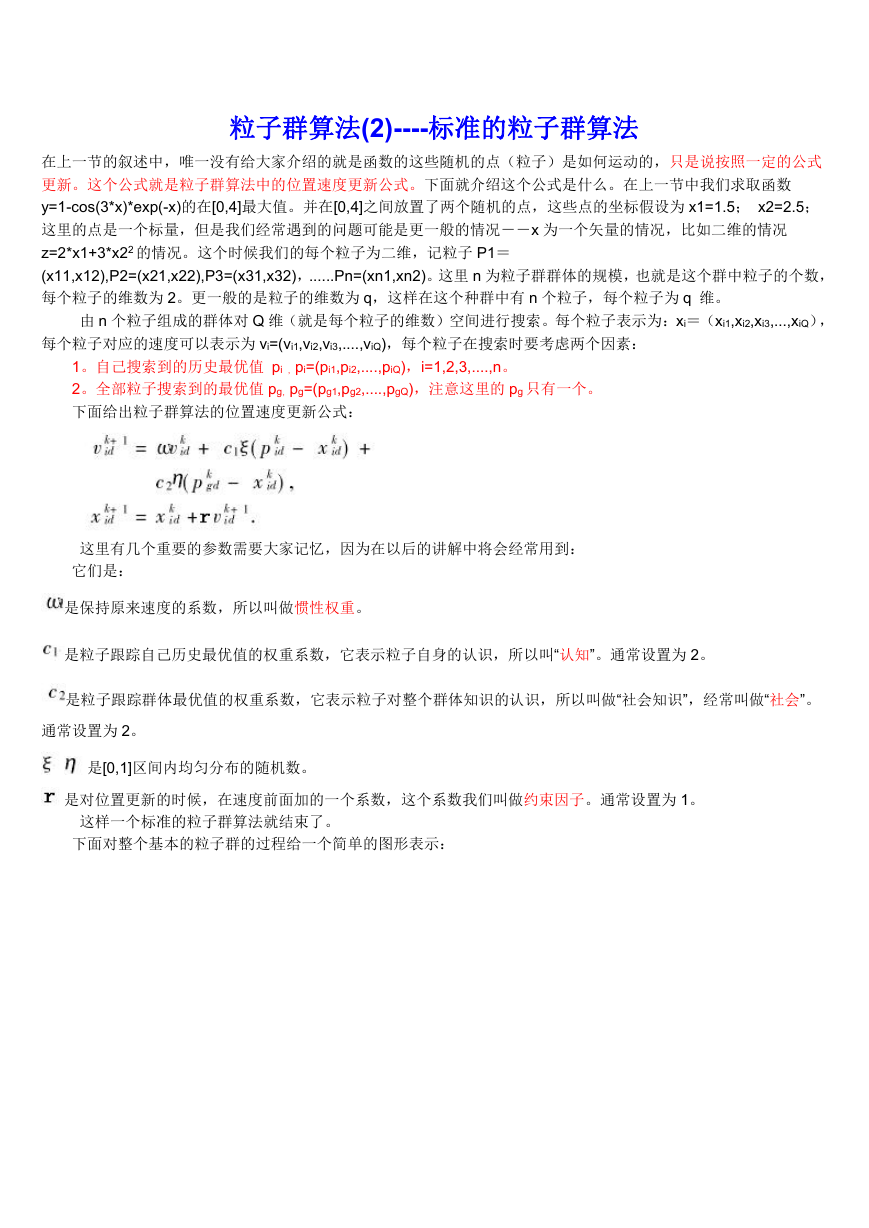

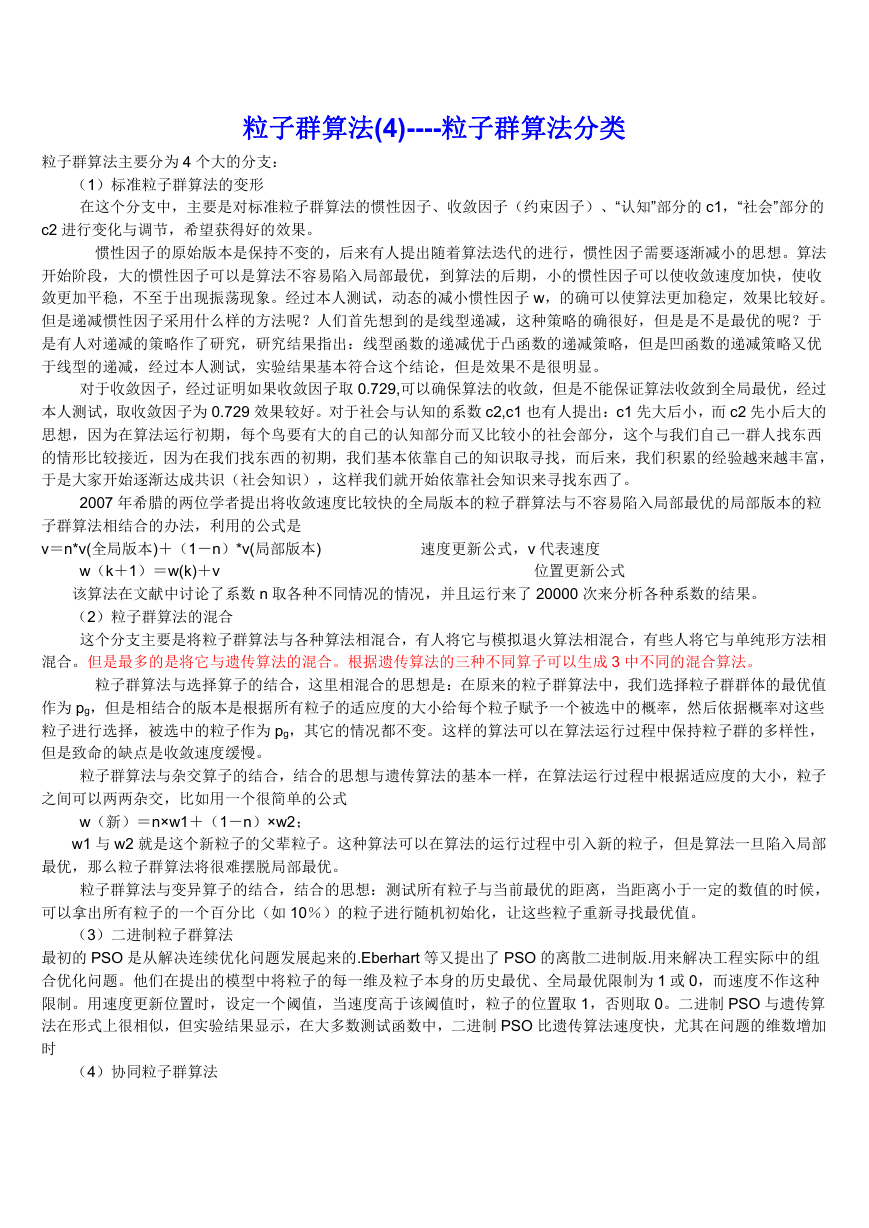

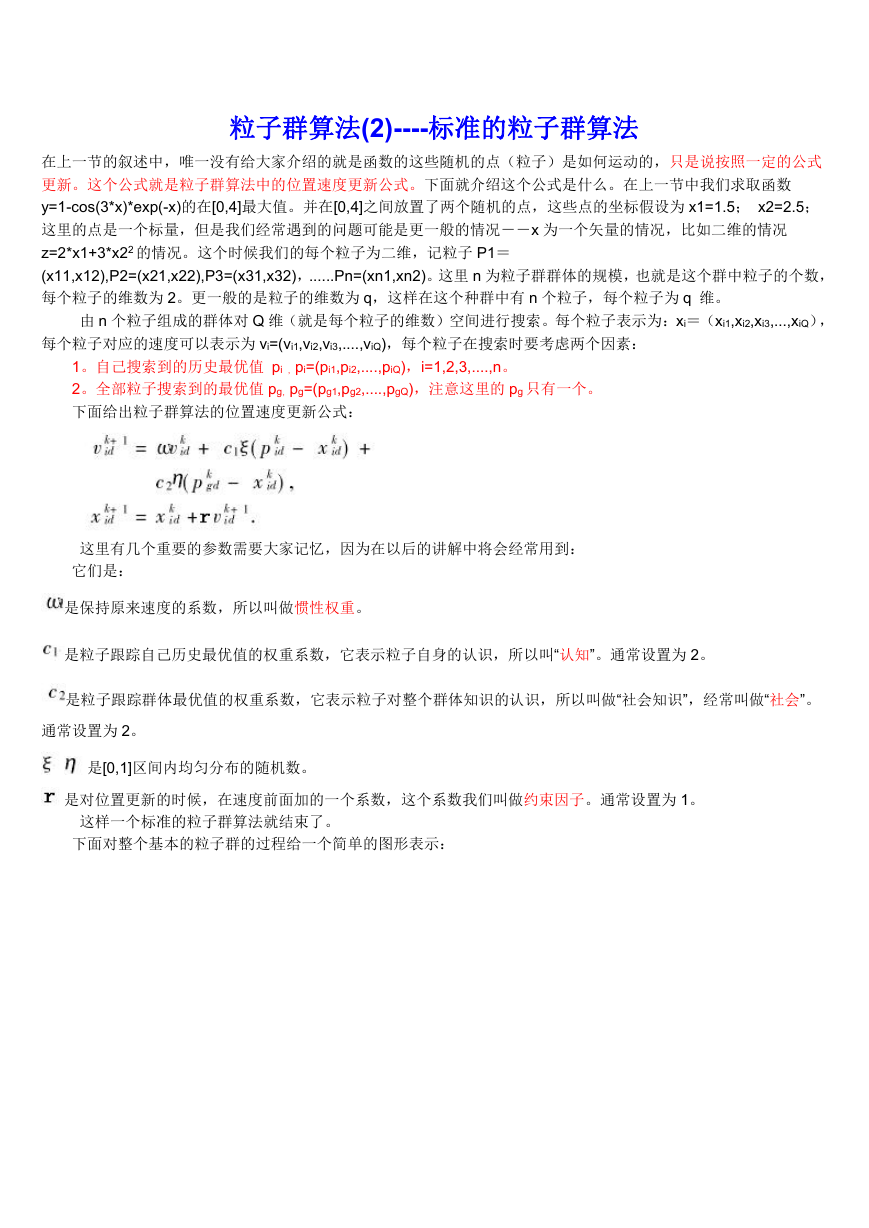

下面给出粒子群算法的位置速度更新公式:

这里有几个重要的参数需要大家记忆,因为在以后的讲解中将会经常用到:

它们是:

是保持原来速度的系数,所以叫做惯性权重。

是粒子跟踪自己历史最优值的权重系数,它表示粒子自身的认识,所以叫“认知”。通常设置为 2。

是粒子跟踪群体最优值的权重系数,它表示粒子对整个群体知识的认识,所以叫做“社会知识”,经常叫做“社会”。

通常设置为 2。

是[0,1]区间内均匀分布的随机数。

是对位置更新的时候,在速度前面加的一个系数,这个系数我们叫做约束因子。通常设置为 1。

这样一个标准的粒子群算法就结束了。

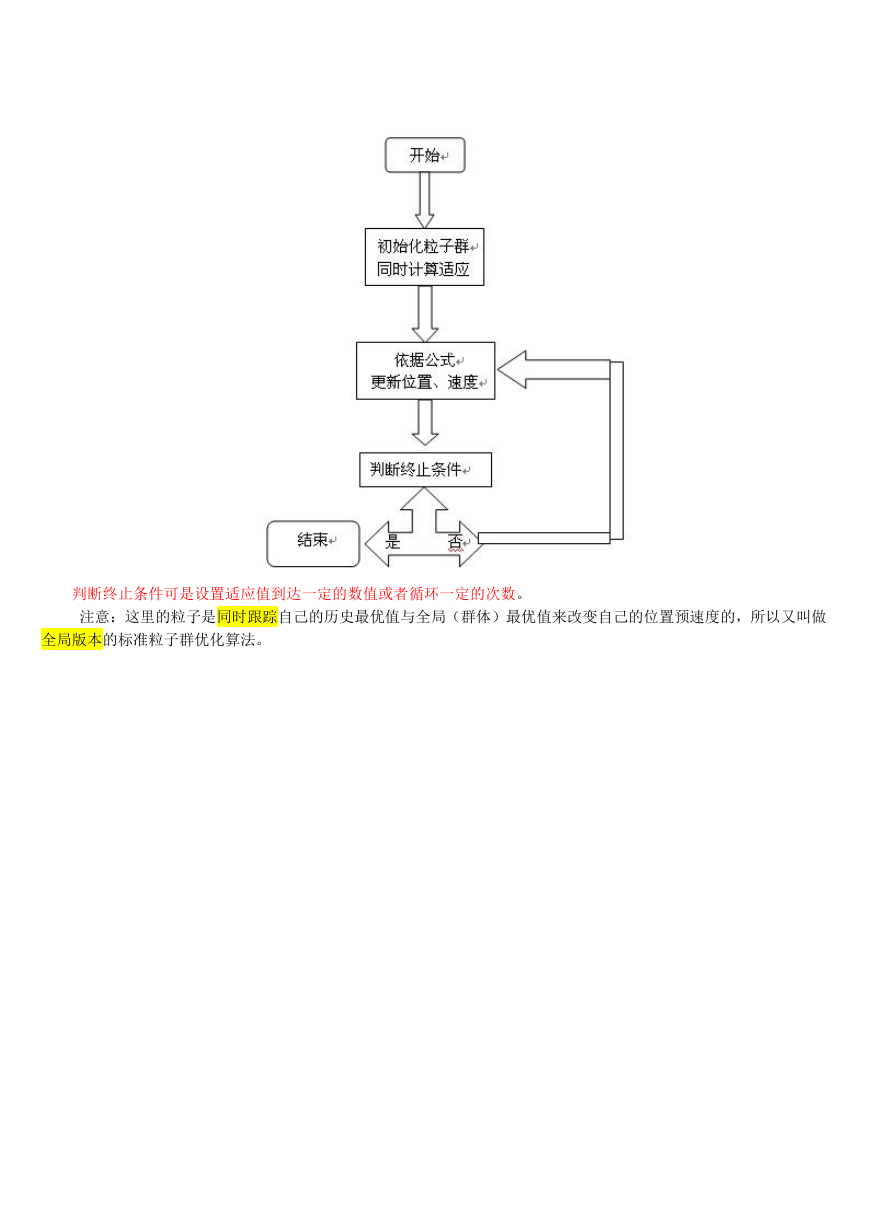

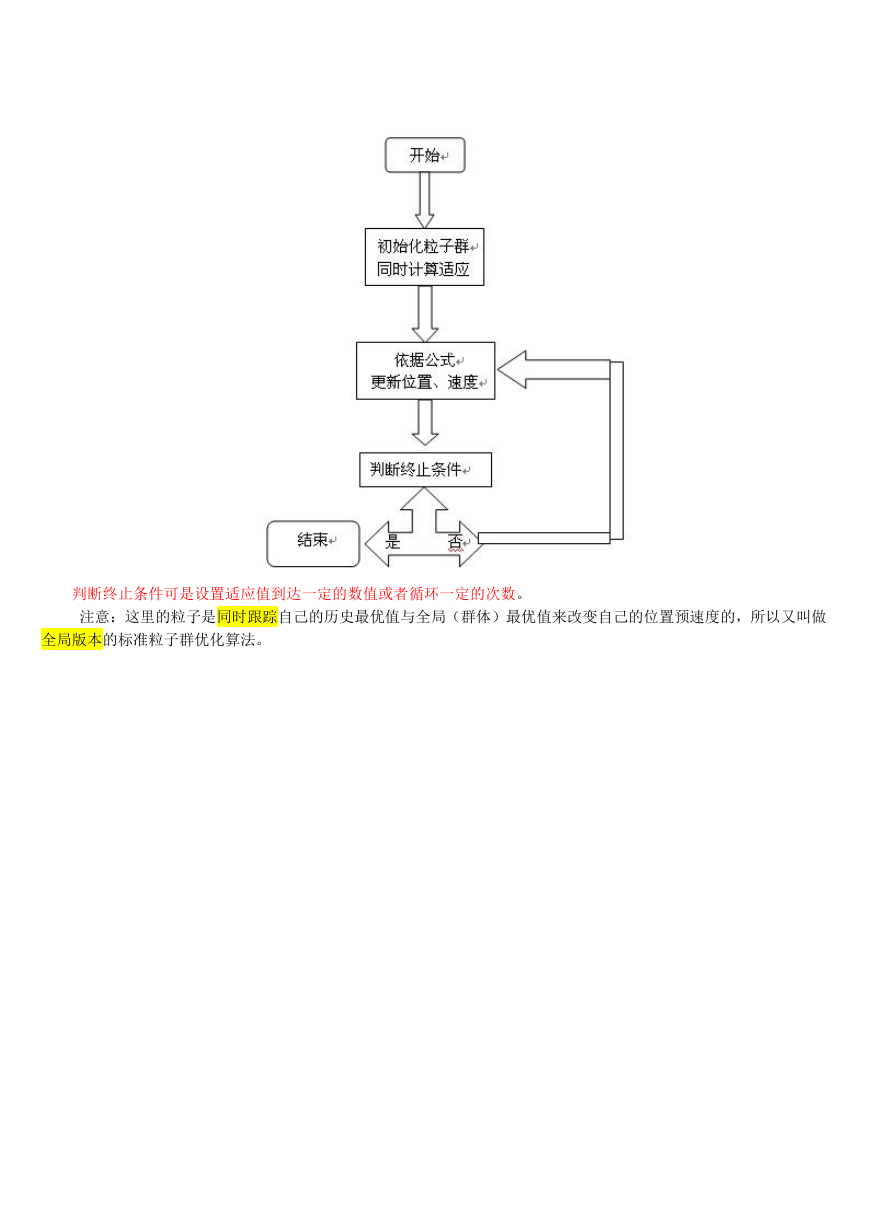

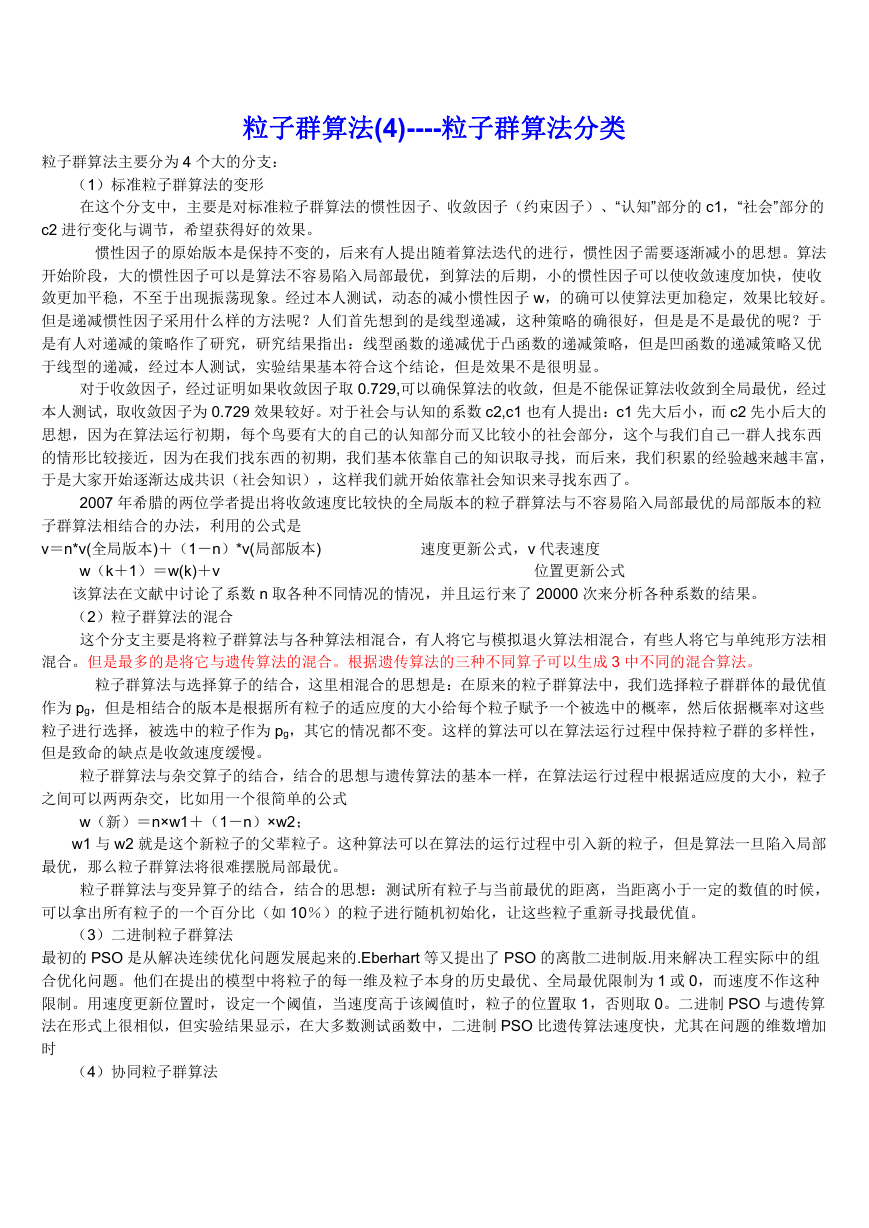

下面对整个基本的粒子群的过程给一个简单的图形表示:

�

判断终止条件可是设置适应值到达一定的数值或者循环一定的次数。

注意:这里的粒子是同时跟踪自己的历史最优值与全局(群体)最优值来改变自己的位置预速度的,所以又叫做

全局版本的标准粒子群优化算法。

�

粒子群算法(3)----标准的粒子群算法(局部版本)

在全局版的标准粒子群算法中,每个粒子的速度的更新是根据两个因素来变化的,这两个因素是:1. 粒子自己历史

最优值 pi。2. 粒子群体的全局最优值 pg。如果改变粒子速度更新公式,让每个粒子的速度的更新根据以下两个因素更

新,A. 粒子自己历史最优值 pi。B. 粒子邻域内粒子的最优值 pnk。其余保持跟全局版的标准粒子群算法一样,这个算法

就变为局部版的粒子群算法。

一般一个粒子 i 的邻域随着迭代次数的增加而逐渐增加,开始第一次迭代,它的邻域为 0,随着迭代次数邻域线

性变大,最后邻域扩展到整个粒子群,这时就变成全局版本的粒子群算法了。经过实践证明:全局版本的粒子群算法

收敛速度快,但是容易陷入局部最优。局部版本的粒子群算法收敛速度慢,但是很难陷入局部最优。现在的粒子群算

法大都在收敛速度与摆脱局部最优这两个方面下功夫。其实这两个方面是矛盾的。看如何更好的折中了。

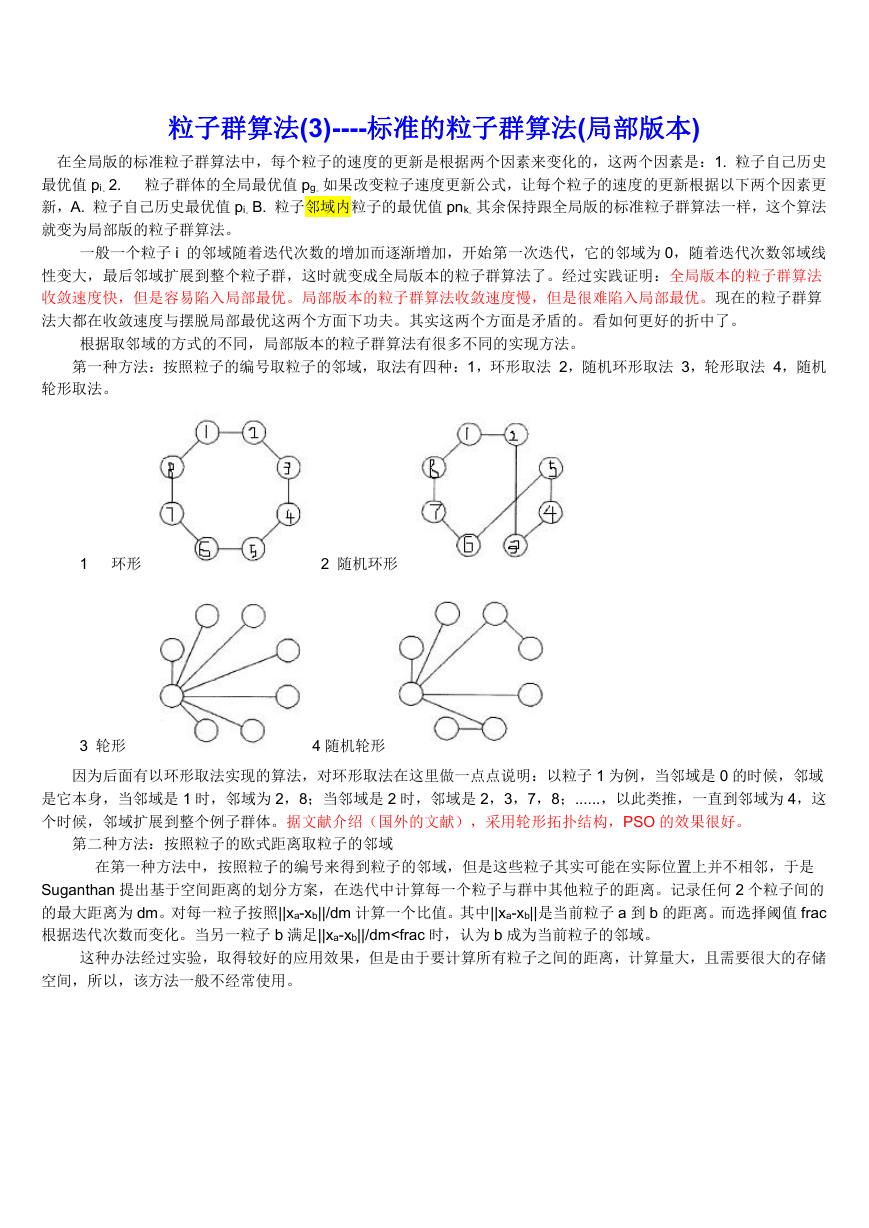

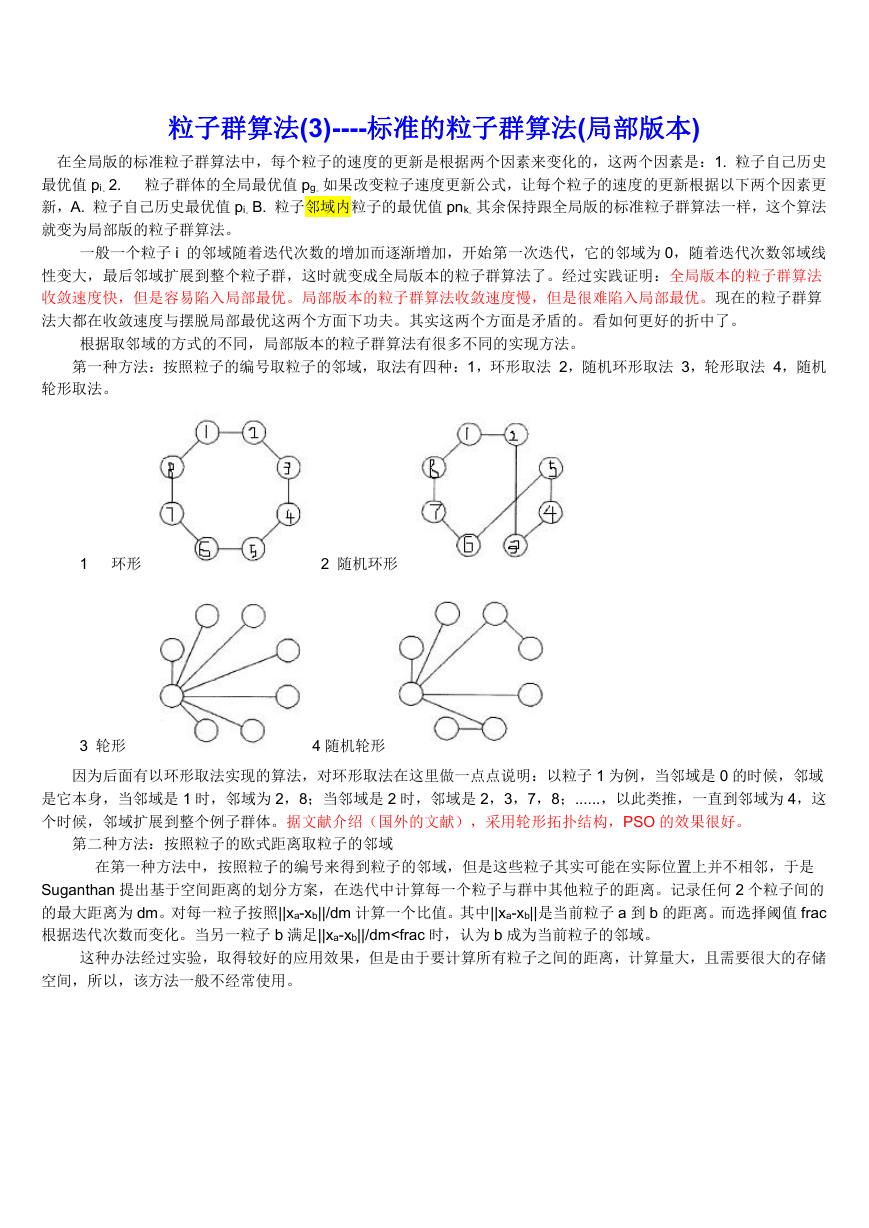

根据取邻域的方式的不同,局部版本的粒子群算法有很多不同的实现方法。

第一种方法:按照粒子的编号取粒子的邻域,取法有四种:1,环形取法 2,随机环形取法 3,轮形取法 4,随机

轮形取法。

1 环形

2 随机环形

3 轮形

因为后面有以环形取法实现的算法,对环形取法在这里做一点点说明:以粒子 1 为例,当邻域是 0 的时候,邻域

是它本身,当邻域是 1 时,邻域为 2,8;当邻域是 2 时,邻域是 2,3,7,8;......,以此类推,一直到邻域为 4,这

个时候,邻域扩展到整个例子群体。据文献介绍(国外的文献),采用轮形拓扑结构,PSO 的效果很好。

4 随机轮形

第二种方法:按照粒子的欧式距离取粒子的邻域

在第一种方法中,按照粒子的编号来得到粒子的邻域,但是这些粒子其实可能在实际位置上并不相邻,于是

Suganthan 提出基于空间距离的划分方案,在迭代中计算每一个粒子与群中其他粒子的距离。记录任何 2 个粒子间的

的最大距离为 dm。对每一粒子按照||xa-xb||/dm 计算一个比值。其中||xa-xb||是当前粒子 a 到 b 的距离。而选择阈值 frac

根据迭代次数而变化。当另一粒子 b 满足||xa-xb||/dm

粒子群算法(4)----粒子群算法分类

粒子群算法主要分为 4 个大的分支:

(1)标准粒子群算法的变形

在这个分支中,主要是对标准粒子群算法的惯性因子、收敛因子(约束因子)、“认知”部分的 c1,“社会”部分的

c2 进行变化与调节,希望获得好的效果。

惯性因子的原始版本是保持不变的,后来有人提出随着算法迭代的进行,惯性因子需要逐渐减小的思想。算法

开始阶段,大的惯性因子可以是算法不容易陷入局部最优,到算法的后期,小的惯性因子可以使收敛速度加快,使收

敛更加平稳,不至于出现振荡现象。经过本人测试,动态的减小惯性因子 w,的确可以使算法更加稳定,效果比较好。

但是递减惯性因子采用什么样的方法呢?人们首先想到的是线型递减,这种策略的确很好,但是是不是最优的呢?于

是有人对递减的策略作了研究,研究结果指出:线型函数的递减优于凸函数的递减策略,但是凹函数的递减策略又优

于线型的递减,经过本人测试,实验结果基本符合这个结论,但是效果不是很明显。

对于收敛因子,经过证明如果收敛因子取 0.729,可以确保算法的收敛,但是不能保证算法收敛到全局最优,经过

本人测试,取收敛因子为 0.729 效果较好。对于社会与认知的系数 c2,c1 也有人提出:c1 先大后小,而 c2 先小后大的

思想,因为在算法运行初期,每个鸟要有大的自己的认知部分而又比较小的社会部分,这个与我们自己一群人找东西

的情形比较接近,因为在我们找东西的初期,我们基本依靠自己的知识取寻找,而后来,我们积累的经验越来越丰富,

于是大家开始逐渐达成共识(社会知识),这样我们就开始依靠社会知识来寻找东西了。

2007 年希腊的两位学者提出将收敛速度比较快的全局版本的粒子群算法与不容易陷入局部最优的局部版本的粒

子群算法相结合的办法,利用的公式是

v=n*v(全局版本)+(1-n)*v(局部版本)

速度更新公式,v 代表速度

w(k+1)=w(k)+v

该算法在文献中讨论了系数 n 取各种不同情况的情况,并且运行来了 20000 次来分析各种系数的结果。

(2)粒子群算法的混合

这个分支主要是将粒子群算法与各种算法相混合,有人将它与模拟退火算法相混合,有些人将它与单纯形方法相

位置更新公式

混合。但是最多的是将它与遗传算法的混合。根据遗传算法的三种不同算子可以生成 3 中不同的混合算法。

粒子群算法与选择算子的结合,这里相混合的思想是:在原来的粒子群算法中,我们选择粒子群群体的最优值

作为 pg,但是相结合的版本是根据所有粒子的适应度的大小给每个粒子赋予一个被选中的概率,然后依据概率对这些

粒子进行选择,被选中的粒子作为 pg,其它的情况都不变。这样的算法可以在算法运行过程中保持粒子群的多样性,

但是致命的缺点是收敛速度缓慢。

粒子群算法与杂交算子的结合,结合的思想与遗传算法的基本一样,在算法运行过程中根据适应度的大小,粒子

之间可以两两杂交,比如用一个很简单的公式

w(新)=n×w1+(1-n)×w2;

w1 与 w2 就是这个新粒子的父辈粒子。这种算法可以在算法的运行过程中引入新的粒子,但是算法一旦陷入局部

最优,那么粒子群算法将很难摆脱局部最优。

粒子群算法与变异算子的结合,结合的思想:测试所有粒子与当前最优的距离,当距离小于一定的数值的时候,

可以拿出所有粒子的一个百分比(如 10%)的粒子进行随机初始化,让这些粒子重新寻找最优值。

(3)二进制粒子群算法

最初的 PSO 是从解决连续优化问题发展起来的.Eberhart 等又提出了 PSO 的离散二进制版.用来解决工程实际中的组

合优化问题。他们在提出的模型中将粒子的每一维及粒子本身的历史最优、全局最优限制为 1 或 0,而速度不作这种

限制。用速度更新位置时,设定一个阈值,当速度高于该阈值时,粒子的位置取 1,否则取 0。二进制 PSO 与遗传算

法在形式上很相似,但实验结果显示,在大多数测试函数中,二进制 PSO 比遗传算法速度快,尤其在问题的维数增加

时

(4)协同粒子群算法

�

协同 PSO,该方法将粒子的 D 维分到 D 个粒子群中,每个粒子群优化一维向量,评价适应度时将这些分量合并

为一个完整的向量。例如第 i 个粒子群,除第 i 个分量外,其他 D-1 个分量都设为最优值,不断用第 i 个粒子群中的粒

子替换第 i 个分量,直到得到第 i 维的最优值,其他维相同。为将有联系的分量划分在一个群,可将 D 维向量分配到 m

个粒子群优化,则前 D mod m 个粒子群的维数是 D/m 的向上取整。后 m-(D mod m)个粒子群的维数是 D/m 的向下

取整。协同 PSO 在某些问题上有更快的收敛速度,但该算法容易被欺骗。

基本的粒子群算法的分支就着 4 个,大部分的粒子群算法都围绕着这 4 个分支在变化,其中粒子群算法的变形居

多,从根本上来说,几乎没有什么新的思想的提出。

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc