!#$ 决定强度的定义

设给 定 训 练 数 据 集 为 %,% 中 的 样 本 由 特 征 向 量 及 其 分 类

结 果 表 示 ,分 类 对 象 的 属 性 表 为&’$,’!, ###,’(),全 部 分 类 结

果构成的集合为*+$,+!,###,+,-,一般的有 (!$ 和 ,!!。对于

每一属性 ’.,其值域为 /(’.)。值域可以是离散的,也可以是

连续的。这样训练数据集的一个样本就可以表示成012+3456的

形式。其中 1 为样本中各属性具体取值2+(1)"*+$2+!,…2+,-

为实例 1 的分类结果。对于给定训练数据集 %,对各属性取值

与 分 类 结 果 取 值 在 (",$)的 范 围 内 进 行 量 化 ,并 通 过 神 经 网 络

训练2则可获得各属性 ’. 与分类结果的具体数学关系模型,即

+(1)78(’$2’!2…2’(

对于给定结构的神经网络来讲,上述关系是以网络的具体

)

权值与阈值来体现。因此就可以通过网络的具体权值与阈值来

分析各特征 ’. 与分类结果的具体作用关系。

为 了 便 于 分 析 各 属 性 ’. 与 分 类 结 果 的 具 体 作 用 关 系 ,在

此引入各属性 ’. 的决定强度 /9(’.)的概念。所谓的决定强度

/9(’.)就是属性 ’. 对分类结果的决定程度。决定强度 /9(’.)

的具体定义如下:

/9(’.

)7

#+(1)

#’.

即为分类结果 +345对属性 ’. 偏导数的绝对值。因此,决定

强度 /9(’.)反映了属性 ’. 对分类结果的影响程度。基于决定

强度 /9 (’.)在各种条件下的具体取值就逐步构造分类决策

树,以获取具体的分类规则。

!#! 决定强度的计算

决定强度 /9(’.)的计算主要涉及分类结果 +345对属性 ’.

偏导数的计算。在该文的研究中,选择多输入单输出的前馈网

络,即多个输入层节点分别对应于数据集 % 的 各 属 性 ’.,单 输

出层节点对应于分类结果 +(1)。

取网络的激发函数为 :3457 $

!

&$;<=34 > !"5),其 中 ,!"

为 一 常

数,在该文的研究中取为 "#?。对于单隐含层前馈神经网络,可

以推出网络输出对网络输入的偏导数的通用计算公式如下

EF$

#@A

#B.

:3!@

A5&$D:3!@

7 C

!!

"

为 输 出 层 各 神 经 元 的 网 络 输 出 ;B.

!*:3!

A5)

F$

F$

G 5&$D:3!

G 5)HAGHG.-

G 7 $

其 中 ,@A

为 输 入 层 各 神

A

经 元 的 网 络 输 入 ;!@

层 各 神 经 元 的 总 输 入 ;HAG

个 神 经 元 的 连 接 权 重 ;HG.

个神经元的连接权重;EF$

EB

数。

为 输 出 层 各 神 经 元 的 总 输 入 ;!

为 隐 含

F$

G

为 输 出 层 第 A 个 神 经 元 与 隐 含 层 第 G

为 隐 含 层 第 G 个 神 经 元 与 输 入 层 第 .

为隐含层神经元个数,.7$2!2I2 …2EB2

为 输 出 层 神 经 元 个

为输入层神 经 元 个 数 ;A77$2!2I2…2E@

,E@

个神经元的连接权重;EF$

经元个数。

与 EF!

分别为 第 $ 与 第 ! 隐 含 层 的 神

分析以上两式可以看出:

($)前 馈 网 络 的 导 数 计 算 公 式 明 显 具 有 递 推 性 ,因 此 容 易

递推出多隐含层网络的输出对输入的导数计算公式。

(!)在 神 经 网 络 的 导 数 计 算 公 式 中 包 含 有 权 值 的 乘 积 项 ,

并且隐含层数越多,权值乘积的阶数就越高。因此,权值的变化

对导数的影响将比对输出值的影响大。在面向关系辨识的网络

训练中应限制网络权值的不必要变化。

!#I 决策树的构造算法

基于神经网络的决策树构造过程与算法如下:

$#数据预处理。数据预处理主要涉及内容包括 数 据 筛 选 、

属性取值的离散化处理与编码、以及属性值与分类结果的量化

处理。在量化处理时,按某种顺序使属性与分类结果均在(",$)

范围内取值。从而形成神经网络训练的具体样本。从本质上讲,

在面向决策树构造的神经网络训练中,其训练的主要目的旨在

辨识各属性对分类结果的决定强度的顺序,而不强调输出数据

的准确性。各属性对分类结果的决定强度的顺序就体现了网络

的 输 出 与 输 入 之 间 的 关 系 。 从 大 量 的 网 络 训 练 实 例 中 可 以 看

出:当样本数据愈多时,输出与输入之间的关系愈易辨识。因此

在学习速度允许的情况下,应适当取较多的训练样本。

!#神经网络训练。利用给定的样本对网络进行训练。在网

络的训练中,只要各属性对分类结果的决定强度的顺序稳定,

就可以认为网络训练已完成。

I#建树算法。算法的核心是选取决定强度最大的属性作为

扩展属性。具体算法如下:

($)对当前例子集合,选择决定强度最大的属性 ’. 作为扩

展属性。

(!)把 在 ’. 处 取 值 相 同 的 例 子 归 于 同 一 子 集 ,’. 取 几 个

值就得几个子集。

(I)对包含不同类的子集,若分类精度低于预定精度,递归

调用建树算法;

(C)若子集为同一种类,对应分枝标上具体种类,返回调用

处。

I 关系强化约束定义与建模

对于用于决策树构造的网络训练,网络训练的目的旨在根

据具体训练数据集,建立一种能准确体现各属性与分类结果之

间关系的具体网络模型。目前的神经网络训练方法主要是通过

使网络的输出误差逐步减少而实现网络的训练。因此在这些训

练方法中,建立输入与输出数值上的正确对应是直接性的,而

建立输入与输出正确的关系是间接性的。结果会造成输出的误

同 样 ,对 于 两 隐 含 层 前 馈 网 络 ,可 以 推 出 网 络 输 出 对 网 络

差很 小 ,但 是 输 入 与 输 出 关 系 (例 如 导 数 关 系 )的 误 差 却 很 大 。

输入的偏导数的通用计算公式如下

基于这些情况,为了提高网络辨识输入与输出关系的效率,并

EF$

便于这些关系的分析与利用,就应在网络训练的误差计算中引

#@A

#B.

7 ?

!I

"

:3!@

A5&$D:3!@

!*:3!

A5)

F!

F!

J 5&$D:3!

J 5)HAJ

EF!

J 7 $

!:3!

F$

G 5

G 7 $

&$D:3!

F$

G 5)HJGHG.-

F!

与 !

F$

G

J

其中,!

分别为第 $ 与 第 ! 隐 含 层 各 神 经 元 的 总 输

为输出层第 A 个神经元与第 ! 隐含层第 J 个神经元的连

为第 ! 隐含层第 J 个神经元与第 $ 隐含层第 G 个神

为 第 $ 隐 含 层 第 G 个 神 经 元 与 输 入 层 第 .

入;HAJ

接权重;HJG

经 元 的 连 接 权 重 ;HG.

CC

!"""#$" 计算机工程与应用

入相应的约束。这些约束就是网络训练的关系强化约束。这些

关系约束的主要作用是提高网络训练的关系学习能力。

根据关系强化约束的性质,这些约束基本上属于诱导型约

束。因此约束的引入可采用如下的引入方式,即

K(1)7L315;

!H.M.

(1)

.

其 中 ,1 为 基 于 具 体 网 络 结 构 的 训 练 解 ;L(1)为 网 络 的 输

�

出误 差 ;%&(’)为 第 & 个 关 系 强 化 约 束 的 约 束 误 差 ;(&

为 第 & 个

关系强化约束的诱导权重,其值取决于该关系强化约束的重要

程 度 以 及 )(’)与 %&(’)的 数 量 差 别 ;*(’)为 网 络 训 练 的 总 误

差。

根据决策树构造过程的具体需要,一般需要引入以下两种

关系强化约束:

($)权值限制约束。从神经网络的偏导数计算公式中可以

看出,在这些计算公式中包含有权值的乘积项。为了限制权值

的 不 必 要 变 化 ,提 高 网 络 所 建 立 关 系 的 准 确 性 ,应 引 入 对 权 值

变化的限制约束。具体约束模型如下

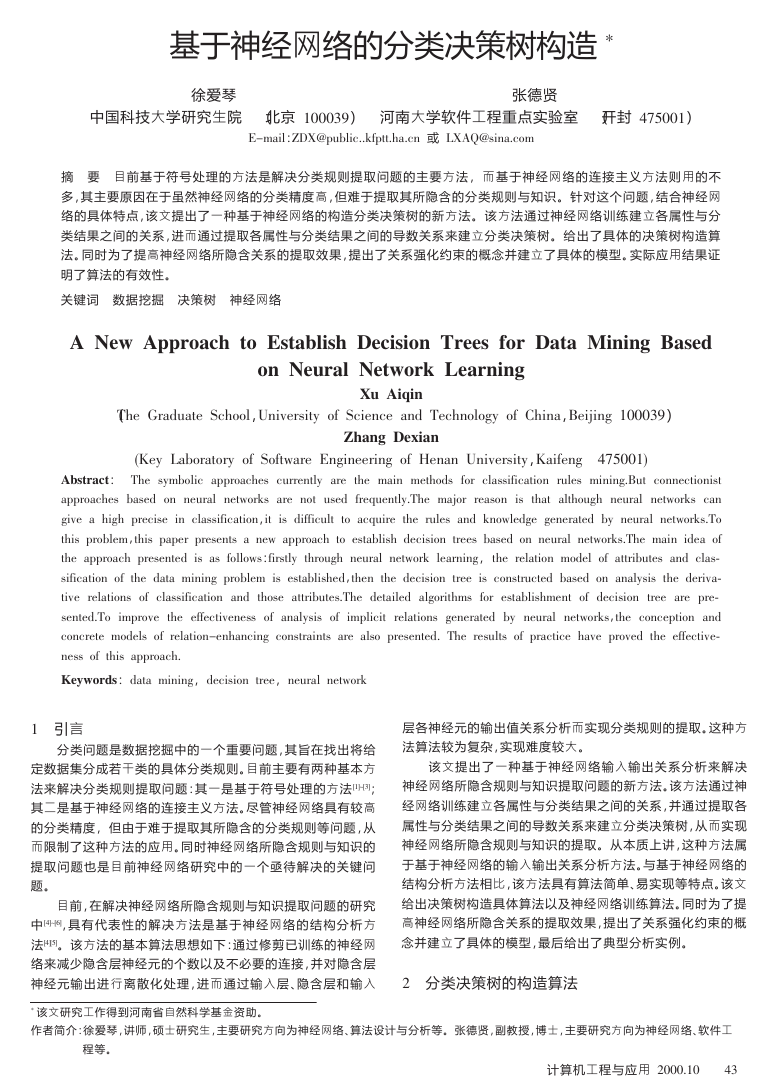

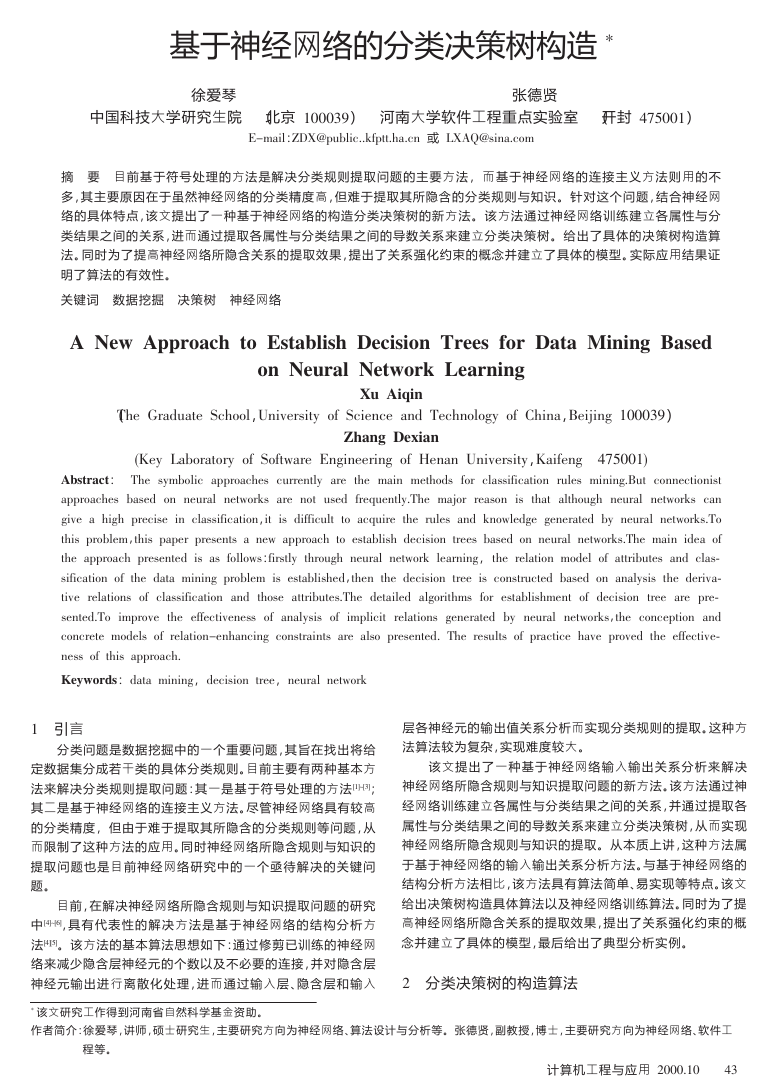

导数关系如图 $ 所示。在这种情况下,无用属性 ?)2A)BC?>B) 的

导数波动仍较大,各有用属性的导数变化不均匀。因此所表现

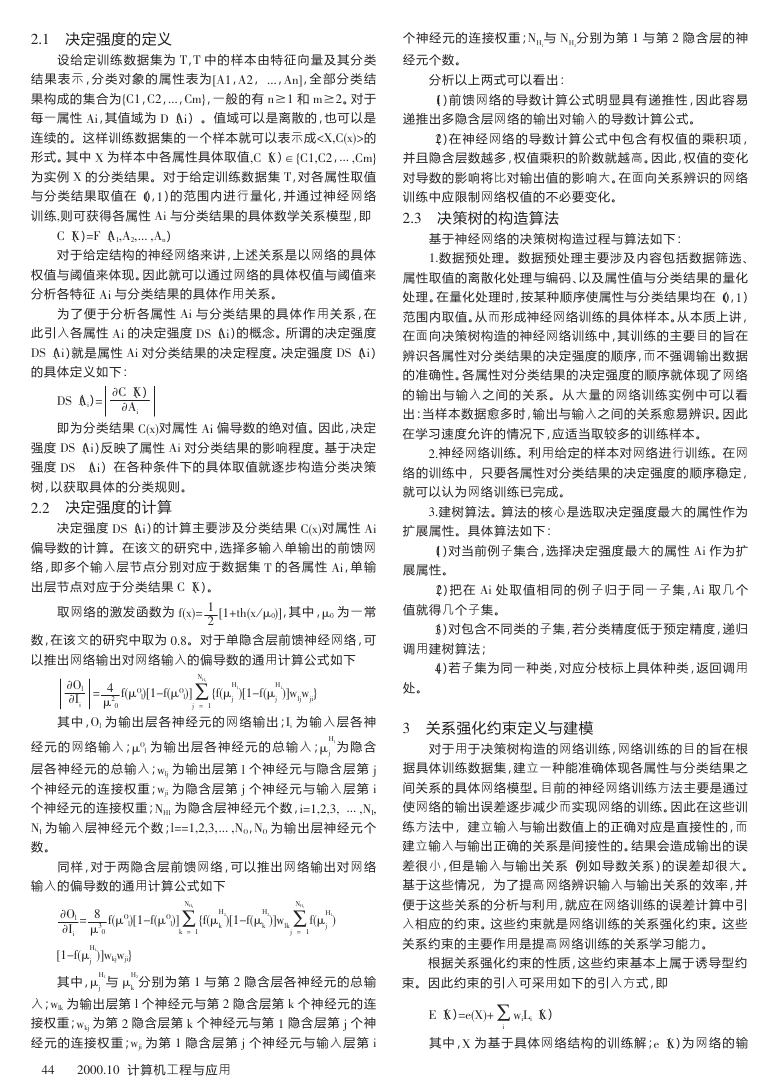

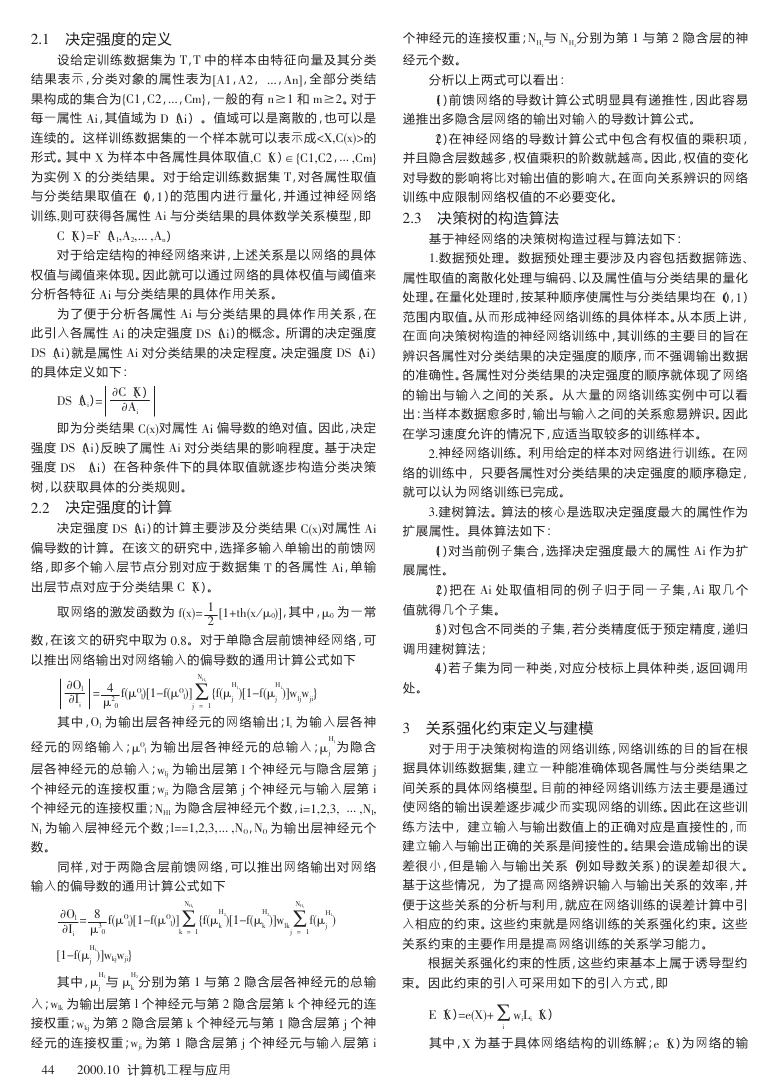

的关系不够清晰。图 !RS 为利用关系强化约束对网络进行训练

时所获得的结果。其中权值限制约束的加权系数为 "#""M,导数

关系限制约束的加权系数为 "#"M。在这种情况下,减少了无用

属性 ?)2A)BC?>B) 的导数波动量,并使各有用属性的导数变化

均匀。因而使建立决策树所需的各种关系变得更加清晰。

%(+’,-

!.(&+’,.

&

其 中 ,%(+’,为 权 值 约 束 误 差 ;(&+’,为 网 络 的 所 有 连 接 权

重。

(!)导数关系限制约束。该约束的主要作用为尽可能减小

各属性导数值的不必要变化。即尽可能减小对分类结果影响小

属性的导数值变化。同时也尽可能使各有用属性导数值均匀单

调变化,以便进行各属性对分类结果作用强度的综合比较。该

约 束 实 现 的 一 种 简 单 方 法 是 要 求 输 出 层 第 / 个 神 经 元 对 输 入

层第 & 个神经元的偏导数为线性关系,这是一种对导数关 系 的

较弱限制。该约束模型可通过如下方式建立:先求出偏导数与

输入层相应神经输入的线性回归曲线,约束误差可利用在各样

本点处的回归曲线的计算值与相应的偏导数值之差来表示,即

图 $ 各属性与分类结果的导数关系(无关系强化约束)

(’)-

%0

!3456+%&,27+ !8/

!%&

2 - $

1

(’)

(’),29!

其中,+ !8/

!%&

(’)

(’),2 为第 2 个样本点处输出层第 / 个神经元

对输入层第 & 个神经元的偏导数值;4 与 6 为偏导数与输入 层

第 & 个 神 经 元 输 入 的 线 性 回 归 常 数 ;+%&,2 为 输 入 层 第 & 个 神 经

元第 2 个样本点处的输入值。

: 算法试验与分析

为 了 便 于 说 明 ,下 面 采 用 一 个 关 于 气 候 的 典 型 实 例 3;9来 进

行 试 验 与 分 析 。 其 分 类 对 象 的 属 性 表 为<=>?/==@,?)2A)BC?>B),

D>2&E&?F,G&HEFI。各属性的值域为:0(=>?/==@)-HHF,=K)BLCJ?,

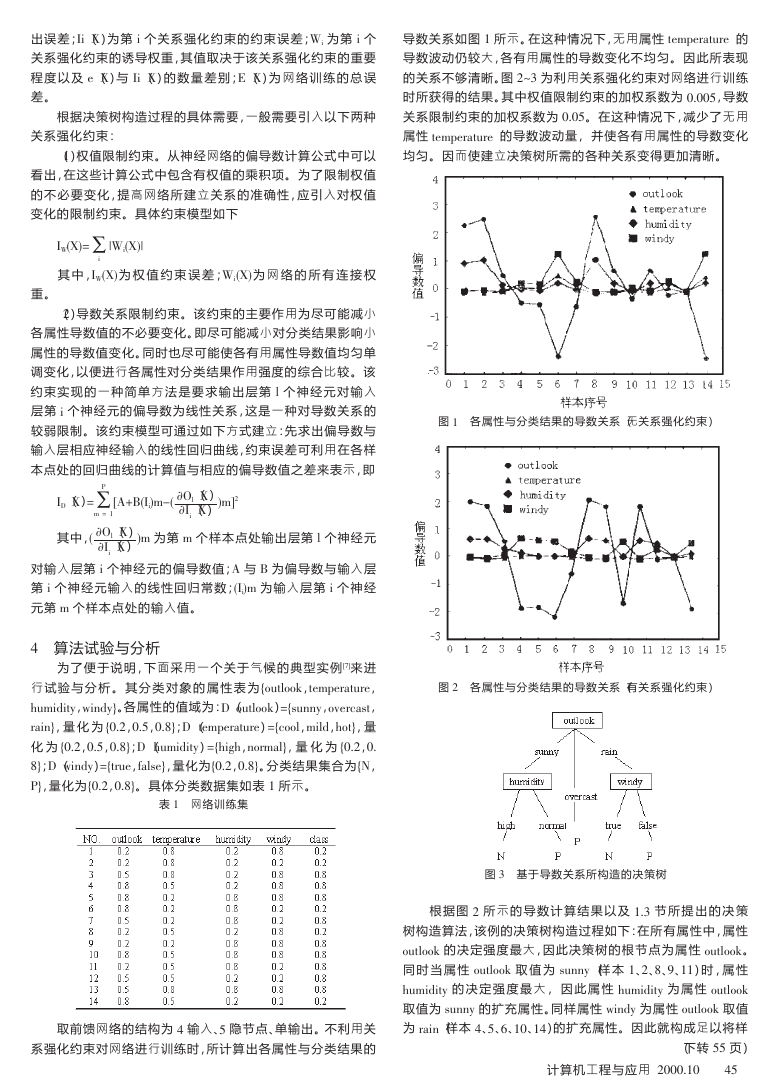

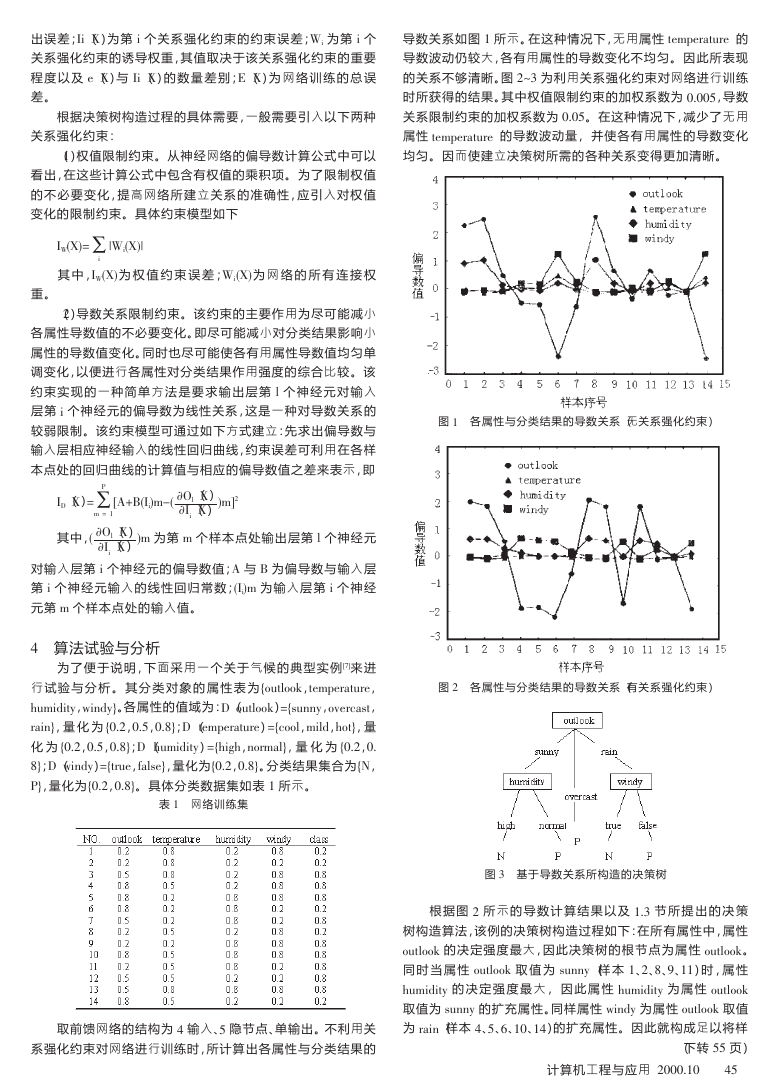

BC&HI,量 化 为 <"#!,"#M,"#NI;0 (?)2A)BC?>B))-2&E&?F)-),PC/J)I,量化为<"#!,"#NI。分类结果集合为?/==@ 的决定强度最大,因此决策树 的 根 节 点 为 属 性 =>?/==@。

同 时 当 属 性 =>?/==@ 取 值 为 J>HHF(样 本 $、!、N、T、$$)时 ,属 性

D>2&E&?F 的 决 定 强 度 最 大 , 因 此 属 性 D>2&E&?F 为 属 性 =>?/==@

取值为 J>HHF 的扩充属性。同样属性 G&HEF 为属性 =>?/==@ 取值

为 BC&H(样本 :、M、U、$"、$:)的扩充属性。因此就构成足以将样

(下转 MM 页)

计算机工程与应用 !"""#$"

:M

�

%#! 影响域与 5.I8 的联系

BRS] M*+7/62I18 ^ E8,

一 个 影 响 域 相 当 于 一 个 映 射 函 数 ,将 (5.I8,测 度 )映 射 为

可信度的线形测度。

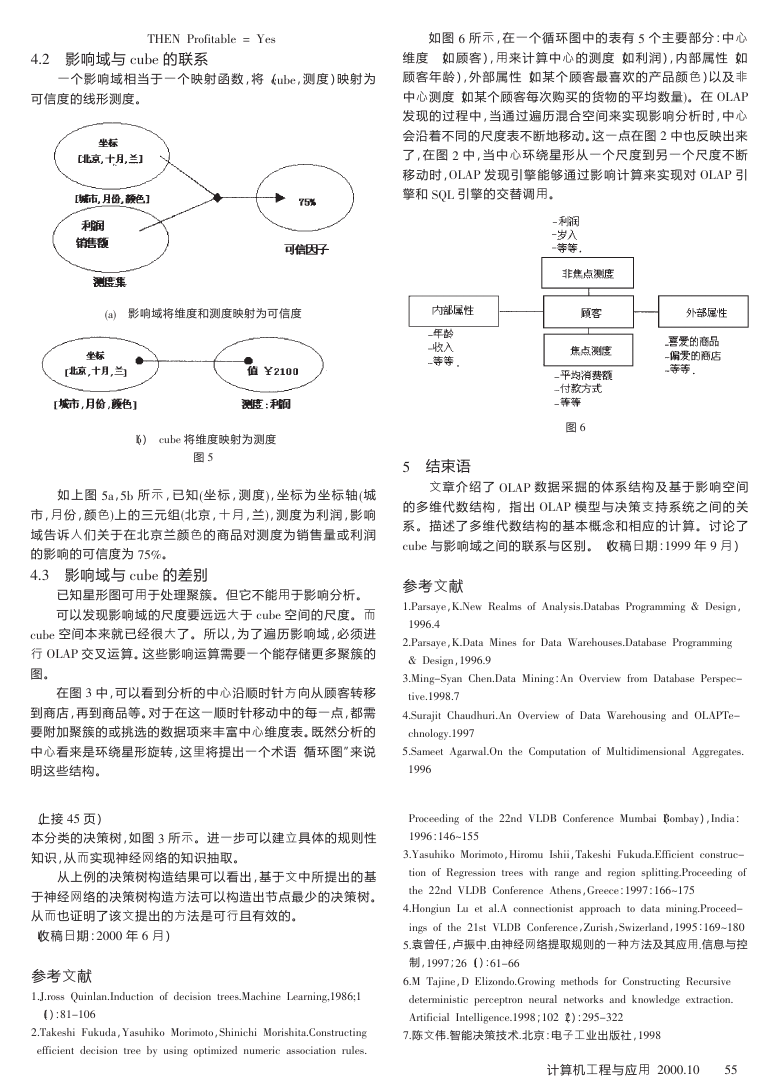

如 图 ( 所 示 ,在 一 个 循 环 图 中 的 表 有 & 个 主 要 部 分 :中 心

维度 (如 顾 客 ),用 来 计 算 中 心 的 测 度 (如 利 润 ),内 部 属 性 (如

顾客 年 龄 ),外 部 属 性 (如 某 个 顾 客 最 喜 欢 的 产 品 颜 色 )以 及 非

中心测度(如某个顾客每次购买的货物的平均数量‘。在 b;VM

发现 的 过 程 中 ,当 通 过 遍 历 混 合 空 间 来 实 现 影 响 分 析 时 ,中 心

会沿着不同的尺度表不断地移动。这一点在图 ! 中也反映出来

了,在 图 ! 中 ,当 中 心 环 绕 星 形 从 一 个 尺 度 到 另 一 个 尺 度 不 断

移 动 时 ,b;VM 发 现 引 擎 能 够 通 过 影 响 计 算 来 实 现 对 b;VM 引

擎和 G-; 引擎的交替调用。

_2‘ 影响域将维度和测度映射为可信度

(I) 5.I8 将维度映射为测度

图 &

如 上 图 &2,&I 所 示 ,已 知 _坐 标 ,测 度 ‘,坐 标 为 坐 标 轴 _城

市 ,月 份 ,颜 色‘上 的 三 元 组_北 京 ,十 月 ,兰‘,测 度 为 利 润 ,影 响

域 告 诉 人 们 关 于 在 北 京 兰 颜 色 的 商 品 对 测 度 为 销 售 量 或 利 润

的影响的可信度为 X&a。

%#’ 影响域与 5.I8 的差别

已知星形图可用于处理聚簇。但它不能用于影响分析。

可以发现影响域的尺度要远远大于 5.I8 空间的尺度。而

5.I8 空间本来就已经很大 了 。 所 以 ,为 了 遍 历 影 响 域 ,必 须 进

行 b;VM 交叉运算。这些影响运算需要一个能存储更多聚簇的

图。

在图 ’ 中,可以看到分析的中心沿顺时针方向从顾客转移

到商店,再到商品等。对于在这一顺时针移动中的每一点,都需

要附加聚簇的或挑选的数据项来丰富中心维度表。既然分析的

中心看来是环绕星形旋转,这里将提出一个术语“循环图”来说

图 (

& 结束语

文 章 介 绍 了 b;VM 数 据 采 掘 的 体 系 结 构 及 基 于 影 响 空 间

的 多 维 代 数 结 构 , 指 出 b;VM 模 型 与 决 策 支 持 系 统 之 间 的 关

系 。 描 述 了 多 维 代 数 结 构 的 基 本 概 念 和 相 应 的 计 算 。 讨 论 了

5.I8 与影响域之间的联系与区别。(收稿日期:$>>> 年 > 月)

参考文献

$#M2*,2J8,c#]8U T821F, +7 V021J,/,#O262I2, M*+<*2FF/0< d O8,/<0,

$>>(#%

!#M2*,2J8,c#O262 9/08, 7+* O262 e2*8:+.,8,#O262I2,8 M*+<*2FF/0<

d O8,/<0,$>>(#>

’#9/0

>?#X

%#G.*2Z/6 H:2.4:.*/#V0 b[8*[/8U +7 O262 e2*8:+.,/0< 204 b;VMB8A

5:0+1+>X

&#G2F886 V<2*U21#b0 6:8 H+FK.626/+0 +7 9.16/4/F80,/+021 V<<*8<268,#

明这些结构。

$>>(

(上接 %& 页)

本分类的决策树,如图 ’ 所示。进一步可以建立具体的规则性

知识,从而实现神经网络的知识抽取。

从上例的决策树构造结果可以看出,基于文中所提出的基

于神经网络的决策树构造方法可以构造出节点最少的决策树。

从而也证明了该文提出的方法是可行且有效的。

(收稿日期:!""" 年 ( 月)

参考文献

$#)#*+,, -./0120#304.56/+0 +7 485/,/+0 6*88,#925:/08 ;82*0/0<=$>?(@$

($):?$A$"(

!#B2C8,:/ D.C.42,E2,.:/C+ 9+*/F+6+,G:/0/5:/ 9+*/,:/62#H+0,6*.56/0<

877/5/806 485/,/+0 6*88 IJ .,/0< +K6/F/L84 0.F8*/5 2,,+5/26/+0 *.18,#

M*+5884/0< +7 6:8 !!04 N;OP H+078*8058 9.FI2/(P+FI2J),304/2:

$>>(:$%(Q$&&

’#E2,.:/C+ 9+*/F+6+,R/*+F. 3,://,B2C8,:/ D.C.42#S77/5/806 5+0,6*.5A

6/+0 +7 T8<*8,,/+0 6*88, U/6: *20<8 204 *8>X:$((Q$X&

%#R+0>&:$(>Q$?"

&#袁曾任,卢振中#由神经网络提取规则的一种方法及其应用#信息与控

制,$>>X;!(($):($A((

(#9 B2Z/08,O S1/L+04+#W*+U/0< F86:+4, 7+* H+0,6*.56/0< T85.*,/[8

4868*F/0/,6/5 K8*58K6*+0 08.*21 086U+*C, 204 C0+U184<8 8\6*256/+0#

V*6/7/5/21 306811/<8058#$>>?;$"!(!):!>&A’!!

X#陈文伟#智能决策技术#北京:电子工业出版社,$>>?

计算机工程与应用 !"""#$"

&&

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc