Webmagic 深度加载

前言:网上参考了大量的 webmagic 深度的例子都不太好用,所以自己整理了一下,直接切

入主题吧。(思路+主要代码)

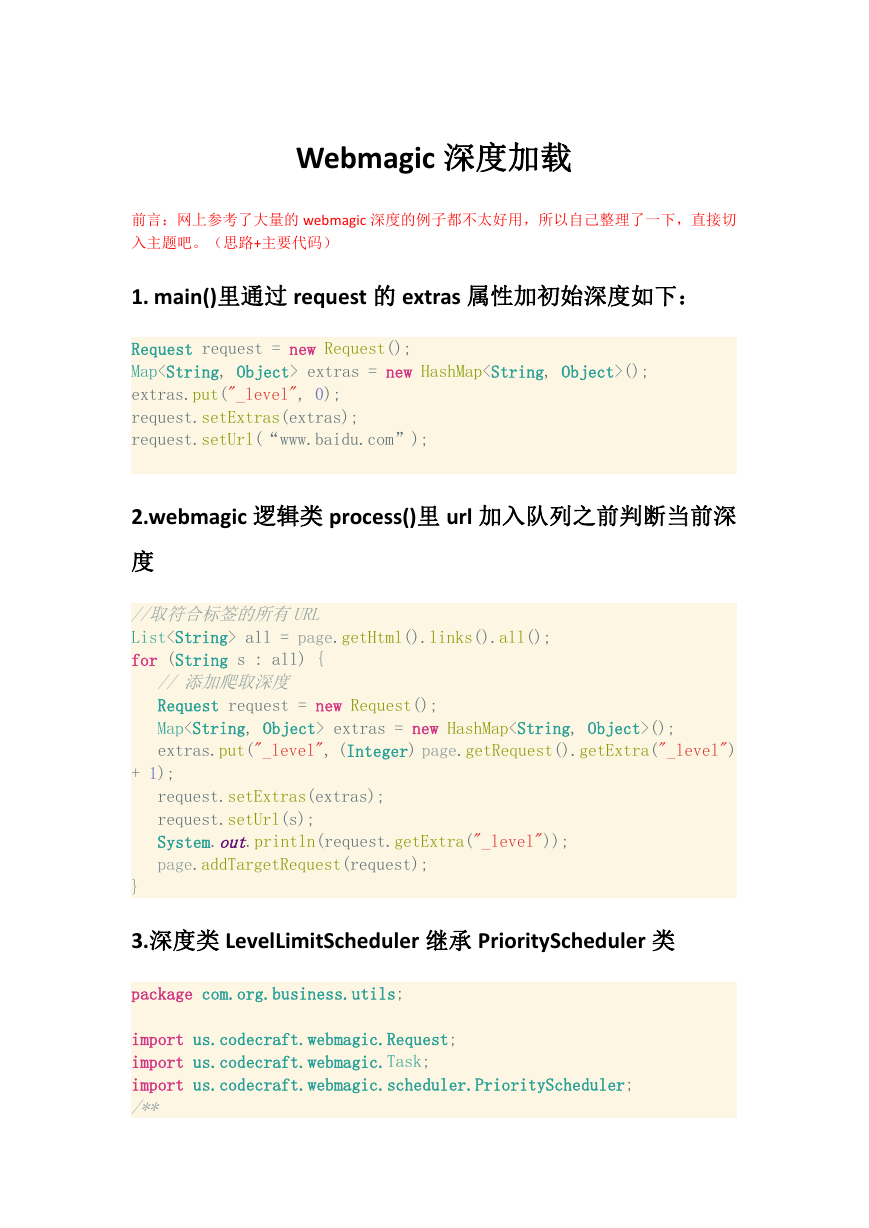

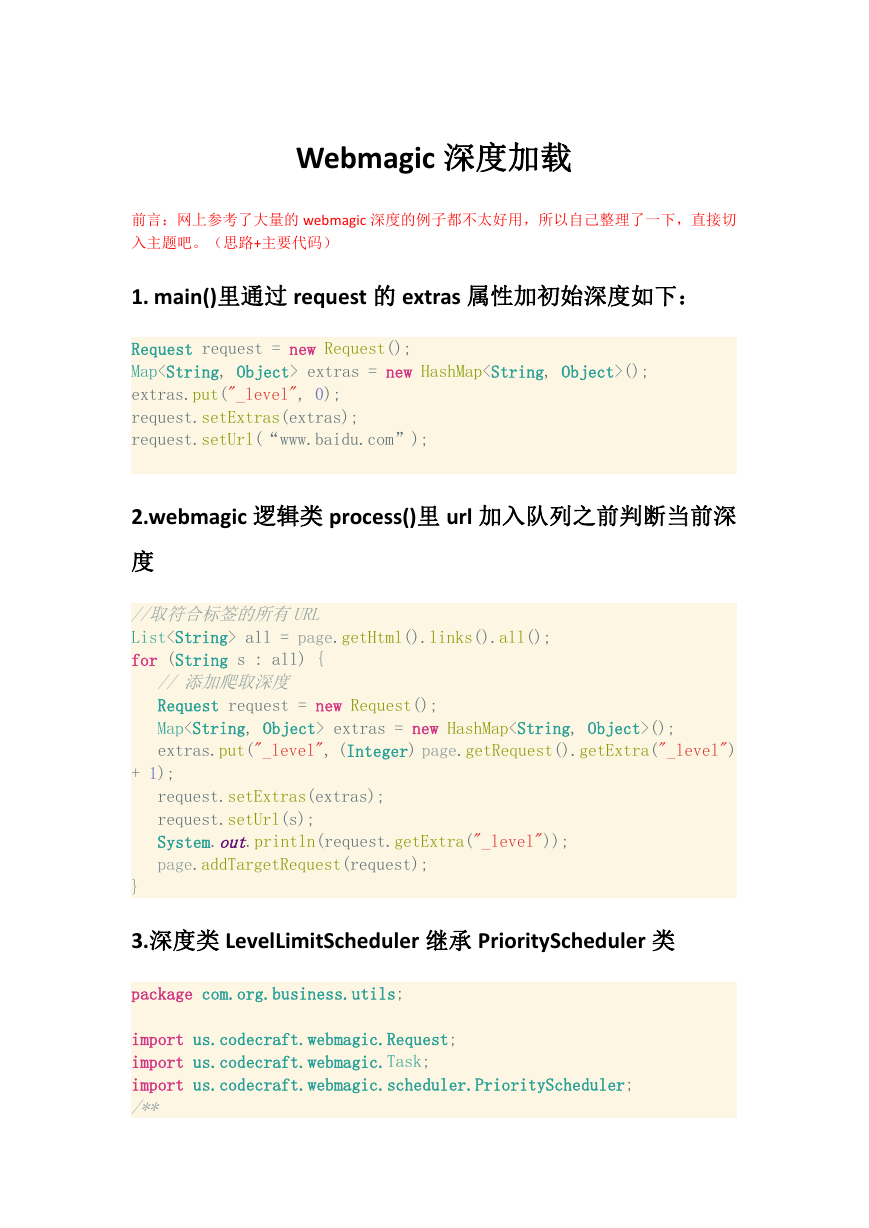

1. main()里通过 request 的 extras 属性加初始深度如下:

Request request = new Request();

Map extras = new HashMap();

extras.put("_level", 0);

request.setExtras(extras);

request.setUrl(“www.baidu.com”);

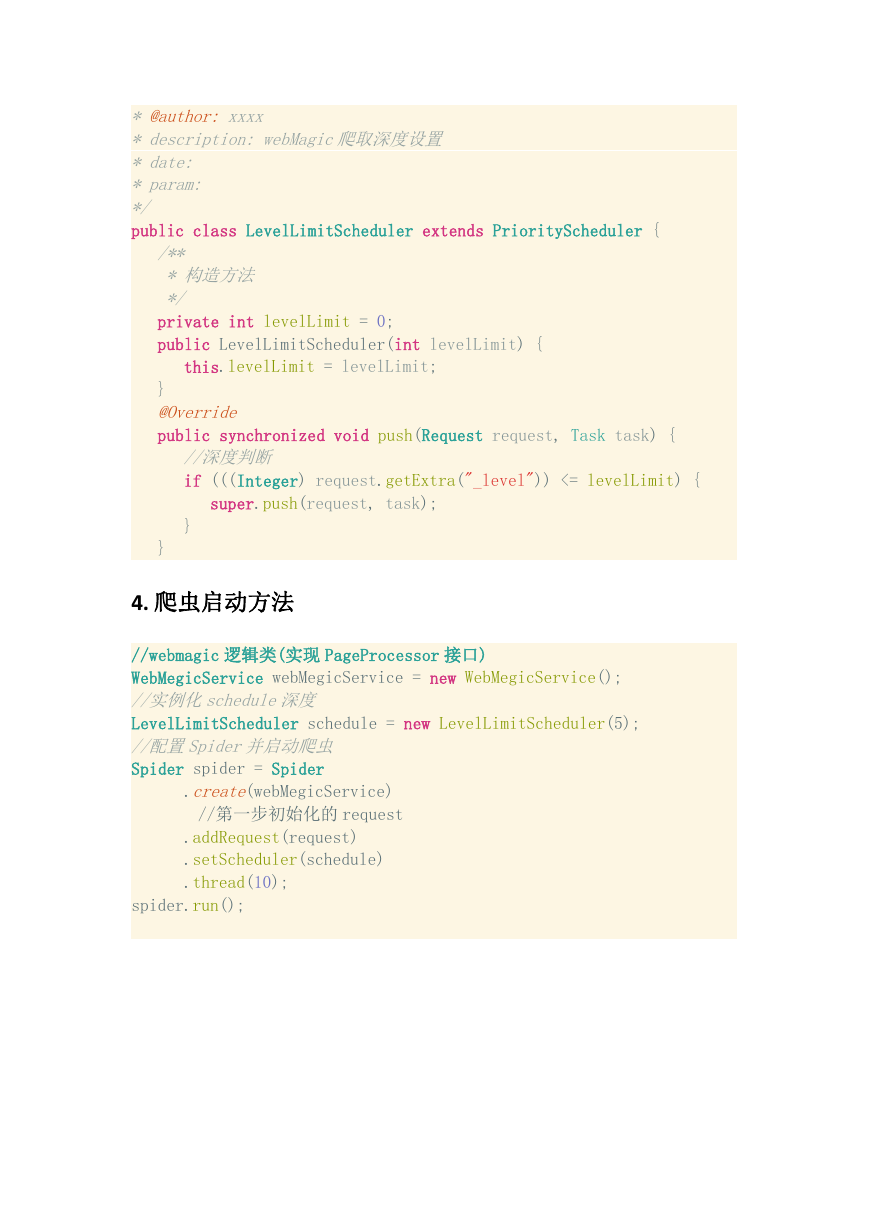

2.webmagic 逻辑类 process()里 url 加入队列之前判断当前深

度

//取符合标签的所有URL

List all = page.getHtml().links().all();

for (String s : all) {

// 添加爬取深度

Request request = new Request();

Map extras = new HashMap();

extras.put("_level", (Integer) page.getRequest().getExtra("_level")

+ 1);

request.setExtras(extras);

request.setUrl(s);

System.out.println(request.getExtra("_level"));

page.addTargetRequest(request);

}

3.深度类 LevelLimitScheduler 继承 PriorityScheduler 类

package com.org.business.utils;

import us.codecraft.webmagic.Request;

import us.codecraft.webmagic.Task;

import us.codecraft.webmagic.scheduler.PriorityScheduler;

/**

�

* @author: xxxx

* description: webMagic爬取深度设置

* date:

* param:

*/

public class LevelLimitScheduler extends PriorityScheduler {

/**

* 构造方法

*/

private int levelLimit = 0;

public LevelLimitScheduler(int levelLimit) {

this.levelLimit = levelLimit;

}

@Override

public synchronized void push(Request request, Task task) {

//深度判断

if (((Integer) request.getExtra("_level")) <= levelLimit) {

super.push(request, task);

}

}

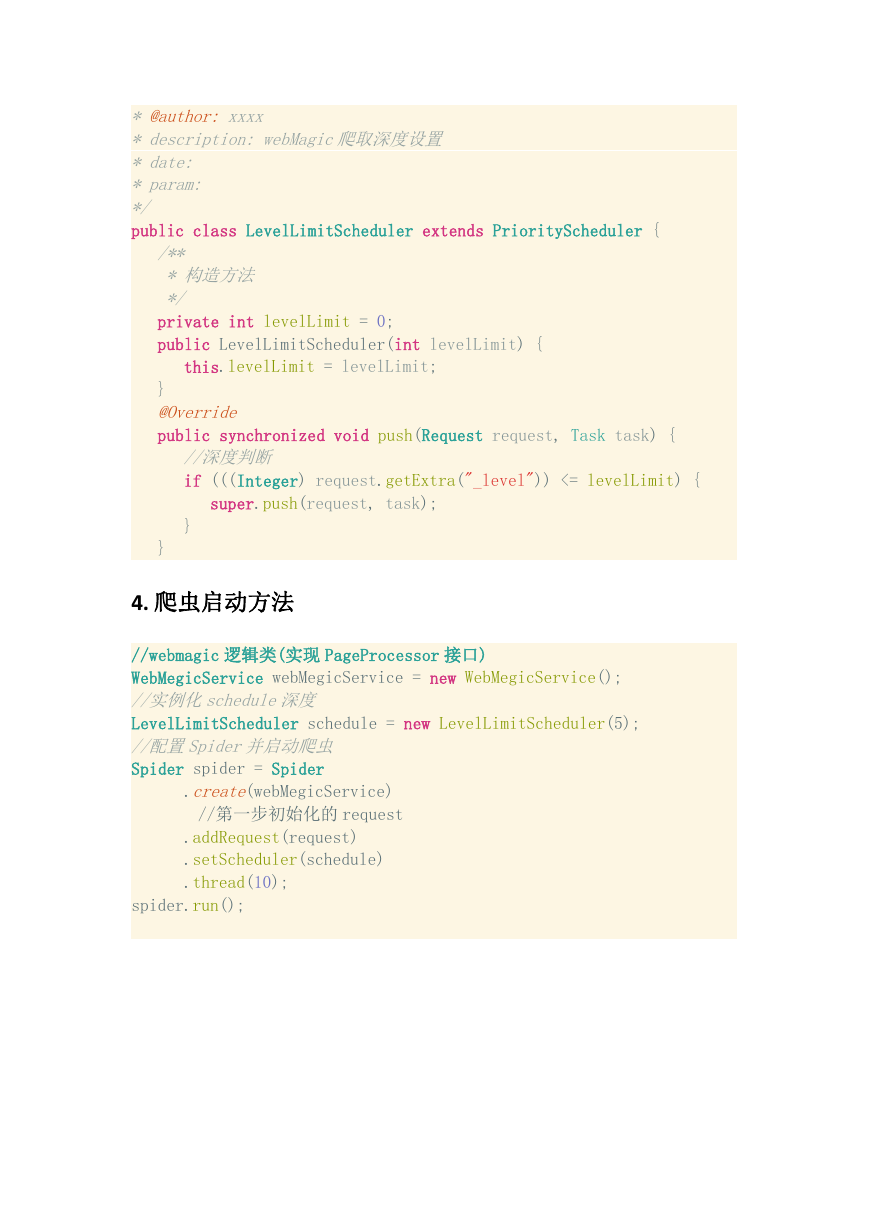

4. 爬虫启动方法

//webmagic 逻辑类(实现 PageProcessor 接口)

WebMegicService webMegicService = new WebMegicService();

//实例化schedule深度

LevelLimitScheduler schedule = new LevelLimitScheduler(5);

//配置Spider并启动爬虫

Spider spider = Spider

.create(webMegicService)

//第一步初始化的 request

.addRequest(request)

.setScheduler(schedule)

.thread(10);

spider.run();

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc