计算机科学与探索

Journal of Frontiers of Computer Science and Technology

1673-9418/2019/13(12)-2149-12

doi: 10.3778/j.issn.1673-9418.1811031

PCANet 下的遮挡定位人脸识别算法*

郭 伟,白文硕+,曲海成

辽宁工程技术大学 软件学院,辽宁 葫芦岛 125000

+ 通讯作者 E-mail: 1179133483@qq.com

摘 要:自然环境中的人脸图像大部分带有遮挡,这对于人脸识别一直是巨大的挑战,用于人脸识别的主流深

度模型对于遮挡人脸图片并不具有特别好的识别性能。针对深度模型由于遮挡的存在以及遮挡位置不确定

所导致的识别率下降的问题,提出一种结合深度学习和特征点遮挡检测的 PCANet 下的遮挡定位人脸识别算

法。分类器用于关键点检测,使用 PCANet 深度学习模型进行特征提取,形成支持向量机(SVM)训练模型组。

遮挡判别分类器定位遮挡,结合特征模型组完成有遮挡人脸识别任务,并且对于表情变化有很强的鲁棒性。

实验结果表明,该算法对于常见遮挡类型取得了非常好的效果,对于大面积遮挡的极端类型也具有很高的识

别率。

关键词:深度学习;关键点;遮挡判别;模型组;人脸识别

文献标志码:A 中图分类号:TP391

郭伟, 白文硕, 曲海成. PCANet 下的遮挡定位人脸识别算法[J]. 计算机科学与探索, 2019, 13(12): 2149-2160.

GUO W, BAI W S, QU H C. Face recognition algorithm of occlusion location based on PCANet[J]. Journal of Frontiers

of Computer Science and Technology, 2019, 13(12): 2149-2160.

Face Recognition Algorithm of Occlusion Location Based on PCANet

*

GUO Wei, BAI Wenshuo+, QU Haicheng

College of Software, Liaoning Technical University, Huludao, Liaoning 125000, China

Abstract: Most face images taken from natural environment have occlusion, which has always been a huge challenge

for face recognition. The mainstream deep model used for face recognition does not have particularly good

identification performance for occlusion of face images. In order to solve the problem that the recognition rate

decreases because occlusion exists and the occlusion position is uncertain for deep model, this paper proposes a face

recognition algorithm of occlusion location based on PCANet (principal components analysis network), which

combines deep learning and feature point occlusion detection. Classifier is used for key point detection, and

PCANet deep learning model is used for feature extraction to form SVM (support vector machine) training model

* The National Natural Science Foundation of China under Grant No. 41701479 (国家自然科学基金青年基金项目); the Natural Science

Foundation of Liaoning Province under Grant No. 20180550529 (辽宁省自然科学基金).

Received 2018-11-21, Accepted 2019-01-14.

CNKI 网络出版: 2019-01-30, https://kns.cnki.net/KCMS/detail/11.5602.TP.20190129.1042.002.html

�

2150

Journal of Frontiers of Computer Science and Technology 计算机科学与探索

2019, 13(12)

group. The occlusion discrimination classifier locates occlusion, combines the group of feature model to complete

the occlusion face recognition task, and has strong robustness to facial expression changes. The experimental results

show that the algorithm has achieved very good results for common occlusion types, and the extreme types of large-

area occlusion also have a high recognition rate.

Key words: deep learning; key points; occlusion discrimination; group of model; face recognition

1 引言

人脸识别的众多先进算法大多都是基于实验环

境中,在可控的参数范围中进行一系列的研究,并且

取得了非常好的效果,但是真实环境中遮挡的存在

大大限制了人脸识别的精度,很多算法对于遮挡人

脸并不具有很高的识别率。遮挡主要分为物理遮

挡、光照遮挡、姿态遮挡等,由于人脸识别的大部分

算法都是基于特征描述,因此物理遮挡成为了识别

精度最大的挑战。要想使人脸识别技术在自然环境

下也具有很高的效率及准确率,遮挡问题的解决是

研究过程中不可避免的任务。

对于遮挡人脸的研究,国内外学者从未停止过

脚步,最早的 Oh 和 Lee 等人[1]利用改进局部特征的方

法将未遮挡区域形成新的投影空间,在此新的投影

空间上进行人脸识别,但是这种方法的人脸特征容

易随遮挡特征的舍弃而损失。而后,Wright 等人[2]提出

的基于稀疏表示的人脸识别方法(sparse representation-

based classifier,SRC)是非常具有代表性的子空间回

归方法。将稀疏表示应用于人脸识别,把不同人脸

的训练样本组合得到训练样本字典。而此训练样本

字典是稀疏的,通过求解稀疏表示,利用重构误差来

判别测试样本的类别,但是此算法对于特征并不敏

感,而是依赖于图像的维数。为此 Wright 等人进而提

出鲁棒的 SRC 模型(robust sparse representation-based

classifier,RSRC)[2],但是此类方法对于遮挡外的非人

脸因素影响很敏感,容易导致鲁棒分类器的混乱,引

起局部混叠。SRC 和 RSRC 都是建立在最小

ℓ1 范数

基础上,因此对于维数过高时计算会很困难。胡正

平等人[3]提出的 Gabor 特征集结合判别式字典学习的

稀疏表示图像识别将不同方向、不同角度的 Gabor,

通过降维增广 Gabor 特征矩阵,学习该字典构成新的

结构化字典,提高了对图像光照遮挡、表情遮挡的识

别率,但是对于图像含有过多噪声的情况算法性能

不太理想。Dai 等人[4]提出了结构化稀疏误差编码的

遮挡人脸识别算法,这类方法考虑了实际遮挡形状

结构信息,提高了算法对于遮挡的鲁棒性,但是不足

的是对于样本要求过高,要求训练字典中不能存在

遮挡,而现实中的大量遮挡人脸样本无法利用。对

于特征提取方面,主成分分析(principal components

analysis,PCA)对于人脸特征的表示和提取以及在人

脸复原方面有着很大的优势。Wei 等人[5]提出的基于

鲁棒主成分分析(PCA)给出了人脸图像训练字典的

学习方法,以及 Luan 等人[6]的研究完成了遮挡人脸的

复原,但是此类方法太过于依赖训练样本,过少的训

练样本将不能“稀释”图片的遮挡信息 [7]。近年来深

度学习的发展[8]使人脸识别算法有了突破性进展,具

有代表性的有 DeepID[9]、FaceNet[10]等。栗科峰等人[11]

的融合深度学习与最大间距准则的人脸识别方法使

用深度学习降低线性判别的误差,最大间距准则获

取更有代表性的高层特征描述,但是这种方法在小

范围特征变化能够取得很好效果,一旦特征变化范

围变大,算法并不能表现出很好的性能。很多学者

致力于将深度学习应用到人脸识别中[12-13],研究发现[7]

即使图像遮挡部分较多,使用深度学习浅层特征仍

然能够有着非常好的效果,然而在遮挡存在位置不

确定的情况下会严重影响算法性能,因此遮挡的存

在比遮挡特征干扰对于算法有着更严重的影响,计

算机视觉对遮挡的感知仍然是困难的,因此让深度

学习模型能够以某种方法确定遮挡位置,势必会提

高遮挡人脸的识别率。相比于传统算法,本文使用

了简洁高效的 PCANet 深度模型,PCANet 模型把卷

积核的获取方式从手工设置改为自主学习,使之卷

积之后即使只具有两层的简单结构,但是对于特征

的表达仍有着非常好的效果。与此同时,本文为深

�

郭 伟 等:PCANet 下的遮挡定位人脸识别算法

2151

度学习设计了遮挡存在判别,使深度模型提取特征

时减少了遮挡特征的干扰,以此中心思想设计的算

法能够有效提高遮挡人脸识别的准确率。

2 PCANet

随着人工神经网络的研究,深度学习的概念被

提了出来,而 Chan 等人[14]于 2015 年底提出的 PCANet

最重要的贡献就是将子空间回归引入深度学习,为

卷积神经网络卷积核的学习提供了新的思路,又将

卷积神经网络(convolutional neural networks,CNN)

的卷积层引入经典的“特征图(feature map)-模式图

(pattern map)- 柱 状 图(histogram)”的 特 征 提 取 框

架。本质上,PCANet 是一个基于 CNN 的简化 Deep

Learning 模型,具体结构如下。

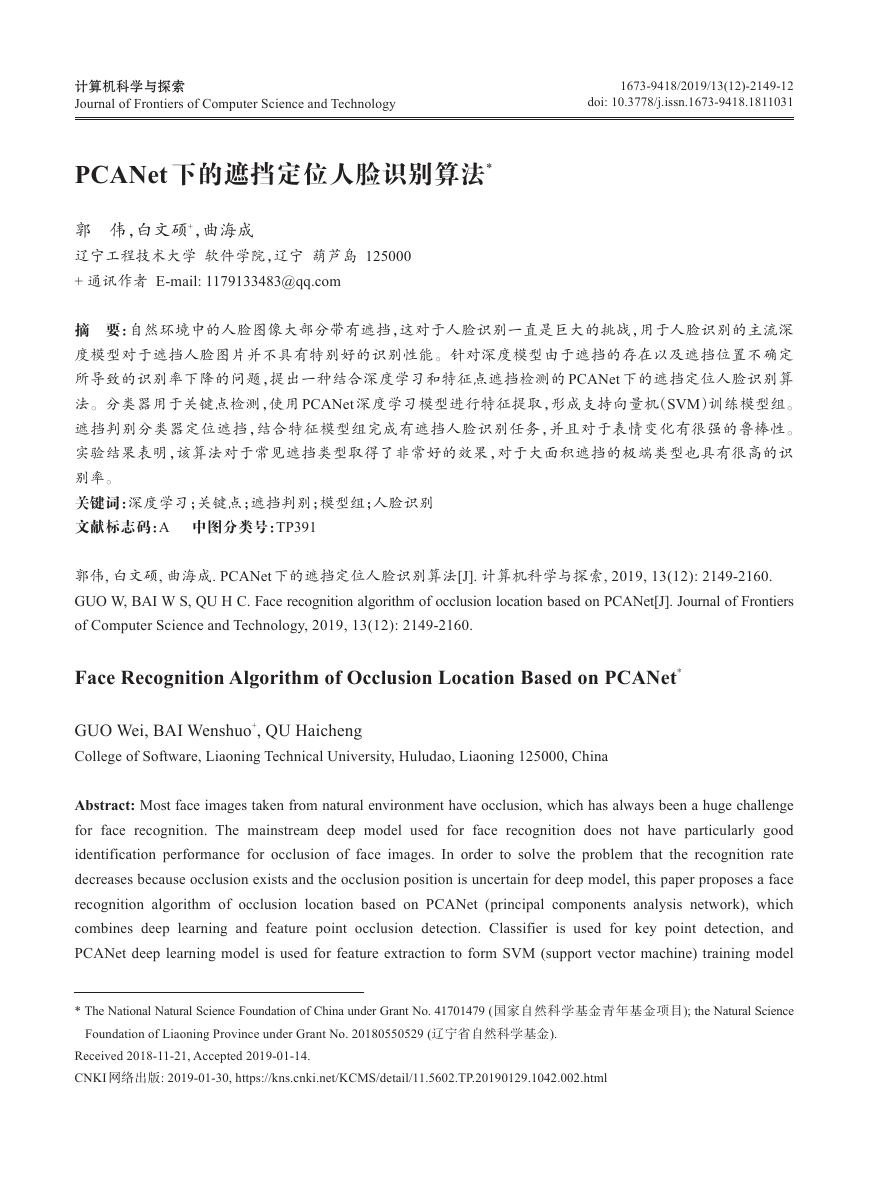

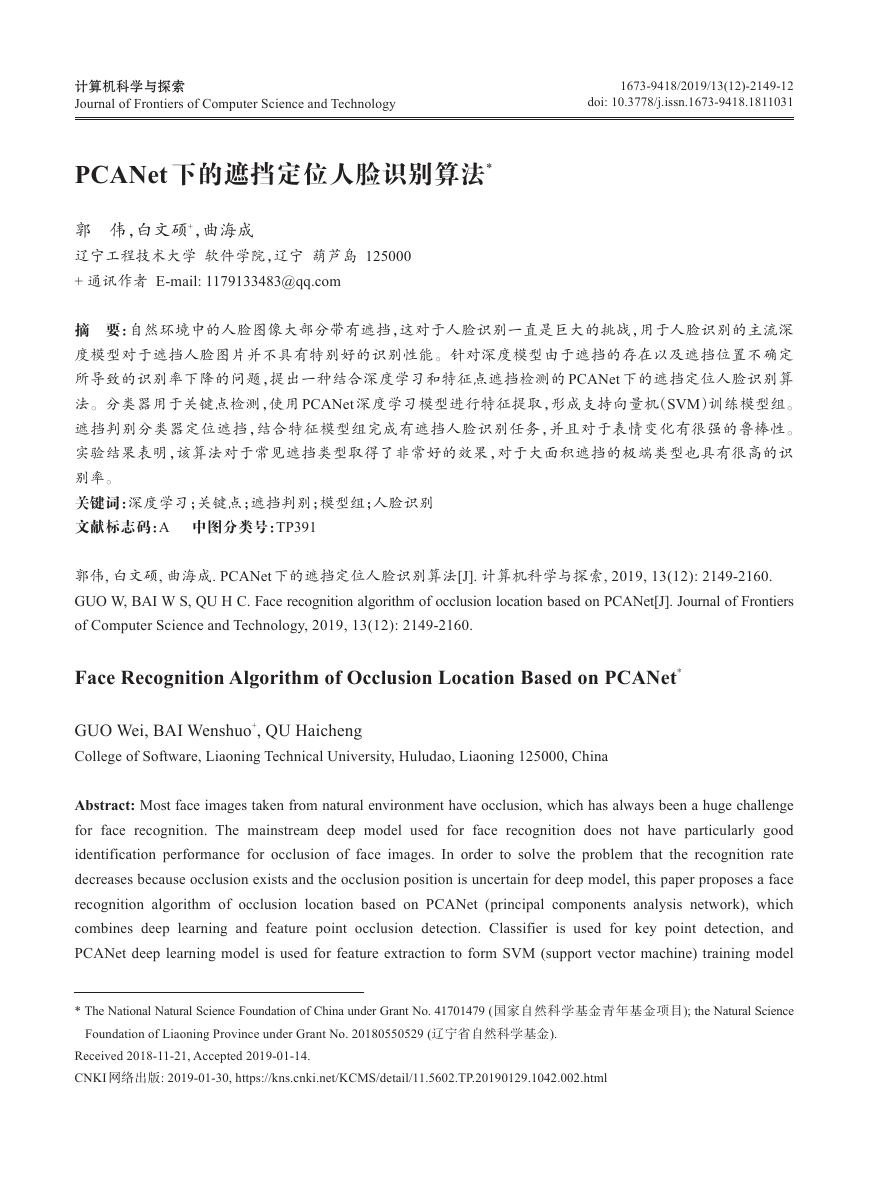

(1)第一层(PCANet),如图 1。

Fig.1 PCANet first layer structure

图 1 PCANet 第一层结构

×

对于图像的每个像素都用 k1

采样,然后级联表示第 i 张图片:

,1,

x

i

x

i

,2,…,

x

,

i

mn

∈R k1k2q

k2 的块采样进行

(1)

×

式(1)中,mn 为图像的高宽数值,采样过后就变成了

ˉ

=[

ˉ

k2 大小的 Patch,将这些 Patch 去平均:

mn 个 k1

x

,2,…,

,1,

ˉ

ˉ

]

(2)

X

x

x

,

i

i

i

i

mn

N 张图片进行以上操作就得到了矩阵 Χ :

式(2)处理完了单张图片的特征提取,将训练集

=[

]∈R k1k2

ˉ

ˉ

Nmn

×

ˉ

1,

X

2,…,

X

(3)

X

X

N

式(3)中,每列代表一个 Patch,一共有 Nmn 列。

对 这 个 矩 阵 Χ 进 行 PCA,假 设 滤 波 器 的 数 量 为 L1

个,寻找列的标准正交矩阵来最小化重构误差。

T

2

F

VV

||X

T

-

=

min

s.t.

∈R k1k2 ×

V

V

所对应的滤波器如式(5),输出图像如图 2。

X||

V

I

L1

L1

(4)

=

1

l

W

(

q

(

l

XX

T))∈R k1,

k2,

l

mat

k1,

k2

=1,2,…,

L1

(5)

Fig.2 PCANet first layer image

图 2 PCANet 第一层图像

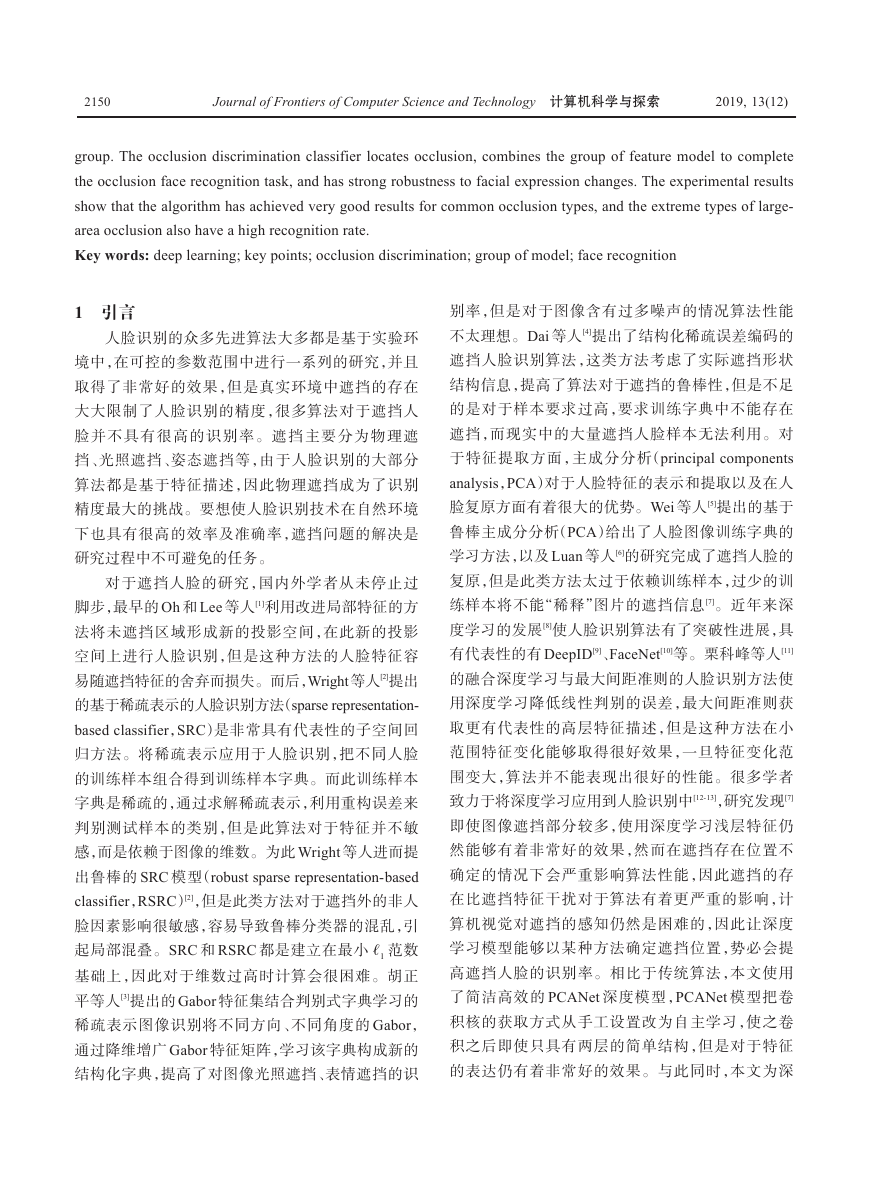

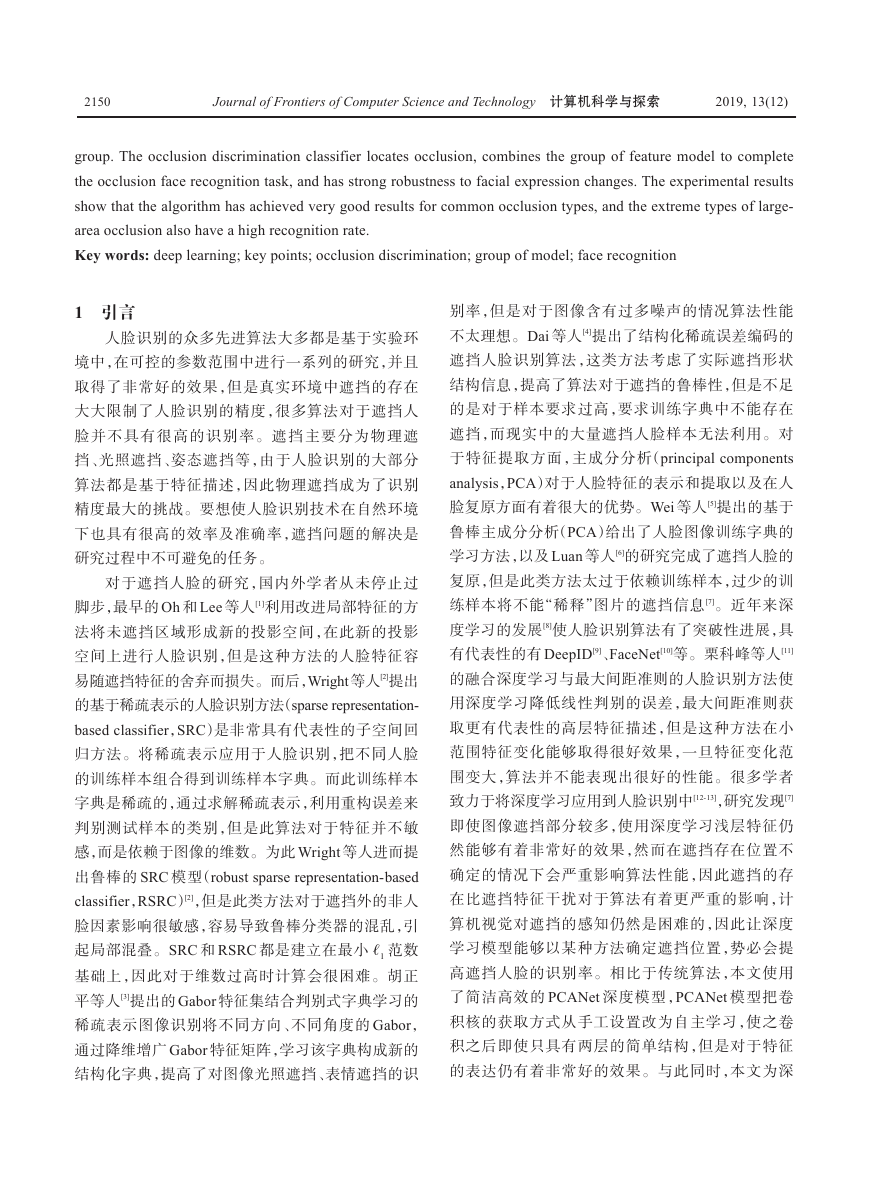

(2)第二层(PCANet),如图 3。

Fig.3 PCANet second layer structure

图 3 PCANet 第二层结构

=1,2,…,

,

1

=

首先计算第一层的 PCA 映射输出:

*

l

i

i

N

I

W

I l

i

需要注意的是在此需要进行边缘补零操作,以

保证映射结果与原图像大小相同。下面的操作与第

一层相同,都是对输入矩阵进行采样、级联、去平均,

只不过这里的输入矩阵是第一层的映射输出,如式(7)。

(6)

ˉ

Y

Y

=[

=[

ˉ

,

1,

y

i

l

i

Y

=

2

l

W

]∈R k1k2 ×

L1Nmn

l

Y

i

l

l

i

,

,

y

y

ˉ

,2,…,

,1,

ˉ

,

2,…,

Y L1]∈R k1k2 ×

k2,

T))∈R k1×

(

(

mn

mat

q

l

k1k2

YY

所对应的第二层滤波器:

mn

(7)

=1,2,…,

l

L2

(8)

第一层具有 L1 个滤波器,产生 L1 个特征输出矩

阵,第二层针对第一层的每个特征输出都会产生 L2

个特征输出矩阵,因此两层的 PCANet 最终对于每一

个样本,会产生 L1

L2 的特征输出矩阵如式(9),输出

*

图像如图 4。

={

×

}L2

2

=1

l

l

Ol

i

I l

i

W

(9)

�

2152

Journal of Frontiers of Computer Science and Technology 计算机科学与探索

2019, 13(12)

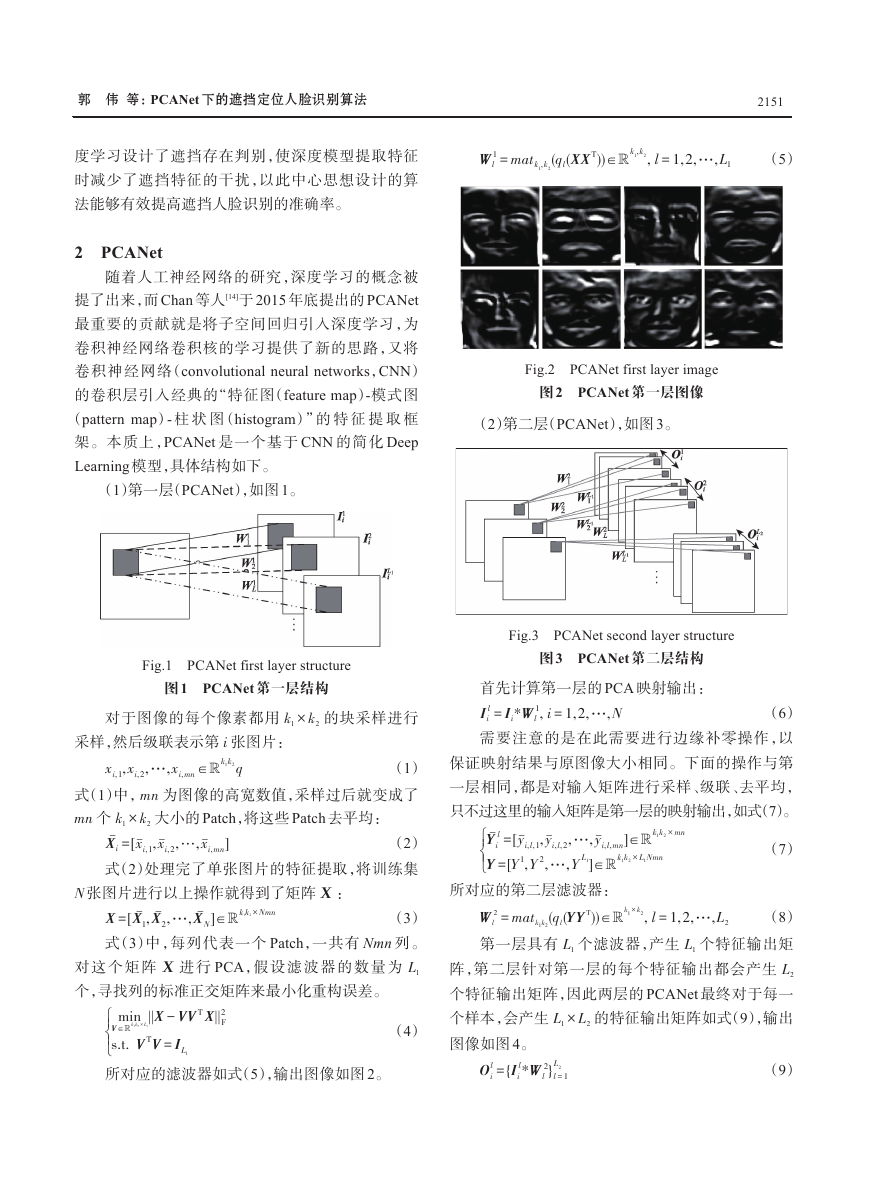

Fig.4 PCANet second layer image

图 4 PCANet 第二层图像

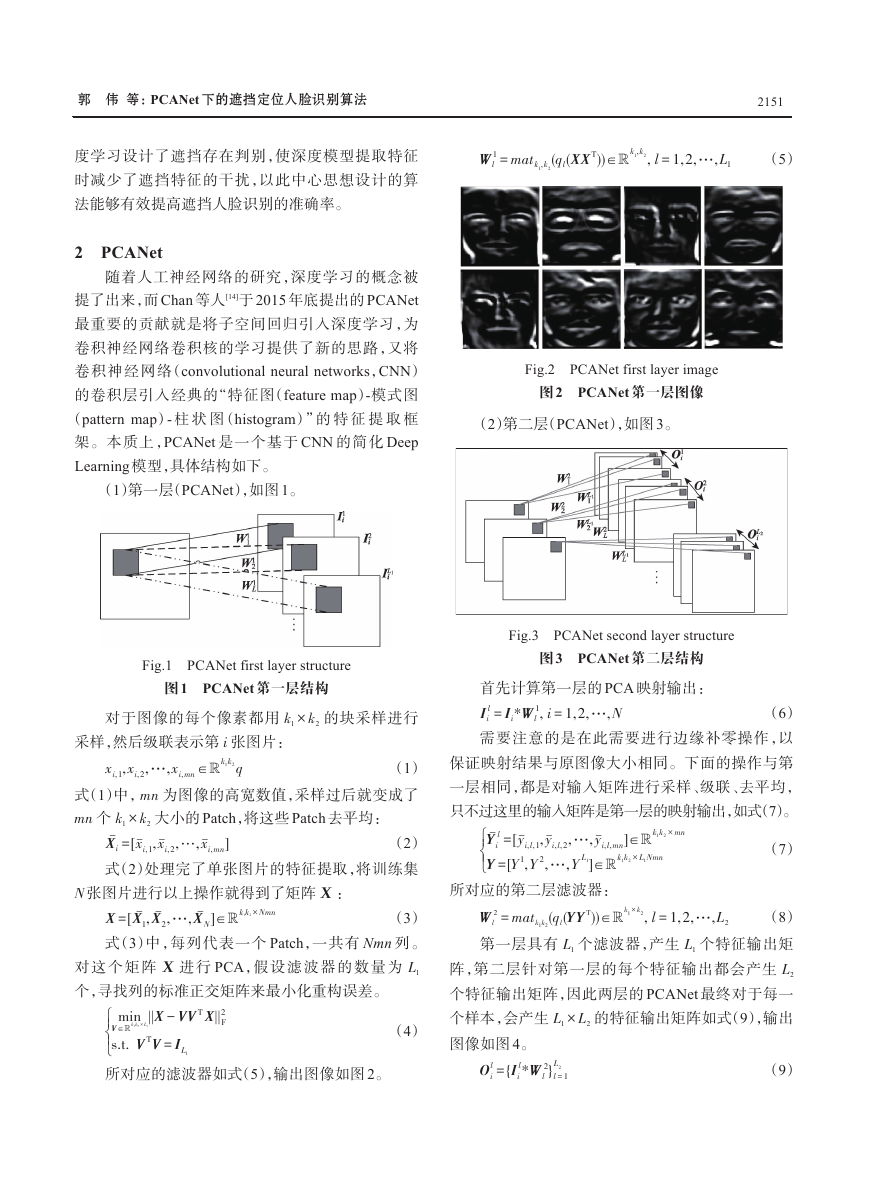

(3)输出层

对第二层的每个输出矩阵进行二值化哈希编

码,编码位数与第二层滤波器相同。

=1,2,…,

(10)

L2 是第二层的

=∑

L2 2l

=1

()

l

T l

i

(

-1

H

*

)

2

l

W

I l

i

这里 H

是跃阶函数,λ

滤波器数目。

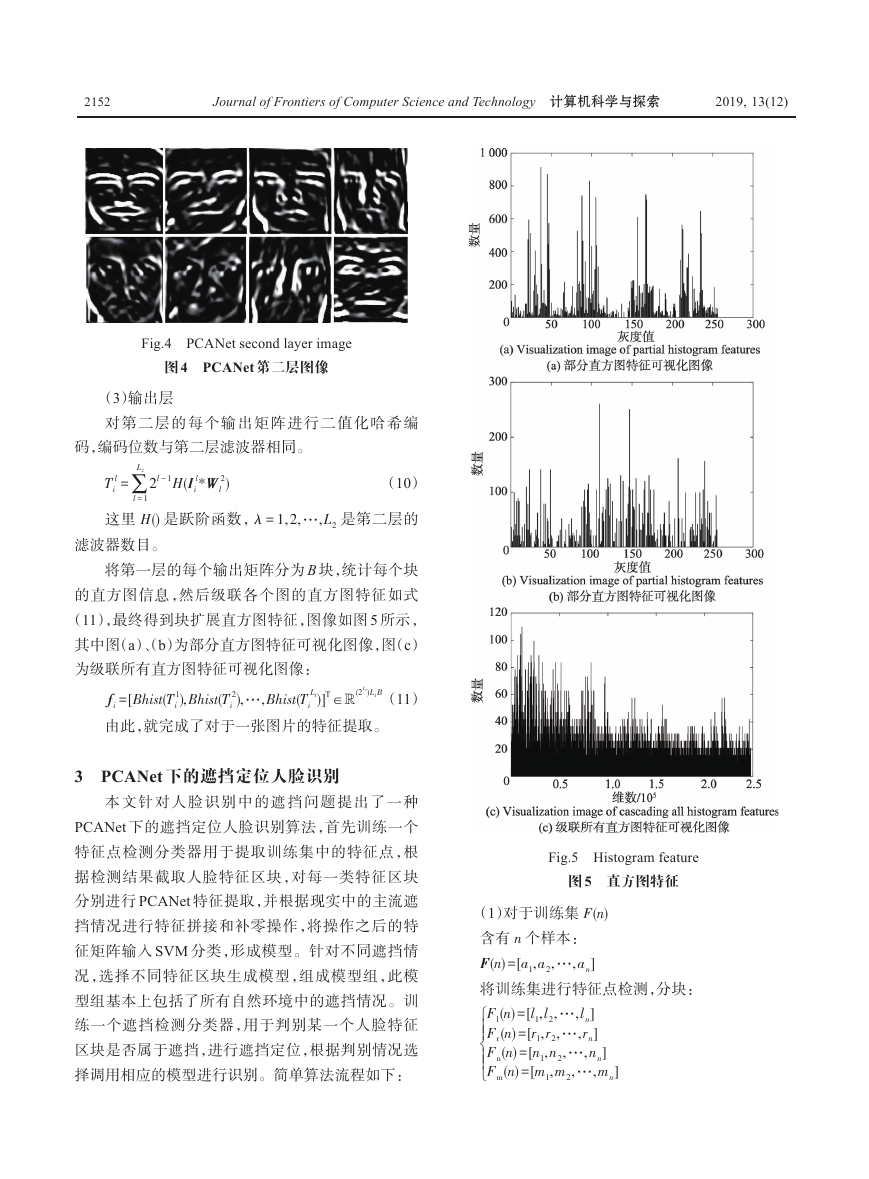

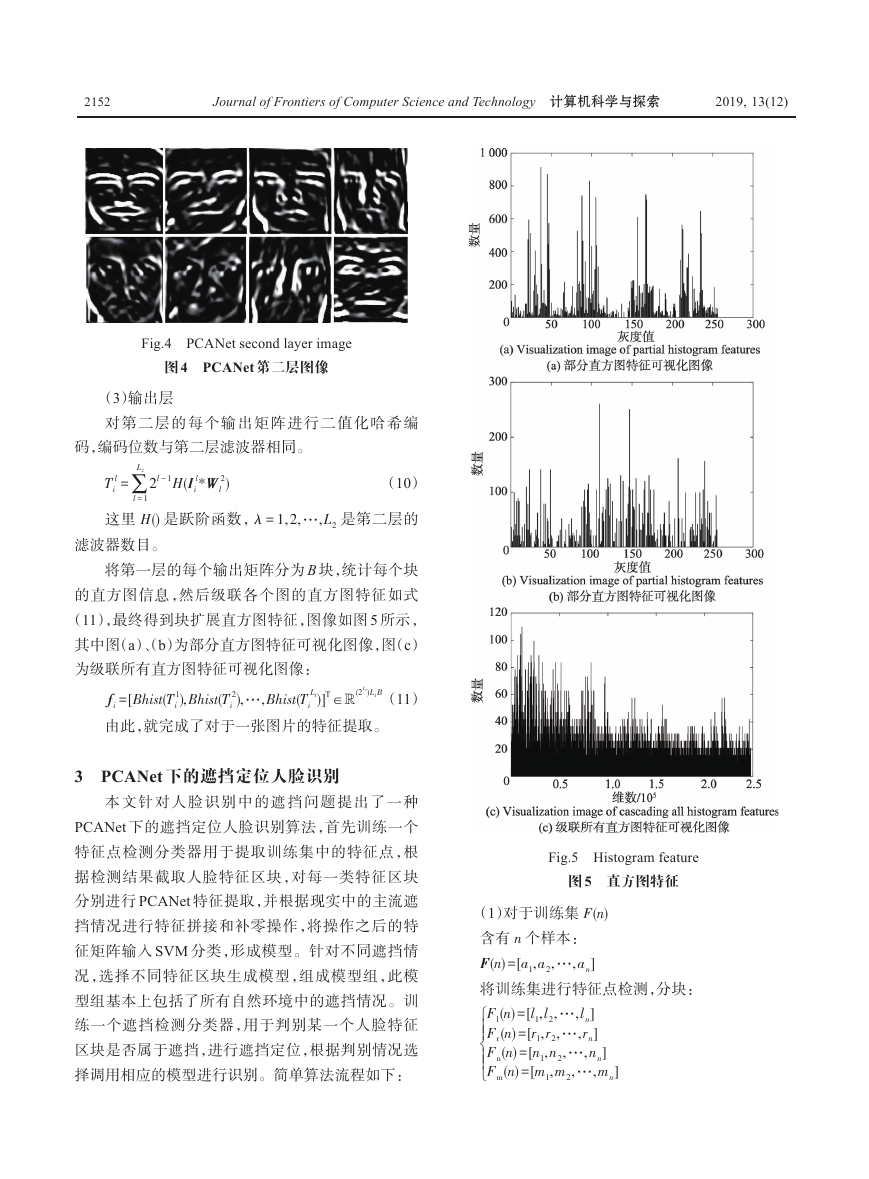

将第一层的每个输出矩阵分为 B 块,统计每个块

的直方图信息,然后级联各个图的直方图特征如式

(11),最终得到块扩展直方图特征,图像如图 5 所示,

其中图(a)、(b)为部分直方图特征可视化图像,图(c)

为级联所有直方图特征可视化图像:

=[

(

),

1

(

),…,

2

f

Bhist

T

Bhist

T

Bhist

i

由此,就完成了对于一张图片的特征提取。

i

i

L1B(11)

)]T ∈R(2L2)

(

T L1

i

3 PCANet 下的遮挡定位人脸识别

本文针对人脸识别中的遮挡问题提出了一种

PCANet 下的遮挡定位人脸识别算法,首先训练一个

特征点检测分类器用于提取训练集中的特征点,根

据检测结果截取人脸特征区块,对每一类特征区块

分别进行 PCANet 特征提取,并根据现实中的主流遮

挡情况进行特征拼接和补零操作,将操作之后的特

征矩阵输入 SVM 分类,形成模型。针对不同遮挡情

况,选择不同特征区块生成模型,组成模型组,此模

型组基本上包括了所有自然环境中的遮挡情况。训

练一个遮挡检测分类器,用于判别某一个人脸特征

区块是否属于遮挡,进行遮挡定位,根据判别情况选

择调用相应的模型进行识别。简单算法流程如下:

Fig.5 Histogram feature

图 5 直方图特征

(

)

n

F

n

n

含有 n 个样本:

a

(1)对于训练集 F

a1,

a2,…,

(

)=[

]

]

Fl(

l1,

)=[

l2,…,

将训练集进行特征点检测,分块:

r2,…,

r1,

Fr(

)=[

]

)=[

Fn(

n1,

n2,…,

m2,…,

Fm(

)=[

m1,

n

n

n

n

l

n

r

n

m

n

n

]

]

n

�

郭 伟 等:PCANet 下的遮挡定位人脸识别算法

2153

其中,Fl(

n

)

、Fr(

n

)

、Fn(

n

)

、Fm(

)

n

分别为左眼、右眼、

鼻子、嘴的样本。此时为同一张人脸的不同特征区

块打上相同的标签。

进行 PCANet 特征提取得到区块特征 fleye 、freye 、

fnose 、fmouse 。

根据实际遮挡类型将不同特征点组合拼接进行

=

SVM 训练:

Model

(

train

fleye,

freye)

仅举一例,后文会有更详细叙述,Model 为训练

好的模型,train 为训练过程,不同特征点组合训练形

成模型组,以此模型进行之后的识别工作。

)

m

(

(2)对于测试集 G

(

]

)=[

b1,

含有 m 个样本:

进 行 特 征 点 检 测 ,同 上 文 得 到 Gl(

b

)

、Gm(

)

b2,…,

。

m

m

G

m

m

Gn(

m

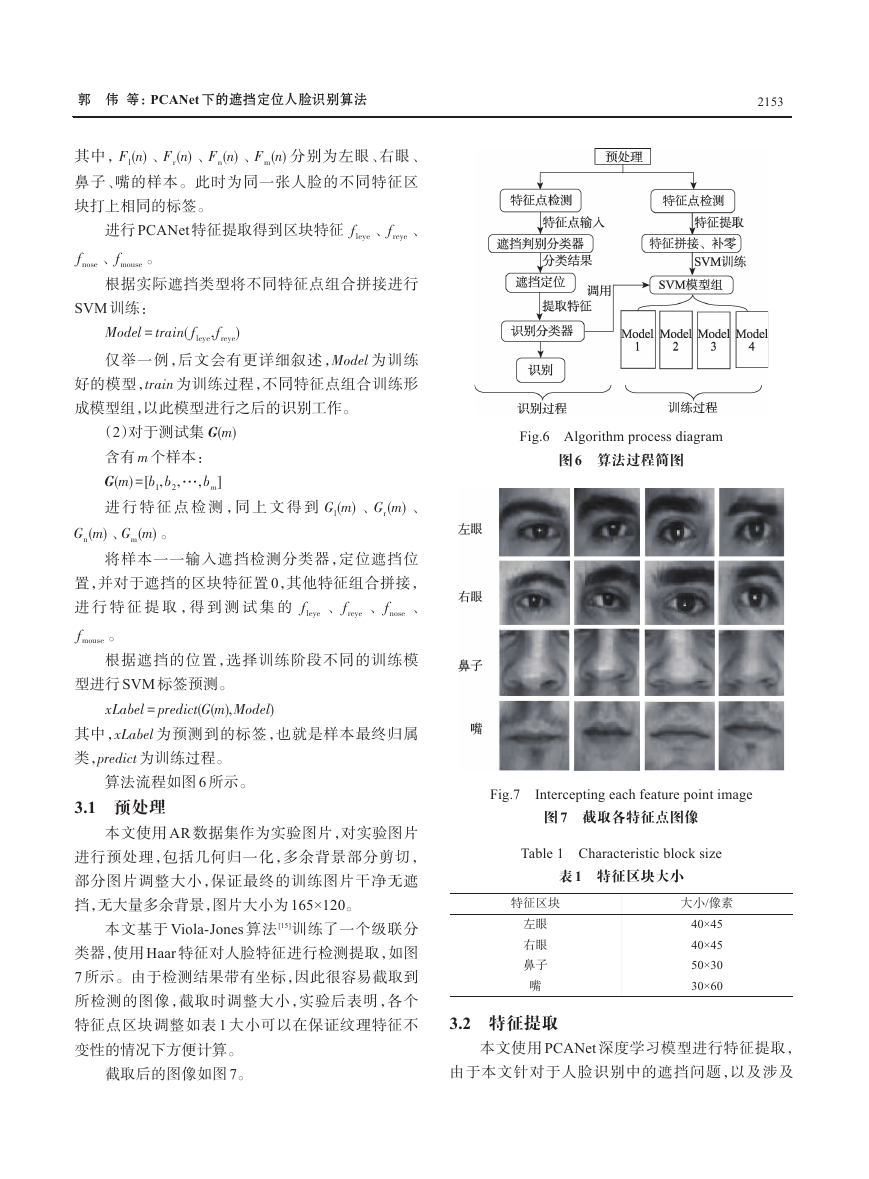

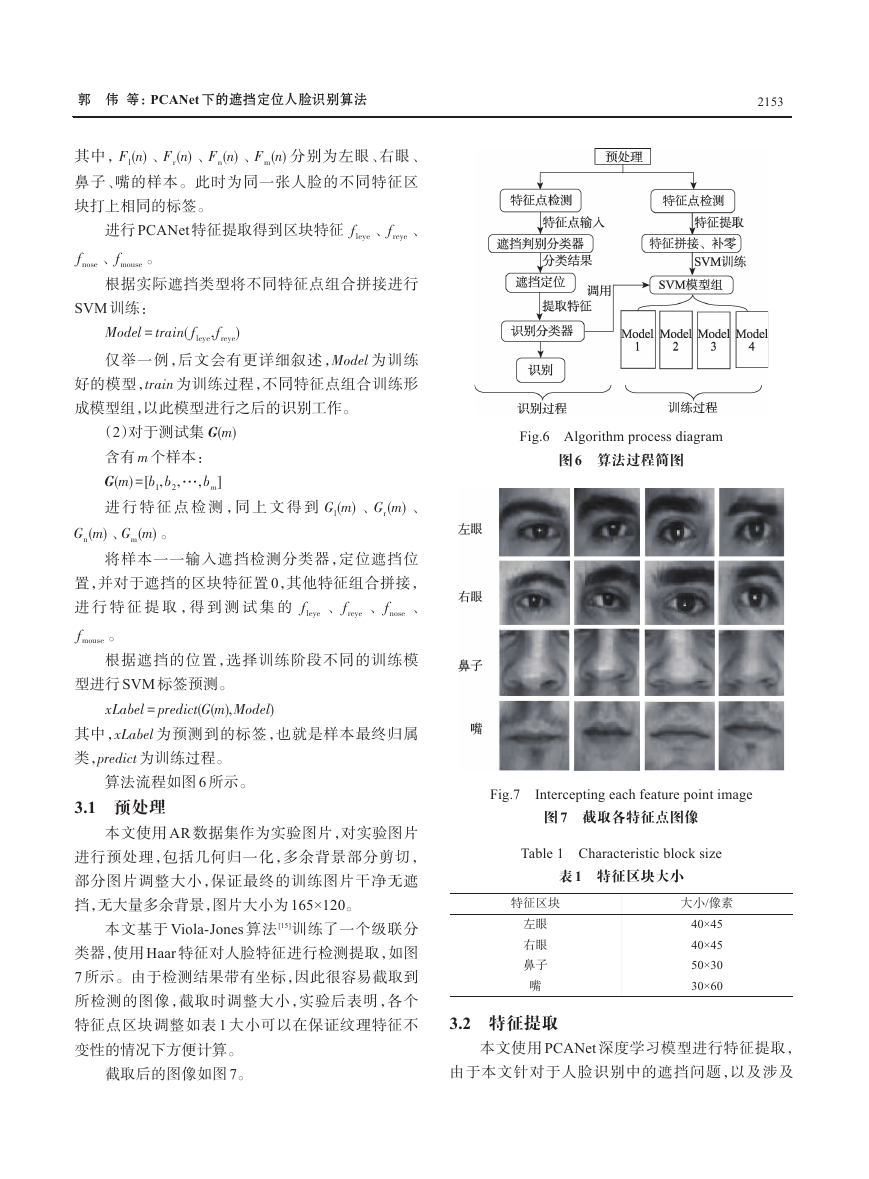

Fig.6 Algorithm process diagram

图 6 算法过程简图

、

)

、Gr(

m

)

将样本一一输入遮挡检测分类器,定位遮挡位

置,并对于遮挡的区块特征置 0,其他特征组合拼接,

进 行 特 征 提 取 ,得 到 测 试 集 的 fleye 、freye 、fnose 、

fmouse 。

根据遮挡的位置,选择训练阶段不同的训练模

),

型进行 SVM 标签预测。

=

(

(

xLabel

predict

G

m

)

Model

其中,xLabel 为预测到的标签,也就是样本最终归属

类,predict 为训练过程。

算法流程如图 6 所示。

3.1 预处理

本文使用 AR 数据集作为实验图片,对实验图片

进行预处理,包括几何归一化,多余背景部分剪切,

部分图片调整大小,保证最终的训练图片干净无遮

挡,无大量多余背景,图片大小为 165×120。

本文基于 Viola-Jones 算法 [15]训练了一个级联分

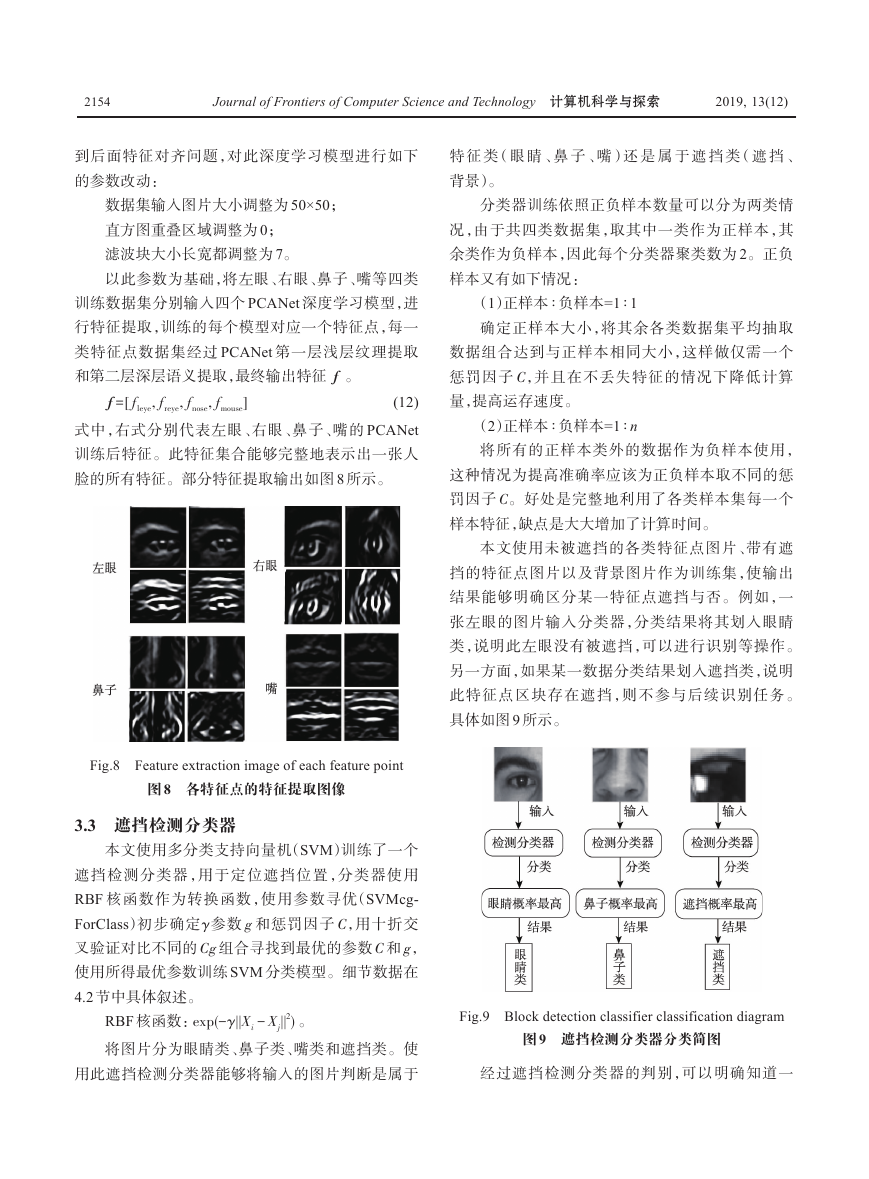

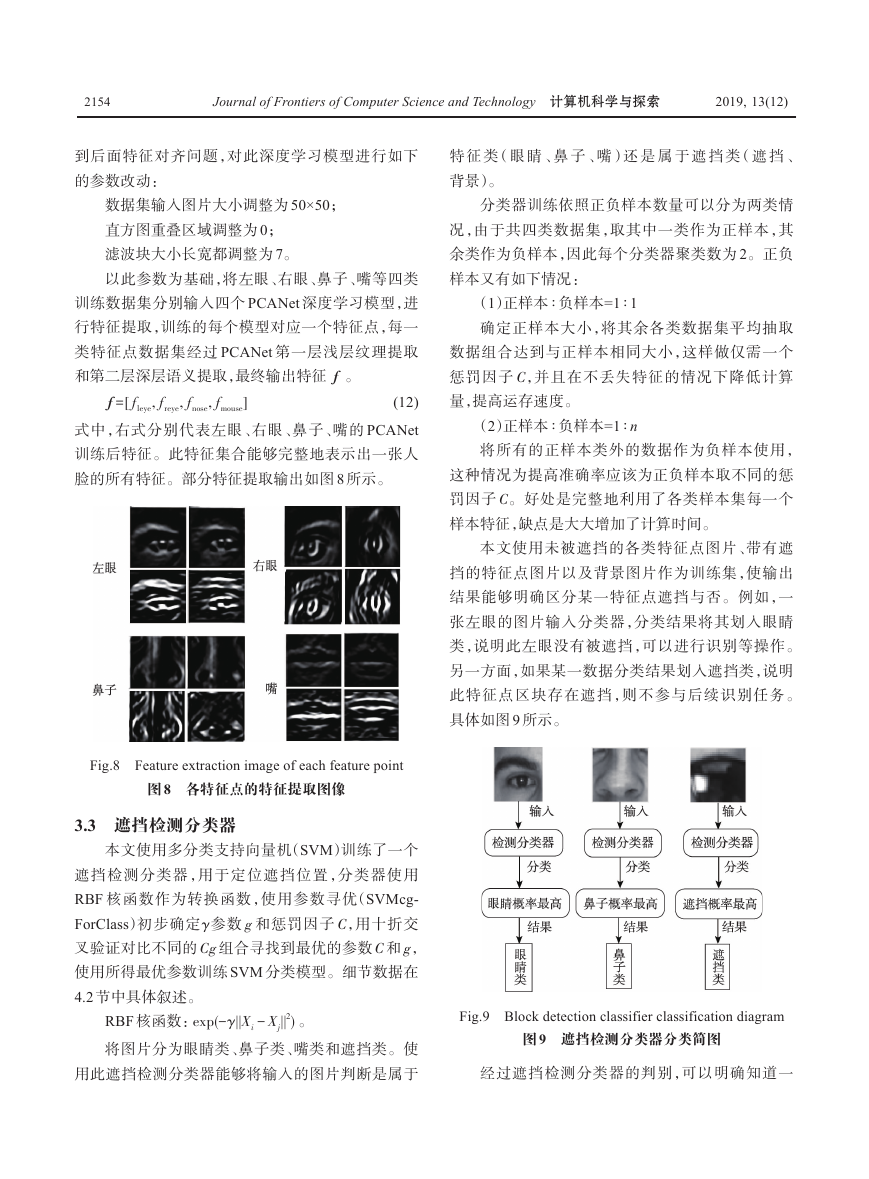

类器,使用 Haar 特征对人脸特征进行检测提取,如图

7 所示。由于检测结果带有坐标,因此很容易截取到

所检测的图像,截取时调整大小,实验后表明,各个

特征点区块调整如表 1 大小可以在保证纹理特征不

变性的情况下方便计算。

截取后的图像如图 7。

Fig.7

Intercepting each feature point image

图 7 截取各特征点图像

Table 1 Characteristic block size

表 1 特征区块大小

特征区块

大小/像素

左眼

右眼

鼻子

嘴

40×45

40×45

50×30

30×60

3.2 特征提取

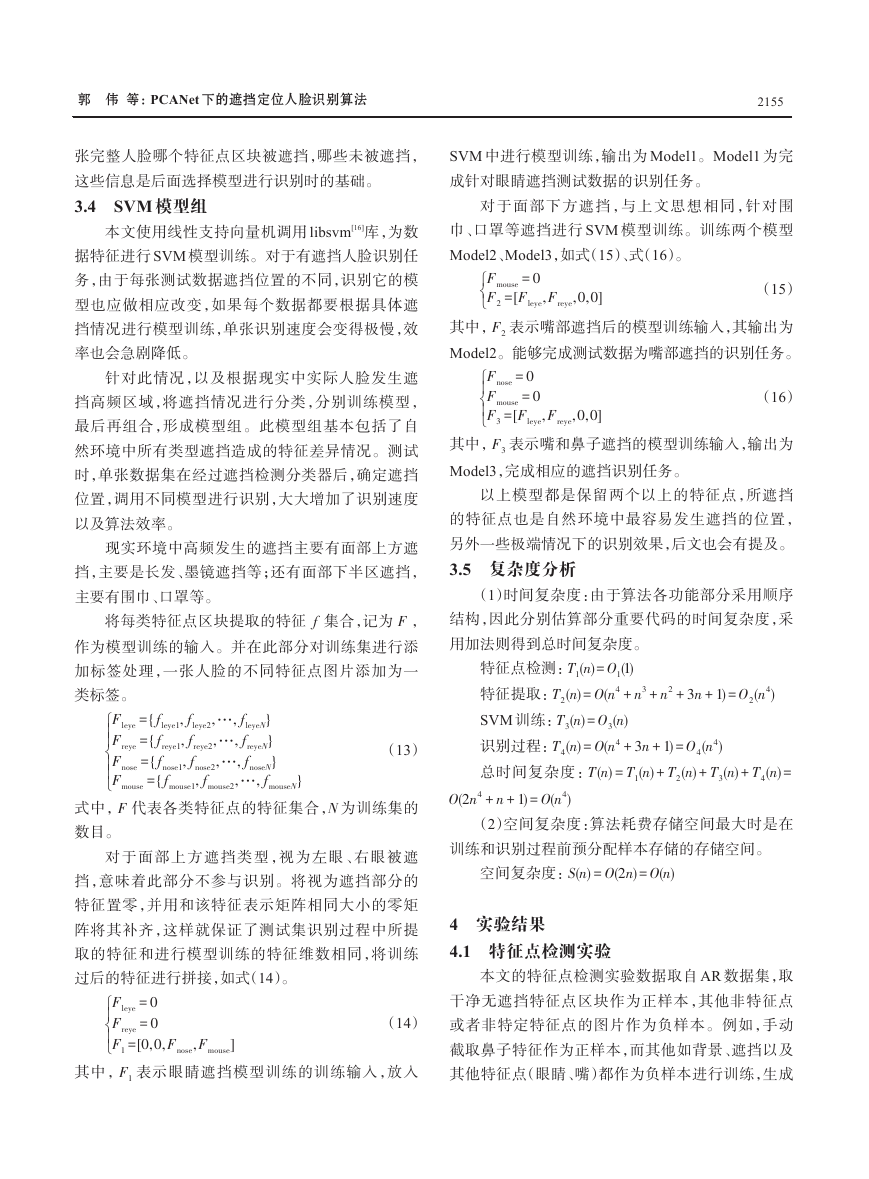

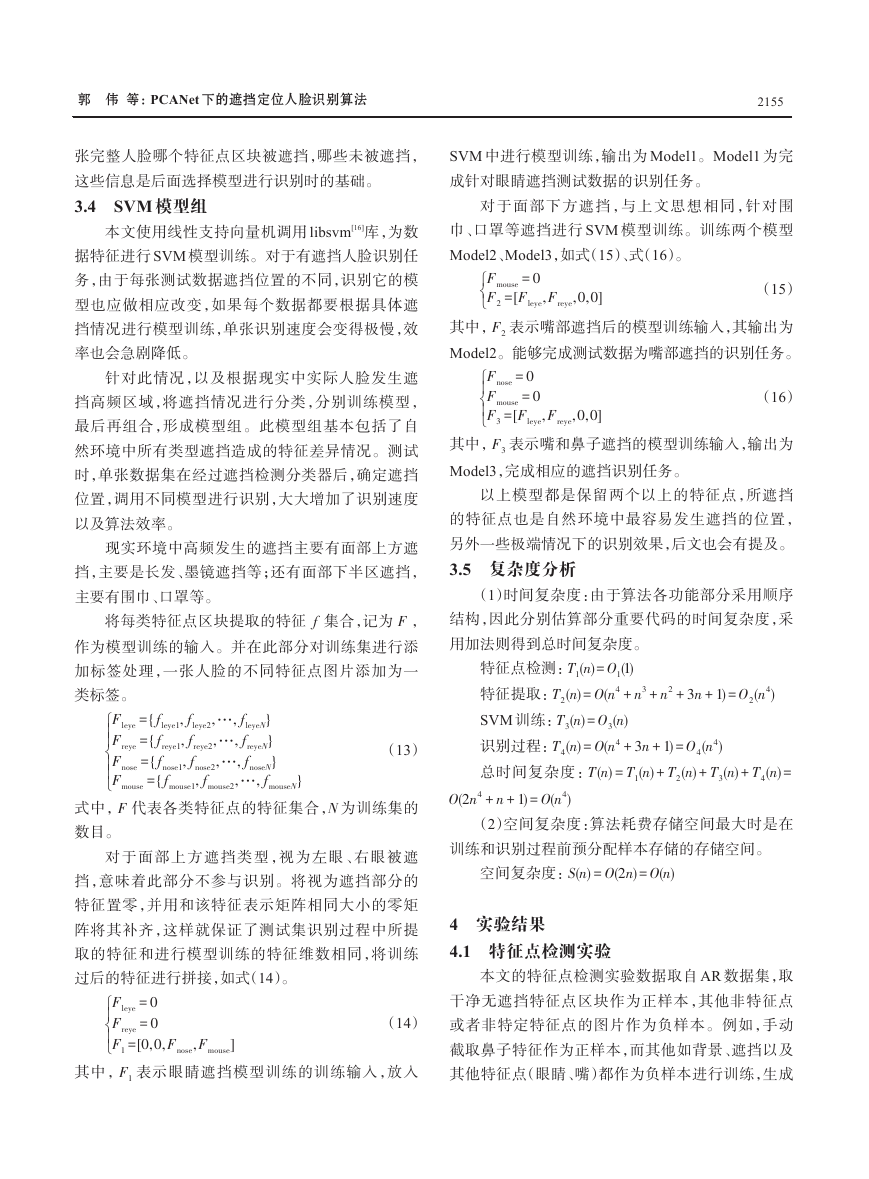

本文使用 PCANet 深度学习模型进行特征提取,

由于本文针对于人脸识别中的遮挡问题,以及涉及

�

2154

Journal of Frontiers of Computer Science and Technology 计算机科学与探索

2019, 13(12)

到后面特征对齐问题,对此深度学习模型进行如下

的参数改动:

特 征 类(眼 睛 、鼻 子 、嘴)还 是 属 于 遮 挡 类(遮 挡 、

背景)。

数据集输入图片大小调整为 50×50;

直方图重叠区域调整为 0;

滤波块大小长宽都调整为 7。

以此参数为基础,将左眼、右眼、鼻子、嘴等四类

训练数据集分别输入四个 PCANet 深度学习模型,进

行特征提取,训练的每个模型对应一个特征点,每一

类特征点数据集经过 PCANet 第一层浅层纹理提取

和第二层深层语义提取,最终输出特征 f 。

(12)

=[

fleye,

f

freye,

fnose,

fmouse]

式中,右式分别代表左眼、右眼、鼻子、嘴的 PCANet

训练后特征。此特征集合能够完整地表示出一张人

脸的所有特征。部分特征提取输出如图 8 所示。

Fig.8 Feature extraction image of each feature point

图 8 各特征点的特征提取图像

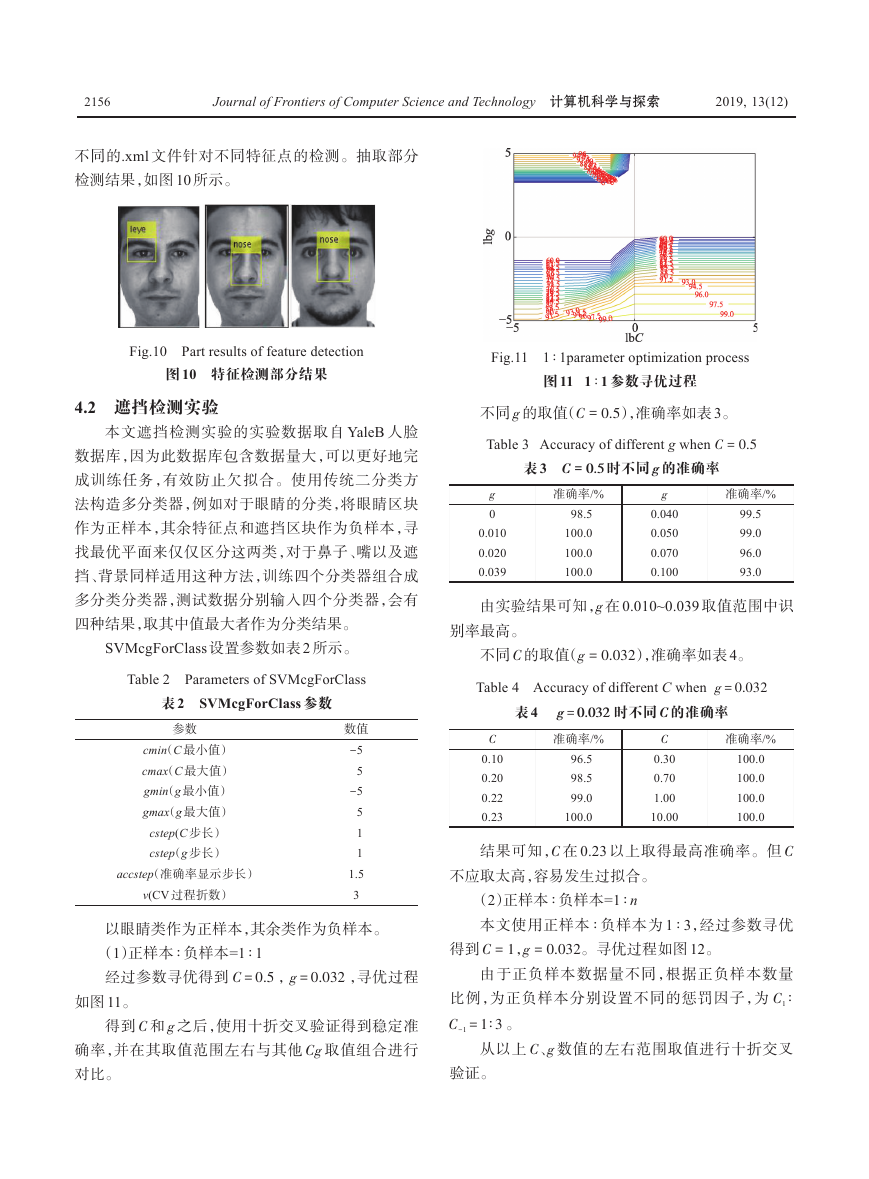

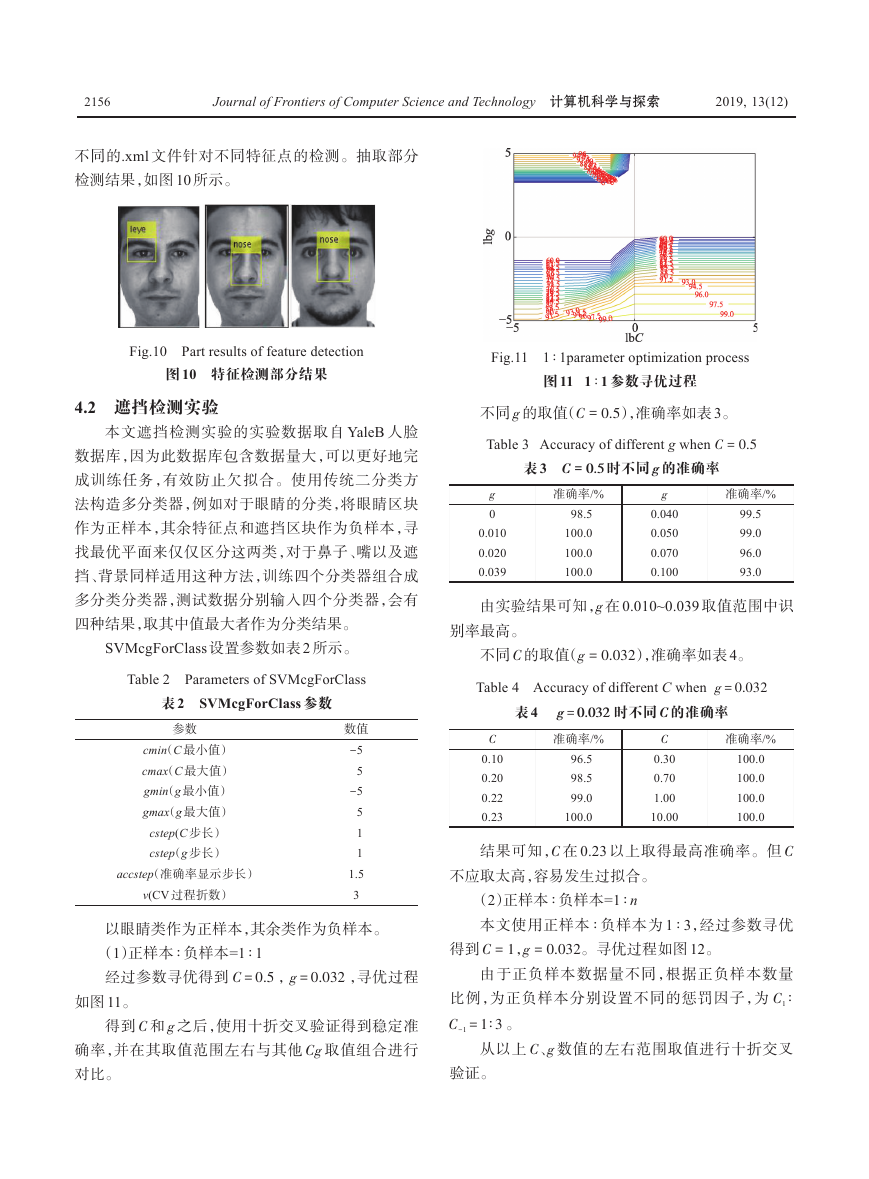

3.3 遮挡检测分类器

本文使用多分类支持向量机(SVM)训练了一个

遮挡检测分类器,用于定位遮挡位置,分类器使用

RBF 核函数作为转换函数,使用参数寻优(SVMcg-

ForClass)初步确定γ参数 g 和惩罚因子 C,用十折交

叉验证对比不同的 Cg 组合寻找到最优的参数 C 和 g,

使用所得最优参数训练 SVM 分类模型。细节数据在

4.2 节中具体叙述。

RBF 核函数:

exp(-

γ||X

2)

-

。

X

||

j

i

将图片分为眼睛类、鼻子类、嘴类和遮挡类。使

用此遮挡检测分类器能够将输入的图片判断是属于

1

分类器训练依照正负样本数量可以分为两类情

况,由于共四类数据集,取其中一类作为正样本,其

余类作为负样本,因此每个分类器聚类数为 2。正负

样本又有如下情况:

∶

∶

(1)正样本

负样本=1

确定正样本大小,将其余各类数据集平均抽取

数据组合达到与正样本相同大小,这样做仅需一个

惩罚因子 C,并且在不丢失特征的情况下降低计算

量,提高运存速度。

∶

∶

负样本=1

(2)正样本

将所有的正样本类外的数据作为负样本使用,

这种情况为提高准确率应该为正负样本取不同的惩

罚因子 C。好处是完整地利用了各类样本集每一个

样本特征,缺点是大大增加了计算时间。

n

本文使用未被遮挡的各类特征点图片、带有遮

挡的特征点图片以及背景图片作为训练集,使输出

结果能够明确区分某一特征点遮挡与否。例如,一

张左眼的图片输入分类器,分类结果将其划入眼睛

类,说明此左眼没有被遮挡,可以进行识别等操作。

另一方面,如果某一数据分类结果划入遮挡类,说明

此特征点区块存在遮挡,则不参与后续识别任务。

具体如图 9 所示。

Fig.9 Block detection classifier classification diagram

图 9 遮挡检测分类器分类简图

经过遮挡检测分类器的判别,可以明确知道一

�

郭 伟 等:PCANet 下的遮挡定位人脸识别算法

2155

张完整人脸哪个特征点区块被遮挡,哪些未被遮挡,

这些信息是后面选择模型进行识别时的基础。

3.4 SVM 模型组

本文使用线性支持向量机调用 libsvm[16]库,为数

据特征进行 SVM 模型训练。对于有遮挡人脸识别任

务,由于每张测试数据遮挡位置的不同,识别它的模

型也应做相应改变,如果每个数据都要根据具体遮

挡情况进行模型训练,单张识别速度会变得极慢,效

率也会急剧降低。

针对此情况,以及根据现实中实际人脸发生遮

挡高频区域,将遮挡情况进行分类,分别训练模型,

最后再组合,形成模型组。此模型组基本包括了自

然环境中所有类型遮挡造成的特征差异情况。测试

时,单张数据集在经过遮挡检测分类器后,确定遮挡

位置,调用不同模型进行识别,大大增加了识别速度

以及算法效率。

现实环境中高频发生的遮挡主要有面部上方遮

挡,主要是长发、墨镜遮挡等;还有面部下半区遮挡,

主要有围巾、口罩等。

将每类特征点区块提取的特征 f 集合,记为 F ,

作为模型训练的输入。并在此部分对训练集进行添

加标签处理,一张人脸的不同特征点图片添加为一

类标签。

Fleye={

Freye={

Fnose={

Fmouse={

fleye1,

freye1,

fnose1,

fmouse1,

fleye2,…,

freye2,…,

fnose2,…,

fmouse2,…,

fleye

freye

fnose

}

}

}

fmouse

N

N

N

(13)

}

N

式中,F 代表各类特征点的特征集合,N 为训练集的

数目。

对于面部上方遮挡类型,视为左眼、右眼被遮

挡,意味着此部分不参与识别。将视为遮挡部分的

特征置零,并用和该特征表示矩阵相同大小的零矩

阵将其补齐,这样就保证了测试集识别过程中所提

取的特征和进行模型训练的特征维数相同,将训练

过后的特征进行拼接,如式(14)。

Fnose,

Fmouse]

(14)

其中,F1 表示眼睛遮挡模型训练的训练输入,放入

Fleye=0

Freye=0

F1=[0,0,

SVM 中进行模型训练,输出为 Model1。Model1 为完

成针对眼睛遮挡测试数据的识别任务。

对于面部下方遮挡,与上文思想相同,针对围

巾、口罩等遮挡进行 SVM 模型训练。训练两个模型

Model2、Model3,如式(15)、式(16)。

(15)

Fmouse=0

F2 =[

Fleye,

Freye,0,0]

Fnose=0

Fmouse=0

F3=[

Fleye,

其中,F2 表示嘴部遮挡后的模型训练输入,其输出为

Model2。能够完成测试数据为嘴部遮挡的识别任务。

Freye,0,0]

(16)

其中,F3 表示嘴和鼻子遮挡的模型训练输入,输出为

Model3,完成相应的遮挡识别任务。

以上模型都是保留两个以上的特征点,所遮挡

的特征点也是自然环境中最容易发生遮挡的位置,

另外一些极端情况下的识别效果,后文也会有提及。

3.5 复杂度分析

(1)时间复杂度:由于算法各功能部分采用顺序

结构,因此分别估算部分重要代码的时间复杂度,采

用加法则得到总时间复杂度。

n

n

O

O1(1)

特征点检测:T1(

)=

(

)=

特征提取:T2(

4 +

O3(

)=

SVM 训练:T3(

)

识别过程:T4(

)=

(

4 +3

T1(

)=

(

4 +

(

4)

总时间复杂度:T

+1)=

O

n

n

n

n

n

n

n

n

O

n

(2

O

n

3+

n

n

2 +3

+1)=

O4(

)+

4)

T3(

+1)=

T2(

)+

n

n

n

n

n

4)

O2(

n

)+

)=

T4(

n

(2)空间复杂度:算法耗费存储空间最大时是在

训练和识别过程前预分配样本存储的存储空间。

空间复杂度:S

n

(

)=

(2

)=

O

n

(

)

O

n

4 实验结果

4.1 特征点检测实验

本文的特征点检测实验数据取自 AR 数据集,取

干净无遮挡特征点区块作为正样本,其他非特征点

或者非特定特征点的图片作为负样本。例如,手动

截取鼻子特征作为正样本,而其他如背景、遮挡以及

其他特征点(眼睛、嘴)都作为负样本进行训练,生成

�

2156

Journal of Frontiers of Computer Science and Technology 计算机科学与探索

2019, 13(12)

不同的.xml 文件针对不同特征点的检测。抽取部分

检测结果,如图 10 所示。

Fig.10 Part results of feature detection

图 10 特征检测部分结果

Fig.11

∶

1parameter optimization process

∶

1

1 参数寻优过程

图 11 1

0.5

不同 g 的取值(C =

),准确率如表 3。

Table 3 Accuracy of different g when C

表 3 C = 0.5 时不同 g 的准确率

= 0.5

4.2 遮挡检测实验

本文遮挡检测实验的实验数据取自 YaleB 人脸

数据库,因为此数据库包含数据量大,可以更好地完

成训练任务,有效防止欠拟合。使用传统二分类方

法构造多分类器,例如对于眼睛的分类,将眼睛区块

作为正样本,其余特征点和遮挡区块作为负样本,寻

找最优平面来仅仅区分这两类,对于鼻子、嘴以及遮

挡、背景同样适用这种方法,训练四个分类器组合成

多分类分类器,测试数据分别输入四个分类器,会有

四种结果,取其中值最大者作为分类结果。

SVMcgForClass 设置参数如表 2 所示。

Table 2 Parameters of SVMcgForClass

表 2 SVMcgForClass 参数

参数

cmin(C 最小值)

cmax(C 最大值)

gmin(g 最小值)

gmax(g 最大值)

cstep(C 步长)

cstep(g 步长)

accstep(准确率显示步长)

v(CV 过程折数)

数值-

5

5-

5

5

1

1

1.5

3

∶

∶

以眼睛类作为正样本,其余类作为负样本。

=0.5

负样本=1

(1)正样本

经过参数寻优得到 C

=0.032

,g

1

,寻优过程

如图 11。

得到 C 和 g 之后,使用十折交叉验证得到稳定准

确率,并在其取值范围左右与其他 Cg 取值组合进行

对比。

g

0

0.010

0.020

0.039

准确率/%

98.5

100.0

100.0

100.0

g

0.040

0.050

0.070

0.100

准确率/%

99.5

99.0

96.0

93.0

由实验结果可知,g 在 0.010~0.039 取值范围中识

别率最高。

= 0.032

不同 C 的取值(g

=

Table 4 Accuracy of different C when g

0.032 时不同 C 的准确率

表 4

g

),准确率如表 4。

=0.032

C

0.10

0.20

0.22

0.23

准确率/%

96.5

98.5

99.0

100.0

C

0.30

0.70

1.00

10.00

准确率/%

100.0

100.0

100.0

100.0

结果可知,C 在 0.23 以上取得最高准确率。但 C

不应取太高,容易发生过拟合。

∶

∶

(2)正样本

负样本=1

= 0.032

本文使用正样本

= 1

n

∶

∶

3,经过参数寻优

负样本为 1

得到 C

,g

。寻优过程如图 12。

∶

由于正负样本数据量不同,根据正负样本数量

比例,为正负样本分别设置不同的惩罚因子,为 C1

C-1

=1∶3

。

从以上 C、g 数值的左右范围取值进行十折交叉

验证。

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc