信息技术与信息化 网络与通信

基于 OPNET 仿真的 MPLS 流量工程的分析

Analysis of MPLS Traffic Engineer based on OPNET Simulation

刘进志* 陈 涤 李国刚

LIU Jin-zhi CHEN Di

LI Guo-gang

摘 要

关键词

MPLS 被认为是下一代 IP 骨干网络技术,而流量工程是合理使用网络资源保障 QoS 的关键。支持 MPLS

的路由器可以使用新的机制实现流量工程。该文基于目前功能最大的网络仿真工具 OPNET,进行基于

MPLS 的流量工程的仿真,并对仿真结果进行比较和分析。

多协议标签交换(MPLS) 流量工程(TE) 负载均衡(LB) 标签交换路径(LSP) 传输控制协议(TCP)

用户数据报协议(UDP)

Abstract MPLS is regarded as the core of the next generation IP network while traffic engineering is the key to

optimize the utilization of network resources and to ensure QoS. Label switch router can use MPLS as new mechanisms to

realize traffic engineering. Based on the powerful Simulation tool-OPNET,this paper will present simulation of Traffic

Engineer based on MPLS and the analysis、compare of the simulation result .

Keywords Multi-Protocol Label Switching(MPLS) Traffic Engineering(TE)load balance

Label Switched

Paths(LSP) Transmission Control Protocol(TCP) User Datagram Protocol(UDP)

1 概述

流量工程的目的是实现对网络中业务流的精确控制,

通过将业务流合理地映射到网络资源,达到提高性能、减少

拥塞和提高可靠性的目的。其性能目标有两类[1]:面向业务

的和面向资源的。面向业务的性能目标主要是增强单个业

务流的 QoS,包括降低丢包率、时延和时延抖动,增强吞吐

量和服务等级协定(SLA )等。面向资源的性能目标主要是

提高网络资源的总体利用率,解决由于流量向网络资源低

效率的映射所带来的拥塞,如通过负载均衡降低丢包率和

传输时延以增强 QoS 等。

本文所做的工作主要是用 OPNET 网络仿真工具对基于

UDP 数据流和基于 TCP 数据流的网络模型在进行 MPLS TE

前、后进行链路利用率和网络吞吐量的比较与分析。

2 MPLS 简述

MPLS 是一种在开放的通信网上利用标签进行数据高

速、高效传输的新技术。它将第二层的交换和第三层的路由

技术很好地结合起来,以简洁的方式完成了信息的传送。网

络结构中主要包括标签交换路由、标签边缘交换路由(LER)

及标签分发协议(LDP)。总的运作过程为:在网络入口 LER

处作 IP 分组到转发等价类(FEC)的映射,用定长的标签编码

山东大学信息科学与工程学院 250100

*

表示。代表 FEC 的标签插入到分组头中,沿着标签交换路径

的后继 IP 节点只需根据标签确定的路径(LSP),将分组转发

出去,直到 LSP 出口。当到达出口时,出口将标签剥去,分组

再由 LSR 第三层转发来处理。因此利用标签,MPLS 能在 In-

ternet 路由器中快速有效地实现分组转发,提高网络的性能。

但最重要的是,MPLS 具有流量工程能力,能很好地控制网络

资源,优化网络性能。数据包在 LSP 中的转发图示如下:

图 1

3 仿真与分析:

3 . 1 网络拓扑结构:

用 OPNET 构建拓扑结构并进行仿真。网络模型共有 20

个路由节点,34 条链路(33 条 PPPDS1,1 条 PPPDS3),五个点

对点工作站,一台服务器。五个工作站经过建立起的干线网

络拓扑向服务器发送单向数据流(数据请求),仿真结果将对

在进行 MPLS 流量工程前和进行 MPLS 流量工程后网络链路

利用率和网络吞吐量的比较和分析。

流量的源、宿及流量模型:

五个 工 作 站(Porland、Porland1、San Francisico、Los Angel、

San Diego)分别发送 TCP / UDP 数据请求 包 到 服 务 器 Maine。

2005 年第 3 期 19

�

网络与通信 信息技术与信息化

数据包的大小服从指数分布,平均值为 64K bit / s,每个工作

站每一次请求发送的数据包的个数服从某一范围内的均匀

其它 :PPPDS1(1 . 544M bit / s)

选择容量小的干线链路是因为可以更容易的反映网络

分布。包与包之间间隔为零秒,请求与请求之间间隔为零秒

节点模型:

标签边缘交换路由器:Las Vegas、Boston

标签交换路由器:其它路由器节点

链路模型:

Bouston < — > Maine :PPPDS3(44 . 736M bit / s)

处于饱和时的状态。

3 . 2 UDP 数据流模型下的仿真与分析

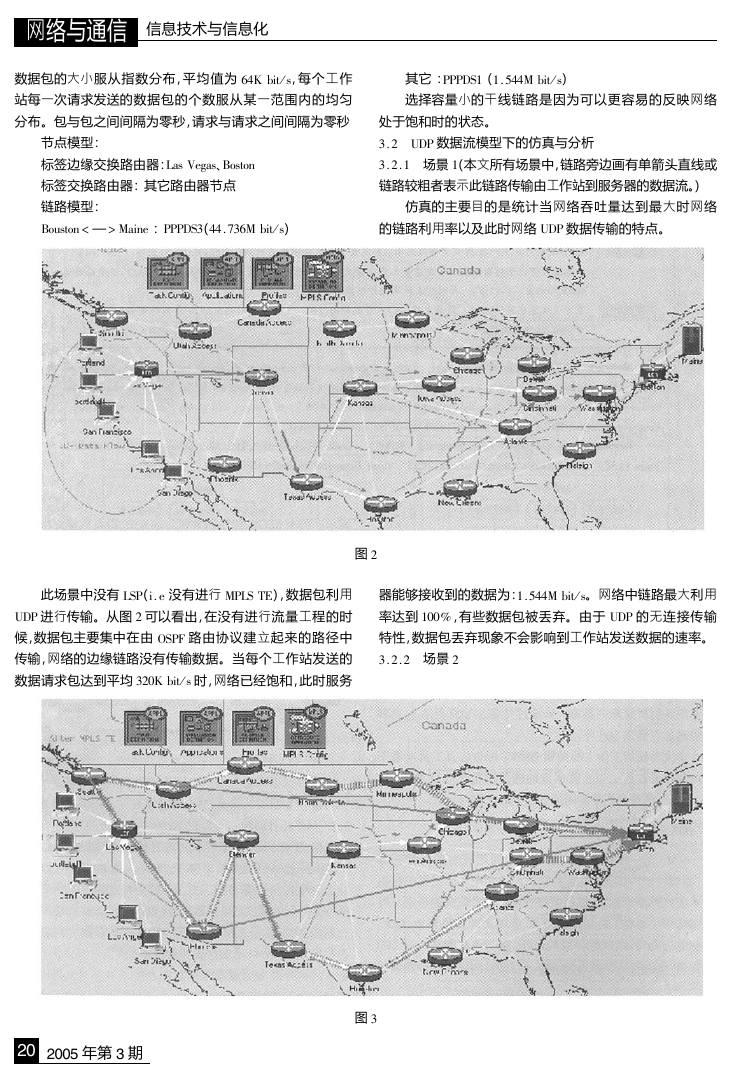

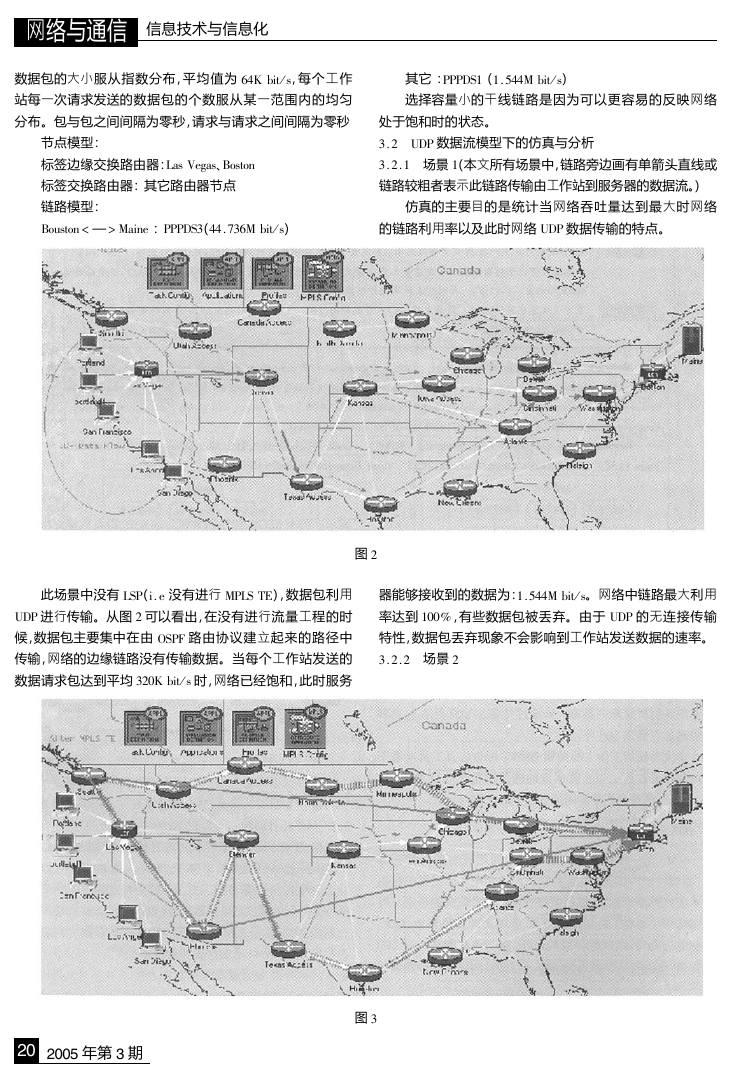

3 . 2 . 1 场景 1(本文所有场景中,链路旁边画有单箭头直线或

链路较粗者表示此链路传输由工作站到服务器的数据流。)

仿真的主要目的是统计当网络吞吐量达到最大时网络

的链路利用率以及此时网络 UDP 数据传输的特点。

图 2

此场景中没有 LSP(i . e 没有进行 MPLS TE),数据包利用

UDP 进行传输。从图 2 可以看出,在没有进行流量工程的时

候,数据包主要集中在由 OSPF 路由协议建立起来的路径中

传输,网络的边缘链路没有传输数据。当每个工作站发送的

数据请求包达到平均 320K bit / s 时,网络已经饱和,此时服务

器能够接收到的数据为:1 . 544M bit / s。网络中链路最大利用

率达到 100% ,有些数据包被丢弃。由于 UDP 的无连接传输

特性,数据包丢弃现象不会影响到工作站发送数据的速率。

3 . 2 . 2 场景 2

20 2005 年第 3 期

图 3

�

对场景 1 中的网络模型进行 MPLS 的流量工程,建立两

条动态 LSP 用以传输工作站 San Francisco 和工作站 Los Ange-

las 的 UDP 数据流,LER:Las Vegas 利用 RSVP 建立经过 Seattle

和 Phoenix 节点的两条 LSP 路径(loadbalancing 1、loadbalancing

2)。从图 3 中可以看出,网络中不仅有传统路由协议建立起

的路径,而且还有两条动态 LSP 建立起的路径。工作站所发

送的流量被较均衡的分配到了网络的链路中。仿真结果表

明:LSP 所实现的负载均衡不仅提高了网络的吞吐量,而且使

网络资源得到了较好的利用。

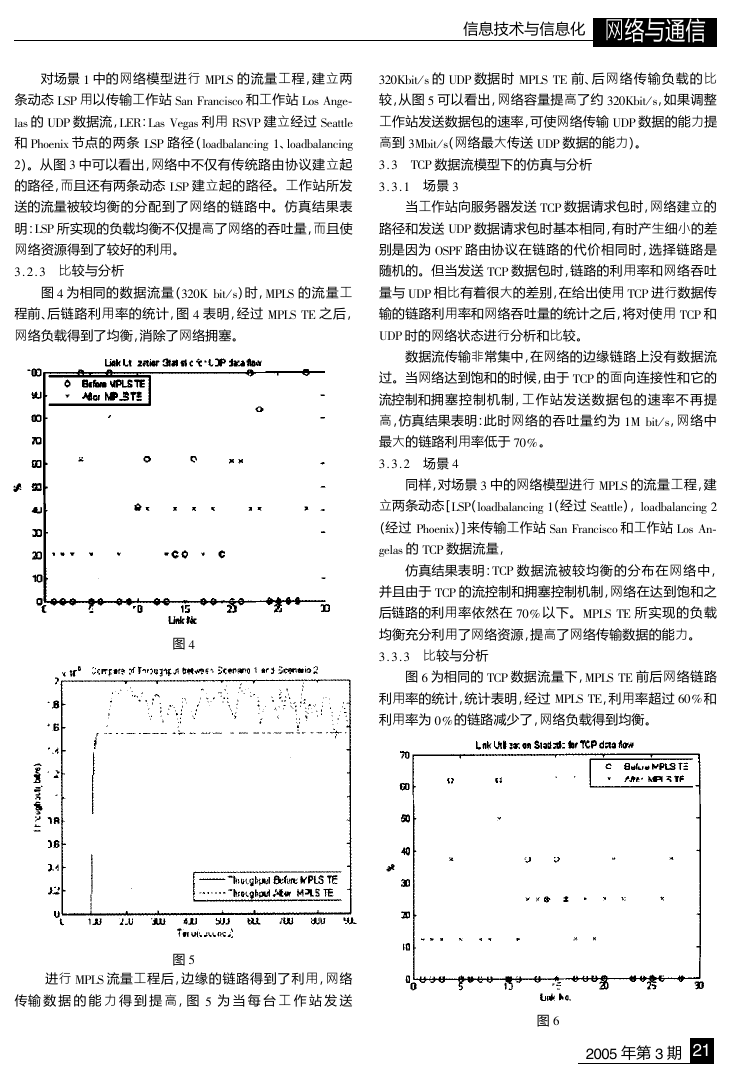

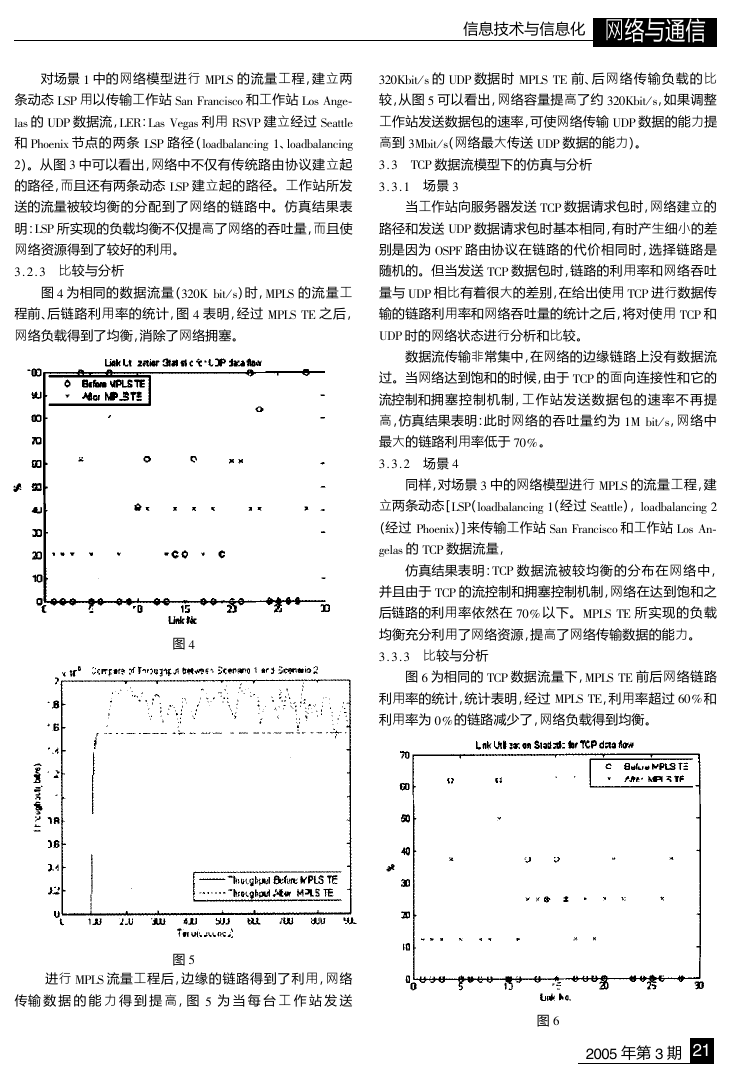

3 . 2 . 3 比较与分析

图 4 为相同的数据流量(320K bit / s)时,MPLS 的流量工

程前、后链路利用率的统计,图 4 表明,经过 MPLS TE 之后,

网络负载得到了均衡,消除了网络拥塞。

图 4

信息技术与信息化 网络与通信

320Kbit / s 的 UDP 数据时 MPLS TE 前、后网络传输负载的比

较,从图 5 可以看出,网络容量提高了约 320Kbit / s,如果调整

工作站发送数据包的速率,可使网络传输 UDP 数据的能力提

高到 3Mbit / s(网络最大传送 UDP 数据的能力)。

3 . 3 TCP 数据流模型下的仿真与分析

3 . 3 . 1 场景 3

当工作站向服务器发送 TCP 数据请求包时,网络建立的

路径和发送 UDP 数据请求包时基本相同,有时产生细小的差

别是因为 OSPF 路由协议在链路的代价相同时,选择链路是

随机的。但当发送 TCP 数据包时,链路的利用率和网络吞吐

量与 UDP 相比有着很大的差别,在给出使用 TCP 进行数据传

输的链路利用率和网络吞吐量的统计之后,将对使用 TCP 和

UDP 时的网络状态进行分析和比较。

数据流传输非常集中,在网络的边缘链路上没有数据流

过。当网络达到饱和的时候,由于 TCP 的面向连接性和它的

流控制和拥塞控制机制,工作站发送数据包的速率不再提

高,仿真结果表明:此时网络的吞吐量约为 1M bit / s,网络中

最大的链路利用率低于 70% 。

3 . 3 . 2 场景 4

同样,对场景 3 中的网络模型进行 MPLS 的流量工程,建

立两条动态[LSP(loadbalancing 1(经过 Seattle),loadbalancing 2

(经过 Phoenix)]来传输工作站 San Francisco 和工作站 Los An-

gelas 的 TCP 数据流量,

仿真结果表明:TCP 数据流被较均衡的分布在网络中,

并且由于 TCP 的流控制和拥塞控制机制,网络在达到饱和之

后链路的利用率依然在 70% 以下。MPLS TE 所实现的负载

均衡充分利用了网络资源,提高了网络传输数据的能力。

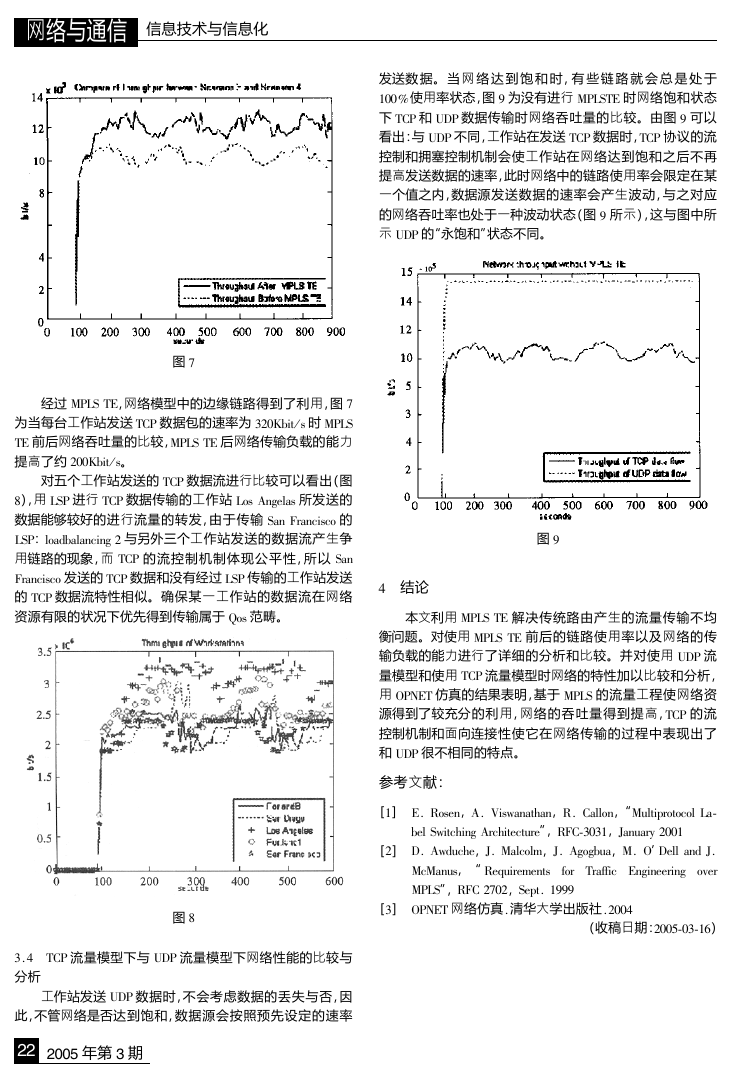

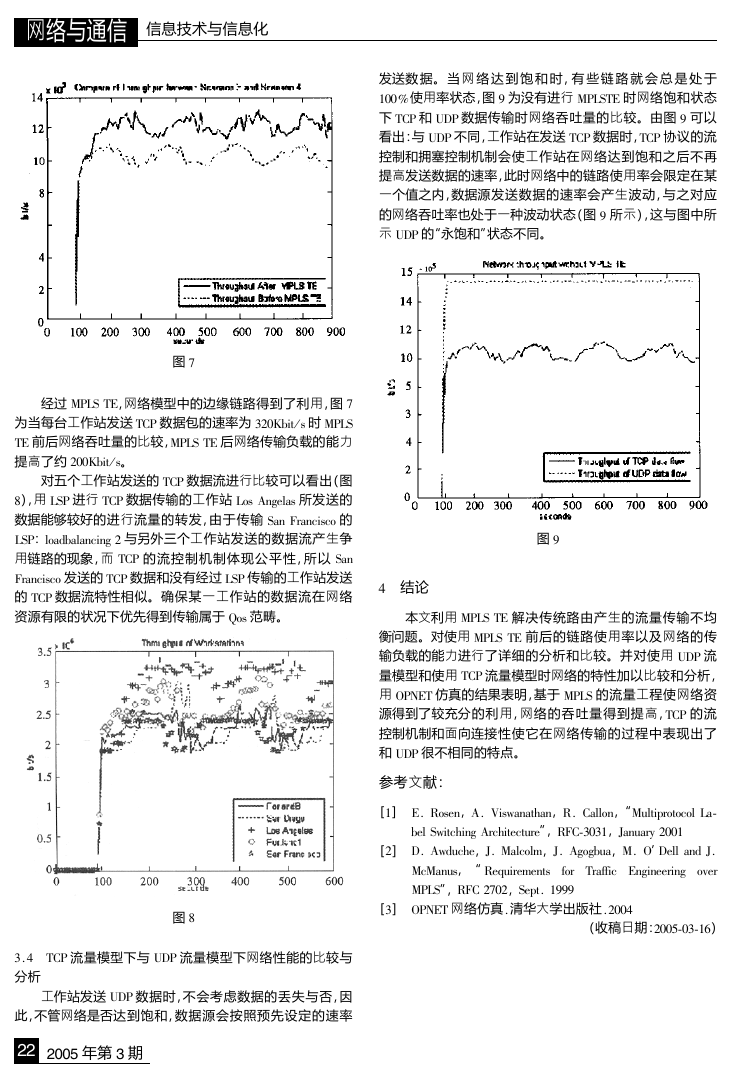

3 . 3 . 3 比较与分析

图 6 为相同的 TCP 数据流量下,MPLS TE 前后网络链路

利用率的统计,统计表明,经过 MPLS TE,利用率超过 60% 和

利用率为 0% 的链路减少了,网络负载得到均衡。

图 5

进行 MPLS 流量工程后,边缘的链路得到了利用,网络

传输 数 据 的 能 力 得 到 提 高,图 5 为 当 每 台 工 作 站 发 送

图 6

2005 年第 3 期 21

�

网络与通信 信息技术与信息化

发送数 据。当 网 络 达 到 饱 和 时,有 些 链 路 就 会 总 是 处 于

100%使用率状态,图 9 为没有进行 MPLSTE 时网络饱和状态

下 TCP 和 UDP 数据传输时网络吞吐量的比较。由图 9 可以

看出:与 UDP 不同,工作站在发送 TCP 数据时,TCP 协议的流

控制和拥塞控制机制会使工作站在网络达到饱和之后不再

提高发送数据的速率,此时网络中的链路使用率会限定在某

一个值之内,数据源发送数据的速率会产生波动,与之对应

的网络吞吐率也处于一种波动状态(图 9 所示),这与图中所

示 UDP 的“永饱和”状态不同。

图 7

经过 MPLS TE,网络模型中的边缘链路得到了利用,图 7

为当每台工作站发送 TCP 数据包的速率为 320Kbit / s 时 MPLS

TE 前后网络吞吐量的比较,MPLS TE 后网络传输负载的能力

提高了约 200Kbit / s。

对五个工作站发送的 TCP 数据流进行比较可以看出(图

8),用 LSP 进行 TCP 数据传输的工作站 Los Angelas 所发送的

数据能够较好的进行流量的转发,由于传输 San Francisco 的

LSP:loadbalancing 2 与另外三个工作站发送的数据流产生争

用链路的现象,而 TCP 的流控制机制体现公平性,所以 San

Francisco 发送的 TCP 数据和没有经过 LSP 传输的工作站发送

的 TCP 数据流特性相似。确保某一工作站的数据流在网络

资源有限的状况下优先得到传输属于 Qos 范畴。

图 8

3 . 4 TCP 流量模型下与 UDP 流量模型下网络性能的比较与

分析

工作站发送 UDP 数据时,不会考虑数据的丢失与否,因

此,不管网络是否达到饱和,数据源会按照预先设定的速率

22 2005 年第 3 期

图 9

4 结论

本文利用 MPLS TE 解决传统路由产生的流量传输不均

衡问题。对使用 MPLS TE 前后的链路使用率以及网络的传

输负载的能力进行了详细的分析和比较。并对使用 UDP 流

量模型和使用 TCP 流量模型时网络的特性加以比较和分析,

用 OPNET 仿真的结果表明,基于 MPLS 的流量工程使网络资

源得到了较充分的利用,网络的吞吐量得到提高,TCP 的流

控制机制和面向连接性使它在网络传输的过程中表现出了

和 UDP 很不相同的特点。

参考文献:

[1] E. Rosen,A. Viswanathan,R. Callon,“Multiprotocol La-

bel Switching Architecture”,RFC-3031,January 2001

[2] D. Awduche,J. Malcolm,J. Agogbua,M. O’Dell and J.

for Traffic Engineering over

McManus,“ Requirements

MPLS”,RFC 2702,Sept . 1999

[3] OPNET 网络仿真 . 清华大学出版社 . 2004

(收稿日期:2005-03-16)

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc