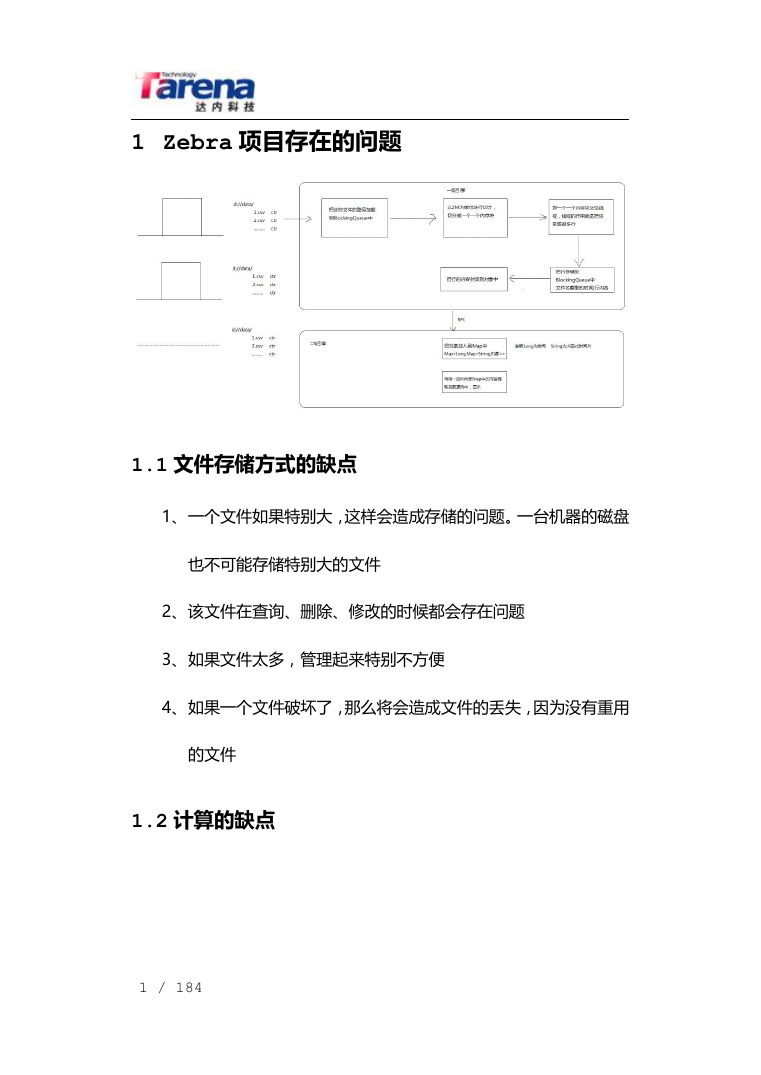

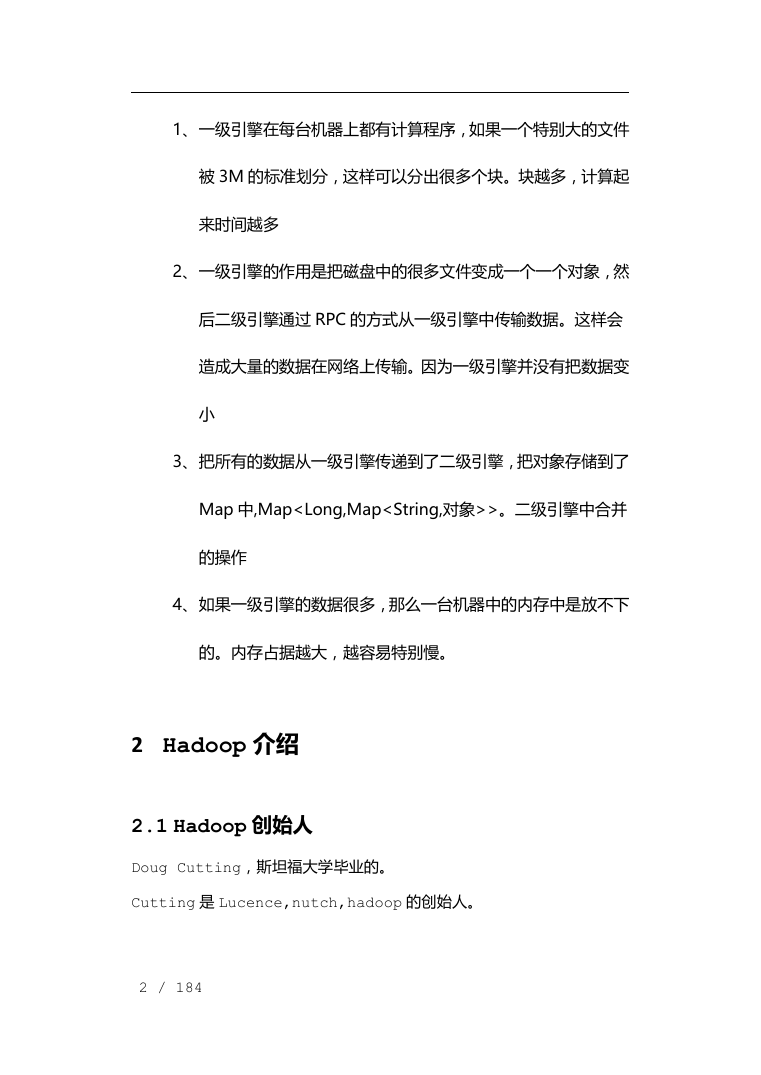

1Zebra项目存在的问题

1.1文件存储方式的缺点

1.2计算的缺点

2Hadoop介绍

2.1Hadoop创始人

2.2Hadoop起源

2.3大数据的特点

2.4大数据带来的变化

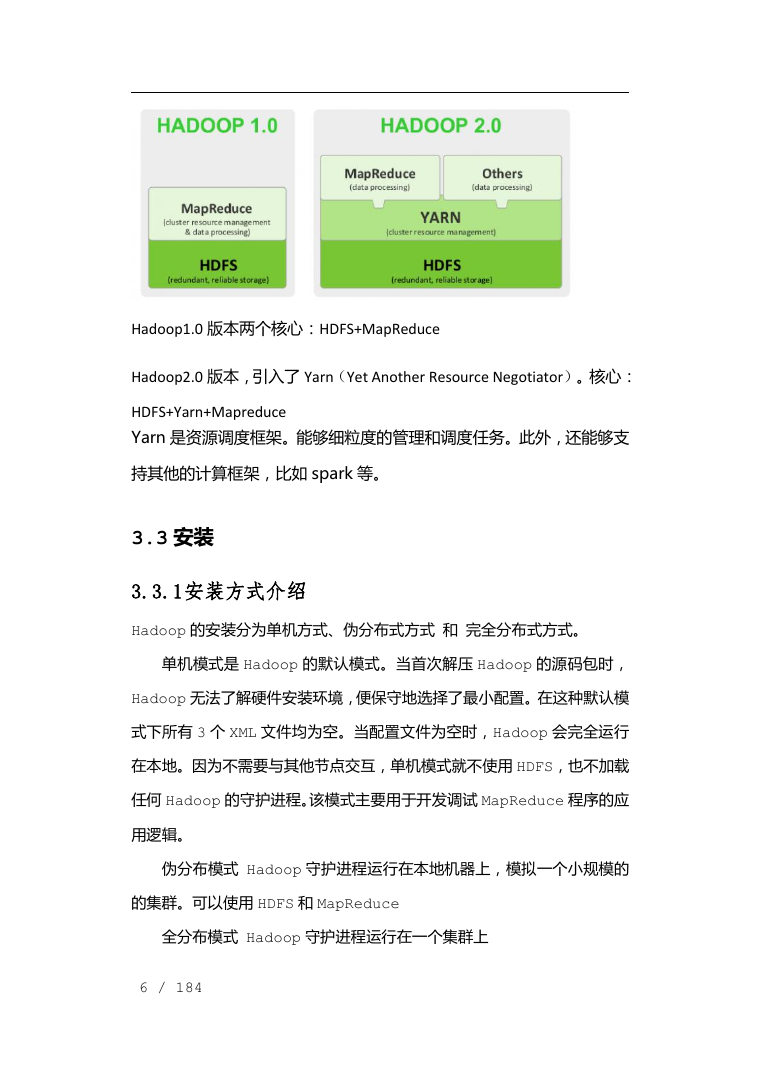

3Hadoop版本介绍和安装

3.1下载

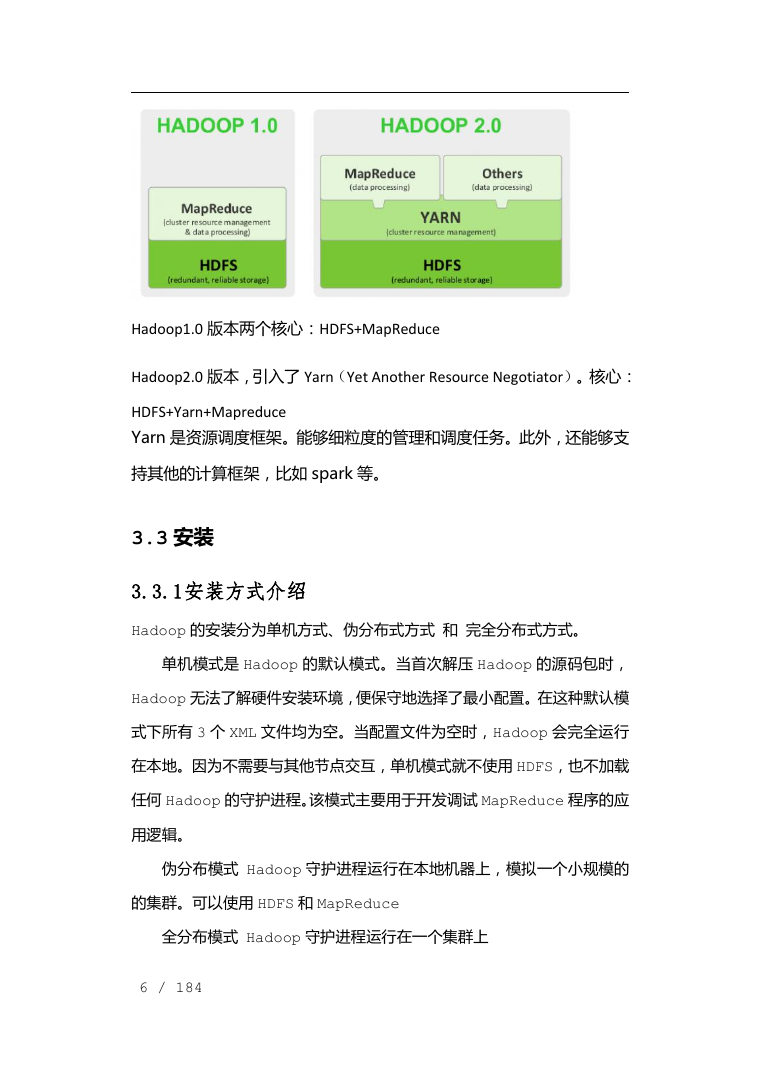

3.2Apache Hadoop版本

3.3安装

3.3.1安装方式介绍

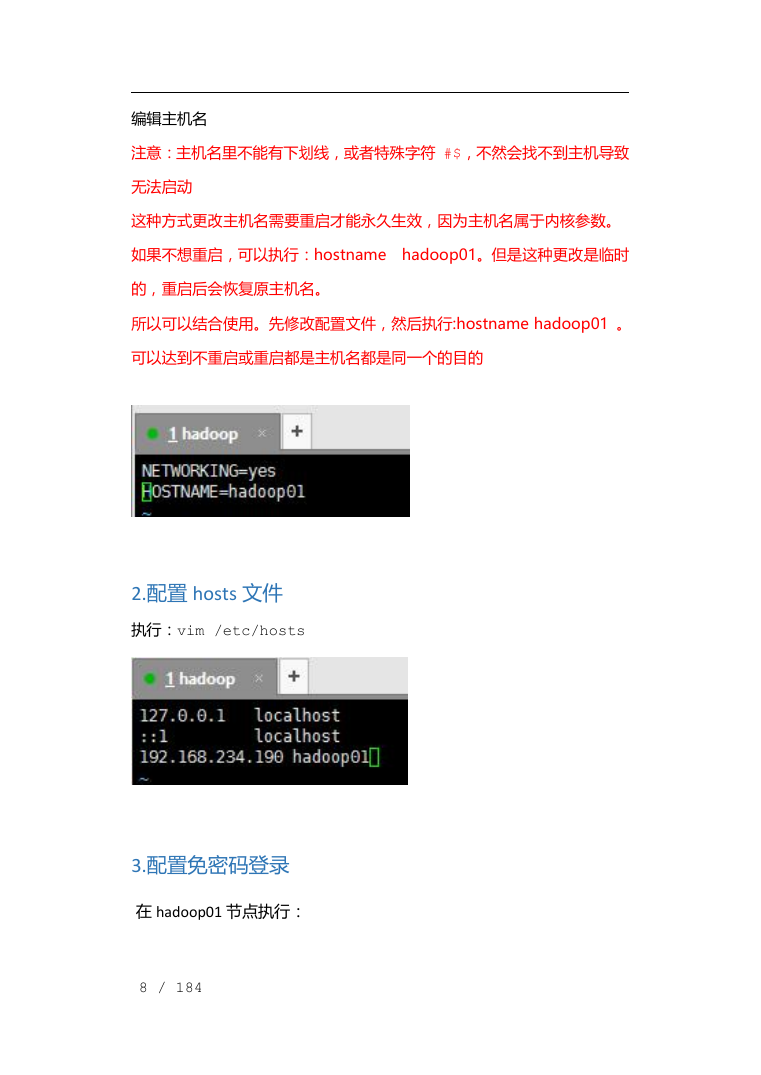

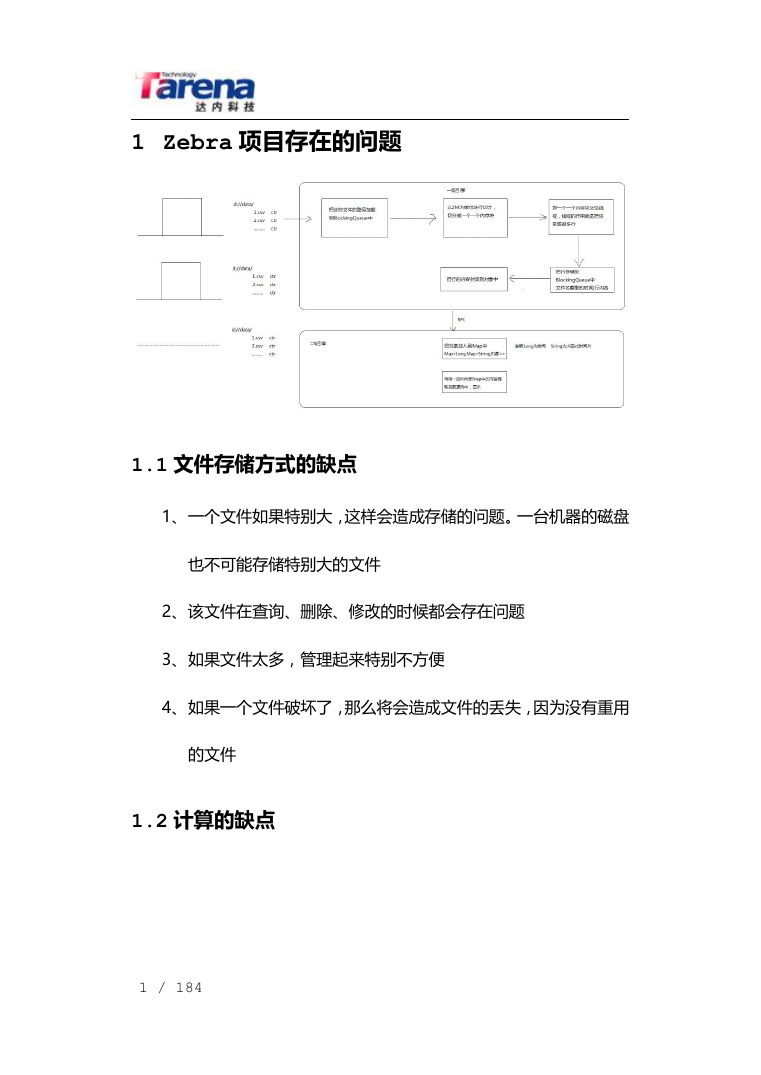

3.3.2伪分布式安装

3.3.3通过浏览器查看管理hadoop

4HDFS的特点

4.1HDFS概述(HDFS架构图):

4.2HDFS优点

4.3HDFS缺点

5HDFS细节说明

5.1Block块概念

5.2NameNode!!!

5.3SecondaryNameNode

5.4DataNode

5.5Block副本放置策略:

6HDFS指令

7HDFS执行流程-day02

7.1HDFS写流程

7.2HDFS读流程图

7.3HDFS的删除流程

7.4安全模式

8HDFS FileSystem JavaAPI

8.1FileSystem流程分析

8.1.1FileSystem读流程分析

8.1.2FileSystem写流程分析

8.2代码实现

8.2.1导入jar包

8.2.2代码开发

8.3Eclipse中Hadoop插件的使用

8.4 插件使用常见问题解决办法

9MapReduce

9.1概述

9.2MapReduce框架的节点组成结构

9.3Map、Reduce的执行步骤

10MapReduce实现单单词统计(WordCount)

10.1案例分析

10.2案例编码实现

10.3通过插件实现WordCount

11常见问题

11.1NullPointerException

11.2控制台无日志输出

11.3Map/Reducelocation status updater".java.lang.NullP

12MR内部执行流程day03

12.1Hadoop1.x的MR执行流程(课后阅读)

12.2Hadoop2.x的MR执行流程

13MR的序列化机制

13.1序列化机制

13.2案例: 统计流量

13.2.1版本一:不使用自定义对象

13.2.2版本二:使用自定义类的对象

14Partitioner -- 分区

14.1分区原理

14.2案例:改造如上统计流量案例,根据不同地区分区存放数据

15sort 排序

15.1原理分析

15.2案例:计算每个人总收益(收入-成本),并按照收益进行排序(文件:profit.txt)

16Combiner -- 合并

16.1合并原理

16.2案例:改造WordCount增加Combiner提高效率

17Shuffle!!!

18Mapper数量

19案例:求最大/小值day04

19.1求文件中数据的最大值/最小值

19.2课后练习:求温度最大值和最小值

20案例:统计考试成绩-按月份产生文件,统计每个人的语数外及总分

20.1案列说明:

20.2代码实现

21案例:zebra实现

22利用sqoop工具导出处理结果到关系型数据库中

23课堂练习day05

23.1课后练习:求平均值

23.1.1案例分析

23.1.2代码实现

23.2案例数据去重

23.2.1数据文件

23.2.2代码实现

24InputFormat

24.1InputFormat概述

24.2常见的InputFormat:

24.3自定义InputFormat

24.4案例1:读取score1.txt文件,从中每4行读取成绩,其中第一行为姓名,后3行为单科成绩,计算总

24.5MultipleInputs

24.6案例2:改造案例1,同时从另一个文件score2.txt中读取数据统计成绩。score2.txt中的

25OutputFormat

25.1常见的OutputFormat:

25.2自定义OutputFormat

25.3案例3:升级wordcount案例,并将输出按照key~value#key1~value1…进行分割

25.3.1原始默认输出版

25.3.2按照指定格式输出版

25.4MultipleOutputs

25.4.1API介绍

25.4.2案例4:改造案例3,将首字母为a-j的输出到"small"中。其他输出到"big"中

25.4.3案例5:升级案例4

26分组GroupingComparator

26.1概述

26.2案例6:改造WordCount案例,实现统计a-n 和 o-z开头的单词数量统计

27Reduce端排序SortComparator

28综合案例7:二次排序

28.1需求描述

28.2方案一

28.3方案二

28.4方案三

29小文件处理

29.1小文件的定义

29.2大量小文件在HDFS中的问题

29.3大量小文件在mapreduce中的问题

29.3.1方法一HadoopJVM重用(课后阅读)

29.3.1.1 Hadoop1.0JVM重用及调优

29.3.1.2Hadoop2.0JVM重用及调优

29.3.2方法二将多个小文件合成一个spilt,即用一个map任务来处理(课后阅读)

30Hadoop常见参数控制+调优策略

31Hadoop2.0 HDFS高可用架构

31.1集群实现思路

31.2集群环境准备

31.3Hadoop集群环境预搭建步骤

31.4具体安装配置步骤:

31.4.1集群节点分配

31.4.2具体安装步骤

31.4.2.1克隆六台虚拟机(jdk,lrzsz),配置固定ip,xshell配置对应的连接

31.4.2.2永久关闭每台机器的防火墙

31.4.2.3为每台机器配置主机名以及hosts文件

31.4.2.4为每天机器配置ssh免秘钥登录

31.4.2.5前三台机器安装和配置zookeeper

31.4.2.6安装和配置01节点的hadoop

31.4.3 测试

31.4.4插件:

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc