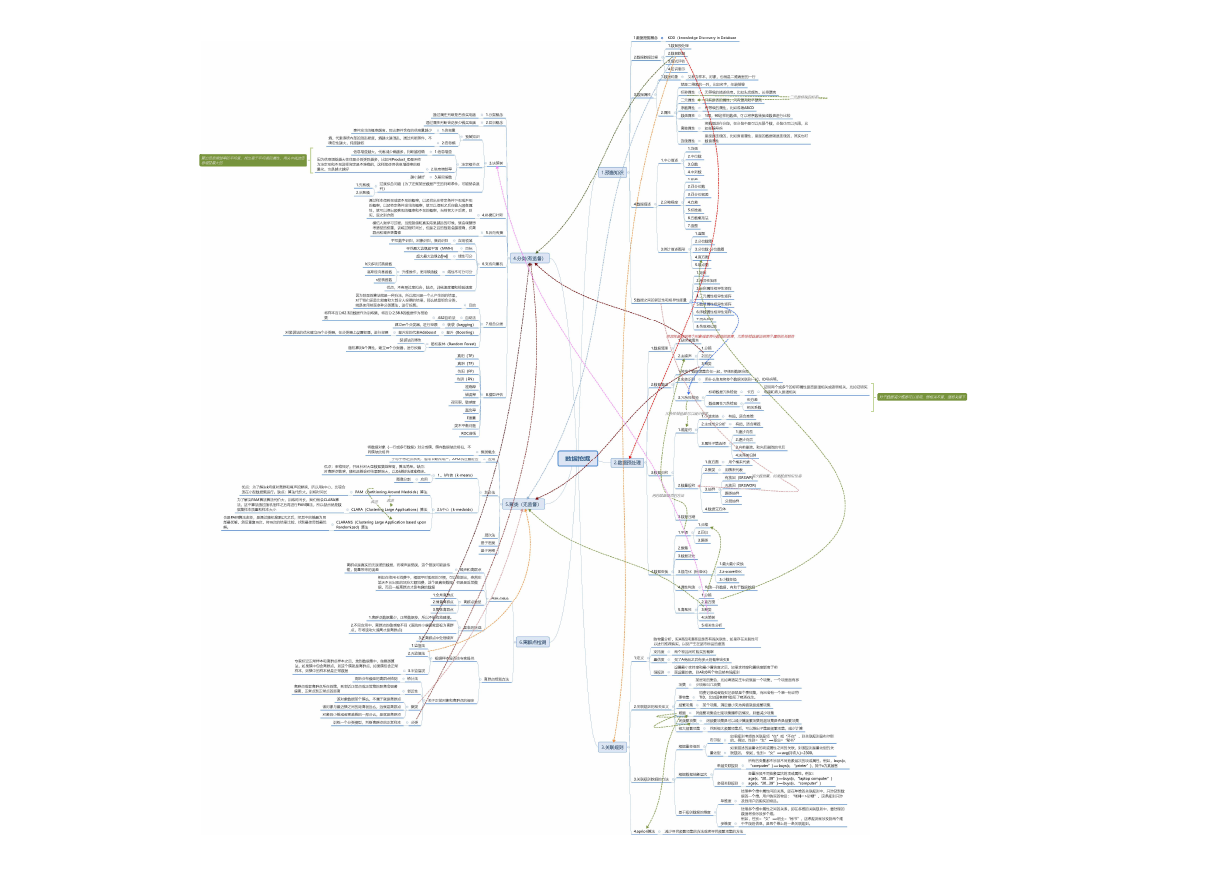

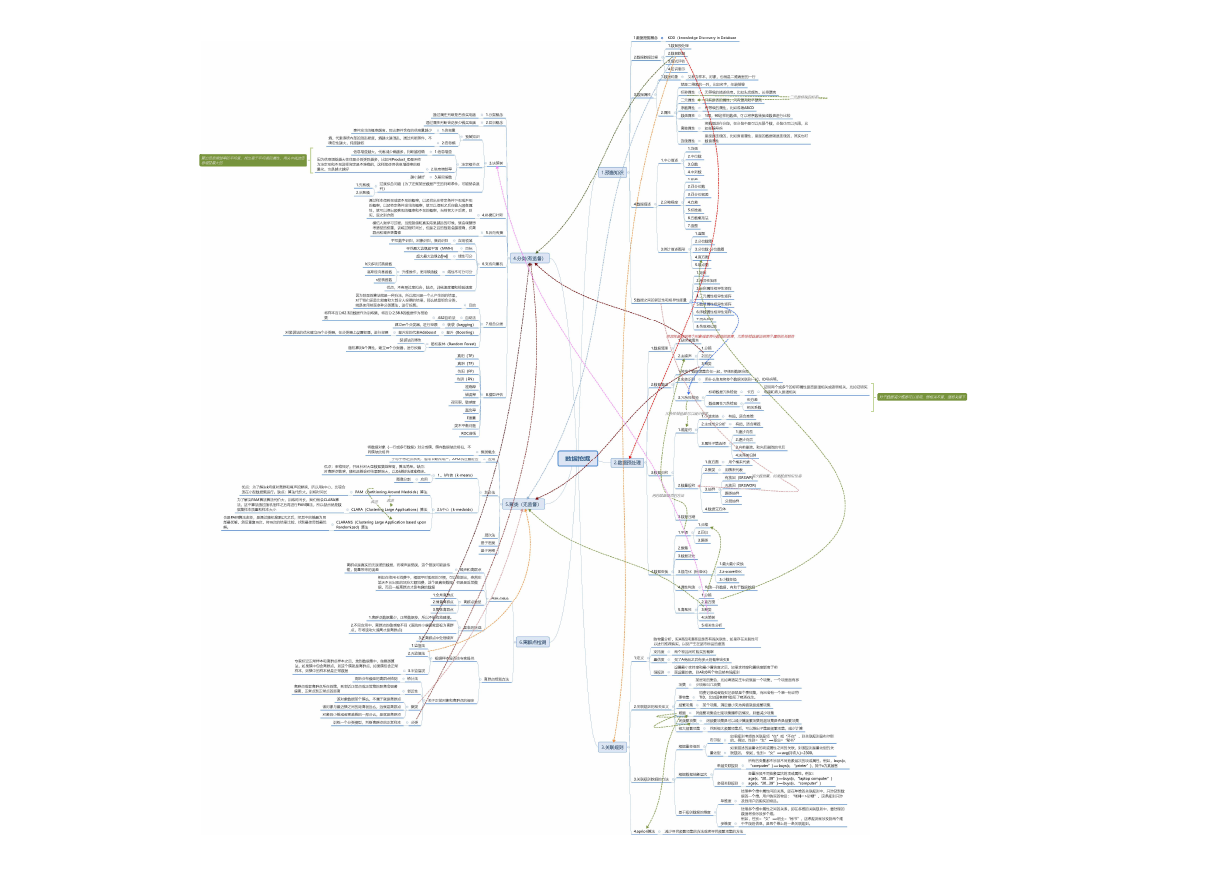

通过属性判断是否会买电脑

1.分类概念

通过属性判断会花多少钱买电脑

2.回归概念

事件发生的概率越高,那么事件含有的信息量越少

1.信息量

熵,代表系统内部的混乱程度,熵越大越混乱,通过判断条件,不

确定性越大,纯度越低

2.信息熵

预备知识

信息增益越大,代表减少熵越多,判断越准确

1.信息增益

因为信息增益越大往往是分的类别越多,比如用Product_ID是用作

为决定买和不买这样肯定是不准确的,这样就使用信息增益率的刚

量化,也是越大越好

2.信息增益率

决定根节点

3.决策树

越小越好

3.基尼指数

1.先剪枝

2.后剪枝

过度拟合问题(为了迁就某些数据产生的判断条件,可能就会误

判)

通过样本得到买或者不买的概率,以及找出在特定条件下买或不买

的概率,以及特定条件发生的概率,就可以得到之后在输入顾客属

性,就可以得出顾客买的概率和不买的概率,当前者大于后者,则

买,反之则亦然

模仿人类学习过程,当预测值和真实结果越远的时候,就会调整思

考路径的权重,训练过程时间长,但是之后的预测会越准确,抗离

群点和噪声更鲁棒

4.朴素贝叶斯

5.后向传播

手写数字识别,对象识别,演说识别

应用领域

寻找最大边缘超平面(MMH)

目标

超大最大边缘2/||w||

线性可分

h次多项式核函数

高斯径向基函数

升维操作,使用核函数

线性不可分可分

s型核函数

优点,不容易过度拟合,缺点,训练速度慢和检验速度

因为前面的算法就是一种方法,所以就只是一个人产生的的结果,

对于我们还是比较喜欢大部分人投票的结果,那么就是组合分类,

就是使用前面多种分类算法,进行投票。

目的

4.分类(有监督)

6.支持向量机

将样本百分62.3的数据作为训练集,将百分之38.8的数据作为检验

集

.632自助法

自助法

建立m个分类器,进行投票

装袋(bagging)

7.组合分类

对装袋法的优化建立m个分类器,在分类器上设置权重,进行投票

提升发的代表Adaboost

提升(Boosting)

随机算则k个属性,建立m个分类器,进行投票

装袋法的修改

随机森林(Random Forest)

真阳(TP)

真阴(TF)

伪阳(FP)

伪阴(FN)

准确率

错误率

召回率,敏感度

真负率

F度量

类不平衡问题

ROC曲线

8.模型评估

层次法

基于密度

基于网格

离群点是真实的无误差的数据,而噪声是错误,这个错误可能是传

输,测量带来的误差

噪声和离群点

例如在信用卡消费中,根据平时购买的习惯,可以检测出,突然在

某天不长出现的地方大额消费,这个是真实数据,但是是反常数

据,而且一般离群点才是有趣的数据

1.全局离群点

2.情景离群点

离群点类型

3.集体离群点

离群点概念

1.离群点数据量少,正常数据多,所以不能有效建模。

2.不同应用中,离群点的敏感度不同(医院对小偏离就是视为离群

点,市场波动大偏离才是离群点)

面临的挑战

3.在离群点中处理噪声

专家标记正常样本和离群点样本之后,放到数据集中,做聚类算

法,如果簇中包含离群点,则这个簇就是离群点,如果簇包含正常

样本,则簇中的样本就是正常数据

1.监督法

2.无监督法

3.半监督发

根据样本是否由专家提供

高斯分布模型的离群点检测

统计法

离群点检测方法

离群点或者离群点所在的簇,到邻近正常点或正常簇的距离会显著

偏离,正常点到正常点的距离

邻近性

该对象数据某个簇么,不属于就是离群点

关于正常对象和离群点的假定

该对象与最近簇之间的距离很远么,远就是离群点

聚类

对象的小簇或者稀疏簇的一部分么,是就是离群点

训练一个分类模型,判断离群点的正常样本

分类

将数据对象(一行或多行数据)划分成簇,簇内数据彼此相似,不

同簇彼此相异

聚类概念

手写字符之别系统,信用卡欺诈用户,ATM机位置定位

应用

优点:伸缩性好,并且针对大型数据集效率高,算法简单。缺点:

对离群点敏感,随机选簇会对结果影响大,以及k簇的k值难确定。

图像分割

应用

1.、k均值(k-means)

数据挖掘

2.数据预处理

3.数据归约

优点:为了解决k均值对离群和噪声的影响,所以用k中心,比较合

适在小型数据集运行。缺点:算法代价大,训练时间长

为了解决PAM算法算法代价大,训练时间长,我们就会CLARA算

法,这中算法通过随机抽样之后再进行PAM算法,所以缺点就是数

据集样本质量和样本大小

PAM(Partitioning Around Medoids)算法

划分法

CLARA(Clustering Large Applications)算法

2.k中心(k-medoids)

5.聚类(无监督)

也是PAM算法改变,是通过随机搜索L次之后,把其中的簇最为局

部最优解,然后重复m次,将m次的结果比较,找到最佳局部最优

解。

CLARANS(Clustering Large Application based upon

Randomized)算法

1.数据挖掘概念

KDD(knowledge Discovery in Database

2.数据挖掘过程

1.数据预处理

2.数据挖掘

3.模式评估

4.知识表示

1.数据对象

又称为样本,对象,也就是二维表里的一行

就是二维表的一列,比如名字,年龄等等

3.数据属性

标称属性

无等级的描述信息,比如头发颜色,长得漂亮

2.属性

1.中心描述

1.预备知识

二元属性

序数属性

数值属性

离散属性

连续属性

只有是否的属性,只有漂亮和不漂亮

有等级的属性,比如成绩ABCD

100,90这样的数值,可以将序数转换成数值进行比较

将数据进行分段,在分段中是可以无限个数,分段也可以无限,比

如邮编号码

里面是连续的,比如身高属性,里面的数据就是连续的,其实也时

数值属性

1.均值

2.中位数

3.众数

4.中列数

1.极差

2.四分位数

3.四分位极差

4.数据描述

2.分散程度

4.方差

5.标准差

6.五数概括法

7.盒图

1.盒图

2.分位数图

3.统计描述图形

3.分位数-分位数图

5.数据之间的邻近性和相异性度量

4.直方图

5.散点图

1.矩阵

2.相异性矩阵

3.标称属性相异性矩阵

4.二元属性相异性矩阵

5.数值属性相异性矩阵

6.序数属性相异性矩阵

7.混合矩阵

8.余弦相似性

1.数据清理

2.数据集成

1.缺失值填充

2.去噪声

1.分箱

2.回归

3.聚类

1.将多个数据源集合在一起,存储到数据仓库

2.实体识别

用什么信息将多个数据关联到一起,ID号码等。

标称数据冗余检验

卡方

证明两个或多个的标称属性是否是强相关或者弱相关,比如证明买

电脑和收入是强相关

3.冗余性检验

1.维规约

数值属性冗余检验

协方差

相关系数

1.小波变换

有损,适合高维

2.主成成分分析

有损,适合稀疏

3.属性子集选择

1.逐步向前

2.逐步向后

3.向前删除,和向后删除的节后

4.决策树归纳

1.直方图

用个桶来代表

2.聚类

用簇来代表

2.数量规约

3.抽样

有放回(SRSWR)

无放回(SRSWOR)

聚类抽样

分层抽样

4.数据立方体

1.分箱

2.回归

3.聚类

3.数据压缩

1.平滑

2.聚集

3.数据泛化

4.数据变换

3.规范化(标准化)

2.z-score变化

1.最大最小变换

3.小数变换

4.属性构造

构造一列数据,有助于数据挖掘

1.分箱

2.直方图

5.离散性

3.聚类

4.决策树

5.相关性分析

6.离群点检测

购物量分析,买A商品和B商品是否有强关联性,如果存在关联性可

以进行推荐购买,以及产生在超市物品的摆放

1.定义

支持度

置信度

强规则

两个物品同时购买的概率

买了A商品之后有多大的概率会买B

设置最小支持度和最小置信度之后,如果支持度和置信度能高于前

面设置的值,则A和B两个物品就有强规则

项集

事物集

某些项的集合,比如啤酒花生牛奶就是一个项集,一个项里面有多

少项就叫几项集

消费记录或者购买记录就是个事物集,而且会有一个唯一标识符

TID,比如顾客001购买了啤酒花生。

2.关联规则的相关定义

频繁项集

某个项集,满足最小支持阈值就是频繁项集

难题

找频繁项集会出现项集爆炸的情况,则要减少项集

闭频繁项集

闭频繁项集是可以减少算频繁项集的超项集是否是频繁项集

极大频繁项集

找到极大频繁项集后,可以推出子集是频繁项集,减少计算

3.关联规则

根据量变级别

布尔型

量化型

如果规则考虑的关联是项“在”或“不在”,则关联规则是布尔型

的。例如,性别=“女”⟹职业=“秘书”

如果描述的是量化的项或属性之间的关联,则该规则是量化型的关

联规则。 例如,性别=“女”⟹avg(月收入)=2300。

单层关联规则

所有的变量都不涉及不同抽象层次的项或属性。例如,buys(x,

“computer”) ⟹buys(x, “printer”),其中x为某顾客

3.关联规则挖掘的方法

根据数据抽象层次

多层关联规则

变量涉及不同抽象层次的项或属性。例如:

age(x,“30…39”)⟹buys(x, “laptop computer”)

age(x,“30…39”)⟹buys(x, “computer”)

基于规则数据的维度

处理单个维中属性间的关系,即在单维的关联规则中,只涉及到数

据的一个维。用户购买的物品:“咖啡=>砂糖”,这条规则只涉

及到用户的购买的物品。

处理多个维中属性之间的关系,即在多维的关联规则中,要处理的

数据将会涉及多个维。

例如,性别=“女”⟹职业=“秘书”,这条规则就涉及到两个维

中字段的信息,是两个维上的一条关联规则。

单维度

多维度

4.apriori算法

减少寻找频繁项集的方法或者寻找频繁项集的方法

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc