第43卷 第5期

2020年5月

计 算 机 学 报

CHINESEJOURNALOFCOMPUTERS

Vol.43No.5

May2020

图卷积神经网络综述

徐冰冰1),2),3) 岑科廷1),2),3) 黄俊杰1),2),3) 沈华伟1),2) 程学旗1),2)

1)(中国科学院网络数据科学与技术重点实验室 北京 100190)

2)(中国科学院计算技术研究所 北京 100190)

3)(中国科学院大学 北京 100049)

摘 要 过去几年,卷积神经网络因其强大的建模能力引起广泛关注,在自然语言处理、图像识别等领域成功应

用.然而,传统的卷积神经网络只能处理欧氏空间数据,而现实生活中的许多场景,如交通网络、社交网络、引用网

络等,都是以图数据的形式存在.将卷积神经网络迁移到图数据分析处理中的核心在于图卷积算子的构建和图池

化算子的构建.本文对图卷积神经网络进行综述,首先介绍了图卷积神经网络的背景并梳理了两类经典方法———

谱方法和空间方法.针对图数据上平移不变性的缺失给图卷积算子的定义带来的困难,谱方法借助卷积定理在谱

域定义图卷积,而空间方法通过在节点域定义节点相关性来实现图卷积.进而,本文介绍了图卷积神经网络的最新

进展,这其中包括如何利用图卷积神经网络建模图上的复杂信息,如异质连接、高阶连接等,以及如何在大规模图

上实现图卷积神经网络;此外,本文介绍了图卷积神经网络的相关应用,包括推荐系统领域、交通预测领域等;最后

本文对图卷积神经网络的发展趋势进行了总结和展望.

关键词 图卷积神经网络;卷积;池化;非欧空间

中图法分类号TP18 犇犗犐号10.11897/SP.J.1016.2020.00755

犃犛狌狉狏犲狔狅狀犌狉犪狆犺犆狅狀狏狅犾狌狋犻狅狀犪犾犖犲狌狉犪犾犖犲狋狑狅狉犽

XUBingBing1),2),3)CENKeTing1),2),3)HUANGJunJie1),2),3)

SHENHuaWei1),2)CHENGXueQi1),2)

1)(犓犲狔犔犪犫狅狉犪狋狅狉狔狅犳犖犲狋狑狅狉犽犇犪狋犪犛犮犻犲狀犮犲犪狀犱犜犲犮犺狀狅犾狅犵狔,犆犺犻狀犲狊犲犃犮犪犱犲犿狔狅犳犛犮犻犲狀犮犲狊,犅犲犻犼犻狀犵 100190)

2)(犐狀狊狋犻狋狌狋犲狅犳犆狅犿狆狌狋犻狀犵犜犲犮犺狀狅犾狅犵狔,犆犺犻狀犲狊犲犃犮犪犱犲犿狔狅犳犛犮犻犲狀犮犲狊,犅犲犻犼犻狀犵 100190)

3)(犝狀犻狏犲狉狊犻狋狔狅犳犆犺犻狀犲狊犲犃犮犪犱犲犿狔狅犳犛犮犻犲狀犮犲狊,犅犲犻犼犻狀犵 100049)

犃犫狊狋狉犪犮狋 Inthepastfewyears,convolutionalneuralnetworkhasattractedwidespreadattention

duetoitspowerfulmodelingcapabilities,andhasachievedgreatimprovementinareassuchas

naturallanguageprocessingandcomputervision.Traditionalconvolutionalneuralnetworkcan

onlyprocessEuclideandata.However,manyreallifescenarios,suchastransportationnetworks,

socialnetworksandcitationnetworks,arelocatedintheformofgraphdata.Themethodused

toprocessgraphdatapreviouslyisnetworkembedding.Specifically,theresearchersmodelthe

graphbasedmissionintoatwostagemodel.Inthefirststage,afixedlengthrepresentationis

learnedforeachnodeviacapturingtheproximityovernodes,thisrepresentationisfedintothe

secondstagetosolvedownstreamtasks,e.g.,linkprediction,nodeclassificationandgraph

classification.Inrecentyears,thepowerfulmodelingcapabilitiesofconvolutionalneuralnetwork

收稿日期:20190506;在线出版日期:20191104.本课题得到国家自然科学基金项目(61425016,91746301)、北京智源人工智能研究院

和王宽诚教育基金会资助.徐冰冰,博士研究生,中国计算机学会(CCF)学生会员,主要研究方向为图神经网络、图上半监督学习.E

mail:xubingbing@ict.ac.cn.岑科廷(共同第一作者),博士研究生,中国计算机学会(CCF)学生会员,主要研究方向为网络表示学习、图

神经网络.Email:cenketing@ict.ac.cn.黄俊杰(共同第一作者),硕士研究生,主要研究方向为社会媒体计算、图神经网络.Email:

huangjunjie17s@ict.ac.cn.沈华伟(通信作者),博士,研究员,中国计算机学会(CCF)高级会员,主要研究领域为社交网络分析和社会媒

体计算.Email:shenhuawei@ict.ac.cn.程学旗,博士,研究员,中国计算机学会(CCF)会士,主要研究领域为大数据分析与挖掘、网络科

学、网络信息安全以及互联网搜索与数据挖掘.

《 计 算 机 学 报 》�

657

计 算 机 学 报

2020年

andtheubiquityofgraphdatahaveinspiredresearcherstotransferconvolutionalneuralnetwork

tographs,whichcansolvethegraphbasedtaskviaanendtoendmanner.Thecoreofgraph

convolutionalneuralnetworkistheconstructionofgraphconvolutionoperatorandpoolingoperator.

Inthispaper,wereviewthegraphconvolutionalneuralnetwork.Firstly,thebackgroundof

graphconvolutionalneuralnetworkanditsclassicalmethodsareintroduced,includingspectral

methodsandspatialmethods.Thelackoftranslationinvarianceonthegraphdatamakesitdifficult

todefinethegraphconvolutionoperator.Thespectralmethodsdefinetheconvolutioninthespectral

domainviatheconvolutiontheorem,whilethespatialmethodsimplementthegraphconvolution

bydefiningthenodecorrelationinthenodedomain.Then,thelatestdevelopmentsareintroduced.

Recentresearchersfocusonhowtomodelthecomplicatedinformationongraphviagraph

convolutionneuralnetwork,e.g.,heterogeneousconnectionandhighorderconnection.In

addition,howtoconstructgraphconvolutionneuralnetworkonlargescalenetworkalsoattracts

muchattention.Moreover,weconcludethegraphconvolutionneuralnetworkinmanyapplications,

includingtrafficpredictionandrecommendersystem.Finally,thedevelopingtrendofgraph

convolutionalneuralnetworkissummarizedandforecasted.

犓犲狔狑狅狉犱狊 graphconvolutionalneuralnetwork;convolution;pooling;nonEuclideanspace

1 引 言

过去几年,卷积神经网络[12]快速发展,并借由

其强大的建模能力引起广泛关注.相比传统方法,卷

积神经网络的引入给图像处理[3]和自然语言处理等

领域带来了很大的提升,如机器翻译[4]、图像识别[5]

和语音识别[6]等.但是,传统的卷积神经网络只能处

理欧氏空间数据(如图像、文本和语音),这些领域的

数据具有平移不变性.平移不变性使得我们可以在

输入数据空间定义全局共享的卷积核,从而定义卷

积神经网络.以图像数据为例,一张图片可以表示为

欧氏空间中一组规则散布的像素点,平移不变性则

表示以任意像素点为中心,可以获取相同尺寸的局

部结构.基于此,卷积神经网络通过学习在每个像素

点共享的卷积核来建模局部连接,进而为图片学习

到意义丰富的隐层表示.

尽管传统的卷积神经网络在文本和图像领域带

来提升,但是它仅能处理欧氏空间数据.而同时,一

种非欧空间数据:图数据,因其普遍存在性逐渐受到

关注.图数据可以自然的表达实际生活中的数据结

构,如交通网络、万维网和社交网络等.不同于图像

和文本数据,图数据中每个节点的局部结构各异,这

使得平移不变性不再满足[7].平移不变性的缺失给

在图数据上定义卷积神经网络提出了挑战.

近年来,由于图数据的普遍存在性,研究人员开

始关注如何在图上构造深度学习模型.借助于卷积

神经网络对局部结构的建模能力及图上普遍存在的

节点依赖关系,图卷积神经网络成为其中最活跃最

重要的一支.近期陆续涌现出一些文章探索图上深

度学习并对其进行综述[89],但是针对其中最重要的

分支,图卷积神经网络,其建模方法和应用方面的深

入探讨和总结仍为空白.对此,我们在本篇文章中深

入整理总结了图卷积神经网络的发展历程及其未来

趋势.

图卷积神经网络的构建所面临的挑战主要来源

于以下几个方面:

(1)图数据是非欧空间数据

图数据作为非欧空间数据,不满足平移不变性,

即每个节点具有各异的局部结构.而传统卷积神经

网络中的基本算子:卷积和池化,依赖于数据的平移

不变性.此时如何在图数据上定义卷积和池化算子

成为一个有挑战的工作.

(2)图数据具有多样的特性

实际生活中的多种应用都可以用图数据自然的

表示,这使得图数据具有多样的特性,如社交网络中

用户的有向连接,引文网络中作者和引文的异质连

接,政治关系网络中的正负倾向带符号连接等.多样

的图特性给图卷积神经网络的构建带来更多信息,

但是多种特性的建模也要求图卷积神经网络的设计

更加复杂精细,给图卷积神经网络带来新的挑战.

(3)图数据的规模很大

《 计 算 机 学 报 》�

5期

徐冰冰等:图卷积神经网络综述

757

在大数据时代,实际应用中的图可能规模极大,

含有百万甚至千万级别的节点,如推荐系统中的用

户商品网络,社交网络中的用户网络.如何在时间和

空间可接受范围内在大规模图上构建图卷积神经网

络也是非常大的挑战.

11 现有方法及分类

图数据建模的历史由来已久.起初,研究人员关

注统计分析的方法,这个时期没有机器学习模型的参

与,如网页排序的常用算法PageRank[10]、HITS[11]

等.此外,研究人员也借用图谱理论的知识,如用拉

普拉斯矩阵的特征值和特征向量做社区分析或者人

群聚类[12]等.随着深度学习的崛起,研究人员开始

考虑把深度学习的模型引入到图数据中,代表性的

研究工作是网络嵌入(NetworkEmbedding)[13],即

通过约束节点的邻近性为每个节点学习固定长度的

表达,如DeepWalk[14]、LINE[15]、node2vec[16]等.这

一时期,在解决具体的应用问题时,研究人员通常将

其建模为两阶段问题,以节点分类为例,第一阶段为

每个节点学习统一长度的表达,第二阶段将节点表

达作为输入,训练分类模型.近年来,研究人员对图

数据建模的关注逐渐转移到如何将深度学习的模型

迁移到图数据上,进行端到端的建模,而图卷积神经

网络则是其中最活跃的一支.

在建模图卷积神经网络时,研究人员关注如何

在图上构建卷积算子.Bruna等人[17]在2013年提出

第一个图卷积神经网络,他们基于图谱理论从卷积

定理出发,在谱空间定义图卷积.这一支后来发展为

图卷积领域的谱方法.最初的谱方法具有时空复杂

度较高的弊端,ChebNet[18]和GCN[19]对谱方法中

的卷积核进行参数化,大大降低了时空复杂度.这两

个方法虽然被归为谱方法,但已经开始从空间角度

定义节点的权重矩阵.在这两个方法的启发下,空间

方法应用而生,开始考虑在节点域用注意力机制、序

列化模型等建模节点间的权重.这一时期的图卷积

神经网络在构建卷积算子过程中没有过多的考虑图

特性,随着卷积算子的逐渐完善,人们开始考虑多样

的图特性,如开始关注如何建模图上的高阶信息,并

分别针对边上带特征的图、异质图等进行精细设计.

此外,如何训练更高效的图卷积神经网络也受到广

泛关注.研究人员开始试图训练更深层的图卷积神

经网络,以增强模型的泛化能力.同时,模型到大规

模图的可扩展性以及训练的速度也是图卷积神经网

络中非常重点的研究方向.表1展示了图卷积神经

网络的主要方法.

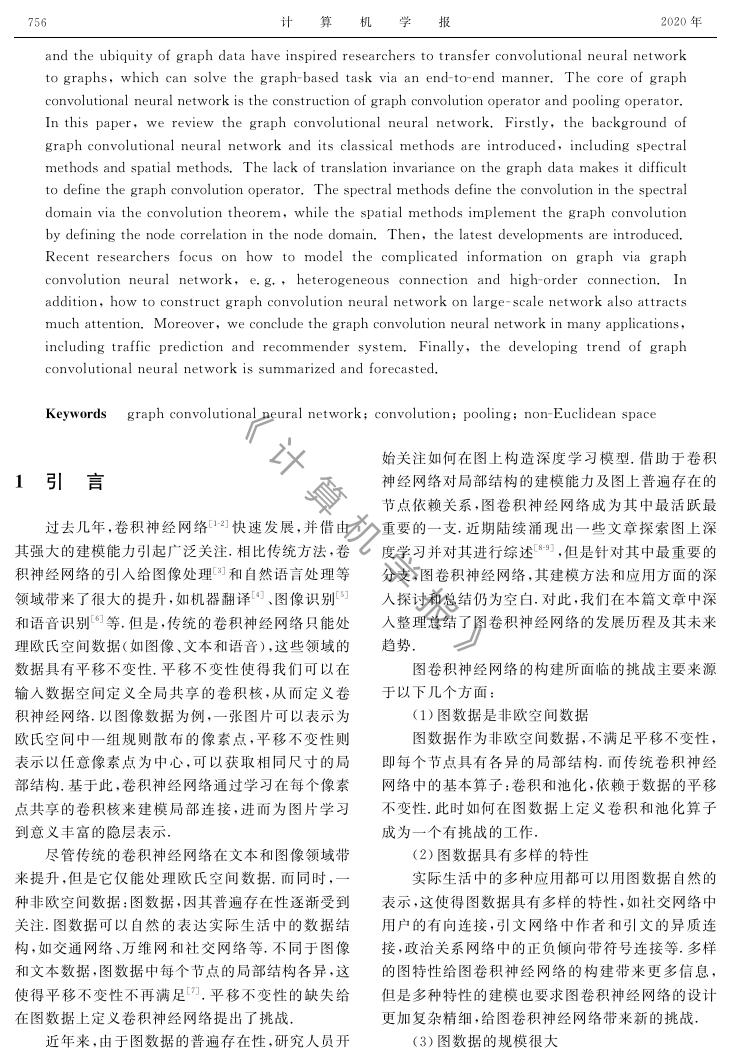

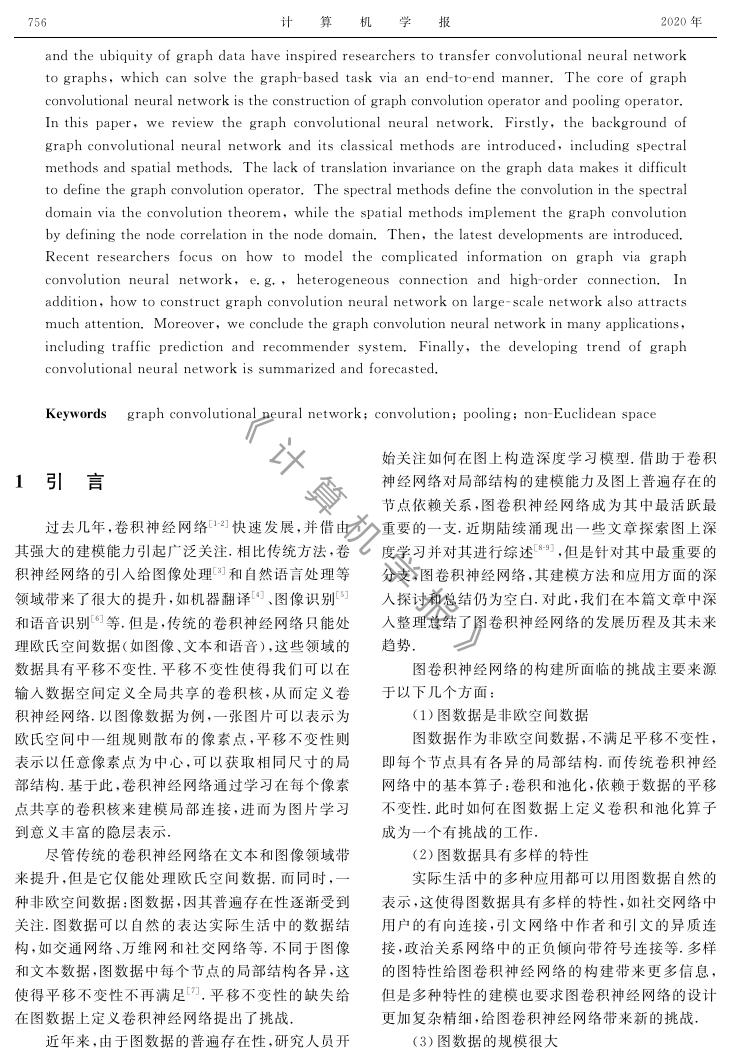

表1 图卷积神经网络的主要方法

相关论文

方法

基于卷积定理的图卷积神经网络SpectralCNN[17],ChebyNet[18],GCN[19],Henaff等人[20],GWNN[21],GraphHeat[22],

基于聚合函数的图卷积神经网络MoNet[25],MPNNs[26],GNNs[27],GAT[28],GraphSAGE[29],DCNN[30],ConfGCN[31],

建模边上信息的图卷积神经网络RGCNs[33],RGAT[34],SGCN[35],DPGCNN[36],EGAT[37],ECC[38]

建模高阶信息的图卷积神经网络HAGCN[39],MotifCNN[40],HAN[41],MCN[42],MotifNet[43]

深层图卷积神经网络

大规模图卷积神经网络 GraphSAGE[29],PinSage[46],ControlVariateBasedAlgorithm(CV)[47],FastGCN[48],Adapt[49]

JumpingKnowledgeNetwork[44],CoTrain[45]

PPNP[23],SPC[24]

HGNN[32]

关注领域

关注卷积

算子构建

关注图上复杂

信息建模

关注训练

过程优化

池化算子作为卷积神经网络的主要组成部分,

作用是扩大感受野,降低参数.近期,也有研究开始

关注图上池化算子的构建.图上池化算子主要用于

图分类问题,目的是学习到图的层级结构.

12 任务

图数据建模所针对的应用场景非常广泛,这也

使得图数据建模所处理的任务多样.我们将下游任

务分为节点级别的任务和图级别的任务,节点级别

的任务包括节点分类,链接预测等,如引文网络中的

文章分类,推荐系统中用户对商品的偏好推断.图级

别的任务包括图生成,图分类等,如药物网络生成,

蛋白质网络中的蛋白质分类.

13 章节组织

本文第2节给定全文的符号定义;第3节回顾

初期图卷积网络中卷积算子和池化算子的定义,其

中卷积算子定义部分又包括了空间方法和谱方法;

第4节主要关注图卷积神经网络的一些新进展,包

括图特性建模和训练优化两个部分;第5节我们详

细介绍了图卷积神经网络在现有各种典型应用下图

的构造及卷积的定义;在第6节和第7节中,我们给

出图卷积神经网络的未来发展展望,并总结全文.

2 符号定义

在这一节中,我们给出文中常见符号的定义.

《 计 算 机 学 报 》�

计 算 机 学 报

2020年

方法.现有的图卷积神经网络分为谱方法和空间方

法两类,谱方法利用图上卷积定理从谱域定义图卷

积,而空间方法从节点域出发,通过定义聚合函数来

聚合每个中心节点和其邻近节点.

3.1.1 图卷积神经网络谱方法

图上平移不变性的缺失,给在节点域定义卷积

神经网络带来困难.谱方法利用卷积定理从谱域定

义图卷积.我们首先给出卷积定理的背景知识.

857

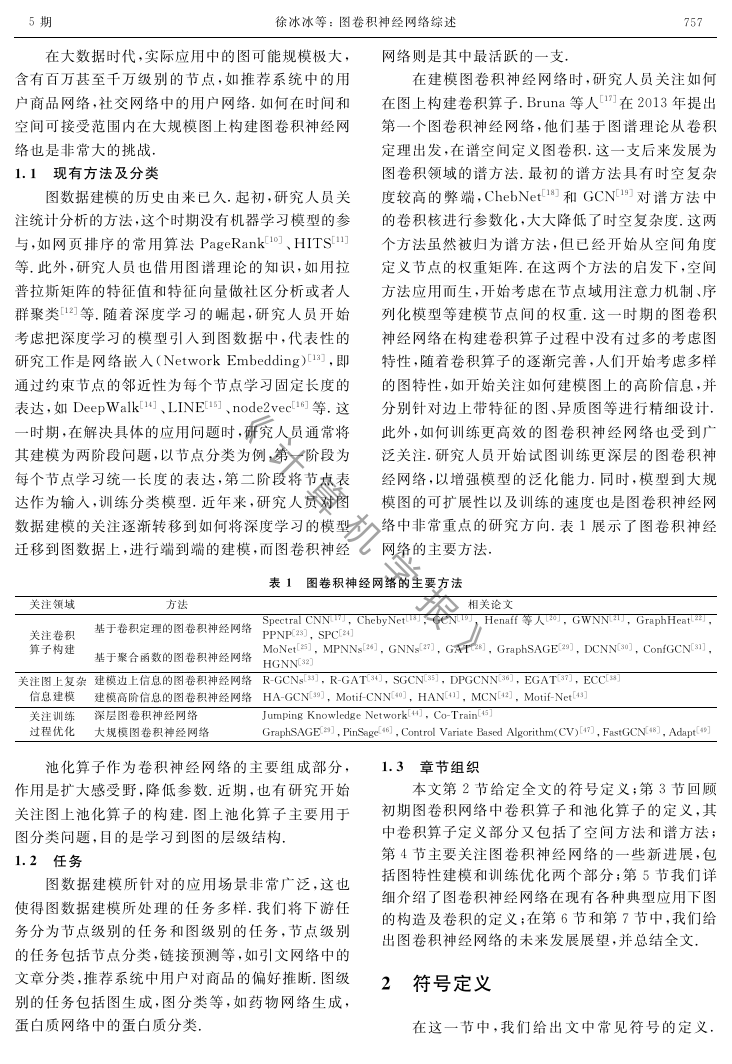

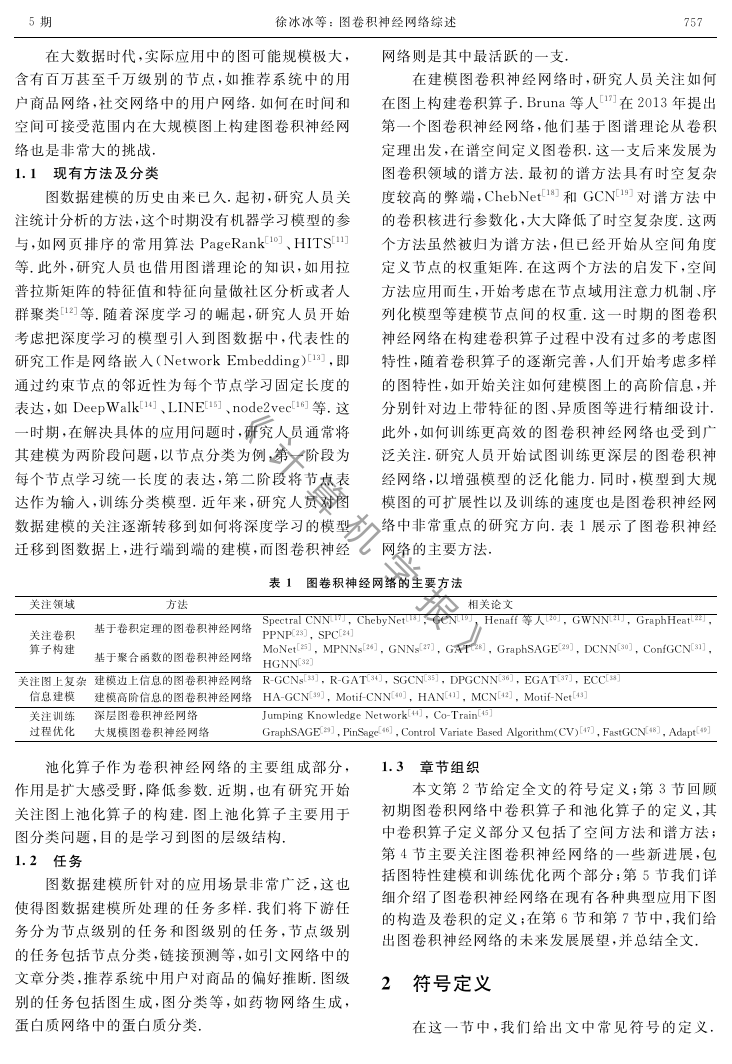

表2展示了每种符号的代表含义.

表示含义

表2 符号定义

图

节点集合

连边集合

节点个数

单位阵

邻接矩阵

度矩阵(对角阵)

拉普拉斯矩阵

特征向量矩阵

特征值矩阵(对角阵)

第犻个特征向量

节点特征矩阵

第犻个节点的特征

信号

符号

犌

犞

犈

狀

犐狀∈犚狀×狀

犃∈犚狀×狀

犇∈犚狀×狀

犔∈犚狀×狀

犝∈犚狀×狀

Λ∈犚狀×狀

狌犻∈犚狀

犡∈犚狀×犇

犡犻∈犚犇

犳∈犚狀

我们用犌={犞,犈,犃}表示无向图,其中犞表示

节点集合,|犞|=狀表示图上共有狀个节点,犈表示

边集合,犃表示邻接矩阵,定义节点之间的相互连

接,且在无向图中犃犻,犼=犃犼,犻.犔=犇-犃表示图上的

拉普拉斯矩阵,其中犇是一个对角阵,犇犻,犻表示第犻

个节点的度且犇犻,犻=∑犼

犃犻,犼.归一化后的拉普拉斯矩

2,其中犐狀∈犚狀×狀是单位

阵定义为犔=犐狀-犇-1

2犃犇-1

阵.因为犔是一个实对称矩阵,对犔做特征分解得

到犔=犝Λ犝T.其中犝={狌犻}狀

犻=1表示狀个相互正交的

特征向量.Λ=diag({λ犻}狀

犻=1)是一个对角阵,λ犻表示

狌犻对应的特征值.

我们用犡表示图犌上的节点特征,其中犡∈

犚狀×犇,犡犻∈犚犇是第犻节点的特征,犡犻犼表示矩阵犡的

第犻行第犼列,即第犻节点的第犼个特征.犳,狓,狔∈

犚狀表示图上的信号,其中犳犻表示节点犻在信号犳上

的取值.

3 图卷积神经网络

图卷积神经网络主要包括卷积算子和池化算子

的构建,其中卷积算子的目的是刻画节点的局部结

构,而池化算子的目的是学到网络的层级化表示,降

低参数.在解决节点级别的任务时,研究人员更关注

如何给每个节点学到更好的表达,此时池化算子并

不必要,因此前期大量的工作仅关注图上卷积算子

的构建,而池化算子通常用在图级别的任务上.在这

一章节中,我们将详细介绍图上卷积算子和池化算

子的构建.

31 图卷积算子的构建

本节介绍关注卷积算子构建的图卷积神经网络

(1)图信号处理

卷积定理:信号卷积的傅立叶变换等价于信号

傅立叶变换的乘积[7]:

犉(犳×犵)=犉(犳)·犉(犵) (1)

其中,犳,犵表示两个原始信号,犉(犳)表示犳的傅立

叶变换,·表示乘积算子,表示卷积算子.对式(1)

两端做傅立叶逆变换,可以得到

犳犵=犉-1(犉(犳)·犉(犵)) (2)

其中,犉-1(犳)表示信号犳的傅立叶逆变换.

利用卷积定理,我们可以对谱空间的信号做乘

法,再利用傅里叶逆变换将信号转换到原空间来实

现图卷积,从而避免了因图数据不满足平移不变性

而造成的卷积定义困难问题.图上傅立叶变换依赖

于图上的拉普拉斯矩阵,在下文中,我们将给出图上

傅立叶变换的定义.

图上傅立叶变换的定义依赖于拉普拉斯矩阵的

特征向量.以特征向量作为谱空间下的一组基底,图

上信号狓的傅立叶变换为

(3)

其中,狓指信号在节点域的原始表示.狓^指信号狓变

换到谱域后的表示,犝T表示特征向量矩阵的转置,

用于做傅立叶变换.信号狓的傅立叶逆变换为

(4)

利用图上傅立叶变换和逆变换,我们可以基于卷积

定理实现图卷积算子

狓犌狔=犝((犝T狓)⊙(犝T狔)) (5)

其中,犌表示图卷积算子,狓,狔表示图上节点域的信

号,⊙指哈达玛乘法,表示两个向量的对应元素相

乘.我们用一个对角阵犵θ代替向量犝T狔,那么哈达玛

乘法可以转化成矩阵乘法.将卷积核犵θ作用在信号

上,图卷积可以表示成如下形式

(6)

犝犵θ犝T狓

卷积定理提供了通过傅立叶变换在图上定义卷

积的方式.基于此卷积算子的定义,国内外陆续涌现

出一些图卷积神经网络.

狓^=犝T狓

狓=犝狓^

(2)基于卷积定理的图卷积神经网络

谱卷积神经网络(SpectralCNN)[17]是最早提

《 计 算 机 学 报 》�

徐冰冰等:图卷积神经网络综述

957

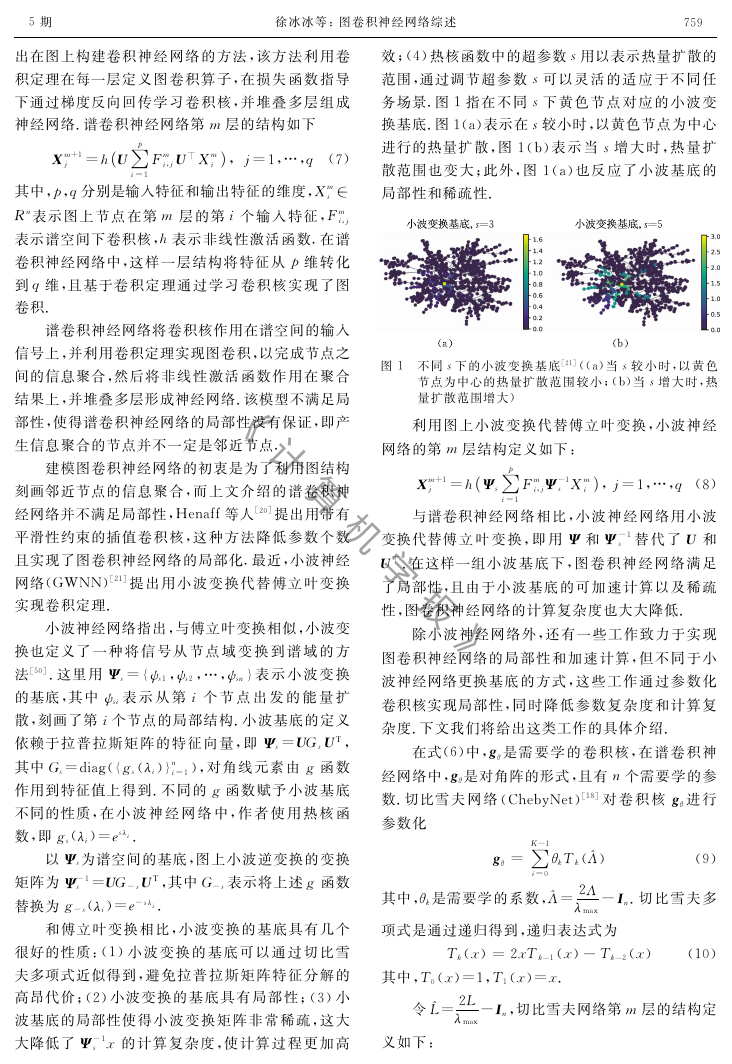

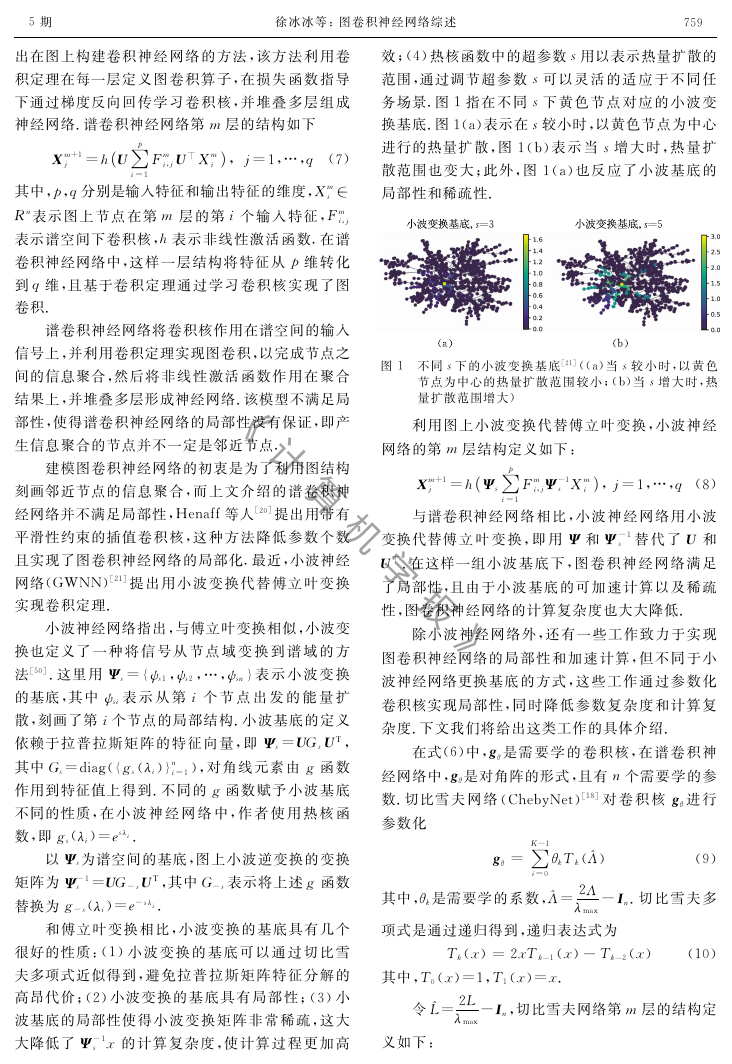

效;(4)热核函数中的超参数狊用以表示热量扩散的

范围,通过调节超参数狊可以灵活的适应于不同任

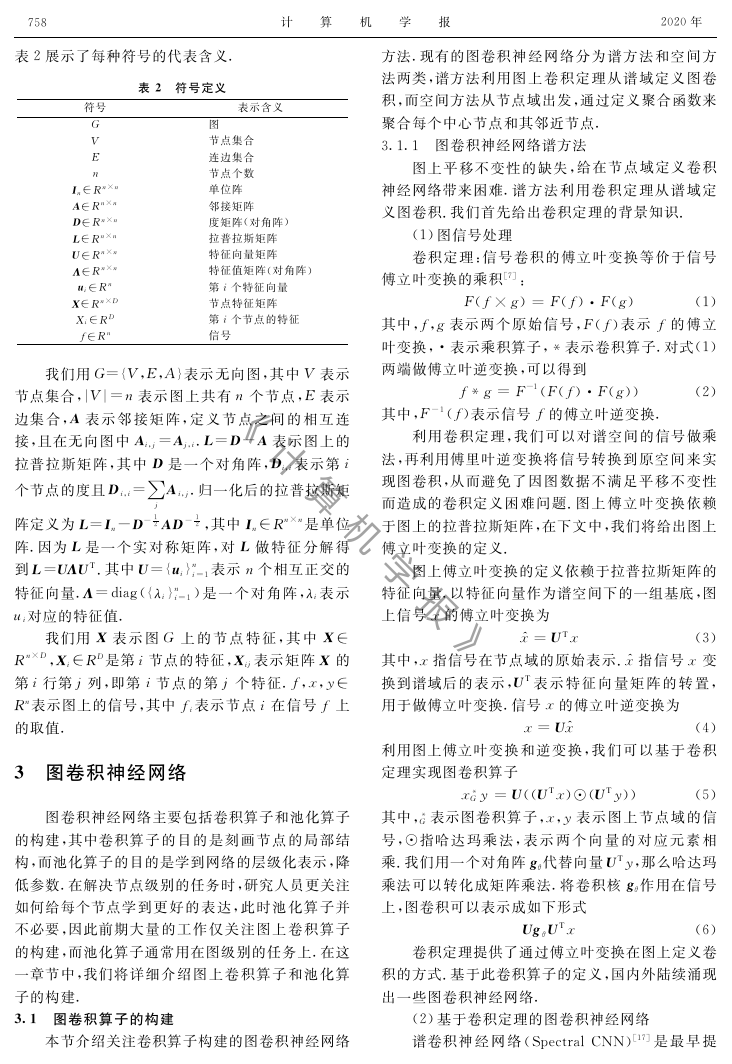

务场景.图1指在不同狊下黄色节点对应的小波变

换基底.图1(a)表示在狊较小时,以黄色节点为中心

进行的热量扩散,图1(b)表示当狊增大时,热量扩

散范围也变大;此外,图1(a)也反应了小波基底的

局部性和稀疏性.

犻=1

(

犼 =犺犝∑狆

犉犿

犡犿+1

犻,犼犝⊥犡犿

5期

出在图上构建卷积神经网络的方法,该方法利用卷

积定理在每一层定义图卷积算子,在损失函数指导

下通过梯度反向回传学习卷积核,并堆叠多层组成

神经网络.谱卷积神经网络第犿层的结构如下

)犻,犼=1,…,狇(7)

其中,狆,狇分别是输入特征和输出特征的维度,犡犿

犻∈

犚狀表示图上节点在第犿层的第犻个输入特征,犉犿

犻,犼

表示谱空间下卷积核,犺表示非线性激活函数.在谱

卷积神经网络中,这样一层结构将特征从狆维转化

到狇维,且基于卷积定理通过学习卷积核实现了图

卷积.

谱卷积神经网络将卷积核作用在谱空间的输入

信号上,并利用卷积定理实现图卷积,以完成节点之

间的信息聚合,然后将非线性激活函数作用在聚合

结果上,并堆叠多层形成神经网络.该模型不满足局

部性,使得谱卷积神经网络的局部性没有保证,即产

生信息聚合的节点并不一定是邻近节点.

建模图卷积神经网络的初衷是为了利用图结构

刻画邻近节点的信息聚合,而上文介绍的谱卷积神

经网络并不满足局部性,Henaff等人[20]提出用带有

平滑性约束的插值卷积核,这种方法降低参数个数

且实现了图卷积神经网络的局部化.最近,小波神经

网络(GWNN)[21]提出用小波变换代替傅立叶变换

实现卷积定理.

小波神经网络指出,与傅立叶变换相似,小波变

换也定义了一种将信号从节点域变换到谱域的方

法[50].这里用Ψ狊={ψ狊1,ψ狊2,…,ψ狊狀}表示小波变换

的基底,其中ψ狊犻表示从第犻个节点出发的能量扩

散,刻画了第犻个节点的局部结构.小波基底的定义

依赖于拉普拉斯矩阵的特征向量,即Ψ狊=犝犌狊犝T,

其中犌狊=diag({犵狊(λ犻)}狀

犻=1),对角线元素由犵函数

作用到特征值上得到.不同的犵函数赋予小波基底

不同的性质,在小波神经网络中,作者使用热核函

数,即犵狊(λ犻)=犲狊λ犻.

以Ψ狊为谱空间的基底,图上小波逆变换的变换

矩阵为Ψ-1狊=犝犌-狊犝T,其中犌-狊表示将上述犵函数

替换为犵-狊(λ犻)=犲-狊λ犻.

和傅立叶变换相比,小波变换的基底具有几个

很好的性质:(1)小波变换的基底可以通过切比雪

夫多项式近似得到,避免拉普拉斯矩阵特征分解的

高昂代价;(2)小波变换的基底具有局部性;(3)小

波基底的局部性使得小波变换矩阵非常稀疏,这大

狊狓的计算复杂度,使计算过程更加高

大降低了Ψ-1

网络的第犿层结构定义如下:

狊犡犿

图1 不同狊下的小波变换基底[21]((a)当狊较小时,以黄色

节点为中心的热量扩散范围较小;(b)当狊增大时,热

量扩散范围增大)

利用图上小波变换代替傅立叶变换,小波神经

)犻,犼=1,…,狇(8)

与谱卷积神经网络相比,小波神经网络用小波

变换代替傅立叶变换,即用Ψ和Ψ-1

狊替代了犝和

犝⊥.在这样一组小波基底下,图卷积神经网络满足

了局部性,且由于小波基底的可加速计算以及稀疏

性,图卷积神经网络的计算复杂度也大大降低.

犼 =犺Ψ狊∑狆

犉犿

犡犿+1

犻,犼Ψ-1

(

犻=1

除小波神经网络外,还有一些工作致力于实现

图卷积神经网络的局部性和加速计算,但不同于小

波神经网络更换基底的方式,这些工作通过参数化

卷积核实现局部性,同时降低参数复杂度和计算复

杂度.下文我们将给出这类工作的具体介绍.

在式(6)中,犵θ是需要学的卷积核,在谱卷积神

经网络中,犵θ是对角阵的形式,且有狀个需要学的参

数.切比雪夫网络(ChebyNet)[18]对卷积核犵θ进行

参数化

犻=0

犵θ=∑犓-1

θ犽犜犽(^Λ)

其中,θ犽是需要学的系数,^Λ=2Λ

项式是通过递归得到,递归表达式为

(9)

λmax-犐狀.切比雪夫多

犜犽(狓)=2狓犜犽-1(狓)-犜犽-2(狓) (10)

其中,犜0(狓)=1,犜1(狓)=狓.

令^犔=2犔

λmax-犐狀,切比雪夫网络第犿层的结构定

义如下:

《 计 算 机 学 报 》�

犽=0

犽=0

犻=1

θ犽犜犽(^Λ(

θ犽犜犽(^犔)犡犿

067

(

犻=1∑犓-1

犼 =犺犝∑狆

犡犿+1

(

犻=1∑犓-1

=犺∑狆

)犻

))犝⊥犡犿

)犻,犼=1,…,狇(11)

切比雪夫网络利用特征值矩阵的多项式参数化卷积

核,实现谱卷积神经网络,且巧妙的利用犔=犝Λ犝T

引入拉普拉斯矩阵,从而避免了拉普拉斯矩阵的特征

分解,同时参数复杂度从犗(狀×狆×狇)下降到犗(犓×

狆×狇).此外,在拉普拉斯矩阵中,当且仅当节点犻,犼

满足犓跳可达时,犔犓

犻,犼≠0,这一性质使得当犓较小

时,切比雪夫网络具有局部性.

(θ0-θ1(犔-犐狀))犡犿

为了使图卷积神经网络在图上半监督学习领域

发挥作用,Kipf等人[19]对切比雪夫网络简化并提出

一阶图卷积神经网络,Kipf等人[19]令犓=2且λmax=

2,则式(11)可以写成

)犻,犼=1,…,狇

犼 =犺∑狆

犡犿+1

(12)

在图上半监督学习场景下,带标签的数据非常少,

为了避免模型过拟合,Kipf等人约束θ=θ0=-θ1来

降低模型参数,并对权重矩阵做归一化处理,最终得

到如下的一阶图卷积神经网络

)犻,犼=1,…,狇(13)

犼 =犺∑狆

θ^犇-1

2^犃^犇-1

2犡犿

犡犿+1

其中,^犃=犃+犐狀,且^犇犻犻=∑犼

^犃犻,犼.

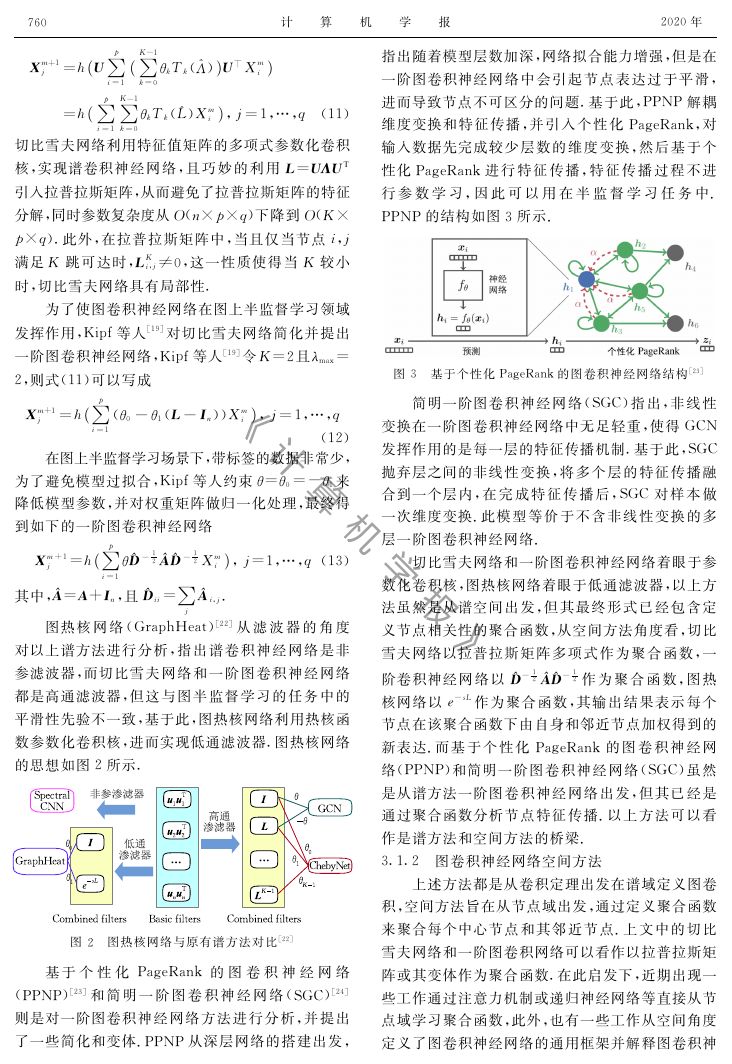

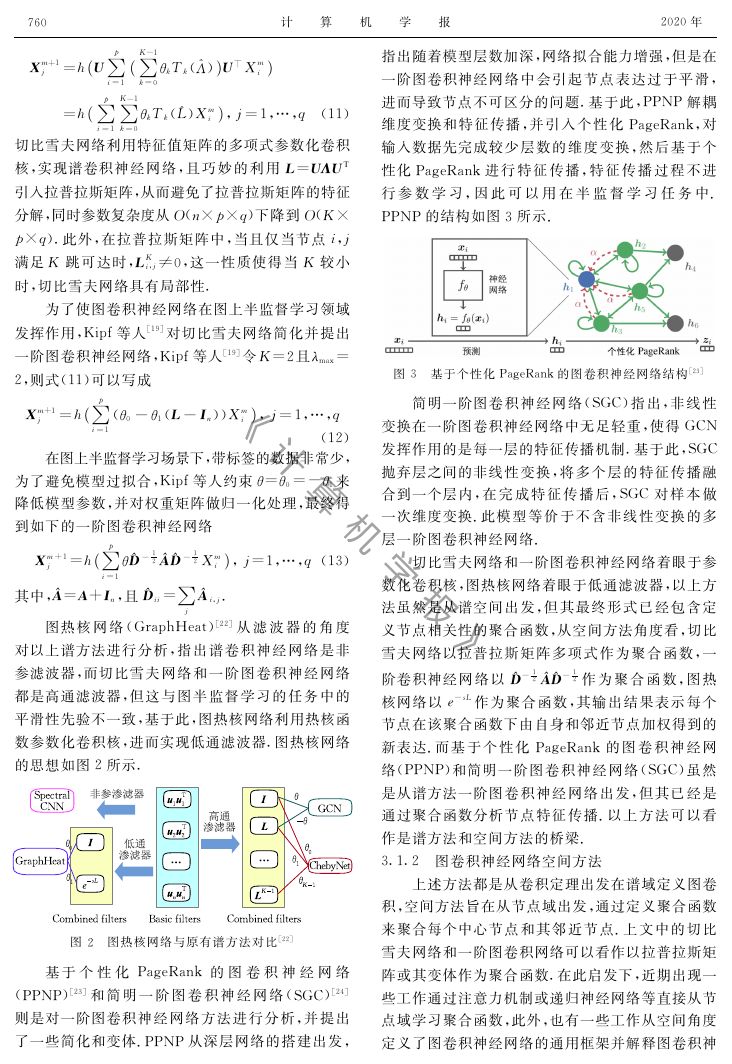

图热核网络(GraphHeat)[22]从滤波器的角度

对以上谱方法进行分析,指出谱卷积神经网络是非

参滤波器,而切比雪夫网络和一阶图卷积神经网络

都是高通滤波器,但这与图半监督学习的任务中的

平滑性先验不一致,基于此,图热核网络利用热核函

数参数化卷积核,进而实现低通滤波器.图热核网络

的思想如图2所示.

(

(

犻=1

图2 图热核网络与原有谱方法对比[22]

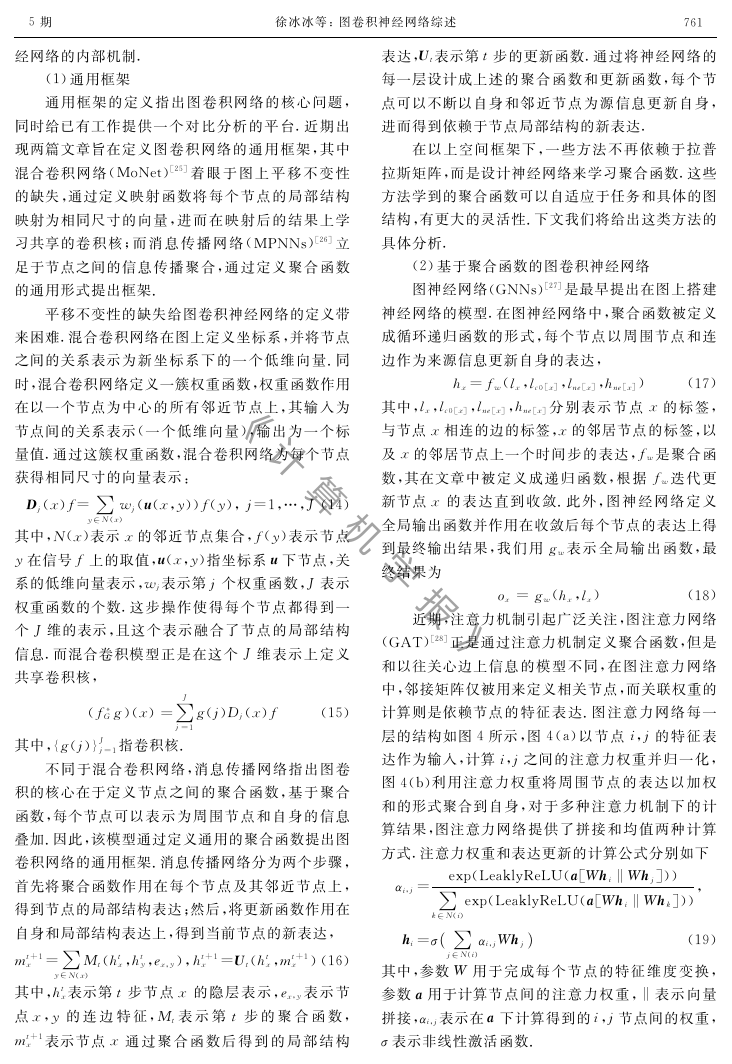

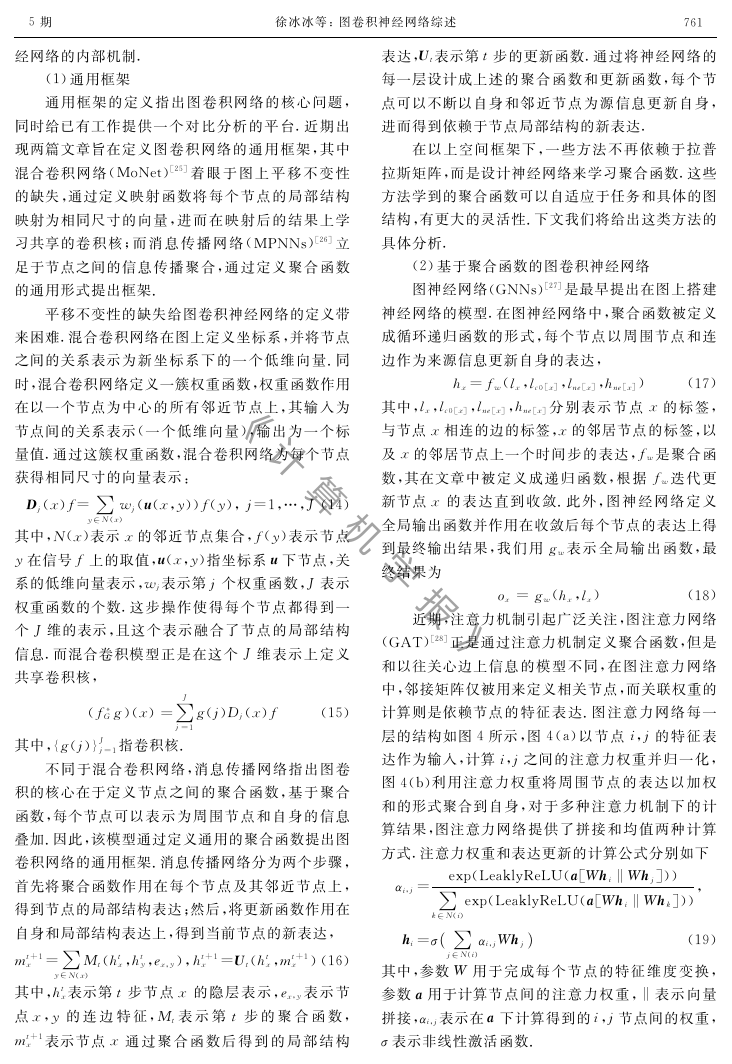

基于个性化PageRank的图卷积神经网络

(PPNP)[23]和简明一阶图卷积神经网络(SGC)[24]

则是对一阶图卷积神经网络方法进行分析,并提出

了一些简化和变体.PPNP从深层网络的搭建出发,

计 算 机 学 报

2020年

指出随着模型层数加深,网络拟合能力增强,但是在

一阶图卷积神经网络中会引起节点表达过于平滑,

进而导致节点不可区分的问题.基于此,PPNP解耦

维度变换和特征传播,并引入个性化PageRank,对

输入数据先完成较少层数的维度变换,然后基于个

性化PageRank进行特征传播,特征传播过程不进

行参数学习,因此可以用在半监督学习任务中.

PPNP的结构如图3所示.

图3 基于个性化PageRank的图卷积神经网络结构[23]

2^犃^犇-1

简明一阶图卷积神经网络(SGC)指出,非线性

变换在一阶图卷积神经网络中无足轻重,使得GCN

发挥作用的是每一层的特征传播机制.基于此,SGC

抛弃层之间的非线性变换,将多个层的特征传播融

合到一个层内,在完成特征传播后,SGC对样本做

一次维度变换.此模型等价于不含非线性变换的多

层一阶图卷积神经网络.

切比雪夫网络和一阶图卷积神经网络着眼于参

数化卷积核,图热核网络着眼于低通滤波器,以上方

法虽然是从谱空间出发,但其最终形式已经包含定

义节点相关性的聚合函数,从空间方法角度看,切比

雪夫网络以拉普拉斯矩阵多项式作为聚合函数,一

阶卷积神经网络以^犇-1

2作为聚合函数,图热

核网络以犲-狊犔作为聚合函数,其输出结果表示每个

节点在该聚合函数下由自身和邻近节点加权得到的

新表达.而基于个性化PageRank的图卷积神经网

络(PPNP)和简明一阶图卷积神经网络(SGC)虽然

是从谱方法一阶图卷积神经网络出发,但其已经是

通过聚合函数分析节点特征传播.以上方法可以看

作是谱方法和空间方法的桥梁.

3.1.2 图卷积神经网络空间方法

上述方法都是从卷积定理出发在谱域定义图卷

积,空间方法旨在从节点域出发,通过定义聚合函数

来聚合每个中心节点和其邻近节点.上文中的切比

雪夫网络和一阶图卷积网络可以看作以拉普拉斯矩

阵或其变体作为聚合函数.在此启发下,近期出现一

些工作通过注意力机制或递归神经网络等直接从节

点域学习聚合函数,此外,也有一些工作从空间角度

定义了图卷积神经网络的通用框架并解释图卷积神

《 计 算 机 学 报 》�

5期

经网络的内部机制.

徐冰冰等:图卷积神经网络综述

(1)通用框架

通用框架的定义指出图卷积网络的核心问题,

同时给已有工作提供一个对比分析的平台.近期出

现两篇文章旨在定义图卷积网络的通用框架,其中

混合卷积网络(MoNet)[25]着眼于图上平移不变性

的缺失,通过定义映射函数将每个节点的局部结构

映射为相同尺寸的向量,进而在映射后的结果上学

习共享的卷积核;而消息传播网络(MPNNs)[26]立

足于节点之间的信息传播聚合,通过定义聚合函数

的通用形式提出框架.

平移不变性的缺失给图卷积神经网络的定义带

来困难.混合卷积网络在图上定义坐标系,并将节点

之间的关系表示为新坐标系下的一个低维向量.同

时,混合卷积网络定义一簇权重函数,权重函数作用

在以一个节点为中心的所有邻近节点上,其输入为

节点间的关系表示(一个低维向量),输出为一个标

量值.通过这簇权重函数,混合卷积网络为每个节点

获得相同尺寸的向量表示:

犇犼(狓)犳=∑狔∈犖(狓)狑犼(狌(狓,狔))犳(狔),犼=1,…,犑(14)

其中,犖(狓)表示狓的邻近节点集合,犳(狔)表示节点

狔在信号犳上的取值,狌(狓,狔)指坐标系狌下节点,关

系的低维向量表示,狑犼表示第犼个权重函数,犑表示

权重函数的个数.这步操作使得每个节点都得到一

个犑维的表示,且这个表示融合了节点的局部结构

信息.而混合卷积模型正是在这个犑维表示上定义

共享卷积核,

犵(犼)犇犼(狓)犳 (15)

(犳犌犵)(狓)=∑犑

犼=1

犼=1指卷积核.

其中,{犵(犼)}犑

不同于混合卷积网络,消息传播网络指出图卷

积的核心在于定义节点之间的聚合函数,基于聚合

函数,每个节点可以表示为周围节点和自身的信息

叠加.因此,该模型通过定义通用的聚合函数提出图

卷积网络的通用框架.消息传播网络分为两个步骤,

首先将聚合函数作用在每个节点及其邻近节点上,

得到节点的局部结构表达;然后,将更新函数作用在

自身和局部结构表达上,得到当前节点的新表达,

犿狋+1狓=∑狔∈犖(狓)犕狋(犺狋狓,犺狋

狔,犲狓,狔),犺狋+1狓=犝狋(犺狋狓,犿狋+1狓)(16)

其中,犺狋狓表示第狋步节点狓的隐层表示,犲狓,狔表示节

点狓,狔的连边特征,犕狋表示第狋步的聚合函数,

犿狋+1狓表示节点狓通过聚合函数后得到的局部结构

167

表达,犝狋表示第狋步的更新函数.通过将神经网络的

每一层设计成上述的聚合函数和更新函数,每个节

点可以不断以自身和邻近节点为源信息更新自身,

进而得到依赖于节点局部结构的新表达.

在以上空间框架下,一些方法不再依赖于拉普

拉斯矩阵,而是设计神经网络来学习聚合函数.这些

方法学到的聚合函数可以自适应于任务和具体的图

结构,有更大的灵活性.下文我们将给出这类方法的

具体分析.

(2)基于聚合函数的图卷积神经网络

图神经网络(GNNs)[27]是最早提出在图上搭建

神经网络的模型.在图神经网络中,聚合函数被定义

成循环递归函数的形式,每个节点以周围节点和连

边作为来源信息更新自身的表达,

狅狓=犵狑(犺狓,犾狓)

犺狓=犳狑(犾狓,犾犮0[狓],犾狀犲[狓],犺狀犲[狓]) (17)

其中,犾狓,犾犮0[狓],犾狀犲[狓],犺狀犲[狓]分别表示节点狓的标签,

与节点狓相连的边的标签,狓的邻居节点的标签,以

及狓的邻居节点上一个时间步的表达,犳狑是聚合函

数,其在文章中被定义成递归函数,根据犳狑迭代更

新节点狓的表达直到收敛.此外,图神经网络定义

全局输出函数并作用在收敛后每个节点的表达上得

到最终输出结果,我们用犵狑表示全局输出函数,最

终结果为

(18)

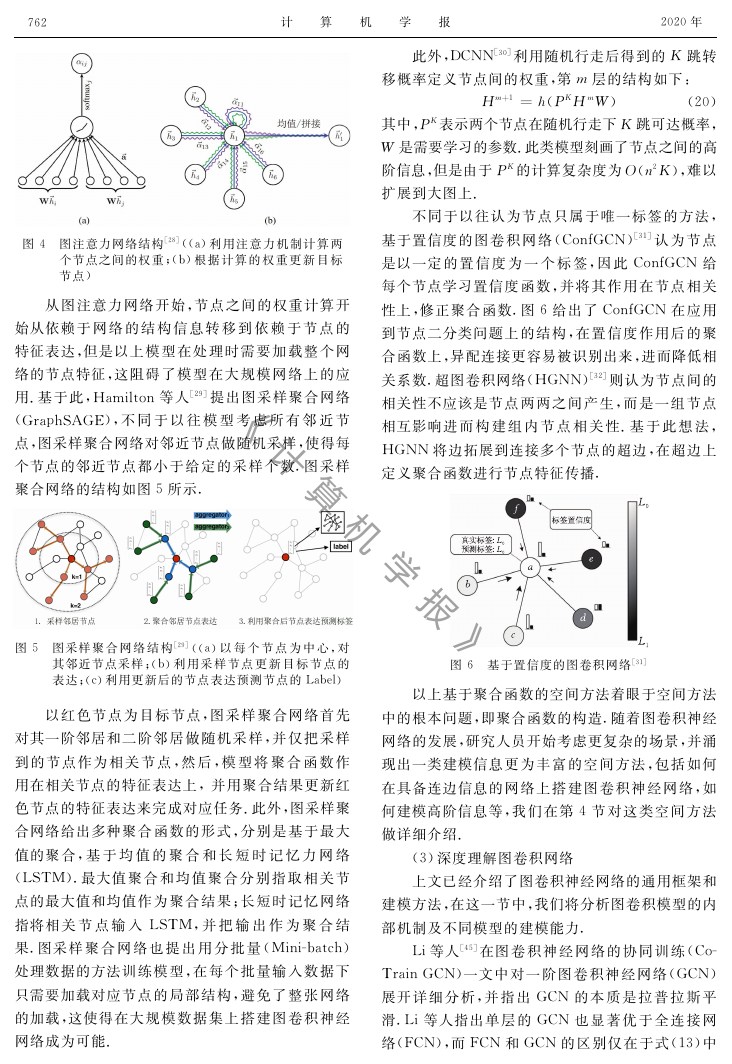

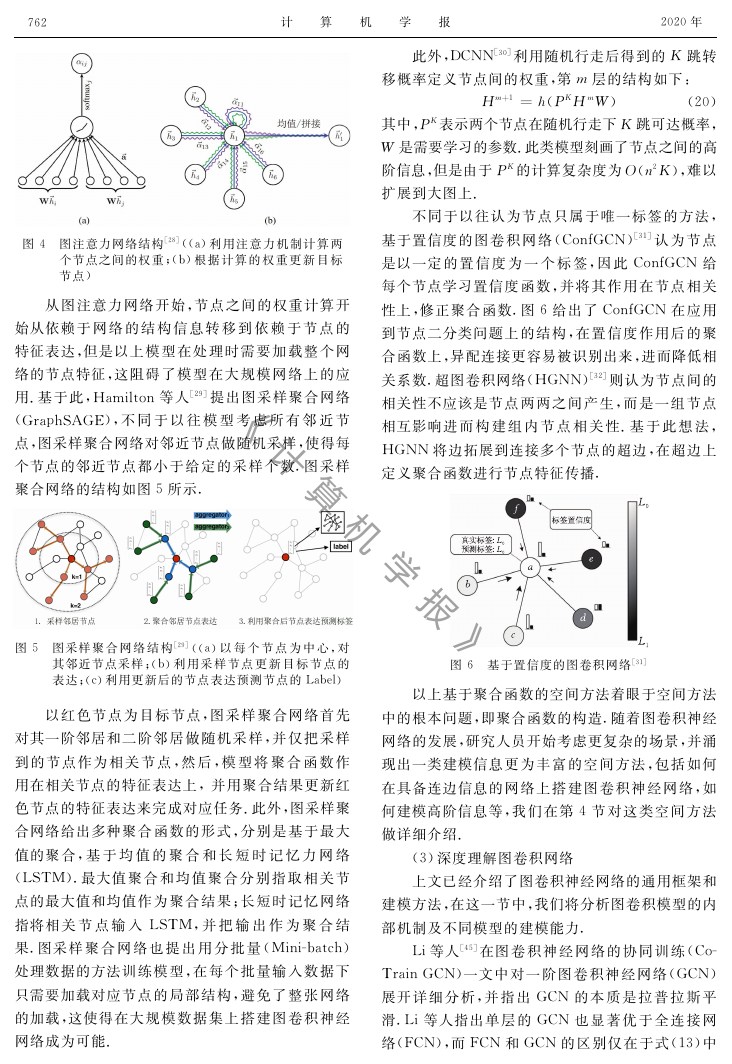

近期,注意力机制引起广泛关注,图注意力网络

(GAT)[28]正是通过注意力机制定义聚合函数,但是

和以往关心边上信息的模型不同,在图注意力网络

中,邻接矩阵仅被用来定义相关节点,而关联权重的

计算则是依赖节点的特征表达.图注意力网络每一

层的结构如图4所示,图4(a)以节点犻,犼的特征表

达作为输入,计算犻,犼之间的注意力权重并归一化,

图4(b)利用注意力权重将周围节点的表达以加权

和的形式聚合到自身,对于多种注意力机制下的计

算结果,图注意力网络提供了拼接和均值两种计算

方式.注意力权重和表达更新的计算公式分别如下

α犻,犼=exp(LeaklyReLU(犪[犠犺犻‖犠犺犼]))

,

∑犽∈犖(犻)exp(LeaklyReLU(犪[犠犺犻‖犠犺犽]))

犺犻=σ∑犼∈犖(犻)α犻,犼犠犺(

)犼

(19)

其中,参数犠用于完成每个节点的特征维度变换,

参数犪用于计算节点间的注意力权重,‖表示向量

拼接,α犻,犼表示在犪下计算得到的犻,犼节点间的权重,

σ表示非线性激活函数.

《 计 算 机 学 报 》�

267

计 算 机 学 报

2020年

此外,DCNN[30]利用随机行走后得到的犓跳转

移概率定义节点间的权重,第犿层的结构如下:

犎犿+1=犺(犘犓犎犿犠) (20)

其中,犘犓表示两个节点在随机行走下犓跳可达概率,

犠是需要学习的参数.此类模型刻画了节点之间的高

阶信息,但是由于犘犓的计算复杂度为犗(狀2犓),难以

扩展到大图上.

不同于以往认为节点只属于唯一标签的方法,

基于置信度的图卷积网络(ConfGCN)[31]认为节点

是以一定的置信度为一个标签,因此ConfGCN给

每个节点学习置信度函数,并将其作用在节点相关

性上,修正聚合函数.图6给出了ConfGCN在应用

到节点二分类问题上的结构,在置信度作用后的聚

合函数上,异配连接更容易被识别出来,进而降低相

关系数.超图卷积网络(HGNN)[32]则认为节点间的

相关性不应该是节点两两之间产生,而是一组节点

相互影响进而构建组内节点相关性.基于此想法,

HGNN将边拓展到连接多个节点的超边,在超边上

定义聚合函数进行节点特征传播.

图4 图注意力网络结构[28]((a)利用注意力机制计算两

个节点之间的权重;(b)根据计算的权重更新目标

节点)

从图注意力网络开始,节点之间的权重计算开

始从依赖于网络的结构信息转移到依赖于节点的

特征表达,但是以上模型在处理时需要加载整个网

络的节点特征,这阻碍了模型在大规模网络上的应

用.基于此,Hamilton等人[29]提出图采样聚合网络

(GraphSAGE),不同于以往模型考虑所有邻近节

点,图采样聚合网络对邻近节点做随机采样,使得每

个节点的邻近节点都小于给定的采样个数.图采样

聚合网络的结构如图5所示.

图5 图采样聚合网络结构[29]((a)以每个节点为中心,对

其邻近节点采样;(b)利用采样节点更新目标节点的

表达;(c)利用更新后的节点表达预测节点的Label)

以红色节点为目标节点,图采样聚合网络首先

对其一阶邻居和二阶邻居做随机采样,并仅把采样

到的节点作为相关节点,然后,模型将聚合函数作

用在相关节点的特征表达上,并用聚合结果更新红

色节点的特征表达来完成对应任务.此外,图采样聚

合网络给出多种聚合函数的形式,分别是基于最大

值的聚合,基于均值的聚合和长短时记忆力网络

(LSTM).最大值聚合和均值聚合分别指取相关节

点的最大值和均值作为聚合结果;长短时记忆网络

指将相关节点输入LSTM,并把输出作为聚合结

果.图采样聚合网络也提出用分批量(Minibatch)

处理数据的方法训练模型,在每个批量输入数据下

只需要加载对应节点的局部结构,避免了整张网络

的加载,这使得在大规模数据集上搭建图卷积神经

网络成为可能.

图6 基于置信度的图卷积网络[31]

以上基于聚合函数的空间方法着眼于空间方法

中的根本问题,即聚合函数的构造.随着图卷积神经

网络的发展,研究人员开始考虑更复杂的场景,并涌

现出一类建模信息更为丰富的空间方法,包括如何

在具备连边信息的网络上搭建图卷积神经网络,如

何建模高阶信息等,我们在第4节对这类空间方法

做详细介绍.

(3)深度理解图卷积网络

上文已经介绍了图卷积神经网络的通用框架和

建模方法,在这一节中,我们将分析图卷积模型的内

部机制及不同模型的建模能力.

Li等人[45]在图卷积神经网络的协同训练(Co

TrainGCN)一文中对一阶图卷积神经网络(GCN)

展开详细分析,并指出GCN的本质是拉普拉斯平

滑.Li等人指出单层的GCN也显著优于全连接网

络(FCN),而FCN和GCN的区别仅在于式(13)中

《 计 算 机 学 报 》�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc