中国科技论文在线

http://www.paper.edu.cn

基于 BP 神经网络的雷达与视觉前车信息融

合研究#

曾杰,郑玲**

(重庆大学汽车工程学院)

摘要:针对智能汽车单一传感器对前方车辆运动信息和方位识别误差较大的问题,在 Prescan

仿真软件中建立起摄像头和毫米波雷达识别车辆的智能车模型,用雷达和摄像头采集被跟踪

车辆在多种运动模式下数据,使用 BP 神经网络实现视觉和雷达对被跟踪车辆的运动信息的

融合,准确识别前方车辆的车速、车距、相对角度信息。研究结果表明:视觉和雷达单独识

别的前方车辆车距、车速、相对角度信息与真值相比存在较大误差,而经过 BP 神经网络融

合视觉和雷达信息后输出的识别结果与真值相比误差较小,有效提高智能汽车对前方车辆的

运动信息识别精度。

关键词:车辆工程;BP 神经网络;雷达;视觉;信息融合;

中图分类号:U461.91 文献标识码:A

Research on ahead vehicle information fusion of radar and

vision based on BP neural network

ZENG Jie, ZHENG Ling

5

10

15

20

(Automobile Egineering school, Chong Qing Universtiy,Chong Qing 400044)

Abstract: The motion and position information of ahead vechicle obtained by single sensor

contain large error information. In this paper,intellegent vehicle with radar and camera is

established in Prescan software,and the motion and position information ofahead vechile in

different motion condition are captured .The information fusion of radar and vision based on BP

neural network is uesd to obtain speed, distance and angle with higher accuracy of ahead

vechile.The result shows that the speed, distance and angle obtained by single radar or vision have

relative large difference compared with ture information value,and the fusion information output

by BP nerual network have relative small difference compared with ture information value.The

information fusion of radar and vision can effectively improve the motion and position recognition

accuracy of ahead vehicle.

Key words: automobile engineering ; BP neural network; radra;vision;information fusion;

25

30

0 引言

近年来,随着我国汽车保有量的不断增加和道路行车密度的急剧增大,交通拥堵加剧、

35

事故频发等问题日益突出,道路交通安全已经成为社会关注的重点问题[1]。如何提高道路车

辆的主动安全性能,有效降低事故发生概率,成为当今的热点课题。装备大量主动安全设备

的智能车辆作为新型的高科技产品,例如视觉呈像技术、智能控制技术、路径规划决策理论、

物体探测技术、多模控制技术、多传感器信息融合技术等,有机的将各种技术融合从而保证

车辆在复杂道路环境中实现智能自主驾驶[2],由于智能汽车自动驾驶系统能够尽可能地避免

40

交通事故的发生并提高道路的通行能力,因此,已经得到了各国政府的重视并逐渐成为汽车

工程界的研究热点。我国也认识到智能车辆技术的经济社会价值,将其视为国家重点研发的

基金项目:国家自然科学基金(50775225)

作者简介:曾杰(1992-),男,研究生在读,主要研究方向:智能汽车环境感知

通信联系人:郑玲(1963-),女,教授,主要研究方向:振动与噪声控制,汽车智能控制,环境感知. E-mail:

zling@cqu.edu.cn

- 1 -

�

中国科技论文在线

http://www.paper.edu.cn

新技术[3]。智能车辆利用视觉传感器、激光雷达、毫米波雷达、红外传感器等设备实现车辆

自身周围环境进行监测,主要实现对周围环境中的行人、车辆、障碍物的识别[4]。由于环境

感知多源异构多模式信息融合以及协同计算的复杂性,目前仍然面临众多挑战,准确、实时、

45

鲁棒的环境感知能力对智能汽车的自主巡航控制、碰撞预警和路径规划等起到至关重要的作

用.文献[5,6]采用毫米波雷达识别运动车辆,将识别到车辆的三维空间信息转化为二维视觉像

素信息,在视觉中标示出感兴趣区域,随后对感兴趣区域利用机器识别或者图像处理的方式

识别目标车辆实现信息融合。受制于毫米波雷达受干扰有误判的影响,这种融合方式的鲁棒

性较差。文献[7,8]利用激光雷达扫描障碍物的云点数据与毫米波雷达信息融合,重现高速路

50

上车辆周围的三维环境,剔除无效区域范围内目标,实现对可通行区域规划,但激光云点数

据处理时间较长,实时性较差,并且激光雷达成本较高难以大规模普及。采用低成本的视觉

传感器和毫米波雷达实现对周围环境的协同感知具有较高的应用价值。文献[9]采用神经网络

与 Adatboost 分类器结合的方法实现了对运动车辆的识别与跟踪,识别精度较高。文献[10]

采用 BP 神经网络实现了雷达与 AIS 传感器的速度、距离、方位角等信息的融合,融合后的

55

船舶运动信息与真值误差较小。BP 神经网络有较强的学习能和容错能力,能够实现对复杂

非线性关系的映射,能够满足多传感器多信息融合信息处理的要求。因此采用 BP 神经网络

实现车辆视觉和毫米波雷达信息融合,有较好的应用基础。

针对智能汽车单一传感器对前方车辆运动信息识别误差较大的问题,本文在提供了众多

传感器和交通道路建模的仿真软件 Pescan 中,建立起搭载摄像机和毫米波雷达的智能汽车

60

模型,提出两种异构传感器的信息融合构架,通过 Simulink 仿真获得丰富的 BP 神经网络训

练样本,并采用 BP 神经网络实现车辆视觉和毫米波雷达的多信息融合,在 Simulink 中实现

融合算法仿真,完成对前方车辆的车距、车速准确识别与跟踪。

1 传感器标定与有效目标信息预处理

65

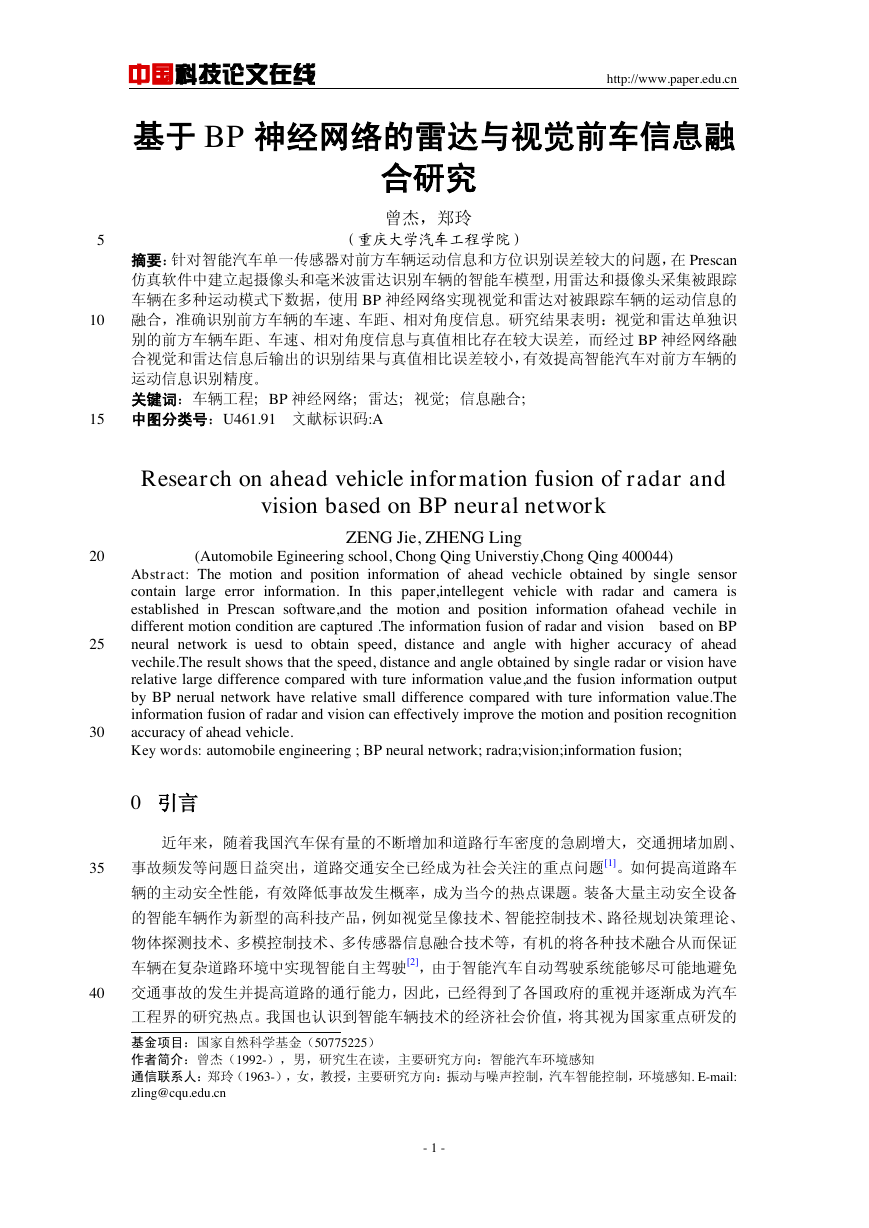

图 1 智能汽车模型

Fig.1 Intelligence automobile model

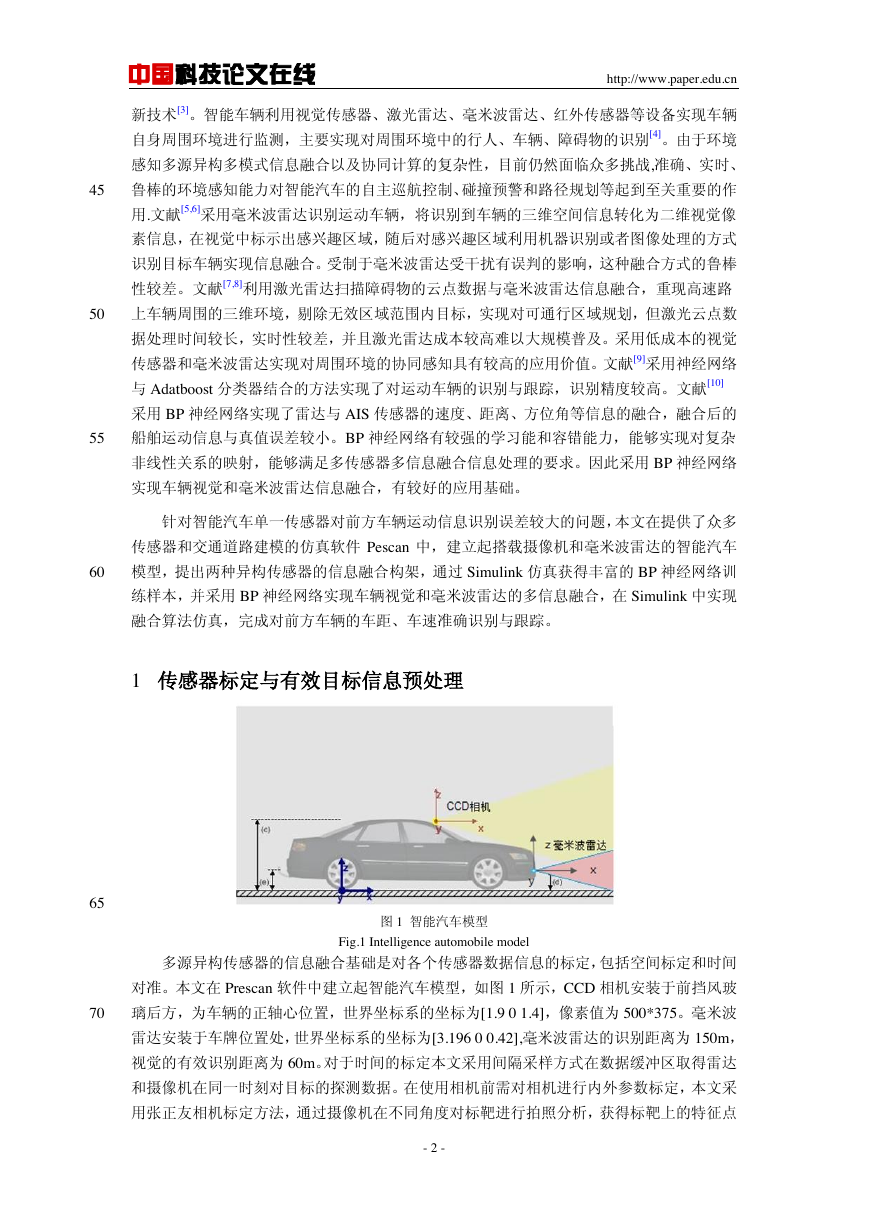

多源异构传感器的信息融合基础是对各个传感器数据信息的标定,包括空间标定和时间

对准。本文在 Prescan 软件中建立起智能汽车模型,如图 1 所示,CCD 相机安装于前挡风玻

70

璃后方,为车辆的正轴心位置,世界坐标系的坐标为[1.9 0 1.4],像素值为 500*375。毫米波

雷达安装于车牌位置处,世界坐标系的坐标为[3.196 0 0.42],毫米波雷达的识别距离为 150m,

视觉的有效识别距离为 60m。对于时间的标定本文采用间隔采样方式在数据缓冲区取得雷达

和摄像机在同一时刻对目标的探测数据。在使用相机前需对相机进行内外参数标定,本文采

用张正友相机标定方法,通过摄像机在不同角度对标靶进行拍照分析,获得标靶上的特征点

- 2 -

�

中国科技论文在线

http://www.paper.edu.cn

75

对应的平面像素点关系,并消除畸变影响[11]。公式(1)为三维世界坐标系中的一点[X Y Z]

通过摄像机镜头投影到像素平面[x y]的投影公式:

(1)

其中:矩阵[M]为相机内参数矩阵,是相机制造的参数。矩阵[G]为相机外参数矩阵,表

示安装引起的镜头旋转和平移向量。

80

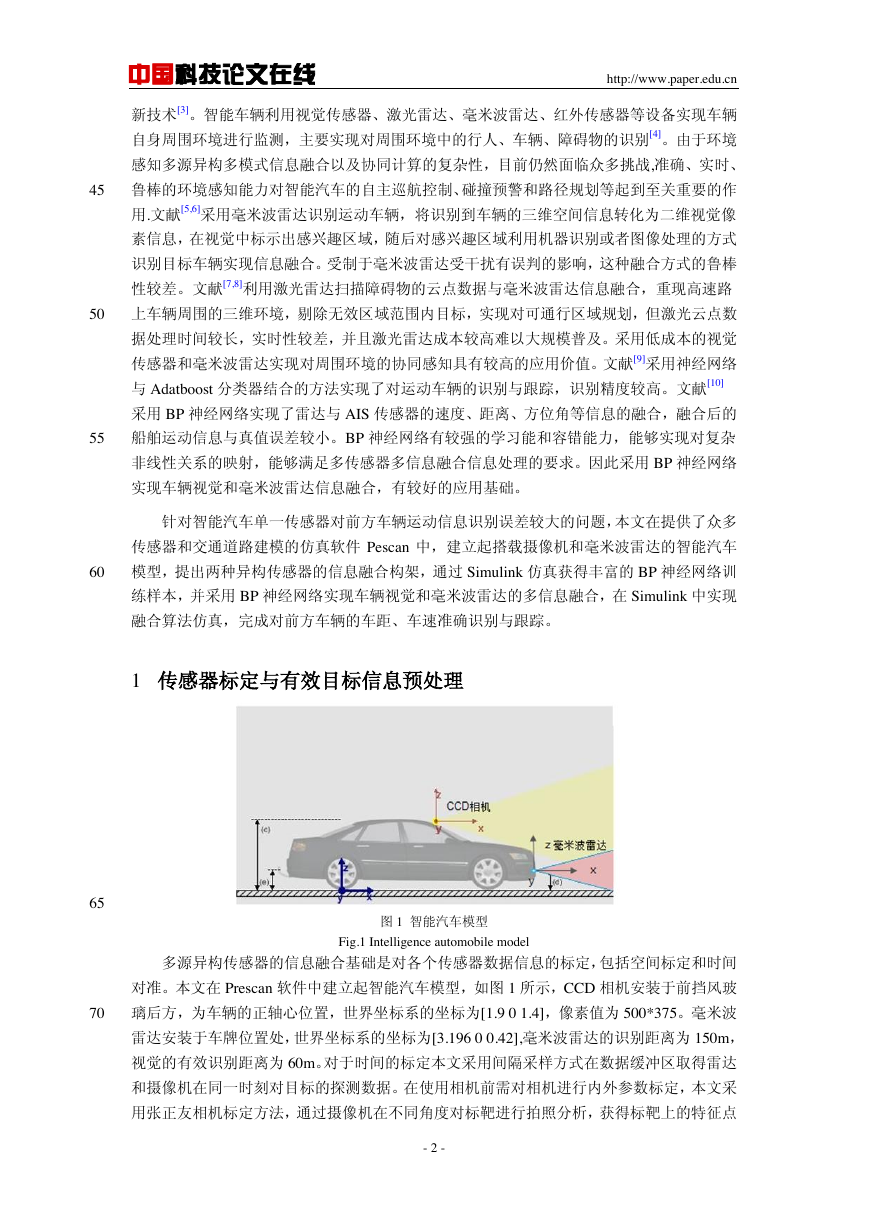

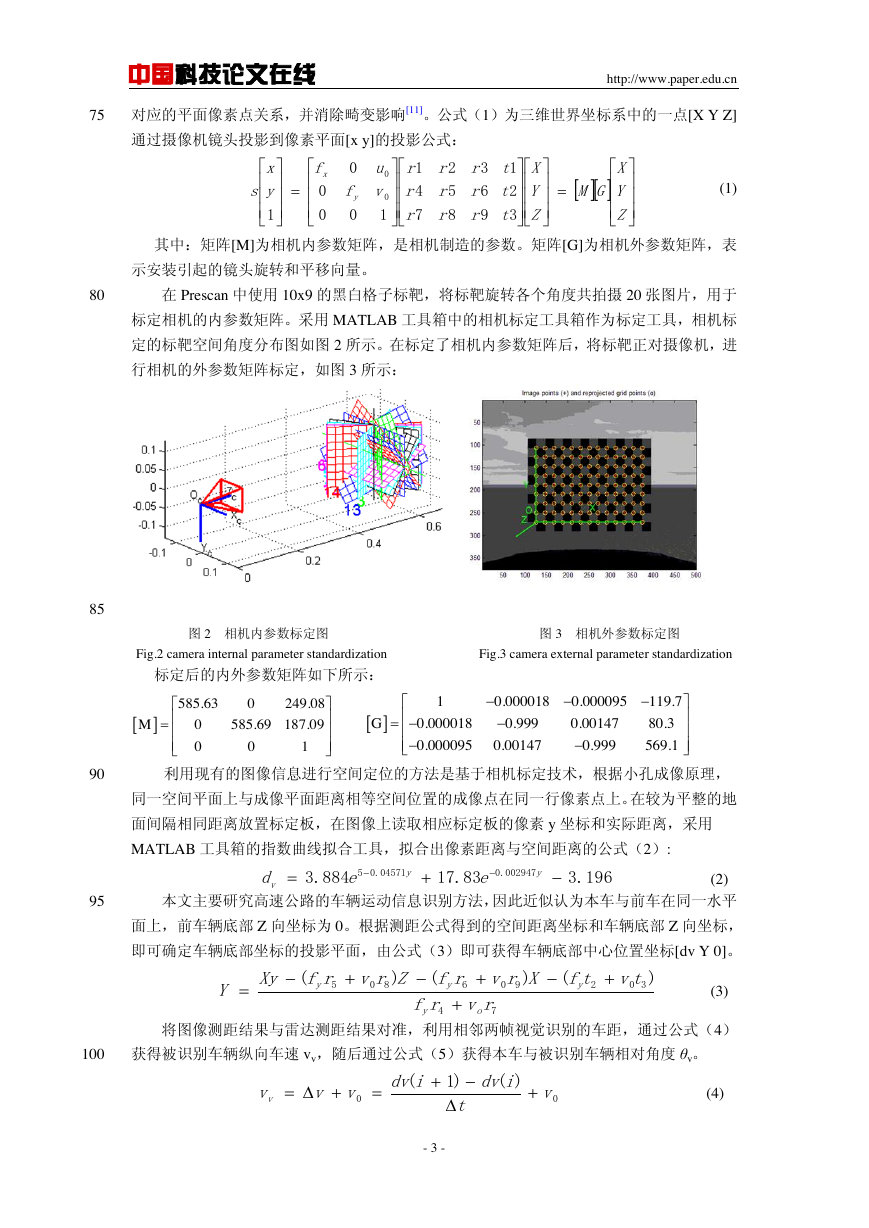

在 Prescan 中使用 10x9 的黑白格子标靶,将标靶旋转各个角度共拍摄 20 张图片,用于

标定相机的内参数矩阵。采用 MATLAB 工具箱中的相机标定工具箱作为标定工具,相机标

定的标靶空间角度分布图如图 2 所示。在标定了相机内参数矩阵后,将标靶正对摄像机,进

行相机的外参数矩阵标定,如图 3 所示:

85

图 2 相机内参数标定图 图 3 相机外参数标定图

Fig.2 camera internal parameter standardization Fig.3 camera external parameter standardization

标定后的内外参数矩阵如下所示:

90

利用现有的图像信息进行空间定位的方法是基于相机标定技术,根据小孔成像原理,

同一空间平面上与成像平面距离相等空间位置的成像点在同一行像素点上。在较为平整的地

面间隔相同距离放置标定板,在图像上读取相应标定板的像素 y 坐标和实际距离,采用

MATLAB 工具箱的指数曲线拟合工具,拟合出像素距离与空间距离的公式(2):

(2)

本文主要研究高速公路的车辆运动信息识别方法,因此近似认为本车与前车在同一水平

95

面上,前车辆底部 Z 向坐标为 0。根据测距公式得到的空间距离坐标和车辆底部 Z 向坐标,

即可确定车辆底部坐标的投影平面,由公式(3)即可获得车辆底部中心位置坐标[dv Y 0]。

(3)

将图像测距结果与雷达测距结果对准,利用相邻两帧视觉识别的车距,通过公式(4)

100

获得被识别车辆纵向车速 vv,随后通过公式(5)获得本车与被识别车辆相对角度 θv。

(4)

- 3 -

ZYXGMZYXtttrrrrrrrrrvuffyxsyx32196385274110000100585.630249.080585.69187.09001M10.0000180.000095119.70.0000180.9990.0014780.30.0000950.001470.999569.1G196.383.17884.3002947.004571.05yyveed74302906805)()()(rvrftvtfXrvrfZrvrfXyYoyyyy00)()1(vtidvidvvvvv�

中国科技论文在线

http://www.paper.edu.cn

(5)

其中:Δt 为摄像机采样时间,y 为图像像素纵坐标,θv 为通过视觉识别的相对角度,v0

为本车车速。

105

图 4 有效目标分类方法

Fig.4 target classification

本文将车道信息分为左、中、右三种车道,车道的宽度为国内标准 3.75m[12]。通过视觉

和雷达识别的车辆通过此标准划分为三类,并且赋予相应的编号。由视觉识别的车辆为不同

110

车道上离本车最近的车辆,毫米波雷达所获得的跟踪目标,将依次根据车道和前后顺序排列

存储。

2 BP( Back Propagation Network)神经网络信息融合

2.1 信息融合构架

融合系统采用单目 CCD 摄像机和毫米波雷达实现对前方道路车辆信息的有效采集,融合

115

系统构架如图 5 所示。分别将雷达和视觉识别的目标经过有效筛选后获得被识别车辆的相对

距离、车速和相对角度信息,随后通过所设计的卡尔曼滤波器将系统和过程噪声滤除,随后

根据目标排序分类的原则,实现对两种传感器对同一目标信息的关联,最终采用 BP 神经网

络实现对信息地融合,输出被跟踪车辆的车速 vnet、车距 dnet 和相对角度 θnet 信息。

120

125

图 5 BP 神经网络融合构架

Fig.5 BP network fusion structure

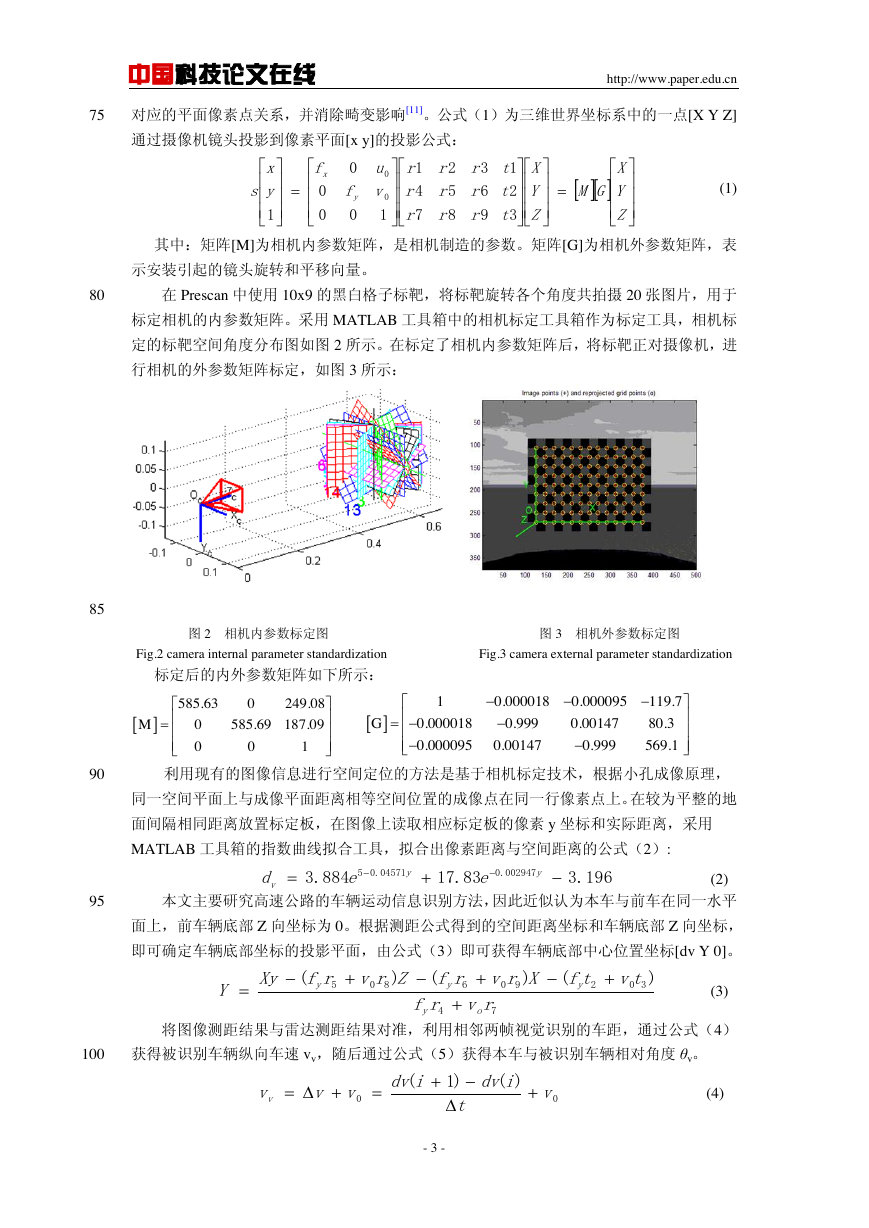

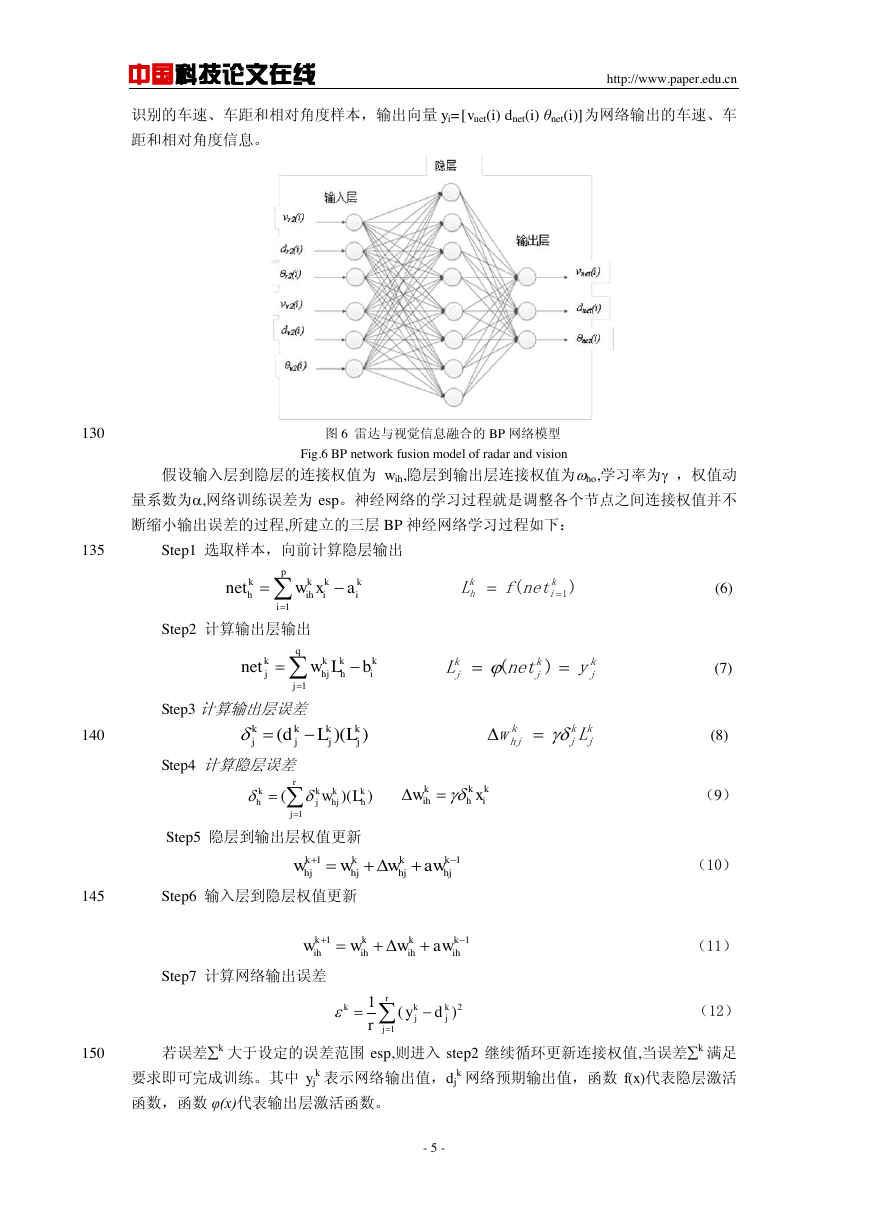

2.2 BP 神经网络模型

BP 神经网络是一种反向传播网络是对非线性可微分函数进行权值和偏置训练的多层前

向型网络,BP 神经网络大量应用于人工神经网络处理实际问题[13]。本文使用 BP 神经网络

进行视觉与雷达两种异构传感的数据信息融合,建立起 6 输入节点、8 隐层节点、3 输出节点

的神经网络,如图 6 所示。输入向量 xi=[vr2(i) dr2(i) θr2(i) vv2(i) dv2(i) θv2(i)]分别为雷达和视觉

- 4 -

vvdYarctan�

中国科技论文在线

http://www.paper.edu.cn

识别的车速、车距和相对角度样本,输出向量 yi=[vnet(i) dnet(i) θnet(i)]为网络输出的车速、车

距和相对角度信息。

130

图 6 雷达与视觉信息融合的 BP 网络模型

Fig.6 BP network fusion model of radar and vision

假设输入层到隐层的连接权值为 wih,隐层到输出层连接权值为ho,学习率为 ,权值动

量系数为,网络训练误差为 esp。神经网络的学习过程就是调整各个节点之间连接权值并不

断缩小输出误差的过程,所建立的三层 BP 神经网络学习过程如下:

135

Step1 选取样本,向前计算隐层输出

(6)

Step2 计算输出层输出

(7)

Step3 计算输出层误差

140

(8)

Step4 计算隐层误差

Step5 隐层到输出层权值更新

145

Step6 输入层到隐层权值更新

Step7 计算网络输出误差

(9)

(10)

(11)

(12)

150

若误差k 大于设定的误差范围 esp,则进入 step2 继续循环更新连接权值,当误差k 满足

k 网络预期输出值,函数 f(x)代表隐层激活

要求即可完成训练。其中 yj

函数,函数 φ(x)代表输出层激活函数。

k 表示网络输出值,dj

- 5 -

1pkkkkhihiiinetwxa)(1kikhnetfL1qkkkkjhjhijnetwLbkjkjkjynetL)(j()()kkkkjjjdLLkjkjkhjLw1()()rkkkkhjhjhjwLkkkihhiwx11kkkkhjhjhjhjwwwaw11kkkkihihihihwwwaw211()rkkkjjjydr�

中国科技论文在线

2.3 BP 网络训练

http://www.paper.edu.cn

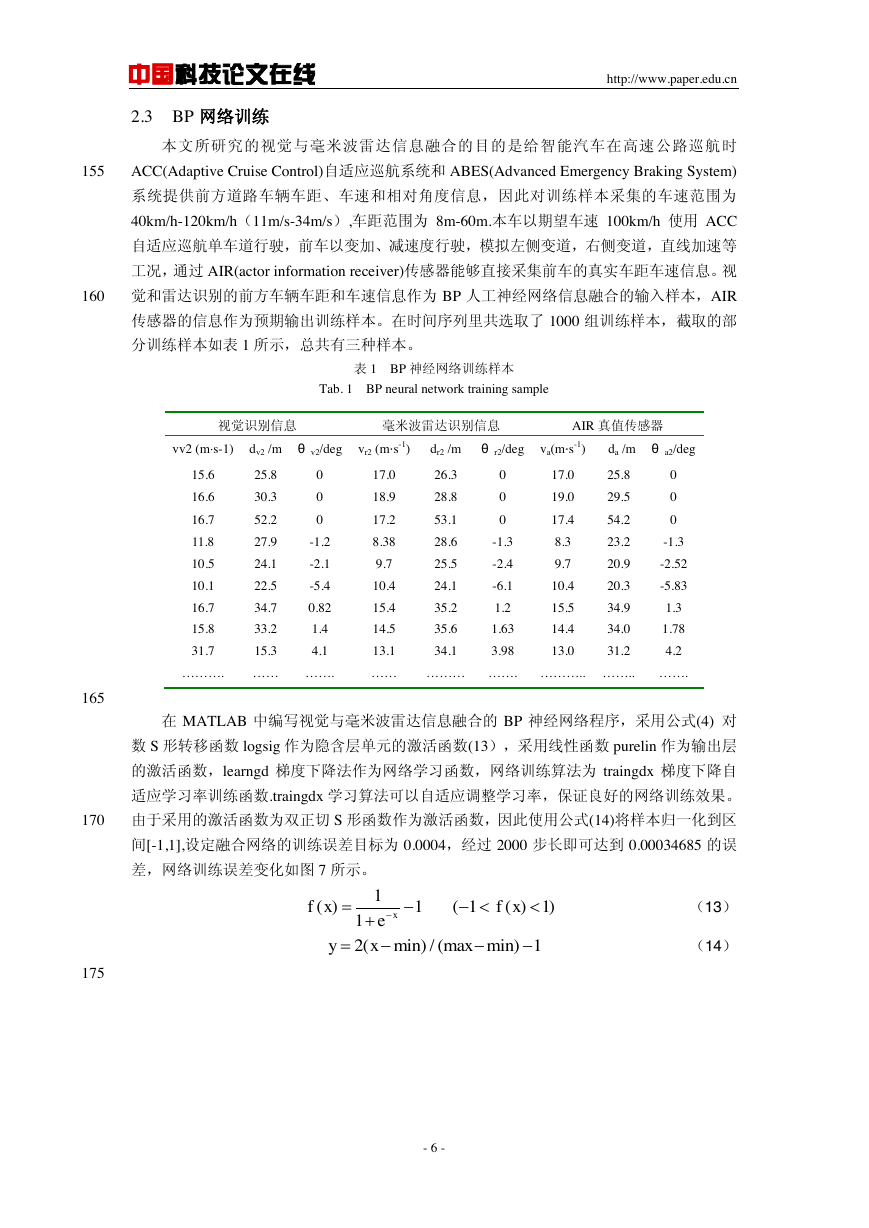

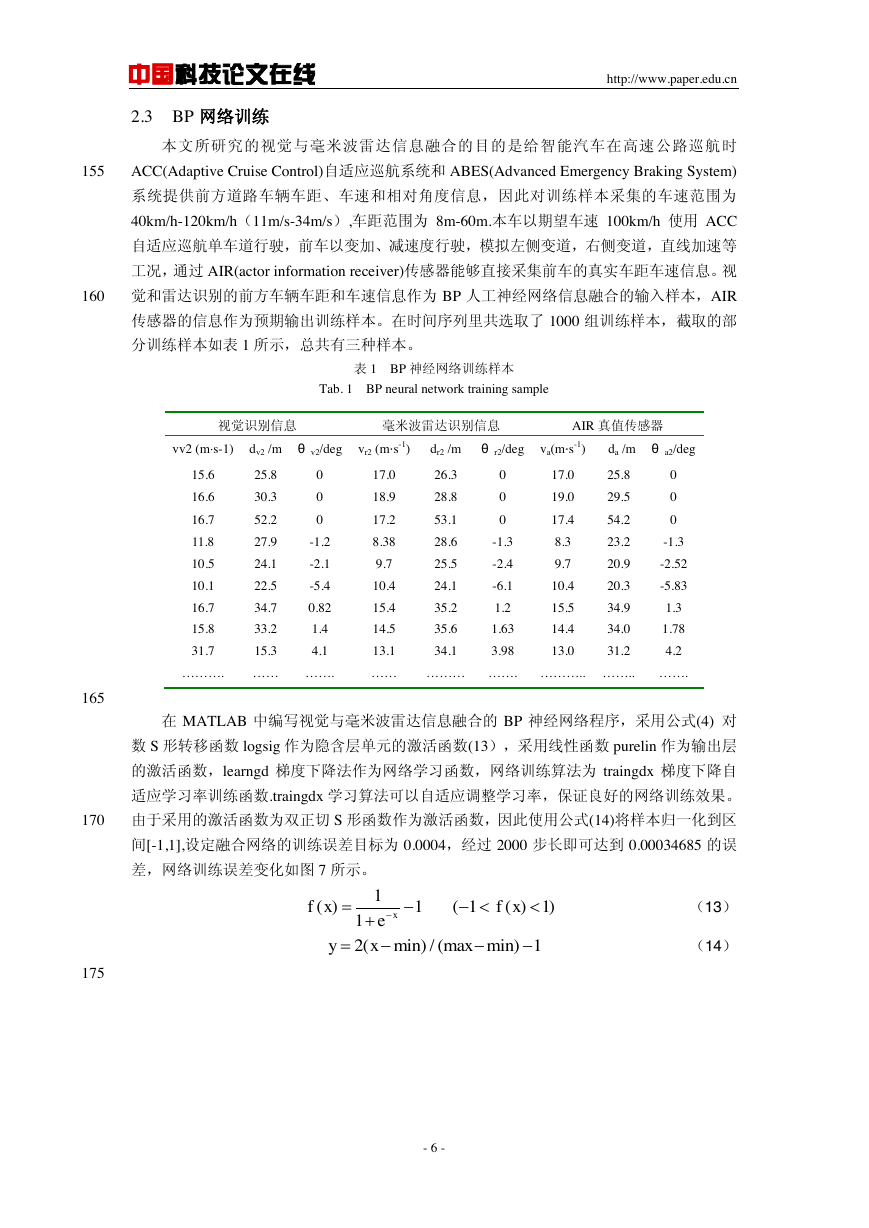

本文所研究的视觉与毫米波雷达信息融合的目的是给智能汽车在高速公路巡航时

155

ACC(Adaptive Cruise Control)自适应巡航系统和 ABES(Advanced Emergency Braking System)

系统提供前方道路车辆车距、车速和相对角度信息,因此对训练样本采集的车速范围为

40km/h-120km/h(11m/s-34m/s),车距范围为 8m-60m.本车以期望车速 100km/h 使用 ACC

自适应巡航单车道行驶,前车以变加、减速度行驶,模拟左侧变道,右侧变道,直线加速等

工况,通过 AIR(actor information receiver)传感器能够直接采集前车的真实车距车速信息。视

160

觉和雷达识别的前方车辆车距和车速信息作为 BP 人工神经网络信息融合的输入样本,AIR

传感器的信息作为预期输出训练样本。在时间序列里共选取了 1000 组训练样本,截取的部

分训练样本如表 1 所示,总共有三种样本。

表 1 BP 神经网络训练样本

Tab. 1 BP neural network training sample

视觉识别信息

毫米波雷达识别信息

AIR 真值传感器

vv2 (ms-1) dv2 /m θ v2/deg vr2 (ms-1)

dr2 /m

θ r2/deg va(ms-1)

da /m θ a2/deg

15.6

16.6

16.7

11.8

10.5

10.1

16.7

15.8

31.7

25.8

30.3

52.2

27.9

24.1

22.5

34.7

33.2

15.3

0

0

0

-1.2

-2.1

-5.4

0.82

1.4

4.1

17.0

18.9

17.2

8.38

9.7

10.4

15.4

14.5

13.1

26.3

28.8

53.1

28.6

25.5

24.1

35.2

35.6

34.1

0

0

0

-1.3

-2.4

-6.1

1.2

1.63

3.98

17.0

19.0

17.4

8.3

9.7

10.4

15.5

14.4

13.0

25.8

29.5

54.2

23.2

20.9

20.3

34.9

34.0

31.2

0

0

0

-1.3

-2.52

-5.83

1.3

1.78

4.2

………. …… …….

…… ……… ……. ……….. …….. …….

165

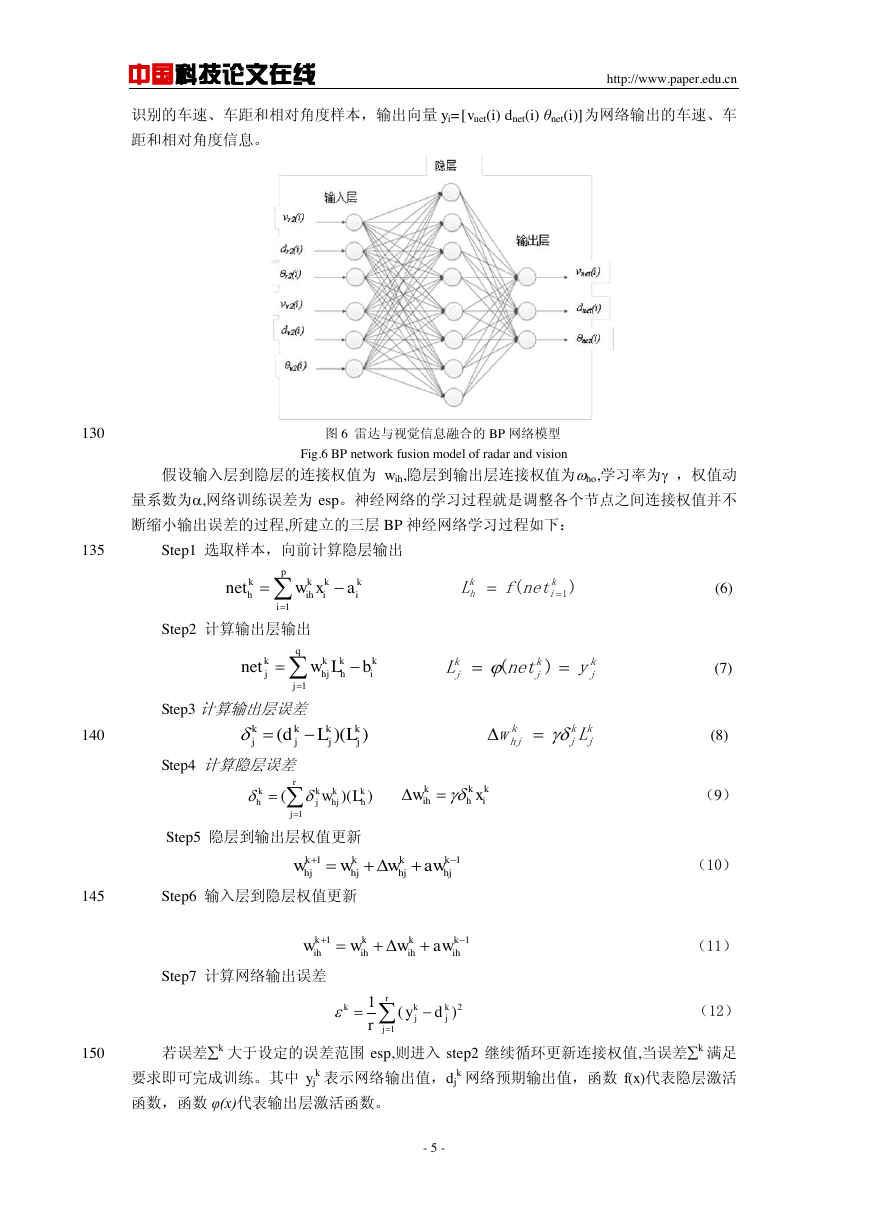

在 MATLAB 中编写视觉与毫米波雷达信息融合的 BP 神经网络程序,采用公式(4) 对

数 S 形转移函数 logsig 作为隐含层单元的激活函数(13),采用线性函数 purelin 作为输出层

的激活函数,learngd 梯度下降法作为网络学习函数,网络训练算法为 traingdx 梯度下降自

适应学习率训练函数.traingdx 学习算法可以自适应调整学习率,保证良好的网络训练效果。

170

由于采用的激活函数为双正切 S 形函数作为激活函数,因此使用公式(14)将样本归一化到区

间[-1,1],设定融合网络的训练误差目标为 0.0004,经过 2000 步长即可达到 0.00034685 的误

差,网络训练误差变化如图 7 所示。

(13)

175

(14)

- 6 -

1()11xfxe(1()1)fx2(min)/(maxmin)1yx�

中国科技论文在线

http://www.paper.edu.cn

图 7BP 神经网络训练误差变化图

Fig.7 Error changing of BP network training

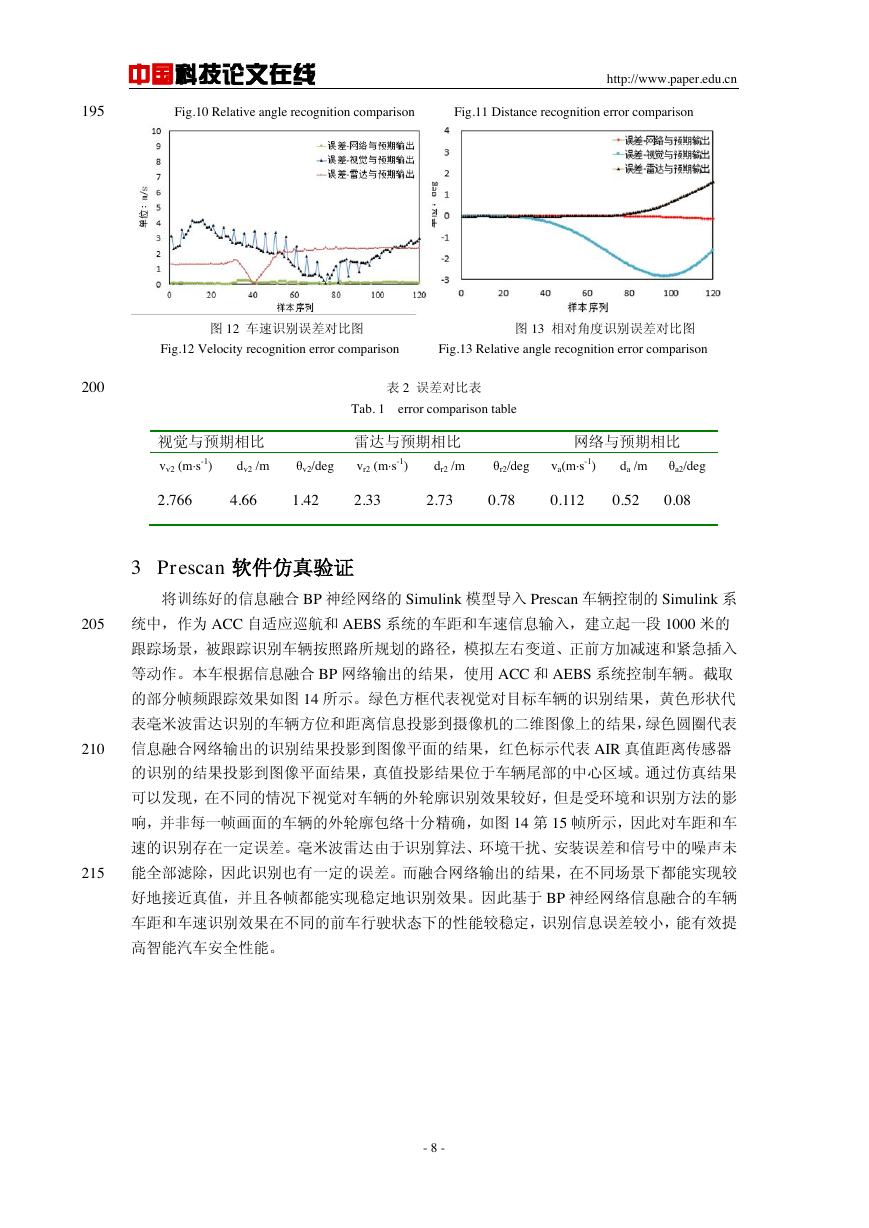

2.4 BP 神经网络测试

180

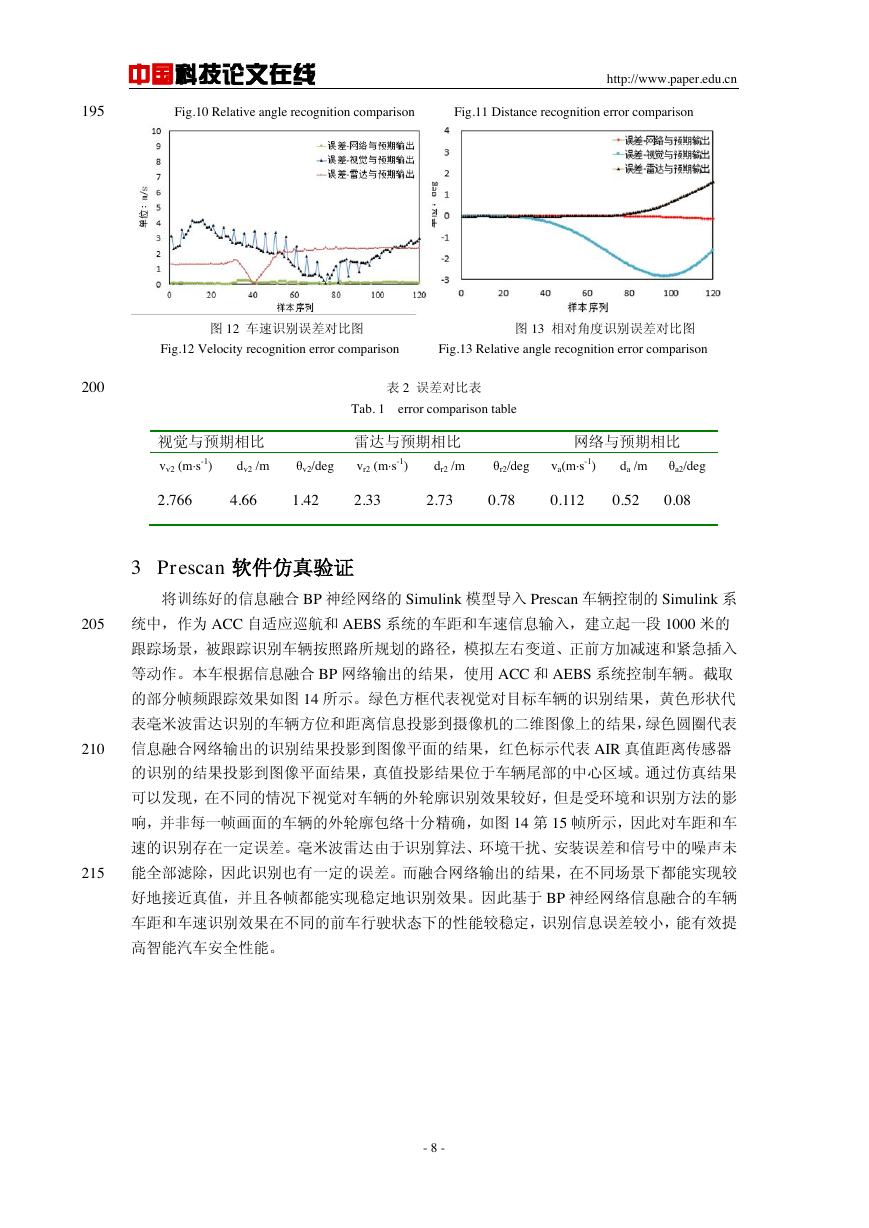

选取 120 组测试样本作为训练好的 BP 神经网络的测试输入,图 8-10 表示前方车距、车

速、相对角度检测的对比结果,图 11-13 表示前方车距、车速、相对角度检测与预期输出的

误差对比结果。各个传感器识别的结果平均绝对误差由表 2 所示。单独视觉检测和雷达检测

输出的车速的平均绝对误差分别为 2.76m/s 和 2.33m/s,大于神经网络输出的 0.112m/s。单

独视觉检测和雷达检测输出的车距的平均绝对误差分别为 4.66m 和 2.73m,大于神经网络输

185

出的 0.52m。单独视觉检测和雷达检测输出的相对角度的平均绝对误差分别为 1.42和 0.78,

大于神经网络输出的 0.08。视觉检测的结果误差大于雷达检测结果,而 BP 网络输出融合

的车距和车速信息能够较好地靠近 AIR 真值传感器输出的真值,融合输出的识别信息误差

小于单独识别的误差,因此经过多组样本训练的 BP 网络能够较好地实现对视觉和雷达输出

的车速、车距、相对角度融合,并输出误差较小的前方车辆信息。

190

图 8 车距识别对比图 图 9 车速识别对比图

Fig.8 Distance recognition comparison Fig.9 Velocity recognition comparison

图 10 相对角度识别对比图 图 11 车距识别误差对比图

- 7 -

�

中国科技论文在线

http://www.paper.edu.cn

195

Fig.10 Relative angle recognition comparison Fig.11 Distance recognition error comparison

图 12 车速识别误差对比图 图 13 相对角度识别误差对比图

Fig.12 Velocity recognition error comparison Fig.13 Relative angle recognition error comparison

200

表 2 误差对比表

Tab. 1 error comparison table

视觉与预期相比

雷达与预期相比

网络与预期相比

vv2 (ms-1)

dv2 /m

θv2/deg

vr2 (ms-1)

dr2 /m

θr2/deg

va(ms-1)

da /m

θa2/deg

2.766

4.66

1.42

2.33

2.73

0.78

0.112

0.52

0.08

3 Prescan 软件仿真验证

将训练好的信息融合 BP 神经网络的 Simulink 模型导入 Prescan 车辆控制的 Simulink 系

205

统中,作为 ACC 自适应巡航和 AEBS 系统的车距和车速信息输入,建立起一段 1000 米的

跟踪场景,被跟踪识别车辆按照路所规划的路径,模拟左右变道、正前方加减速和紧急插入

等动作。本车根据信息融合 BP 网络输出的结果,使用 ACC 和 AEBS 系统控制车辆。截取

的部分帧频跟踪效果如图 14 所示。绿色方框代表视觉对目标车辆的识别结果,黄色形状代

表毫米波雷达识别的车辆方位和距离信息投影到摄像机的二维图像上的结果,绿色圆圈代表

210

信息融合网络输出的识别结果投影到图像平面的结果,红色标示代表 AIR 真值距离传感器

的识别的结果投影到图像平面结果,真值投影结果位于车辆尾部的中心区域。通过仿真结果

可以发现,在不同的情况下视觉对车辆的外轮廓识别效果较好,但是受环境和识别方法的影

响,并非每一帧画面的车辆的外轮廓包络十分精确,如图 14 第 15 帧所示,因此对车距和车

速的识别存在一定误差。毫米波雷达由于识别算法、环境干扰、安装误差和信号中的噪声未

215

能全部滤除,因此识别也有一定的误差。而融合网络输出的结果,在不同场景下都能实现较

好地接近真值,并且各帧都能实现稳定地识别效果。因此基于 BP 神经网络信息融合的车辆

车距和车速识别效果在不同的前车行驶状态下的性能较稳定,识别信息误差较小,能有效提

高智能汽车安全性能。

- 8 -

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc