基于深度学习的视频行为识别综述

课 程 报 告

课 程 名 称

机器学习与知识发现

所 在 学 院

计算机与软件工程学院

专

姓

学

日

业

名

号

期

计算机技术

林晓兵

212018085211028

2018 年 1

月

12

日

�

基于深度学习的视频行为识别综述

基于深度学习的视频行为识别综述

摘要:人体行为识别和深度学习理论是目标视频分析理论的研究热点,近年来得到了

学业界的广泛关注。深度学习特别是卷积神经网络在图像处理领域取得了非凡的成就,并

逐步推广至视频视频行为识别领域。本文对近年来提出的基于不同深度学习框架的人体行

为识别新进展进行了介绍和总结分析,包括双流法(Two-Stream)、CNN+LSTM 方法以及

基于 3D 卷积神经网络的方法。

关键字:行为识别;深度学习;LSTM;卷积神经网络

�

基于深度学习的视频行为识别综述

目录

1. 概述........................................................................................................................................................................ 1

2 双流(Two-Stream)方法.......................................................................................................................................... 2

3. CNN+LSTM 方法....................................................................................................................................................... 4

4 基于 3D 卷积神经网络的方法................................................................................................................................ 7

5 总结.......................................................................................................................................................................... 9

参考文献:.................................................................................................................................................................. 9

�

基于深度学习的视频行为识别综述

1. 概述

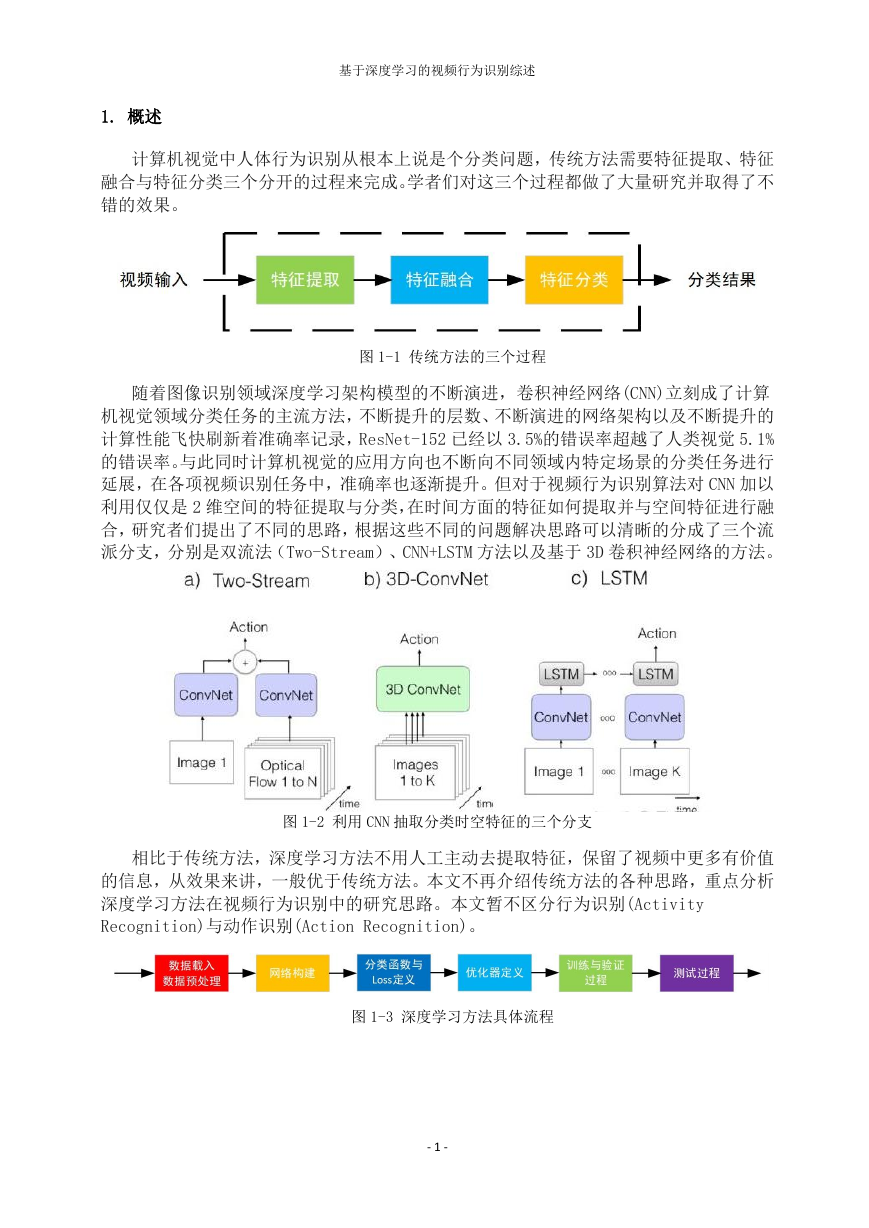

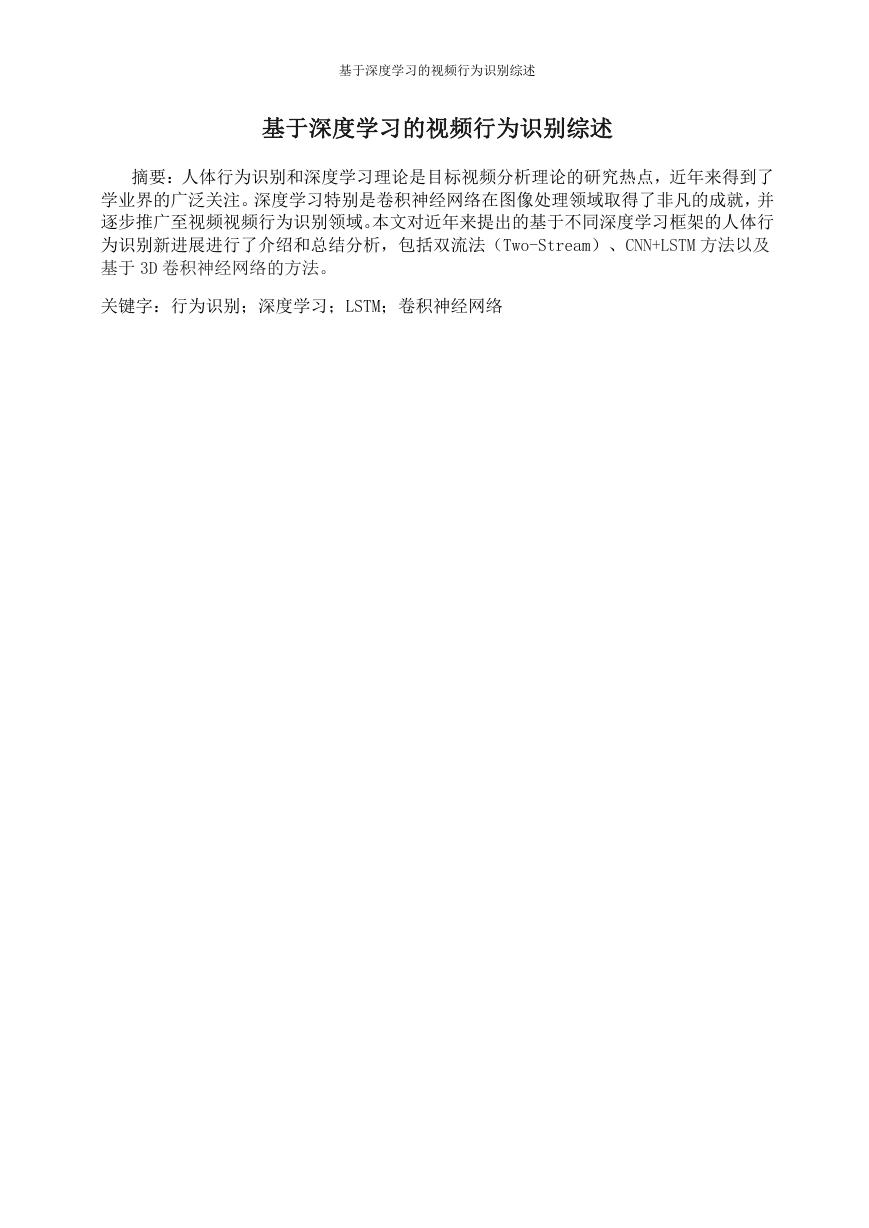

计算机视觉中人体行为识别从根本上说是个分类问题,传统方法需要特征提取、特征

融合与特征分类三个分开的过程来完成。学者们对这三个过程都做了大量研究并取得了不

错的效果。

图 1-1 传统方法的三个过程

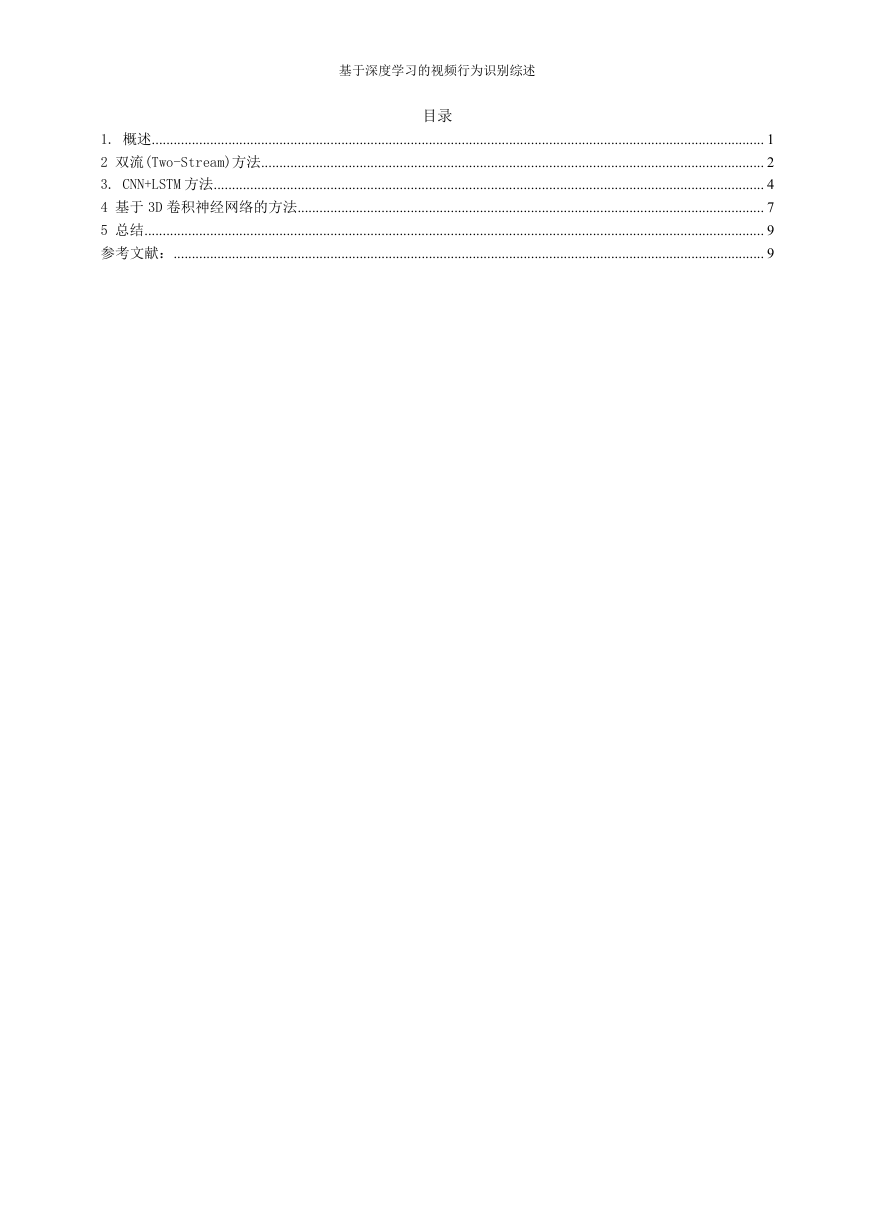

随着图像识别领域深度学习架构模型的不断演进,卷积神经网络(CNN)立刻成了计算

机视觉领域分类任务的主流方法,不断提升的层数、不断演进的网络架构以及不断提升的

计算性能飞快刷新着准确率记录,ResNet-152 已经以 3.5%的错误率超越了人类视觉 5.1%

的错误率。与此同时计算机视觉的应用方向也不断向不同领域内特定场景的分类任务进行

延展,在各项视频识别任务中,准确率也逐渐提升。但对于视频行为识别算法对 CNN 加以

利用仅仅是 2 维空间的特征提取与分类,在时间方面的特征如何提取并与空间特征进行融

合,研究者们提出了不同的思路,根据这些不同的问题解决思路可以清晰的分成了三个流

派分支,分别是双流法(Two-Stream)、CNN+LSTM 方法以及基于 3D 卷积神经网络的方法。

图 1-2 利用 CNN 抽取分类时空特征的三个分支

相比于传统方法,深度学习方法不用人工主动去提取特征,保留了视频中更多有价值

的信息,从效果来讲,一般优于传统方法。本文不再介绍传统方法的各种思路,重点分析

深度学习方法在视频行为识别中的研究思路。本文暂不区分行为识别(Activity

Recognition)与动作识别(Action Recognition)。

图 1-3 深度学习方法具体流程

- 1 -

�

基于深度学习的视频行为识别综述

2 双流(Two-Stream)方法

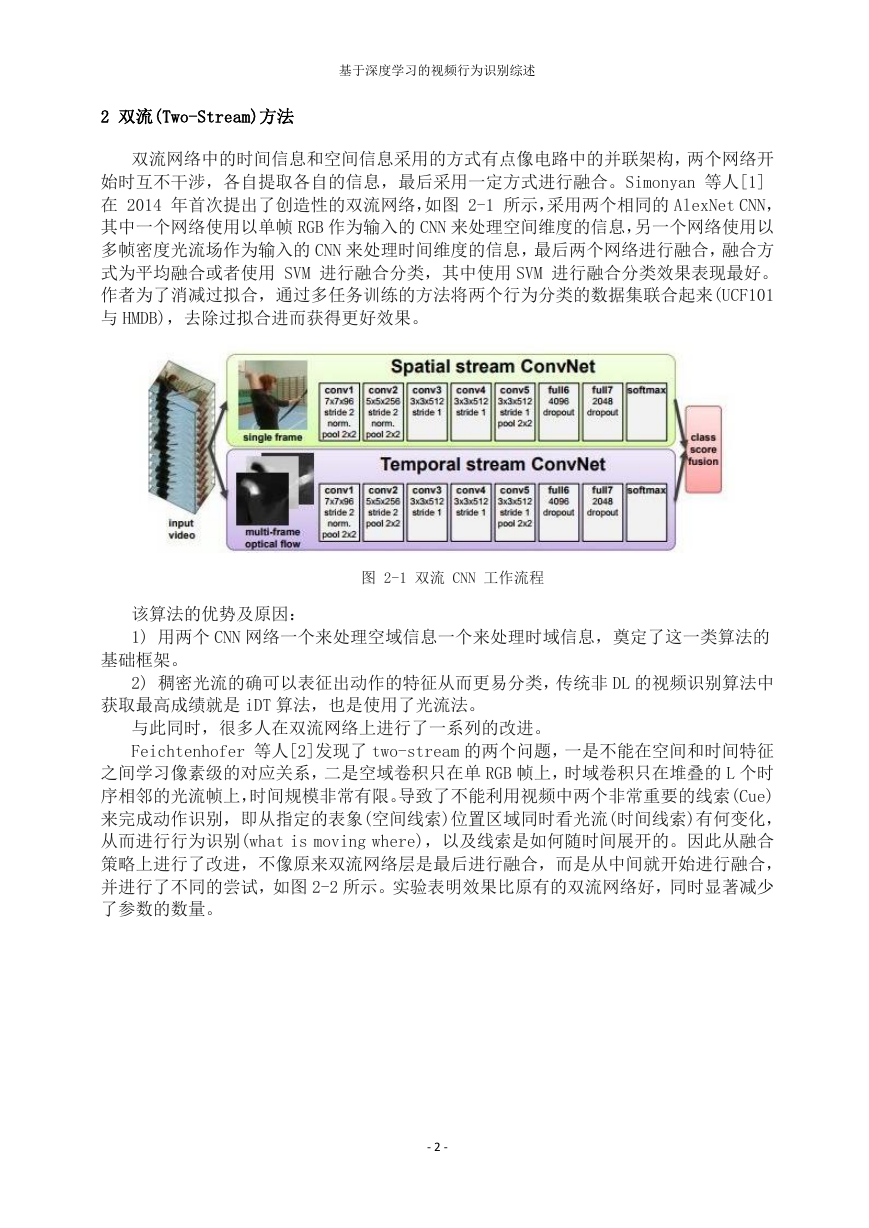

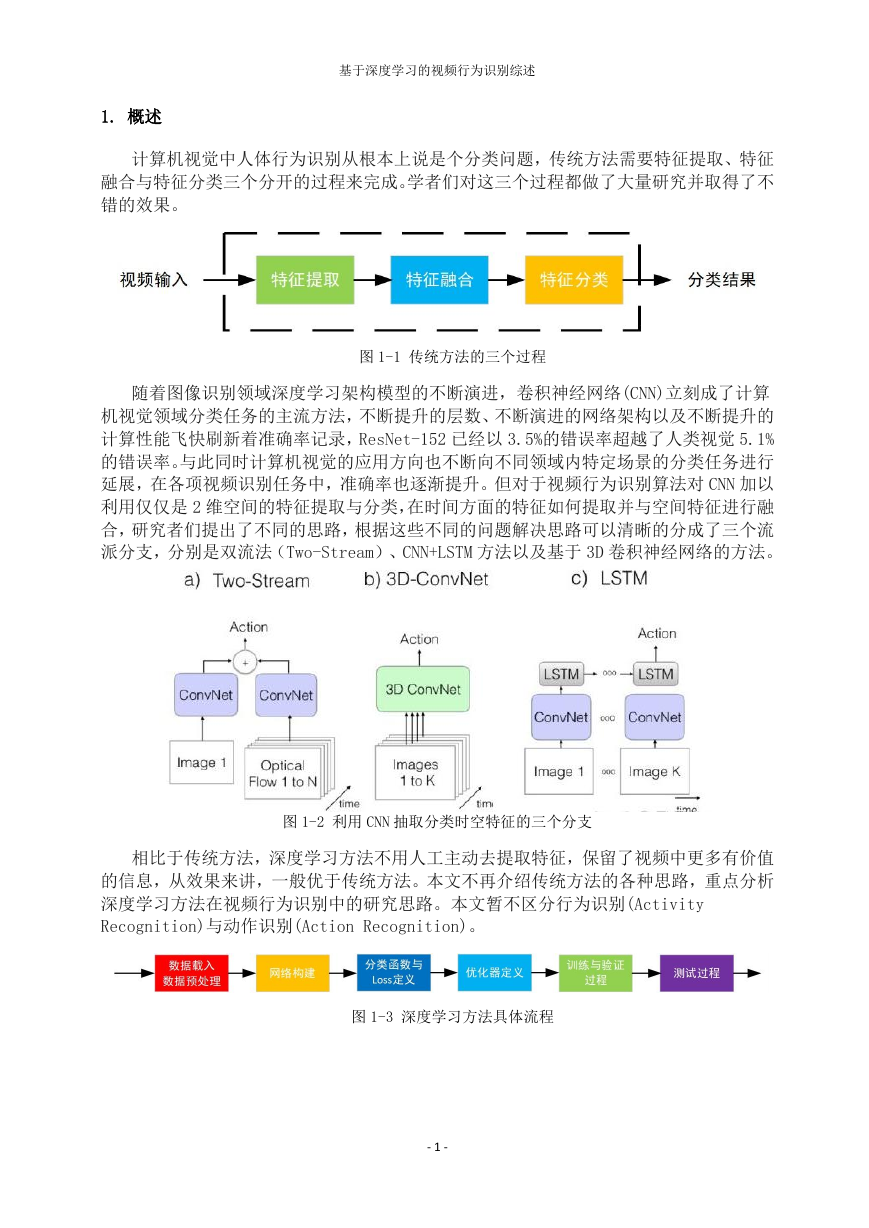

双流网络中的时间信息和空间信息采用的方式有点像电路中的并联架构,两个网络开

始时互不干涉,各自提取各自的信息,最后采用一定方式进行融合。Simonyan 等人[1]

在 2014 年首次提出了创造性的双流网络,如图 2-1 所示,采用两个相同的 AlexNet CNN,

其中一个网络使用以单帧 RGB 作为输入的 CNN 来处理空间维度的信息,另一个网络使用以

多帧密度光流场作为输入的 CNN 来处理时间维度的信息,最后两个网络进行融合,融合方

式为平均融合或者使用 SVM 进行融合分类,其中使用 SVM 进行融合分类效果表现最好。

作者为了消减过拟合,通过多任务训练的方法将两个行为分类的数据集联合起来(UCF101

与 HMDB),去除过拟合进而获得更好效果。

图 2-1 双流 CNN 工作流程

该算法的优势及原因:

1) 用两个 CNN 网络一个来处理空域信息一个来处理时域信息,奠定了这一类算法的

基础框架。

2) 稠密光流的确可以表征出动作的特征从而更易分类,传统非 DL 的视频识别算法中

获取最高成绩就是 iDT 算法,也是使用了光流法。

与此同时,很多人在双流网络上进行了一系列的改进。

Feichtenhofer 等人[2]发现了 two-stream 的两个问题,一是不能在空间和时间特征

之间学习像素级的对应关系,二是空域卷积只在单 RGB 帧上,时域卷积只在堆叠的 L 个时

序相邻的光流帧上,时间规模非常有限。导致了不能利用视频中两个非常重要的线索(Cue)

来完成动作识别,即从指定的表象(空间线索)位置区域同时看光流(时间线索)有何变化,

从而进行行为识别(what is moving where),以及线索是如何随时间展开的。因此从融合

策略上进行了改进,不像原来双流网络层是最后进行融合,而是从中间就开始进行融合,

并进行了不同的尝试,如图 2-2 所示。实验表明效果比原有的双流网络好,同时显著减少

了参数的数量。

- 2 -

�

基于深度学习的视频行为识别综述

图 2-2 Feichtenhofer 等人的双流网络融合策略

Wang 等人[3]使用改进的轨迹(iDT)代替光流提取时间信息,空间网络不变,并将

局部 ConvNet 响应汇集在以轨迹为中心的时空管上,其中生成的描述符称为 TDD,最后,

使用 Fisher 向量把整个视频中的局部 TDD 聚合成全局超向量,并使用线性 SVM 作为分

类器来执行行为识别。

Wang 等人[4]在发现了前人研究成果(尤其是 two-stream)只能处理短期运动

(short-term),对长期运动(long-range)时间结构进行理解不足,且训练样本较小,于是

使用了稀疏时间采样策略和基于视频监督的策略,将视频进行时域分割后随机抽取片段,

来弥补第一个不足,用交叉预训练、正则化技术和数据扩张技术弥补第二个不足,并将此

网络结构命名为时域分割网络(Temporal Segment Network, TSN),如图 2-3 所示,这样

不仅可以减少复杂度,还可以对多个分段进行融合,能够获取更多的上下文信息。时间流

网络的输入使用弯曲的光流(warped optical flow fields)来代替原有光流,这样可以

消除相机运动带来的影响。另外在训练时加入了交叉形式预训练、正则化、数据增强等技

术,使得网络更优。从最终效果分析,时间网络的输入采用光流、轨迹还是光流和轨迹的

改进方法,本质上对最终的结果影响不大,决定性的因素还是在网络的结构以及最终的融

合方式。

图 2-3 时域分割网络(Temporal Segment Network, TSN)

- 3 -

�

基于深度学习的视频行为识别综述

3. CNN+LSTM 方法

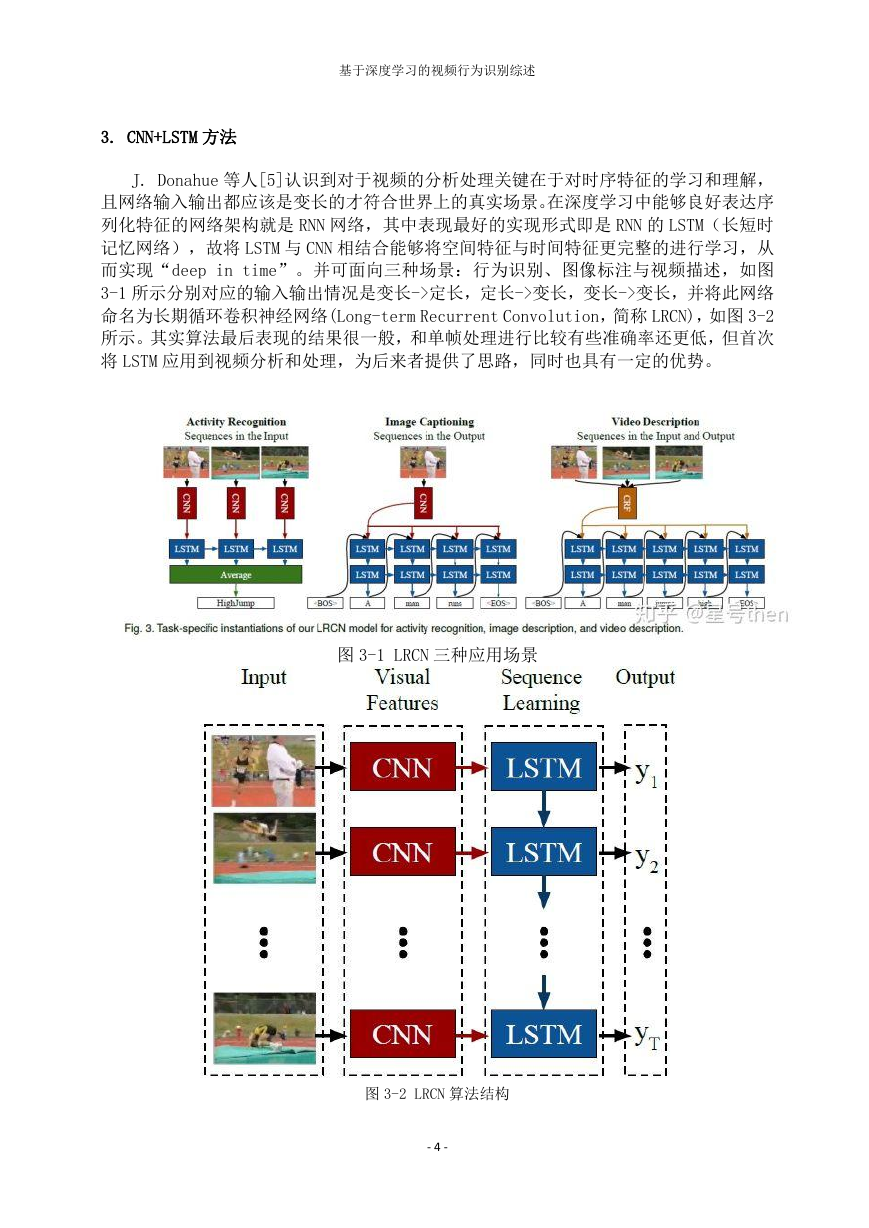

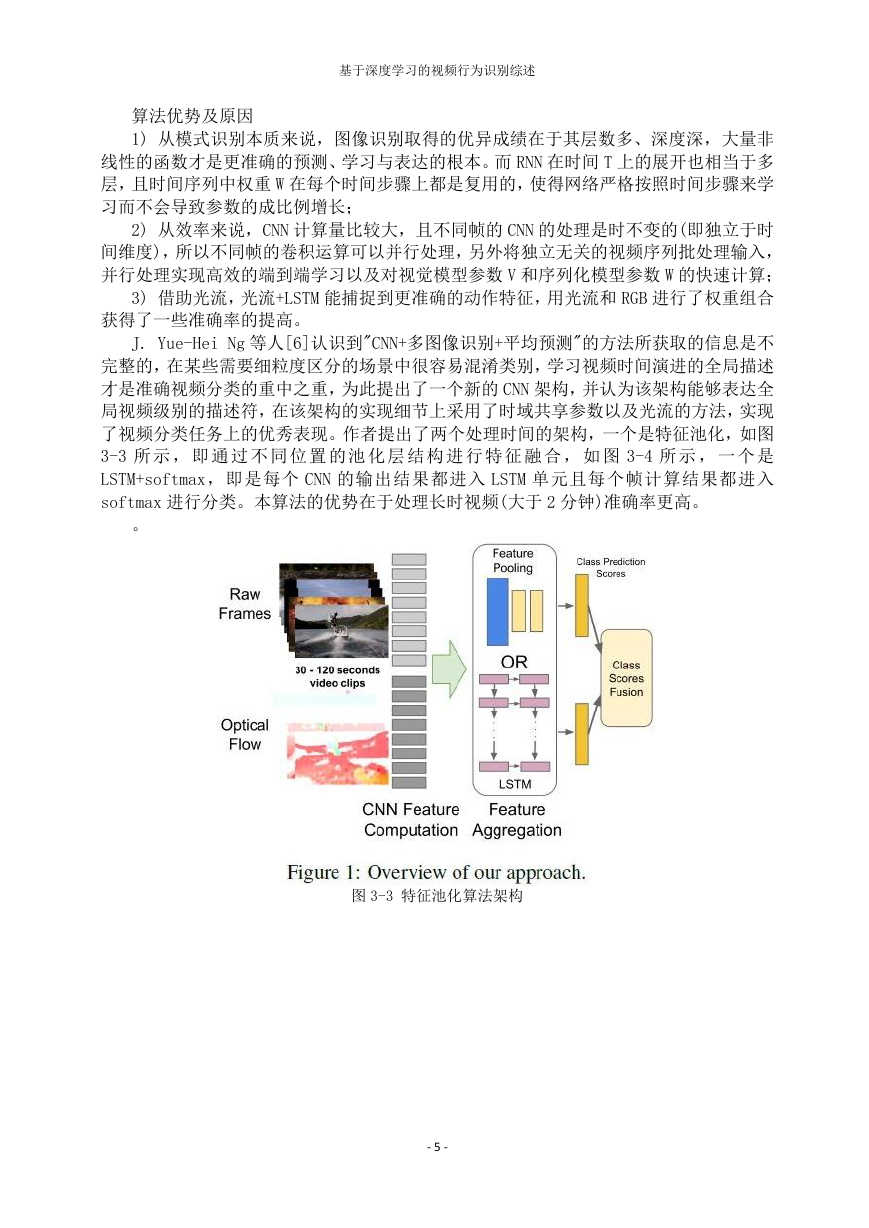

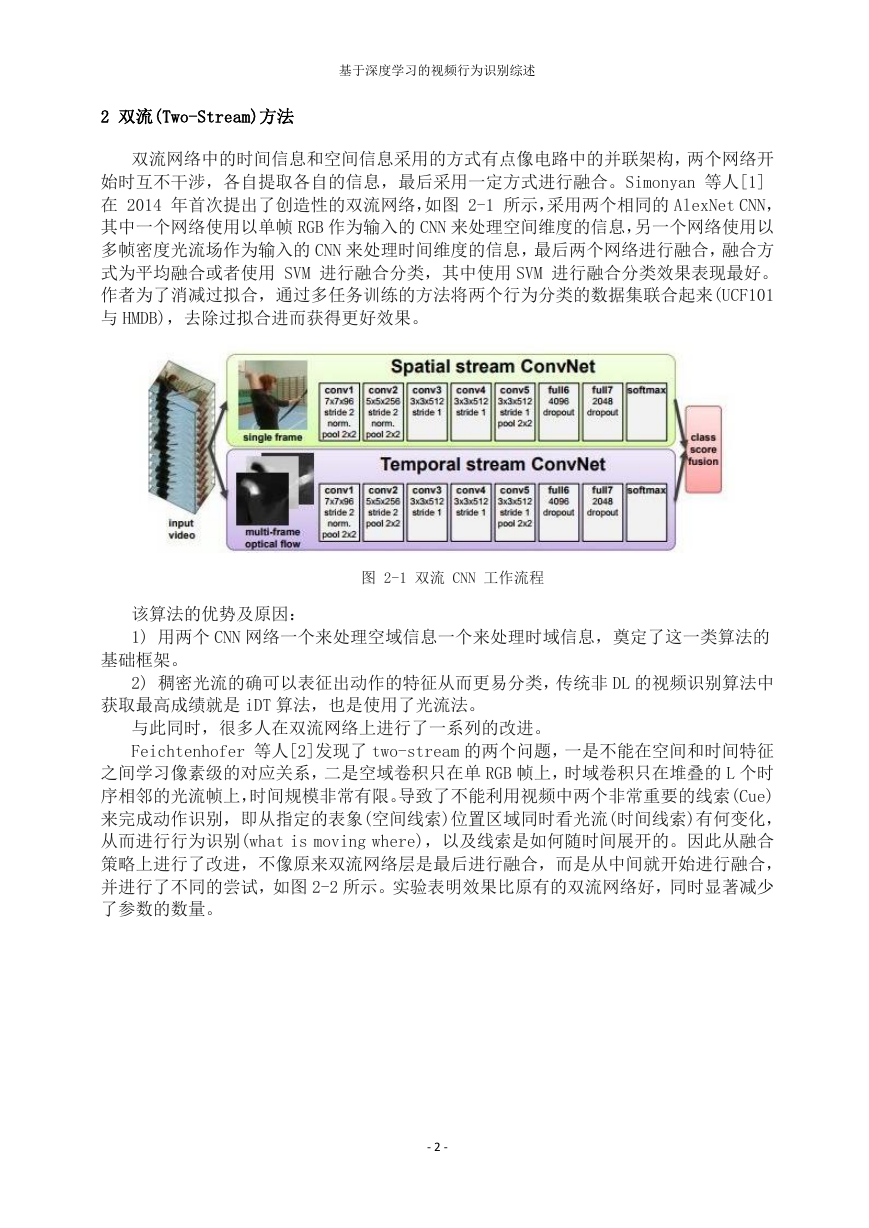

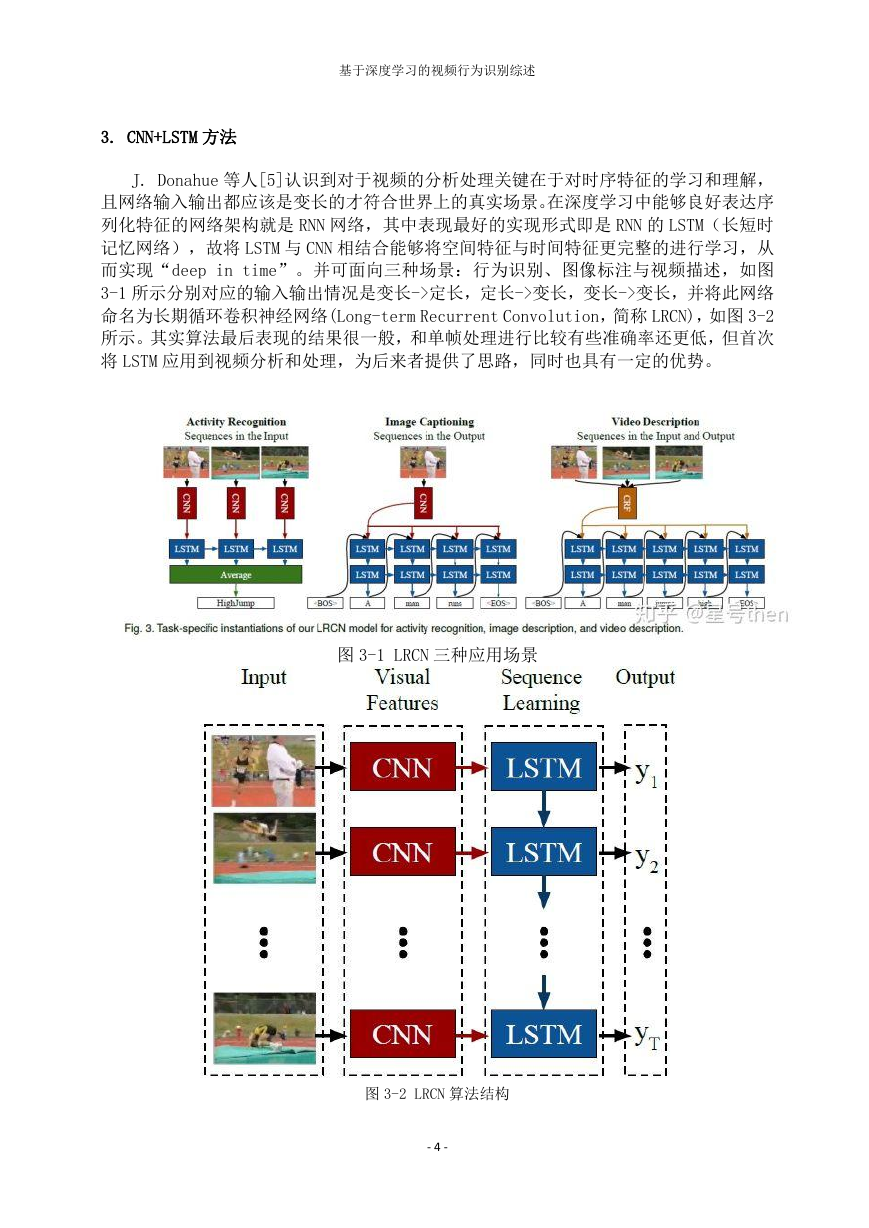

J. Donahue 等人[5]认识到对于视频的分析处理关键在于对时序特征的学习和理解,

且网络输入输出都应该是变长的才符合世界上的真实场景。在深度学习中能够良好表达序

列化特征的网络架构就是 RNN 网络,其中表现最好的实现形式即是 RNN 的 LSTM(长短时

记忆网络),故将 LSTM 与 CNN 相结合能够将空间特征与时间特征更完整的进行学习,从

而实现“deep in time”。并可面向三种场景:行为识别、图像标注与视频描述,如图

3-1 所示分别对应的输入输出情况是变长->定长,定长->变长,变长->变长,并将此网络

命名为长期循环卷积神经网络(Long-term Recurrent Convolution,简称 LRCN),如图 3-2

所示。其实算法最后表现的结果很一般,和单帧处理进行比较有些准确率还更低,但首次

将 LSTM 应用到视频分析和处理,为后来者提供了思路,同时也具有一定的优势。

图 3-1 LRCN 三种应用场景

图 3-2 LRCN 算法结构

- 4 -

�

基于深度学习的视频行为识别综述

算法优势及原因

1) 从模式识别本质来说,图像识别取得的优异成绩在于其层数多、深度深,大量非

线性的函数才是更准确的预测、学习与表达的根本。而 RNN 在时间 T 上的展开也相当于多

层,且时间序列中权重 W 在每个时间步骤上都是复用的,使得网络严格按照时间步骤来学

习而不会导致参数的成比例增长;

2) 从效率来说,CNN 计算量比较大,且不同帧的 CNN 的处理是时不变的(即独立于时

间维度),所以不同帧的卷积运算可以并行处理,另外将独立无关的视频序列批处理输入,

并行处理实现高效的端到端学习以及对视觉模型参数 V 和序列化模型参数 W 的快速计算;

3) 借助光流,光流+LSTM 能捕捉到更准确的动作特征,用光流和 RGB 进行了权重组合

获得了一些准确率的提高。

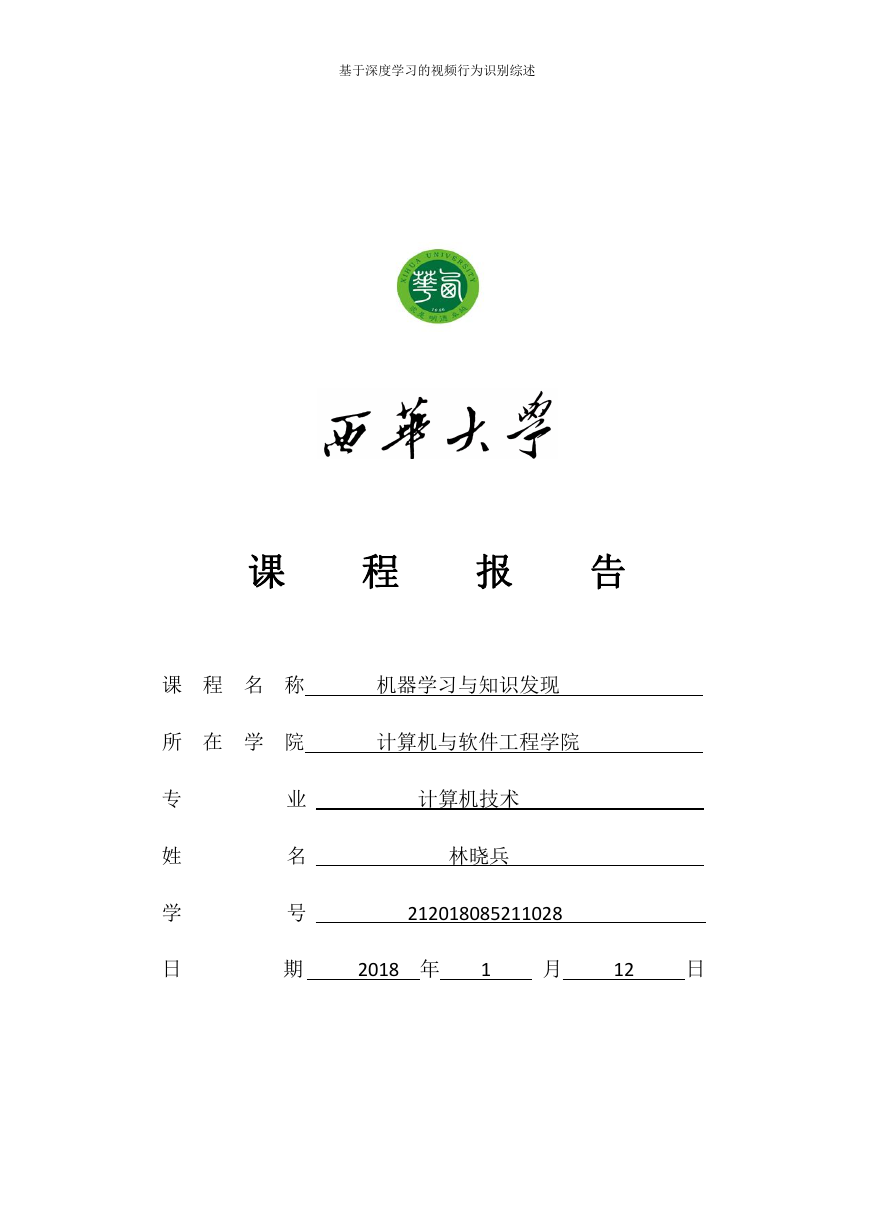

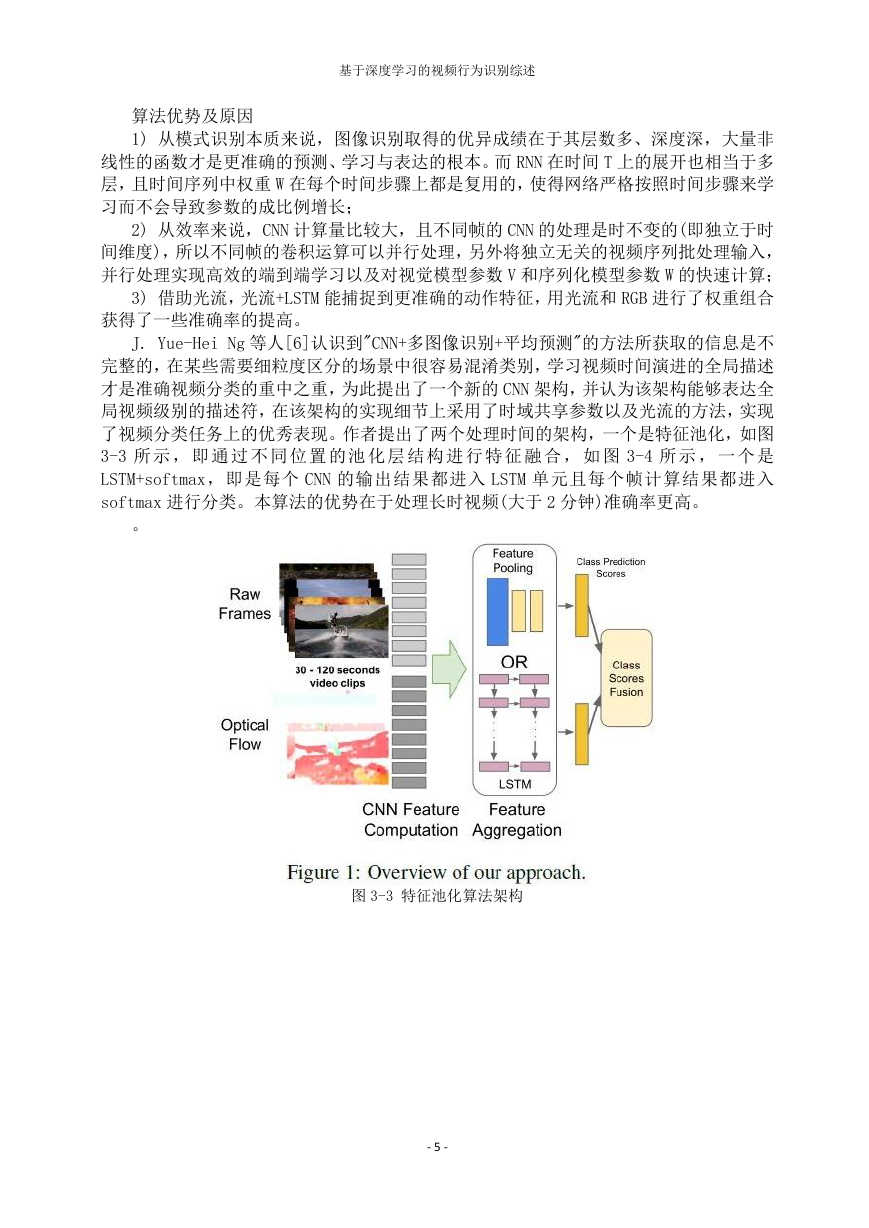

J. Yue-Hei Ng 等人[6]认识到"CNN+多图像识别+平均预测"的方法所获取的信息是不

完整的,在某些需要细粒度区分的场景中很容易混淆类别,学习视频时间演进的全局描述

才是准确视频分类的重中之重,为此提出了一个新的 CNN 架构,并认为该架构能够表达全

局视频级别的描述符,在该架构的实现细节上采用了时域共享参数以及光流的方法,实现

了视频分类任务上的优秀表现。作者提出了两个处理时间的架构,一个是特征池化,如图

3-3 所 示 , 即 通 过 不 同 位 置 的 池 化 层 结 构 进 行 特 征 融 合 , 如 图 3-4 所 示 , 一 个 是

LSTM+softmax,即是每个 CNN 的输出结果都进入 LSTM 单元且每个帧计算结果都进入

softmax 进行分类。本算法的优势在于处理长时视频(大于 2 分钟)准确率更高。

。

图 3-3 特征池化算法架构

- 5 -

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc