简易网络爬虫程序的开发(c#版)收藏

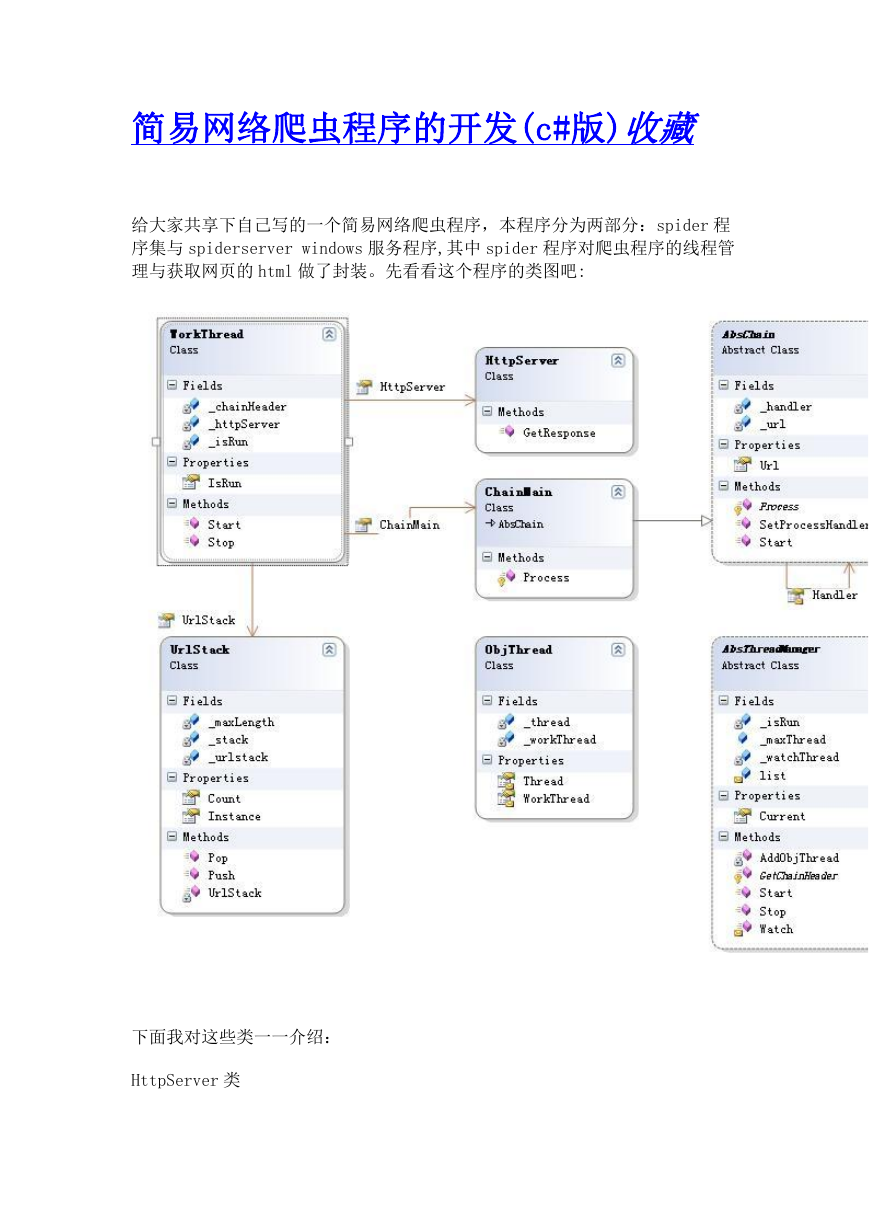

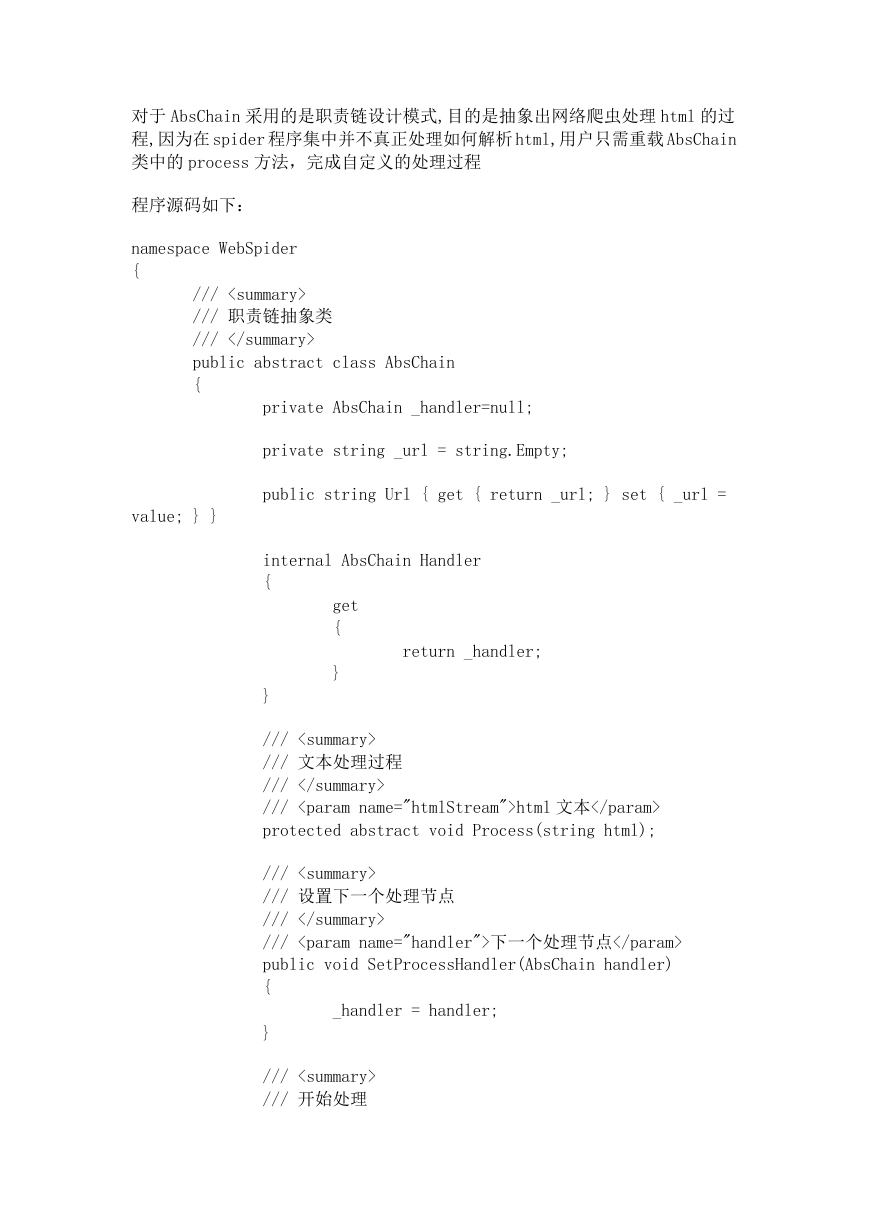

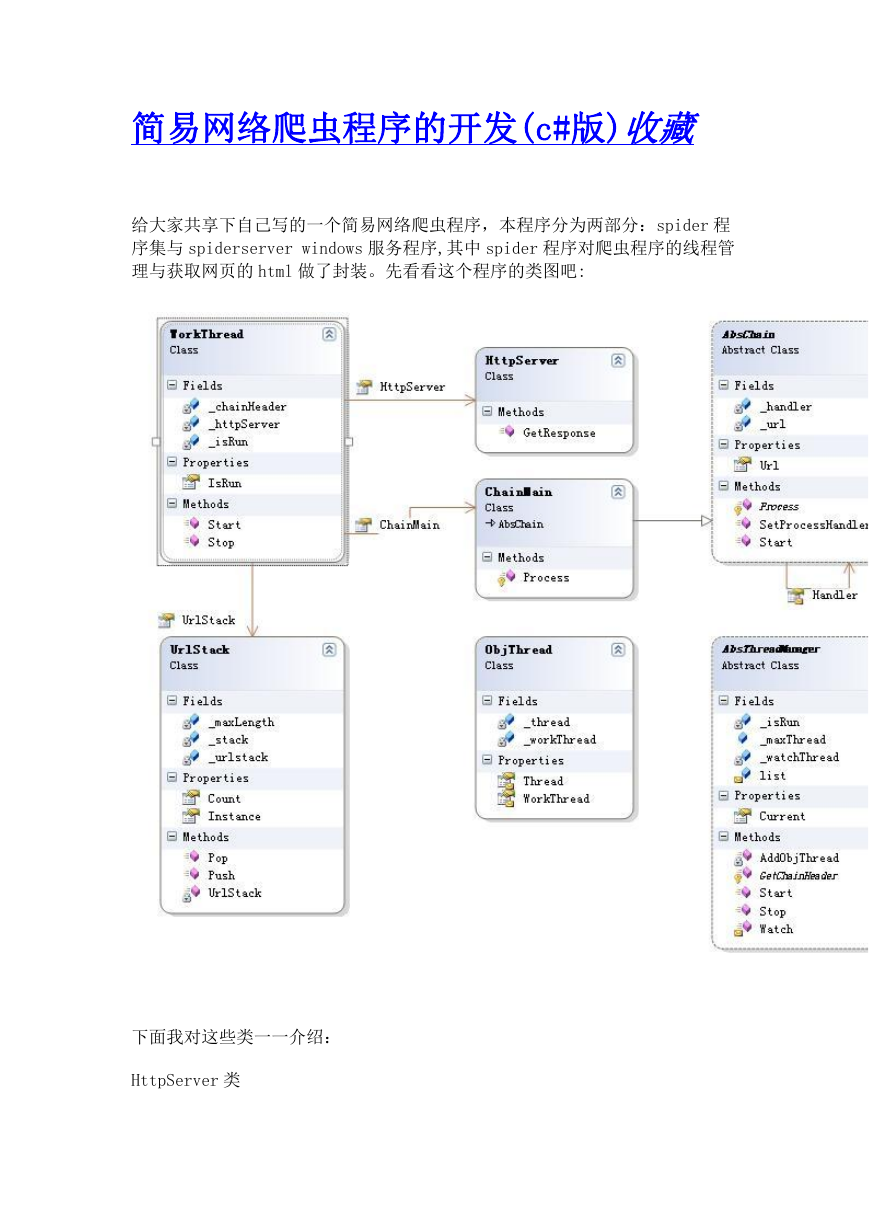

给大家共享下自己写的一个简易网络爬虫程序,本程序分为两部分:spider 程

序集与 spiderserver windows 服务程序,其中 spider 程序对爬虫程序的线程管

理与获取网页的 html 做了封装。先看看这个程序的类图吧:

下面我对这些类一一介绍:

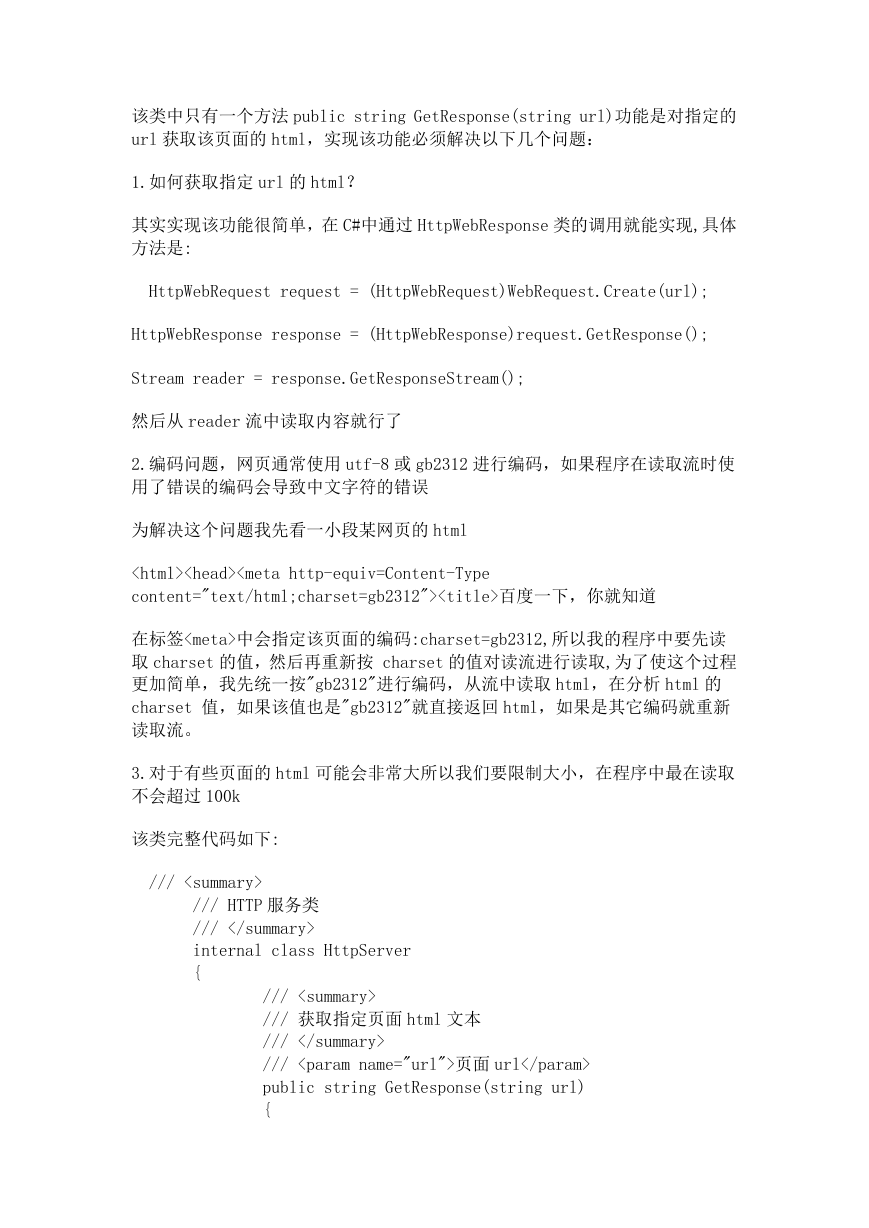

HttpServer 类

�

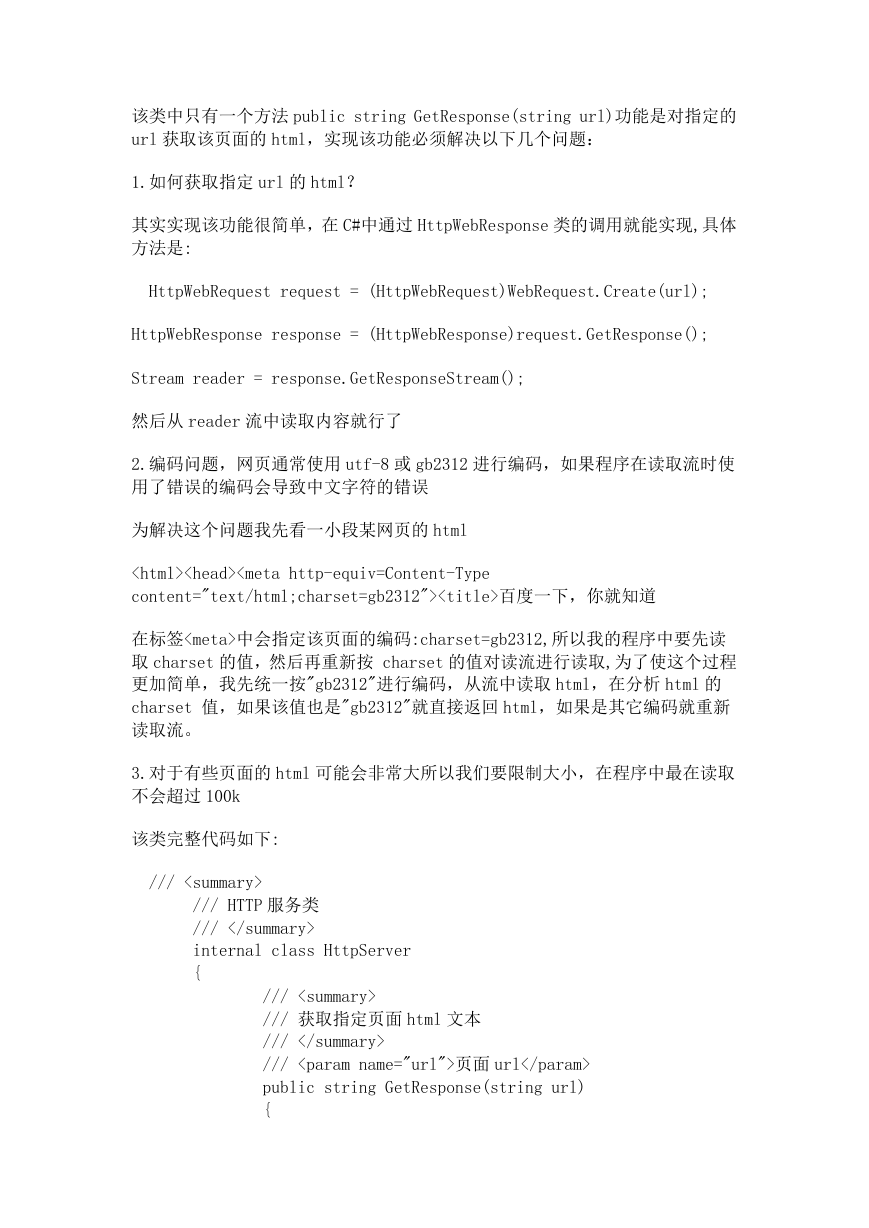

该类中只有一个方法 public string GetResponse(string url)功能是对指定的

url 获取该页面的 html,实现该功能必须解决以下几个问题:

1.如何获取指定 url 的 html?

其实实现该功能很简单,在 C#中通过 HttpWebResponse 类的调用就能实现,具体

方法是:

HttpWebRequest request = (HttpWebRequest)WebRequest.Create(url);

HttpWebResponse response = (HttpWebResponse)request.GetResponse();

Stream reader = response.GetResponseStream();

然后从 reader 流中读取内容就行了

2.编码问题,网页通常使用 utf-8 或 gb2312 进行编码,如果程序在读取流时使

用了错误的编码会导致中文字符的错误

为解决这个问题我先看一小段某网页的 html

百度一下,你就知道

在标签<meta>中会指定该页面的编码:charset=gb2312,所以我的程序中要先读

取 charset 的值,然后再重新按 charset 的值对读流进行读取,为了使这个过程

更加简单,我先统一按"gb2312"进行编码,从流中读取 html,在分析 html 的

charset 值,如果该值也是"gb2312"就直接返回 html,如果是其它编码就重新

读取流。

3.对于有些页面的 html 可能会非常大所以我们要限制大小,在程序中最在读取

不会超过 100k

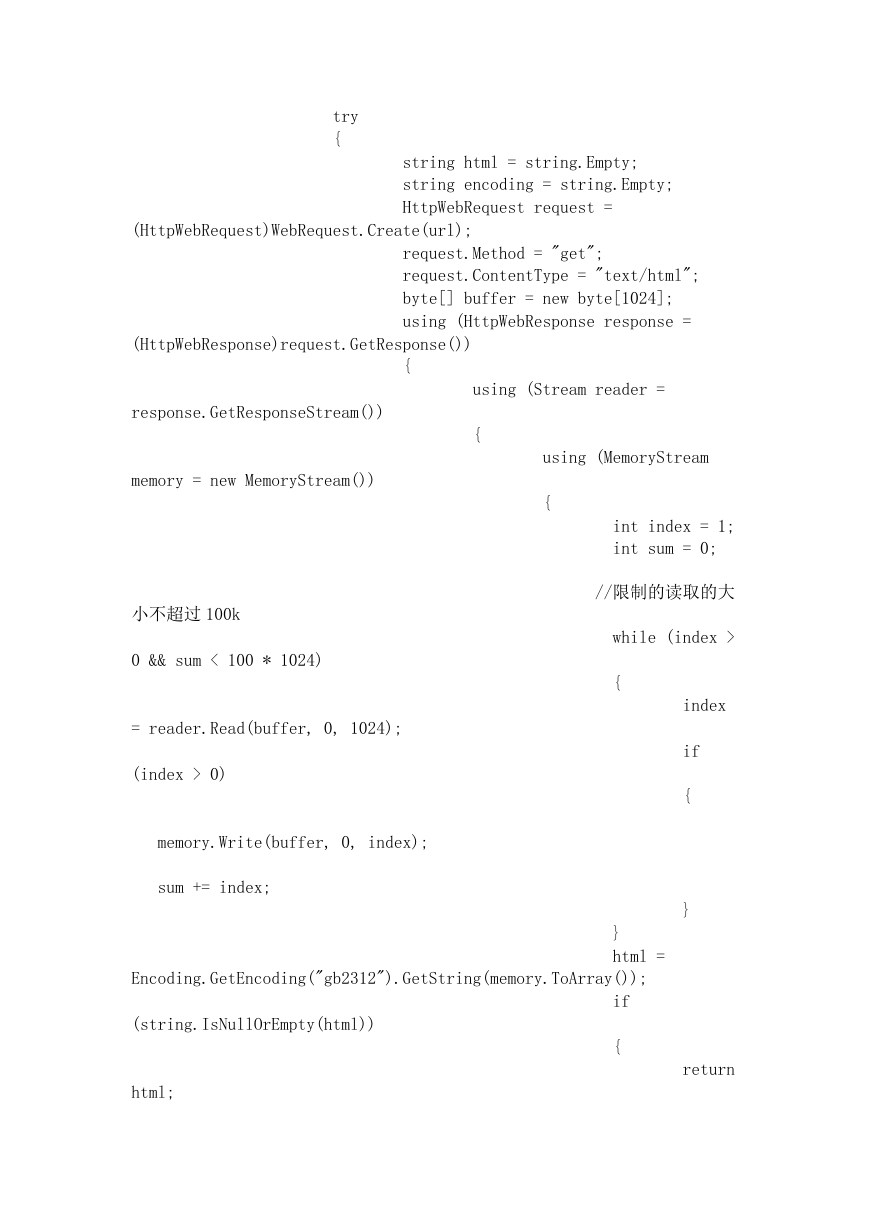

该类完整代码如下:

/// <summary>

/// HTTP 服务类

/// </summary>

internal class HttpServer

{

/// <summary>

/// 获取指定页面 html 文本

/// </summary>

/// <param name="url">页面 url</param>

public string GetResponse(string url)

{

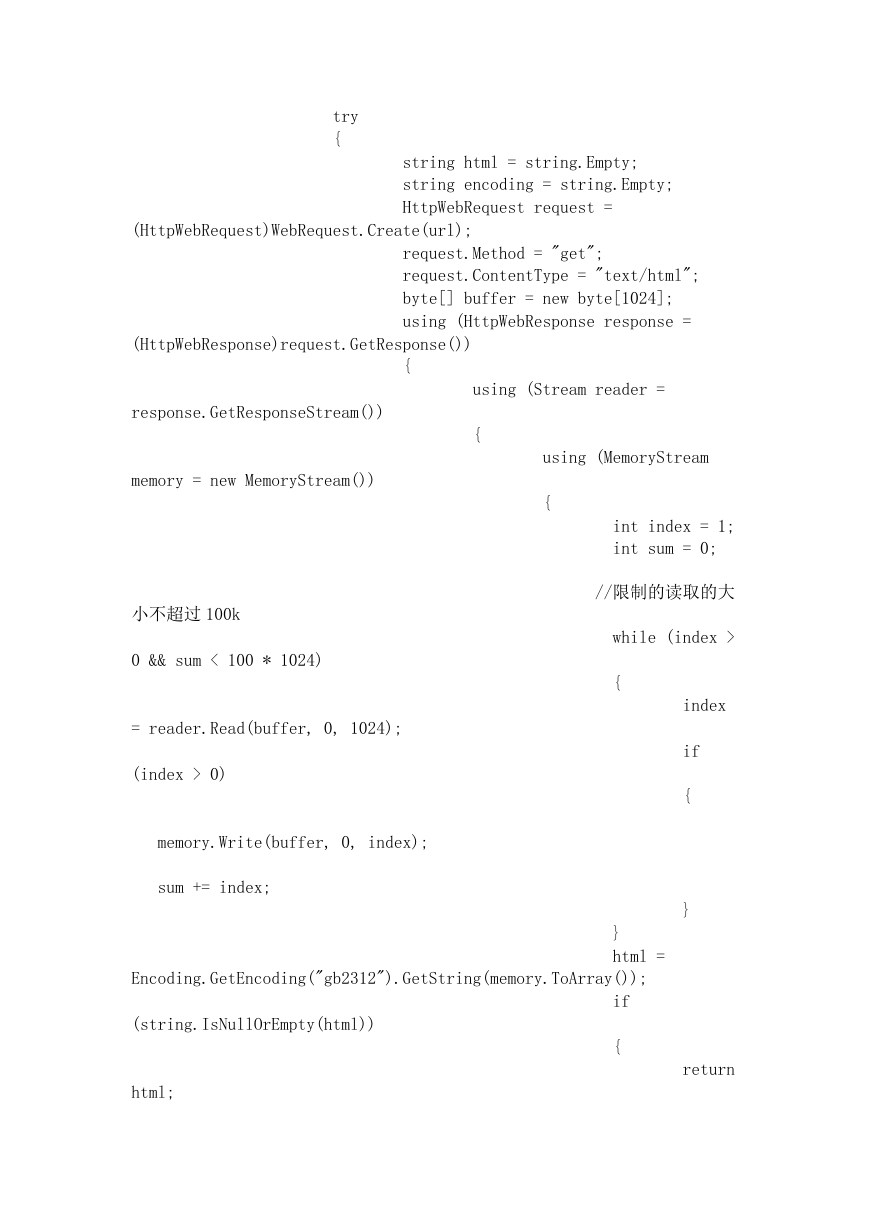

�</div><div id='PreviewText_3' class='preview-text'>try

{

string html = string.Empty;

string encoding = string.Empty;

HttpWebRequest request =

(HttpWebRequest)WebRequest.Create(url);

request.Method = "get";

request.ContentType = "text/html";

byte[] buffer = new byte[1024];

using (HttpWebResponse response =

(HttpWebResponse)request.GetResponse())

response.GetResponseStream())

memory = new MemoryStream())

{

using (Stream reader =

{

using (MemoryStream

{

小不超过 100k

0 && sum < 100 * 1024)

= reader.Read(buffer, 0, 1024);

(index > 0)

memory.Write(buffer, 0, index);

sum += index;

int index = 1;

int sum = 0;

//限制的读取的大

while (index >

{

index

if

{

}

}

html =

Encoding.GetEncoding("gb2312").GetString(memory.ToArray());

(string.IsNullOrEmpty(html))

html;

if

{

return

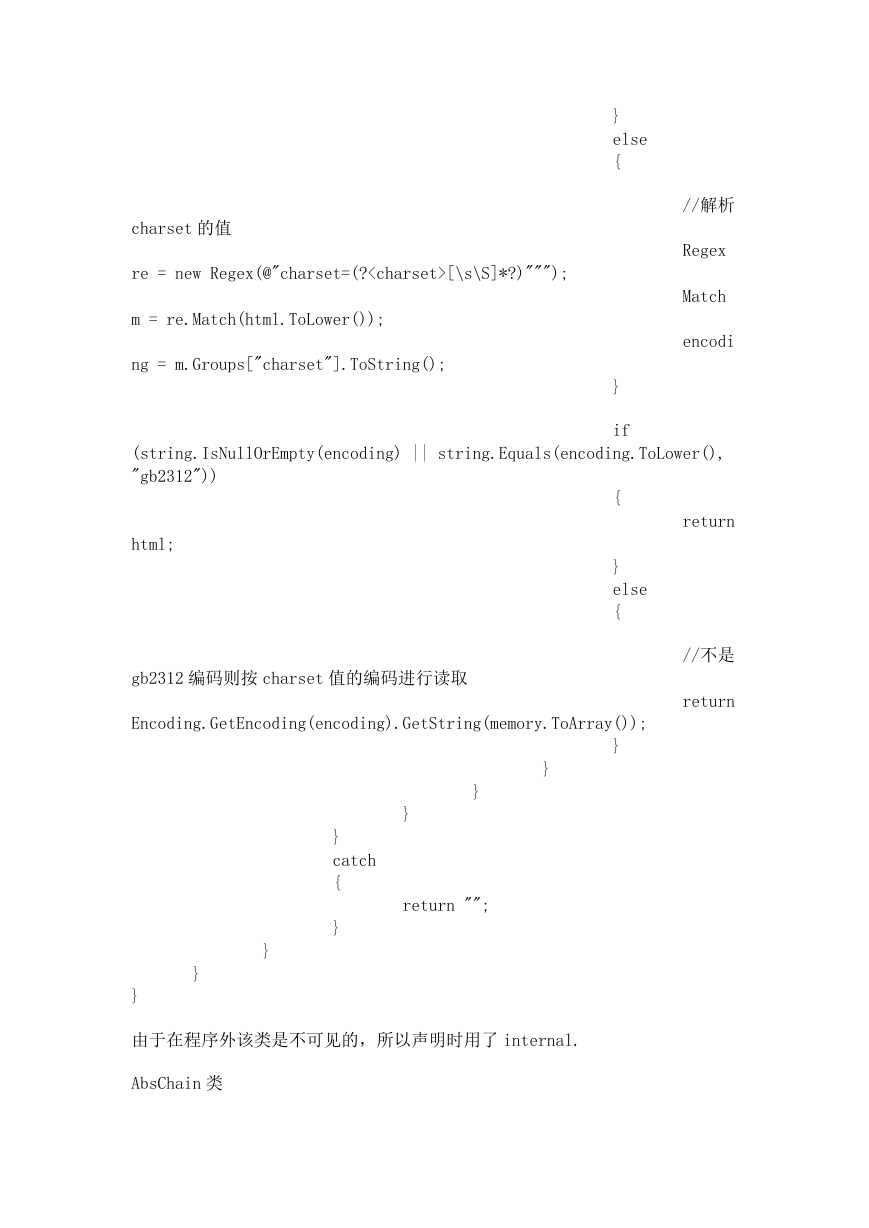

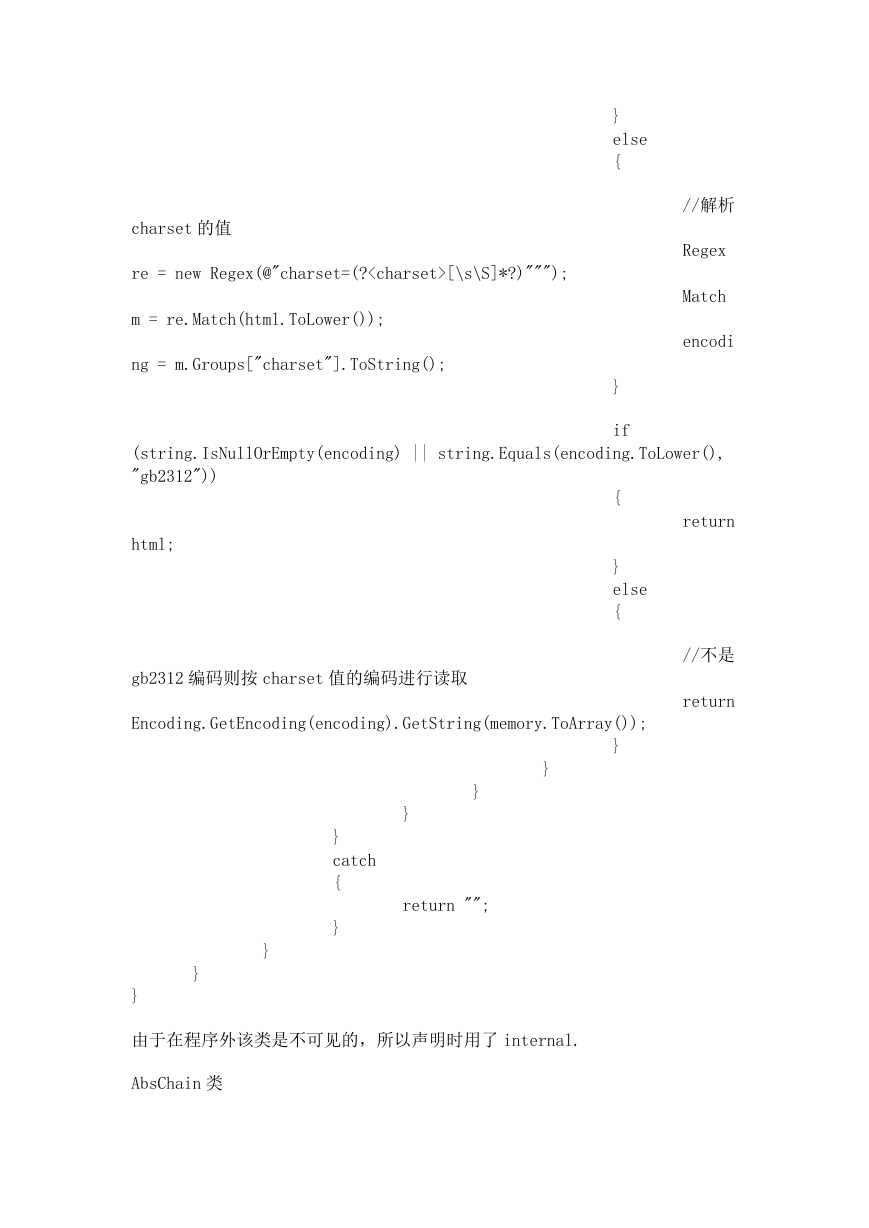

�</div><div id='PreviewText_4' class='preview-text'>charset 的值

re = new Regex(@"charset=(?<charset>[\s\S]*?)""");

m = re.Match(html.ToLower());

ng = m.Groups["charset"].ToString();

}

else

{

}

if

//解析

Regex

Match

encodi

(string.IsNullOrEmpty(encoding) || string.Equals(encoding.ToLower(),

"gb2312"))

html;

gb2312 编码则按 charset 值的编码进行读取

{

}

else

{

return

//不是

return

Encoding.GetEncoding(encoding).GetString(memory.ToArray());

}

}

}

}

return "";

}

catch

{

}

}

}

}

由于在程序外该类是不可见的,所以声明时用了 internal.

AbsChain 类

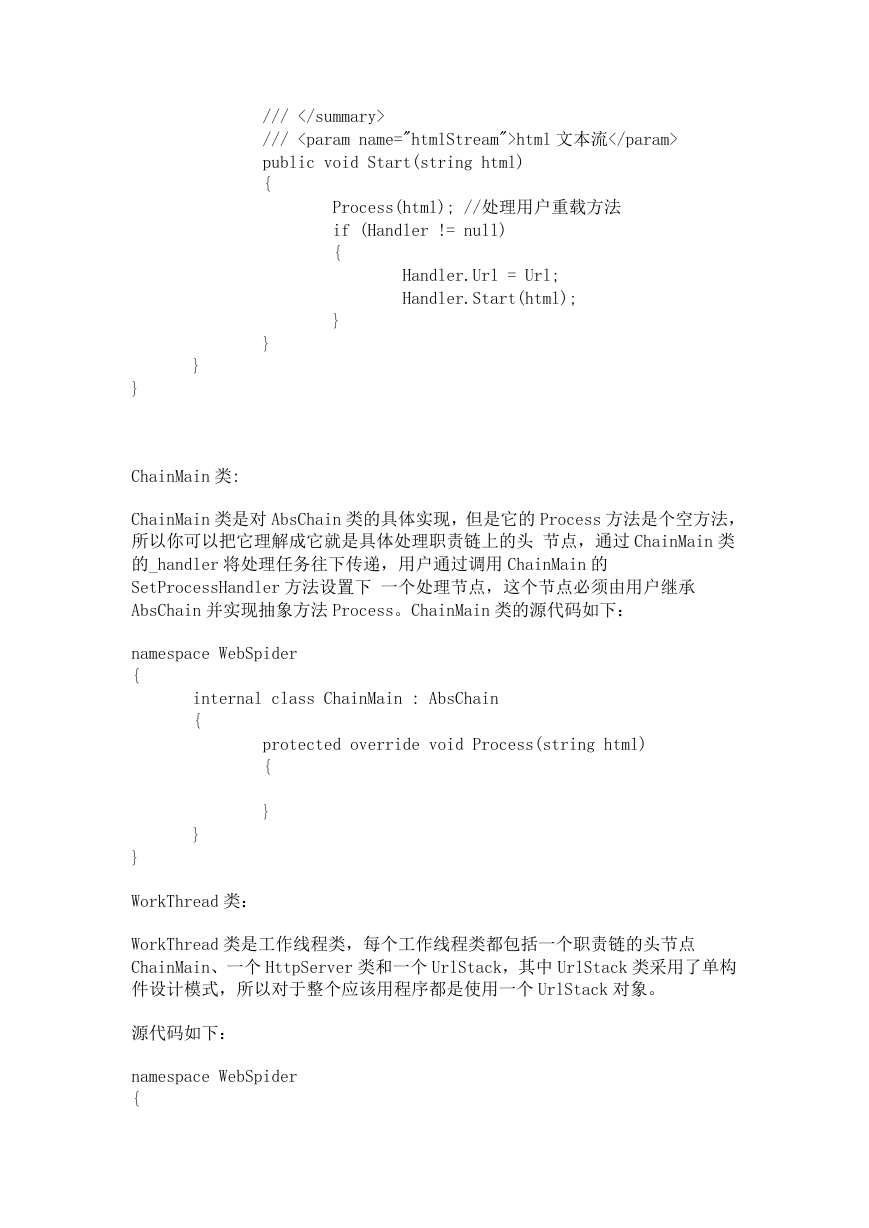

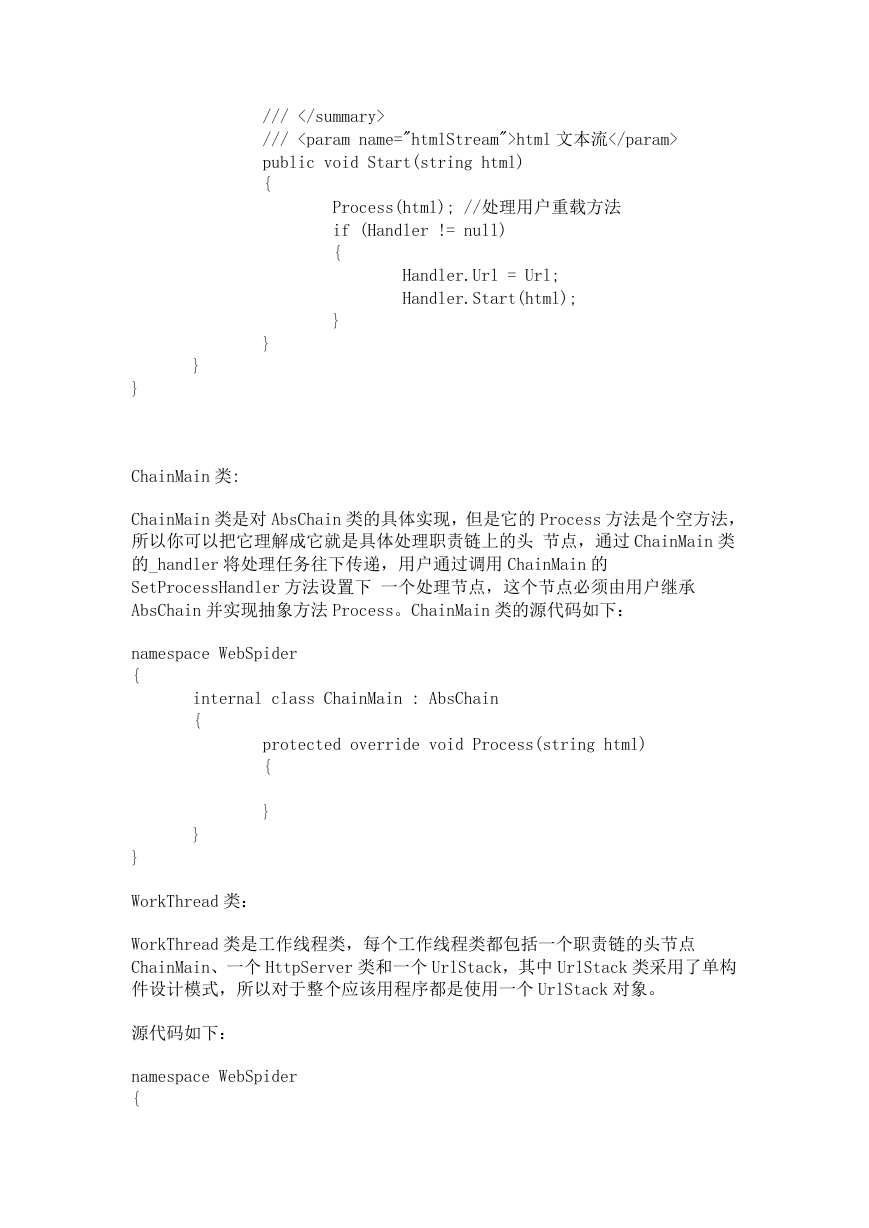

�</div><div id='PreviewText_5' class='preview-text'>对于 AbsChain 采用的是职责链设计模式,目的是抽象出网络爬虫处理 html 的过

程,因为在 spider 程序集中并不真正处理如何解析 html,用户只需重载 AbsChain

类中的 process 方法,完成自定义的处理过程

程序源码如下:

namespace WebSpider

{

/// <summary>

/// 职责链抽象类

/// </summary>

public abstract class AbsChain

{

private AbsChain _handler=null;

private string _url = string.Empty;

public string Url { get { return _url; } set { _url =

value; } }

internal AbsChain Handler

{

get

{

}

}

return _handler;

/// <summary>

/// 文本处理过程

/// </summary>

/// <param name="htmlStream">html 文本</param>

protected abstract void Process(string html);

/// <summary>

/// 设置下一个处理节点

/// </summary>

/// <param name="handler">下一个处理节点</param>

public void SetProcessHandler(AbsChain handler)

{

_handler = handler;

}

/// <summary>

/// 开始处理

�</div><div id='PreviewText_6' class='preview-text'>/// </summary>

/// <param name="htmlStream">html 文本流</param>

public void Start(string html)

{

Process(html); //处理用户重载方法

if (Handler != null)

{

Handler.Url = Url;

Handler.Start(html);

}

}

}

}

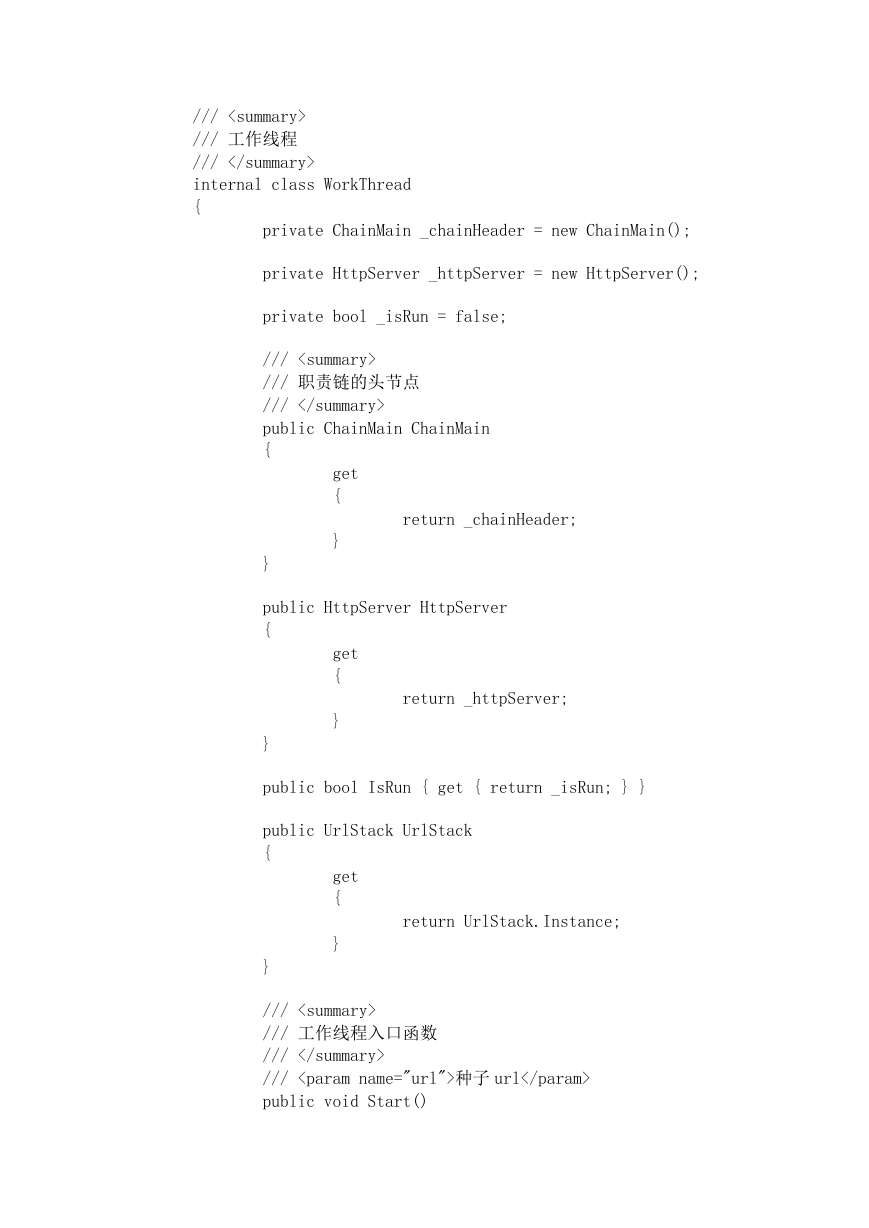

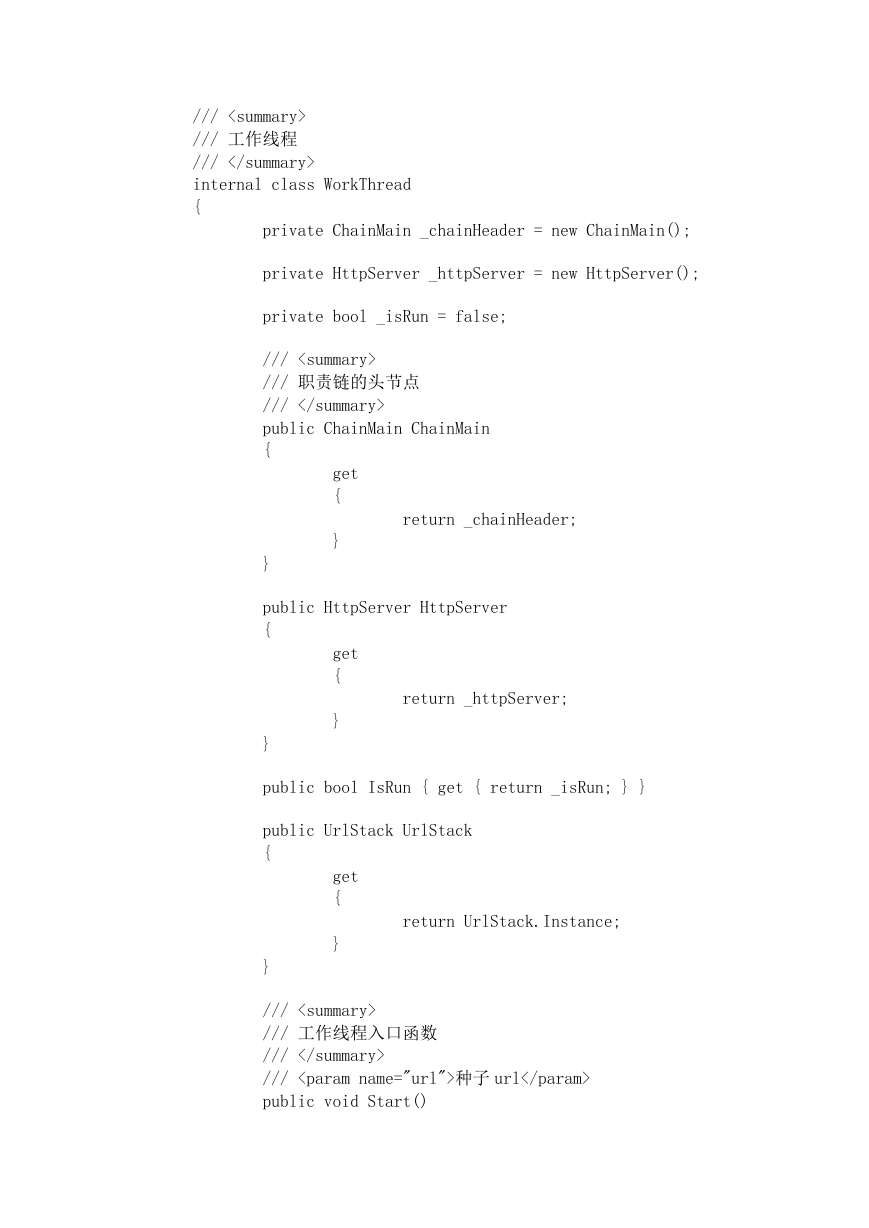

ChainMain 类:

ChainMain 类是对 AbsChain 类的具体实现,但是它的 Process 方法是个空方法,

所以你可以把它理解成它就是具体处理职责链上的头 节点,通过 ChainMain 类

的_handler 将处理任务往下传递,用户通过调用 ChainMain 的

SetProcessHandler 方法设置下 一个处理节点,这个节点必须由用户继承

AbsChain 并实现抽象方法 Process。ChainMain 类的源代码如下:

namespace WebSpider

{

internal class ChainMain : AbsChain

{

protected override void Process(string html)

{

}

}

}

WorkThread 类:

WorkThread 类是工作线程类,每个工作线程类都包括一个职责链的头节点

ChainMain、一个 HttpServer 类和一个 UrlStack,其中 UrlStack 类采用了单构

件设计模式,所以对于整个应该用程序都是使用一个 UrlStack 对象。

源代码如下:

namespace WebSpider

{

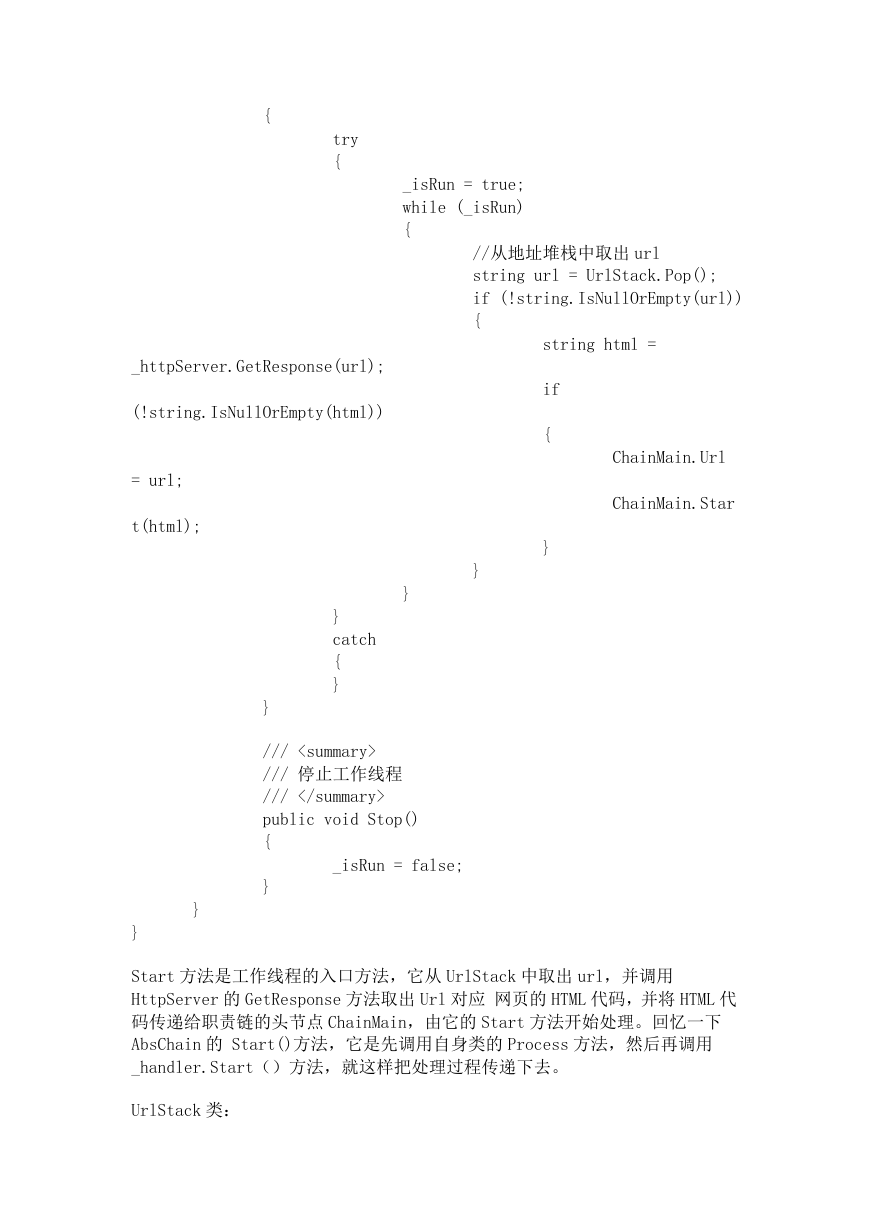

�</div><div id='PreviewText_7' class='preview-text'>/// <summary>

/// 工作线程

/// </summary>

internal class WorkThread

{

private ChainMain _chainHeader = new ChainMain();

private HttpServer _httpServer = new HttpServer();

private bool _isRun = false;

/// <summary>

/// 职责链的头节点

/// </summary>

public ChainMain ChainMain

{

get

{

}

}

return _chainHeader;

public HttpServer HttpServer

{

get

{

}

}

return _httpServer;

public bool IsRun { get { return _isRun; } }

public UrlStack UrlStack

{

get

{

}

}

return UrlStack.Instance;

/// <summary>

/// 工作线程入口函数

/// </summary>

/// <param name="url">种子 url</param>

public void Start()

�</div><div id='PreviewText_8' class='preview-text'>{

try

{

_isRun = true;

while (_isRun)

{

_httpServer.GetResponse(url);

(!string.IsNullOrEmpty(html))

= url;

t(html);

//从地址堆栈中取出 url

string url = UrlStack.Pop();

if (!string.IsNullOrEmpty(url))

{

string html =

if

{

}

ChainMain.Url

ChainMain.Star

}

}

}

catch

{

}

}

/// <summary>

/// 停止工作线程

/// </summary>

public void Stop()

{

_isRun = false;

}

}

}

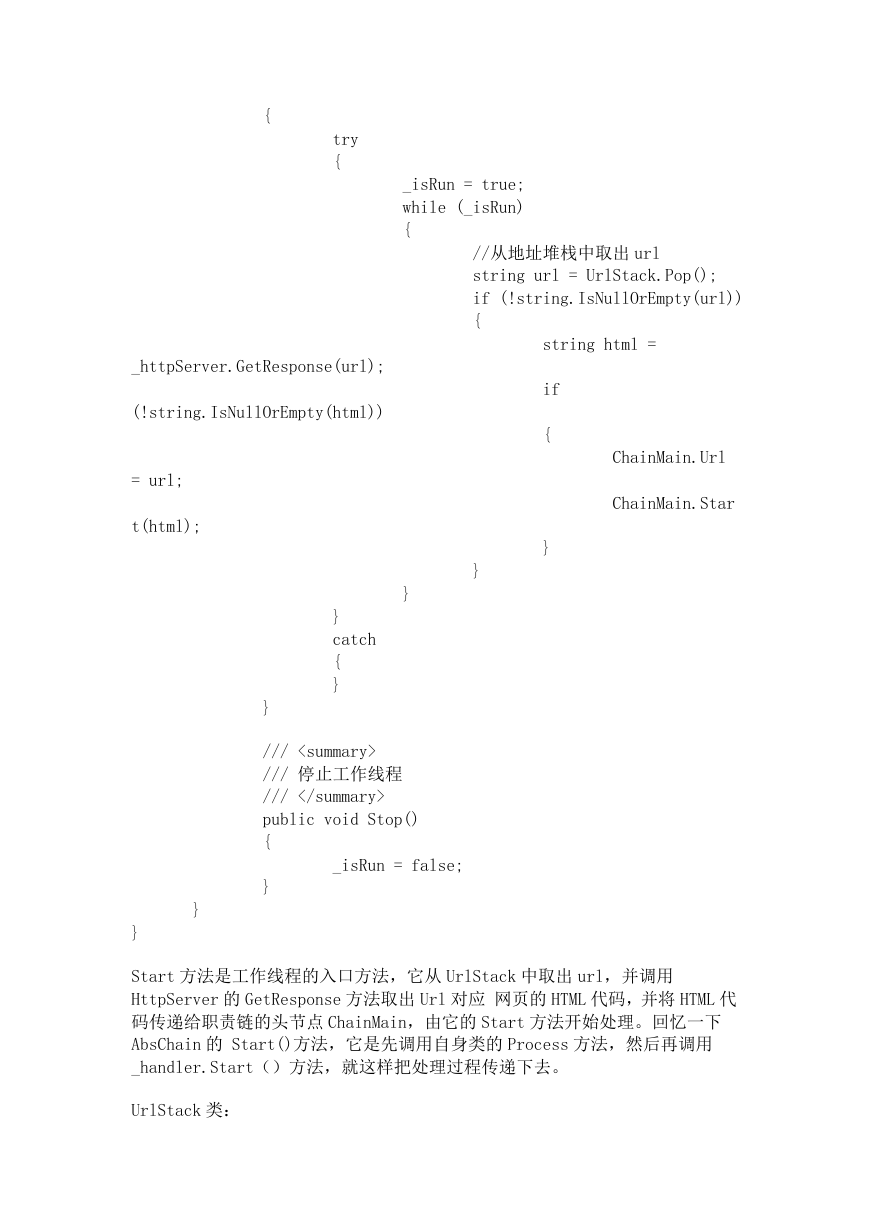

Start 方法是工作线程的入口方法,它从 UrlStack 中取出 url,并调用

HttpServer 的 GetResponse 方法取出 Url 对应 网页的 HTML 代码,并将 HTML 代

码传递给职责链的头节点 ChainMain,由它的 Start 方法开始处理。回忆一下

AbsChain 的 Start()方法,它是先调用自身类的 Process 方法,然后再调用

_handler.Start()方法,就这样把处理过程传递下去。

UrlStack 类:

�</div>

</div>

</div>

</div>

</div>

</div>

<div class="article-actions clearfix">

<div class="shares">

<strong>分享到:</strong>

<a href="javascript:;" data-url="https://www.ziliaoku.com/res/info_89665bf051d444c5aa41758867f32fbc.html" class="share-weixin" title="分享到微信"><i class="fa"></i><span class="share-popover"><span class="share-popover-inner" id="weixin-qrcode"><canvas width="80" height="80"></canvas></span></span></a>

<a etap="share" data-share="weibo" class="share-tsina" title="分享到微博"><i class="fa"></i></a>

<a etap="share" data-share="tqq" class="share-tqq" title="分享到腾讯微博"><i class="fa"></i></a>

<a etap="share" data-share="qq" class="share-sqq" title="分享到QQ好友" href="http://connect.qq.com/widget/shareqq/index.html?url=https://www.ziliaoku.com/res/info_89665bf051d444c5aa41758867f32fbc.html&desc=简易网络爬虫程序的开发(c#版).doc&summary=简易网络爬虫程序的开发(c#版).doc&site=zeshlife&pics=https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/0a/45/ff/0a45ffc851bc4b29aa877bdd247804d5.doc-1.png" target="_blank"><i class="fa"></i></a>

<a etap="share" data-share="qzone" class="share-qzone" title="分享到QQ空间"><i class="fa"></i></a>

<a etap="share" data-share="renren" class="share-renren" title="分享到人人网"><i class="fa"></i></a>

<a etap="share" data-share="douban" class="share-douban" title="分享到豆瓣网" href="http://www.douban.com/share/service?image=https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/0a/45/ff/0a45ffc851bc4b29aa877bdd247804d5.doc-1.png&href=https://www.ziliaoku.com/res/info_89665bf051d444c5aa41758867f32fbc.html&name=简易网络爬虫程序的开发(c#版).doc&text=简易网络爬虫程序的开发(c#版).doc" target="_blank"><i class="fa"></i></a>

<a etap="share" data-share="line" class="share-line" title="分享到Line"><i class="fa"></i></a>

<a etap="share" data-share="twitter" class="share-twitter" title="分享到Twitter"><i class="fa"></i></a>

<a etap="share" data-share="facebook" class="share-facebook" title="分享到Facebook"><i class="fa"></i></a>

</div>

<a href="javascript:;" class="action-like" data-pid="738" etap="like"><i class="fa"></i>赞</a>

<a href="javascript:;" class="action-rewards" etap="rewards" onclick="_addFavorite();"><i class="fa"></i>收藏</a>

</div>

<nav class="article-nav">

<span class="article-nav-prev">上一篇<br><a href="/res/info_5d2bbd4510254ff7a7b2b1cc37f76b3b.html" rel="prev">计算机网络课设 局域网聊天程序.doc</a></span>

<span class="article-nav-next">下一篇<br><a href="/res/info_68b1a9e04ddc4f8597d3e526b0da18ab.html" rel="next">基于simmulink通信系统的仿真.doc</a></span>

</nav>

<div class="postitems">

<h3>相关推荐</h3>

<ul>

<li><a href="/res/info_zzz8bbffpzwc77d3.html"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/96/37/f9/9637f9bca5da44bf9a72f2353532ddea.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/96/37/f9/9637f9bca5da44bf9a72f2353532ddea.doc-1.jpg" class="thumb" style="display: inline;"></span>2023年江西萍乡中考道德与法治真题及答案.doc</a></li>

<li><a href="/res/info_zzv4kvehwxajlrrd.html"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/3f/20/20/3f20200fa16c42fe973b806ef1833c15.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/3f/20/20/3f20200fa16c42fe973b806ef1833c15.doc-1.jpg" class="thumb" style="display: inline;"></span>2012年重庆南川中考生物真题及答案.doc</a></li>

<li><a href="/res/info_zzutixupdlfsp4gm.html"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/f2/52/77/f252773010bc416bb15350f6ac835eb3.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/f2/52/77/f252773010bc416bb15350f6ac835eb3.doc-1.jpg" class="thumb" style="display: inline;"></span>2013年江西师范大学地理学综合及文艺理论基础考研真题.doc</a></li>

<li><a href="/res/info_zzsw805nk55ktbj6.html"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/e5/2d/a9/e52da94308cc490887b8f5c46709e097.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/e5/2d/a9/e52da94308cc490887b8f5c46709e097.doc-1.jpg" class="thumb" style="display: inline;"></span>2020年四川甘孜小升初语文真题及答案I卷.doc</a></li>

<li><a href="/res/info_zzo0tzo32vipprxu.html"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/a7/3e/00/a73e0061e54941e6863e426522bade6a.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/a7/3e/00/a73e0061e54941e6863e426522bade6a.doc-1.jpg" class="thumb" style="display: inline;"></span>2020年注册岩土工程师专业基础考试真题及答案.doc</a></li>

<li><a href="/res/info_zznacs5xqljofnz1.html"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/bb/7a/32/bb7a3246ed2243cfa3ce8b05d4aa359e.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/bb/7a/32/bb7a3246ed2243cfa3ce8b05d4aa359e.doc-1.jpg" class="thumb" style="display: inline;"></span>2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc</a></li>

<li><a href="/res/info_zzl1gsww6q8h52fa.html"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/fc/0e/b0/fc0eb0b957a3463bae5b6e90390d446a.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/fc/0e/b0/fc0eb0b957a3463bae5b6e90390d446a.doc-1.jpg" class="thumb" style="display: inline;"></span>2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc</a></li>

<li><a href="/res/info_zzjb9rbw4rxdb8lc.html"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/7f/58/8a/7f588a3487ac4a58ba609c40ca2cc0bd.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/7f/58/8a/7f588a3487ac4a58ba609c40ca2cc0bd.doc-1.jpg" class="thumb" style="display: inline;"></span>2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc</a></li>

<li><a href="/res/info_zzd5wrjymt6tiath.html"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/f5/f0/10/f5f0100141344f8cb5f2670be453cec9.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/f5/f0/10/f5f0100141344f8cb5f2670be453cec9.doc-1.jpg" class="thumb" style="display: inline;"></span>2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc</a></li>

<li><a href="/res/info_zzcfv7cli5t0npk3.html"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/0c/d0/0c/0cd00c52726241acab6ba9a853146da1.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/0c/d0/0c/0cd00c52726241acab6ba9a853146da1.doc-1.jpg" class="thumb" style="display: inline;"></span>2012年河北国家公务员申论考试真题及答案-省级.doc</a></li>

<li><a href="/res/info_zz91b71hx63ngobo.html"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/11/56/bc/1156bc0125dd4245bf23aa9c02b040d2.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/11/56/bc/1156bc0125dd4245bf23aa9c02b040d2.doc-1.jpg" class="thumb" style="display: inline;"></span>2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc</a></li>

<li><a href="/res/info_zz8ngxhpcerte231.html"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/b5/bc/c3/b5bcc35f57c74788ad625ee2d2448a52.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/b5/bc/c3/b5bcc35f57c74788ad625ee2d2448a52.doc-1.jpg" class="thumb" style="display: inline;"></span>2022下半年黑龙江教师资格证中学综合素质真题及答案.doc</a></li>

</ul>

</div>

</div>

</div>

<div class="sidebar">

<div class="widget widget-textosst">

<a class="style01" href="/g_c19.html" target="_blank">

<strong>

资料库

</strong>

<h2>

网络技术

</h2>

<p>

共收录2367份资料,累计7个分类,关注成员有19位,主要包括:综合布线,网管软件,网络监控,网络设备,其它,系统集成,网络基础

</p>

</a>

</div>

<div class="widget widget-htags">

<h3>

热门标签

</h3>

<div class="items">

<a href="/key_%E7%BB%BC%E5%90%88%E5%B8%83%E7%BA%BF_1.html" target="_blank" title="综合布线">综合布线</a>

<a href="/key_%E7%BD%91%E7%AE%A1%E8%BD%AF%E4%BB%B6_1.html" target="_blank" title="网管软件">网管软件</a>

<a href="/key_%E7%BD%91%E7%BB%9C%E7%9B%91%E6%8E%A7_1.html" target="_blank" title="网络监控">网络监控</a>

<a href="/key_%E7%BD%91%E7%BB%9C%E8%AE%BE%E5%A4%87_1.html" target="_blank" title="网络设备">网络设备</a>

<a href="/key_%E5%85%B6%E5%AE%83_1.html" target="_blank" title="其它">其它</a>

<a href="/key_%E7%B3%BB%E7%BB%9F%E9%9B%86%E6%88%90_1.html" target="_blank" title="系统集成">系统集成</a>

<a href="/key_%E7%BD%91%E7%BB%9C%E5%9F%BA%E7%A1%80_1.html" target="_blank" title="网络基础">网络基础</a>

</div>

</div>

<div class="widget widget-postlist">

<h3>

最新资料

</h3>

<ul><li><a href="/res/info_dqbz8ogo25ttlam8.html" style="word-wrap: break-word;"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/e6/cf/4d/e6cf4d1a1b06416d85c62a6627056a6f.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/e6/cf/4d/e6cf4d1a1b06416d85c62a6627056a6f.doc-1.jpg" class="thumb" style="display: inline;"></span>2022-2023学年河北省唐山市高三上学期期末数学试题及答案.doc</a></li><li><a href="/res/info_qc5ty3yf6tk2c25m.html" style="word-wrap: break-word;"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/da/3a/83/da3a83dc320d43d4826c106daec6fec5.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/da/3a/83/da3a83dc320d43d4826c106daec6fec5.doc-1.jpg" class="thumb" style="display: inline;"></span>2022-2023学年河北省张家口市高三上学期期末数学试题及答案.doc</a></li><li><a href="/res/info_m0yr0bwx0zvps8g0.html" style="word-wrap: break-word;"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/31/c8/9e/31c89ed1045c4c36b5a87d4894999de1.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/31/c8/9e/31c89ed1045c4c36b5a87d4894999de1.doc-1.jpg" class="thumb" style="display: inline;"></span>2022-2023学年河北省衡水市高三上学期期末语文试题及答案.doc</a></li><li><a href="/res/info_3pbmjf6yc3kpnrw1.html" style="word-wrap: break-word;"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/e0/6a/8c/e06a8c8ed7b043dea71a42462d9c9d43.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/e0/6a/8c/e06a8c8ed7b043dea71a42462d9c9d43.doc-1.jpg" class="thumb" style="display: inline;"></span>2022-2023学年河北省保定市高三上学期期末数学试题及答案.doc</a></li><li><a href="/res/info_8gks7ez19hdwm56j.html" style="word-wrap: break-word;"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/7e/82/e5/7e82e5288edd476889d6a287737adf0f.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/7e/82/e5/7e82e5288edd476889d6a287737adf0f.doc-1.jpg" class="thumb" style="display: inline;"></span>2022-2023学年河北省张家口市高三上学期期末语文试题及答案.doc</a></li><li><a href="/res/info_v0exlfmpzj2r1k6x.html" style="word-wrap: break-word;"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/08/1e/25/081e25f43efd442c8a12b62ec8fa48b1.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/08/1e/25/081e25f43efd442c8a12b62ec8fa48b1.doc-1.jpg" class="thumb" style="display: inline;"></span>2022-2023学年河北省石家庄市高三上学期期末语文试题及答案.doc</a></li><li><a href="/res/info_332tqgwoxby4e4pk.html" style="word-wrap: break-word;"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/d9/7f/75/d97f756355a14fdfa6aa8ef8cdb1f962.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/d9/7f/75/d97f756355a14fdfa6aa8ef8cdb1f962.doc-1.jpg" class="thumb" style="display: inline;"></span>2020-2021年四川省凉山州西昌市高一物理上学期期中试卷及答案.doc</a></li><li><a href="/res/info_se75katfrrhgasg2.html" style="word-wrap: break-word;"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/b5/ce/d1/b5ced10e0aa6432f8597d6ce8c619894.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/b5/ce/d1/b5ced10e0aa6432f8597d6ce8c619894.doc-1.jpg" class="thumb" style="display: inline;"></span>2020-2021年四川省遂宁市安居区高一英语上学期期中试卷及答案.doc</a></li><li><a href="/res/info_jopp59ho0y2mkxtu.html" style="word-wrap: break-word;"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/bc/fd/3a/bcfd3aaef5834ad68afe3c8577cff4c0.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/bc/fd/3a/bcfd3aaef5834ad68afe3c8577cff4c0.doc-1.jpg" class="thumb" style="display: inline;"></span>2020-2021年四川省西昌市高一英语上学期期中试卷及答案.doc</a></li><li><a href="/res/info_ctcta4r0peitip7b.html" style="word-wrap: break-word;"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/9a/fd/de/9afdde3b132143eebb41c526a70b67ea.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/9a/fd/de/9afdde3b132143eebb41c526a70b67ea.doc-1.jpg" class="thumb" style="display: inline;"></span>2021-2022年四川省广安市岳池县高一地理上学期期中试卷及答案.doc</a></li><li><a href="/res/info_5kj24xatcc95u2oj.html" style="word-wrap: break-word;"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/41/2b/f6/412bf64f3e8c4db19c74d3c82625ef94.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/41/2b/f6/412bf64f3e8c4db19c74d3c82625ef94.doc-1.jpg" class="thumb" style="display: inline;"></span>2021-2022年四川省成都市郫都区高一物理上学期期中试卷及答案.doc</a></li><li><a href="/res/info_lww42ijiamo88if4.html" style="word-wrap: break-word;"><span class="thumbnail"><img src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/6d/f8/de/6df8de4794874e0abdcc2823b80aac37.doc-1.jpg" data-src="https://img01.ziliaoku.com/38ec5853054240eb91f23f3a01141758/previews/6d/f8/de/6df8de4794874e0abdcc2823b80aac37.doc-1.jpg" class="thumb" style="display: inline;"></span>2021-2022年四川省广安市岳池县高一物理上学期期中试卷及答案.doc</a></li></ul>

</div>

</div>

</section>

<form id="payForm" action="/Pay/_AddOrder" method="post">

<input type="hidden" name="tradeType" value="Resource" />

<input type="hidden" name="num" value="1" />

<input type="hidden" name="resId" value="89665bf051d444c5aa41758867f32fbc" />

<input type="hidden" name="orderId" value="" />

<input type="hidden" name="payPlatForm" value="WxH5Pay" />

</form>

<footer class="footer">

<div class="bomnav">

</div>

<div class="bomnav">

<a href="/site-about.html" target="_blank">关于本站</a> <a href="/site-contact.html" target="_blank">联系我们</a> <a href="/site-copyright.html" target="_blank">侵权处理</a> <a href="/site-download_statement.html" target="_blank">免责声明</a>

<a target="_blank" href="https://beian.miit.gov.cn/">冀ICP备17022707号</a>

<script>

var _hmt = _hmt || [];

(function() {

var hm = document.createElement("script");

hm.src = "https://hm.baidu.com/hm.js?7733904a9db9b513a05a5e2177918a24";

var s = document.getElementsByTagName("script")[0];

s.parentNode.insertBefore(hm, s);

})();

</script>

</div>

<span id="copyrights">

© 2026 本站由 <a href="https://www.ziliaopu.net" target="_blank">资料铺</a> 提供技术支持 <a href="/sitemap.xml" target="_blank">网站地图</a>

</span>

</footer>

<script type="text/javascript">

if (window.jQuery)

$.post("/ajax/PostTrackLog", { type: 201, title: document.title, data: '{}', key: location.href, referrer: document.referrer, url: location.href }, function (result) { });

</script>

<script type='text/javascript' src='/themes/tob/js/main.js?ver=1.1'></script>

<script type="text/javascript" src="/themes/tob/js/layer/layer.js"></script>

<script type="text/javascript">

function isHaveDownloadPower_New() {

var url = "/Res/_GetDownloadPower_New?resId=89665bf051d444c5aa41758867f32fbc";

$.ajax({

type: 'POST',

url: url,

data: { payPlatForm: "WxH5Pay", tradeType: "Resource", num: 1, resId: "89665bf051d444c5aa41758867f32fbc" },

method: 'POST'

}).done(function (data, textStatus, jqXHR) {

if (data.isDownLoad) {

location.href = $('.downloada').attr('data-href');

}

else {

layer.open({

type: 2,

title: '请通过以下方式下载',

shadeClose: false,

shade: 0.6,

area: ['500px', '500px'],

content: '/res/pretask_89665bf051d444c5aa41758867f32fbc.html'

});

}

console.log(data);

});

}

</script>

<script type="text/javascript">

function isHaveDownloadPower(resId) {

//之所以不将支付逻辑嵌入到页面,是因为微信支付内打开此页时,iframe无法加载jssdk支付逻辑,应该是有iframe无法唤起微信的支付弹窗这个官方限制

//正确逻辑应该是:

//1.监测当前用户是否有下载权限,如果有直接下载

//2.如果没有权限,那么弹窗完成任务后再下载

//其中任务有:登录后赠送/关注公众号后下载/支付后下载/充值vip后下载/。。。

if (location.href.indexOf('isdebug') > 0||true) {

isHaveDownloadPower_New();

return;

}

var url = "/Res/_GetDownloadPower?resId=89665bf051d444c5aa41758867f32fbc";

$.ajax({

type: 'POST',

url: url,

data: { payPlatForm: "WxH5Pay", tradeType: "Resource", num: 1, resId: "89665bf051d444c5aa41758867f32fbc" },

method: 'POST'

}).done(function (data, textStatus, jqXHR) {

if (data.isDownLoad) {

location.href = $('.downloada').attr('data-href');

}

else {

var payUrl = 'https://pay.ziliaopu.net/38ec5853054240eb91f23f3a01141758/pay/confirm.html?tradeType=Resource&num=1&resId=89665bf051d444c5aa41758867f32fbc&returnUrl=https%3A%2F%2Fwww.ziliaoku.com%2Fres%2Fdownload_89665bf051d444c5aa41758867f32fbc.html';

location.href = payUrl;

return;

}

console.log(data);

});

}

function _addFavorite() {

var url = window.location;

var title = document.title;

var ua = navigator.userAgent.toLowerCase();

if (ua.indexOf("360se") > -1) {

alert("由于360浏览器功能限制,请按 Ctrl+D 手动收藏!");

} else if (ua.indexOf("msie 8") > -1) {

window.external.AddToFavoritesBar(url, title); //IE8

} else if (document.all) {//IE类浏览器

try {

window.external.addFavorite(url, title);

} catch (e) {

alert('您的浏览器不支持,请按 Ctrl+D 手动收藏!');

}

} else if (window.sidebar) {//firfox等浏览器; window.sidebar.addPanel(title, url, "");

} else {

alert('您的浏览器不支持,请按 Ctrl+D 手动收藏!');

}

}

$(function () {

$.ajax({

url: "/Res/_UpdateLookTimes?resId=89665bf051d444c5aa41758867f32fbc",

method: 'get',

dataType: 'json',

cache: false, //不保存缓存

success: function(data) {}

});

$('.tab-nav li a').click(function () {

$(".tab-item").hide();

$('[data-tab-item=' + $(this).attr("data-tab-target") + ']').show();

});

var articleBar = $('.article-bar');

$(window).scroll(function () {

var h = document.documentElement.scrollTop + document.body.scrollTop;

var contentHeight = $('.article-content').height();

if (h > 200 && h < contentHeight) {

articleBar.addClass("fixed");

$('.article-bar').css('width', $('.article-content').width());

$('.article-bar').css('margin-left', $('.article-content').offset().left);

}

else {

articleBar.removeClass("fixed");

$('.article-bar').css('width', '');

$('.article-bar').css('margin-left', '');

}

});

})

</script>

<!--Cached In 2/2/2026 8:53:48 PM-->

</body>

</html>