目录

一、前言:....................................................................................................................4

二、项目说明:............................................................................................................4

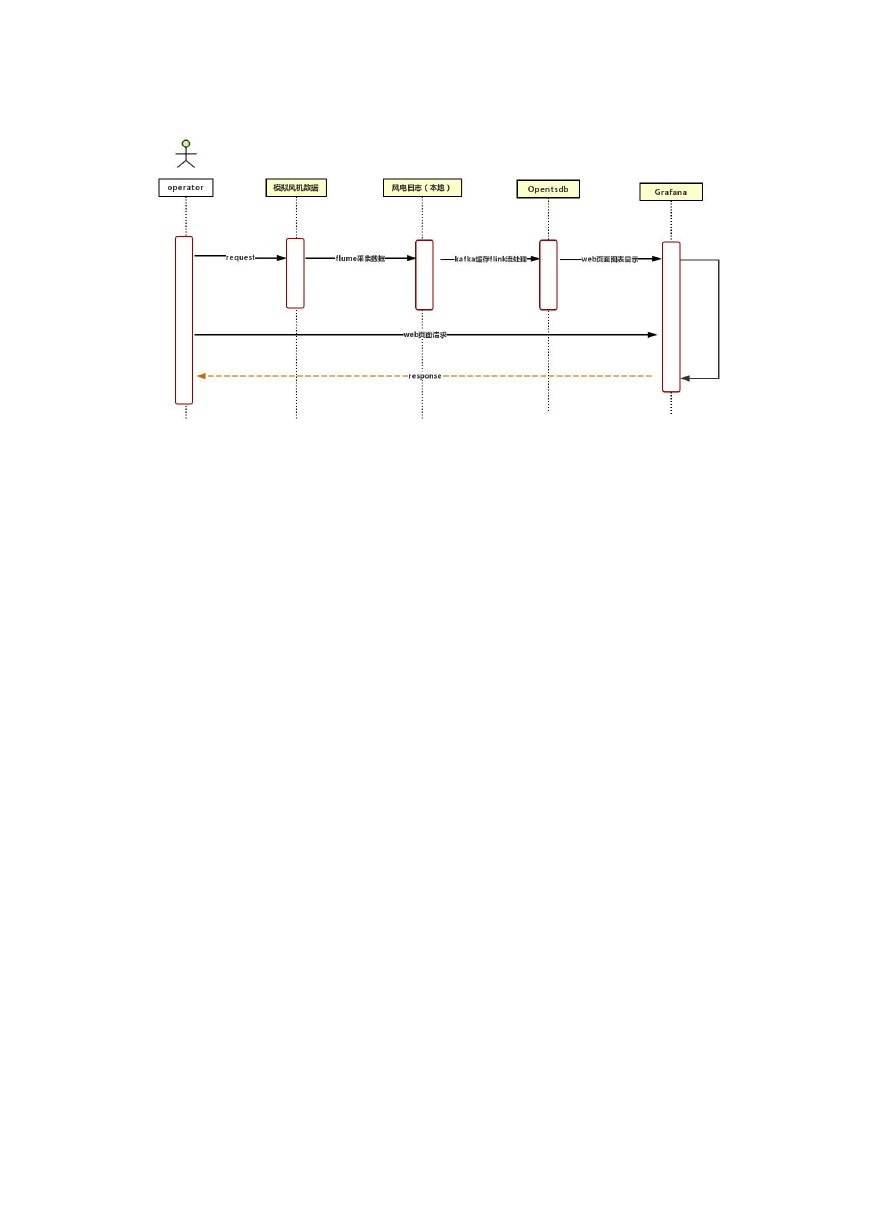

架构图.....................................................................................................................4

流程图.....................................................................................................................6

三、程序运行环境:....................................................................................................6

四、实现过程:..............................................................................................................7

五、集群配置过程:....................................................................................................7

1.修改 CentOS 默认 yum 源为 mirrors.163.com................................................7

2.分别配置 hostname、ip、配置 hosts 文件....................................................7

3.分别 ssh 安全配置以及 ssh key 认证登录.....................................................9

4.测试免密钥连接:如图成功...........................................................................10

四、配置 java 环境变量............................................................................................10

五、搭建 hadoop 集群(master,slave1 和 slave2)............................................... 10

1.切换进配置文件路径.......................................................................................10

2.增加 slave 节点...............................................................................................11

3.配置 core-site.xml........................................................................................11

4.配置 hdfs-site.xml........................................................................................11

5.创建 hdfs 需要用的文件目录.........................................................................11

6.初始化 hdfs 文件系统.....................................................................................12

7.启动 hdfs 文件系统.........................................................................................12

8.网址查看:.......................................................................................................12

9.在 hdfs 中准备运行目录.................................................................................12

六、搭建 yarn 集群....................................................................................................13

1.配置 yarn-site.xml........................................................................................13

2.配置 mapred-site.xml....................................................................................15

3.配置 yarn 的本地目录.....................................................................................17

4.启动 yarn 服务.................................................................................................17

5.验证...................................................................................................................18

七、安装配置 flume 步骤:......................................................................................18

1.1 下载安装包并解压.......................................................................................18

1.2 修改 flume-env.sh 配置文件,主要是 JAVA_HOME 变量设置.................18

1.3 配置 flume 文件...........................................................................................19

1.4 启动 flume....................................................................................................20

八、Flink 及 kafka 安装部署...................................................................................20

1、简介.................................................................................................................20

2、Flink 的开发准备..........................................................................................22

3、集群环境准备.................................................................................................23

九、配置 Hbase 集群..................................................................................................26

1.配置文件 hbase-site.xml..............................................................................26

2.配置修改 hbase-env.sh..................................................................................28

3.配置修改修改 regionservers.......................................................................... 28

4.准备 hbase 目录...............................................................................................28

5.修改环境变量....................................................................................................29

�

6.启动 Hbase 集群..............................................................................................29

十、OpenTSDB 部署.....................................................................................................30

十一、组件连接:......................................................................................................31

一、flink 连接 kafka.........................................................................................31

二、flink 连接 opentsdb...................................................................................33

十二、打包..................................................................................................................36

(一) 创建工程之前的准备.............................................................................36

(二) 创建步骤.................................................................................................36

十三、启动服务及运行..............................................................................................48

1、 首先启动 zookeeper 集群...........................................................................48

2、启动 kafka 集群(3 台都要启动)..............................................................49

3、启动 hdfs........................................................................................................50

4、 启动 Flink 集群...........................................................................................50

5、 在 flink 的 bin 目录下提交计划...............................................................55

图:Mainclass 路径..............................................................................................56

十四、Grafana 部署安装...........................................................................................61

1. 下载 grafana 压缩包.....................................................................................61

2. 解压到指定目录.............................................................................................61

3. 为了使用饼状图,我们需要安装 Pie chart 插件.....................................61

4. 安装日志服务插件.........................................................................................61

5. 安装好插件后重启 grafana-server............................................................61

6. 登录查看.........................................................................................................61

7. 为 grafana 配置数据源为 opentsdb............................................................62

8. 创建个图表,并配置告警...............................................................................63

�

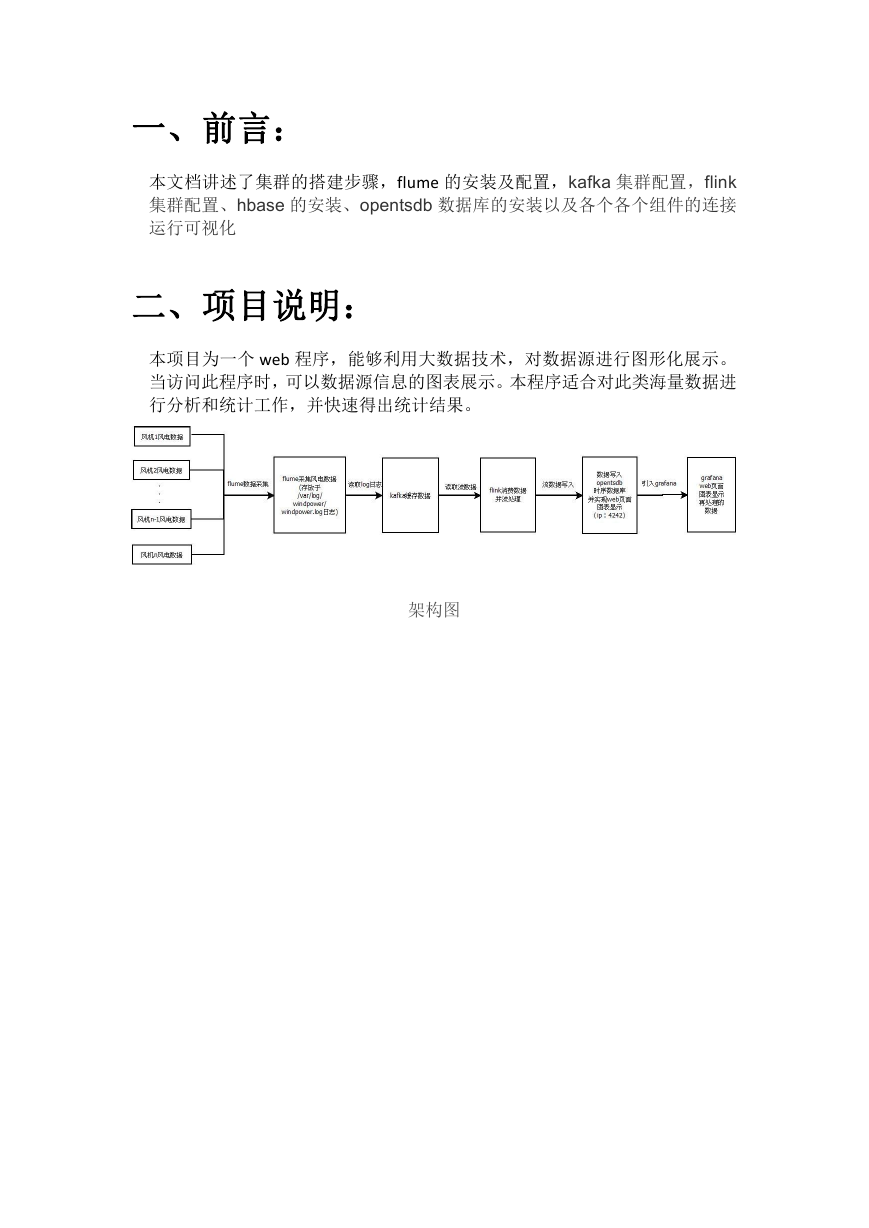

一、前言:

本文档讲述了集群的搭建步骤,flume 的安装及配置,kafka 集群配置,flink

集群配置、hbase 的安装、opentsdb 数据库的安装以及各个各个组件的连接

运行可视化

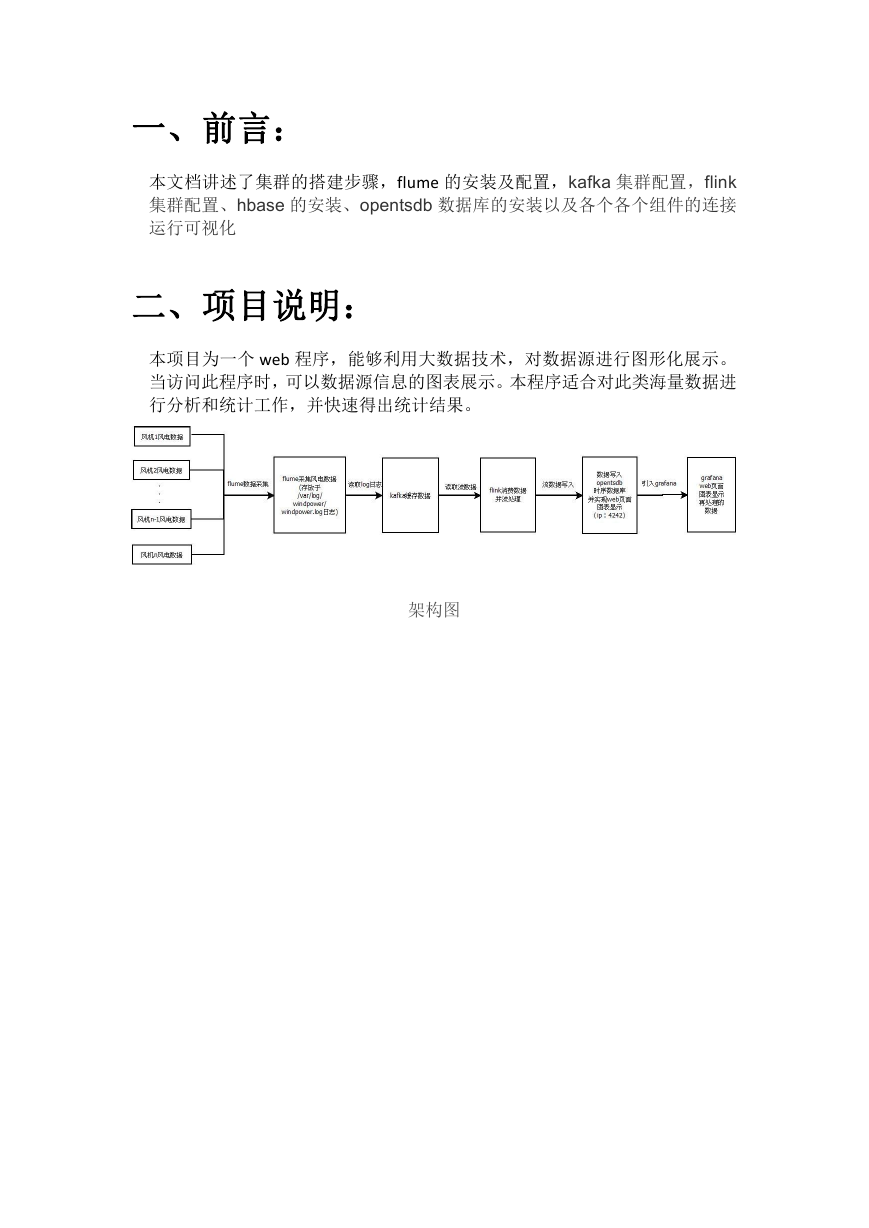

二、项目说明:

本项目为一个 web 程序,能够利用大数据技术,对数据源进行图形化展示。

当访问此程序时,可以数据源信息的图表展示。本程序适合对此类海量数据进

行分析和统计工作,并快速得出统计结果。

架构图

�

�

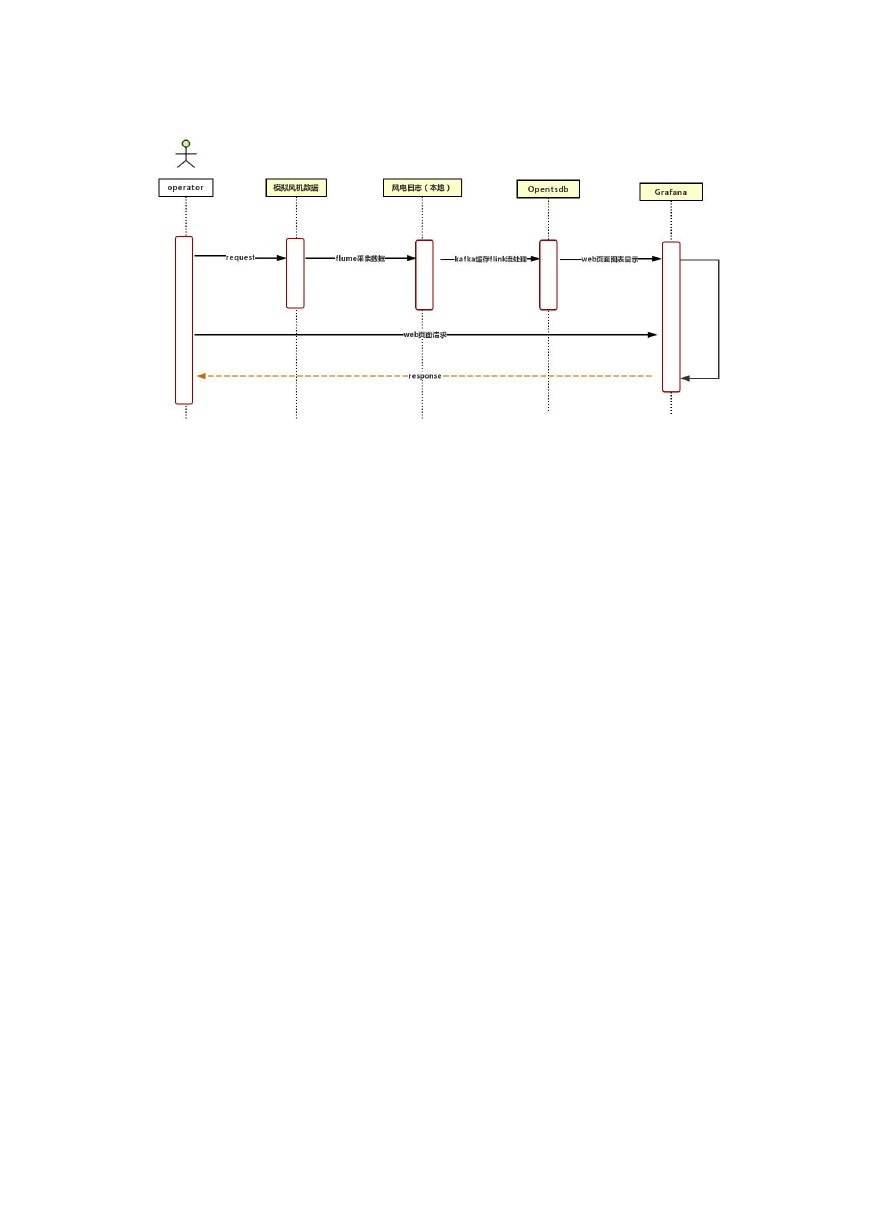

流程图

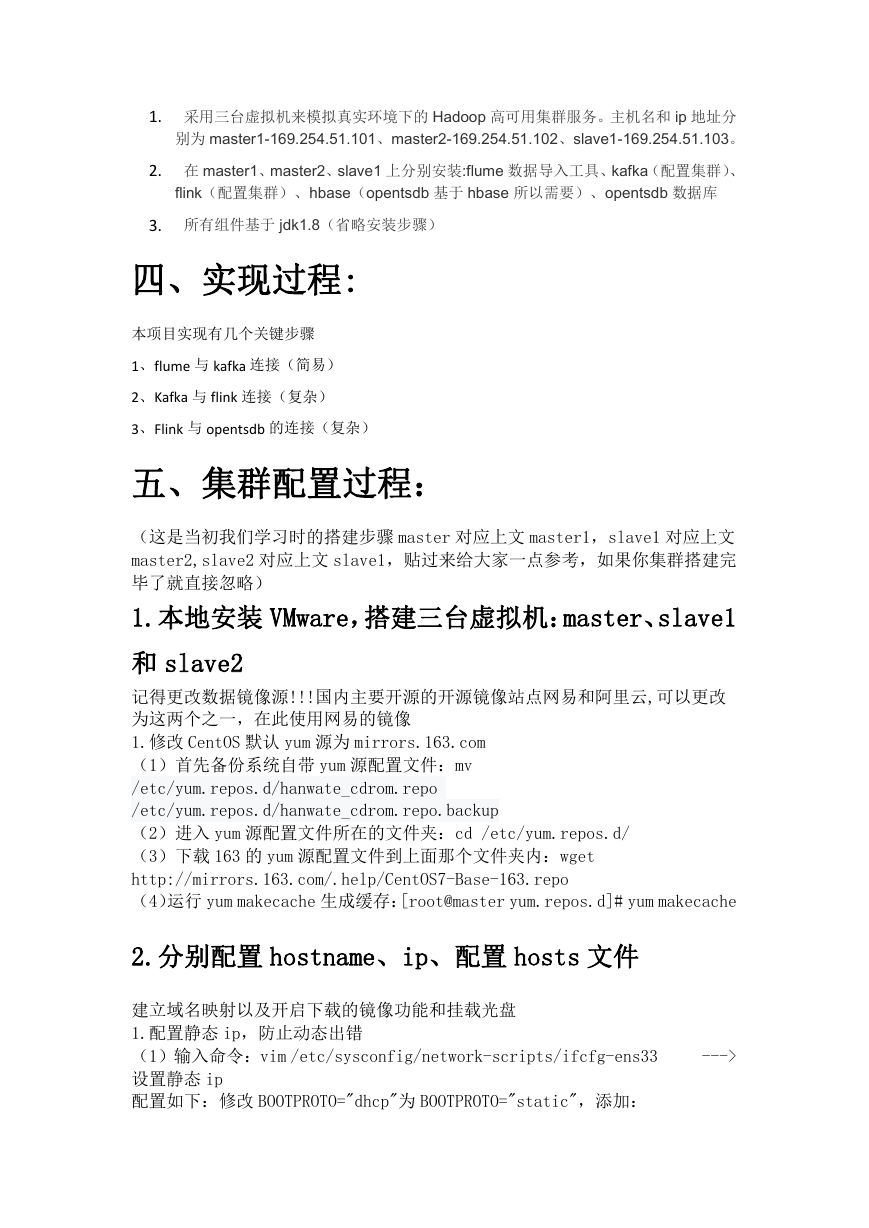

三、程序运行环境:

�

1. 采用三台虚拟机来模拟真实环境下的 Hadoop 高可用集群服务。主机名和 ip 地址分

别为 master1-169.254.51.101、master2-169.254.51.102、slave1-169.254.51.103。

2. 在 master1、master2、slave1 上分别安装:flume 数据导入工具、kafka(配置集群)、

flink(配置集群)、hbase(opentsdb 基于 hbase 所以需要)、opentsdb 数据库

3. 所有组件基于 jdk1.8(省略安装步骤)

四、实现过程:

本项目实现有几个关键步骤

1、flume 与 kafka 连接(简易)

2、Kafka 与 flink 连接(复杂)

3、Flink 与 opentsdb 的连接(复杂)

五、集群配置过程:

(这是当初我们学习时的搭建步骤 master 对应上文 master1,slave1 对应上文

master2,slave2 对应上文 slave1,贴过来给大家一点参考,如果你集群搭建完

毕了就直接忽略)

1.本地安装 VMware,搭建三台虚拟机:master、slave1

和 slave2

记得更改数据镜像源!!!国内主要开源的开源镜像站点网易和阿里云,可以更改

为这两个之一,在此使用网易的镜像

1.修改 CentOS 默认 yum 源为 mirrors.163.com

(1)首先备份系统自带 yum 源配置文件:mv

/etc/yum.repos.d/hanwate_cdrom.repo

/etc/yum.repos.d/hanwate_cdrom.repo.backup

(2)进入 yum 源配置文件所在的文件夹:cd /etc/yum.repos.d/

(3)下载 163 的 yum 源配置文件到上面那个文件夹内:wget

http://mirrors.163.com/.help/CentOS7-Base-163.repo

(4)运行 yum makecache 生成缓存:[root@master yum.repos.d]# yum makecache

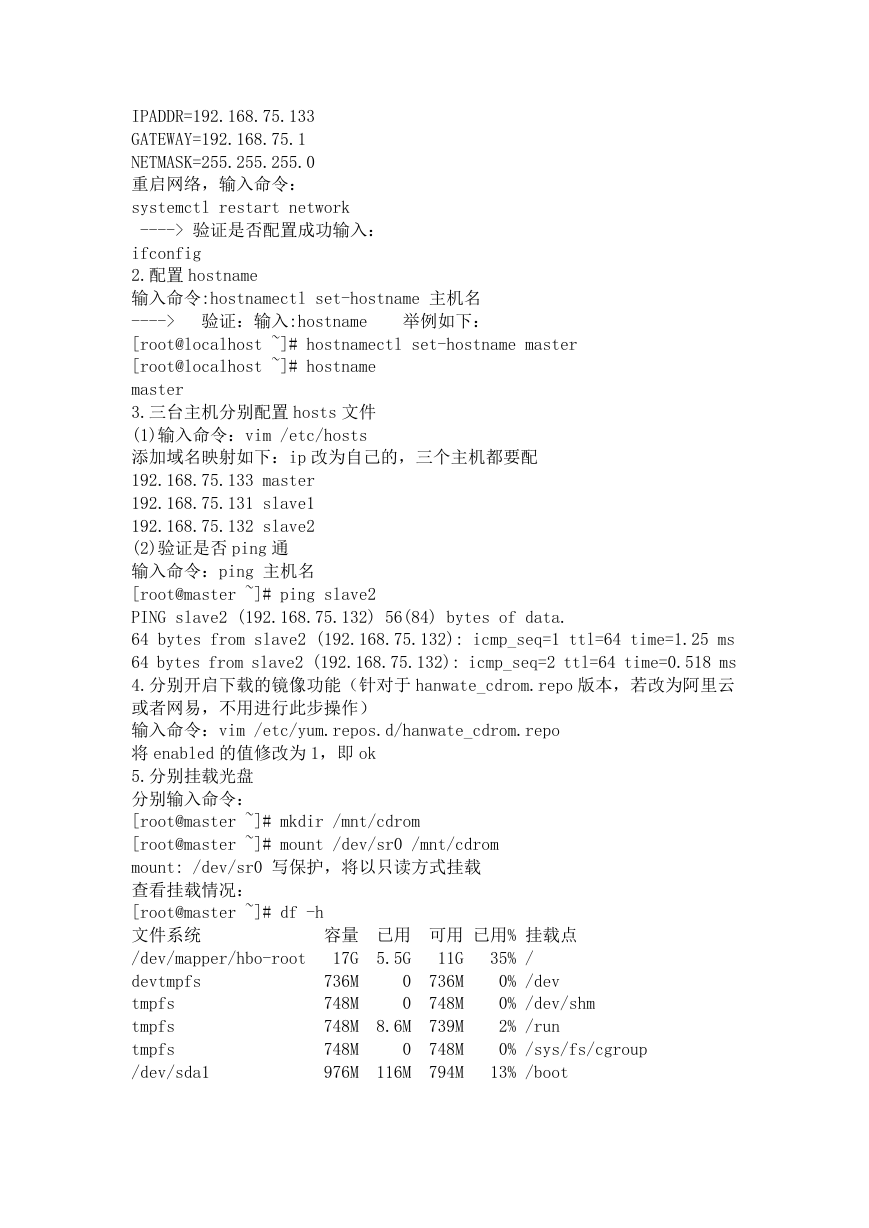

2.分别配置 hostname、ip、配置 hosts 文件

建立域名映射以及开启下载的镜像功能和挂载光盘

1.配置静态 ip,防止动态出错

(1)输入命令:vim /etc/sysconfig/network-scripts/ifcfg-ens33

设置静态 ip

配置如下:修改 BOOTPROTO="dhcp"为 BOOTPROTO="static",添加:

--->

�

IPADDR=192.168.75.133

GATEWAY=192.168.75.1

NETMASK=255.255.255.0

重启网络,输入命令:

systemctl restart network

----> 验证是否配置成功输入:

举例如下:

ifconfig

2.配置 hostname

输入命令:hostnamectl set-hostname 主机名

----> 验证:输入:hostname

[root@localhost ~]# hostnamectl set-hostname master

[root@localhost ~]# hostname

master

3.三台主机分别配置 hosts 文件

(1)输入命令:vim /etc/hosts

添加域名映射如下:ip 改为自己的,三个主机都要配

192.168.75.133 master

192.168.75.131 slave1

192.168.75.132 slave2

(2)验证是否 ping 通

输入命令:ping 主机名

[root@master ~]# ping slave2

PING slave2 (192.168.75.132) 56(84) bytes of data.

64 bytes from slave2 (192.168.75.132): icmp_seq=1 ttl=64 time=1.25 ms

64 bytes from slave2 (192.168.75.132): icmp_seq=2 ttl=64 time=0.518 ms

4.分别开启下载的镜像功能(针对于 hanwate_cdrom.repo 版本,若改为阿里云

或者网易,不用进行此步操作)

输入命令:vim /etc/yum.repos.d/hanwate_cdrom.repo

将 enabled 的值修改为 1,即 ok

5.分别挂载光盘

分别输入命令:

[root@master ~]# mkdir /mnt/cdrom

[root@master ~]# mount /dev/sr0 /mnt/cdrom

mount: /dev/sr0 写保护,将以只读方式挂载

查看挂载情况:

[root@master ~]# df -h

文件系统

/dev/mapper/hbo-root

devtmpfs

tmpfs

tmpfs

tmpfs

/dev/sda1

0% /dev

0% /dev/shm

2% /run

0% /sys/fs/cgroup

11G

736M

748M

739M

748M

794M

17G

736M

748M

748M

748M

976M

5.5G

0

0

8.6M

0

116M

容量 已用 可用 已用% 挂载点

35% /

13% /boot

�

tmpfs

/dev/sr0

150M

4.1G

0

4.1G

150M

0

0% /run/user/0

100% /mnt/cdrom

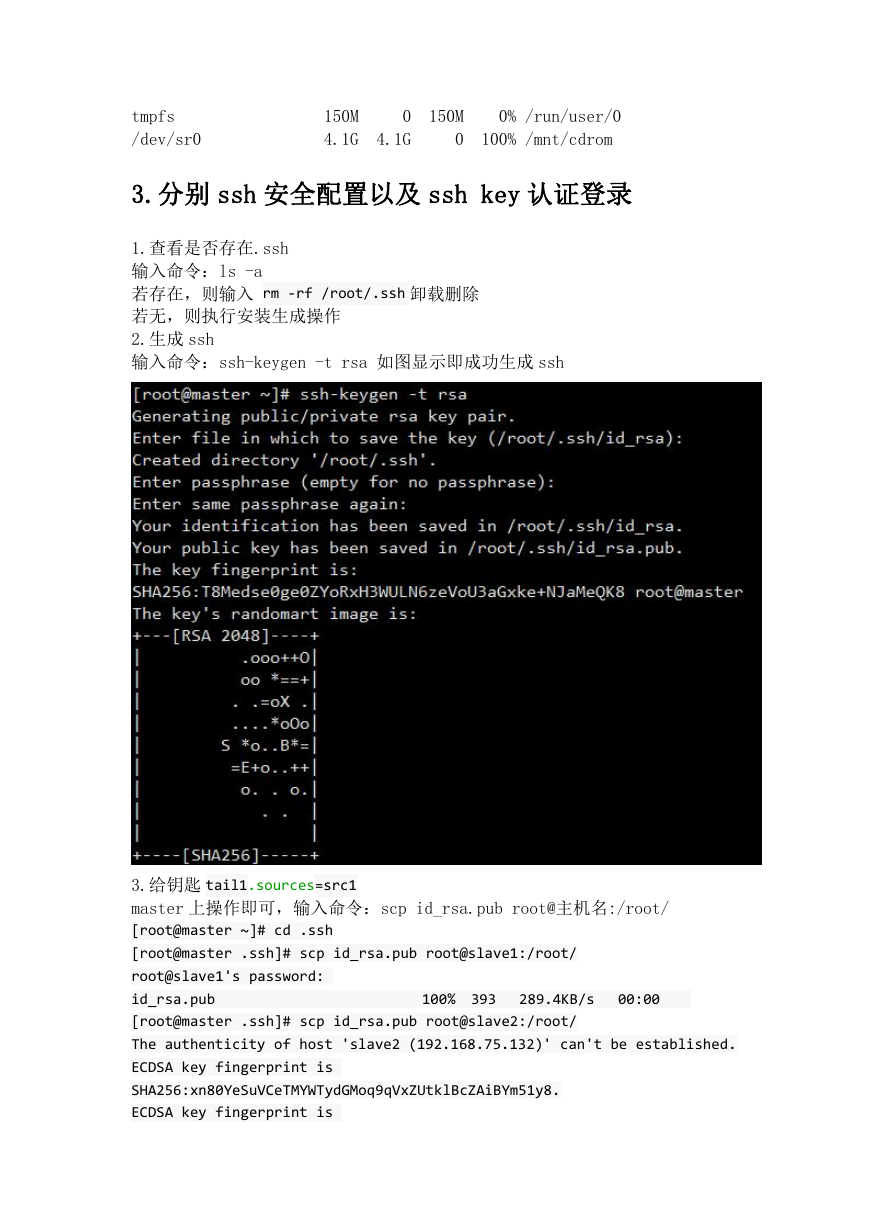

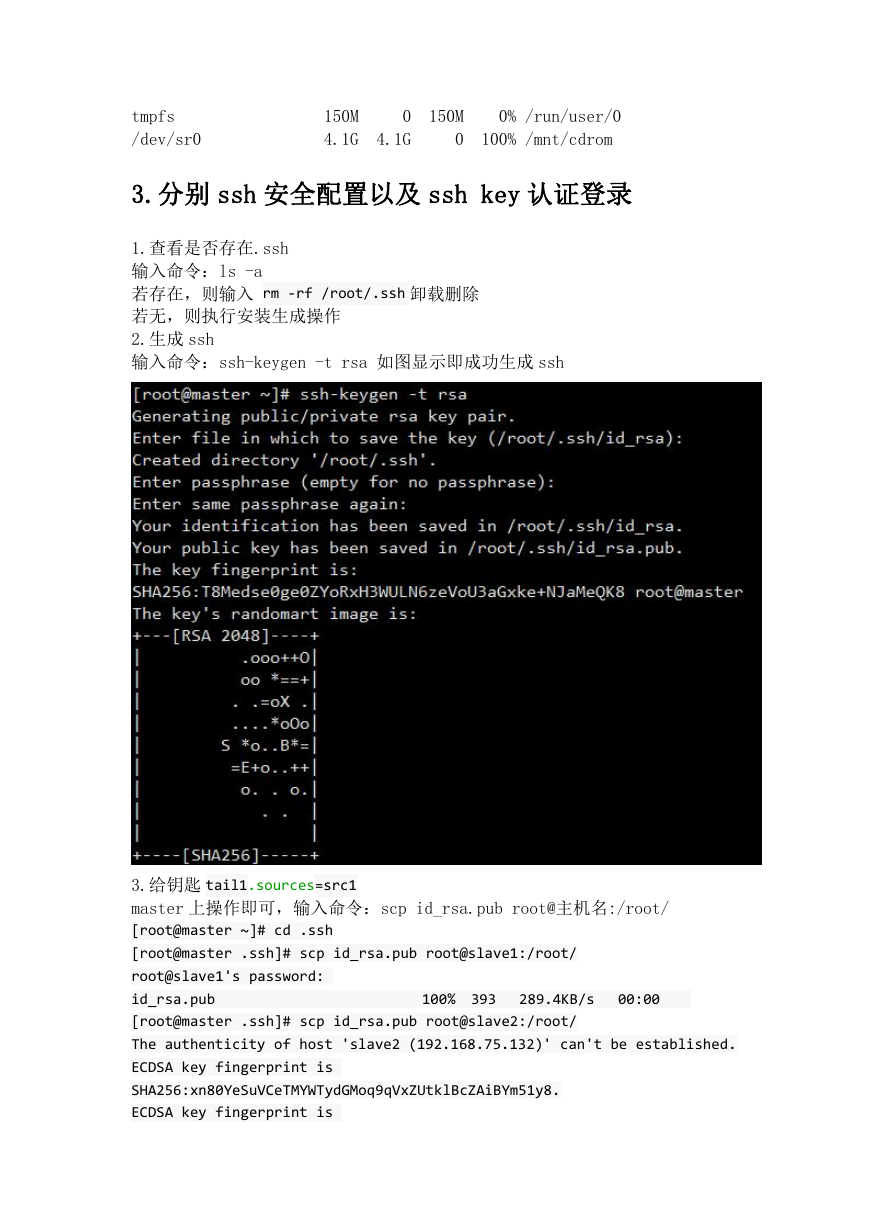

3.分别 ssh 安全配置以及 ssh key 认证登录

1.查看是否存在.ssh

输入命令:ls -a

若存在,则输入 rm -rf /root/.ssh 卸载删除

若无,则执行安装生成操作

2.生成 ssh

输入命令:ssh-keygen -t rsa 如图显示即成功生成 ssh

3.给钥匙 tail1.sources=src1

master 上操作即可,输入命令:scp id_rsa.pub root@主机名:/root/

[root@master ~]# cd .ssh

[root@master .ssh]# scp id_rsa.pub root@slave1:/root/

root@slave1's password:

id_rsa.pub

[root@master .ssh]# scp id_rsa.pub root@slave2:/root/

The authenticity of host 'slave2 (192.168.75.132)' can't be established.

ECDSA key fingerprint is

SHA256:xn80YeSuVCeTMYWTydGMoq9qVxZUtklBcZAiBYm51y8.

ECDSA key fingerprint is

289.4KB/s

100% 393

00:00

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc