基于局部搜索的反向学习竞争粒子群优化算

http://www.paper.edu.cn

法

钱晓宇1,方伟2,董洪伟3

1 江南大学物联网工程学院,无锡 214122

2 江南大学物联网工程学院,无锡 214122

3 江南大学物联网工程学院,无锡 214122

摘要:为了提升粒子群优化算法在复杂优化问题, 特别是高维优化问题上的优化性能, 提出了

一种基于 Solis&Wets 局部搜索的反向学习竞争粒子群优化算法 (Solis and Wets - Opposition

Based Learning Competitive particle Swarm Optimizer,SW-OBLCSO).SW-OBLCSO 算法采

用了竞争学习和反向学习两种学习机制, 并设计了基于个体的局部搜索算子. 在 SW-OBLCSO

算法的每次迭代中, 竞争学习在来自群体的四个随机选择的粒子之间进行, 具有最佳适应值的

粒子, 表示为获胜者, 直接传递给下一次迭代; 具有最差适应值的粒子直接获得获胜者的位置并

增加一个偏移量, 加快算法的收敛速度; 两个中等适应值的粒子分别采用向获胜者学习和反向

学习策略. 在求解性能连续多次没有得到改善后加入 SW 局部搜索策略, 提高算法跳出局部最

优的能力. 利用 10 个常用基准测试函数在 100 维、500 维和 1000 维情况下将 SW-OBLCSO

算法与多种优化算法进行对比. 实验结果表明所提算法在收敛速度和全局搜索能力上表现出了

突出的性能; 对模糊认知图 (Fuzzy Cognitive Maps) 学习问题的测试表明 SW-OBLCSO 算法

在处理实际问题时同样具有出色的性能.

关键词:计算机软件与理论;粒子群优化算法;反向学习;竞争学习;大规模优化问题

中图分类号: TP18

Local Search Based Competitive Particle Swarm

Optimizer With Opposition-Based Learning

QIAN Xiao-Yu1, FANG Wei2,DONG Hong-Wei3

1 Department of IoT Engineering,Jiangnan University, WuXi 214122

2 Department of IoT Engineering,Jiangnan University, WuXi 214122

3 Department of IoT Engineering,Jiangnan University, WuXi 214122

Abstract: In order to improve the optimization ability of particle swarm optimization(PSO)

algorithm in complex optimization problems,especially in high dimensional problems,a

competitive particle swarm optimization algorithm(SW-OBLCSO) based on opposition-based

learning and Solis&Wets local search is proposed.SW-OBLCSO adopts two learning

基 金 项 目: 国 家 自 然 科 学 基 金 项 目 (61673194),江 苏 省 自 然 科 学 基 金 项 目 (BK20131106),中 国 博 士 后 科 学 基 金 项 目

(2014M560390),江南大学自主科研计划重点项目 (JUSRP51410B)

作者简介: 钱晓宇(1995-),男,研究生,主要研究方向:粒子群优化算法。通信作者:方伟(1980-),男,教授,主要研究

方向:计算智能。E-mail: fangwei@jiangnan.edu.cn

- 1 -

�

http://www.paper.edu.cn

mechanisms,namely competitive swarm optimizer(CSO) and opposition-based learning,and

embeds individual-based local search operators in it.In each iteration of

SW-OBLCSO,competitive learning is performed between four randomly selected particles

from the population.Particles with optimal fitness values are passed directly to the next

iteration.The particle with the worst fitness value directly obtains the position of the winner

and adds an offset to speed up the convergence of the algorithm.Two medium-adaptive

particles update from the winner and by Opposition-Based Learning strategy

respectively.After the performance of the solution has not been improved for many times,the

SW local search strategy is added to improve the ability of the algorithm to jump out of local

optimum.The SW-OBLCSO algorithm is compared with various optimization algorithms on

the 10 benchmarks functions in 100,500 and 1000 dimensions.The experimental results show

that the proposed algorithm exhibits outstanding performance in convergence speed and

global search ability.Testing of fuzzy cognitive map (FCM) learning problems shows that

SW-OBLCSO also has excellent performance when dealing with practical problems.

Key words: Computer software and theory;Particle Swarm Optimizer;Opposition-Based

Learning;Competitive learning; Large-scale optimization problem

0 引言

粒子群优化 (Particle Swarm Optimization,PSO) 算法是 Kennedy 等人[1-2] 在 1995 年提

出的一种群体智能优化算法, 该算法源自对鸟类捕食问题的研究. 在标准 PSO 算法中, 种群由

若干个个体组成, 每个个体用速度和位置表示, 个体的速度决定了它的迭代方向和距离, 位置代

表其中一个解向量, 并通过个体的速度来更新自己的位置, 进而获取最优解.PSO 算法具有较强

的优化能力, 并且有计算复杂度低, 易于实现和参数较少等特点.

PSO 算法自提出以来便受到各领域学者的关注, 并取得了丰硕的研究成果[3-6]. 通常, 收敛

速度和全局搜索能力是 PSO 算法的两个重要的性能指标. 然而,PSO 算法易出现早熟收敛而导

致优化性能降低, 为此, 研究人员在算法的性能改进方面展开了较多的研究, 从不同的角度提出

了算法的改进方案. 其中一类改进方法是通过设计粒子不同的邻域结构来改善群体的信息交流

机制, 以提高群体的搜索能力, 如文献 [7] 中研究的环形、冯诺依曼拓扑方式、全连接方式等结

构. 群体多样性降低是 PSO 算法在进化过程中无法回避的问题, 也被认为是引起早熟收敛的原

因之一.Liang 等[8] 引入多种群提出了动态多种群粒子群算法 (DMS-PSO), 而后又提出了用于

求解多峰函数的深入学习粒子群算法 (CLPSO)[9]. 文献 [10] 通过设置群体多样性的上下限来控

制群体的发散和收缩行为; 文献 [11] 基于邻居节点的搜索行为提出了多样性增强机制, 以平衡

群体的搜索和勘探能力. 在 PSO 算法中改进或引入更为智能的学习机制来影响群体的学习方

法, 以提升算法的优化性能也是一直以来的研究热点.Zhan 等在文献 [12] 中提出了自适应学习

的 PSO 算法; Cheng 等提出了社会学习型粒子群优化算法 (SL-PSO)[13]; Sun 等[14-15] 结合金

属导体中自由电子的定向漂移运动和随机无规则热运动方式, 提出了随机漂移粒子群 (RDPSO)

- 2 -

�

http://www.paper.edu.cn

算法. 对参数设置的研究中, 文献 [16] 首先在 PSO 算法中引入了惯性权重, 后来在 [17] 中提出

了权重线性递减方法. 文献 [18] 提出了权重凹函数递减方法. 另外, 遗传算法中的交叉[19]、变

异[20] 等进化操作方式也常被应用于 PSO 算法, 以提高算法的优化能力. 不同的概率采样方式

可以改变粒子的搜索方式, 也能起到性能改进的目的, 如高斯采样[21]、Levy 采样[22]、双指数采

样[23] 等. 为了进一步改善 PSO 算法的求解效果, 本文提出了基于局部搜索的反向学习竞争粒

子群算法 (SW-OBLCSO). 在 SW-OBLCSO 算法中, 采用了两种学习机制, 即竞争学习和反向

学习. 其中竞争学习是 CSO 算法[24] 的改进版本, 具有更智能的竞争行为. 反向学习用于快速探

索搜索空间, 此外, 算法结合了基于个体的 SW[25] 局部启发式搜索算子, 帮助算法跳出局部最

优解.

1 粒子群优化 (PSO) 算法

在 PSO 算法中,种群中的每个粒子代表问题的潜在解,位置向量表示为 Xi = [Xi1; Xi2;

··· ; XiD], 速度向量表示为 Vi = [Vi1; Vi2;··· ; ViD],其中 D 是问题的维度. 在进化过程中记录

和更新第 i 个粒子的个体历史最佳位置, 并表示为 Pi = [Pi1; Pi2;··· ; PiD]. 在种群中, 具有最佳

适应度的粒子被认为是全局最佳粒子并且表示为 G = [G1; G2;··· ; GD]. 在初始化阶段, 在有限

搜索空间中以随机位置和速度生成粒子. 然后随着进化过程, 粒子根据他们自己的经验和群体的

经验不断更新速度和位置, 更新公式如下所示:

Vid(t + 1) = ! · Vid(t)+c1 · r1d(t) · (Pid(t) − Xid(t)) + c2 · r2d(t) · (Gd(t) − Xid(t));

(1)

(2)

其中 t 是迭代次数, ! 是用于平衡全局和局部搜索能力的惯性权重.c1 和 c2 是两个常数, 分别称

为自学习因子和社会学习因子.r1d 和 r2d 是两个均匀分布在 [0,1] 范围内的随机数. 从速度和位

置更新公式可以看出粒子的位置由其自身的先前速度, 从粒子到其个体历史最佳位置的距离以

及粒子与每次迭代中的全局最佳位置之间的距离确定.

Xid(t + 1) = Xid(t) + Vid(t + 1):

PSO 算法的流程如下:

Step 1: 设定群体大小, 初始化粒子位置和速度;

Step 2: 计算目标函数值, 更新全局最优位置和粒子的局部最优位置;

Step 3: 根据式 (1) 和 (2) 更新粒子的速度和位置;

Step 4: 判断是否满足结束条件, 若满足, 则输出结果并结束, 否则转入 Step 2.

2 基于局部搜索的反向学习竞争粒子群优化 (SW-OBLCSO)

算法

2.1 反向学习机制

反向学习机制 (Opposition-Based Learning, OBL)[26] 是由 Tizhoosh 提出的一种可以有效

的拓宽搜索空间, 覆盖可行解区域的机制, 并且已被有效应用在差分进化算法[27] 中. 反向学习

- 3 -

�

机制可以在单次迭代中计算候选解决方案及其相应的反向解决方案. 反向算子是当前候选解决

方案的扩展, 有概率更接近最优解. 考虑区间 [a; b] 中的实数 x,x 的反向数 ~x 计算如下:

http://www.paper.edu.cn

~x = a + b − x:

(3)

将一维空间的反向数概念扩展到多维空间非常容易. 设 P (x1; x2;··· ; xD) 为 D 维空间中的

数,x1; x2;··· ; xD 均为实数,xi ∈ [ai; bi]. 则其反向数 ~P 由其坐标 ~x1; ~x2;··· ; ~xD 定义, 其中:

(4)

~xi = ai + bi − xi:

引入反向学习的优点是, 它可以同时搜索当前点和反向点, 如果反向点的适应值优于当前点的适

应值, 则粒子可以直接跳转到反向点或其邻域继续搜索. 这可以快速扩大解决方案空间, 增加找

到全局最优解的可能性.

2.2 Solis&Wets 局部搜索 (SW) 算法

局部搜索算法是解决优化问题常用的一种元启发式算法. 局部搜索从一个初始解出发, 然后

探索其邻域. 如果发现较优的解, 则移动到该解并继续执行搜索, 否则保留在当前解. 局部搜索

的优点是简单、灵活且易于实现, 缺点是容易出现早熟且解的质量受初始解和邻域结构的影响

较大.

SW 算法是一个强有力的局部搜索算法, 属于带有自适应步长的随机爬山算法, 它的性能

在很多大规模优化算法中得到了验证. 首先通过高斯采样得到偏差向量 d, d 的维度和问题维数

相同. 在初始搜索点 x 的基础上产生两个新解 x + d 和 x − d. 计算两个新解的适应度值, 并选

择一个较优解作为当前新解 x_new. 比较 x 和 x_new 的适应度值, 如果当前新解较优, x 则被

x_new 替换, 成功搜索计数器递增一次且失败搜索计数器清零. 如果原来的解较优, 则保持原

来的解不变, 失败搜索计数器递增一次且成功搜索计数器清零. 如果成功搜索计数器的值超过了

预先设定的阈值, 则增大髙斯函数的标准差并清零成功搜索计数器. 如果失败搜索计数器的值超

过了预先设定的阈值, 则减小高斯函数的标准差并清零失败搜索计数器. SW 的算法流程如下所

示:

Step 1: 初始化迭代次数、各计数器阈值. 获取初始解 x,val

Step 2: 生成高斯分布随机向量 d, 产生新解 x1 = x + d,x2 = x − d 并评估, 取较优解记为

x3, 其适应度值为 val(x3)

Step 3: 比较较优解与当前解的适应度大小, 更新当前解和相关计数器

Step 4: 判断计数器值是否超过阈值, 调整搜索步长并更新计数器

Step 5: 判断是否满足结束条件, 若满足, 则输出结果并结束, 否则转入 Step 2.

2.3 竞争学习机制和 SW-OBLCSO

在 PSO 算法中, 全局最佳粒子的影响始终被认为是早熟收敛的主要原因. 随着进化过程

的进行, 粒子的个体历史最佳位置可能与全局最佳粒子具有相同的值, 导致群体的多样性降低.

- 4 -

�

http://www.paper.edu.cn

为了削弱或消除全局最佳粒子和个体历史最佳粒子的影响, 文献 [24] 提出了竞争群体优化器

(CSO), 其中群体通过粒子之间的连续随机成对竞争来更新.CSO 中的竞争学习机制非常简单但

有效, 在成对竞争之后, 具有更好适应性的粒子是获胜者而另一个是失败者. 获胜者粒子直接传

递给下一次迭代, 失败者粒子从获胜者粒子中学习. 所有获胜者都在各自的竞争中发挥作用.

在本文中, 提出了一种基于局部搜索的反向学习竞争粒子群算法 (SW-OBLCSO). 算法在

竞争机制的基础上结合了反向学习和局部搜索, 相比竞争粒子群 (CSO) 算法而言同样简单却更

有效. 算法迭代过程中, 每次把种群随机分成四组, 每组依次选取一个粒子进行适应度评估, 然

后根据适应度值进行排序. 排名首位的粒子直接进入下一代, 称为优胜者; 排名第二的粒子进行

反向学习; 排名第三的粒子向优胜者粒子竞争学习, 排名最后的粒子获得优胜者粒子的位置并

添加一个偏置量, 以提高收敛速度并保持种群多样性. 四组中的所有粒子都参加竞争后, 找出群

体中此时的最小适应度值, 如果连续多代最小适应度值没有发生变化, 则以后的迭代中对具有

最小适应度的粒子进行 SW 搜索, 其中偏差向量随迭代次数增加而变小. 在每次迭代中, 对于大

小为 N 的种群, 需要 N/4 次竞争才能让所有粒子都参与竞争. 在 N/4 次竞争后. 有 3N/4 的

粒子更新了位置和速度. 其效率高于 CSO.SW-OBLCSO 算法中第二 (Second)、第三 (Third)、

第四 (Loser) 适应度值的粒子分别通过以下公式更新位置和速度:

td(t) + Rk

2d(t) · (X k

td(t) + V k

V k

td(t + 1) =

1d(t) · V k

Rk

X k

td(t + 1) = X k

sd(t + 1) = ubd + lbd − X k

X k

wd(t) ± tanh′

X k

ld(t + 1) = X k

wd(t) − X k

td(t + 1);

sd(t) + Rk

i · pd(t);

td(t)) + · Rk

3d(t) · ( ~X k

d (t) − X k

td(t));

4d(t) · X k

sd(t);

(5)

(6)

(7)

(8)

td(t) 和 X k

td(t) 是第 t 次迭代第 k 轮竞争中第三名的第 d 维的速度.Rk

ld(t) 分别代表第 t 次迭代第 k 轮竞争中的第二名, 第三名和失败者位

sd(t),X k

其中,X k

置的第 d 维.V k

3d(t) 和

d (t) 是所有粒子的平均位置.ubd 和 lbd

4d(t) 是 [0,1] 内的 4 个随机数. 是人工设置的参数, ~X k

Rk

是第 d 维搜索空间中的上界和下界.pd(t) 是与问题维数相同的高斯采样偏差向量在第 t 次迭代

i · p 和 x − tanh′

i · p. 计算两

中的第 d 维. i 为常数. 在优胜者的基础上产生两个新解 x + tanh′

个新解的适应度值, 并选择一个较优解赋给失败者.SW-OBLCSO 的算法流程如下:

1d(t),Rk

2d(t),Rk

Step 1: 初始化种群 P 、粒子的位置和速度

Step 2:WHILE FEs

http://www.paper.edu.cn

搜索空间

[-100,100]

[-30,30]

[-100,100]

[-5.12,5.12]

[-32,32]

[-600,600]

[-100,100]

[-100,100]

[-1.28,1.28]

[-50,50]

表 1: 文中所用测试函数

− xi+1)2 + (xi − 1)2)

∑

f1(x) =

f2(x) =

f3(x) =

f4(x) =

f5(x) = −20exp(−0:2

∑

∑

函数表达式

∑

D

i=1 x2

i

D1

∑

i=1 (100(x2

i

i=1(⌊xi + 0:5⌋)2

√∑

D

D

i=1(x2

i

i /4000 −∏

∑

∑

∑

D

i=1 x2

∑

D

i=1(

i=1 i ∗ x4

{10(sin(y1))2 +

exp(

D

D

i=1 x2

i=1 cos(2xi)/D) + 20 + e

− 10 cos(2xi) + 10)

i /D)−

√

i=1 cos(xi/

i) + 1

D

f6(x) =

i

j=1 xj)2

f7(x) =

f8(x) = maxi=1; ;D |xi|

∑

∑

f9(x) =

i + random[0; 1)

i=1 (yi − 1)2[1+

D1

f10(x) =

D

10(sin(yi + 1))2] + (yD − 1)2} +

where yi = 1 + (xi + 1)/4,

D

u(xi; a; k; m) =

k(xi − a)m

0

k(−xi − a)m

D

i=1 u(xi; 10; 100; 4)

xi > a

− a ≤ xi ≤ a ; i = 1;··· ; D

xi < a

Step 7: 根据公式 (5)(6) 更新第三名粒子的位置

Step 8: 根据公式 (7) 更新第二名粒子的位置

Step 9: 根据公式 (8) 更新第四名粒子的位置

Step 10: 更新第二第三第四名的适应度值

Step 11:end for

Step 12: 找出种群的最优适应度粒子, 记录 [min_index,min_f it]

Step 13: 若 min_f it 的值连续 N 次不变, 则对 P (min_index) 进行 SW 局部搜索

Step 14:END WHILE

Step 15: 判断是否满足结束条件, 若满足, 则输出结果并结束, 否则转入 Step 2

3 实验结果与分析

3.1 SW-OBLCSO 在 10 个基准测试上的实验

3.1.1 参数设置

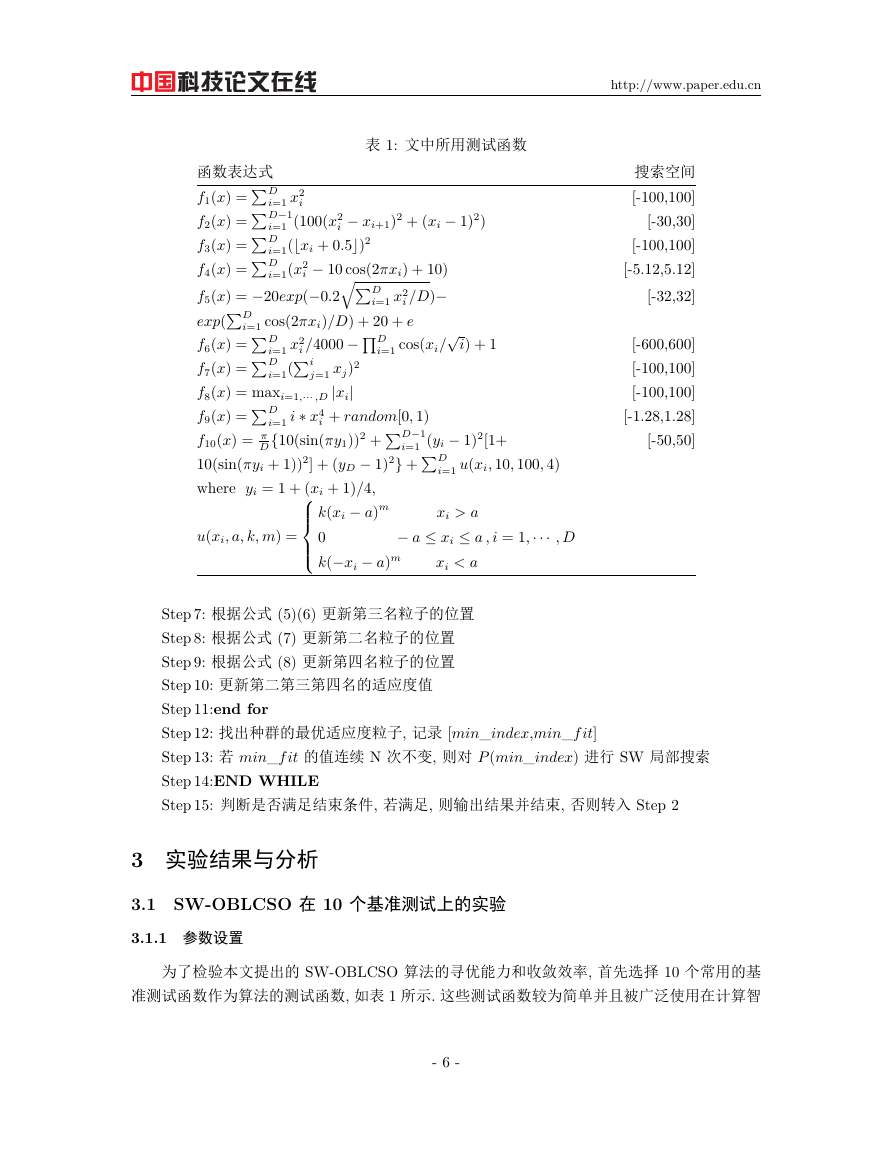

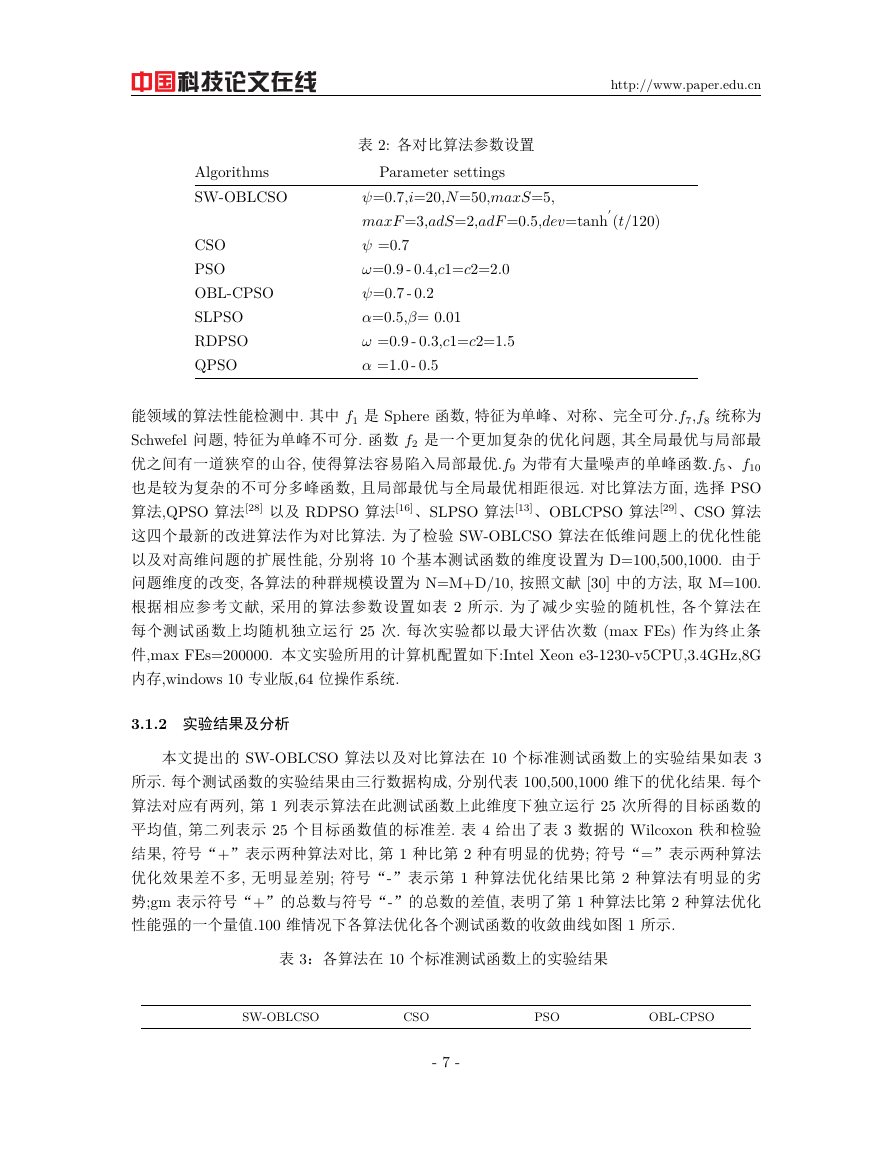

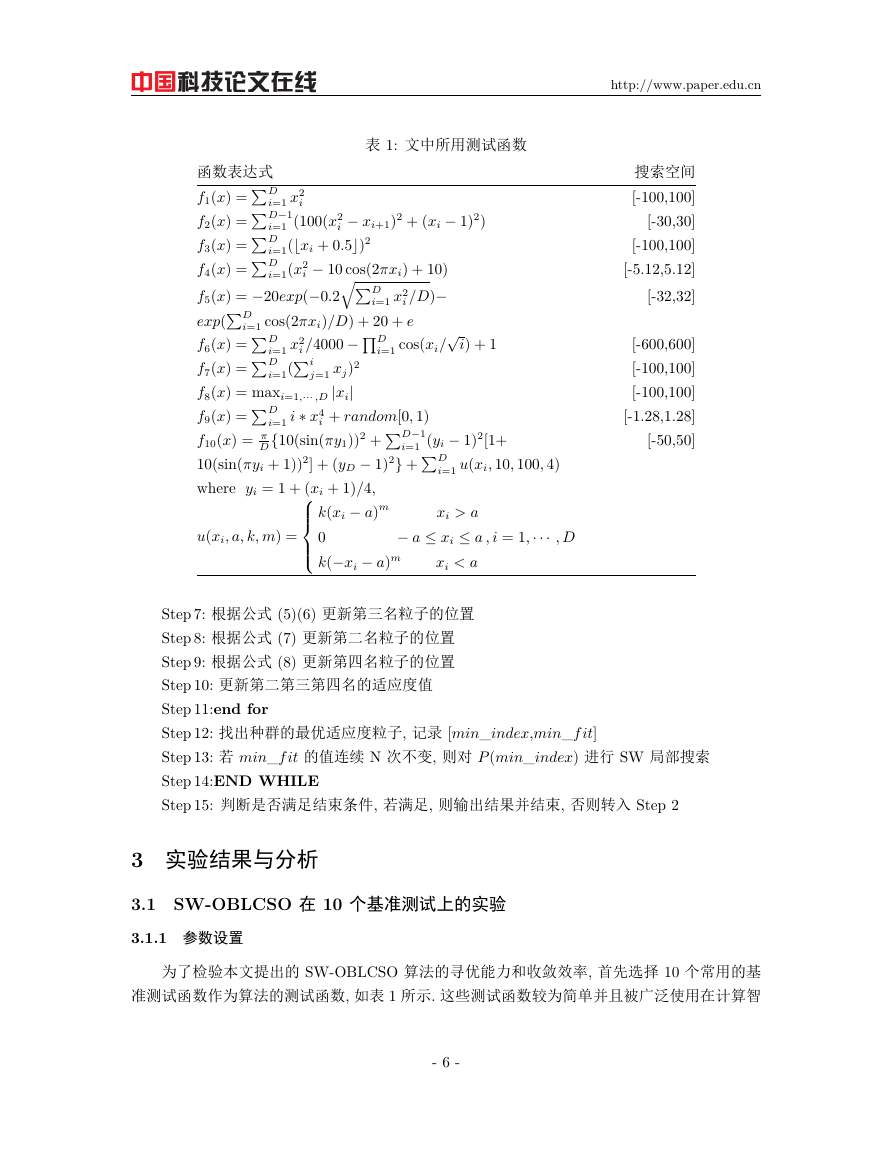

为了检验本文提出的 SW-OBLCSO 算法的寻优能力和收敛效率, 首先选择 10 个常用的基

准测试函数作为算法的测试函数, 如表 1 所示. 这些测试函数较为简单并且被广泛使用在计算智

- 6 -

�

http://www.paper.edu.cn

Algorithms

SW-OBLCSO

CSO

PSO

OBL-CPSO

SLPSO

RDPSO

QPSO

表 2: 各对比算法参数设置

Parameter settings

=0.7,i=20,N=50,maxS=5,

maxF=3,adS=2,adF=0.5,dev=tanh′

=0.7

!=0.9 - 0.4,c1=c2=2.0

=0.7 - 0.2

=0.5,= 0.01

! =0.9 - 0.3,c1=c2=1.5

=1.0 - 0.5

(t/120)

能领域的算法性能检测中. 其中 f1 是 Sphere 函数, 特征为单峰、对称、完全可分.f7,f8 统称为

Schwefel 问题, 特征为单峰不可分. 函数 f2 是一个更加复杂的优化问题, 其全局最优与局部最

优之间有一道狭窄的山谷, 使得算法容易陷入局部最优.f9 为带有大量噪声的单峰函数.f5、f10

也是较为复杂的不可分多峰函数, 且局部最优与全局最优相距很远. 对比算法方面, 选择 PSO

算法,QPSO 算法[28] 以及 RDPSO 算法[16]、SLPSO 算法[13]、OBLCPSO 算法[29]、CSO 算法

这四个最新的改进算法作为对比算法. 为了检验 SW-OBLCSO 算法在低维问题上的优化性能

以及对高维问题的扩展性能, 分别将 10 个基本测试函数的维度设置为 D=100,500,1000. 由于

问题维度的改变, 各算法的种群规模设置为 N=M+D/10, 按照文献 [30] 中的方法, 取 M=100.

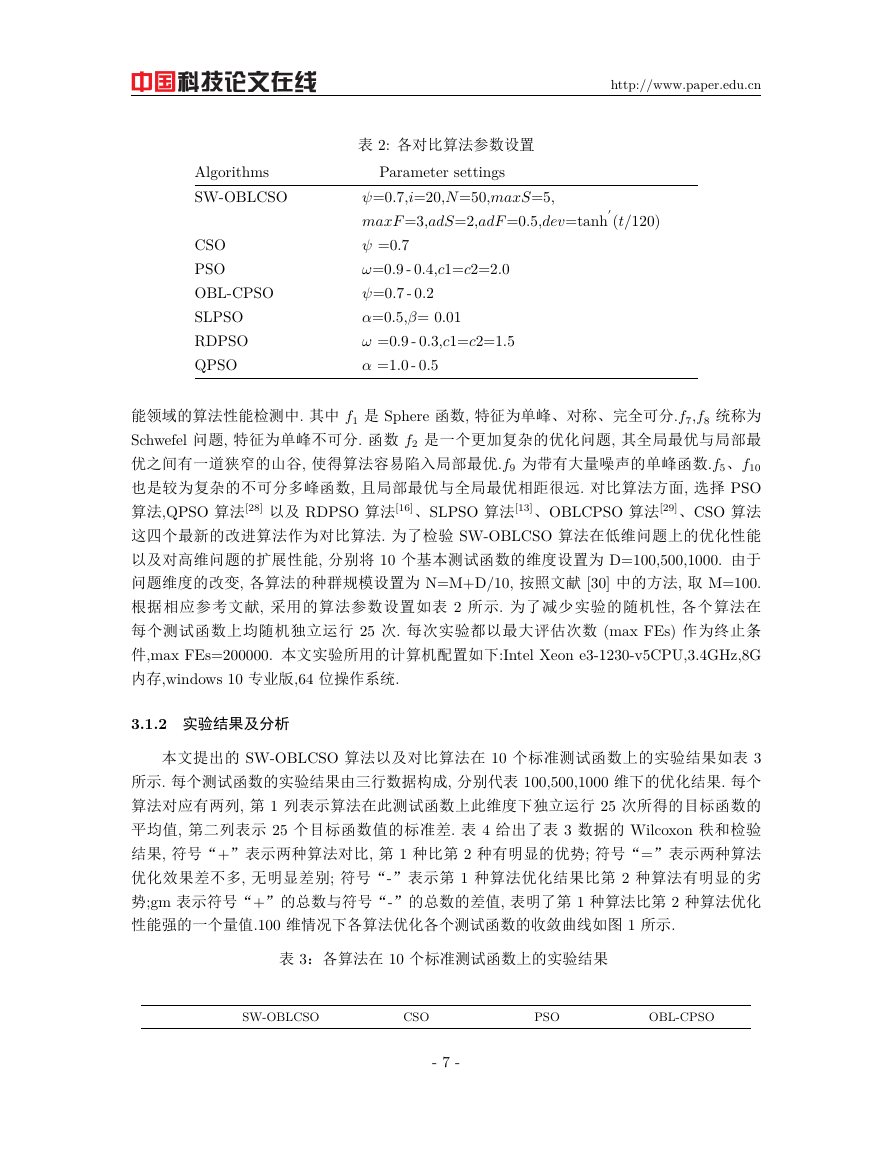

根据相应参考文献, 采用的算法参数设置如表 2 所示. 为了减少实验的随机性, 各个算法在

每个测试函数上均随机独立运行 25 次. 每次实验都以最大评估次数 (max FEs) 作为终止条

件,max FEs=200000. 本文实验所用的计算机配置如下:Intel Xeon e3-1230-v5CPU,3.4GHz,8G

内存,windows 10 专业版,64 位操作系统.

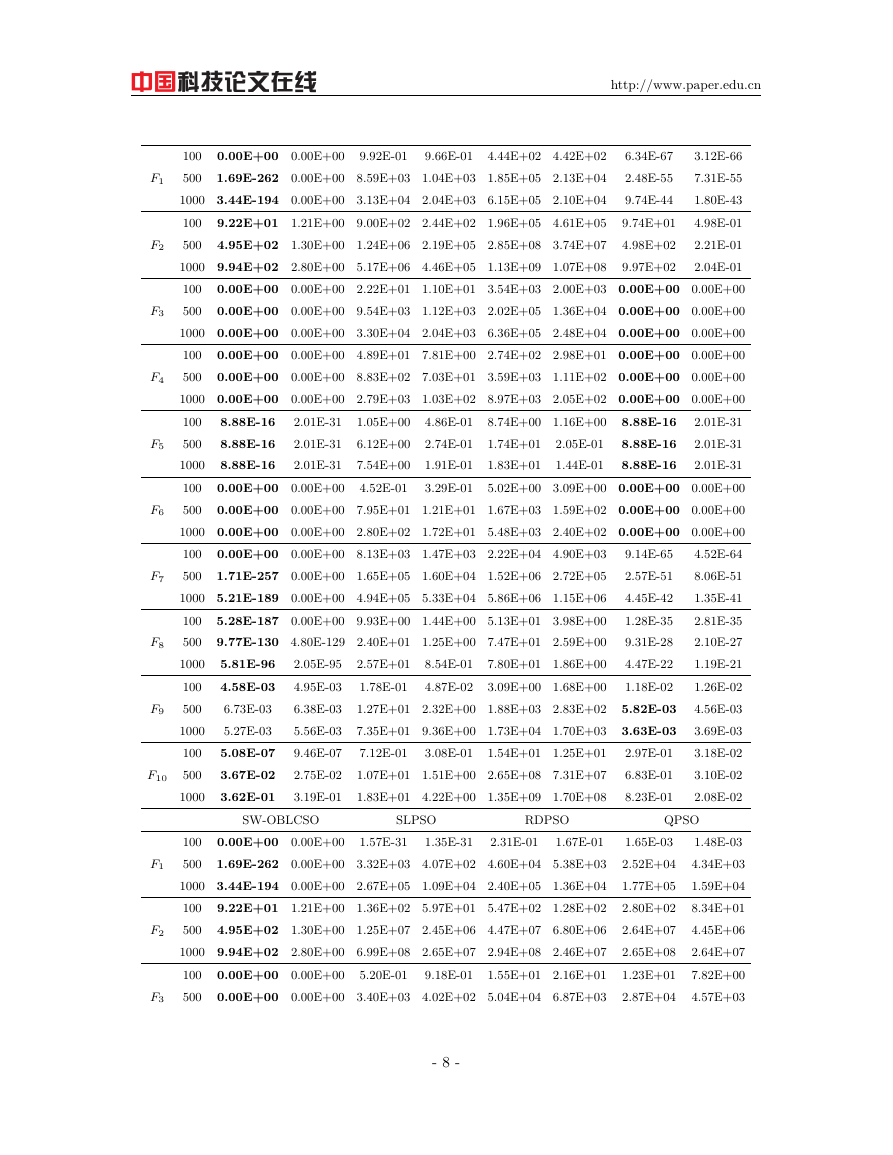

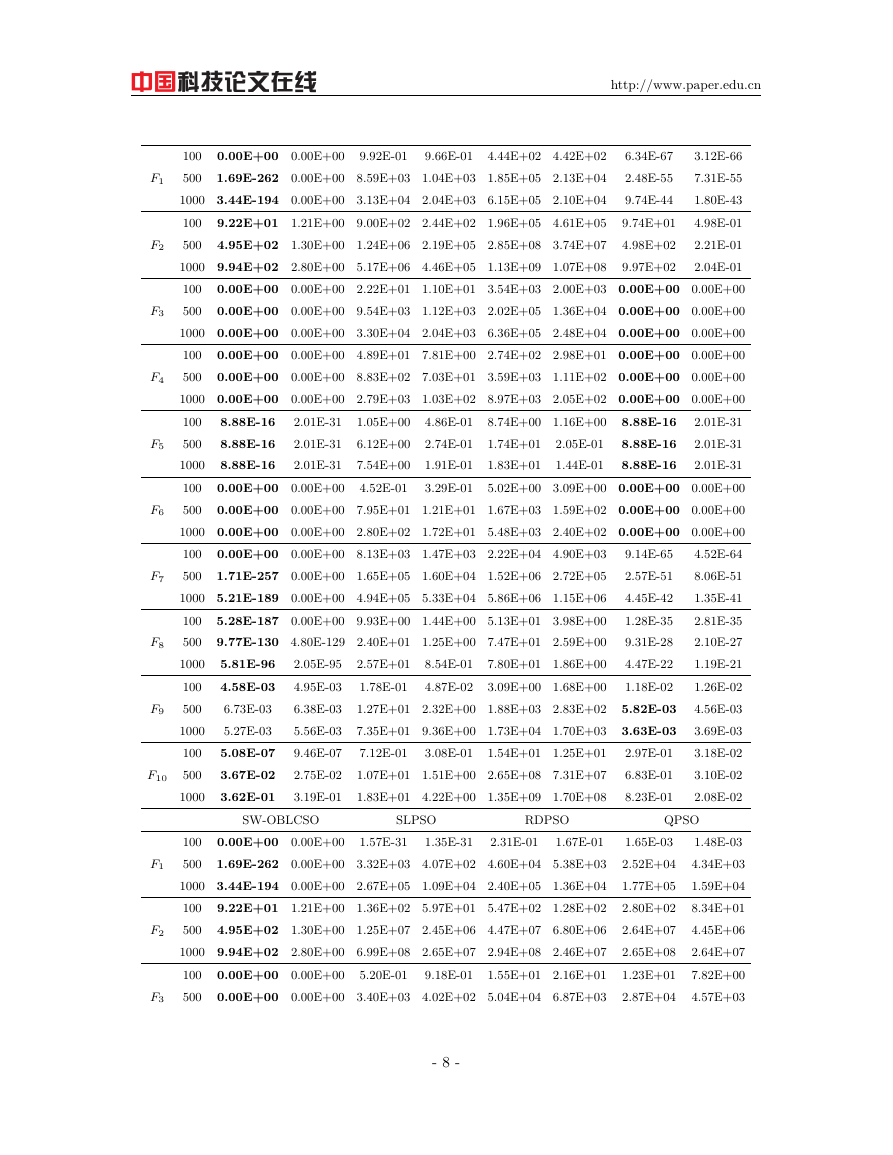

3.1.2 实验结果及分析

本文提出的 SW-OBLCSO 算法以及对比算法在 10 个标准测试函数上的实验结果如表 3

所示. 每个测试函数的实验结果由三行数据构成, 分别代表 100,500,1000 维下的优化结果. 每个

算法对应有两列, 第 1 列表示算法在此测试函数上此维度下独立运行 25 次所得的目标函数的

平均值, 第二列表示 25 个目标函数值的标准差. 表 4 给出了表 3 数据的 Wilcoxon 秩和检验

结果, 符号“+”表示两种算法对比, 第 1 种比第 2 种有明显的优势; 符号“=”表示两种算法

优化效果差不多, 无明显差别; 符号“-”表示第 1 种算法优化结果比第 2 种算法有明显的劣

势;gm 表示符号“+”的总数与符号“-”的总数的差值, 表明了第 1 种算法比第 2 种算法优化

性能强的一个量值.100 维情况下各算法优化各个测试函数的收敛曲线如图 1 所示.

表 3:各算法在 10 个标准测试函数上的实验结果

SW-OBLCSO

CSO

PSO

OBL-CPSO

- 7 -

�

http://www.paper.edu.cn

F1

F2

F3

F4

F5

F6

F7

F8

F9

F10

F1

F2

F3

9.92E-01

9.66E-01

6.34E-67

2.48E-55

9.74E-44

9.74E+01

4.98E+02

9.97E+02

0.00E+00 0.00E+00

3.12E-66

4.44E+02 4.42E+02

100

1.69E-262 0.00E+00 8.59E+03 1.04E+03 1.85E+05 2.13E+04

7.31E-55

500

1000 3.44E-194 0.00E+00 3.13E+04 2.04E+03 6.15E+05 2.10E+04

1.80E-43

9.22E+01 1.21E+00 9.00E+02 2.44E+02 1.96E+05 4.61E+05

4.98E-01

100

4.95E+02 1.30E+00 1.24E+06 2.19E+05 2.85E+08 3.74E+07

2.21E-01

500

1000 9.94E+02 2.80E+00 5.17E+06 4.46E+05 1.13E+09 1.07E+08

2.04E-01

0.00E+00 0.00E+00 2.22E+01 1.10E+01 3.54E+03 2.00E+03 0.00E+00 0.00E+00

100

0.00E+00 0.00E+00 9.54E+03 1.12E+03 2.02E+05 1.36E+04 0.00E+00 0.00E+00

500

1000 0.00E+00 0.00E+00 3.30E+04 2.04E+03 6.36E+05 2.48E+04 0.00E+00 0.00E+00

0.00E+00 0.00E+00 4.89E+01 7.81E+00 2.74E+02 2.98E+01 0.00E+00 0.00E+00

100

0.00E+00 0.00E+00 8.83E+02 7.03E+01 3.59E+03 1.11E+02 0.00E+00 0.00E+00

500

1000 0.00E+00 0.00E+00 2.79E+03 1.03E+02 8.97E+03 2.05E+02 0.00E+00 0.00E+00

8.88E-16

2.01E-31

2.01E-31

100

8.74E+00 1.16E+00

8.88E-16

2.01E-31

2.01E-31

500

2.05E-01

1.74E+01

8.88E-16

2.01E-31

1.83E+01

1000

2.01E-31

1.44E-01

0.00E+00 0.00E+00

5.02E+00 3.09E+00 0.00E+00 0.00E+00

100

0.00E+00 0.00E+00 7.95E+01 1.21E+01 1.67E+03 1.59E+02 0.00E+00 0.00E+00

500

1000 0.00E+00 0.00E+00 2.80E+02 1.72E+01 5.48E+03 2.40E+02 0.00E+00 0.00E+00

0.00E+00 0.00E+00 8.13E+03 1.47E+03 2.22E+04 4.90E+03

100

4.52E-64

1.71E-257 0.00E+00 1.65E+05 1.60E+04 1.52E+06 2.72E+05

8.06E-51

500

1000 5.21E-189 0.00E+00 4.94E+05 5.33E+04 5.86E+06 1.15E+06

1.35E-41

5.28E-187 0.00E+00 9.93E+00 1.44E+00 5.13E+01 3.98E+00

100

2.81E-35

9.77E-130 4.80E-129 2.40E+01 1.25E+00 7.47E+01 2.59E+00

2.10E-27

500

5.81E-96

1.19E-21

7.80E+01 1.86E+00

1000

2.57E+01

4.58E-03

1.26E-02

1.78E-01

100

3.09E+00 1.68E+00

500

6.73E-03

1.27E+01 2.32E+00 1.88E+03 2.83E+02

4.56E-03

3.69E-03

7.35E+01 9.36E+00 1.73E+04 1.70E+03

5.27E-03

1000

5.08E-07

3.18E-02

7.12E-01

100

1.54E+01 1.25E+01

3.67E-02

500

1.07E+01 1.51E+00 2.65E+08 7.31E+07

3.10E-02

3.62E-01

2.08E-02

1.83E+01 4.22E+00 1.35E+09 1.70E+08

1000

9.14E-65

2.57E-51

4.45E-42

1.28E-35

9.31E-28

4.47E-22

1.18E-02

5.82E-03

3.63E-03

2.97E-01

6.83E-01

8.23E-01

2.05E-95

4.95E-03

6.38E-03

5.56E-03

9.46E-07

2.75E-02

3.19E-01

1.05E+00

6.12E+00

7.54E+00

4.52E-01

4.86E-01

2.74E-01

1.91E-01

3.29E-01

8.88E-16

8.88E-16

8.88E-16

8.54E-01

4.87E-02

3.08E-01

SW-OBLCSO

SLPSO

RDPSO

QPSO

1.35E-31

1.57E-31

2.31E-01

0.00E+00 0.00E+00

1.67E-01

100

1.69E-262 0.00E+00 3.32E+03 4.07E+02 4.60E+04 5.38E+03

500

1000 3.44E-194 0.00E+00 2.67E+05 1.09E+04 2.40E+05 1.36E+04

9.22E+01 1.21E+00 1.36E+02 5.97E+01 5.47E+02 1.28E+02

100

4.95E+02 1.30E+00 1.25E+07 2.45E+06 4.47E+07 6.80E+06

500

1000 9.94E+02 2.80E+00 6.99E+08 2.65E+07 2.94E+08 2.46E+07

0.00E+00 0.00E+00

100

1.55E+01 2.16E+01

0.00E+00 0.00E+00 3.40E+03 4.02E+02 5.04E+04 6.87E+03

500

5.20E-01

9.18E-01

1.65E-03

2.52E+04

1.77E+05

2.80E+02

2.64E+07

2.65E+08

1.23E+01

2.87E+04

1.48E-03

4.34E+03

1.59E+04

8.34E+01

4.45E+06

2.64E+07

7.82E+00

4.57E+03

- 8 -

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc