第 3 卷第 12 期

2017 年 12 月

网络与信息安全学报

Chinese Journal of Network and Information Security

Vol.3 No.12

December 2017

基于块效应网格偏移的重获取 JPEG 图像篡改检测

黄维 1,2,黄添强 1,2,张雪莉 1,2,肖辉 1,2

(1. 福建师范大学数学与信息学院,福建 福州 350117;

2. 福建省大数据挖掘与应用工程技术研究中心,福建 福州 350117)

摘 要:重获取图像是原始或篡改后的图像经过中间媒介的映射后再次拍摄获取的图像,一张高质量的重获

取伪造图像很难通过人眼判别真伪。针对 JPEG 格式的重获取图像篡改操作,提出了一种重压缩块效应网格

偏移的检测方法。重获取图像由于再获取过程会引入与原图不相关的背景信息,该图像进行多次压缩会产生

块效应网格偏移,即重压缩产生的块效应网格会与原始的网格错匹配,利用图像的平均信息损失量进行块效

应网格是否发生偏移来检测图像的原始性。实验表明,该方法比已有的重获取图像检测方法准确率更高,且

平均检测时间更短。

关键词:图像取证;重获取图像;JPEG 图像;重压缩;块效应网格偏移

中图分类号:TP393

文献标识码:A

doi: 10.11959/j.issn.2096-109x.2017.00220

JPEG recapture image tamper detection method

based on block effect grid offset

HUANG Wei1,2, HUANG Tian-qiang1,2, ZHANG Xue-li1,2, XIAO Hui1,2

(1. College of Mathematics and Informatics, Fujian Normal University, Fuzhou 350117, China;

2. Fujian Provincial Engineering Research Center of Big Data Analysis and Application, Fuzhou 350117, China)

Abstract: Recaptured images are captured original or distorted image shown on the intermediaries, a high-quality

recapture image is difficult to distinguish the authenticity of the human eye. Aimed at the tampering operation of

JPEG image, a method of detecting block effect grid offset due to re-compression was proposed. The original image

was compressed multiple times did not produce the block effect of the grid offset, and the recapture image, because

of the recapture process would introduce background information that was not related to the original image, the

re-compression of the block effect grid with the original grid is mismatched, and the average information loss

amount of the image was used to detect whether the block effect grid generates an offset or not to detect the

recapture image. Experiments show that this method is more accurate than the existing recapture image detection

method, and the average detection time is shorter.

Key words: image forensics, recapture images, JPEG images, repetitive compression, offset of BAG

收稿日期:2017-10-15;修回日期:2017-11-24。通信作者:黄添强,fjhtq@fjnu.edu.cn

基金项目:国家自然科学基金资助项目(No.61070062, No.61502103);福建省高校产学合作科技重大基金资助项目

(No.2015H6007);福州市科技计划基金资助项目(No.2014-G-76);福建省高等学校新世纪优秀人才支持基金资助项目

(No.JAI1038);福建省科学厅 K 类基金资助项目(No.2011007);福建省教育厅 A 类基金资助项目(No.JA10064)

Foundation Items: The National Natural Science Foundation of China (No.61070062, No.61502103), Industry-University

Cooperation Major Project of Fujian Province (No.2015H6007), Science and Technology Program of Fuzhou (No.2014-G-76)

Program for New Century Excellent Talents in University of Fujian Province(No.JAI1038), The K-class Foundation Project of

Fujian Provincial Science and Technology (No.2011007), The A-class Foundation Project of Fujian Provincial Education

Department (No.JA10064)

00220-1

�

黄维等:基于块效应网格偏移的重获取 JPEG 图像篡改检测

·25·

第 12 期

1 引言

随着智能化数码拍摄设备的普及,以及多媒体

编辑软件功能的易于操作和强大,数字图像的篡改

越来越容易进行。恶意的伪造篡改图像内容会使图

像的真实性和可靠性遭受怀疑,因此,对于数字图

像真伪的辨别研究显得尤为重要[1]。

重获取图像是一种常见的图像伪造手段,是

原始或篡改后的图像经过中间媒介的映射后再次

拍摄获取的图像。对重获取图像而言,只要其图

像质量高,就可能使人们对于图像的原始所有者

或者内容产生疑惑,引起争执,甚至产生利益上

的伤害,如许多产品外包装的造假以及“华南虎

事件”[2],都引起了社会的广泛关注,造成了一

定的负面影响,更加说明了对于重获取图像的取

证研究所具有的现实意义。

目前,对于重获取图像的研究已经有了一定

的进展。Farid 等[3]最早提出利用高阶小波统计特

征来区分自然图像和非自然图像。非自然图像指

的 是 重 获 取 图 像 和 计 算 机 合 成 图 像 ( CG,

composite graph),但是对于高质量重获取图像的

检测效果不佳,精度不高。Yu 等[4]提出了针对于

重获取打印图像的级联双色模型概念。作者利用

文献[5]提出的基本原理是将图像分解成两部分:

镜面反射部分和漫反射部分,图像的漫反射分量

中存在一些与纸质表面的纹理特性有关的高频分

量。作者采用 400 张图像组成的图像库进行实验,

利用镜面反射分量除以图像本身得到镜面反射分

量在图像本身中的占比,进一步消除了图像亮度

的影响,验证了自然图像的镜面反射分量的占比

梯度直方图近似服从拉普拉斯分布,重获取图像

的镜面反射分量占比梯度直方图服从瑞利分布,

但文中并没有给出该算法在区分原始图像和重获

取图像的准确率[6]。Gao 等[7]提出了一个通用物理

模型,以函数响应的形式给出重获取图像的物理

过程,分析了一系列的物理特征量检测重获取图

像,但是特征维度高,提取特征时间较长,实时性

较差。Kot 等[8]建立了针对 PC 机液晶显示器上的重

获取图像库,提出了 3 种图像特征进行检测,其一

是多尺度的图像纹理描述算子 Multi-LBP(local

binary pattern)特征,其二是多尺度小波特征,其

三是颜色特征空间。该方法取得了较好的实验效

果,本文的算法也将与之对比。Yin 等[9]在文章中

采用了噪声特性和 JPEG 压缩特性来分析 PC 机液

晶显示器上的重获取图像。实验结果显示该算法具

有一定的区分能力,但是准确率方面还有待提高。

文献[10,11]提出基于边缘轮廓线字典学习的方法,

是对 PC 机 LCD 显示屏上的重获取图像进行检

测。该方法具有较好的实时性,提取特征的维数

较少,时间相应减少。Li 等[12]提出基于图像的物

理特征方法,对液晶屏上的重获取图像进行检测。

本文针对重获取的 JPEG 图像重压缩造成的

网格不匹配特性进行检测。块效应网格偏移一般

用于图像复制粘贴中篡改区域的定位检测,而重

获取的 JPEG 图像也会因为重压缩造成块效应网

格偏移,所以针对此特性,本文首次把它用来检

测重获取的 JPEG 图像。由于 JPEG 图像编码过

程中会对图像进行 8×8 的分块,在重获取图像

的过程中会对图像进行再次编码,再次编码划

分 的 块 不 同 造 成 图 像 重 压 缩 网 格 不 匹 配 的 特

性。本文利用 JPEG 压缩之后的平均信息损失量

检测出网格不匹配现象,从而确定图像是否为

重获取图像。

本文的算法检测对象不仅是 PC 机 LCD 显示

屏上的重获取 JPEG 图像,还可以是印刷产品外

包装或其他地方重获取的 JPEG 图像,检测范围

更广。本文的算法具有提取的特征维数低、准确

率高的性能。本文提取特征的时间与基于多尺度

LBP 特征的方法和基于多尺度小波特征检测方法

相比较,检测时间更短,检测效果更好。

2

JPEG 图像网格错匹配

JPEG 图像编码过程中,将图像分成 8×8 的

像素块,然后对每块分别进行离散余弦变换(DCT,

discrete cosine transform),得到 64 个 DCT 系数,

该操作导致块与块之间的相关性被忽略。对每块

的 DCT 系数进行量化时,由于量化过程中的 DCT

系数需要取整,导致一些图像的高频分量丢失,

使解码的图像块与块边界处的像素不连续,产生

水平竖直的网格线,这种现象被称为块效应网格

(BAG, block artifact grid)[11]。

JPEG 重获取图像的伪造过程为:在一个真实

00220-2

�

·26·

网络与信息安全学报

第 3 卷

的场景利用图像采集设备进行拍摄,得到一个原

始 JPEG 图像,此时该图像经过一次 JPEG 压缩。

该图像可以在 LCD 显示屏、手机、扫描仪、彩色

打印机等设备显示。篡改者可通过对这些图像显

示设备上的原图像进行再次拍摄,得到重获取的

JPEG 图像,此时图像经历再一次 JPEG 压缩。在

重获取原图像的过程中,会或多或少引入与原始

图像无关的背景信息,可利用现有的图像编辑软

件,如 Photoshop、光影魔术手、ISEE 等进一步

处理图像,使图像与原图像尽可能相似,无法

通过人眼直接辨别。重获取图像的操作流程如

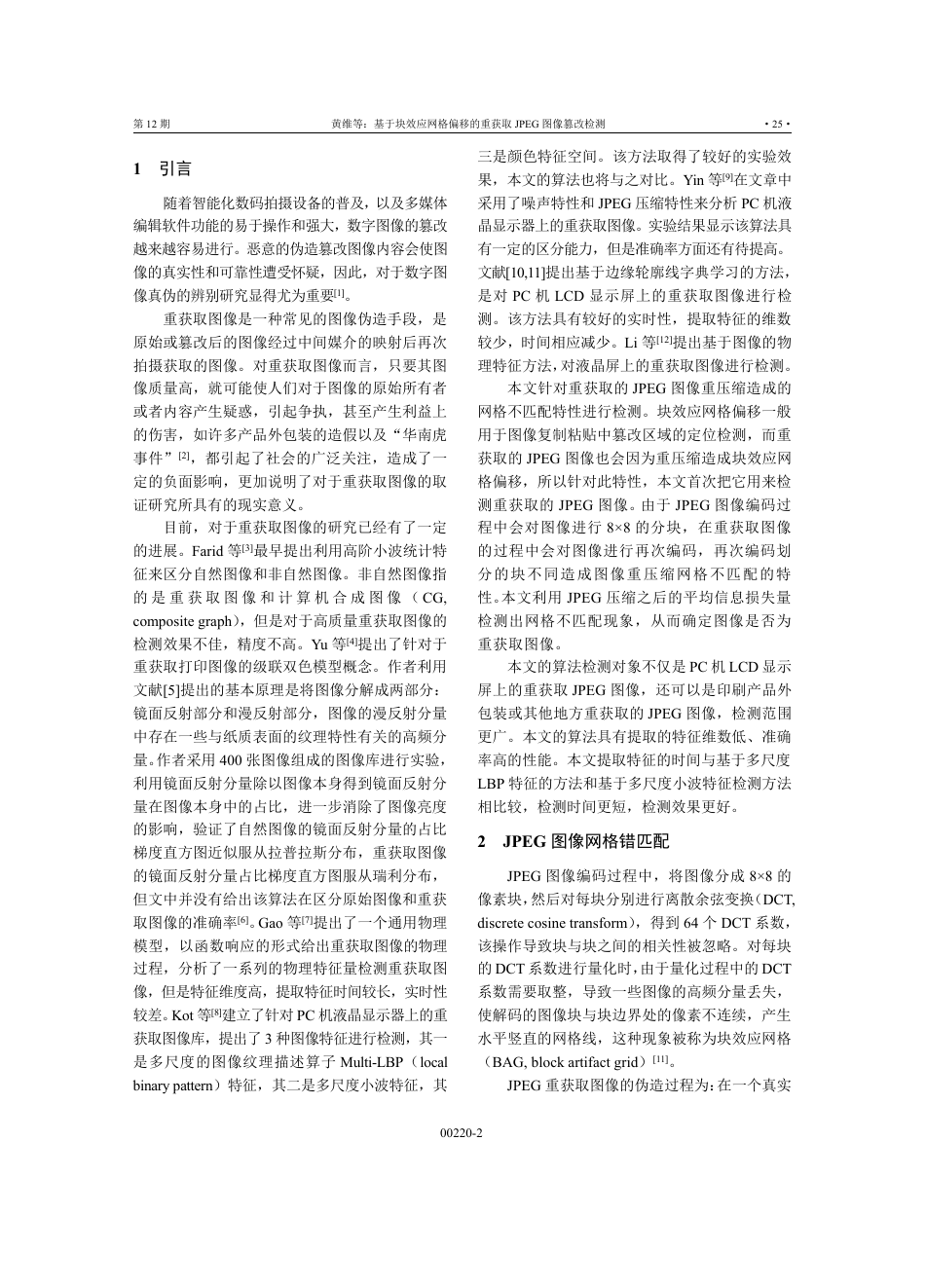

图 1 所示。

压缩偏移量,将图像剪切 m 行 n 列(0≤m≤7,

0≤n≤7),并且提取图像的质量因子 QF2,再以

质量因子 QF2 压缩剪切图像,对压缩之后的图像

进行分块以及离散余弦变换求出图像平均信息损

失 度 , 由 于 图 像 剪 切 m 行 n 列 (0≤m≤7 ,

0≤n≤7),所以生成了 64 维平均信息损失量特

征,然后根据提取的 64 维平均信息损失量特征的

峰值确定是否发生 BAG 的错匹配,峰值出现的

位置是 0 行 0 列代表了图像的原始性,不是 0 行

0 列的位置则判定该图像为重获取图像。算法主

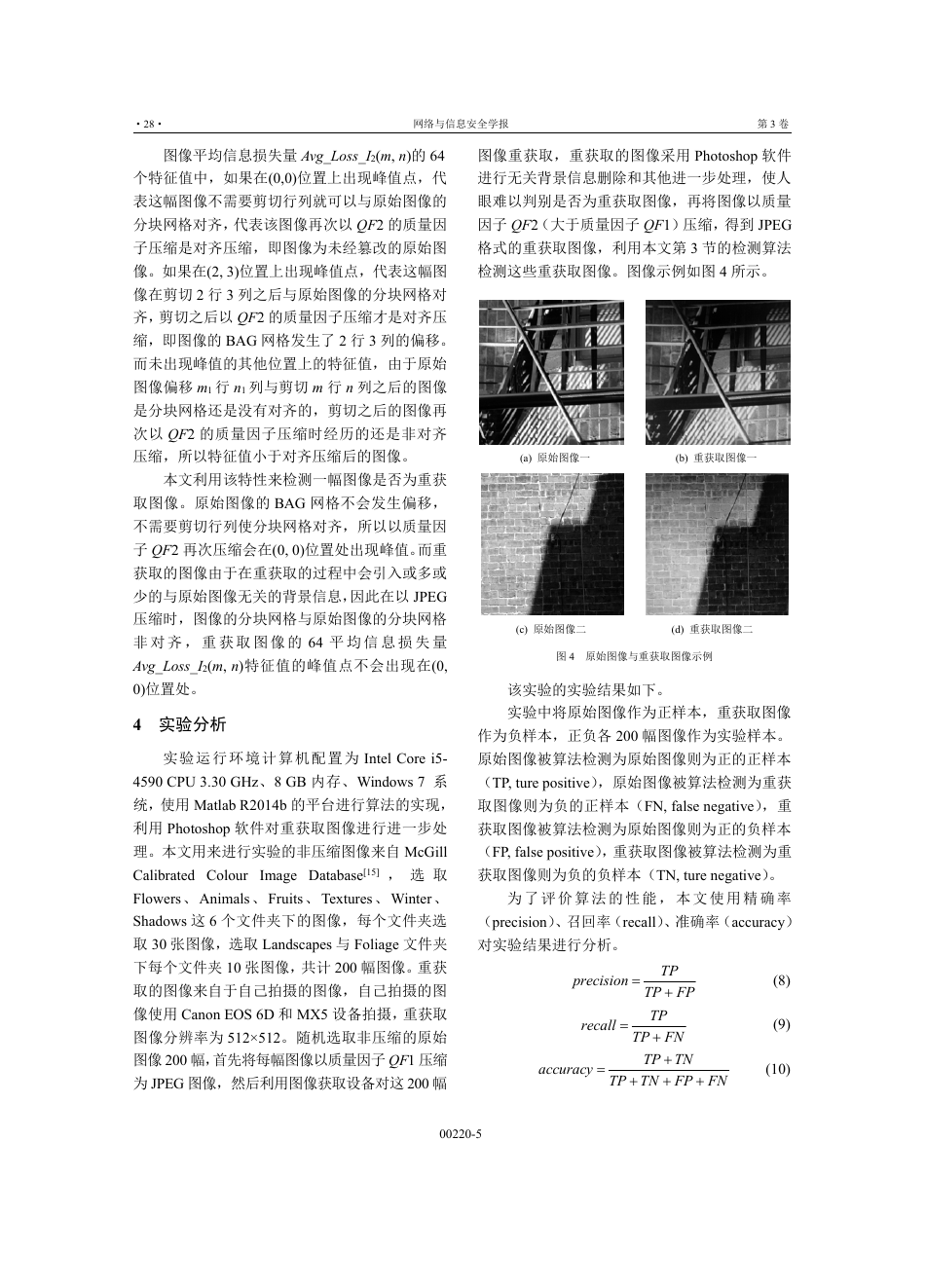

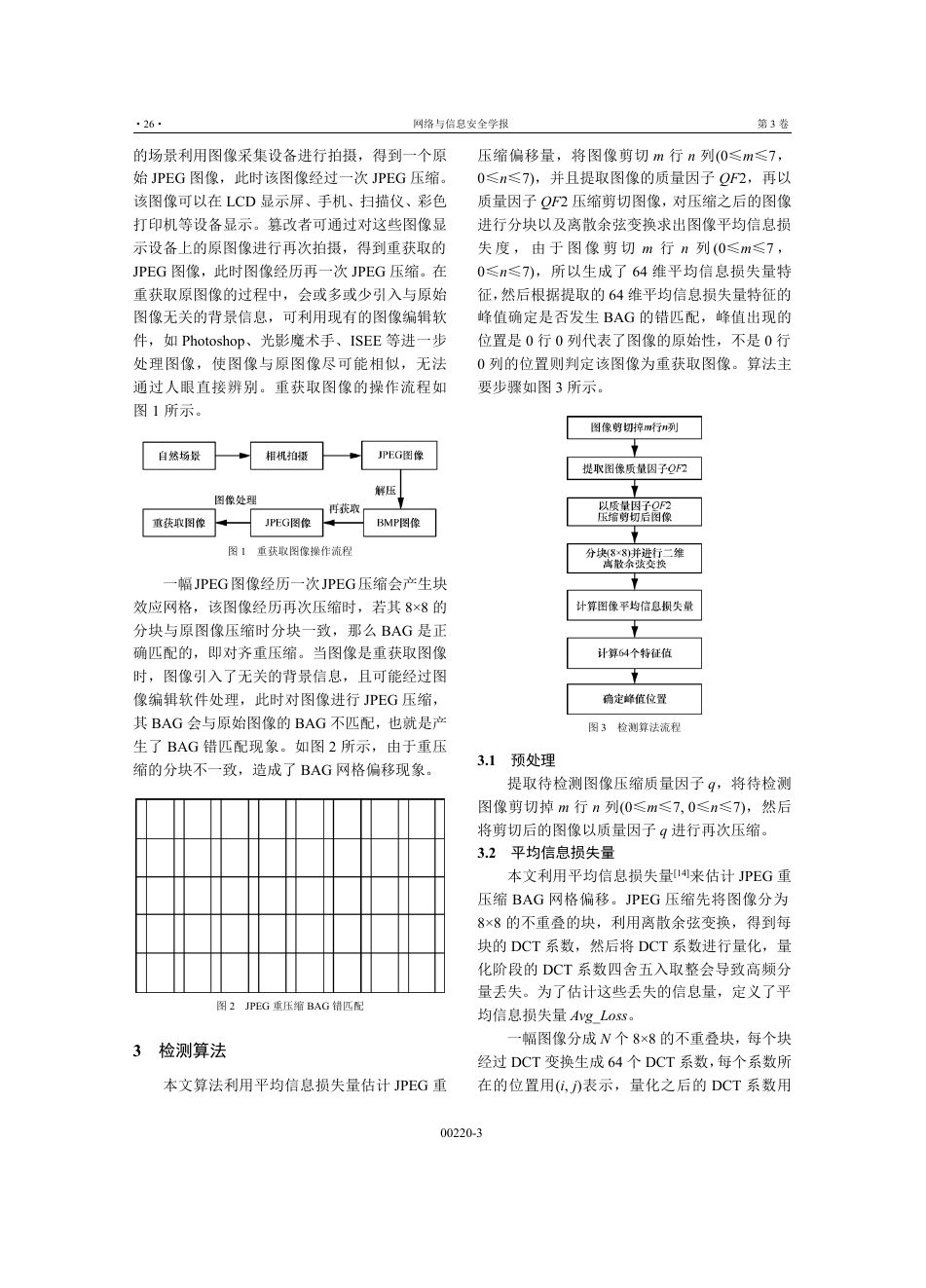

要步骤如图 3 所示。

图 1 重获取图像操作流程

一幅JPEG 图像经历一次JPEG 压缩会产生块

效应网格,该图像经历再次压缩时,若其 8×8 的

分块与原图像压缩时分块一致,那么 BAG 是正

确匹配的,即对齐重压缩。当图像是重获取图像

时,图像引入了无关的背景信息,且可能经过图

像编辑软件处理,此时对图像进行 JPEG 压缩,

其 BAG 会与原始图像的 BAG 不匹配,也就是产

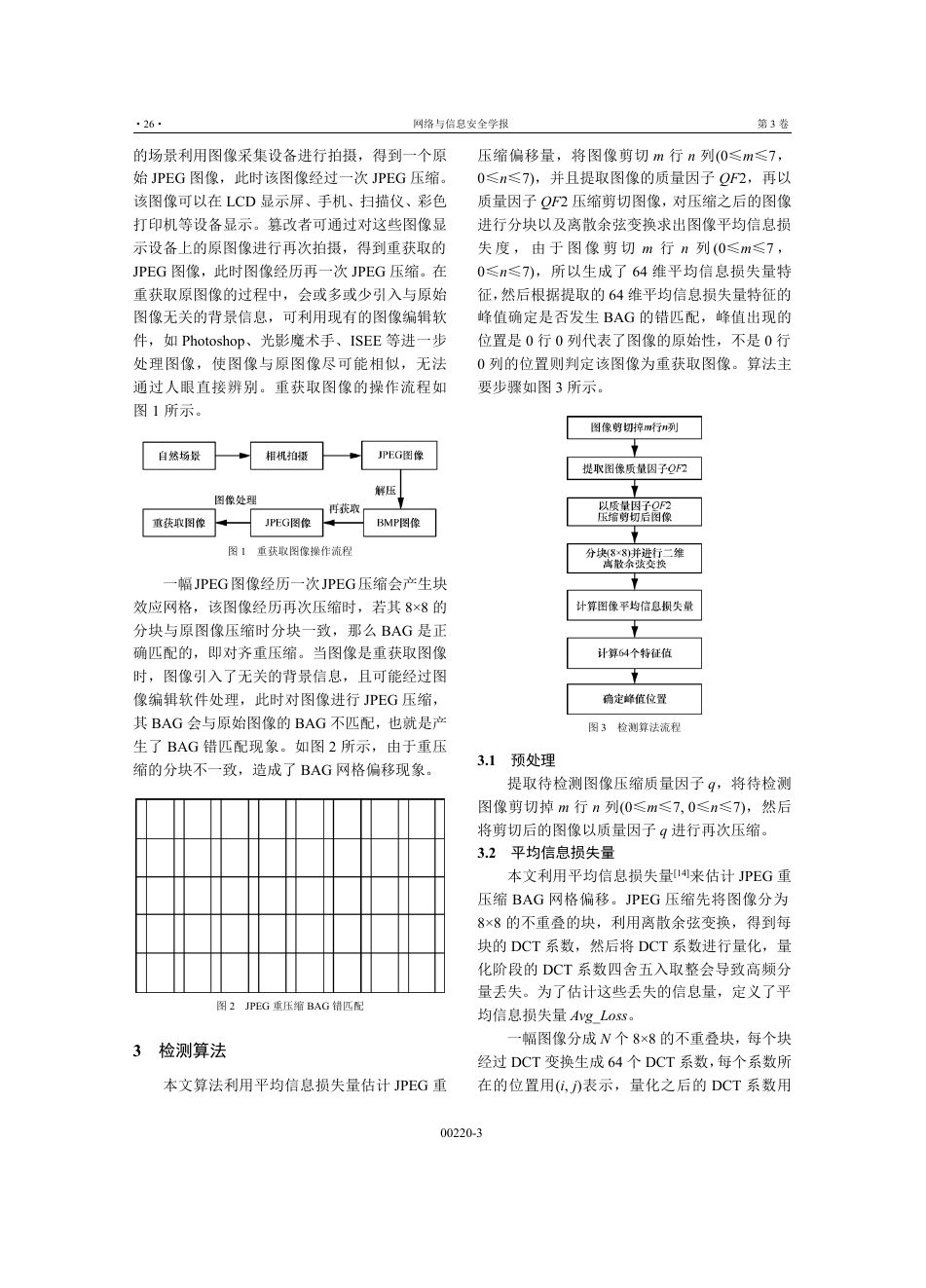

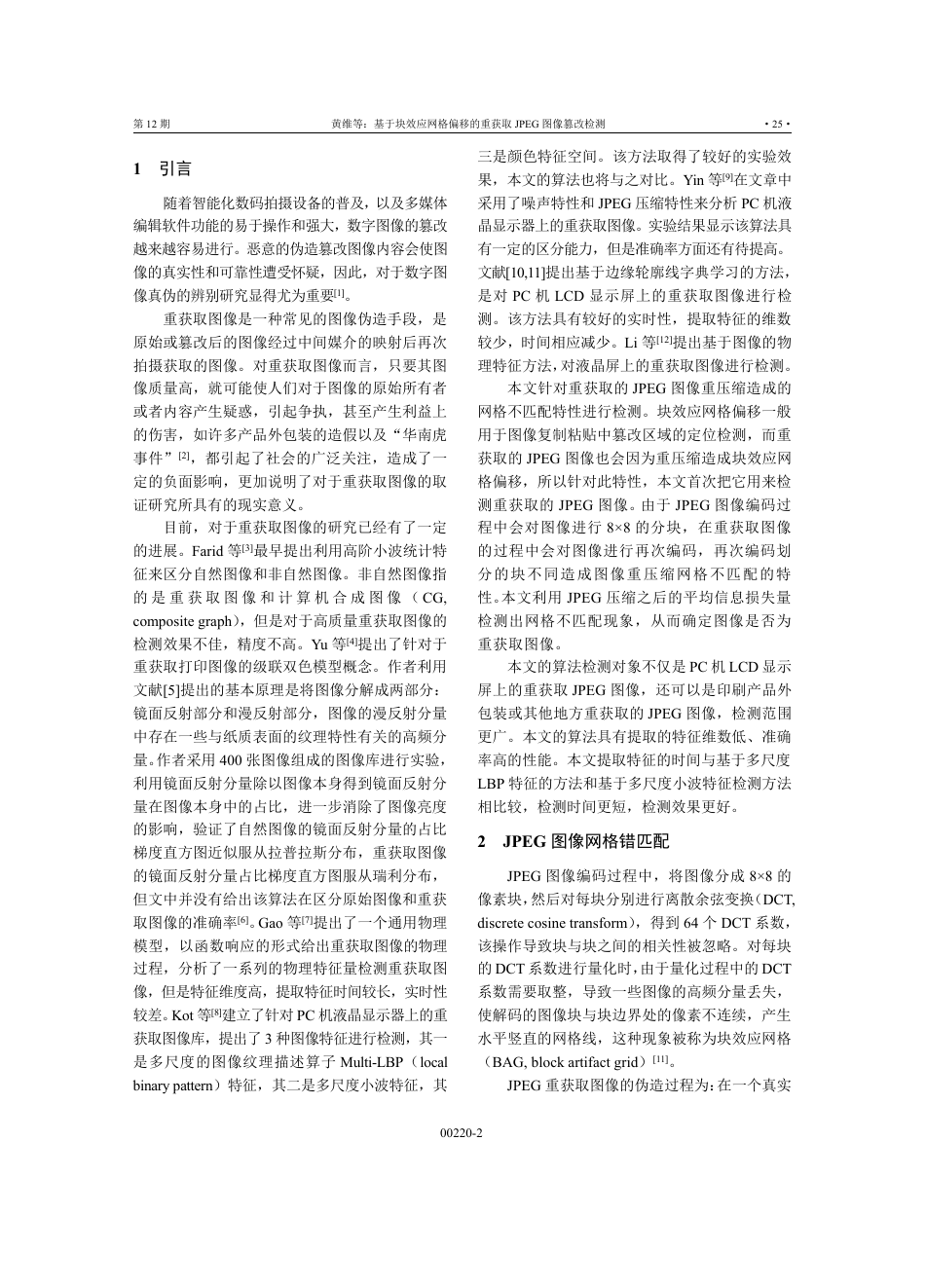

生了 BAG 错匹配现象。如图 2 所示,由于重压

缩的分块不一致,造成了 BAG 网格偏移现象。

图 2 JPEG 重压缩 BAG 错匹配

3 检测算法

本文算法利用平均信息损失量估计 JPEG 重

图 3 检测算法流程

3.1 预处理

提取待检测图像压缩质量因子 q,将待检测

图像剪切掉 m 行 n 列(0≤m≤7, 0≤n≤7),然后

将剪切后的图像以质量因子 q 进行再次压缩。

3.2 平均信息损失量

本文利用平均信息损失量[14]来估计 JPEG 重

压缩 BAG 网格偏移。JPEG 压缩先将图像分为

8×8 的不重叠的块,利用离散余弦变换,得到每

块的 DCT 系数,然后将 DCT 系数进行量化,量

化阶段的 DCT 系数四舍五入取整会导致高频分

量丢失。为了估计这些丢失的信息量,定义了平

均信息损失量 Avg_Loss。

一幅图像分成 N 个 8×8 的不重叠块,每个块

经过 DCT 变换生成 64 个 DCT 系数,每个系数所

在的位置用(i, j)表示,量化之后的 DCT 系数用

00220-3

�

第 12 期

黄维等:基于块效应网格偏移的重获取 JPEG 图像篡改检测

·27·

Q_DCT 表示,则 Q_DCT(i, j)(0≤i≤7,0≤j≤7)

表示块的第 i 行第 j 列的量化 DCT 系数。N 个块

中于(i, j)位置上的 Q_DCT 值为 0 的个数总和用

n_Q_DCT(i, j)表示,则 JPEG 图像 N 个块于(i, j)

位置上的信息损失量 Loss(i, j)表示如下。

n Q DCT i

_

j

( , )

_

j

i

=

N

, 0

7,0

j

( , )

Loss i

≤ ≤ ≤ ≤

7

(1)

一幅图像有 N 个块,每个块有 64 个量化的

DCT 系数,对每个位置计算其 DCT 系数为 0 的

个数,产生 64 个信息损失量 Loss(i, j),对这 64

个信息损失量求取平均值,即该图像的平均信息

损失量,如式(2)所示。

8

∑

j

1

==

i

,

Avg L ss

o

_

Loss i

j

( , )

0

≤ ≤ ≤ ≤

7,0

i

64

7

j

(2)

在压缩过程中,图像的质量因子 q 越大,所

对应的 DCT 量化表的值越小,量化处理的 DCT

系数为 0 的个数越少,图像的平均信息损失量就

会随之减小。

3.3 对齐与非对齐压缩

一 幅 图 像 经 过 质 量 因 子 为 QF1 的 第 一 次

JPEG 压缩,该图像的平均信息损失量用 Loss_QF1

表示。该图像重获取过程中经历再次 JPEG 压缩,

为使重获取的图像尽可能真实,压缩的质量因子

QF2 会尽可能大,使重获取图像的质量尽可能高。

图像的压缩质量因子越大,其平均信息损失量就

会越小。而重获取图像由于网格线与原图像有偏

移,其再次压缩过程所经历的是非对齐压缩,此

时平均信息损失量用 Loss_QF2 表示。当质量因子

QF2 大于 QF1,图像以 QF2 或 QF1 的质量因子压

缩时,质量因子 QF2 所对应的量化表的值比 QF1

所对应的量化表的值小,量化后 DCT 系数为 0 的

个数越少,图像的平均信息损失量就会越小,所

以 Loss_QF2 小于 Loss_QF1。

重获取图像的网格线非对齐,假设网格线的

偏移量是 m 行 n 列,那么可以对图像进行剪切,

将图像剪切 m 行 n 列(0≤m≤7,0≤n≤7),使

图像的网格线与原始图像网格线对齐,之后再对

图像进行质量因子为 QF2 的压缩,则图像此次经

历的压缩就是对齐压缩。在对齐压缩的过程中,

图像的平均信息损失量就会接近于第一次 JPEG

压缩引起的图像平均信息损失量 Loss_QF1,而非

对齐压缩的过程中,图像的平均信息损失量就会

接近于再次 JPEG 压缩引起的图像平均信息损失

量 Loss_QF2。

定义一幅图像 I,剪切 m 行 n 列后的图像为

I(m, n)。该图像经历第一次 JPEG 压缩后的图像为

I1,定义为

I

1

(3)

经历第二次 JPEG 压缩后的图像为 I2,定义为

(4)

那么,剪切 m 行 n 列后的图像 I2(m, n)经历与

F compressed QF I

2(

1

F compressed QF I

1 )

(

=

=

_

_

_

_

I

)

2

第二次质量因子一样的 JPEG 压缩后定义为

)

(

=

I m n

,

2

F compressed QF I

(

2

(5)

此时,将剪切 m 行 n 列后的图像的平均信息

_

_

)

2

损失量 Avg_Loss_I2(m, n)定义为

∑

j

1

==

Avg Loss

I m n

,

2

_

_

(

)

8

i

,

64

7

≤ ≤ ≤ ≤

,0

m

n

7

Loss

_

I

2

i

j

( , )

(6)

0

3.4 检测峰值点

由于DCT 变换过程是将图像分成8×8 不重叠

的块。所以剪切的 m 行 n 列的数值范围为[0,7]。

提取的剪切图像平均信息损失量 Avg_Loss_I2(m, n)

特征是一个 8×8 的矩阵,有 64 个特征值,每个特

征值所在的位置(m, n)代表了经过剪切 m 行 n 列

后的每幅图像,该位置的特征值代表剪切后的该

幅图像的平均信息损失量。

(

_

_

Avg Loss

a

12

a

22

a

32

a

42

a

52

a

62

a

72

a

82

m

a

11

a

21

a

31

a

41

a

51

a

61

a

71

a

81

0

≤ ≤ ≤ ≤

I m n

, )

2

a

a

14

13

a

a

23

24

a

a

34

33

a

a

44

43

a

a

54

53

a

a

64

63

a

a

74

73

a

a

84

83

n

8,0

=

a

16

a

26

a

36

a

46

a

56

a

66

a

76

a

86

a

17

a

27

a

37

a

47

a

57

a

67

a

77

a

87

a

18

a

28

a

38

a

48

a

a

68

a

78

a

88

58

a

15

a

25

a

35

a

45

a

55

a

65

a

75

a

85

8

(7)

00220-4

�

·28·

网络与信息安全学报

第 3 卷

图像平均信息损失量 Avg_Loss_I2(m, n)的 64

个特征值中,如果在(0,0)位置上出现峰值点,代

表这幅图像不需要剪切行列就可以与原始图像的

分块网格对齐,代表该图像再次以 QF2 的质量因

子压缩是对齐压缩,即图像为未经篡改的原始图

像。如果在(2, 3)位置上出现峰值点,代表这幅图

像在剪切 2 行 3 列之后与原始图像的分块网格对

齐,剪切之后以 QF2 的质量因子压缩才是对齐压

缩,即图像的 BAG 网格发生了 2 行 3 列的偏移。

而未出现峰值的其他位置上的特征值,由于原始

图像偏移 m1 行 n1 列与剪切 m 行 n 列之后的图像

是分块网格还是没有对齐的,剪切之后的图像再

次以 QF2 的质量因子压缩时经历的还是非对齐

压缩,所以特征值小于对齐压缩后的图像。

本文利用该特性来检测一幅图像是否为重获

取图像。原始图像的 BAG 网格不会发生偏移,

不需要剪切行列使分块网格对齐,所以以质量因

子 QF2 再次压缩会在(0, 0)位置处出现峰值。而重

获取的图像由于在重获取的过程中会引入或多或

少的与原始图像无关的背景信息,因此在以 JPEG

压缩时,图像的分块网格与原始图像的分块网格

非 对 齐 , 重 获 取 图 像 的 64 平 均 信 息 损 失 量

Avg_Loss_I2(m, n)特征值的峰值点不会出现在(0,

0)位置处。

4 实验分析

实 验 运 行 环 境 计 算 机 配 置 为 Intel Core i5-

4590 CPU 3.30 GHz、8 GB 内存、Windows 7 系

统,使用 Matlab R2014b 的平台进行算法的实现,

利用 Photoshop 软件对重获取图像进行进一步处

理。本文用来进行实验的非压缩图像来自 McGill

Calibrated Colour

Image Database[15] , 选 取

Flowers 、Animals 、Fruits 、Textures 、Winter 、

Shadows 这 6 个文件夹下的图像,每个文件夹选

取 30 张图像,选取 Landscapes 与 Foliage 文件夹

下每个文件夹 10 张图像,共计 200 幅图像。重获

取的图像来自于自己拍摄的图像,自己拍摄的图

像使用 Canon EOS 6D 和 MX5 设备拍摄,重获取

图像分辨率为 512×512。随机选取非压缩的原始

图像 200 幅,首先将每幅图像以质量因子 QF1 压缩

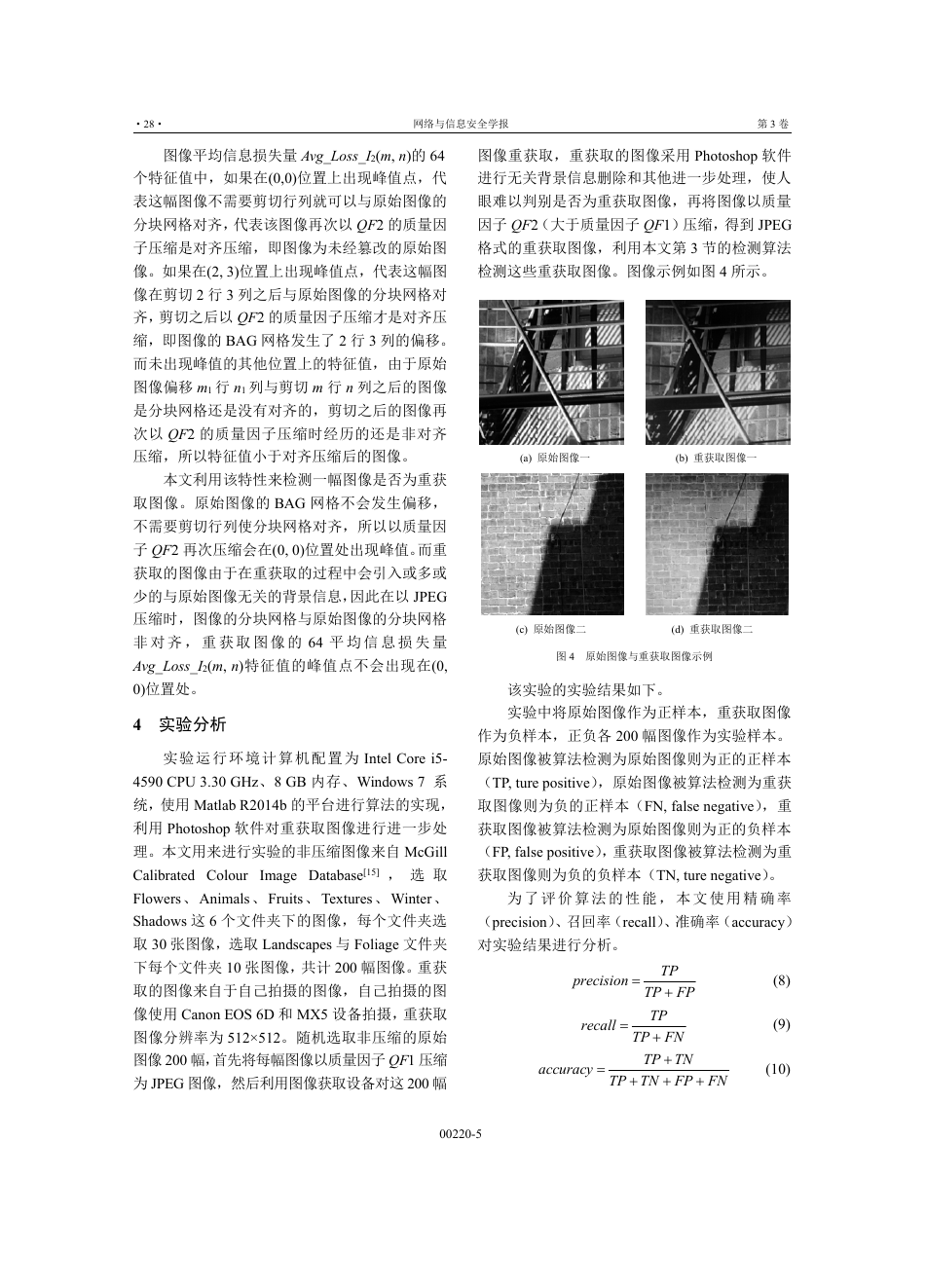

为 JPEG 图像,然后利用图像获取设备对这 200 幅

图像重获取,重获取的图像采用 Photoshop 软件

进行无关背景信息删除和其他进一步处理,使人

眼难以判别是否为重获取图像,再将图像以质量

因子 QF2(大于质量因子 QF1)压缩,得到 JPEG

格式的重获取图像,利用本文第 3 节的检测算法

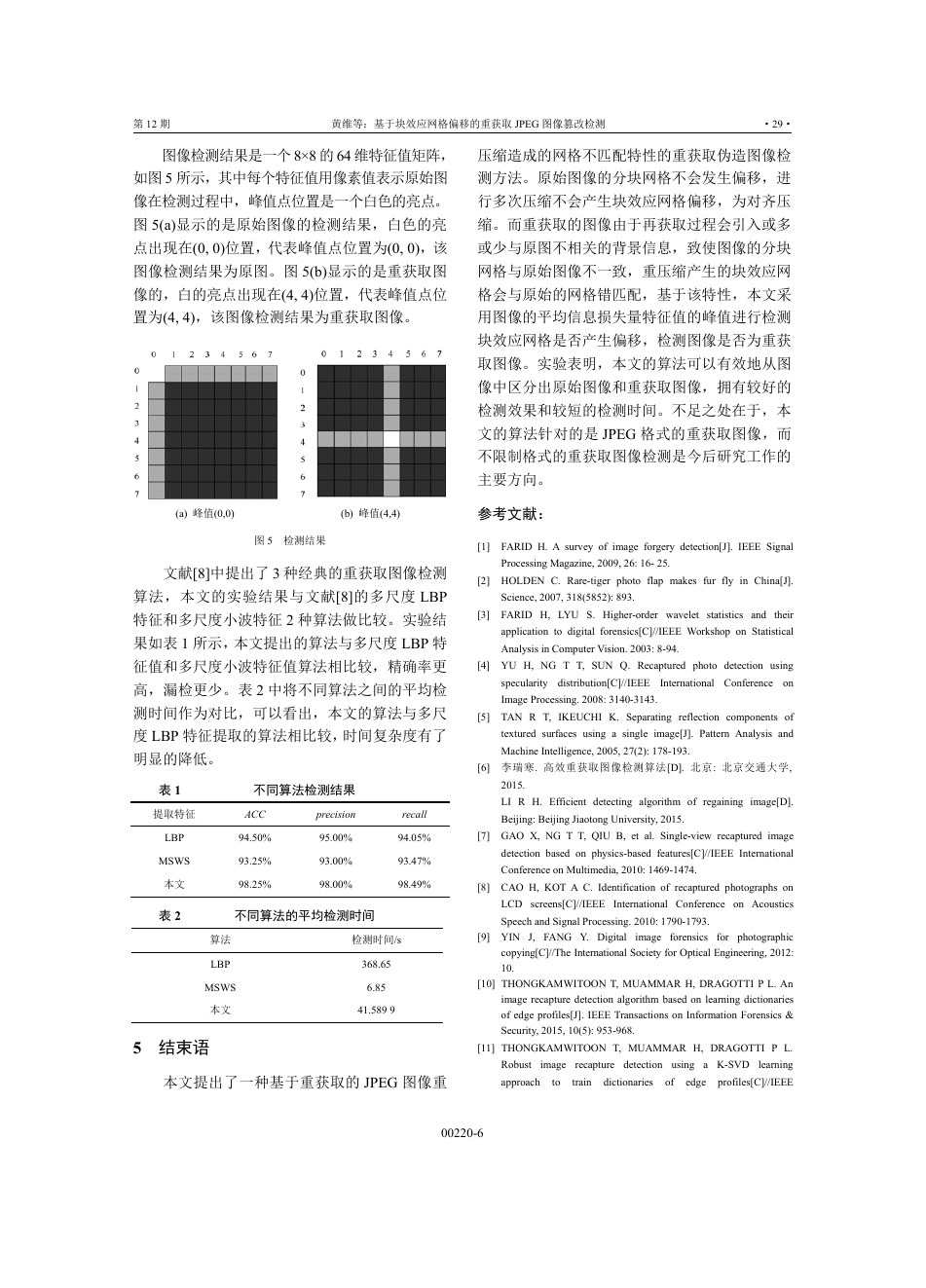

检测这些重获取图像。图像示例如图 4 所示。

(a) 原始图像一

(b) 重获取图像一

(c) 原始图像二

(d) 重获取图像二

图 4 原始图像与重获取图像示例

该实验的实验结果如下。

实验中将原始图像作为正样本,重获取图像

作为负样本,正负各 200 幅图像作为实验样本。

原始图像被算法检测为原始图像则为正的正样本

(TP, ture positive),原始图像被算法检测为重获

取图像则为负的正样本(FN, false negative),重

获取图像被算法检测为原始图像则为正的负样本

(FP, false positive),重获取图像被算法检测为重

获取图像则为负的负样本(TN, ture negative)。

为 了 评 价 算 法 的 性 能 , 本 文 使 用 精 确 率

(precision)、召回率(recall)、准确率(accuracy)

对实验结果进行分析。

precision

recall

=

=

TP

TP FP

+

TP

TP FN

+

TP TN

+

+

accuracy

=

TP TN FP FN

+

+

(8)

(9)

(10)

00220-5

�

第 12 期

黄维等:基于块效应网格偏移的重获取 JPEG 图像篡改检测

·29·

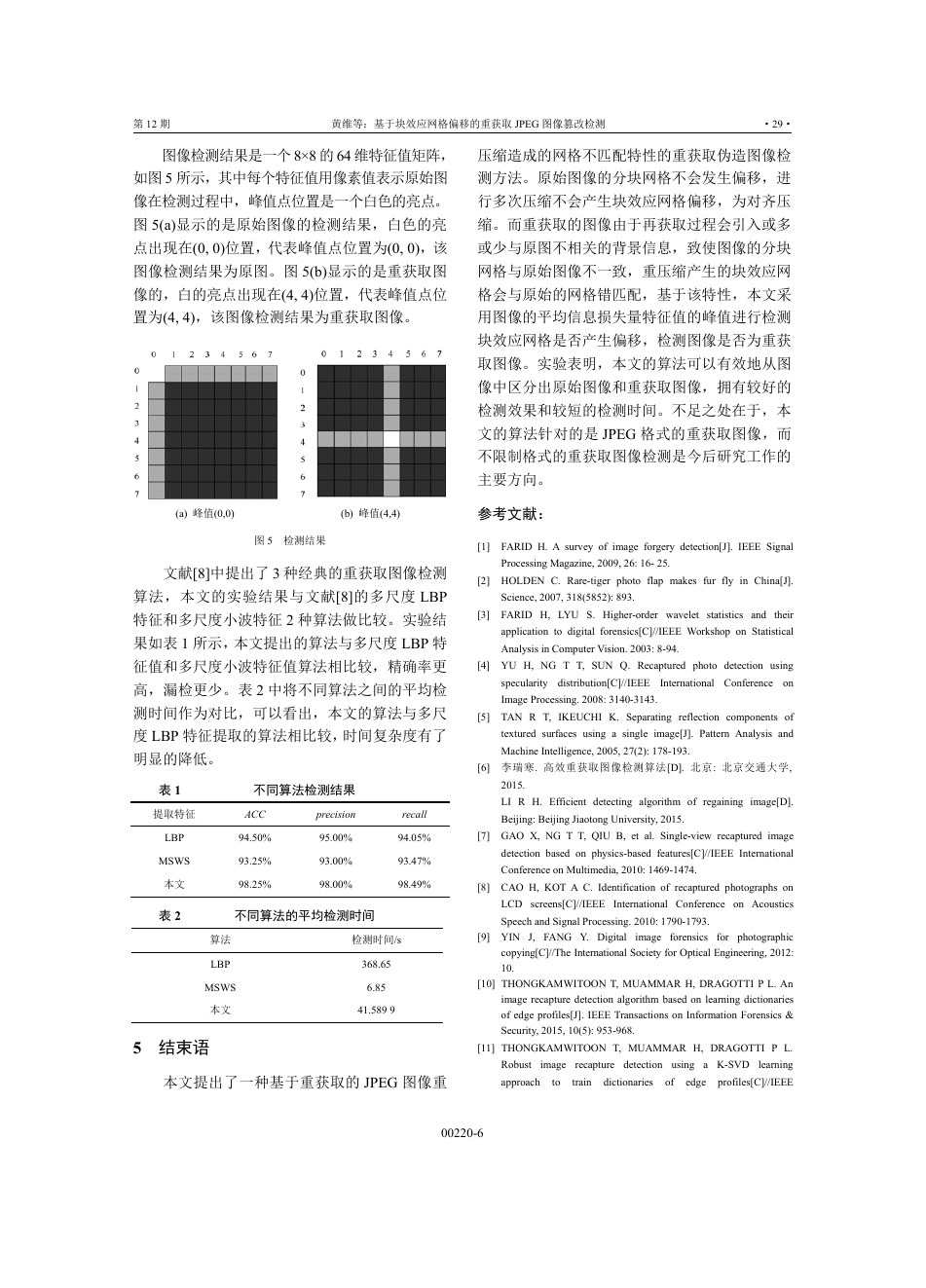

图像检测结果是一个 8×8 的 64 维特征值矩阵,

如图 5 所示,其中每个特征值用像素值表示原始图

像在检测过程中,峰值点位置是一个白色的亮点。

图 5(a)显示的是原始图像的检测结果,白色的亮

点出现在(0, 0)位置,代表峰值点位置为(0, 0),该

图像检测结果为原图。图 5(b)显示的是重获取图

像的,白的亮点出现在(4, 4)位置,代表峰值点位

置为(4, 4),该图像检测结果为重获取图像。

(a) 峰值(0,0)

(b) 峰值(4,4)

图 5 检测结果

文献[8]中提出了 3 种经典的重获取图像检测

算法,本文的实验结果与文献[8]的多尺度 LBP

特征和多尺度小波特征 2 种算法做比较。实验结

果如表 1 所示,本文提出的算法与多尺度 LBP 特

征值和多尺度小波特征值算法相比较,精确率更

高,漏检更少。表 2 中将不同算法之间的平均检

测时间作为对比,可以看出,本文的算法与多尺

度 LBP 特征提取的算法相比较,时间复杂度有了

明显的降低。

表 1

提取特征

LBP

MSWS

本文

表 2

不同算法检测结果

ACC

94.50%

93.25%

98.25%

precision

95.00%

93.00%

98.00%

recall

94.05%

93.47%

98.49%

不同算法的平均检测时间

算法

LBP

MSWS

本文

5 结束语

检测时间/s

368.65

6.85

41.589 9

本文提出了一种基于重获取的 JPEG 图像重

压缩造成的网格不匹配特性的重获取伪造图像检

测方法。原始图像的分块网格不会发生偏移,进

行多次压缩不会产生块效应网格偏移,为对齐压

缩。而重获取的图像由于再获取过程会引入或多

或少与原图不相关的背景信息,致使图像的分块

网格与原始图像不一致,重压缩产生的块效应网

格会与原始的网格错匹配,基于该特性,本文采

用图像的平均信息损失量特征值的峰值进行检测

块效应网格是否产生偏移,检测图像是否为重获

取图像。实验表明,本文的算法可以有效地从图

像中区分出原始图像和重获取图像,拥有较好的

检测效果和较短的检测时间。不足之处在于,本

文的算法针对的是 JPEG 格式的重获取图像,而

不限制格式的重获取图像检测是今后研究工作的

主要方向。

参考文献:

[1] FARID H. A survey of image forgery detection[J]. IEEE Signal

Processing Magazine, 2009, 26: 16- 25.

[2] HOLDEN C. Rare-tiger photo flap makes fur fly in China[J].

Science, 2007, 318(5852): 893.

[3] FARID H, LYU S. Higher-order wavelet statistics and their

application to digital forensics[C]//IEEE Workshop on Statistical

Analysis in Computer Vision. 2003: 8-94.

[4] YU H, NG T T, SUN Q. Recaptured photo detection using

specularity distribution[C]//IEEE International Conference on

Image Processing. 2008: 3140-3143.

[5] TAN R T, IKEUCHI K. Separating reflection components of

textured surfaces using a single image[J]. Pattern Analysis and

Machine Intelligence, 2005, 27(2): 178-193.

[6] 李瑞寒. 高效重获取图像检测算法[D]. 北京: 北京交通大学,

2015.

LI R H. Efficient detecting algorithm of regaining image[D].

Beijing: Beijing Jiaotong University, 2015.

[7] GAO X, NG T T, QIU B, et al. Single-view recaptured image

detection based on physics-based features[C]//IEEE International

Conference on Multimedia, 2010: 1469-1474.

[8] CAO H, KOT A C. Identification of recaptured photographs on

LCD screens[C]//IEEE International Conference on Acoustics

Speech and Signal Processing. 2010: 1790-1793.

image forensics

for photographic

copying[C]//The International Society for Optical Engineering, 2012:

10.

[9] YIN J, FANG Y. Digital

[10] THONGKAMWITOON T, MUAMMAR H, DRAGOTTI P L. An

image recapture detection algorithm based on learning dictionaries

of edge profiles[J]. IEEE Transactions on Information Forensics &

Security, 2015, 10(5): 953-968.

[11] THONGKAMWITOON T, MUAMMAR H, DRAGOTTI P L.

image recapture detection using a K-SVD learning

profiles[C]//IEEE

Robust

approach

dictionaries

of

edge

to

train

00220-6

�

·30·

网络与信息安全学报

第 3 卷

黄添强(1971-),男,福建莆田人,

博士,福建师范大学教授,主要研究方

向为机器学习、数字多媒体取证。

张雪莉(1993-),女,河南正阳人,

福建师范大学硕士生,主要研究方向为

信息安全、数字多媒体取证。

肖辉(1991-),男,福建南平人,

福建师范大学硕士生,主要研究方向为

信息安全、视频目标跟踪。

International Conference on Image Processing. 2014:5317-5321.

[12] LI R, NI R, ZHAO Y. An effective detection method based on

physical

recaptured images on LCD screens[M]//

Digital-Forensics and Watermarking. Berlin: Springer International

Publishing, 2015.

traits of

[13] 赵洁, 郭继昌, 张艳, 等. JPEG 图像双重压缩偏移量估计的篡改

区 域 自 动 检 测 定 位 [J]. 中 国 图 象 图 形 学 报 , 2015, 20(10):

1304-1312.

ZHAO J, GUO J C, ZHANG Y, et al. Automatic detection

positioning in area of double compression offset estimation of

JPEG[J]. Journal of Image and Graphic, 2015, 20(10): 1304-1312.

[14] WU L, KONG X. Image tampering localization via estimating the

International

JPEG compression[J]. The

non-aligned double

Society for Optical Engineering, 2013, 8665.

[15] McGill calibrated color Image database[EB/OL]. http://tabby.vision.

mcgill.ca/.

作者简介:

黄维(1994-),女,福建莆田人,

福建师范大学硕士生,主要研究方向为

信息安全、数字多媒体取证。

00220-7

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc