中国科技论文在线

http://www.paper.edu.cn

基于 transformer 的端到端中文语音合成

张宇强1,刘刚2**

(1. 北京邮电大学模式识别实验室,北京 100876;

2. 北京邮电大学模式识别实验室,北京 100876)

摘要:语音合成是人机交互关键部分,有很高的研究价值和应用价值。传统的语音合成系统

需要多个组件如:文本前端、声学模型、声码器后端,基于注意力的端到端模型直接建模原

始文本和声学特征的映射关系。本文将研究基于 transformer 的端到端模型在语音合成中的

应用,并基于语音合成任务的特性对基线模型作出改进,研究发现语音合成对编码器结构和

注意力机制的要求很高,尤其是对齐的单调性尤为重要,因此本文对编码器结构和注意力机

制进行了改进,引入相对位置编码和混合注意力机制,并通过手工预测停止符克服了 stop

token 模型预测不稳定。最终得到的语音梅尔倒谱失真小、对齐稳定性高,出现跳字、重复

的现象明显减少,整体效果稳定。

关键词:语音合成;混合注意力机制;位置编码

中图分类号:TP391.3

5

10

15

Transformer-based end-to-end Chinese speech synthesis

20

(1. Beijing University of Posts and Telecommunications Pattern Recognition laboratory,Beijing

Zhang Yuqiang1, Liu Gang2

100876;

2. Beijing University of Posts and Telecommunications Pattern Recognition laboratory,Beijing

100876)

Abstract:Speech synthesis is a key part of human-computer interaction and has high research and

application value. Traditional speech synthesis systems require multiple components such as: text front

end, acoustic model, and vocoder back end. The end-to-end model based on attention directly models

the mapping relationship between the original text and the acoustic features. This article will study the

application of the end-to-end model based on transformer in speech synthesis, and improve the baseline

model based on the characteristics of the speech synthesis task. The research finds that speech synthesis

has high requirements for the encoder structure and attention mechanism, especially alignment The

monotonicity is especially important, so this paper improves the encoder structure and attention

mechanism, introduces relative position encoding and mixed attention mechanism, and overcomes the

prediction instability of the stop token model by manually predicting stop characters. The resulting

speech Mel has low cepstrum distortion and high alignment stability, and the phenomenon of word

skipping and repetition is significantly reduced, and the overall effect is stable.

Keywords: text to speech; hybrid attention mechanism; position embedding

25

30

35

0 引言

40

语音合成(TTS,text to speech)是将文本信息转换为语音的过程,语音合成对人机交

互有着重要的意义。一直受到学术界和工业界的极大关注,从单元挑选与波形拼接合成到参

数合成,到现在发展迅速的端到端语音合成。

单元挑选

[1]

与波形拼接语音合成方法首先按照一定的单元的挑选规则从录制好的音库

中挑选最优单元,然后利用单元调整算法对选中单元做适当调整,最后将其拼接得到合成语

45

音。由于最终合成的语音是用原始录音中挑选的单元拼接合成的,所以合成语音保持了原发

作者简介:张宇强(1994-),男,硕士,研究方向:数据挖掘与信息检索

通信联系人:刘刚(1973-),男,副教授,主要研究方向:信息检索、语音识别. E-mail: liugang@bupt.edu.cn

- 1 -

�

中国科技论文在线

http://www.paper.edu.cn

音人的发音风格,但是音库的设计和制造是一个复杂的工作,并且对音库的大小、音质有着

很高的要求,合成的单元风格单一,因此很难满足要求。

随着神经网络的发展,DNN(Deep Neural Networks)被引入用作声学参数建模

[2]

,模

型采用输出预测的声学参数和当前帧的真实声学参数的均方误差作为损失函数,在 DNN 的

50

训练和预测时,难以捕捉到长时范围内的文本相关性。由于不受上下文音素的影响,前向网

络的预测是受到限制的。递归神经网络(RNN,Recurrent Neural Network)是序列上前向网

络的简单扩展,其输入来源于外界输入和网络自身的状态。根据递归神经网络的这一特性,

通过递归神经网络得到的声学特征参数精度有了很大的提升。虽然各种神经网络对声学特征

参数精度都有了较大的提升,但参数合成均需要采用多个组件如音素持续时间模型和声学模

55

型,会导致这两个模型优化方法不一致,并且生成的声学参数过平滑现象,语音合成质量较

差。

近几年来,端到端的结构在语音识别、机器翻译等领域快速发展,并且效果都要优于传

统模 型。在语音 合成领域, 也出现了许 多的端到端 模型如 tacotron[3] 、char2wav[4] 、

tacotron2[5]、deepvoice3[6]、transformer[7]、fastspeech[8]等模型。这种端到端模型主要由

编码器、注意力机制和解码器组成,直接对文本和语音声学特征建模,可省去复杂的文本前

60

端,同时编码器和解码器联合优化,不需要多个模型单独训练,最后得到的音质很好。

本文将选择 transformer 端到端模型作为基线模型进行中文语音合成实验,主要因为

transformer 模型可直接建立长时依赖,进行快速训练,但依然存在问题,模型的设计没考虑

到语音合成的特性,还有许多可改进的空间。

65

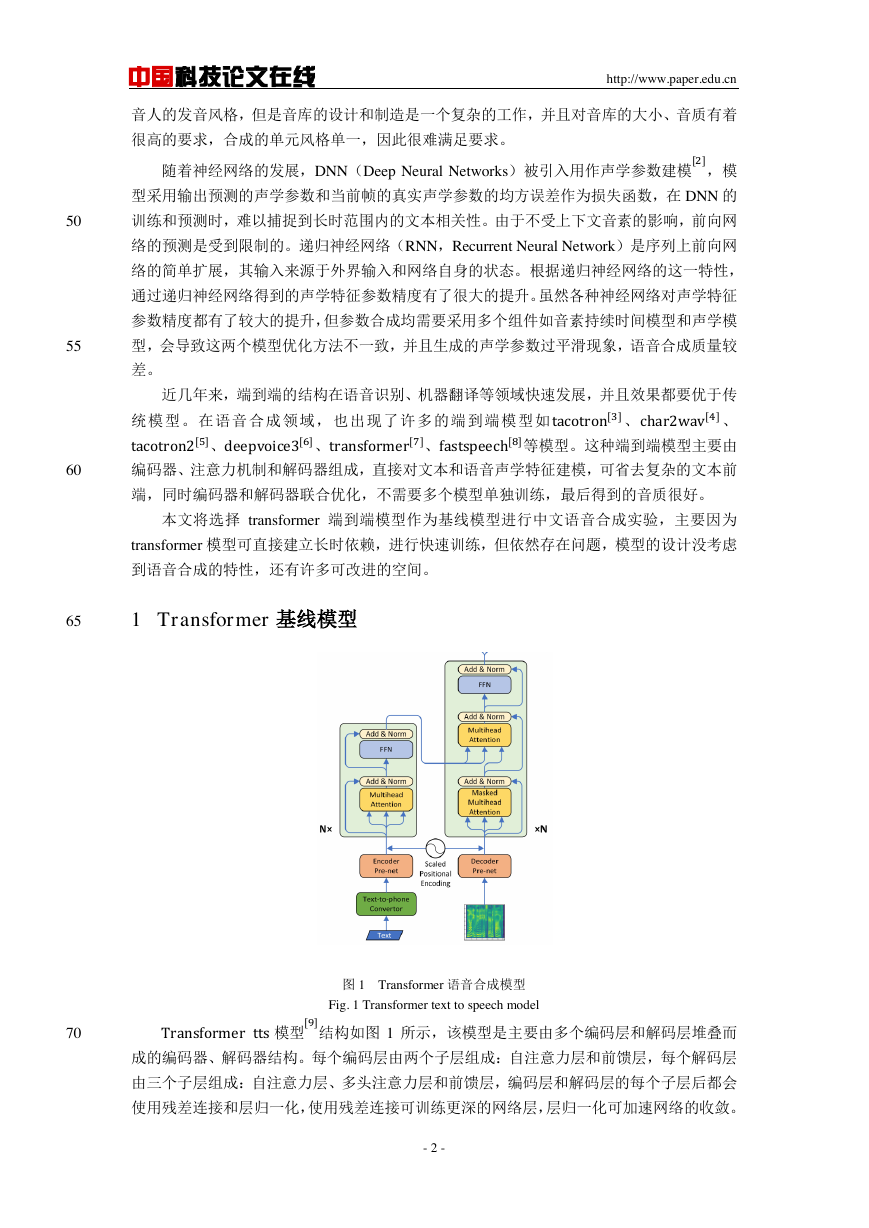

1 Transformer 基线模型

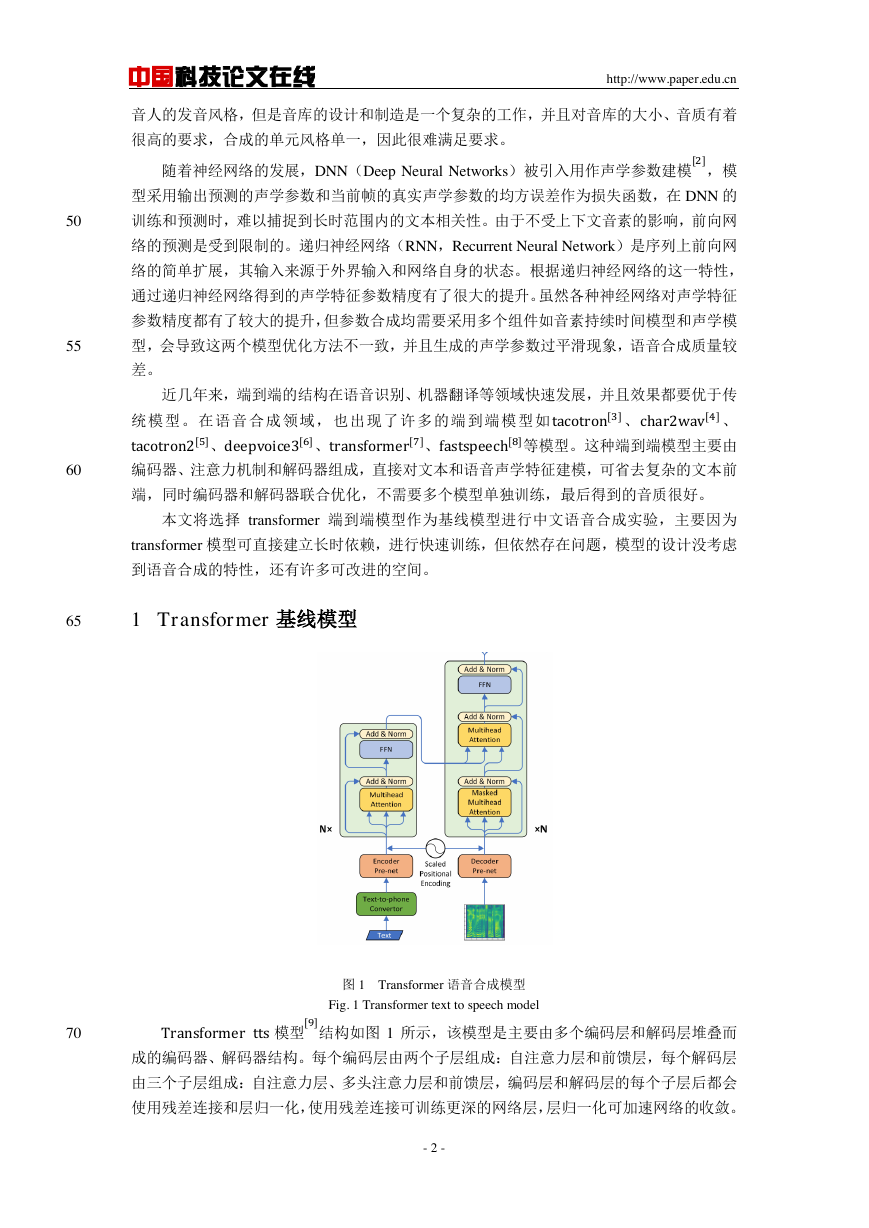

图 1 Transformer 语音合成模型

Fig. 1 Transformer text to speech model

70

Transformer tts 模型

[9]

结构如图 1 所示,该模型是主要由多个编码层和解码层堆叠而

成的编码器、解码器结构。每个编码层由两个子层组成:自注意力层和前馈层,每个解码层

由三个子层组成:自注意力层、多头注意力层和前馈层,编码层和解码层的每个子层后都会

使用残差连接和层归一化,使用残差连接可训练更深的网络层,层归一化可加速网络的收敛。

- 2 -

�

中国科技论文在线

http://www.paper.edu.cn

解码层的自注意力层和编码层的自注意力层不同之处在于解码层的自注意力层依然是一个

75

递归的思想,因此需要掩盖掉未来时刻的信息,防止信息泄露,而编码层的自注意力层可看

到整个序列。

本文将基于 transformer 模型进行中文语音合成实验,认为可能模型存在以下问题:

首先,由于自注意力层的存在会导致不同位置的相同信息学习到的表示是相同的,该模

型解决这一方法是使用固定不训练的绝对位置编码将内容编码和位置编码融合来缓解这一

80

问题,但依然存在问题,语音合成任务无论是对音素编码和语音帧表示都是需要建立局部依

赖的,因此需要使用更合适的相对位置编码。

接着,端到端语音合成是自回归的预测任务,对合成对齐的单调连续性有严格的要求。

Transformer 模型即使实现了并行化训练,但损失了加入对齐连续性的限制,因此需要更稳

定的注意力机制。

85

因此本文进行了以下几方面的工作:

(1)引入相对位置编码

[10]

,缓解固定位置编码所带来的局限性,这种相对位置编码符

合语音合成的特性。

(2)Transformer 模型的注意力机制不符合语音合成的特性,使用混合注意力机制提高

来提高模型的稳定性,减少跳字、重复的现象。

90

1.1 相对位置编码

自注意力层会使用多个头注意力,然后通过将多个头的表示拼接起来形成最终表示。每

一 个 注 意 力 头 处 理 输 入 序 列 x = (x1, … , xn), xi ∈ Rdx , 然 后 计 算 一 个 新 的 表 示 序 列 z =

(z1, … , zn), zi ∈ Rdz。

每一个输入表示zi可由xi和其他位置的输入相关性来表示,如下:

95

100

105

n

zi = ∑ αij(xj

WV)

j=1

每一个权重系数αij经过 softmax 归一化得到:

exp eij

αij =

n

∑

k=1

exp eik

而eij是基于点乘的方式计算与其他的位置的相关性得到:

eij =

(xiWQ)(xjWK)T

√dz

把输入序列的相关表示看作一个n × n有向图,则相对位置表示为αK ∈ Rn×n×dk 和αV ∈

Rn×n×dv 。 若 输 入 距 离 长 度 为 12 , 最 大 截 断 距 离 k 为 4 , 则 n × n 矩 阵 第 一 行 为

[4,5,6,7,8,8,8,8,8,8,8,8],最后一行为[0,0,0,0,0,0,0,0,1,2,3,4],查表即可得任意两个元素之间的

V,将计算eij和zi的公式延伸如下。如两个元素之间的距离绝对值大于等

相对位置表示αij

于 k,则以最大距离的相对位置编码为准这个相对位置表示,并且在同层的多个头之间共享。

K和αij

n

V)

zi = ∑ αij(xjWV + αij

eij =

j=1

(xiWQ)(xjwK + αij

K)T

√dz

- 3 -

�

中国科技论文在线

1.2 混合注意力机制

http://www.paper.edu.cn

Transformer 模型在解码层用基于掩码自注意力机制,隐式的完成了和 RNN 同样的工作,

110

并且使得模型可并行化训练,也导致模型无法利用之前时刻的对齐信息,在合成时稳定性较

差。混合注意力机制即是考虑到语音合成的连续性,引入前一时刻的注意力权重信息,使得

115

120

注意力权重不会产生突变,出现跳字的频率降低。

transformer 模型解码器时使用的是基于内容的注意力机制,计算相关性eij的时候使用的

是基于点乘的计算方式,下边首先对基于内容的注意力机制进行介绍:

eij = score(si, hj) = va

Ttanh (Wasi + Uahj)

其中,si为当前时刻解码器的隐状态,hj对应于编码器第 h 时刻的输出表示,va、Wa、

Ua是待训练参数。基于内容的注意力机制只会根据相关性去查询,而与位置无关,在语音

合成中会带来跳字的情况。

本文将使用 tacotron2 中使用到的混合注意力机制,下边将作介绍:

eij = score(si, hjαi−1, ) = va

Ttanh (Wsi + Vhj + Ufi,j)

其中,si为当前时刻解码器的隐状态,hj是编码器 h 时刻的输出表示,αi−1是上一时刻

解码的注意力权重,位置特性fi使用累加注意力权重cαi卷积而来:

fi = F ∗ cαi−1

i−1

cαi−1 = ∑ αj

j=1

125

通过累加注意力权重,可使得注意力权重网络了解到已经学习到的注意力信息,使得模

型能再序列中持续进行并且避免重复未预料的语音,符合语音合成的特性。

2 实验设置和结果分析

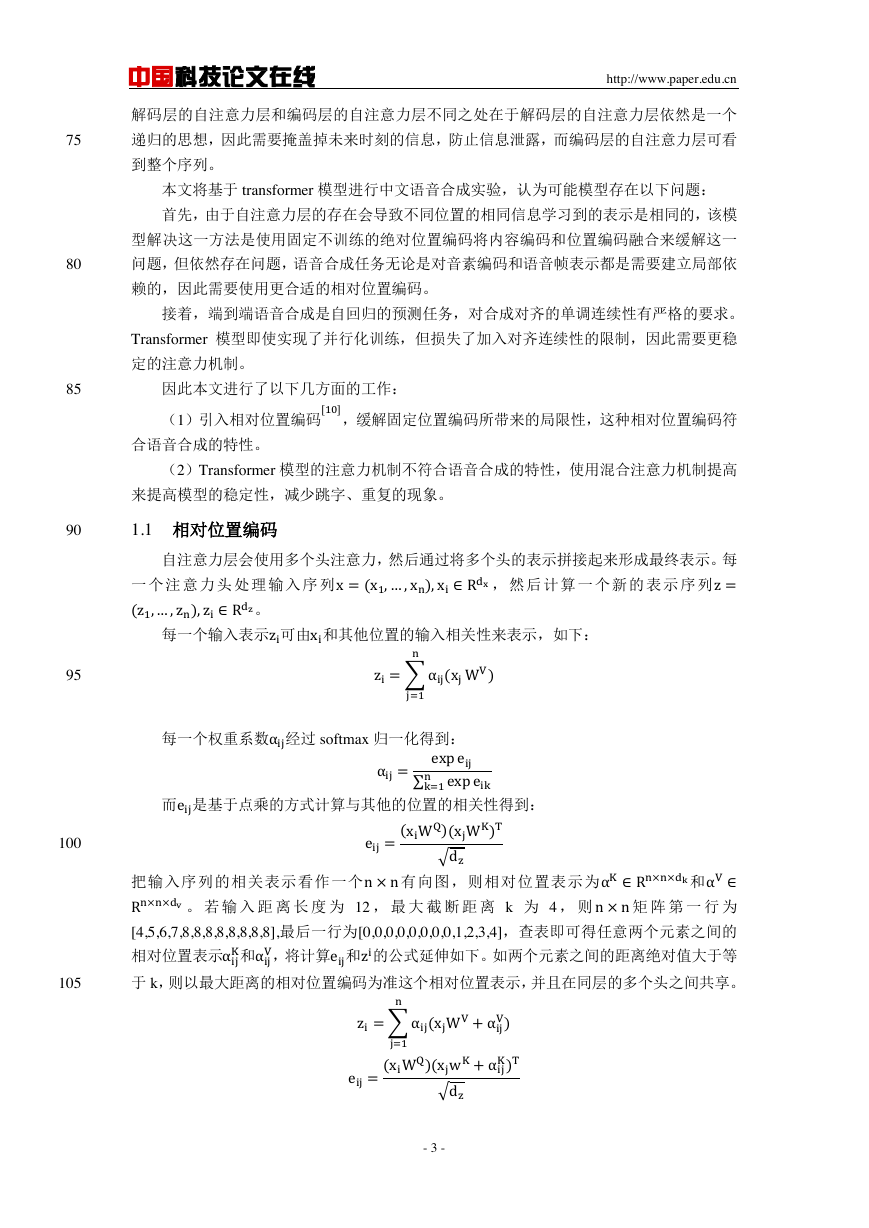

本文使用标贝 12 小时中文女生语音数据集,预训练解码器使用 thcoss 中文语音数据集,

声学模型预测使用 transformer 模型,声码器使用 griffin-lim 算法恢复语音信号。合成语音的

130

质量是计算和真实语音的梅尔倒谱失真度(MCD)的大小,上节提到的对注意力机制改善

的评价标准是跳字、重复的频率,其余两个评价标准是 MCD,MCD 越小代表失真度越小,

合成的语音质量越高。

本文基线模型参数设置为:embedding_dim=256,encoder_stcak=3,decoder_stack,multi-

heads=4,基线模型的表现如表 1 和表 2 所示:

135

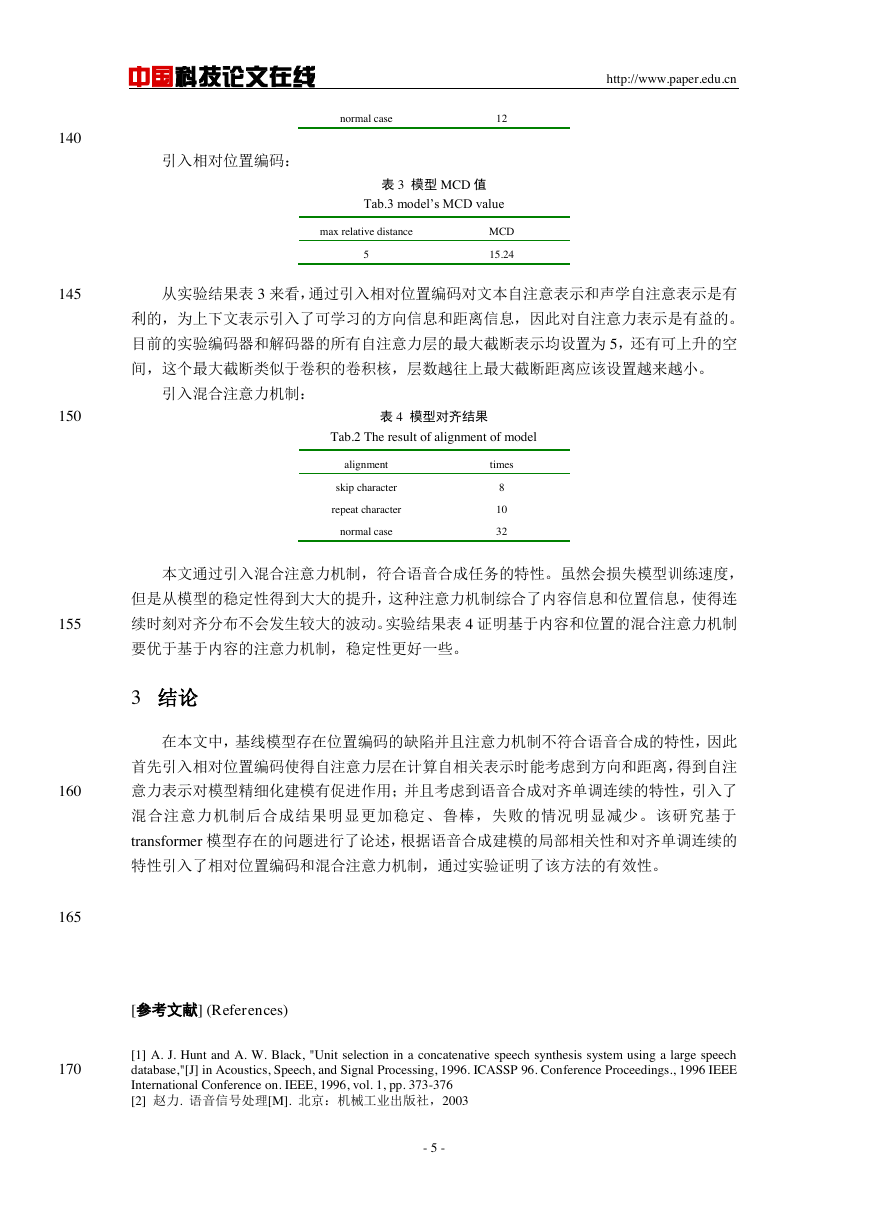

表 1 基线模型 MCD 值

Tab.1 Based model’s MCD value

Transformer

1-head

4-head

MCD

18.36

16.58

表 2 基线模型对齐结果

Tab.2 The result of alignment of based model

alignment

skip character

repeat character

times

12

26

- 4 -

�

中国科技论文在线

http://www.paper.edu.cn

引入相对位置编码:

normal case

12

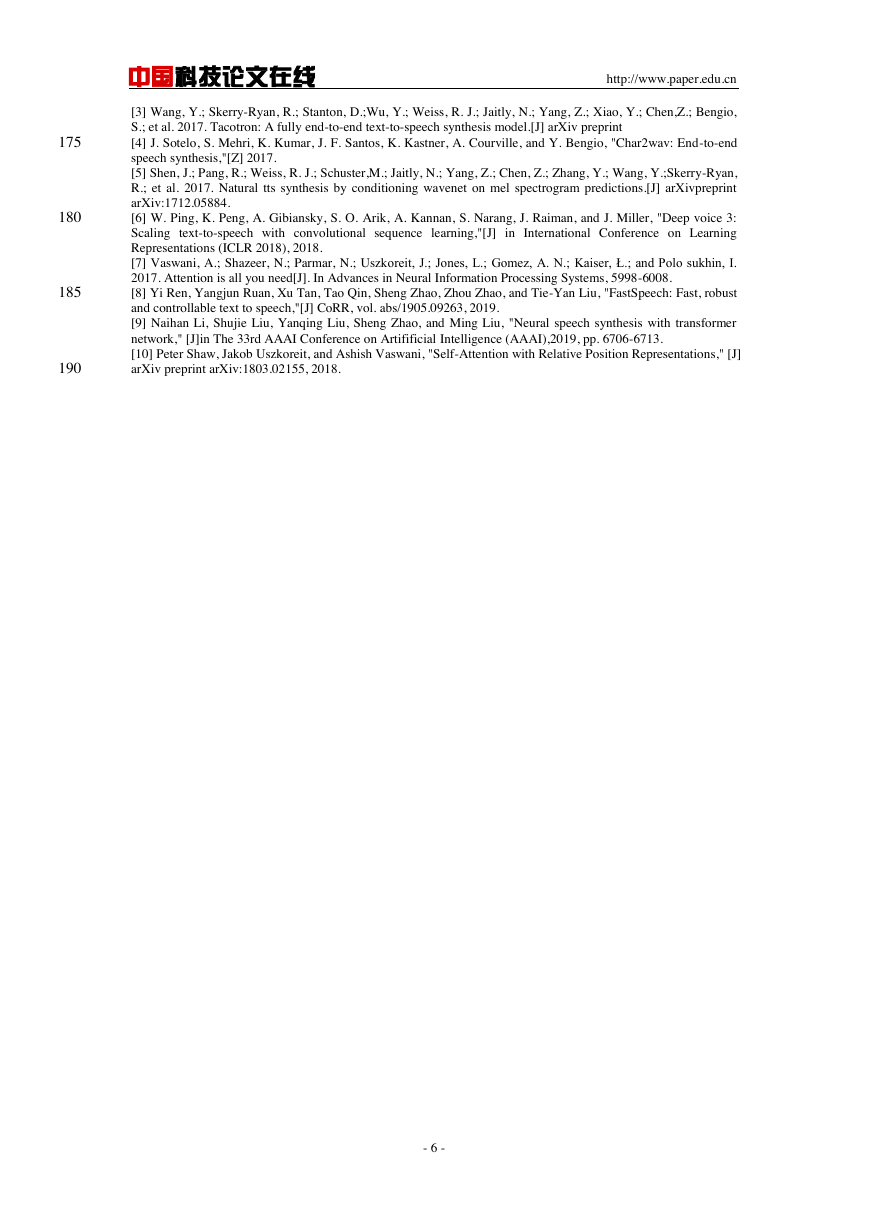

表 3 模型 MCD 值

Tab.3 model’s MCD value

max relative distance

5

MCD

15.24

140

145

从实验结果表 3 来看,通过引入相对位置编码对文本自注意表示和声学自注意表示是有

利的,为上下文表示引入了可学习的方向信息和距离信息,因此对自注意力表示是有益的。

目前的实验编码器和解码器的所有自注意力层的最大截断表示均设置为 5,还有可上升的空

间,这个最大截断类似于卷积的卷积核,层数越往上最大截断距离应该设置越来越小。

引入混合注意力机制:

150

表 4 模型对齐结果

Tab.2 The result of alignment of model

alignment

times

skip character

repeat character

normal case

8

10

32

本文通过引入混合注意力机制,符合语音合成任务的特性。虽然会损失模型训练速度,

但是从模型的稳定性得到大大的提升,这种注意力机制综合了内容信息和位置信息,使得连

155

续时刻对齐分布不会发生较大的波动。实验结果表 4 证明基于内容和位置的混合注意力机制

要优于基于内容的注意力机制,稳定性更好一些。

3 结论

在本文中,基线模型存在位置编码的缺陷并且注意力机制不符合语音合成的特性,因此

首先引入相对位置编码使得自注意力层在计算自相关表示时能考虑到方向和距离,得到自注

160

意力表示对模型精细化建模有促进作用;并且考虑到语音合成对齐单调连续的特性,引入了

混合注意力机制后合成结果明显更加稳定、鲁棒,失败的情况明显减少。该研究基于

transformer 模型存在的问题进行了论述,根据语音合成建模的局部相关性和对齐单调连续的

特性引入了相对位置编码和混合注意力机制,通过实验证明了该方法的有效性。

165

170

[参考文献] (References)

[1] A. J. Hunt and A. W. Black, "Unit selection in a concatenative speech synthesis system using a large speech

database,"[J] in Acoustics, Speech, and Signal Processing, 1996. ICASSP 96. Conference Proceedings., 1996 IEEE

International Conference on. IEEE, 1996, vol. 1, pp. 373-376

[2] 赵力. 语音信号处理[M]. 北京:机械工业出版社,2003

- 5 -

�

中国科技论文在线

http://www.paper.edu.cn

[3] Wang, Y.; Skerry-Ryan, R.; Stanton, D.;Wu, Y.; Weiss, R. J.; Jaitly, N.; Yang, Z.; Xiao, Y.; Chen,Z.; Bengio,

S.; et al. 2017. Tacotron: A fully end-to-end text-to-speech synthesis model.[J] arXiv preprint

[4] J. Sotelo, S. Mehri, K. Kumar, J. F. Santos, K. Kastner, A. Courville, and Y. Bengio, "Char2wav: End-to-end

speech synthesis,"[Z] 2017.

[5] Shen, J.; Pang, R.; Weiss, R. J.; Schuster,M.; Jaitly, N.; Yang, Z.; Chen, Z.; Zhang, Y.; Wang, Y.;Skerry-Ryan,

R.; et al. 2017. Natural tts synthesis by conditioning wavenet on mel spectrogram predictions.[J] arXivpreprint

arXiv:1712.05884.

[6] W. Ping, K. Peng, A. Gibiansky, S. O. Arik, A. Kannan, S. Narang, J. Raiman, and J. Miller, "Deep voice 3:

Scaling text-to-speech with convolutional sequence learning,"[J] in International Conference on Learning

Representations (ICLR 2018), 2018.

[7] Vaswani, A.; Shazeer, N.; Parmar, N.; Uszkoreit, J.; Jones, L.; Gomez, A. N.; Kaiser, Ł.; and Polo sukhin, I.

2017. Attention is all you need[J]. In Advances in Neural Information Processing Systems, 5998-6008.

[8] Yi Ren, Yangjun Ruan, Xu Tan, Tao Qin, Sheng Zhao, Zhou Zhao, and Tie-Yan Liu, "FastSpeech: Fast, robust

and controllable text to speech,"[J] CoRR, vol. abs/1905.09263, 2019.

[9] Naihan Li, Shujie Liu, Yanqing Liu, Sheng Zhao, and Ming Liu, "Neural speech synthesis with transformer

network," [J]in The 33rd AAAI Conference on Artifificial Intelligence (AAAI),2019, pp. 6706-6713.

[10] Peter Shaw, Jakob Uszkoreit, and Ashish Vaswani, "Self-Attention with Relative Position Representations," [J]

arXiv preprint arXiv:1803.02155, 2018.

175

180

185

190

- 6 -

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc