NVDIA Jetson TX2 Introduce

介绍

JETSON TX2 模块

它是一台基于 NVIDIA Pascal™架构的 AI 单模块超级计算机。它性能强大,但

外形小巧,节能高效,非常适合机器人、无人机、智能摄像机和便携医疗设备等

智能终端设备。它支持 Jetson TX1 模块的所有功能,同时可以铸就更大型、更

复杂的深度神经网络。

�

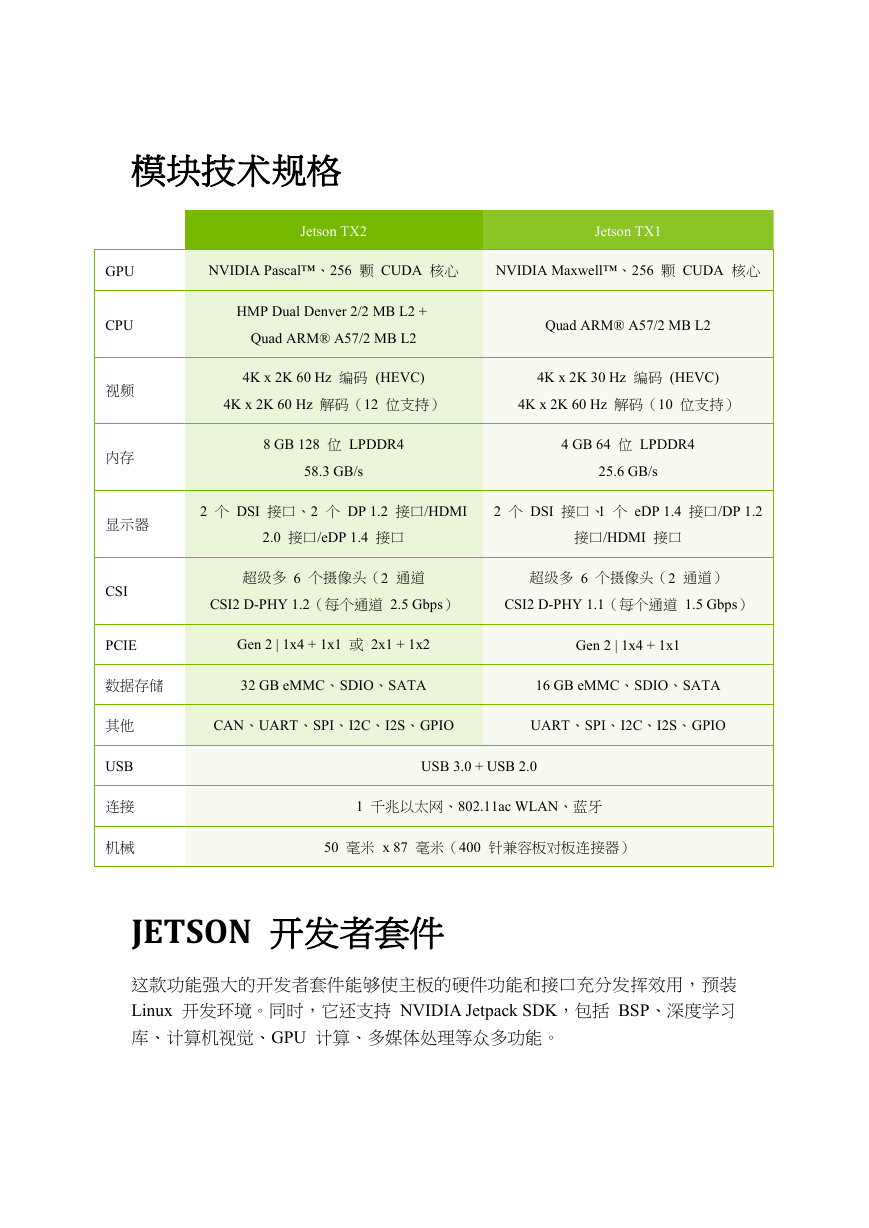

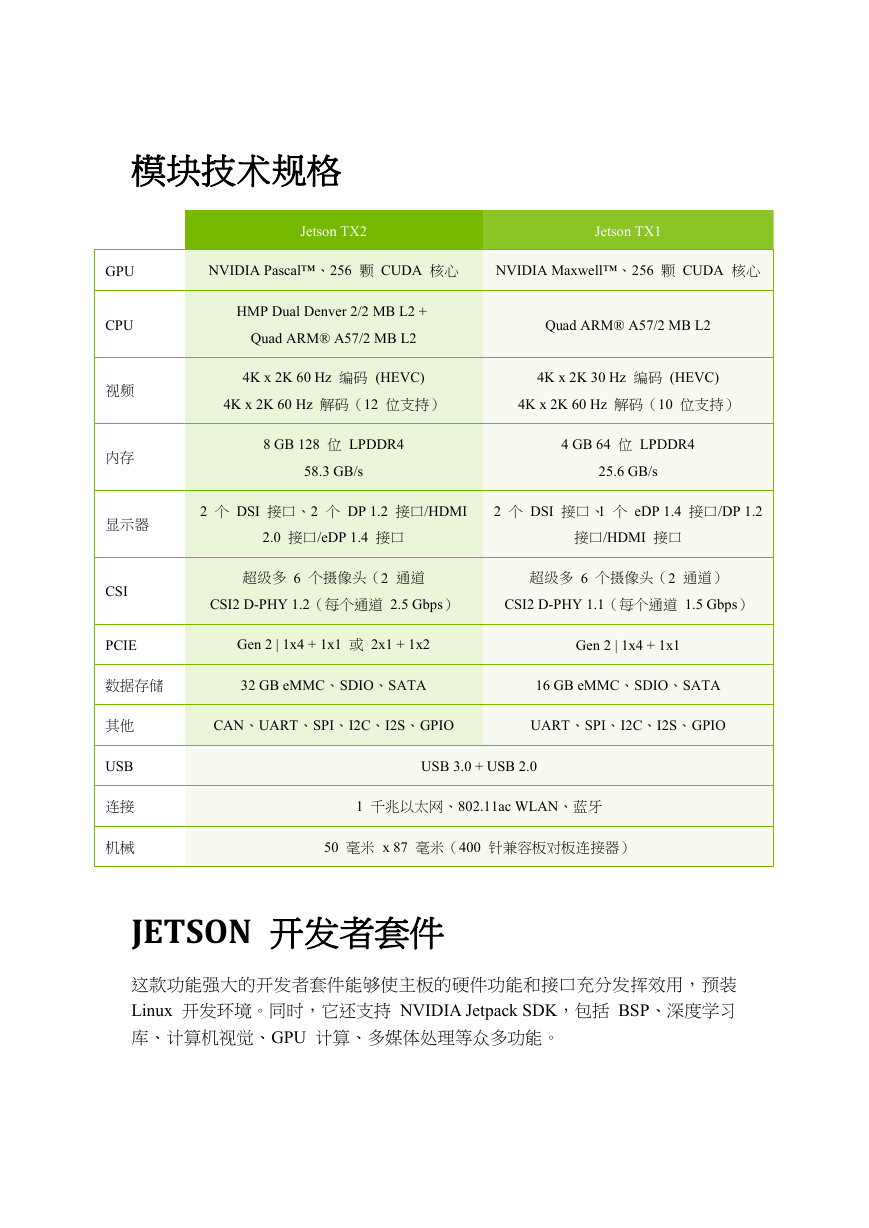

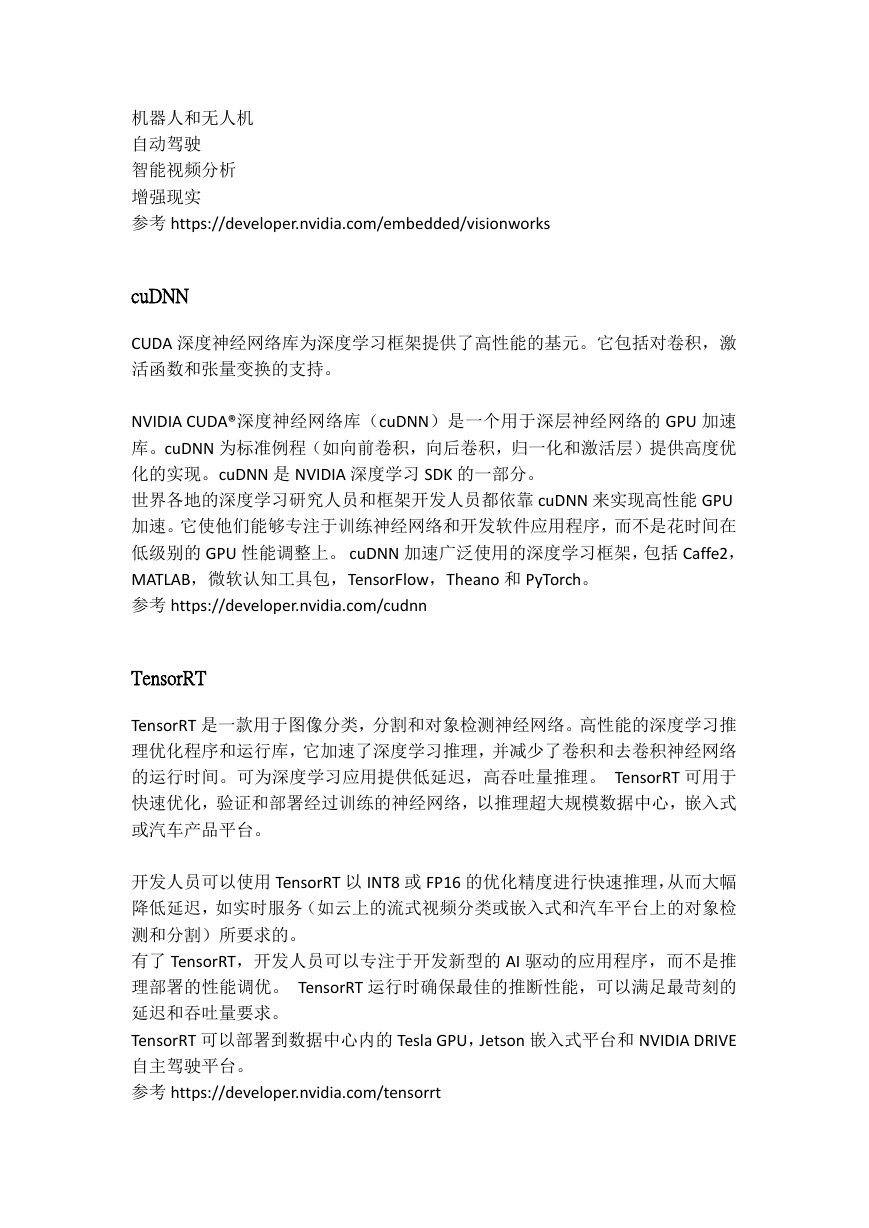

模块技术规格

Jetson TX2

Jetson TX1

NVIDIA Pascal™、256 颗 CUDA 核心

NVIDIA Maxwell™、256 颗 CUDA 核心

HMP Dual Denver 2/2 MB L2 +

Quad ARM® A57/2 MB L2

Quad ARM® A57/2 MB L2

4K x 2K 60 Hz 编码 (HEVC)

4K x 2K 30 Hz 编码 (HEVC)

4K x 2K 60 Hz 解码(12 位支持)

4K x 2K 60 Hz 解码(10 位支持)

8 GB 128 位 LPDDR4

58.3 GB/s

4 GB 64 位 LPDDR4

25.6 GB/s

2 个 DSI 接口、2 个 DP 1.2 接口/HDMI

2 个 DSI 接口、1 个 eDP 1.4 接口/DP 1.2

2.0 接口/eDP 1.4 接口

接口/HDMI 接口

超级多 6 个摄像头(2 通道

超级多 6 个摄像头(2 通道)

CSI2 D-PHY 1.2(每个通道 2.5 Gbps)

CSI2 D-PHY 1.1(每个通道 1.5 Gbps)

Gen 2 | 1x4 + 1x1 或 2x1 + 1x2

Gen 2 | 1x4 + 1x1

GPU

CPU

视频

内存

显示器

CSI

PCIE

数据存储

32 GB eMMC、SDIO、SATA

16 GB eMMC、SDIO、SATA

其他

USB

连接

机械

CAN、UART、SPI、I2C、I2S、GPIO

UART、SPI、I2C、I2S、GPIO

USB 3.0 + USB 2.0

1 千兆以太网、802.11ac WLAN、蓝牙

50 毫米 x 87 毫米(400 针兼容板对板连接器)

JETSON 开发者套件

这款功能强大的开发者套件能够使主板的硬件功能和接口充分发挥效用,预装

Linux 开发环境。同时,它还支持 NVIDIA Jetpack SDK,包括 BSP、深度学习

库、计算机视觉、GPU 计算、多媒体处理等众多功能。

�

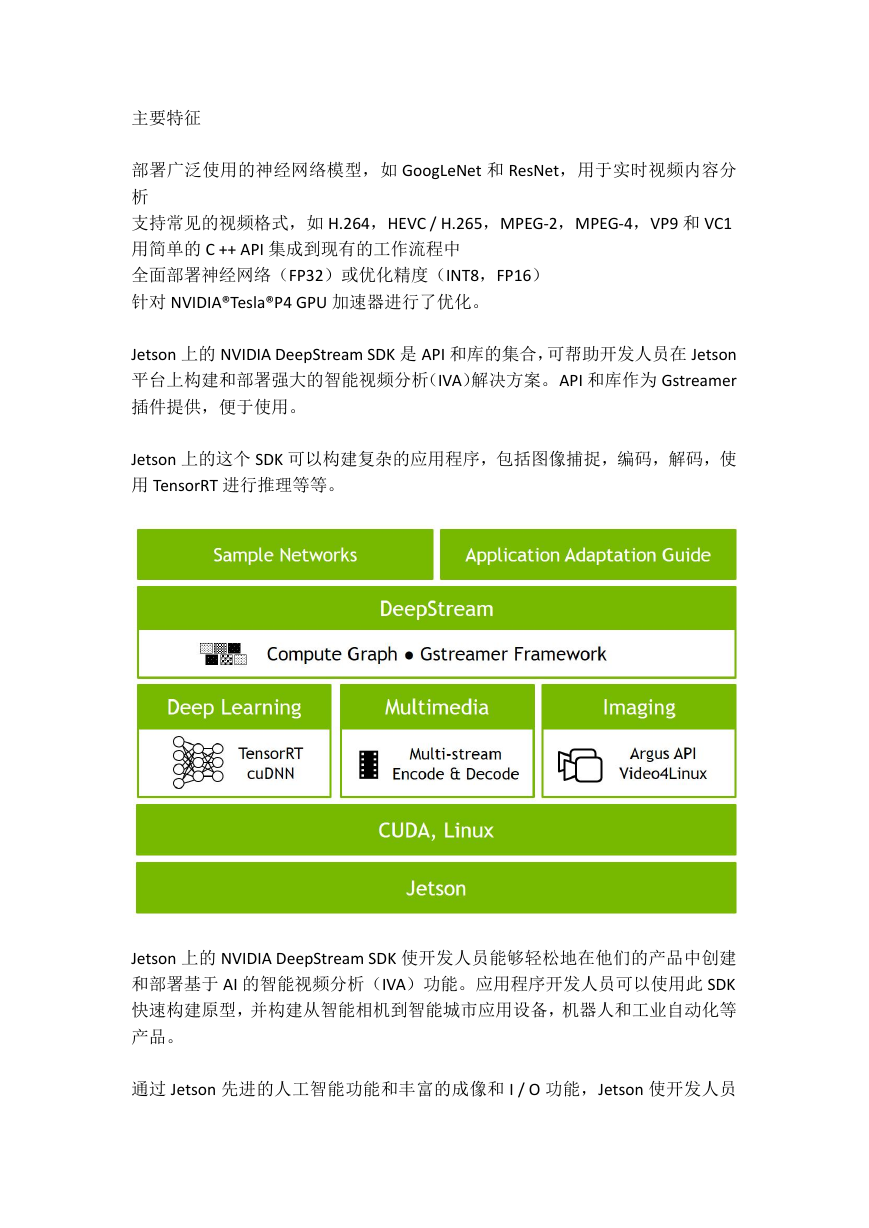

Jetson Software

JetPack

Jetson Development Pack (JetPack) 是一个按需提供的一体化软件包,捆绑并安装

了适用于 NVIDIA Jetson 嵌入式平台的所有开发用软件工具。NVIDIA JetPack SDK

是构建 AI 应用程序的最全面的解决方案。它捆绑了所有 Jetson 平台软件,包括

TensorRT,cuDNN,CUDA 工具包,VisionWorks,Streamer 和 OpenCV,这些都是

基于 LTS Linux 内核的 L4T。

JetPack 包括:

深度学习: TensorRT、cuDNN、NVIDIA DIGITS™ 工作流程

计算机视觉: NVIDIA VisionWorks、OpenCV

GPU 计算: NVIDIA CUDA、CUDA 库

多媒体: ISP 支持、摄像头图像、视频 CODEC

同时,它还包括 ROS 兼容性、OpenGL、高级开发者工具等等。

OS 镜像

一个 Ubuntu 衍生的用于 Jetson 的 sample 文件系统

�

库

CUDA

用于主机的 CUDA 工具包(带有交叉开发支持的 Ubuntu)

Jetson 的 CUDA 工具包

CUDA® 是 NVIDIA 创造的一个并行计算平台和编程模型。它利用图形处理器

(GPU) 能力,实现计算性能的显著提高。借助目前已售出的数百万支持 CUDA 的

GPU,软件开发人员、科学家和研究人员正在各种各样的应用程序中使用 GPU 加

速计算。CUDA 工具包为 C 和 C ++开发人员构建提供了一个全面的开发环境 ,

GPU 加速的应用程序。该工具包包括用于 NVIDIA GPU 的编译器,数学库以及用

于调试和优化应用程序性能的工具。

参考 http://www.nvidia.cn/object/cudazone-cn.html

OpenCV

OpenCV 是计算机视觉,图像处理和机器学习领域的领先开源库,现在提供 GPU

加速以实现实时操作。

OpenCV 被广泛的应用,包括:

街景图像拼接

自动检查和监视

机器人和无人驾驶的汽车导航和控制

医学图像分析

视频/图像搜索和检索

电影 – 3D

交互艺术设备

参考 https://developer.nvidia.com/opencv

VisionWorks

VisionWorks 是用于计算机视觉(CV)和图像处理的软件开发包。VisionWorks™

实现并扩展了 Khronos OpenVX 标准,并针对具有 CUDA 功能的 GPU 和 SOC 进行

了优化,使开发人员能够在可扩展的灵活平台上实现 CV 应用程序。它包括 VPI

(视觉编程接口),这是 CUDA 开发人员使用的一组优化的 CV 原语。NVX 库允许

直接访问 VPI,OVX 库允许通过 OpenVX 框架间接访问 VPI。

VisionWorks 的核心功能是针对以下方面的解决方案而设计的:

�

机器人和无人机

自动驾驶

智能视频分析

增强现实

参考 https://developer.nvidia.com/embedded/visionworks

cuDNN

CUDA 深度神经网络库为深度学习框架提供了高性能的基元。它包括对卷积,激

活函数和张量变换的支持。

NVIDIA CUDA®深度神经网络库(cuDNN)是一个用于深层神经网络的 GPU 加速

库。cuDNN 为标准例程(如向前卷积,向后卷积,归一化和激活层)提供高度优

化的实现。cuDNN 是 NVIDIA 深度学习 SDK 的一部分。

世界各地的深度学习研究人员和框架开发人员都依靠 cuDNN 来实现高性能 GPU

加速。它使他们能够专注于训练神经网络和开发软件应用程序,而不是花时间在

低级别的 GPU 性能调整上。 cuDNN 加速广泛使用的深度学习框架,包括 Caffe2,

MATLAB,微软认知工具包,TensorFlow,Theano 和 PyTorch。

参考 https://developer.nvidia.com/cudnn

TensorRT

TensorRT 是一款用于图像分类,分割和对象检测神经网络。高性能的深度学习推

理优化程序和运行库,它加速了深度学习推理,并减少了卷积和去卷积神经网络

的运行时间。可为深度学习应用提供低延迟,高吞吐量推理。 TensorRT 可用于

快速优化,验证和部署经过训练的神经网络,以推理超大规模数据中心,嵌入式

或汽车产品平台。

开发人员可以使用 TensorRT 以 INT8 或 FP16 的优化精度进行快速推理,从而大幅

降低延迟,如实时服务(如云上的流式视频分类或嵌入式和汽车平台上的对象检

测和分割)所要求的。

有了 TensorRT,开发人员可以专注于开发新型的 AI 驱动的应用程序,而不是推

理部署的性能调优。 TensorRT 运行时确保最佳的推断性能,可以满足最苛刻的

延迟和吞吐量要求。

TensorRT 可以部署到数据中心内的 Tesla GPU,Jetson 嵌入式平台和 NVIDIA DRIVE

自主驾驶平台。

参考 https://developer.nvidia.com/tensorrt

�

多媒体 API

Jetson 多媒体 API 包提供了底层的 API,用于灵活的应用程序开发。

相机应用程序 API:libargus 为相机应用程序提供低级帧同步 API,每帧相机参数

控制,多个(包括同步)相机支持和 EGL 流输出。RAW 输出需要 ISP 的 CSI 相机

可以与 libargus 或 GStreamer 插件一起用。无论哪种情况,都使用 V4L2 媒体控制

器传感器驱动程序 API。

传感器驱动程序 API:V4L2 API 支持视频解码,编码,格式转换和缩放功能。用

于编码的 V4L2 开启了许多功能,比如比特率控制,质量预设,低延迟编码,时

间折衷,运动矢量地图等等。

L4T

NVIDIA L4T 为 Jetson 平台提供了 Linux 内核,bootloader,NVIDIA 驱动程序,闪

存实用程序,示例文件系统等。

您可以定制 L4T 软件以适应您的项目需求。 通过遵循平台调整和启动指南,您

可以优化使用完整的 Jetson 产品功能集。

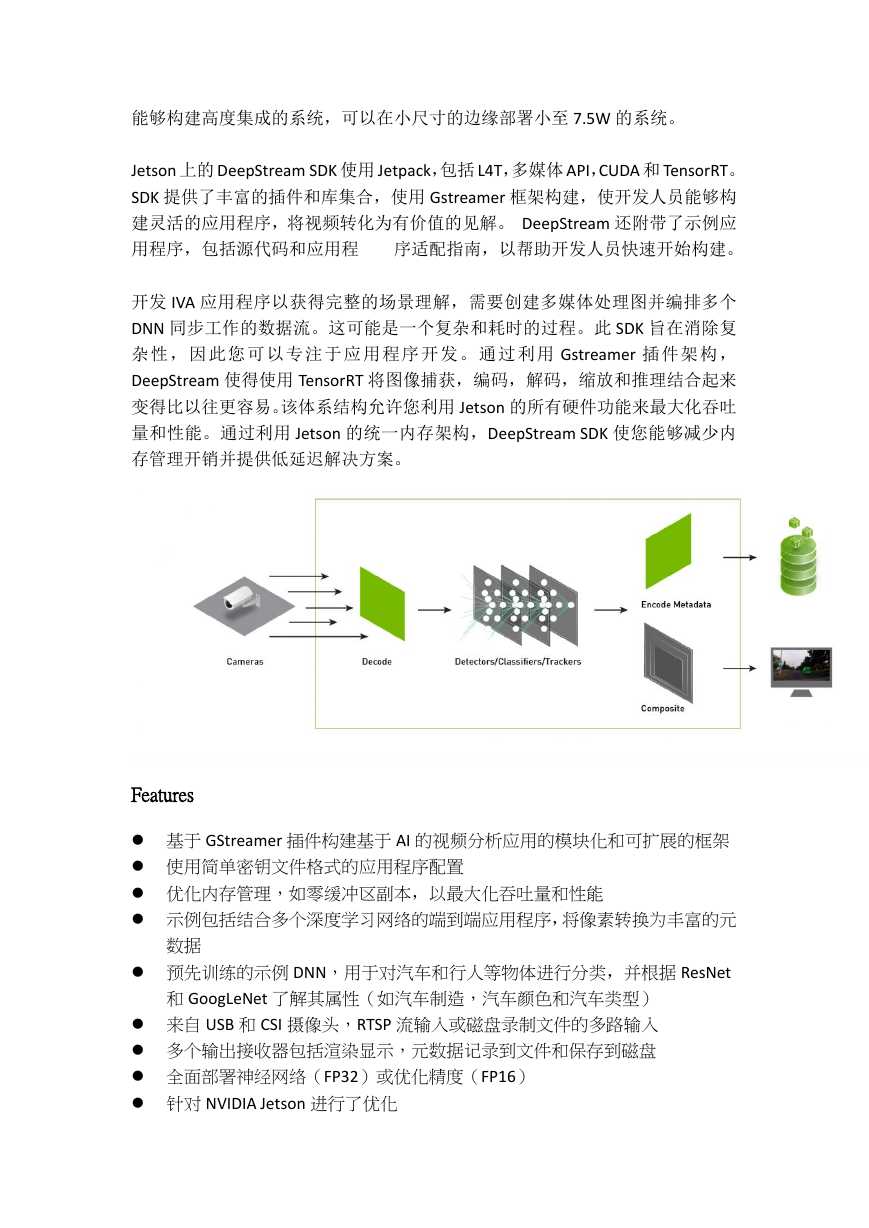

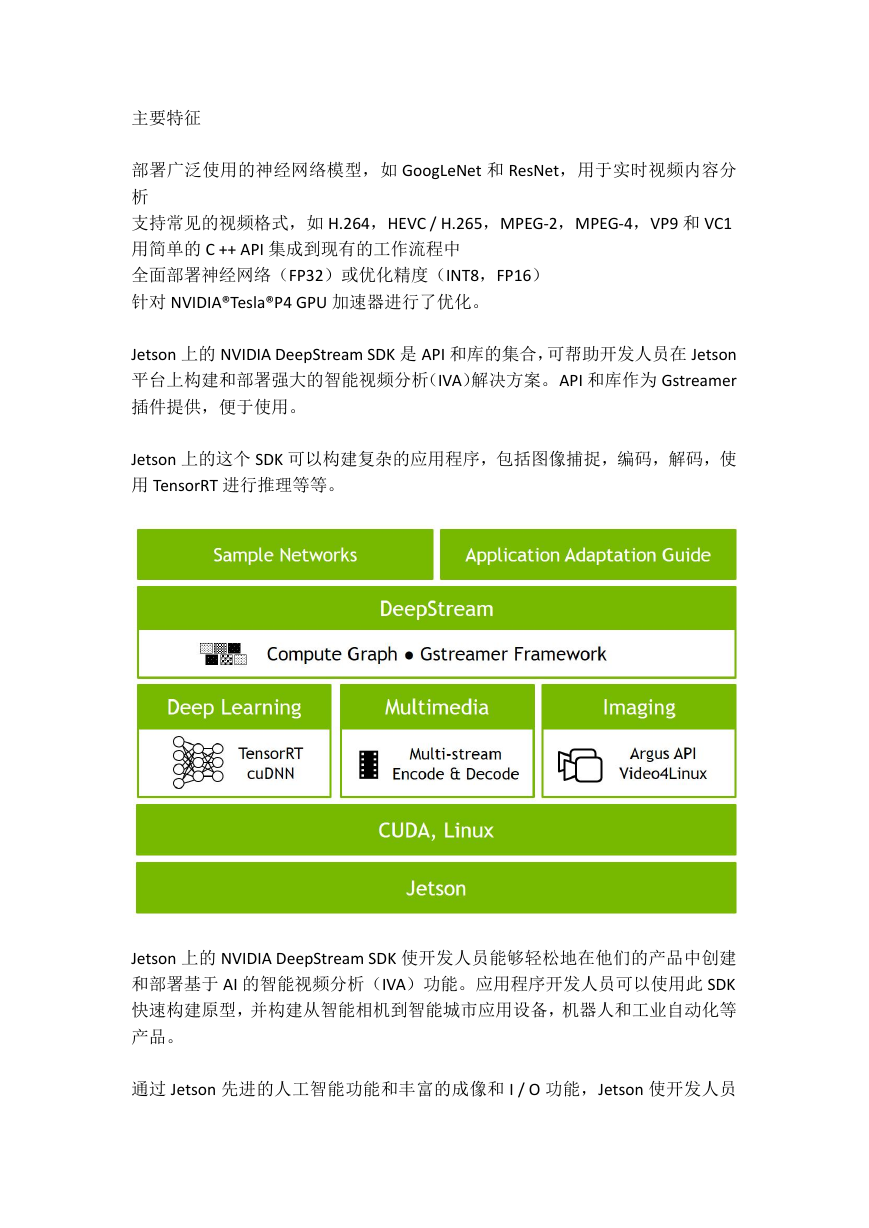

DeepStream SDK on Jetson

NVIDIA DeepStream 简化了智能城市和超大规模数据中心深度学习的可扩展智能

视频分析(IVA)应用程序的开发。它将用于推理的 NVIDIA TensorRT,用于转码

的视频编解码器 SDK 以及所有需要的预处理和数据管理集成到一个优化的 API

中。开发人员现在可以使用它来快速构建新的应用程序,将视频转化为宝贵的见

解。

DeepStream SDK 的应用程序包括图像分类,场景理解,视频分类和内容过滤。

开发人员可以使用 SDK 来有效处理和理解视频帧,以满足最苛刻的吞吐量和延迟

要求。使用 DeepStream SDK 开发的应用程序可以部署到 NVIDIA Tesla 加速计算平

台。

SDK 包括样例代码和预先训练好的深度学习模型,作为对视频流进行分类和对象

检测的例子。对于需要高通道密度的应用,SDK 包含智能解码的示例。

�

主要特征

部署广泛使用的神经网络模型,如 GoogLeNet 和 ResNet,用于实时视频内容分

析

支持常见的视频格式,如 H.264,HEVC / H.265,MPEG-2,MPEG-4,VP9 和 VC1

用简单的 C ++ API 集成到现有的工作流程中

全面部署神经网络(FP32)或优化精度(INT8,FP16)

针对 NVIDIA®Tesla®P4 GPU 加速器进行了优化。

Jetson 上的 NVIDIA DeepStream SDK 是 API 和库的集合,可帮助开发人员在 Jetson

平台上构建和部署强大的智能视频分析(IVA)解决方案。API 和库作为 Gstreamer

插件提供,便于使用。

Jetson 上的这个 SDK 可以构建复杂的应用程序,包括图像捕捉,编码,解码,使

用 TensorRT 进行推理等等。

Jetson 上的 NVIDIA DeepStream SDK 使开发人员能够轻松地在他们的产品中创建

和部署基于 AI 的智能视频分析(IVA)功能。应用程序开发人员可以使用此 SDK

快速构建原型,并构建从智能相机到智能城市应用设备,机器人和工业自动化等

产品。

通过 Jetson 先进的人工智能功能和丰富的成像和 I / O 功能,Jetson 使开发人员

�

能够构建高度集成的系统,可以在小尺寸的边缘部署小至 7.5W 的系统。

Jetson 上的 DeepStream SDK 使用 Jetpack,包括 L4T,多媒体 API,CUDA 和 TensorRT。

SDK 提供了丰富的插件和库集合,使用 Gstreamer 框架构建,使开发人员能够构

建灵活的应用程序,将视频转化为有价值的见解。 DeepStream 还附带了示例应

用程序,包括源代码和应用程

序适配指南,以帮助开发人员快速开始构建。

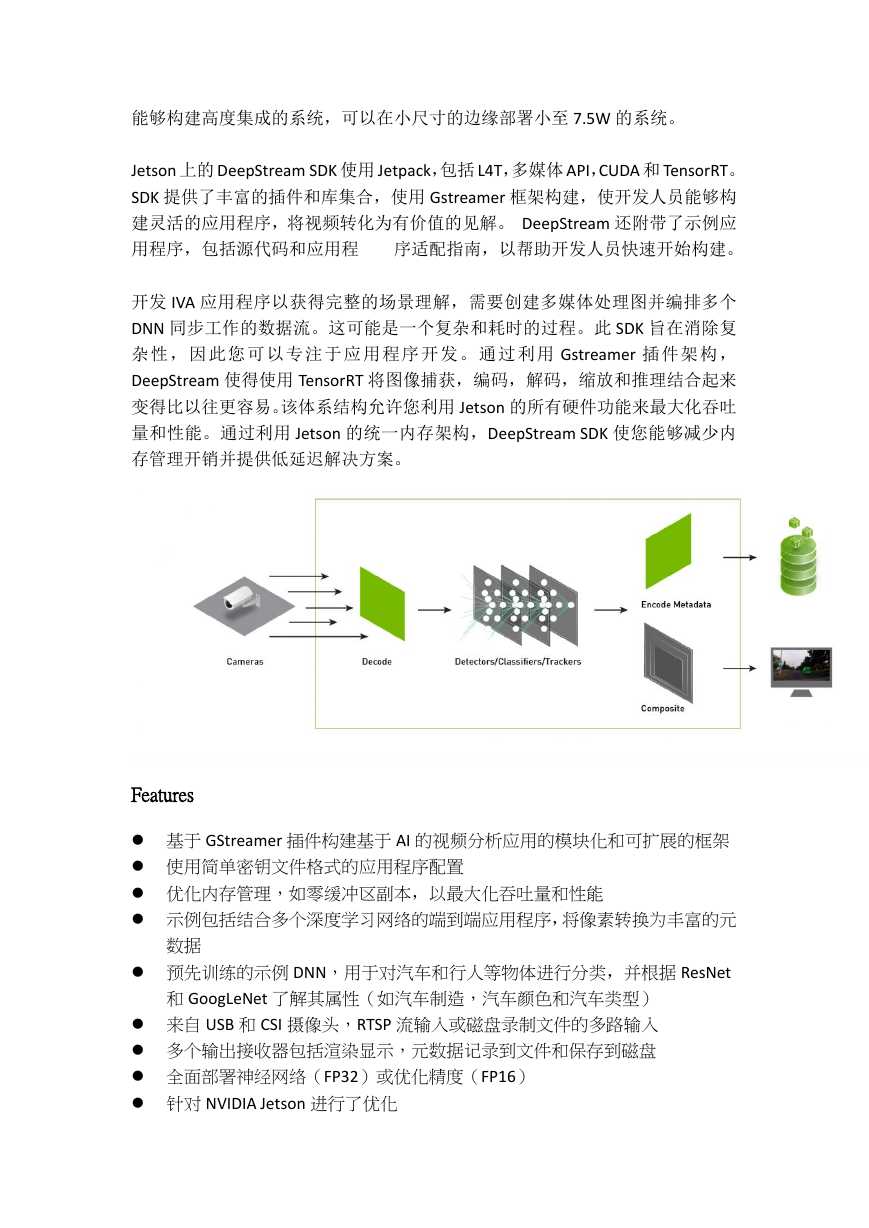

开发 IVA 应用程序以获得完整的场景理解,需要创建多媒体处理图并编排多个

DNN 同步工作的数据流。这可能是一个复杂和耗时的过程。此 SDK 旨在消除复

杂性 ,因 此您可 以专注 于应 用 程序 开发 。通过 利用 Gstreamer 插件 架构 ,

DeepStream 使得使用 TensorRT 将图像捕获,编码,解码,缩放和推理结合起来

变得比以往更容易。该体系结构允许您利用 Jetson 的所有硬件功能来最大化吞吐

量和性能。通过利用 Jetson 的统一内存架构,DeepStream SDK 使您能够减少内

存管理开销并提供低延迟解决方案。

Features

基于 GStreamer 插件构建基于 AI 的视频分析应用的模块化和可扩展的框架

使用简单密钥文件格式的应用程序配置

优化内存管理,如零缓冲区副本,以最大化吞吐量和性能

示例包括结合多个深度学习网络的端到端应用程序,将像素转换为丰富的元

数据

预先训练的示例 DNN,用于对汽车和行人等物体进行分类,并根据 ResNet

和 GoogLeNet 了解其属性(如汽车制造,汽车颜色和汽车类型)

来自 USB 和 CSI 摄像头,RTSP 流输入或磁盘录制文件的多路输入

多个输出接收器包括渲染显示,元数据记录到文件和保存到磁盘

全面部署神经网络(FP32)或优化精度(FP16)

针对 NVIDIA Jetson 进行了优化

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc