中国科技论文在线

http://www.paper.edu.cn

基于机器学习的文档级情感分析#

金鑫,张宪超**

(大连理工大学软件学院,辽宁 大连 116621)

摘要:情感分析或者舆情挖掘意在识别评论中表达的观点。例如商人们想要知道消费者是否

对他们的产品满意,推荐系统倾向于推荐那些受到很多好评的商品。本文主要研究文档级别

的情感极性分类问题。为了更好的完成该任务,我们把实验分为三个部分。(1)从大量未

标注过的句子中自动标注出主观句子和客观句子,进而用标注过的句子们训练句子级别主客

观检测器。(2)通过结合第一步中的主客观检测器和句子之间的邻近度信息提出基于最小

割的句子级主客观检测器为给定评论创建只包含主观性信息的摘要。(3)最后我们在抽取

的摘要上进行分类任务从而提高分类的准确率。

关键词:情感分析;机器学习;最小割

中图分类号:TP181

Document-level Sentiment Analysis based on Machine

Learning

JIN Xin, ZHANG Xianchao

(Software School,Dalian University of Technology, LiaoNing DaLian 116621)

Abstract: Sentiment analysis or opinion mining aims at identifying viewpoints of reviews which is

quite popular in several fields. For example, businessman wants to find out if customers like their

products or not and recommend systems tend to recommend items which receives many positive

reviews. This paper focuses on document level polarity classification problem. To do this job

better, we (1) use un-labeled sentences to create a huge dataset where sentences are annotated as

either subjective or not, and the dataset can further be used to train subjectivity detector, (2) create

an extract of a given review which only contain subjective information by using graph-cut-based

subjectivity detector.(3)Then we perform polarity classification algorithm on this extract which

can achieve high precision.

Keywords: sentiment analysis; machine learning; minimum cut

5

10

15

20

25

30

0 引言

35

40

由于情感分析很多潜在的应用,对于文本中观点、情感和主客观性的分析和研究得到了

很多的关注。例如,信息抽取和问答系统可以给出有关观点的陈述和问题,而不是有关事实

的(Jancy W 2003) [1]。而且对于公司或者推荐系统来说,从评论中抽取主观性表达式以用来

总结人们的观点或者只是提供评论的极性都是非常有用的。

文档级情感极性分类相对于传统的文本分类要难得多(Pang,Lee, and Vaithyanathan,

2002 [2])。之前的方法集中于选择有象征性的单词特征比如“good”,根据给定文档中出现

这种特征的数量对该篇文档进行分类。与此相对应,我们提出如下过程:(1)标注给定文

档中的每个句子为主观或者客观,然后把标注为客观的句子丢掉(2)运用标准的机器学习

分类器对在第一步得到的摘要进行分类。这可以防止情感极性分类器考虑那些不相关甚至有

误导性的文本。同时,包含主观信息的摘要也可以作为带有情感文本的内容总结提供给用户。

本文的实验结果表明我们创建的主观性摘要以更紧凑的形式表达出原始文档中的情感

基金项目:教育部博士点基金(20120041110046);高等学校博士学科点专项科研基金(新教师类)项目

(20100041120033)

作者简介:金鑫,(1988-),男,大连理工大学硕士研究生,研究方向:情感分析。

通信联系人:张宪超,(1971-),男,教授,主要研究方向:数据挖掘,信息检索,机器学习。E-mail:

xczhang@dlut.edu.cn

- 1 -

�

中国科技论文在线

http://www.paper.edu.cn

信息。同时,我们也探索了基于最小割的提取主观性摘要的方法,它可以很好地结合句子之

间的信息和传统的词袋特征。

1 情感分类方法

45

1.1 架构

50

55

60

65

70

我们可以把文档级情感极性分类问题看成文本分类的一个特例,与传统的基于话题的文

本分类不同的是极性分类是基于文档所表达出来的情感的。所以,标准的机器学习分类算法

如支持向量机分类算法和朴素贝叶斯分类算法都可以用于分类整个文档的情感。我们把这种

分类技术称为默认情感极性分类器。

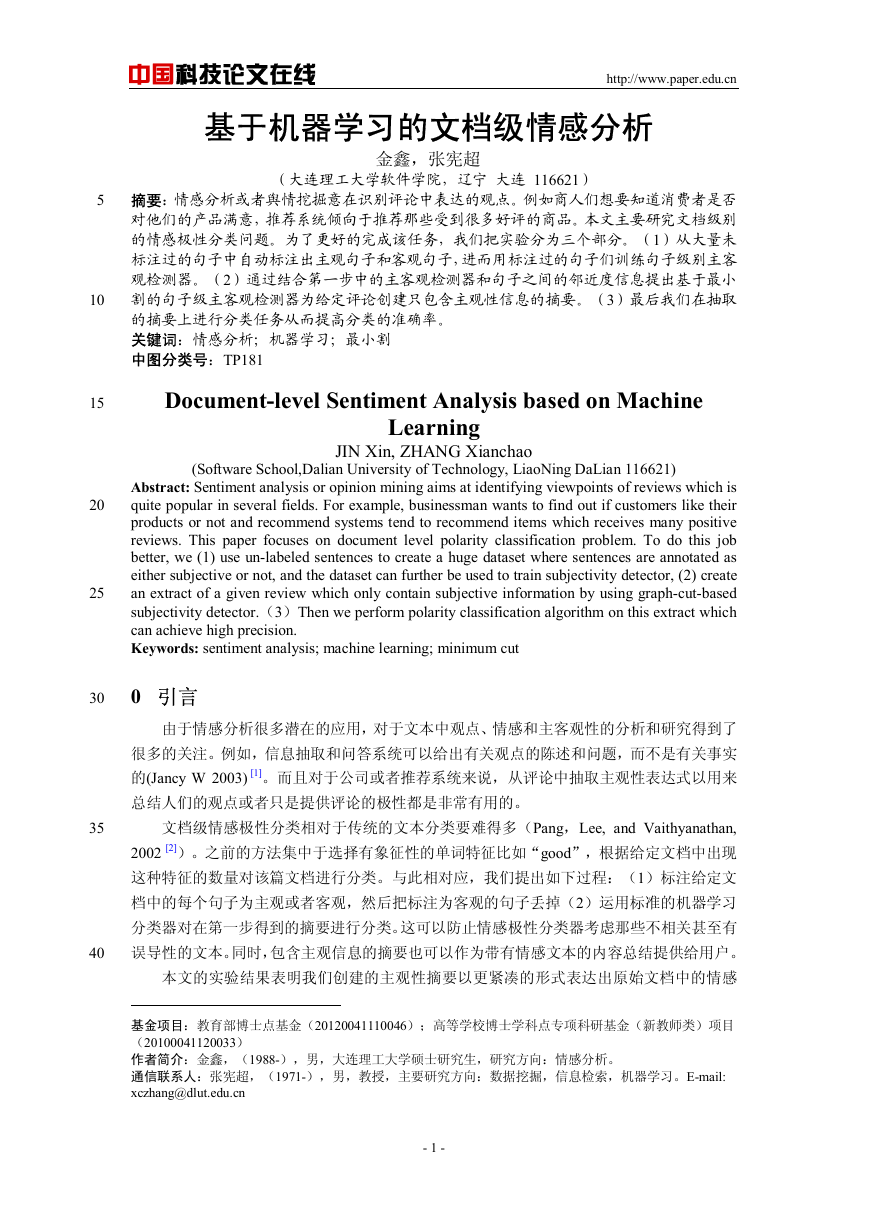

然而,就像上面提到的,我们可能通过去掉客观性信息来提高情感极性分类算法的准确

率。所以,如图 1 描述的,我们首先用训练好的主客观检测器去决定文档的每一个句子是主

观的还是客观的,然后去掉那些客观信息形成摘要(extract)。摘要能更好的表达文档的主

观内容,从而提高默认情感极性分类器的准确率。

图 1 通过主客观检测器进行情感极性分类

Fig. 1 Sentiment polarity classification via subjectivity detection

据我所知,之前的工作有研究过结合句子级别主客观检测器与文档级情感极性检测。但

是那些论文中用到了大量的人工标注为主观或者是客观的句子作为主客观检测器的训练数

据,人工标注大量的句子是非常耗费时间的工作,所以这里我们通过自动标注未标注过的海

量句子为主观或者客观来获得训练数据。

1.2 上下文和主观性检测

对于文档级情感极性分类,我们可以对每一个句子运用基于标准的机器学习分类算法的

主客观检测器。但是,对句子之间的关系进行建模可以让我们利用句子之间的一致性信息

(coherence),指的是在同一片文档之内的距离比较近的句子之间的主客观性往往是一致的,

这在论文 Wiebe(1994)[3]中提到。

所以我们为算法提供句子之间的相关信息,即声明两个特定的句子应该得到相同的主客

观标签,但是不声明到底是主观标签还是客观标签。这对于分类器来说是一个难题,因为像

朴素贝叶斯或者支持向量机这样的分类器的输入样例一般都是单独的特征向量,而且分类器

都是单独标注每一个样例。为了解决这个问题一些人可能想加一些两个句子中值相同的虚拟

特征,但是被证明是很繁琐且效率极低的。所以,为了避开繁琐的特征选择问题,我们采用

相对高效而且直观的基于图的公式,依赖于寻找图中的最小割。这种方法最早在机器学习的

刊物 Blum 和 Chawla(2001)[4]中指出,尽管他们把注意力集中在样例之间的相似度,而我

们关心的是待分类样例之间的物理相似度,即在同一篇文档中出现的句子之间的距离。事实

- 2 -

�

中国科技论文在线

http://www.paper.edu.cn

75

上,为相似度信息通过图中的割建模被证明是非常有效的分类方法。

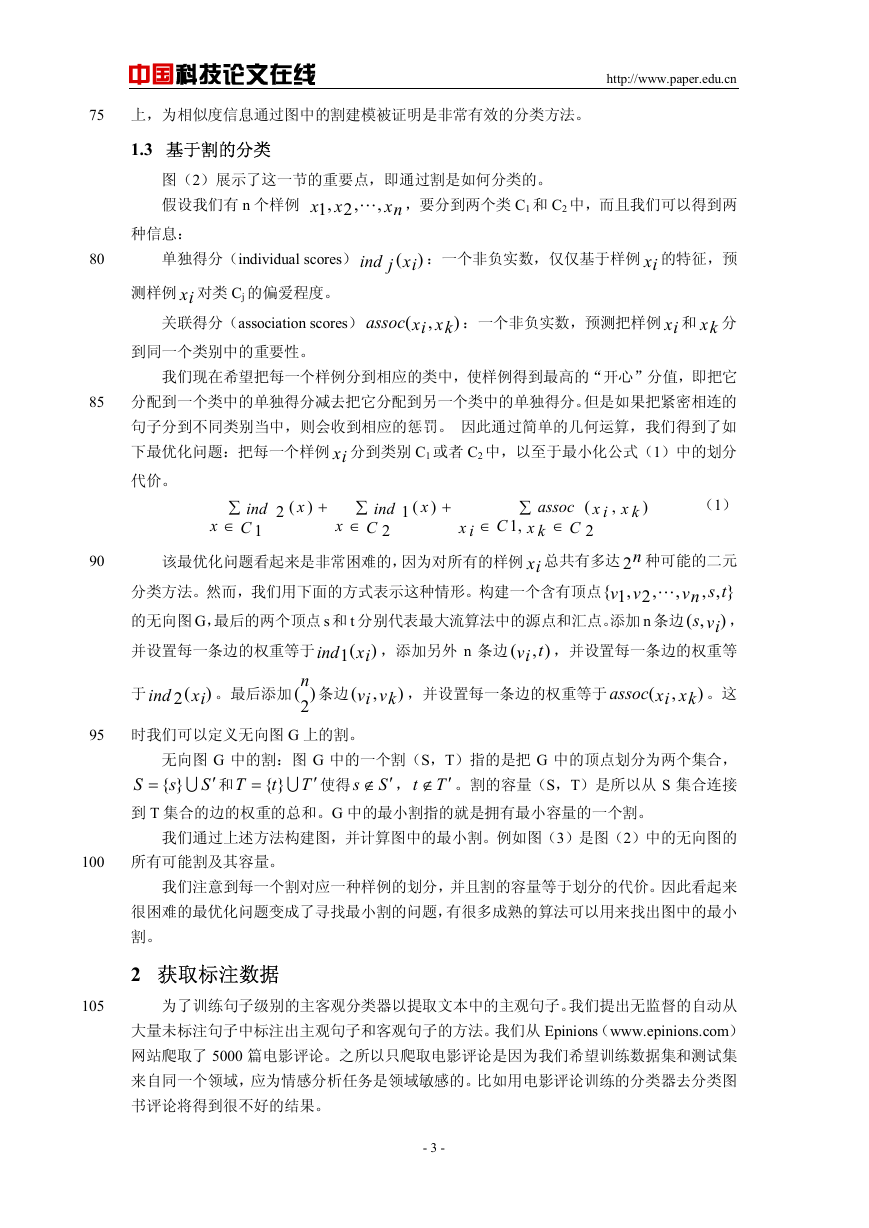

1.3 基于割的分类

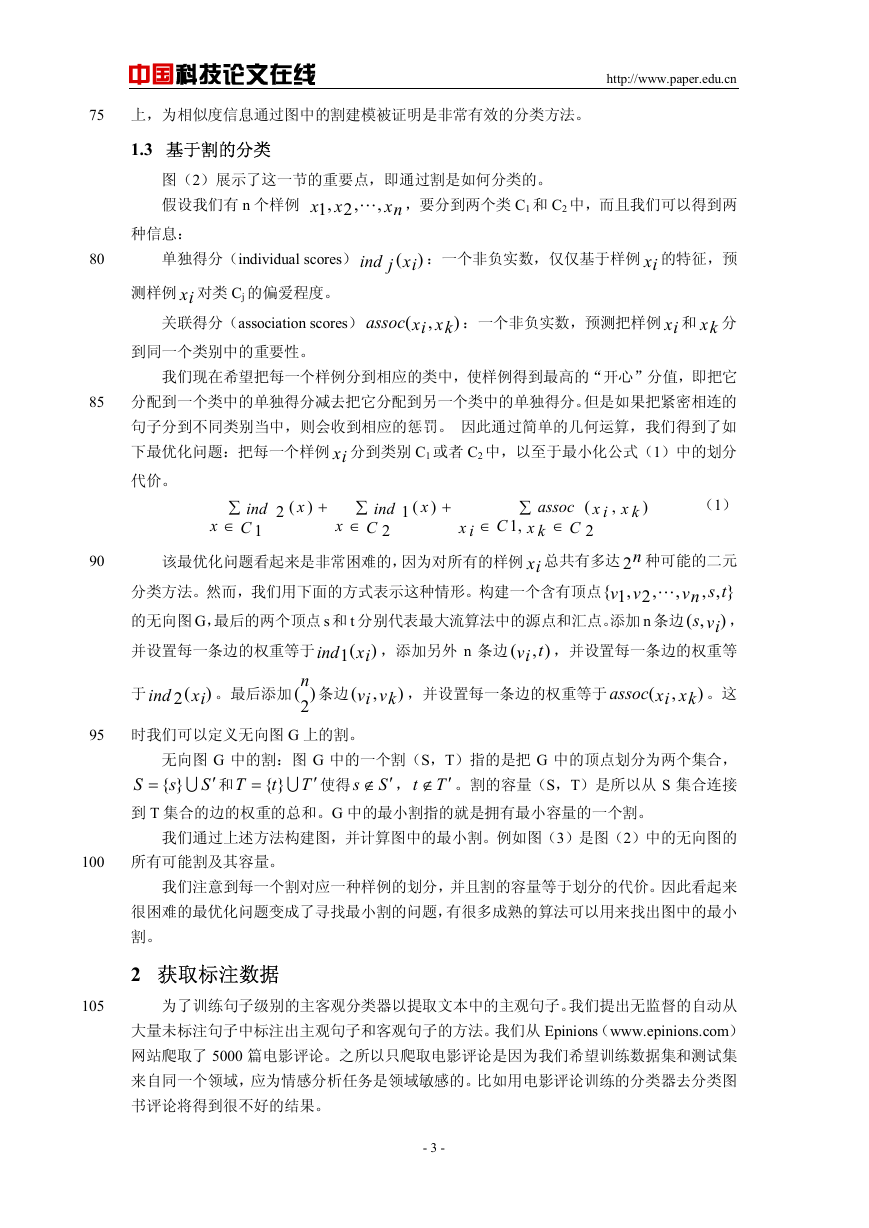

图(2)展示了这一节的重要点,即通过割是如何分类的。

假设我们有 n 个样例

,2,1 L ,要分到两个类 C1 和 C2 中,而且我们可以得到两

x

xn

x

,

种信息:

80

单独得分(individual scores)

ind j

(xi

)

:一个非负实数,仅仅基于样例 xi 的特征,预

测样例 xi 对类 Cj 的偏爱程度。

关联得分(association scores)

assoc

(

xi

,

)

xk

:一个非负实数,预测把样例 xi 和 xk 分

到同一个类别中的重要性。

我们现在希望把每一个样例分到相应的类中,使样例得到最高的“开心”分值,即把它

分配到一个类中的单独得分减去把它分配到另一个类中的单独得分。但是如果把紧密相连的

句子分到不同类别当中,则会收到相应的惩罚。 因此通过简单的几何运算,我们得到了如

下最优化问题:把每一个样例 xi 分到类别 C1 或者 C2 中,以至于最小化公式(1)中的划分

代价。

∑

∈

ind

C

1

x

(2

x

)

+

ind

∑

∈

C

2

x

(1

x

)

+

assoc

∑

,1

∈

C

x k

(

x i

2

∈

C

x i

,

x k

)

(1)

分类方法。然而,我们用下面的方式表示这种情形。构建一个含有顶点

,

L

的无向图 G,最后的两个顶点 s 和 t 分别代表最大流算法中的源点和汇点。添加 n 条边

该最优化问题看起来是非常困难的,因为对所有的样例 xi 总共有多达 2n 种可能的二元

ts

},

,

vn

s ,

,( vi

)

tvi ,并设置每一条边的权重等

,添加另外 n 条边

,2,1{

vv

(1 xi

ind

),

(

)

85

90

并设置每一条边的权重等于

n

。最后添加 )

2

(2 xi

ind

于

)

(

条边

(

vi

,

vk

)

,并设置每一条边的权重等于

assoc

(

xi

,

)

xk

。这

95

时我们可以定义无向图 G 上的割。

无向图 G 中的割:图 G 中的一个割(S,T)指的是把 G 中的顶点划分为两个集合,

s

U}{

′∉ 。割的容量(S,T)是所以从 S 集合连接

S

到 T 集合的边的权重的总和。G 中的最小割指的就是拥有最小容量的一个割。

′∉ , Tt

使得 S

t

U}{

和

T

T

=

=

S

s

′

′

我们通过上述方法构建图,并计算图中的最小割。例如图(3)是图(2)中的无向图的

100

所有可能割及其容量。

我们注意到每一个割对应一种样例的划分,并且割的容量等于划分的代价。因此看起来

很困难的最优化问题变成了寻找最小割的问题,有很多成熟的算法可以用来找出图中的最小

割。

2 获取标注数据

105

为了训练句子级别的主客观分类器以提取文本中的主观句子。我们提出无监督的自动从

大量未标注句子中标注出主观句子和客观句子的方法。我们从 Epinions(www.epinions.com)

网站爬取了 5000 篇电影评论。之所以只爬取电影评论是因为我们希望训练数据集和测试集

来自同一个领域,应为情感分析任务是领域敏感的。比如用电影评论训练的分类器去分类图

书评论将得到很不好的结果。

- 3 -

�

中国科技论文在线

http://www.paper.edu.cn

图 2 根据三个样例的单独得分和关联得分对它们建图

Fig. 2 Build graph for three items based on their individual scores and association scores

110

115

120

图 3 对图(2)中的无向图计算所有的割及其容量

Fig. 3 All cuts of figure (2) and its corresponding cost

Riloff 和 Wiebe(2003)[5]提供了 8000 个带情感的单词,它们被分为强主观性单词和弱

主观性单词。如果一个文档中的某个句子含有两个或者两个以上的强主观性单词,我们就把

它分类为主观。如果一个文档中的某个句子,以及该句子的前后句都不包含强主观性单词,

且最多包含一个弱主观性单词,则我们把该句子分类为客观。

通过以上这种无监督的方法,我们从 5000 篇文档中选出了 5000 个主观性句子和 5000

个客观性句子作为训练集。本文把它称为主客观数据集。

3 实验

125

3.1 实验评价框架

我们的实验包括把电影评论分类为褒义或者贬义两类。给定一篇电影评论,褒义的评论

指的就是该篇评论的作者喜爱这部电影,贬义的评论则指的是该篇评论的作者讨厌这部电

影。这是一个非常吸引人的任务。第一,例如一个用户只想看到关于某部电影的主观评论而

不是客观事实。这时特定的面向情感的搜索引擎就派上用场了。第二,电影评论的分类问题

- 4 -

�

中国科技论文在线

http://www.paper.edu.cn

130

135

要比其他领域的评论分类难得多,像 P. Turney(2002)[6]实验表明的那样。第三,电影评论

的分类结果可以自动获取,例如从用户给的评级信息中。我们实验中用到的数据集包含 1000

篇 褒 义 的 电 影 评 论 和 1000 篇 贬 义 的 电 影 评 论 。 从 网 站

www.cs.cornell.edu/people/pabo/movie-review-data/可以获取到数据集。我们把它成极性数据

集(polarity dataset)。

默认极性分类器(Default polarity classifiers):我们在实验中用到支持向量机分类器和

朴素贝叶斯分类器,如 B. Pang 和 L. Lee[2]中用的方法。我们采用一元单词出现与否作为特

征,即如果特征向量中的第 i 个特征出现则设置其值为 1,如果第 i 个特征没有出现则设置

其值为 0。每一个文档级别默认分类器都是以提取的摘要作为训练数据集。

主客观数据集(subjectivity dataset):为了训练我们的句子级主客观检测器,我们需要

大量标注为主观或者客观的句子作为分类器的训练集。但是人工标注这种数据集是非常耗时

140

而且困难的。所以我们用自动从海量未标注的句子中标注句子为主观或者客观的方法来获取

主客观检测器的训练数据集。其方法第 2 节提到。

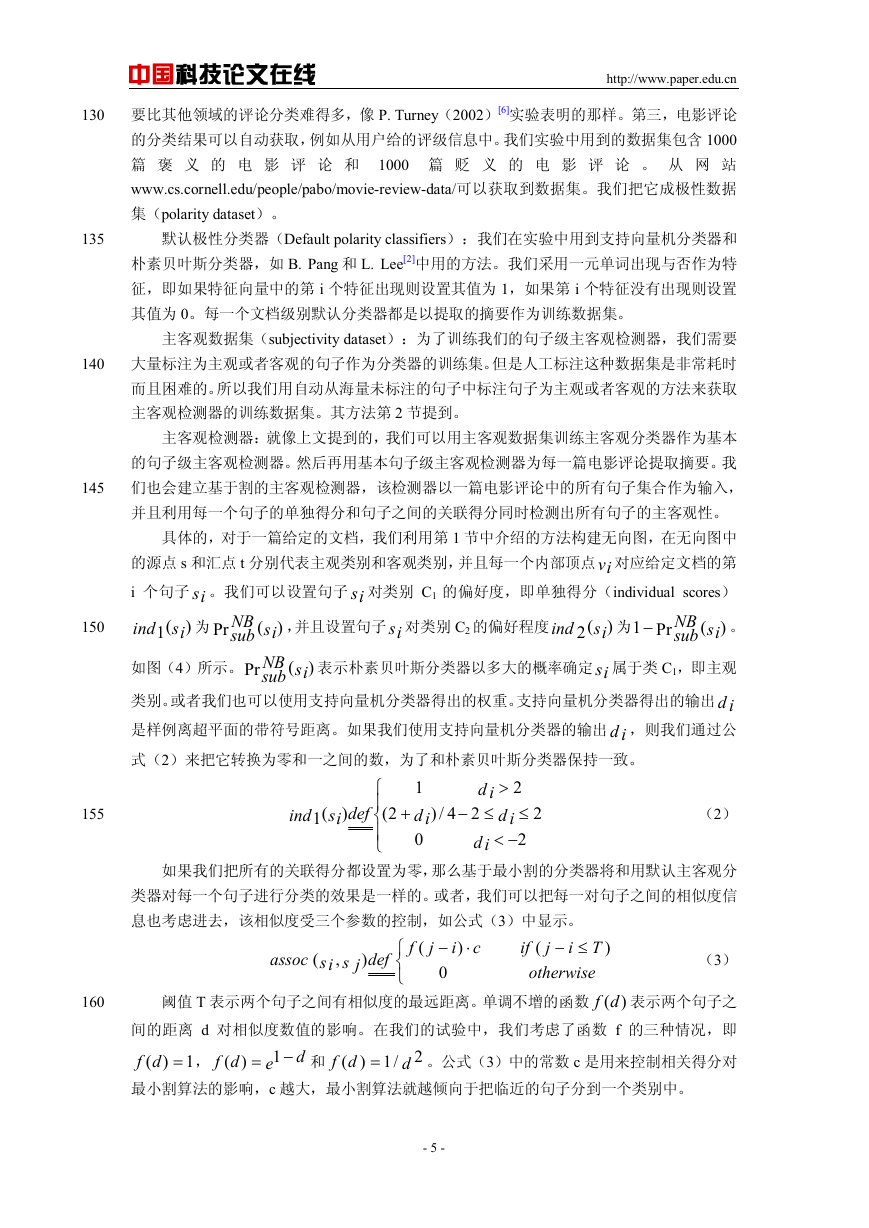

主客观检测器:就像上文提到的,我们可以用主客观数据集训练主客观分类器作为基本

的句子级主客观检测器。然后再用基本句子级主客观检测器为每一篇电影评论提取摘要。我

145

150

155

160

NB

sub

Pr

si

NB

sub

,并且设置句子 si 对类别 C2 的偏好程度

(

)

们也会建立基于割的主客观检测器,该检测器以一篇电影评论中的所有句子集合作为输入,

并且利用每一个句子的单独得分和句子之间的关联得分同时检测出所有句子的主客观性。

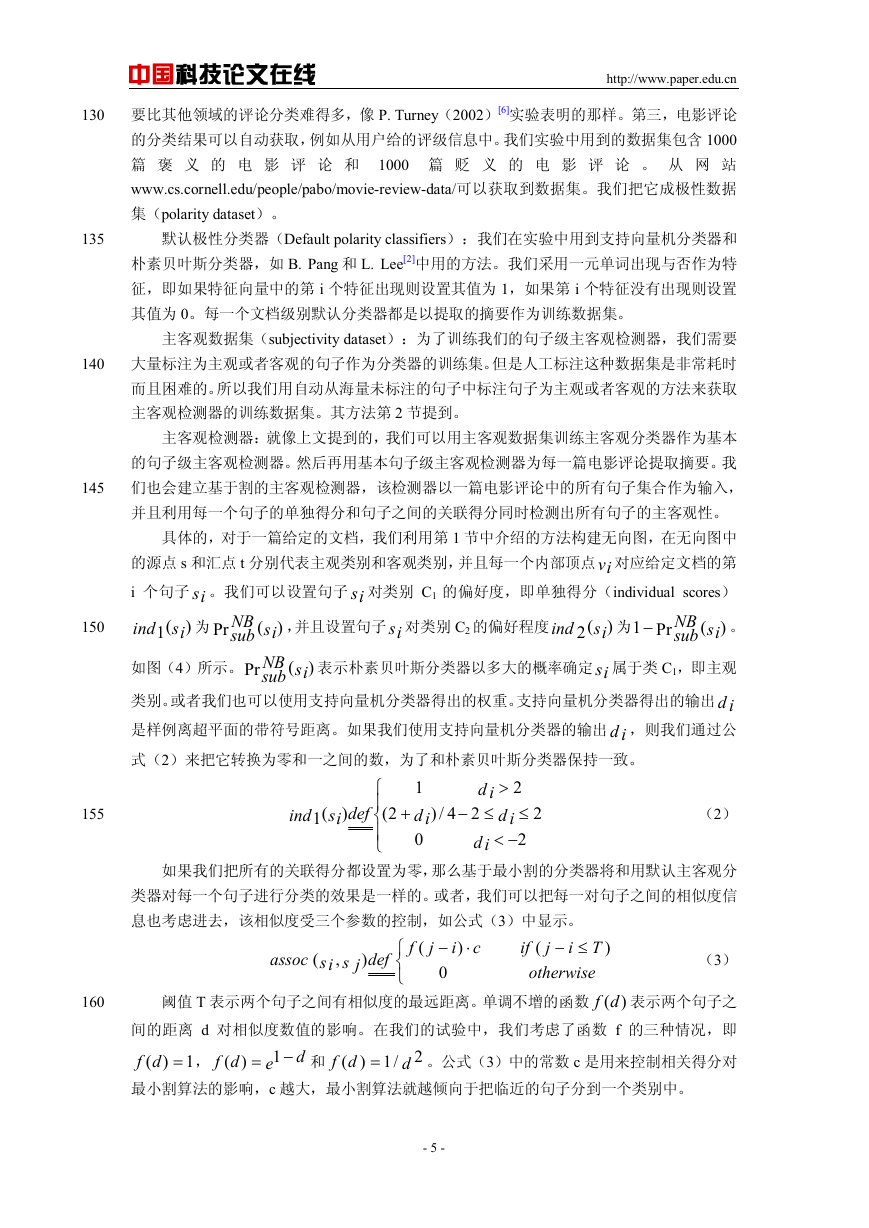

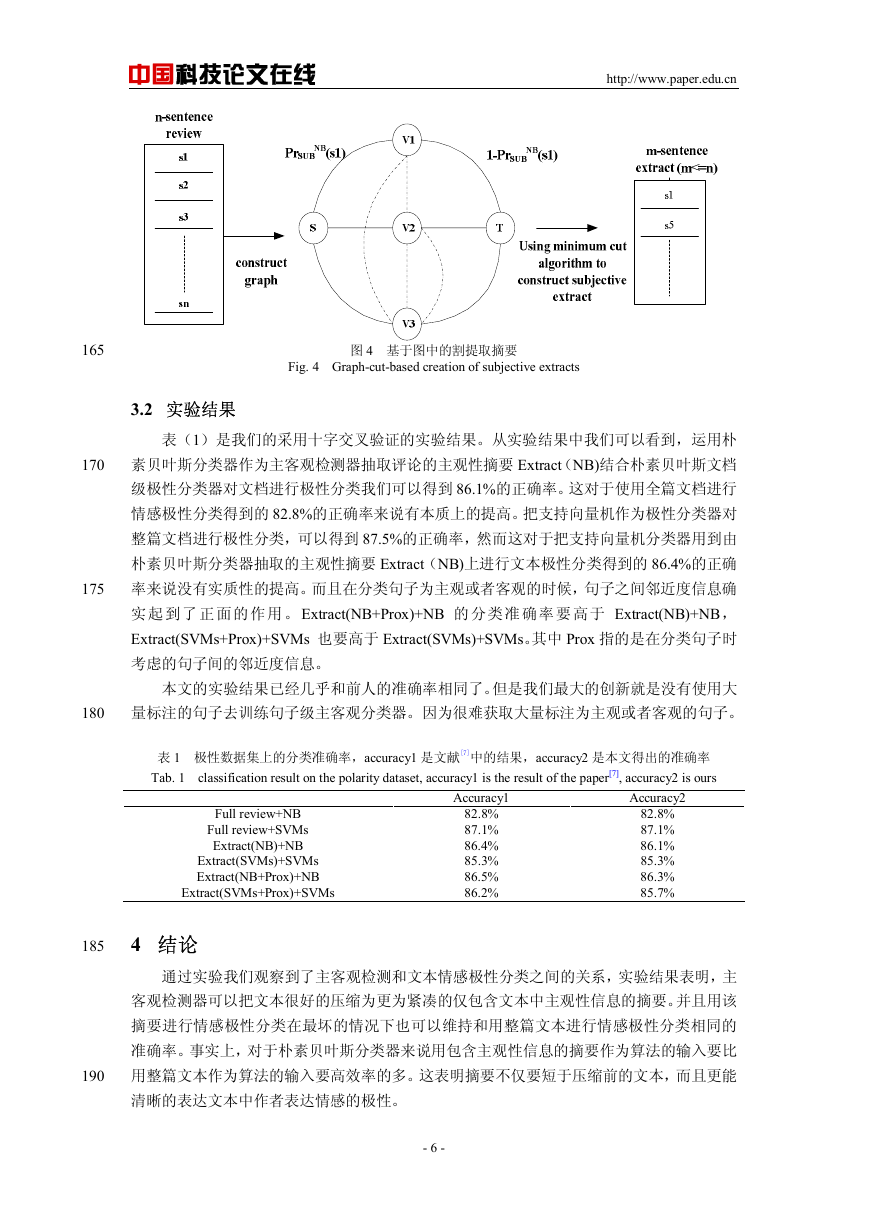

具体的,对于一篇给定的文档,我们利用第 1 节中介绍的方法构建无向图,在无向图中

的源点 s 和汇点 t 分别代表主观类别和客观类别,并且每一个内部顶点vi 对应给定文档的第

i 个句子 si 。我们可以设置句子 si 对类别 C1 的偏好度,即单独得分(individual scores)

)

ind

。

ind

为

为

−

1

Pr

Pr

(

)

(

)

)

(2 si

(1 si

NB

sub

si

si

表示朴素贝叶斯分类器以多大的概率确定 si 属于类 C1,即主观

如图(4)所示。

类别。或者我们也可以使用支持向量机分类器得出的权重。支持向量机分类器得出的输出 d i

是样例离超平面的带符号距离。如果我们使用支持向量机分类器的输出 d i ,则我们通过公

式(2)来把它转换为零和一之间的数,为了和朴素贝叶斯分类器保持一致。

ind

(1

si

)

def

⎧

⎪

2(

⎨

⎪

⎩

+

1

d i

0

4/)

d i

2

≤−

d i

2

>

≤

d i

2

−<

2

(2)

如果我们把所有的关联得分都设置为零,那么基于最小割的分类器将和用默认主客观分

(

,

f

(

j

assoc

类器对每一个句子进行分类的效果是一样的。或者,我们可以把每一对句子之间的相似度信

息也考虑进去,该相似度受三个参数的控制,如公式(3)中显示。

Ti

if

(

≤−

otherwise

阈值 T 表示两个句子之间有相似度的最远距离。单调不增的函数

)(df 表示两个句子之

间的距离 d 对相似度数值的影响。在我们的试验中,我们考虑了函数 f 的三种情况,即

=df

1)(

最小割算法的影响,c 越大,最小割算法就越倾向于把临近的句子分到一个类别中。

。公式(3)中的常数 c 是用来控制相关得分对

(3)

)

⋅−

0

2/1

d

= 1

e

df

)(

df

(

def

s j

⎧

⎨

⎩

si

,

和

=

−

d

c

)

j

)

)

i

- 5 -

�

中国科技论文在线

http://www.paper.edu.cn

165

170

175

图 4 基于图中的割提取摘要

Fig. 4 Graph-cut-based creation of subjective extracts

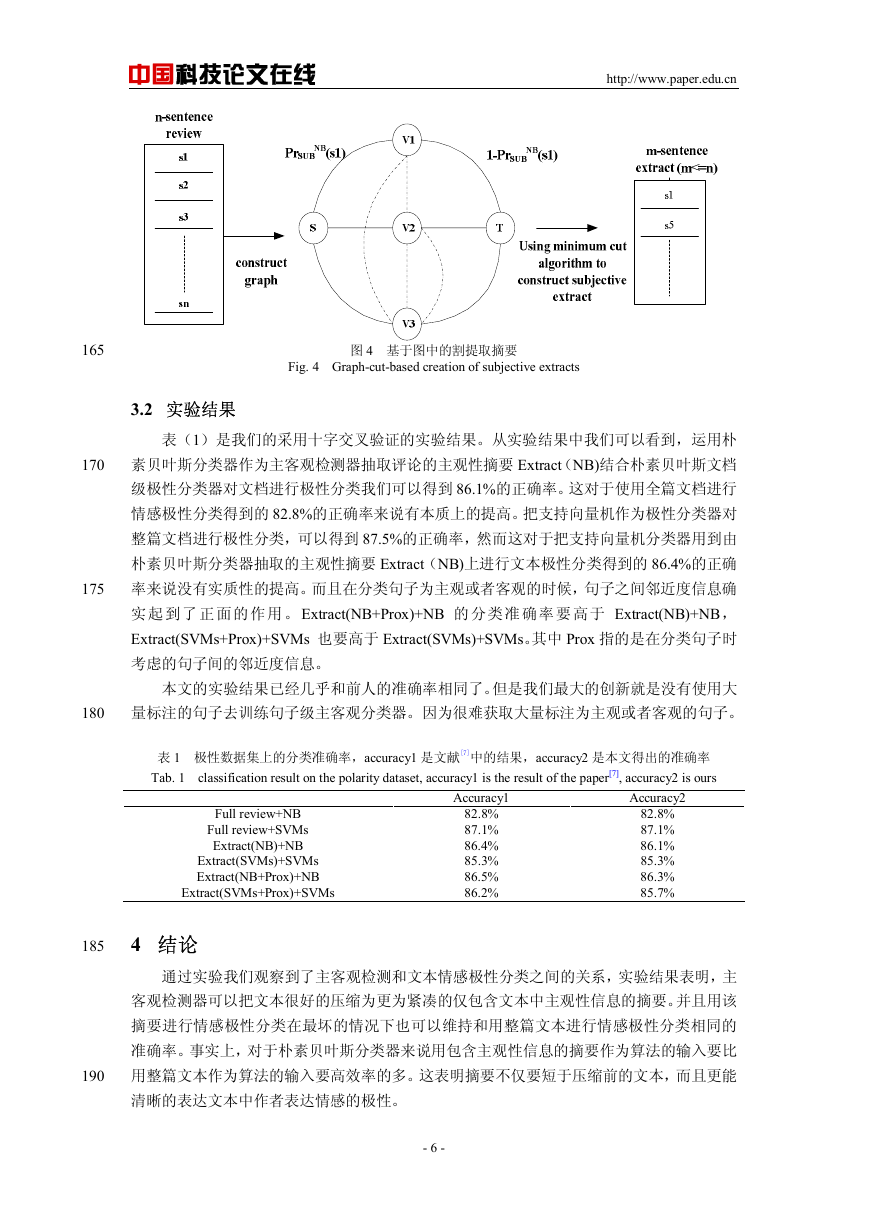

3.2 实验结果

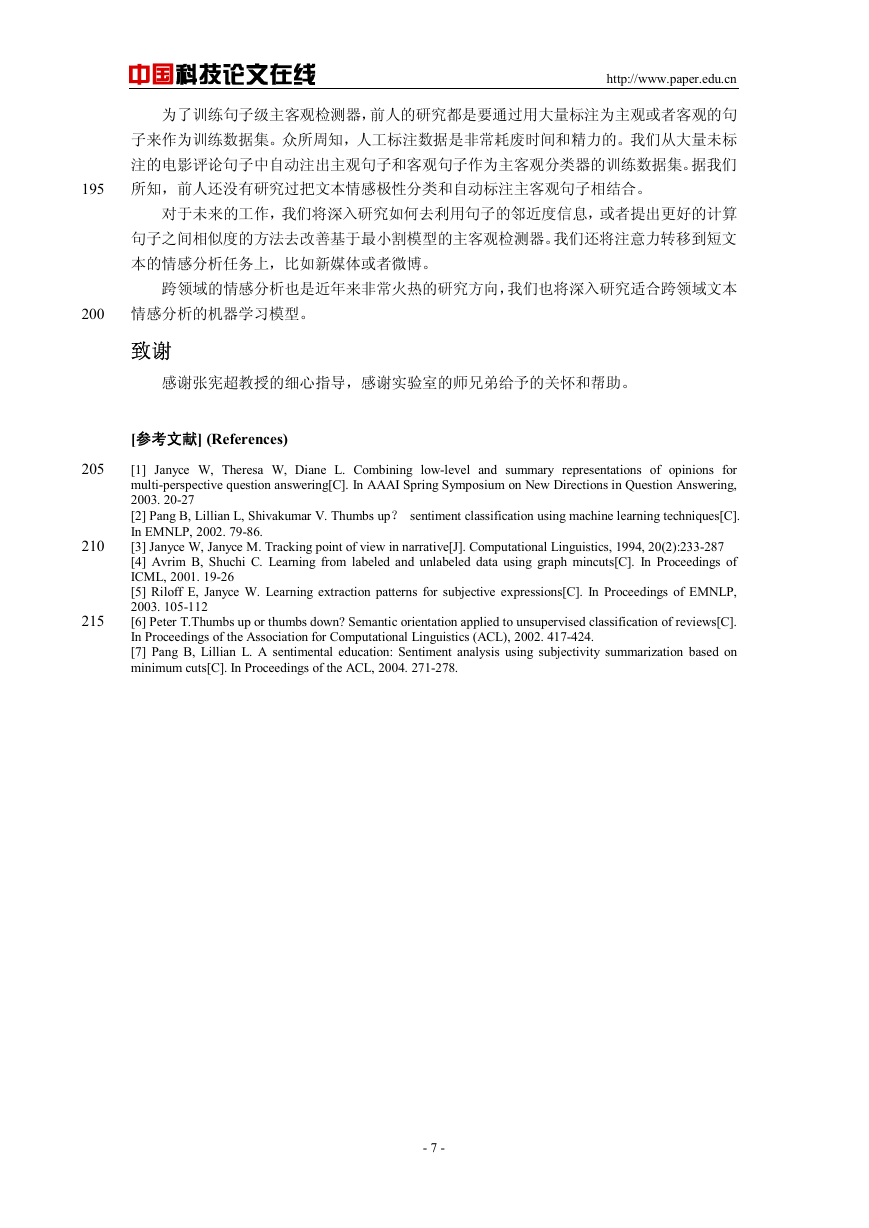

表(1)是我们的采用十字交叉验证的实验结果。从实验结果中我们可以看到,运用朴

素贝叶斯分类器作为主客观检测器抽取评论的主观性摘要 Extract(NB)结合朴素贝叶斯文档

级极性分类器对文档进行极性分类我们可以得到 86.1%的正确率。这对于使用全篇文档进行

情感极性分类得到的 82.8%的正确率来说有本质上的提高。把支持向量机作为极性分类器对

整篇文档进行极性分类,可以得到 87.5%的正确率,然而这对于把支持向量机分类器用到由

朴素贝叶斯分类器抽取的主观性摘要 Extract(NB)上进行文本极性分类得到的 86.4%的正确

率来说没有实质性的提高。而且在分类句子为主观或者客观的时候,句子之间邻近度信息确

实 起 到了 正 面的 作用 。Extract(NB+Prox)+NB 的 分类 准 确率 要 高于 Extract(NB)+NB,

Extract(SVMs+Prox)+SVMs 也要高于 Extract(SVMs)+SVMs。其中 Prox 指的是在分类句子时

考虑的句子间的邻近度信息。

本文的实验结果已经几乎和前人的准确率相同了。但是我们最大的创新就是没有使用大

量标注的句子去训练句子级主客观分类器。因为很难获取大量标注为主观或者客观的句子。

180

表 1 极性数据集上的分类准确率,accuracy1 是文献[7]中的结果,accuracy2 是本文得出的准确率

Tab. 1 classification result on the polarity dataset, accuracy1 is the result of the paper[7], accuracy2 is ours

Full review+NB

Full review+SVMs

Extract(NB)+NB

Extract(SVMs)+SVMs

Extract(NB+Prox)+NB

Extract(SVMs+Prox)+SVMs

Accuracy1

82.8%

87.1%

86.4%

85.3%

86.5%

86.2%

Accuracy2

82.8%

87.1%

86.1%

85.3%

86.3%

85.7%

185

4 结论

通过实验我们观察到了主客观检测和文本情感极性分类之间的关系,实验结果表明,主

客观检测器可以把文本很好的压缩为更为紧凑的仅包含文本中主观性信息的摘要。并且用该

摘要进行情感极性分类在最坏的情况下也可以维持和用整篇文本进行情感极性分类相同的

准确率。事实上,对于朴素贝叶斯分类器来说用包含主观性信息的摘要作为算法的输入要比

190

用整篇文本作为算法的输入要高效率的多。这表明摘要不仅要短于压缩前的文本,而且更能

清晰的表达文本中作者表达情感的极性。

- 6 -

�

中国科技论文在线

http://www.paper.edu.cn

为了训练句子级主客观检测器,前人的研究都是要通过用大量标注为主观或者客观的句

子来作为训练数据集。众所周知,人工标注数据是非常耗废时间和精力的。我们从大量未标

注的电影评论句子中自动注出主观句子和客观句子作为主客观分类器的训练数据集。据我们

所知,前人还没有研究过把文本情感极性分类和自动标注主客观句子相结合。

195

对于未来的工作,我们将深入研究如何去利用句子的邻近度信息,或者提出更好的计算

句子之间相似度的方法去改善基于最小割模型的主客观检测器。我们还将注意力转移到短文

本的情感分析任务上,比如新媒体或者微博。

跨领域的情感分析也是近年来非常火热的研究方向,我们也将深入研究适合跨领域文本

200

情感分析的机器学习模型。

致谢

感谢张宪超教授的细心指导,感谢实验室的师兄弟给予的关怀和帮助。

[参考文献] (References)

205

210

215

[1] Janyce W, Theresa W, Diane L. Combining low-level and summary representations of opinions for

multi-perspective question answering[C]. In AAAI Spring Symposium on New Directions in Question Answering,

2003. 20-27

[2] Pang B, Lillian L, Shivakumar V. Thumbs up? sentiment classification using machine learning techniques[C].

In EMNLP, 2002. 79-86.

[3] Janyce W, Janyce M. Tracking point of view in narrative[J]. Computational Linguistics, 1994, 20(2):233-287

[4] Avrim B, Shuchi C. Learning from labeled and unlabeled data using graph mincuts[C]. In Proceedings of

ICML, 2001. 19-26

[5] Riloff E, Janyce W. Learning extraction patterns for subjective expressions[C]. In Proceedings of EMNLP,

2003. 105-112

[6] Peter T.Thumbs up or thumbs down? Semantic orientation applied to unsupervised classification of reviews[C].

In Proceedings of the Association for Computational Linguistics (ACL), 2002. 417-424.

[7] Pang B, Lillian L. A sentimental education: Sentiment analysis using subjectivity summarization based on

minimum cuts[C]. In Proceedings of the ACL, 2004. 271-278.

- 7 -

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc