数据分析与知识发现

Data Analysis and Knowledge Discovery

ISSN 2096-3467,CN 10-1478/G2

《数据分析与知识发现》网络首发论文

题目:

作者:

网络首发日期: 2020-06-03

引用格式:

基于 BERT 模型的中文医学文献分类研究

赵旸,张智雄,刘欢,丁良萍

赵旸,张智雄,刘欢,丁良萍.基于 BERT 模型的中文医学文献分类研究.数

据分析与知识发现.

http://kns.cnki.net/kcms/detail/10.1478.G2.20200603.1457.004.html

网络首发:在编辑部工作流程中,稿件从录用到出版要经历录用定稿、排版定稿、整期汇编定稿等阶

段。录用定稿指内容已经确定,且通过同行评议、主编终审同意刊用的稿件。排版定稿指录用定稿按照期

刊特定版式(包括网络呈现版式)排版后的稿件,可暂不确定出版年、卷、期和页码。整期汇编定稿指出

版年、卷、期、页码均已确定的印刷或数字出版的整期汇编稿件。录用定稿网络首发稿件内容必须符合《出

版管理条例》和《期刊出版管理规定》的有关规定;学术研究成果具有创新性、科学性和先进性,符合编

辑部对刊文的录用要求,不存在学术不端行为及其他侵权行为;稿件内容应基本符合国家有关书刊编辑、

出版的技术标准,正确使用和统一规范语言文字、符号、数字、外文字母、法定计量单位及地图标注等。

为确保录用定稿网络首发的严肃性,录用定稿一经发布,不得修改论文题目、作者、机构名称和学术内容,

只可基于编辑规范进行少量文字的修改。

出版确认:纸质期刊编辑部通过与《中国学术期刊(光盘版)》电子杂志社有限公司签约,在《中国

学术期刊(网络版)》出版传播平台上创办与纸质期刊内容一致的网络版,以单篇或整期出版形式,在印刷

出版之前刊发论文的录用定稿、排版定稿、整期汇编定稿。因为《中国学术期刊(网络版)》是国家新闻出

版广电总局批准的网络连续型出版物(ISSN 2096-4188,CN 11-6037/Z),所以签约期刊的网络版上网络首

发论文视为正式出版。

�

网络首发时间:2020-06-03 15:23:52

网络首发地址:http://kns.cnki.net/kcms/detail/10.1478.G2.20200603.1457.004.html

基于 BERT 模型的中文医学文献分类研究

赵旸 1,2,4 张智雄*1,2,3,4 刘欢 1,2,4 丁良萍 1,2,4

1 (中国科学院文献情报中心 北京 100190)

2(中国科学院大学经济与管理学院图书情报与档案管理系 北京 100190)

3(中国科学院武汉文献情报中心 武汉 430071)

4(科技大数据湖北省重点实验室 武汉 430071)

摘要:[目的] 探究 BERT 中文基础模型(BERT-Base-Chinese)和 BERT 中文医学预训练模型

(BERT-Re-Pretraining-Med-Chi)在中文医学文献分类上的分类效果及差异原因。[方法] 本

研究以 34 万篇中文医学文献摘要为医学文本预训练语料,分别以 16,000 和 32,000 条中文医

学文献摘要为分类的训练样本,并以另外的 3200 条摘要作为测试样本,利用 BERT 的两个

模型来进行中文医学文献分类研究,并以 SVM 方法作为对比基准。[结果] BERT 的两种模

型在分类效果上均优于 SVM 模型,两种模型的 F1 值均比 SVM 模型高出 5%左右;

BERT-Re-Pretraining-Med-Chi 模型在两种样本量下 F1 值分别达到 0.8390 和 0.8607,均为三者

中最好的分类效果。[局限] 本研究仅对中图分类号 R 下的 16 个类别进行了分类研究,其余

4 个类别因数据量过少等原因而未纳入分类体系中。[结论] BERT-Re-Pretraining-Med-Chi 方

法能够显著提升医学文献的分类效果;基于 BERT 的深度学习方法在多类别大规模训练集

下更能体现其分类的优越性。

关键词: 深度学习;BERT;文献分类;预训练模型

分类号: G202;TP3

DOI: 10.11925/infotech.2096-3467.2019.1238

Research on Chinese Medical Literatures

Classification Based on BERT Model

Zhao Yang1,2,4 Zhang Zhixiong1,2,3,4 Liu Huan1,2,4 Ding Liangping1,2,4

1 (National Science Library, Chinese Academy of Sciences, Beijing 100190)

2 (Department of Library Information and Archives Management,

University of Chinese Academy of Science, Beijing 100190)

3 (Wuhan Library, Chinese Academy of Sciences, Wuhan 430071)

4 (Hubei Key Laboratory of Big Data in Science and Technology, Wuhan 430071)

Abstract:[Objective] This paper is to explore the classification effect on the Chinese medical

literatures based on the BERT-Base-Chinese model and the BERT Chinese medical pre-training

model(BERT-Re-Pretraining-Med-Chi) and analyze the difference in classification effect.

[Methods] This study used 340,000 Chinese medical literature abstracts to build a medical text

pre-training corpus, with 16,000 and 32,000 Chinese medical literature abstracts as training

*通讯作者:张智雄,OCRID: 0000-0003-1596-7487,E-mail:zhangzhx@mail.las.ac.cn。

�

samples, and another 3200 abstracts as test samples. The two models of BERT were used to study

the classification of Chinese medical literature, and the SVM method was used as a comparison

benchmark. [Results] Among the three methods used in the experiment, the two models of BERT

are better than the SVM model in classification effect, and the average F1-score is about 5%

higher than the SVM model in the case of two sample sizes; the F1-score of the

BERT-Re-Pretraining-Med-Chi model under the two sample sizes respectively reaches 0.8390 and

0.8607, which are the best classification effects among the three. [Limitations] This study only

classified 16 categories of the medical and health categories in the Chinese Library Classification,

but there were 20 categories in this field, the other 4 categories were not included in the

classification due to the small amount of data.[Conclusions] The BERT-Re-Pretraining-Med-Chi

model can significantly improve the classification effect of medical literatures; the BERT-based

deep learning method can better reflect the superiority of classification under multi-class and

large-scale training set.

Keywords:deep learning, BERT, literatures classification, pre-training model

1 引言

文献分类是图书馆学情报学的一个传统问题。当前的文献分类主要以《中国

图书馆分类法》为依据,如何充分利用当前机器学习的新技术方法,以文献数据

库中已广泛存在的、基于中图法的大规模文摘分类数据为训练语料,实现文献自

动分类效果的提升,是当前图书馆学情报学需要迫切解决的一个问题。

在目前的自动分类研究中,基于传统的机器学习方法和基于深度学习的机器

学习方法均受到关注。在基于传统机器学习的自动方法中,有朴素贝叶斯模型(El

H et al.[1])、支持向量机模型(Wei Ou[2]、Jafari Ashkan[3]、陈玉芹[4]、白小明[5]、

王昊[6]、杨敏[7])、K-邻近模型(K-Nearest Neighbor,KNN)(陈玉芹[4]、白小明

[5])、LDA(Latent Dirichlet Allocation)模型(李湘东[8][9])等方法被广泛应用。而在

基于深度学习的自动分类方法中,有卷积神经网络(Zhang S[10],Sun Xingping [11],

郭利敏[12])、双向长短期记忆网络模型(朱肖颖[13]、马建红[14])等相关研究。

BERT[15]是谷歌公司 AI 团队在 2018 年 10 月发布的一种基于深度学习的新

的语言表示模型,其全称是 Bidirectional Encoder Representation from Transformers,

意为基于转换器的双向编码表征模型,它在 11 种不同的自然语言处理(NLP)

测试中创出最佳成绩,是 NLP 领域近期最重要的进展。

基于 BERT 模型的自然语言处理任务通过两个过程来实现,即预训练

(Pre-training)过程和微调(Fine-tuning)过程。其中,预训练过程利用大规模

没有标注过的文本语料,通过无监督训练方法,实现在深层双向神经网络中文本

内容的深层向量表示,形成相应文本的预训练模型;而微调过程则建立在上述基

础之上,以特定的经过标注的语料为输入,在模型上再加入一个输出层,即可创

建出一个可用的深度学习模型来实现特定的自然语言处理任务。BERT 团队发布

的中文预训练模型(BERT-Base,Chinese)可以实现中文文献的分类任务。

而目前也有一些基于 BERT 的分类应用研究,大多数还是基于 BERT 的微调

过程,如胡春涛[16]使用迁移学习策略将模型应用于舆情文本分类任务、Yao

Liang[17]用 BERT 和领域特定语料库对中医临床记录进行分类、Zhang XH[18]利用

BERT 实体抽取以提取乳腺癌的概念及其属性;Jwa H[19]提出 exBAKE,即利用

BERT 模型分析的新闻标题和内容之间的关系,以检测假新闻文本。也有一些研

�

究开始基于中文文献实现预训练模型,如王英杰等[20]基于 BERT 的预训练过程,

以中文百科为主,构建了面向科技文本分析的预训练语言表征模型来进行分类实

验。

由于目前 BERT 的中文预训练模型主要以中文百科等为语料,没有充分学习

到中文医学科技文献中的语言特征。因此本研究在 BERT 自身语言模型的基础之

上,进一步加入一定体量的中文医学文献进行预训练,观察其是否能够进一步提

升医学文献的分类效果。

具体而言,本文探究基于 BERT 的两个模型,即 BERT 自带的中文基础模

型(BERT-Base-Chinese)和笔者加入 34 万篇中文医学文献摘要之后所生成的

BERT 中文医学预训练模型(BERT-Re-Pretraining-Med-Chi)在中文医学文献分

类上的分类效果,并分析效果差异的原因。

2 研究设计

本研究基于三个模型,即 BERT 自带的中文基础模型(BERT-Base-Chinese)、

笔者加入 34 万篇中文医学文献摘要之后所生成的 BERT 中文医学预训练模型

(BERT-Re-Pretraining-Med-Chi)、以及传统的机器学习方法 SVM 模型,采用

相同的语料,设计了相应的分类实验,探究三种模型的分类效果,并分析分类效

果的影响因素。

2.1 训练语料的构建及样本选择

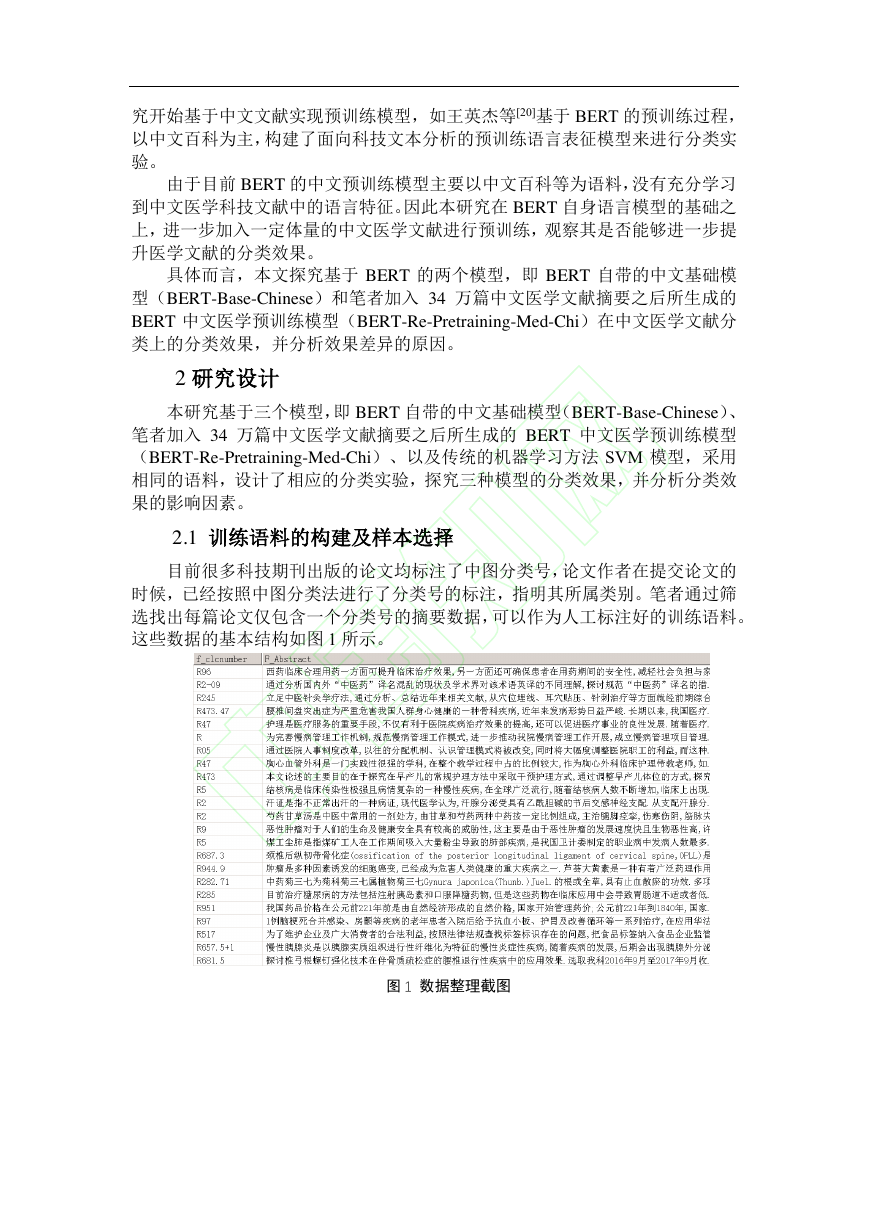

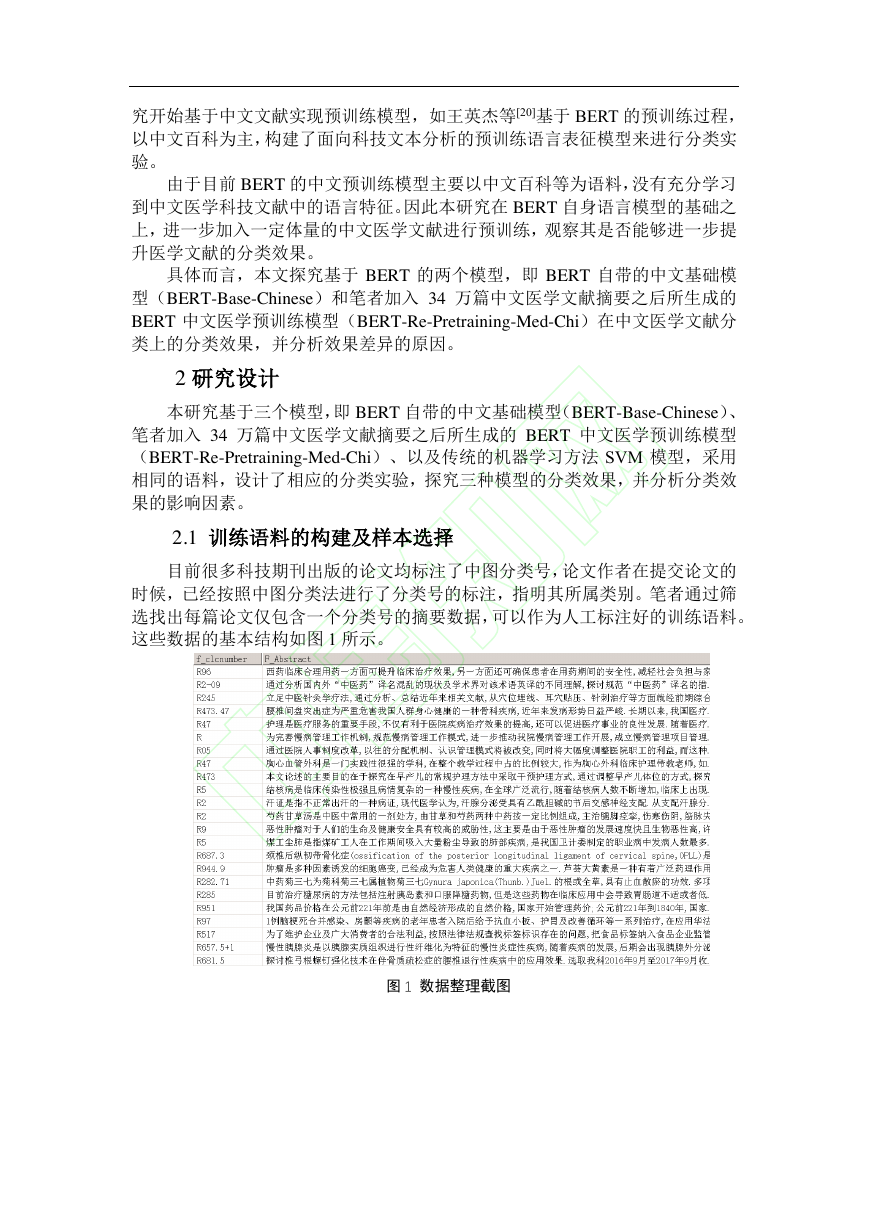

目前很多科技期刊出版的论文均标注了中图分类号,论文作者在提交论文的

时候,已经按照中图分类法进行了分类号的标注,指明其所属类别。笔者通过筛

选找出每篇论文仅包含一个分类号的摘要数据,可以作为人工标注好的训练语料。

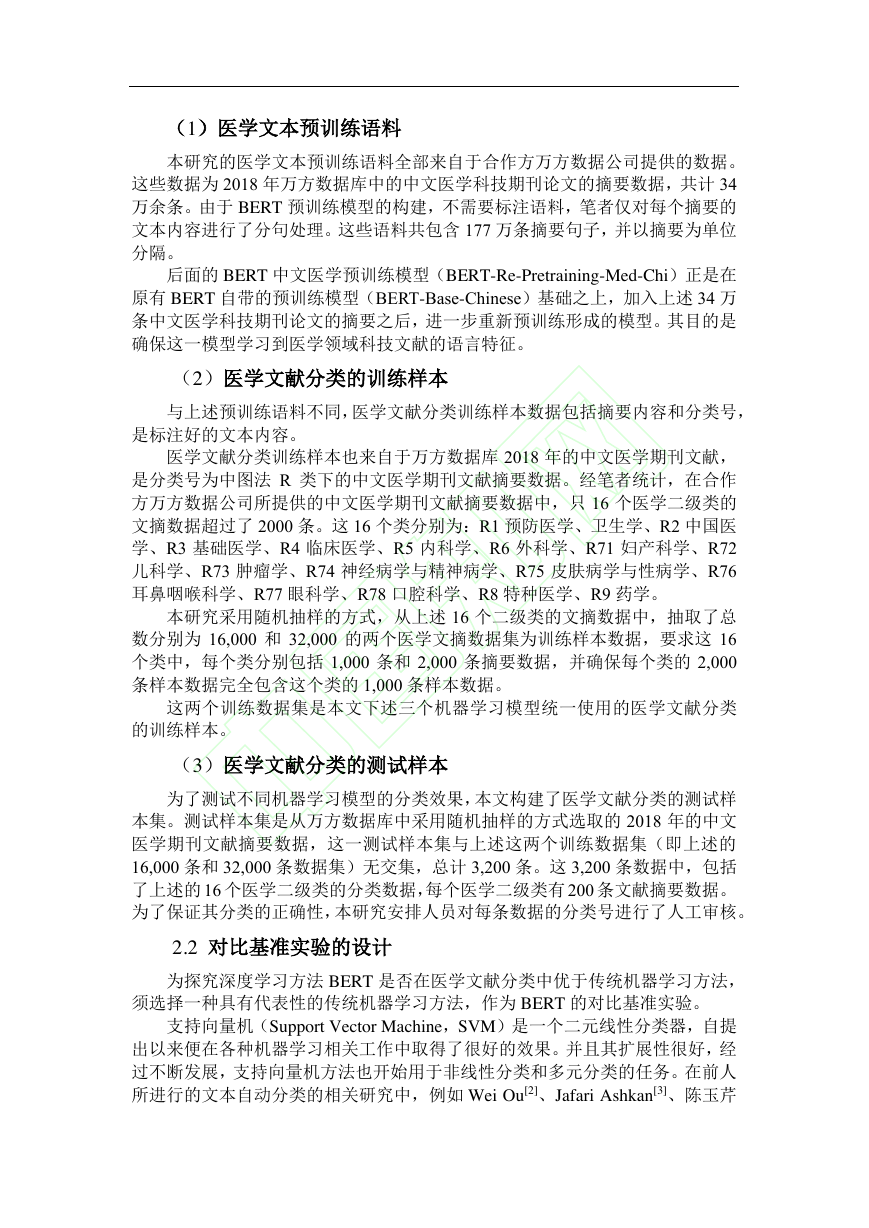

这些数据的基本结构如图 1 所示。

图 1 数据整理截图

�

(1)医学文本预训练语料

本研究的医学文本预训练语料全部来自于合作方万方数据公司提供的数据。

这些数据为 2018 年万方数据库中的中文医学科技期刊论文的摘要数据,共计 34

万余条。由于 BERT 预训练模型的构建,不需要标注语料,笔者仅对每个摘要的

文本内容进行了分句处理。这些语料共包含 177 万条摘要句子,并以摘要为单位

分隔。

后面的 BERT 中文医学预训练模型(BERT-Re-Pretraining-Med-Chi)正是在

原有 BERT 自带的预训练模型(BERT-Base-Chinese)基础之上,加入上述 34 万

条中文医学科技期刊论文的摘要之后,进一步重新预训练形成的模型。其目的是

确保这一模型学习到医学领域科技文献的语言特征。

(2)医学文献分类的训练样本

与上述预训练语料不同,医学文献分类训练样本数据包括摘要内容和分类号,

是标注好的文本内容。

医学文献分类训练样本也来自于万方数据库 2018 年的中文医学期刊文献,

是分类号为中图法 R 类下的中文医学期刊文献摘要数据。经笔者统计,在合作

方万方数据公司所提供的中文医学期刊文献摘要数据中,只 16 个医学二级类的

文摘数据超过了 2000 条。这 16 个类分别为:R1 预防医学、卫生学、R2 中国医

学、R3 基础医学、R4 临床医学、R5 内科学、R6 外科学、R71 妇产科学、R72

儿科学、R73 肿瘤学、R74 神经病学与精神病学、R75 皮肤病学与性病学、R76

耳鼻咽喉科学、R77 眼科学、R78 口腔科学、R8 特种医学、R9 药学。

本研究采用随机抽样的方式,从上述 16 个二级类的文摘数据中,抽取了总

数分别为 16,000 和 32,000 的两个医学文摘数据集为训练样本数据,要求这 16

个类中,每个类分别包括 1,000 条和 2,000 条摘要数据,并确保每个类的 2,000

条样本数据完全包含这个类的 1,000 条样本数据。

这两个训练数据集是本文下述三个机器学习模型统一使用的医学文献分类

的训练样本。

(3)医学文献分类的测试样本

为了测试不同机器学习模型的分类效果,本文构建了医学文献分类的测试样

本集。测试样本集是从万方数据库中采用随机抽样的方式选取的 2018 年的中文

医学期刊文献摘要数据,这一测试样本集与上述这两个训练数据集(即上述的

16,000 条和 32,000 条数据集)无交集,总计 3,200 条。这 3,200 条数据中,包括

了上述的 16 个医学二级类的分类数据,每个医学二级类有 200 条文献摘要数据。

为了保证其分类的正确性,本研究安排人员对每条数据的分类号进行了人工审核。

2.2 对比基准实验的设计

为探究深度学习方法 BERT 是否在医学文献分类中优于传统机器学习方法,

须选择一种具有代表性的传统机器学习方法,作为 BERT 的对比基准实验。

支持向量机(Support Vector Machine,SVM)是一个二元线性分类器,自提

出以来便在各种机器学习相关工作中取得了很好的效果。并且其扩展性很好,经

过不断发展,支持向量机方法也开始用于非线性分类和多元分类的任务。在前人

所进行的文本自动分类的相关研究中,例如 Wei Ou[2]、Jafari Ashkan[3]、陈玉芹

�

[4]、白小明[5]、王昊[6]、杨敏[7]等的研究中,都使用了 SVM 模型,并且在分类实

验中表现出了不错的实验效果。这里选择支持向量机方法进行对比基准实验。

在进行 SVM 分类实验时,首先使用结巴分词对中文语料进行处理,然后设

置 N 元词取值,通过简单词频统计或者使用 TF-IDF 对词频进行加权,将 N 元词

转化为特征向量,最后输入到 SVM 模型,使用 one-vs-rest 策略训练中文医学分

类模型。实验通过控制变量的方法,探究了 N-gram 取值、词频加权方法等因素

对于模型性能的影响,最终选取性能最好的模型作为深度学习实验的对比基准。

2.3 基于 BERT 中文基础模型的分类实验设计

本研究中 BERT-Base-Chinese 模型的分类方法为直接调用 BERT 中文基础预

训练模型,加入分类训练样本对模型进行微调后将该模型用于完成下游的分类任

务。

在进行 BERT-Base-Chinese 模型的实验时,笔者分别在训练轮数、批训练大

小、学习率等参数的设置上进行了探索,找到使模型分类效果较好的参数,并在

样本量为 16,000 和 32,000 的情况下进行了对比实验。

2.4 基于 BERT 中文医学预训练模型的分类实验设计

在进行 BERT-Re-Pretraining-Med-Chi 模型的实验时,笔者首先构建了医学

文本预训练语料库,而词汇文件和配置文件仍继续沿用 BERT 所提供的中文基础

文件,并对该预训练模型在批训练大小等参数设置上进行了调优。

微调训练则与上述过程一致,笔者分别在训练轮数、批训练大小、学习率等

参数的设置上进行了探索,找到使模型分类效果较好的参数,并在样本量为

16,000 和 32,000 的情况下进行了对比实验。

2.5 分类效果指标

本研究通过对分类结果进行评估以判断其分类效果,查准率(Precision,P),

又称精确度,用于衡量被预测为正样本的样本中正确率的高低;查全率(Recall,

R),又称召回率,用于衡量实际为正样本的样本中被正确分类的概率;F1 值

(F1-score)综合了查全率和查准率两项指标,F1 值越大,则表示分类的效果越

好。本研究通过对三种分类模型的查全率、查准率、F1 值进行比较,以分析模

型的分类效果。

3 实验步骤及结果分析

根据以上的实验设计思路,分别构建了 SVM 模型、BERT-Base-Chinese 和

BERT-Re-Pretraining-Med-Chi 三种模型。利用选择好的训练样本和测试集,进行

了基于三种方法的分类实验。以下是具体的实验步骤和实验结果。

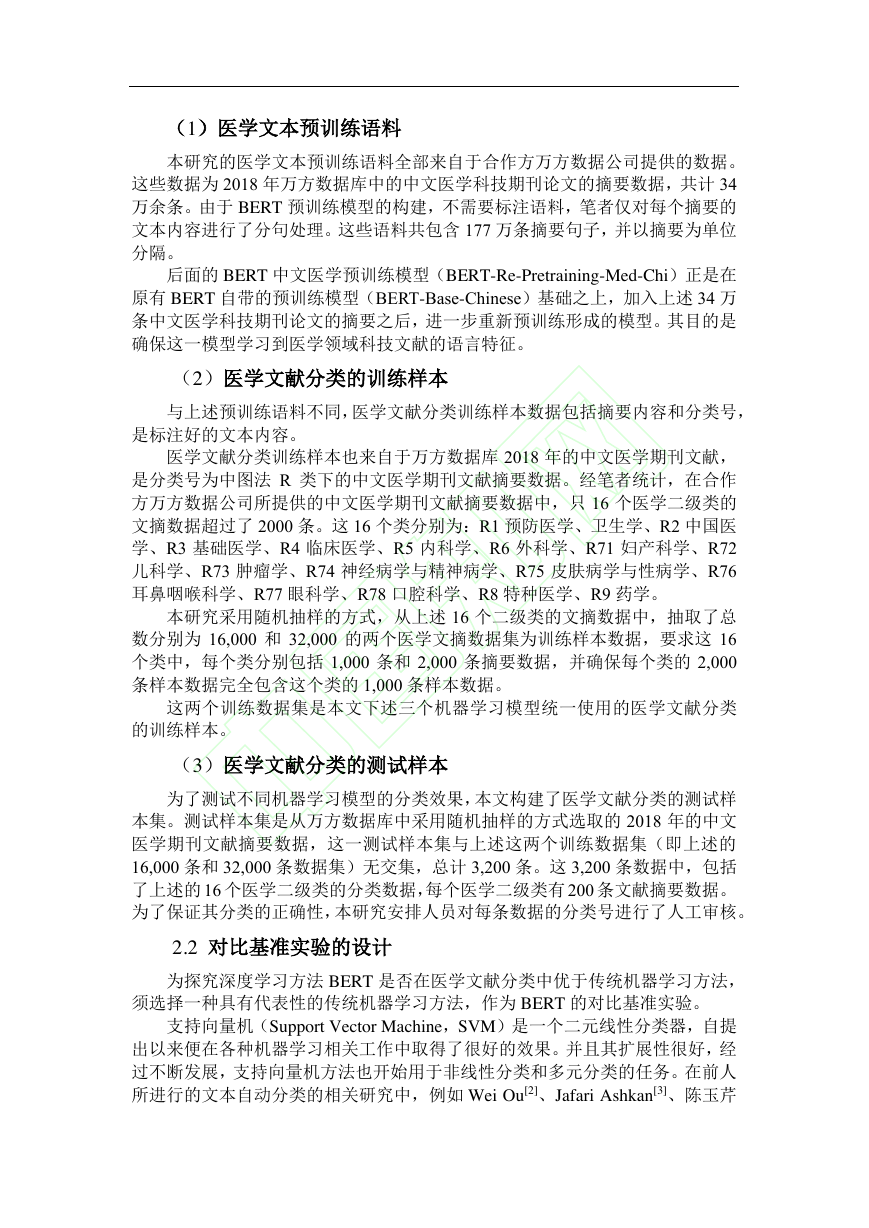

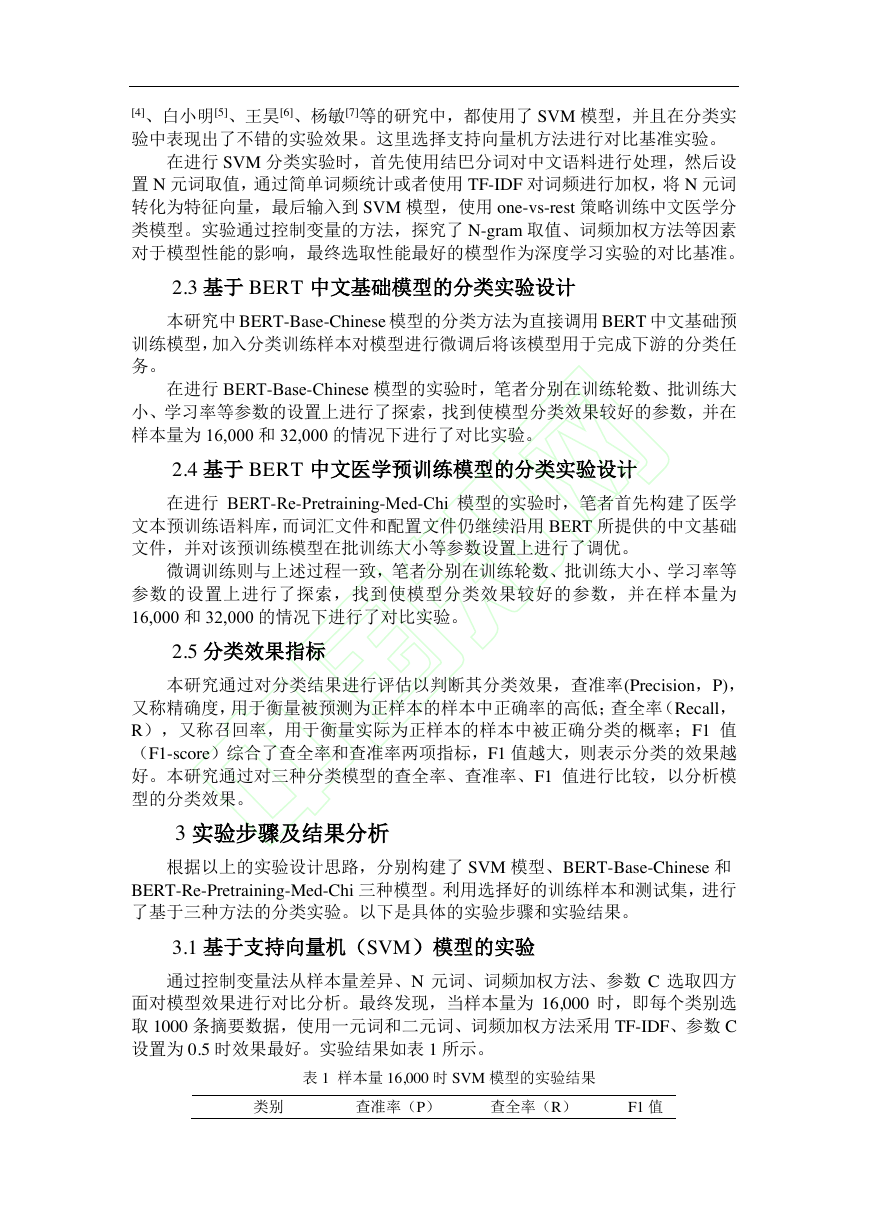

3.1 基于支持向量机(SVM)模型的实验

通过控制变量法从样本量差异、N 元词、词频加权方法、参数 C 选取四方

面对模型效果进行对比分析。最终发现,当样本量为 16,000 时,即每个类别选

取 1000 条摘要数据,使用一元词和二元词、词频加权方法采用 TF-IDF、参数 C

设置为 0.5 时效果最好。实验结果如表 1 所示。

表 1 样本量 16,000 时 SVM 模型的实验结果

类别

查准率(P)

查全率(R)

F1 值

�

0.62

0.80

0.83

0.92

0.96

0.91

0.82

0.65

0.56

0.91

0.70

0.72

0.82

0.78

0.78

0.78

0.85

0.49

0.92

0.90

0.96

0.89

0.47

0.80

0.75

0.59

0.58

0.72

0.91

0.81

0.85

0.85

0.72

0.61

0.87

0.91

0.96

0.90

0.60

0.71

0.64

0.72

0.64

0.72

0.86

0.80

0.81

0.82

R1

R2

R3

R4

R5

R6

R71

R72

R73

R74

R75

R76

R77

R78

R8

R9

平均值

0.7850

0.7713

0.7681

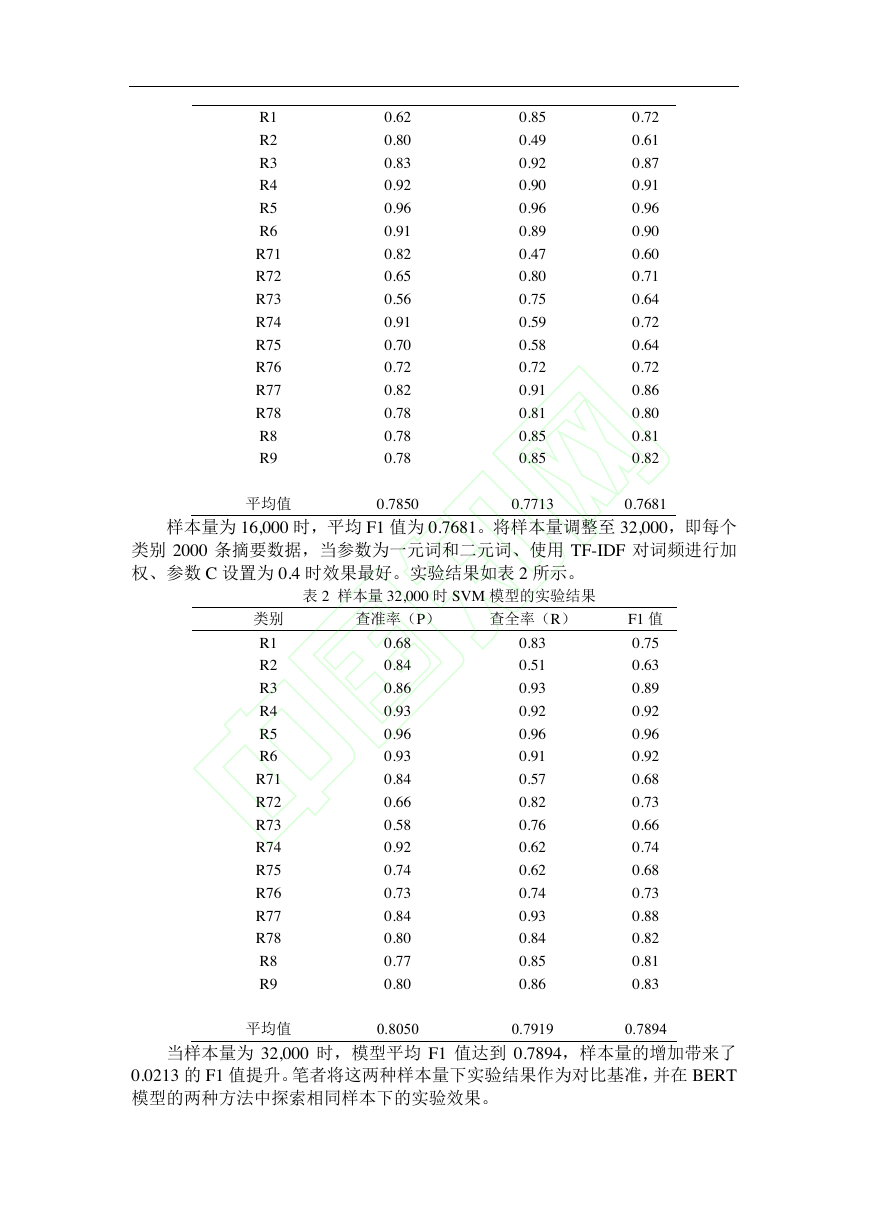

样本量为 16,000 时,平均 F1 值为 0.7681。将样本量调整至 32,000,即每个

类别 2000 条摘要数据,当参数为一元词和二元词、使用 TF-IDF 对词频进行加

权、参数 C 设置为 0.4 时效果最好。实验结果如表 2 所示。

表 2 样本量 32,000 时 SVM 模型的实验结果

类别

查准率(P)

查全率(R)

F1 值

R1

R2

R3

R4

R5

R6

R71

R72

R73

R74

R75

R76

R77

R78

R8

R9

0.68

0.84

0.86

0.93

0.96

0.93

0.84

0.66

0.58

0.92

0.74

0.73

0.84

0.80

0.77

0.80

0.83

0.51

0.93

0.92

0.96

0.91

0.57

0.82

0.76

0.62

0.62

0.74

0.93

0.84

0.85

0.86

0.75

0.63

0.89

0.92

0.96

0.92

0.68

0.73

0.66

0.74

0.68

0.73

0.88

0.82

0.81

0.83

平均值

0.8050

0.7919

0.7894

当样本量为 32,000 时,模型平均 F1 值达到 0.7894,样本量的增加带来了

0.0213 的 F1 值提升。笔者将这两种样本量下实验结果作为对比基准,并在 BERT

模型的两种方法中探索相同样本下的实验效果。

�

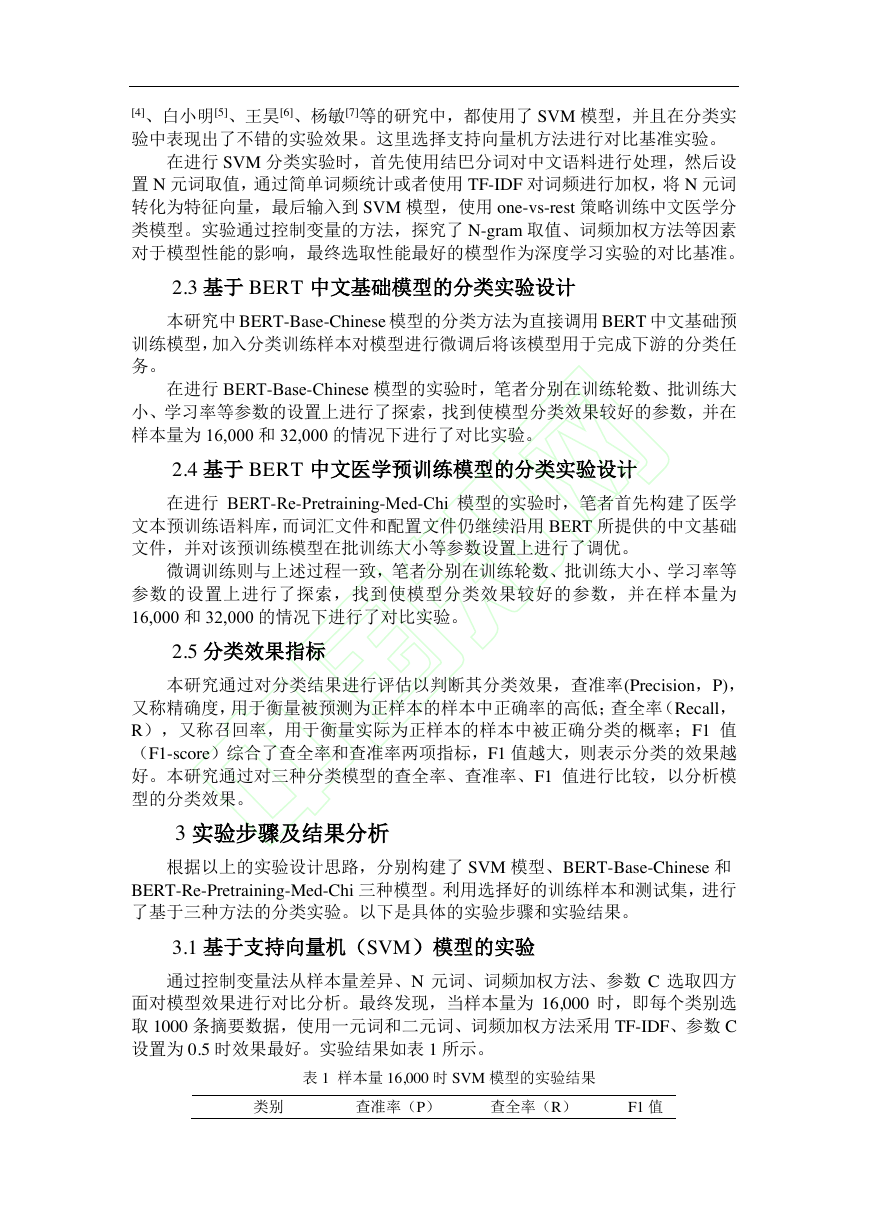

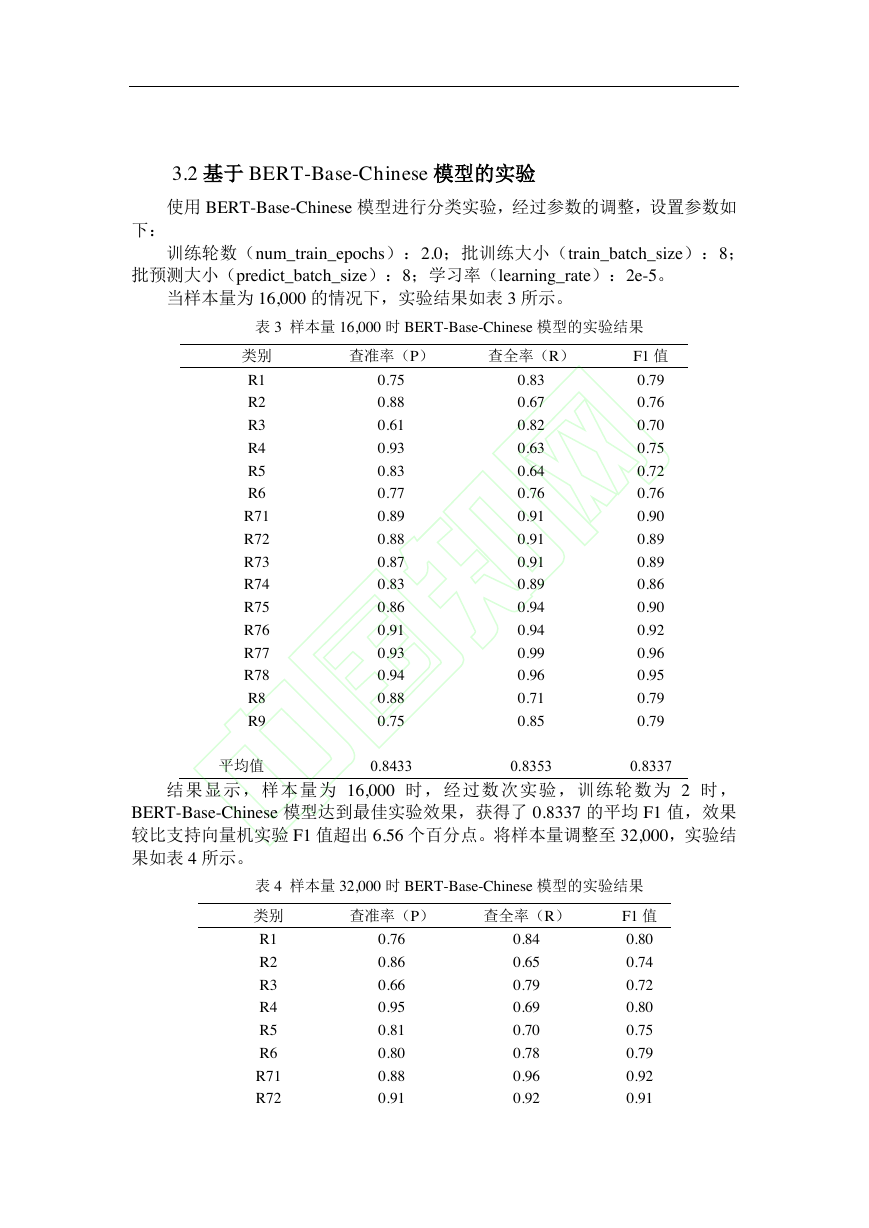

3.2 基于 BERT-Base-Chinese 模型的实验

使用 BERT-Base-Chinese 模型进行分类实验,经过参数的调整,设置参数如

下:

训练轮数(num_train_epochs):2.0;批训练大小(train_batch_size):8;

批预测大小(predict_batch_size):8;学习率(learning_rate):2e-5。

当样本量为 16,000 的情况下,实验结果如表 3 所示。

表 3 样本量 16,000 时 BERT-Base-Chinese 模型的实验结果

类别

查准率(P)

查全率(R)

F1 值

R1

R2

R3

R4

R5

R6

R71

R72

R73

R74

R75

R76

R77

R78

R8

R9

平均值

0.75

0.88

0.61

0.93

0.83

0.77

0.89

0.88

0.87

0.83

0.86

0.91

0.93

0.94

0.88

0.75

0.83

0.67

0.82

0.63

0.64

0.76

0.91

0.91

0.91

0.89

0.94

0.94

0.99

0.96

0.71

0.85

0.79

0.76

0.70

0.75

0.72

0.76

0.90

0.89

0.89

0.86

0.90

0.92

0.96

0.95

0.79

0.79

0.8433

0.8353

0.8337

结果显示,样本量为 16,000 时,经过数次实验,训练轮数为 2 时,

BERT-Base-Chinese 模型达到最佳实验效果,获得了 0.8337 的平均 F1 值,效果

较比支持向量机实验 F1 值超出 6.56 个百分点。将样本量调整至 32,000,实验结

果如表 4 所示。

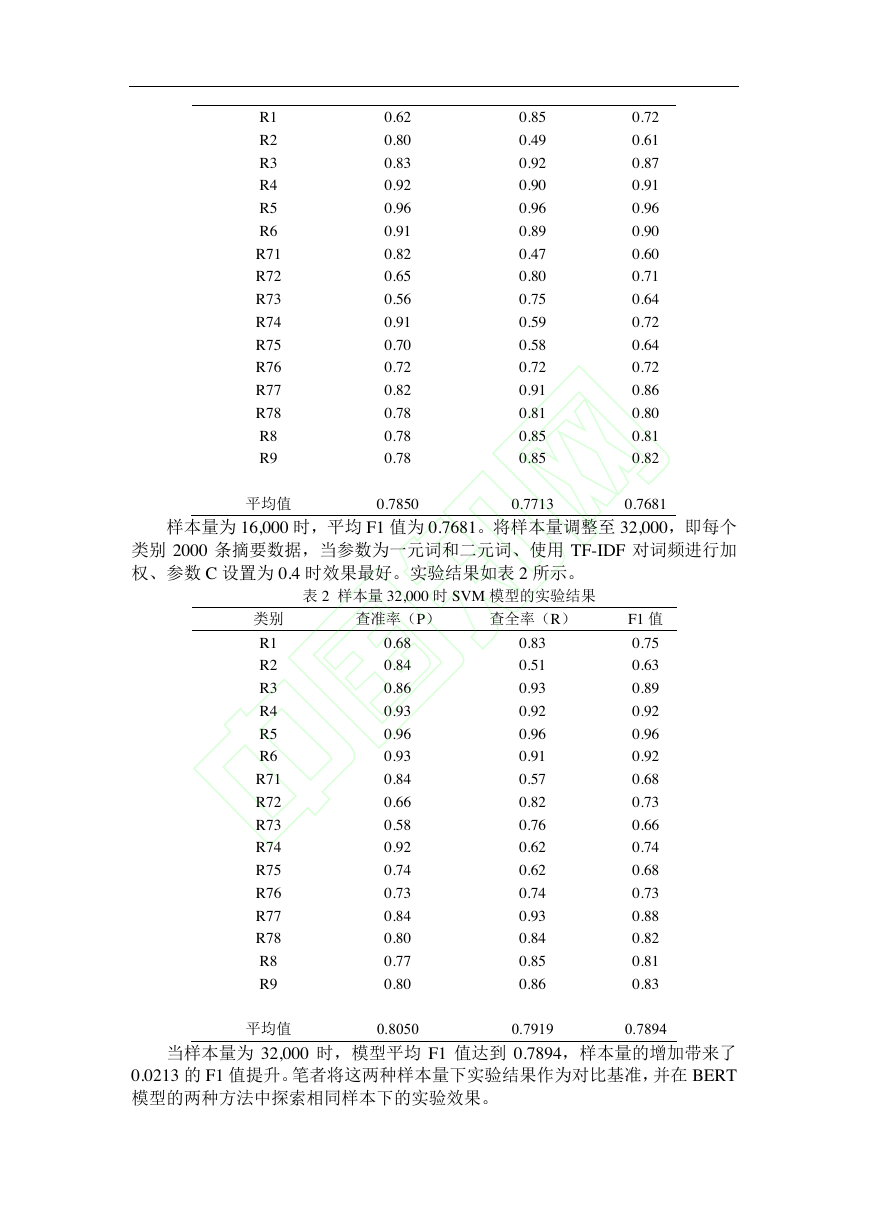

表 4 样本量 32,000 时 BERT-Base-Chinese 模型的实验结果

类别

查准率(P)

查全率(R)

F1 值

R1

R2

R3

R4

R5

R6

R71

R72

0.76

0.86

0.66

0.95

0.81

0.80

0.88

0.91

0.84

0.65

0.79

0.69

0.70

0.78

0.96

0.92

0.80

0.74

0.72

0.80

0.75

0.79

0.92

0.91

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc