110

2019,55(2)

Computer Engineering and Applications 计算机工程与应用

基于对抗训练和卷积神经网络的面部图像修复

刘 昱,刘厚泉

中国矿业大学 计算机科学与技术学院,江苏 徐州 221116

摘 要:为了有效地修复大面积破损的面部图像,使用了解码器-编码器结构的卷积神经网络作为生成模型,并在其

部分层之间增加 skip-connection,以增强生成模型的结构信息预测能力,同时引入对抗训练策略优化生成模型。该

模型首先训练一个判别模型识别真实图像,再利用其判别待修复图像输入生成模型后所得到的输出是否为真实,以

此为生成模型提供优化梯度。结合了卷积神经网络的结构信息预测能力和 GANs 对抗策略的优化能力,提高了图像

补全的效果。在 CelebA 人脸数据集上进行的实验结果表明,该方法在补全大面积破损的图像任务上性能明显优于

其他方法。

关键词:深度学习 ;生成对抗网络(GANs);卷积神经网络(CNN);图像补全 ;跳跃连接

文献标志码:A 中图分类号:TP391

doi:10.3778/j.issn.1002-8331.1805-0248

刘昱,刘厚泉 . 基于对抗训练和卷积神经网络的面部图像修复 . 计算机工程与应用,2019,55(2):110-115.

LIU Yu, LIU Houquan. Facial image restoration based on adversarial training and convolutional neural network. Computer

Engineering and Applications, 2019, 55(2):110-115.

Facial Image Restoration Based on Adversarial Training and Convolutional Neural Network

LIU Yu, LIU Houquan

School of Computer Science and Technology, China University of Mining and Technology, Xuzhou, Jiangsu 221116, China

Abstract:In order to repair facial images with large areas damaged efficiently, a method is introduced that using encoder-

decoder structured Convolutional Neural Network(CNN)as the generative model, and skip-connections are added between

partial layers of it to enhance its structured prediction power, at the same time, an anti-training strategy is introduced to

optimize the generative model. This model first trains the discriminator to identify the real image, and then uses the dis-

criminator to judge whether the generator’s output which obtained after the damaged image is input to the generator is

true or faker. The discriminator is used to provide gradient to the generator to optimize the generator. Combining the struc-

tured prediction power of CNN and the optimization ability of GANs’antagonism strategy, it improves the results of

image completion obviously. The experimental results on the CelebA face dataset show that the proposed method is superior

to other methods in repairing images with large areas of damage.

Key words:deep learning; Generative Adversarial Networks(GANs); Convolutional Neural Network(CNN); image com-

pletion; skip-connection

1 引言

在信息时代,图像是信息的主要载体之一。在分享

图像之前,用户或多或少会对图像做一些处理操作,如

擦除图像中的一些元素、调整图像中物体位置或者移除

图像中的一部分等,这些操作都会造成图像信息的损

失。如何自动地复原这些破损的视觉信息成为计算机

视觉领域一个热门的课题。

已存在的传统的图像修复方法主要有两种[1]:一种

是基于图像分解的修复技术[2-6]。其主要思想是将图像

分解为结构部分和纹理部分,其中结构部分用修复算法

修补,纹理部分用纹理合成的方法填充。另一种方法是

基于块的纹理合成技术来填充丢失的信息[7-9],其主要思

想是首先从待修补区域的边界上选取一个像素点,同时

以该点为中心,根据图像的纹理特征,选取大小合适的

作者简介:刘昱(1992—),男,硕士研究生,CCF会员,主要研究领域为机器学习,深度学习,E-mail:klausly@yeah.net;刘厚泉(1964—),

男,博士,教授,主要研究领域为虚拟现实。

收稿日期:2018-05-15 修回日期:2018-10-22 文章编号:1002-8331(2019)02-0110-06

CNKI 网络出版:2018-11-01, http://kns.cnki.net/kcms/detail/11.2127.TP.20181030.1040.023.html

计算机工程与应用www.ceaj.org�

刘 昱,等:基于对抗训练和卷积神经网络的面部图像修复

2019,55(2)

111

纹理块,然后在待修补区域的周围寻找与之最相近的纹

理匹配块来替代该纹理块。

传统方法在修复很小很细微的破损部分时能得到

不错的效果,但当破损区域扩大的时候其效果变得不尽

如人意。其主要根源在于传统方法无法像人一样理解

图像的内容,而深度卷积神经网络的出现解决了这一难

题。深度卷积神经网络通过将图像逐层抽象的方式提

取图像的特征映射(feature map),从而获得理解图像内

容的能力。深度卷积神经网络在计算机视觉和图形图

像处理等领域已有广泛的应用,并且也取得了不错的进

展[10],在图像分类、目标检测等任务,深度神经网络的准

确率已经明显高于人工处理。在图像修复方面,Google

团队提出像素循环神经网络(Pixel RNNs)[11],使用深度

神经网络进行像素点预测,其变换图像形状的操作仍然

可以看作是扩散机制的一种延伸,这个方法对整体图像

均匀变化的缺失图像修复效果比较明显,但对于结构性

信息比较强的图像(如人脸)其孔洞修复效果并不理想。

Context Encoder[12]是第一个利用深度生成网络处理缺

失图像的模型,它利用自动编码机(Auto Encoder)[13]的

预测能力,根据缺失图像周围已知的图像信息预测缺失

图像的内容,从实验结果上能明显地看出该模型对图像

内容的整体有了一定的理解能力,能合理地对图像缺失

的内容进行预测,这是一个很大的进步。但是该模型生

成的图像略显粗糙,其预测生成的图像语义与原始图像

也相差很大,导致修复后图像在视觉上并不真实。理论

上,自动编码器通过编码器将原始图像编码成低维特征

编码,再由解码器将低维编码重新映射回原始图像形

式,可以用于处理图像修复工作。深度卷积生成对抗网

络(Deep Convolutional Generative Adversarial Networks,

DCGAN)[14]通过使用在生成器部分使用反卷积的特殊

网络架构,也可以通过生成与待修复图像相似的图像,

使用所生成图像中对应位置的切片补全待修复图像的

方法完成图像补全工作。

本文在卷积神经网络的基础上,结合自动编码器

和 DCGAN 的方法特点,使用编码器-解码器(encoder-

decoder)结构的卷积神经网络[15]作为生成模型,生成与

待修复图像相似的图像;并在生成模型部分层之间增加

跳跃链接(skip-connection)[15- 16],通过对低层卷积抽象

的位置特征的再利用,强化神经网络结构信息的预测

能力,同时防止网络层数增加而导致的梯度弥散问题

与 退 化问题;另一方面引入生成对抗网络(Generative

Adversarial Networks,GANs)[17]的对抗训练策略,通过

“博弈”的方式优化训练生成模型,使生成模型结果更加

清晰。本文方法结合了深度神经网络模仿人脑的理解

力和对抗训练策略优化生成模型时的优势。本文使用

CelebA 和 IMDBWIKI 人脸数据集作为实验集,实验结

果表明本文方法在修复大面积破损的面部图像时比其

他深度学习方法具有更好的性能。

2 本文方法

本文方法的主要思路:通过训练一个生成模型学习

到真实图像的概率分布,同时使用 GANs 中的对抗学习

方法优化生成模型的学习效果。使用训练后的生成模

型根据待修复图像生成与之相似的完整图像,然后从生

成的图像的相对应位置切片补全至待修复图像的缺失

部分以完成修复图像的目标。

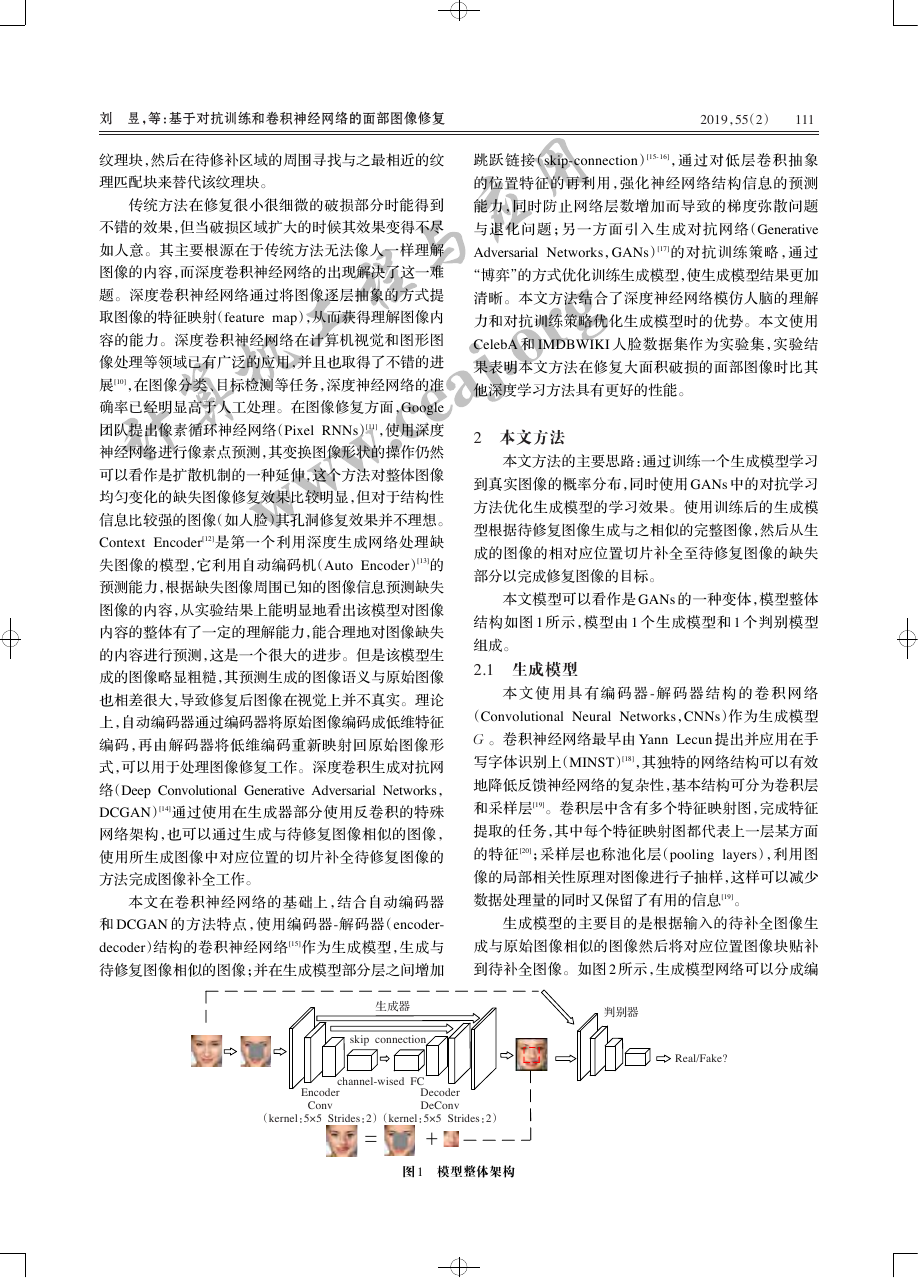

本文模型可以看作是 GANs 的一种变体,模型整体

结构如图 1 所示,模型由 1 个生成模型和 1 个判别模型

组成。

2.1 生成模型

本 文 使 用 具 有 编 码 器 - 解 码 器 结 构 的 卷 积 网 络

(Convolutional Neural Networks,CNNs)作为生成模型

G 。卷积神经网络最早由 Yann Lecun 提出并应用在手

写字体识别上(MINST)[18],其独特的网络结构可以有效

地降低反馈神经网络的复杂性,基本结构可分为卷积层

和采样层[19]。卷积层中含有多个特征映射图,完成特征

提取的任务,其中每个特征映射图都代表上一层某方面

的特征 [20];采样层也称池化层(pooling layers),利用图

像的局部相关性原理对图像进行子抽样,这样可以减少

数据处理量的同时又保留了有用的信息[19]。

生成模型的主要目的是根据输入的待补全图像生

成与原始图像相似的图像然后将对应位置图像块贴补

到待补全图像。如图 2 所示,生成模型网络可以分成编

生成器

skip connection

判别器

Real/Fake?

Encoder

Conv

(kernel:5×5 Strides:2)

(kernel:5×5 Strides:2)

channel-wised FC

Decoder

DeConv

图 1 模型整体架构

计算机工程与应用www.ceaj.org=+�

112

2019,55(2)

Computer Engineering and Applications 计算机工程与应用

skip connection

skip connection

待修复图像 x0

生成器网络

(带有 skip connection 的卷积神经网络)

图 2 生成模型生成图像结构

conv

deconv

生成图像 G(x0)

码器和解码器部分。待修复图像(均匀高斯分布噪声遮

挡作为图像缺失部分)输入至编码器部分编码,这个过

程可以看作是将待修复图像逐层抽象成隐层表征 [21]。

之后再将隐层表征输入解码器生成预测图像。与普

通自动编码器结构不同的 是 ,本文模型在 encoder 和

decoder的中间层使用逐信道全连接(channel-wised fully-

connection)代替全连接。另外在编码器和解码器部分

对应层之间添加了 skip-connection,如图 3 所示,在高层

解码阶段再一次利用对应分辨率的低层编码阶段的输

出,这样做可以为解码器补充编码器下采样阶段损失掉

的部分结构特征信息,强化生成器结构预测能力,而生

成的图像也比没有加 skip-connection 的网络的生成图像

与原始图像更加相似。值得注意的是本文模型在生成

模型中并没有添加池化层,而是在编码和解码阶段分别

使用步长为 2 的卷积和反卷积操作代替池化操作。这

样做很大程度上简化了模型的执行步骤,而对于没有池

化层造成的结构性信息的损失,则通过 skip-connection

操作在编码器编码阶段使用低层 feature map 进行结构

性信息强化。

Encoder-decoder

Skip-connection

图 3 Encoder-decoder 和 Skip-connection

2.2 判别模型

生成模型的训练是为缺失图像生成相似图像,同时

保持重建误差较小。但是这并不能保证生成图像在视

觉上真实,并且与原始图像一致。为保证生成的缺失部

分在视觉上真实引入一个二分类判别网络作为判别模

型 D ,用以判断图像为真实图像或生成图像,效仿原始

GANs 网络引入对抗策略优化生成模型输出。实验证

明引入对抗策略有效地提高了生成图像的细节。

2.3 损失函数

真实图像相似的结果。所以在生成模型部分使用最小

化重建损失的方式训练生成模型。通过最小化重建损

失,优化生成模型根据缺失图像已知区域部分的信息学

习图像整体结构的能力。另一方面,使用对抗损失以使

生成图像部分看起来更加真实,同时也可以从分布中提

取特定信息。

(1)

2

重建损失与传统自动编码器网络相似,通过最小化

编码-解码过程的重建损失优化卷积神经网络。本文图

像补全方法的主要思路是,根据输入的待补全图像,使

用网络 F 生成图像 F(x0) 去逼近真实图像 xt 。即对于

每个待修复图像 x0 生成网络的重建损失为:

x0,x =

)

F(x0) - x 2

L

rec(

本文采用平方 L2 范数作为重建损失,因为 L2 范数

对异常值有较大的惩罚,所以使用 L2 范数的模型更倾

向于生成合理的结果。但是这也导致当模型采用 L2 损

失时,生成的图像相对于其他损失较为模糊。同时由于

原始编码器的目的只是为了降维,并不是为了生成,而

卷积其实是一种信息损失的操作,所以即便是编码器-

解码器结构的卷积神经网络也很难从低维数据生成原

始图像。而 GANs 结构的出现,在很大程度上解决了神

经网络的生成问题。为解决这些问题,引入对抗损失。

对抗损失本文对抗训练策略受生成式对抗网络

(Generative Adversarial Networks,GANs)启发。为使

生成模型 G 更准确地学习到数据的分布。GAN 在训练

生成模型的同时联合训练一个判别模型 D 为生成模型

提供梯度。生成模型 G 将从在噪声分布(一般为均匀

分布)采样得到的噪声 z 映射到真实数据分布,而判别

模型 D 则用于判别数据是否真实。整个模型的学习过

程类似于两个玩家对抗的游戏:判别模型以生成模型 G

的生成数据和真实数据作为数据集训练,并尝试区分这

两种数据;生成模型 G 通过尽可能地使其生成数据与

真实数据相似来骗过判别模型。对抗训练的核心就是

通过生成模型 G 和判别模型 D 的对抗训练,使用判别

模型为生成模型提供的梯度不断优化生成模型,生成模

型学习到真实数据分布。其目标函数为:

1 - (

D(

]

)D(

)x

Ex ∈ X[

ln(

min

G

max

D

ln(

+ Ez ∈ Zé

ë

)G( )z (2)

)

)

ù

û

通过将生成图像逼近原始真实图像的方式获得与

在本文模型中,使用带有 skip-connection 的 encoder-

计算机工程与应用www.ceaj.org�

刘 昱,等:基于对抗训练和卷积神经网络的面部图像修复

2019,55(2)

113

decoder 结构的卷积神经网络网络 F 作为生成模型,即

F(x0) ≜ G(x0) 。同时,与标准 GAN 不同的是,本文生成

模型的输入 x0 采样自待补全图像集 X0 ,而不是取自均

匀分布的噪声 z ,所以对抗损失为:

L

adv = max

D

t

Ext ∈ X

ln(

é

ë

0

Ex0 ∈ X

[

ln(

D(

1 -(

D(

]

)

)xt

+

G(

)x0

)

)

)

ù

û

(3)

引入对抗训练策略用来帮助生成器拟合数据分布,

最终使得生成器可以生成与数据分布相似的一些数据;

而对抗训练,通过判别器判别图像的真假给生成器提供

梯度实际上是数据增强的一种表现。所以引入对抗训

练策略不仅能让生成器生成期望的图片,还能让生成的

图像更加“真实”、清晰。

联合损失最终全局目标函数为:

F(

{λrec

arg min

F

λadv max

Ext ∈ X

D

ln(

1 -(

é

ë

Ex0 ∈ X

)x0 - x 2

2

[

ln(

D(

D(

G(

0

t

+

]

)

)xt

)

)

)

)x0

ù

û

+

}

(4)

实验中 λrec = 0.99, λadv = 0.01 ,使用随机梯度下降

算法(Stochastic Gradient Descent,SGD)和 ADAM 算法

联合优化生成模型 F 和判别模型 D 。

3 实验

面部图像的特征可以简单地分为几何特征和表现

特征。但由于拍摄时的角度、灯光等因素,即使是拍摄

同一个人所得到的面部图像也会不同。而由于人的表

情的变化,同一个人面部的几何特征和表现特征都有所

差别。所以在修复破损的面部图像时,如何对待修复图

像的角度和面部表情做出相应的应对处理是修复工作

的难点所在。

为验证本文方法的面部图像修复效果,基于 Ten-

sorFlow 平台将其编码实现,并在 CelebA 和 IMDBWIKI

人脸数据集上进行实验,并与其他深度学习方法进行比

较。证明本文方法在大面积破损面部图像修复问题上

效果更加优越。

3.1 数据集

本文方法将在 CelebA 和 IMDBWIKI 人脸数据集

上进行训练和评估,实验过程不使用与图片相关的标

签或者其他信息。CelebA 数据集包含了 20 万张图片,

IMDBWIKI 数据集包含 52 万张图片,对这些图片进行

面部识别,并裁剪出仅包含面部图像的方形区域,由

于在裁剪过程中部分图片丢失,最终 CelebA 数据集剩余

186 000 张面部图像,IMDBWIKI 数据集剩余 348 000 张

面部图像。对于每个数据集单独训练,分别从这两个数

据集中用随机的方式选取 2 000 张图片作为测试集,余

下的图像集合作为训练集。

3.2 实验细节

由 于 裁 剪 出 来 的 面 部 图 像 基 本 都 是 86×86 或 者

107×107,为减少图像缩放损失而导致实验效果有所偏

差,对比几种方法在修复图像尺寸为 96×96,缺失区域

为 24×24 的图像效果。首先,与损失函数为平方 L2 损

失的 encoder-decoder 结构的卷积神经网络的实验结果

比较;然后,与 DCGAN 的实验结果比较;最后,与同样

适用编码器解码器结构的 Context Encoder 的实验结果

进行比较。最终比较结果证明本文提出的方法在修复

人脸这一类结构性比较强的图像时更加高效。

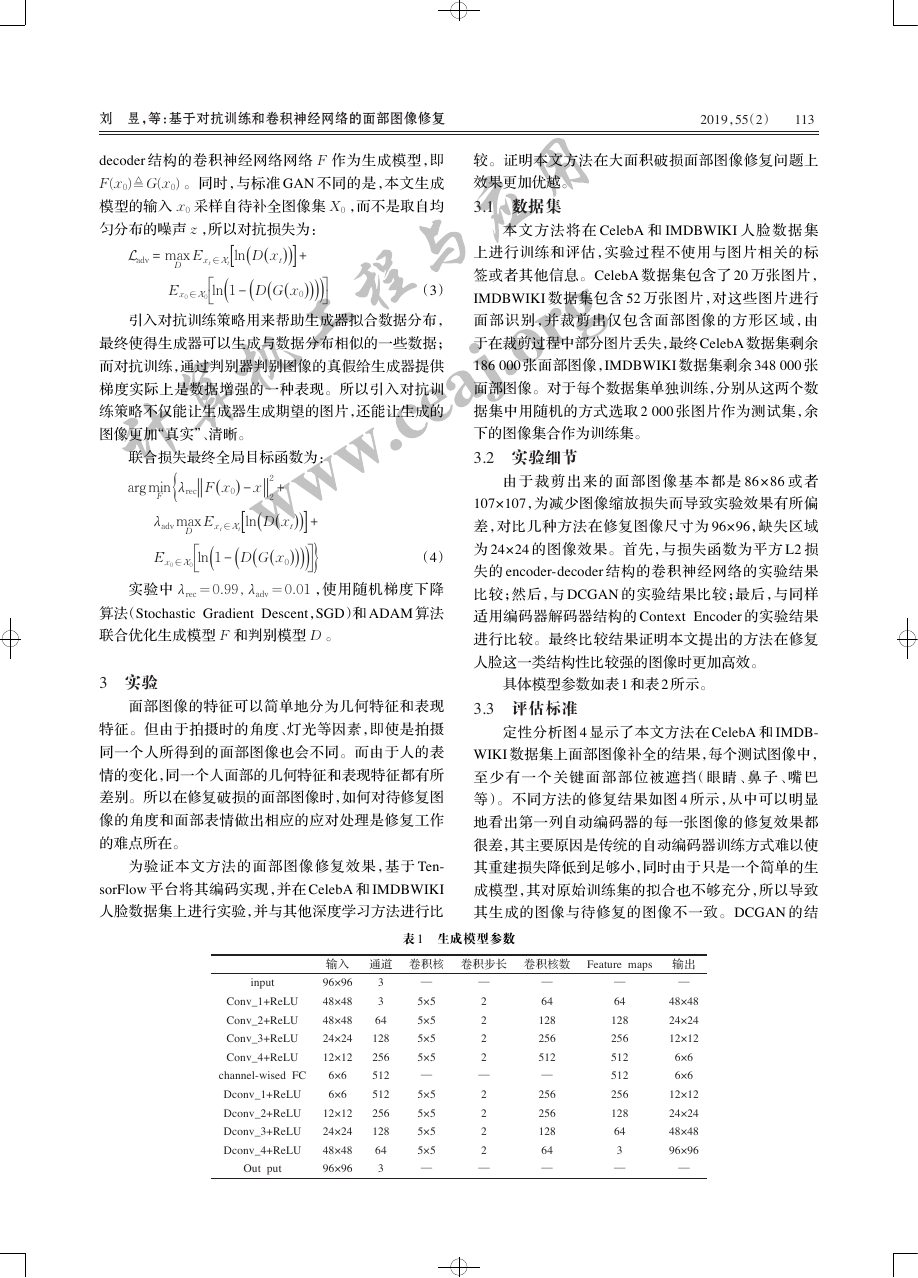

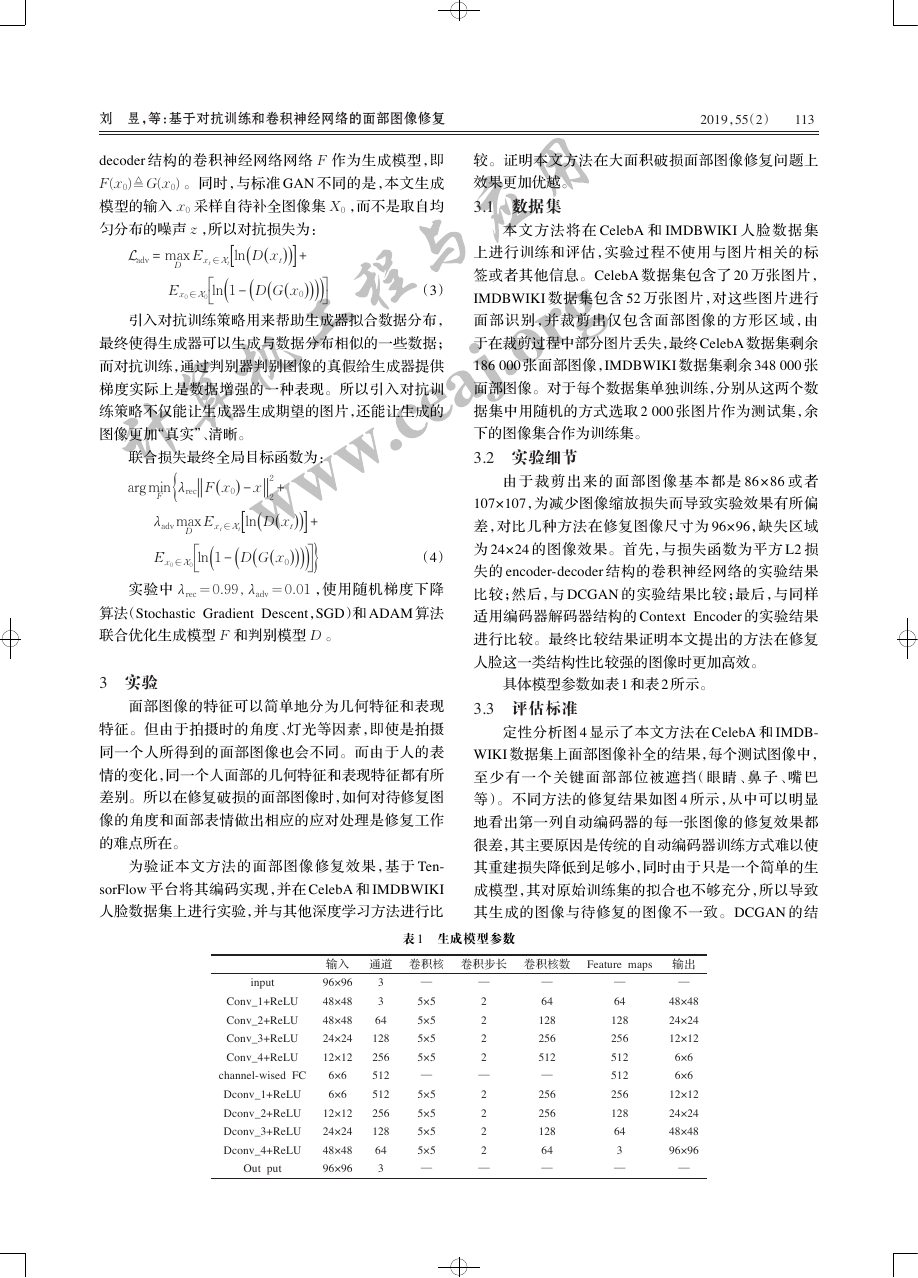

具体模型参数如表 1 和表 2 所示。

3.3 评估标准

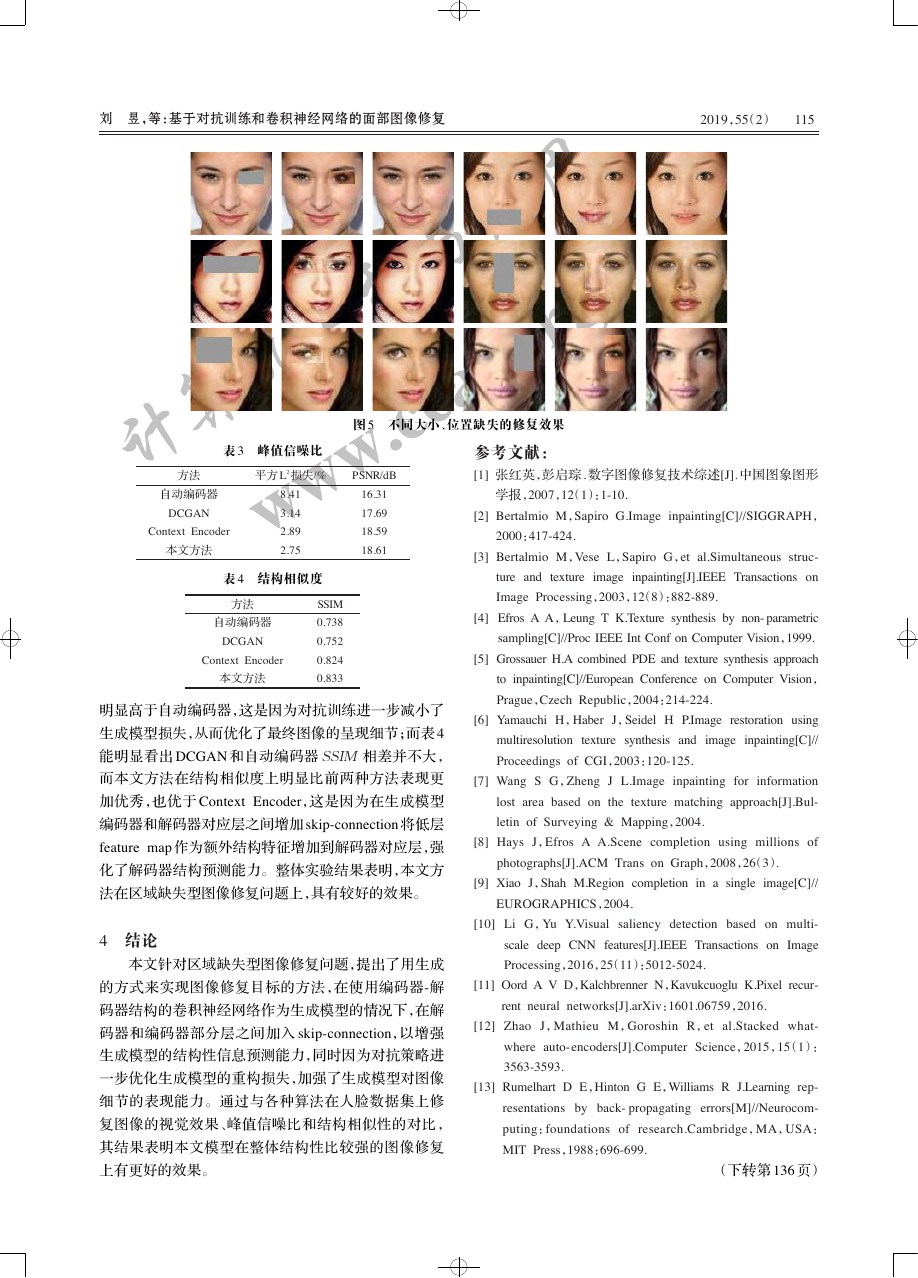

定性分析图 4 显示了本文方法在 CelebA 和 IMDB-

WIKI 数据集上面部图像补全的结果,每个测试图像中,

至 少 有 一 个 关 键 面 部 部 位 被 遮 挡(眼 睛 、鼻 子 、嘴 巴

等)。不同方法的修复结果如图 4 所示,从中可以明显

地看出第一列自动编码器的每一张图像的修复效果都

很差,其主要原因是传统的自动编码器训练方式难以使

其重建损失降低到足够小,同时由于只是一个简单的生

成模型,其对原始训练集的拟合也不够充分,所以导致

其生成的图像与待修复的图像不一致。DCGAN 的结

表 1 生成模型参数

输入

通道

卷积核

卷积步长

卷积核数

Feature maps

input

Conv_1+ReLU

Conv_2+ReLU

Conv_3+ReLU

Conv_4+ReLU

channel-wised FC

Dconv_1+ReLU

Dconv_2+ReLU

Dconv_3+ReLU

Dconv_4+ReLU

Out put

96×96

48×48

48×48

24×24

12×12

6×6

6×6

12×12

24×24

48×48

96×96

3

3

64

128

256

512

512

256

128

64

3

—

5×5

5×5

5×5

5×5

—

5×5

5×5

5×5

5×5

—

—

2

2

2

2

—

2

2

2

2

—

—

64

128

256

512

—

256

256

128

64

—

—

64

128

256

512

512

256

128

64

3

—

输出

—

48×48

24×24

12×12

6×6

6×6

12×12

24×24

48×48

96×96

—

计算机工程与应用www.ceaj.org�

114

2019,55(2)

Computer Engineering and Applications 计算机工程与应用

input

Conv_1+ReLU

Conv_2+ReLU

Conv_3+ReLU

Conv_4+ReLU

Full Connection

Soft max

输入

96×96

48×48

48×48

24×24

12×12

6×6

1×1

通道

3

3

64

128

256

512

1 024

表 2 判别模型参数

卷积核

卷积步长

卷积核数

Feature maps

—

5×5

5×5

5×5

5×5

—

—

—

2

2

2

2

—

—

—

64

128

256

512

—

—

—

64

128

256

512

1 024

—

输出

—

48×48

24×24

12×12

6×6

1×1

1×1

待修复图像

自动编码器

DCGAN

Context Encoder

图 4 不同方法修复效果对比

本文方法

原始图像

果可以看出其修补后的图像在整体的内容表达上与原

图是一致的,同时相比自动编码器,其引入的对抗训练

策略使得 DCGAN 的生成模型更好地拟合训练集的分

布,生成出的图像内容质量更加好,但是由于 DCGAN 生

成器的反卷积结构,其难以还原出更多的图像细节。结

合了自动编码器和对抗训练的优势的 Context Encoder不

管是在整体的内容复原上还是局部细节的呈现上都优

于自动编码器和 DCGAN。结合了卷积神经网络和对

抗训练使得本文方法可以像 Context Encoder 方法一样

充分拟合训练集。同时得益于跳跃链接,编码器-解码

器结构的卷积神经网络在解码生成阶段使用跳跃连接

传递的低维特征映射强化了图像的结构特征,在一定程

度上弥补了卷积过程中的信息损失。使得本文方法与

Context Encoder 以及其他方法相比,修复结果的图像色

彩与原始图像更加一致,同时修复的细节也更加细腻。

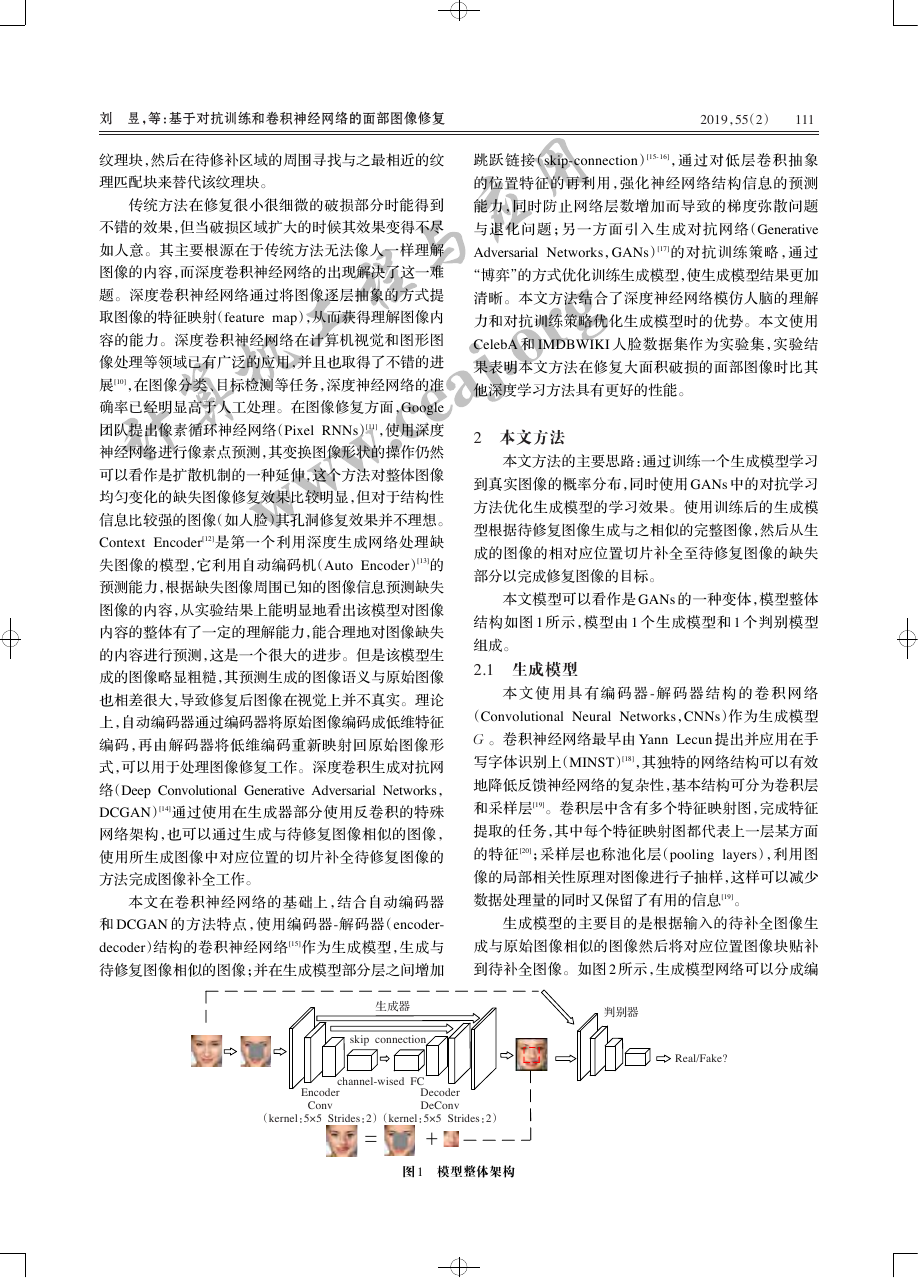

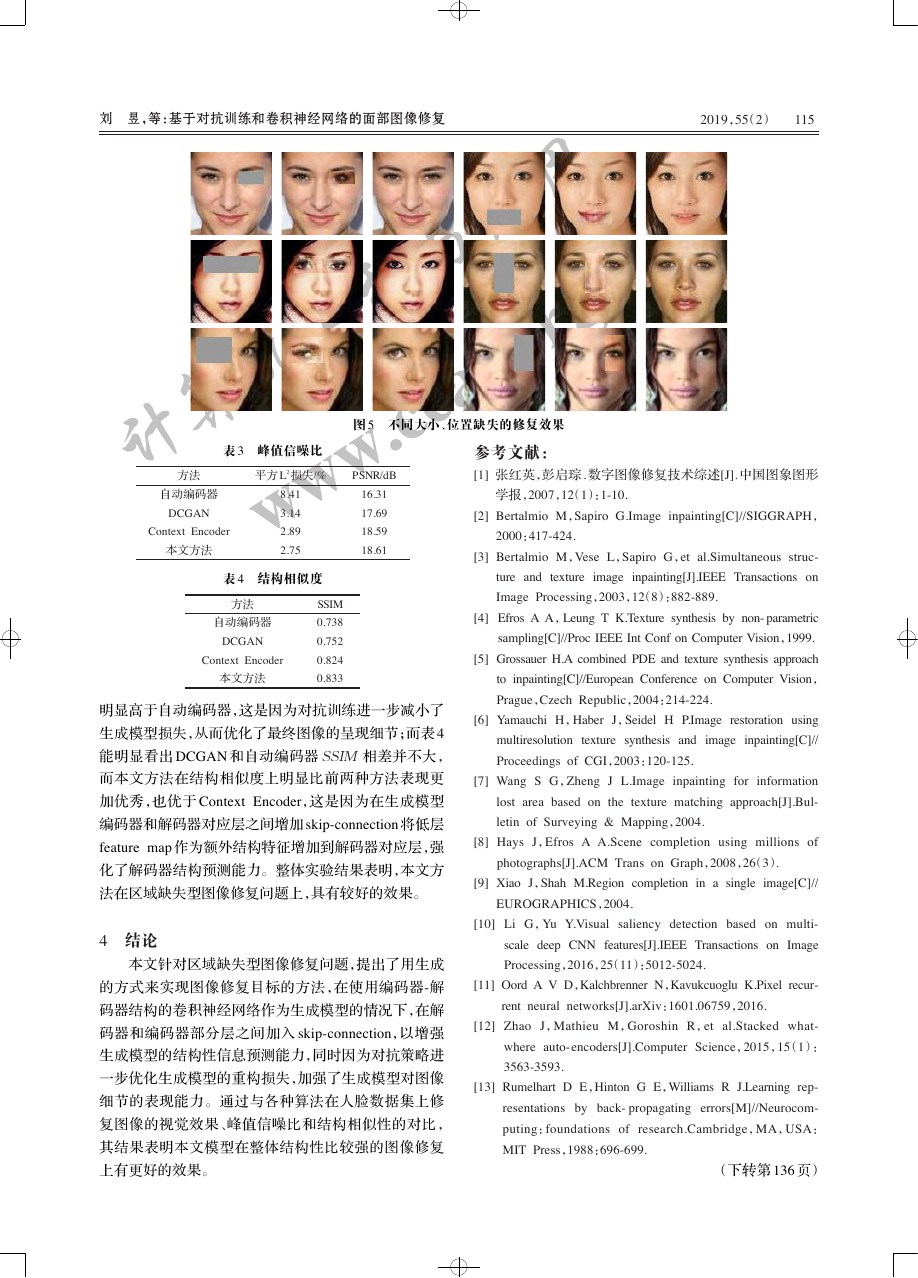

同时,如图 5 所示,本文方法在缺失区域的大小、位

置不同的情况下,依然有不错的修复结果。

定量分析作为对视觉定性评估的补充,使用两个

尺度对 CelebA 数据集上的实验结果进行定量评估。第

一个尺度是峰值信噪比(Peak Signal

to Noise Ratio,

PSNR),PSNR 是最普遍和使用最为广泛的一种图像

客观评价指标,它是基于对应像素点间的误差,即基于

误差敏感的图像质量评价。一般情况下,PSNR 越大

表明修复后图像与原始图像越接近。第二个尺度是结

构相似性(Structural Similarity Index,SSIM)用于评估

两张图片整体上的相似性,它分别从亮度、对比度、结构

三方面度量图像相似性。 SSIM 取值范围[0,1],值越

大,表示图像相似性越高。通过在不同方法补全后的图

像和原始图像之间进行计算得到不同方法在不同尺度

下对应的值。结果如表 3、表 4 所示。

表 3 可以看出,在 CelebA 数据集的实验中,本文方

法和 Context Encoder 以及 DCGAN 的结果的 PSNR 值

计算机工程与应用www.ceaj.org�

刘 昱,等:基于对抗训练和卷积神经网络的面部图像修复

2019,55(2)

115

16.31

17.69

18.59

18.61

表 3 峰值信噪比

方法

平方 L2损失/%

自动编码器

DCGAN

Context Encoder

本文方法

8.41

3.14

2.89

2.75

表 4 结构相似度

方法

自动编码器

DCGAN

Context Encoder

本文方法

SSIM

0.738

0.752

0.824

0.833

明显高于自动编码器,这是因为对抗训练进一步减小了

生成模型损失,从而优化了最终图像的呈现细节;而表 4

能明显看出 DCGAN 和自动编码器 SSIM 相差并不大,

而本文方法在结构相似度上明显比前两种方法表现更

加优秀,也优于 Context Encoder,这是因为在生成模型

编码器和解码器对应层之间增加 skip-connection 将低层

feature map 作为额外结构特征增加到解码器对应层,强

化了解码器结构预测能力。整体实验结果表明,本文方

法在区域缺失型图像修复问题上,具有较好的效果。

4 结论

本文针对区域缺失型图像修复问题,提出了用生成

的方式来实现图像修复目标的方法,在使用编码器-解

码器结构的卷积神经网络作为生成模型的情况下,在解

码器和编码器部分层之间加入 skip-connection,以增强

生成模型的结构性信息预测能力,同时因为对抗策略进

一步优化生成模型的重构损失,加强了生成模型对图像

细节的表现能力。通过与各种算法在人脸数据集上修

复图像的视觉效果、峰值信噪比和结构相似性的对比,

其结果表明本文模型在整体结构性比较强的图像修复

上有更好的效果。

图 5 不同大小、位置缺失的修复效果

参考文献:

[1] 张红英,彭启琮 . 数字图像修复技术综述[J]. 中国图象图形

PSNR/dB

学报,2007,12(1):1-10.

[2] Bertalmio M,Sapiro G.Image inpainting[C]//SIGGRAPH,

2000:417-424.

[3] Bertalmio M,Vese L,Sapiro G,et al.Simultaneous struc-

ture and texture image inpainting[J].IEEE Transactions on

Image Processing,2003,12(8):882-889.

[4] Efros A A,Leung T K.Texture synthesis by non- parametric

sampling[C]//Proc IEEE Int Conf on Computer Vision,1999.

[5] Grossauer H.A combined PDE and texture synthesis approach

to inpainting[C]//European Conference on Computer Vision,

Prague,Czech Republic,2004:214-224.

[6] Yamauchi H,Haber J,Seidel H P.Image restoration using

multiresolution texture synthesis and image inpainting[C]//

Proceedings of CGI,2003:120-125.

[7] Wang S G,Zheng J L.Image inpainting for information

lost area based on the texture matching approach[J].Bul-

letin of Surveying & Mapping,2004.

[8] Hays J,Efros A A.Scene completion using millions of

photographs[J].ACM Trans on Graph,2008,26(3).

[9] Xiao J,Shah M.Region completion in a single image[C]//

EUROGRAPHICS,2004.

[10] Li G,Yu Y.Visual saliency detection based on multi-

scale deep CNN features[J].IEEE Transactions on Image

Processing,2016,25(11):5012-5024.

[11] Oord A V D,Kalchbrenner N,Kavukcuoglu K.Pixel recur-

rent neural networks[J].arXiv:1601.06759,2016.

[12] Zhao J,Mathieu M,Goroshin R,et al.Stacked what-

where auto-encoders[J].Computer Science,2015,15(1):

3563-3593.

[13] Rumelhart D E,Hinton G E,Williams R J.Learning rep-

resentations by back- propagating errors[M]//Neurocom-

puting:foundations of research.Cambridge,MA,USA:

MIT Press,1988:696-699.

(下转第 136 页)

计算机工程与应用www.ceaj.org�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc