第57卷 第20期

2020年10月

激 光 与 光 电 子 学 进 展

Laser & Optoelectronics Progress

Vol. 57, No. 20

October, 2020

基于改进 Frustum PointNet的3D 目标检测

刘训华1,2*, 孙韶媛1,2, 顾立鹏1,2, 李想1,2

1东华大学信息科学与技术学院, 上海 201620;

2东华大学数字化纺织服装技术教育部工程研究中心, 上海 201620

摘要 提出对图像和激光雷达点云数据进 行3D 目 标 检 测 的 改 进F-PointNet(Frustum PointNet)。首 先 利 用 图 像

的2D 目标检测模型提取目标2D 区域,并将其映射到点云数据中,得到该目标的点云候选区域,然后预测候选区域

的3D 目标掩模,最后利用掩模对3D 目标进行检测。当预测掩 模 时,提 出 的 宽 阈 值 掩 模 处 理 可 以 用 来 减 少 原 始 网

络的信息损失;增加注意力机制可以获取需要被 关 注 的 点 和 通 道 层;使 用Focal Loss可 以 解 决 目 标 与 背 景 不 平 衡

的问题。通过多次对比实验,证明宽阈值掩模处理可以提高3D 目 标 检 测 的 准 确 率,同 时 注 意 力 机 制 和Focal Loss

可以提高预测的准确率。

关键词 机器视觉; 激光雷达; 点云数据; 3D 目标检测; 宽阈值掩模处理

中图分类号 TN958.98 文献标志码 A

doi: 10.3788/LOP57.201508

3D Object Detection Based on Improved Frustum PointNet

Liu Xunhua1 2* Sun Shaoyuan1 2 Gu Lipeng1 2 Li Xiang1 2

1College of Information Science and Technology Donghua University Shanghai 201620 China

2Engineering Research Center of Digitized Textile & Fashion Technology Ministry of Education

Donghua University Shanghai 201620 China

Abstract An improved F-PointNet Frustum PointNet for 3D target detection on image and lidar point cloud data

is proposed First the 2D target detection model of the image is used to extract 2D region of the target and it is

mapped to the point cloud data to obtain the candidate region of the target Then the 3D target mask of the

candidate region is predicted Finally the 3D target is detected by using mask When the mask is predicted the

proposed wide-threshold mask processing is used to reduce the information loss of the original network the

attention mechanism is added to obtain the points and channel layers that require attention the Focal Loss can solve

the imbalance between the target and the background problem Through multiple comparison experiments it is

proved that wide-threshold mask processing can improve the accuracy of 3D target detection and the attention

mechanism and Focal Loss can improve the accuracy of prediction

Key words machine vision lidar point cloud data 3D object detection wide-threshold mask processing

OCIS codes 150 6910 150 4232 100 4996

1 引 言

随着自动驾驶技术的发展,3D 目标检测变得越

来越重要。3D 目 标 检 测 是 在 自 动 驾 驶 环 境 中 感 知

动态障碍物,如车辆、行人和自行车[1],实现难度大。

基于图像 的3D 目 标 检 测,其 准 确 率 较 低,近 年 来

In0.53Ga0.47As(InGaAs)单 光 子 探 测 阵 列 的 深 入 研

收稿日期: 2019-12-24; 修回日期: 2020-02-19; 录用日期: 2020-03-09

*E-mail: XunHua_LIU@163.com

基金项目: 上海市科委基础研究项目(15JC1400600)

201508-1

及基于图像与激光雷达融合的方案越来越多且准确

究推动了激光 雷 达 的 发 展[2],因 此 基 于 激 光 雷 达 以

率较高。融合的方案能够结合图像与激光雷达的优

势,有效提高3D 目标检测的准确率,但是如何融合

息,这是提高3D 目标检测效果的关键。

才能减少较少的信息损失且同时剔除大量的冗余信

基于RGB(Red,Green,Blue)图像和激光点云融

�

激 光 与 光 电 子 学 进 展

合数据的3D目标检测方法主要有多视图融合检测框

架和 PointNet融 合 检 测 框 架[3]。Chen 等[4]提 出 的

MV3D(Multi-View 3D)检测网络是典型的多视图融

合检测结构,使用激光点云数据的前视图和鸟瞰图来

表示三维点云信息,并与 RGB 图像融合以预测定向

3D边界框,但是该网络使用的是转换成视图的点云

数据,不是 原 始 点 云 数 据,这 会 造 成 信 息 损 失。Qi

等[5]提出的F-PointNet(Frustum PointNet)是典型的

PointNet融 合 检 测 结 构,通 过 Mask R-CNN(Region

Convolutional Neural Networks)[6]结合深度信息以得

到视锥目标区域,然后使用PointNet++[7]对得到的

视锥区域进行目标的3D 边界框回归估计,该网络是

在原始点云上进行特征提取的,但是边界框预测直接

使用了掩模结果,这依旧会存在信息损失的问题。万

鹏[8]在F-PointNet的基础上修改参数初始化的方式、

增加正则化以及减少 T-Net(Transform Network)卷

积核数,有效提升了检测精度,但是并未解决原始网

络信息损失的问题。

经过掩模预测后,发现大部分非目标点的预测

概率 接 近0,剩 余 部 分 目 标 点 的 预 测 概 率 既 有 大 于

0.5,也有小于0.5。因此本文对F-PointNet中掩模

预测部分的网络结 构 进 行 改 进,使 用 宽 阈 值 掩 模 处

理放宽掩模判定的 边 界,解 决 原 始 网 络 在 该 处 损 失

信息的问题。同时增加注意力机制[9]并提取全局特

征以进一步增加目 标 信 息,并 且 更 换 损 失 函 数 为 适

合目 标 点 较 少、背 景 点 较 多 的 Focal Loss[10],通 过

多个对 比 实 验,证 明 改 进 的 F-PointNet可 以 提 高

3D 目标检测的效果。

2 基本原理

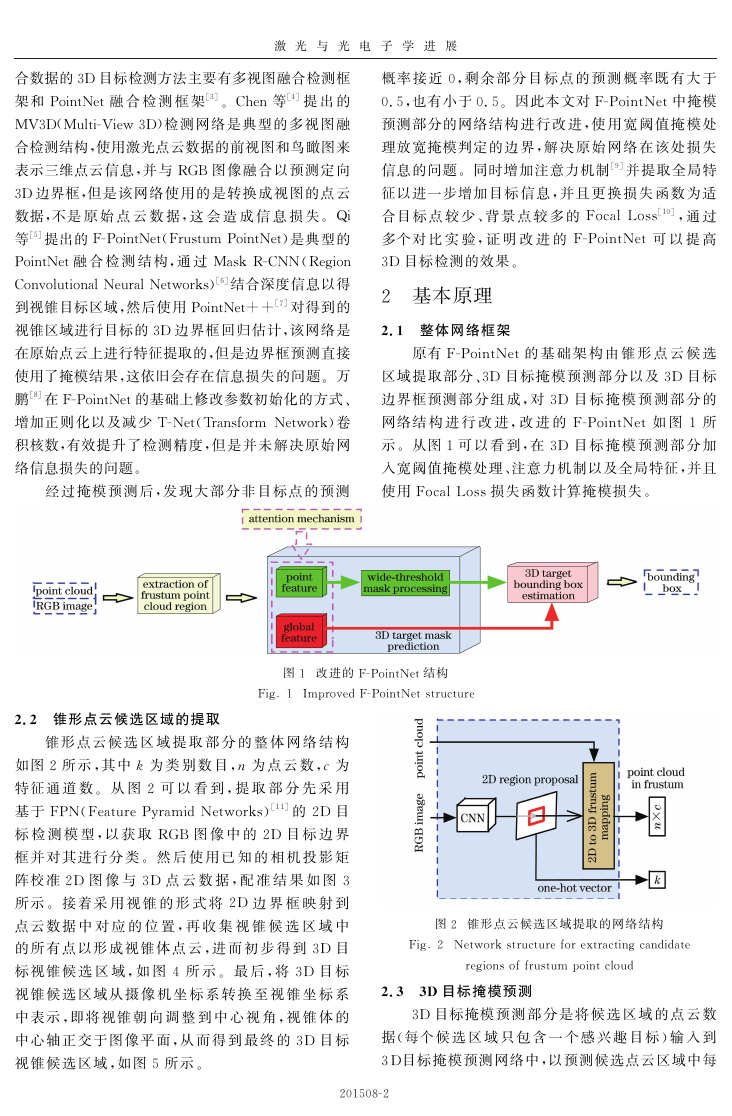

2.1 整体网络框架

原有F-PointNet的 基 础 架 构 由 锥 形 点 云 候 选

区域提取部分、3D 目标掩模预测部分以及3D 目标

边界框预测部 分 组 成,对3D 目 标 掩 模 预 测 部 分 的

网络结 构 进 行 改 进,改 进 的 F-PointNet如 图1 所

示。从图1可 以 看 到,在3D 目 标 掩 模 预 测 部 分 加

入宽阈值掩模处理、注意力机制以及全局特征,并且

使用Focal Loss损失函数计算掩模损失。

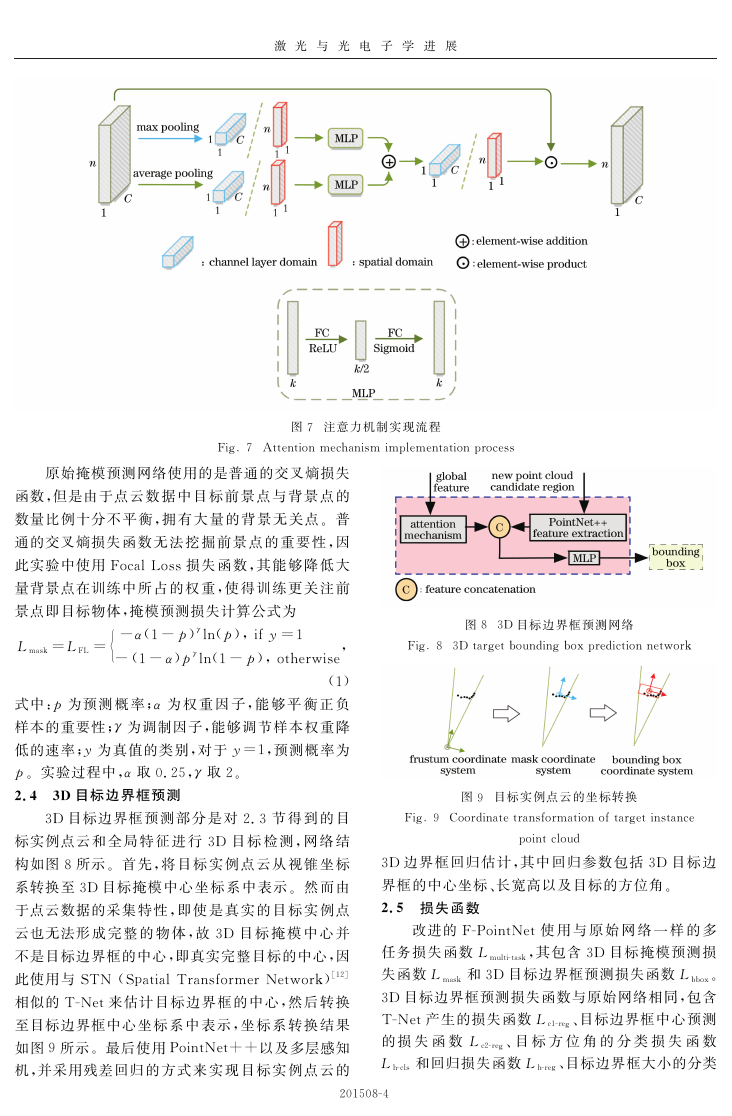

锥形点云候选 区 域 提 取 部 分 的 整 体 网 络 结 构

2.2 锥形点云候选区域的提取

如图2所示,其中k为 类 别 数 目,n为 点 云 数,c为

特征通 道 数。 从 图2 可 以 看 到,提 取 部 分 先 采 用

基于FPN(Feature Pyramid Networks)[11]的2D 目

标 检 测 模 型,以 获 取 RGB 图 像 中 的2D 目 标 边 界

框并对其进行分 类。 然 后 使 用 已 知 的 相 机 投 影 矩

阵校准2D 图 像 与3D 点 云 数 据,配 准 结 果 如 图3

所示。接着 采 用 视 锥 的 形 式 将2D 边 界 框 映 射 到

点云数据 中 对 应 的 位 置,再 收 集 视 锥 候 选 区 域 中

的所有点以形成视锥体 点 云,进 而 初 步 得 到3D 目

标视锥候 选 区 域,如 图4 所 示。 最 后,将3D 目 标

中表示,即将视锥 朝 向 调 整 到 中 心 视 角,视 锥 体 的

中心轴正交于图像平面,从 而 得 到 最 终 的3D 目 标

视锥候选区域,如图5所示。

视锥候选区域从 摄 像 机 坐 标 系 转 换 至 视 锥 坐 标 系

201508-2

图1 改进的F-PointNet结构

Fig 1 Improved F-PointNet structure

图2 锥形点云候选区域提取的网络结构

Fig 2 Network structure for extracting candidate

regions of frustum point cloud

2.3 3D 目标掩模预测

3D 目标掩模预 测 部 分 是 将 候 选 区 域 的 点 云 数

据(每个 候 选 区 域 只 包 含 一 个 感 兴 趣 目 标)输 入 到

3D目标掩模预测网络中,以预测候选点云区域中每

�

激 光 与 光 电 子 学 进 展

图5 视锥朝向调整示意图

Fig 5 Schematic of viewing frustum orientation adjustment

个点的概 率 得 分,进 而 得 到 该 候 选 区 域 的 目 标 掩

模预测结 果,最 后 根 据 预 测 的 掩 模 结 果,在3D 目

标视锥候选区域点云中提取目标实例点云。3D 目

标掩模预测网络 如 图6 所 示,其 中 MLP 为 多 层 感

知机。从图6可 以 看 到,3D 目 标 掩 模 预 测 网 络 主

要由PointNet++构成。与原始网络不同,该 网 络

是在此基 础 上 使 用 宽 阈 值 掩 模 处 理,增 加 注 意 力

机制 且 提 取 全 局 特 征,并 更 换 损 失 函 数 为 Focal

Loss。宽阈 值 掩 模 处 理 能 够 丰 富 下 一 步3D 目 标

边界框预测的输入信息,从 而 提 高3D 目 标 边 界 框

预测的准确率。注 意 力 机 制 能 够 找 到 点 云 数 据 中

需要被关 注 的 空 间 点 和 特 征 通 道,结 合 全 局 特 征

可以有效增加 目 标 信 息。 使 用 Focal Loss能 够 解

决点云数 据 中 目 标 与 背 景 类 别 不 平 衡 的 问 题,二

者相结合有利于3D 目标掩模的预测。

图3 2D 图像与3D 点云的配准结果。(a) RGB图像;

(b)3D 点云数据;(c)图(a)与图(b)的配准效果

Fig 3Registration results of 2D images and 3D point

clouds a RGB image b 3D point cloud data

c registration effect of Fig a and Fig b

图4 初步获取的3D 目标视锥候选区域

Fig 4 3D target frustum candidate region initially obtained

当预测3D 目标边界 框 时,需 要 利 用 掩 模 结 果

来提取目 标 实 例 点 云,这 可 能 会 出 现 由 于 目 标 掩

模预测结果不准 确 而 缺 失 有 用 信 息 的 情 况。 因 此

采用宽阈 值 掩 模 处 理 放 宽 判 定 目 标 掩 模 的 边 界,

从 原 来 大 于 1/2 为 掩 模,放 宽 为 大 于

(1-xmargin)/2,其 中 xmargin 为 原 阈 值 被 放 宽 的 程

度,取值范围 为0~1。 该 处 理 过 程 不 仅 能 够 将 大

部分预测 概 率 接 近 于0 的 非 目 标 点 剔 除,而 且 能

够有效保留预测 概 率 小 于0.5 的 目 标 点。 通 过 多

次实验,实验选取最佳的xmargin=0.2,既减少在3D

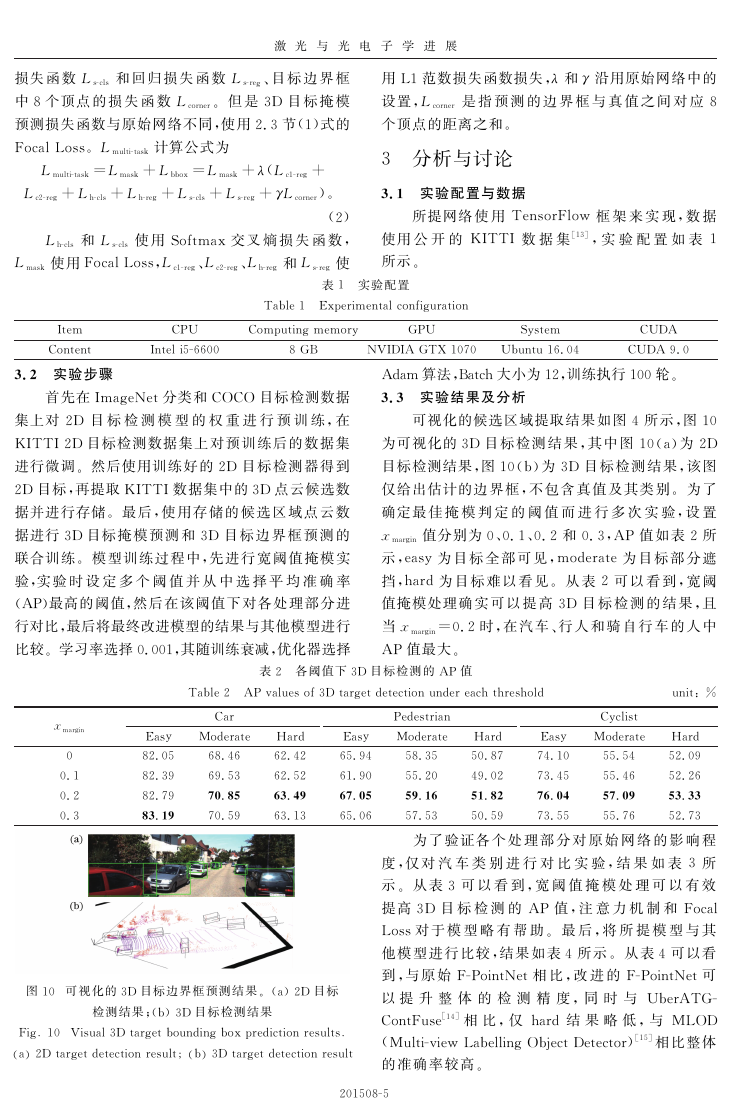

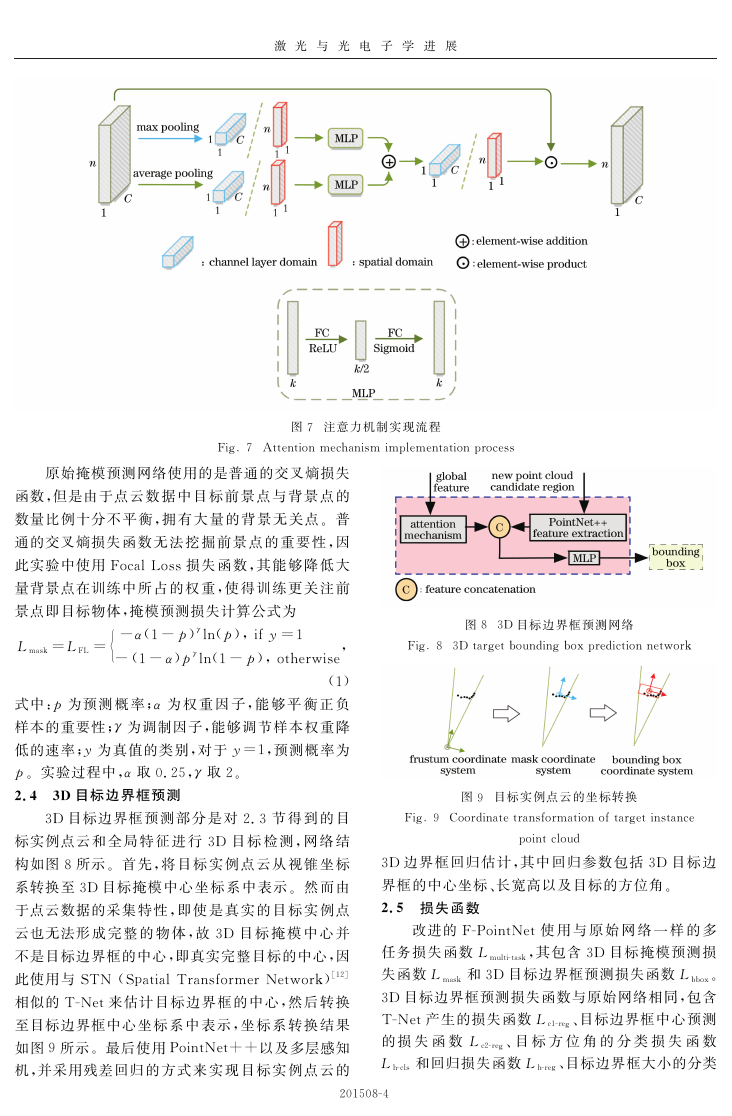

受到基于二维图像的混合域软注意力机制的启

目标边界 框 预 测 输 入 的 冗 余 信 息,又 增 加 有 用 信

息,有利于获得更好的检测结果。

发,实验对3D 点 云 数 据 的 注 意 力 机 制 分 为 空 间 域

和通道域。空间域注意力机制能够找到3D 点云数

据中需要关注的点,通 道 域 能 够 找 到 特 征 图 中 需 要

关注的通道层,实现方式均采用基础的注意力模型。

图7为通道/空间域 注 意 力 机 制 实 现 流 程,FC 为 全

连接层,其中输入为上一层的特征,输出为经过注意

力机制处理后的特征。

图6 3D 目标掩模预测网络

Fig 6 3D target mask prediction network

201508-3

�

激 光 与 光 电 子 学 进 展

图7 注意力机制实现流程

Fig 7 Attention mechanism implementation process

原始掩模预测网络使用的是普通的交叉熵损失

函数,但是由于点云 数 据 中 目 标 前 景 点 与 背 景 点 的

数量比例十分不 平 衡,拥 有 大 量 的 背 景 无 关 点。普

通的交叉熵损失函 数 无 法 挖 掘 前 景 点 的 重 要 性,因

此实验中使用Focal Loss损失函数,其 能 够 降 低 大

量背景点在训练中 所 占 的 权 重,使 得 训 练 更 关 注 前

景点即目标物体,掩模预测损失计算公式为

-α(1-p)γln(p), if y=1

,

Lmask=LFL =

-(1-α)pγln(1-p), otherwise

(1)

式中:p为预测 概 率;α为 权 重 因 子,能 够 平 衡 正 负

样本的重要性;γ为调制因子,能够调节样本权重降

低的速率;y为真值的类别,对于y=1,预测概率为

p。实验过程中,α取0.25,γ取2。

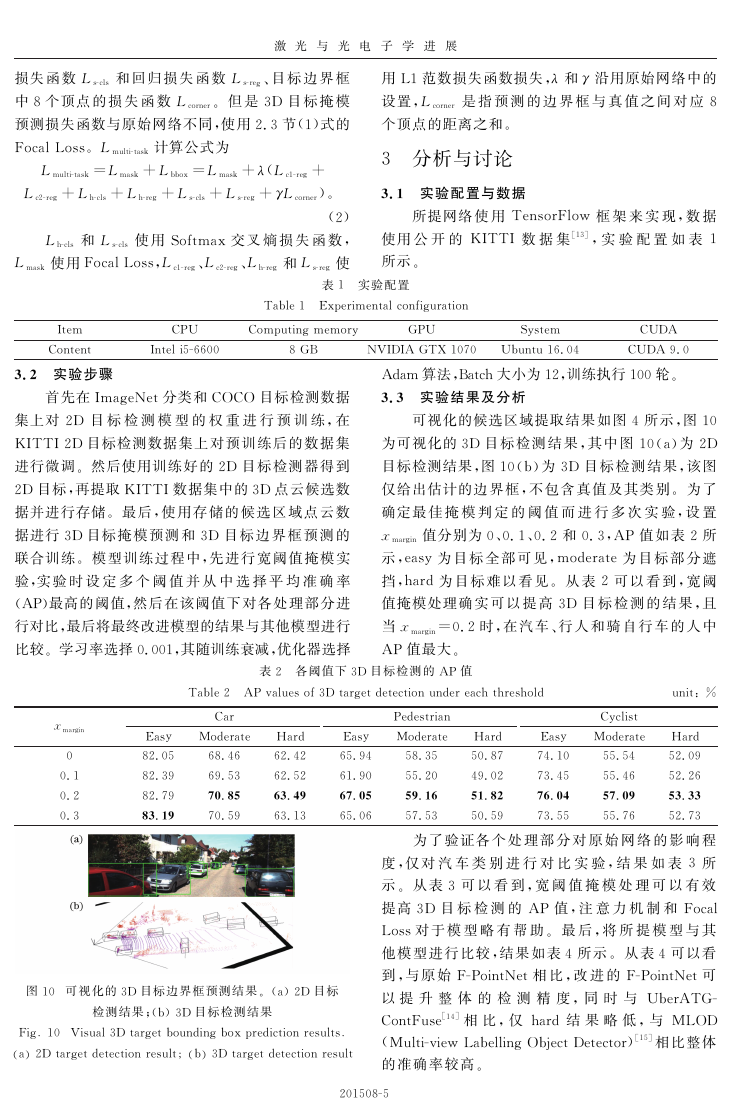

2.4 3D 目标边界框预测

3D 目标边界框预 测 部 分 是 对2.3 节 得 到 的 目

标实例点云和 全 局 特 征 进 行3D 目 标 检 测,网 络 结

构如图8所示。首 先,将 目 标 实 例 点 云 从 视 锥 坐 标

系转换至3D 目标掩模中心坐标系中表示。然而由

于点云数据的采集 特 性,即 使 是 真 实 的 目 标 实 例 点

云也无法形成 完 整 的 物 体,故3D 目 标 掩 模 中 心 并

不是目标边界框的中心,即真实完整目标的中心,因

此使用与STN (Spatial Transformer Network)[12]

相似的T-Net来估计目标边界框的中心,然 后 转 换

至目标边界框中心 坐 标 系 中 表 示,坐 标 系 转 换 结 果

如图9所示。最后使用PointNet++以及多层感知

机,并采用残差回归 的 方 式 来 实 现 目 标 实 例 点 云 的

201508-4

图8 3D 目标边界框预测网络

Fig 8 3D target bounding box prediction network

图9 目标实例点云的坐标转换

Fig 9 Coordinate transformation of target instance

point cloud

3D 边界框回归估计,其中回归参数包括3D 目标边

界框的中心坐标、长宽高以及目标的方位角。

2.5 损失函数

改进的F-PointNet使 用 与 原 始 网 络 一 样 的 多

任务损失函数Lmulti-task,其包含3D 目标掩模预测损

失函数Lmask 和3D 目标边界框预测损失函数Lbbox。

3D 目标边界框预测损失函数与原始网络相同,包含

T-Net产生的损失函数Lc1-reg、目标边界框中心预测

的 损 失 函 数 Lc2-reg、目 标 方 位 角 的 分 类 损 失 函 数

Lh-cls 和回归损失函数Lh-reg、目标边界框大小的分类

�

激 光 与 光 电 子 学 进 展

损失函 数Ls-cls 和 回 归 损 失 函 数Ls-reg、目 标 边 界 框

中8个顶点 的 损 失 函 数Lcorner。 但 是3D 目 标 掩 模

预测损失函数与原始网络不同,使用2.3节(1)式的

Focal Loss。Lmulti-task 计算公式为

Lmulti-task=Lmask+Lbbox=Lmask+λ(Lc1-reg+

Lc2-reg+Lh-cls+Lh-reg+Ls-cls+Ls-reg+γLcorner)。

(2)

Lh-cls 和Ls-cls 使 用Softmax 交 叉 熵 损 失 函 数,

Lmask 使用Focal Loss,Lc1-reg、Lc2-reg、Lh-reg 和Ls-reg 使

用L1范数损失函数损失,λ和γ沿用原始网络中的

设置,Lcorner 是 指 预 测 的 边 界 框 与 真 值 之 间 对 应8

个顶点的距离之和。

3 分析与讨论

3.1 实验配置与数据

所提网络 使 用 TensorFlow 框 架 来 实 现,数 据

使用 公 开 的 KITTI 数 据 集[13],实 验 配 置 如 表 1

所示。

表1 实验配置

Table 1 Experimental configuration

GPU

8 GB

System

CPU

Intel i5-6600

Item

Content

Computing memory

3.2 实验步骤

首先在ImageNet分类和COCO 目标检测数据

集上对2D 目 标 检 测 模 型 的 权 重 进 行 预 训 练,在

KITTI 2D 目标检测数据集上对预训练后的数据集

进行微调。然后使用训练好的2D 目标检测器得到

2D 目标,再提取KITTI数据集中的3D 点云候选数

据并进行存储。最 后,使 用 存 储 的 候 选 区 域 点 云 数

据进行3D 目标掩 模 预 测 和3D 目 标 边 界 框 预 测 的

联合训练。模型训练过程 中,先 进 行 宽 阈 值 掩 模 实

验,实验 时 设 定 多 个 阈 值 并 从 中 选 择 平 均 准 确 率

(AP)最高的阈值,然后在该阈值下对各处理部分进

行对比,最后将最终改进模型的结果与其他模型进行

比较。学习率选择0.001,其随训练衰减,优化器选择

CUDA

CUDA 9.0

NVIDIA GTX 1070 Ubuntu 16.04

Adam 算法,Batch大小为12,训练执行100轮。

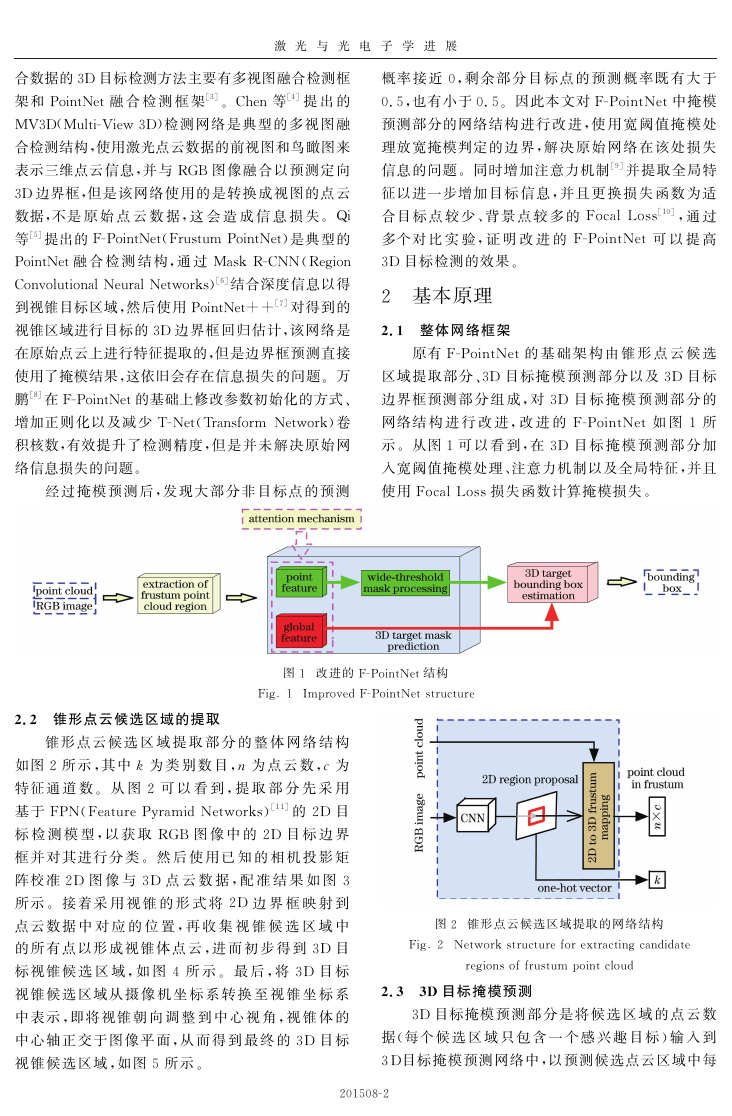

3.3 实验结果及分析

可视化的候选区域提取结果如图4所示,图10

为可视化的3D 目 标 检 测 结 果,其 中 图10(a)为2D

目标检测结果,图10(b)为3D 目 标 检 测 结 果,该 图

仅给出估计的边 界 框,不 包 含 真 值 及 其 类 别。为 了

确定最 佳 掩 模 判 定 的 阈 值 而 进 行 多 次 实 验,设 置

xmargin 值分别为0、0.1、0.2 和0.3,AP 值 如 表2 所

示,easy 为 目 标 全 部 可 见,moderate为 目 标 部 分 遮

挡,hard 为 目 标 难 以 看 见。从 表2 可 以 看 到,宽 阈

值掩模处理确 实 可 以 提 高3D 目 标 检 测 的 结 果,且

当xmargin=0.2时,在 汽 车、行 人 和 骑 自 行 车 的 人 中

AP值最大。

表2 各阈值下3D 目标检测的 AP值

图10 可视化的3D 目标边界框预测结果。(a) 2D 目标

Fig 10 Visual 3D target bounding box prediction results

a 2D target detection result b 3D target detection result

检测结果;(b) 3D 目标检测结果

201508-5

xmargin

0

0.1

0.2

0.3

Easy

82.05

82.39

82.79

83.19

Table 2 AP values of 3D target detection under each threshold

Car

Moderate Hard

68.46

62.42

69.53

62.52

70.85

63.49

63.13

70.59

Pedestrian

Moderate Hard

58.35

50.87

55.20

49.02

59.16

51.82

50.59

57.53

Easy

65.94

61.90

67.05

65.06

unit: %

Cyclist

55.54

55.46

57.09

55.76

Easy Moderate Hard

74.10

52.09

73.45

52.26

76.04

53.33

52.73

73.55

为了验证各 个 处 理 部 分 对 原 始 网 络 的 影 响 程

度,仅对 汽 车 类 别 进 行 对 比 实 验,结 果 如 表3 所

示。从表3 可 以 看 到,宽 阈 值 掩 模 处 理 可 以 有 效

提高3D 目 标 检 测 的 AP 值,注 意 力 机 制 和 Focal

Loss对于 模 型 略 有 帮 助。 最 后,将 所 提 模 型 与 其

他模型进行比较,结果如表4所示。从表4可以看

到,与原 始 F-PointNet相 比,改 进 的 F-PointNet可

以 提 升 整 体 的 检 测 精 度,同 时 与 UberATG-

ContFuse[14]相 比,仅 hard 结 果 略 低,与 MLOD

(Multi-view Labelling Object Detector)[15]相比整体

的准确率较高。

�

激 光 与 光 电 子 学 进 展

表3 各处理部分对 AP值的影响

Table 3 Influence of each processing part on AP values

Part

Attention mechanism Focal Loss

-

-

√

-

√

Wide-threshold mask

(xmargin=0.2)

-

√

-

-

√

Easy

71.29

82.05

UberATG-ContFuse[14] 82.54

72.24

83.04

表4 不同模型的 AP值对比

Table 4 Comparison of AP values of different models

AP /%

Moderate Hard

56.56

62.28

68.46

62.42

66.22

64.04

64.20

57.20

63.82

71.25

Method

MV3D[4]

F-PointNet[5]

MLOD[15]

Proposed

4 结 论

为 了 提 高 3D 目 标 检 测 的 准 确 率,对 F-

PointNet的掩模预测部分进 行 改 进,使 用 宽 阈 值 掩

模处理,增 加 注 意 力 机 制 并 更 换 损 失 函 数 为 Focal

Loss。实验结果表 明,宽 阈 值 掩 模 处 理 在 减 少 点 云

冗余信息的同时,能够充分利用其有用信息,最终与

基于其他网络的3D 目 标 检 测 相 比,基 于 改 进 的F-

PointNet的3D 目标检测可以获得较优的结果。但

针对无人驾驶 领 域 的3D 目 标 检 测 研 究,准 确 率 还

有提升的空间,后续 的 研 究 将 进 一 步 在 网 络 结 构 设

计及目标检测过程的机理上深入挖掘。

参 考 文 献

1 Zhang Y Ren G Q Cheng Z Y et al Application

research of there-dimensional LiDAR in unmanned

vehicle environment perception J Laser &

Optoelectronics Progress 2019 56 13 130001

张银 任国全 程子阳 等 三维 激 光 雷 达 在 无 人 车

环境感知中的 应 用 研 究 J 激 光 与 光 电 子 学 进 展

2019 56 13 130001

2 Liu K B Yang X H He T T et al Indium

phosphide-based near-infrared single photon avalanche

photodiode detector arrays J Laser &

Optoelectronics Progress 2019 56 22 220001

刘凯宝 杨晓红 何 婷 婷 等 InP 基 近 红 外 单 光 子

雪崩 光 电 探 测 器 阵 列 J 激 光 与 光 电 子 学 进 展

2019 56 22 220001

AP /%

Moderate

68.46

70.85

69.23

69.89

71.25

Easy

82.05

82.79

81.89

82.73

83.04

Hard

62.42

63.49

62.54

63.27

63.82

-

-

-

√

√

3 Ji Y M Chen Z Y Tian P H et al A survey of 3D

target detection methods in unmanned driving J

Journal of Nanjing University of Posts and

Telecommunications Natural Science Edition

2019 39 4 72-79

季一木 陈治宇 田 鹏 浩 等 无 人 驾 驶 中3D 目 标

检测方法研究 综 述 J 南 京 邮 电 大 学 学 报 自 然 科

学版 2019 39 4 72-79

4 Chen X Z Ma H M Wan J et al Multi-view 3D

object detection network for autonomous driving C ∥

2017 IEEE Conference on Computer Vision and

Pattern Recognition CVPR July 21-26 2017

Honolulu HI USA New York IEEE 2017

6526-6534

5 Qi C R Liu W Wu C X et al Frustum PointNets

for 3D object detection from RGB-D data C ∥2018

IEEE CVF Conference on Computer Vision and

Pattern Recognition June 18-23 2018 Salt Lake

City UT USA New York IEEE 2018 918-927

6 He K M Gkioxari G Dollar P et al Mask R-CNN

J IEEE Transactions on Pattern Analysis and

Machine Intelligence 2020 42 2 386-397

7 Qi C R Yi L Su H et al PointNet+ + deep

hierarchical feature learning on point sets in a metric

space EB OL 2017-07-07 2019-12-23 https ∥

arxiv org abs 1706 02413

8 Wan P Object detection of 3D point clouds based on

F-PointNet J Journal of Shandong University

Engineering Science 2019 49 5 98-104

万鹏 基于F-PointNet的3D 点云数据目标检测 J

山东大学学报 工学版 2019 49 5 98-104

9 Woo S Park J Lee J Y et al CBAM

convolutional block attention module M ∥Ferrari V

Hebert M Sminchisescu C et al Computer vision-

ECCV 2018 Lecture notes in computer science

Cham Springer 2018 11211 3-19

10 Lin T Y Goyal P Girshick R et al Focal loss for

dense object detection J IEEE Transactions on

201508-6

�

激 光 与 光 电 子 学 进 展

Pattern Analysis and Machine Intelligence 2020 42

2 318-327

11 Lin T Y Dollár P Girshick R et al Feature

pyramid networks for object detection C ∥2017

IEEE Conference on Computer Vision and Pattern

Recognition CVPR July 21-26 2017 Honolulu

HI USA New York IEEE 2017 936-944

12 Jaderberg M Simonyan K Zisserman A et al

Spatial transformer networks EB OL 2016-02-

04 2019-12-23 https ∥arxiv org abs 1506

02025

13 Geiger A Lenz P Urtasun R Are we ready for

autonomous driving The KITTI vision benchmark

suite C ∥2012 IEEE Conference on Computer Vision

and Pattern Recognition June 16-21 2012

Providence RI USA New York IEEE 2012

3354-3361

14 Liang M Yang B Wang S L et al Deep continuous

fusion for multi-sensor 3D object detection M ∥

Ferrari V Hebert M Sminchisescu C et al

Computer vision-ECCV 2018 Lecture notes in

computer science Cham Springer 2018 11220

663-678

15 Deng J Czarnecki K MLOD a multi-view 3D object

detection based on robust feature fusion method C ∥

2019 IEEE Intelligent Transportation Systems

Conference ITSC October 27-30 2019

Auckland New Zealand New York IEEE 2019

279-284

201508-7

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc