准备工作:

1、笔记本 4G 内存 ,操作系统 WIN7 (屌丝的配置)

2、工具 VMware Workstation

3、虚拟机:CentOS6.4 共四台

虚拟机设置:

每台机器:内存 512M,硬盘 40G,网络适配器:NAT 模式

选择高级,新生成虚机 Mac 地址(克隆虚拟机,Mac 地址不会改变,每次最后手动重新生

成)

�

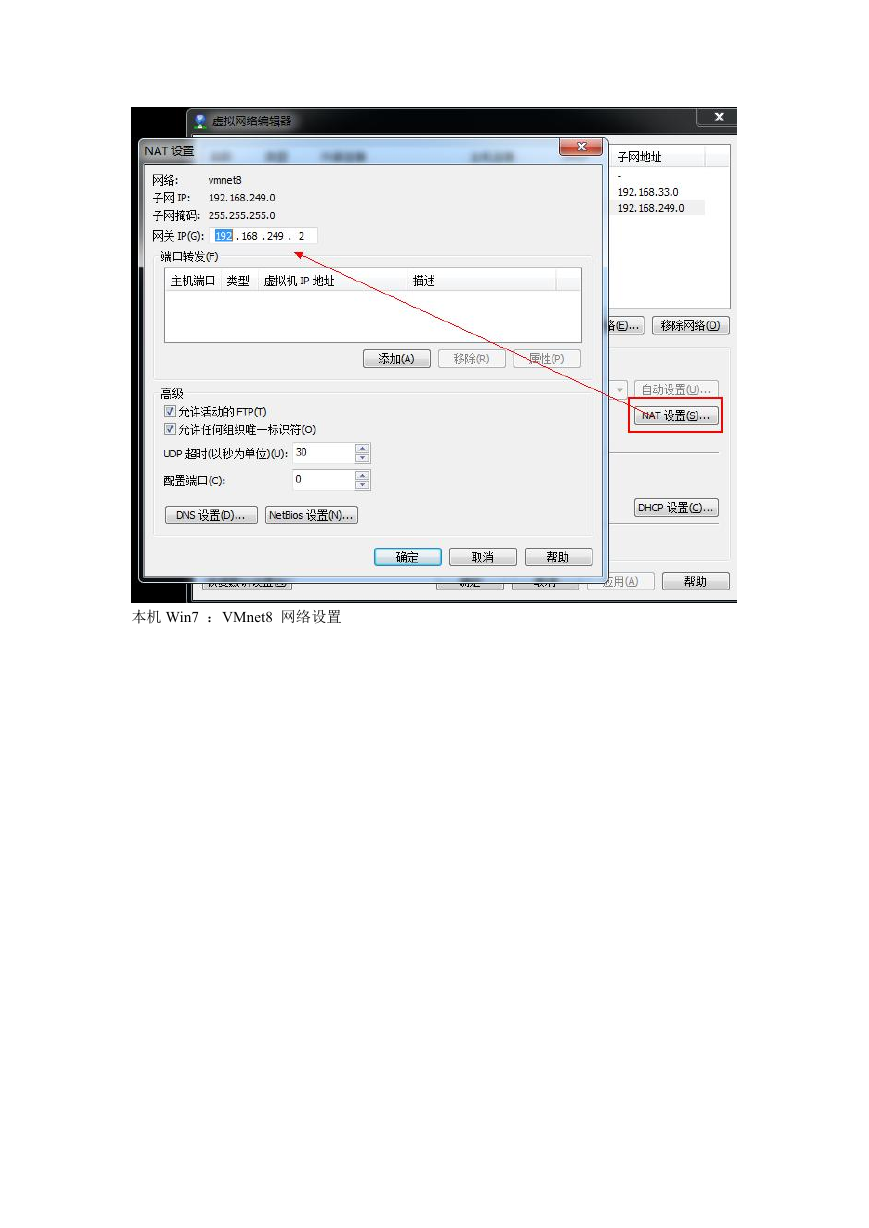

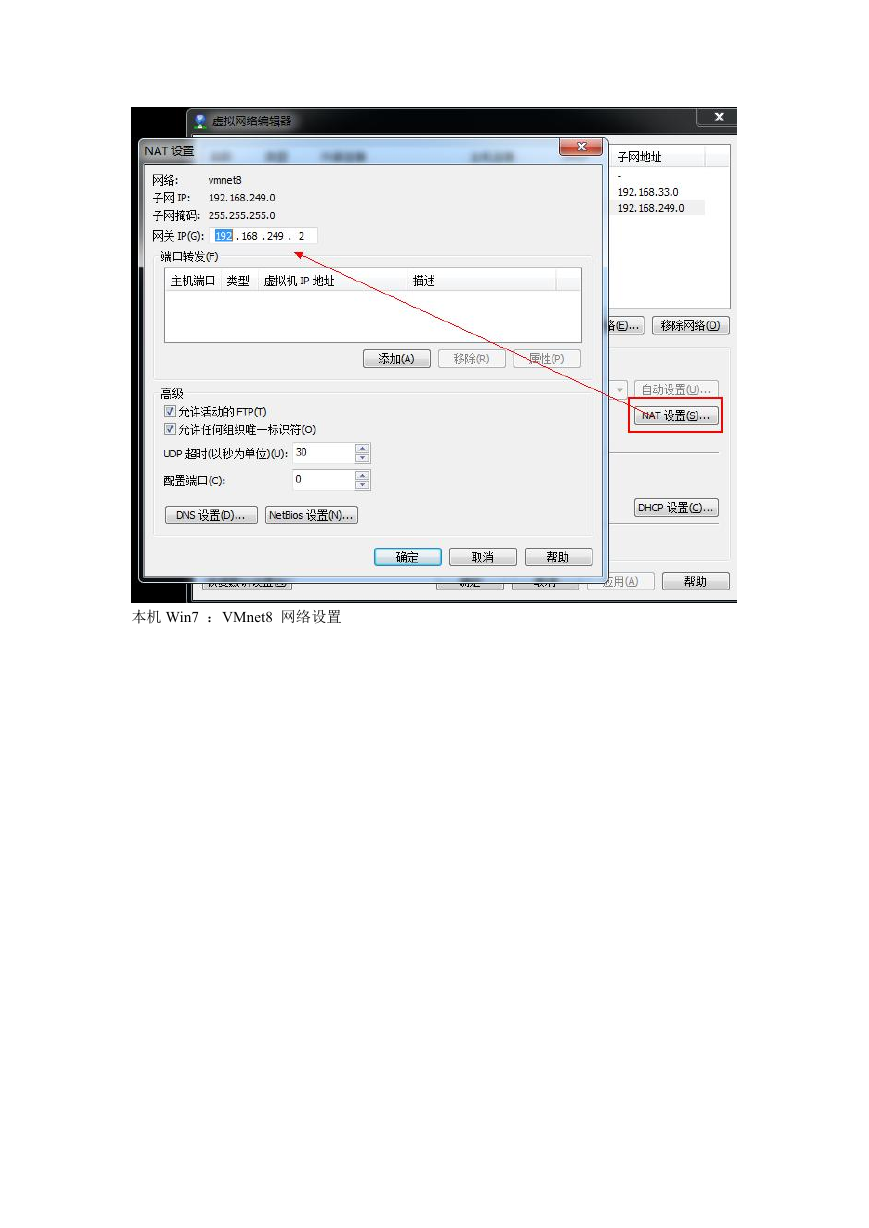

编辑虚拟机网络:

�

点击 NAT 设置,查看虚机网关 IP,并记住它,该 IP 在虚机的网络设置中非常重要。

NAT 设置默认 IP 会自动生成,但是我们的集群中 IP 需要手动设置。

�

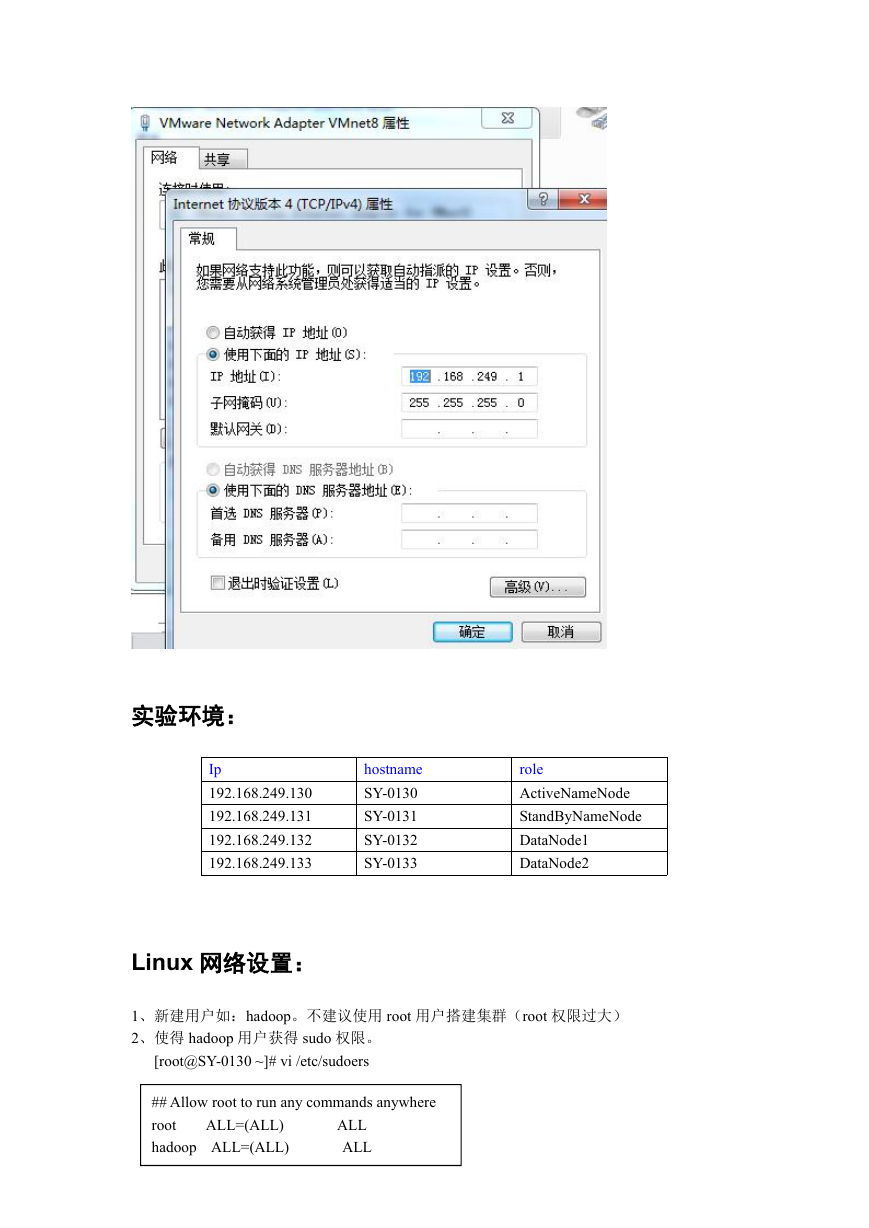

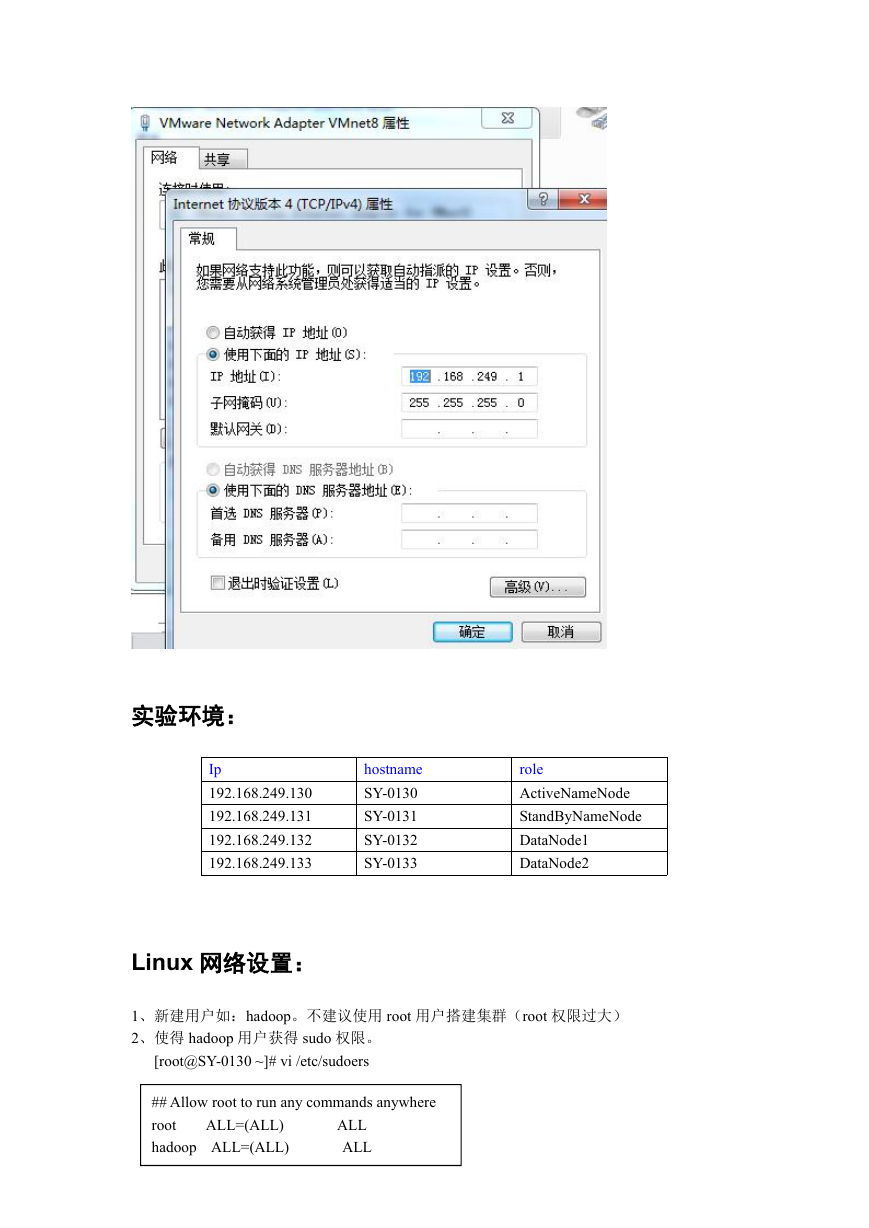

本机 Win7 :VMnet8 网络设置

�

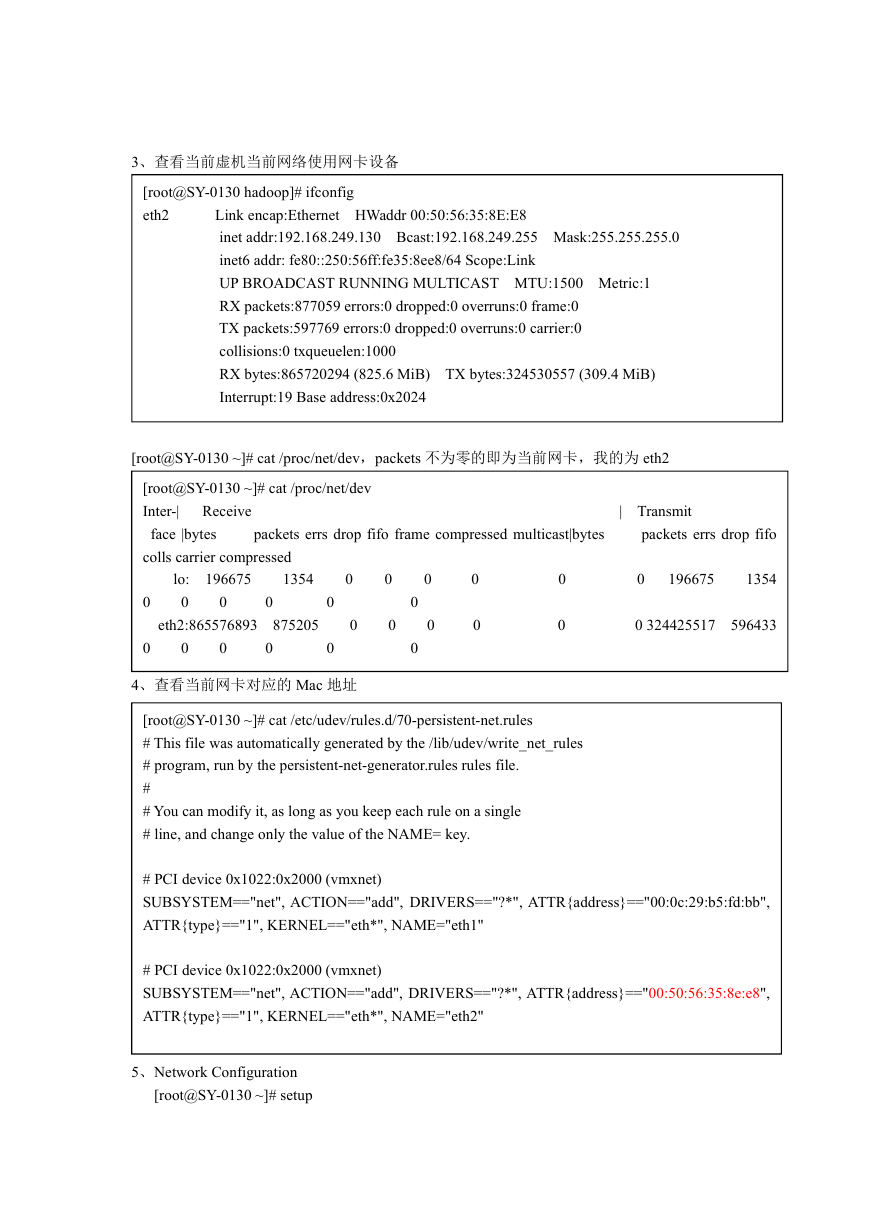

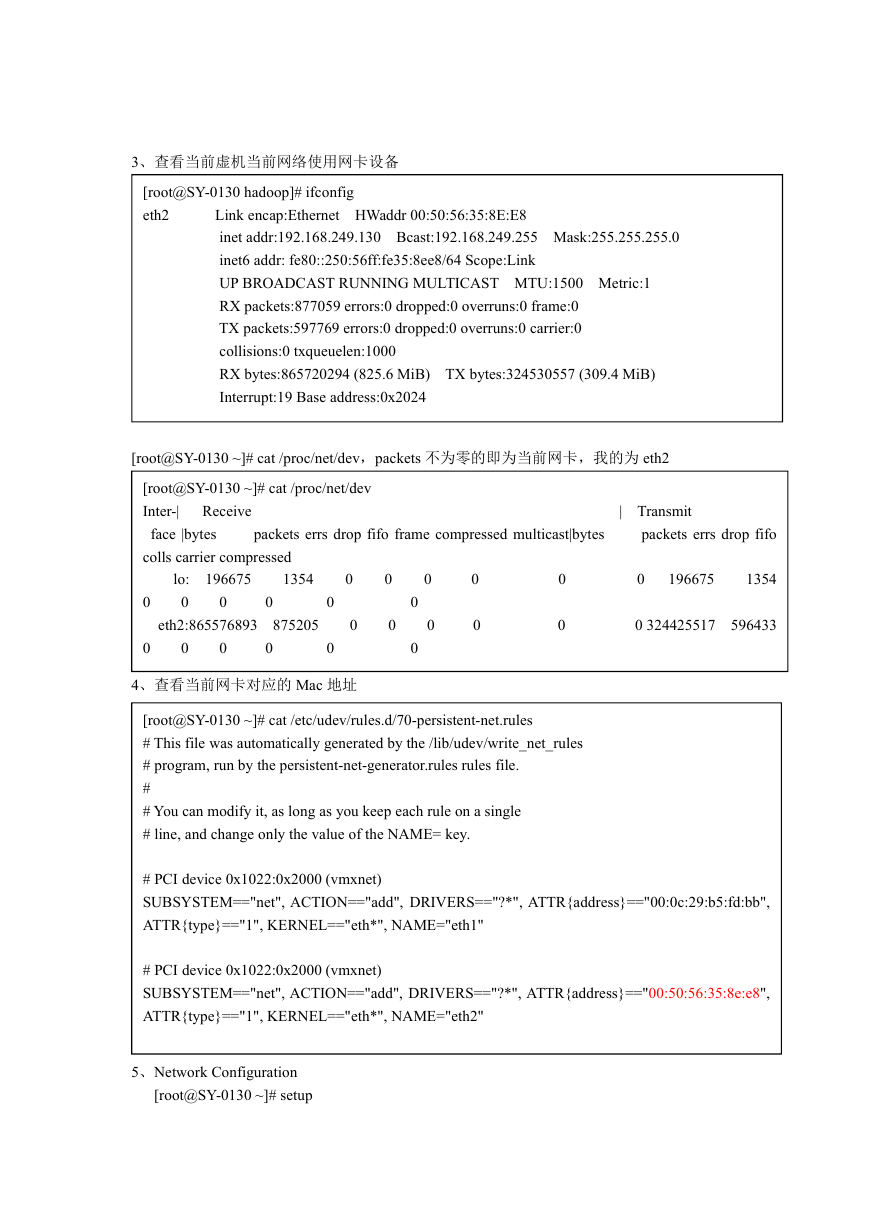

实验环境:

Ip

192.168.249.130

192.168.249.131

192.168.249.132

192.168.249.133

hostname

SY-0130

SY-0131

SY-0132

SY-0133

role

ActiveNameNode

StandByNameNode

DataNode1

DataNode2

Linux 网络设置:

1、新建用户如:hadoop。不建议使用 root 用户搭建集群(root 权限过大)

2、使得 hadoop 用户获得 sudo 权限。

[root@SY-0130 ~]# vi /etc/sudoers

## Allow root to run any commands anywhere

ALL=(ALL)

root

hadoop ALL=(ALL)

ALL

ALL

�

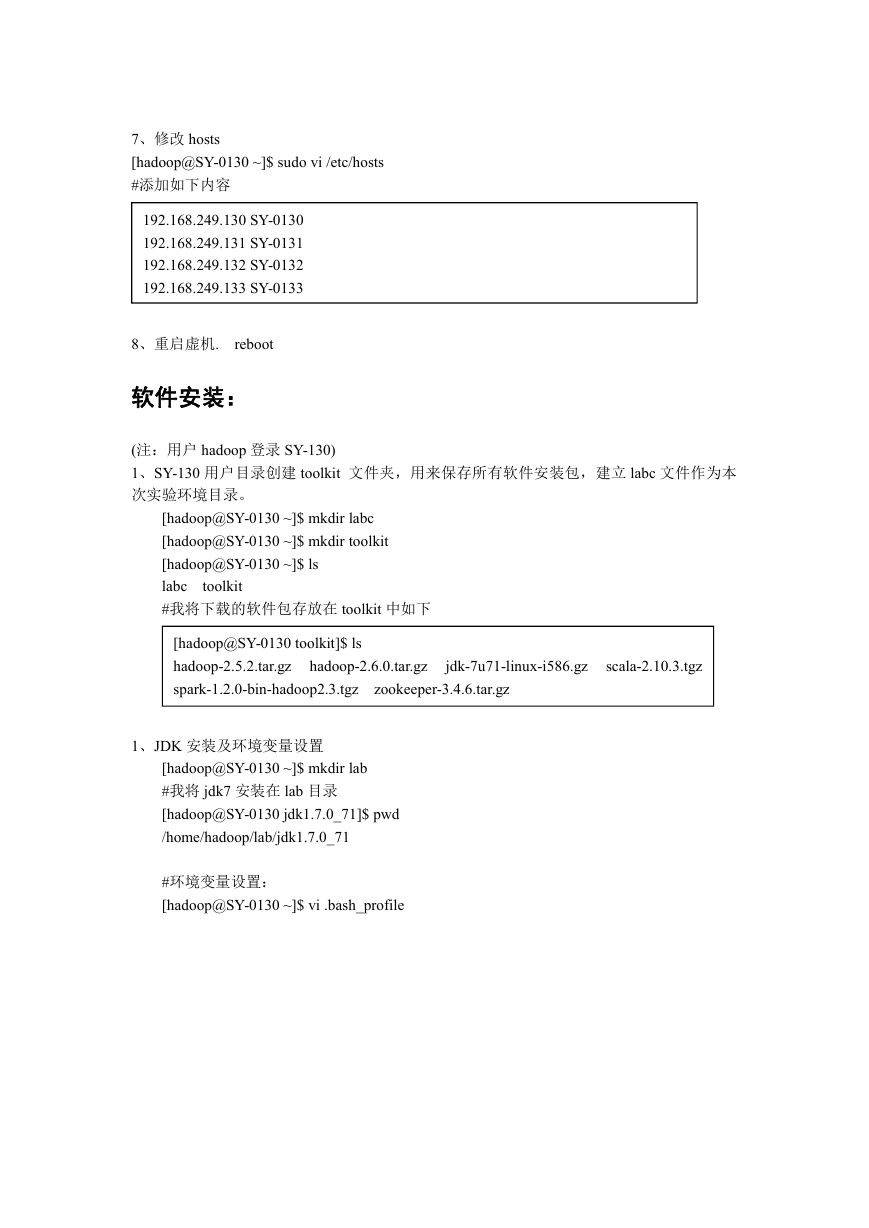

3、查看当前虚机当前网络使用网卡设备

[root@SY-0130 hadoop]# ifconfig

eth2

Link encap:Ethernet HWaddr 00:50:56:35:8E:E8

inet addr:192.168.249.130 Bcast:192.168.249.255 Mask:255.255.255.0

inet6 addr: fe80::250:56ff:fe35:8ee8/64 Scope:Link

UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1

RX packets:877059 errors:0 dropped:0 overruns:0 frame:0

TX packets:597769 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:865720294 (825.6 MiB) TX bytes:324530557 (309.4 MiB)

Interrupt:19 Base address:0x2024

[root@SY-0130 ~]# cat /proc/net/dev,packets 不为零的即为当前网卡,我的为 eth2

Receive

[root@SY-0130 ~]# cat /proc/net/dev

Inter-|

face |bytes

colls carrier compressed

packets errs drop fifo frame compressed multicast|bytes

| Transmit

packets errs drop fifo

196675

1354

lo:

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

196675

1354

0 324425517

596433

0

0

875205

0

0

eth2:865576893

0

0

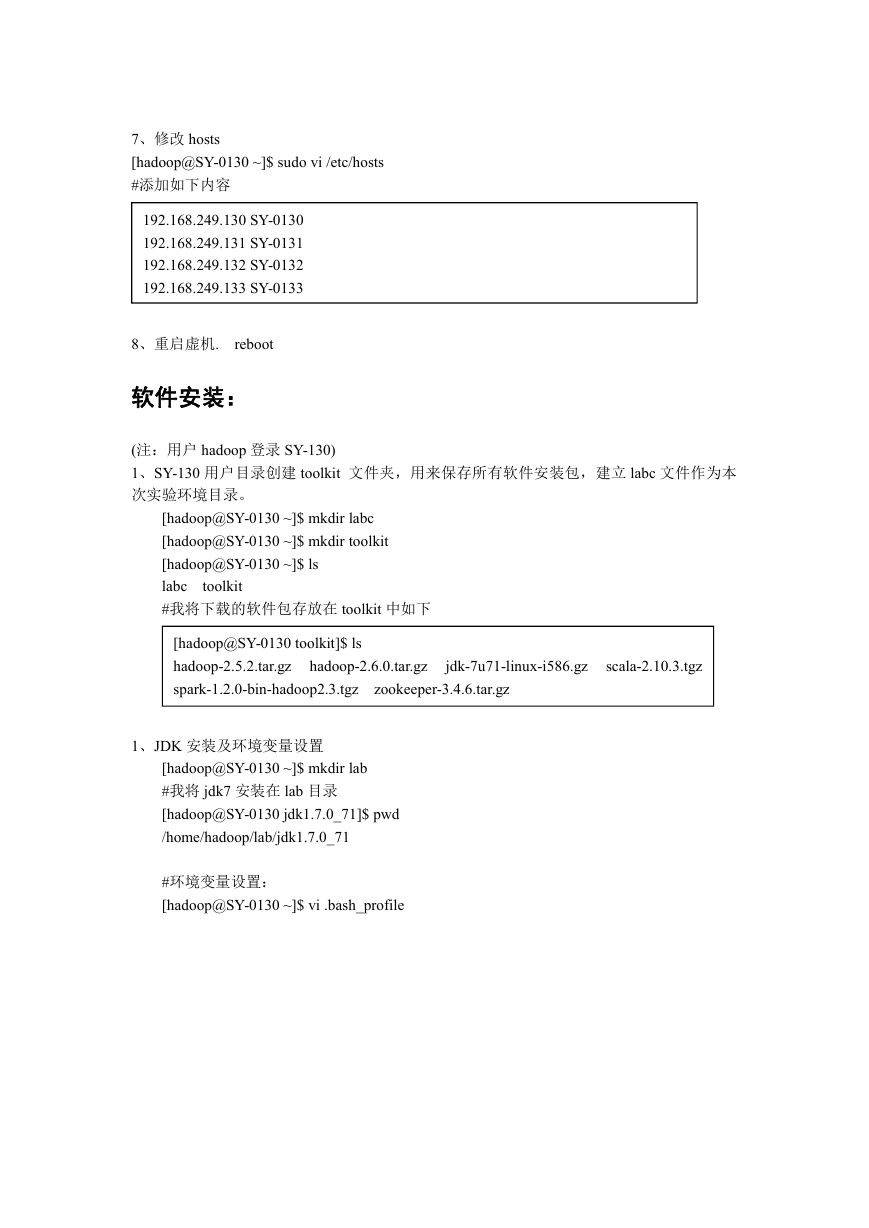

4、查看当前网卡对应的 Mac 地址

[root@SY-0130 ~]# cat /etc/udev/rules.d/70-persistent-net.rules

# This file was automatically generated by the /lib/udev/write_net_rules

# program, run by the persistent-net-generator.rules rules file.

#

# You can modify it, as long as you keep each rule on a single

# line, and change only the value of the NAME= key.

# PCI device 0x1022:0x2000 (vmxnet)

SUBSYSTEM=="net", ACTION=="add", DRIVERS=="?*", ATTR{address}=="00:0c:29:b5:fd:bb",

ATTR{type}=="1", KERNEL=="eth*", NAME="eth1"

# PCI device 0x1022:0x2000 (vmxnet)

SUBSYSTEM=="net", ACTION=="add", DRIVERS=="?*", ATTR{address}=="00:50:56:35:8e:e8",

ATTR{type}=="1", KERNEL=="eth*", NAME="eth2"

5、Network Configuration

[root@SY-0130 ~]# setup

�

选择 eth2,进行设置,更改为当前网卡设备 eth2,并且进行 IP、网管、DNS 设置。

DNS Server 与 Win7 的网络中的 DNS Server 一致,这样虚拟机也可以连接 Internet 网了,方

便下载安装软件。

另外还有将防火墙关闭。

6、修改 hostname

[root@SY-0130 ~]# vi /etc/sysconfig/network

NETWORKING=yes

HOSTNAME=SY-0130

�

7、修改 hosts

[hadoop@SY-0130 ~]$ sudo vi /etc/hosts

#添加如下内容

192.168.249.130 SY-0130

192.168.249.131 SY-0131

192.168.249.132 SY-0132

192.168.249.133 SY-0133

8、重启虚机.

reboot

软件安装:

(注:用户 hadoop 登录 SY-130)

1、SY-130 用户目录创建 toolkit 文件夹,用来保存所有软件安装包,建立 labc 文件作为本

次实验环境目录。

[hadoop@SY-0130 ~]$ mkdir labc

[hadoop@SY-0130 ~]$ mkdir toolkit

[hadoop@SY-0130 ~]$ ls

labc

#我将下载的软件包存放在 toolkit 中如下

toolkit

[hadoop@SY-0130 toolkit]$ ls

hadoop-2.5.2.tar.gz

spark-1.2.0-bin-hadoop2.3.tgz

zookeeper-3.4.6.tar.gz

hadoop-2.6.0.tar.gz

jdk-7u71-linux-i586.gz

scala-2.10.3.tgz

1、JDK 安装及环境变量设置

[hadoop@SY-0130 ~]$ mkdir lab

#我将 jdk7 安装在 lab 目录

[hadoop@SY-0130 jdk1.7.0_71]$ pwd

/home/hadoop/lab/jdk1.7.0_71

#环境变量设置:

[hadoop@SY-0130 ~]$ vi .bash_profile

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc