【多易教育】

yiee 数据运营系统

<数据仓库>

DOIT 北京多易教育科技有限公司

QQ 群:965123607

www.51doit.com

�

1 【项目介绍篇】

本项目是一个典型的大数据处理系统;

1.1 项目整体背景

本项目所适用的行业或业务背景有: 主营业务在线上(app/网站)进行的公司!(外卖公司、各类 app<

比如:下厨房;头条;安居客;内涵段子;斗鱼;每日优鲜>、页游、唯品会、拼多多、当当、苏宁

易购、国美在线、网易严选、携程、中华会计网校、多易教育、小象学院、慕课网、尚德教育、有钱

花、上哪借 ……)

这类公司,都需要针对用户的线上访问行为、消费行为、业务行为进行统计分析!以支撑公司的业务

运营,提高业务转化率,改善公司运营效果!

这些需求,都需要通过构建一个数仓系统来支撑!

数据仓库:作为数据的管理和运算中心;

数据存档;

各种统计、运算任务的核心平台;

这类公司,往往还需要对每个用户进行个性化推荐/营销运营,改善用户体验,提高用户粘性,增大

销售额!

这些需求,可以通过对用户进行精准用户画像系统(深入分析用户后给用户打上各种规范标签:年龄,

性别,地域特征,偏好特征,价值指数,行为习惯,消费习惯......)、推荐系统来实现!

用户画像系统:用于支撑精细化营运;

比如,针对不同的人群发放不同的优惠券;

比如,针对不同的人群定制不同的打折规则;

比如,针对不同的人群推行不同的营销活动;

比如,针对流失概率大的人群进行挽留;

推荐系统:用于个性化推荐

对不同的人,在不同的场景中,推荐不同的物品

以上所述的数据仓库系统、用户画像系统、推荐系统,整体上来说,需要一个大型的综合性的数据处

理系统;

该数据处理系统可以使用离线计算方式实现,也可以使用实时计算方式实现;

更多的是离线和实时结合起来实现;

公司一般会根据不同的场景,灵活使用离线和实时技术:

离线:系统化的,计算的数据时间跨度长的,运算量大的任务

实时:对时效要求高的需求

DOIT 北京多易教育科技有限公司

QQ 群:965123607

www.51doit.com

�

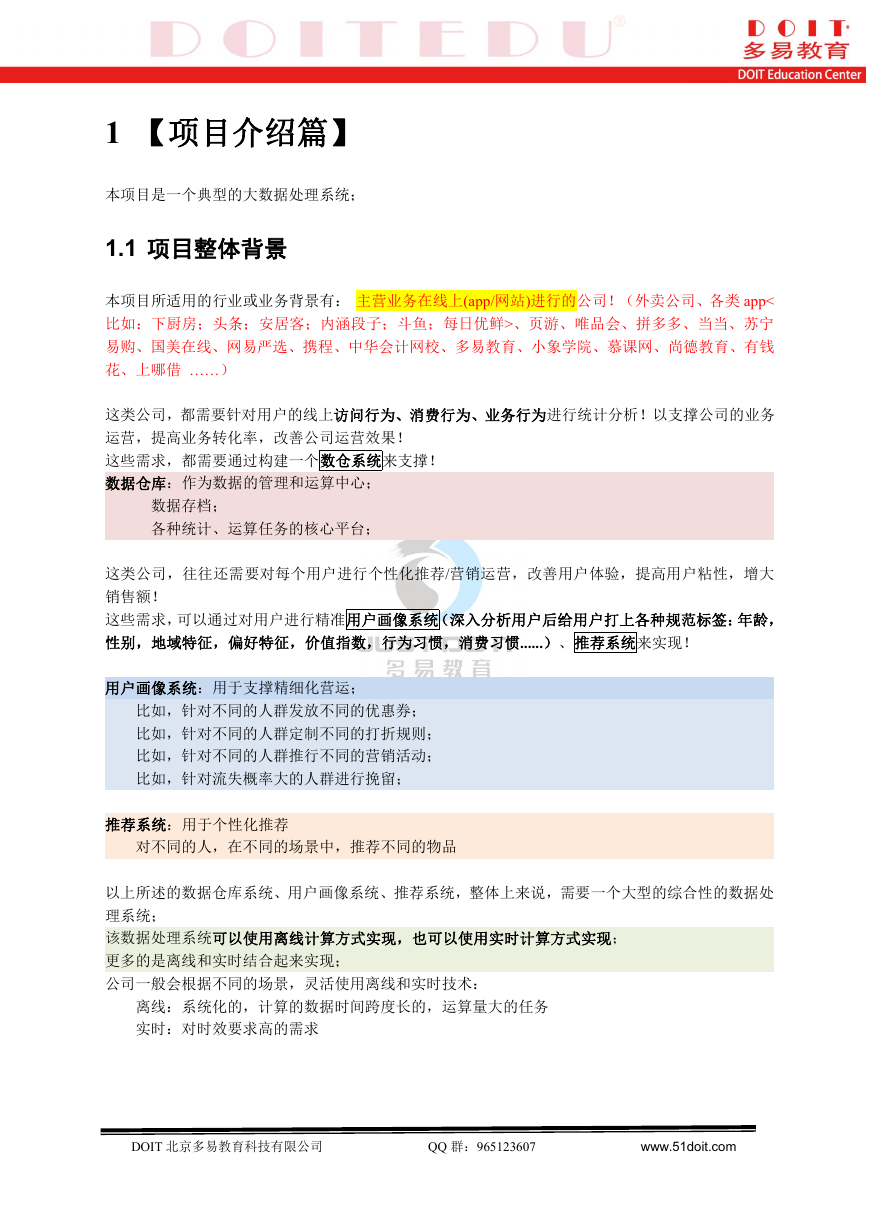

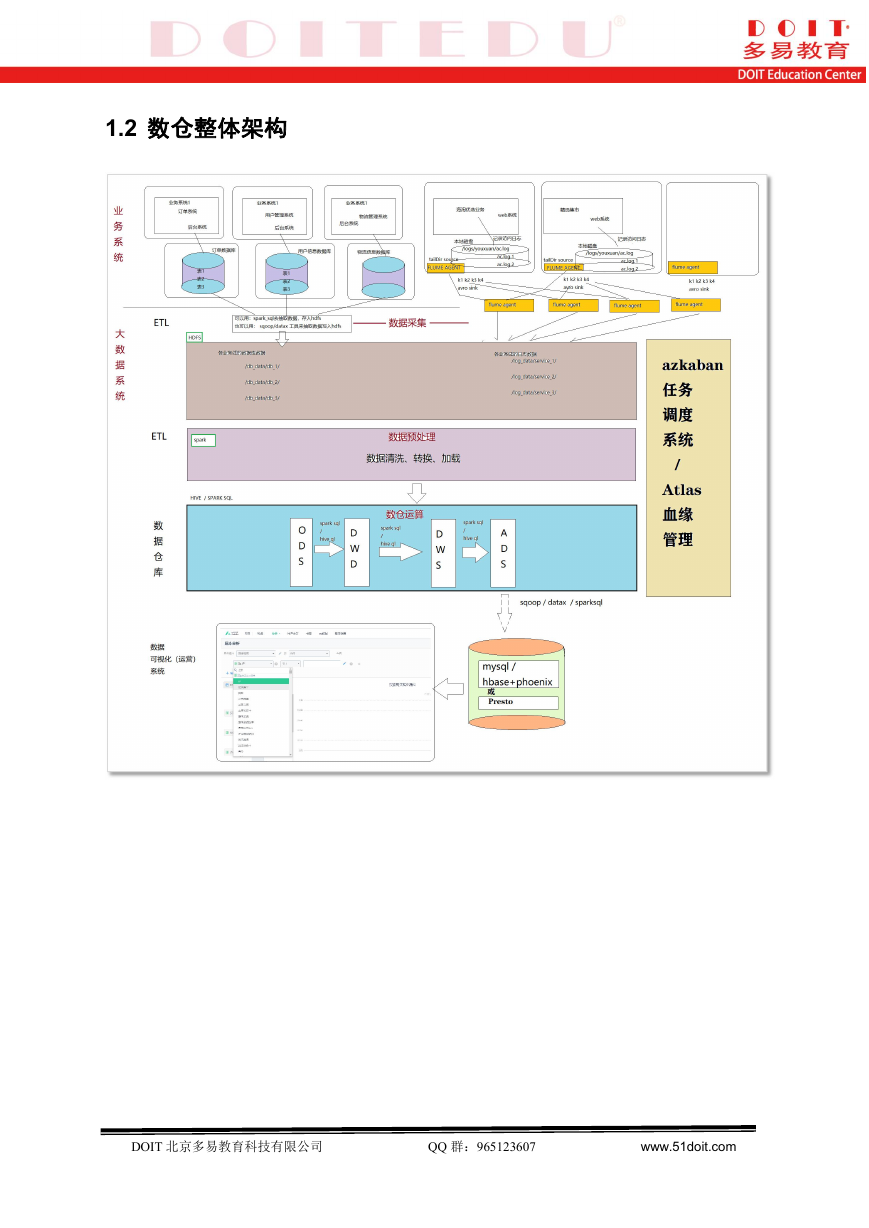

1.2 数仓整体架构

DOIT 北京多易教育科技有限公司

QQ 群:965123607

www.51doit.com

�

1.3 数仓的前端分析平台系统

前端分析平台上有两个功能:

展示固定的报表数据(提前每天固定通过离线技术 Hive 算好的)

交互式的联机数据分析 OLAP(在页面上自定义报表需求,实时得到报表结果-presto)

1.3.1 固定报表可视化

DOIT 北京多易教育科技有限公司

QQ 群:965123607

www.51doit.com

�

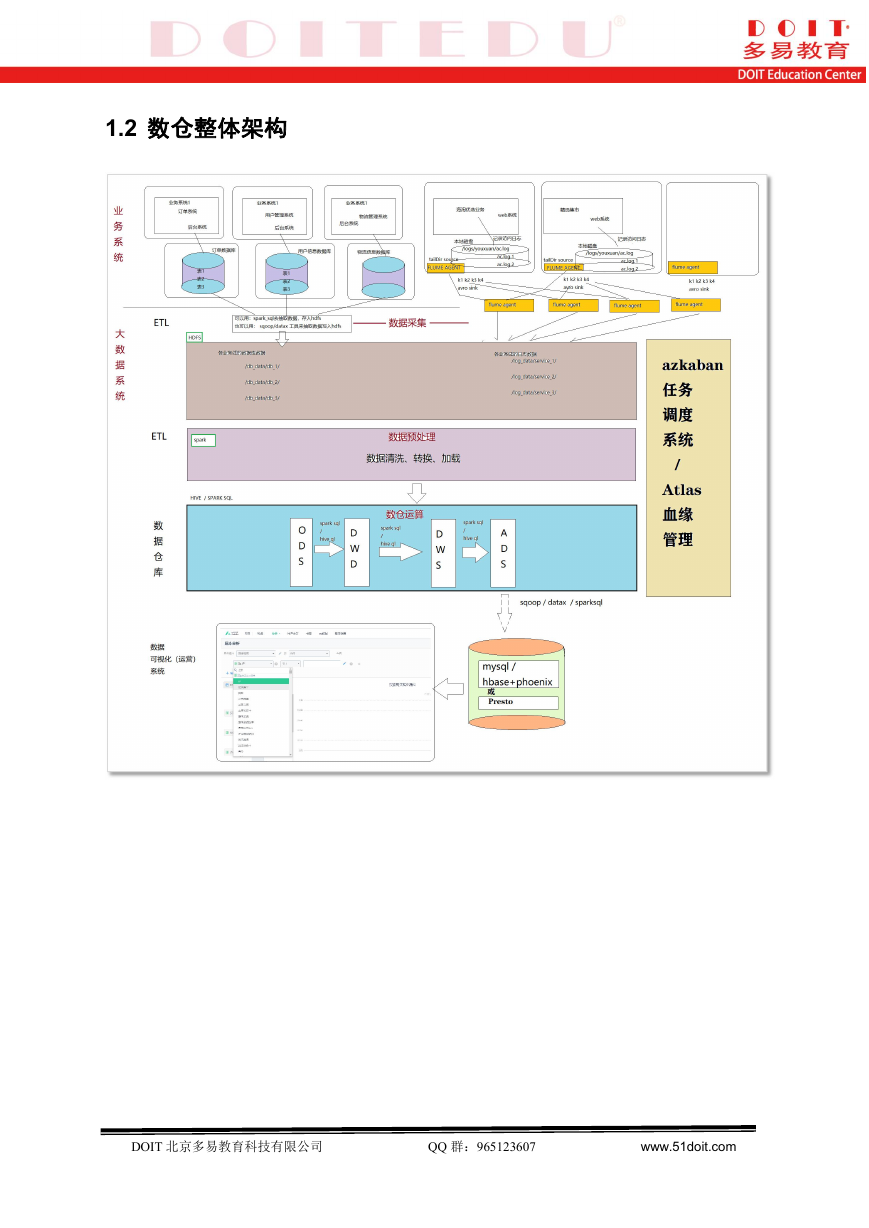

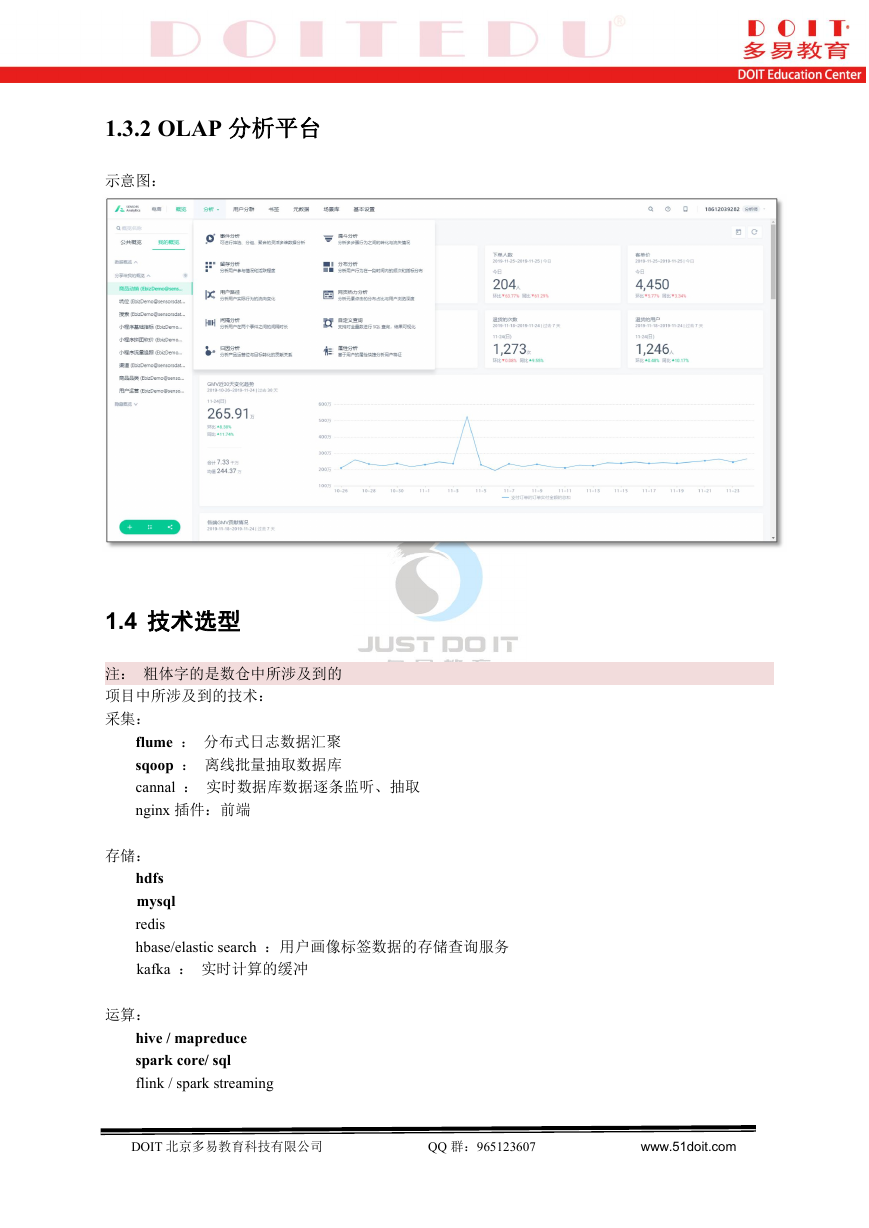

1.3.2 OLAP 分析平台

示意图:

1.4 技术选型

注: 粗体字的是数仓中所涉及到的

项目中所涉及到的技术:

采集:

flume : 分布式日志数据汇聚

sqoop : 离线批量抽取数据库

cannal : 实时数据库数据逐条监听、抽取

nginx 插件:前端

存储:

hdfs

mysql

redis

hbase/elastic search :用户画像标签数据的存储查询服务

kafka : 实时计算的缓冲

运算:

hive / mapreduce

spark core/ sql

flink / spark streaming

DOIT 北京多易教育科技有限公司

QQ 群:965123607

www.51doit.com

�

OLAP 引擎

Presto

数仓元数据管理(血缘管理):

Atlas

job 调度系统:

Azkaban

算法(用户画像/推荐系统):

spark 代码/sql 代码实现的通用统计计算;

图计算: SparkGraphx;

机器学习算法:

k 均值

KNN k 近邻

KMEANS

Naive Bayes 朴素贝叶斯

随机森林

协同过滤算法

各类相似度算法:欧几里得距离、余弦相似度、皮尔逊相关系数

NLP 算法:

TF-IDF 关键词提取

文本向量化算法

文本相似度算法

文本分类算法

关联规则分析:FP-GROWTH 算法/APRIORI 算法

DOIT 北京多易教育科技有限公司

QQ 群:965123607

www.51doit.com

�

2 【数据介绍篇】

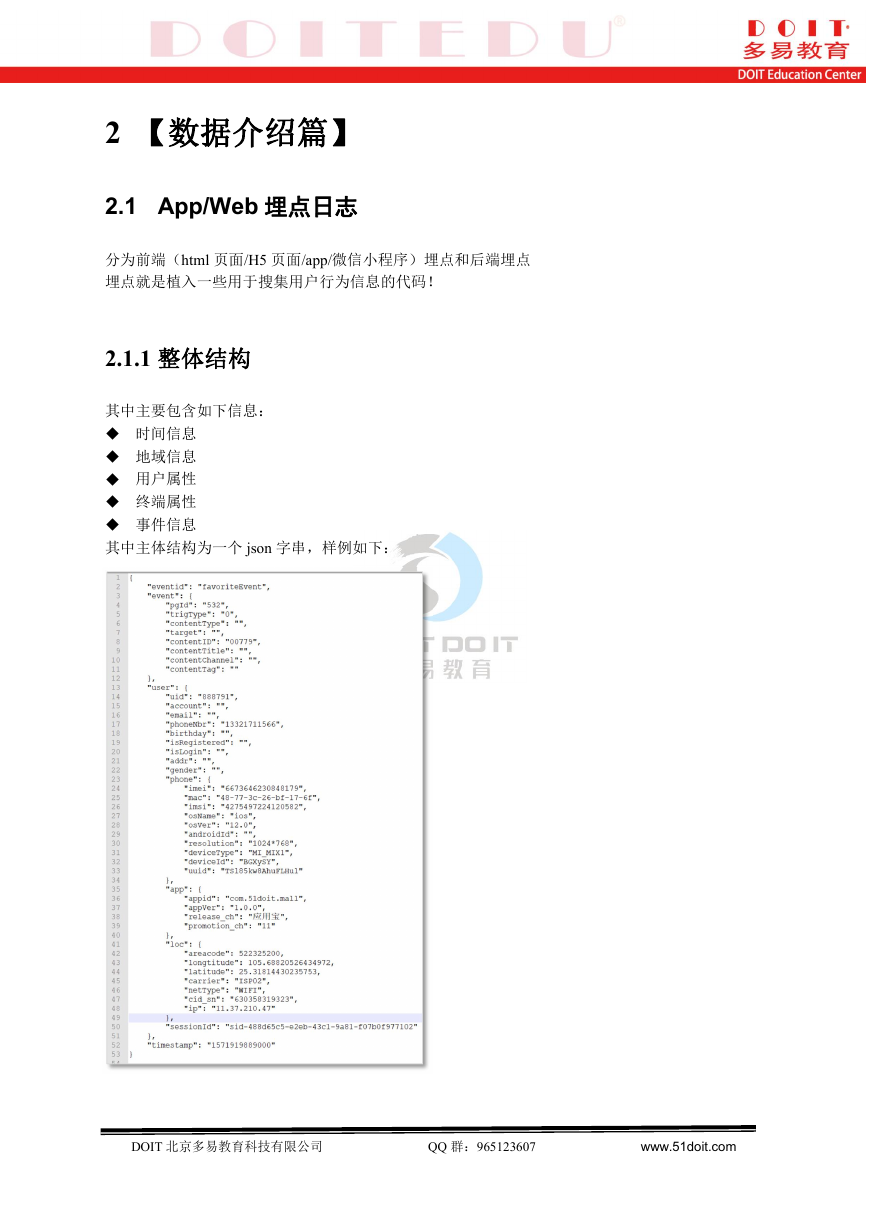

2.1 App/Web 埋点日志

分为前端(html 页面/H5 页面/app/微信小程序)埋点和后端埋点

埋点就是植入一些用于搜集用户行为信息的代码!

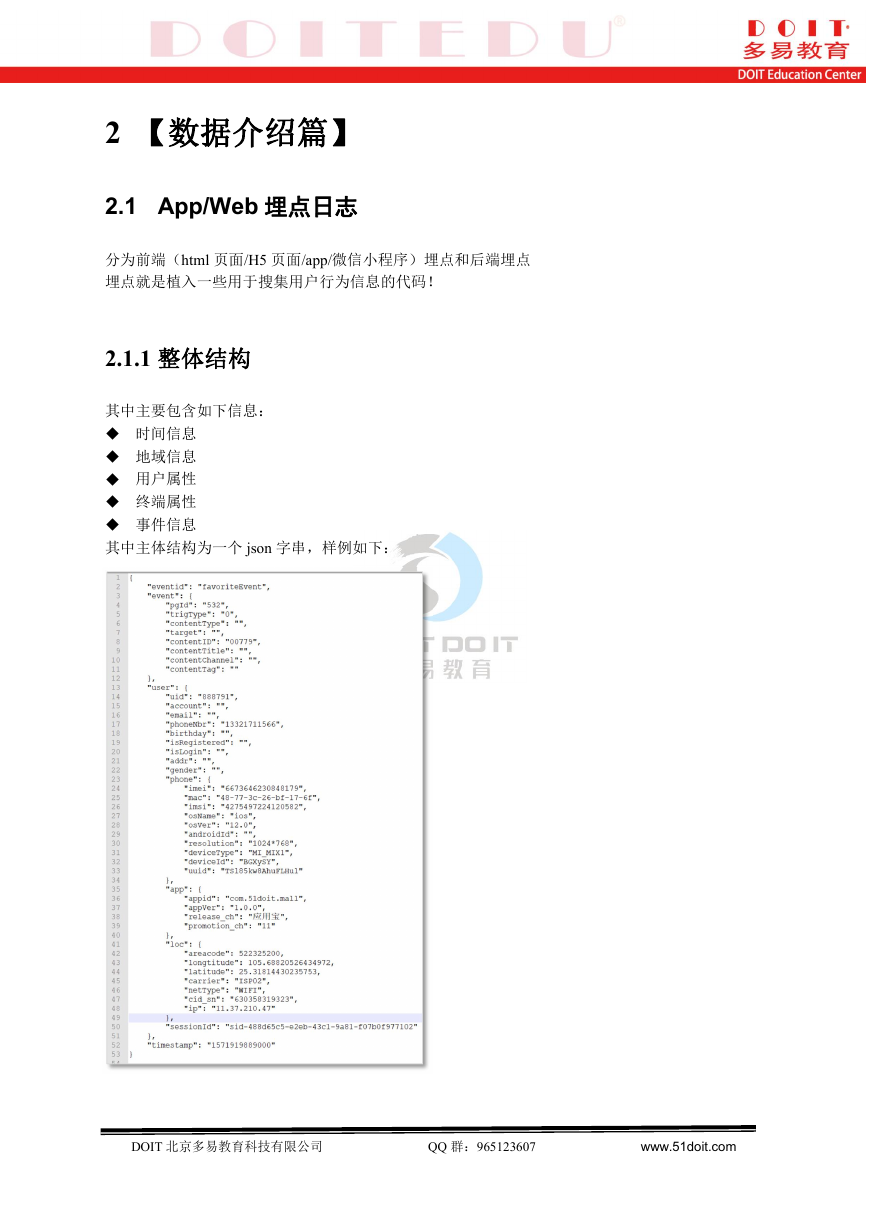

2.1.1 整体结构

其中主要包含如下信息:

时间信息

地域信息

用户属性

终端属性

事件信息

其中主体结构为一个 json 字串,样例如下:

DOIT 北京多易教育科技有限公司

QQ 群:965123607

www.51doit.com

�

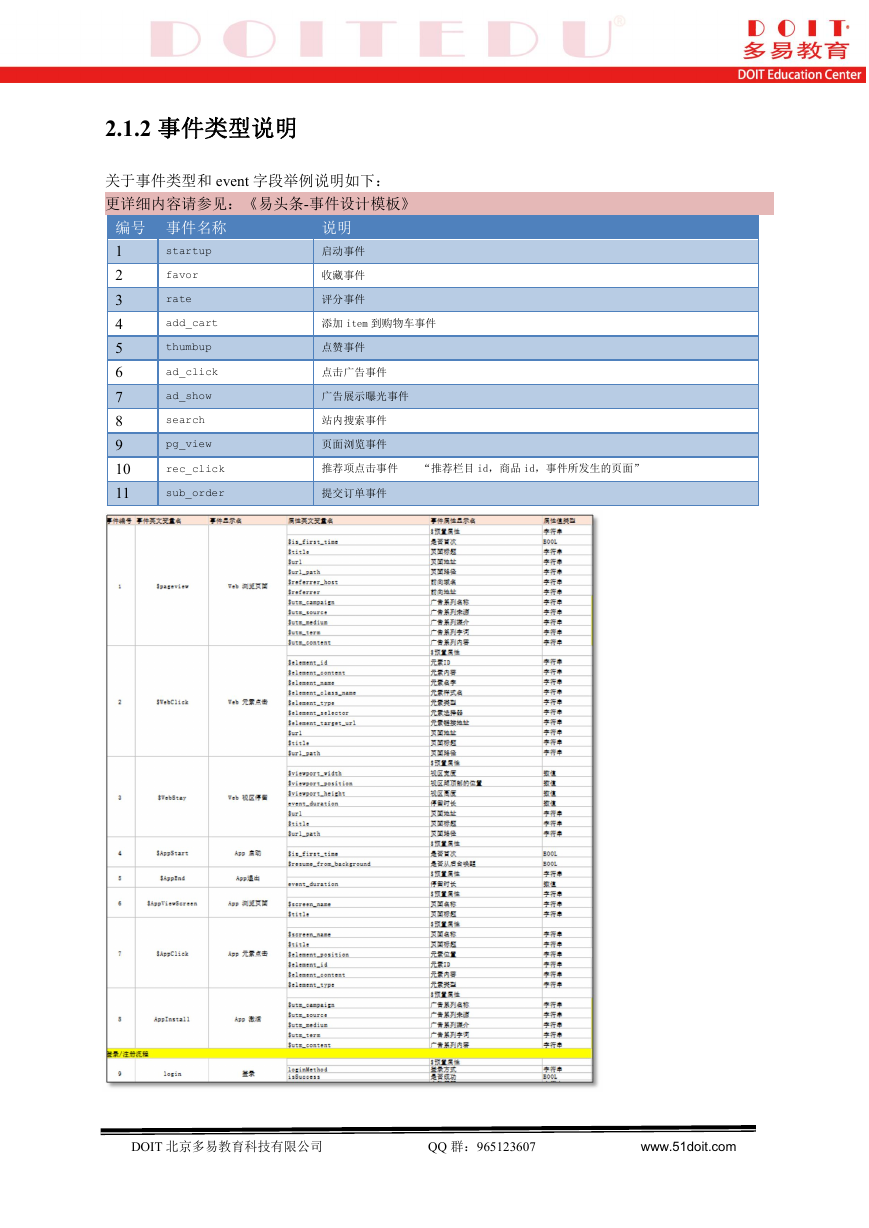

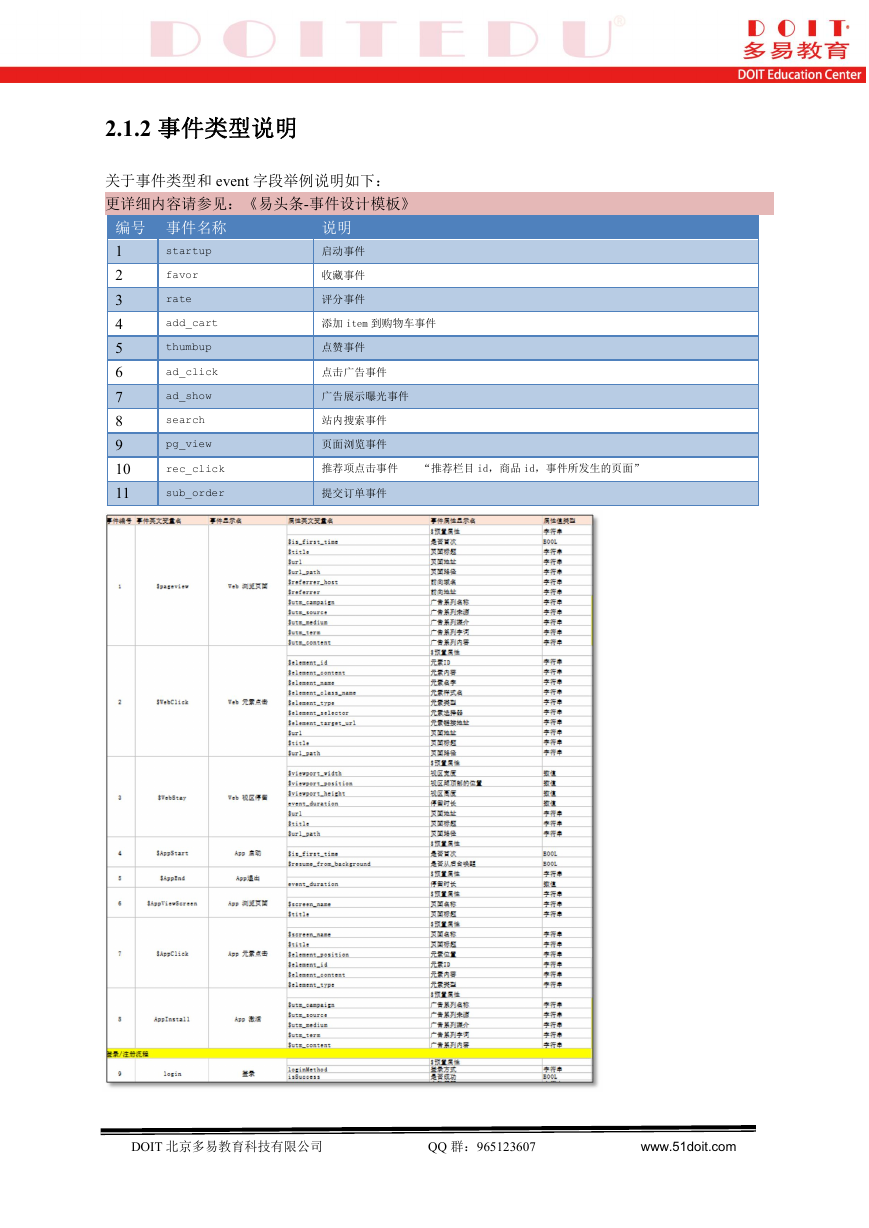

2.1.2 事件类型说明

关于事件类型和 event 字段举例说明如下:

更详细内容请参见:《易头条-事件设计模板》

编号 事件名称

1

2

3

4

5

6

7

8

9

10

11

startup

favor

rate

add_cart

thumbup

ad_click

ad_show

search

pg_view

rec_click

sub_order

说明

启动事件

收藏事件

评分事件

添加 item 到购物车事件

点赞事件

点击广告事件

广告展示曝光事件

站内搜索事件

页面浏览事件

推荐项点击事件

“推荐栏目 id,商品 id,事件所发生的页面”

提交订单事件

DOIT 北京多易教育科技有限公司

QQ 群:965123607

www.51doit.com

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc