极限学习机(Extreme Learning Machine,ELM)

一,ELM 概要

极 限 学 习 机 是 一 种 针 对 单 隐 含 层 前 馈 神 经 网 络 (Single-hidden Layer

Feedforward Neural Network, SLFN)的新算法。相对于传统前馈神经网络训练速度

慢,容易陷入局部极小值点,学习率的选择敏感等缺点,ELM 算法随机产生输入

层与隐含层的连接权值及隐含层神经元的阈值,且在训练过程中无需调整,只需

要设置隐含层神经元的个数,便可以获得唯一的最优解。与之前的传统训练方法

相比,ELM 方法具有学习速度快,泛化性能好等优点。

二,ELM 概述

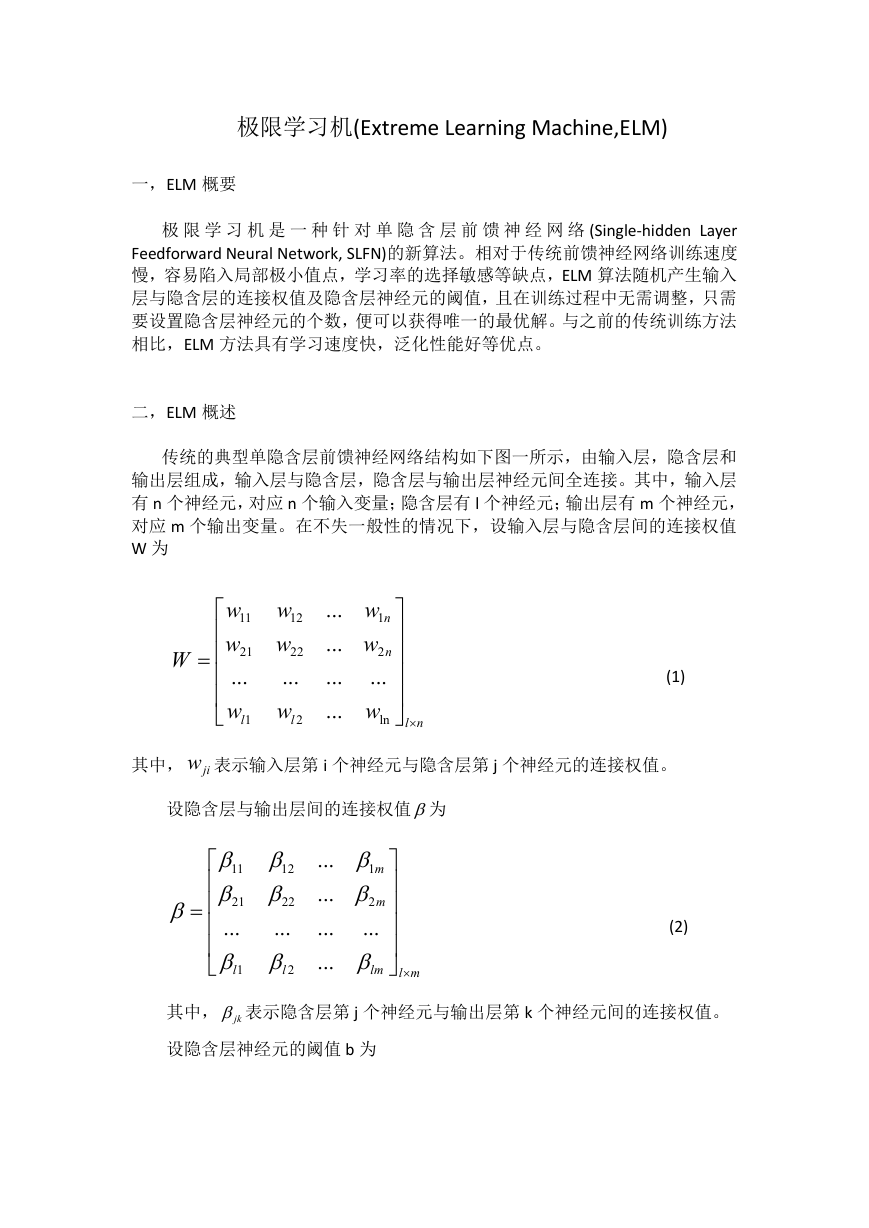

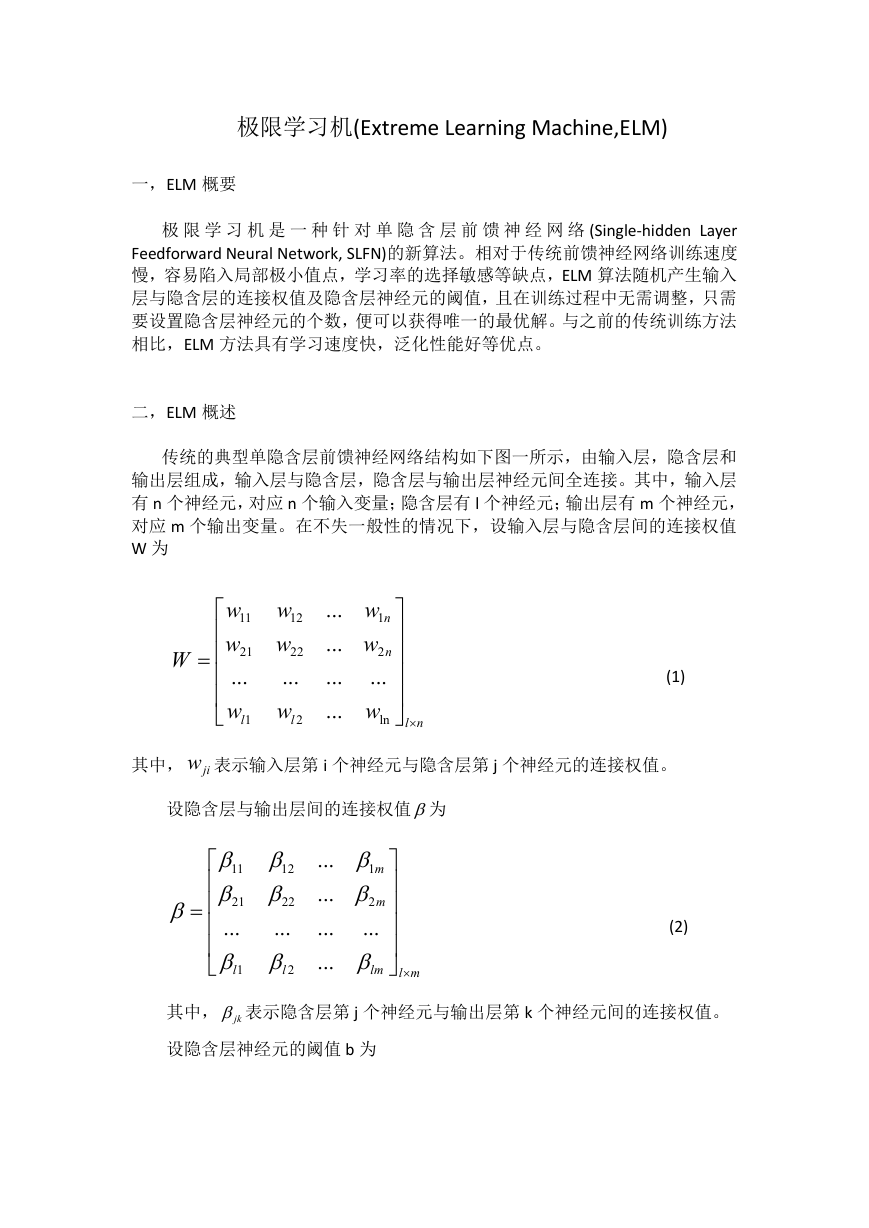

传统的典型单隐含层前馈神经网络结构如下图一所示,由输入层,隐含层和

输出层组成,输入层与隐含层,隐含层与输出层神经元间全连接。其中,输入层

有 n 个神经元,对应 n 个输入变量;隐含层有 l 个神经元;输出层有 m 个神经元,

对应 m 个输出变量。在不失一般性的情况下,设输入层与隐含层间的连接权值

W 为

W

w

11

w

21

...

w

l

1

w

12

w

22

...

w

l

2

...

...

...

...

w

n

1

w

n

2

...

w

ln

nl

(1)

其中, jiw 表示输入层第 i 个神经元与隐含层第 j 个神经元的连接权值。

设隐含层与输出层间的连接权值为

11

12

21

22

...

...

l

2

l

1

...

...

...

...

m

1

m

2

...

lm

ml

(2)

其中, jk 表示隐含层第 j 个神经元与输出层第 k 个神经元间的连接权值。

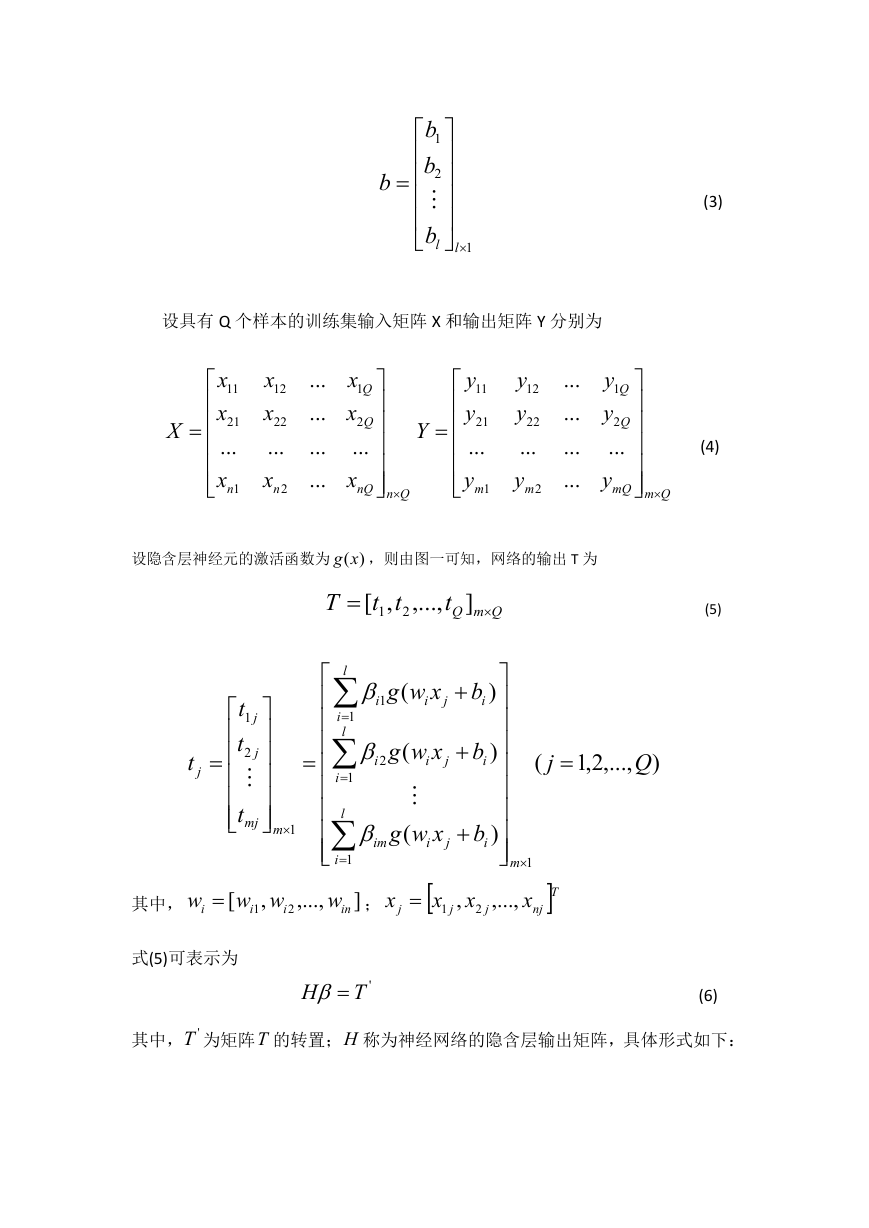

设隐含层神经元的阈值 b 为

�

b

b

1

b

2

lb

l

1

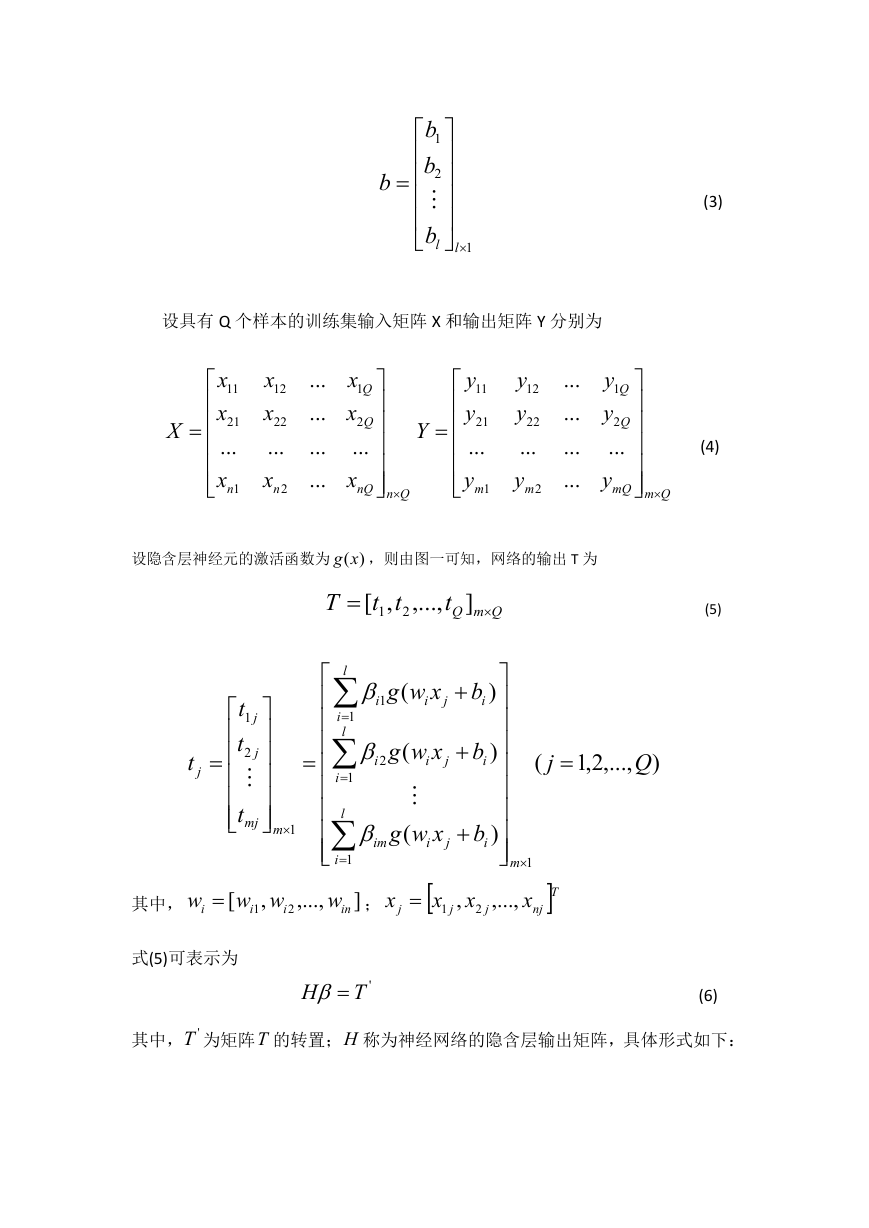

设具有 Q 个样本的训练集输入矩阵 X 和输出矩阵 Y 分别为

X

x

11

x

21

...

x

n

1

x

12

x

22

...

x

n

2

...

...

...

...

x

Q

1

x

Q

2

...

x

nQ

Qn

Y

y

11

y

21

...

y

m

1

y

12

y

22

...

y

m

2

...

...

...

...

y

Q

1

y

Q

2

...

y

mQ

Qm

设隐含层神经元的激活函数为 )(xg ,则由图一可知,网络的输出 T 为

T

t

,[

1

t

2

,...,

QmQt

]

t

j

(

j

,...,2,1

Q

)

j

j

t

1

t

mmj

2

t

l

i

1

l

i

1

l

1

i

1

i

1

xwg

(

i

j

b

i

)

i

2

xwg

(

i

j

b

i

)

xwg

(

i

im

b

i

)

j

其中,

w

i

[

ww

i

i

1

,

2

,...,

w

in

]

;

x

j

x

1

,

x

j

2

j

式(5)可表示为

H

'T

m

1

x

,...,

T

nj

(3)

(4)

(5)

(6)

其中, 'T 为矩阵T 的转置;H 称为神经网络的隐含层输出矩阵,具体形式如下:

�

2

1

1

,

,

xxb

wwH

bbw

,...,

(

,

,...,

,

,

l

l

2

1

2

1

xwg

xwg

b

b

)

)

(

(

1

1

1

2

bxwg

xwg

b

)

)

(

(

1

2

2

...

...

xwg

xwg

(

(

Q

Q

b

2

b

1

)

2

1

2

2

1

2

)

x

,...

Q

...

...

...

...

)

l

xwg

(

1

xwg

(

2

...

xwg

(

Q

l

l

b

l

b

l

)

)

b

l

)

lQ

(7)

在前人的基础上,黄广斌等人提出了以下两个定理:

定理 1 给定任意Q 个不同样本(

(

i tx ,其中,

,

)

i

x

i

[

x

i

1

,

x

i

2

,...,

x

in

T

]

n

R

,

t

i

t

[

,

t

i

2

,...,

t

i

1

im

]

R

m

,一个任意区间无限可微的激活函数

于具有Q 个隐含层神经元的 SLFN,在任意赋值

i Rw 和

n

隐含层输出矩阵 H 可逆且有

||

H

T

'

0||

.

Rg :

R,则对

bi 的情况下,其

R

定理 2 给定任意Q 个不同样本

(

i tx

,

i

)

,其中,

x

i

[

x

i

1

,

x

i

2

,...,

x

in

T

]

n

R

,

t

i

t

[

,

t

i

2

,...,

t

i

1

im

]

R

m

,给定任意小误差

0 ,和一个任意区间无限可微的

激活函数

Rg :

任意赋值

i Rw 和

n

R,则总存在一个含有 K

bi 的情况下,有

R

(

QK 个隐含层神经元的 SLFN,在

)

||

H

'T

||

.

mMMN

由定理 1 可知,若隐含层神经元个数与训练集样本个数相等,则对于任意的 w 和

b ,SLFN 都可以零误差逼近训练样本,即

Q

||

t

j

j

1

y

mj

其中,

y

j

[

y

1

j

,

y

2

j

,...,

T

(]

j

,...,2,1

Q

)

.

y

j

0||

(8)

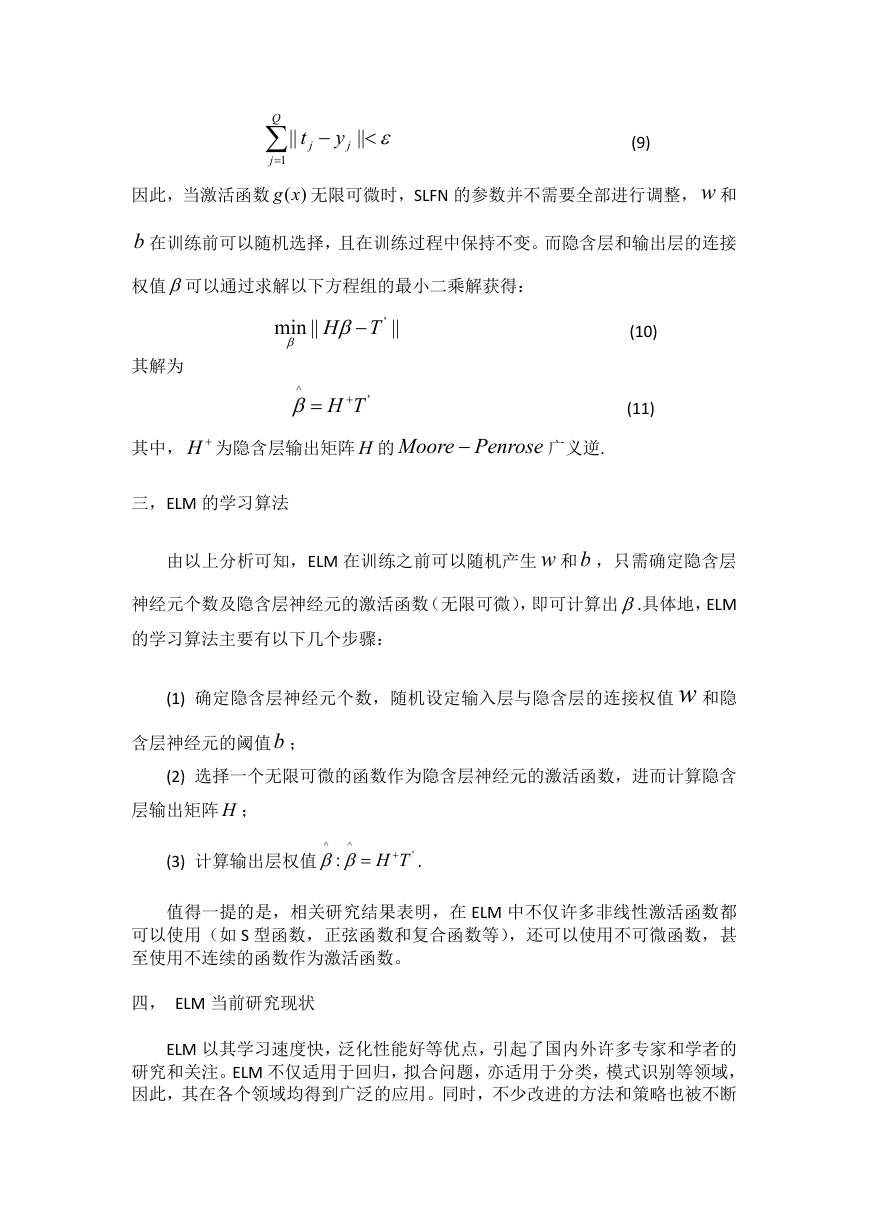

然而,当训练样本个数Q 较大时,为了减少计算量,隐含层神经元个数 K 通常

取比Q 小的数,由定理 2 可知,SLFN 的训练误差逼近一个任意的

0 ,即

�

||

t

j

Q

j

1

y

j

||

(9)

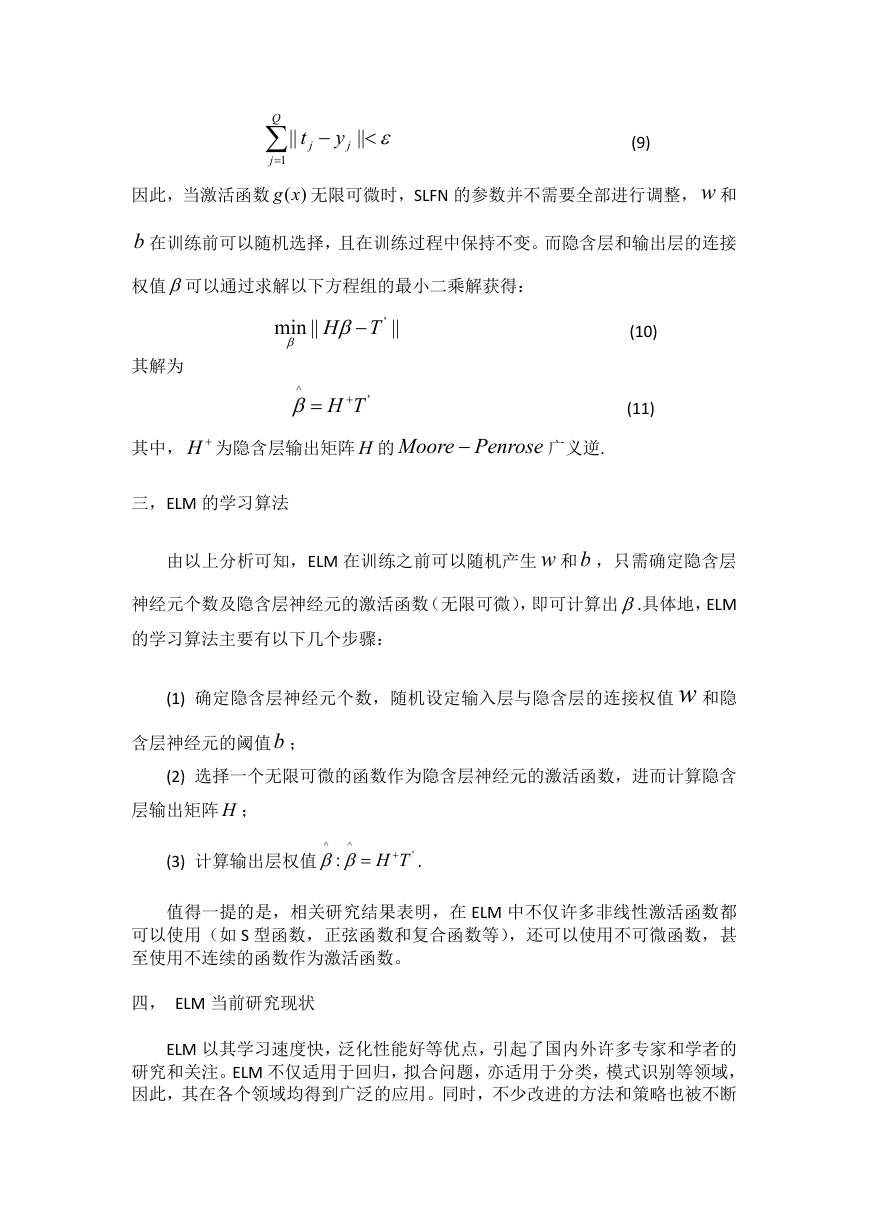

因此,当激活函数 )(xg 无限可微时,SLFN 的参数并不需要全部进行调整,w 和

b 在训练前可以随机选择,且在训练过程中保持不变。而隐含层和输出层的连接

权值可以通过求解以下方程组的最小二乘解获得:

其解为

||min

H

'T

||

^

TH

'

(10)

(11)

其中, H 为隐含层输出矩阵 H 的

Moore

Penrose

广义逆.

三,ELM 的学习算法

由以上分析可知,ELM 在训练之前可以随机产生 w 和 b ,只需确定隐含层

神经元个数及隐含层神经元的激活函数(无限可微),即可计算出.具体地,ELM

的学习算法主要有以下几个步骤:

(1) 确定隐含层神经元个数,随机设定输入层与隐含层的连接权值 w 和隐

含层神经元的阈值b ;

(2) 选择一个无限可微的函数作为隐含层神经元的激活函数,进而计算隐含

层输出矩阵 H ;

(3) 计算输出层权值

^

^

:

TH

'

.

值得一提的是,相关研究结果表明,在 ELM 中不仅许多非线性激活函数都

可以使用(如 S 型函数,正弦函数和复合函数等),还可以使用不可微函数,甚

至使用不连续的函数作为激活函数。

四, ELM 当前研究现状

ELM 以其学习速度快,泛化性能好等优点,引起了国内外许多专家和学者的

研究和关注。ELM 不仅适用于回归,拟合问题,亦适用于分类,模式识别等领域,

因此,其在各个领域均得到广泛的应用。同时,不少改进的方法和策略也被不断

�

提及,ELM 的性能也得到了很大的提升,其应用范围亦愈来愈广,其重要性亦日

益体现出来。

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc