20

2019,55(13)

Computer Engineering and Applications 计算机工程与应用

基于注意力机制的 CNN-LSTM 模型及其应用

李 梅 1,2,宁德军 1,郭佳程 1,2

1. 中国科学院 上海高等研究院,上海 200120

2. 中国科学院大学,北京 100049

摘 要:时序数据存在时序性,并且其短序列的特征存在重要程度差异性。针对时序数据特征,提出一种基于注意

力机制的卷积神经网络(CNN)联合长短期记忆网络(LSTM)的神经网络预测模型,融合粗细粒度特征实现准确的时

间序列预测。该模型由两部分构成 :基于注意力机制的 CNN,在标准 CNN 网络上增加注意力分支,以抽取重要细粒

度特征 ;后端为 LSTM,由细粒度特征抽取潜藏时序规律的粗粒度特征。在真实的热电联产供热数据上的实验表明,

该模型比差分整合移动平均自回归、支持向量回归、CNN 以及 LSTM 模型的预测效果更好,对比目前企业将预定量

作为预测量的方法,预测缩放误差平均值(MASE)与均方根误差(RMSE)指标分别提升了 89.64%和 61.73%。

关键词:注意力机制 ;卷积神经网络(CNN);长短期记忆网络(LSTM);时间序列 ;负荷预测

文献标志码:A 中图分类号:TP391;TK01

doi:10.3778/j.issn.1002-8331.1901-0246

李梅,宁德军,郭佳程 . 基于注意力机制的 CNN-LSTM 模型及其应用 . 计算机工程与应用,2019,55(13):20-27.

LI Mei, NING Dejun, GUO Jiacheng. Attention mechanism- based CNN- LSTM model and its application. Computer

Engineering and Applications, 2019, 55(13):20-27.

Attention Mechanism-Based CNN-LSTM Model and Its Application

LI Mei1,2, NING Dejun1, GUO Jiacheng1,2

1.Shanghai Advanced Research Institute, Chinese Academy of Sciences, Shanghai 200120, China

2.University of Chinese Academy of Sciences, Beijing 100049, China

Abstract:Time series have temporal property, and the characteristics of its short sequences are different in importance.

Aiming at the characteristics of time series, a neural network prediction model based on Convolution Neural Network

(CNN)and Long Short-Term Memory(LSTM)is proposed, which combines coarse and fine grain features to achieve

accurate time series prediction. The model consists of two parts. CNN based on attention mechanism adds attention

branch to standard CNN network to extract important fine- grained features. The back end is LSTM, which extracts the

coarse-grained features of the hidden time series from fine-grained features. Experiments on real cogeneration heat load

dataset demonstrate that the model is better than the autoregressive integrated moving average, support vector regression,

CNN and LSTM models. Compared with the pre- determined method currently used by enterprises, the Mean Absolute

Scaled Error(MASE)and Root Mean Square Error(RMSE)have been increased by 89.64% and 61.73% respectively.

Key words:attention mechanism; Convolution Neural Network(CNN); Long Short- Term Memory Network(LSTM);

time series; load forecasting

1 引言

时间序列一般定义为依据发生时间的前后顺序,排

列相同统计指标的数值所形成的有序集合。时序预测

具有重要的应用价值,是近年来热门研究课题之一 [1]。

时间序列数据[2]具有时序相关性,并且时序特征在时间

维度上具有不同重要程度,某些子序列的特征重要程度

基金项目:中国科学院战略性先导科技专项(No.XDA06010800)。

作者简介:李梅(1993—),女,硕士研究生,研究领域为数据挖掘、智能信息处理,E-mail:limei@sari.ac.cn;宁德军(1972—),男,博

士,正高级工程师,研究领域为数据挖掘、软件工程;郭佳程(1995—),男,硕士研究生,研究领域为数据挖掘、区块链。

收稿日期:2019-01-17 修回日期:2019-03-11 文章编号:1002-8331(2019)13-0020-08

CNKI 网络出版:2019-04-18, http://kns.cnki.net/kcms/detail/11.2127.tp.20190416.1717.016.html

计算机工程与应用www.ceaj.org�

李 梅,等:基于注意力机制的 CNN-LSTM 模型及其应用

2019,55(13)

21

大于其他子序列,当前模型通常没有考虑不同特征的重

要程度[3]。

现有时间序列预测技术可总结为统计方法和机器

学习方法两大类 [1,4]。以自回归求和滑动平均(Autore-

gressive Integrated Moving Average,ARIMA)模型 [4]为

代表的统计方法适用于线性系统预测,以人工神经网

络、支持向量机为代表的机器学习方法适用于复杂非线

性的时间序列。Hochreiter[5]等人提出的机器学习方法

长短期记忆网络(Long Short-Term Memory Network,

LSTM),具备一定的长距离时序数据的信息挖掘能力,

被广泛应用于语音识别、机器翻译、故障预测和负荷预

测 [1,5-6]等领域。输入越长,其所含信息量越多,而面对

过长序列时,训练单一 LSTM 时会出现不稳定性和梯度

消失现象,故而不能捕捉非常长期的相互依赖性 [3,5,7]。

因此,有学者融合卷积神经网络(Convolution Neural

Network,CNN)与 LSTM 用于行为预测、语音识别等领

域[8-12],文献[11]运用 CNN 学习可穿戴传感器数据特征,

结合 LSTM 建模动作间的时间依赖性;文献[12]运用

CNN 从原始网络自动学习语音信号的最佳表示,结合

LSTM 学习最佳时间表示。这类方法的共有思想是借

助 CNN 的短序列特征抽象能力提取高维特征 ,再由

LSTM 综合短序列高维特征进行时序预测,适合处理具

备局部相关性的时序数据。但通常在时间维度上时序

特征的重要程度并不一致,例如,预测天气时,潜藏在异

常天气数据中的特征将比正常天气的特征重要;负荷预

测时,潜藏在异常峰值时期的特征比平稳运行时期的特

征重要。这类时序特征重要程度的差异性,标准 CNN

模型难以体现,由于重要特征较少出现,可能会导致模

型错误评估其重要性甚至直接忽略特征[3,13]。

专家学者根据对人类视觉的研究,提出了注意力机

制[14],计算机视觉、自然语言处理等领域[14-17]引入该机制

优化现有模型,学习并确定重点关注的目标区域,使模

型能够在有限资源下关注最有效的信息。本文基于这

一机制改进 CNN 联合 LSTM 的体系结构,通过注意力

机制处理被现有结构忽略的短序列特征的重要度差异,

提取显著细粒度特征,同时便于 LSTM 更有效地捕捉时

间依赖性。

针对 CNN 联合 LSTM 时,忽略短期特征重要度而

导致的重要特征丢失、长期时序规律挖掘有待优化等问

题 ,本 文 提 出 基 于 注 意 力 机 制 的 CNN-LSTM 预 测 模

型。设计基于注意力机制的 CNN 结构,基于标准 CNN,

以并行注意力支路提取显著性特征。注意力支路比

CNN 设计了更大的输入尺度,以扩大输入感受野,从而

更全面获取时序上下文信息,学习局部序列特征的重要

程度。注意力模块通过提升最终模型中重要时序特征

的影响力,降低最终模型中非重要特征的影响力,有效

地应对模型未能较好区分时序特征重要程度差异性的

不足。同时,标准 CNN 模块和注意力机制模块以不同

长度序列作为输入的多尺度输入方式,能有效提取更丰

富的短序列特征。LSTM 从前端抽取出的细粒度特征

中抽取粗粒度特征,精细化处理不同维度特征,并且能

够一定程度避免因步长过长造成的记忆丢失和梯度弥

散。通过基于注意力机制的 CNN-LSTM 模型,实现粗

细粒度特征融合,全面刻画时序数据。

负荷需求量预测为典型的时序预测问题,负荷需求

量变化受不同特征影响,并且短时间内各特征的影响程

度不同[13]。本文对热电联产企业历史数据进行实验,设

计并调整模型结构,最终搭建一种有效的时序预测模

型,实验预测结果优于自回归积分滑动平均、支持向量

回归和单一的神经网络模型。

2 背景知识

2.1 卷积神经网络

2.1.1 卷积神经网络原理

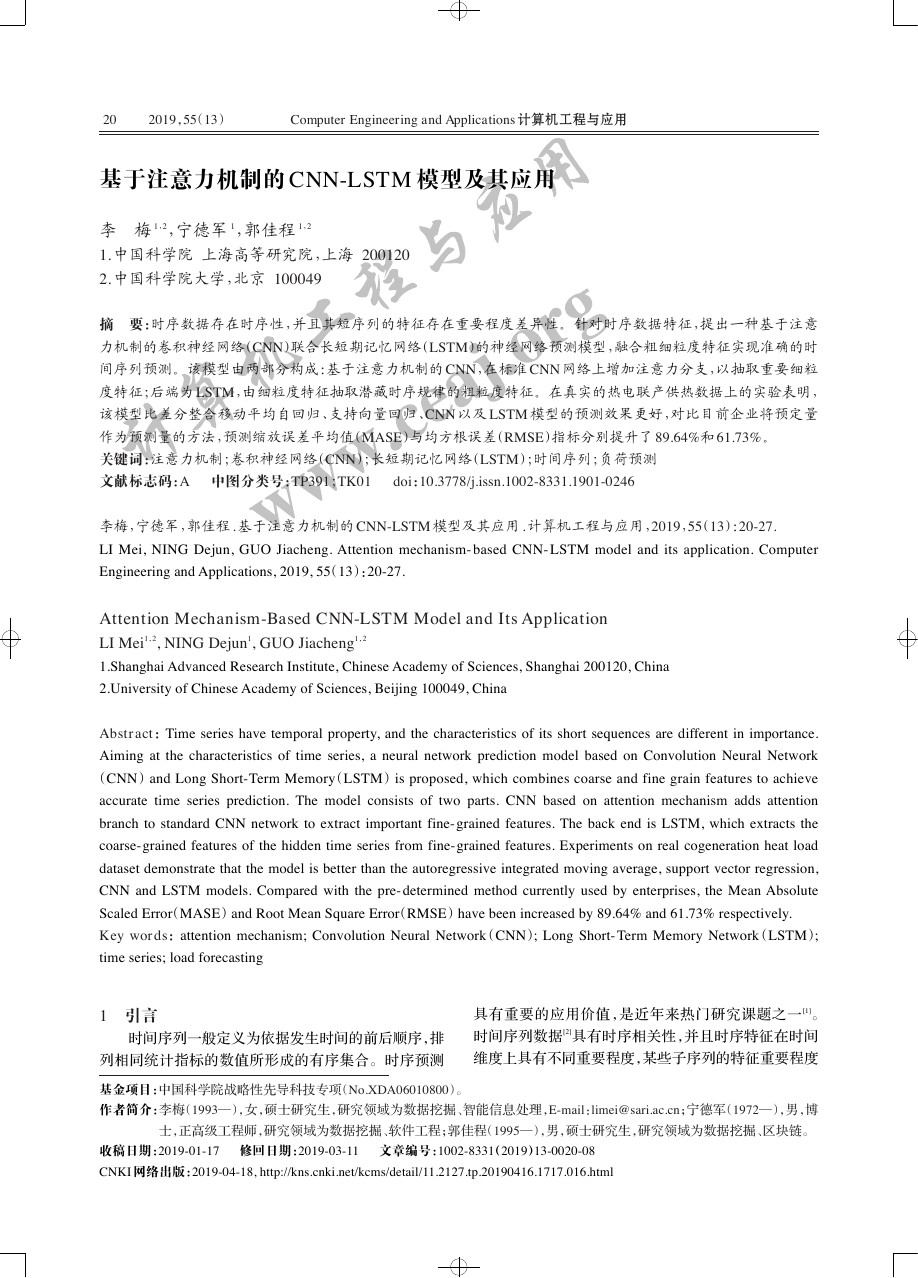

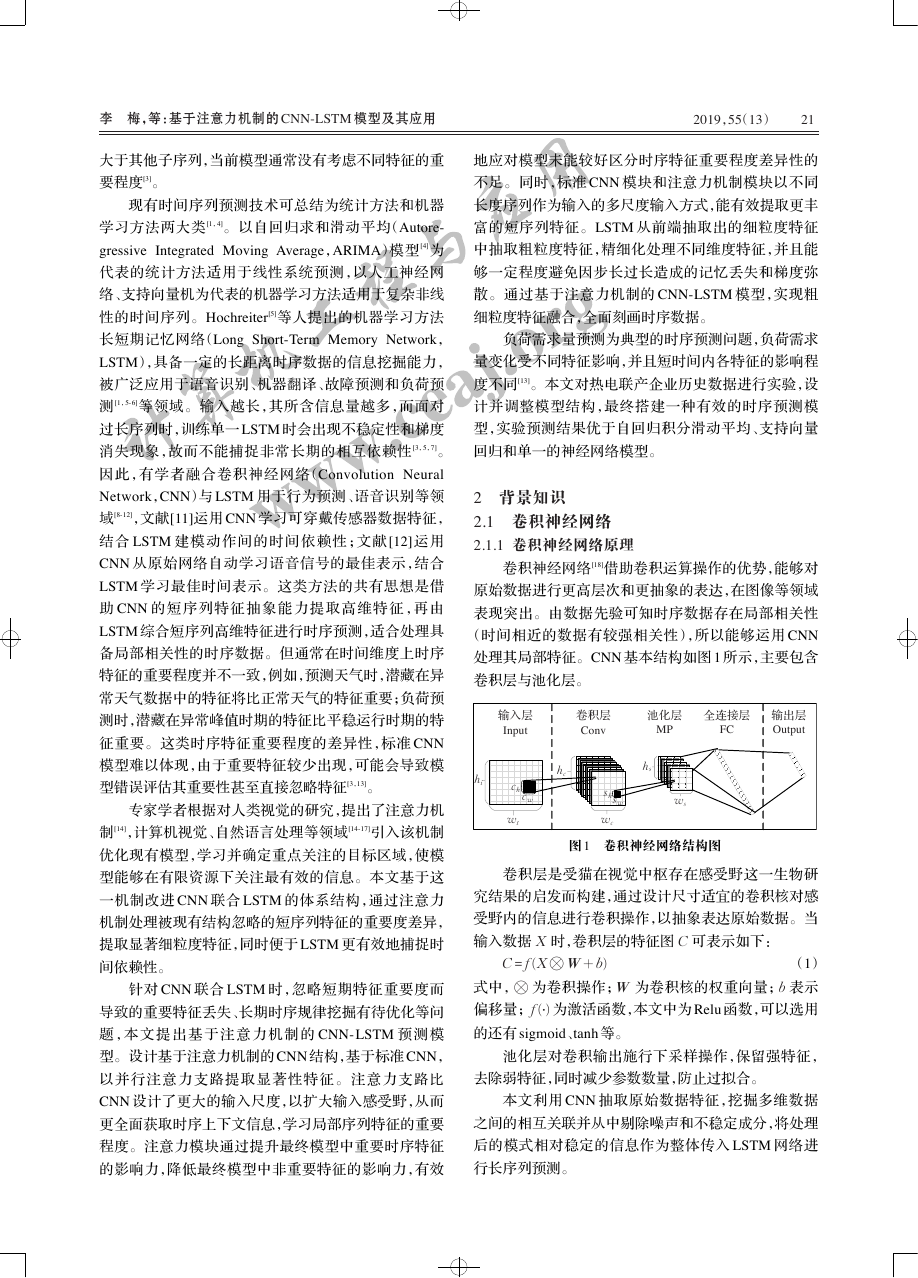

卷积神经网络[18]借助卷积运算操作的优势,能够对

原始数据进行更高层次和更抽象的表达,在图像等领域

表现突出。由数据先验可知时序数据存在局部相关性

(时间相近的数据有较强相关性),所以能够运用 CNN

处理其局部特征。CNN 基本结构如图 1 所示,主要包含

卷积层与池化层。

输入层

Input

卷积层

Conv

池化层

全连接层

MP

FC

输出层

Output

hi

ch

cw

wt

hc

hs

shsw

wc

ws

图 1 卷积神经网络结构图

卷积层是受猫在视觉中枢存在感受野这一生物研

究结果的启发而构建,通过设计尺寸适宜的卷积核对感

受野内的信息进行卷积操作,以抽象表达原始数据。当

输入数据 X 时,卷积层的特征图 C 可表示如下:

C = f (X ⊗ W + b)

(1)

式中,⊗ 为卷积操作;W 为卷积核的权重向量;b 表示

偏移量;f (⋅) 为激活函数,本文中为 Relu 函数,可以选用

的还有 sigmoid、tanh 等。

池化层对卷积输出施行下采样操作,保留强特征,

去除弱特征,同时减少参数数量,防止过拟合。

本文利用 CNN 抽取原始数据特征,挖掘多维数据

之间的相互关联并从中剔除噪声和不稳定成分,将处理

后的模式相对稳定的信息作为整体传入 LSTM 网络进

行长序列预测。

计算机工程与应用www.ceaj.org�

22

2019,55(13)

Computer Engineering and Applications 计算机工程与应用

2.1.2 注意力机制原理

专家学者根据对人类视觉的研究,提出了注意力机

制[12],实现信息处理资源的高效分配。由于长时间序列

的短子序列中特征重要程度存在差异,重要的显著特征

往往会包含更多信息量,对实际需求量的趋势影响程度

更大。假若赋予 CNN 更关注高重要度特征的能力,可

以更好实现短期模式的有效提取和 LSTM 输入信息的

优化。因此,本文使用注意力机制提取短序列的显著性

特征。

注意力机制可归结为硬注意力(hard attention)与

软注意力(soft attention)[19]。硬注意力机制筛选出受关

注区域当作输入,在图像研究领域剔除无意义的背景数

据后输入,能够有效聚焦目标物体。硬注意力机制采用

直接限制输入内容的处理方法,在时序预测领域并不完

全适用。即使输入序列的重要程度存在差异,但由于各

输入子序列均含有一定信息,这些信息存在于序列的不

同位置,无法明确定位以去除。此外,硬注意力机制需

要用强化学习优化,训练难度较高,通用性较差。相较

而言,软注意力机制以神经网络训练出的权值,在空间

或通道上加权全局输入特征,从而达到关注特定空间区

域或通道的目的。同时,这一方式在反向计算时为可微

的,故而能够采用端到端的学习方式,直接学习注意力

网络。基于上述原理,本文将软注意力机制引入一维

CNN,为所有输入特征逐个加权,关注特定空间和通道,

实现时间序列的显著细粒度特征的提取。

2.2 长短期记忆网络

LSTM 是由循环神经网络衍生而来的时序卷积神

经网络,通过引入门函数,可以挖掘时间序列中相对较

长间隔和延迟等的时序变化规律[5]。

LSTM 内部结构如图 2 所示,xt 指代第 t 个输入序

列元素值;c 指代记忆单元(cell)或称为细胞状态,是网

络的核心,控制信息的传递;i 指代输入门(input gate)

决定当前 xt 保留多少信息给 ct ;f 指代遗忘门(forget

gate)决定保存多少前一时刻的细胞状态 ct - 1 至当前的

ct ;o 指代输出门(output gate)决定 ct 传递多少至当前

状态的输出 ht ;ht - 1 指代在 t - 1 时刻的隐层状态。上

述过程对应公式如下所示:

输入门 i

输出门

o

ct - 1

ht - 1

xt

输入模块

记忆单元

c

ht

f

遗忘门

(2)

(3)

it = σ(Wxi xt + Whiht - 1 + bi)

ft = σ(Wxf xt + Whf ht - 1 + bf )

ot = σ(Wxo xt + Whoht - 1 + bo)

~ct = tanh(Wxc xt + Whcht - 1 + bc)

ct = ft⊙ct - 1 + it⊙~ct

ht = ot⊙ tanh(ct)

(4)

(5)

(6)

(7)

式中,Wxi 、Wxf 、Wxo 、Wxc 分别指代输入层到输入门、

遗忘门、输出门与细胞状态的权重向量;Whi 、Whf 、

Who 、Whc 分别指代隐藏层到输入门、遗忘门、输出门与

细胞状态的权重向量;bi 、bf 、bo 、bc 分别指代输入门、

遗忘门、输出门与细胞状态的偏移量;σ(⋅) 指代 sigmoid

激活函数;tanh 指代双曲正切激活函数;⊙ 表示向量

元素乘。常规应用中,会继续通过全连接等步骤由 ht

获取最终的预测值 pt 。

LSTM 通过门函数,控制历史信息的传递,具备一

定的时间序列处理与预测能力。理论上其步长越长,挖

掘出的信息量越多。然而在步长超出一定长度时,仍旧

会出现远距离记忆丢失及梯度消失。本文通过优化

CNN 网络,更有效提取子序列特征,去除干扰信息后输

入 LSTM,尽可能保留更长的有效记忆信息,减少 LSTM

步长,解决梯度弥散问题。

3 基于注意力机制的神经网络模型

3.1 时间序列预测模型体系架构

基于注意力机制与神经网络,构建时间序列预测模

型,本文称之为“基于注意力机制的 CNN-LSTM”,其整

体架构如图 3 所示。

预处理

Attention&CNN 单元 LSTM 单元

输出

CNNs

Attention

CNNs

Attention

LSTM

LSTM

原

始

数

据

集

…

…

…

CNNs

Attention

LSTM

预

测

量

图 2 LSTM 内部结构图

图 3 基于注意力机制的 CNN-LSTM 模型整体架构图

计算机工程与应用www.ceaj.org···�

李 梅,等:基于注意力机制的 CNN-LSTM 模型及其应用

2019,55(13)

23

基于注意力机制的 CNN-LSTM 模型由数据预处

理、基于注意力机制的 CNN 单元、LSTM 单元和输出单

元三部分构成,详细介绍如下。

(1)数据预处理:针对异常数据,采用临近均值进行

替换;针对不同变量取值大小相差较大,进行归一化。

按照 4.3 节介绍的划分方法将数据集划分为训练集、测

试集和验证集。

(2)基于注意力机制的 CNN 单元:从原始数据中截

取多个部分重叠的连续子序列作为该单元的输入,详细

模型结构和处理步骤在 3.2 节介绍。

(3)LSTM 单元:将前一单元的输出作为本单元的

输入,搭建时间序列预测模型。

(4)输出单元:LSTM 网络中最后的隐层进行输出。

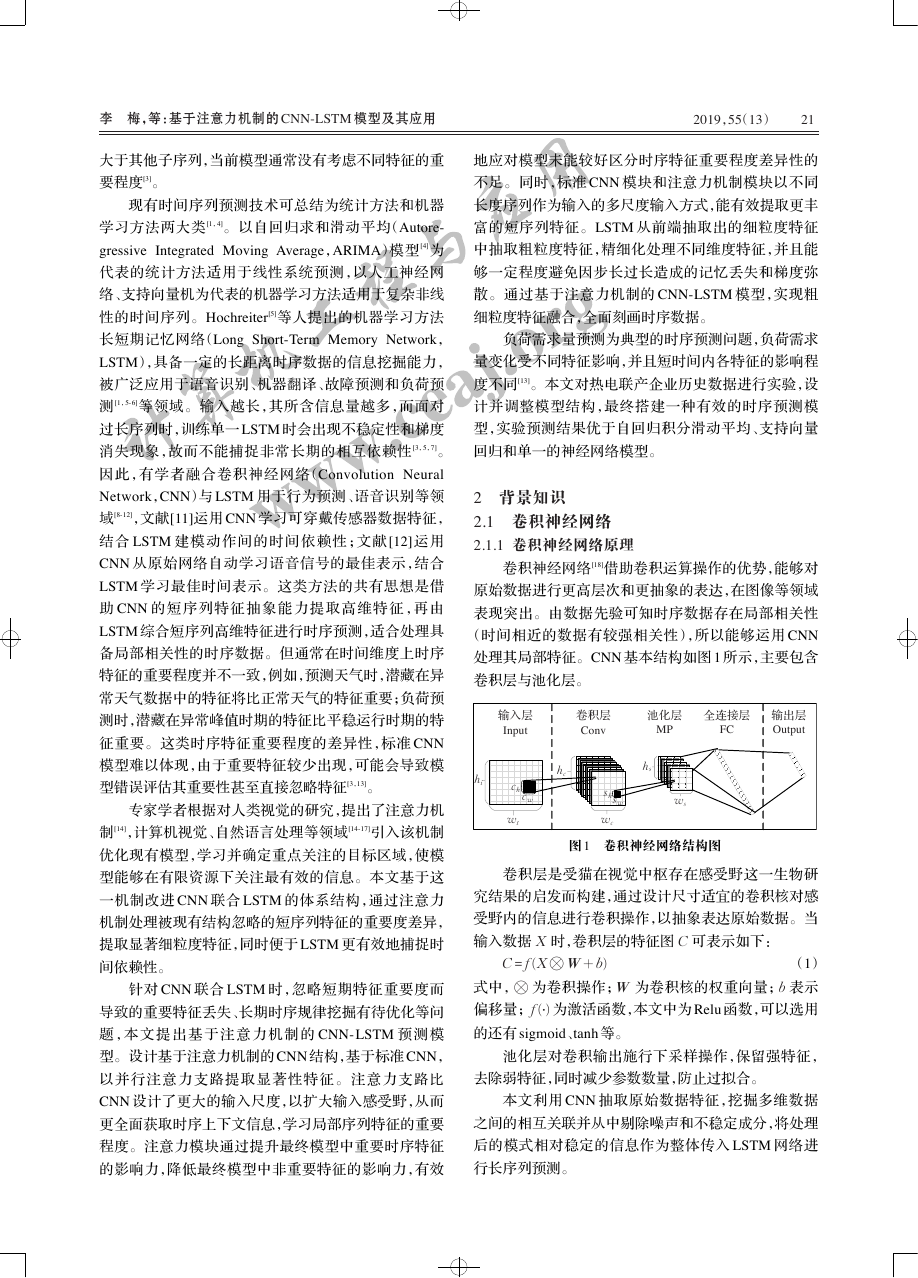

3.2 基于注意力机制的 CNN 结构

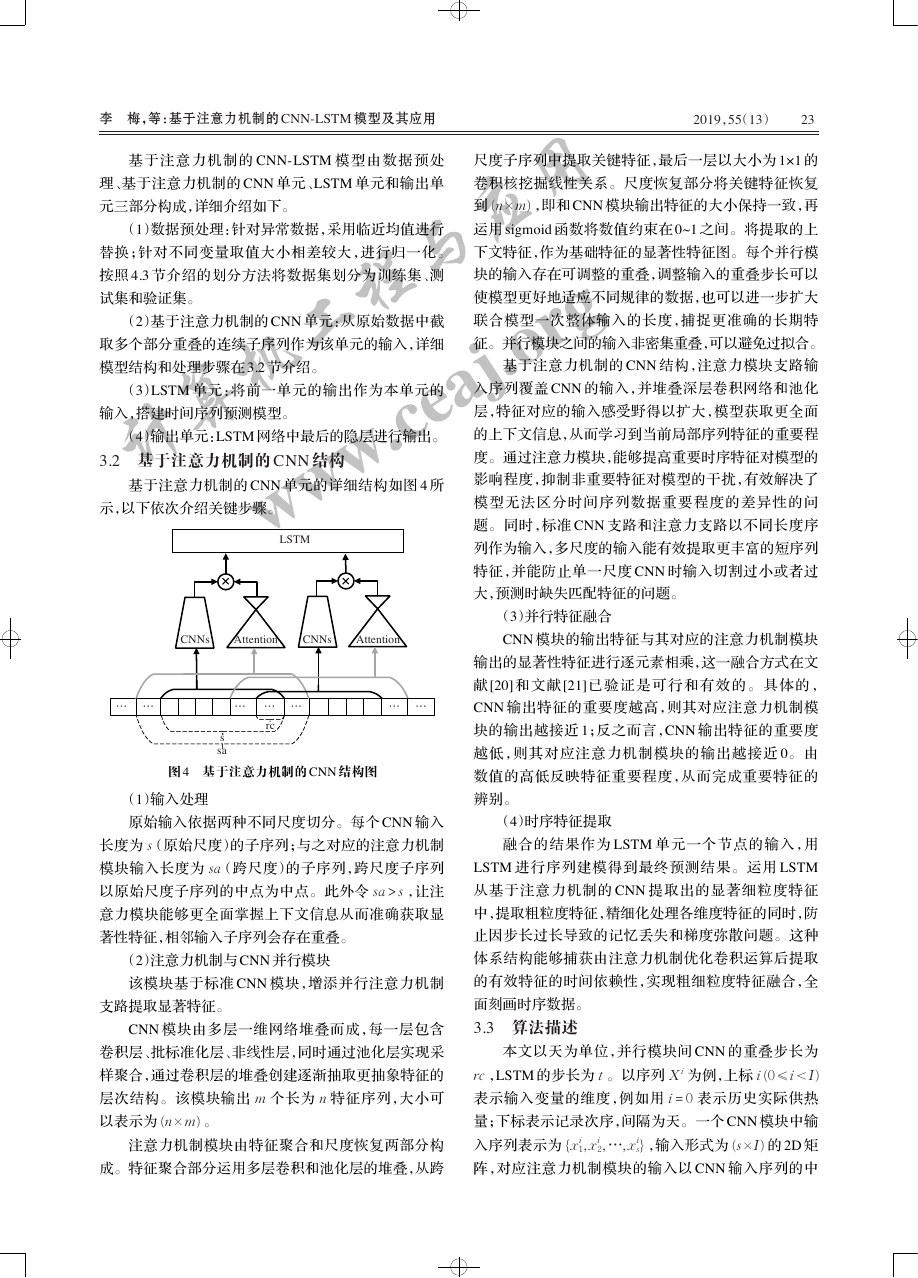

基于注意力机制的 CNN 单元的详细结构如图 4 所

示,以下依次介绍关键步骤。

LSTM

CNNs

Attention

CNNs

Attention

… …

… … …

… …

rc

s

sa

图 4 基于注意力机制的 CNN 结构图

(1)输入处理

原始输入依据两种不同尺度切分。每个 CNN 输入

长度为 s(原始尺度)的子序列;与之对应的注意力机制

模块输入长度为 sa(跨尺度)的子序列,跨尺度子序列

以原始尺度子序列的中点为中点。此外令 sa > s ,让注

意力模块能够更全面掌握上下文信息从而准确获取显

著性特征,相邻输入子序列会存在重叠。

(2)注意力机制与 CNN 并行模块

该模块基于标准 CNN 模块,增添并行注意力机制

支路提取显著特征。

CNN 模块由多层一维网络堆叠而成,每一层包含

卷积层、批标准化层、非线性层,同时通过池化层实现采

样聚合,通过卷积层的堆叠创建逐渐抽取更抽象特征的

层次结构。该模块输出 m 个长为 n 特征序列,大小可

以表示为 (n × m) 。

注意力机制模块由特征聚合和尺度恢复两部分构

成。特征聚合部分运用多层卷积和池化层的堆叠,从跨

尺度子序列中提取关键特征,最后一层以大小为 1×1 的

卷积核挖掘线性关系。尺度恢复部分将关键特征恢复

到 (n × m) ,即和 CNN 模块输出特征的大小保持一致,再

运用 sigmoid 函数将数值约束在 0~1 之间。将提取的上

下文特征,作为基础特征的显著性特征图。每个并行模

块的输入存在可调整的重叠,调整输入的重叠步长可以

使模型更好地适应不同规律的数据,也可以进一步扩大

联合模型一次整体输入的长度,捕捉更准确的长期特

征。并行模块之间的输入非密集重叠,可以避免过拟合。

基于注意力机制的 CNN 结构,注意力模块支路输

入序列覆盖 CNN 的输入,并堆叠深层卷积网络和池化

层,特征对应的输入感受野得以扩大,模型获取更全面

的上下文信息,从而学习到当前局部序列特征的重要程

度。通过注意力模块,能够提高重要时序特征对模型的

影响程度,抑制非重要特征对模型的干扰,有效解决了

模型无法区分时间序列数据重要程度的差异性的问

题。同时,标准 CNN 支路和注意力支路以不同长度序

列作为输入,多尺度的输入能有效提取更丰富的短序列

特征,并能防止单一尺度 CNN 时输入切割过小或者过

大,预测时缺失匹配特征的问题。

(3)并行特征融合

CNN 模块的输出特征与其对应的注意力机制模块

输出的显著性特征进行逐元素相乘,这一融合方式在文

献 [20]和 文献 [21]已 验证 是可行 和 有效的。具体的 ,

CNN 输出特征的重要度越高,则其对应注意力机制模

块的输出越接近 1;反之而言,CNN 输出特征的重要度

越低,则其对应注意力机制模块的输出越接近 0。由

数值的高低反映特征重要程度,从而完成重要特征的

辨别。

(4)时序特征提取

融合的结果作为 LSTM 单元一个节点的输入,用

LSTM 进行序列建模得到最终预测结果。运用 LSTM

从基于注意力机制的 CNN 提取出的显著细粒度特征

中,提取粗粒度特征,精细化处理各维度特征的同时,防

止因步长过长导致的记忆丢失和梯度弥散问题。这种

体系结构能够捕获由注意力机制优化卷积运算后提取

的有效特征的时间依赖性,实现粗细粒度特征融合,全

面刻画时序数据。

3.3 算法描述

本文以天为单位,并行模块间 CNN 的重叠步长为

rc ,LSTM 的步长为 t 。以序列 X i 为例,上标 i (0 ≤ i < I)

表示输入变量的维度,例如用 i = 0 表示历史实际供热

量;下标表示记录次序,间隔为天。一个 CNN 模块中输

入序列表示为 {xi

s} ,输入形式为 (s × I) 的 2D 矩

阵,对应注意力机制模块的输入以 CNN 输入序列的中

2,…,xi

1,xi

计算机工程与应用www.ceaj.org�

24

2019,55(13)

Computer Engineering and Applications 计算机工程与应用

预定需求量

实际使用量

)

化

一

归

(

荷

负

热

供

)

化

一

归

(

荷

负

热

供

1.0

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

1.0

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

û

û

1,xi

点 为 中 点 ,具 体 输 入 序 列 为 {xi

1 -(sa - s)/2,…,xi

2,…,

ë

xi

s,…,xi

(sa + s)/2 } ,ëû· 表示向下取整,超出 CNN 模块输入

ë

的部分用 0 补齐,合理选择 s 与 sa ,输入形式为 (sa × I)

的 2D 矩阵。则如图 4 所示,第一组 t 步并行的注意力机

制与 CNN 模块的总输入序列为 {xi

s × t - rc × (t - 1)} ,

LSTM 预测输出 p 对应的真实值等于 x0

s × t - rc × (t - 1) + 1 ,以

此类推。

2,…,xi

1,xi

序列 X i 经过 CNN 模块的输出表示为 WCNN ,经过

对应注意力模块的输出表示为 Wattention ,将两者输出逐

元素相乘:

W(i,c) = WCNN(i,c)⊙Wattention(i,c)

(8)

其中 ⊙ 指代逐元素相乘;i 指代特征层中时间序列的

相应位置;c 指代通道。式(8)对应的注意力机制主要

运用了网络对时间序列位置以及通道的偏置。

将最终的特征层 W(i,c) 作为 LSTM 一个节点的输

入,具体的,式(2)~(5)中的 xt 为 W(i,c) 。按照上述步

骤向前调整输入序列完成前向传播过程,得到预测输出

值 p 。再结合真实值,反向传播求解并更新模型参数,

循环上述步骤,直至算法收敛。

4 实验及结果

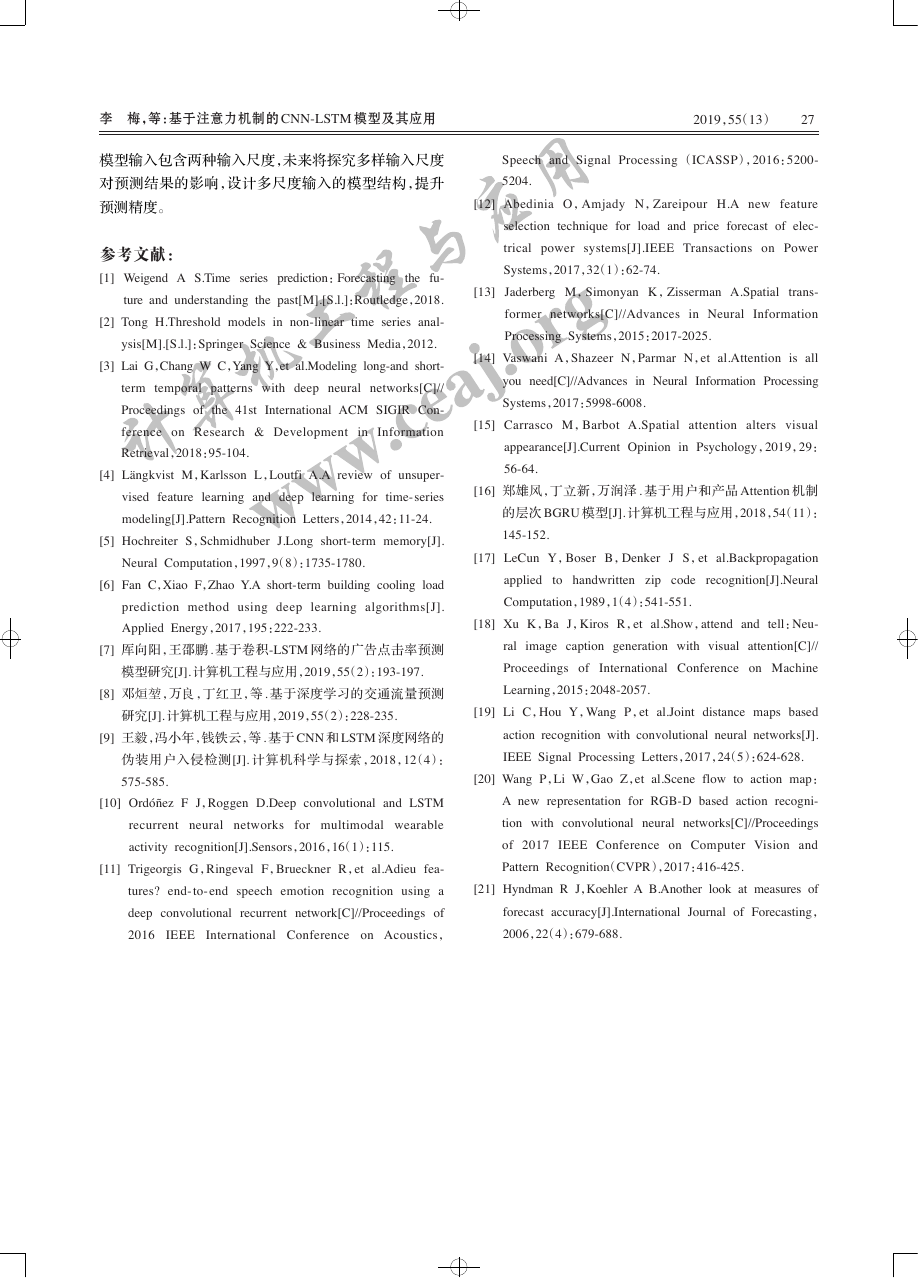

4.1 实验数据简介

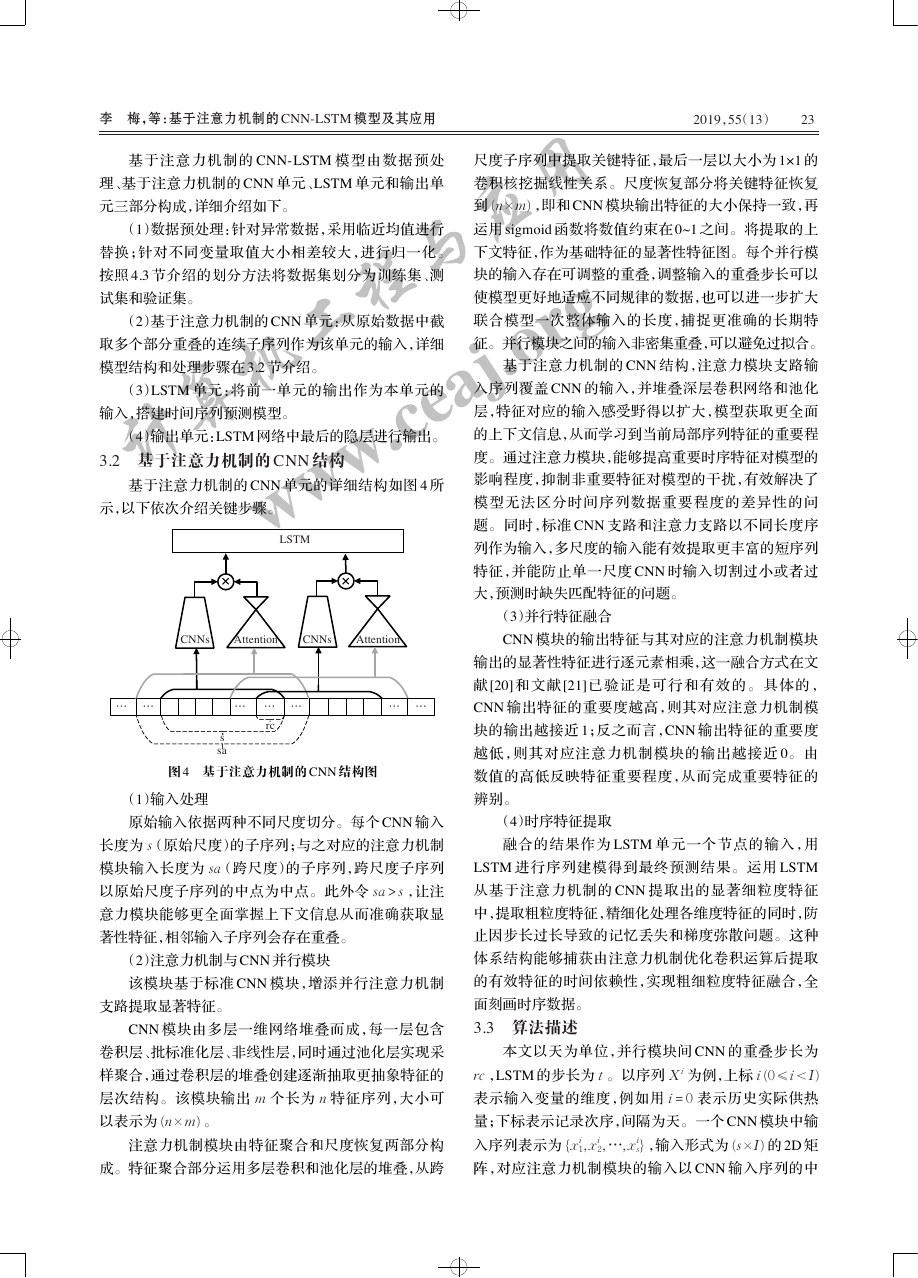

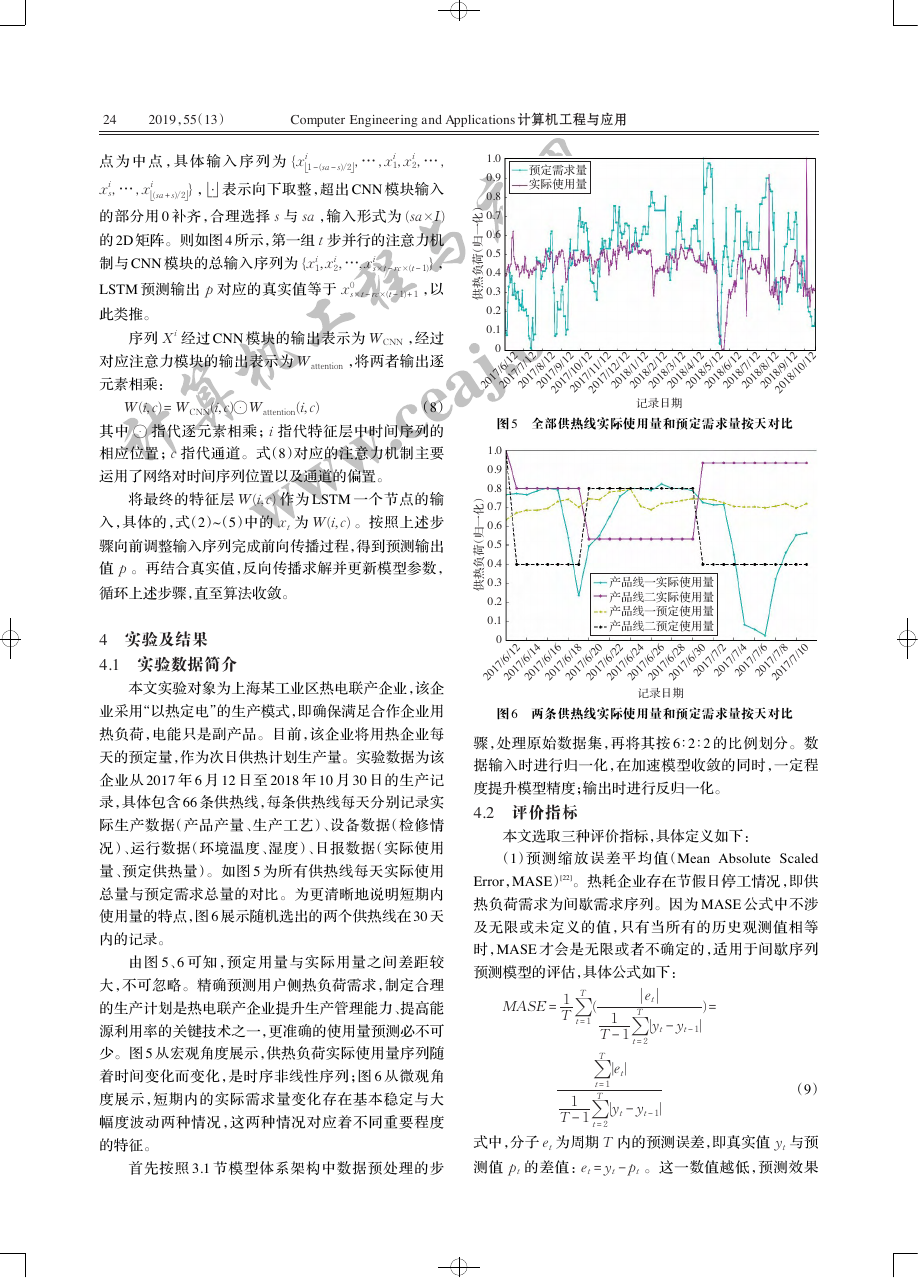

本文实验对象为上海某工业区热电联产企业,该企

业采用“以热定电”的生产模式,即确保满足合作企业用

热负荷,电能只是副产品。目前,该企业将用热企业每

天的预定量,作为次日供热计划生产量。实验数据为该

企业从 2017 年 6 月 12 日至 2018 年 10 月 30 日的生产记

录,具体包含 66 条供热线,每条供热线每天分别记录实

际生产数据(产品产量、生产工艺)、设备数据(检修情

况)、运行数据(环境温度、湿度)、日报数据(实际使用

量、预定供热量)。如图 5 为所有供热线每天实际使用

总量与预定需求总量的对比。为更清晰地说明短期内

使用量的特点,图 6 展示随机选出的两个供热线在 30 天

内的记录。

由图 5、6 可知,预定用量与实际用量之间差距较

大,不可忽略。精确预测用户侧热负荷需求,制定合理

的生产计划是热电联产企业提升生产管理能力、提高能

源利用率的关键技术之一,更准确的使用量预测必不可

少。图 5 从宏观角度展示,供热负荷实际使用量序列随

着时间变化而变化,是时序非线性序列;图 6 从微观角

度展示,短期内的实际需求量变化存在基本稳定与大

幅度波动两种情况,这两种情况对应着不同重要程度

的特征。

首先按照 3.1 节模型体系架构中数据预处理的步

2018/4/12

2017/6/12

2017/7/12

2017/9/12

2017/10/12

2017/11/12

2018/1/12

2018/2/12

2018/3/12

2018/5/12

2018/6/12

2018/7/12

2018/10/12

2018/8/12

2017/12/12

2017/8/12

2018/9/12

记录日期

图 5 全部供热线实际使用量和预定需求量按天对比

产品线一实际使用量

产品线二实际使用量

产品线一预定使用量

产品线二预定使用量

2017/7/2

2017/6/16

2017/6/14

2017/6/18

2017/6/20

2017/6/24

2017/6/26

2017/6/28

2017/6/30

2017/6/22

2017/6/12

2017/7/4

2017/7/6

2017/7/8

2017/7/10

记录日期

图 6 两条供热线实际使用量和预定需求量按天对比

骤,处理原始数据集,再将其按 6∶2∶2 的比例划分。数

据输入时进行归一化,在加速模型收敛的同时,一定程

度提升模型精度;输出时进行反归一化。

4.2 评价指标

本文选取三种评价指标,具体定义如下:

(1)预 测 缩 放 误 差 平 均 值(Mean Absolute Scaled

Error,MASE)[22]。热耗企业存在节假日停工情况,即供

热负荷需求为间歇需求序列。因为 MASE 公式中不涉

及无限或未定义的值,只有当所有的历史观测值相等

时,MASE 才会是无限或者不确定的,适用于间歇序列

预测模型的评估,具体公式如下:

MASE = 1

T

T

(

t = 1

T ∑

|

|et

T - 1∑

1

|yt - yt - 1|

∑

|et|

T - 1∑

1

|yt - yt - 1|

t = 1

T

t = 2

T

t = 2

) =

(9)

式中,分子 et 为周期 T 内的预测误差,即真实值 yt 与预

测值 pt 的差值:et = yt - pt 。这一数值越低,预测效果

计算机工程与应用www.ceaj.org�

李 梅,等:基于注意力机制的 CNN-LSTM 模型及其应用

2019,55(13)

25

越好。

(2)均方根误差(Root Mean Square Error,RMSE),

真实值与预测值误差平方的均值,公式为:

RMSE = 1

T

T ∑

t = 1

(yt - pt)2

(10)

(3)确定性相关系数( R2 score),衡量模型预测未知

样本的效果,数值越高越好,计算公式如下:

R2 = 1 -

T

∑

∑

t = 1

T

t = 1

(pt - yˉ)2

(yt - yˉ)2

(11)

其中,yˉ 表示原始数据均值。

4.3 实验结果及分析

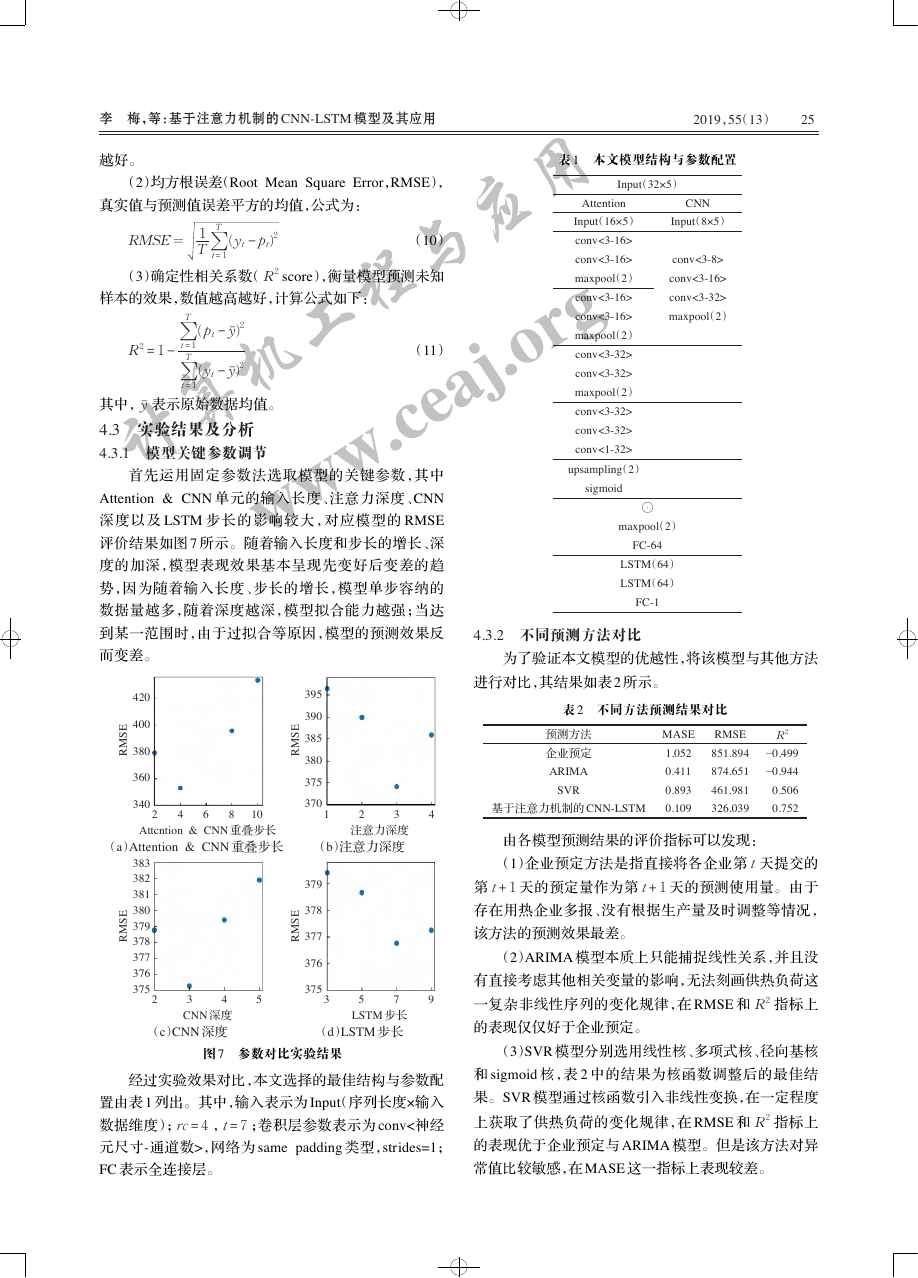

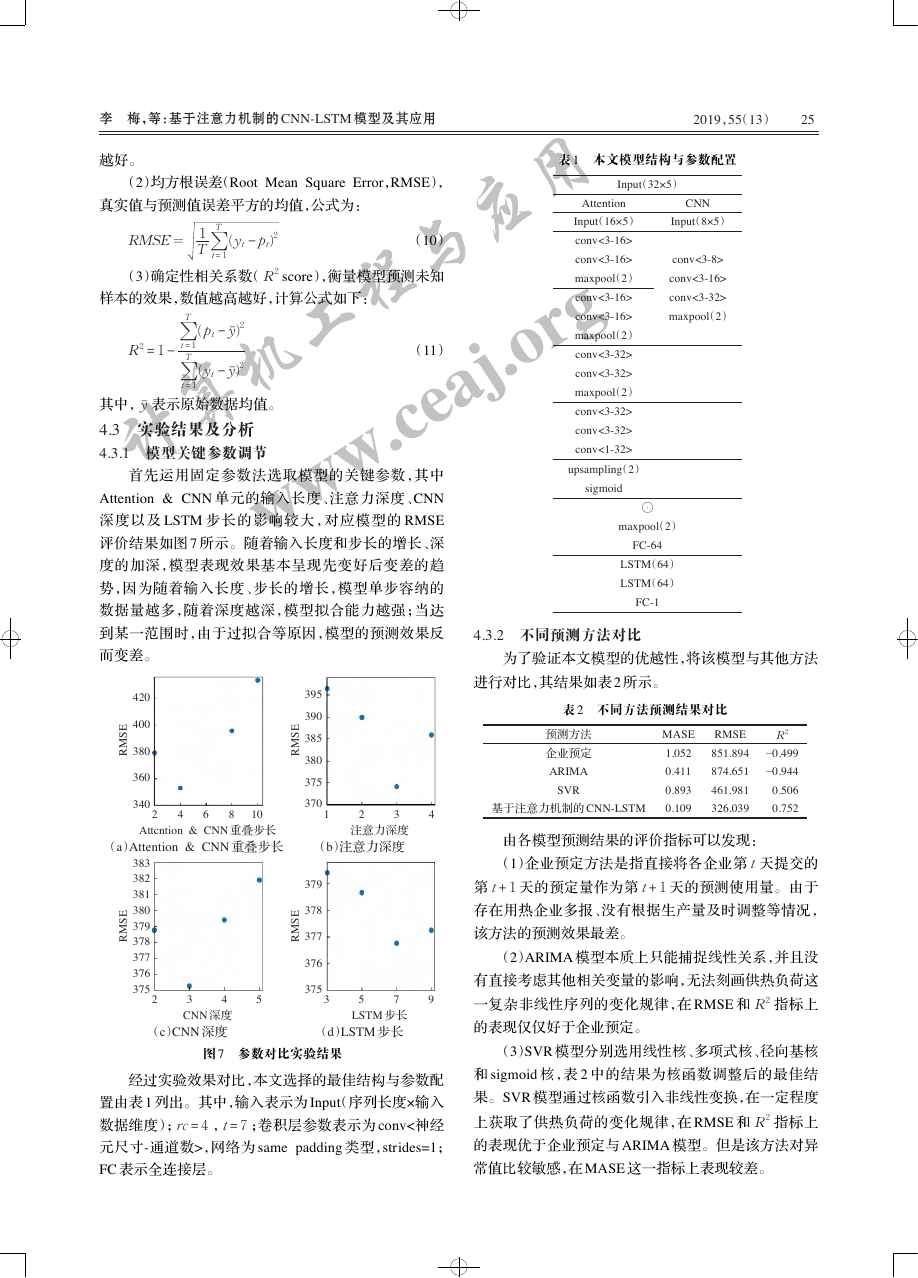

4.3.1 模型关键参数调节

首先运用固定参数法选取模型的关键参数,其中

Attention & CNN 单元的输入长度、注意力深度、CNN

深度以及 LSTM 步长的影响较大,对应模型的 RMSE

评价结果如图 7 所示。随着输入长度和步长的增长、深

度的加深,模型表现效果基本呈现先变好后变差的趋

势,因为随着输入长度、步长的增长,模型单步容纳的

数据量越多,随着深度越深,模型拟合能力越强;当达

到某一范围时,由于过拟合等原因,模型的预测效果反

而变差。

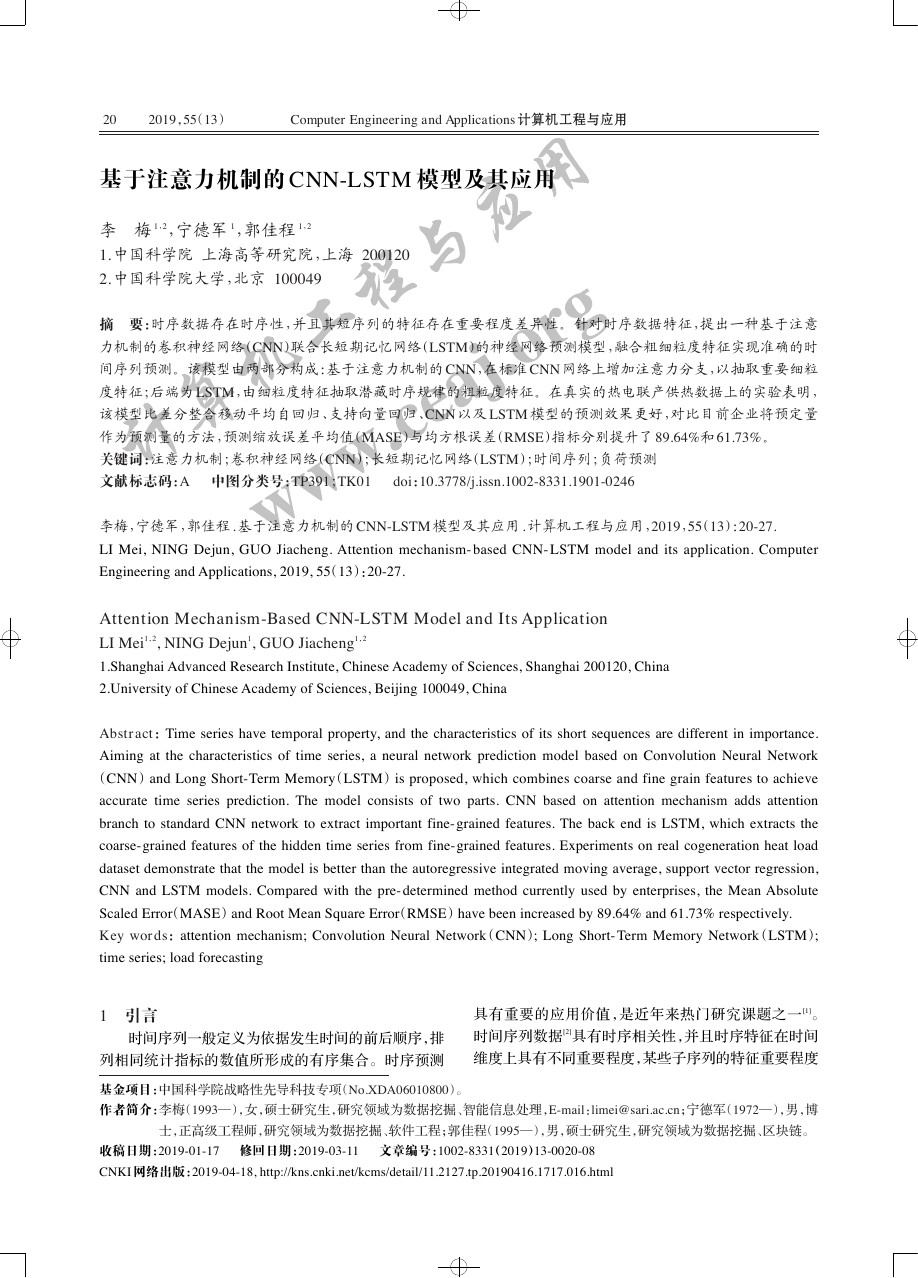

表 1 本文模型结构与参数配置

Input(32×5)

CNN

Input(8×5)

conv<3-8>

conv<3-16>

conv<3-32>

maxpool(2)

Attention

Input(16×5)

conv<3-16>

conv<3-16>

maxpool(2)

conv<3-16>

conv<3-16>

maxpool(2)

conv<3-32>

conv<3-32>

maxpool(2)

conv<3-32>

conv<3-32>

conv<1-32>

upsampling(2)

sigmoid

⊙

maxpool(2)

FC-64

LSTM(64)

LSTM(64)

FC-1

4.3.2 不同预测方法对比

为了验证本文模型的优越性,将该模型与其他方法

进行对比,其结果如表 2 所示。

表 2 不同方法预测结果对比

E

S

M

R

420

400

380

360

340

2

4

6

8

10

E

S

M

R

395

390

385

380

375

370

预测方法

企业预定

ARIMA

SVR

1

2

3

4

基于注意力机制的 CNN-LSTM

MASE

1.052

0.411

0.893

0.109

RMSE

851.894

874.651

461.981

326.039

R2

−0.499

−0.944

0.506

0.752

Attcntion & CNN 重叠步长

(a)Attention & CNN 重叠步长

注意力深度

(b)注意力深度

E

S

M

R

383

382

381

380

379

378

377

376

375

2

3

4

CNN 深度

(c)CNN 深度

5

379

378

377

376

E

S

M

R

375

7

3

5

LSTM 步长

(d)LSTM 步长

9

图 7 参数对比实验结果

经过实验效果对比,本文选择的最佳结构与参数配

置由表 1 列出。其中,输入表示为 Input(序列长度×输入

数据维度);rc = 4 ,t = 7 ;卷积层参数表示为 conv<神经

元尺寸-通道数>,网络为 same padding 类型,strides=1;

FC 表示全连接层。

由各模型预测结果的评价指标可以发现:

(1)企业预定方法是指直接将各企业第 t 天提交的

第 t + 1 天的预定量作为第 t + 1 天的预测使用量。由于

存在用热企业多报、没有根据生产量及时调整等情况,

该方法的预测效果最差。

(2)ARIMA 模型本质上只能捕捉线性关系,并且没

有直接考虑其他相关变量的影响,无法刻画供热负荷这

一复杂非线性序列的变化规律,在 RMSE 和 R2 指标上

的表现仅仅好于企业预定。

(3)SVR 模型分别选用线性核、多项式核、径向基核

和 sigmoid 核,表 2 中的结果为核函数调整后的最佳结

果。SVR 模型通过核函数引入非线性变换,在一定程度

上获取了供热负荷的变化规律,在 RMSE 和 R2 指标上

的表现优于企业预定与 ARIMA 模型。但是该方法对异

常值比较敏感,在 MASE 这一指标上表现较差。

计算机工程与应用www.ceaj.org�

26

2019,55(13)

Computer Engineering and Applications 计算机工程与应用

(4)本文模型融合不同粒度特征,建立热电联产供

热负荷数据的深度模型,在各项指标上表现最好,比企

业 现 用 的 预 定 方 法 在 MASE 指 标 上 提 升 了 89.64% ,

RMSE 指标上提升了 61.73%。

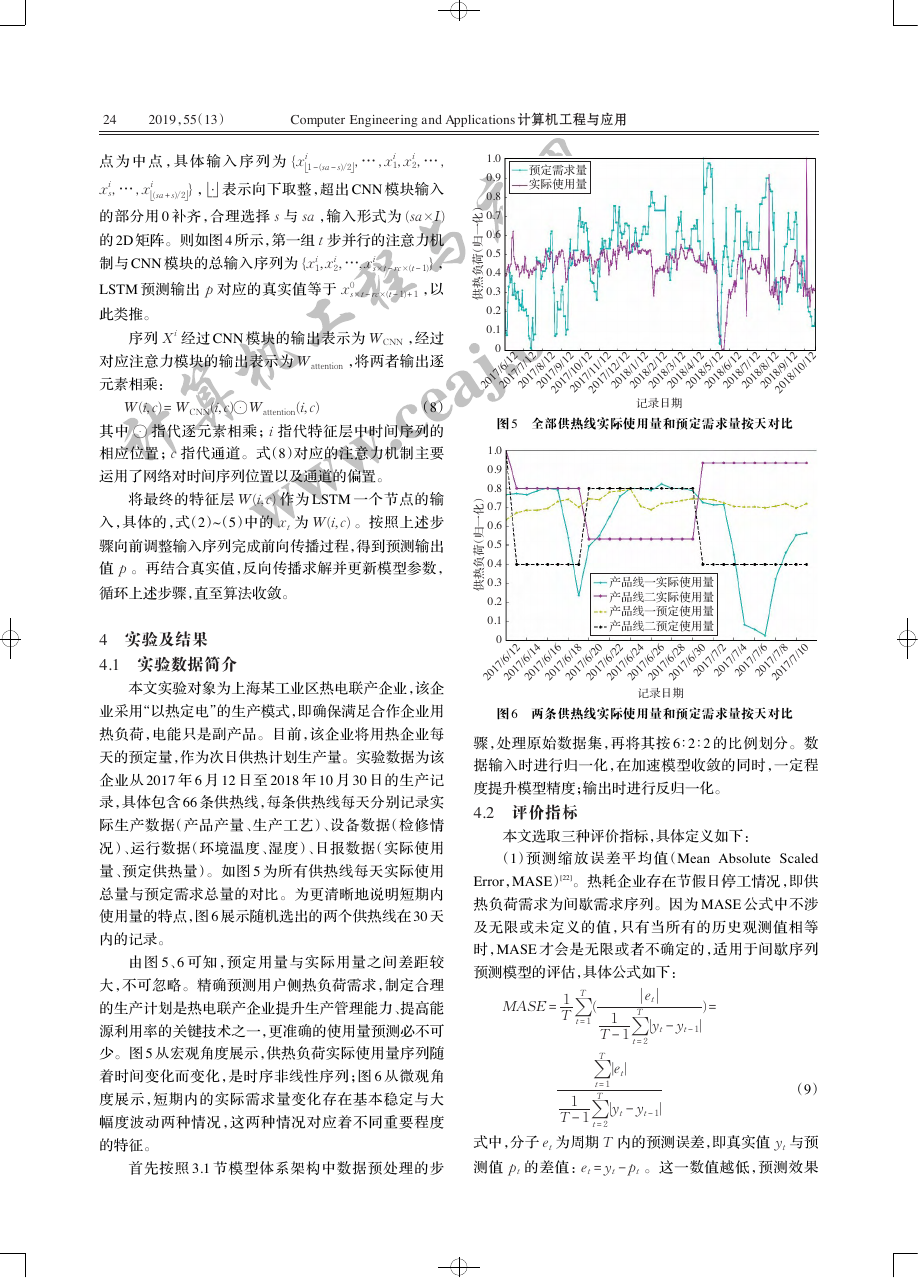

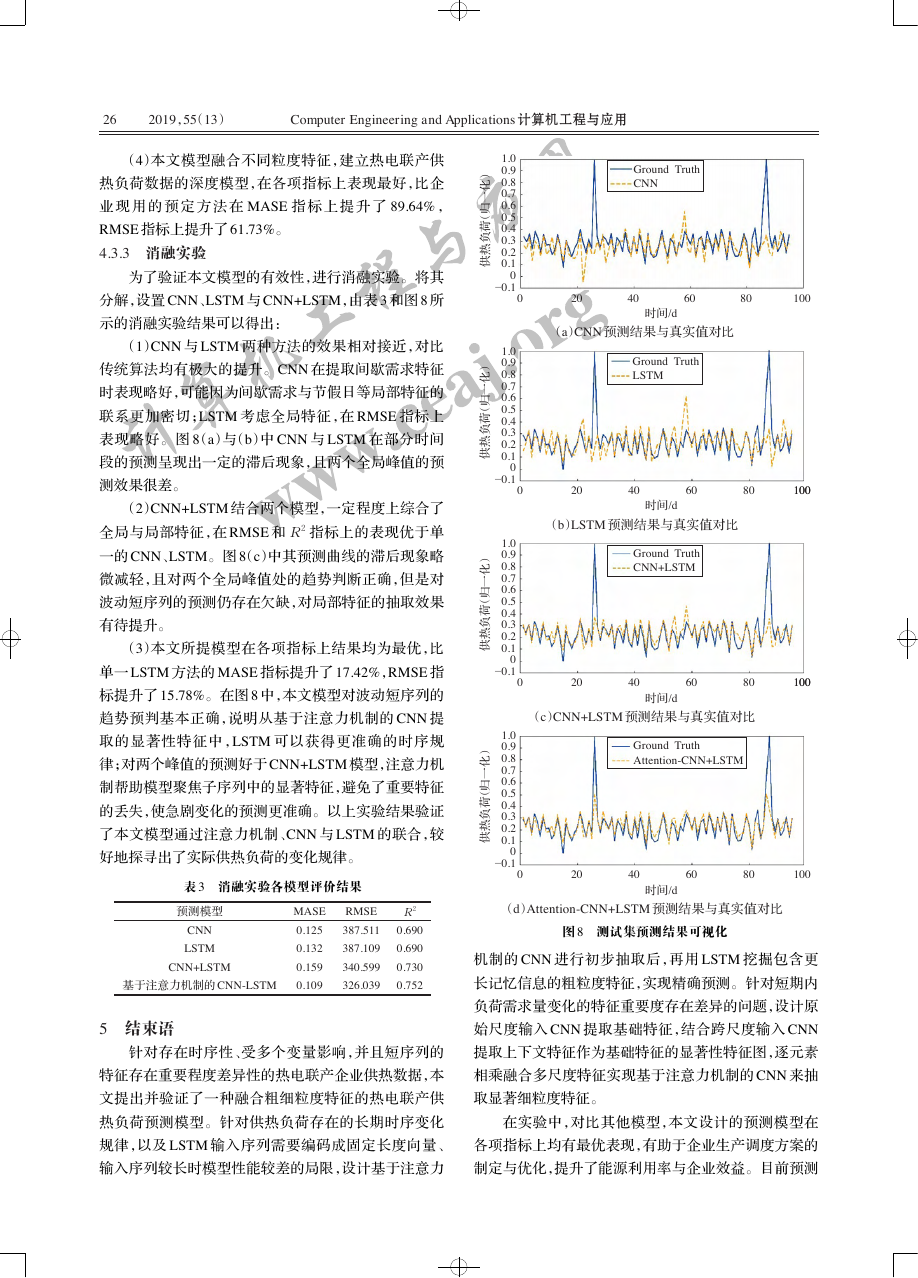

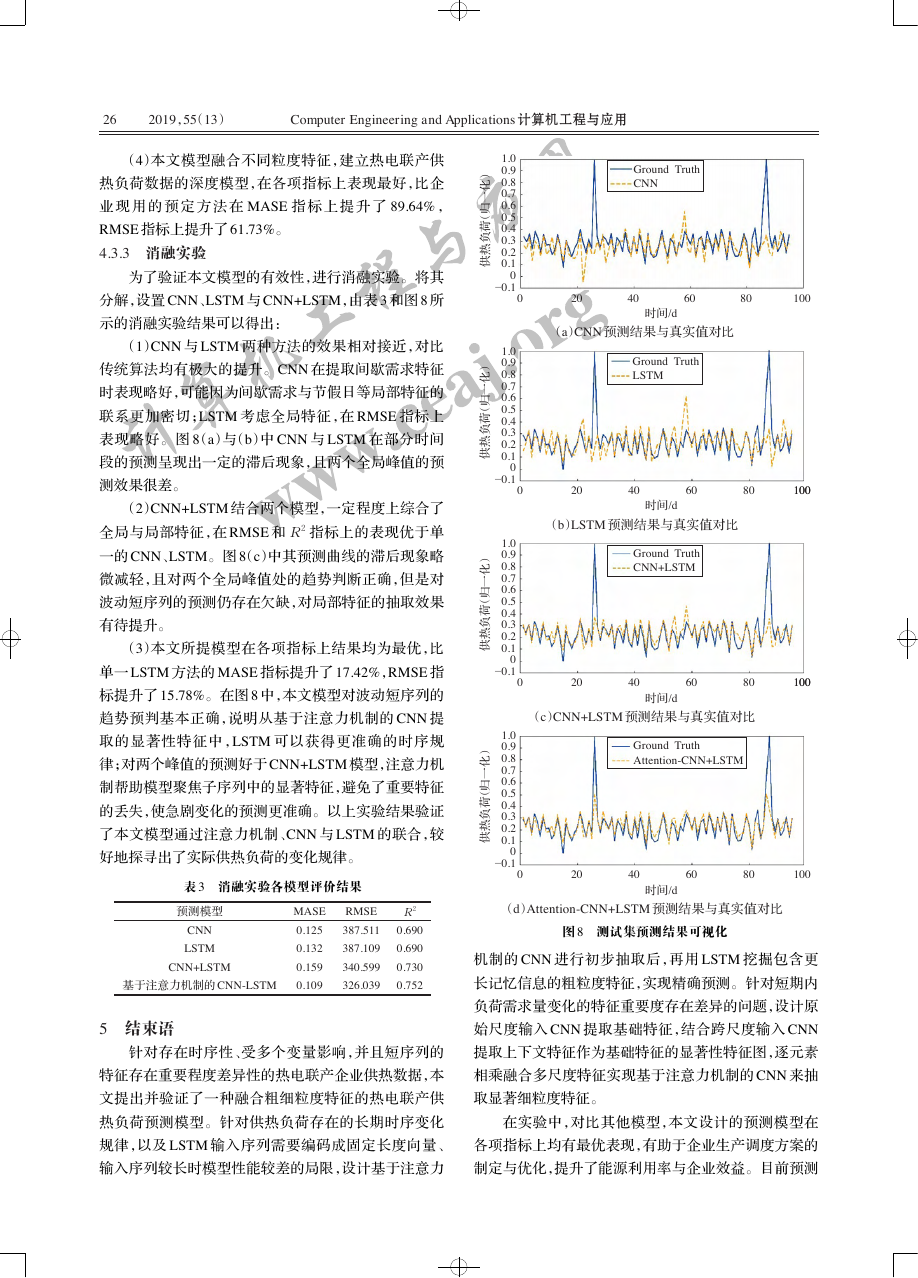

4.3.3 消融实验

为了验证本文模型的有效性,进行消融实验。将其

分解,设置 CNN、LSTM 与 CNN+LSTM,由表 3 和图 8 所

示的消融实验结果可以得出:

(1)CNN 与 LSTM 两种方法的效果相对接近,对比

传统算法均有极大的提升。CNN 在提取间歇需求特征

时表现略好,可能因为间歇需求与节假日等局部特征的

联系更加密切;LSTM 考虑全局特征,在 RMSE 指标上

表现略好。图 8(a)与(b)中 CNN 与 LSTM 在部分时间

段的预测呈现出一定的滞后现象,且两个全局峰值的预

测效果很差。

(2)CNN+LSTM 结合两个模型,一定程度上综合了

全局与局部特征,在 RMSE 和 R2 指标上的表现优于单

一的 CNN、LSTM。图 8(c)中其预测曲线的滞后现象略

微减轻,且对两个全局峰值处的趋势判断正确,但是对

波动短序列的预测仍存在欠缺,对局部特征的抽取效果

有待提升。

(3)本文所提模型在各项指标上结果均为最优,比

单一 LSTM 方法的 MASE 指标提升了 17.42%,RMSE 指

标提升了 15.78%。在图 8 中,本文模型对波动短序列的

趋势预判基本正确,说明从基于注意力机制的 CNN 提

取的显著性特征中,LSTM 可以获得更准确的时序规

律;对两个峰值的预测好于 CNN+LSTM 模型,注意力机

制帮助模型聚焦子序列中的显著特征,避免了重要特征

的丢失,使急剧变化的预测更准确。以上实验结果验证

了本文模型通过注意力机制、CNN 与 LSTM 的联合,较

好地探寻出了实际供热负荷的变化规律。

表 3 消融实验各模型评价结果

预测模型

CNN

LSTM

CNN+LSTM

基于注意力机制的 CNN-LSTM

5 结束语

MASE

0.125

0.132

0.159

0.109

RMSE

387.511

387.109

340.599

326.039

R2

0.690

0.690

0.730

0.752

针对存在时序性、受多个变量影响,并且短序列的

特征存在重要程度差异性的热电联产企业供热数据,本

文提出并验证了一种融合粗细粒度特征的热电联产供

热负荷预测模型。针对供热负荷存在的长期时序变化

规律,以及 LSTM 输入序列需要编码成固定长度向量、

输入序列较长时模型性能较差的局限,设计基于注意力

)

化

一

归

(

荷

负

热

供

)

化

一

归

(

荷

负

热

供

)

化

一

归

(

荷

负

热

供

)

化

一

归

(

荷

负

热

供

1.0

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

−0.1

1.0

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

−0.1

1.0

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

−0.1

1.0

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

−0.1

Ground Truth

CNN

0

20

40

60

80

100

时间/d

(a)CNN 预测结果与真实值对比

Ground Truth

LSTM

0

20

40

60

80

100100

时间/d

(b)LSTM 预测结果与真实值对比

Ground Truth

CNN+LSTM

0

20

40

60

80

100100

(c)CNN+LSTM 预测结果与真实值对比

时间/d

Ground Truth

Attention-CNN+LSTM

0

20

40

60

80

100

时间/d

(d)Attention-CNN+LSTM 预测结果与真实值对比

图 8 测试集预测结果可视化

机制的 CNN 进行初步抽取后,再用 LSTM 挖掘包含更

长记忆信息的粗粒度特征,实现精确预测。针对短期内

负荷需求量变化的特征重要度存在差异的问题,设计原

始尺度输入 CNN 提取基础特征,结合跨尺度输入 CNN

提取上下文特征作为基础特征的显著性特征图,逐元素

相乘融合多尺度特征实现基于注意力机制的 CNN 来抽

取显著细粒度特征。

在实验中,对比其他模型,本文设计的预测模型在

各项指标上均有最优表现,有助于企业生产调度方案的

制定与优化,提升了能源利用率与企业效益。目前预测

计算机工程与应用www.ceaj.org�

李 梅,等:基于注意力机制的 CNN-LSTM 模型及其应用

2019,55(13)

27

模型输入包含两种输入尺度,未来将探究多样输入尺度

对预测结果的影响,设计多尺度输入的模型结构,提升

预测精度。

Speech and Signal Processing (ICASSP),2016:5200-

5204.

[12] Abedinia O,Amjady N,Zareipour H.A new feature

参考文献:

[1] Weigend A S.Time series prediction:Forecasting the fu-

ture and understanding the past[M].[S.l.]:Routledge,2018.

[2] Tong H.Threshold models in non-linear time series anal-

ysis[M].[S.l.]:Springer Science & Business Media,2012.

[3] Lai G,Chang W C,Yang Y,et al.Modeling long-and short-

term temporal patterns with deep neural networks[C]//

Proceedings of the 41st International ACM SIGIR Con-

ference on Research & Development

Retrieval,2018:95-104.

in Information

[4] Längkvist M,Karlsson L,Loutfi A.A review of unsuper-

vised feature learning and deep learning for time-series

modeling[J].Pattern Recognition Letters,2014,42:11-24.

[5] Hochreiter S,Schmidhuber J.Long short-term memory[J].

Neural Computation,1997,9(8):1735-1780.

[6] Fan C,Xiao F,Zhao Y.A short-term building cooling load

prediction method using deep learning algorithms[J].

Applied Energy,2017,195:222-233.

[7] 厍向阳,王邵鹏 . 基于卷积-LSTM 网络的广告点击率预测

模型研究[J]. 计算机工程与应用,2019,55(2):193-197.

[8] 邓烜堃,万良,丁红卫,等 . 基于深度学习的交通流量预测

研究[J]. 计算机工程与应用,2019,55(2):228-235.

[9] 王毅,冯小年,钱铁云,等 . 基于 CNN 和 LSTM 深度网络的

伪装用户入侵检测[J]. 计算机科学与探索,2018,12(4):

575-585.

[10] Ordóñez F J,Roggen D.Deep convolutional and LSTM

for multimodal wearable

recurrent neural networks

activity recognition[J].Sensors,2016,16(1):115.

[11] Trigeorgis G,Ringeval F,Brueckner R,et al.Adieu fea-

tures? end- to- end speech emotion recognition using a

deep convolutional recurrent network[C]//Proceedings of

2016 IEEE International Conference on Acoustics,

selection technique for load and price forecast of elec-

trical power systems[J].IEEE Transactions on Power

Systems,2017,32(1):62-74.

[13] Jaderberg M,Simonyan K,Zisserman A.Spatial

trans-

former networks[C]//Advances in Neural Information

Processing Systems,2015:2017-2025.

[14] Vaswani A,Shazeer N,Parmar N,et al.Attention is all

you need[C]//Advances in Neural Information Processing

Systems,2017:5998-6008.

[15] Carrasco M,Barbot A.Spatial attention alters visual

appearance[J].Current Opinion in Psychology,2019,29:

56-64.

[16] 郑雄风,丁立新,万润泽 . 基于用户和产品 Attention 机制

的层次 BGRU 模型[J]. 计算机工程与应用,2018,54(11):

145-152.

[17] LeCun Y,Boser B,Denker J S,et al.Backpropagation

applied to handwritten zip code recognition[J].Neural

Computation,1989,1(4):541-551.

[18] Xu K,Ba J,Kiros R,et al.Show,attend and tell:Neu-

ral

image caption generation with visual attention[C]//

Proceedings of

Learning,2015:2048-2057.

International Conference on Machine

[19] Li C,Hou Y,Wang P,et al.Joint distance maps based

action recognition with convolutional neural networks[J].

IEEE Signal Processing Letters,2017,24(5):624-628.

[20] Wang P,Li W,Gao Z,et al.Scene flow to action map:

A new representation for RGB-D based action recogni-

tion with convolutional neural networks[C]//Proceedings

of 2017 IEEE Conference on Computer Vision and

Pattern Recognition(CVPR),2017:416-425.

[21] Hyndman R J,Koehler A B.Another look at measures of

forecast accuracy[J].International Journal of Forecasting,

2006,22(4):679-688.

计算机工程与应用www.ceaj.org�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc