第一章 绪论

Part1 名词解释

训练过程中使用的数据集称为训练集,其中的每一个样本称为训练样本。

测试:学得模型后,使用该模型进行预测的过程,被预测的样本成为测试样本

假设:学得模型对应于数据的某种潜在规律,这种潜在的规律自身成为真相或真实

学习的过程就是为了找出或逼近真相,将这种模型成为学习器

样例:拥有标记信息的示例

分类:预测的是离散值,则称分类

回归:预测的是连续纸,则称回归

根据训练数据是否有标记信息分:监督学习(分类和回归)、无监督学习(聚类)

泛化:学得的模型适用于新样本的能力

假设空间之科学推理的两大基本手段——归纳与演绎

归纳:从特殊到一般的泛化,即从具体试试归纳到一般性规律

演绎:从一般到特殊的特化,即从基本原理推演到具体状况

归纳偏好:机器学习算法在学习过程中对某种类型假设的偏好

没有免费的午餐定理:

NLF 讲的是在不考虑具体问题的情况下,没有任何一个算法比另一个算法更优,甚至

没有胡乱猜测更好。不存在一个与具体应用无关的,普遍适用的“最优分类器”;学习算

法必须要作出一个与问题领域有关的“假设”,分类器必须与问题域相适应。但是,NFL

定理的前提是,所有问题出现的机会相等、或所有问题都是同等重要。但是现实中,我们

往往会得到特定的数据,特定的分布,解决特定的问题,所以我们只需要解决自己关注的

问题,而不需要考虑这个模型是否很好的解决其他的问题。只有对于特定的问题,我们比

较不同模型的才有意义。不仅是机器学习,我们在做其他算法的时候也是这样,如果不考

虑实际解决的问题,很难说算法的优劣。

Note:在进行样本训练时,我们通常假设所有的样本独立同分布。

机器学习的应用:

在总统候选人第一次辩论后,分析出哪些选民将倒戈,为每一位选民找出一个最

能说服他的理由

精准定位不同选民群体,建议购买冷门广告时段,广告资金效率比 2008 年提高 18%

�

向奥巴马推荐,精选后期应当在什么地方展开活动--哪里有更多争取对象

借助模型帮助奥巴马筹集到创纪录的 10 亿美元

在生物信息、web 搜索、入侵检测、汽车自动驾驶、火星机器人、决策助手等方面

都有应用

习题 1.5:简述机器学习能在互联网搜索中的哪些环节起什么作用?

1.在向搜索引擎提交信息的阶段,能够从提交文本中进行信息提取,进行语义分析。

2.在搜索引擎进行信息匹配的阶段,能够提高问题与各个信息的匹配程度。

3.在向用户展示搜索结果的阶段,能够根据用户对结果感兴趣的程度进行排序。

补充知识点

关于假设空间和版本空间

假设空间:假设数据集有 3 种属性,第 1 个属性有 2 种取值,第 2 种属性有 3 种取值,

第 3 个属性有 2 种取值。因为每个属性有一个泛化取值(*),且还存在一个空集的情况。

所以可能的假设有(2+1)*(3+1)*(2+1)+1=37 种。再用空集表示没有正例,假设空间

中一共种假设。

版本空间:在现实问题中常面临很大的假设空间,我们可以寻找一个与训练集一致的

假设集合,称之为版本空间。版本空间从假设空间剔除了与正例不一致和与反例一致的假

设(根据经验,最后在求版本空间时,空集的那个假设常常也会去除),它可以看成是对

正例的最大泛化。

第二章 模型评估与选择

Part1 经验误差与过拟合

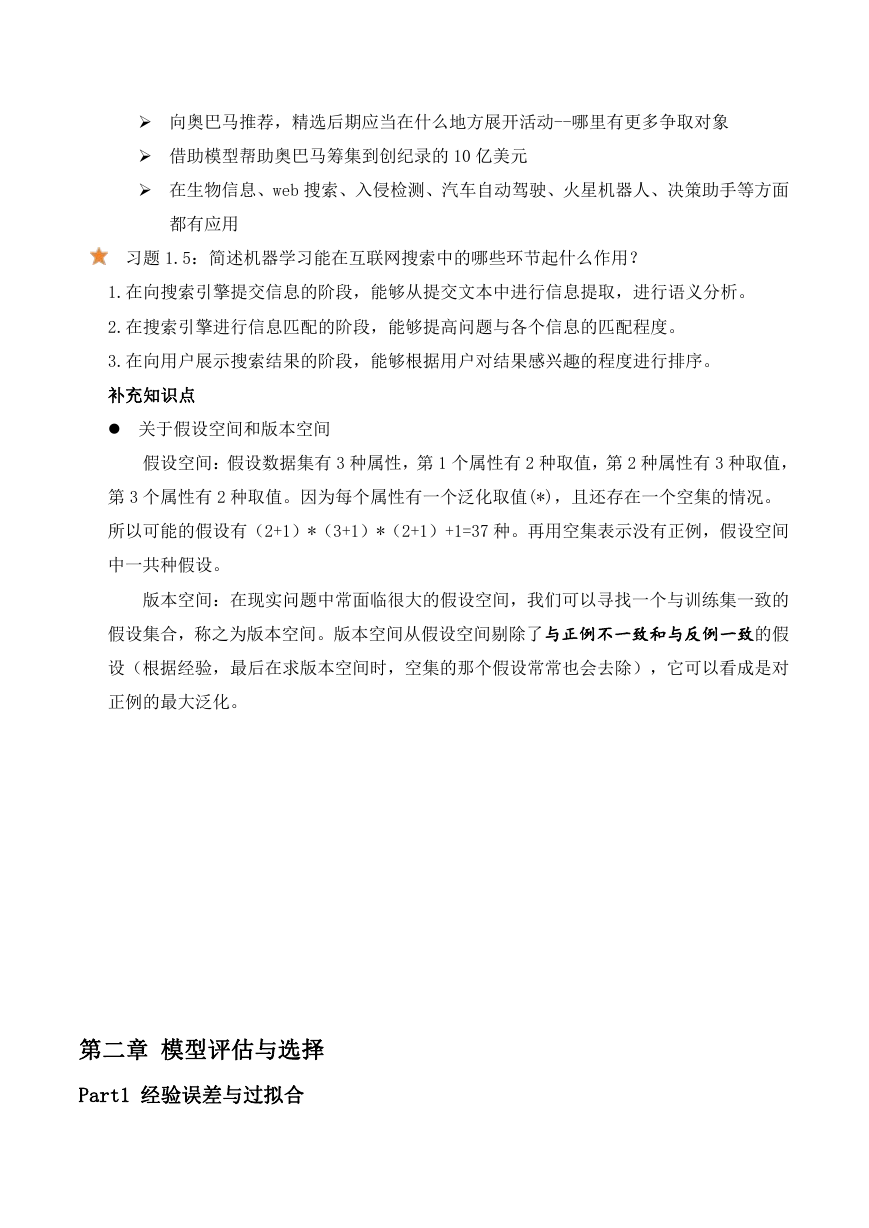

�

精确度=1-错误率

泛化误差:在新样本上的误差

过拟合:学习器把训练样本学得太好了,很可能已经把训练样本自身的一些特点当作了所有潜

在样本都具有的一般性质,这样会导致泛化能力下降

产生过拟合的原因:学习能力太强了

欠拟合:对训练样本的一般性质尚未学好

欠拟合产生的原因:学习能力低下

Part2 评估方法

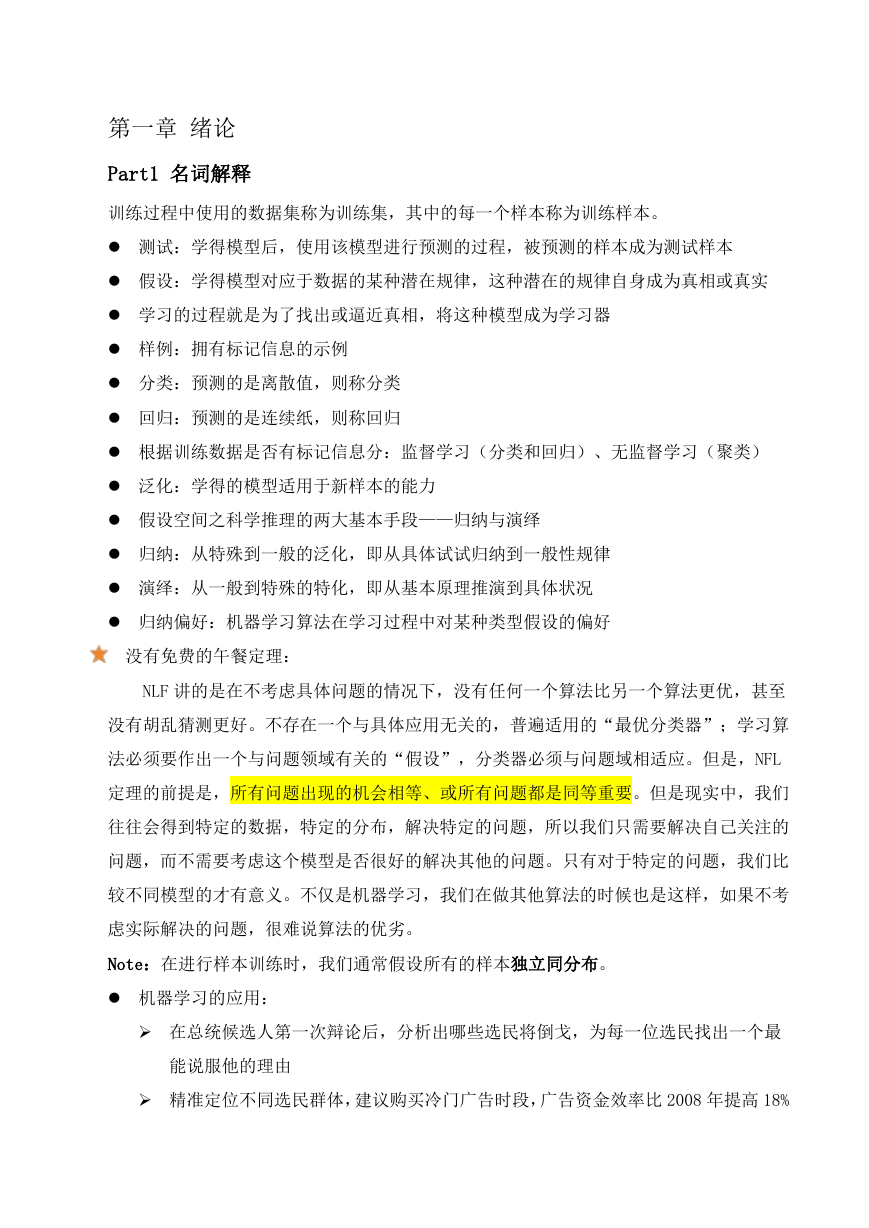

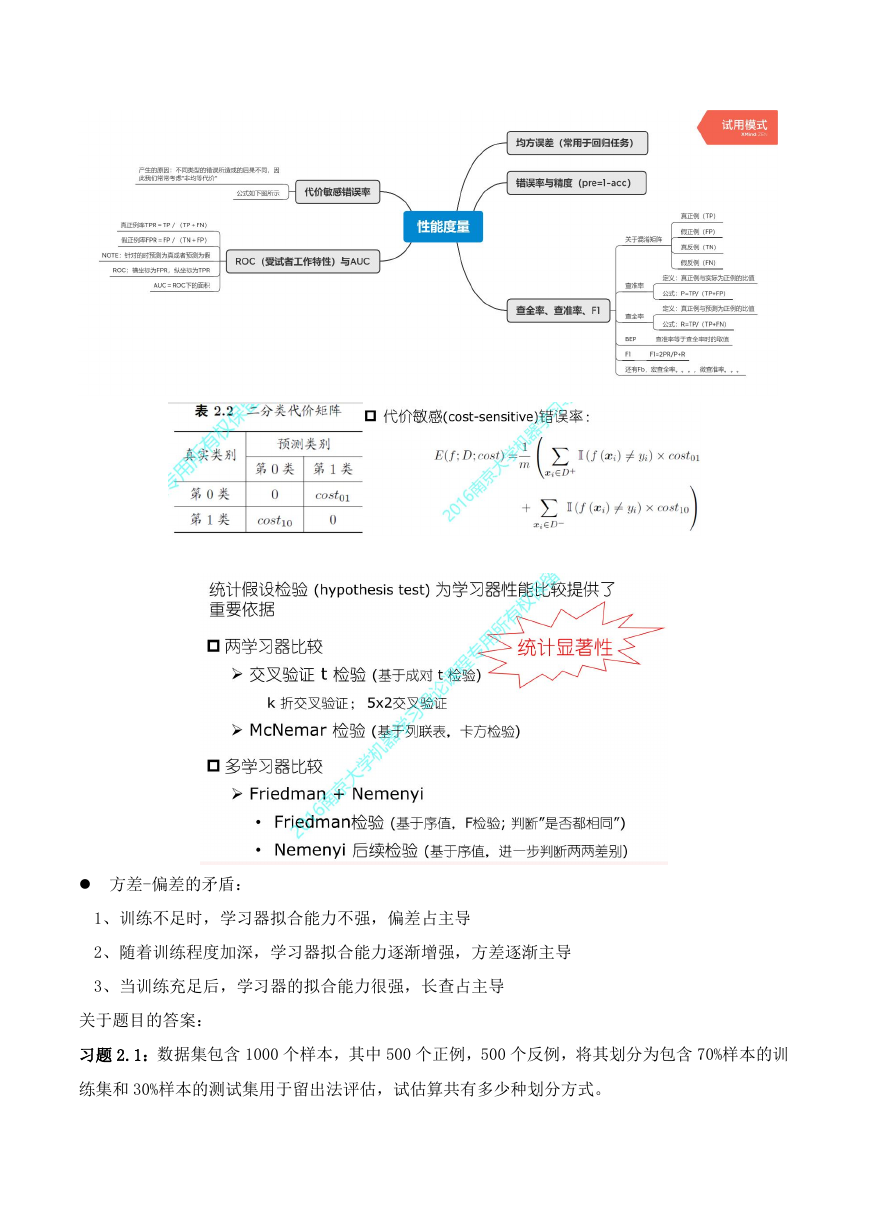

Part3 性能度量

�

方差-偏差的矛盾:

1、训练不足时,学习器拟合能力不强,偏差占主导

2、随着训练程度加深,学习器拟合能力逐渐增强,方差逐渐主导

3、当训练充足后,学习器的拟合能力很强,长查占主导

关于题目的答案:

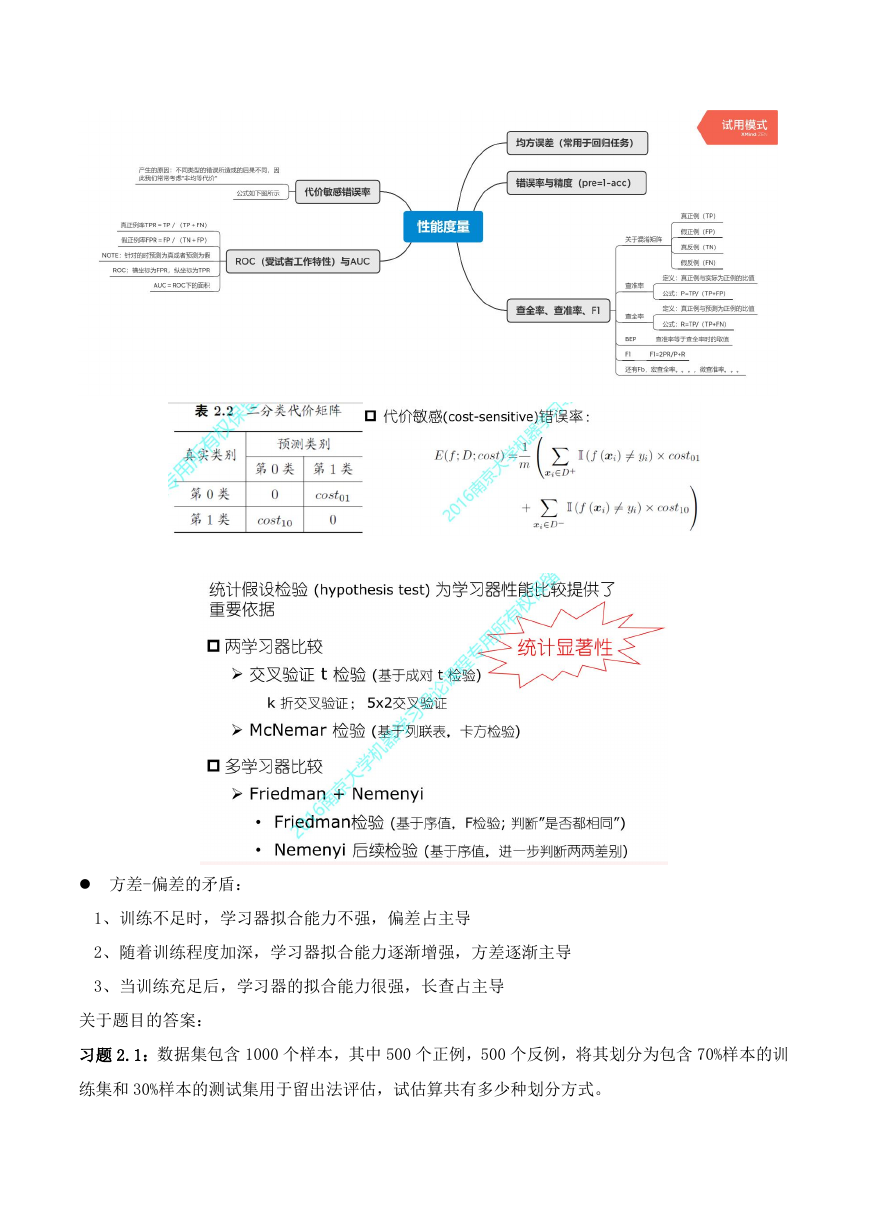

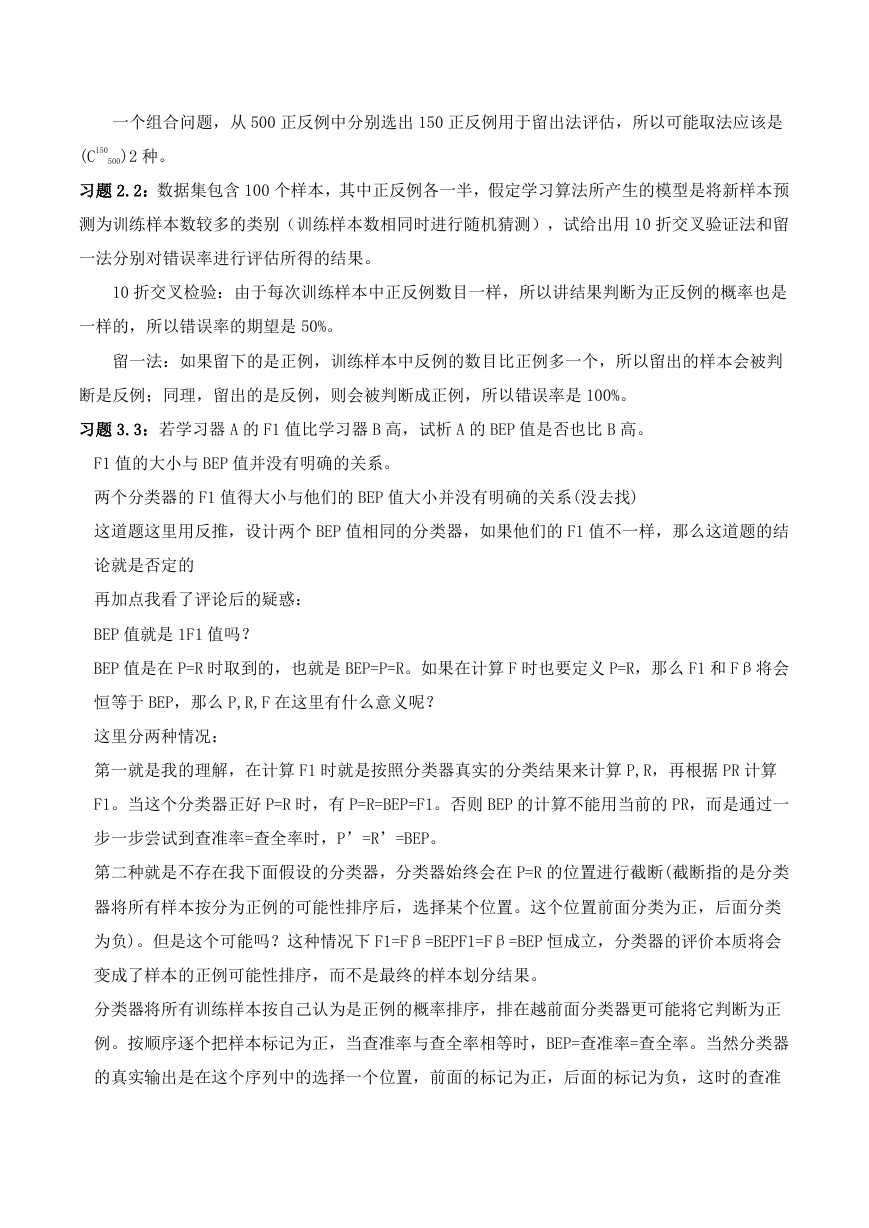

习题 2.1:数据集包含 1000 个样本,其中 500 个正例,500 个反例,将其划分为包含 70%样本的训

练集和 30%样本的测试集用于留出法评估,试估算共有多少种划分方式。

�

一个组合问题,从 500 正反例中分别选出 150 正反例用于留出法评估,所以可能取法应该是

(C150

500)2 种。

习题 2.2:数据集包含 100 个样本,其中正反例各一半,假定学习算法所产生的模型是将新样本预

测为训练样本数较多的类别(训练样本数相同时进行随机猜测),试给出用 10 折交叉验证法和留

一法分别对错误率进行评估所得的结果。

10 折交叉检验:由于每次训练样本中正反例数目一样,所以讲结果判断为正反例的概率也是

一样的,所以错误率的期望是 50%。

留一法:如果留下的是正例,训练样本中反例的数目比正例多一个,所以留出的样本会被判

断是反例;同理,留出的是反例,则会被判断成正例,所以错误率是 100%。

习题 3.3:若学习器 A 的 F1 值比学习器 B 高,试析 A 的 BEP 值是否也比 B 高。

F1 值的大小与 BEP 值并没有明确的关系。

两个分类器的 F1 值得大小与他们的 BEP 值大小并没有明确的关系(没去找)

这道题这里用反推,设计两个 BEP 值相同的分类器,如果他们的 F1 值不一样,那么这道题的结

论就是否定的

再加点我看了评论后的疑惑:

BEP 值就是 1F1 值吗?

BEP 值是在 P=R 时取到的,也就是 BEP=P=R。如果在计算 F 时也要定义 P=R,那么 F1 和 Fβ将会

恒等于 BEP,那么 P,R,F 在这里有什么意义呢?

这里分两种情况:

第一就是我的理解,在计算 F1 时就是按照分类器真实的分类结果来计算 P,R,再根据 PR 计算

F1。当这个分类器正好 P=R 时,有 P=R=BEP=F1。否则 BEP 的计算不能用当前的 PR,而是通过一

步一步尝试到查准率=查全率时,P’=R’=BEP。

第二种就是不存在我下面假设的分类器,分类器始终会在 P=R 的位置进行截断(截断指的是分类

器将所有样本按分为正例的可能性排序后,选择某个位置。这个位置前面分类为正,后面分类

为负)。但是这个可能吗?这种情况下 F1=Fβ=BEPF1=Fβ=BEP 恒成立,分类器的评价本质将会

变成了样本的正例可能性排序,而不是最终的样本划分结果。

分类器将所有训练样本按自己认为是正例的概率排序,排在越前面分类器更可能将它判断为正

例。按顺序逐个把样本标记为正,当查准率与查全率相等时,BEP=查准率=查全率。当然分类器

的真实输出是在这个序列中的选择一个位置,前面的标记为正,后面的标记为负,这时的查准

�

率与查全率用来计算 F1F1 值。可以看出有同样的 BEP 值的两个分类器在不同位置截断可能有不

同的 F1 值,所以 F1 值高不一定 BEP 值也高。

习题 2.4:试述真正例率(TPR)、假正例率(FPR)与查准率(P)、查全率(R)之间的联系。

查全率: 真实正例被预测为正例的比例

真正例率: 真实正例被预测为正例的比例

显然查全率与真正例率是相等的。

查准率:预测为正例的实例中真实正例的比例

假正例率: 真实反例被预测为正例的比例

两者并没有直接的数值关系。

�

第三章 线性模型

Part5 关于多分类学习

一对一(OvO):将 N 个类别两两配对,从而产生 N(N-1)/2 个二分类任务。在测试阶

段,新样本将同时提交给所有分类器,于是我们将得到 N(N-1)/2 个分类结果,最终

结果可通过投票产生:即把被预测得最多的类别作为分类结果

一对多(OvR):每次将一个类的样例作为正例,所有其他类的样例作为反例来训练 N

个分类器。在测试时若仅有一个分类器预测为正类,则对应的类别标记作为最终分类结

果。若有多个分类器预测为正类,则通常考虑各分类器的预测置信度,选择置信度最大

的类别标记作为分类结果。

以上两种方法可以从存储开销和训练时间两个角度来分析模型的优势。

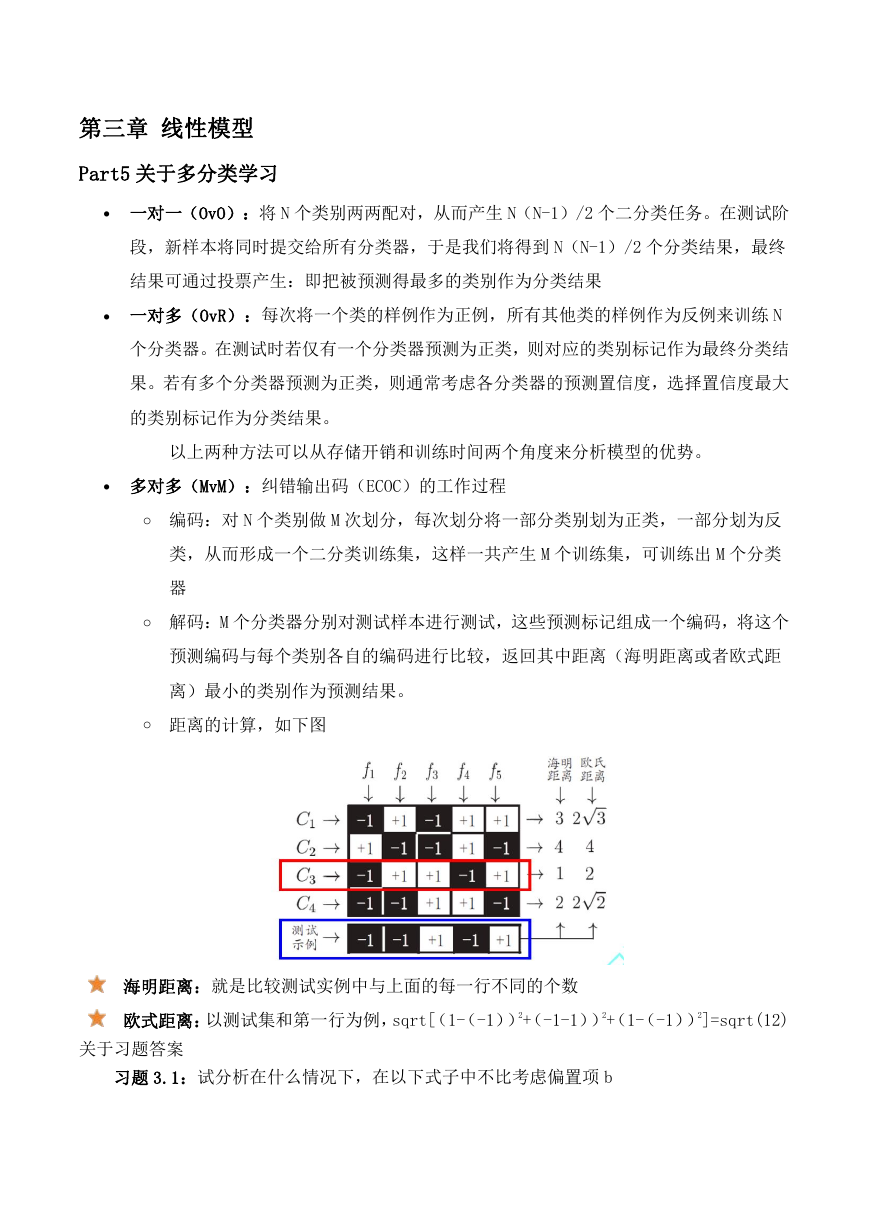

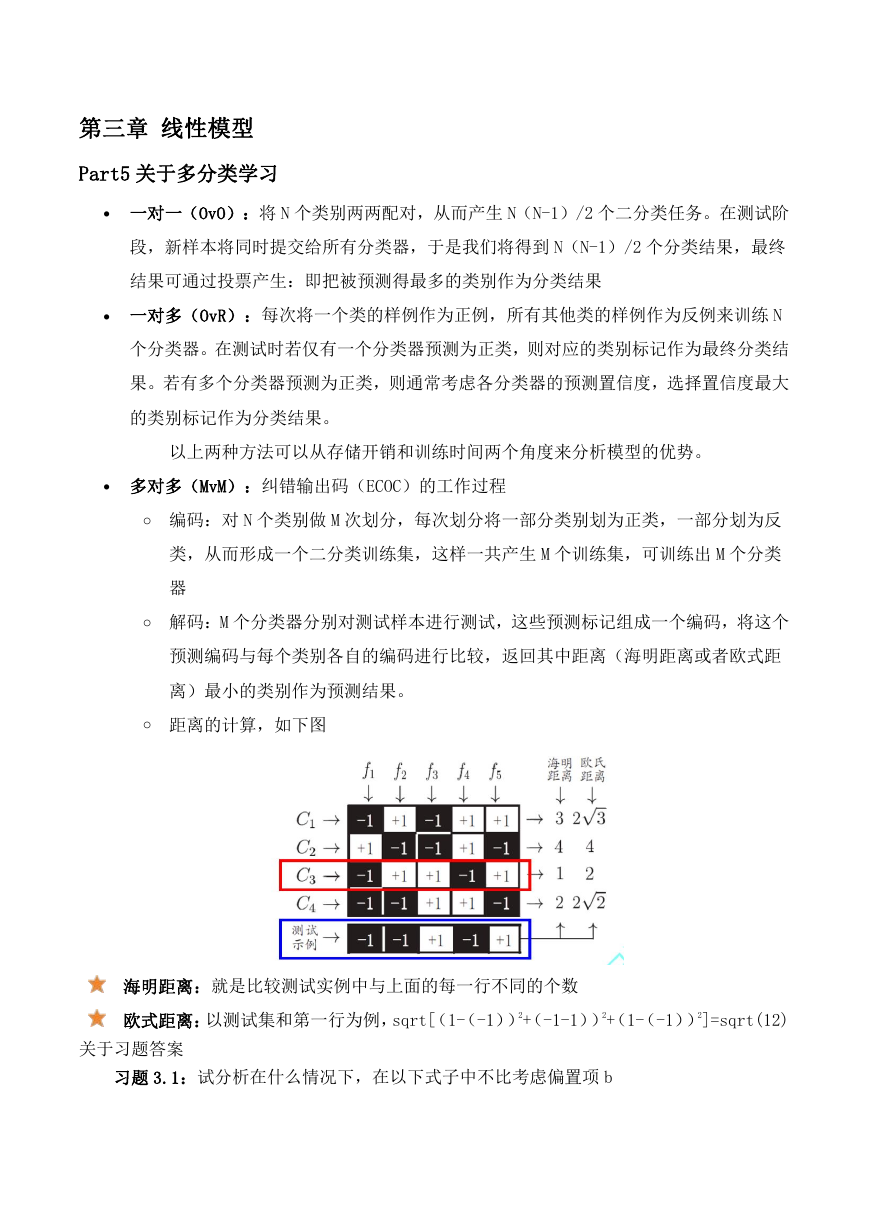

多对多(MvM):纠错输出码(ECOC)的工作过程

o 编码:对 N 个类别做 M 次划分,每次划分将一部分类别划为正类,一部分划为反

类,从而形成一个二分类训练集,这样一共产生 M 个训练集,可训练出 M 个分类

器

o 解码:M 个分类器分别对测试样本进行测试,这些预测标记组成一个编码,将这个

预测编码与每个类别各自的编码进行比较,返回其中距离(海明距离或者欧式距

离)最小的类别作为预测结果。

o 距离的计算,如下图

海明距离:就是比较测试实例中与上面的每一行不同的个数

欧式距离:以测试集和第一行为例,sqrt[(1-(-1))2+(-1-1))2+(1-(-1))2]=sqrt(12)

关于习题答案

习题 3.1:试分析在什么情况下,在以下式子中不比考虑偏置项 b

�

线性模型 y=wtx+by=wtx+b,两个实例相减得到 yi−y0=wt(xi−x0),以此消除了 b。所以可以

对训练集每个样本都减去第一个样本,然后对新的样本做线性回归,只需要用模型 y=wtx。

习题 3.6:LDA 仅在线性可分数据上能获得理想结果,试设计一个改进方法,使其能较好

地用于非线性可分数据。

在当前维度线性不可分,可以使用适当的映射方法,使其在更高一维上可分,典型的方法

有 KLDA,可以很好的划分数据。

习题 3.7:令码长为 9,类别数为 4,试给出海明距离意义下理论最优的 EOOC 二元码并证

明之。

对于 ECOC二元码,当码长为 2n时,至少可以使 2n个类别达到最优间隔,他们的海明距离为

2(n−1)。因此当类别数为 4 时,一共可能的分类器共有 24−2 种(排除了全 1 和全 0),在码长为 8

的最优分类器后添加一列没有出现过的分类器,就是码长为 9 的最优分类器。

习题 3.9:使用 OvR 和 MvM 将多分类任务分解为二分类任务求解时,试述为何无需专门针对类

别不平衡性进行处理。

书中提到,对于 OvROvR,MvMMvM 来说,由于对每个类进行了相同的处理,其拆解出的二分类

任务中类别不平衡的影响会相互抵消,因此通常不需要专门处理。以 ECOC 编码为例,每个生成的

二分类器会将所有样本分成较为均衡的二类,使类别不平衡的影响减小。当然拆解后仍然可能出

现明显的类别不平衡现象,比如一个超级大类和一群小类。

第四章 决策树

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc