3s卷第18期

No.18

Vo互35

·人工智能及识别技术·

计算机工程

Computer Engineering

文章编号。loo邺428(2009Jl譬珈200珈3

2009年9月

September 2009

文献标识码:A

中圈分类号t TP391

基于目标跟踪的并联机器人视觉位姿检测

(1.东华大学信息科学与技术学院,上海201620;2.东华大学数字化纺织服装技术教育部工程研究中心,上海201620)

陈楚林It丁永生L2,邦矿荣1,张奴平1

■蔓:建立一种基于视觉的并联机器人位姿检测系统框架,包括图像采集、图像处理、位姿检测、参数反馈4个部分。使用单日摄像头

采集图像,以二自IlI度冗余机器人为控制对象,利用Haar特征提取对目标进行粗跟踪。进一步获得目标l=特定的几个特征点,基于平行

不变性原理,得到机器人末端操作器的实际位姿参数。通过求解机器人的逆运动学方程,得到电机的控制参数。实验和仿真验证了该系统

的n『行性。

关健谣:Haar特征;二自由度并联机器人;位姿检测

vision Pose Measurement for Parallel Robot

Based on Object Tracking

CHEN Jian.finl,DING Yong-shen910 HAO Kuang.ton91,ZHANG Shu.pin91

(1.CollegeofInformation Sciences andTechnology,DonghuaUniversity,Shanghai 201620;

2.Engineering Research Center of.Digitized Textile&Fashion Technology,Ministry of Education.Donghua University,Shanghai 201620)

[Abstract|This paper presents a vision based feedback system framework of position and orientation measurement for parallel robot.It is

composed of image acquisition,camera calibration,position and orientation measurement,and parameter feedback.Single camera is used for image

acquisition.A kind of 2-DOF parallel robot is used as Control object,and Haar-like feature detection is presented as a method of rough object

tracking.In order tO acquire the real parameters based on invariants of trapezia,the special feature points on the object are determined.An

inverse·kinematics of robot is used tO get the control signals of every motor.And the feasibility of吐屺system is proved by simulation experiments.

[Key words]Haar feature;2-DOF parallel robot;pose measurement

l概述

在机器人控制中,机器人末端操作器位姿是反映机器人

控制受控对象时运动状态的重要参数。近年来有不少学者研

究通过视觉的方法来检测位姿。相对于传统检测手段机构复

杂、检测速度慢等困难,视觉方法具有非接触、检测速度快

等优点,具有较大的灵活性,能够实现多自由度的测茸。

视觉检测…系统通常包括摄像机标定、图像采集、目标

跟踪、位姿检测等步骤。在位姿检测过程中,一般需要得到

跟踪目标的几个特征点,为了能够精确地得到这些特征点,

降低背景对特征检测的影响,必须剔除目标以外的区域。

标系下的坐标。

西黧末端

L

匹童妇

一k/厂 ◆《酬摄像帐定l

。必 、哆尹

N南

再菇司. 网等吖网

P(i插槽

际嘉

l!:兰竺!厂

在本文提出的系统中,对目标Haar特征通过Adaboost睇’

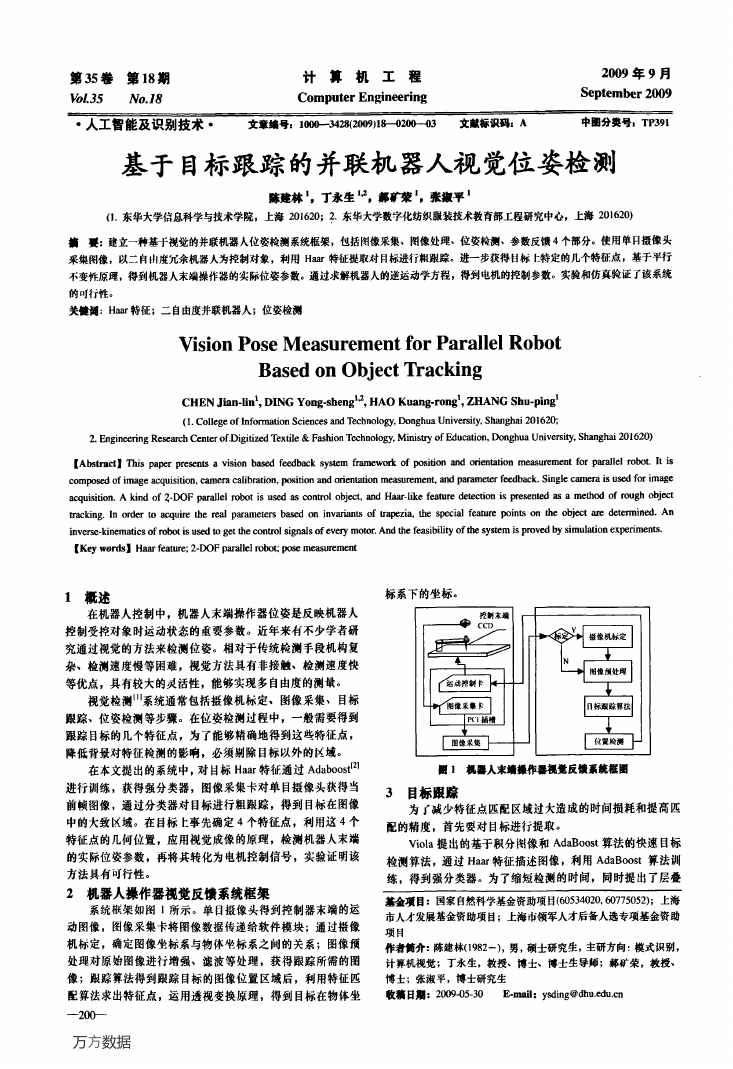

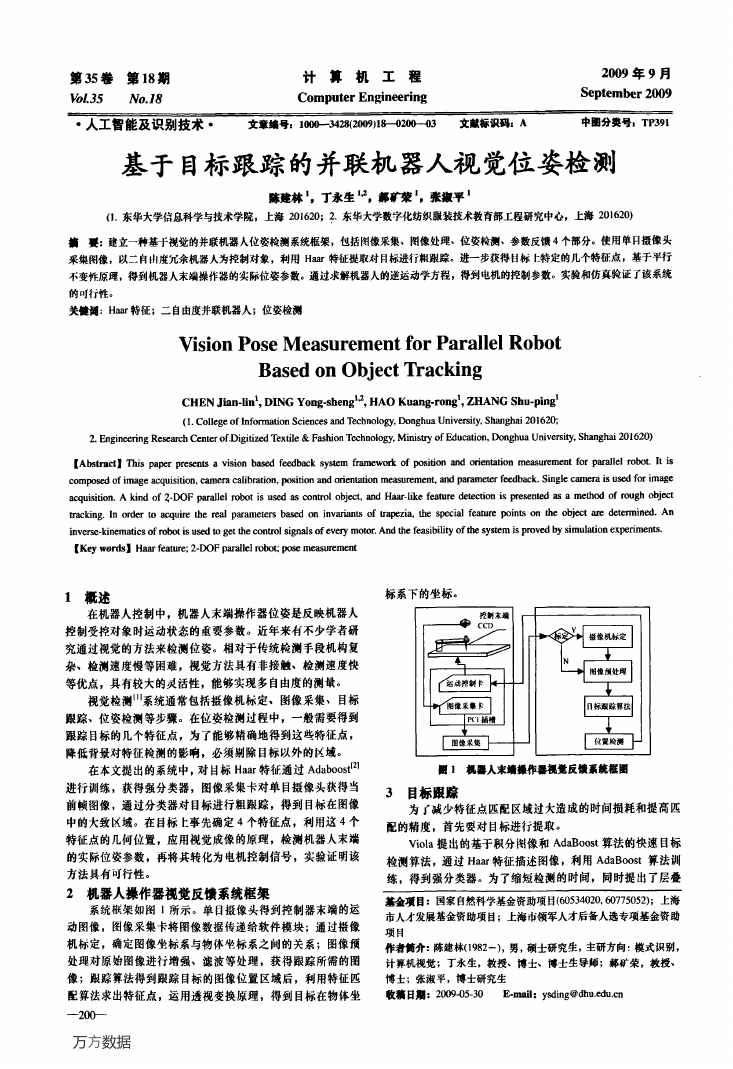

■1机器人末II撮作嚣视觉反馈系统框圈

进行训练,获得强分类器,图像采集卡对单目摄像头获得当

前帧图像,通过分类器对目标进行粗跟踪,得到目标在图像

中的大致区域。在目标E事先确定4个特征点,利用这4个

特征点的几何位置,应用视觉成像的原理,检测机器人末端

的实际位姿参数,再将其转化为电机控制信号,实验证明该

方法具有可行性。

2机器人操作器视觉反馈系统框架

系统框架如图1所示。单目摄像头得到控制器末端的运

动图像,图像采集卡将图像数据传递给软件模块;通过摄像

机标定,确定图像坐标系与物体啦标系之间的关系;图像预

处理对原始图像进行增强、滤波等处理,获得跟踪所需的图

像;跟踪算法得到跟踪目标的图像位置区域后,利用特征匹

配算法求出特征点,运用透视变换原理,得到目标在物体坐

一2()衅一

万方数据

3 目标跟踪

为r减少特征点匹配区域过大造成的时间损耗和提高匹

配的精度,首先要对目标进行提取。

Viola提出的基于积分图像和AdaBoost算法的快速目标

检测算法,通过Haar特征描述图像,利用AdaBoost算法训

练,得到强分类器。为了缩短检测的时间,同时提出了层叠

基金项目:国家自然科学基金资助项目(60534020,60775052);上海

市人才发展基金资助项目;上海市领军人才后备人选专项基金资助

项目

作者骱:陈建林(1982-),男,硕士研究生,主研方向:模式识别,

计算机视觉;丁永生,教授、博士、博士生导师;郝矿荣,教授、

博士;张淑平,博士研究生

收藕日期:2009—05—30

E-mail:ysding@dhu.edu.Cll

�

分类的思想,Viola算法在保留统计学习方法所具有的鲁棒性

由式(5)~式(7),得

的情况下使目标检测速度大大提高。

3.1

ltaar特征选择

基于过完备Haar特征集合的分类器在物体识别问题上

的优异性得到了充分的表现,而且积分图像方法的引入使得

Haar特征值的求取能够满足实时计算的要求。与以卜提及的

直方图、轮廓等特征相比,Haar特征不仅具有更强的表现能

力,同时还提供了多尺度刻画目标的能力。

3.2

AdaBoost分类算法

AdaBoost算法的基本目标是将一组弱学习算法结合成

为一个强学习算法,从而通过样本训练得到一个识别准确率

乃=五r~qj,.『=l,2;乃=五r~qJ,J=3.4

从而矩阵4个顶点在摄像机坐标系下的坐标为

x,=五r。19,,_,=l,2;x』=五r~q』,-『=3。4

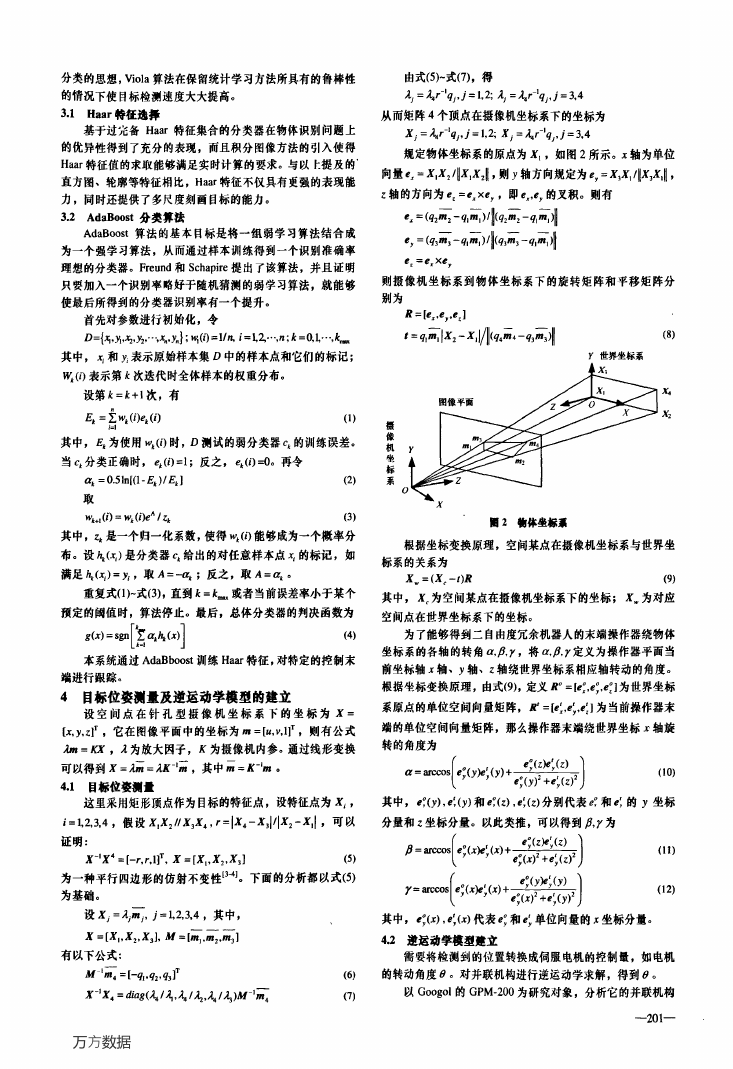

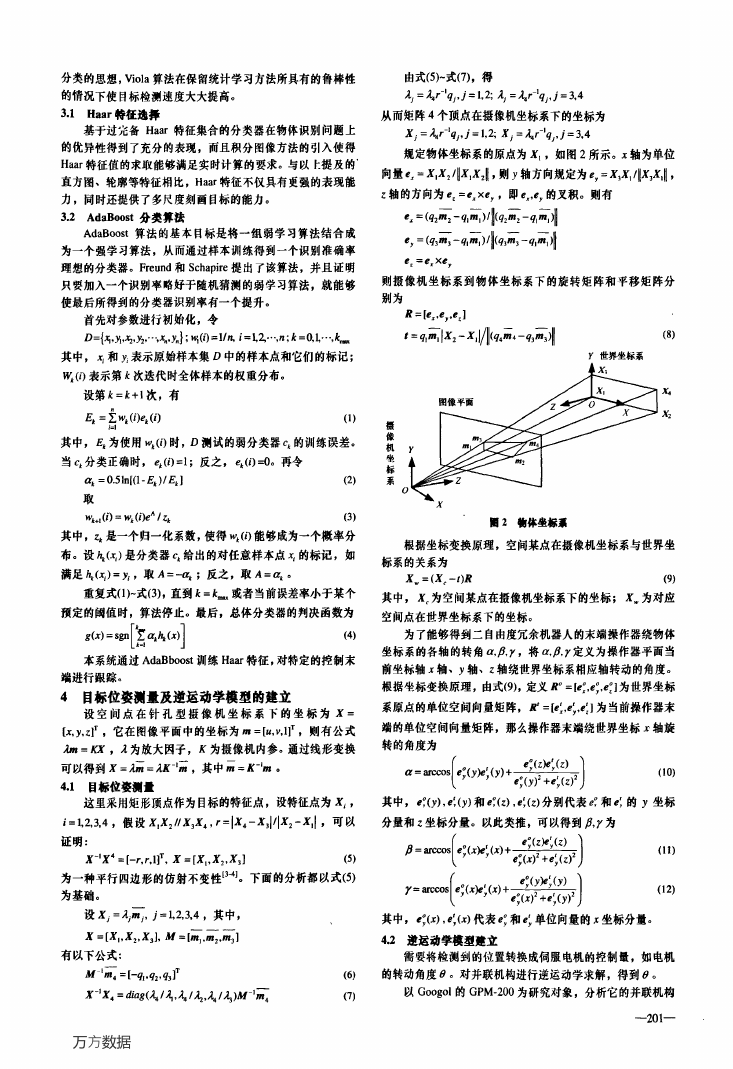

规定物体坐标系的原点为x。,如图2所示。工轴为单位

向量气=x.x:/Ix。X:lI,则Y轴方向规定为P,=x,x./Ix,五0,

z轴的方向为P:=P。XG,,即P,,口,的叉积。则有

气=(口2i—q,i)州(吼瓦一q.i)8

寥,=(q3m-:一吼i)钏(吼i一吼i)0

理想的分类器。Freund和Schapire提出了该算法,并且证明

Pz=ff×ev

只要加入一个识别率略好于随机猜测的弱学习算法,就能够

使最后所得到的分类器识别率有一个提升。

首先对参数进行初始化,令

D={再,Yl,x2,Y2,。·、‘,靠J;M{(D=l/n,i=LZ…,以;k=o'L…,七。

其中,五和Yl表示原始样本集D中的样本点和它们的标记;

睨(f)表示第k次迭代时全体样本的权重分布。

设第k=k+1次,有

^

乓=Z心(i)ek(i)

f-l

其中,巨为使用M(f)时,D测试的弱分类器q的训练误差。

当q分类正确时,ek(i)=l;反之,ek(i)--0。再令

呸=0.5In[(1一巨)/邑】

取

M+l(f)=%(i弦6,磊

(2)

(3)

其中,磊是一个归一化系数,使得%(f)能够成为一个概率分

布。设嚏(玉)是分类器q给出的对任意样本点玉的标记,如

满足以(五)=咒,取A=咆;反之,取A=吼。

重复式(1)~式(3),直到k=女~或者当前误差率小于某个

预定的阈值时,算法停止。最后,总体分类器的判决函数为

则摄像机坐标系到物体坐标系下的旋转矩阵和平移矩阵分

别为

足=k,舌,,P:】

t=ql—ml IX:一x,I/ll,q,磊·一q3i)0

y世界坐标系

(8)

兄

魁

摄

像

机

坐

标

系

D

圈2麓体坐标熏

根据坐标变换原理,空间某点在摄像机坐标系与世界坐

标系的关系为

X。=(X,-t)R

(9)

其中,x。为空间某点在摄像机坐标系下的坐标;x。为对应

空间点在世界坐标系下的坐标。

(4)

为了能够得到二自由度冗余机器人的末端操作器绕物体

坐标系的各轴的转角a,p,y,将口,∥,y定义为操作器平面当

前坐标轴J轴、Y轴、z轴绕世界坐标系相应轴转动的角度。

根据坐标变换原理,由式(9),定义眉。=瞵,口O,,P;】为世界坐标

系原点的单位空间向量矩阵,F=№:,P:,P:】为当前操作器末

端的单位空问向量矩阵,那么操作器末端绕世界坐标工轴旋

g(曲=sgnl‘窆嚷嚏(工)I

Lk=l

J

本系统通过AdaBboost训练Haar特征,对特定的控制末

端进行跟踪。

4 目标位姿测量及逆运动学模型的建立

设空间点在针孔型摄像机坐标系下的坐标为x=

Ix,y’z17,它在图像平面中的坐标为册=【戤v,1]T,则有公式

加=KI",五为放大因子,x为摄像机内参。通过线形变换

可以得到x=加=2K。肺,其中历=K“小。

4.1目标位姿撼量

这里采用矩形顶点作为目标的特征点,设特征点为x,,

f=l,2,3,4,假设xlx2/,x3工4,r=Ix4一x3I/Ix2一xlI,可以

证明:

x一1x4=【一r,r,l】T,x=IX.,x2,x3】

(5)

为一种平行四边形的仿射不变性‘341。下面的分析都以式(5)

为基础。

设xf=五f册f,J=k2,3,4,其中,

X=ixI,X2。X3】,M=【ml,册2,肼3】

有以下公式:

M1珊4=[--ql。吼,吼】1

x‘1x4=d/ag(五/&,五,五,五/五)』If一肌4

万方数据

其中,P;(),),口:(y)和口;(z),P:(z)分别代表£;和P;的Y坐标

转的角度为非一s卜啪+器)

∥=一卜蹦力+器)

y=一卜蹦曲+揣)

分量和z坐标分量。以此类推,可以得到∥,y为

㈣,

…,

m,

其中,c0,(j),P:(工)代表P:和e:单位向量的工坐标分量。

4.2逆运动学模型建立

需要将检测到的位置转换成伺服电机的控制量,如电机

(6)

(7)

的转动角度0。对并联机构进行逆运动学求解,得到0。

以Googoi的GPM-200为研究对象,分析它的并联机构

—201—

�

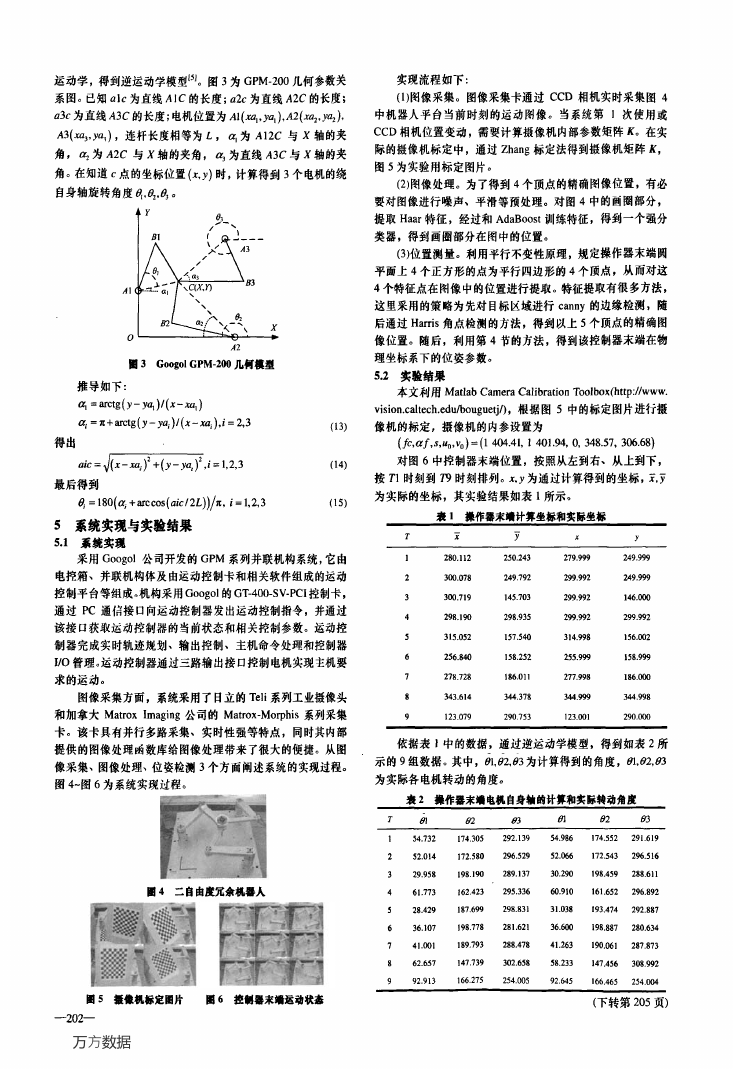

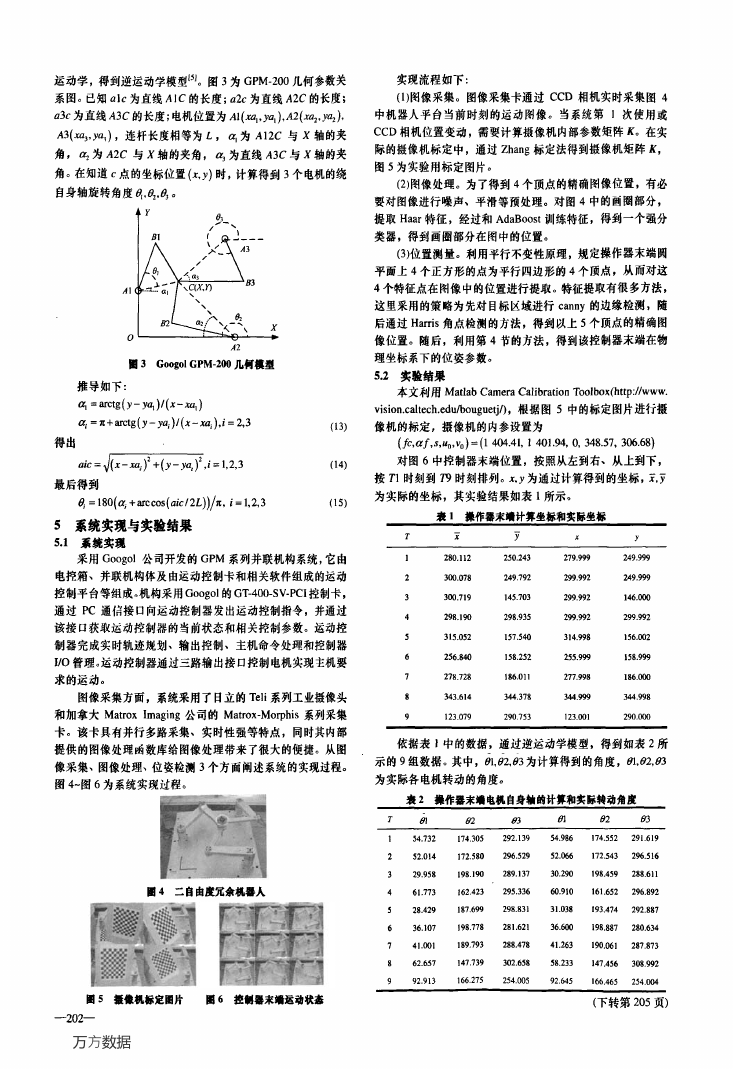

运动学,得到逆运动学模型f5J。图3为GPM一200几何参数关

实现流程如下:

系图。已知nlc为直线A1C的长度;a2c为直线A2C的长度;

a3c为直线A3C的长度;电机位置为Al(嘲,妈),A2(xa2,Ya2),

A3(xa3,飓),连杆长度相等为L,q为A12C与x轴的夹

角,呸为A2C与x轴的夹角,%为直线A3C与x轴的夹

角。在知道c点的坐标位置(工,Y)时,计算得到3个电机的绕

自身轴旋转角度塌,岛,最。

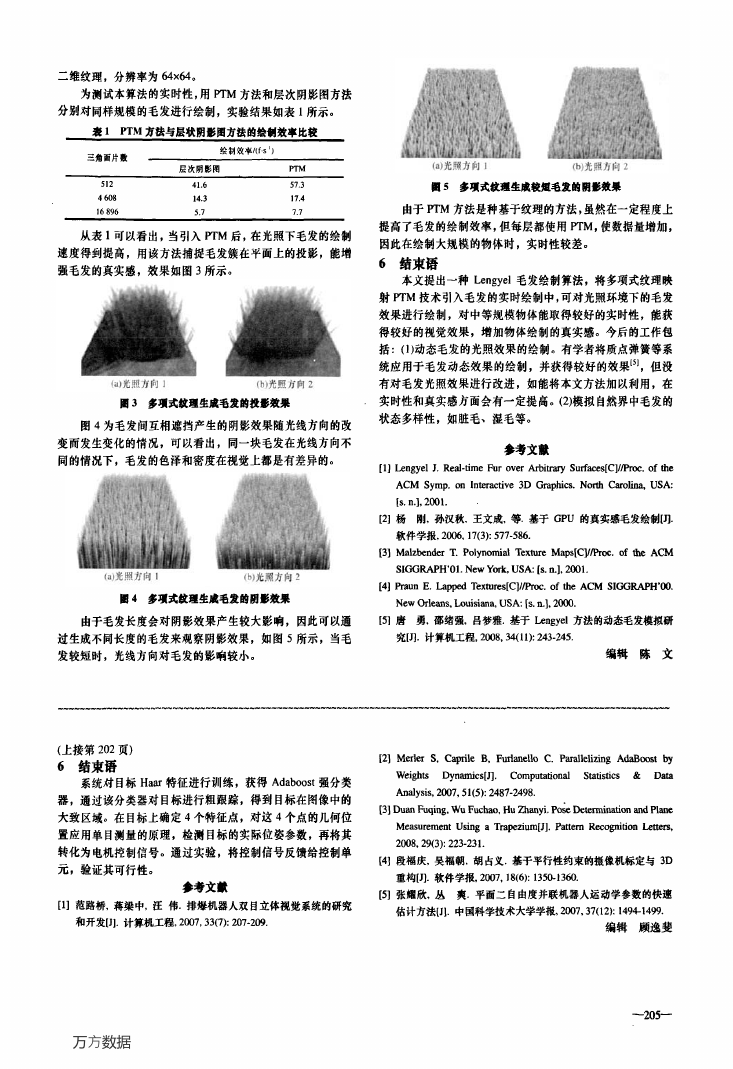

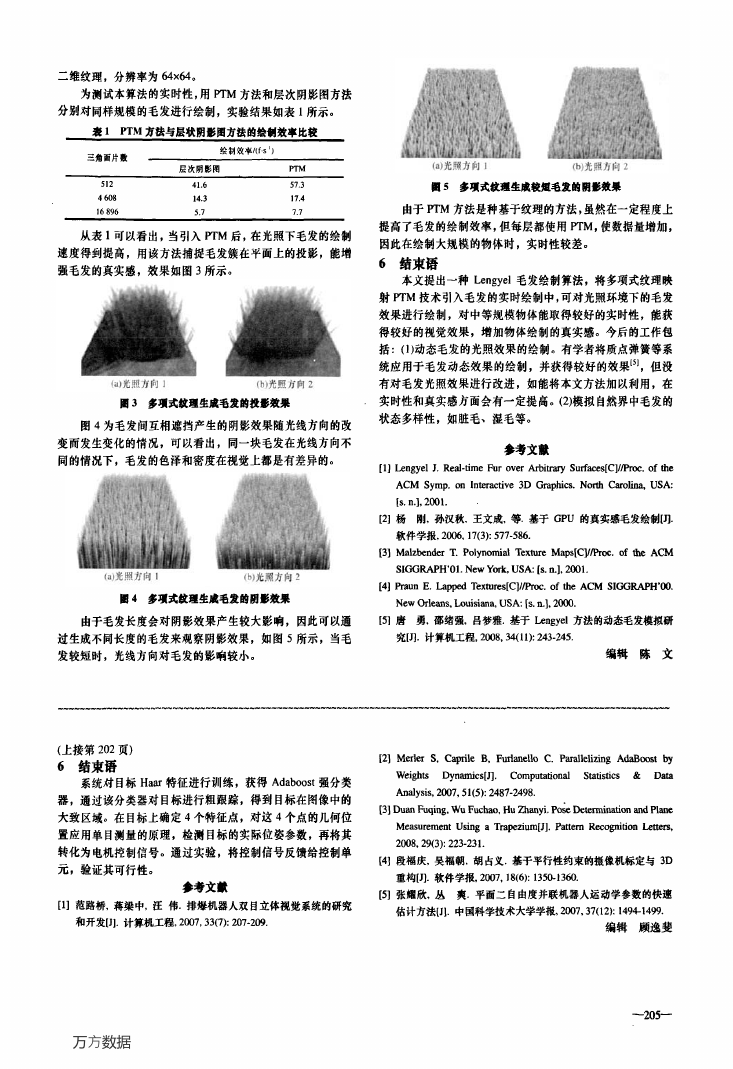

(1)图像采集。图像采集卡通过CCD相机实时采集图4

中机器人平台当前时刻的运动图像。当系统第1次使用或

CCD相机位置变动,需要计算摄像机内部参数矩阵膏。在实

际的摄像机标定中,通过Zhang标定法得到摄像机矩阵丘,

图5为实验用标定图片。

(2)图像处理。为了得到4个顶点的精确图像位置,有必

要对图像进行噪声、平滑等预处理。对图4中的画圈部分,

提取Haar特征,经过和AdaBoost训练特征,得到一个强分

类器,得到画圈部分在图中的位置。

(3)位置测量。利用平行不变性原理,规定操作器末端圆

平面上4个正方形的点为平行四边形的4个顶点,从而对这

4个特征点在图像中的位置进行提取。特征提取有很多方法,

这里采用的策略为先对目标区域进行canny的边缘检测,随

后通过Harris角点检测的方法,得到以上5个顶点的精确图

像位置。随后,利用第4节的方法,得到该控制器末端在物

理坐标系下的位姿参数。

5.2实验结果

本文利用Matlab Camera Calibration Toolbox(http://www.

vision.caltech.edu/bouguetj/),根据图5中的标定图片进行摄

f131

像机的标定,摄像机的内参设置为

(fc,af^Uo,V0)=(1 404.41,1 401.94,0,348.57,306.68)

对图6中控制器末端位置,按照从左到右、从上到下,

按丁1时刻到四时刻排列。X,Y为通过计算得到的坐标,i,歹

为实际的坐标,其实验结果如表1所示。

(14)

(15)

表1 操作器末麓计算坐标和实际坐标

一1

0

月Z

圈3

Googol GPM一200几何模型

推导如下:

q 2arctg(y—yaI)I(x~xoa)

啦='t+arctg(y—yai)l(x一.觋),i=2,3

得出

r——————:————————一

a/c=4(x—xaf)‘+(y—ya,)‘,i=l,2,3

最后得到

瞑=180(aj+arecos(aicl2L))/g,i=1,2,3

5系统实现与实验结果

5.1系统实现

采用Googol公司开发的GPM系列并联机构系统,它由

电控箱、并联机构体及由运动控制卡和相关软件组成的运动

控制平台等组成。机构采用Googol的GT-400一SV-PCI控制卡,

通过PC通信接13向运动控制器发出运动控制指令,并通过

该接口获取运动控制器的当前状态和相关控制参数。运动控

制器完成实时轨迹规划、输出控制、主机命令处理和控制器

I/O管理。运动控制器通过三路输出接121控制电机实现主机要

求的运动。

图像采集方面,系统采用了日立的Teli系列工业摄像头

和加拿大Matrox Imaging公司的Matrox—Morphis系列采集

卡。该卡具有并行多路采集、实时性强等特点,同时其内部

提供的图像处理函数库给图像处理带来了很大的便捷。从图

像采集、图像处理、位姿检测3个方面阐述系统的实现过程。

图4一图6为系统实现过程。

圈4二自由度冗余机器人

依据表l中的数据,通过逆运动学模型,得到如表2所

示的9组数据。其中,口l,p2,口3为计算得到的角度,研,铊,∞

为实际各电机转动的角度。

裹2擐作器末■电机自身轴昀计算和实际转动角度

圈5董量机标定图片

圈6控爿器末靖运动状杏

(下转第205页)

一202一

万方数据

�

二维纹理,分辨率为64x64。

为测试本算法的实时性,用町M方法和层次阴影图方法

分别对同样规模的毛发进行绘制,实验结果如表1所示。

表I

PTM方法与层状阴影图方法的绘倒效率比较

从表l可以看出,当引入PTM后,在光照下毛发的绘制

速度得到提高,用该方法捕捉毛发簇在平面上的投影,能增

强毛发的真实感,效果如图3所示。

圈3多项式纹理生成毛发的投影效果

图4为毛发间互相遮挡产生的阴影效果随光线方向的改

变而发生变化的情况,可以看出,同一块毛发在光线方向不

同的情况下,毛发的色泽和密度在视觉上都是有差异的。

圈4多项式纹理生成毛发的阴影效果

圈5多疆武纹理生成较短毛发的阴影效果

由于PTM方法是种基于纹理的方法,虽然在一定程度上

提高了毛发的绘制效率,但每层都使用PTM,使数据量增加,

因此在绘制大规模的物体时,实时性较差。

6结束语

本文提出一种Lengyel毛发绘制算法,将多项式纹理映

射盯M技术引入毛发的实时绘制中,可对光照环境下的毛发

效果进行绘制,对中等规模物体能取得较好的实时性,能获

得较好的视觉效果,增加物体绘制的真实感。今后的工作包

括:(1)动态毛发的光照效果的绘制。有学者将质点弹簧等系

统应用于毛发动态效果的绘制,并获得较好的效果pJ,但没

有对毛发光照效果进行改进,如能将本文方法加以利用,在

实时性和真实感方面会有一定提高。(2)模拟自然界中毛发的

状态多样性,如脏毛、湿毛等。

参考文献

【l】Lengyel J.Real·time Fur over Arbitrary Surfaces[C]//Proc.of the

ACM Symp.on Interactive 3D Graphics.North Carolina,USA:

IS.n.】,2001.

【21杨刚,孙汉秋,王文成,等.基于GPU的真实感毛发绘制叨.

软件学报,2006,17(3):577·586.

【3】Malzbender T.Polynomial Texture Maps[C]//Proe.of the删

SIGGRAPH’01.New York,USA:Is.n.】。2001.

【4】Praun E.Lapped Textures[C]//Proe.of the ACM SlGGRA附’oo.

New Orleans,Louisiana,USA:【s.n.】,2000.

由于毛发长度会对阴影效果产生较大影响,因此可以通

【51唐勇,邵绪强,吕梦雅.基于Lengyel方法的动态毛发模拟研

过生成不同长度的毛发来观察阴影效果,如图5所示,当毛

究【J】.计算机工程,2008,34(11):243—245.

发较短时,光线方向对毛发的影响较小。

编辑陈文

(上接第202页)

6结束语

系统对目标Haar特征进行训练,获得Adaboost强分类

器,通过该分类器对目标进行粗跟踪,得到目标在图像中的

大致区域。在目标上确定4个特征点,对这4个点的几何位

置应用单目测量的原理,检测目标的实际位姿参数,再将其

转化为电机控制信号。通过实验,将控制信号反馈给控制单

元,验证其可行性。

参考文献

【1】范路桥,蒋梁中,汪伟.排爆机器人双目立体视觉系统的研究

和开发【J】.计算机工程,2007,33(7):207.209.

【2】Merler S,Caprile B,Furlanello C.Parallelizing AdaBoost by

Weights

Dynamics[J]. Computational

Statistics &Data

Analysis,21207,5 l(5):2487-2498.

【3】Duan Fuqing,Wu Fuchao,Hu Zhanyi.Pose Determination and Plane

Measurement Using a Trapezium[J].Pattern Recognition Letters,

2008,29(3):223—231.

【4】段福庆,吴福朝,胡占义.基于平行性约束的摄像机标定与3D

重构【J】.软件学报.2007,18(6):1350-1360.

【5】张耀欣,丛 爽.平面二自由度并联机器人运动学参数的快速

估计方法【J1.中国科学技术大学学报,2007,37(12):1494-1499.

编辑顾逸斐

万方数据

—205—

�

基于目标跟踪的并联机器人视觉位姿检测

作者:

陈建林, 丁永生, 郝矿荣, 张淑平, CHEN Jian-lin, DING Yong-sheng, HAO Kuang-

rong, ZHANG Shu-ping

作者单位:

陈建林,郝矿荣,张淑平,CHEN Jian-lin,HAO Kuang-rong,ZHANG Shu-ping(东华大学信息科

学与技术学院,上海,201620), 丁永生,DING Yong-sheng(东华大学信息科学与技术学院,上

海,201620;东华大学数字化纺织服装技术教育部工程研究中心,上海,201620)

刊名:

计算机工程

英文刊名:

COMPUTER ENGINEERING

2009,35(18)

年,卷(期):

参考文献(5条)

1.范路桥;蒋梁中;汪伟 排爆机器人双目立体视觉系统的研究和开发[期刊论文]-计算机工程 2007(07)

2.Duan Fuqing;Wu Fuchao;Hu Zhanyi Pose Determination and Plane Measurement Using a Trapezium[外文期

刊] 2008(03)

3.Merler S;Caprile B;Furlanello C Parallelizing AdaBoost by Weights Dynamics[外文期刊] 2007(05)

4.张耀欣;丛爽 平面二自由度并联机器人运动学参数的快速估计方法[期刊论文]-中国科学技术大学学报 2007(12)

5.段福庆;吴福朝;胡占义 基于平行性约束的摄像机标定与3D重构[期刊论文]-软件学报 2007(06)

本文链接:http://d.g.wanfangdata.com.cn/Periodical_jsjgc200918070.aspx

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc