178

2018,54(8)

Computer Engineering and Applications 计算机工程与应用

⦾图形图像处理⦾

基于 RGB-D 融合特征的图像分类

向程谕,王冬丽,周 彦,李雅芳

XIANG Chengyu, WANG Dongli, ZHOU Yan, LI Yafang

湘潭大学 信息工程学院,湖南 湘潭 411100

School of Information Engineering, Xiangtan University, Xiangtan, Hunan 411100, China

XIANG Chengyu, WANG Dongli, ZHOU Yan, et al. Image classification based on RGB-D fusion feature. Computer

Engineering and Applications, 2018, 54(8):178-182.

Abstract:The classic image classification algorithms are mostly based on RGB or grayscale images, and the depth infor-

mation of the object or scene has not been utilized effectively. To solve this problem, this paper proposes an image classifi-

cation method based on RGB-D fusion feature. Firstly, the dense SIFT feature of color image is fused with the global Gist

feature of the depth image to generate a combined vector. Secondly, the improved K-means algorithm is used to build the

visual dictionary of the fusion feature, overcoming the dependence on the initial point selection of traditional K-means

algorithm. Moreover, in the stage of image representation, the approximate LLC feature coding method is introduced to

operate sparse coding on feature base and its corresponding visual dictionary. Finally, the linear SVM is used for image

classification. The experimental results show that the proposed algorithm can effectively improve the classification accuracy.

Key words:depth image; dense Scale Invariant Feature Transform(SIFT)feature; Gist feature; K-means; Locality-

constrained Linear Coding(LLC)sparse coding

摘 要:当前经典的图像分类算法大多是基于 RGB 图像或灰度图像,并没有很好地利用物体或场景的深度信息,针

对这个问题,提出了一种基于 RGB-D 融合特征的图像分类方法。首先,分别提取 RGB 图像 dense SIFT 局部特征与

深度图 Gist 全局特征,然后将得到的两种图像特征进行特征融合 ;其次,使用改进 K-means 算法对融合特征建立视觉

词典,克服了传统 K-means 算法过度依赖初始点选择的问题,并在图像表示阶段引入 LLC 稀疏编码对融合特征与其

对应的视觉词典进行稀疏编码 ;最后,利用线性 SVM 进行图像分类。实验结果表明,所提出的算法能有效地提高图

像分类的精度。

关键词:深度图像 ;dense 尺度不变特征变化(SIFT)特征 ;Gist 特征 ;K-means 算法 ;局部约束线性编码(LLC)稀疏编码

文献标志码:A 中图分类号:TP391.4

doi:10.3778/j.issn.1002-8331.1610-0018

1 引言

当今社会已经进入信息爆炸的时代,除了大量的文

本信息外,人类接触的多媒体信息(图片、视频等)也呈

爆炸式增长。为了准确、高效地利用、管理和检索图像,

需要计算机按照人类理解的方式准确地理解图像内

容。图像分类是解决图像理解问题的重要途径,对多媒

体检索技术的发展有着重要的推动作用。而计算机所

获取的图像可能受到视点变化、照明、遮挡与背景等多

因素的影响,使得图像分类一直以来都是计算机视觉、

人工智能领域一个具有挑战性的难题,因此,图像特征

描述和分类技术得到了迅速发展。

当 前 的 主 要 算 法 是 基 于 特 征 袋(Bag- of- Feature,

基金项目:国家自然科学基金(No.61100140,No.61104210,No.61175008)。

作者简介:向程谕(1990—),男,硕士研究生,主要研究方向为模式识别与智能信息处理;王冬丽(1980—),女,博士,副教授,主要

研究方向为模式识别与机器视觉,E-mail:wangdl@xtu.edu.cn;周彦(1978—),男,博士,副教授,主要研究方向为信息融

合;李雅芳(1992—),女,硕士研究生,主要研究方向为机器视觉。

收稿日期:2016-10-08 修回日期:2017-01-05 文章编号:1002-8331(2018)08-0178-05

CNKI 网络出版:2017-03-16, http://kns.cnki.net/kcms/detail/11.2127.TP.20170316.1515.018.html

计算机工程与应用www.ceaj.org�

向程谕,王冬丽,周 彦,等:基于 RGB-D 融合特征的图像分类

2018,54(8)

179

BOF)[1-3]算法,在文献[3]中,S.Lazebnik 提出了基于 BOF

的空间金字塔匹配(Spatial Pyramid Matching,SPM)框

架,该框架克服了 BOF 算法中丢失的空间信息,有效地

提高了图像分类的准确率。但是基于这些方法获得的

图像表示必须结合非线性核函数,比如非线性支持向量

机(Support Vector Machine,SVM),才能获得较好的分

类模型,因此图像分类的效率很低。

近几年来,随着稀疏编码(Sparse Coding,SC)理论

的日渐成熟,该理论也逐渐成为图像分类领域最为热门

的技术。文献[4]中 Yang 提出了一种基于稀疏编码空间

金字塔匹配(Sparse coding Spatial Pyramid Matching,

ScSPM),该模型用稀疏编码的方式替代硬分配模式,能

对视觉词汇的权重系数进行优化,从而更好地量化图像

特征,因此图像分类的准确度和效率都有很大的提升。

但由于过完备字典的原因,原本相似度极高的几个特征

有可能被截然不同地表示出来。由此可见,ScSPM 模型

的稳定性并不好。Wang 等[5]改进了 ScSPM,提出了局部

约束线性编码(Locality-constrained Linear Coding,LLC),

文中指出局部性比稀疏性更加重要,用视觉字典中的多

个基表示一个特征描述子,且相似的特征描述子通过共

享其局部的基,得到相似的编码,这使得 ScSPM 的不稳

定性得到极大改善。

然而,上述方法都是针对彩色图像的分类,忽略了

物体或者场景中的深度信息,而深度信息又是图像分类

的重要线索之一。深度信息根据距离很容易将前景与

背景分开,在一定程度上反映了物体或场景的三维信

息。随着 Kinect[6-7]的兴起,深度图像的获取变得越来越

容易,结合深度信息进行图像分类的算法也开始流行起

来。在文献[8]中,A.Janoch 使用方向梯度直方图(Histo-

gram of Oriented Gradient,HOG)算法对 RGB-D 图像

进行分类,并得出结论:对一般的深度图像分类,HOG

算法可以取得较好的效果,但当深度图像中的场景或物

体过于复杂时,HOG 算法的分类准确率会显著下降,

基于梯度特征的描述符并不能很好地描述深度特征。

文 献 [9]中 N.Silberman 先 用 尺 度 不 变 特 征 变 化(Scale

Invariant Feature Transform,SIFT)算法提取 RGB-D 图

像的特征,然后采用 SPM 编码进行图像分类,结果表明

基于 RGB-D 融合特征的图像分类比基于单特征的图像

分类效果要好得多。但是该算法存在一个缺陷,即深度

图像的深度值要么在边缘区域变化强烈,要么在背景区

域保持不变。而 SIFT 特征也是基于梯度的特征描述

符,这就导致 SIFT 算法会在深度图像边缘产生大量低

对比度、不稳定的边缘点,这些特征点并不能很好地描

述深度特征。

通过现有的方法来看,对于深度图像的特征提取,

传统的基于梯度特征的描述符并不适用。鉴于此,本文

综合考虑深度图像与彩色图像的优点与缺点,提出了一

种基于 RGB-D 融合特征与稀疏编码的图像分类算法,

首先,对彩色图像和深度图像进行特征提取,将不同的

特征结合起来,生成一个联合向量作为新的特征向量;

然后,使用改进的 K-means 聚类算法对融合的特征进行

聚类处理构造视觉字典;接着在图像表示阶段,引入近

似 LLC 模型对图像内的特征基与其对应的视觉词典进

行稀疏编码;最后利用线性 SVM 进行图像分类。

2 RGB-D 融合特征与稀疏编码

2.1 特征提取

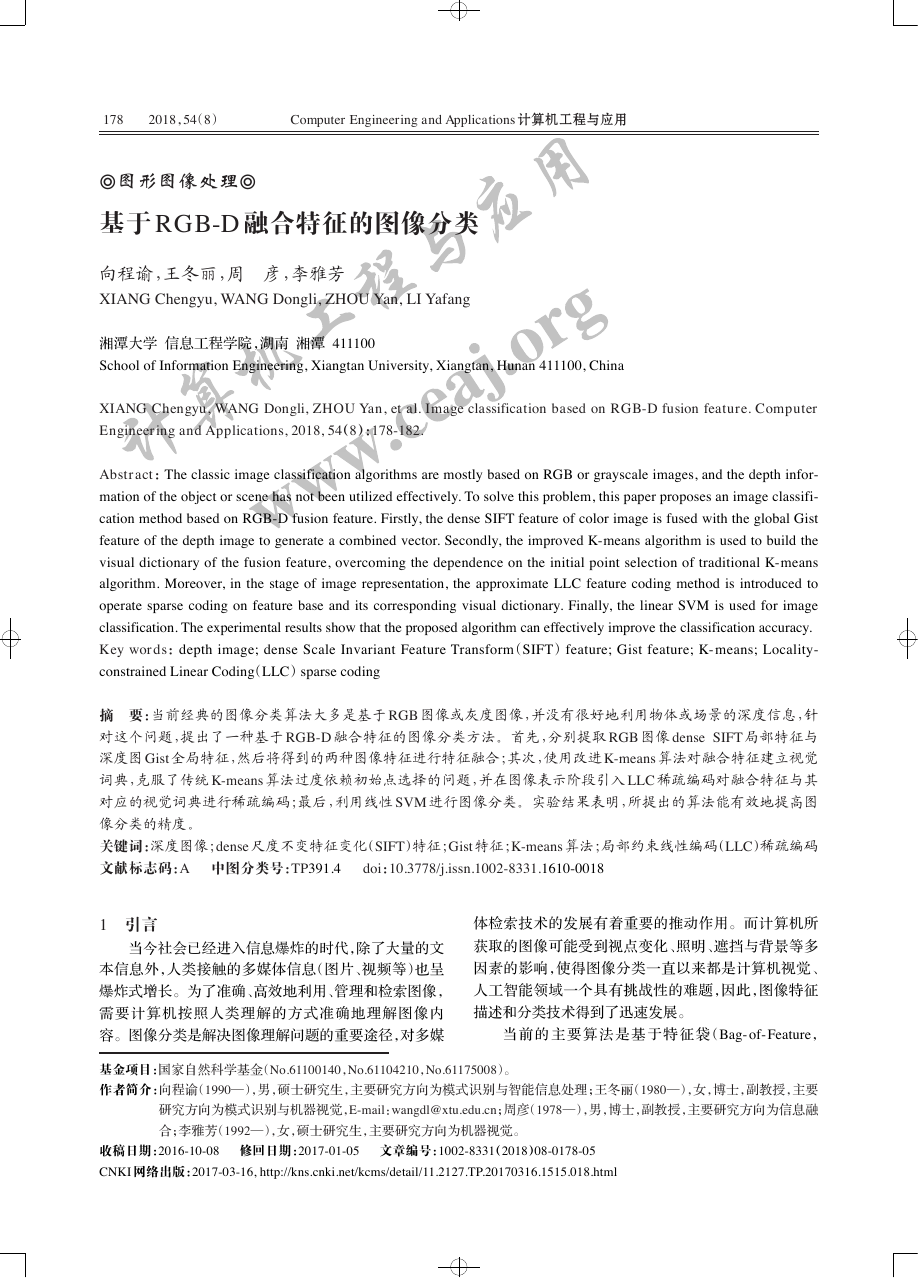

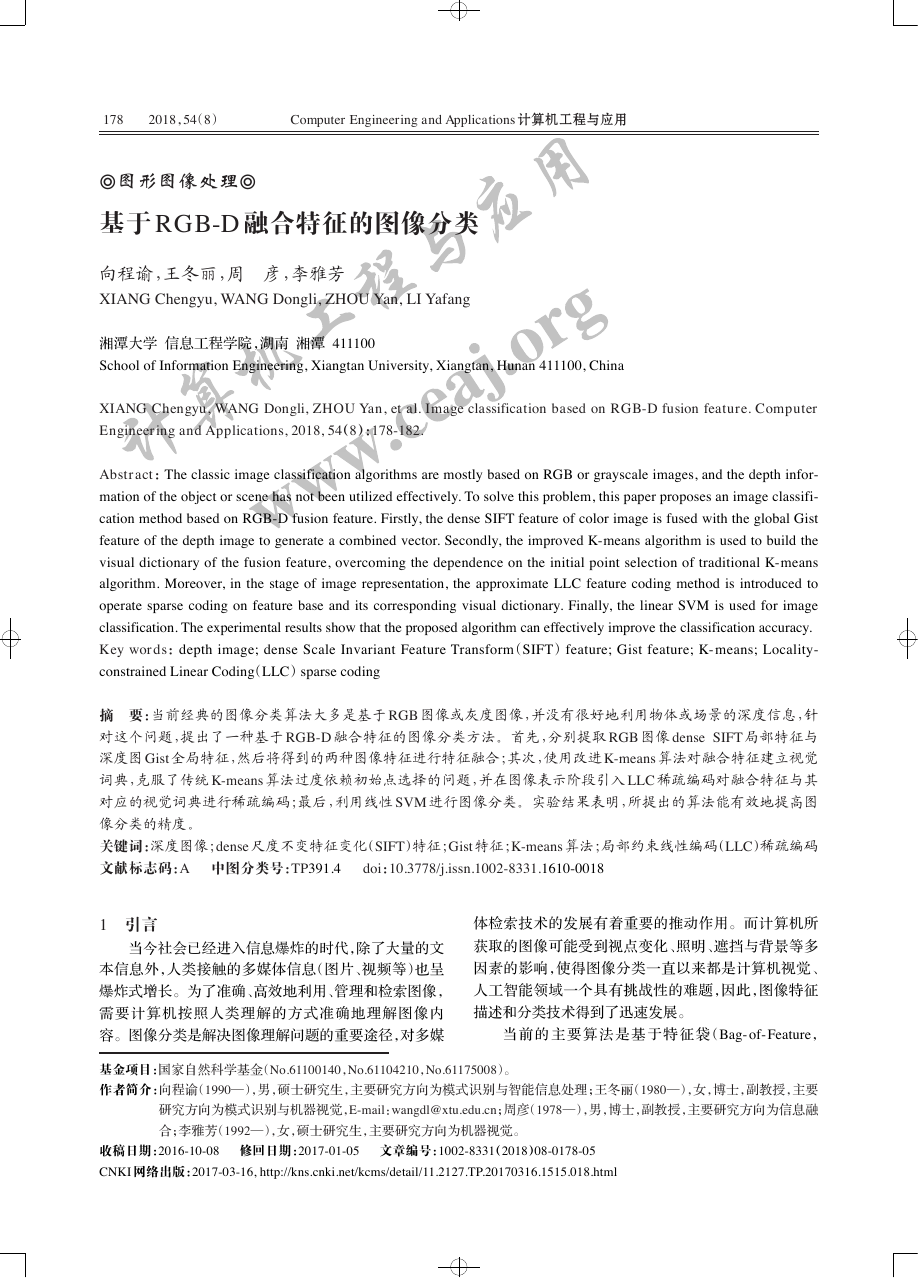

如图 1 所示,彩色图像具有良好的细节纹理与颜色

信息,但易受光照等环境因素影响。而深度图像没有光

照阴影及物体表面上纹理产生的困扰,可以得到物体更

可靠的几何信息,这两幅图像所蕴含的信息具有较强的

互补作用。在对图像进行特征提取时,图像的局部特征

描述符对目标区域识别的部分特性具有良好的适应性,

在出现不同视角和不同光照强度等环境下能很好地适

应;图像的全局特征描述符反映了一幅图像宏观方面的

整体信息,特征提取的范围覆盖图像空间的所有像素

点,全局特征能较好地表示图像的大致结构,如图像的

几何特征。所以本文基于彩色图像与深度图像的优缺

点,以及图像局部特征和全局特征的优点,提出对彩色

图像进行局部特征提取,对深度图像进行全局特征提取。

(a)RGB 图像

(b)深度图像

图 1 彩色图像与深度图像

2.1.1 RGB 图像的 dense SIFT 特征提取

SIFT 特征[10]是性能较好的局部特征描述子,具有对

不同视点、角度旋转以及尺度改变的不变性,且具有一

定的抗噪声性能。但对图像分类而言,特征的密度是决

定最终分类准确率的决定因素,而传统的 SIFT 算法提

取的图像特征较少,很容易丢失图像的部分信息,因而

在图像分类时,传统 SIFT 算法表现并不好。在文献[11]

中 Li 改进了 SIFT 算法,提出了 dense SIFT 算法,并在

实 验 中将其与传统 SIFT 算 法进行了比较 ,结果表明

dense SIFT 分类效果远好于 SIFT 算法。因此本文将采

用 dense SIFT 算法对 RGB 图像进行特征提取。

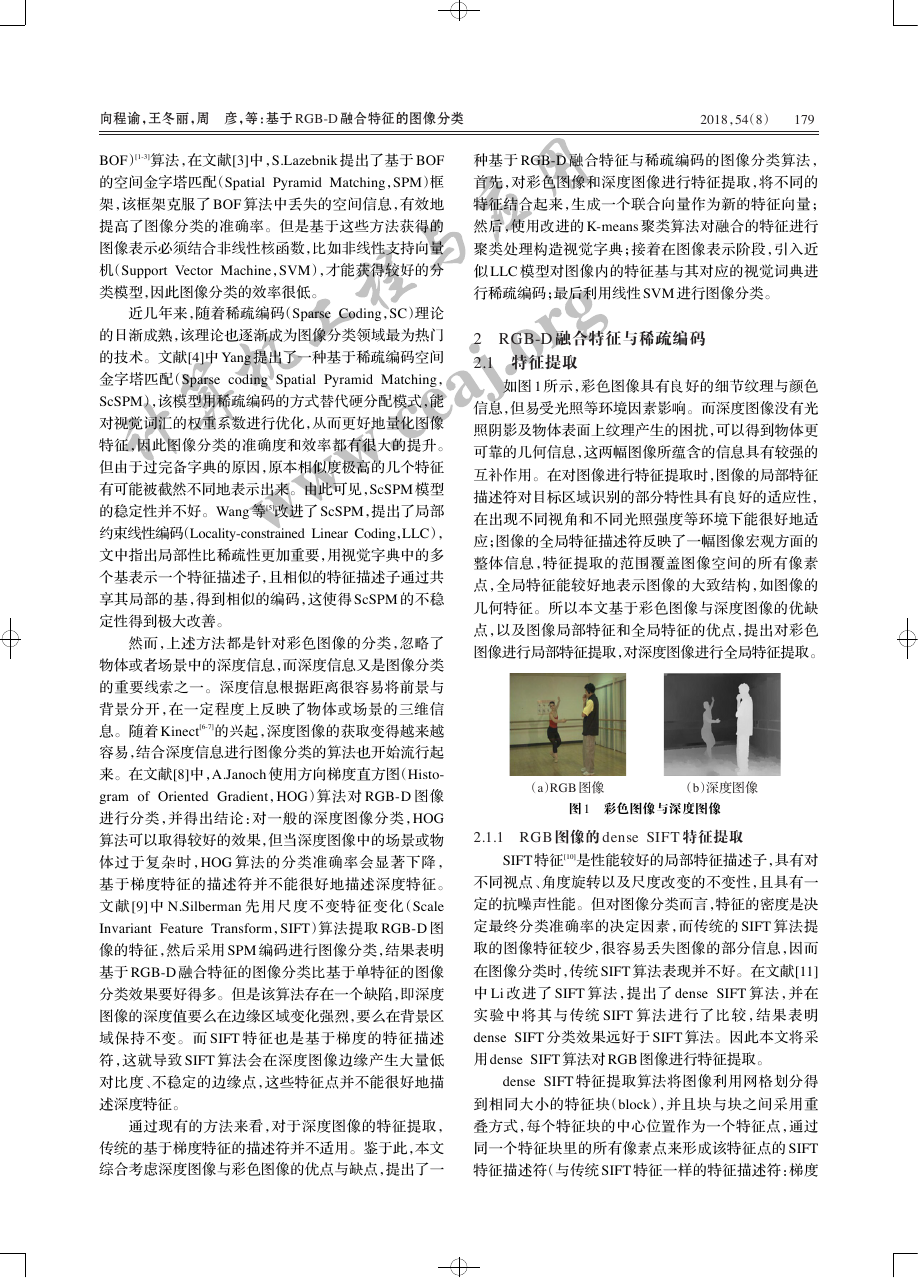

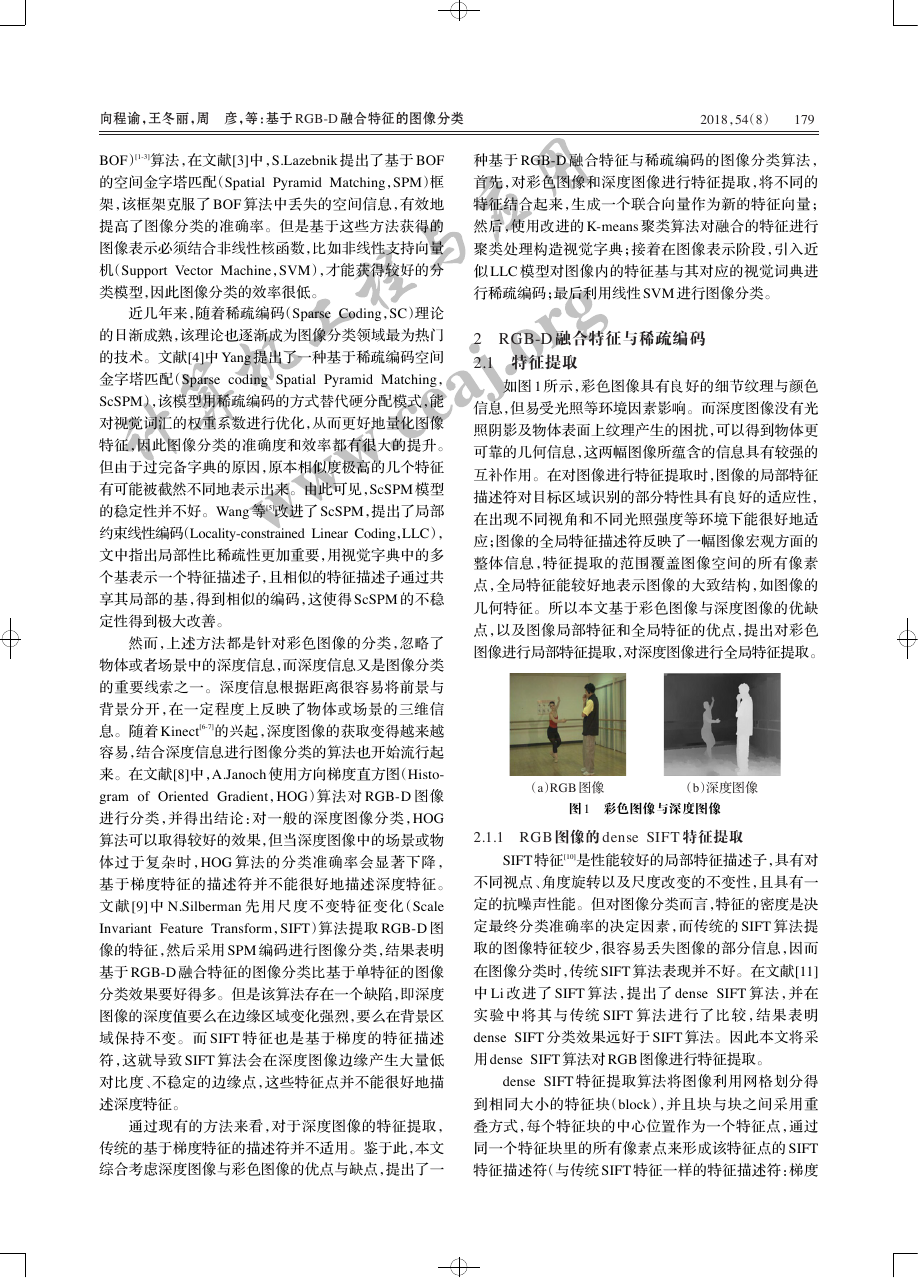

dense SIFT 特征提取算法将图像利用网格划分得

到相同大小的特征块(block),并且块与块之间采用重

叠方式,每个特征块的中心位置作为一个特征点,通过

同一个特征块里的所有像素点来形成该特征点的 SIFT

特征描述符(与传统 SIFT 特征一样的特征描述符:梯度

计算机工程与应用www.ceaj.org�

180

2018,54(8)

Computer Engineering and Applications 计算机工程与应用

直方图)。从图 2 可以看出,dense SIFT 算法能提取到

大量的特征点,可以将整个图像信息都包括在内。

(a)RGB 图像

(b)dense SIFT 特征

图 2 RGB 图像及其 dense SIFT 特征

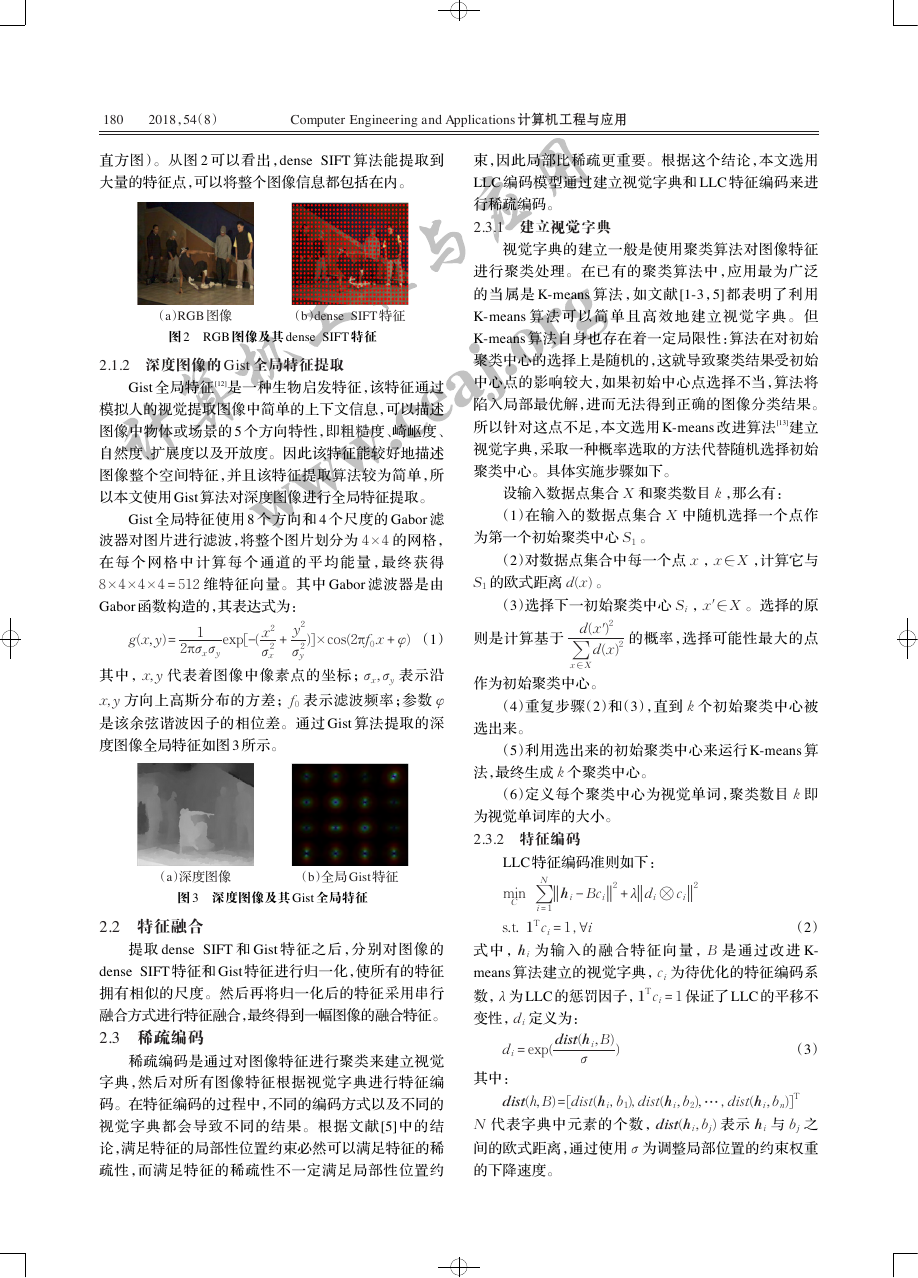

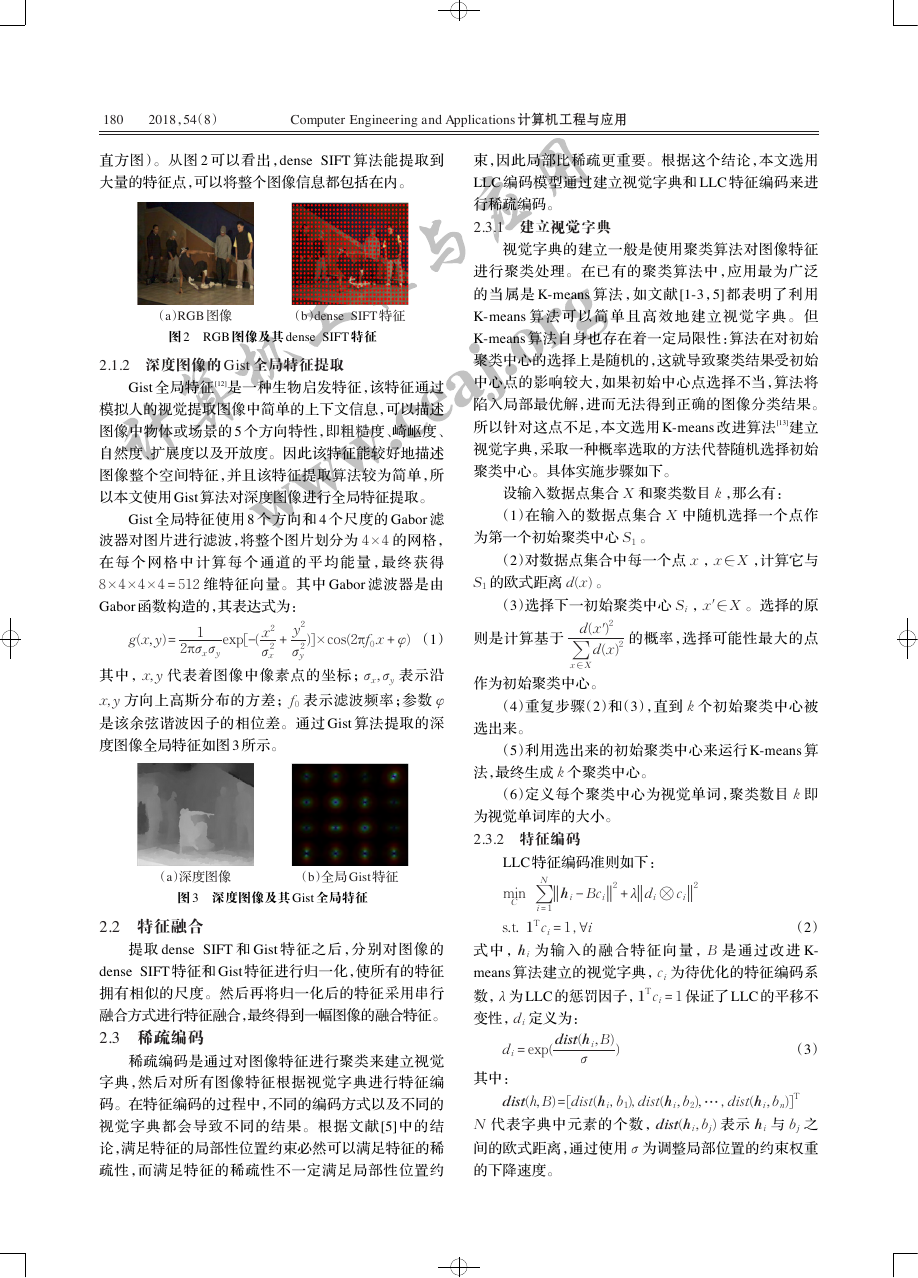

2.1.2 深度图像的 Gist 全局特征提取

Gist 全局特征[12]是一种生物启发特征,该特征通过

模拟人的视觉提取图像中简单的上下文信息,可以描述

图像中物体或场景的 5 个方向特性,即粗糙度、崎岖度、

自然度、扩展度以及开放度。因此该特征能较好地描述

图像整个空间特征,并且该特征提取算法较为简单,所

以本文使用 Gist 算法对深度图像进行全局特征提取。

Gist 全局特征使用 8 个方向和 4 个尺度的 Gabor 滤

波器对图片进行滤波,将整个图片划分为 4 × 4 的网格,

在 每 个 网 格 中 计 算 每 个 通 道 的 平 均 能 量 ,最 终 获 得

8 × 4 × 4 × 4 = 512 维特征向量。其中 Gabor 滤波器是由

Gabor 函数构造的,其表达式为:

y2

σ 2

y

)] × cos(2πf0 x + φ) (1)

exp[-( x2

σ 2

x

2πσxσy

g(x,y) =

+

1

其中,x,y 代表着图像中像素点的坐标;σx,σy 表示沿

x,y 方向上高斯分布的方差;f0 表示滤波频率;参数 φ

是该余弦谐波因子的相位差。通过 Gist 算法提取的深

度图像全局特征如图 3 所示。

(a)深度图像

(b)全局 Gist 特征

图 3 深度图像及其 Gist 全局特征

2.2 特征融合

提取 dense SIFT 和 Gist 特征之后,分别对图像的

dense SIFT 特征和 Gist 特征进行归一化,使所有的特征

拥有相似的尺度。然后再将归一化后的特征采用串行

融合方式进行特征融合,最终得到一幅图像的融合特征。

2.3 稀疏编码

稀疏编码是通过对图像特征进行聚类来建立视觉

字典,然后对所有图像特征根据视觉字典进行特征编

码。在特征编码的过程中,不同的编码方式以及不同的

视觉字典都会导致不同的结果。根据文献[5]中的结

论,满足特征的局部性位置约束必然可以满足特征的稀

疏性,而满足特征的稀疏性不一定满足局部性位置约

束,因此局部比稀疏更重要。根据这个结论,本文选用

LLC 编码模型通过建立视觉字典和 LLC 特征编码来进

行稀疏编码。

2.3.1 建立视觉字典

视觉字典的建立一般是使用聚类算法对图像特征

进行聚类处理。在已有的聚类算法中,应用最为广泛

的当属是 K-means 算法,如文献[1-3,5]都表明了利用

K-means 算 法 可 以 简 单 且 高 效 地 建 立 视 觉 字 典 。 但

K-means 算法自身也存在着一定局限性:算法在对初始

聚类中心的选择上是随机的,这就导致聚类结果受初始

中心点的影响较大,如果初始中心点选择不当,算法将

陷入局部最优解,进而无法得到正确的图像分类结果。

所以针对这点不足,本文选用 K-means 改进算法[13]建立

视觉字典,采取一种概率选取的方法代替随机选择初始

聚类中心。具体实施步骤如下。

设输入数据点集合 X 和聚类数目 k ,那么有:

(1)在输入的数据点集合 X 中随机选择一个点作

为第一个初始聚类中心 S1 。

(2)对数据点集合中每一个点 x ,x ∈ X ,计算它与

S1 的欧式距离 d(x) 。

(3)选择下一初始聚类中心 Si ,x′ ∈ X 。选择的原

则是计算基于

d(x′)2

∑

d(x)2

x ∈ X

作为初始聚类中心。

的概率,选择可能性最大的点

(4)重复步骤(2)和(3),直到 k 个初始聚类中心被

选出来。

(5)利用选出来的初始聚类中心来运行 K-means 算

法,最终生成 k 个聚类中心。

(6)定义每个聚类中心为视觉单词,聚类数目 k 即

为视觉单词库的大小。

2.3.2 特征编码

LLC 特征编码准则如下:

∑

N

hi - Bci

min

C

s.t. 1Tci = 1,∀i

i = 1

2 + λ

di ⊗ ci

2

(2)

式 中 ,hi 为 输 入 的 融 合 特 征 向 量 ,B 是 通 过 改 进 K-

means 算法建立的视觉字典,ci 为待优化的特征编码系

数,λ 为 LLC 的惩罚因子,1Tci = 1 保证了 LLC 的平移不

变性,di 定义为:

di = exp( dist(hi,B)

σ

)

(3)

其中:

dist(h,B) =[dist(hi,b1),dist(hi,b2),⋯,dist(hi,bn)]T

N 代表字典中元素的个数,dist(hi,bj) 表示 hi 与 bj 之

间的欧式距离,通过使用 σ 为调整局部位置的约束权重

的下降速度。

计算机工程与应用www.ceaj.org�

向程谕,王冬丽,周 彦,等:基于 RGB-D 融合特征的图像分类

2018,54(8)

181

式(2)中,编码模型在 ci 的求解过程中,待编码的特

征值倾向选择视觉字典中距离较近的基,形成一个局部

坐标系统。因此,根据这个规律,Wang[5]提出一种简单

的近似 LLC 特征编码方式来加速编码过程,即不求解

式(2),对于任意一个带编码的特征值 hi ,使用 k 邻近

搜索选取视觉字典 B 中距离其最近的 K 个基,通过求

解规模更小的线性系统来获得编码。其表达式如下:

∑

N

2

i = 1

hi - Bici

min

C

s.t. 1Tci = 1,∀i

(4)

根据式(4)解析解,近似 LLC 特征编码能够将计算

复杂度从 o(N 2) 降为 o(N + K 2) ,其中 K << N ,但最后的

性能与 LLC 特征编码相差不大。由于近似 LLC 特征编

码方式既可以保留局部特征,又可以保证编码稀疏性的

要求,所以本文的特征编码采用近似 LLC 特征编码。

(a)RGB-D Object 数据集

3 实验结果与分析

为了验证本文算法的有效性,实验采用了两个数据

集:RGB-D Object 数据集[14]和 RGB-D Scenes[15]数据集,

来验证本文算法的分类性能,并根据结果进一步分析了

不同的特征与不同的视觉字典的构建对分类性能的

影响。

3.1 实验数据集

(1)RGB-D Object 数据集。RGB-D Object 数据集

由 51 个类别 300 种不同视角、不同光照条件下的常见日

用品的 RGB-D 图像组成,这些图像全部通过 Kinect 摄

像机获取,共 278 374 幅。

(2)RGB-D Scenes 数据集。RGB-D Scenes 数据集

是由华盛顿大学提供的一个多视角的场景图片数据集,

该数据集由 8 个分类场景组成,共 5 972 张图片,图像大

小均为 640×480。

实验数据集中的部分图像如图 4 所示。

3.2 实验结果

3.2.1 RGB-D Object 数据集

在 RGB-D Object 数据集中,因为图片数据过于巨

大,所以本文选择 45 000 幅深度图像与 RGB 图像用于

实验,并将图像尺寸调整为 64 × 64 大小。对于特征提

取,实验中 RGB 图像提取的 dense SIFT 特征采样间隔

设置为 2 像素,图像块为 4 × 4 ;深度图像全局 Gist 特征

提取按本文 2.1.2 节进行设置。建立视觉字典时,字典

大 小 设 为 200。 SVM 分 类 时 采 用 LIBSVM 工 具 包 的

libsvm3.12 工具箱,选取 80%图片用于训练,20%图片

用于测试。

分类准确率与其他方法的对比如表 1 所示。

Bo 等在文献[15]中将三种特征集成,分别用线性

Linear SVM、Kernel SVM 和 Random Forest 对其进行

训练与分类,在此次实验中分别获得 81.9%、83.8%与

(b)RGB-D Scenes 数据集

图 4 实验数据集中的部分图像

表 1 RGB-D Object 数据集上的图像分类准确率比较

方法

准确率/%

Linear SVM[15]

Kernel SVM[15]

Random Forest[15]

DKD[16]

HMP[17]

SIFT+SPM[10]

本文方法

81.9

83.8

79.6

86.0

85.4

84.2

87.5

79.6%分类准确率;Ren 在文献[16]中利用深度图与彩色

图进行三维重建获取点云模型,然后在点云模型的基础

上 提 取 特 征 ,从 而 进 行 分 类 ,在 本 次 实 验 中 获 得 了

86.0%准确率;Fox 等在文献[17]中使用空间金字塔模型

无监督地从原始 RGB-D 图像中学习分层的特征,并利

用 这 些 特 征 实 现 最 后 的 分 类 ,在 本 次 实 验 中 获 得 了

85.4%准确率;而本文提出的算法获得了 87.5%的准确

率,与之前最好的结果相比提高了约 1.5%,由此可以看

出本文算法具有良好的分类性能。

3.2.2 RGB-D Scenes 数据集

在 RGB-D Scenes 数据集中,将全部图像用于实验,

并将图像尺寸调整为 512×512。对于特征提取,本次实

计算机工程与应用www.ceaj.org�

182

2018,54(8)

Computer Engineering and Applications 计算机工程与应用

desk1

1.00

0.00

0.00

0.00

0.00

0.00

0.00

0.00

desk1

1.00

0.00

0.00

0.00

0.00

0.00

0.00

0.00

desk2

0.07

0.76

0.17

0.00

0.00

0.00

0.00

0.00

desk2

0.10

0.78

0.12

0.00

0.00

0.00

0.00

0.00

desk3

0.07

0.15

0.77

0.00

0.00

0.00

0.00

0.00

desk3

0.02

0.17

0.81

0.00

0.00

0.00

0.00

0.00

kitchen_small

0.00

0.00

0.00

0.95

0.05

0.00

0.00

0.00

kitchen_small

0.00

0.00

0.00

1.00

0.00

0.00

0.00

0.00

meeting_small

0.00

0.00

0.00

0.03

0.97

0.00

0.00

0.00

meeting_small

0.00

0.00

0.00

0.03

0.97

0.00

0.00

0.00

table

0.00

0.00

0.00

0.00

0.00

1.00

0.00

0.00

table

0.00

0.00

0.00

0.00

0.00

1.00

0.00

0.00

table_small_1

0.00

0.00

0.00

0.00

0.00

0.00

0.88

0.13

table_small_1

0.00

0.00

0.00

0.00

0.00

0.00

0.86

0.14

table_small_2

0.00

0.00

0.00

0.00

0.00

0.11

0.83

table_small_2

0.00

0.00

0.00

0.00

0.00

desk1

desk2

meeting_small

kitchen_small

desk3

0.06

table

table_small_1

table_small_2

desk1

desk2

meeting_small

kitchen_small

desk3

0.04

0.96

0.00

table

table_small_1

table_small_2

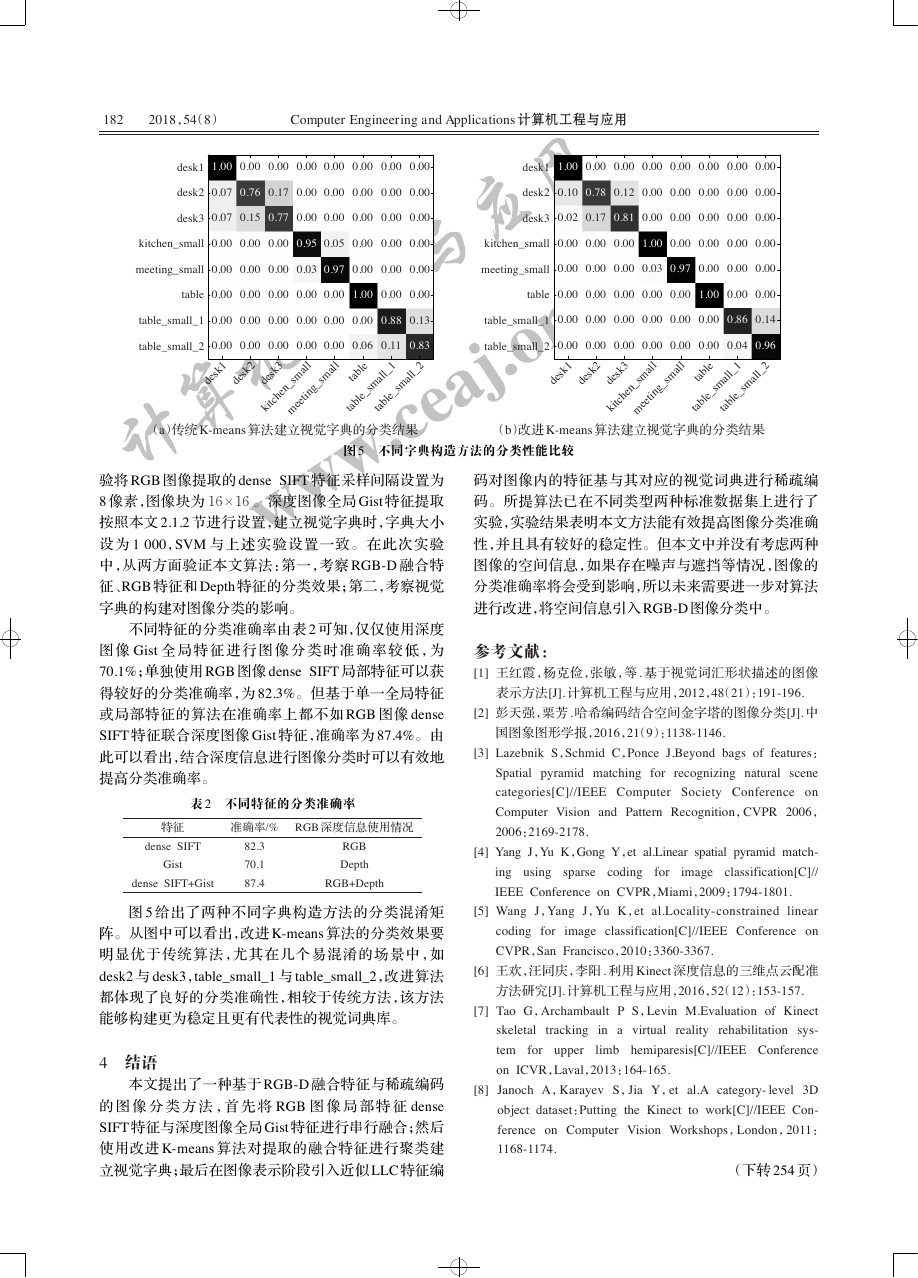

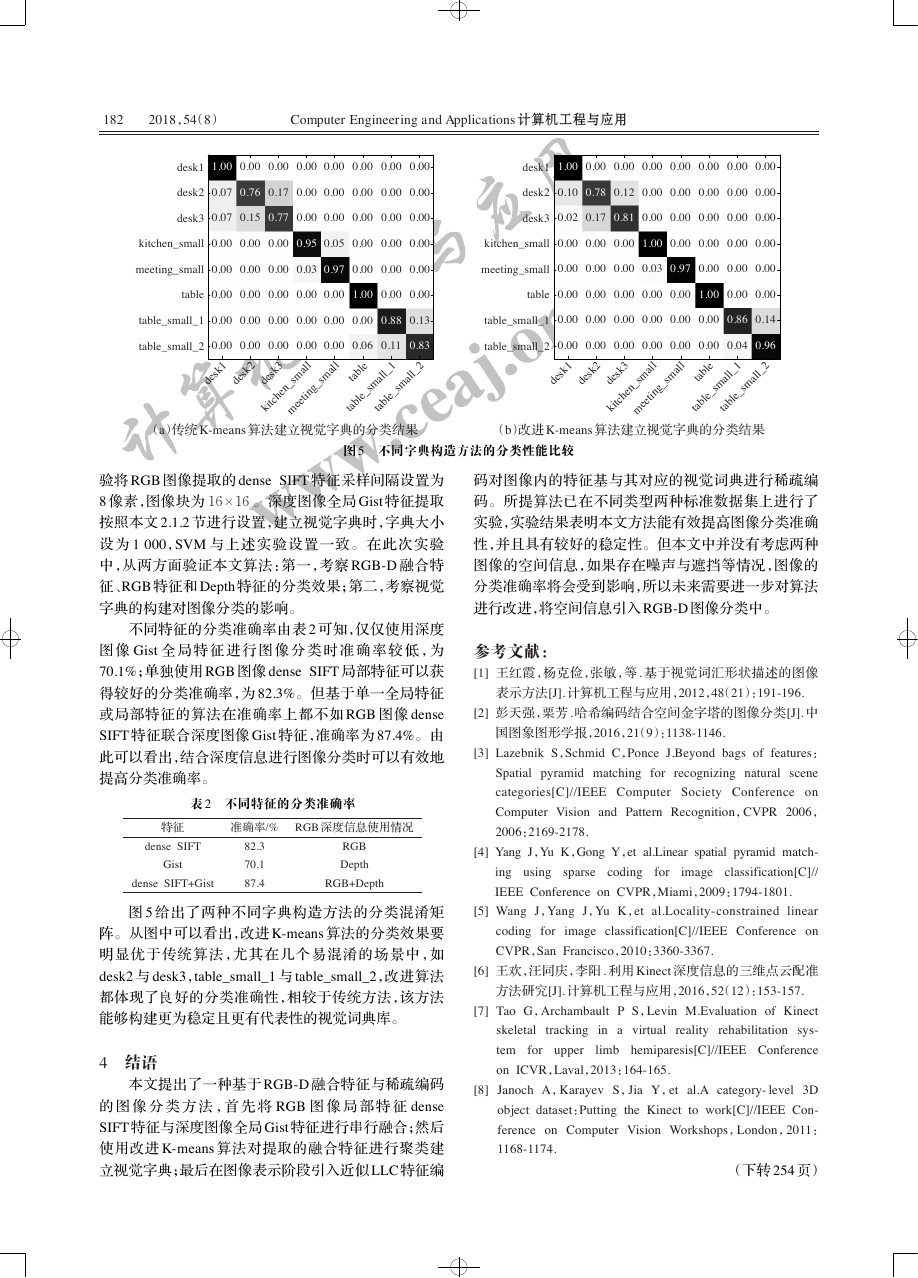

(a)传统 K-means 算法建立视觉字典的分类结果

(b)改进 K-means 算法建立视觉字典的分类结果

图 5 不同字典构造方法的分类性能比较

验将 RGB 图像提取的 dense SIFT 特征采样间隔设置为

8 像素,图像块为 16 × 16 。深度图像全局 Gist 特征提取

按照本文 2.1.2 节进行设置,建立视觉字典时,字典大小

设为 1 000,SVM 与上述实验设置一致。在此次实验

中,从两方面验证本文算法:第一,考察 RGB-D 融合特

征、RGB 特征和 Depth 特征的分类效果;第二,考察视觉

字典的构建对图像分类的影响。

不同特征的分类准确率由表 2 可知,仅仅使用深度

图 像 Gist 全 局 特 征 进 行 图 像 分 类 时 准 确 率 较 低 ,为

70.1%;单独使用 RGB 图像 dense SIFT 局部特征可以获

得较好的分类准确率,为 82.3%。但基于单一全局特征

或局部特征的算法在准确率上都不如 RGB 图像 dense

SIFT 特征联合深度图像 Gist 特征,准确率为 87.4%。由

此可以看出,结合深度信息进行图像分类时可以有效地

提高分类准确率。

表 2 不同特征的分类准确率

特征

准确率/%

RGB 深度信息使用情况

dense SIFT

Gist

dense SIFT+Gist

82.3

70.1

87.4

RGB

Depth

RGB+Depth

图 5 给出了两种不同字典构造方法的分类混淆矩

阵。从图中可以看出,改进 K-means 算法的分类效果要

明显优于传统算法,尤其在几个易混淆的场景中,如

desk2 与 desk3,table_small_1 与 table_small_2,改进算法

都体现了良好的分类准确性,相较于传统方法,该方法

能够构建更为稳定且更有代表性的视觉词典库。

4 结语

本文提出了一种基于 RGB-D 融合特征与稀疏编码

的 图 像 分 类 方 法 ,首 先 将 RGB 图 像 局 部 特 征 dense

SIFT 特征与深度图像全局 Gist 特征进行串行融合;然后

使用改进 K-means 算法对提取的融合特征进行聚类建

立视觉字典;最后在图像表示阶段引入近似 LLC 特征编

码对图像内的特征基与其对应的视觉词典进行稀疏编

码。所提算法已在不同类型两种标准数据集上进行了

实验,实验结果表明本文方法能有效提高图像分类准确

性,并且具有较好的稳定性。但本文中并没有考虑两种

图像的空间信息,如果存在噪声与遮挡等情况,图像的

分类准确率将会受到影响,所以未来需要进一步对算法

进行改进,将空间信息引入 RGB-D 图像分类中。

参考文献:

[1] 王红霞,杨克俭,张敏,等 . 基于视觉词汇形状描述的图像

表示方法[J]. 计算机工程与应用,2012,48(21):191-196.

[2] 彭天强,栗芳 . 哈希编码结合空间金字塔的图像分类[J]. 中

国图象图形学报,2016,21(9):1138-1146.

[3] Lazebnik S,Schmid C,Ponce J.Beyond bags of features:

Spatial pyramid matching for

recognizing natural scene

categories[C]//IEEE Computer Society Conference on

Computer Vision and Pattern Recognition,CVPR 2006,

2006:2169-2178.

[4] Yang J,Yu K,Gong Y,et al.Linear spatial pyramid match-

classification[C]//

ing using sparse

IEEE Conference on CVPR,Miami,2009:1794-1801.

coding for

image

[5] Wang J,Yang J,Yu K,et al.Locality-constrained linear

image classification[C]//IEEE Conference on

coding for

CVPR,San Francisco,2010:3360-3367.

[6] 王欢,汪同庆,李阳 . 利用 Kinect 深度信息的三维点云配准

方法研究[J]. 计算机工程与应用,2016,52(12):153-157.

[7] Tao G,Archambault P S,Levin M.Evaluation of Kinect

reality rehabilitation sys-

limb hemiparesis[C]//IEEE Conference

skeletal

tem for upper

on ICVR,Laval,2013:164-165.

tracking in a virtual

[8] Janoch A,Karayev S,Jia Y,et al.A category- level 3D

object dataset:Putting the Kinect to work[C]//IEEE Con-

ference on Computer Vision Workshops,London,2011:

1168-1174.

(下转 254 页)

计算机工程与应用www.ceaj.org�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc