过拟合、正则化点点滴滴

1. 判断方法

过拟合(Over-fitting),模型在训练样本表现的过于优越,在验证集和测试

集表现不佳。出现这种现象的原因是训练数据中存在噪音或者训练数据太少。

过拟合问题,特征维度(或参数)过多,导致拟合的函数完美的经过训练集,

但是对新数据的预测结果较差。

2. 产生的原因

造成过拟合的原因可以归结为:参数过多 或 样本过少

常见的原因:

1) 训练样本数据量太少、样本标注错误

2) 样本噪音干扰过大,使得机器将部分噪音认为是特征从而扰乱了预设的分类规则

3) 参数太多,模型复杂度过高

4) 权值学习迭代次数足够多(Overtraining)即训练轮数过大,拟合了训练数据中的

噪音和训练样例中没有代表性的特征。

3. 解决方法|防止过拟合

1) 在神经网络模型中,可使用权值衰减(L2)的方法,即每次迭代过程中以某个小因

子降低每个权值。

Early stopping:选取合适的停止训练标准,使对机器的训练在合适的程度

2)

3) 数据增强

4) 正则化,L1 和 L2 正则化、Dropout 随机选取正则化。

4. 为什么正则化能解决过拟合?

特征变量过多会导致过拟合,为了防止过拟合会选择一些比较重要的特征变量,删掉很

多次要的特征变量,但是我们希望利用这些特征信息,所以添加正则化来约束这些特征变量,

使得这些特征变量的权重很小,接近 0,这样就能保留这些特征变量,又不至于使得这些特

征变量的影响过大。

5. L1 和 L2 正则化?

L2 和 L1 范数正则化都有助于降低过拟合风险,但是 L1 还会带来一个额外的好处,L1

正则化更易获得“稀疏”解,即它求得的参数 W 会有更少的非零分量。

�

6. L1 为什么更能容易得到稀疏解?

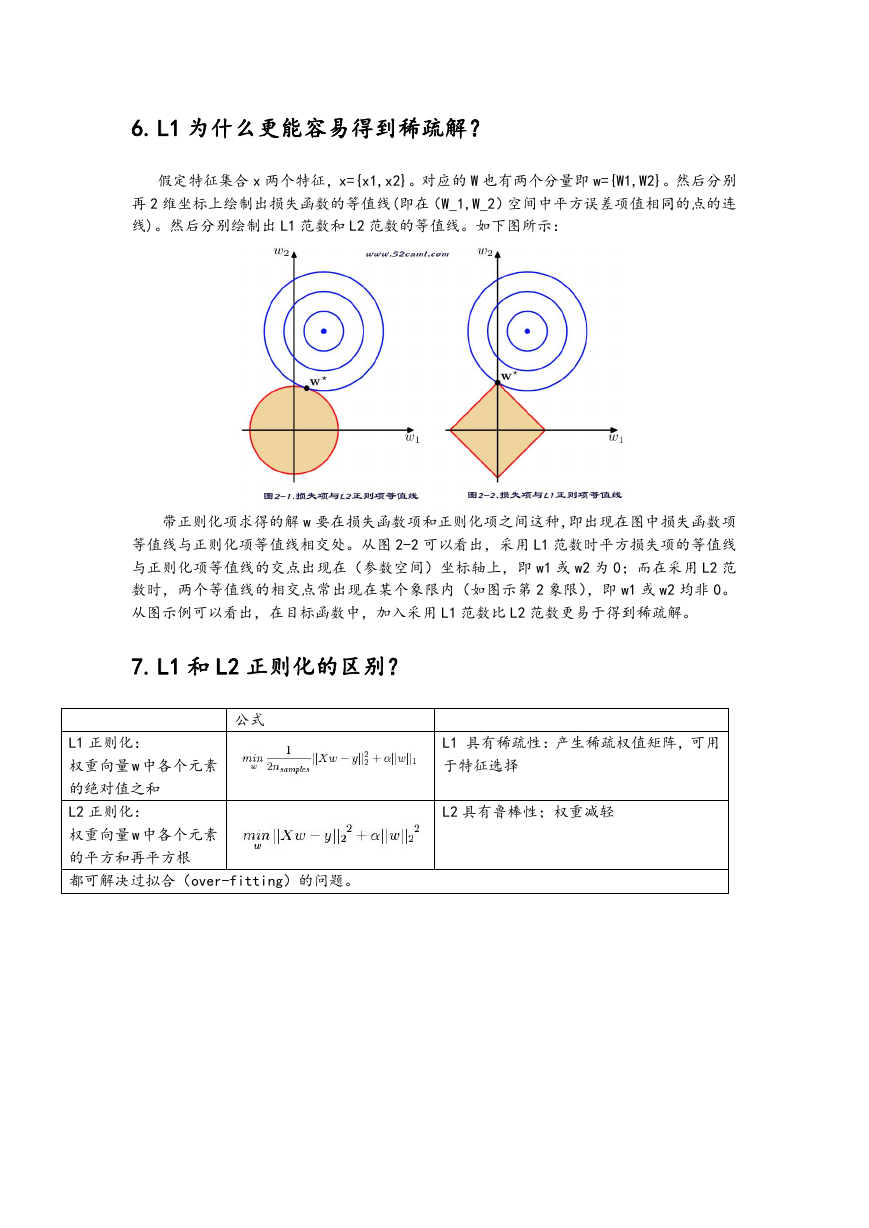

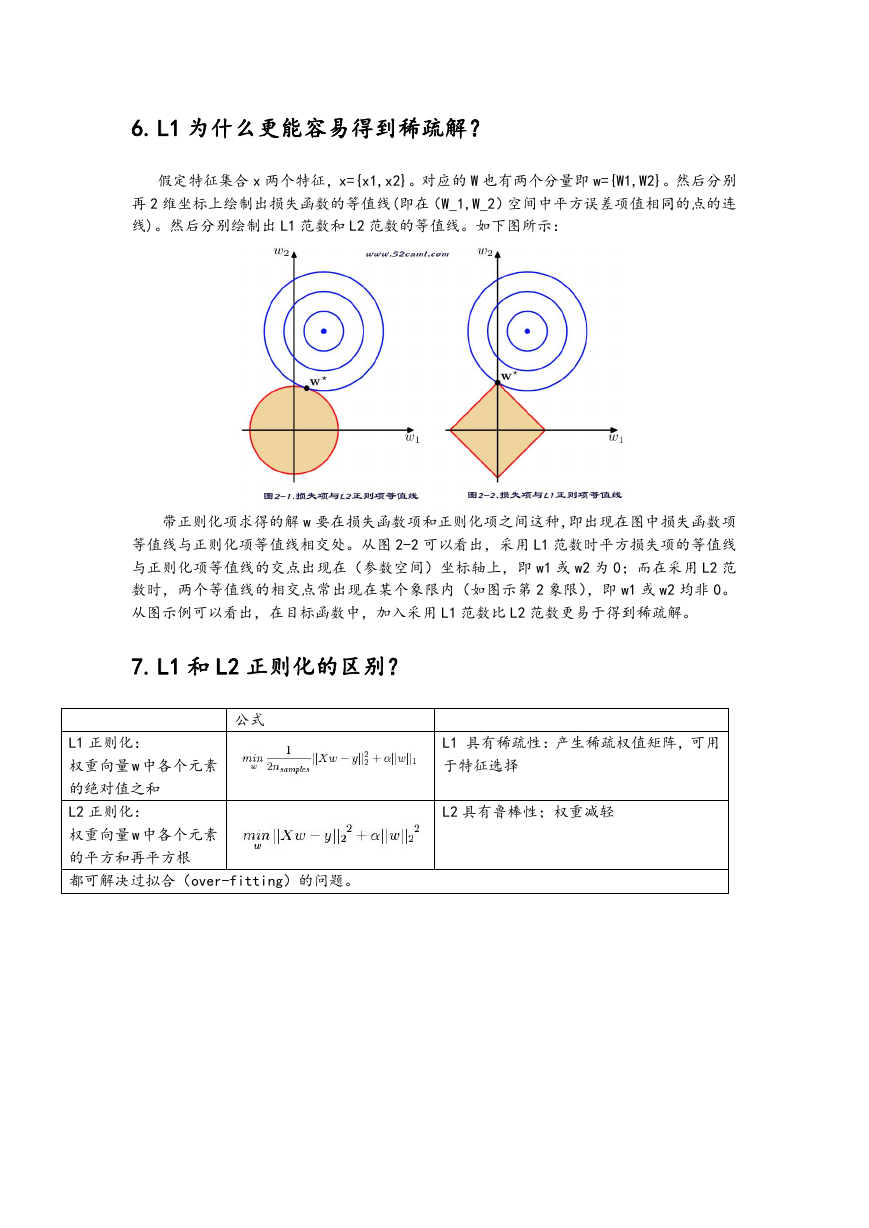

假定特征集合 x 两个特征,x={x1,x2}。对应的 W 也有两个分量即 w={W1,W2}。然后分别

再 2 维坐标上绘制出损失函数的等值线(即在(W_1,W_2)空间中平方误差项值相同的点的连

线)。然后分别绘制出 L1 范数和 L2 范数的等值线。如下图所示:

带正则化项求得的解 w 要在损失函数项和正则化项之间这种,即出现在图中损失函数项

等值线与正则化项等值线相交处。从图 2-2 可以看出,采用 L1 范数时平方损失项的等值线

与正则化项等值线的交点出现在(参数空间)坐标轴上,即 w1 或 w2 为 0;而在采用 L2 范

数时,两个等值线的相交点常出现在某个象限内(如图示第 2 象限),即 w1 或 w2 均非 0。

从图示例可以看出,在目标函数中,加入采用 L1 范数比 L2 范数更易于得到稀疏解。

7. L1 和 L2 正则化的区别?

公式

L1 正则化:

权重向量 w 中各个元素

的绝对值之和

L2 正则化:

权重向量 w 中各个元素

的平方和再平方根

都可解决过拟合(over-fitting)的问题。

L1 具有稀疏性:产生稀疏权值矩阵,可用

于特征选择

L2 具有鲁棒性;权重减轻

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc