Fast Visual Tracking via Dense

SpatioTemporal Context

Learning

Kaihua zhang * ECCV 2014*

* 香港理工大学*

Tracking相关论文:

Realtime Compressive Tracking

理论研究与实际工程应用差距巨大

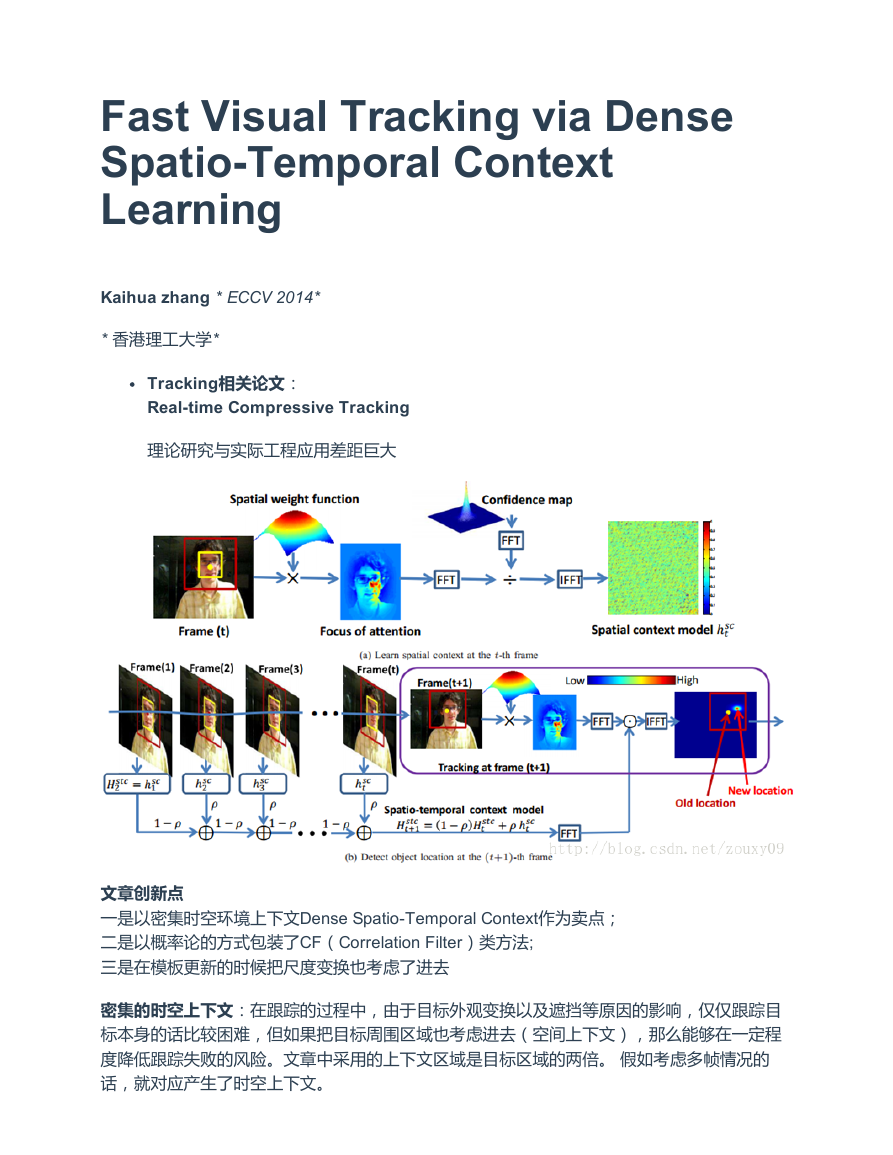

文章创新点

一是以密集时空环境上下文Dense SpatioTemporal Context作为卖点;

二是以概率论的方式包装了CF(Correlation Filter)类方法;

三是在模板更新的时候把尺度变换也考虑了进去

密集的时空上下文:在跟踪的过程中,由于目标外观变换以及遮挡等原因的影响,仅仅跟踪目

标本身的话比较困难,但如果把目标周围区域也考虑进去(空间上下文),那么能够在一定程

度降低跟踪失败的风险。文章中采用的上下文区域是目标区域的两倍。 假如考虑多帧情况的

话,就对应产生了时空上下文。

�

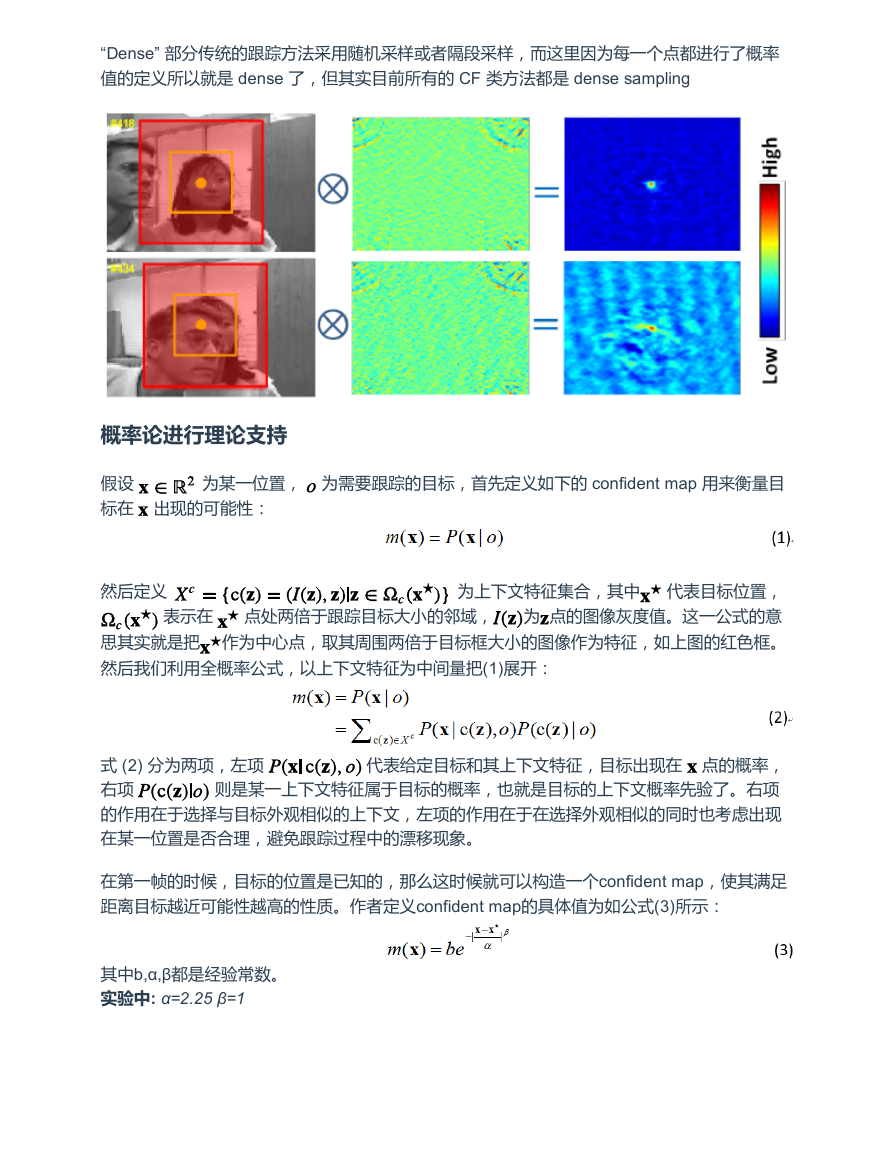

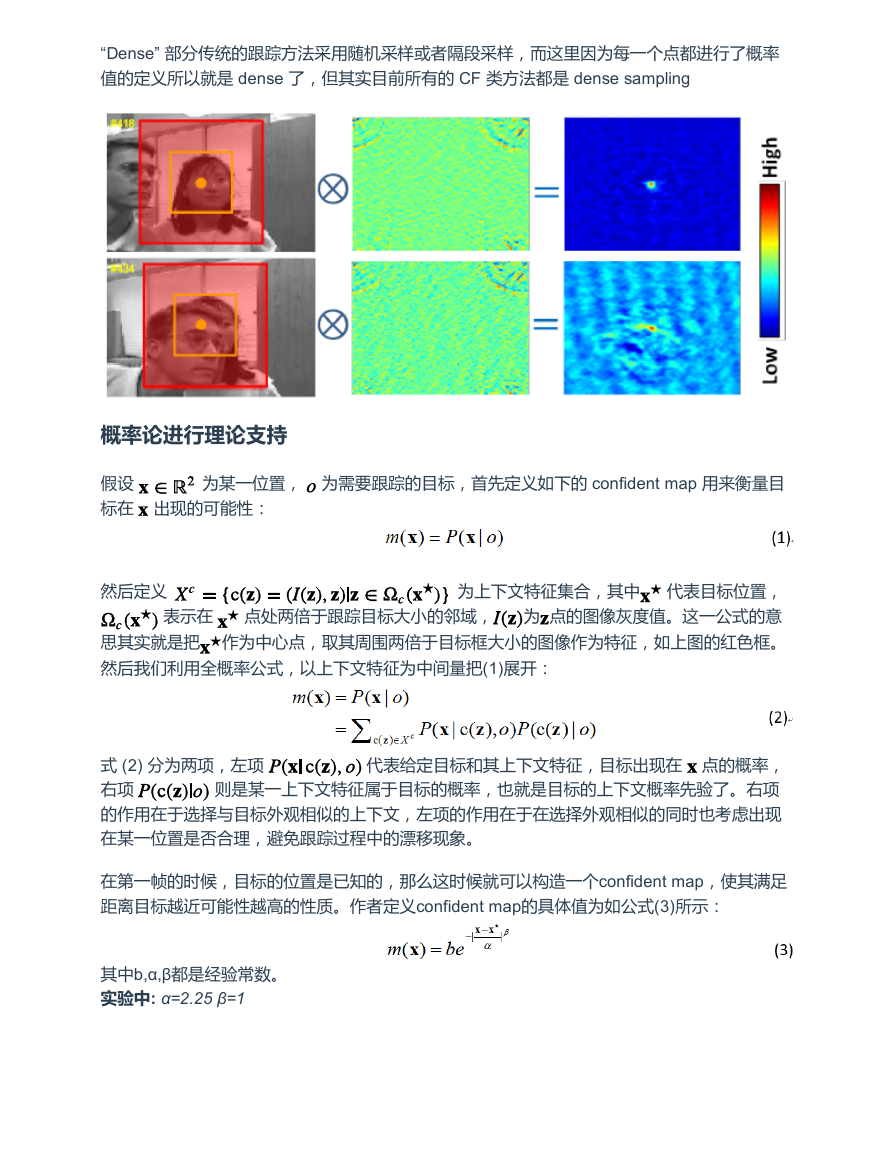

“Dense” 部分传统的跟踪方法采用随机采样或者隔段采样,而这里因为每一个点都进行了概率

值的定义所以就是 dense 了,但其实目前所有的 CF 类方法都是 dense sampling

概率论进行理论支持

假设

标在

为某一位置,

为需要跟踪的目标,首先定义如下的 confident map 用来衡量目

出现的可能性:

然后定义

★ 为上下文特征集合,其中 ★ 代表目标位置,

★ 表示在 ★ 点处两倍于跟踪目标大小的邻域, 为 点的图像灰度值。这一公式的意

思其实就是把 ★作为中心点,取其周围两倍于目标框大小的图像作为特征,如上图的红色框。

然后我们利用全概率公式,以上下文特征为中间量把(1)展开:

点的概率,

式 (2) 分为两项,左项

右项

则是某一上下文特征属于目标的概率,也就是目标的上下文概率先验了。右项

的作用在于选择与目标外观相似的上下文,左项的作用在于在选择外观相似的同时也考虑出现

在某一位置是否合理,避免跟踪过程中的漂移现象。

代表给定目标和其上下文特征,目标出现在

在第一帧的时候,目标的位置是已知的,那么这时候就可以构造一个confident map,使其满足

距离目标越近可能性越高的性质。作者定义confident map的具体值为如公式(3)所示:

其中b,α,β都是经验常数。

实验中: α=2.25 β=1

�

先看

,是目标的上下文先验,定义为如下所示:

有了,就可以带入

其就是目标框附近的图像灰度值的高斯加权和,然后

(2) 求解

的卷积 ( 互相关 ) ,通

过 FFT 转到频率域变为点乘运算,运算完后逆变换回空间域,找响应最大值的地方作为目标位

置。 具体就是,设

。首先将

表示为

有了,

和

,得

根据卷积

的定义:

所以 (5) 式其实就是一卷积(

就是 或

,

就是 或

),根据卷积定理:

更新跟踪下一帧目标需要的时空上下文模型:

实验中ρ=0.075

更新confident map

�

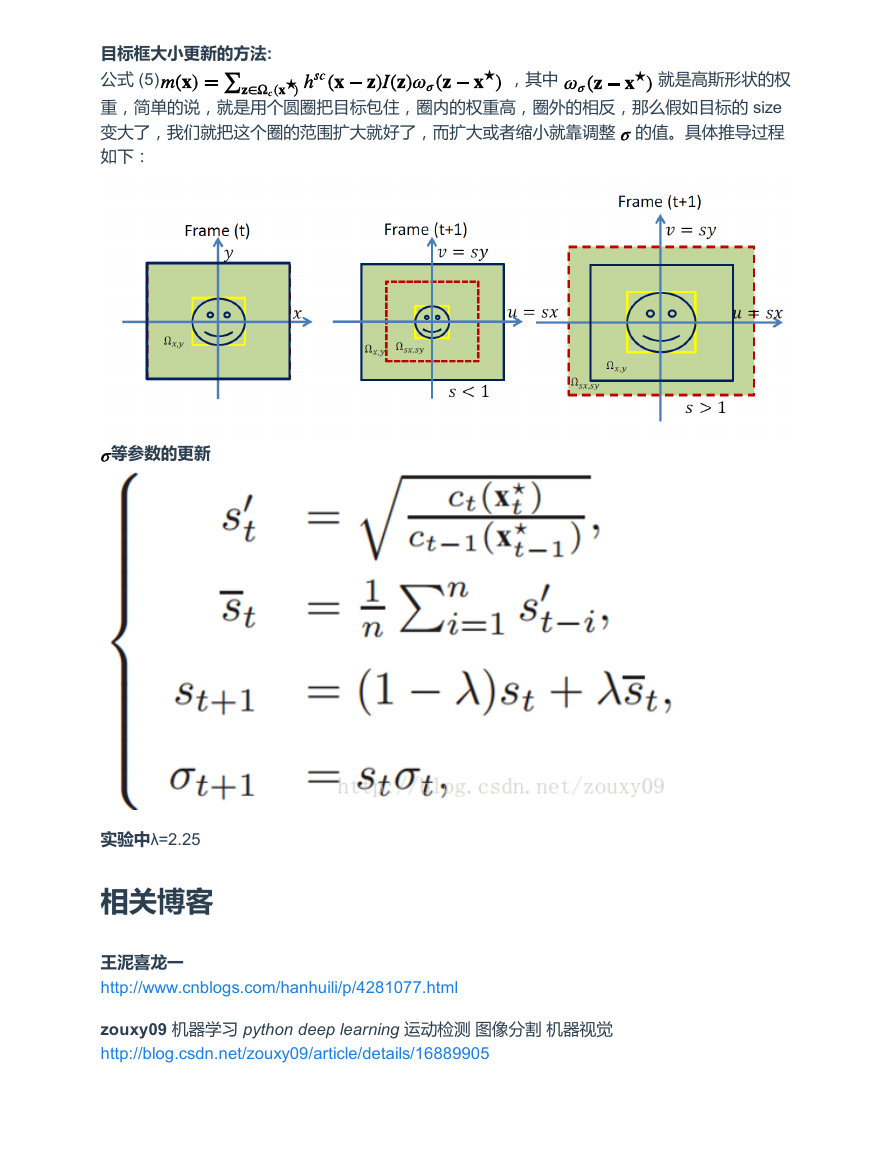

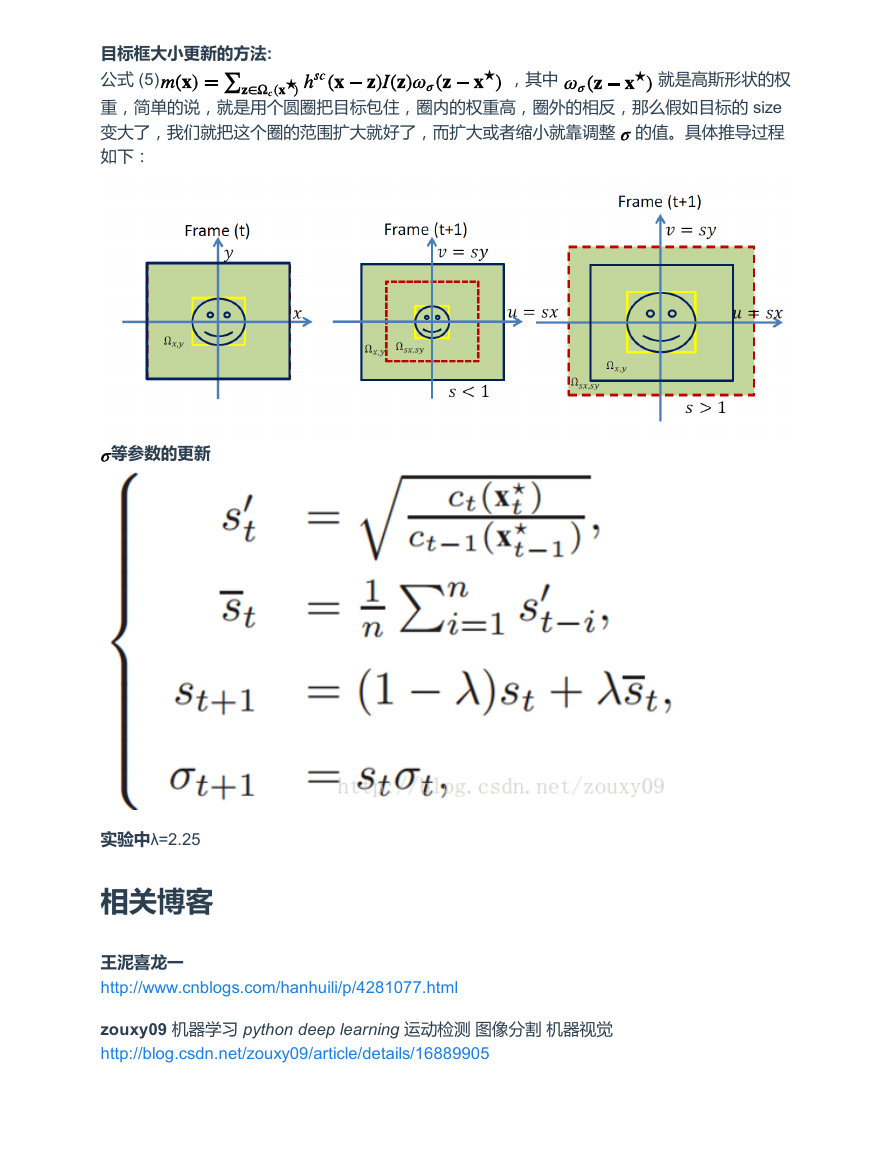

目标框大小更新的方法:

★ 就是高斯形状的权

公式 (5)

重,简单的说,就是用个圆圈把目标包住,圈内的权重高,圈外的相反,那么假如目标的 size

变大了,我们就把这个圈的范围扩大就好了,而扩大或者缩小就靠调整

的值。具体推导过程

如下:

★ ,其中

★

等参数的更新

实验中λ=2.25

相关博客

王泥喜龙一

http://www.cnblogs.com/hanhuili/p/4281077.html

zouxy09 机器学习 python deep learning 运动检测 图像分割 机器视觉

http://blog.csdn.net/zouxy09/article/details/16889905

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc