5

10

15

20

25

30

35

40

中国科技论文在线

基于 CNN 特征与 HMM 时序建模的人体行

http://www.paper.edu.cn

为识别研究

(哈尔滨工程大学信息与通信工程学院,哈尔滨 150001)

王冬雪,张磊**

摘要:随着视频的总量和类别数量迅速增长,智能化的视频分析方法已经成为许多实际应用

中的核心技术,例如异常监控、医疗诊断和视频检索等等。人是社会的主体,所以视频中的

大多数都是关于人体行为的内容,对人体行为的识别也就成为视频分析的核心技术。现阶段

对图像的识别技术已经成熟,而且视频可以看作是一个图像序列,所以对视频的分析可以转

换成图像的处理。深度学习是图像处理方面现阶段最为火热的方法,其中的 CNN 模型已经

取得了非常好的成果,相较于一些传统的人工特征提取方法有着很大的优势。视频是具有时

序信息的信号,所以在分类识别时更好的利用时序信息能够大大的提升识别准确率。本文提

出一种人体行为识别方法:利用 CNN 对视频进行图像特征提取,然后应用 HMM 对图像特

征序列进行时序建模,创新性的使用 HMM 的参数作为视频整体的特征表示。最后,本文的

方法在公共人体行为数据库上进行了验证,取得很高的识别准确率。

关键词:行为识别;CNN;特征提取;HMM;特征表示

中图分类号:TP391.4

Research on human behavior recognition based on CNN

features and HMM time series modeling

WANG Dongxue, ZHANG Lei

150001)

(Harbin Engineering University College of information and Communication Engineering, Harbin

Abstract: With the rapid growth of the total number and category of video, intelligent video analysis

has become the core technology in many practical applications, such as anomaly monitoring, medical

diagnosis and video retrieval. People are the main body of the society, so most of the videos are about

the contents of human behavior, and the recognition of human behavior has become the core

technology of video analysis. At present, the technology of image recognition is mature, and video can

be regarded as an image sequence, so the analysis of video can be converted into image processing.

Deep learning is the most popular method in the field of image processing. The CNN model has

achieved very good results, which has great advantages compared with some traditional manual feature

extraction methods. Video is a signal with time sequence information, so better use of time sequence

information in classification recognition can greatly improve the accuracy of recognition. In this paper,

a human behavior recognition method is proposed, which uses CNN to extract the image features, and

then applies HMM to sequence the image feature sequence, and innovatively uses the parameters of

HMM as the overall feature representation of the video. Finally, the method of this paper is verified on

the public human behavior database, and the accuracy of recognition is very high.

Keywords: action recognition; CNN; feature extraction; HMM; feature representation

0 引言

近几年影像设备和智能手机迅速普及,互联网技术也飞速进步,各种社交软件和视频处

理软件层出不穷,使得视频从录制到传播越来越快速和便捷,视频总量的增长速度也十分惊

人。很多实际应用中,人们对于视频的需求也不仅仅局限于听和看,更需要的是智能化地解

作者简介:王冬雪(1990-),男,硕士研究生,主要研究方向:计算机视觉

通信联系人:张磊(1973-),女,教授/博士生副导师、硕士导师,主要研究方向:数字图像处理、语音信号处

理、计算机视觉与模式识别等. E-mail: zlei@hrbeu.edu.cn

- 1 -

�

45

50

55

60

65

70

中国科技论文在线

http://www.paper.edu.cn

析视频中的内容人是社会的主体,所以大多数的视频内容都是以人为主要的目标,对于人体

行为的识别也理所当然的成为视频分析的重点技术。由于大量的视频是不同的场景使用不同

的设备拍摄的,存在着相机运动、背景变化、目标遮挡以及视角变化等诸多问题,这为人体

行为识别的研究带来了诸多挑战。

视频实质上是一个具有时序关系的图像序列,这就可以先把视频分析问题转化为图像分

析问题,也就是对视频先做图像特征提取。图像特征提取方法可以分为两种:一种是人工特

征提取,以 HOG 和 SIFT 最具有代表性;另一种则是近几年热门的深度学习方法,包括卷

积神经网络(CNN)、递归神经网络(RNN)以及深度置信网络(DBN)等多种网络模型,其中以

CNN 应用最为广泛。相较于人工特征提取方法,深度学习不仅能够自动提取特征,而且对

原始数据有着更强的特征表达能力。此外,由于每个视频的持续时间各不相同,分解得到的

图像序列长度也就不同,经过图像特征提取之后会得到尺寸不同的特征集合,这样就使得一

般的分类器无法进行分类。特征表示就是将尺寸不同的图像特征集合以相同的尺寸表示,得

到一个维度相同的视频特征向量。特征表示代表性的算法有词袋、VLAD 等,这些方法原理

相对简单计算速度快而且效果也很好,但是由于在算法中没有考虑时序信息,所以在识别结

果上仍有着较大的提升。

文献[1]中,M.S.Ryoo 等人提出了一种新的特征表达方法,该方法被称作合并时间序列,

能够捕获视频的全部动态信息和局部信息,通过高维特征描述符的长短时变化的表达,并且

结合了包括 CNN 特征在内的四种图像帧描述符;文献[2]中,提出了一种短中长三个层次的

动态建模方法:CNN 提取底层特征,LDS 建模中程的时序信息以及 VLAD 建模长期的时序

信息,这种方法能够对中短时间标度内均匀但是长时间标度不均匀的视频很好的时序建模。

文献[3]也是利用 CNN 的方法,不同的是该方法将视频合成一张既包括空间信息又包括时序

信息的动态图像,具体的做法是在 CNN 模型中加入 Rank Pooling 的功能,能够得到视频的

合成特征图,然后再进行特征提取和分类。在文献[4]中,Basura Fernando 等人提出了一种视

频的特征表示方法,用 RankSVM 来捕获视频图像特征数据间潜在的结构,从视频的图像序

列之间的关系获得整个视频的特征表示。HMM 是经典的时序模型,已经在语音识别领域证

明了对于时序信号的建模能力,理论上在视频分析上也会有着很好的效果。本文提出一种基

于 CNN 特征和 HMM 时序特征表示的人体行为识别方法,并且创新性的应用 HMM 的参数

作为视频的特征表示,最后在 Youtube 人体行为数据库上进行验证。

1 图像特征提取

1.1 HOG 特征与 CNN 特征

75

HOG(Histograms of Oriented Gradients)特征[5],是由 Dalal 于 2005 年针对行人检测问题

80

提出的,具有较强的图像内容表达能力,从而被广泛的熟知并应用。除了应用于行人检测外,

HOG 特征在非行人目标检测方面表现也很突出。因此,在图像特征提取上,HOG 特征是单

一特征表现效果相对较好的人工特征方法,除了行人检测以外,还被应用到行为识别、场景

分类和人脸识别等方面。

CNN(Convolutional Neural Network)特征[6],是现阶段最为火热的特征提取方法,通过将

原始数据进行卷积操作以使原图像特征增强,并且降低噪声,然后进行 pooling 操作,即对

不同位置的特征进行聚合统计以降低过拟合现象。最后通过反向传播的方式训练网络各个节

点的权值,使得 CNN 模型有着很强的特征表达能力。CNN 在图像识别、目标检测和人体行

- 2 -

�

中国科技论文在线

http://www.paper.edu.cn

为识别等应用中取得极好的成果。VGG 模型是 CNN 最具代表性的模型,本文将选择 VGG16

模型的 fc6 层输出作为视频的图像特征。

1.2 实验对比

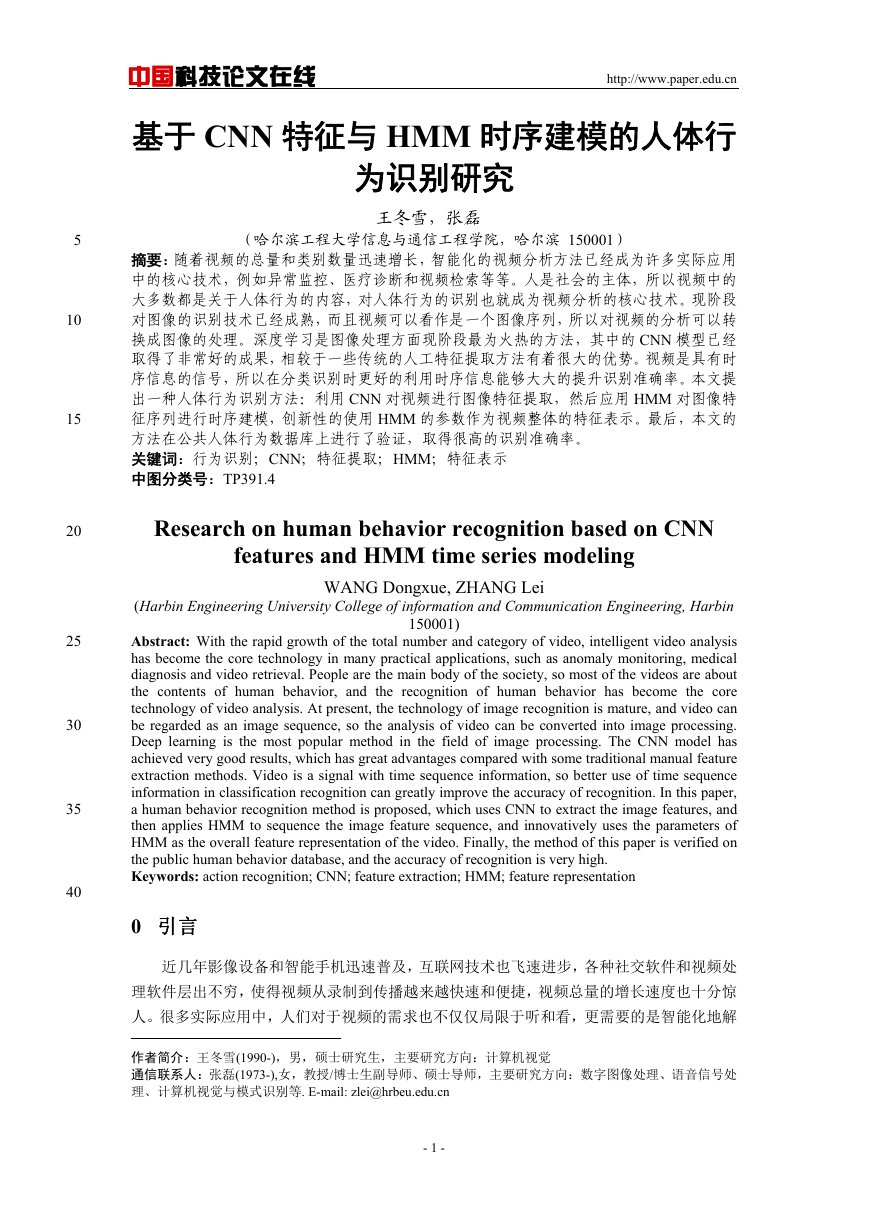

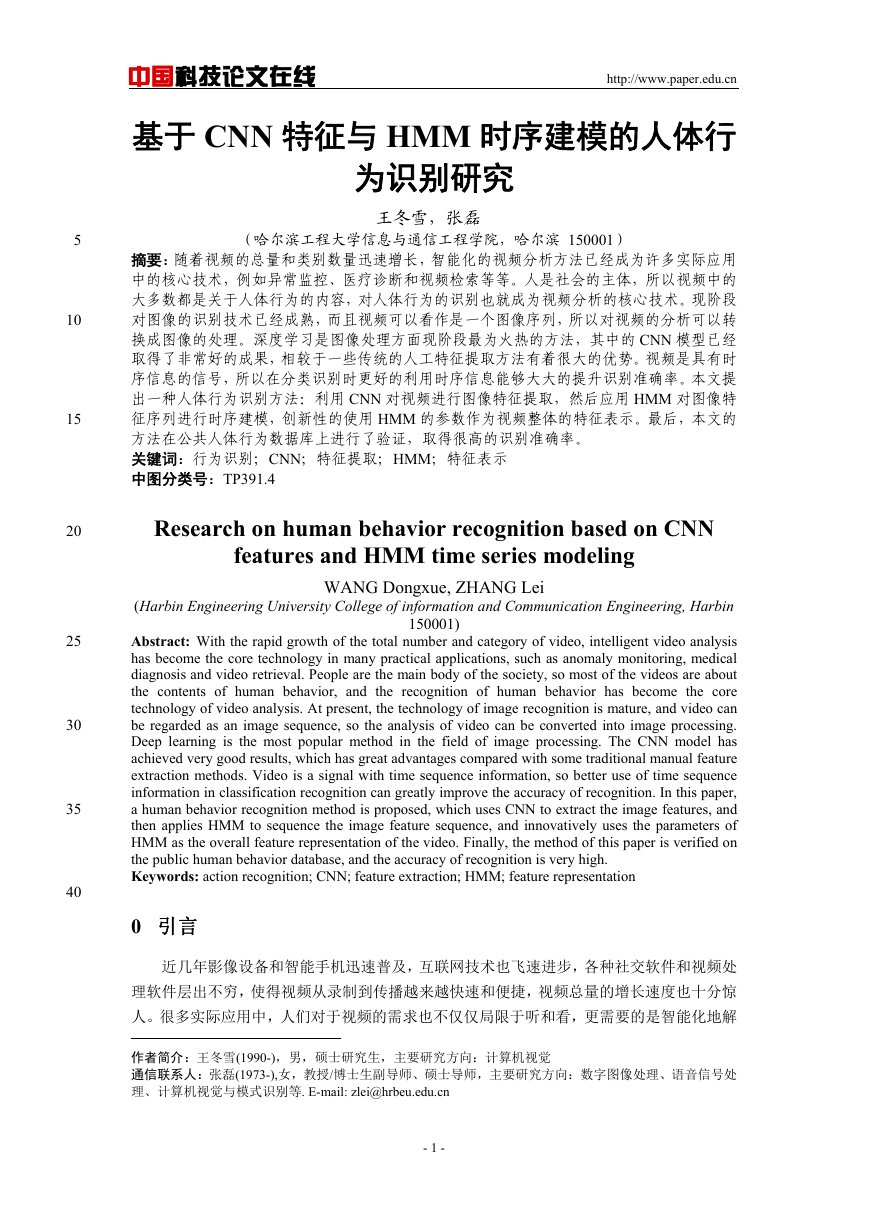

Youtube 数据库[7]一共有 11 个人体的行为类别:包括投篮、骑自行车、跳水、打高尔夫、

荡秋千、走路、骑马、跳跃、打网球、打排球等。这个数据库由于大量变化的运动摄像、目

标的外观和姿势、目标的规模和视角、杂乱的背景、光线条件,所以处理这样的视频数据库

非常具有一定的挑战性。每一类视频都被分成二十五组,每组至少有四个动作片段。每一组

里的动作片段具有相同的特征,比如一样的人、相似的背景和视角等等。

85

90

图 1 Youtube 数据库类别图像

为了实现 HOG 特征和 CNN 特征的对比,以 VLAD 算法[8][9]作为特征表示方法,并在

95

Youtube 数据库上进行实验,表 1 为两种特征得到的识别结果。

表 1 两种特征识别准确率

实验方法

HOG+VLAD

CNN+VLAD

分类结果

70.48%

86.00%

从表 1 中可以看出,CNN 特征的识别效果要大大好于 HOG 特征,这也证明了 CNN 方

法更加先进,相较于人工特征提取方法有着很大的优势,本文也将会选用 CNN 特征作为视

频的图像特征表达方法。

2 HMM 特征表示

2.1 时序建模

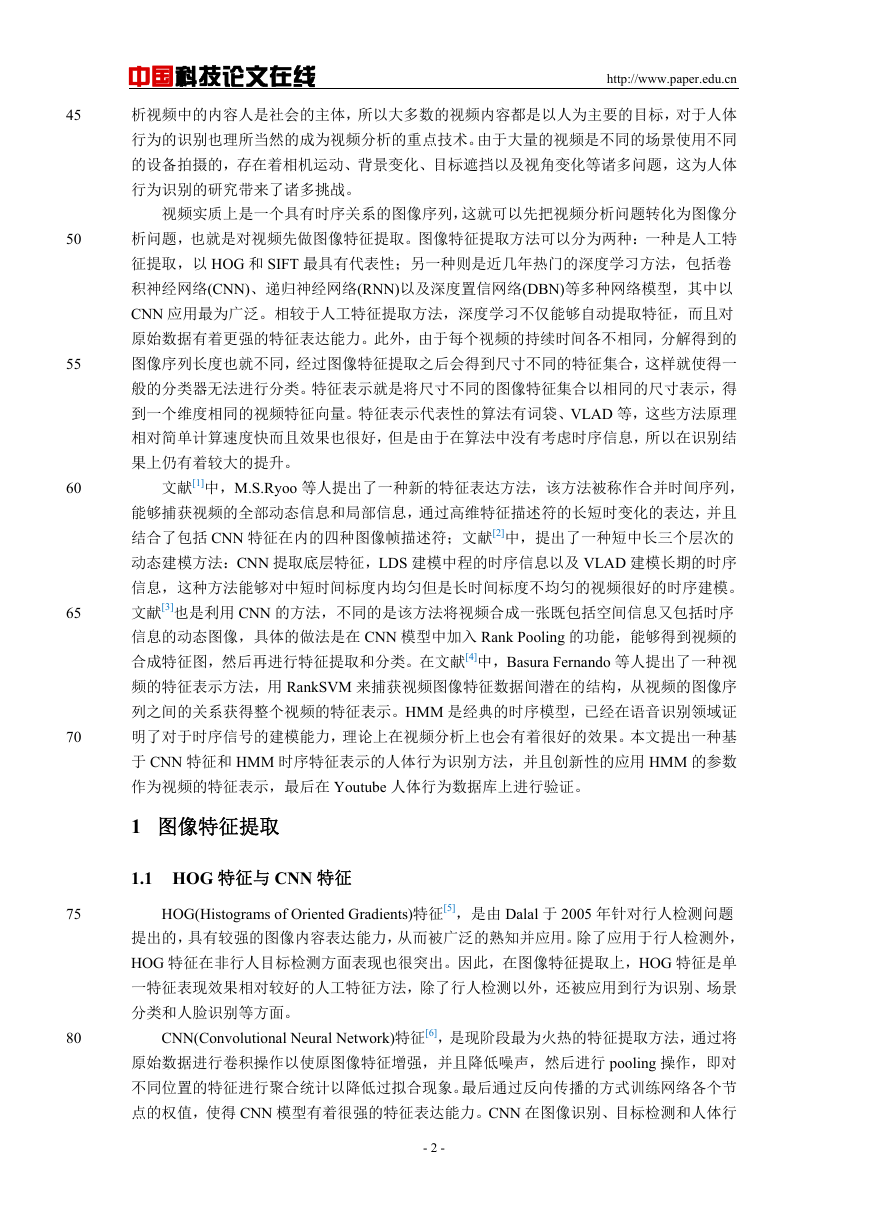

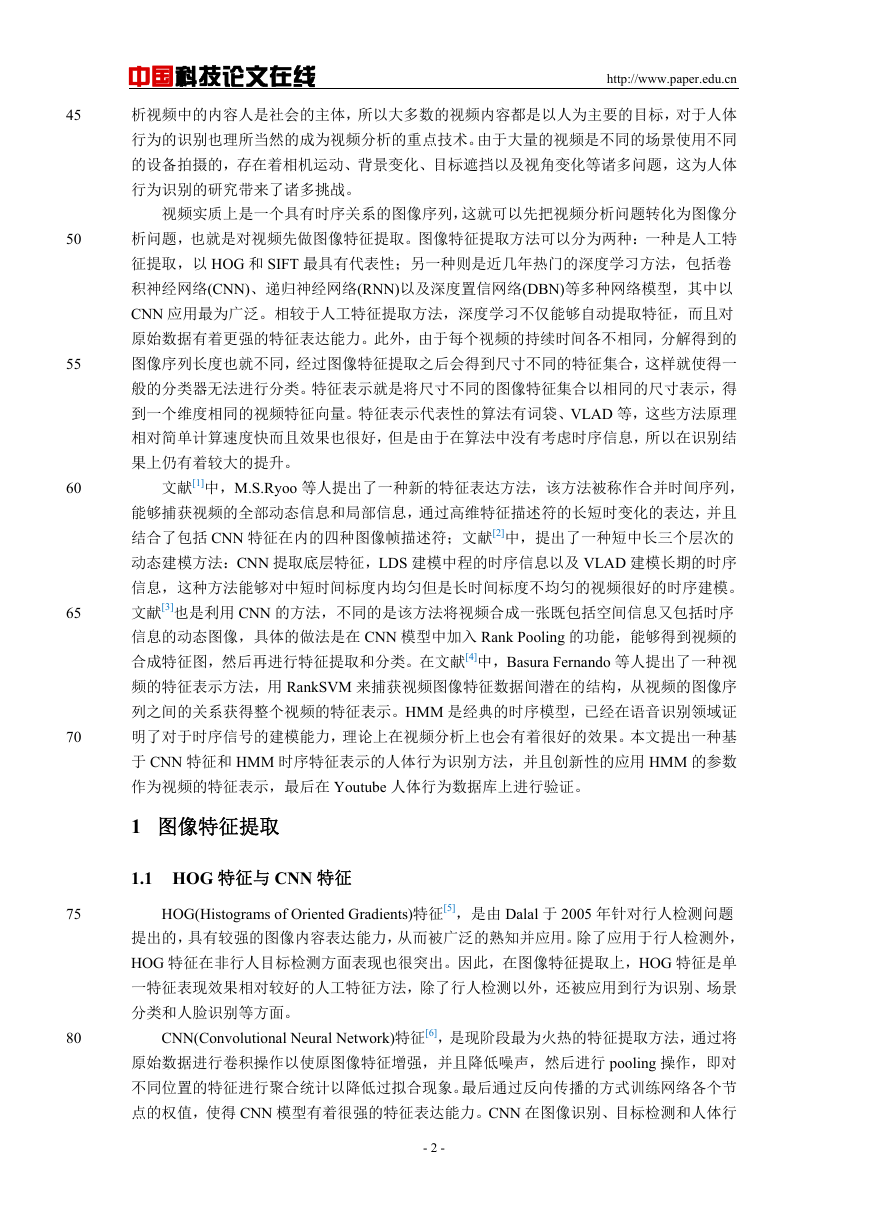

通过对大量的视频进行观察可以得出,人体的行为是周期性的过程,如图 2 所示。对于

任意一种行为,都可以从每个行为周期中提取若干个动作作为该行为的关键状态。通过对大

量的视频行为观察发现,大多数的行为都可以通过五个关键动作进行表达。例如图 2 中的第

一行,将一个投篮的行为分解为五个关键动作:接到球、将球举过头顶准备起跳、到达最高

- 3 -

100

105

�

中国科技论文在线

http://www.paper.edu.cn

点准备投篮、将球投出,最后落地回到最初的状态。其它的视频行为都可以做这样的动作分

解。

图 2 人体行为的分解

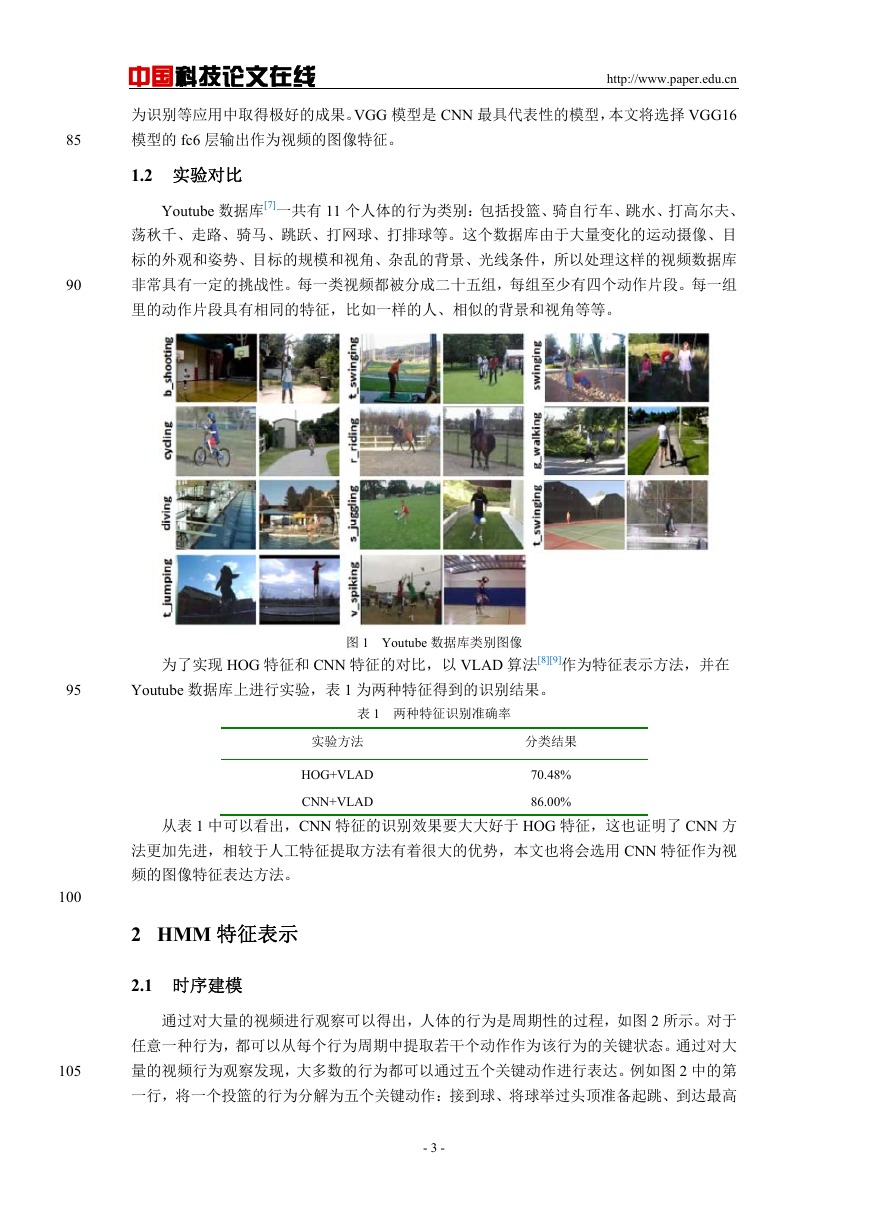

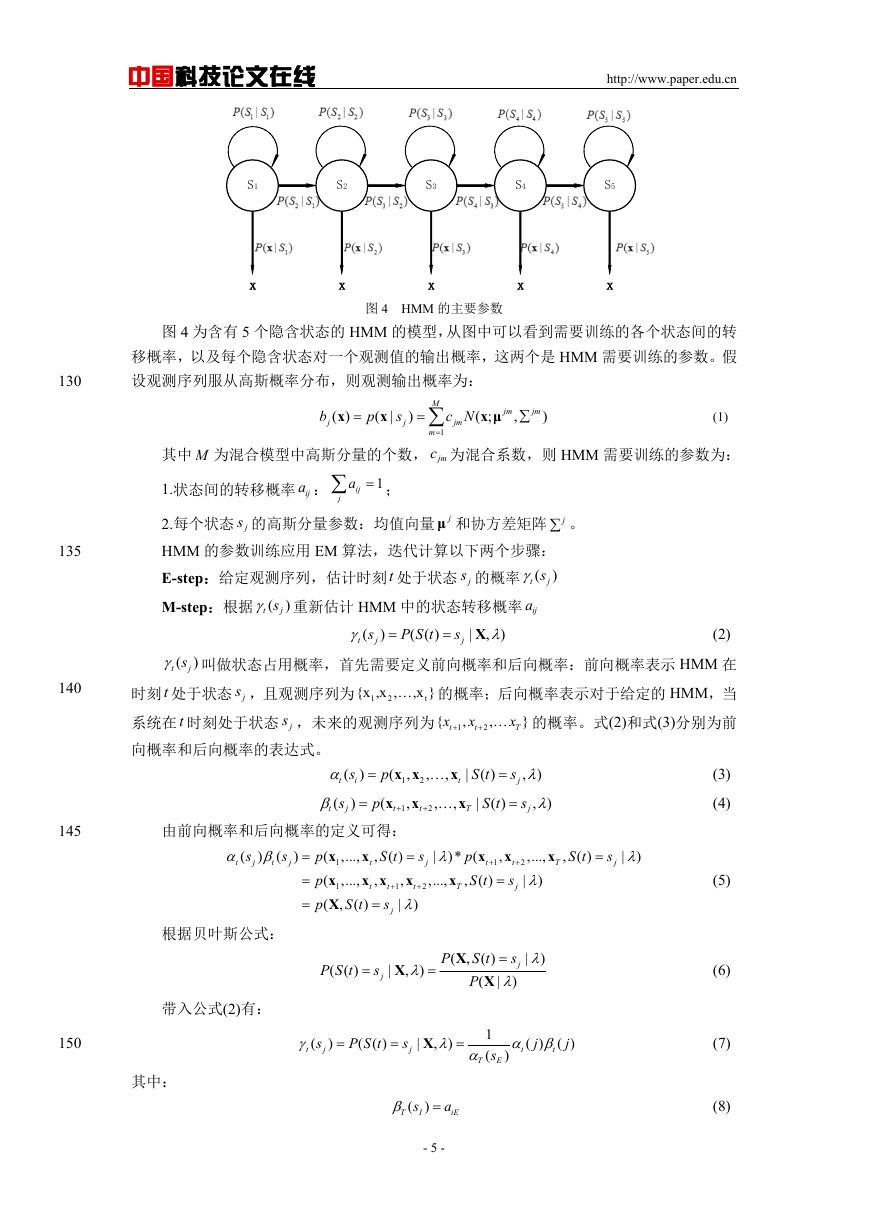

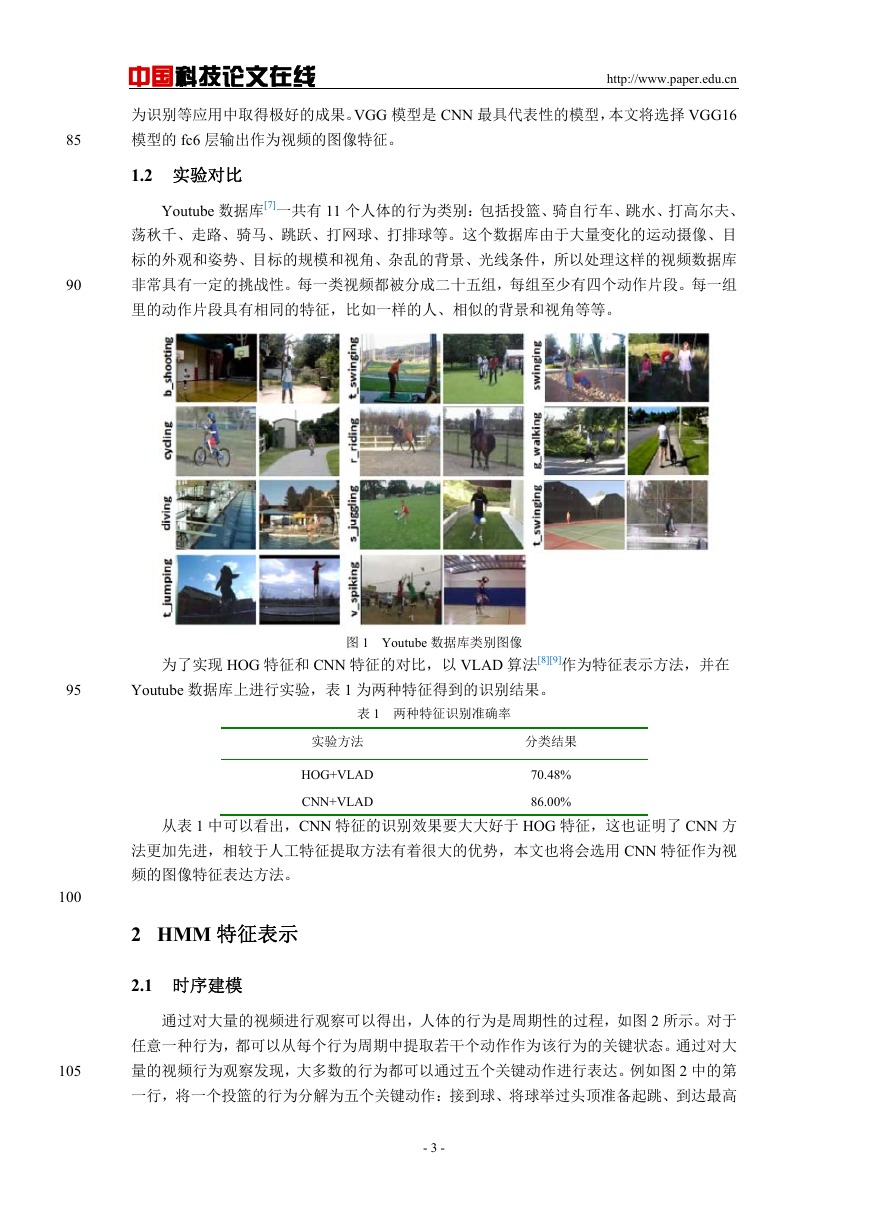

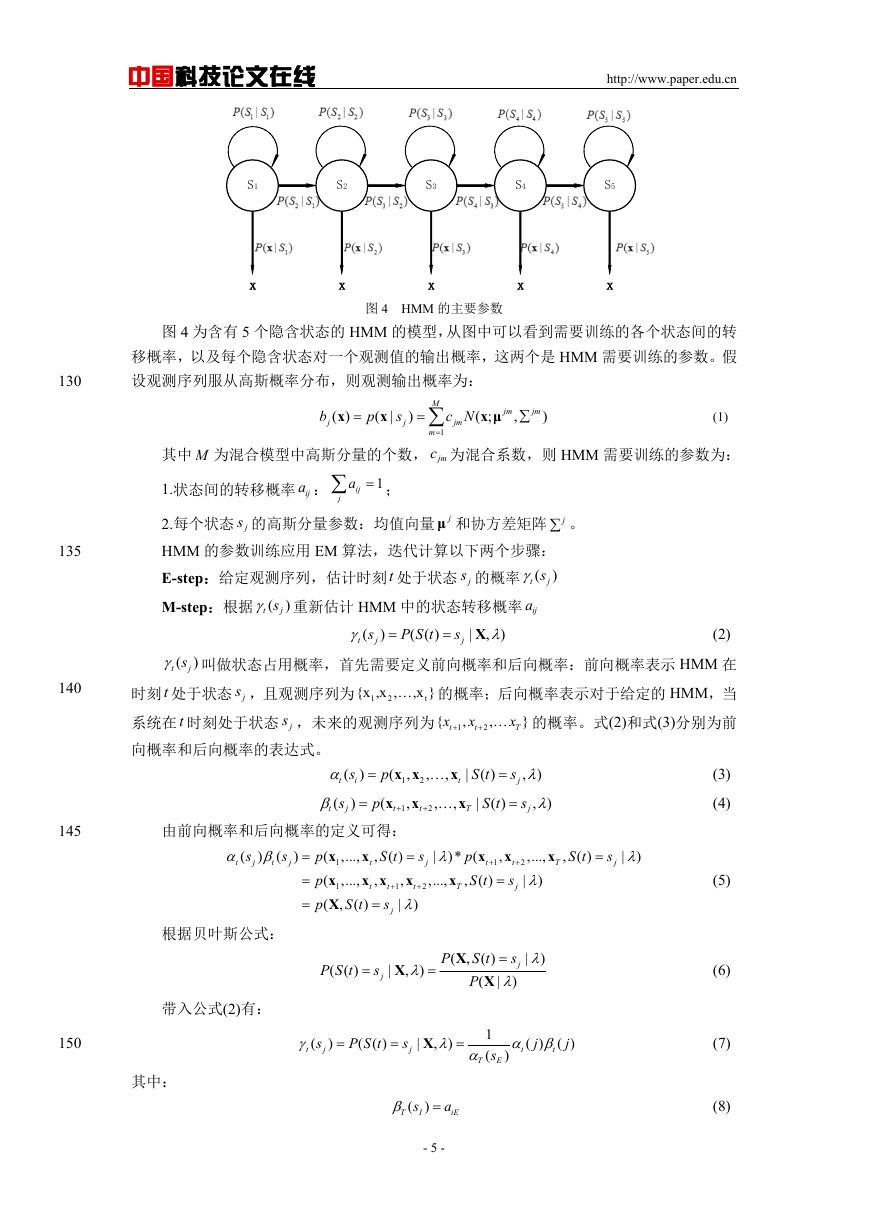

图 3 所示的为 HMM 模型[10]对人体行为建模的过程:第一行的是人体行为的关键动作

分解,对应于 HMM 模型的五个状态;第二行是一个包含五个隐含状态的 HMM 模型;第三

行是人体行为的观测动作序列,HMM 模型的每个隐含状态分别对应于连续的一段观测序

列。

110

115

S1

S2

S3

S4

S5

2.2 GMM-HMM 参数训练

图 3 HMM 时序建模

120

GMM-HMM 模型的训练,就是通过对输入数据进行学习,得到模型的参数。由于视频

行为识别选用的 HMM 为特殊的左右结构,并且是连续型的,所以其参数有如下特点:

1.HMM 的初始状态一定处于第一个隐含状态,所以初始概率矩阵为首个元素 1 其它位

置为 0 的向量;

2.由于采用的是连续型 HMM 结构,也就是用 GMM 作为隐含状态的输出概率,所以输

125

出概率参数的训练实质上就是训练每个隐含状态的 GMM 的参数。

- 4 -

�

中国科技论文在线

http://www.paper.edu.cn

S1

x

S2

x

S3

x

S4

x

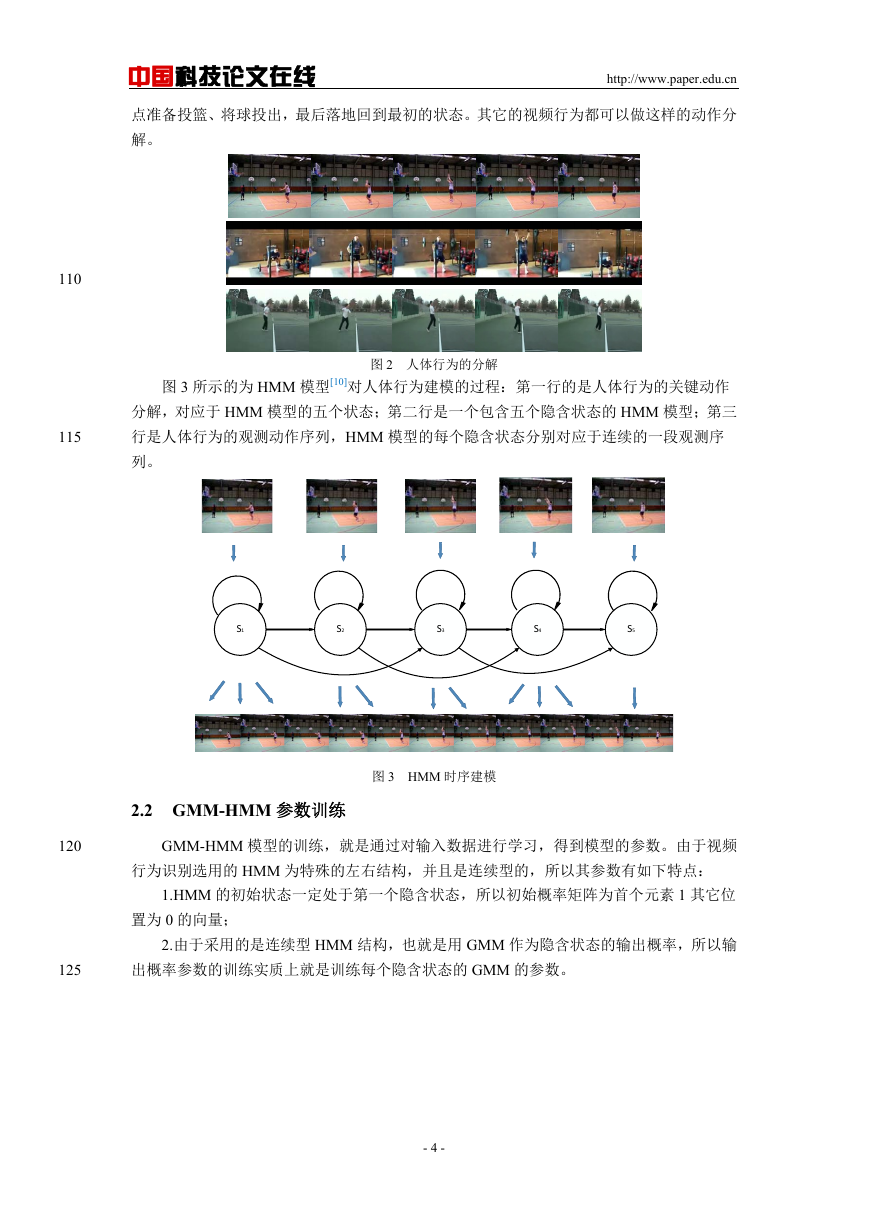

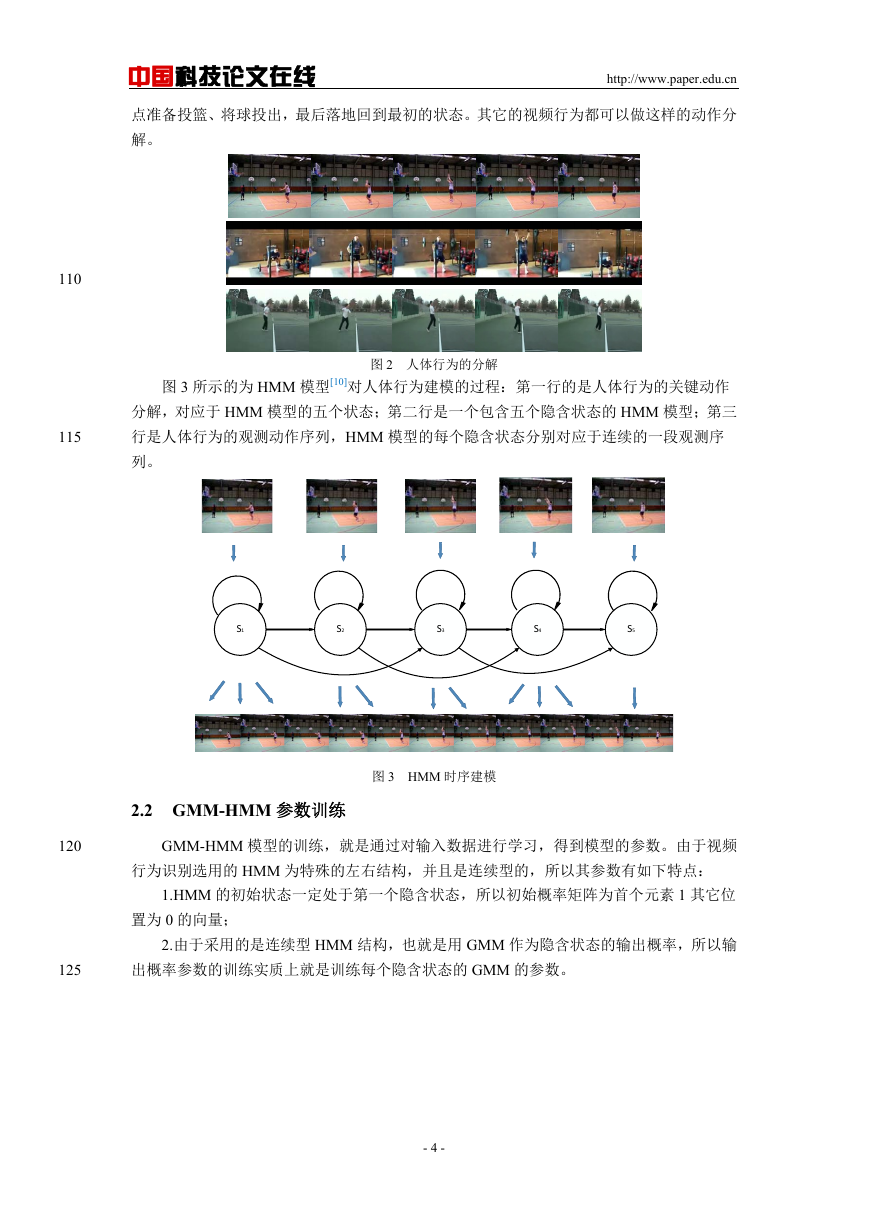

图 4 HMM 的主要参数

S5

x

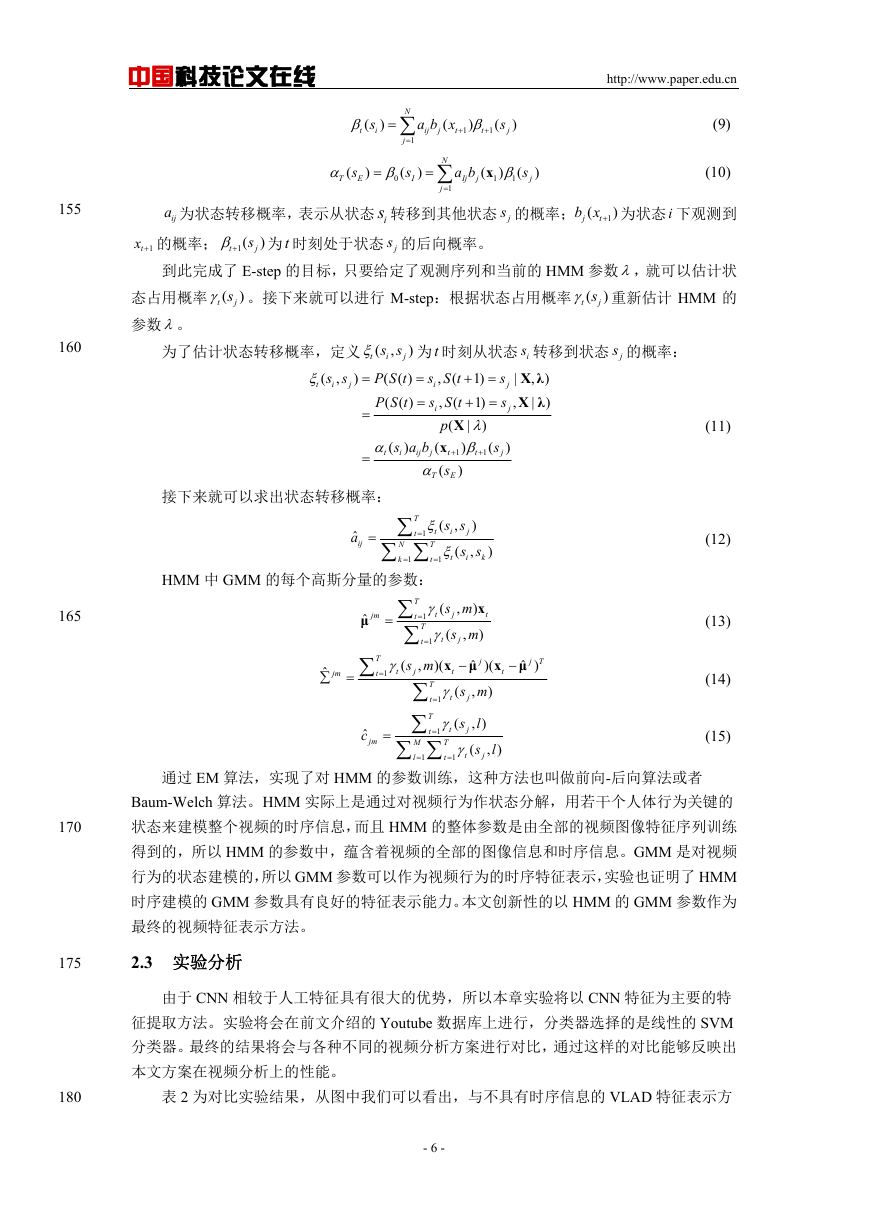

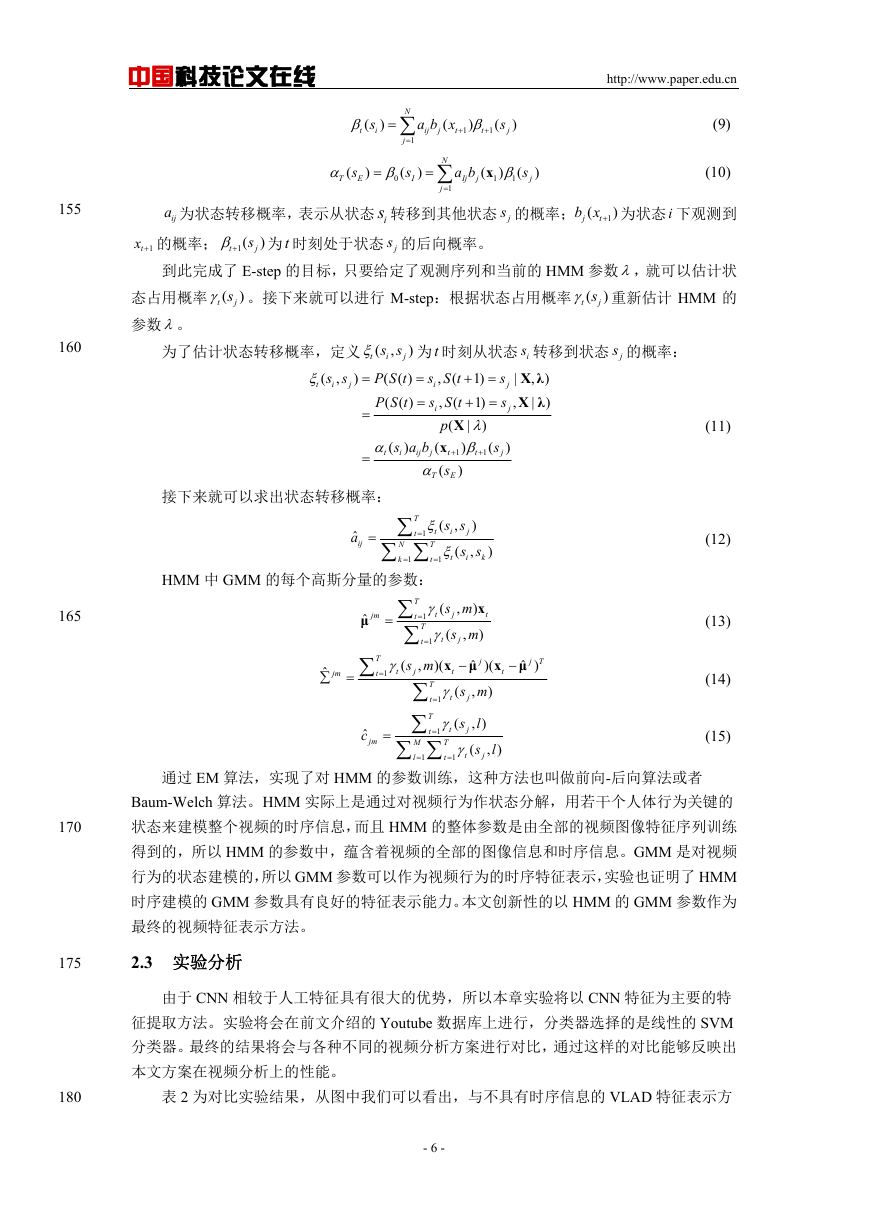

图 4 为含有 5 个隐含状态的 HMM 的模型,从图中可以看到需要训练的各个状态间的转

移概率,以及每个隐含状态对一个观测值的输出概率,这两个是 HMM 需要训练的参数。假

设观测序列服从高斯概率分布,则观测输出概率为:

b

j

x

( )

p

(

x

|

s

)

j

M

m

1

c N

jm

x μ

( ;

jm

,

jm

)

(1)

其中 M 为混合模型中高斯分量的个数, jmc 为混合系数,则 HMM 需要训练的参数为:

1.状态间的转移概率 ija :

a

ij

j

1

;

2.每个状态 js 的高斯分量参数:均值向量 jμ 和协方差矩阵 j 。

HMM 的参数训练应用 EM 算法,迭代计算以下两个步骤:

E-step:给定观测序列,估计时刻 t 处于状态 js 的概率 (

js

)

t

js 重新估计 HMM 中的状态转移概率 ija

M-step:根据 (

t

)

j

)

(

)

(

s

t

P S t

( ( )

(2)

js 叫做状态占用概率,首先需要定义前向概率和后向概率:前向概率表示 HMM 在

t

,x } 的概率;后向概率表示对于给定的 HMM,当

,

的概率。式(2)和式(3)分别为前

{x ,x ,

2

X

)

x

T

x

t

x

t

}

s

,

,

|

2

j

t

{

时刻 t 处于状态 js ,且观测序列为 1

系统在 t 时刻处于状态 js ,未来的观测序列为 1

向概率和后向概率的表达式。

(

t

s

(

t

x x

,

1

x

,

1

由前向概率和后向概率的定义可得:

S t

( )

x

,

t

1

)

|

x

x

,...,

,

t

1

x

x x

,

,...,

t

t

1

X

s

S t

( )

,

t

p

(

x

(

p

p

p

p

x

,

|

x

,

,

s

i

)

(

(

(

s

s

s

)

(

)

(

)

,

2

2

2

j

t

t

t

j

t

j

j

j

S t

( )

S t

( )

|

s

j

,

)

s

,

)

j

T

x

x

p

)* (

|

,

t

t

1

x

s

S t

( )

,...,

,

T

2

|

j

,...,

)

x

T

,

S t

( )

s

j

|

)

根据贝叶斯公式:

带入公式(2)有:

P S t

( ( )

s

j

|

X

,

)

P

(

X

S t

( )

,

X

P

(

s

|

)

j

|

)

t

(

s

j

)

P S t

( ( )

s

j

|

X

,

)

1

s

(

)

E

T

t

j

( )

t

j

( )

其中:

s

(

)

T

I

a

iE

- 5 -

130

135

140

145

150

(3)

(4)

(5)

(6)

(7)

(8)

�

中国科技论文在线

http://www.paper.edu.cn

t

(

s

i

)

N

j

1

a b x

(

ij

t

j

)

t

1

1

(

s

j

)

T

(

s

E

)

0

(

s

I

)

N

j

1

a b

Ij

j

(

x

1

)

1

(

s

j

)

(9)

(10)

ija 为状态转移概率,表示从状态 is 转移到其他状态 js 的概率;

b x 为状态 i 下观测到

j

(

)

1

t

1tx 的概率; 1(

js 为 t 时刻处于状态 js 的后向概率。

t

)

到此完成了 E-step 的目标,只要给定了观测序列和当前的 HMM 参数,就可以估计状

js 。接下来就可以进行 M-step:根据状态占用概率 (

js 重新估计 HMM 的

态占用概率 (

t

t

参数。

)

)

s s

,

)

为了估计状态转移概率,定义 (

j

t

i

P S t

( ( )

P S t

( ( )

s s

,

i

t

(

)

j

j

|

,

s

s

为 t 时刻从状态 is 转移到状态 js 的概率:

s S t

1)

(

,

i

s S t

1)

(

,

i

X

p

|

)

(

x

s a b

)

(

t

i

ij

t

j

1

1

s

(

)

T

X λ

)

,

X λ

|

)

s

)

(

)

E

j

j

t

(

接下来就可以求出状态转移概率:

T

s s

(

,

t

i

t

1

T

(

t

t

1

HMM 中 GMM 的每个高斯分量的参数:

N

k

1

ˆ

a

ij

)

j

s s

,

i

)

k

ˆ

jm

T

t

t

1

x

t

ˆ

μ

)

j T

j

ˆ

μ

)(

s m

(

)

,

j

jm

ˆ

μ

ˆ

c

jm

x

s m

,

)

j

s m

)

(

,

j

t

T

(

t

t

1

T

t

t

1

x

s m

,

(

)(

j

t

T

t

t

1

T

s

(

t

j

t

1

T

t

t

1

M

l

1

l

, )

s

(

j

l

, )

155

160

165

170

175

(11)

(12)

(13)

(14)

(15)

通过 EM 算法,实现了对 HMM 的参数训练,这种方法也叫做前向-后向算法或者

Baum-Welch 算法。HMM 实际上是通过对视频行为作状态分解,用若干个人体行为关键的

状态来建模整个视频的时序信息,而且 HMM 的整体参数是由全部的视频图像特征序列训练

得到的,所以 HMM 的参数中,蕴含着视频的全部的图像信息和时序信息。GMM 是对视频

行为的状态建模的,所以 GMM 参数可以作为视频行为的时序特征表示,实验也证明了 HMM

时序建模的 GMM 参数具有良好的特征表示能力。本文创新性的以 HMM 的 GMM 参数作为

最终的视频特征表示方法。

2.3 实验分析

由于 CNN 相较于人工特征具有很大的优势,所以本章实验将以 CNN 特征为主要的特

征提取方法。实验将会在前文介绍的 Youtube 数据库上进行,分类器选择的是线性的 SVM

分类器。最终的结果将会与各种不同的视频分析方案进行对比,通过这样的对比能够反映出

本文方案在视频分析上的性能。

180

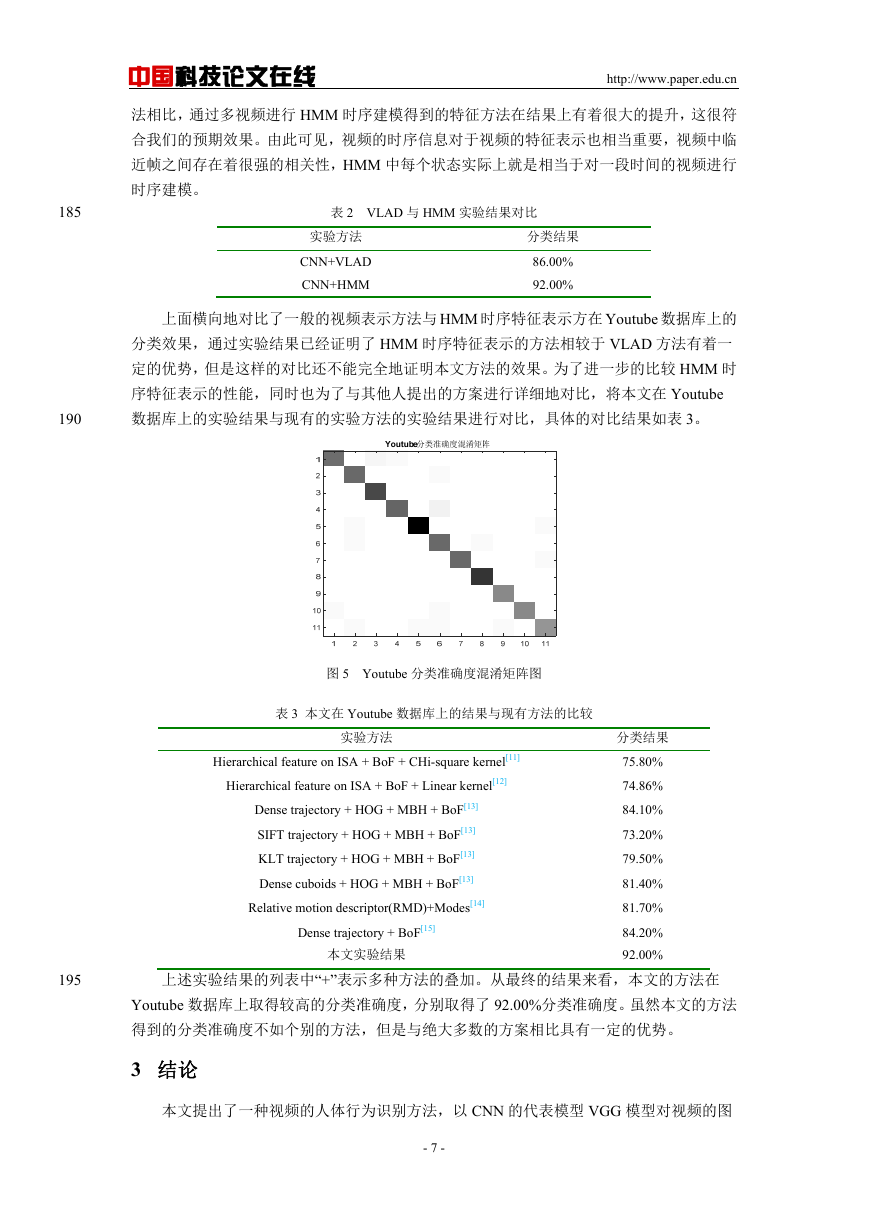

表 2 为对比实验结果,从图中我们可以看出,与不具有时序信息的 VLAD 特征表示方

- 6 -

�

中国科技论文在线

http://www.paper.edu.cn

法相比,通过多视频进行 HMM 时序建模得到的特征方法在结果上有着很大的提升,这很符

合我们的预期效果。由此可见,视频的时序信息对于视频的特征表示也相当重要,视频中临

近帧之间存在着很强的相关性,HMM 中每个状态实际上就是相当于对一段时间的视频进行

时序建模。

表 2 VLAD 与 HMM 实验结果对比

实验方法

CNN+VLAD

CNN+HMM

分类结果

86.00%

92.00%

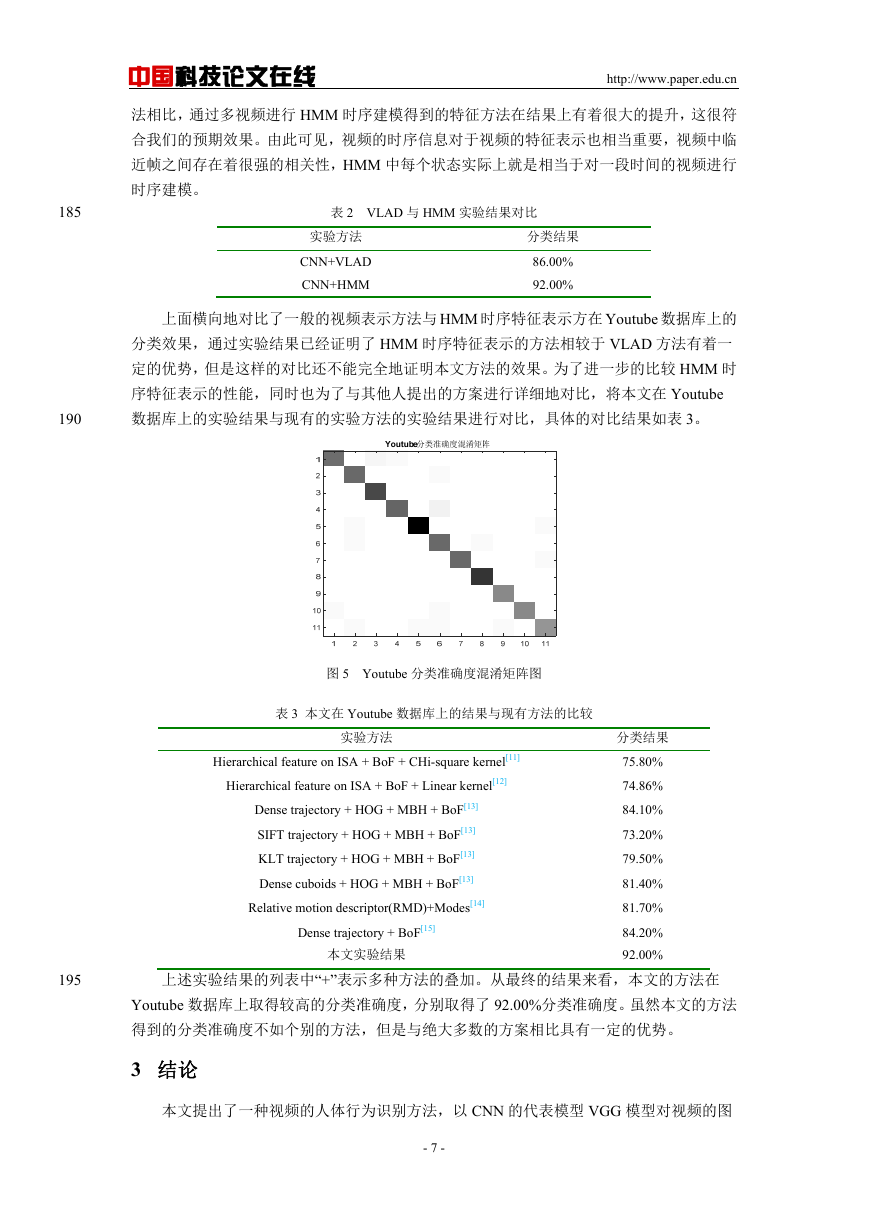

上面横向地对比了一般的视频表示方法与 HMM 时序特征表示方在 Youtube 数据库上的

分类效果,通过实验结果已经证明了 HMM 时序特征表示的方法相较于 VLAD 方法有着一

定的优势,但是这样的对比还不能完全地证明本文方法的效果。为了进一步的比较 HMM 时

序特征表示的性能,同时也为了与其他人提出的方案进行详细地对比,将本文在 Youtube

数据库上的实验结果与现有的实验方法的实验结果进行对比,具体的对比结果如表 3。

185

190

图 5 Youtube 分类准确度混淆矩阵图

表 3 本文在 Youtube 数据库上的结果与现有方法的比较

实验方法

Hierarchical feature on ISA + BoF + CHi-square kernel[11]

Hierarchical feature on ISA + BoF + Linear kernel[12]

Dense trajectory + HOG + MBH + BoF[13]

SIFT trajectory + HOG + MBH + BoF[13]

KLT trajectory + HOG + MBH + BoF[13]

Dense cuboids + HOG + MBH + BoF[13]

Relative motion descriptor(RMD)+Modes[14]

Dense trajectory + BoF[15]

本文实验结果

分类结果

75.80%

74.86%

84.10%

73.20%

79.50%

81.40%

81.70%

84.20%

92.00%

195

上述实验结果的列表中“+”表示多种方法的叠加。从最终的结果来看,本文的方法在

Youtube 数据库上取得较高的分类准确度,分别取得了 92.00%分类准确度。虽然本文的方法

得到的分类准确度不如个别的方法,但是与绝大多数的方案相比具有一定的优势。

3 结论

本文提出了一种视频的人体行为识别方法,以 CNN 的代表模型 VGG 模型对视频的图

- 7 -

�

中国科技论文在线

http://www.paper.edu.cn

200

像信息进行提取,接着应用 HMM 对视频的图像特征序列进行时序建模得到 HMM 特征表示,

最后使用线性分类器对整体特征进行分类识别。本文方案在视频行为数据库 Youtube 上进行

了实验验证,取得了较高的识别精确度,并且好于许多经典的人体行为识别方法,证明了在

特征表示中加入视频的时序信息有助于提升识别准确率,HMM 模型是适用于人体行为识别

的时序模型。

205

[参考文献] (References)

210

215

220

225

230

[1] M.S.Ryoo, Brandon Rothrock, and Larry Matthies. Pooled Motion Features for First-Person Videos[C].In

CVPR,2015:896-904.

[2] Yingwei Liy, Weixin Li, Vijay Mahadevan, Nuno Vasconcelos. Encoding Dynamics of Deep Features for

Action Recognition[C].In ICCV,2013:1951-1960.

[3] Hakan Bileny, Basura Fernandoz, Efstratios Gavvesx, Andrea Vedaldiy, Stephen Gould. Dynamic Image

Networks for Action Recognition[C].In CVPR,2016:3034-3042.

[4] Basura Fernando, Efstratios Gavves, Jose Oramas M, Amir Ghodrati, and Tinne Tuytelaars. Rank Pooling for

Action Recognition[C].In CVPR,2017,39(4):773-779.

[5] N Dalal, B Triggs. Histograms of Oriented Gradients for Human Detection[C].IEEE Computer Society

Conference on Computer Vision & Pattern Recognition,2005,1(12):886-893.

[6] Yoshua Bengio, Ian Goodfellow, Aaron Courville. Deep Learning [M]. 《Nature》,2015,521(7553):436.

[7] H.Jegou, M.Douze, C.Schmid, and P.Perez. Aggregating local descriptors into a compact image

representation[C].In CVPR,2010 ,238(6):3304-3311.

[8] J.Liu, J.Luo and M.Shah. Recognizing realistic actions from videos"in the wild"[C].In CVPR 2009, Miami,FL.

[9] H.Jegou, F.Perronnin, M.Douze, J.Sanchez, P.P erez and C.Schmid. Aggregating local image descriptor s into

compact codes[J]. TPAMI,34(9):1704-1716,2012.

[10] Quoc V.Le ,Will Y.Zhou,Serena Y.Yeung,and Andrew Y.Ng.Learning hierarchical invariant spatiotemporal

feature for action recognition with idependent subspace analysis[C].In CVPR,2011,42(7):3361-3368.

[11] Lawrence Rabiner, Biing-Hwang Juang. Fundamentals of Speech Recognition[M].北京:清华大学出版

社,1999.

[12] Jiqing Han, Xiantong Zhen, Lei Zhang, Yangyang Feng. Realistic human action recognition: When deep

learning meets vlad[C].In ICASSP, 2016:1352-1356.

[13] Wang H, Klaser A, Schmid C, et al. Dense Trajectories and Motion Boundary Descriptors for Action

Recognition[J].International Journal of Computer Vision,2013,103(1):60-79.

[14] Olusegun Oshin,Andrew Gilbert,and Richerd Bowden.Capturing relative motion and finging modes for action

recognition in the wild[J].Int.Journal Computer Vision and Image Understanding, CVIU,2014,vol.125,155-171.

[15] Heng Wang, Alexander Klaser, Cordelia Schmid and Chenglin Liu. Action Recognition by dense

trajectories[C].In CVPR,2011,42(7) :3169-3176.

- 8 -

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc