应用 Hopfield 网络的英文字母识别

http://www.paper.edu.cn

韩基超,刘武寅,李茜

辽宁工程技术大学理学院,辽宁阜新(123000)

E-mail: hoonri@yahoo.com.cn , caobei504039355@126.com

摘 要:本文应用 Hopfield 神经网络作联想存储器解决英文字母图像识别问题,将每个字母

看作一个图像并从中提取出原始数据,把原始数据提取部分作为网络学习的数据,计算出正

确的权值,建立起网络模型,再将要识别的字母图像代入网络,对字母图像进行识别。本文

分析了 Hopfield 神经网络如何识别大写英文字母,展示了 Hopfield 神经网络在模式识别中

的有效性和实用性。以及 Hopfield 神经网络的容错能力,并给出了模式识别过程中的 Matlab

软件实现。

关键词:Hopfield 网络,联想存储器,模式识别

1 引言

自然界的事物和现象一般可分为多个相似,但又不完全相同的群体或个体组成类别,人

们把这样的类别称为模式类或模式,而把其中多个事物或现象称为该模式的一个样本。所谓

模式识别就是从模式空间到类别隶属空间的正确映射。[1]

人工神经网络在识别领域的应用之广泛,发展之长远,有着不可估量的潜力。人工神经

网络,正一步步迈进人类的生活。从数字识别系统,可以扩展到人脸识别,指纹识别等等更

加高深的领域。人工神经网络的应用也将更加广泛。但是,相对于其他经典数学研究,人工

神经网络只是刚刚起步的一门新兴学科,它的学习和研究,还有很多待以发掘的地方。特别

是 Hopfield 神经网络在模式识别中的应用越来越得到重视。

2 背景知识

2.1 Hopfield 网络介绍

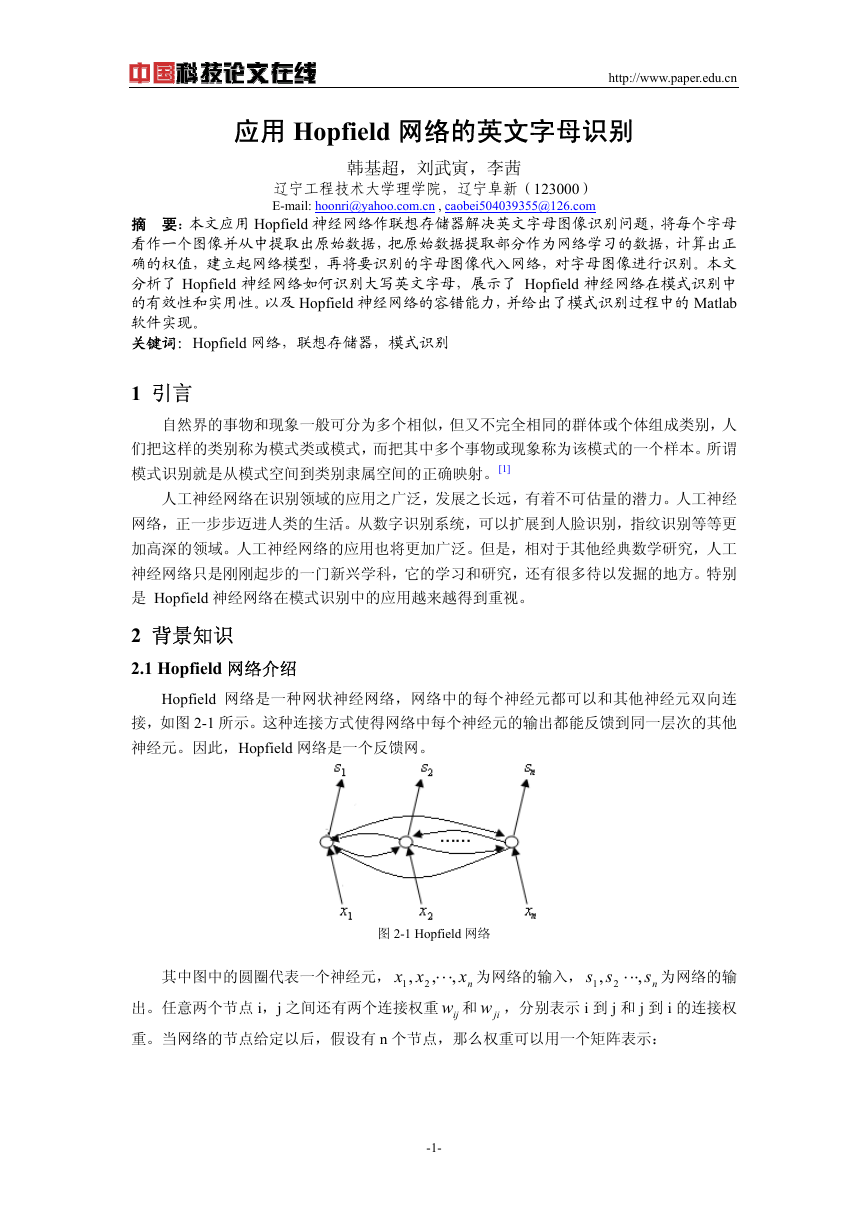

Hopfield 网络是一种网状神经网络,网络中的每个神经元都可以和其他神经元双向连

接,如图 2-1 所示。这种连接方式使得网络中每个神经元的输出都能反馈到同一层次的其他

神经元。因此,Hopfield 网络是一个反馈网。

图 2-1 Hopfield 网络

其中图中的圆圈代表一个神经元,

为网络的输

出。任意两个节点 i,j 之间还有两个连接权重 ijw 和 jiw ,分别表示 i 到 j 和 j 到 i 的连接权

重。当网络的节点给定以后,假设有 n 个节点,那么权重可以用一个矩阵表示:

为网络的输入,

xx

,

1

2

ss

, 2

1

,

⋅⋅⋅

ns

,

,

⋅⋅⋅

nx

-1-

�

ijwW

=

[

]

nn

×

而网络的输出可以用

S

=

{

ss

, 2

1

,

⋅⋅⋅

http://www.paper.edu.cn

=

12

22

11

1n

21

w

⎛

ww

⎜

ww

⎜

⎜

⋅⋅⋅

⋅⋅⋅

⎜⎜

ww

⎝

}ns

表示。所以,一个 Hopfield 经常表示成(W,S)。

(2-1)

w

⋅⋅⋅

w

⋅⋅⋅

⋅⋅⋅

⋅⋅⋅

⋅⋅⋅

⎞

⎟

⎟

⎟

⎟⎟

⎠

n2

n1

2n

nn

Hopfield 网络分为离散型和连续型两种,用

}1,0{)( ∈t

型网络异步地按照下述规则该表网络中各神经元的状态

s j

表示第 j 个神经元的状态,则离散

s

j

=

i

j

≠

若

∑

∑

⎧

,1

⎪

⎪

⎪

,0

⎨

⎪

⎪

不变,若

⎪

⎩

若

≠

j

i

∑

i

≠

j

tsw

)(

ij

i

tsw

)(

ij

i

+

I

j

>

θ

j

+

I

j

<

θ

j

(2-2)

tsw

)(

ij

i

+

I

j

=

θ

j

其中 jI 为第 j 个神经节点的偏流,它表示环境对神经元 j 的输入, jθ 为第 j 个神经节点的阈

限值。如果不加说明,本文的 Hopfield 网络均指离散型的 Hopfield 网络。

2.2 Hopfield 网络的稳定性

{

X

xx

,

=

对于一个 Hopfield 网络(W,S),给定一组输入

1

})1(

S

ns

,

)1(

⋅⋅⋅

{

s

1

),1(

=

s

2

)1(

S

{

s

=

1

)2(

=

),1(

{

s

1

s

2

),2(

)1(

s

2

})1(

ns

,

⋅⋅⋅

ns

)2(

,

⋅⋅⋅

,而将

})2(

S

)1(

……

出

,

,

⋅⋅⋅

2

}nx

便会得到一组输出

作为输入,又会得到一组输

2

(

(

)

)

+

=

=

+

=

即

)1

)1

NS

(

(

)1

),

=

})

+

Ns

1

Ns

n

NS

(

)

NS

(

),

,

)

⋅⋅⋅

,

),

⋅⋅⋅

Ns

(

n

Ns

(

n

,有这样的等式

)1

{

NsNs

(

=

反复进行下去,直到存在一个 N,

1

2

NsNs

Ns

(

(

(

+

存在

1

2

(NS 为稳定态(又叫系统的吸引子)。

考虑一个问题:Hopfield 网络(W,S)能否从任意一个初始状态出发,都一定能收敛

到一个稳定态

w

2,1

ij

证明:引入能量函数

1

2

Hopfield 定 理 : 设 ( W , S ) 是 一 个 具 有 n 个 神 经 元 的 Hopfield 网 络 , 若

w

=

(NS ?答案当然是肯定的,现给出 Hopfield 定理并证明。

,则网络(W,S)一定能收敛到一个稳定状态。

(2-3)

i

,,0且

∑

θ

j

SSw

ij

i

i

(

≠

SI

j

∑

∑

∑

−=

。称

w

ii

⋅⋅⋅

E

=

+

−

n

S

)

)

)

j

j

ji

≥

n

n

n

n

j

i

j

i

1

=

j

1

=

j

1

=

j

1

=

E 随状态 kS 的变化为

因为

ij w

w = ,则

ji

E

∆

S

∆

k

k

−=

1

2

n

∑

i

1

=

Sw

ik

i

−

1

2

n

∑

i

1

=

Sw

ki

i

−

I

k

θ+

k

(2-4)

E

∆

k

−=

(

n

∑

i

1

=

Sw

ik

i

+

I

k

−

θ

k

)

S

∆

k

(2-5)

-2-

�

Sw

ik

i

+

I

k

−

θ ,则由离散型模型(1-2)知,若

k

* >kS

0

,则有

+tS k

(

1)1

=

,

http://www.paper.edu.cn

,即

S 与*

S

k

0>

,所以系统总是朝着能量减小的方向运行,最终稳定在定态。[2]

,由式(1-5)有

*

3.2.1 充分必要条件

若 m 个 样 本

X

i

•

X

T

j

=

⎧

⎨

⎩

http://www.paper.edu.cn

,

x

i

2

,

,

⋅⋅⋅

x

in

),

x

ij

−∈

1},1,1{

≤≤

mi

1,

≤≤

j

n

两 两 正 交 , 即

,又若权重矩阵

W

m

= ∑

i

1

=

(

X

T

i

•

X

i

−

EE

),

为单位阵

,那么

x

(

=

≠

=

i

1

j

j

i

X

i

,0

in

,

所有向量 iX 都是网络的吸引子。

证明:要求样本个数 m 要小于神经元个数 n,即

0m-n

> 。对于任意的 i=1,2,…,m 有

(

X

T

j

•

X

j

−

E

])

•

X

T

i

E

)

+

(

X

T

j

•

X

∑

j

X

i

≠

T

i

−

E

)]

•

X

T

i

•

X

j

−

E

)]

•

X

T

i

j

T

j

X

T

i

)

=

(

n

−

)1

X

T

i

−

(

m

−

)1

X

T

i

=

(

T

i

Xmn

−

)

+

[

X

T

j

X

(

∑

j

i

≠

0

−•

XW

•

T

i

=

[

=

[(

X

T

i

•

X

m

∑

1

=

−

j

i

=

(

X

T

i

•

X

i

−

E

)

•

=

X

T

i

Xn

−•

即

=

XW

T

(

•

i

XW

sgn(

•

于是

T

i

j

(

+

∑

Xmn

−

X

T

)

i

i

≠

)

=

T

i

T

i

0m-n,

>

网络收敛

3.2.2 充分条件

事实上在一般情况下,两两都相交的样本是很难找到的。所以要寻找当 iX 不是两两相

交时 iX 都是系统的吸引子的条件。

=

记

= 且,

,则

。

X

n

εε

ji

ε=

ij

i X

•

⎛

⎜

⎜

⎜

⎜

⎜

⎝

=

1

T

j

XX

XX

2

⋅⋅⋅

XX

m

T

1

T

1

T

1

1

ε

ij

XX

XX

2

⋅⋅⋅

XX

m

T

2

T

2

T

1

⋅⋅⋅

⋅⋅⋅

⋅⋅⋅

⋅⋅⋅

1

ij

XX

XX

2

⋅⋅⋅

XX

m

令

M

,

B

=

(

X

1

X

2

⋅⋅⋅

)mX

,则

T

m

T

m

T

m

⎞

⎟

⎟

⎟

⎟

⎟

⎠

BM

•

T

=

n

ε

⎛

12

⎜

n

ε

⎜

21

⎜

⋅⋅⋅

⋅⋅⋅

⎜⎜

εε

⎝

m

m

1

2

⋅⋅⋅

⋅⋅⋅

⋅⋅⋅

⋅⋅⋅

ε

m

1

ε

m

2

⋅⋅⋅

n

⎛

⎞

⎜

⎟

⎜

⎟

⎜

⎟

⎜⎜

⎟⎟

⎠

⎝

1

X

X

2

⋅⋅⋅

X

m

=

⎞

⎟

⎟

⎟

⎟⎟

⎠

⎛

⎜

⎜

⎜

⎜

⎜

⎜

⎜⎜

⎝

nX

1

+

nX

2

+

j

1

≠

∑

∑

j

≠

2

ε

1

X

j

j

ε

2

j

X

j

⋅⋅⋅

nX

+

m

ε

mj

∑

mj

≠

X

j

(3-3)

⎞

⎟

⎟

⎟

⎟

⎟

⎟

⎟⎟

⎠

若 iX 均是可记忆的,则

sgn(

BM

•

T

)

=

T

B

=

⎛

⎜

⎜

⎜

⎜⎜

⎝

-4-

1

X

X

2

⋅⋅⋅

X

m

(3-4)

⎞

⎟

⎟

⎟

⎟⎟

⎠

�

即对于任给 iX ,

sgn(

nX

i

+

∑

ε

ij

X

)

=

j

X

i

,它的第 k 个分量

sgn(

nx

ik

+

∑

ε

ij

x

jk

)

=

x

i

http://www.paper.edu.cn

所以 iX 是系统吸引子的充分条件是

|

ij <∑

|

ε

j

i

≠

n

。[4]

4 利用 Hopfield 网络做模式识别具体应用

识别英文字母是模式识别的一项重要课题,它不仅对科研领域有很大的帮助,还能够为

日常生活生产的应用起到巨大的推动作用。所以,就以 26 个英文字母为例做模式识别。

10

15× 个子部分,这样就可以用一个

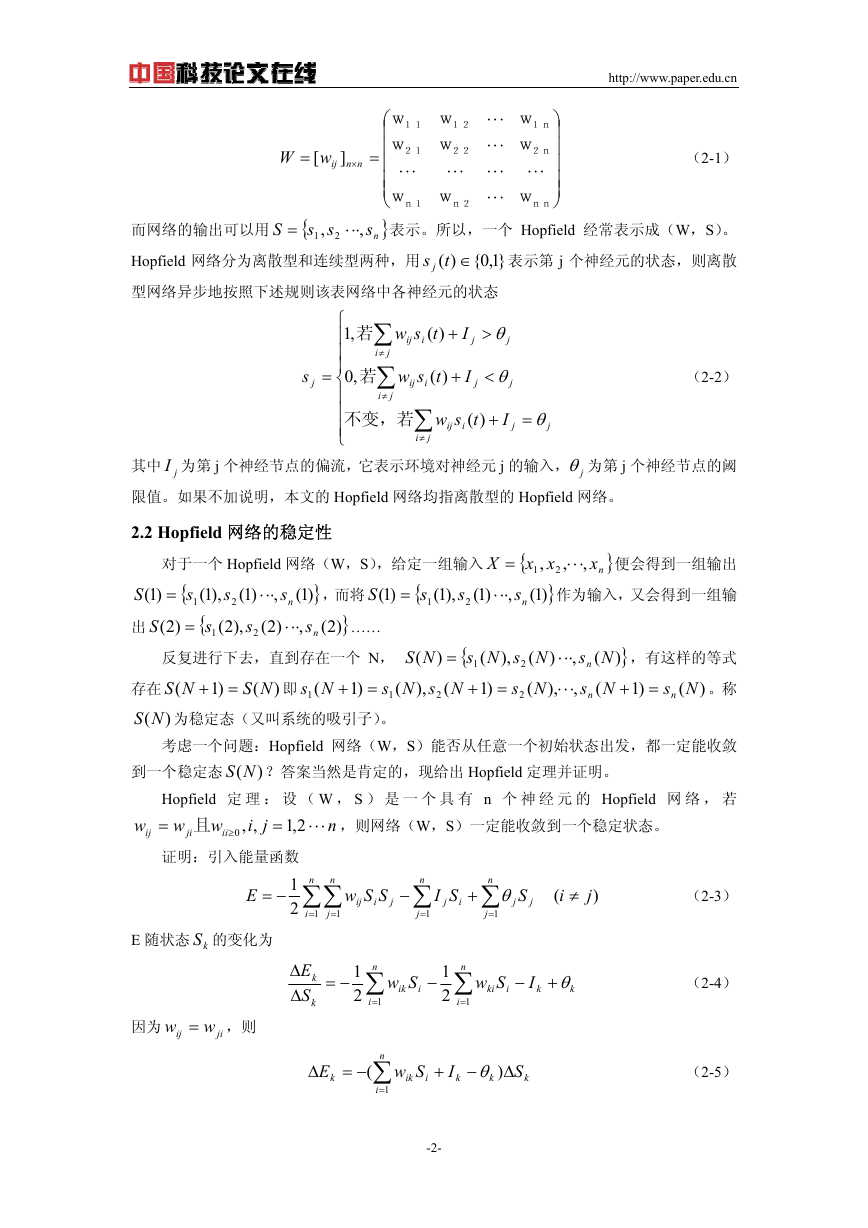

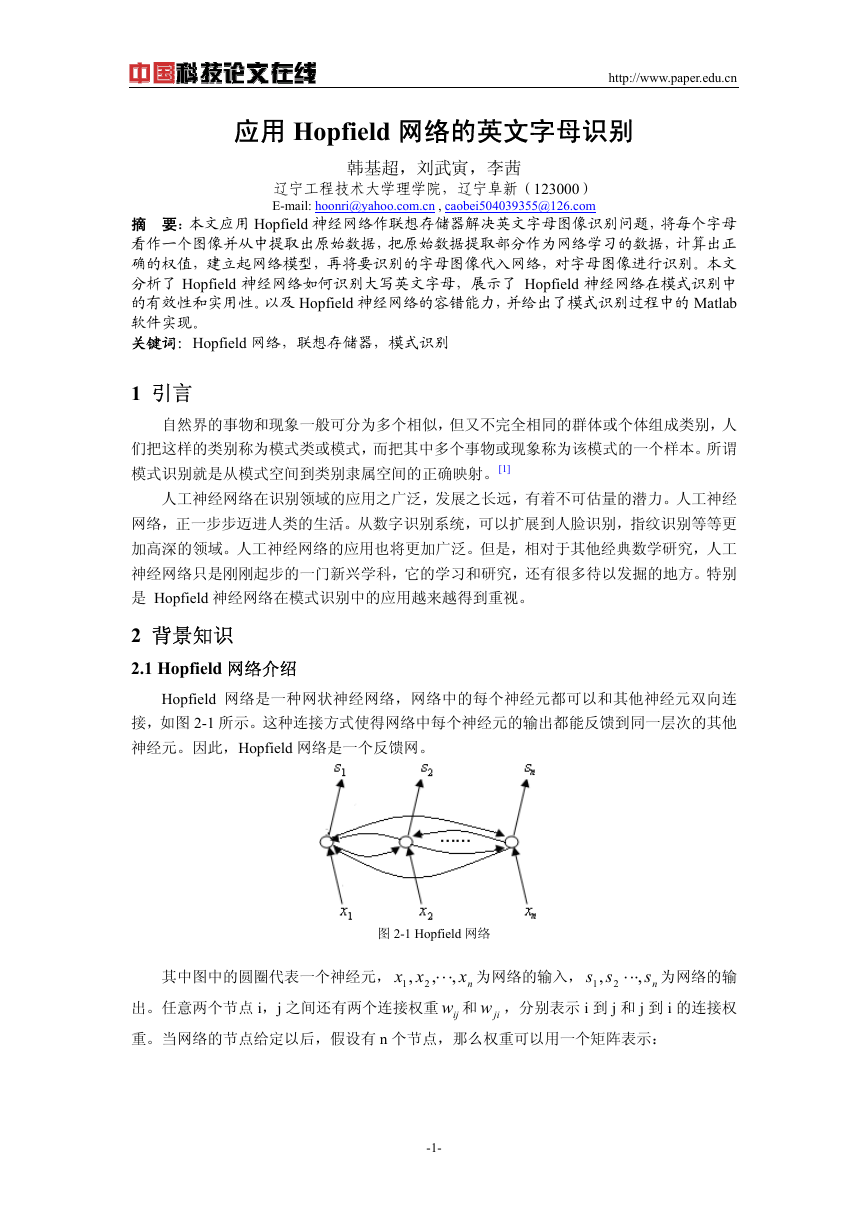

4.1 选择标准样本做系统的吸引子

选取标准的英文字母,如图 4-1(a)所示。对于每个样本,选取笔画的边缘处做图像的上

15× 矩

下左右边界;将选取后的图像平均的划分为

阵来存储这样一个字母图像了;对于每个子部分,如果此部分的一半面积以上都有笔画,则

视为此部分有笔画,并将对应的矩阵元素置为 1,否则将其置为-1(如果用于图像的显示时

15× 矩阵按行向量拉直成一个行向量并转置。这样对每个

还要将-1 改为 0);再将得到的

字母做一次上述处理后就得到了系统的 26 个吸引子。易证这些吸引子满足 3.2.2 中的充分条

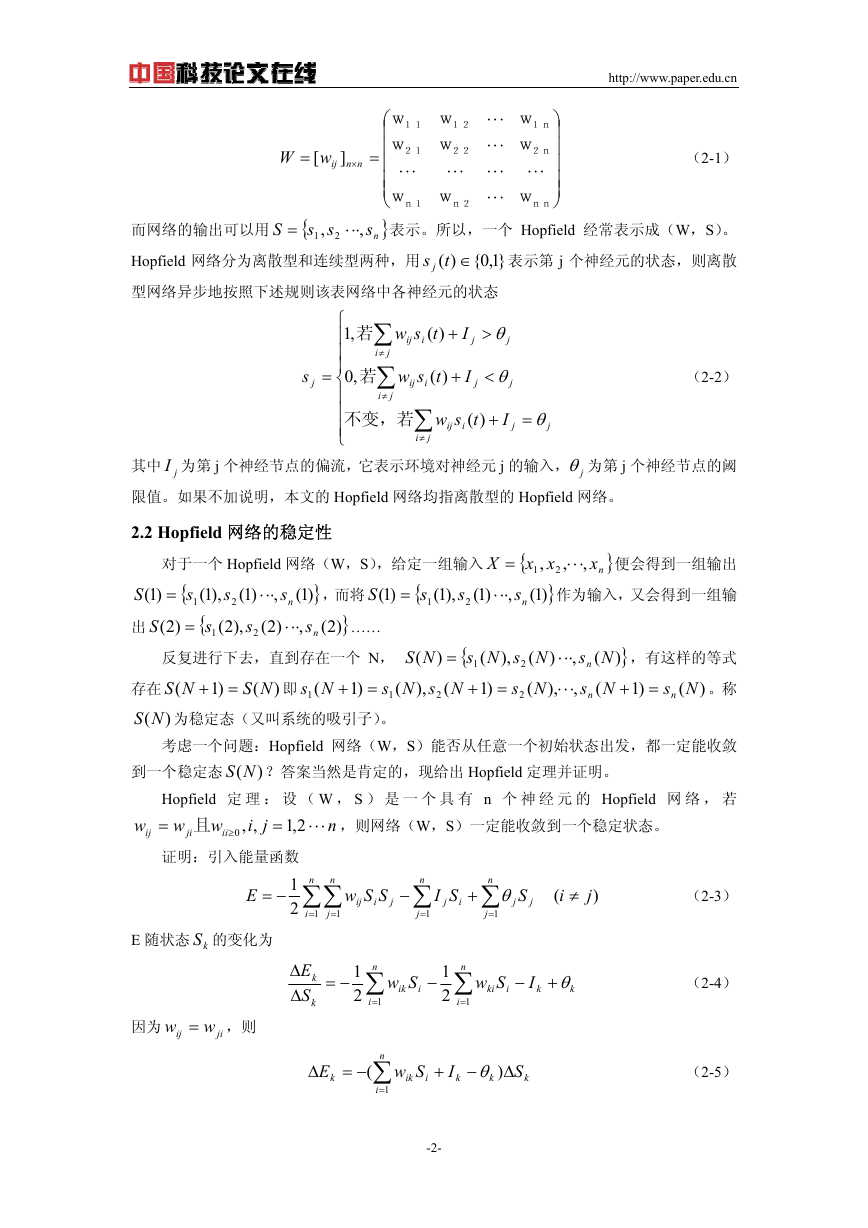

件。将这 26 个吸引子对应的图像画出,如图 4-1(b)所示。这样就可以根据这些样本建立一

个神经元节点的 Hopfield 网络,利用这个网络以残缺信息做网络的输入,

个

进行联想并做出识别。

由于篇幅有限,26 吸引子的具体数据见附录 1 所示。

150

10

10

15

×

10

=

图 4-1(a) 标准英文字母模式样本

图 4-1(b) 26 个吸引子对应的图像

4.2 模式识别

由于所选取的残缺信息(即要识别的图像)太多,这里只取 A,B,Z 为例子做模式识别。

选取 A,B,Z 三个字母的模糊图像各一个,如图 4-2(a)所示。再按照 4.1 对图像的划分得到存

储它们

15× 矩阵做网络的输入,并画出,如图 4-2(b)。

10

-5-

�

http://www.paper.edu.cn

图 4-2(a) 要识别的图像 图 4-2(b) 网络的输入

经过 Matlab 软件的计算,第一个图像经过 16 次迭代收敛到字母 A 的图像,第二个图像

经过 105 次迭代收敛到字母 B 的图像,第三个图像经过 25 次迭代收敛到字母 Z 的图像。它

们的收敛过程分别用图 4-3(a)(b)(c)表示(由于篇幅有限,第二个图像每迭代五次显示一次并

显示最后一次,第三个图像每迭代二次显示一次)。

由于篇幅有限,Matlab 程序见附录 2。

图 4-3(a) 第一个图像的收敛过程

图 4-3(b) 第二个图像的收敛过程(每五次迭代显示一次)

图 4-3(c) 第三个图像的收敛过程(每两次迭代显示一次)

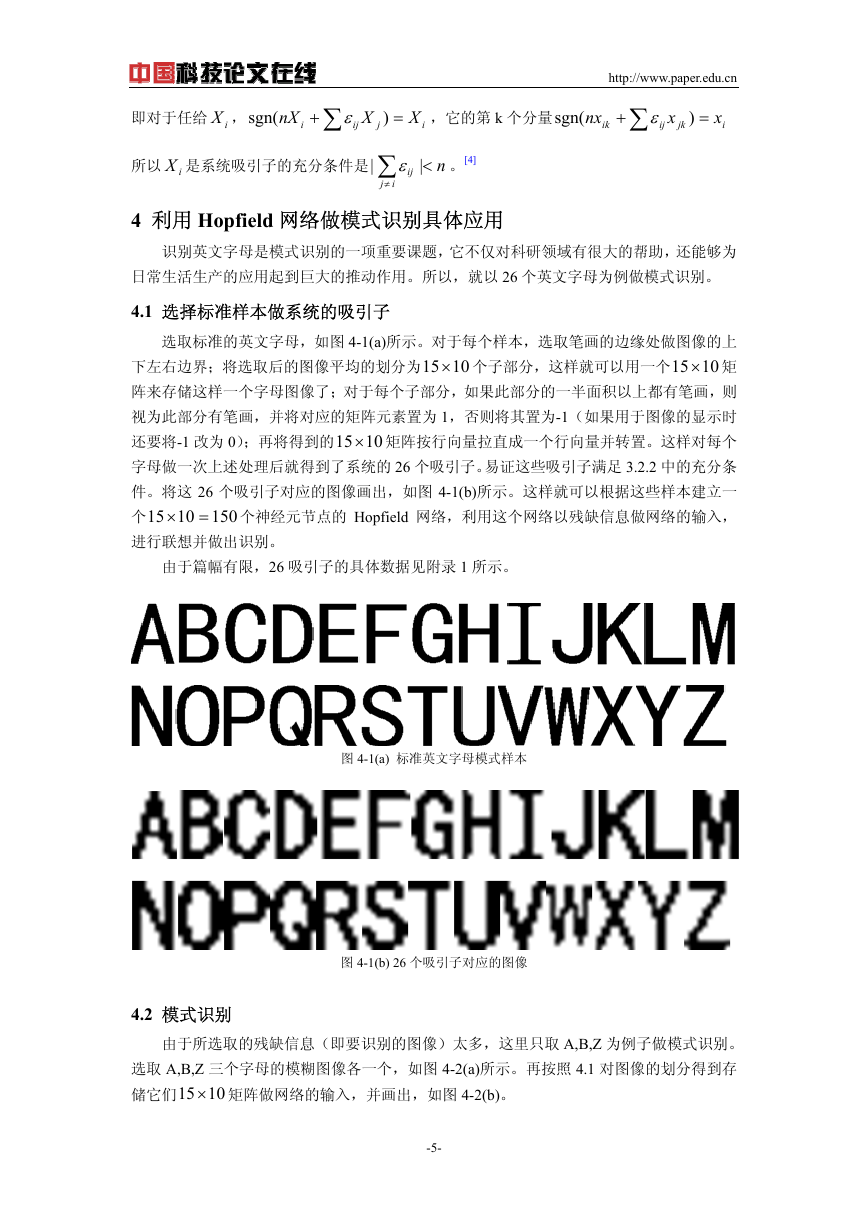

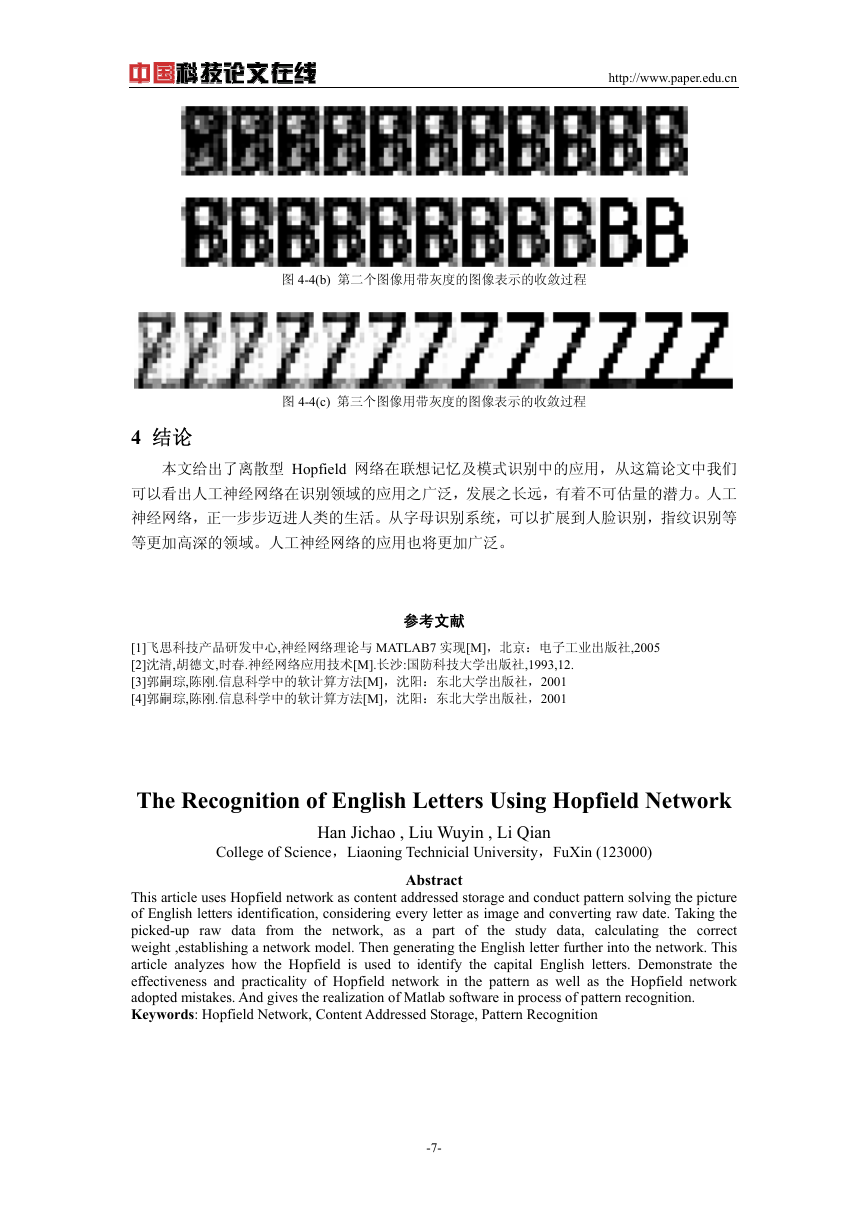

由于用 0,1 的黑白图像对图像的收敛情况不能够非常清楚的表现出来,现将它们的收敛

情况用 0~255 的带灰度的图像表示出来,如图 4-4(a)(b)(c)所示。

图 4-4(a) 第一个图像用带灰度的图像表示的收敛过程

-6-

�

http://www.paper.edu.cn

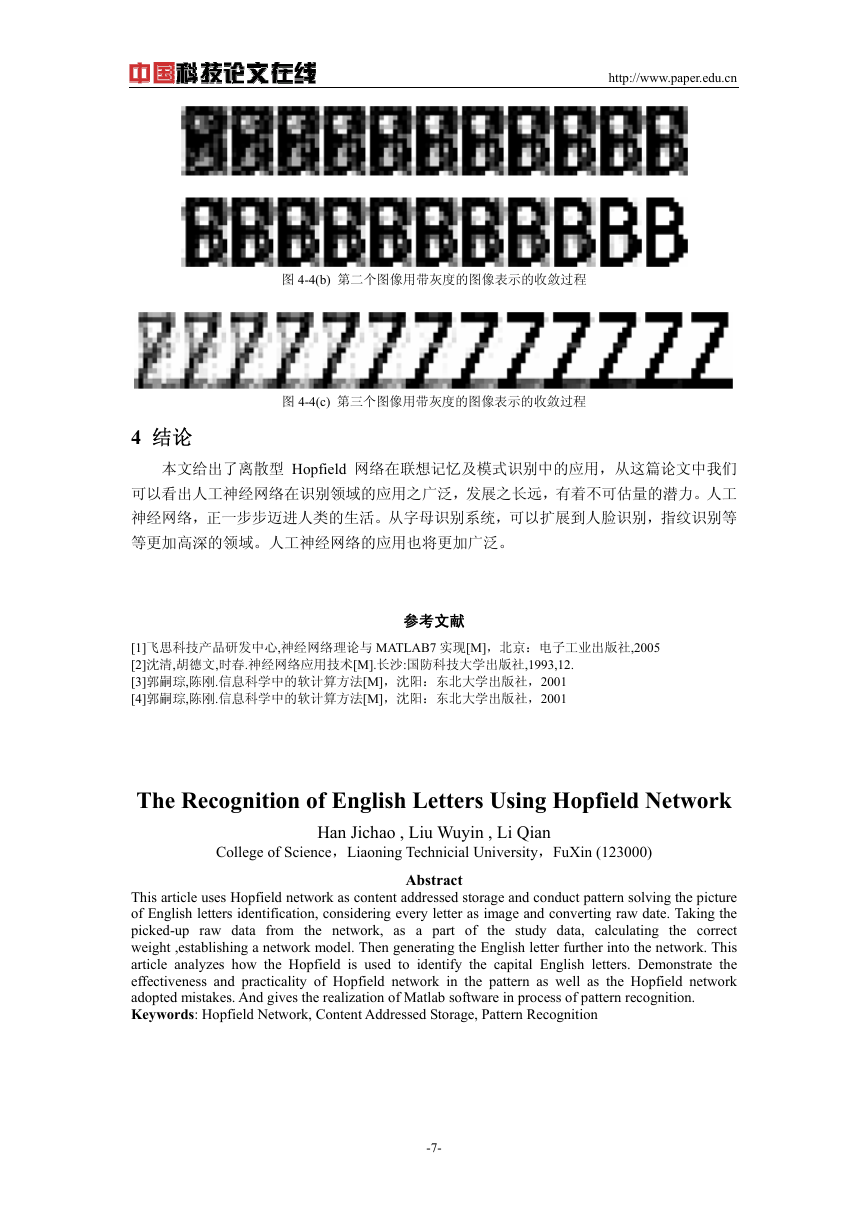

图 4-4(b) 第二个图像用带灰度的图像表示的收敛过程

图 4-4(c) 第三个图像用带灰度的图像表示的收敛过程

4 结论

本文给出了离散型 Hopfield 网络在联想记忆及模式识别中的应用,从这篇论文中我们

可以看出人工神经网络在识别领域的应用之广泛,发展之长远,有着不可估量的潜力。人工

神经网络,正一步步迈进人类的生活。从字母识别系统,可以扩展到人脸识别,指纹识别等

等更加高深的领域。人工神经网络的应用也将更加广泛。

参考文献

[1]飞思科技产品研发中心,神经网络理论与 MATLAB7 实现[M],北京:电子工业出版社,2005

[2]沈清,胡德文,时春.神经网络应用技术[M].长沙:国防科技大学出版社,1993,12.

[3]郭嗣琮,陈刚.信息科学中的软计算方法[M],沈阳:东北大学出版社,2001

[4]郭嗣琮,陈刚.信息科学中的软计算方法[M],沈阳:东北大学出版社,2001

The Recognition of English Letters Using Hopfield Network

Han Jichao , Liu Wuyin , Li Qian

College of Science,Liaoning Technicial University,FuXin (123000)

Abstract

This article uses Hopfield network as content addressed storage and conduct pattern solving the picture

of English letters identification, considering every letter as image and converting raw date. Taking the

picked-up raw data from the network, as a part of the study data, calculating the correct

weight ,establishing a network model. Then generating the English letter further into the network. This

article analyzes how the Hopfield is used to identify the capital English letters. Demonstrate the

effectiveness and practicality of Hopfield network in the pattern as well as the Hopfield network

adopted mistakes. And gives the realization of Matlab software in process of pattern recognition.

Keywords: Hopfield Network, Content Addressed Storage, Pattern Recognition

-7-

�

http://www.paper.edu.cn

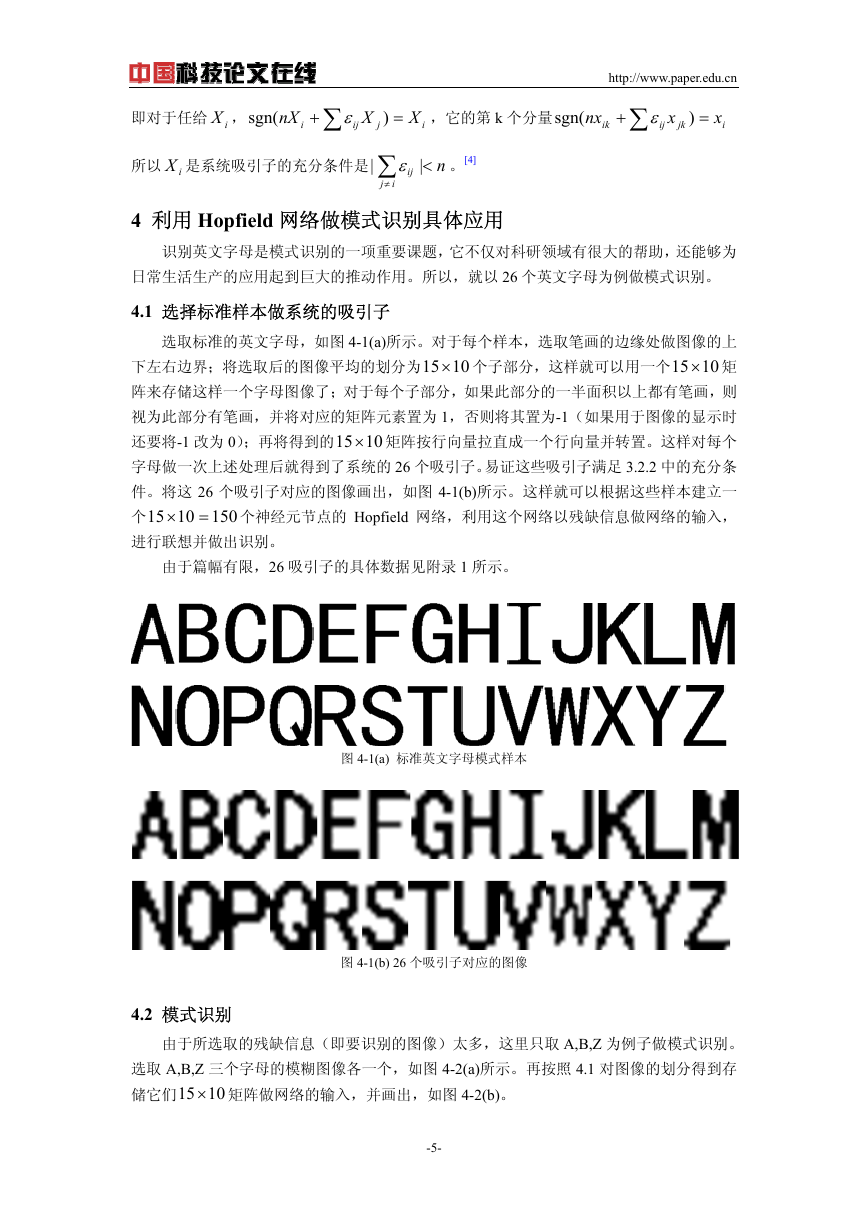

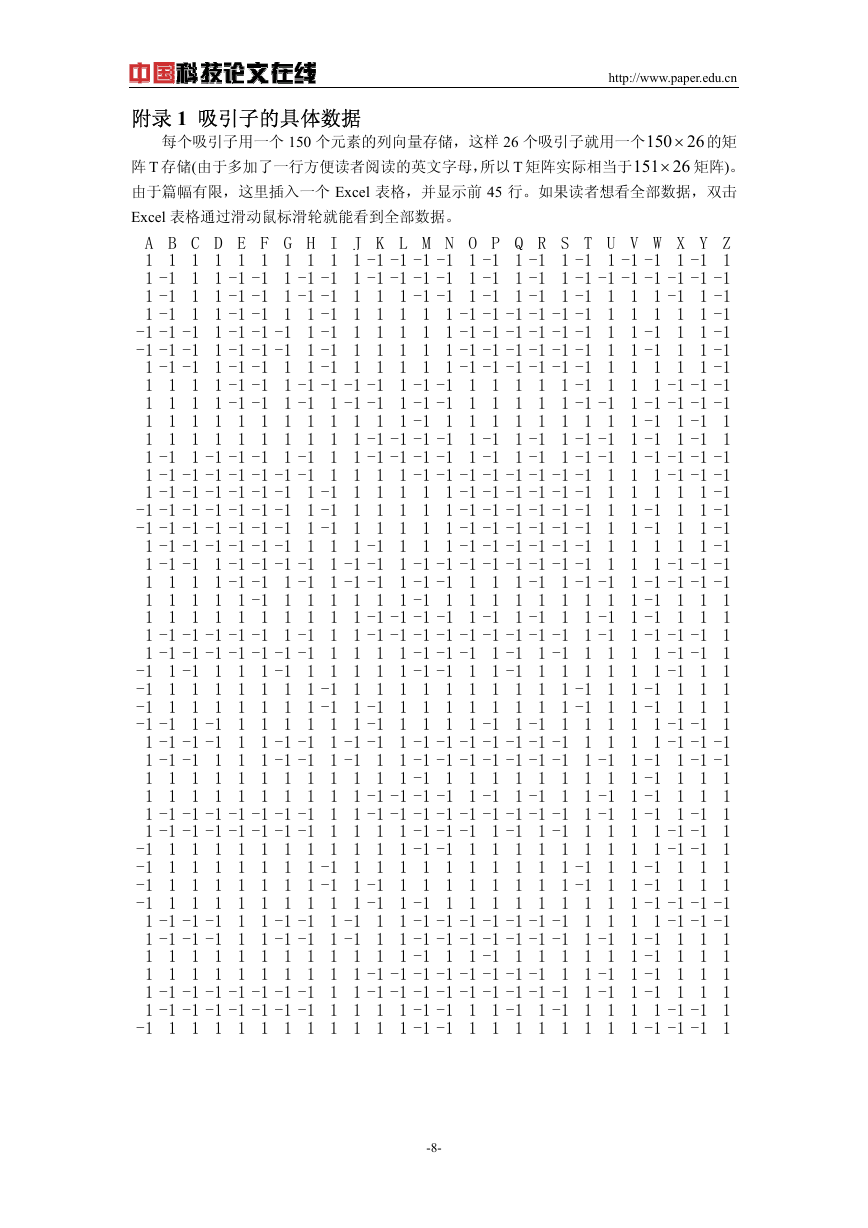

附录 1 吸引子的具体数据

150 × 的矩

每个吸引子用一个 150 个元素的列向量存储,这样 26 个吸引子就用一个

151× 矩阵)。

阵 T 存储(由于多加了一行方便读者阅读的英文字母,所以 T 矩阵实际相当于

由于篇幅有限,这里插入一个 Excel 表格,并显示前 45 行。如果读者想看全部数据,双击

Excel 表格通过滑动鼠标滑轮就能看到全部数据。

26

26

A B C D E F G H I J K L M N O P Q R S T U V W X Y Z

1 1 1 1 1 1 1 1 1 1 -1 -1 -1 -1 1 -1 1 -1 1 -1 1 -1 -1 1 -1 1

1 -1 1 1 -1 -1 1 -1 -1 1 -1 -1 -1 -1 1 -1 1 -1 1 -1 -1 -1 -1 -1 -1 -1

1 -1 1 1 -1 -1 1 -1 -1 1 1 1 -1 -1 1 -1 1 -1 1 -1 1 1 1 -1 1 -1

1 -1 1 1 -1 -1 1 1 -1 1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 1 1 1 -1

-1 -1 -1 1 -1 -1 -1 1 -1 1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 -1 1 1 -1

-1 -1 -1 1 -1 -1 -1 1 -1 1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 -1 1 1 -1

1 -1 -1 1 -1 -1 1 1 -1 1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 1 1 1 -1

1 1 1 1 -1 -1 1 -1 -1 -1 -1 1 -1 -1 1 1 1 1 1 -1 1 1 1 -1 -1 -1

1 1 1 1 -1 -1 1 -1 1 -1 -1 1 -1 -1 1 1 1 1 1 -1 -1 1 -1 -1 -1 -1

1 1 1 1 1 1 1 1 1 1 1 1 -1 1 1 1 1 1 1 1 1 1 -1 1 -1 1

1 1 1 1 1 1 1 1 1 1 -1 -1 -1 -1 1 -1 1 -1 1 -1 -1 1 -1 1 -1 1

1 -1 1 -1 -1 -1 1 -1 1 1 -1 -1 -1 -1 1 -1 1 -1 1 -1 -1 1 -1 -1 -1 -1

1 -1 -1 -1 -1 -1 -1 -1 1 1 1 1 -1 -1 -1 -1 -1 -1 -1 -1 1 1 1 -1 -1 -1

1 -1 -1 -1 -1 -1 -1 1 -1 1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 1 1 1 -1

-1 -1 -1 -1 -1 -1 -1 1 -1 1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 -1 1 1 -1

-1 -1 -1 -1 -1 -1 -1 1 -1 1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 -1 1 1 -1

1 -1 -1 -1 -1 -1 -1 1 1 1 -1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 1 1 1 -1

1 -1 -1 1 -1 -1 -1 -1 1 -1 -1 1 -1 -1 -1 -1 -1 -1 -1 -1 1 1 1 -1 -1 -1

1 1 1 1 -1 -1 1 -1 1 -1 -1 1 -1 -1 1 1 1 -1 1 -1 -1 1 -1 -1 -1 -1

1 1 1 1 1 -1 1 1 1 1 1 1 -1 1 1 1 1 1 1 1 1 1 -1 1 1 1

1 1 1 1 1 1 1 1 1 1 -1 -1 -1 -1 1 -1 1 -1 1 1 -1 1 -1 1 1 1

1 -1 -1 -1 -1 -1 1 -1 1 1 -1 -1 -1 -1 -1 -1 -1 -1 -1 1 -1 1 -1 -1 -1 1

1 -1 -1 -1 -1 -1 -1 -1 1 1 1 1 -1 -1 -1 1 -1 1 -1 1 1 1 1 -1 -1 1

-1 1 -1 1 1 1 -1 1 1 1 1 1 -1 -1 1 1 -1 1 1 1 1 1 1 -1 1 1

-1 1 1 1 1 1 1 1 -1 1 1 1 1 1 1 1 1 1 1 -1 1 1 -1 1 1 1

-1 1 1 1 1 1 1 1 -1 1 -1 1 1 1 1 1 1 1 1 -1 1 1 -1 1 1 1

-1 -1 1 -1 1 1 1 1 1 1 -1 1 1 1 1 -1 1 -1 1 1 1 1 1 -1 -1 1

1 -1 -1 -1 1 1 -1 -1 1 -1 -1 1 -1 -1 -1 -1 -1 -1 -1 1 1 1 1 -1 -1 -1

1 -1 -1 1 1 1 -1 -1 1 -1 1 1 -1 -1 -1 -1 -1 -1 -1 1 -1 1 -1 1 -1 -1

1 1 1 1 1 1 1 1 1 1 1 1 -1 1 1 1 1 1 1 1 1 1 -1 1 1 1

1 1 1 1 1 1 1 1 1 1 -1 -1 -1 -1 1 -1 1 -1 1 1 -1 1 -1 1 1 1

1 -1 -1 -1 -1 -1 -1 -1 1 1 -1 -1 -1 -1 -1 -1 -1 -1 -1 1 -1 1 -1 1 -1 1

1 -1 -1 -1 -1 -1 -1 -1 1 1 1 1 -1 -1 -1 1 -1 1 -1 1 1 1 1 -1 -1 1

-1 1 1 1 1 1 1 1 1 1 1 1 -1 -1 1 1 1 1 1 1 1 1 1 -1 -1 1

-1 1 1 1 1 1 1 1 -1 1 1 1 1 1 1 1 1 1 1 -1 1 1 -1 1 1 1

-1 1 1 1 1 1 1 1 -1 1 -1 1 1 1 1 1 1 1 1 -1 1 1 -1 1 1 1

-1 1 1 1 1 1 1 1 1 1 -1 1 -1 1 1 1 1 1 1 1 1 1 -1 -1 -1 -1

1 -1 -1 -1 1 1 -1 -1 1 -1 1 1 -1 -1 -1 -1 -1 -1 -1 1 1 1 1 -1 -1 -1

1 -1 -1 -1 1 1 -1 -1 1 -1 1 1 -1 -1 -1 -1 -1 -1 -1 1 -1 1 -1 1 1 1

1 1 1 1 1 1 1 1 1 1 1 1 -1 1 1 -1 1 1 1 1 1 1 -1 1 1 1

1 1 1 1 1 1 1 1 1 1 -1 -1 -1 -1 -1 -1 -1 -1 1 1 -1 1 -1 1 1 1

1 -1 -1 -1 -1 -1 -1 -1 1 1 -1 -1 -1 -1 -1 -1 -1 -1 -1 1 -1 1 -1 1 1 1

1 -1 -1 -1 -1 -1 -1 -1 1 1 1 1 -1 -1 1 1 -1 1 -1 1 1 1 1 -1 -1 1

-1 1 1 1 1 1 1 1 1 1 1 1 -1 -1 1 1 1 1 1 1 1 1 -1 -1 -1 1

-8-

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc