基于神经网络的机器人视觉伺服控制

1.中科院沈阳自动化研究所, 辽宁 沈阳 110016 2.中国科学院研究生院, 北京 100039

谢冬梅 1, 2 , 曲道奎 1 , 徐方 1

摘 要:视觉伺服可以应用于机器人初始定位自动导引、自动避障、轨线跟踪和运动目标跟踪等控制系统中。

传统的视觉伺服系统在运行时包括工作空间定位和动力学逆运算两个过程,需要实时计算视觉雅可比矩阵

和机器人逆雅可比矩阵,计算量大,系统结构复杂。本文分析了基于图像的机器人视觉伺服的基本原理,

使用 BP 神经网络来确定达到指定位姿所需要的关节角度,将视觉信息直接融入伺服过程,在保证伺服精

度的情况下大大简化了控制算法。文中针对 Puma560 工业机器人的模型进行了仿真实验,结果验证了该方

法的有效性。

关键词: 视觉伺服; 图像雅可比矩阵; 逆雅可比矩阵; BP 神经网络; 视觉控制器

中图分类号: TP273+ 文献标识码:A

Design of Robotic Visual Servo Controll Based on Neural Network

Xie Dongmei1,2 Qu Daokui1 Xu Fang1

1.Shenyang Institute of Automation, Chinese Academy of Sciences,Shenyang 110016

2.Graduate School of Chinese Academy of Sciences, Beijing 100039

Abstract: Visual servo system can be used in the control systems of robot original orientation guiding,

obstacle avoiding, trajectory tracking and moving object tracking, etc. During working, the traditional visual

servo system consists of two processes: determination of the workpiece position and inverse kinetic calculation. So

real-time computation of visual Jacobian and inverse Jacobian of the robot have been needed. Both the

computation and the structure of the system are complex. In this paper, the basic principle of robot visual servo

system is analyzed. A BP neural network is proposed to determine the required joint angles for the set position and

orientation. This method can integrate visual data directly into the servo process, so under the condition that the

servo precision is ensured, the computation of the control arithmetic is greatly simplified. The simulation

experiment for Puma560 robot is made and simulation results proved the effectiveness of the method.

Keywords: Visual servo; Image jacobian matrix; Inverse jacobian matrix; BP neural nerwork; Visual controller

1. 引言

目前视觉伺服控制的研究在机器人研究领域是一个热点问题[1]。Shirai 和 Inouei[2]在

1973 年首次将视觉控制引入机器人操作当中。他们采用固定摄像机的方式,利用视觉来提

高机器人的定位精度,实现了抓取和放置的任务。1979 年 Hill 和 Park[3]提出了“视觉伺服

(Visual servo)look-and-move 方式”的概念。视觉首次被引入了闭环,以克服系统模型(包

括机器人、视觉系统、环境)存在的不确定性,提高机器人的操作精度。

人工神经网络是生物神经网络的一种模拟和近似,它特别适用于不能用显性公式表示

的、具有复杂非线性关系的系统,并具有较强的适应和学习功能。近年来,机器人智能视觉

控制器的应用越来越引起关注。已有不少研究者讨论过将神经网络应用在机器人控制中的可

行性。这一主题所讨论的中心问题是使用神经网络学习机器人视觉系统的特征。Wells 分别

用 4 点特征、傅立叶描述子和几何矩作为神经网络的输入[4],对六自由度机器人进行定位实

验。其特点是采用全局的图像特征,这样可扩大应用范围。但利用全局特征的定位精度较低。

Sun 采用两个神经网络[5]:用一个 Kohonen 网进行全局控制,视觉信号来自两个固定于工作

空间的摄像机;另一个采用 BP 网进行局部控制,视觉信号来自安装在末端上的两个摄像机。

Stanley 借助于神经网络进行特征抽取和求逆雅可比[6]。Hashimoto 使用 BP 网络来学习图像

特征变化和机器人关节角度变化之间的关系[7],网络的输入是图像特征的变化,输出是期望

的关节角的变化。但是他只做了神经网络的设计工作,并没有给出设计的神经网络用在视觉

伺服系统中的伺服效果。

本文提出了一种基于图像的视觉伺服控制方案,将视觉信息直接用于伺服过程。为达到

指令定位位置使用一个人工神经网络来确定所需的关节角度变化,对机器人末端操作手定

位,这种方法使得系统省略了计算视觉雅可比矩阵和机器人逆雅可比矩阵及手眼标定的过

程,简化了控制算法的计算。

2. 问题陈述

2.1 问题提出

在机器人应用中,最基本的任务是抓取和放置。通常,这项工作由以下的子任务组成:

1)机器人末端执行器到达工件处; 2)使其抓起工件; 3)将其移动至别处。在本文中,将要讨论

第一个子任务。本文研究的视觉伺服系统属于眼在手上构型,即摄像机安装于机器人末端执

1

�

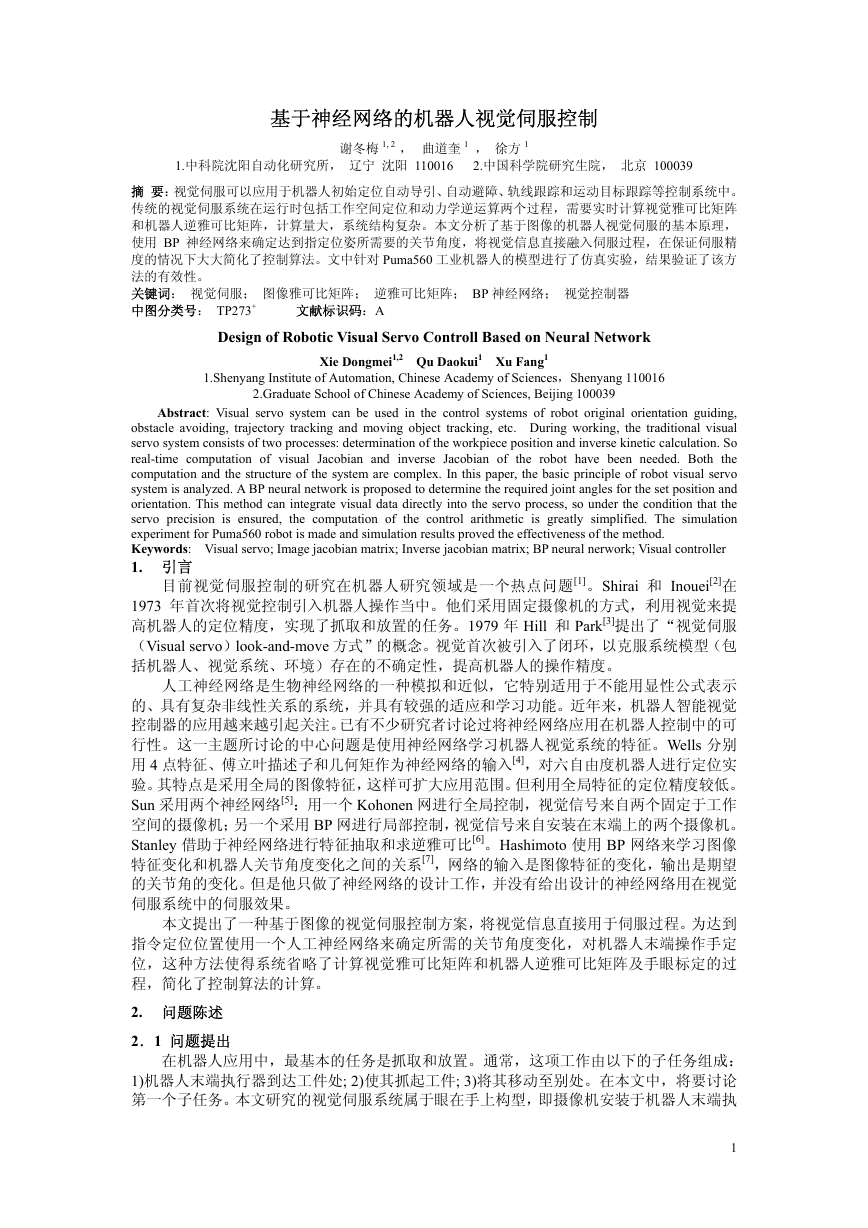

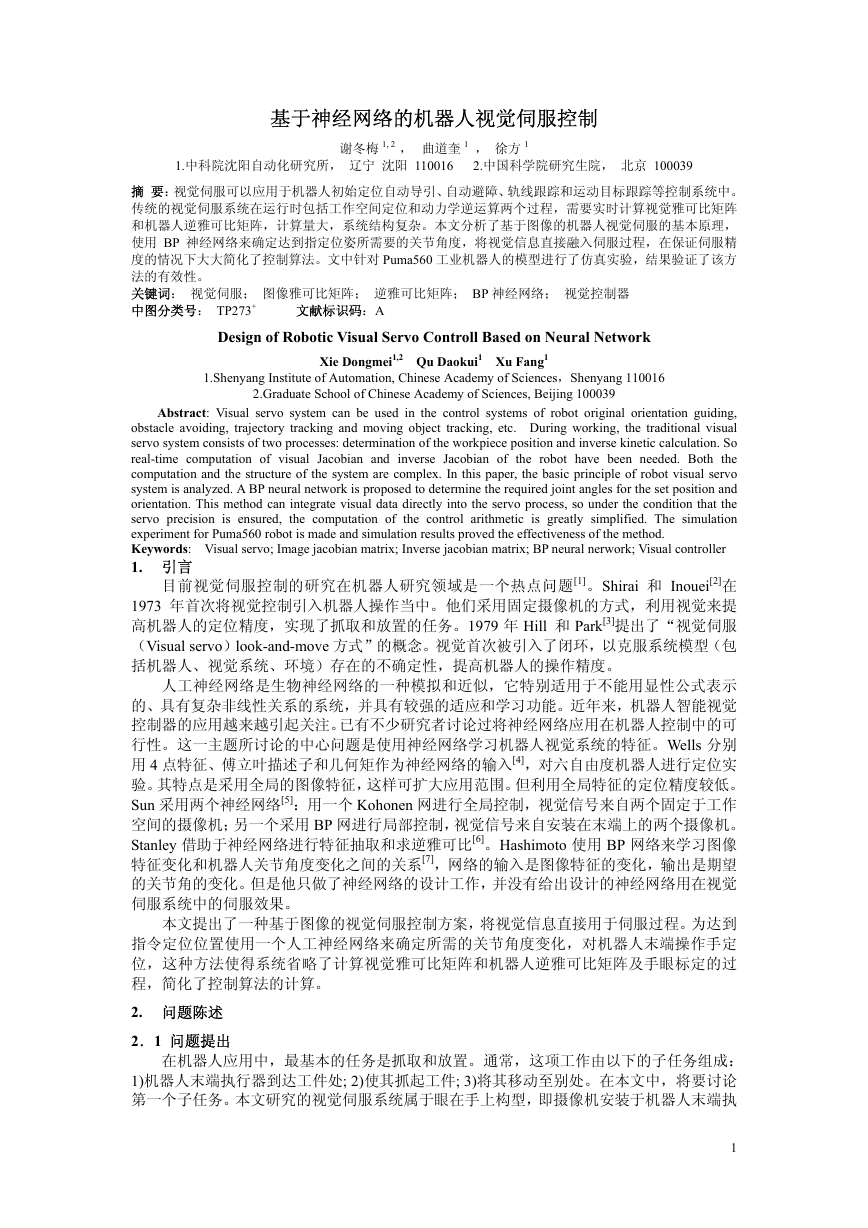

行器上的类型。光轴 CZ 是将末端执行器坐标系{ }T 的 T Z 轴平移一定量得到的,如图 1。

2.2 坐标系定义

{ }C

本文中所涉及的坐标系主要有:末端执行器坐

标系{ }T :定义在机器人手部末端的坐标系;摄像机

坐标系{ }C :以摄像机中心为原点的坐标系,摄像机

光轴作为 z 轴;图像平面坐标系{ }I :摄像机内的像

平面坐标系统,与{ }C 的 xy 平面平行,且两坐标系

}W :工作环境中

的 x 轴和 y 轴重合;世界坐标系{

的基准坐标系,在机器人控制中一般以机器人的基

坐标系作为世界坐标系;目标坐标系{ }O :级联于目标的坐标系。

3. 图像雅可比矩阵

{ }O

A

D

B

C

{ }I

A′ B′

C′

{ }T

D′

{ }W

图 1 坐标系定义

基于图像的视觉伺服控制,要根据所选的图像特征构造图像雅可比矩阵。图像雅可比矩

阵是用来描述图像特征空间与机器人末端位姿空间的微分关系的,其推导过程:坐标系定义

如图 1 所示,设 A 为目标在摄像机坐标系下的一个目标点,将其在摄像机坐标系{ }C 下的位

置定义为向量:(

x y 。目标 A 与其投影点 A′ 成

I

针孔模型关系:

(1)

,点 A 在图像平面的投影 A′ 为:(

x y z

,

c

=

)

)

,

,

T

T

c

c

I

x

I

y

I

⎡

⎢

⎣

⎤

⎥

⎦

f

z

c

α

⎡

0

⎢

⎣

0

⎤

β

⎥

⎦

x

c

y

c

⎡

⎢

⎣

⎤

⎥

⎦

其中 f 为焦距,α、 β为单位距离内像素的个数。对(1)式两边进行时间求导得到

&

x

I

&

y

I

⎤

⎥

⎦

⎡

⎢

⎣

=

f

z

c

α

⎡

0

⎢

⎣

0

⎤

β

⎥

⎦

⎡

⎢

⎣

1 0

0 1

−

−

x

c

y

c

/

/

z

c

z

c

⎡

⎤

⎢

⎥

⎦ ⎣

&

x

c

&

y

c

&

z

c

⎤

⎥

⎦

同时,假设此时摄像机相对于目标的线速度 ( )v t 和角速度 ( )tω 分别为

(2)

⎧

⎪

⎨

⎪

⎩

T

v

v

t

( )

⎤

⎦

ω

t ω ω ω

( )

z

=

=

v

⎡

⎣

⎡

⎣

v

x

y

x

y

z

(3)

T

⎤

⎦

则由运动学可以知道,目标在摄像机坐标系下的运动速度为:

⎤

⎥

⎥

⎦

y

c

x

−

c

0

v

t

( )

ω

t

( )

0

z

c

y

−

z

−

0

x

c

0

0

1

−

0

1

−

0

1

−

0

0

(

sk P

&

x

c

&

y

c

&

z

c

= −

⎡

⎣

⎤

⎥

⎥

⎦

⎡

⎢

⎢

⎣

⎡

⎢

⎢

⎣

⎡

⎢

⎣

⎤

⎥

⎦

=

⎤

⎦

)

I

c

c

将(4)式代入(2)式得到:

v v v

,

x

,

y

z

,

ω ω ω

z

,

,

x

y

T

⎤

⎦

(4)

⎡

⎣

&

x

I

&

y

I

⎤

⎥

⎦

⎡

⎢

⎣

=

f

z

c

α

⎡

0

⎢

⎣

0

⎤

β

⎥

⎦

1 0

−

0

1

−

⎡

⎢

⎢

⎢

⎢

⎣

x

c

z

c

y z

c

z

c

x y

c

c

z

c

+

z

c

2

c

y

z

−

−

2

c

x

2

c

2

c

+

z

c

x y

c

c

z

c

y

c

−

x

c

v

⎡

⎤

x

v

⎢

⎥

y

v

⎢

⎥

z

ω

⎢

⎥

x

ω

⎢

y

⎥

ω

⎦ ⎣

z

⎤

⎥

⎥

⎥

⎥

⎦

=

⎡

⎢

⎢

⎢

⎢

⎣

−

α

f

z

c

0

0

−

β

x

c

z

c

y

I

z

c

f

z

c

2

α

−

−

y

2

I

I

x y

I

f

β

f

2

+

f

β

2

β

2

f

+

f

α

x y

I

f

α

I

x

2

I

y

α

I

β

x

β

I

α

−

⎤

⎥

⎥

⎥

⎥

⎦

v

⎡

x

v

⎢

y

v

⎢

z

ω

⎢

x

ω

⎢

y

ω

⎣

z

⎤

⎥

⎥ =

⎥

⎥

⎦

IJ

v

t

( )

ω

t

( )

⎡

⎢

⎣

⎤

⎥

⎦

(5)

令 r 代表摄像机在机器人任务空间的位姿向量, ξ 代表图像特征向量,则 &r 代表摄像机的速

=ξ& & & 。

度矢量,由(3)式可得

于是根据(5)式可得:

, &ξ 代表相应的图像特征变化率矢量: [

( ) T

t

⎤

⎦

&r

⎡

= ⎣

x , y

I

t

( ),

ω

T

]T

v

T

I

I=&

&J r

(6)

ξ

fα

⎡

−⎢

z

= ⎢

⎢

0

⎢

⎣

(7)

f

+

f

α

x y

I

−

f

α

y

α

I

β

x

β

I

α

x y

I

f

β

f

2

+

f

β

x

z

c

y

I

z

⎤

⎥

⎥

⎥

⎥

⎦

−

β

2

β

2

α

f

z

IJ

−

0

x

y

2

I

2

I

2

c

c

c

I

I

I

(7)式为图像雅可比矩阵的解析表达式。如果需要描述机器人关节速度 &q 与对应的图像特征变

化速度 &ξ 之间的关系,则有:

&

=

ξ

(8)

& &

Jq

=

J J q

I

cq

其中 cqJ 为机器人雅可比矩阵, IJ 为图像雅可比矩阵,

=J

J J 称为复合雅可比矩阵。

I

cq

2

�

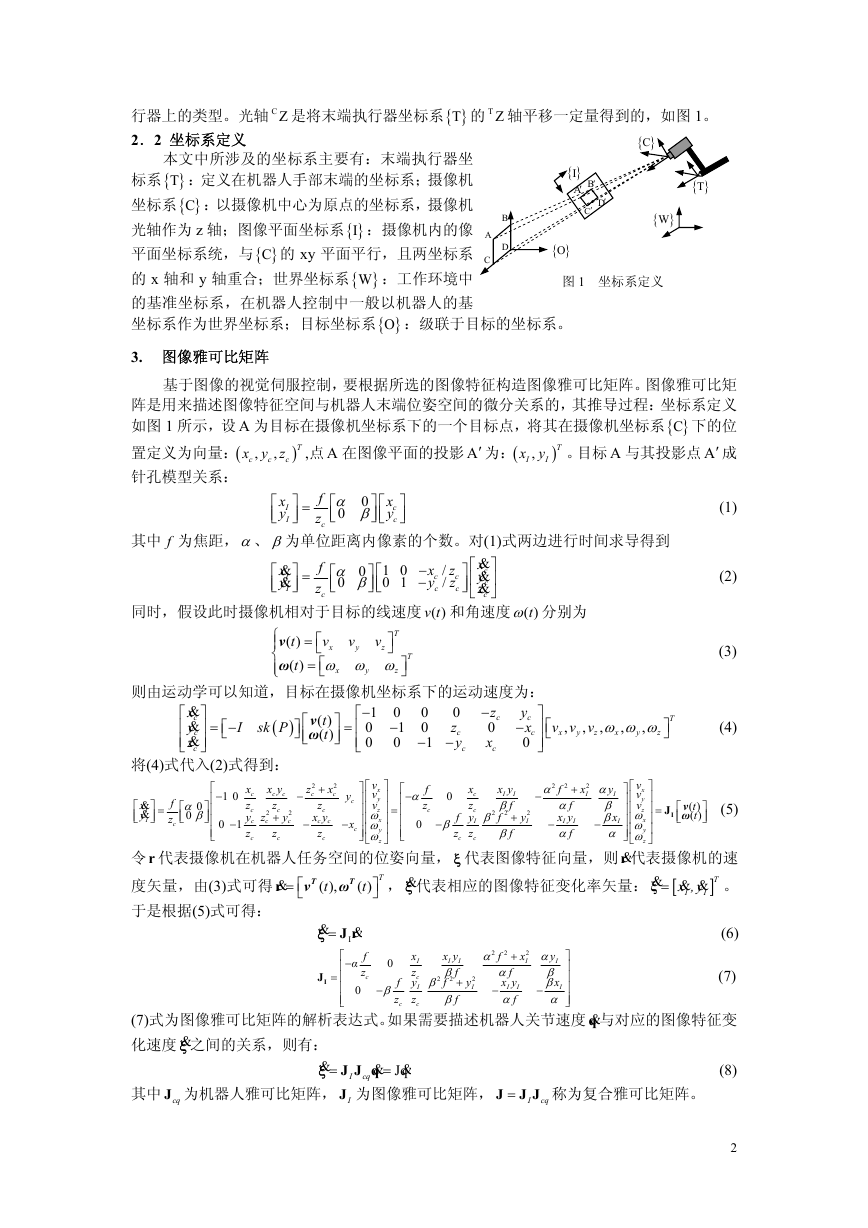

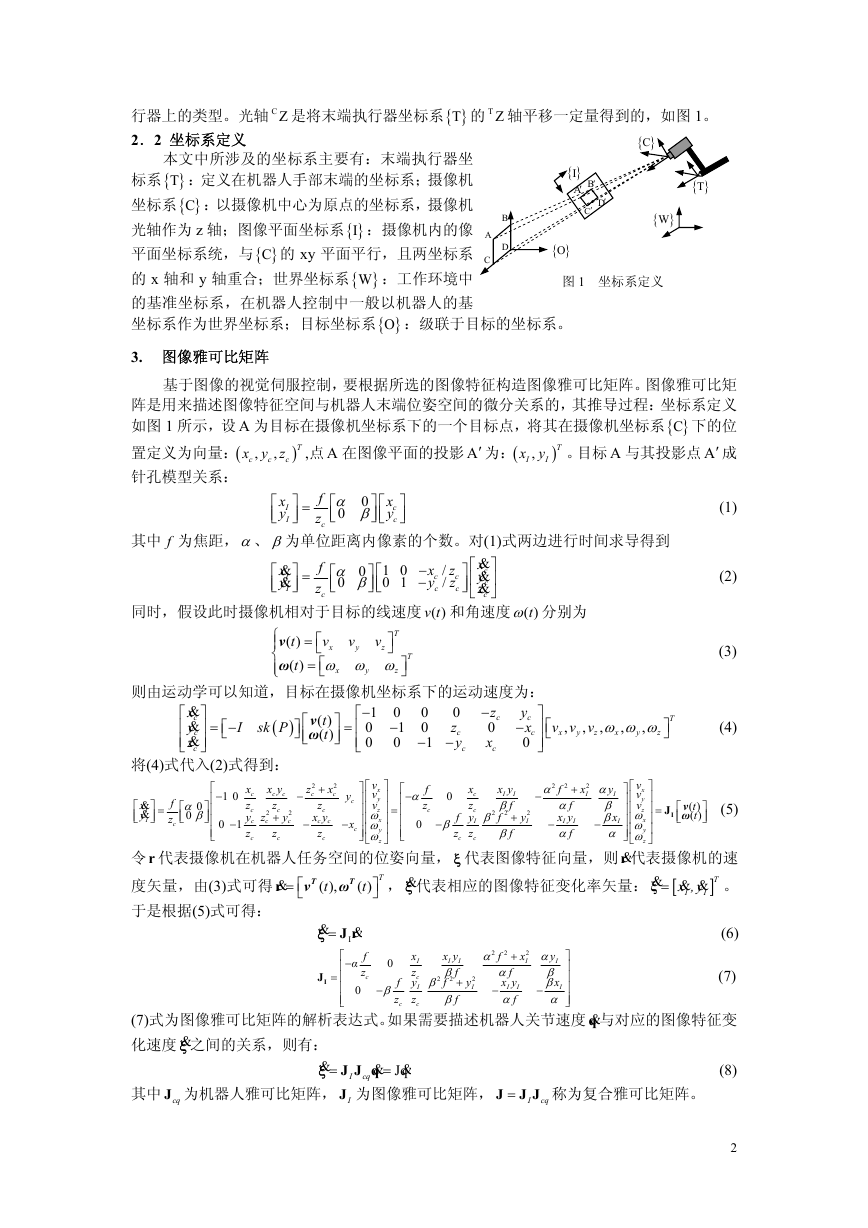

4. 基于图像的视觉伺服系统

图 2 为本文的视觉伺服控制系统结构图。图

中为基于图像的视觉伺服系统,其伺服误差定义

在图像特征空间。误差信号是通过比较当前图像

特征与期望图像特征而得到的。

图像特征误差为:

e

d=

ξ

−

ξ (9)

e

-

dξ

+

ξ

Pk

+J

视觉控制器

∆q

机器人控

制器

机器人

摄像机

-

目标

图像处理及特征提取 图像采集

图 2 基于图像的视觉伺服控制系统结构图

式中 dξ 是期望的图像特征,ξ 为实际经过图像采集与处理后得到的关于目标的图像特征。 dξ

与 ξ 均为列向量。由(8)式可知,图像特征变化率与机器人关节角速度之间的关系由复合雅可

比矩阵决定。视觉控制器为:

1∆θ 2∆θ 3∆θ 4∆θ 5∆θ 6∆θ

Pk

&

=q

J e

+

(10)

式中 &q 是机器人关节角速度, Pk 为正比例系数, +J 是

复合雅可比矩阵的伪逆。

控制器的稳定性进行分析:取李雅普诺夫函数为

输出层

(6 个节点)

隐层

(48 个节点)

1

2

=

e e ,此函数是正定的。将上面的李雅普诺夫

T

=V

函数对时间求导,则有

&

&

&

V e e

e Jq

)

T

T

= −

显然此时的 0≤&V

雅普诺夫意义下的稳定。

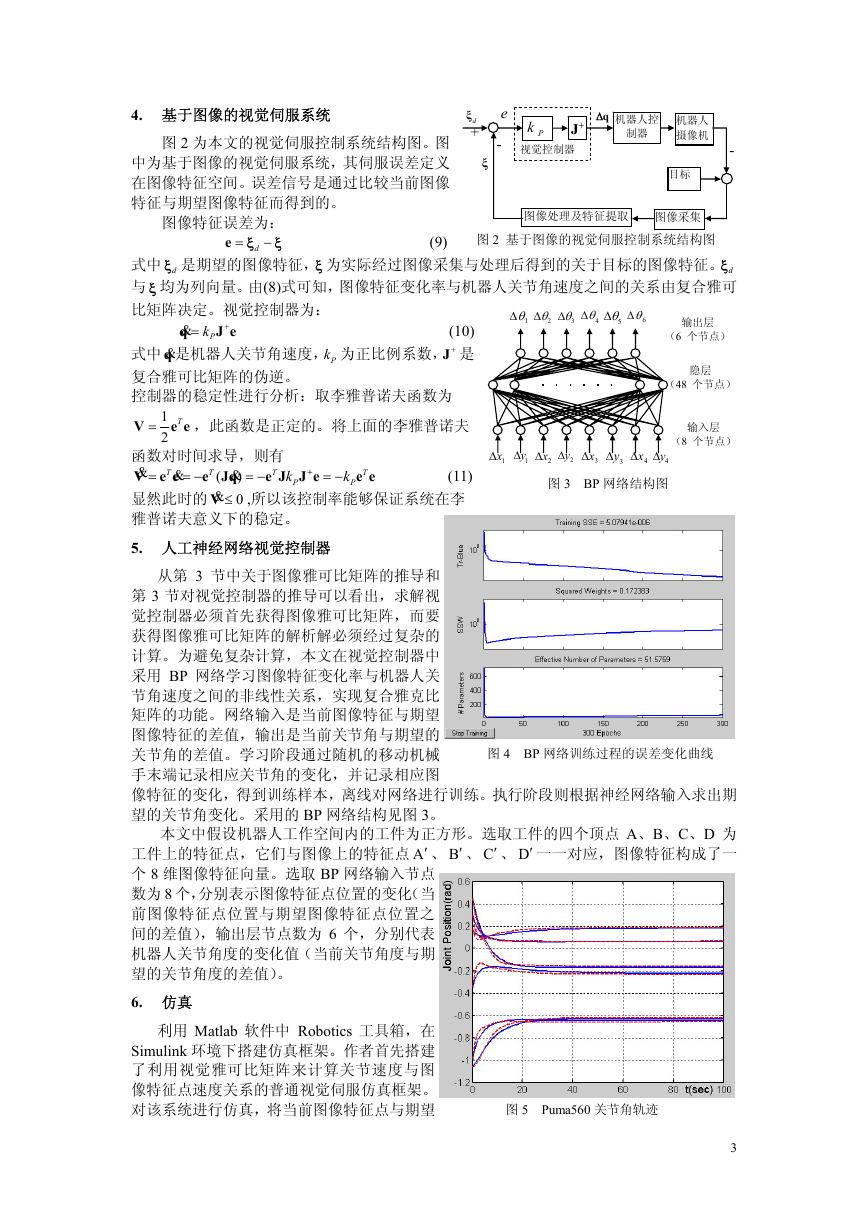

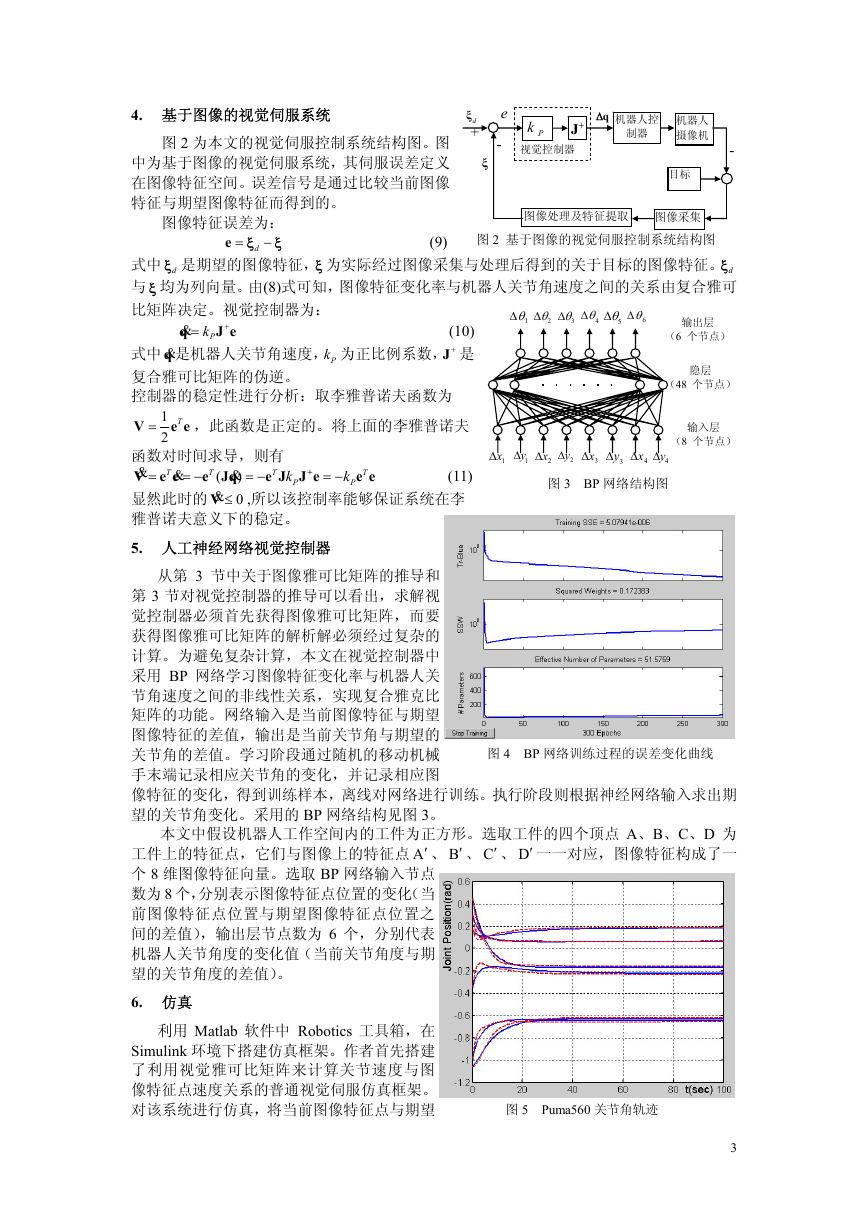

5. 人工神经网络视觉控制器

(11)

= −

,所以该控制率能够保证系统在李

图 3 BP 网络结构图

e J J e

+

T

(8 个节点)

3y∆

= −

k

输入层

4x∆

4y∆

e e

T

P

3x∆

1y∆

2x∆

2y∆

1x∆

k

P

(

从第 3 节中关于图像雅可比矩阵的推导和

第 3 节对视觉控制器的推导可以看出,求解视

觉控制器必须首先获得图像雅可比矩阵,而要

获得图像雅可比矩阵的解析解必须经过复杂的

计算。为避免复杂计算,本文在视觉控制器中

采用 BP 网络学习图像特征变化率与机器人关

节角速度之间的非线性关系,实现复合雅克比

矩阵的功能。网络输入是当前图像特征与期望

图像特征的差值,输出是当前关节角与期望的

关节角的差值。学习阶段通过随机的移动机械

手末端记录相应关节角的变化,并记录相应图

像特征的变化,得到训练样本,离线对网络进行训练。执行阶段则根据神经网络输入求出期

望的关节角变化。采用的 BP 网络结构见图 3。

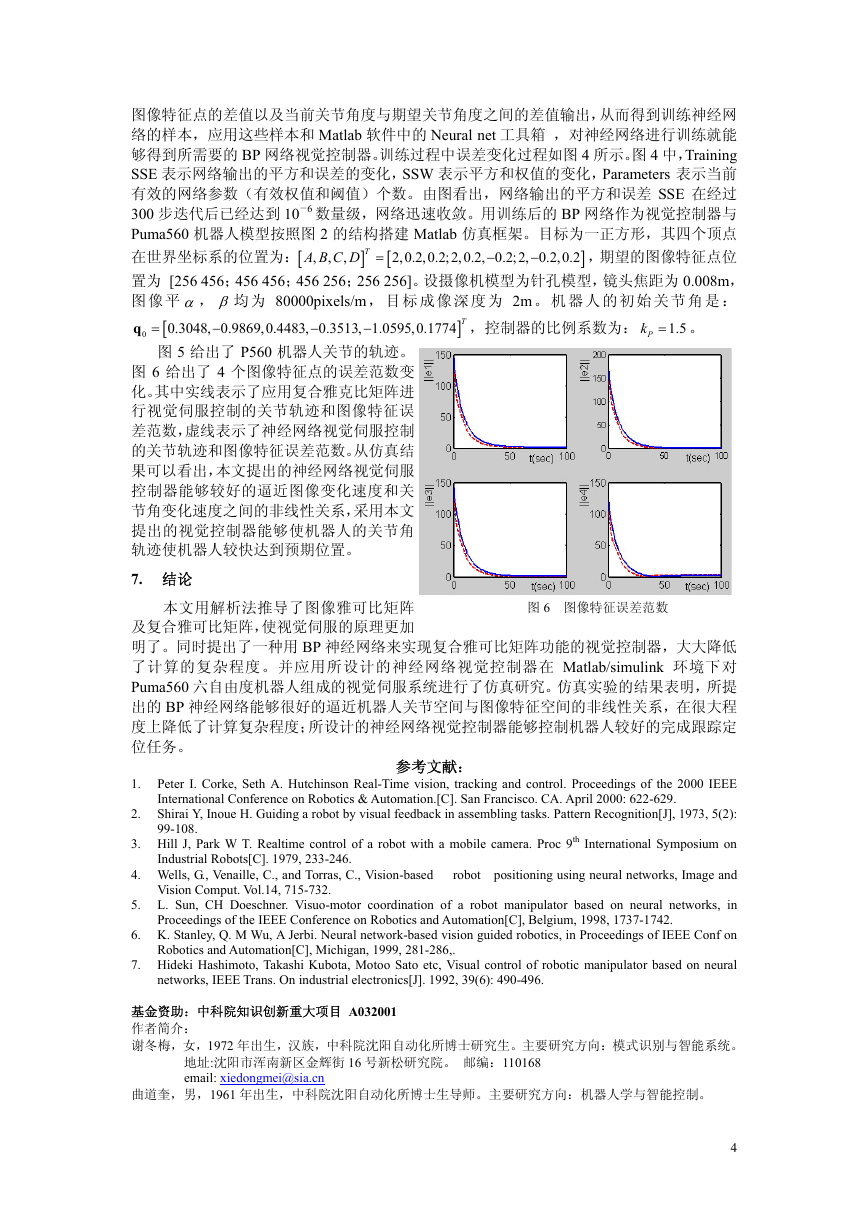

图 4 BP 网络训练过程的误差变化曲线

本文中假设机器人工作空间内的工件为正方形。选取工件的四个顶点 A、B、C、D 为

工件上的特征点,它们与图像上的特征点 A′ 、 B′ 、 C′ 、 D′ 一一对应,图像特征构成了一

个 8 维图像特征向量。选取 BP 网络输入节点

数为 8 个,分别表示图像特征点位置的变化(当

前图像特征点位置与期望图像特征点位置之

间的差值),输出层节点数为 6 个,分别代表

机器人关节角度的变化值(当前关节角度与期

望的关节角度的差值)。

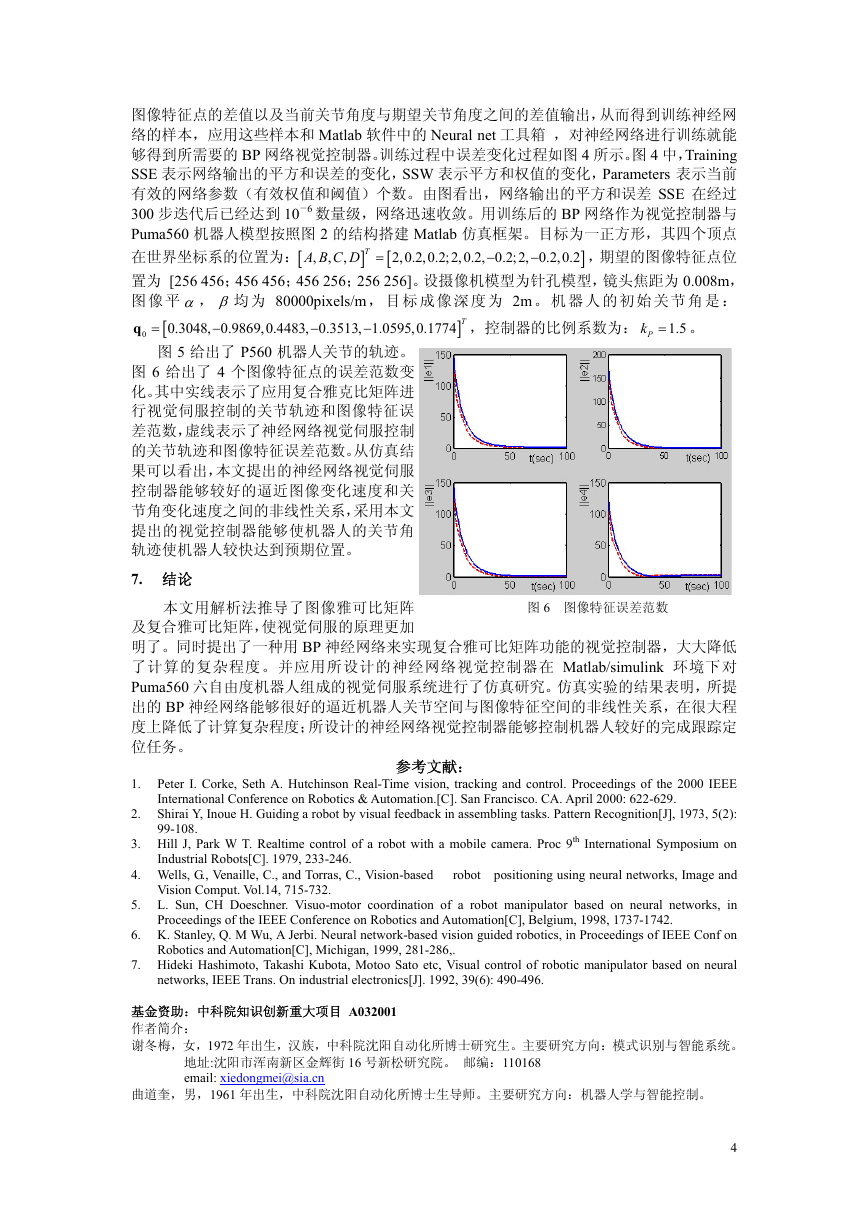

6. 仿真

利用 Matlab 软件中 Robotics 工具箱,在

Simulink 环境下搭建仿真框架。作者首先搭建

了利用视觉雅可比矩阵来计算关节速度与图

像特征点速度关系的普通视觉伺服仿真框架。

对该系统进行仿真,将当前图像特征点与期望

图 5 Puma560 关节角轨迹

3

�

图像特征点的差值以及当前关节角度与期望关节角度之间的差值输出,从而得到训练神经网

络的样本,应用这些样本和 Matlab 软件中的 Neural net 工具箱 ,对神经网络进行训练就能

够得到所需要的 BP 网络视觉控制器。训练过程中误差变化过程如图 4 所示。图 4 中,Training

SSE 表示网络输出的平方和误差的变化,SSW 表示平方和权值的变化,Parameters 表示当前

有效的网络参数(有效权值和阈值)个数。由图看出,网络输出的平方和误差 SSE 在经过

300 步迭代后已经达到 10-6 数量级,网络迅速收敛。用训练后的 BP 网络作为视觉控制器与

Puma560 机器人模型按照图 2 的结构搭建 Matlab 仿真框架。目标为一正方形,其四个顶点

在世界坐标系的位置为:[

,期望的图像特征点位

置为 [256 456;456 456;456 256;256 256]。设摄像机模型为针孔模型,镜头焦距为 0.008m,

图 像 平 α, β 均 为 80000pixels/m , 目 标 成 像 深 度 为 2m 。 机 器 人 的 初 始 关 节 角 是 :

q

,控制器的比例系数为: 1.5

2,0.2,0.2;2,0.2, 0.2;2, 0.2,0.2

A B C D =

,

−

−

[

]

]

,

,

T

Pk = 。

0

−

−

−

]

[

0.3048, 0.9869,0.4483, 0.3513, 1.0595,0.1774 T

=

图 5 给出了 P560 机器人关节的轨迹。

图 6 给出了 4 个图像特征点的误差范数变

化。其中实线表示了应用复合雅克比矩阵进

行视觉伺服控制的关节轨迹和图像特征误

差范数,虚线表示了神经网络视觉伺服控制

的关节轨迹和图像特征误差范数。从仿真结

果可以看出,本文提出的神经网络视觉伺服

控制器能够较好的逼近图像变化速度和关

节角变化速度之间的非线性关系,采用本文

提出的视觉控制器能够使机器人的关节角

轨迹使机器人较快达到预期位置。

7. 结论

图 6 图像特征误差范数

本文用解析法推导了图像雅可比矩阵

及复合雅可比矩阵,使视觉伺服的原理更加

明了。同时提出了一种用 BP 神经网络来实现复合雅可比矩阵功能的视觉控制器,大大降低

了计算的复杂程度。并应用所设计的神经网络视觉控制器在 Matlab/simulink 环境下对

Puma560 六自由度机器人组成的视觉伺服系统进行了仿真研究。仿真实验的结果表明,所提

出的 BP 神经网络能够很好的逼近机器人关节空间与图像特征空间的非线性关系,在很大程

度上降低了计算复杂程度;所设计的神经网络视觉控制器能够控制机器人较好的完成跟踪定

位任务。

参考文献:

1. Peter I. Corke, Seth A. Hutchinson Real-Time vision, tracking and control. Proceedings of the 2000 IEEE

International Conference on Robotics & Automation.[C]. San Francisco. CA. April 2000: 622-629.

2. Shirai Y, Inoue H. Guiding a robot by visual feedback in assembling tasks. Pattern Recognition[J], 1973, 5(2):

3. Hill J, Park W T. Realtime control of a robot with a mobile camera. Proc 9th International Symposium on

4. Wells, G., Venaille, C., and Torras, C., Vision-based robot positioning using neural networks, Image and

99-108.

Industrial Robots[C]. 1979, 233-246.

Vision Comput. Vol.14, 715-732.

5. L. Sun, CH Doeschner. Visuo-motor coordination of a robot manipulator based on neural networks, in

Proceedings of the IEEE Conference on Robotics and Automation[C], Belgium, 1998, 1737-1742.

6. K. Stanley, Q. M Wu, A Jerbi. Neural network-based vision guided robotics, in Proceedings of IEEE Conf on

Robotics and Automation[C], Michigan, 1999, 281-286,.

7. Hideki Hashimoto, Takashi Kubota, Motoo Sato etc, Visual control of robotic manipulator based on neural

networks, IEEE Trans. On industrial electronics[J]. 1992, 39(6): 490-496.

基金资助:中科院知识创新重大项目 A032001

作者简介:

谢冬梅,女,1972 年出生,汉族,中科院沈阳自动化所博士研究生。主要研究方向:模式识别与智能系统。

地址:沈阳市浑南新区金辉街 16 号新松研究院。 邮编:110168

email: xiedongmei@sia.cn

曲道奎,男,1961 年出生,中科院沈阳自动化所博士生导师。主要研究方向:机器人学与智能控制。

4

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc