40

2017

第

2

卷第

年

1

期

月

长春理工大学学报 (自然科学版)

Journal of Changchun University of Science and Technology (Natural Science Edition)

无人驾驶汽车环境感知技术综述

王世峰,戴祥,徐宁,张鹏飞

(长春理工大学 光电工程学院,长春 130022)

Vol.40 No.1

Feb.2017

摘 要:无人驾驶汽车在行驶过程中获取外界环境信息是车辆进行导航定位、路径规划及运动控制的根本前提。首先对无

人车环境感知所需传感器的特点和原理进行了介绍,然后阐述了激光雷达和相机的标定方法,并论述了道路、行人、车

辆、交通信号及标识检测任务中的关键技术,同时分析了各种传感器的优势与限定条件,论述了各项关键技术的原理与方

法,从而对无人驾驶汽车在环境感知领域的关键技术进行了综合论述。

关键词:激光雷达;相机;毫米波雷达;环境感知;无人驾驶汽车

中图分类号: TP242.6

文章编号:1672-9870(2017)01-0001-06

文献标识码:A

Overview on Environment Perception Technology

for Unmanned Ground Vehicle

WANG Shifeng,DAI Xiang,XU Ning,ZHANG Pengfei

(School of Optoelectronic Engineering,Changchun University of Science and Technology,Changchun 130022)

Abstract:Navigation and location path planning and motor control are essential prerequisites of obtaining environmental

information during the Unmanned Ground Vehicle’s driving. First of all, this paper introduces characteristics and the

theories of sensors which are employed in environmental perception of UGV. The methods of calibration for lidar and

camera as well as the crucial technique in road,pedestrians,vehicles,traffic signal and marked detection assignments

are described afterwards. Due to the limits and advantages of all types of sensors and the theories of each item,this

paper makes a comprehensively and synthetic discussion about the unmanned ground vehicle environmental perception.

Key words:lidar;camera;ESR;environment perception;unmanned ground vehicle

自主行驶机器人包含无人地面行驶车辆、无人

航空飞行器和无人水面/水下舰船,它们都具备自主

对所行驶/飞行/航行的环境进行感知和判断的能

力,从而指导机器人行进并到达指定位置。

无人地面行驶车辆也称作无人驾驶汽车(简称

无人车),由于近年来新型传感器的研制和机器学习

技术基础研究的飞速发展[1],使得民用无人驾驶汽

车的研制在技术上成为可能。国内外的科研机构和

企业纷纷投入智能汽车或无人驾驶汽车的研发行

列,其中一些机构称将在未来五年内实现无人车的

商业化推广[2]。

无人车的技术结构主要分为环境感知、导航定

位、路径规划和运动控制四个方面[3]。本文将详细

对环境感知中的常用技术手段和关键技术进行讲解

与分析,并阐述所涉及使用到的各种传感器。

1 无人车获取环境信息的传感器

无人车在行驶过程中需要对环境信息进行实时

获取并处理。从目前的大多数技术方案来看,激光

雷达对周围环境的三维空间感知完成了 60%~75%

的环境信息获取,其次是相机获取的图像信息,再次

是毫米波雷达获取的定向目标距离信息,以及 GPS

定位及惯性导航获取的无人车位置及自身姿态信

息,最后是其他超声波传感器、红外线传感器等其他

光电传感器获取的各种信息[4]。

收稿日期:2016-09-16

基金项目:吉林省自然科学基金项目 (20150101047JC);长春理工大学青年科学基金 (XQNJJ-2014-05)

作者简介:王世峰 (1978-),男,博士,副教授,E-mail:SF.Wang@cust.edu.cn

�

2

1.1 激光雷达

长春理工大学学报 (自然科学版)

2017

年

(2)

D = Dret + Dcorr

= D cos θ - V0 sin θ

Dxy

Px = Dxy

sin β - H0 cos β

= Dxy

P

cos β + H0 sin β

Pz = D sin θ + V0 cos θ

y

激光雷达可获取环境空间的三维尺寸信息。激

光雷达使用远距测距技术,通过向目标发射光线并

且分析反射光来完成距离的测量。有单线(亦称单

层、二维)和多线(亦称多层、三维)两种激光雷达,多

线雷达能够增加一定角度的俯仰,实现一定程度的

面扫描。一般在无人驾驶汽车上会结合两种激光雷

达来实现障碍物探测和指导汽车安全通过道路的功

能。

1.1.1 单线激光雷达

以德国 SICK 公司的 LMS511 单线激光雷达为

典型代表[5],它能够发出一条激光束扫描某一区域,

并根据区域内各点与扫描仪的相对位置返回由极坐

标表达的测量值即测量物体与扫描仪扫描中心之间

的距离和相对角度。它可以设置多种角度分辨率和

扫描频率组合。该雷达有多种数据传递方式,一般

选择网络接口传输的方式,由上位机向雷达发送请

求,雷达根据请求中的测量要求收集数据并返回给

上位机。

(1)

式中,ρ 为距离值,θ 为相对角度值。为了提高数据

返回速度,常用网络接口传输方式连接上位机。

SICK LMS511 可以根据需要设置不同角度分辨率

和扫描频率组合,其参数如表 1 所示。在无人驾驶

技术中常使用多个单线激光雷达来协助实现地形重

建。

{x = ρ cos θ

y = ρ sin θ

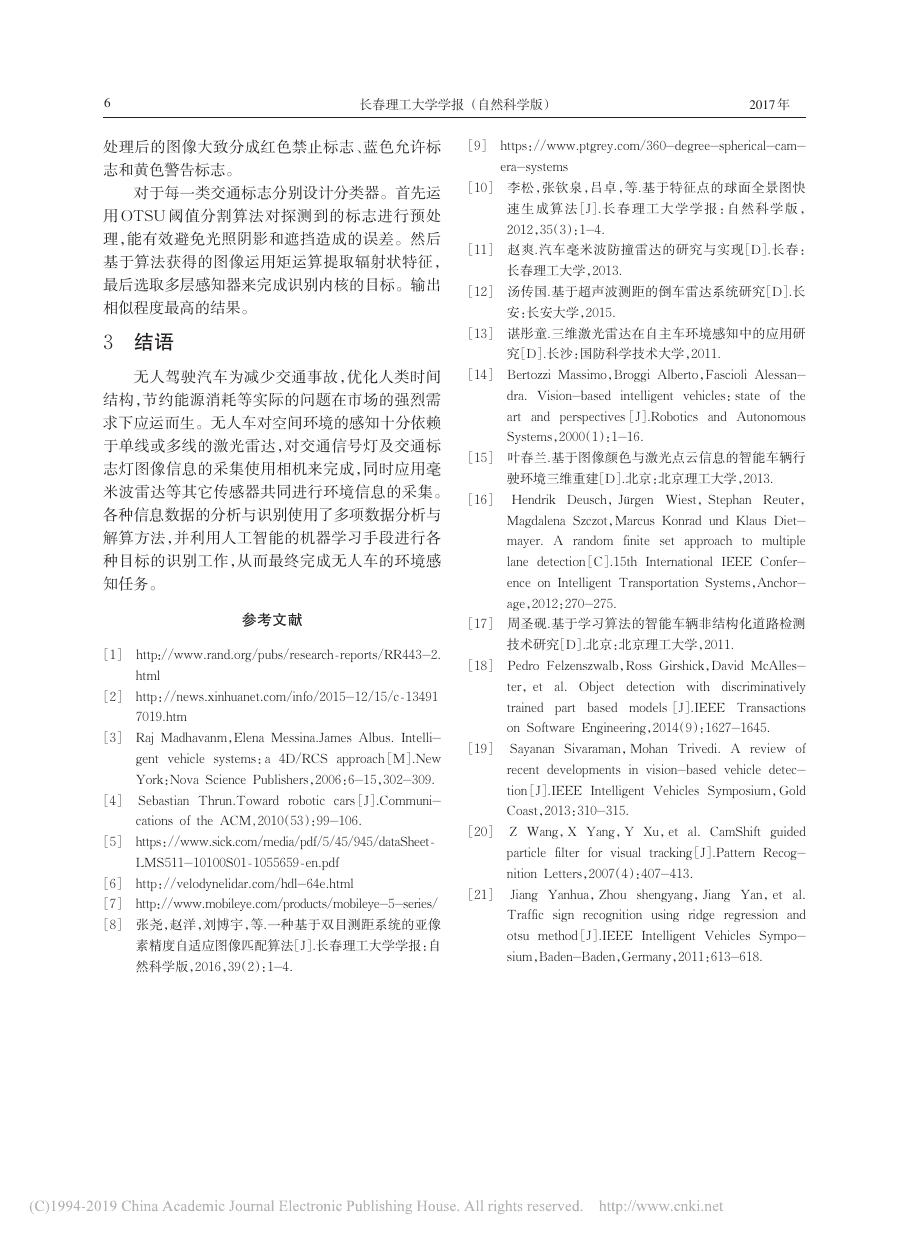

表 1 SICK LMS511 参数指标

扫描视角

角度分辨率

最大扫描距离

每帧扫描点数

扫描频率

0.25°

-5~185°

80m

1.1.2 多激光雷达传感器

761

25Hz

多线激光雷达是指发射 2 条或以上的激光束作

为探测光的激光雷达,目前以美国 Velodyne 公司的

HDL-64E S2 激光雷达为典型代表[6],它发出多达

64 个激光束,全部安装在旋转电机上,其水平探测

范围 360°垂直方向探测范围 26.8°。上位机通过串

口连接对其发送控制命令,通过基于 UDP 协议网络

连接返回数据。因为雷达 64 对激光发射器与接收

器分为上下两层,传输数据也分为两部分。处理收

集到的数据建立几何模型,首先,由于激光器安放位

置不同,而坐标原点应在同一垂直平面因此每一个

激光器都有一组校准数据来协助建模。

式中,Dcorr 为距离校正因子、V0 为垂直偏移量、H0

为水平偏移量、θ 为垂直校正角、α 为旋转校正角。

通过每一条激光束返回的距离 Dret 值和当前激光雷

达的旋转角度 γ 转化为激光雷达坐标系中的笛卡尔

坐标(Px ,P

,Pz)。

y

激光雷达因其测距精度高、实时性好、抗干扰能

力强等优点,在障碍检测、道边检测、动态障碍分类、

跟踪、移动机器人定位和导航中被广泛使用。

1.2 相机

图像传感器—相机能够获取环境彩色景象信

息,是无人车获取环境信息的第二大来源。相机可

选择的型号和种类非常多样,可简单分为单目相机、

双目立体相机和全景相机三种。

1.2.1 单目相机

无人车的环境成像是机器视觉在车辆上的应

用,需要满足车辆行驶环境及自身行驶状况的要

求。天气变化、车辆运动速度、车辆运动轨迹、随机

扰动、相机安装位置等都会影响车载视觉。无人车

任务中对图像质量要求高,不仅在图像输出速度上

需要较高帧频,且在图像质量上也具有较高要求。

单目相机是只使用一套光学系统及固体成像器

件的连续输出图像的相机。通常对无人车任务的单

目相机要求能够对其实现实时调节光积分时间、自

动白平衡,甚至能够完成开窗口输出图像功能。另

外,对相机光学系统的视场大小、景深尺度、像差抑

制都有一定要求。

值得一提的是以色列Mobileye 公司的单目智能

相机产品[7],它将图像处理及运算部件也集成在同

一相机产品之内,完成诸如前向碰撞、行人探测、车

道线偏离等检测功能,其性能在同类产品中具有一

定优势。

1.2.2 双目相机

双目相机能够对视场范围内目标进行立体成

像,其设计是建立在对人类视觉系统研究的基础上,

通过双目立体图像处理,而获取场景的三维信息[8]。

其结果表现为深度图,再经过一步处理就可以得到

三维空间中的景物,实现二维图像到三维图像的重

构。但是在无人车任务应用中,双目相机的两套成

�

1

期

第

王世峰,等:无人驾驶汽车环境感知技术综述

3

像系统未必能够完美对目标进行成像和特征提取,

也就是说,所需目标三维信息往往不能十分可靠地

获取。

1.2.3 全景相机

以加拿大 Point Grey 公司的 Lady bug 相机为

代表的多相机拼接成像的全景相机被用于地图街景

成像的图像传感器[9],它是由完全相同6 个相机对上

方和360 度全周进行同时成像,然后再进行6 幅图像

矫正和拼接,以获得同时成像的全景图像。使用该

全景相机的无人车可以同时获得车辆周围环境的全

景图像,并进行处理和目标识别。

另外,使用鱼眼镜头的单目相机也能呈现全景

图像[10],虽然原始图像的畸变较大,但其计算任务量

相对多相机拼接方式较小,且价格低廉,也开始受到

无人车领域的重视。

1.3 毫米波雷达传感器

毫米波雷达传感器是工作频率选在30~300GHz

频域(波长为 1~10mm,即毫米波段)的雷达[11]。其

优势在于波束窄,角分辨率高,频带宽,隐蔽性好,抗

干扰能力强,体积小,重量轻,可测距离远。虽然没

有激光雷达的探测范围大,但其较好的指向性和穿

透力仍然使其无法被激光雷达替代。根据测量原理

不同,毫米波雷达传感器可分为脉冲方式和调频连

续波方式两种。

1.3.1 脉冲方式的毫米波雷达传感器

采用脉冲方式的毫米波雷达需要在短时间内发

射大功率脉冲信号,通过脉冲信号控制雷达的压控

振荡器从低频瞬时跳变到高频;同时对回波信号进

行放大处理之前需将其与发射信号进行严格隔离。

1.3.2 调频连续波方式的毫米波雷达

调频连续波测距方式的雷达结构简单、体积小,

最大的优势是可以同时得到目标的相对距离和相对

速度。当它发射的连续调频信号遇到前方目标时,

会产生与发射信号有一定延时的回波,再通过雷达

的混频器进行混频处理,而混频后的结果与目标的

相对距离和相对速度有关。

1.3.3 ESR 毫米波雷达

ESR(Electronically Scanning Rader)高频电子

扫描毫米波雷达,在其视域内可同时检测 64 个目

标。该雷达的发射波段为 76~77GHz,同时具有中

距离和远距离的扫描能力。因为其硬件体积小且不

易受恶劣天气影响等优点,仍然被应用于无人车领

域,且在商用上被广泛应用在汽车的自适应巡航系

统、汽车防撞系统等产品中。

1.4 超声波传感器

超声波传感器是利用超声波的特性研制而成的

传感器。超声波传感器的数据处理简单快速,检测

距离较短,主要用于近距离障碍物检测。超声波在

空气中传播时能量会有较大的衰减,难以得到准确

的距离信息,一般不单独用于环境感知,或者仅仅用

于对感知精度要求不高的场合,如倒车雷达的探测

任务中[12]。

2 无人驾驶汽车环境感知关键技术

无人车使用了多种传感器进行环境感知,将这

些传感器安装于车辆固定位置后,需要对这些传感

器进行标定。在无人车行驶过程中,对环境感知的

要求是极其多样和复杂的,作为一个地面自主行驶

机器人,其应该具备提取路面信息、检测障碍物、计

算障碍物相对于车辆的位置和速度等能力。也就是

无人车对道路环境的感知通常至少包含结构化道

路、非结构化道路检测,行驶环境中行人和车辆检

测,交通信号灯和交通标志的检测等能力。

2.1 传感器标定

通过传感器标定来确定传感器输入与输出之间

的关系,从而完成基础性的环境识别。

2.1.1 激光雷达标定

激光雷达与车体为刚性连接,两者间的相对姿

态和位移固定不变,为了处理数据的方便性,需要把

各个激光雷达的坐标系转化到统一的车体坐标系

上[13]。首先进行对激光雷达外部安装参数的标定,

然后通过雷达返回的极坐标数据实现单个激光雷达

的数据转换,最后实现多个激光雷达数据转换。通

过(3)实现基准坐标中的转化。

1

-di cos(b0 + iA)

é

ù

ù

é

ê

ú

ú

ê

0 cos(-β0) -sin(-β0)

ê

ú

di sin(b0 + iA)

ú

ê

úú

êê

sin(-β0)

0

cos(-β0)

0

ë

û

ë

û

-di cos(b0 + iA)

é

ù

ú

ê

ú

ê

di sin(b0 + iA)cos β0

úú

êê

-di sin(b0 + iA)sin β0

ë

û

x

é

ù

ê

ú

y

ú

ê

z

ë

û

(3)

=

=

0

0

式中,β0 为基准坐标系旋转的角度,di 为扫描距

离,i 为激光雷达数据序列号,A 是设计采样步距。

通过式(4)实现车辆坐标系建立。

x

é

ù

V

ê

ú

yVz

ê

ú

ë

û

b0 + iA cos γ + di sin(

b0 + iA cos β0 + L

b0 + iA sin γ - di sin(

-di cos(

é

ê

di sin(

êê

ê

-di cos(

ë

b0 + iA sin β0 sin γ

ù

ú

úú

ú

b0 + iA sin β0 cos γ + HL - HV

û

(4)

=

)

)

)

V

)

)

�

4

长春理工大学学报 (自然科学版)

2017

年

式中,L 为激光雷达安装点到车辆质心的距离沿 y

轴的分量,HL 为激光雷达安装点离地的高度,HV

为汽车质心离地的高度。

2.1.2 相机的标定

相机与车体也为刚性连接,两者相对姿态和位

置固定不变,相机的标定是为了找到相机所生成的

图像像素坐标系中的点坐标与相机环境坐标系中的

物点坐标之间的转换关系。从而实现把相机采集到

的环境数据与车辆行驶环境中的真实物体对应。

单目相机的标定主要包括对相机模型的建立和

对物点坐标的转换[14]。通过下式可以得到相机环境

坐标系中的物点 P(x

vc) 到图像像素坐标系

中的像点 Pi(u,v) 的转化关系。

yc,yvc,z

z

c

u

é

ù

úú

êê

v

1

ë

û

=

f

é

ê

dx

ê

ê

êêê

0

ê

ê

0 0 1

ë

ù

0 u0

ú

ú

ú

f

úúú

v0

d

ú

ú

û

y

R*

c

x

é

ù

vc

ê

ú

yvcz

ê

ú

ë

û

vc

æ

ç

ç

çç

è

+ T *

c

ö

÷

÷

÷÷

ø

(5)

y

式中,f 为透镜的焦距,dx 与 d

分别为相机传感器

x 与 y 方向的像素单元距离由厂家提供,R*

c 为 3*3

c 为 1*3 的坐标平移矩阵,u0 与

的坐标旋转矩阵,T *

v0 为图像像素中心坐标,z

c 为相机坐标系下 P 点的

z

c 轴上的值。(5)忽略实际情况中畸变的误差。双目

立体相机标定主要包括双目立体视觉模型建立、双

目图像去畸变处理、双目图像校正、双目图像裁切等

四个步骤。

2.1.3 相机和激光雷达联合标定

相机的每一个像素点和激光雷达的每一个数据

点都对应着三维空间中唯一的一个点,因此能实现

激光雷达与相机的空间对准[15]。其中有空间上和时

间上两部分数据的融合。空间上数据的融合通过下

式实现:

c = K -1

c U

R*

c ⋅ Xlv + T *

c 为坐标旋转矩阵,T *

(6)

c 为坐标平移矩阵,Xlv

式中,R*

由激光雷达的外参标定,而 K -1

c 为相机内参标定矩

阵,U 是可见光图像中投影点的坐标。确定式(6)

需要 12 个参数,所以要求多次改变标定箱的远近和

方位,使其位置尽可能均匀分布在图像分辨率的各

个位置。时间上的数据融合是为了解决传感器在采

集数据时间差异问题的方法。通过 GPS 获得绝对

时间,给不同的传感器所记录数据进行时间戳标定。

2.2 结构化道路检测

线和道路边界的标准化道路的信息来准确获得本车

相对于车道的位置和方向[16]。

2.2.1 结构化道路的常用假设

由于各地的路况都有一定的区别,所以只能提

供一个简化的道路场景。因此建立了道路形状假

设、道路宽度和道路平坦假设、道路特征一致假设、

感兴趣区域假设等,有助于识别结构化的道路。

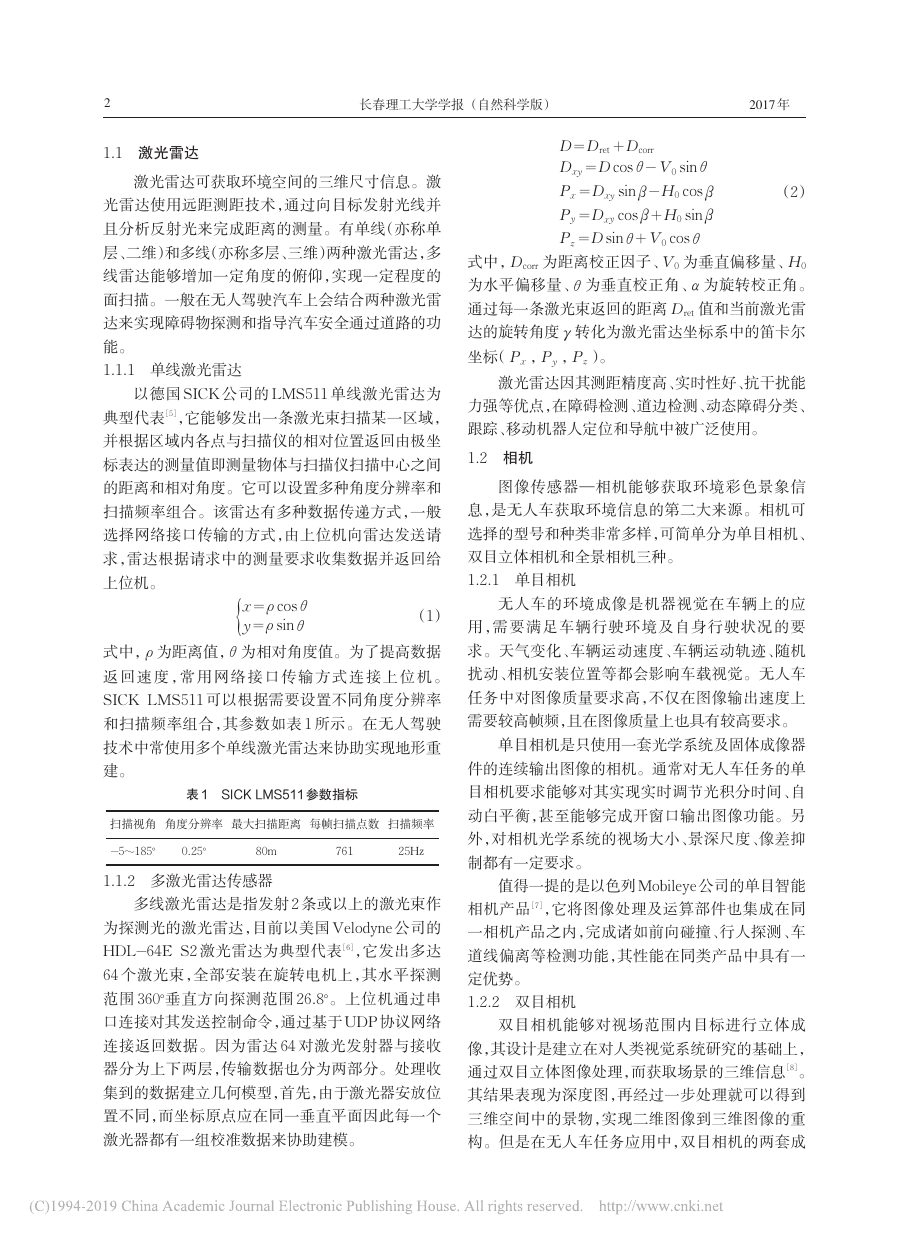

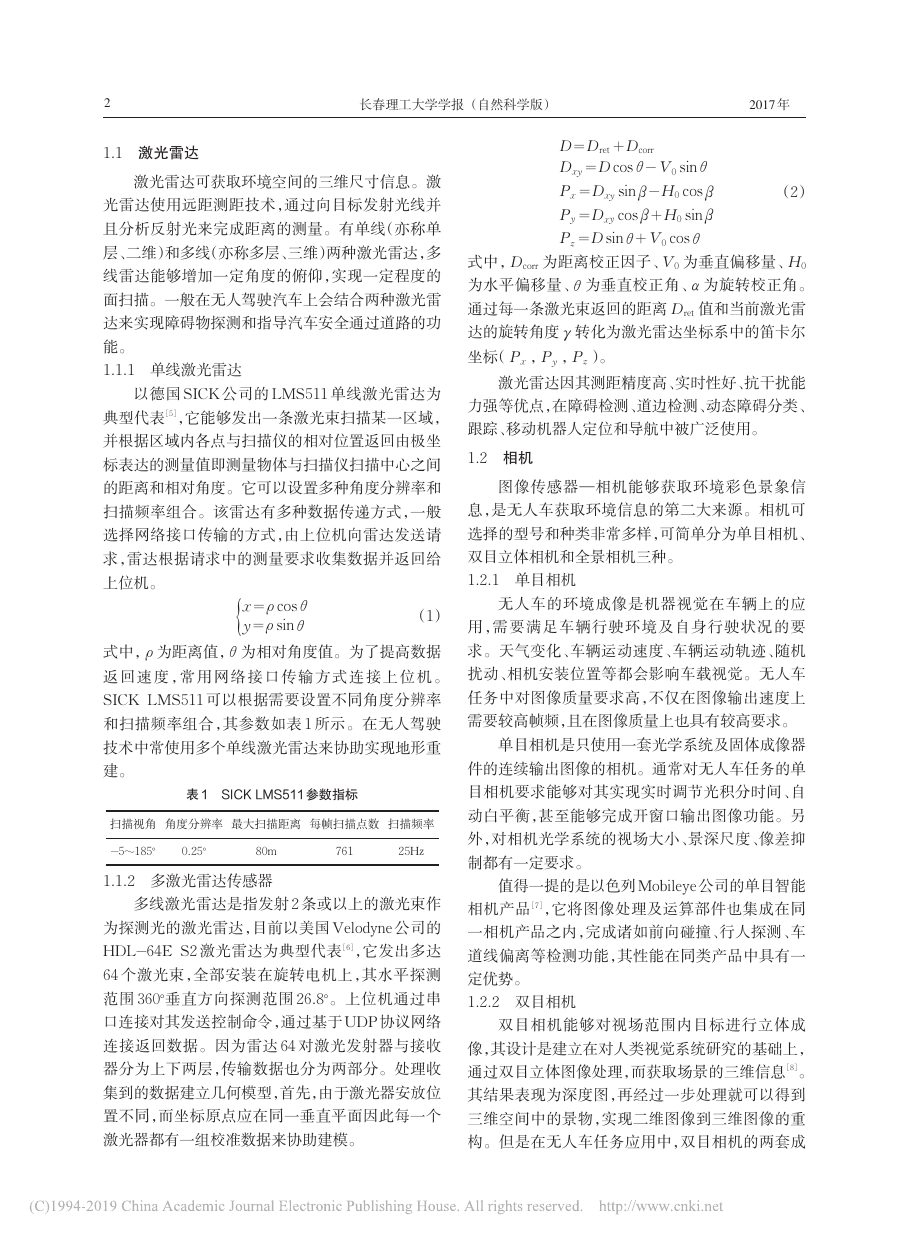

2.2.2 直道检测

在官方制定的行业标准下,结构化道路的设计

和建设都比较规则,有明显的区分道路和非道路的

车道线。在视觉导航系统中,利用距相机不远处的

车道线方向变化不大,即曲率变化很小的假设,近似

用直线来拟合车道线。

通过车道线边缘点搜索和车道线边缘曲线拟合

实现直道拟合。其算法流程如图1 所示。

图 1 算法流程

2.2.3 弯道检测

弯道是公路中必不可少的道路形式,因此需要

从道路图像中检测出弯曲车道线的边界,判断道路

弯曲的方向,确定弯道的曲率半径才能为无人车提

供有效的信息。一般公路平面的线形主要分为直

线、圆曲线与回旋线,因此选择俯视图进行拟合。国

内外的弯道检测办法主要是基于道路模型的检测办

法。一般分为三个步骤:建立弯道模型,完成对道路

形状的假设;提取车道线像素点,把每一条车道线的

像素点从前景像素点中提取出来作为依据;拟合车

道模型,运用检测到的像素点确定弯道数学模型的

最优参数。

2.2.4 复杂环境下检测图像预处理

结构化道路检测是通过了解具有清晰车道标志

实际情况下往往会出现复杂的情况,由于外界

�

1

期

第

王世峰,等:无人驾驶汽车环境感知技术综述

5

环境光线的变化不均匀导致相机提取的图像出现多

块纯白色和纯黑色区域,让图像识别算法失去目

标。常用图像预处理来解决这个问题。其中有:

Gamma 调节、灰度映射调节、直方图调节等方法。

由于无人车在车载视觉中的导航图像对图像灰

度信息、图像真实性、图像实时性要求较高,所以图

像预处理方法必须要满足快速、简单、合成图像平滑

自然和产生合成痕迹少等要求。可采用设置长短快

门进行多重曝光,用双目相机中不同相机交替曝光

等方法。

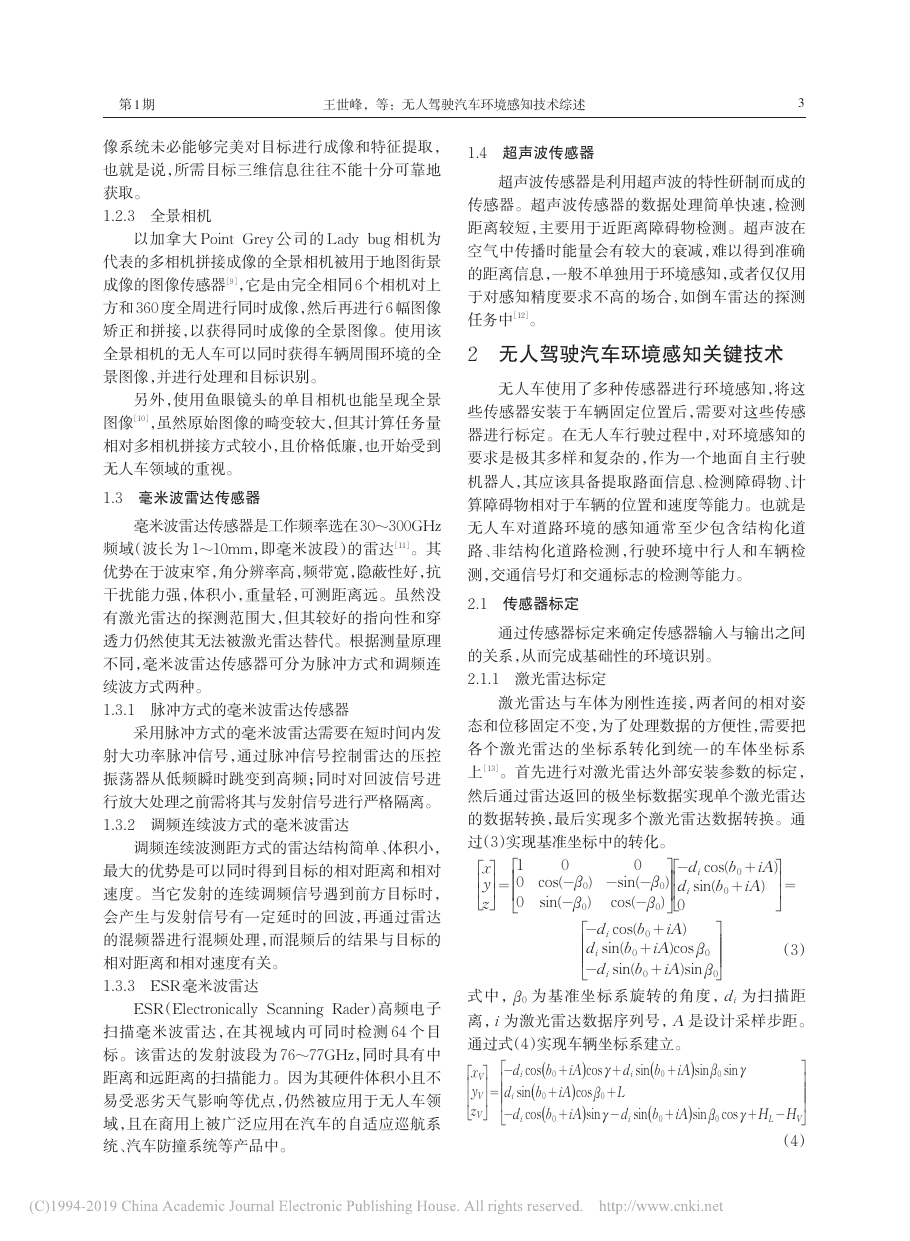

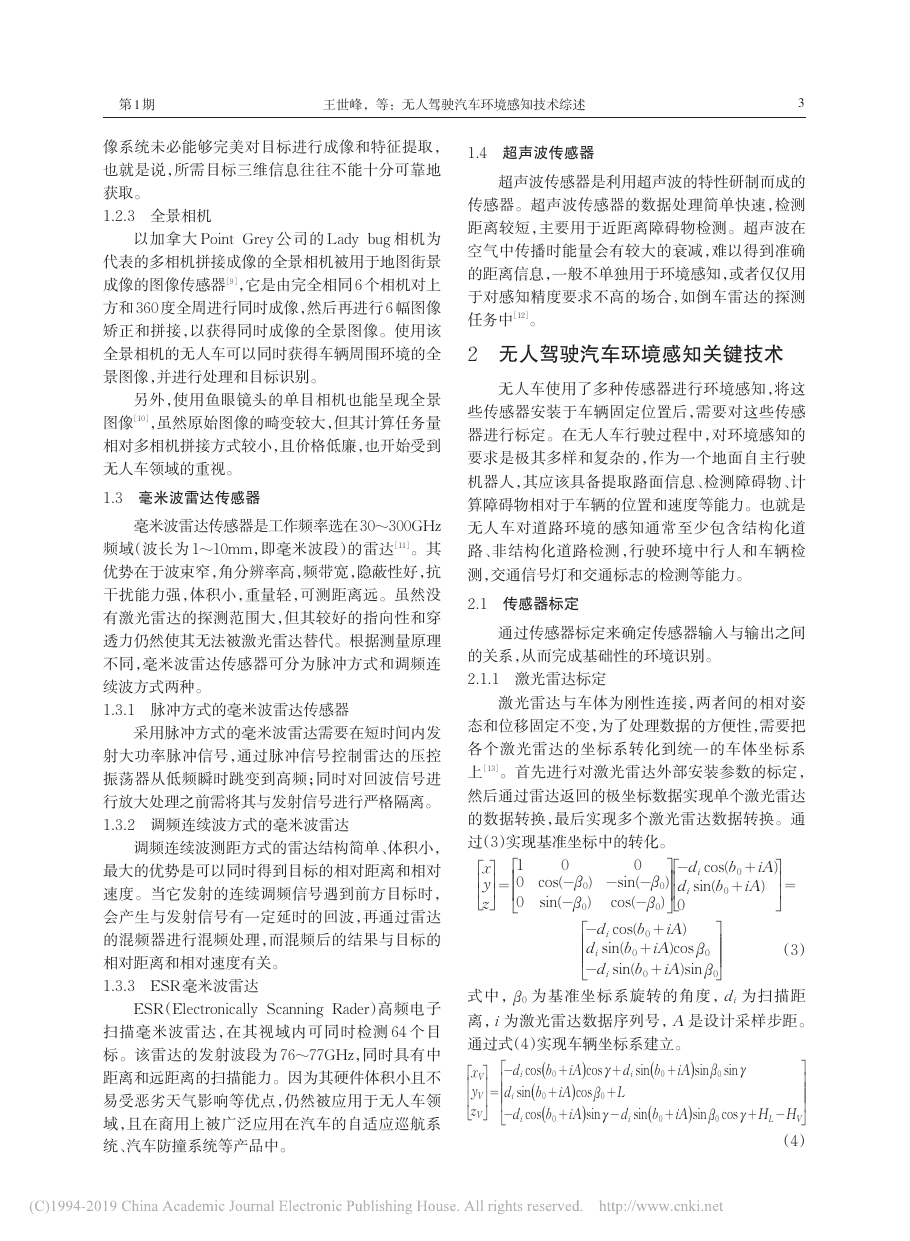

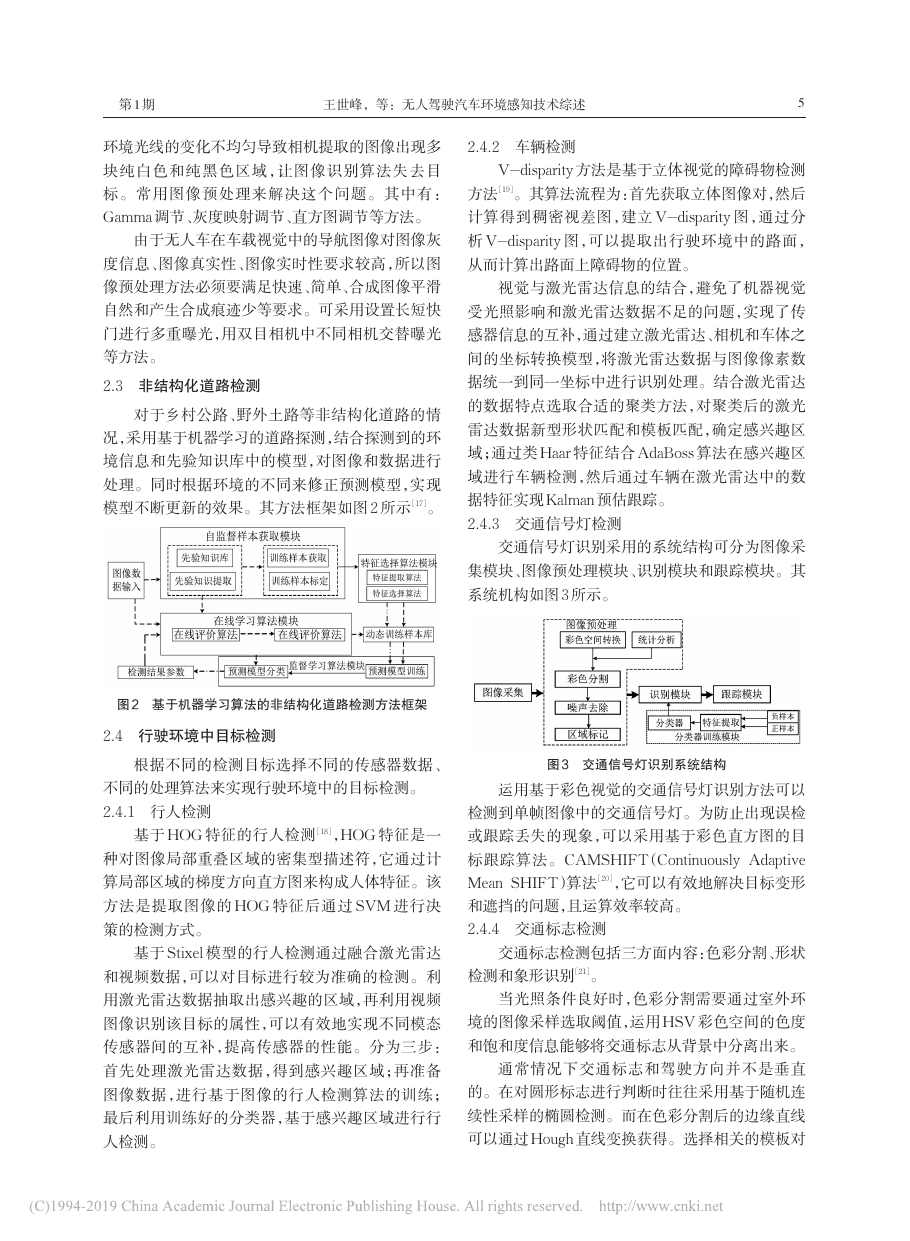

2.3 非结构化道路检测

对于乡村公路、野外土路等非结构化道路的情

况,采用基于机器学习的道路探测,结合探测到的环

境信息和先验知识库中的模型,对图像和数据进行

处理。同时根据环境的不同来修正预测模型,实现

模型不断更新的效果。其方法框架如图 2 所示[17]。

2.4.2 车辆检测

V-disparity 方法是基于立体视觉的障碍物检测

方法[19]。其算法流程为:首先获取立体图像对,然后

计算得到稠密视差图,建立 V-disparity 图,通过分

析 V-disparity 图,可以提取出行驶环境中的路面,

从而计算出路面上障碍物的位置。

视觉与激光雷达信息的结合,避免了机器视觉

受光照影响和激光雷达数据不足的问题,实现了传

感器信息的互补,通过建立激光雷达、相机和车体之

间的坐标转换模型,将激光雷达数据与图像像素数

据统一到同一坐标中进行识别处理。结合激光雷达

的数据特点选取合适的聚类方法,对聚类后的激光

雷达数据新型形状匹配和模板匹配,确定感兴趣区

域;通过类 Haar 特征结合 AdaBoss 算法在感兴趣区

域进行车辆检测,然后通过车辆在激光雷达中的数

据特征实现Kalman 预估跟踪。

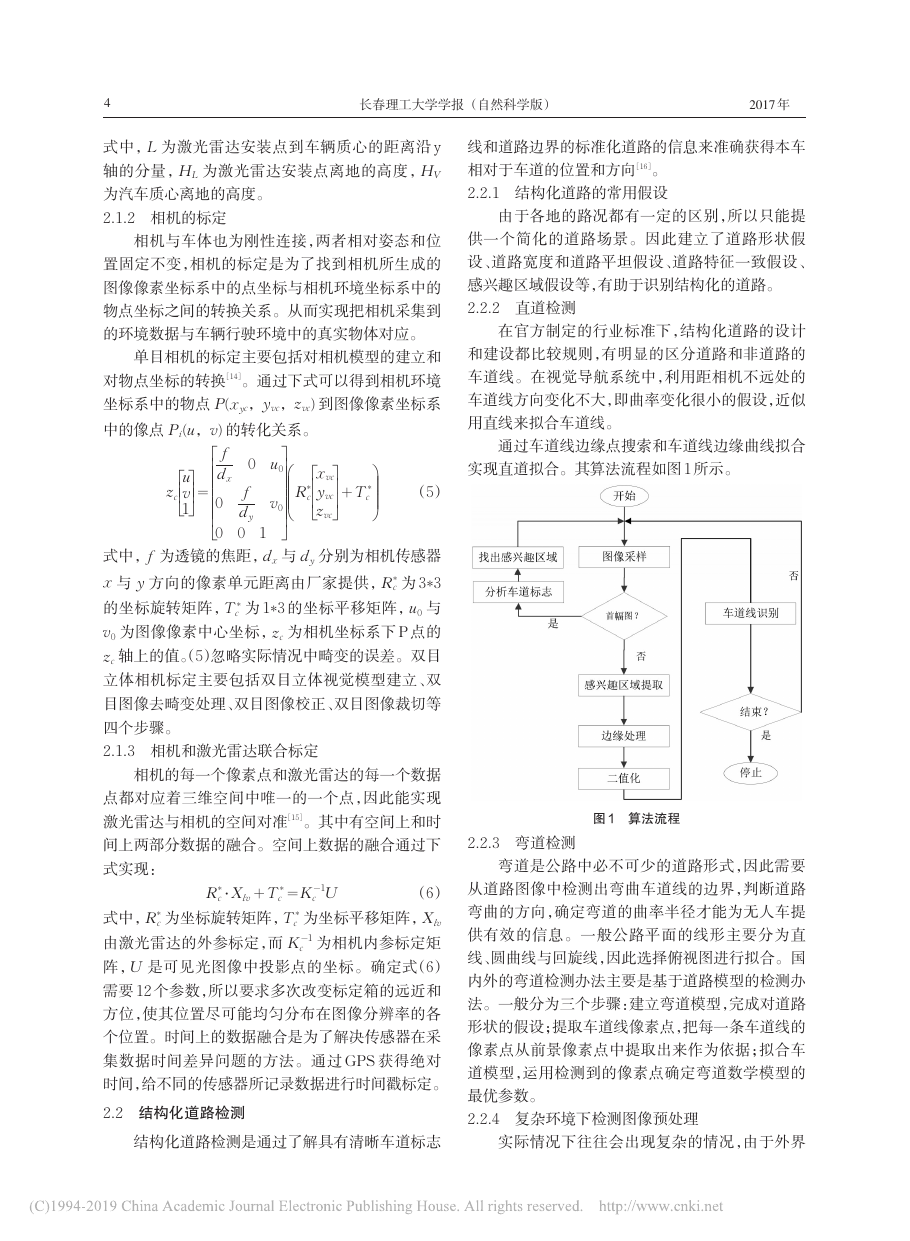

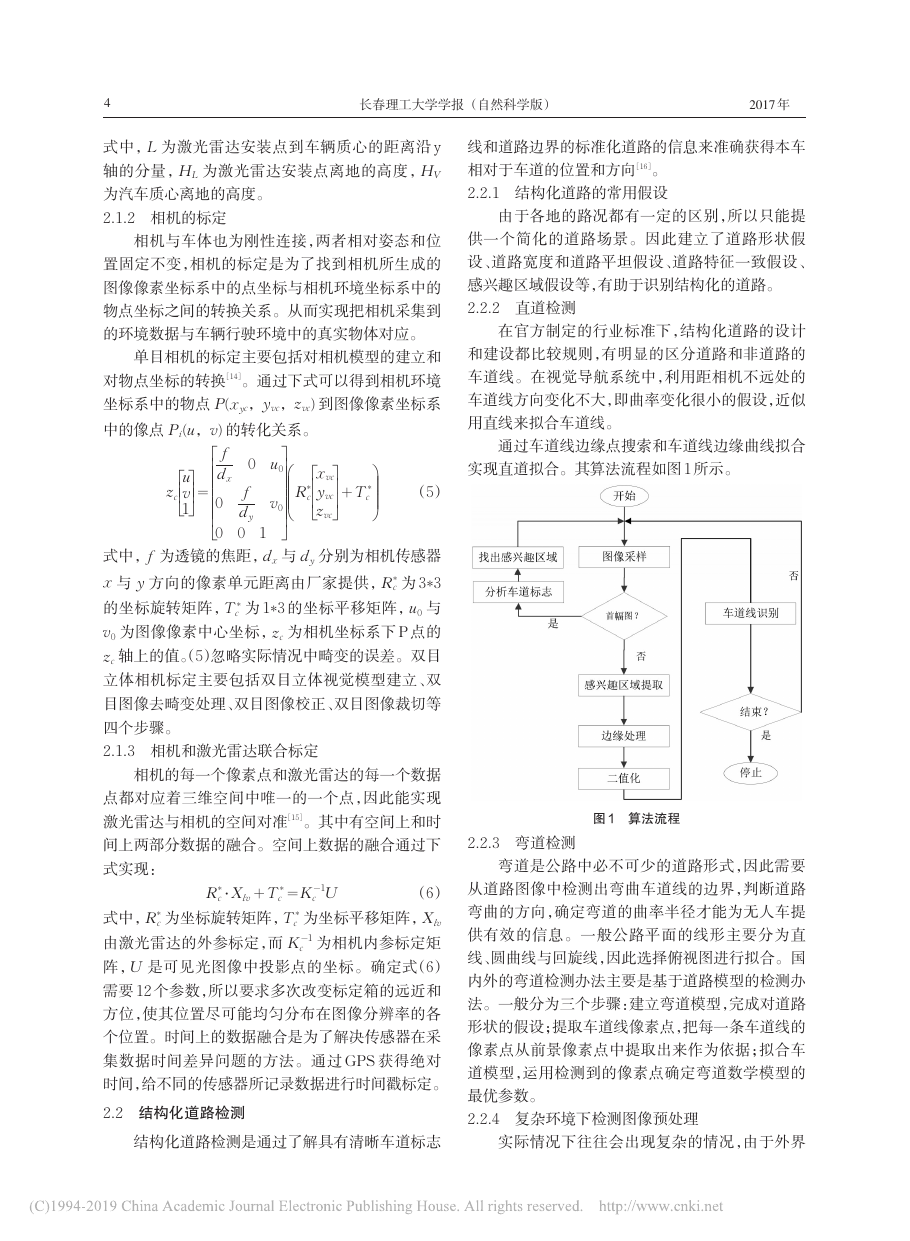

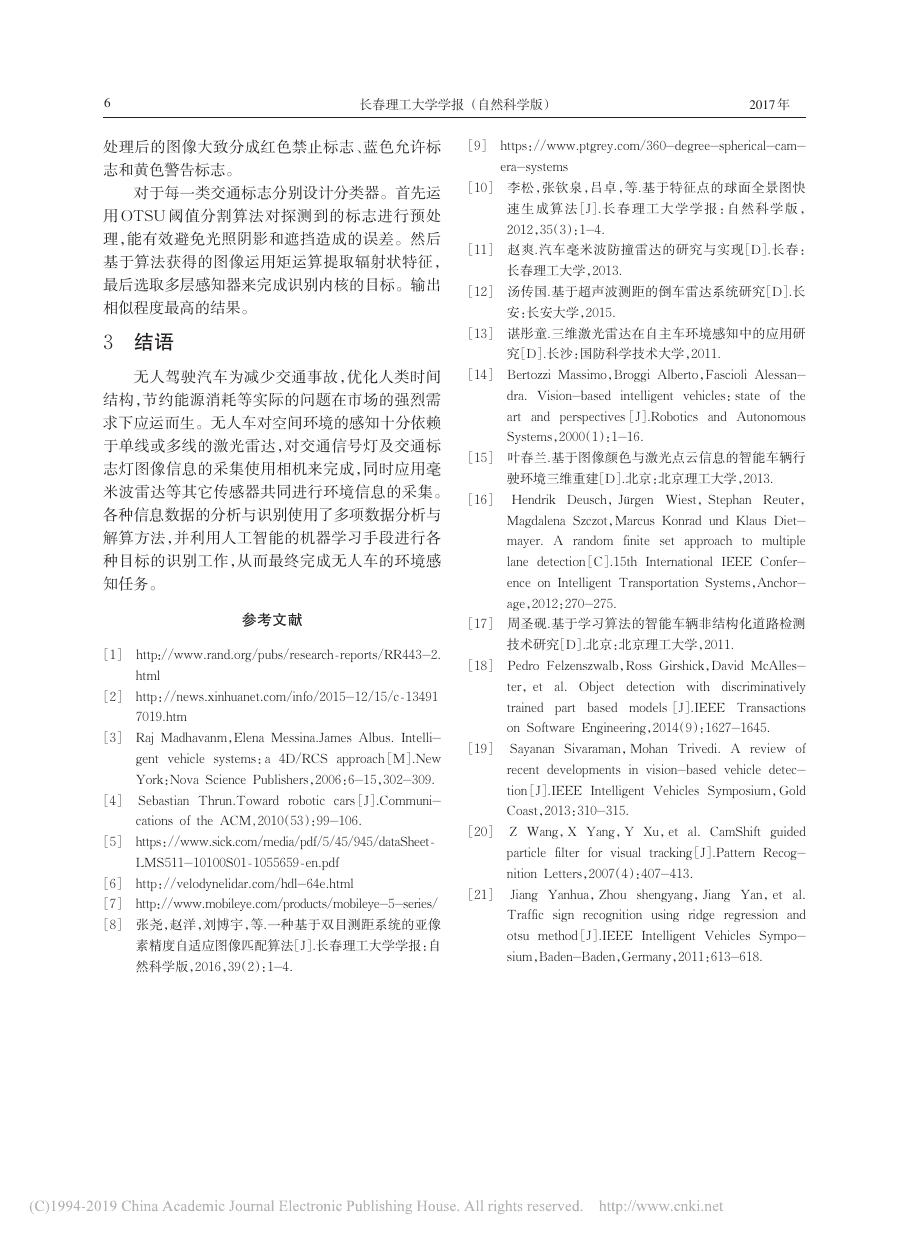

2.4.3 交通信号灯检测

交通信号灯识别采用的系统结构可分为图像采

集模块、图像预处理模块、识别模块和跟踪模块。其

系统机构如图3 所示。

图 2 基于机器学习算法的非结构化道路检测方法框架

2.4 行驶环境中目标检测

根据不同的检测目标选择不同的传感器数据、

图 3 交通信号灯识别系统结构

不同的处理算法来实现行驶环境中的目标检测。

2.4.1 行人检测

基于 HOG 特征的行人检测[18],HOG 特征是一

种对图像局部重叠区域的密集型描述符,它通过计

算局部区域的梯度方向直方图来构成人体特征。该

方法是提取图像的 HOG 特征后通过 SVM 进行决

策的检测方式。

基于 Stixel 模型的行人检测通过融合激光雷达

和视频数据,可以对目标进行较为准确的检测。利

用激光雷达数据抽取出感兴趣的区域,再利用视频

图像识别该目标的属性,可以有效地实现不同模态

传感器间的互补,提高传感器的性能。分为三步:

首先处理激光雷达数据,得到感兴趣区域;再准备

图像数据,进行基于图像的行人检测算法的训练;

最后利用训练好的分类器,基于感兴趣区域进行行

人检测。

运用基于彩色视觉的交通信号灯识别方法可以

检测到单帧图像中的交通信号灯。为防止出现误检

或跟踪丢失的现象,可以采用基于彩色直方图的目

标跟踪算法。CAMSHIFT(Continuously Adaptive

Mean SHIFT)算法[20],它可以有效地解决目标变形

和遮挡的问题,且运算效率较高。

2.4.4 交通标志检测

交通标志检测包括三方面内容:色彩分割、形状

检测和象形识别[21]。

当光照条件良好时,色彩分割需要通过室外环

境的图像采样选取阈值,运用 HSV 彩色空间的色度

和饱和度信息能够将交通标志从背景中分离出来。

通常情况下交通标志和驾驶方向并不是垂直

的。在对圆形标志进行判断时往往采用基于随机连

续性采样的椭圆检测。而在色彩分割后的边缘直线

可以通过Hough 直线变换获得。选择相关的模板对

�

6

长春理工大学学报 (自然科学版)

2017

年

处理后的图像大致分成红色禁止标志、蓝色允许标

志和黄色警告标志。

对于每一类交通标志分别设计分类器。首先运

用 OTSU 阈值分割算法对探测到的标志进行预处

理,能有效避免光照阴影和遮挡造成的误差。然后

基于算法获得的图像运用矩运算提取辐射状特征,

最后选取多层感知器来完成识别内核的目标。输出

相似程度最高的结果。

3 结语

无人驾驶汽车为减少交通事故,优化人类时间

结构,节约能源消耗等实际的问题在市场的强烈需

求下应运而生。无人车对空间环境的感知十分依赖

于单线或多线的激光雷达,对交通信号灯及交通标

志灯图像信息的采集使用相机来完成,同时应用毫

米波雷达等其它传感器共同进行环境信息的采集。

各种信息数据的分析与识别使用了多项数据分析与

解算方法,并利用人工智能的机器学习手段进行各

种目标的识别工作,从而最终完成无人车的环境感

知任务。

参考文献

[1] http://www.rand.org/pubs/research_reports/RR443-2.

html

[2] http://news.xinhuanet.com/info/2015-12/15/c_13491

7019.htm

[3] Raj Madhavanm,Elena Messina.James Albus. Intelli-

gent vehicle systems:a 4D/RCS approach[M].New

York:Nova Science Publishers,2006:6-15,302-309.

[4] Sebastian Thrun.Toward robotic cars[J].Communi-

cations of the ACM,2010(53):99-106.

[5] https://www.sick.com/media/pdf/5/45/945/dataSheet_

LMS511-10100S01_1055659_en.pdf

[6] http://velodynelidar.com/hdl-64e.html

[7] http://www.mobileye.com/products/mobileye-5-series/

[8] 张尧,赵洋,刘博宇,等.一种基于双目测距系统的亚像

素精度自适应图像匹配算法[J].长春理工大学学报:自

然科学版,2016,39(2):1-4.

[9] https://www.ptgrey.com/360-degree-spherical-cam-

era-systems

[10] 李松,张钦泉,吕卓,等.基于特征点的球面全景图快

速生成算法[J].长春理工大学学报:自然科学版,

2012,35(3):1-4.

[11] 赵爽.汽车毫米波防撞雷达的研究与实现[D].长春:

长春理工大学,2013.

[12] 汤传国.基于超声波测距的倒车雷达系统研究[D].长

安:长安大学,2015.

[13] 谌彤童.三维激光雷达在自主车环境感知中的应用研

究[D].长沙:国防科学技术大学,2011.

[14] Bertozzi Massimo,Broggi Alberto,Fascioli Alessan-

dra. Vision-based intelligent vehicles:state of

the

art and perspectives[J].Robotics and Autonomous

Systems,2000(1):1-16.

[15] 叶春兰.基于图像颜色与激光点云信息的智能车辆行

驶环境三维重建[D].北京:北京理工大学,2013.

ü

[16] Hendrik Deusch,J

rgen Wiest,Stephan Reuter,

Magdalena Szczot,Marcus Konrad und Klaus Diet-

mayer. A random finite set approach to multiple

lane detection[C].15th International IEEE Confer-

ence on Intelligent Transportation Systems,Anchor-

age,2012:270-275.

[17] 周圣砚.基于学习算法的智能车辆非结构化道路检测

技术研究[D].北京:北京理工大学,2011.

[18] Pedro Felzenszwalb,Ross Girshick,David McAlles-

ter,et al. Object detection with discriminatively

trained part based models[J].IEEE Transactions

on Software Engineering,2014(9):1627-1645.

[19] Sayanan Sivaraman,Mohan Trivedi. A review of

recent developments in vision-based vehicle detec-

tion[J].IEEE Intelligent Vehicles Symposium,Gold

Coast,2013:310-315.

[20] Z Wang,X Yang,Y Xu,et al. CamShift guided

particle filter for visual tracking[J].Pattern Recog-

nition Letters,2007(4):407-413.

[21] Jiang Yanhua,Zhou shengyang,Jiang Yan,et al.

Traffic sign recognition using ridge regression and

otsu method[J].IEEE Intelligent Vehicles Sympo-

sium,Baden-Baden,Germany,2011:613-618.

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc