LOGO

卷积神经网络与迁移学习

寒小阳

2016年9月25日

寒⼩小阳

�

LOGO

■ 卷积神经网络快速回顾

1.层级结构 2.数据处理 3.训练算法 4.优缺点

■ 典型CNN

1.AlexNet 2.GoogLeNet 3.VGG Net 4.ResNet

■ 物体定位

1.回归的思路

■ 物体检测

1.早期做法 2.RCNN/Fast-RCNN/Faster_RCNN 3.R-FCN

■ 文艺绘画与Neural Style

1.风格描述 2.主体对调与损失最小化

寒⼩小阳

�

LOGO

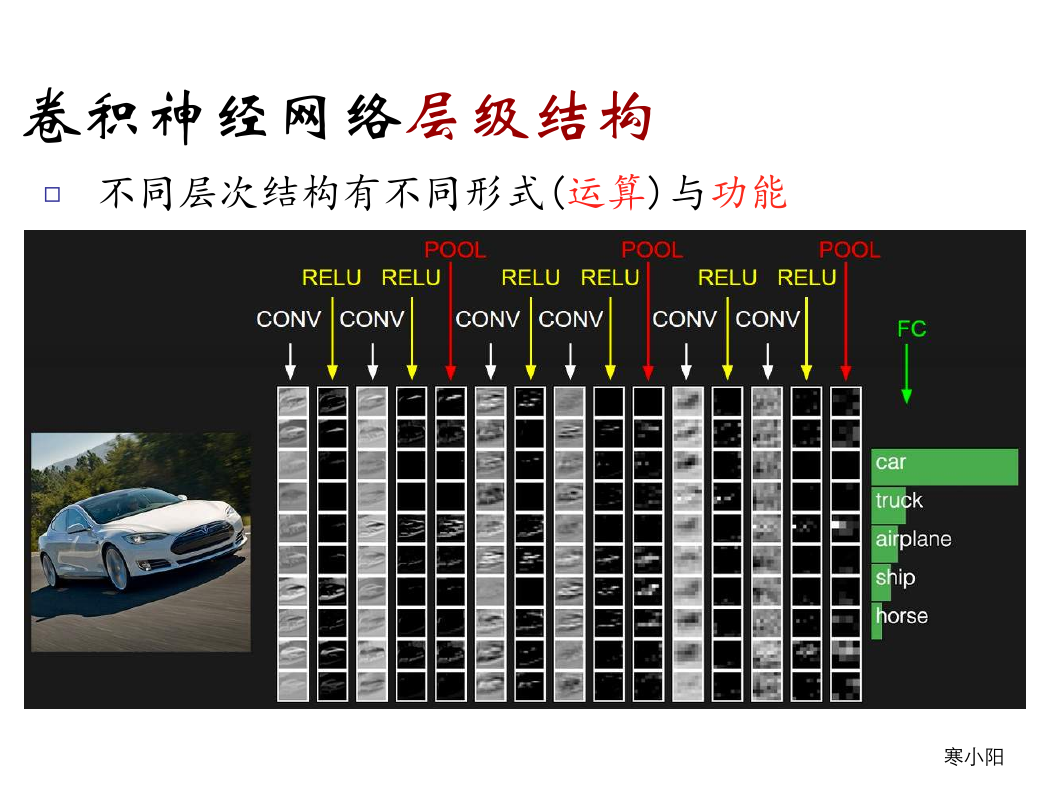

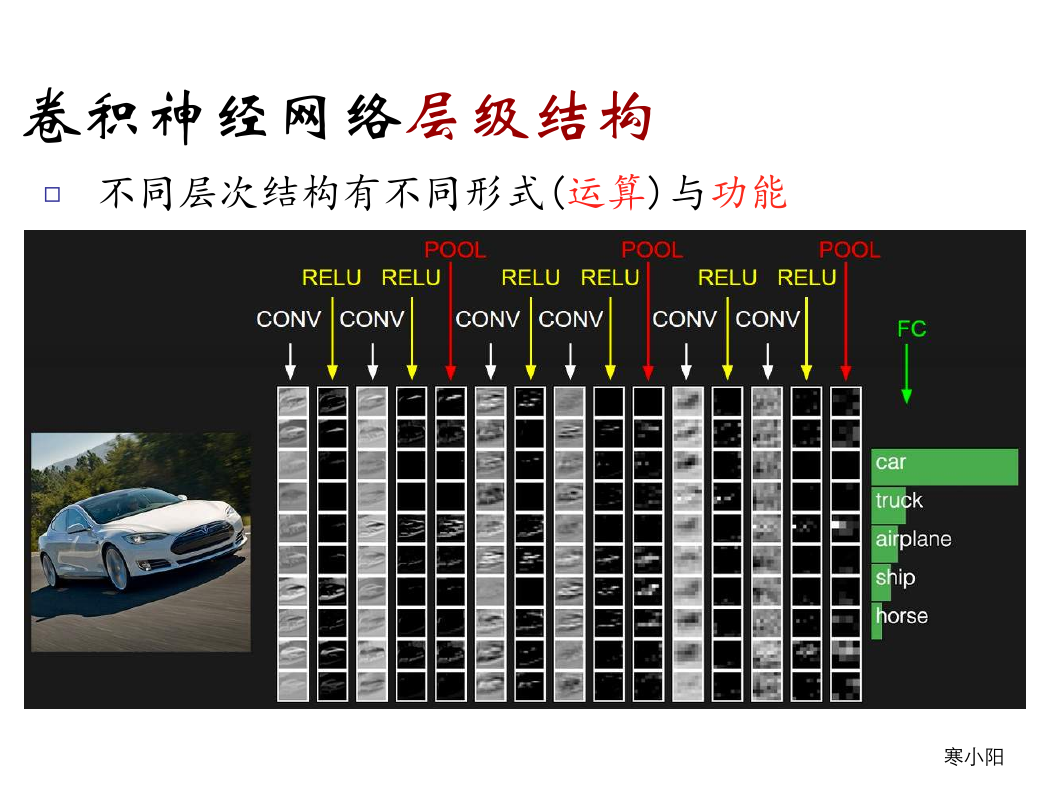

卷积神经网络层级结构

□ 不同层次结构有不同形式(运算)与功能

寒⼩小阳

�

LOGO

主要是以下层次

□ 数据输入层/ Input layer

□ 卷积计算层/ CONV layer

□ ReLU激励层 / ReLU layer

□ 池化层 / Pooling layer

□ 全连接层 / FC layer

□ Batch Normalization层(可能有)

寒⼩小阳

�

LOGO

□ 数据输入层/ Input layer

有3种常见的图像数据处理方式

□ 去均值

□ 归一化

□ PCA/白化

■ 把输入数据各个维度都中心化到0

■ 幅度归一化到同样的范围

■ 用PCA降维

■ 白化是对数据每个特征轴上的幅度归一化

寒⼩小阳

�

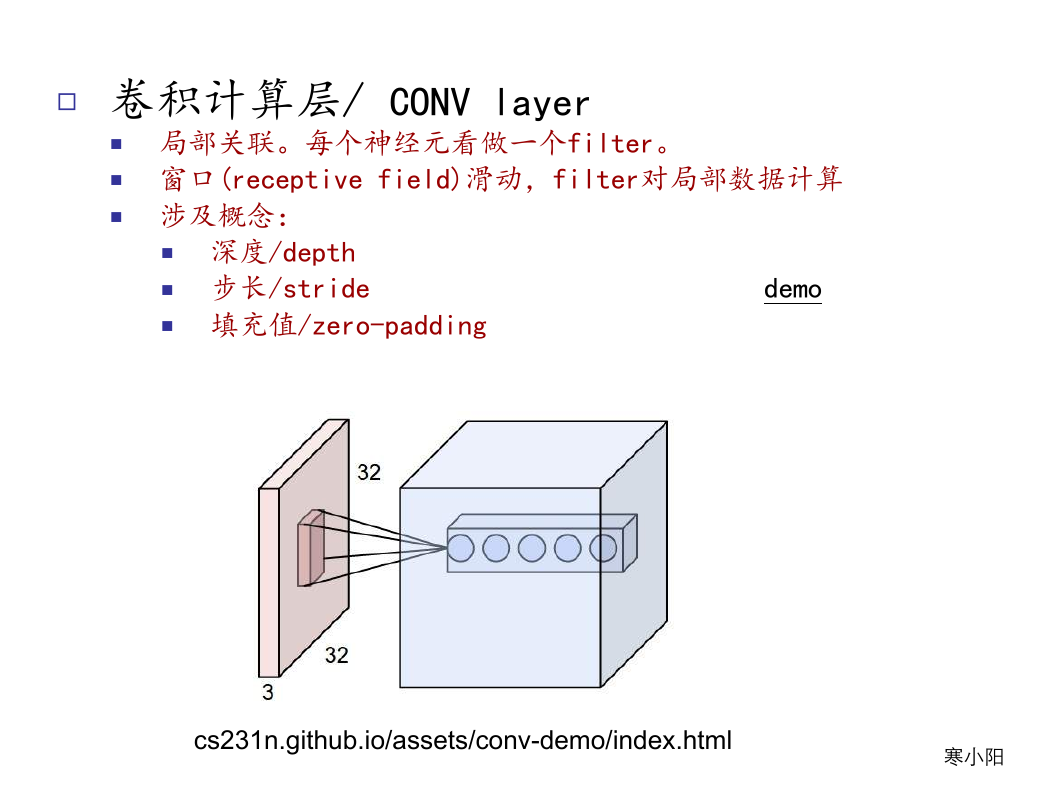

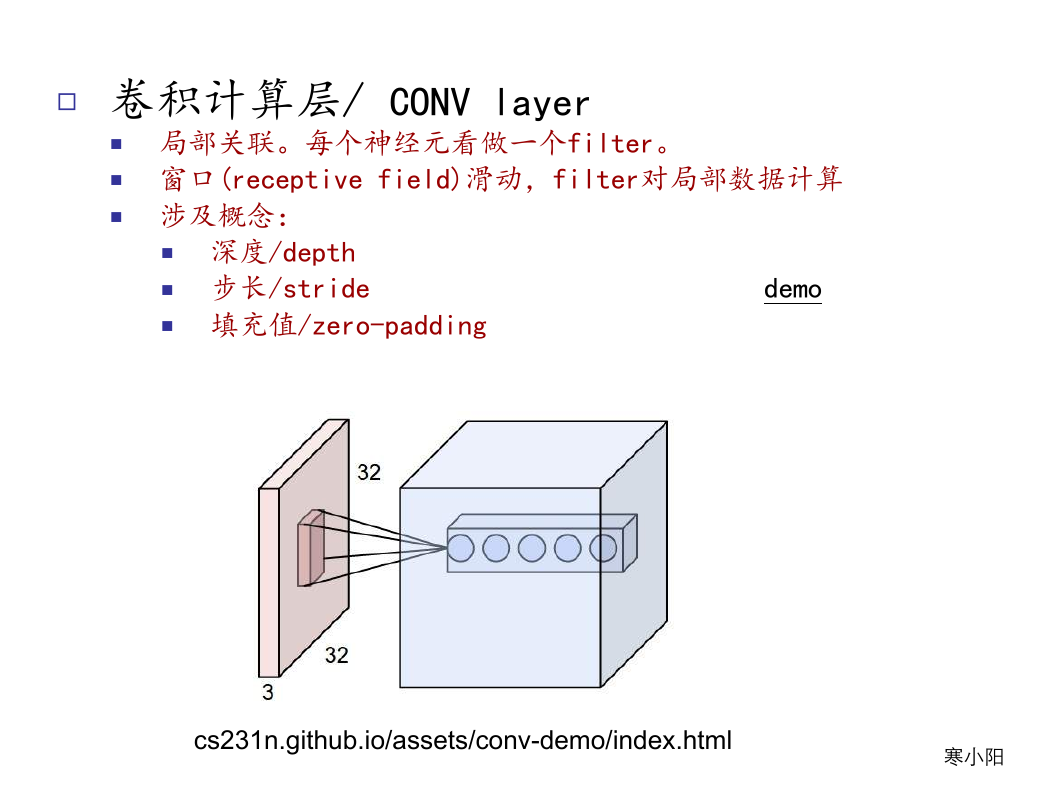

□ 卷积计算层/ CONV layer

LOGO

■ 局部关联。每个神经元看做一个filter。

■ 窗口(receptive field)滑动,filter对局部数据计算

■ 涉及概念:

■ 深度/depth

■ 步长/stride demo

■ 填充值/zero-padding

cs231n.github.io/assets/conv-demo/index.html

寒⼩小阳

�

LOGO

寒⼩小阳

�

□ 卷积计算层/ CONV layer

LOGO

■ 参数共享机制

■ 假设每个神经元连接数据窗的权重是固定的

■ 固定每个神经元连接权重,可以看做模板

■ 需要估算的权重个数减少: AlexNet 1亿 => 3.5w

■ 一组固定的权重和不同窗口内数据做内积: 卷积

每个神经元只关注一个特性

寒⼩小阳

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc