学习神经网络的好助手,可以仿照其中的代码,只需修改个别参数便可以轻易实现自己需要完成的任务。

p=p1';t=t1';

[pn,minp,maxp,tn,mint,maxt]=premnmx(p,t);

%原始数据归一化

net=newff(minmax(pn),[5,1],{'tansig','purelin'},'traingdx'); %设置网络,建立相应的 BP 网络

net.trainParam.show=2000; % 训练网络

net.trainParam.lr=0.01;

net.trainParam.epochs=100000;

net.trainParam.goal=1e-5;

[net,tr]=train(net ,pn,tn);

网络

pnew=pnew1';

pnewn=tramnmx(pnew,minp,maxp);

anewn=sim(net,pnewn);

anew=postmnmx(anewn,mint,maxt);

y=anew';

%对 BP 网络进行仿真

%还原数据

%调用 TRAINGDM 算法训练 BP

1、BP 网络构建

(1)生成 BP 网络

net

newff PR S S

,[ 1 2...

(

SNl TF TF

],{

1

2...

TFNl BTF BLF PF

},

,

,

)

PR :由 R 维的输入样本最小最大值构成的 2R 维矩阵。

[ 1 2...

S S

SNl :各层的神经元个数。

]

{

TF TF

1

2...

TFNl :各层的神经元传递函数。

}

BTF :训练用函数的名称。

(2)网络训练

,

[

,

,

net tr Y E Pf Af

,

,

]

train net P T Pi Ai VV TV

(

,

,

,

,

,

,

)

(3)网络仿真

[ ,

Y Pf Af E perf

,

,

,

]

,

sim net P Pi Ai T

(

,

,

,

)

{'tansig','purelin'},'trainrp'

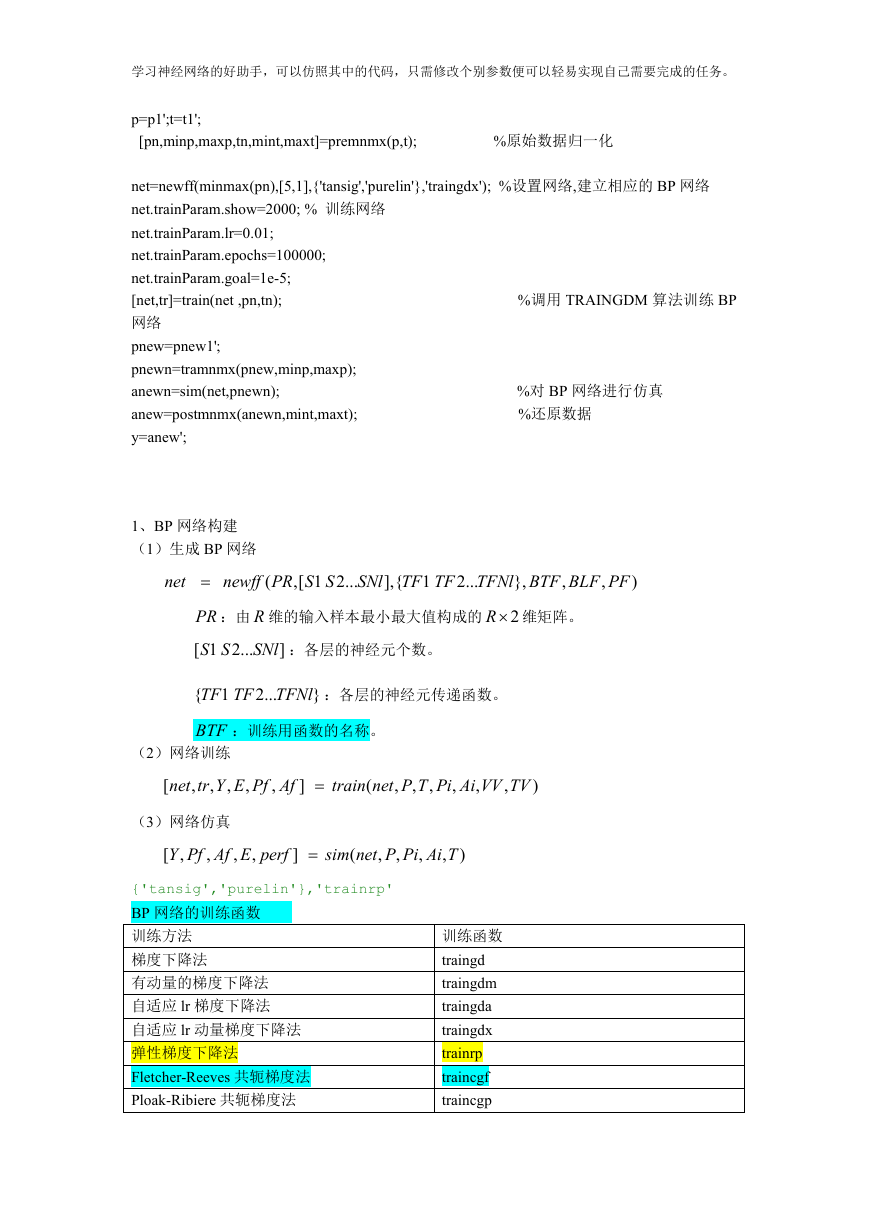

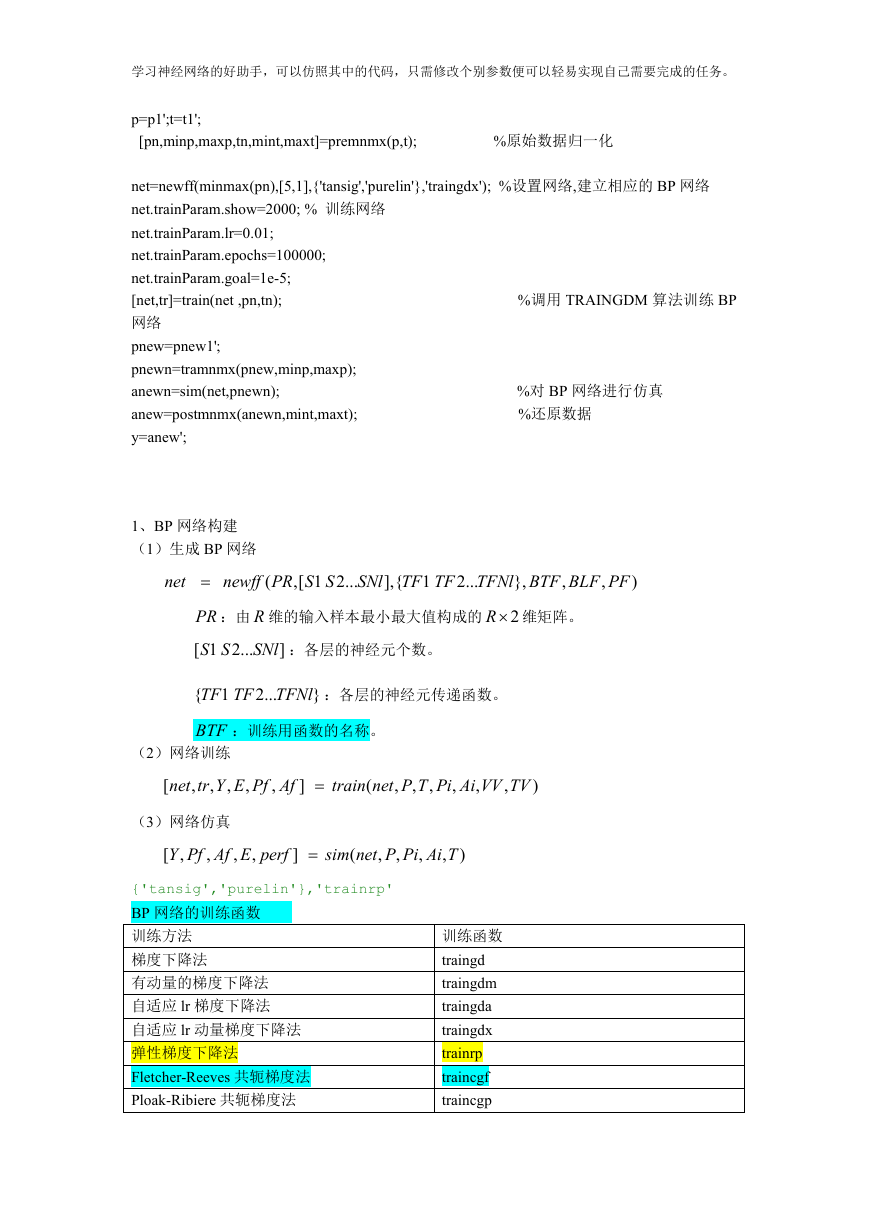

BP 网络的训练函数

训练方法

梯度下降法

有动量的梯度下降法

自适应 lr 梯度下降法

自适应 lr 动量梯度下降法

弹性梯度下降法

Fletcher-Reeves 共轭梯度法

Ploak-Ribiere 共轭梯度法

训练函数

traingd

traingdm

traingda

traingdx

trainrp

traincgf

traincgp

�

学习神经网络的好助手,可以仿照其中的代码,只需修改个别参数便可以轻易实现自己需要完成的任务。

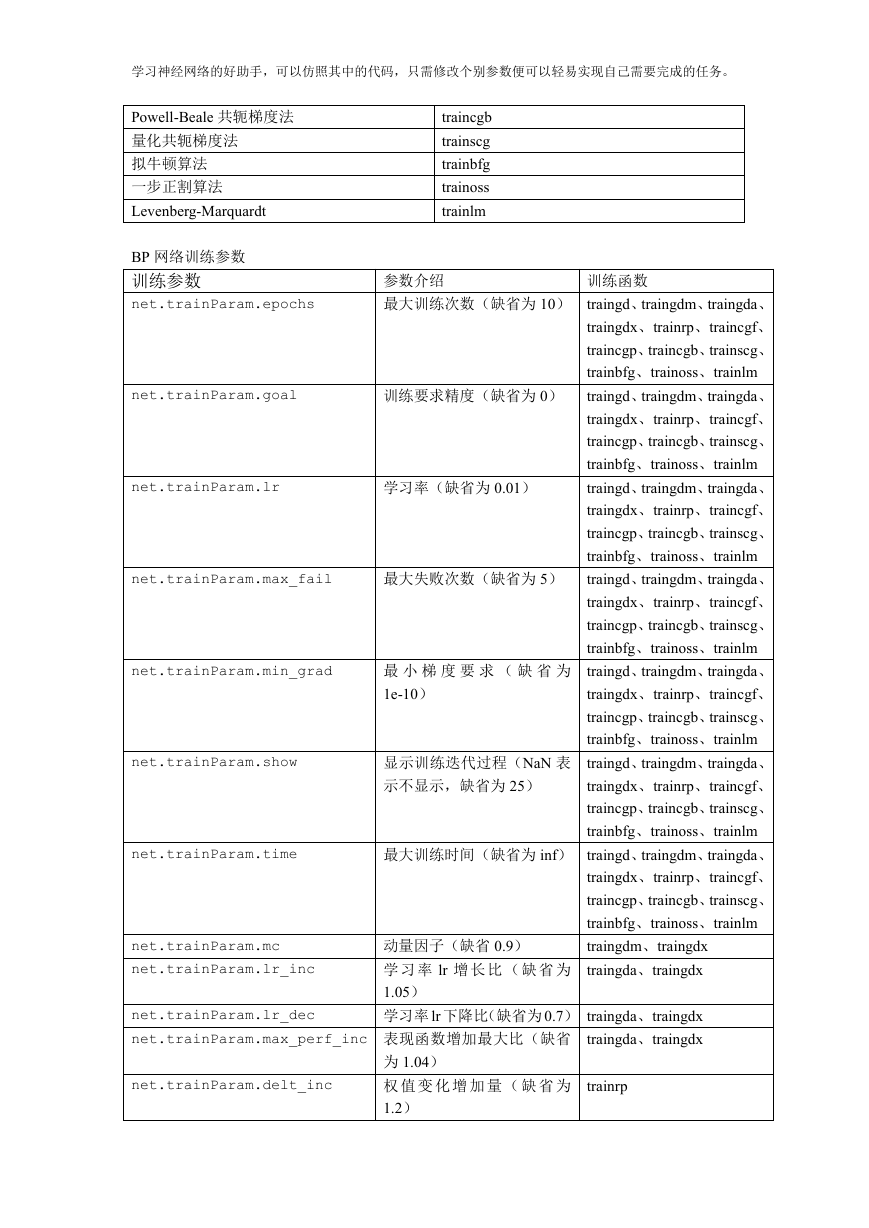

Powell-Beale 共轭梯度法

量化共轭梯度法

拟牛顿算法

一步正割算法

Levenberg-Marquardt

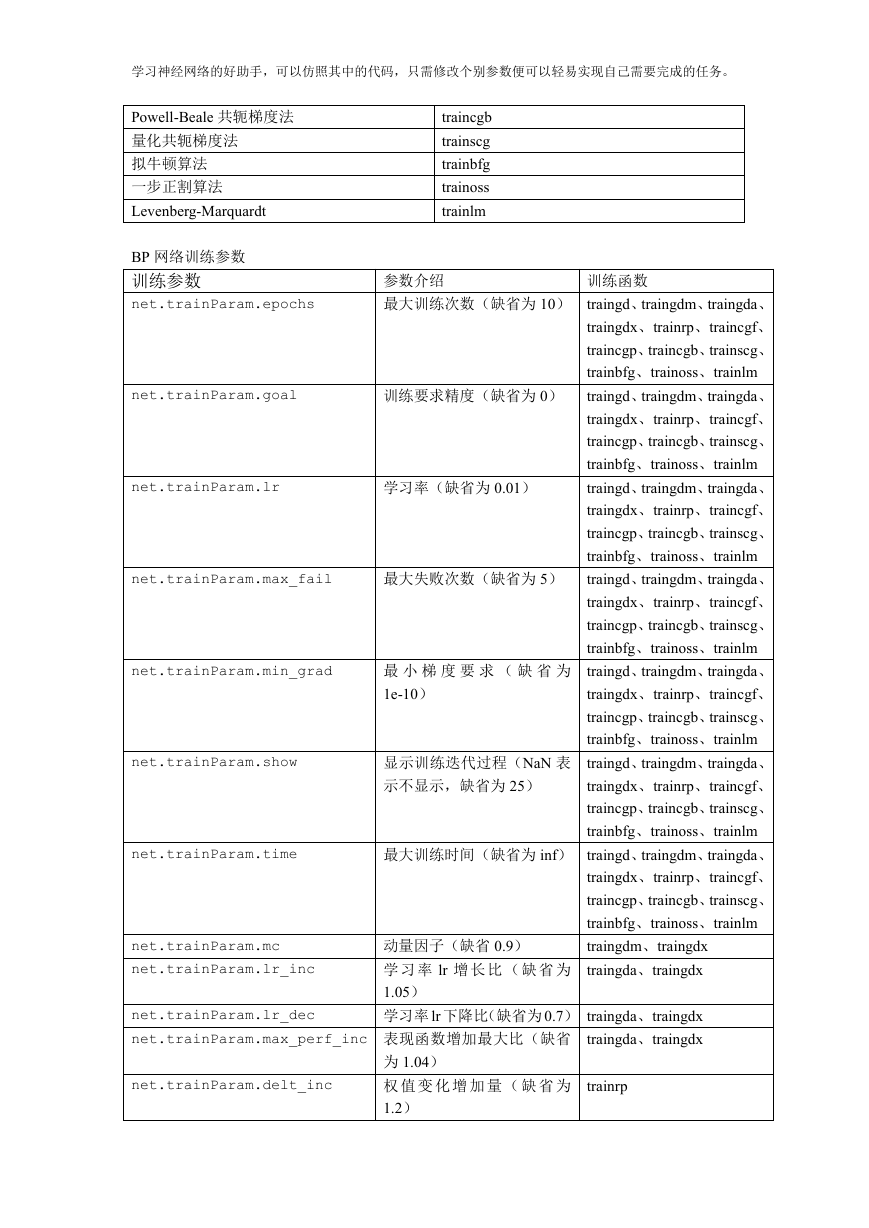

BP 网络训练参数

训练参数

net.trainParam.epochs

net.trainParam.goal

net.trainParam.lr

net.trainParam.max_fail

net.trainParam.min_grad

net.trainParam.show

net.trainParam.time

net.trainParam.mc

net.trainParam.lr_inc

traincgb

trainscg

trainbfg

trainoss

trainlm

训练函数

参数介绍

最大训练次数(缺省为 10) traingd、traingdm、traingda、

traingdx、trainrp、traincgf、

traincgp、traincgb、trainscg、

trainbfg、trainoss、trainlm

训练要求精度(缺省为 0) traingd、traingdm、traingda、

traingdx、trainrp、traincgf、

traincgp、traincgb、trainscg、

trainbfg、trainoss、trainlm

traingd、traingdm、traingda、

traingdx、trainrp、traincgf、

traincgp、traincgb、trainscg、

trainbfg、trainoss、trainlm

学习率(缺省为 0.01)

最 小 梯 度 要 求 ( 缺 省 为

1e-10)

最大失败次数(缺省为 5) traingd、traingdm、traingda、

traingdx、trainrp、traincgf、

traincgp、traincgb、trainscg、

trainbfg、trainoss、trainlm

traingd、traingdm、traingda、

traingdx、trainrp、traincgf、

traincgp、traincgb、trainscg、

trainbfg、trainoss、trainlm

traingd、traingdm、traingda、

traingdx、trainrp、traincgf、

traincgp、traincgb、trainscg、

trainbfg、trainoss、trainlm

显示训练迭代过程(NaN 表

示不显示,缺省为 25)

最大训练时间(缺省为 inf) traingd、traingdm、traingda、

traingdx、trainrp、traincgf、

traincgp、traincgb、trainscg、

trainbfg、trainoss、trainlm

traingdm、traingdx

traingda、traingdx

动量因子(缺省 0.9)

学 习 率 lr 增 长 比 ( 缺 省 为

1.05)

学习率 lr 下降比(缺省为 0.7) traingda、traingdx

traingda、traingdx

net.trainParam.lr_dec

net.trainParam.max_perf_inc 表现函数增加最大比(缺省

net.trainParam.delt_inc

为 1.04)

权 值 变 化 增 加 量 ( 缺 省 为

1.2)

trainrp

�

学习神经网络的好助手,可以仿照其中的代码,只需修改个别参数便可以轻易实现自己需要完成的任务。

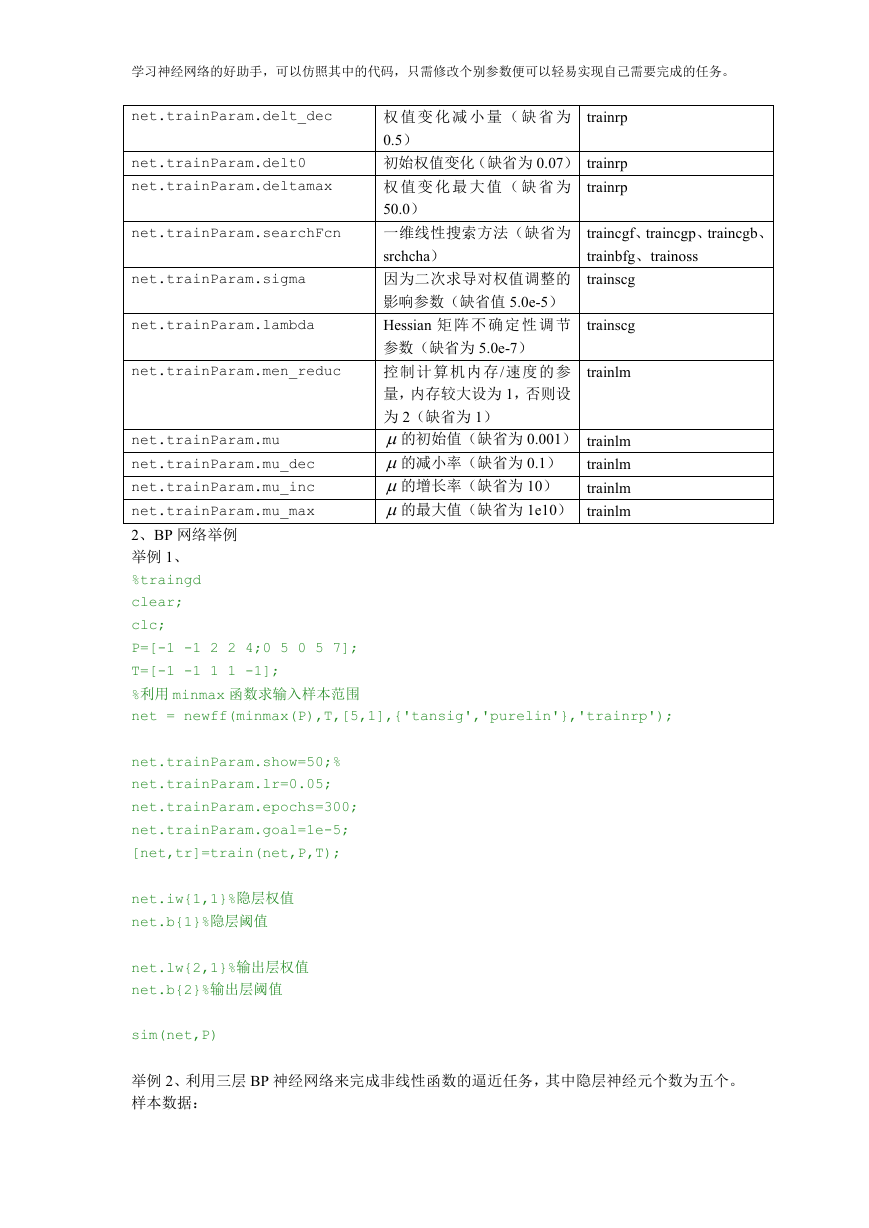

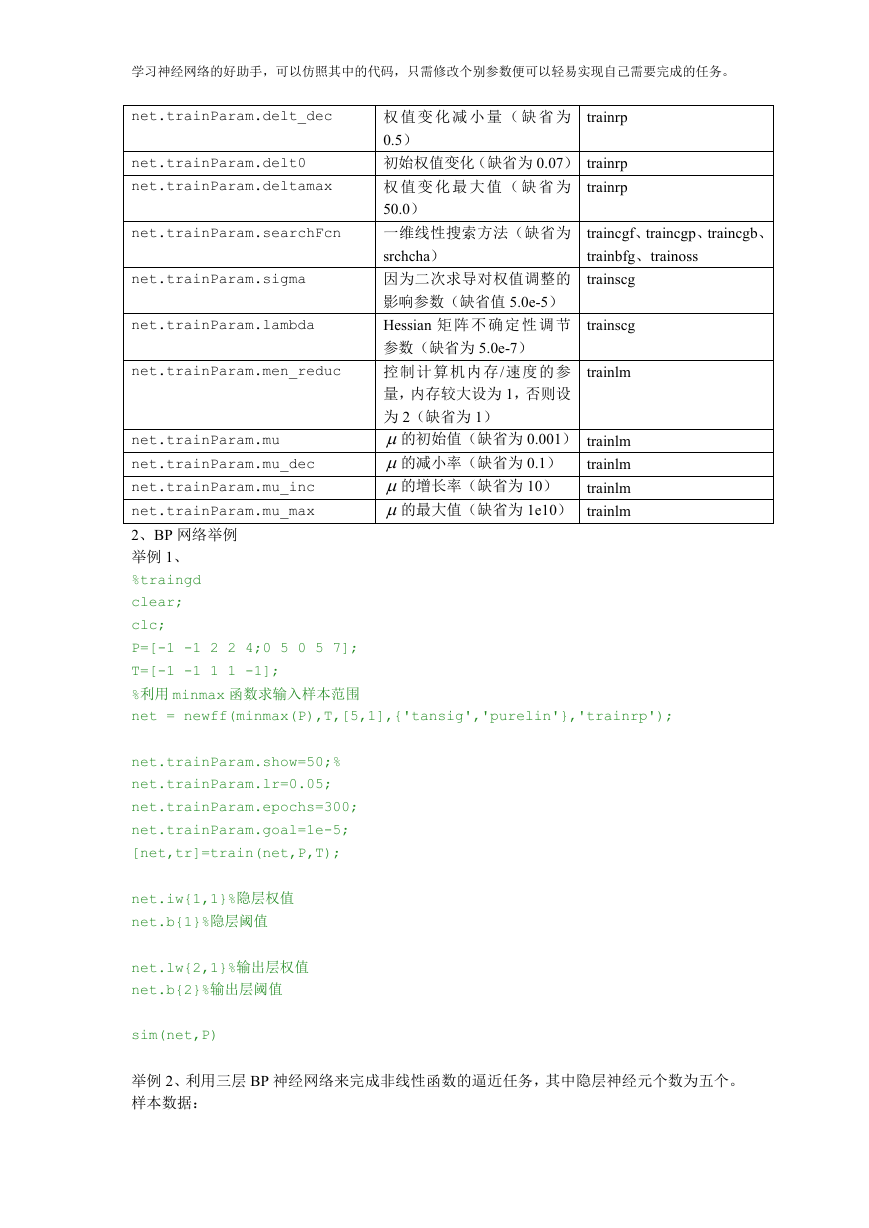

net.trainParam.delt_dec

net.trainParam.delt0

net.trainParam.deltamax

net.trainParam.searchFcn

net.trainParam.sigma

net.trainParam.lambda

net.trainParam.men_reduc

traincgf、traincgp、traincgb、

trainbfg、trainoss

trainscg

trainscg

trainrp

权 值 变 化 减 小 量 ( 缺 省 为

0.5)

初始权值变化(缺省为 0.07) trainrp

trainrp

权 值 变 化 最 大 值 ( 缺 省 为

50.0)

一维线性搜索方法(缺省为

srchcha)

因为二次求导对权值调整的

影响参数(缺省值 5.0e-5)

Hessian 矩 阵 不 确 定 性 调 节

参数(缺省为 5.0e-7)

控制 计算 机内存/速度 的参

量,内存较大设为 1,否则设

为 2(缺省为 1)

的初始值(缺省为 0.001) trainlm

的减小率(缺省为 0.1) trainlm

的增长率(缺省为 10) trainlm

的最大值(缺省为 1e10) trainlm

trainlm

net.trainParam.mu

net.trainParam.mu_dec

net.trainParam.mu_inc

net.trainParam.mu_max

2、BP 网络举例

举例 1、

%traingd

clear;

clc;

P=[-1 -1 2 2 4;0 5 0 5 7];

T=[-1 -1 1 1 -1];

%利用 minmax 函数求输入样本范围

net = newff(minmax(P),T,[5,1],{'tansig','purelin'},'trainrp');

net.trainParam.show=50;%

net.trainParam.lr=0.05;

net.trainParam.epochs=300;

net.trainParam.goal=1e-5;

[net,tr]=train(net,P,T);

net.iw{1,1}%隐层权值

net.b{1}%隐层阈值

net.lw{2,1}%输出层权值

net.b{2}%输出层阈值

sim(net,P)

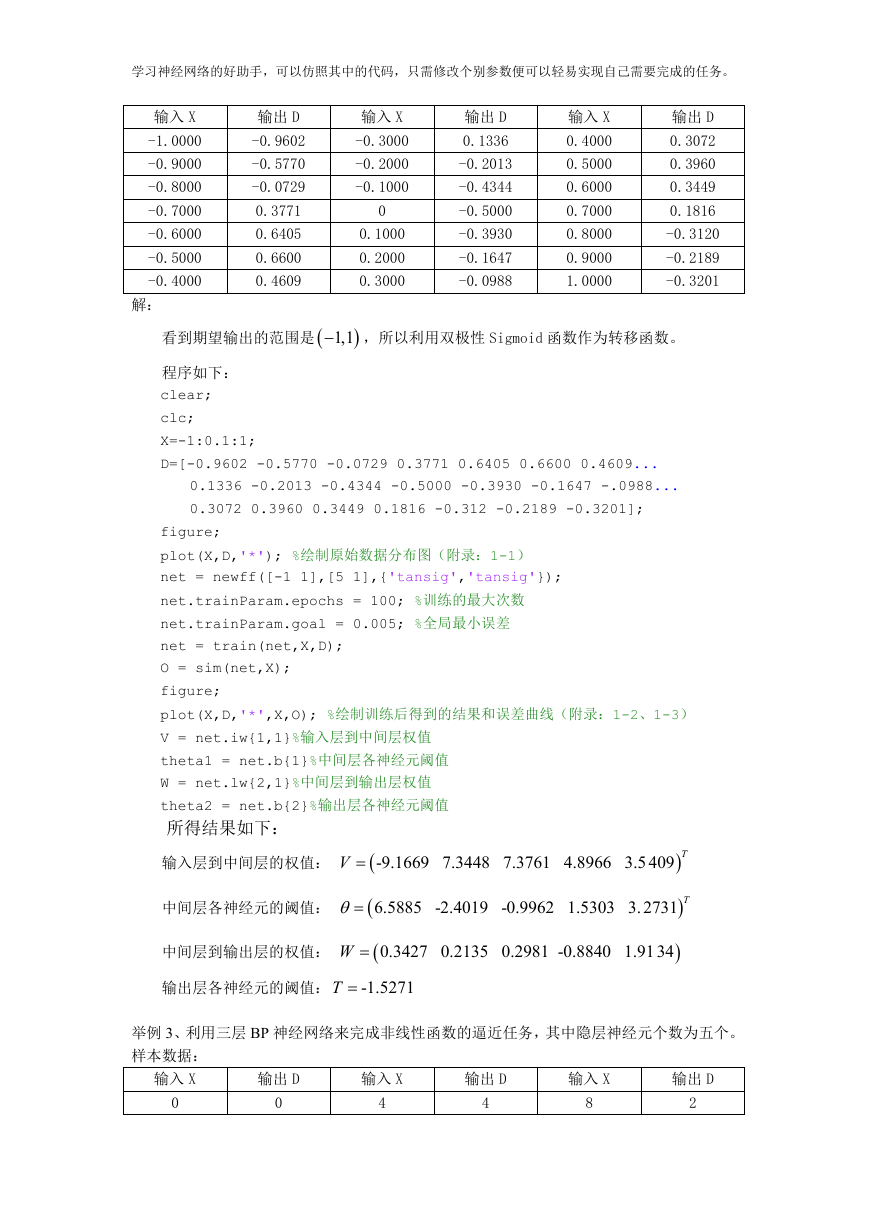

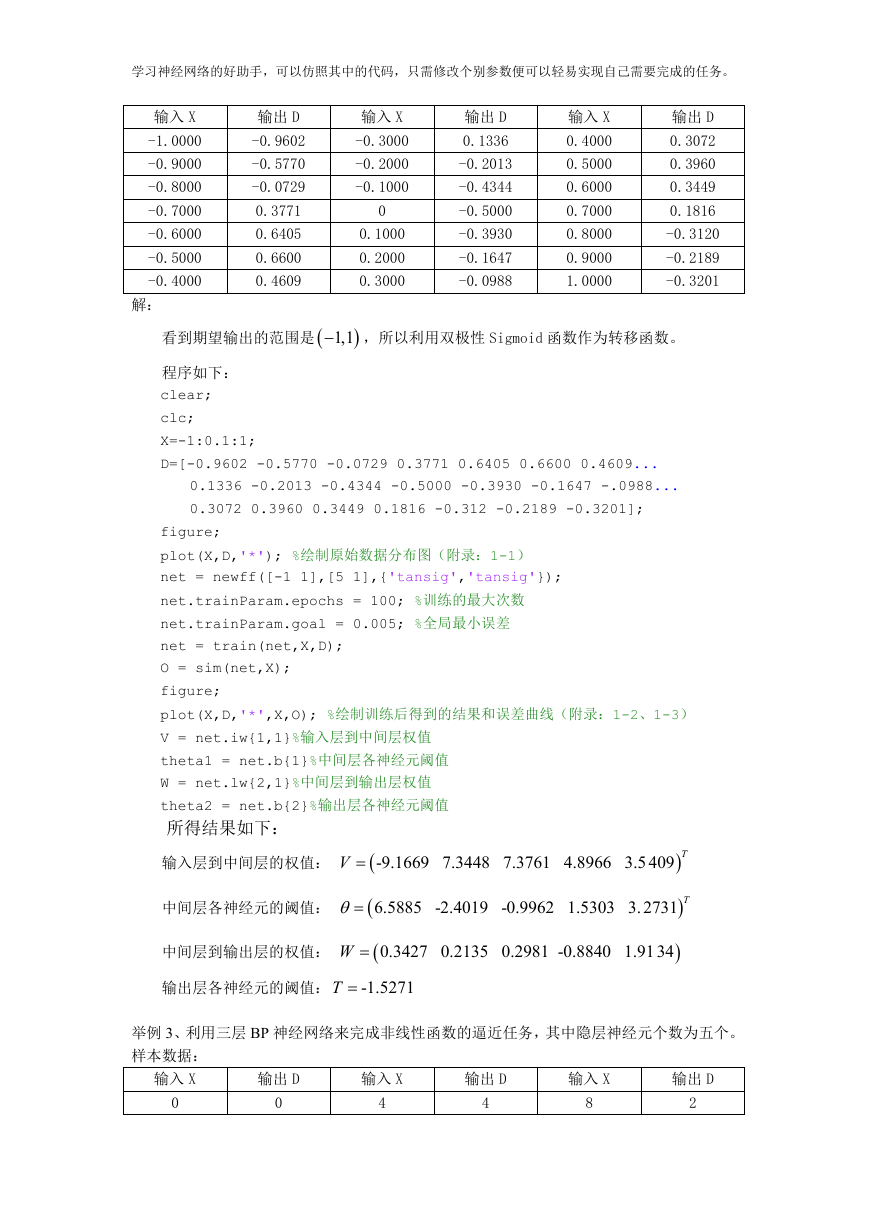

举例 2、利用三层 BP 神经网络来完成非线性函数的逼近任务,其中隐层神经元个数为五个。

样本数据:

�

学习神经网络的好助手,可以仿照其中的代码,只需修改个别参数便可以轻易实现自己需要完成的任务。

输入 X

-1.0000

-0.9000

-0.8000

-0.7000

-0.6000

-0.5000

-0.4000

解:

输出 D

-0.9602

-0.5770

-0.0729

0.3771

0.6405

0.6600

0.4609

输入 X

-0.3000

-0.2000

-0.1000

0

0.1000

0.2000

0.3000

输出 D

0.1336

-0.2013

-0.4344

-0.5000

-0.3930

-0.1647

-0.0988

输入 X

0.4000

0.5000

0.6000

0.7000

0.8000

0.9000

1.0000

输出 D

0.3072

0.3960

0.3449

0.1816

-0.3120

-0.2189

-0.3201

看到期望输出的范围是

1,1 ,所以利用双极性 Sigmoid 函数作为转移函数。

程序如下:

clear;

clc;

X=-1:0.1:1;

D=[-0.9602 -0.5770 -0.0729 0.3771 0.6405 0.6600 0.4609...

0.1336 -0.2013 -0.4344 -0.5000 -0.3930 -0.1647 -.0988...

0.3072 0.3960 0.3449 0.1816 -0.312 -0.2189 -0.3201];

figure;

plot(X,D,'*'); %绘制原始数据分布图(附录:1-1)

net = newff([-1 1],[5 1],{'tansig','tansig'});

net.trainParam.epochs = 100; %训练的最大次数

net.trainParam.goal = 0.005; %全局最小误差

net = train(net,X,D);

O = sim(net,X);

figure;

plot(X,D,'*',X,O); %绘制训练后得到的结果和误差曲线(附录:1-2、1-3)

V = net.iw{1,1}%输入层到中间层权值

theta1 = net.b{1}%中间层各神经元阈值

W = net.lw{2,1}%中间层到输出层权值

theta2 = net.b{2}%输出层各神经元阈值

所得结果如下:

输入层到中间层的权值:

V

-9.1669 7.3448 7.3761 4.8966 3.5409 T

中间层各神经元的阈值:

6.5885 -2.4019 -0.9962 1.5303 3.2731 T

中间层到输出层的权值:

输出层各神经元的阈值:

T

W

0.3427 0.2135 0.2981 -0.8840 1.9134

-1.5271

举例 3、利用三层 BP 神经网络来完成非线性函数的逼近任务,其中隐层神经元个数为五个。

样本数据:

输入 X

0

输出 D

0

输入 X

4

输出 D

4

输入 X

8

输出 D

2

�

学习神经网络的好助手,可以仿照其中的代码,只需修改个别参数便可以轻易实现自己需要完成的任务。

1

2

3

解:

1

2

3

5

6

7

3

2

1

9

10

3

4

看到期望输出的范围超出

1,1 ,所以输出层神经元利用线性函数作为转移函数。

程序如下:

clear;

clc;

X = [0 1 2 3 4 5 6 7 8 9 10];

D = [0 1 2 3 4 3 2 1 2 3 4];

figure;

plot(X,D,'*'); %绘制原始数据分布图

net = newff([0 10],[5 1],{'tansig','purelin'})

net.trainParam.epochs = 100;

net.trainParam.goal=0.005;

net=train(net,X,D);

O=sim(net,X);

figure;

plot(X,D,'*',X,O); %绘制训练后得到的结果和误差曲线(附录:2-2、2-3)

V = net.iw{1,1}%输入层到中间层权值

theta1 = net.b{1}%中间层各神经元阈值

W = net.lw{2,1}%中间层到输出层权值

theta2 = net.b{2}%输出层各神经元阈值

所得结果如下:

输入层到中间层的权值:

V

0.8584 2.0890 -1.2166 0.2752 -0.3910 T

中间层各神经元的阈值:

-14.0302 -9.8340 7.4331 -2.0135 0.5610 T

中间层到输出层的权值:

W

-0.4675 -1.1234 2.3208 4.6402 -2.2686

输出层各神经元的阈值: 1.7623

T

问题:以下是上证指数 2009 年 2 月 2 日到 3 月 27 日的收盘价格,构建一个三层 BP 神经网

络,利用该组信号的 6 个过去值预测信号的将来值。

日期

2009/02/02

2009/02/03

2009/02/04

2009/02/05

2009/02/06

2009/02/09

2009/02/10

价格

2011.682

2060.812

2107.751

2098.021

2181.241

2224.711

2265.161

日期

2009/03/02

2009/03/03

2009/03/04

2009/03/05

2009/03/06

2009/03/09

2009/03/10

价格

2093.452

2071.432

2198.112

2221.082

2193.012

2118.752

2158.572

�

学习神经网络的好助手,可以仿照其中的代码,只需修改个别参数便可以轻易实现自己需要完成的任务。

2009/02/11

2009/02/12

2009/02/13

2009/02/16

2009/02/17

2009/02/18

2009/02/19

2009/02/20

2009/02/23

2009/02/24

2009/02/25

2009/02/26

2009/02/27

2260.822

2248.092

2320.792

2389.392

2319.442

2209.862

2227.132

2261.482

2305.782

2200.652

2206.572

2121.252

2082.852

2009/03/11

2009/03/12

2009/03/13

2009/03/16

2009/03/17

2009/03/18

2009/03/19

2009/03/20

2009/03/23

2009/03/24

2009/03/25

2009/03/26

2009/03/27

2139.021

2133.881

2128.851

2153.291

2218.331

2223.731

2265.761

2281.091

2325.481

2338.421

2291.551

2361.701

2374.44

load data3_1.txt;

[m,n]=size( data3_1);

tsx = data3_1(1:m-1,1);

tsx=tsx';

ts = data3_1(2:m,1);

ts=ts';

[TSX,TSXps]=mapminmax(tsx,1,2);

[TS,TSps]=mapminmax(ts,1,2);

TSX=TSX';

figure;

plot(ts,'LineWidth',2);

title('到杭旅游总人数(1999.01.01-2009.12.31)','FontSize',12);

xlabel('统计年份(1990.12.19-2009.08.19)','FontSize',12);

ylabel('归一化后的总游客数/万人','FontSize',12);

grid on;

% 生成BP网络、利用minmax函数求输入样本范围

net_1=newff(minmax(TS),[10,1],{'tansig','purelin'},'traincgf')

% 设置训练参数

net_1.trainParam.show = 50; %显示训练迭代过程(NaN表示不显示,缺省25)

net_1.trainParam.lr = 0.025;

net_1.trainParam.mc = 0.9;

net_1.trainParam.epochs = 10000; %最大训练次数

net_1.trainParam.goal = 0.001;

%训练要求精度

%动量因子(缺省0.9)

%学习率(缺省0.01)

�

学习神经网络的好助手,可以仿照其中的代码,只需修改个别参数便可以轻易实现自己需要完成的任务。

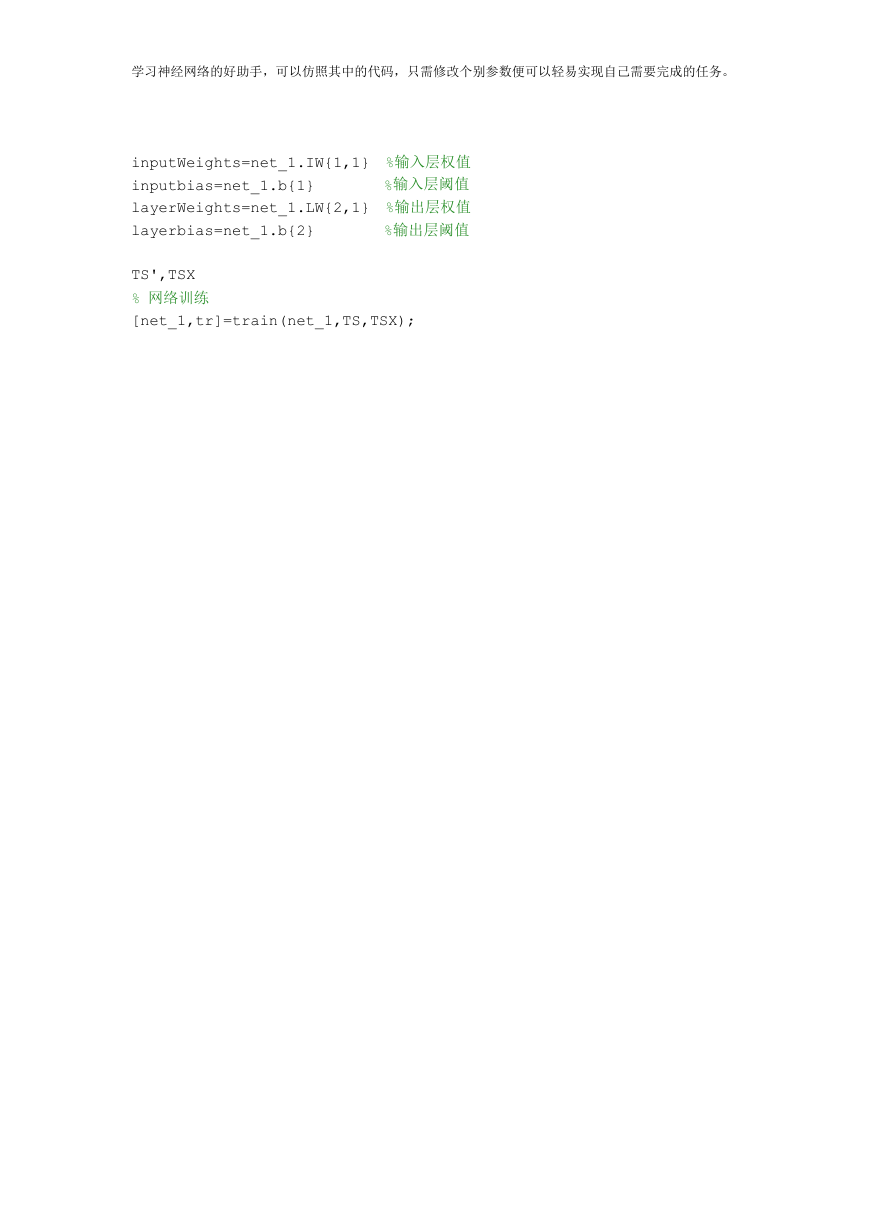

inputWeights=net_1.IW{1,1} %输入层权值

inputbias=net_1.b{1}

%输入层阈值

layerWeights=net_1.LW{2,1} %输出层权值

layerbias=net_1.b{2}

%输出层阈值

TS',TSX

% 网络训练

[net_1,tr]=train(net_1,TS,TSX);

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc