快速入门

1 目的

2 先决条件

2.1 支持平台

2.2 所需软件

2.3 安装软件

3 下载

4 运行Hadoop集群的准备工作

5 单机模式的操作方法

6 伪分布式模式的操作方法

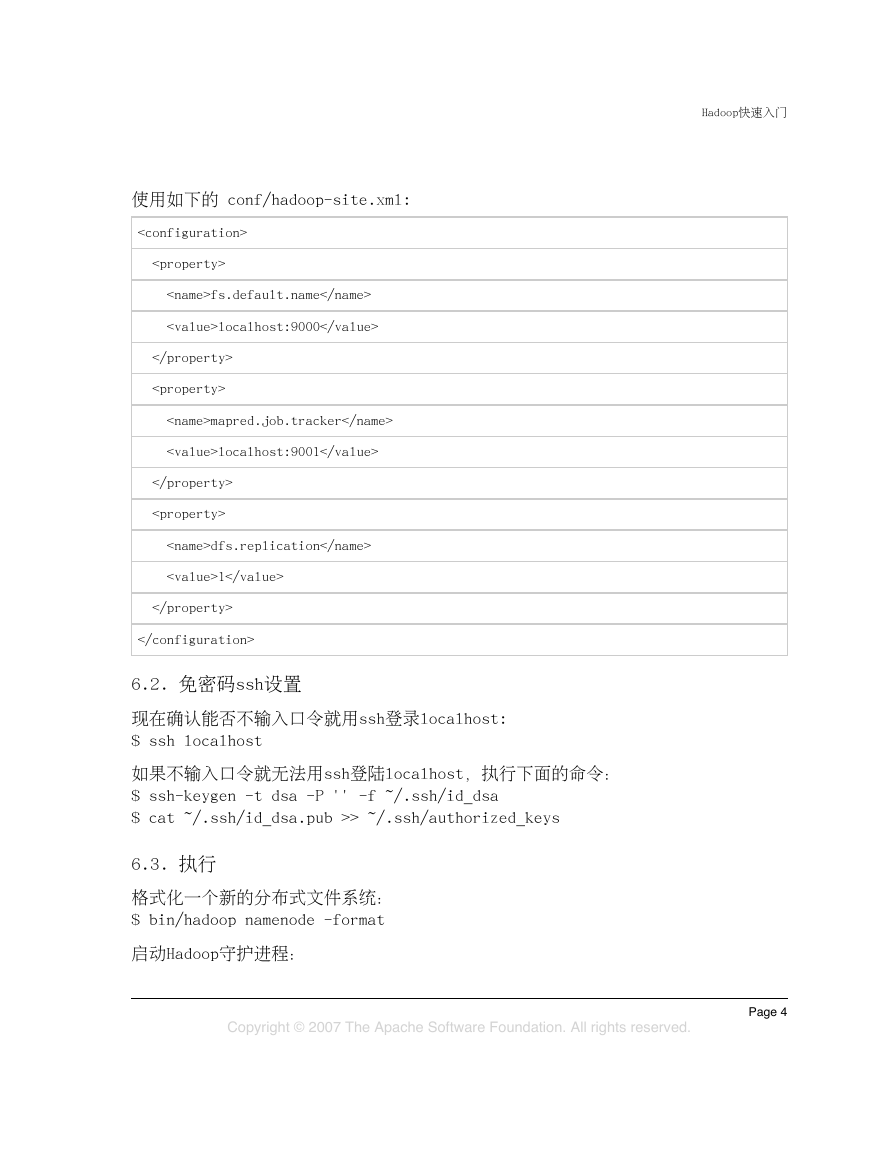

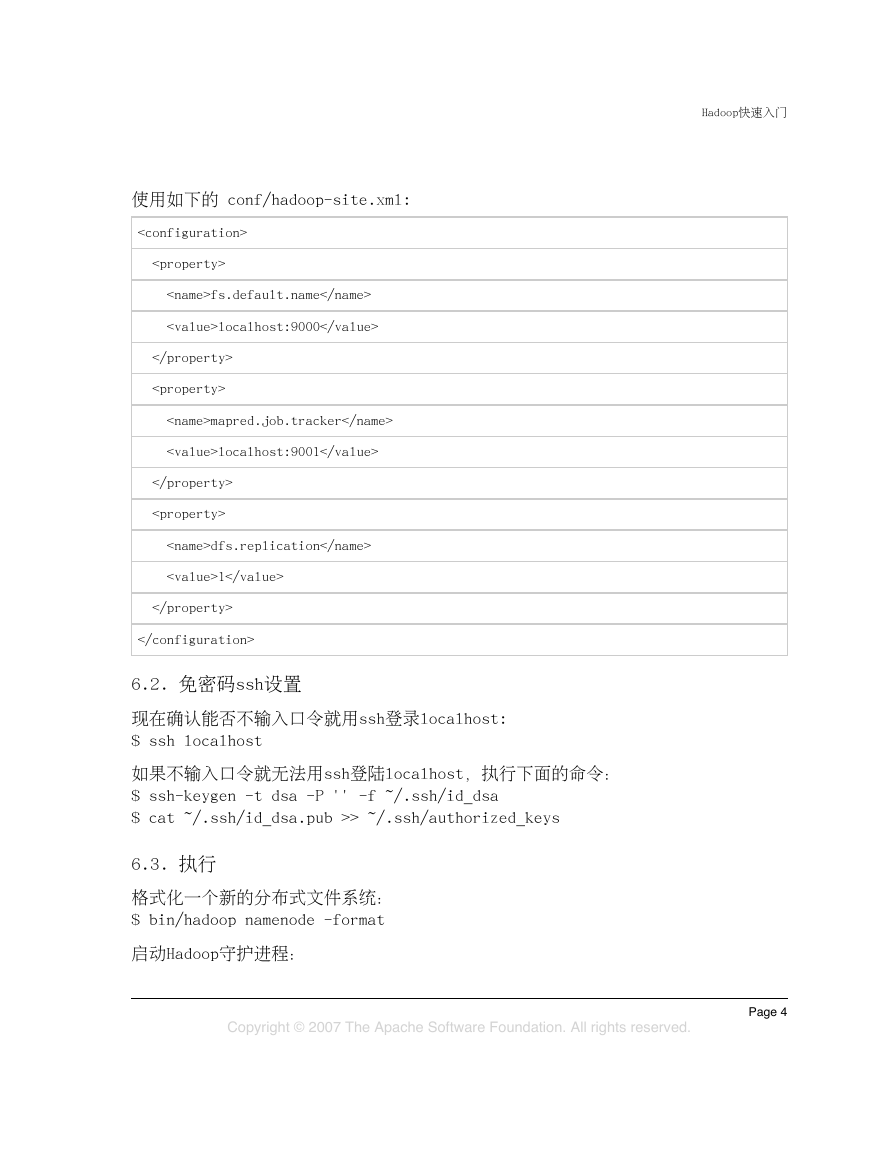

6.1 配置

6.2 免密码ssh设置

6.3 执行

7 完全分布式模式的操作方法

集群搭建

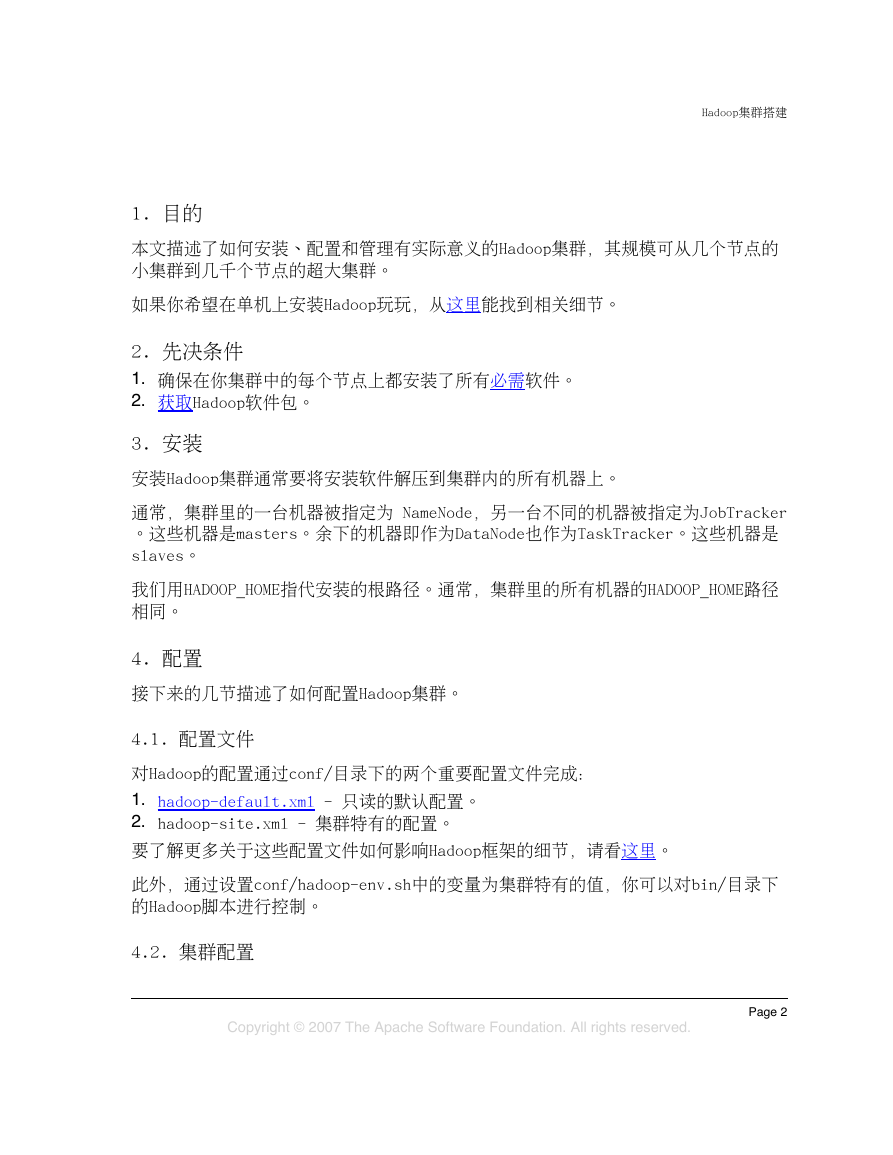

1 目的

2 先决条件

3 安装

4 配置

4.1 配置文件

4.2 集群配置

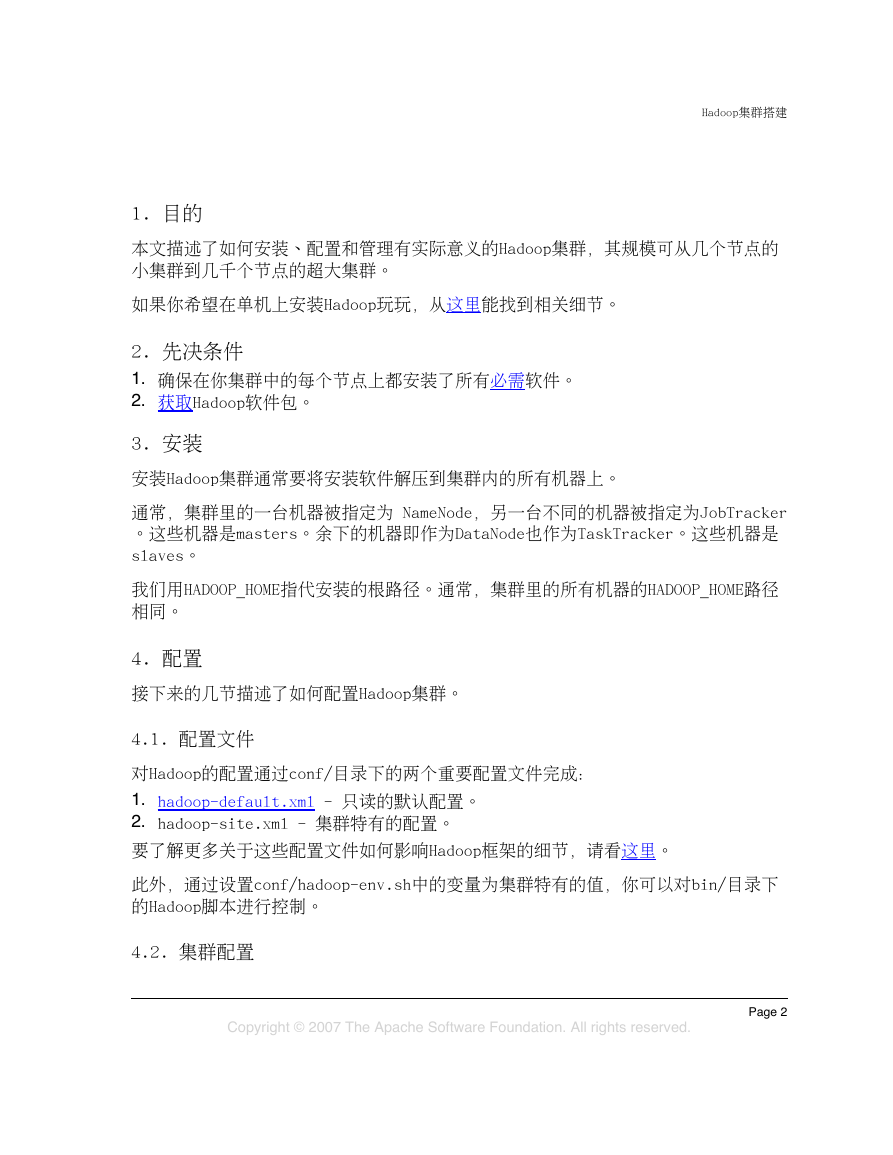

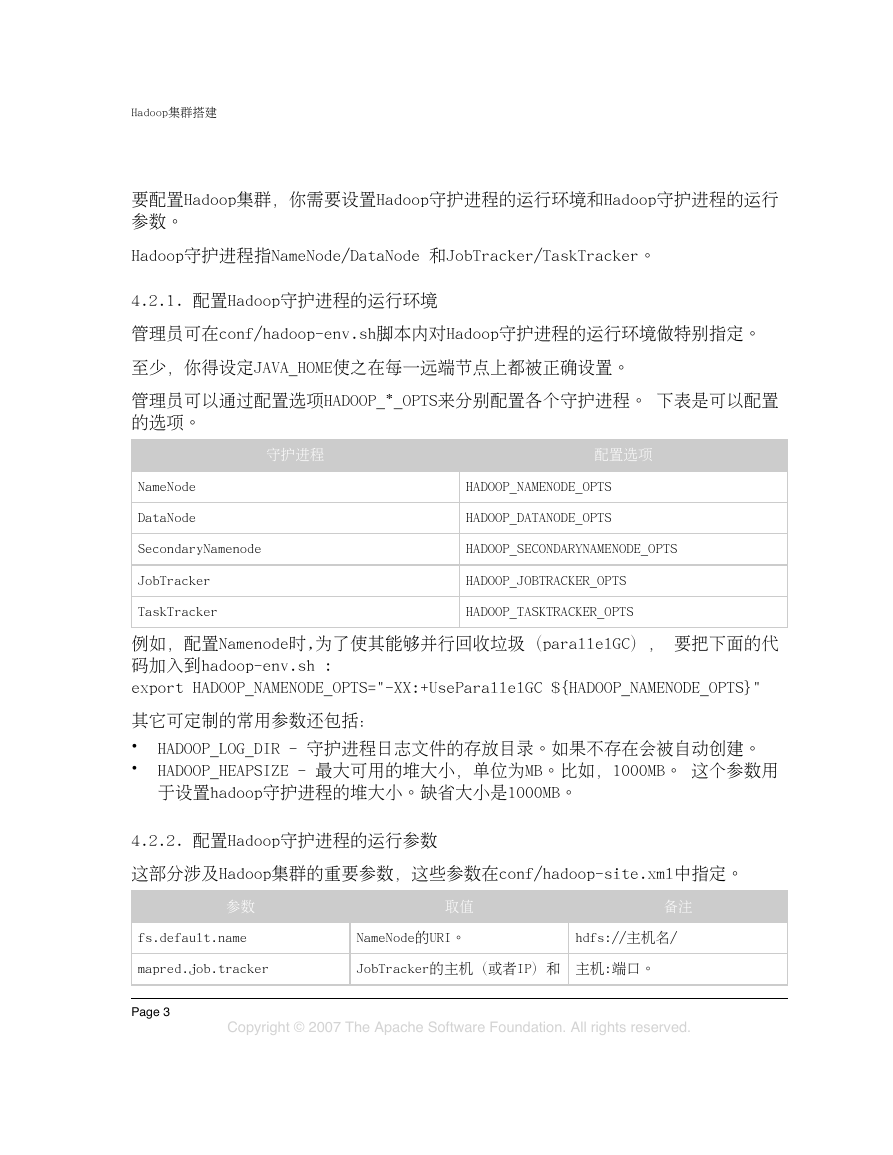

4.2.1 配置Hadoop守护进程的运行环境

4.2.2 配置Hadoop守护进程的运行参数

4.2.2.1 现实世界的集群配置

4.2.3 Slaves

4.2.4 日志

4.2.4.1 历史日志

5 Hadoop的机架感知

6 启动Hadoop

7 停止Hadoop

HDFS架构设计

1 引言

2 前提和设计目标

2.1 硬件错误

2.2 流式数据访问

2.3 大规模数据集

2.4 简单的一致性模型

2.5 “移动计算比移动数据更划算”

2.6 异构软硬件平台间的可移植性

3 Namenode 和 Datanode

4 文件系统的名字空间 (namespace)

5 数据复制

5.1 副本存放: 最最开始的一步

5.2 副本选择

5.3 安全模式

6 文件系统元数据的持久化

7 通讯协议

8 健壮性

8.1 磁盘数据错误,心跳检测和重新复制

8.2 集群均衡

8.3 数据完整性

8.4 元数据磁盘错误

8.5 快照

9 数据组织

9.1 数据块

9.2 Staging

9.3 流水线复制

10 可访问性

10.1 DFSShell

10.2 DFSAdmin

10.3 浏览器接口

11 存储空间回收

11.1 文件的删除和恢复

11.2 减少副本系数

12 参考资料

HDFS使用指南

1 目的

2 概述

3 先决条件

4 Web接口

5 Shell命令

5.1 DFSAdmin命令

6 Secondary NameNode

7 Rebalancer

8 机架感知(Rack awareness)

9 安全模式

10 fsck

11 升级和回滚

12 文件权限和安全性

13 可扩展性

14 相关文档

HDFS权限指南

1 概述

2 用户身份

3 理解系统的实现

4 文件系统API变更

5 Shell命令变更

6 超级用户

7 Web服务器

8 在线升级

9 配置参数

HDFS配额管理指南

命令手册

1 概述

1.1 常规选项

2 用户命令

2.1 archive

2.2 distcp

2.3 fs

2.4 fsck

2.5 jar

2.6 job

2.7 pipes

2.8 version

2.9 CLASSNAME

3 管理命令

3.1 balancer

3.2 daemonlog

3.3 datanode

3.4 dfsadmin

3.5 jobtracker

3.6 namenode

3.7 secondarynamenode

3.8 tasktracker

FS Shell使用指南

1 FS Shell

1.1 cat

1.2 chgrp

1.3 chmod

1.4 chown

1.5 copyFromLocal

1.6 copyToLocal

1.7 cp

1.8 du

1.9 dus

1.10 expunge

1.11 get

1.12 getmerge

1.13 ls

1.14 lsr

1.15 mkdir

1.16 movefromLocal

1.17 mv

1.18 put

1.19 rm

1.20 rmr

1.21 setrep

1.22 stat

1.23 tail

1.24 test

1.25 text

1.26 touchz

DistCp使用指南

1 概述

2 使用方法

2.1 基本使用方法

2.2 选项

2.2.1 选项索引

2.2.2 更新和覆盖

3 附录

3.1 Map数目

3.2 不同HDFS版本间的拷贝

3.3 Map/Reduce和副效应

Map-Reduce 教程

1 目的

2 先决条件

3 概述

4 输入与输出

5 例子:WordCount v1.0

5.1 源代码

5.2 用法

5.3 解释

6 Map/Reduce - 用户界面

6.1 核心功能描述

6.1.1 Mapper

6.1.1.1 需要多少个Map?

6.1.2 Reducer

6.1.2.1 Shuffle

6.1.2.2 Sort

6.1.2.2.1 Secondary Sort

6.1.2.3 Reduce

6.1.2.4 需要多少个Reduce?

6.1.2.5 无Reducer

6.1.3 Partitioner

6.1.4 Reporter

6.1.5 OutputCollector

6.2 作业配置

6.3 任务的执行和环境

6.4 作业的提交与监控

6.4.1 作业的控制

6.5 作业的输入

6.5.1 InputSplit

6.5.2 RecordReader

6.6 作业的输出

6.6.1 任务的Side-Effect File

6.6.2 RecordWriter

6.7 其他有用的特性

6.7.1 Counters

6.7.2 DistributedCache

6.7.3 Tool

6.7.4 IsolationRunner

6.7.5 Profiling

6.7.6 调试

6.7.6.1 如何分发脚本文件:

6.7.6.2 如何提交脚本:

6.7.6.3 默认行为

6.7.7 JobControl

6.7.8 数据压缩

6.7.8.1 中间输出

6.7.8.2 作业输出

7 例子:WordCount v2.0

7.1 源代码

7.2 运行样例

7.3 程序要点

Hadoop本地库

1 目的

2 组件

3 使用方法

4 支持的平台

5 构建Hadoop本地库

5.1 注意

6 使用DistributedCache 加载本地库

Streaming

1 Hadoop Streaming

2 Streaming工作原理

3 将文件打包到提交的作业中

4 Streaming选项与用法

4.1 只使用Mapper的作业

4.2 为作业指定其他插件

4.3 Hadoop Streaming中的大文件和档案

4.4 为作业指定附加配置参数

4.5 其他选项

5 其他例子

5.1 使用自定义的方法切分行来形成Key/Value对

5.2 一个实用的Partitioner类 (二次排序,-partitioner org.apache.hadoop.mapred.lib.KeyFieldBasedPartitioner 选项)

5.3 Hadoop聚合功能包的使用(-reduce aggregate 选项)

5.4 字段的选取(类似于unix中的 'cut' 命令)

6 常见问题

6.1 我该怎样使用Hadoop Streaming运行一组独立(相关)的任务呢?

6.2 如何处理多个文件,其中每个文件一个map?

6.3 应该使用多少个reducer?

6.4 如果在Shell脚本里设置一个别名,并放在-mapper之后,Streaming会正常运行吗? 例如,alias cl='cut -fl',-mapper "cl"会运行正常吗?

6.5 我可以使用UNIX pipes吗?例如 –mapper "cut –fl | set s/foo/bar/g"管用么?

6.6 在streaming作业中用-file选项运行一个分布式的超大可执行文件(例如,3.6G)时, 我得到了一个错误信息“No space left on device”。如何解决?

6.7 如何设置多个输入目录?

6.8 如何生成gzip格式的输出文件?

6.9 Streaming中如何自定义input/output format?

6.10 Streaming如何解析XML文档?

6.11 在streaming应用程序中如何更新计数器?

6.12 如何更新streaming应用程序的状态?

Hadoop A

rchives

1 什么是Hadoop archives?

2 如何创建archive?

3 如何查看archives中的文件?

Hadoop On Demand

1 简介

2 文档

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc