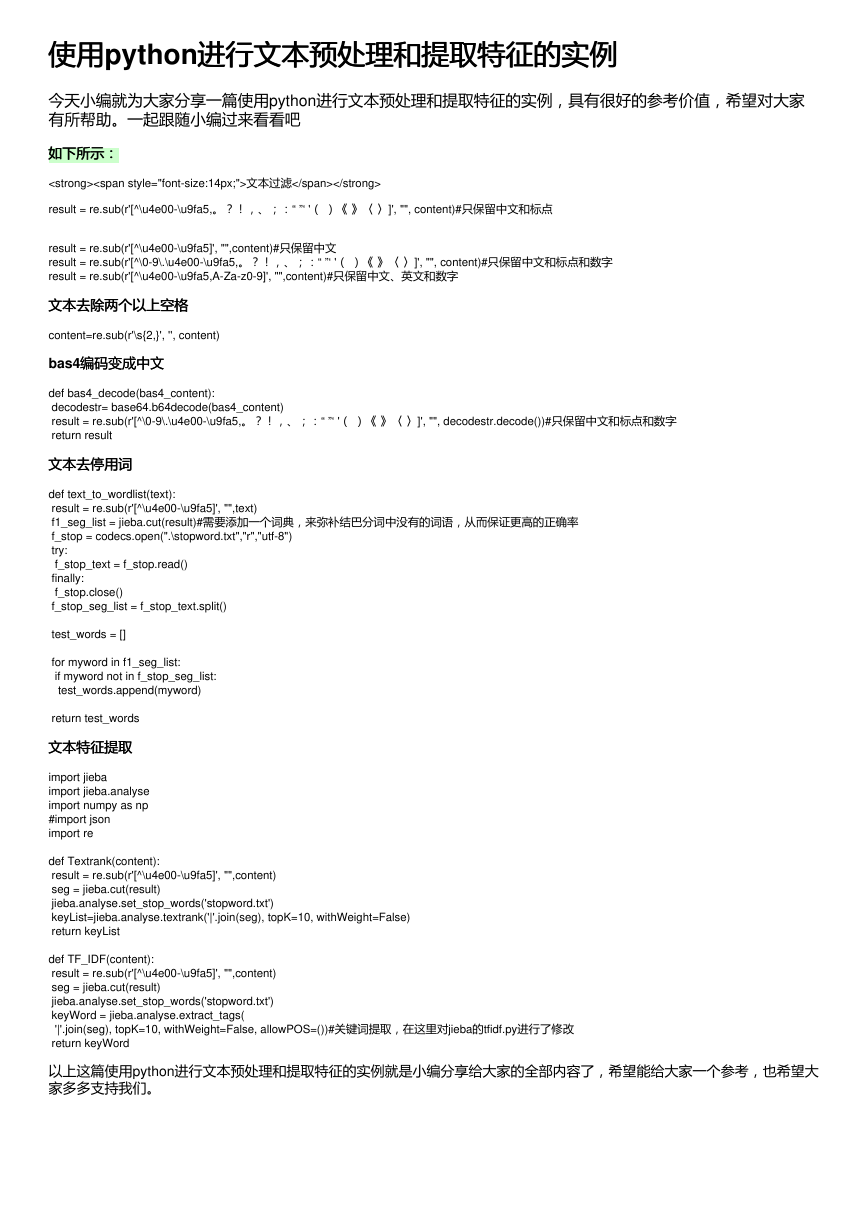

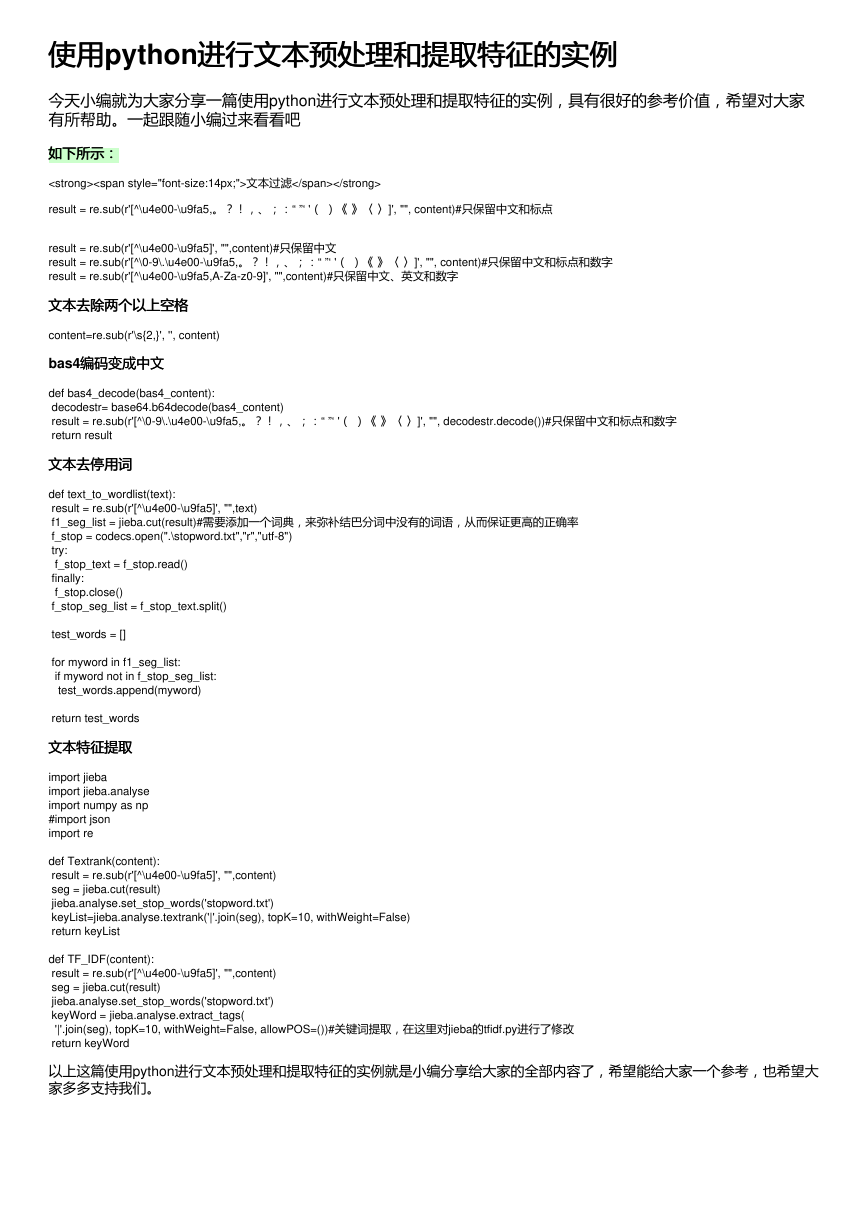

使用使用python进行文本预处理和提取特征的实例

进行文本预处理和提取特征的实例

今天小编就为大家分享一篇使用python进行文本预处理和提取特征的实例,具有很好的参考价值,希望对大家

有所帮助。一起跟随小编过来看看吧

如下所示:

如下所示:

文本过滤

result = re.sub(r'[^\u4e00-\u9fa5,。?!,、;:“ ”‘ '( )《 》〈 〉]', "", content)#只保留中文和标点

result = re.sub(r'[^\u4e00-\u9fa5]', "",content)#只保留中文

result = re.sub(r'[^\0-9\.\u4e00-\u9fa5,。?!,、;:“ ”‘ '( )《 》〈 〉]', "", content)#只保留中文和标点和数字

result = re.sub(r'[^\u4e00-\u9fa5,A-Za-z0-9]', "",content)#只保留中文、英文和数字

文本去除两个以上空格

文本去除两个以上空格

content=re.sub(r'\s{2,}', '', content)

bas4编码变成中文

编码变成中文

def bas4_decode(bas4_content):

decodestr= base64.b64decode(bas4_content)

result = re.sub(r'[^\0-9\.\u4e00-\u9fa5,。?!,、;:“ ”‘ '( )《 》〈 〉]', "", decodestr.decode())#只保留中文和标点和数字

return result

文本去停用词

文本去停用词

def text_to_wordlist(text):

result = re.sub(r'[^\u4e00-\u9fa5]', "",text)

f1_seg_list = jieba.cut(result)#需要添加一个词典,来弥补结巴分词中没有的词语,从而保证更高的正确率

f_stop = codecs.open(".\stopword.txt","r","utf-8")

try:

f_stop_text = f_stop.read()

finally:

f_stop.close()

f_stop_seg_list = f_stop_text.split()

test_words = []

for myword in f1_seg_list:

if myword not in f_stop_seg_list:

test_words.append(myword)

return test_words

文本特征提取

文本特征提取

import jieba

import jieba.analyse

import numpy as np

#import json

import re

def Textrank(content):

result = re.sub(r'[^\u4e00-\u9fa5]', "",content)

seg = jieba.cut(result)

jieba.analyse.set_stop_words('stopword.txt')

keyList=jieba.analyse.textrank('|'.join(seg), topK=10, withWeight=False)

return keyList

def TF_IDF(content):

result = re.sub(r'[^\u4e00-\u9fa5]', "",content)

seg = jieba.cut(result)

jieba.analyse.set_stop_words('stopword.txt')

keyWord = jieba.analyse.extract_tags(

'|'.join(seg), topK=10, withWeight=False, allowPOS=())#关键词提取,在这里对jieba的tfidf.py进行了修改

return keyWord

以上这篇使用python进行文本预处理和提取特征的实例就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大

家多多支持我们。

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc