版权声明:本文及PPT为博主原创,未经博主允许不得转载

署名(BY) :dkjkls(dkj卡洛斯)

文章出处:http://blog.csdn.net/dkjkls

http://blog.csdn.net/dkjkls

�

壹 Ensemble Learning 集成学习

贰 Bagging: 随机森林 及实战

叁 Boosting: GBDT 及实战

肆 XGBoost & LightGBM

http://blog.csdn.net/dkjkls

http://blog.csdn.net/dkjkls

�

集成学习

http://blog.csdn.net/dkjkls

http://blog.csdn.net/dkjkls

�

三个臭皮匠,顶个诸葛亮

http://blog.csdn.net/dkjkls

�

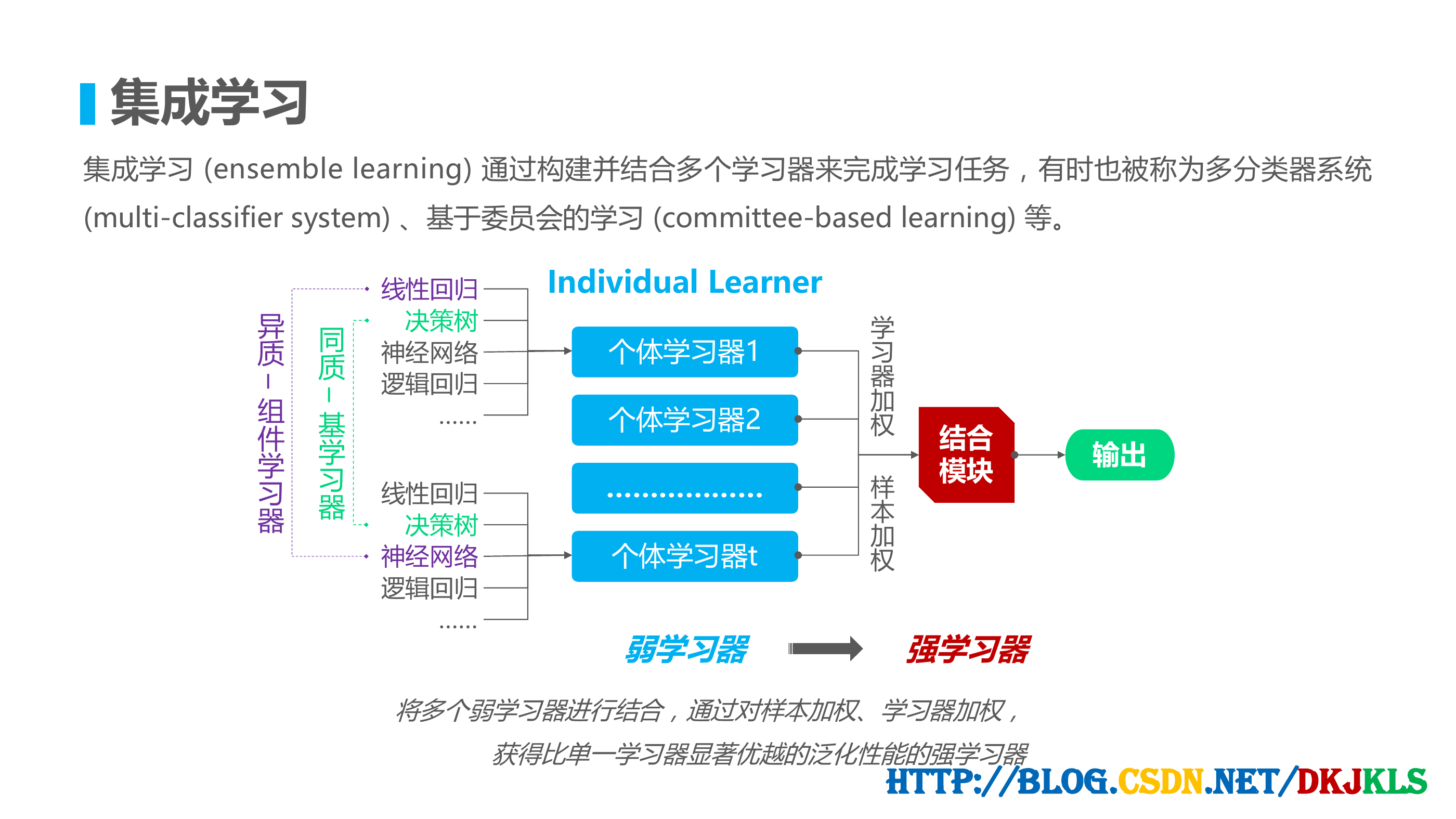

集成学习

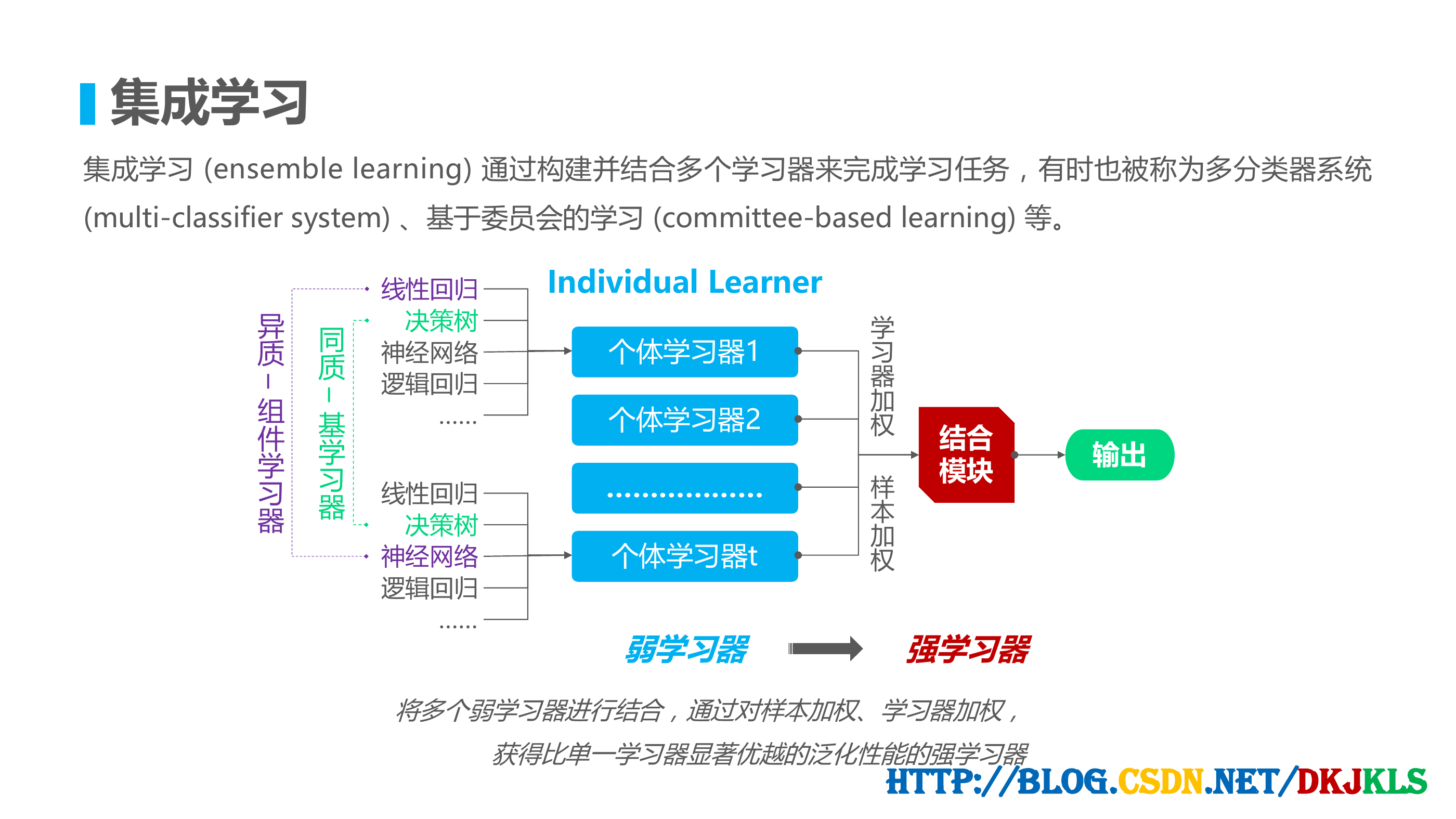

集成学习 (ensemble learning) 通过构建并结合多个学习器来完成学习任务,有时也被称为多分类器系统

(multi-classifier system) 、基于委员会的学习 (committee-based learning) 等。

异

质

–

组

件

学

习

器

同

质

–

基

学

习

器

线性回归

决策树

神经网络

逻辑回归

……

线性回归

决策树

神经网络

逻辑回归

……

Individual Learner

个体学习器1

个体学习器2

………………

个体学习器t

学

习

器

加

权

样

本

加

权

结合

模块

输出

弱学习器

强学习器

将多个弱学习器进行结合,通过对样本加权、学习器加权,

获得比单一学习器显著优越的泛化性能的强学习器

http://blog.csdn.net/dkjkls

�

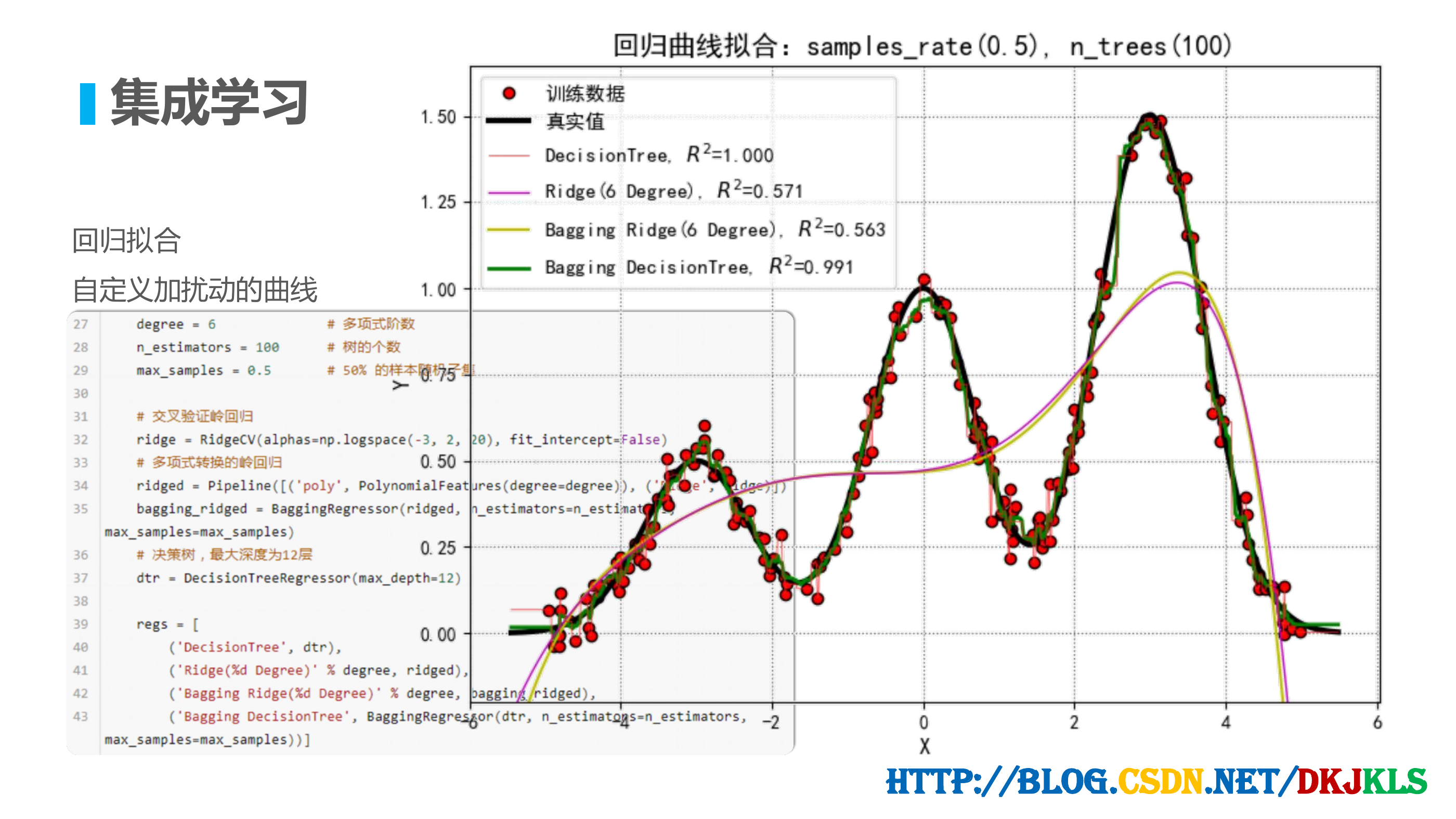

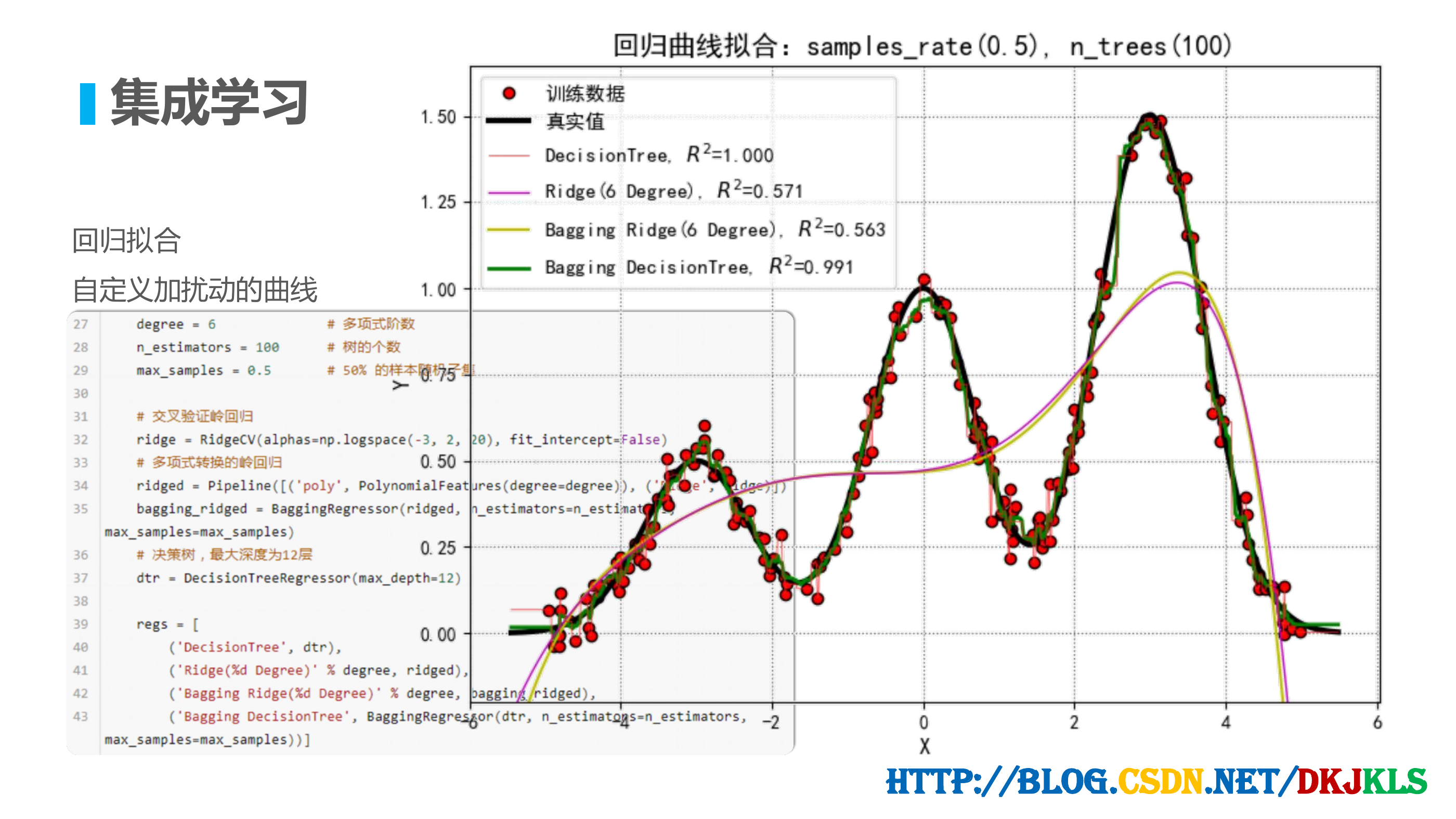

集成学习

回归拟合

自定义加扰动的曲线

http://blog.csdn.net/dkjkls

�

Bagging: 随机森林 及实战

http://blog.csdn.net/dkjkls

http://blog.csdn.net/dkjkls

�

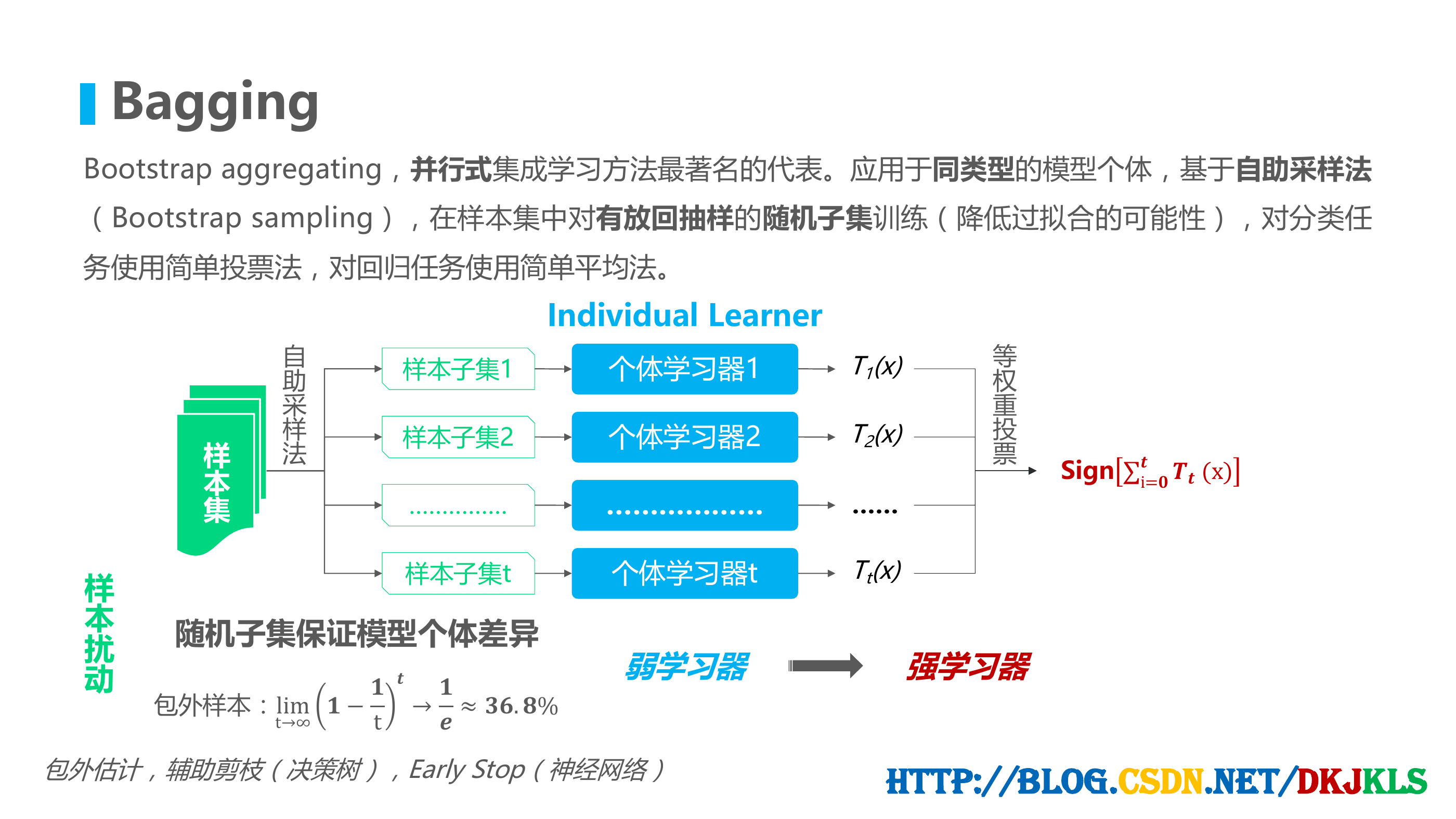

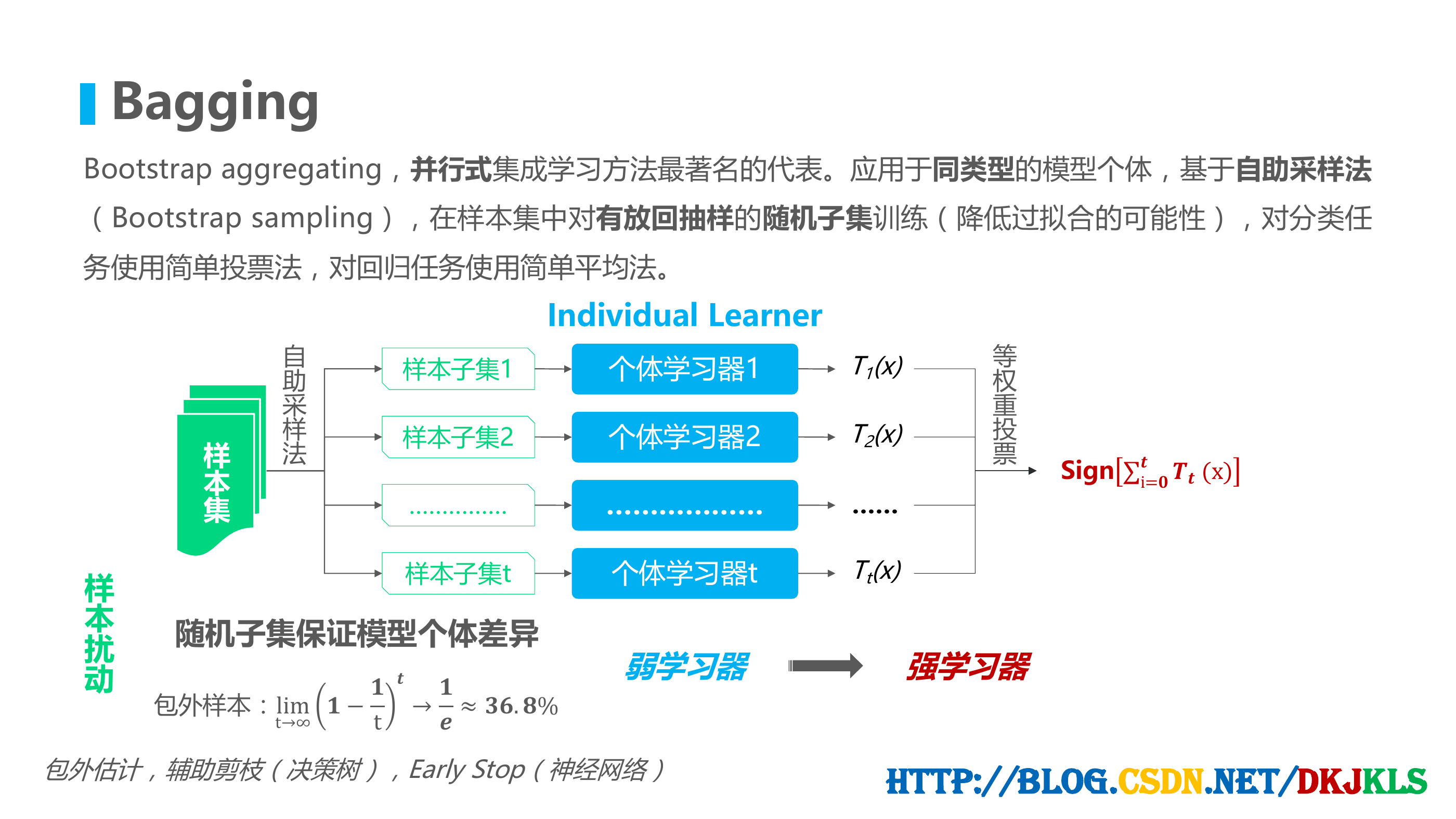

Bagging

Bootstrap aggregating,并行式集成学习方法最著名的代表。应用于同类型的模型个体,基于自助采样法

(Bootstrap sampling),在样本集中对有放回抽样的随机子集训练(降低过拟合的可能性),对分类任

务使用简单投票法,对回归任务使用简单平均法。

自

助

采

样

法

样

本

集

Individual Learner

样本子集1

个体学习器1

样本子集2

个体学习器2

……………

………………

样本子集t

个体学习器t

T1(x)

T2(x)

……

Tt(x)

等

权

重

投

票

Sign i= (x)

弱学习器

强学习器

样

本

扰

动

随机子集保证模型个体差异

包外样本:limt→∞ −t →≈.%

包外估计,辅助剪枝(决策树),Early Stop(神经网络)

http://blog.csdn.net/dkjkls

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc