公众号:数据挖掘 DW

ID:

d a t a d w

关注公众号并回复”数学”,可获取 word 版资料

机器学习中的数学(1)-回归(regression)、梯度下降(gradient descent)

这个系列主要想能够用数学去描述机器学习,想要学好机器学习,首先得去理解其中的数学意义,

不一定要到能够轻松自如的推导中间的公式,不过至少得认识这些式子吧,不然看一些相关的论文可

就看不懂了,这个系列主要将会着重于去机器学习的数学描述这个部分,将会覆盖但不一定局限于回

归、聚类、分类等算法。

回归与梯度下降:

回归在数学上来说是给定一个点集,能够用一条曲线去拟合之,如果这个曲线是一条直线,那就被

称为线性回归,如果曲线是一条二次曲线,就被称为二次回归,回归还有很多的变种,如 locally

weighted 回归,logistic 回归,等等,这个将在后面去讲。

用一个很简单的例子来说明回归,这个例子来自很多的地方,也在很多的 open source 的软件中

看到,比如说 weka。大概就是,做一个房屋价值的评估系统,一个房屋的价值来自很多地方,比如

说面积、房间的数量(几室几厅)、地段、朝向等等,这些影响房屋价值的变量被称为特征(feature),

feature 在机器学习中是一个很重要的概念,有很多的论文专门探讨这个东西。在此处,为了简单,

假设我们的房屋就是一个变量影响的,就是房屋的面积。

假设有一个房屋销售的数据如下:

面积(m^2) 销售价钱(万元)

123

250

�

150

87

102

…

320

160

220

…

这个表类似于帝都 5 环左右的房屋价钱,我们可以做出一个图,x 轴是房屋的面积。y 轴是房屋的

售价,如下:

如果来了一个新的面积,假设在销售价钱的记录中没有的,我们怎么办呢?

我们可以用一条曲线去尽量准的拟合这些数据,然后如果有新的输入过来,我们可以在将曲线上这

个点对应的值返回。如果用一条直线去拟合,可能是下面的样子:

绿色的点就是我们想要预测的点。

首先给出一些概念和常用的符号,在不同的机器学习书籍中可能有一定的差别。

房屋销售记录表 - 训练集(training set)或者训练数据(training data), 是我们流程中的输入数

据,一般称为 x

房屋销售价钱 - 输出数据,一般称为 y

拟合的函数(或者称为假设或者模型),一般写做 y = h(x)

训练数据的条目数(#training set), 一条训练数据是由一对输入数据和输出数据组成的

输入数据的维度(特征的个数,#features),n

�

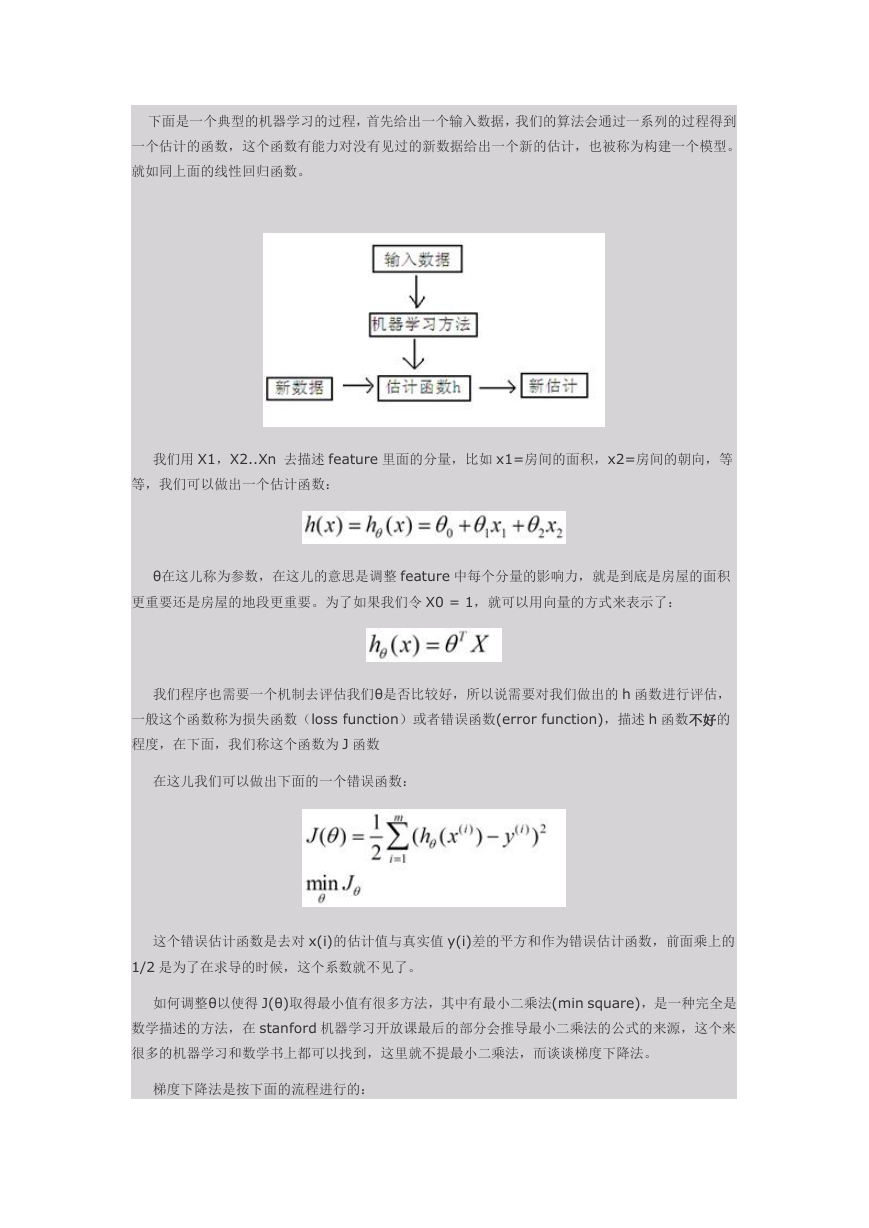

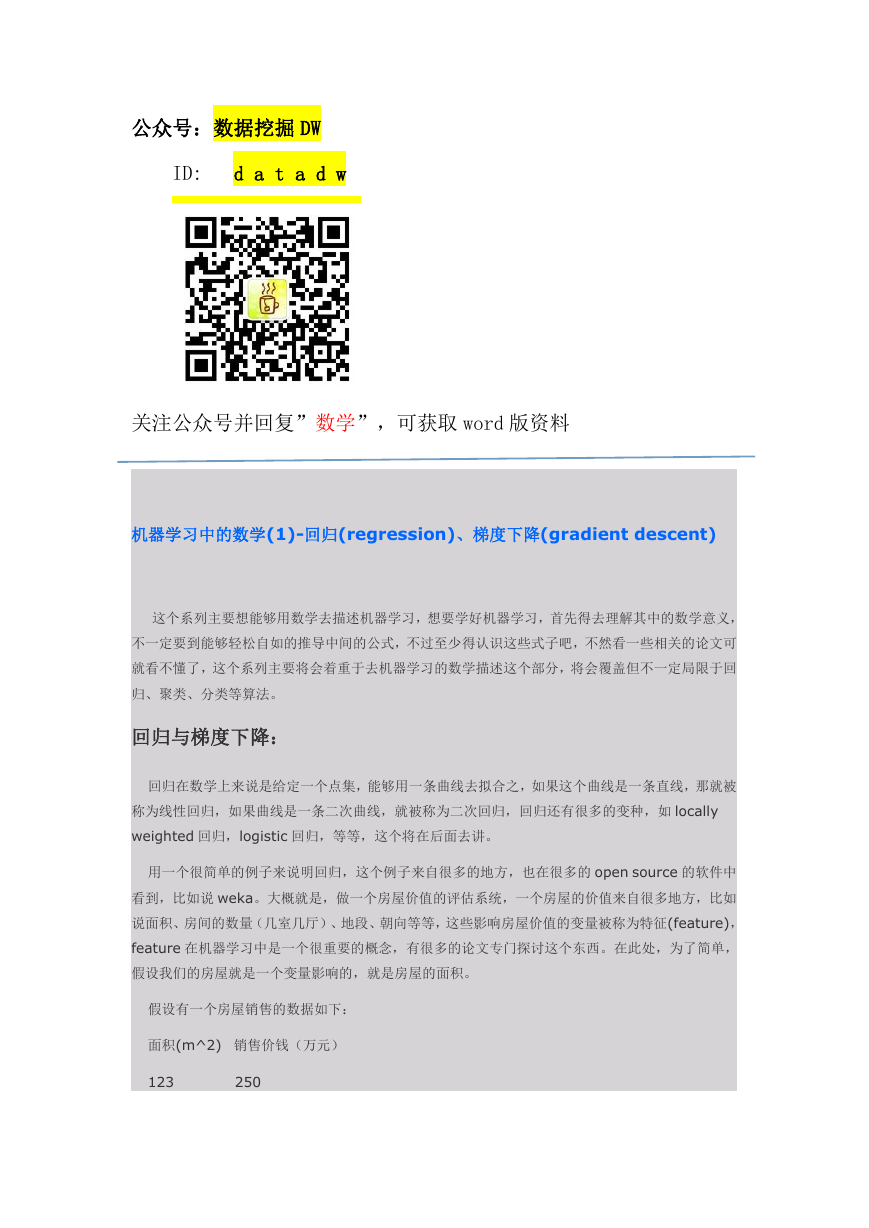

下面是一个典型的机器学习的过程,首先给出一个输入数据,我们的算法会通过一系列的过程得到

一个估计的函数,这个函数有能力对没有见过的新数据给出一个新的估计,也被称为构建一个模型。

就如同上面的线性回归函数。

我们用 X1,X2..Xn 去描述 feature 里面的分量,比如 x1=房间的面积,x2=房间的朝向,等

等,我们可以做出一个估计函数:

θ在这儿称为参数,在这儿的意思是调整 feature 中每个分量的影响力,就是到底是房屋的面积

更重要还是房屋的地段更重要。为了如果我们令 X0 = 1,就可以用向量的方式来表示了:

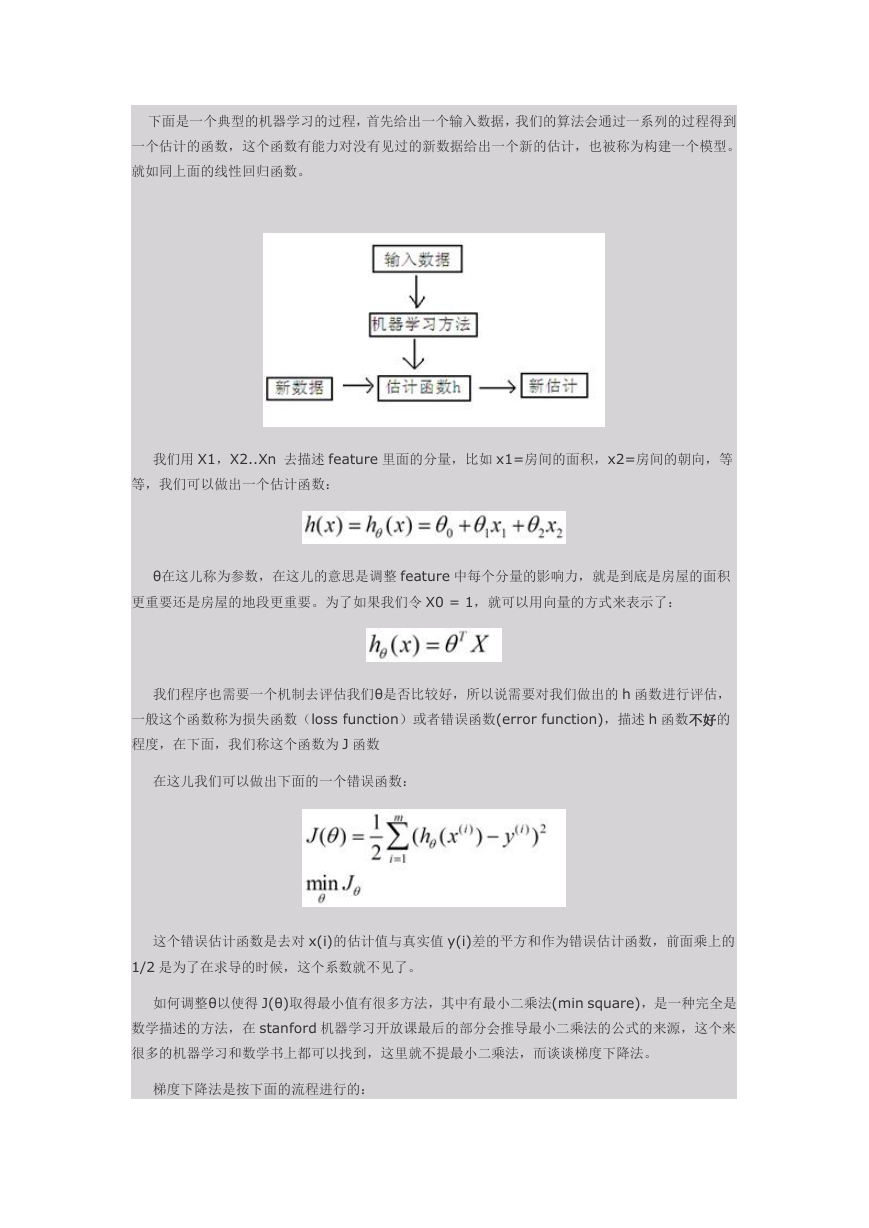

我们程序也需要一个机制去评估我们θ是否比较好,所以说需要对我们做出的 h 函数进行评估,

一般这个函数称为损失函数(loss function)或者错误函数(error function),描述 h 函数不好的

程度,在下面,我们称这个函数为 J 函数

在这儿我们可以做出下面的一个错误函数:

这个错误估计函数是去对 x(i)的估计值与真实值 y(i)差的平方和作为错误估计函数,前面乘上的

1/2 是为了在求导的时候,这个系数就不见了。

如何调整θ以使得 J(θ)取得最小值有很多方法,其中有最小二乘法(min square),是一种完全是

数学描述的方法,在 stanford 机器学习开放课最后的部分会推导最小二乘法的公式的来源,这个来

很多的机器学习和数学书上都可以找到,这里就不提最小二乘法,而谈谈梯度下降法。

梯度下降法是按下面的流程进行的:

�

1)首先对θ赋值,这个值可以是随机的,也可以让θ是一个全零的向量。

2)改变θ的值,使得 J(θ)按梯度下降的方向进行减少。

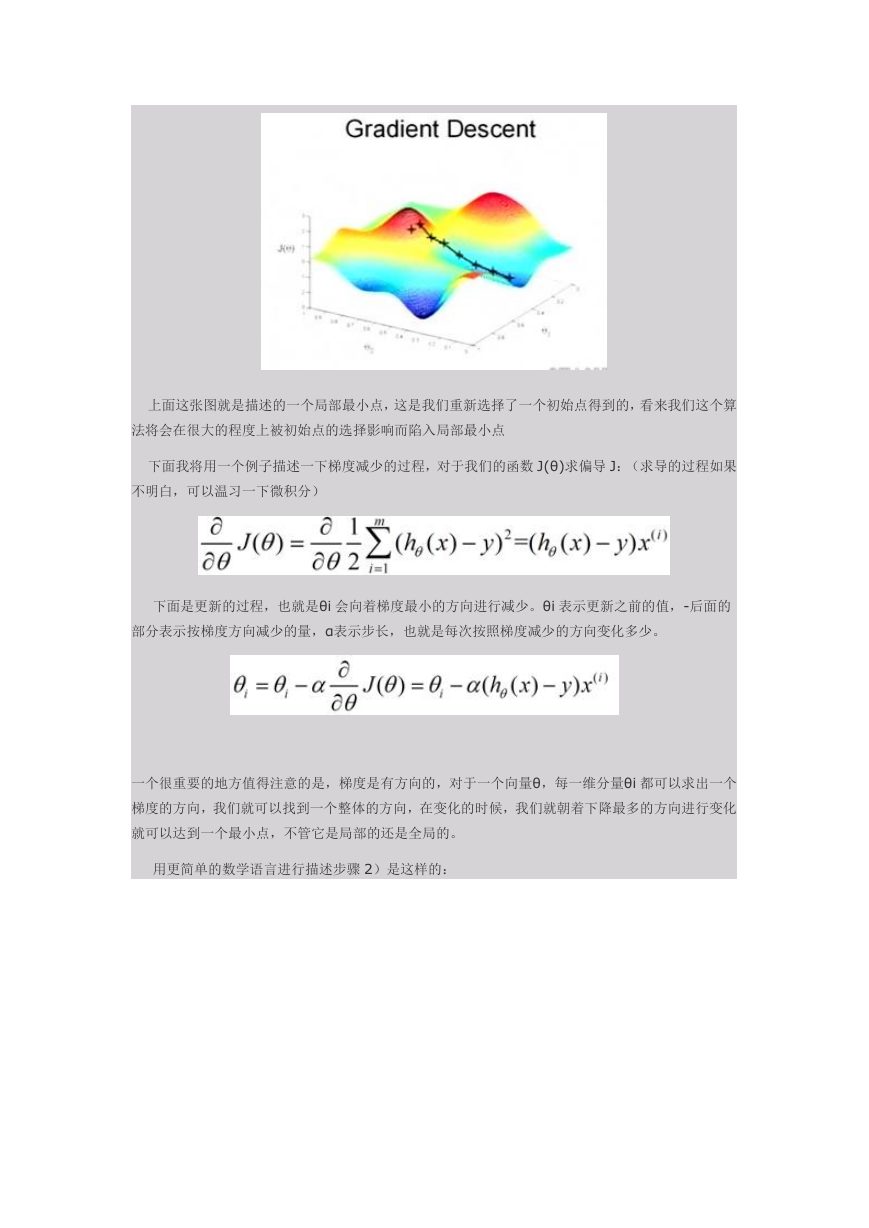

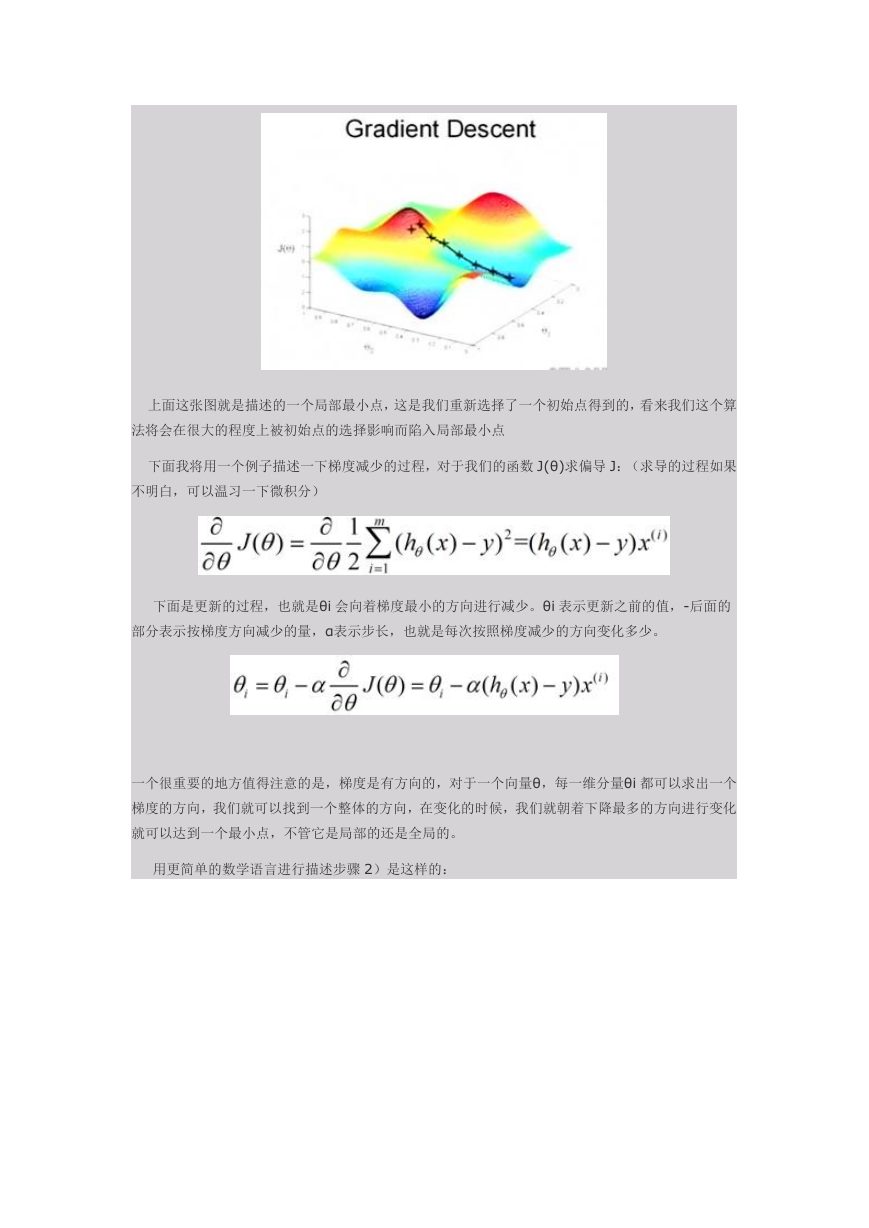

为了更清楚,给出下面的图:

这是一个表示参数θ与误差函数 J(θ)的关系图,红色的部分是表示 J(θ)有着比较高的取值,我们需要

的是,能够让 J(θ)的值尽量的低。也就是深蓝色的部分。θ0,θ1 表示θ向量的两个维度。

在上面提到梯度下降法的第一步是给θ给一个初值,假设随机给的初值是在图上的十字点。

然后我们将θ按照梯度下降的方向进行调整,就会使得 J(θ)往更低的方向进行变化,如图所示,

算法的结束将是在θ下降到无法继续下降为止。

当然,可能梯度下降的最终点并非是全局最小点,可能是一个局部最小点,可能是下面的情况:

�

上面这张图就是描述的一个局部最小点,这是我们重新选择了一个初始点得到的,看来我们这个算

法将会在很大的程度上被初始点的选择影响而陷入局部最小点

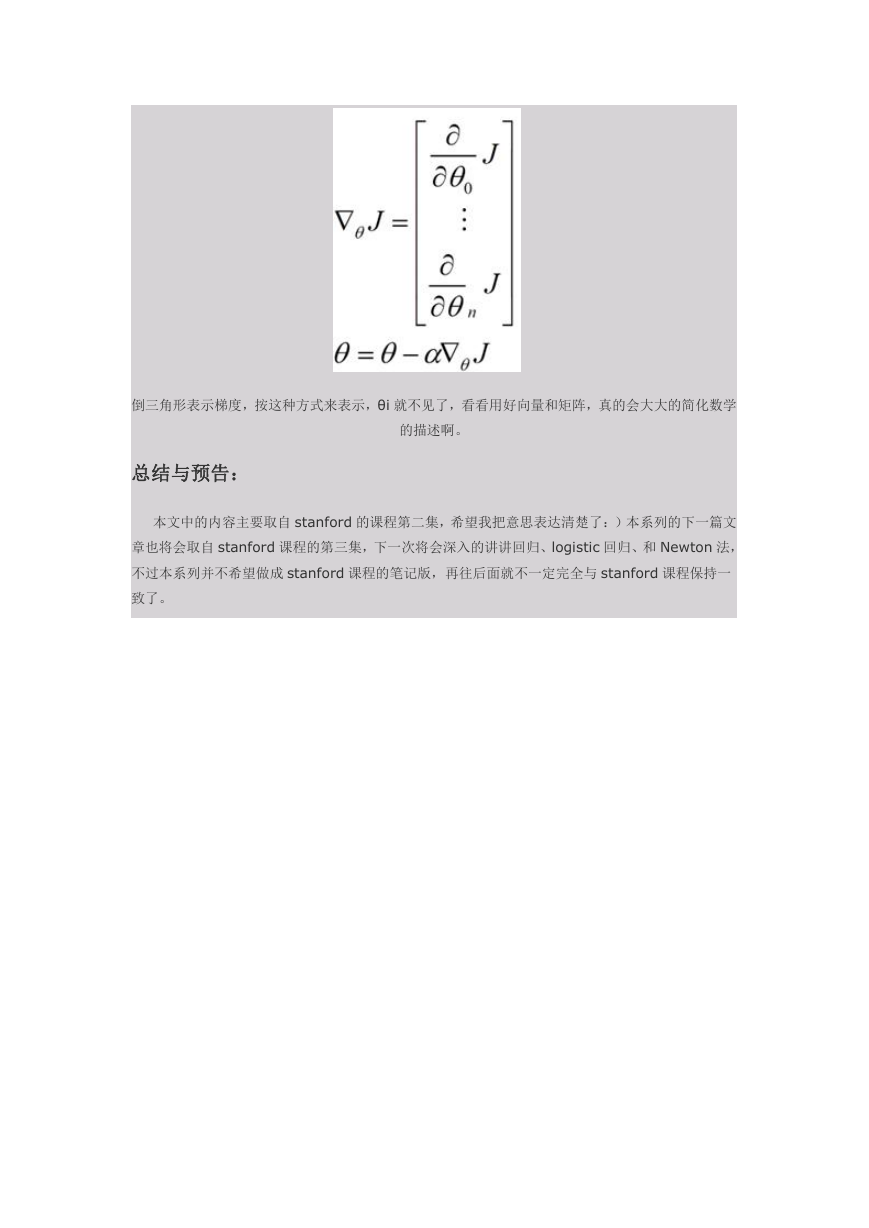

下面我将用一个例子描述一下梯度减少的过程,对于我们的函数 J(θ)求偏导 J:(求导的过程如果

不明白,可以温习一下微积分)

下面是更新的过程,也就是θi 会向着梯度最小的方向进行减少。θi 表示更新之前的值,-后面的

部分表示按梯度方向减少的量,α表示步长,也就是每次按照梯度减少的方向变化多少。

一个很重要的地方值得注意的是,梯度是有方向的,对于一个向量θ,每一维分量θi 都可以求出一个

梯度的方向,我们就可以找到一个整体的方向,在变化的时候,我们就朝着下降最多的方向进行变化

就可以达到一个最小点,不管它是局部的还是全局的。

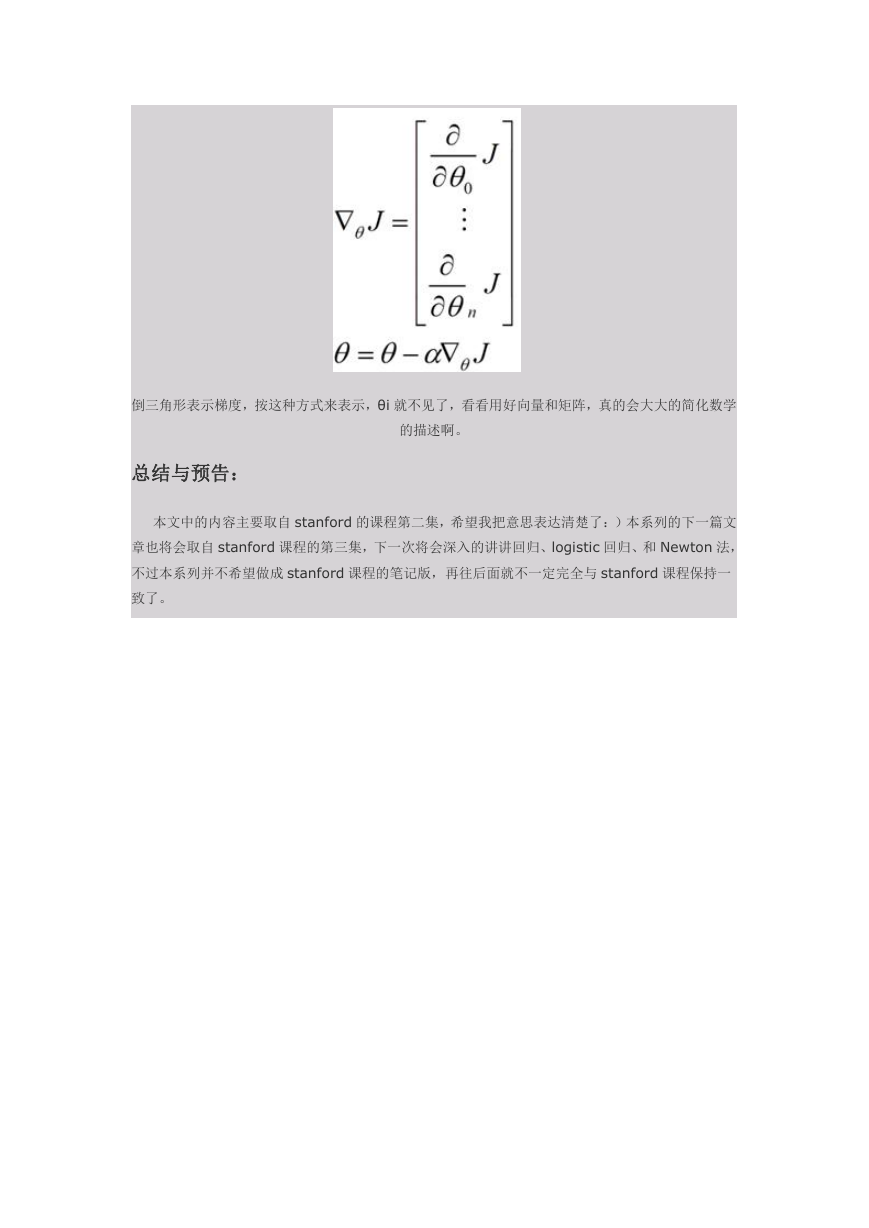

用更简单的数学语言进行描述步骤 2)是这样的:

�

倒三角形表示梯度,按这种方式来表示,θi 就不见了,看看用好向量和矩阵,真的会大大的简化数学

的描述啊。

总结与预告:

本文中的内容主要取自 stanford 的课程第二集,希望我把意思表达清楚了:)本系列的下一篇文

章也将会取自 stanford 课程的第三集,下一次将会深入的讲讲回归、logistic 回归、和 Newton 法,

不过本系列并不希望做成 stanford 课程的笔记版,再往后面就不一定完全与 stanford 课程保持一

致了。

�

机器学习中的数学(2)-支持向量机(SVM)基础

关于 SVM 的论文、书籍都非常的多,引用强哥的话“SVM 是让应

用数学家真正得到应用的一种算法”。SVM 对于大部分的普通人来说,

要完全理解其中的数学是非常困难的,所以要让这些普通人理解,得要

把里面的数学知识用简单的语言去讲解才行。而且想明白了这些数学,

对学习其他的内容也是大有裨益的。我就是属于绝大多数的普通人,为

了看明白 SVM,看了不少的资料,这里把我的心得分享分享。

其实现在能够找到的,关于 SVM 的中文资料已经不少了,不过个人

觉得,每个人的理解都不太一样,所以还是决定写一写,一些雷同的地

方肯定是不可避免的,不过还是希望能够写出一点与别人不一样的地方

吧。另外本文准备不谈太多的数学(因为很多文章都谈过了),尽量简

单地给出结论,就像题目一样-机器学习中的算法(之前叫做机器学习

中的数学),所以本系列的内容将更偏重应用一些。如果想看更详细的

数学解释,可以看看参考文献中的资料。

一、线性分类器:

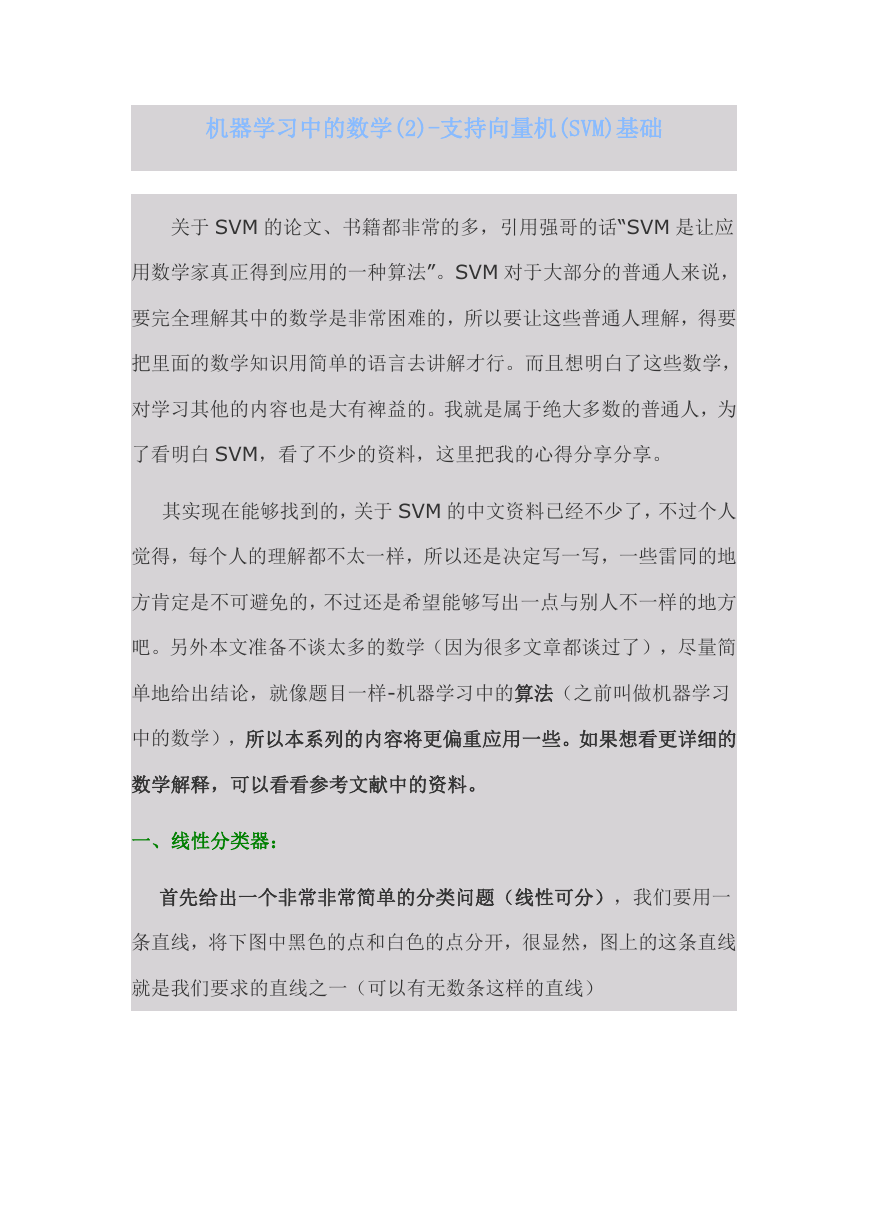

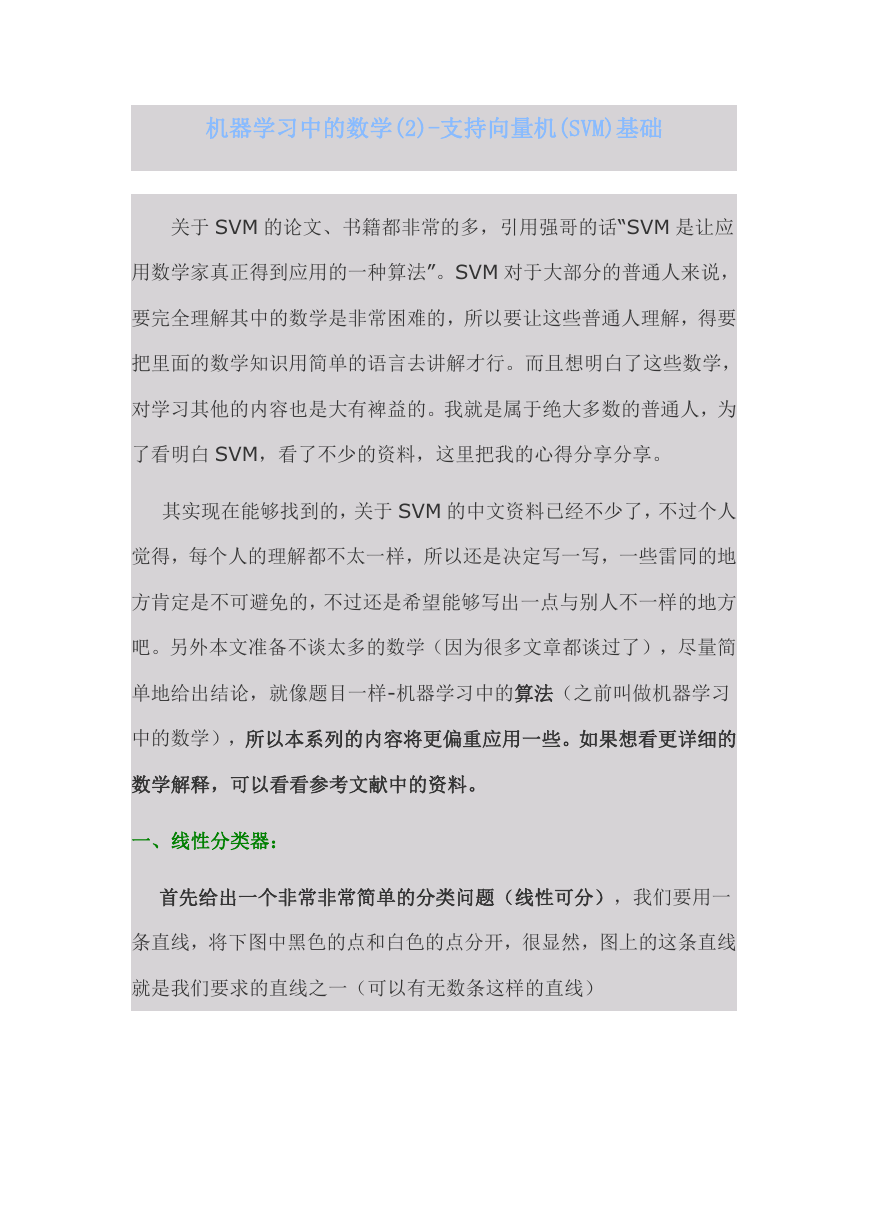

首先给出一个非常非常简单的分类问题(线性可分),我们要用一

条直线,将下图中黑色的点和白色的点分开,很显然,图上的这条直线

就是我们要求的直线之一(可以有无数条这样的直线)

�

假如说,我们令黑色的点 = -1, 白色的点 = +1,直线 f(x) = w.x

+ b,这儿的 x、w 是向量,其实写成这种形式也是等价的 f(x) = w1x1

+ w2x2 … + wnxn + b, 当向量 x 的维度=2 的时候,f(x) 表示二

维空间中的一条直线, 当 x 的维度=3 的时候,f(x) 表示 3 维空间中

的一个平面,当 x 的维度=n > 3 的时候,表示 n 维空间中的 n-1 维

超平面。这些都是比较基础的内容,如果不太清楚,可能需要复习一下

微积分、线性代数的内容。

刚刚说了,我们令黑色白色两类的点分别为+1, -1,所以当有一个

新的点 x 需要预测属于哪个分类的时候,我们用 sgn(f(x)),就可以预

测了,sgn 表示符号函数,当 f(x) > 0 的时候,sgn(f(x)) = +1, 当

f(x) < 0 的时候 sgn(f(x)) = –1。

但是,我们怎样才能取得一个最优的划分直线 f(x)呢?下图的直线

表示几条可能的 f(x)

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc