第 46 卷 第 5 期

Vol. 46

No. 5

·热点与综述·

计 算 机 工 程

Computer Engineering

2020

年

5

月

M ay 2020

文章编号: 1000-3428( 2020) 05-0001-11

文献标志码: A

中图分类号: TP391. 1

面向深度学习的多模态融合技术研究综述

何 俊1,张彩庆2a,李小珍1,张德海2b

(

1.

昆明学院 信息工程学院,昆明

650214

;

2.

云南大学

a.

外国语学院;

b.

软件学院,昆明

)

650206

摘 要: 面向深度学习的多模态融合技术是指机器从文本

升模型性能,而模态的普遍性和深度学习的热度促进了多模态融合技术的发展

提升深度学习模型分类与回归性能为出发点,阐述多模态融合架构

编解码器

与对齐技术,在此基础上归纳多模态融合研究的常用公开数据集,并对跨模态转移学习

态组合评价等下一步的研究方向进行展望

关键词: 深度学习; 多模态; 模态融合; 模态对齐; 多核学习; 图像模型

语音和视频等领域获取信息实现转换与融合以提

、

在多模态融合技术发展前期,以

协同

、

图像模型和神经网络等具体融合方法

、

多模

、

种融合架构在深度学习中的应用情况与优缺点,以及多核学习

融合方法和对齐技术

、

模态语义冲突消解

、

重点分析联合

图像

、

。

。

。

3

、

开放科学( 资源服务) 标志码( OSID) :

中文引用格式: 何俊,张彩庆,李小珍,等

]

面向深度学习的多模态融合技术研究综述[

J

.

.

计算机工程,

2020

(

,

46

5

) :

1-11.

英文引用格式: HE Jun

deep learning

[

]

J

,

ZHANG Caiqing

. Computer Engineering

,

,

2020

LI Xiaozhen

) :

(

,

46

5

1-11.

,

et al. Survey of research on multimodal fusion technology for

Survey of Research on Multimodal Fusion Technology for Deep Learning

HE Jun1,

ZHANG Caiqing 2a,

,

Kunming University

LI Xiaozhen1,

ZHANG Dehai2b

,

Kunming 650214

,

China

;

1. College of Information Engineering

(

2a. College of Foreign Languages

2b. College of Softw are

;

,

Yunnan University

,

Kunming 650206

,

China

)

)

(

(

M FT

,

images

)

for Deep Learning

,

voices

DL

,

videos and other materials

refers to the conversion and fusion of

【Abstract】M ultimodal Fusion Technology

,

so as to improve the performance

information obtained by machine from texts

of the model. The universality of modals and the heat of DL boost the rapid development of multimodal fusion. In order to

fusion

improve the performance of DL model classification or regression

,

fusion methods and alignment technologies in the early stage of M FT development. This paper focuses on the

architecture

,

analysis of the three fusion architectures

in terms of their adoption in DL and

advantages / disadvantages. The specific fusion methods and alignment technologies such as M ultiple Kernel Learning

,

(

the public datasets commonly used in

,

,

cooperative and codec architectures

this paper summarizes the multimodal

are also studied. Finally

and Neural Netw ork

Graphic M odel

M KL

) ,

joint

GM

NN

,

,

(

)

(

)

:

and the direction of

further research in cross-modal

transfer learning

,

and multimodal combination evaluation is prospected.

;

;

;

multimodality

modal fusion

modal alignment

M ultiple Kernel Learning

(

) ;

M KL

multimodal fusion research are summarized

resolution of modal semantic conflicts

【Key words】Deep Learning

Graphical M odel

DOI

10. 19678 / j. issn. 1000-3428. 0057370

GM

DL

) ;

(

(

)

:

0 概述

近年来,深度学习(

机器翻译

、

、

情感分析

、

Deep Learning

DL

自然语言处理 (

,

) 在图像

Natural

识别

,

NLP

) 等领域得到广泛应用并

Language Processing

取得较多研究成果,为使机器能更全面高效地感知

周围的世界,需要赋予其理解

推理及融合多模态信

、

息的能力,并且由于人们生活在一个多领域相互交

基金项目: 国家自然科学基金(

作者简介: 何 俊(

张德海,副教授

博士

、

收稿日期: 2020-02-11

1977—

。

修回日期: 2020-03-13

E-mail: 369885901@ qq. com

61263043

) ,男,副教授

,

61864004

博士,主研方向为机器学习

、

) ; 云南省地方本科高校基础研究联合专项(

软件演化

、

2017FH001-05

数据分析; 张彩庆,讲师

、

、

)

。

硕士; 李小珍,讲师

博士;

、

�

2

计 算 机 工 程

2020

年

5

月

15

日

、

看到的实物

、

融的环境中,听到的声音

闻到的味道

都是一种模态,因此研究人员开始关注如何将多领

域数据进行融合实现异质互补,例如语音识别的研

究表明,视觉模态提供了嘴的唇部运动和发音信息,

包括张开和关闭,有助于提高语音识别性能

可见,

利用多种模式的综合语义对深度学习研究具有重要

意义

深度学习中的多模态融合技术(

Multimodality

]是模型在分析和识别任务

Fusion Technology

时处理不同形式数据的过程

多模态数据的融合可

为模型决策提供更多信息,从而提高决策总体结果

的准确率,其目标是建立能够处理和关联来自多种

模态信息的模型

,

MFT

) [

。

。

。

1

。

]

3

]

2

]

4

。

、

、

、

。

。

M FT

转 换

融 合

主要包括模 态 表 示

对 齐 技

由于不同模态的特征向量最初位于不同的子

术[

空间中,即具有异质性,因此将影响多模态数据在深

为解决该问题,可将异构特

度学习领域的应用[

征投影到公共子空间,由相似向量表示具有相似语

因此,多模态融合技术的主要

义的多模态数据[

目标是缩小语义子空间中的分布差距,同时保持模

态特定语义的完整性,例如利用多模态融合特征,提

高视频分类[

跨模态

情感分析[

、

翻译[

特别是多模态融合近

期在计算机视觉

和语音识别等应用中取得的

],已引起学术界和工业界的广泛关

突出性成果[

注

模态对齐

、

方式和公开数据资源等,对面向深度学习的多模态

融合技术进行分析与研究

事件检测[

、

]等跨媒体分析性能

本文根据多模态融合架构

融合方法

、

、NLP

。

。

、

]

5

8-9

6-7

]

]

10

11

。

1 多模态融合架构

2

。

。

]: 联合架构,协同架构和编解码器架构

多模态融合的主要目标是缩小模态间的异质性

差异,同时保持各模态特定语义的完整性,并在深度

学习模型中取得较优的性能

多模态融合架构分

联合架

为[

构是将单模态表示投影到一个共享语义子空间中,

以便能够融合多模态特征

协同架构包括跨模态相

似模型和典型相关分析,其目标是寻找协调子空间

中模态间的关联关系

编解码器架构是将一个模态

种融合

映射到另一个模态的多模态转换任务中

语音识别等领域得到广

架构在视频分类

、

泛应用,且涉及图像

文本等融合内容,

语音

、

具体应用情况如表

情感分析

、

视频

、

所示

。3

。

。

、

1

。

Table 1

3 种多模态融合架构的应用情况

表 1

Application situation of three architectures for

multimodal fusion

架构

应用领域

融合内容

参考文献

视频分类 语音

事件检测 语音

情绪分析 语音

视觉问答

情感分析 语音

视频

、

视频

、

视频

、

图像

文本 文献[

,

5

、

12

文献[

]

文本

、

7

文本 文献[

、

文本

、

视频

、

语音

文献[

文献[

文献[

15-16

]

13-14

]

17

]

]

]

18

语音识别

跨模态搜索

图像标注

跨模态嵌入 图像

图像

文本

、

视频

、

文本

、

文本

、

视频

、

图像

图像

联合

架构

协同

架构

]

文献[

文献[

19-20

]

21

文献[

22-23

]

24

文献[

]

25

文本 文献[

、

文本

、

文本

、

文本

、

文本

、

文献[

文献[

26-27

]

28

]

]

图像

视频

图像

编解码器

架构

转移学习

图像标注

视频解码

图像合成

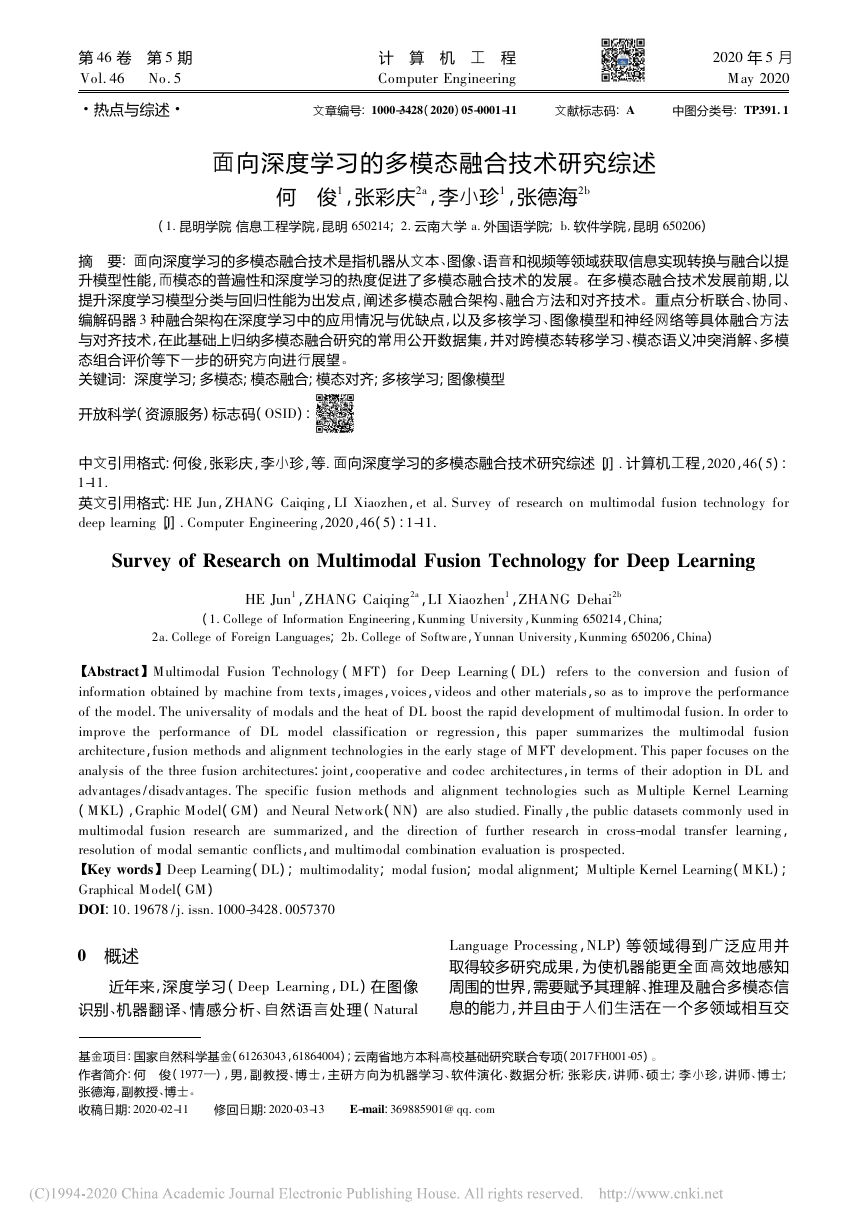

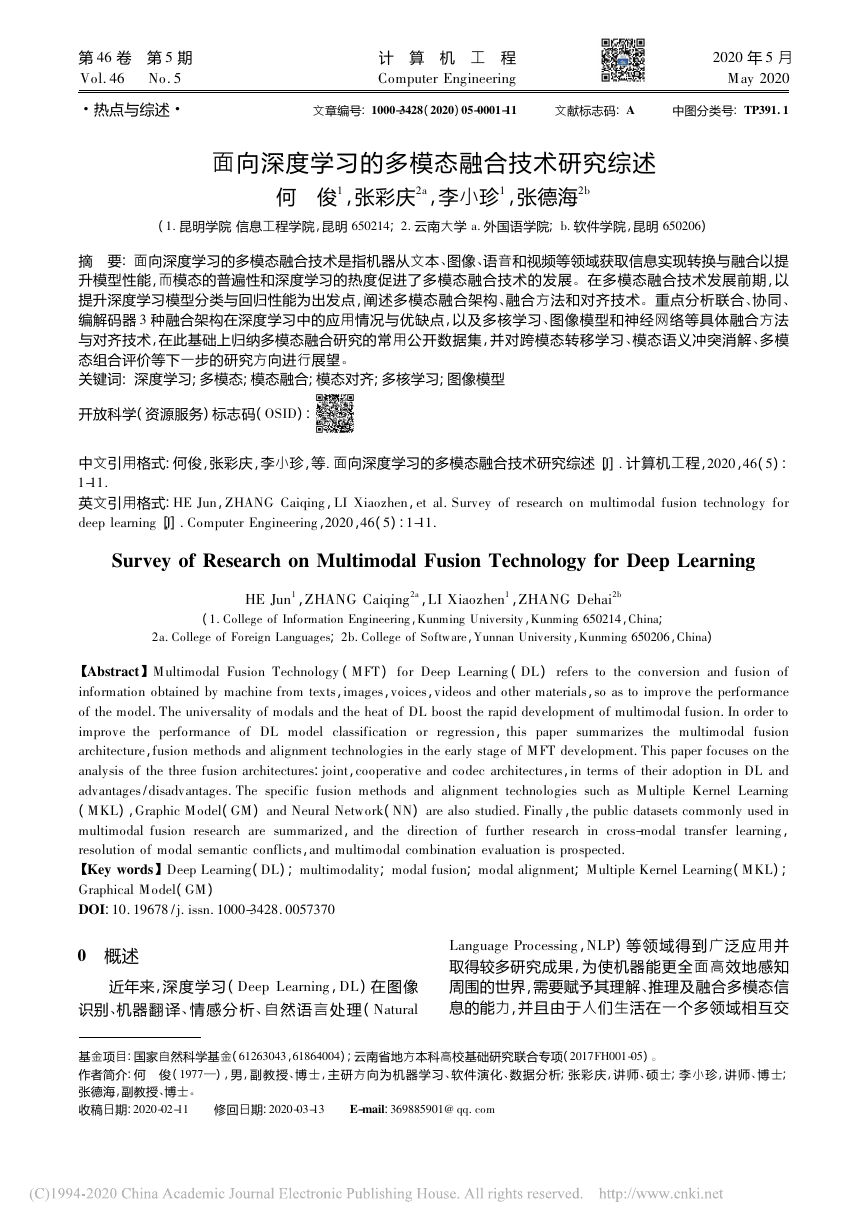

1. 1 联合架构

多模态融合策略是集成不同类型的特征来提高

机器学习模型性能,消除不同模态的异质性差异

。

联合架构是将多模态空间映射到共享语义子空间

中,从而融合多个模态特征[

每个单

一模态通过单独编码后,将被映射到共享子空间中,

遵循该策略,其在视频分类[

情感分

、

]等多模态分

析[

类或回归任务中都表现出较优的性能

事件检测[

、

视觉问答[

、

]和语音识别[

],如图

所示

。

13-14

15-16

17-18

]

7

1

]

]

12

2

。

图 1 联合融合架构示意图

Fig. 1 Schematic diagram of joint fusion architecture

多模态联合架构的关键是实现特征

,一

种较简单的方法是直接连接,即

该

方法在不同的隐藏层实现共享语义子空间,将转换

后的各个单模态特征向量语义组合在一起,从而实

联合

联合方法

加

“

”

“

”

。

�

第

46

卷 第

期

5

现多模态融合,如式(

何 俊,张彩庆,李小珍,等: 面向深度学习的多模态融合技术研究综述

3

) 所示:

1

z = f

wT

1 v1 + wT

2 v2 + … + wT

(

是共享语义子空间中的输出结果,

v

)

是各单

是权重,下标表示不同的模态,通过

n vn

1

)

(

其中,

z

模态的输入,

w

映射

将所有子模态语义转换到共享子空间

f

另一种常用方法是

“

乘

联合方法,如文献[

]

视频和音频等模态融合在统一的张量中,而

将语言

、

张量是由所有单模态特征向量的输出乘积构成,如

式(

) 所示:

”

29

。

2

]

[

v1

1

]

[

v2

1

z =

…

[

]

vn

1

(

)

2

表示不同的

表示融合张量后的结果输出,

v

表示外积算子

。

其中,

z

模态,

尽管

”

“

”

“

乘

加

联合方法简单且容易实现,但其特征

向量语义组合容易造成后期语义丢失,使模型性能

降低,而

联合方法弥补了这一不足,通过张量计

算使特征语义得到充分融合,例如文献[

]的多模

态情感预测模型由包括许多内部乘积的连续神经层

组成,其充分利用深度神经网络的多层性质,将不同

模态有序分布在不同层中,并在模型训练过程中动

态实现向量语义组合

17

。

。

30 -31

文献[

此外,联合架 构 对 每 个 单 模 态 的 语 义 完 整 性

有较高要求,数据不完整或错误 问 题 在 后 期 融 合

中会被放大,一些研究人员通过 联 合 训 练 或 模 态

]通过多模

相关性来解决这一问题

态联合处理某些单模态中的部 分 数 据 缺 失 问 题 ,

以便可以利用更多且更完整的 训 练 数 据 ,或 者 在

一种或多种模态数据缺失的情 况 下 ,尽 量 减 少 对

]利 用 各 单 模 态

后续训练任 务 的 影 响

特征之间的相 关 性 ( 如 权 重 相 似 性 ) 来 发 现 模 态

之间的关系,从而对这些特征进行分类使用,该方

法在视频分类任务中的实验结果表明其有助于提

高机器学习模型性能

文 献[

12

。

。

多模态联合架构的优点是融合方式简单,且共

享子空间通常具备语义不变性,有助于在机器学习

模型 中 将 知 识 从 一种 模 态 转 换 到 另 一 种 模 态

。

其缺点是各单模态语义完整性不易在早期发现和

处理

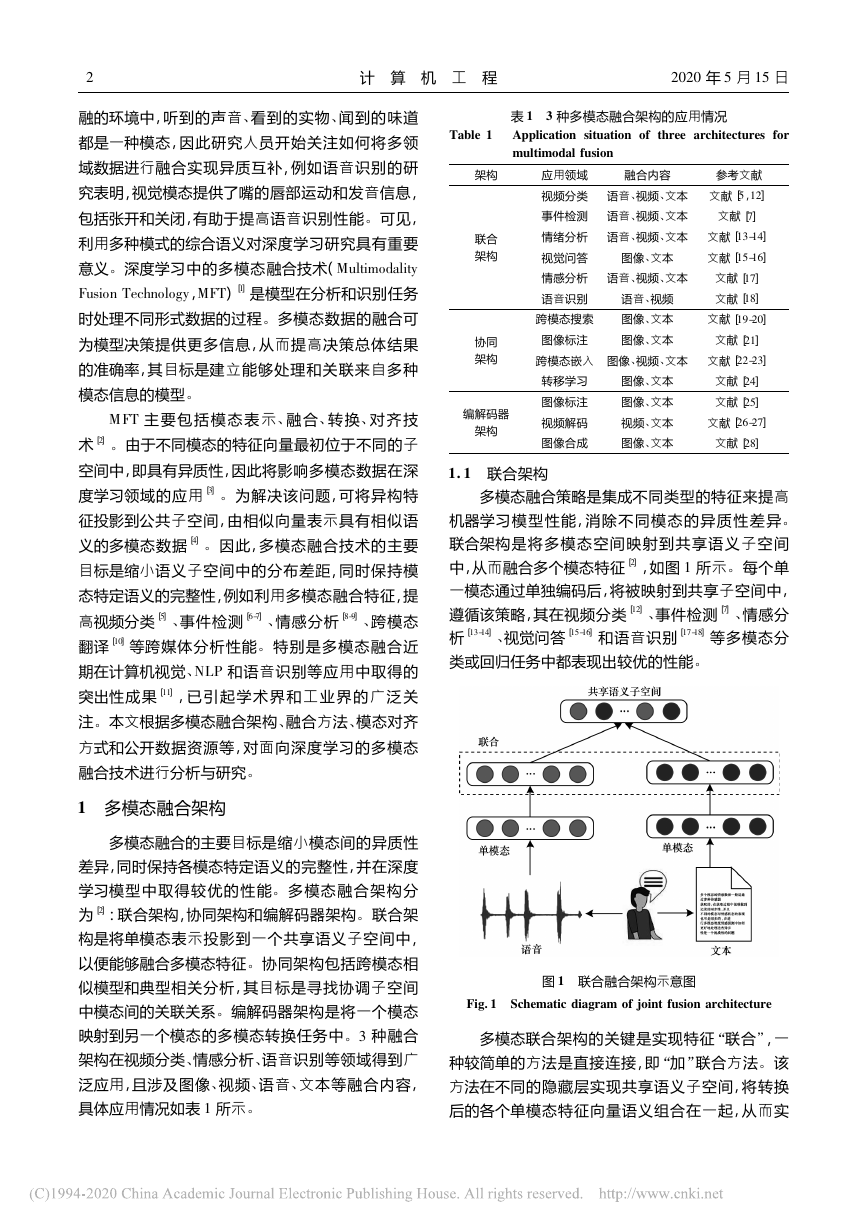

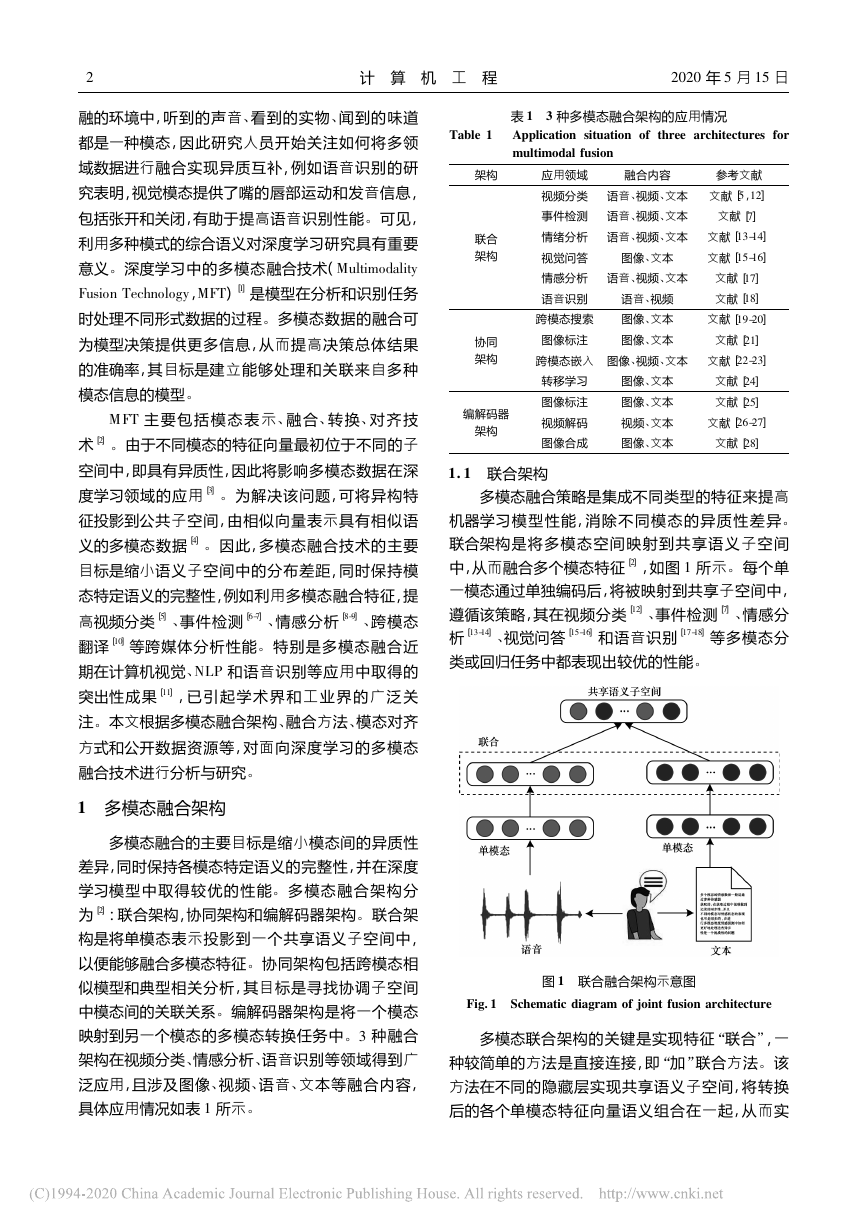

1. 2 协同架构

。

多模态协同架构是将各种单模态在一些约束的

由于不同模态包含的信息

作用下实现相互协同[

不同,因此协同架构有利于保持各单模态独有的特

征和排它性,如图

所示

。

]

2

2

。

图 2 协同融合架构示意图

Fig. 2 Schematic diagram of collaborative fusion architecture

协同架构在跨模态学习中已经得到广泛应用,

主流的协同方法是基于交叉模态相似性方法,该方

法旨在通过直接测量向量与不同模态的距离来学习

公共子空间[

基于交叉模态相关性的方法旨在

学习一个共享子空间,从而使不同模态表示集的相

关性最大化[

。

]

4

]

32

。

f

3

(

∈D

) 所示:

,

)

v

t

,

)

v

t

交叉模态相似性方法在相似性度量的约束下保

持模态间和模态内的相似性结构,使得相同语义或

相关对象的跨模态相似距离尽可能小,不同语义的

距离尽可能大,例如文献[

]提出的模态间排名方

法用于完成视觉和文本融合任务,将视觉和文本的

匹配嵌入向量表示为(

,融合目标函数用一

个损失函数

,

)

v

t

表示,如式(

23

t

)

(

(

(

(

(

(

3

0

+

22

+ S

+ S

∑

t -

∑

v -

max

f = ∑

v

,

33-34

,

α - S

,

α - S

0

是相似性度量函数,

t - ) )

,

v

,

v - ) )

max

∑

t

其中,

是边缘,

不匹

t - 是与

v

S

α

不匹配的嵌入向量,且

配的嵌入向量,

t - 和

v - 是与

t

该方法保持了模态间和模态

v - 是随机选择的样本

。

内的相似性结构,同时实现模态之间相互协同

此

]采用其他方法来度量距离,如欧

外,文献[

式距离,其目的都是使配对样本距离最小化

除了

学习模态间相似性的度量外,跨模态应用的另一个

关键问题是保持模态间相似性结构,此类方法通常

对模态特征的类别进行分类,使它们在每种模态下

],同时兼顾模态协同和特征融

具有一定的区分度[

由于协同架构的这一灵活特点,使其在语音识

合

。

迁移学习和图像标注等领域都有广泛应用

别

、

协同架构的优点是每个单模态都可以独立运

行,这一特性有利于跨模式迁移学习,其目的是在不

。

。

。

19

�

4

计 算 机 工 程

2020

年

5

月

15

日

其缺点是模态融合难

同模态或领域之间传递知识

度较大,使跨模态学习模型不容易实现,同时模型很

难在两种以上的模态之间实现迁移学习

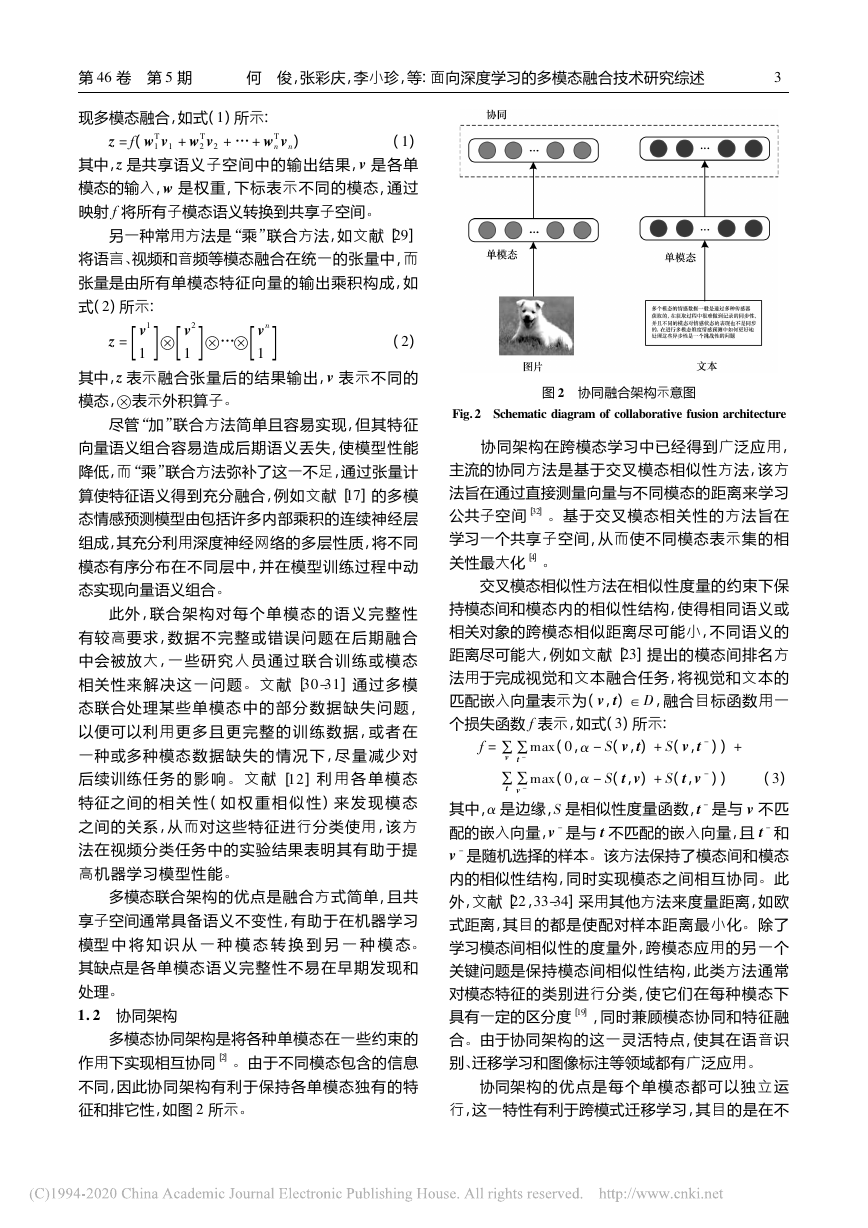

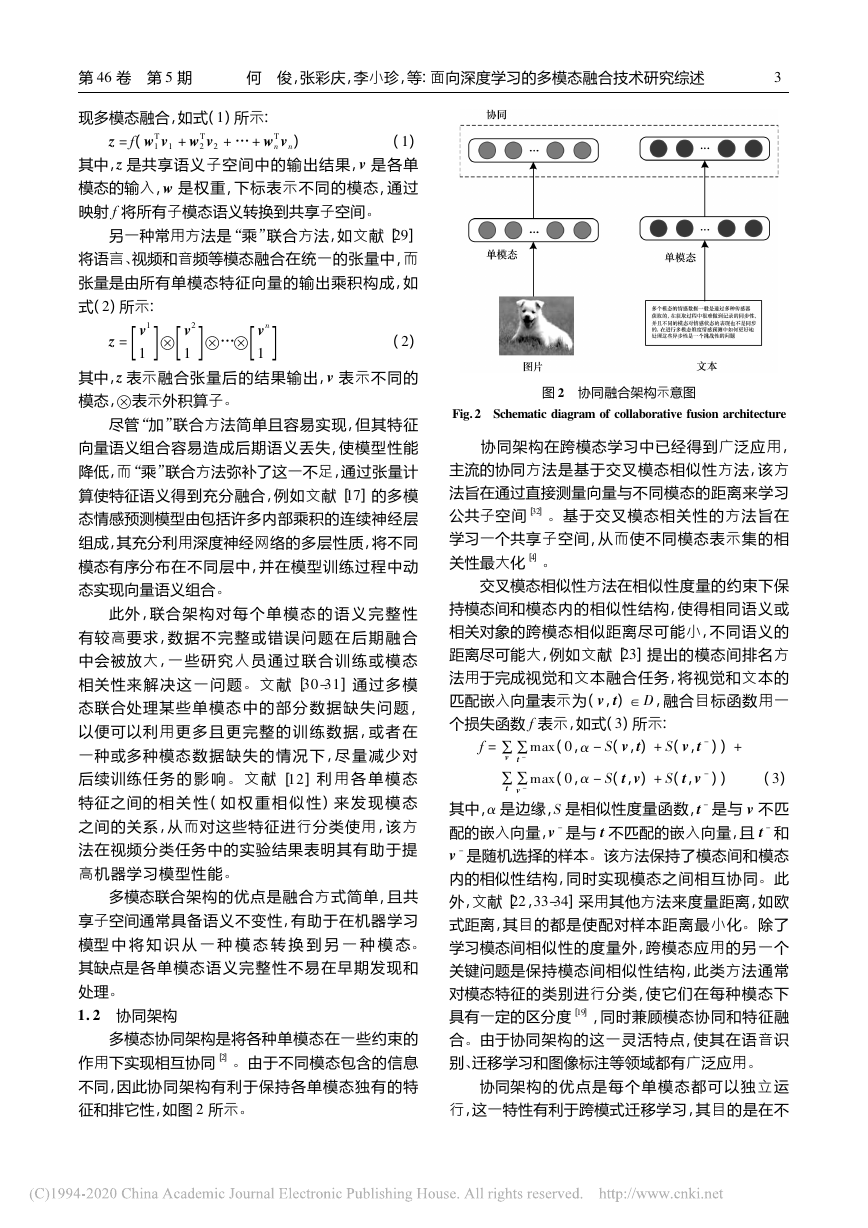

1. 3 编解码器架构

。

。

编解码器架构通常用于将一种模态映射到另一

种模态的多模态转换任务中,主要由编码器和解码

中,

器两部分组成

。

v

解码器基于向量

该

生成一个新的目标模态样本

v

架构在图像标注

视频解码等领域有广泛

图像合成

、

、

应用,如图

所示

编码器将源模态映射到向量

。

3

。

一些正则化术语保持模态之间的语义一致性,需确保

编码器能正确检测和编码信息,而解码器能推理高级

语义和生成语法,以保证源模态中语义的正确理解和

目标模态中新样本的生成

为解决多模序列的编码

和解码问题,需训练一个灵活的特征选择模块,而训

练序列的编码或解码可以看作顺序决策问题,因此通

常需采用决策能力强的模型和方法处理该问题,例如

深度强化学习(

) ,

其是一种常用的多模序列编解码工具[

Deep Reinforcement Learning

,

DRL

。

]

35

尽管多数编解码器架构只包含编码器和解码

器,但也有一些架构是由多个编码器或解码器组成

。

]提出一种跨乐器翻译音乐的模型,其

例如: 文献[

中涉及一个编码器和多个解码器; 文献[

]是一种

图像到图像的翻译模型,由多个内容编码器和样式

编码器组成,每个编码器都负责一部分工作

37

36

。

编解码器架构的优点是能够在源模态基础上生成

其缺点是每个编码器和解码器只

新的目标模态样本

能编码其中一种模态,并且决策模块设计复杂

。

。

。

图 3 编解码器融合架构示意图

2 多模态融合方法

Fig. 3 Schematic diagram of encoder-decoder fusion architecture

目前,编解码器架构重点关注共享语义捕获和多

模序列的编解码问题

为有效捕获源模态和目标模

态 两种模态的共享语义,主流的解决方案是通过

。

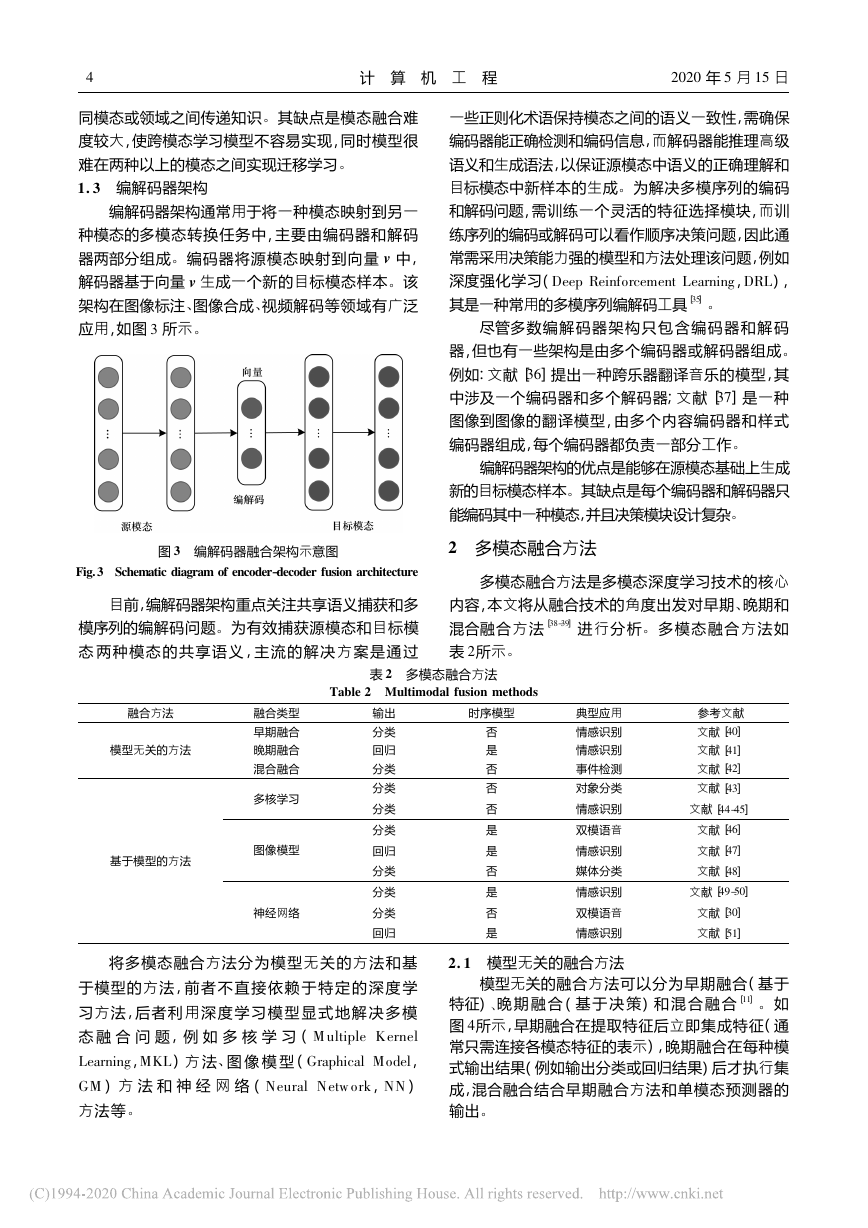

多模态融合方法是多模态深度学习技术的核心

晚期和

、

多模态融合方法如

内容,本文将从融合技术的角度出发对早期

混合融合方法[

表

]进行分析

。

38-39

所示

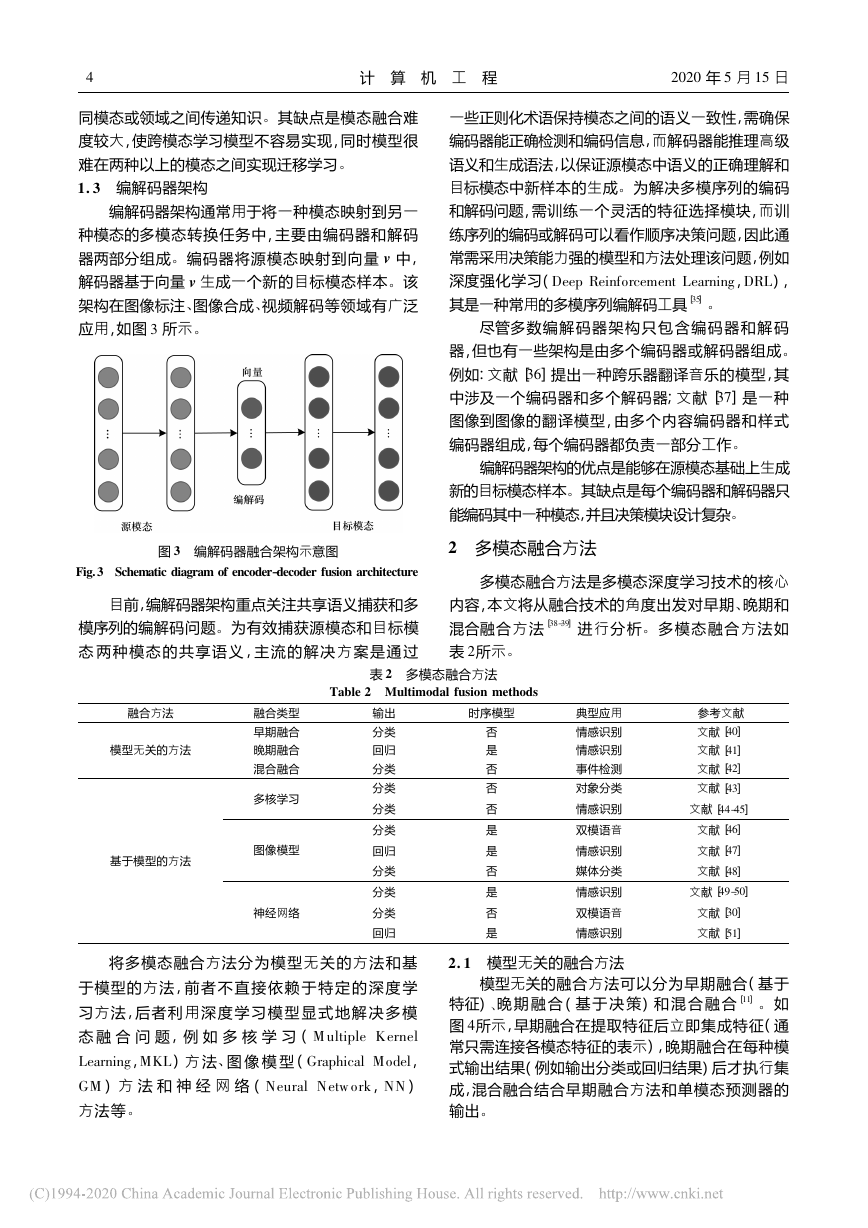

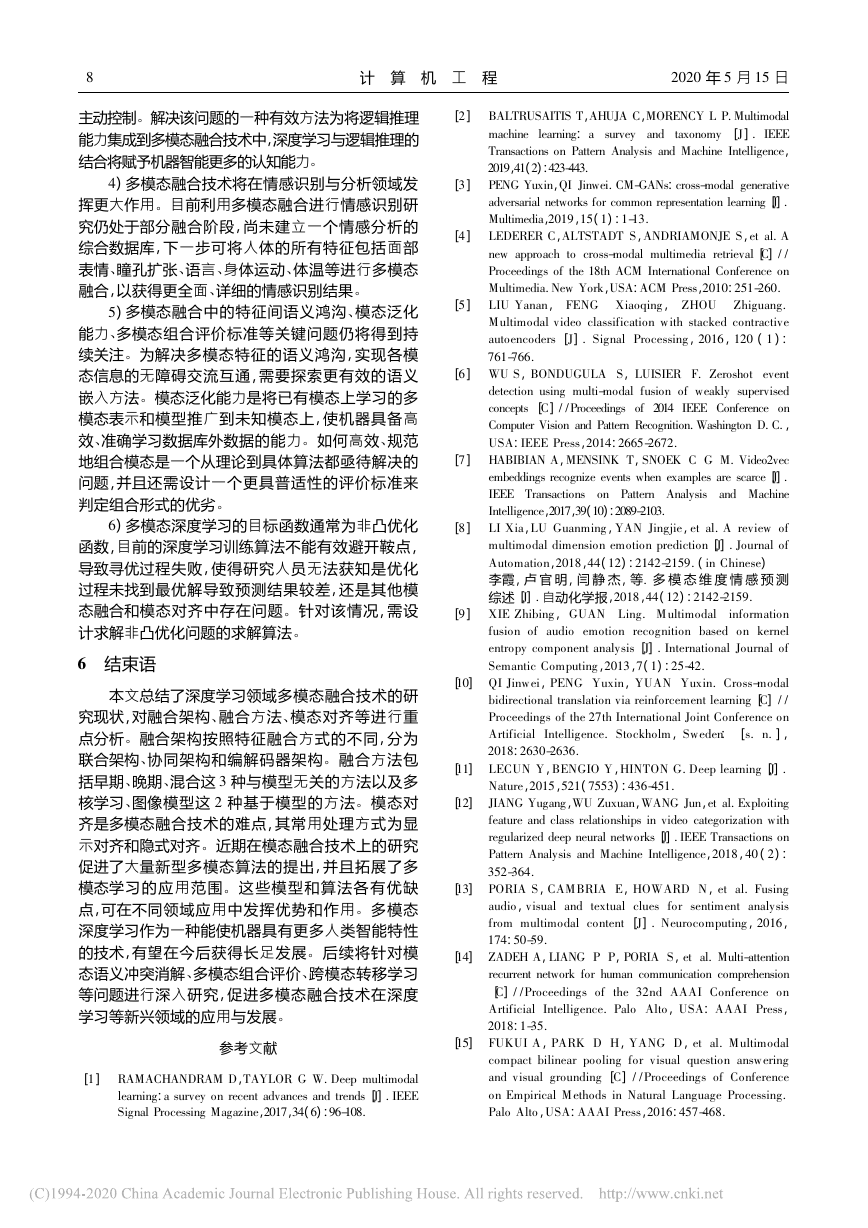

表 2 多模态融合方法

2

。

融合方法

模型无关的方法

基于模型的方法

融合类型

早期融合

晚期融合

混合融合

多核学习

图像模型

神经网络

Table 2 Multimodal fusion methods

输出

分类

回归

分类

分类

分类

分类

回归

分类

分类

分类

回归

时序模型

否

是

否

否

否

是

是

否

是

否

是

典型应用

情感识别

情感识别

事件检测

对象分类

情感识别

双模语音

情感识别

媒体分类

情感识别

双模语音

情感识别

40

参考文献

]

文献[

]

文献[

文献[

]

文献[

]

41

42

43

文献[

]

文献[

44-45

]

46

文献[

文献[

]

]

47

48

文献[

]

文献[

49-50

]

30

文献[

]

51

将多模态融合方法分为模型无关的方法和基

于模型的方法,前者不直接依赖 于 特 定 的 深 度 学

习方法,后者利用深度学习模型 显 式 地 解 决 多 模

态 融 合 问 题,例 如 多 核 学 习 (

图 像 模 型 (

) 方 法

Learning

,

MKL

、

M ultiple Kernel

,

Graphical Model

)

,

Neural Netw ork

NN

) 方 法 和 神 经 网 络 (

GM

方法等

。

2. 1 模型无关的融合方法

4

晚 期 融 合 ( 基 于 决 策) 和 混 合 融 合[

、

模型无关的融合方法可以分为早期融合( 基于

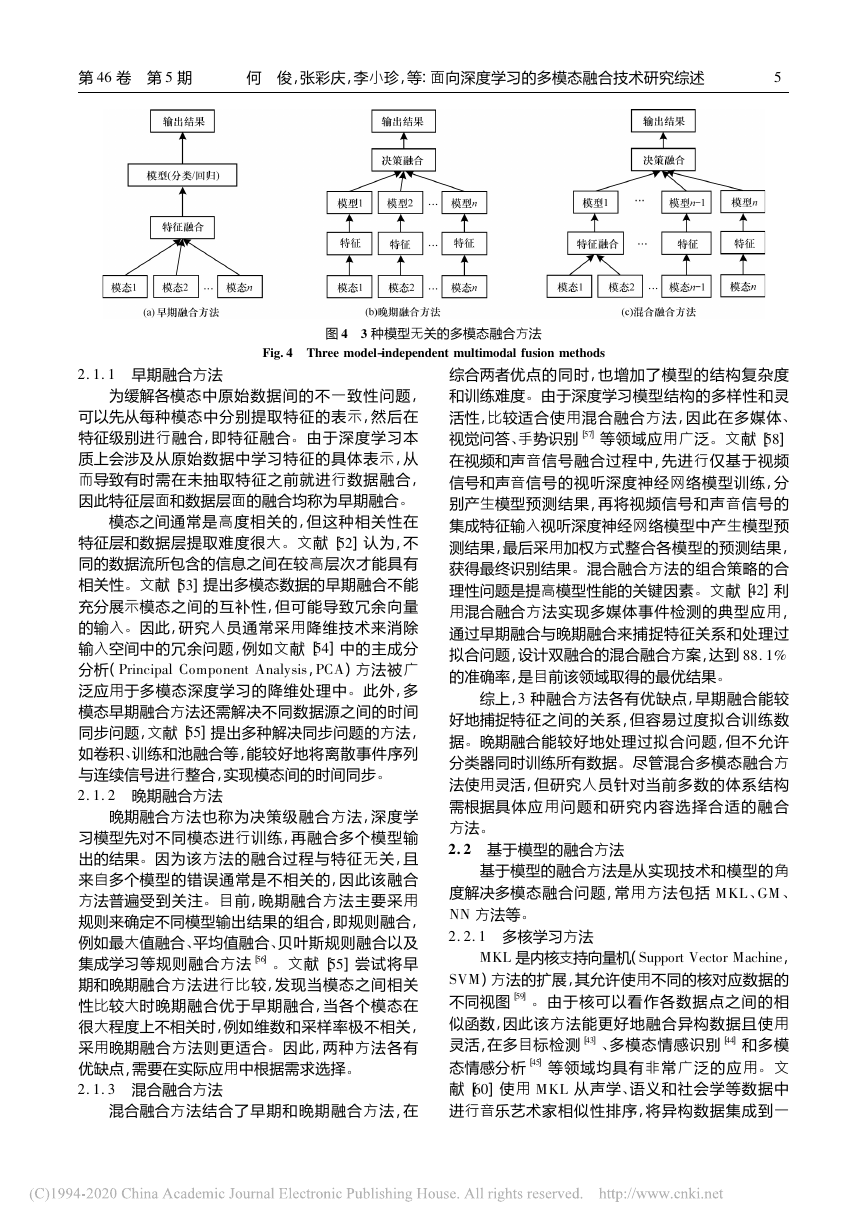

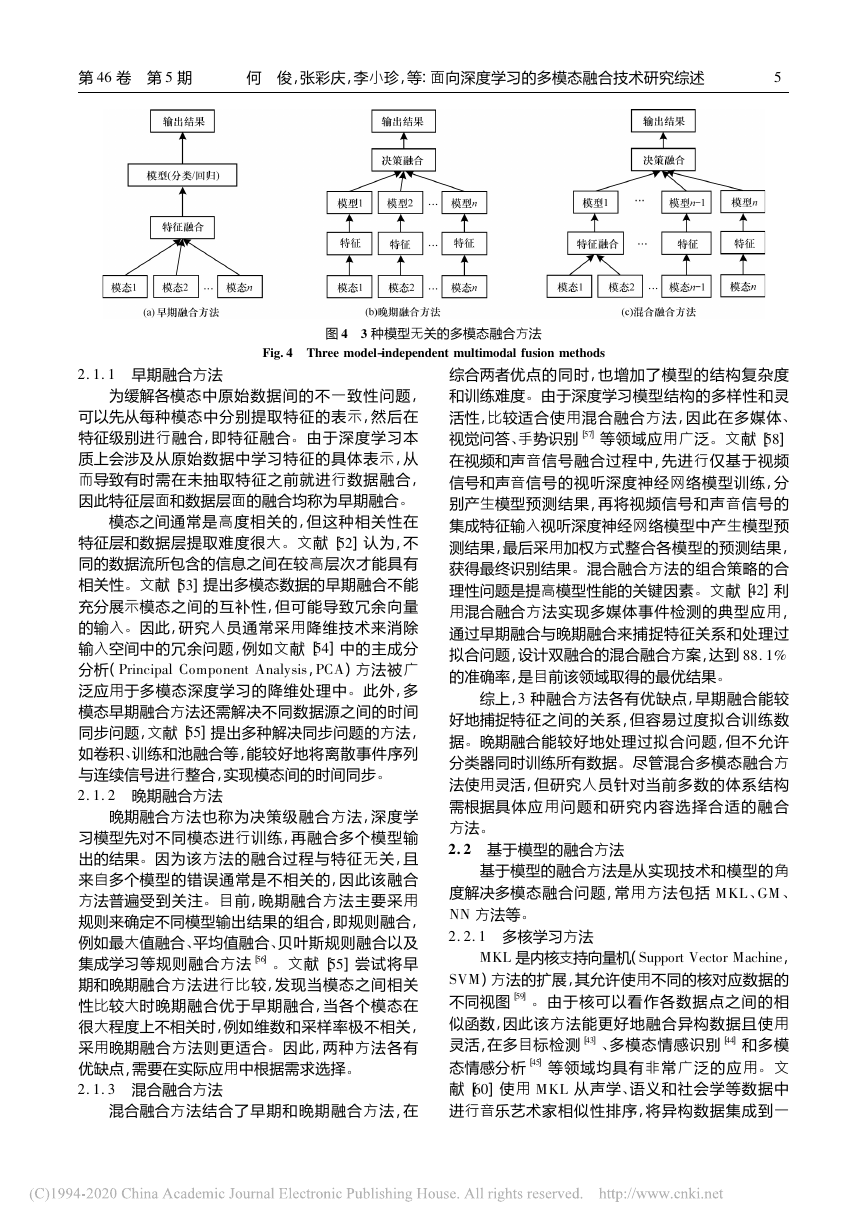

特征)

如

所示,早期融合在提取特征后立即集成特征( 通

图

常只需连接各模态特征的表示) ,晚期融合在每种模

式输出结果( 例如输出分类或回归结果) 后才执行集

成,混合融合结合早期融合方法和单模态预测器的

输出

。

]

11

。

�

第

46

卷 第

期

5

何 俊,张彩庆,李小珍,等: 面向深度学习的多模态融合技术研究综述

5

图 4

3 种模型无关的多模态融合方法

Fig. 4 Three model-independent multimodal fusion methods

2. 1. 1

早期融合方法

。

文献[

为缓解各模态中原始数据间的不一致性问题,

可以先从每种模态中分别提取特征的表示,然后在

特征级别进行融合,即特征融合

由于深度学习本

质上会涉及从原始数据中学习特征的具体表示,从

而导致有时需在未抽取特征之前就进行数据融合,

因此特征层面和数据层面的融合均称为早期融合

。

模态之间通常是高度相关的,但这种相关性在

]认为,不

特征层和数据层提取难度很大

同的数据流所包含的信息之间在较高层次才能具有

]提出多模态数据的早期融合不能

相关性

充分展示模态之间的互补性,但可能导致冗余向量

因此,研究人员通常采用降维技术来消除

的输入

]中的主成分

输入空间中的冗余问题,例如文献[

54

) 方法被广

分析(

,

PCA

此外,多

泛应用于多模态深度学习的降维处理中

模态早期融合方法还需解决不同数据源之间的时间

同步问题,文献[

]提出多种解决同步问题的方法,

训练和池融合等,能较好地将离散事件序列

如卷积

、

与连续信号进行整合,实现模态间的时间同步

Principal Component Analysis

文献[

53

。

。

。

。

55

52

。

2. 1. 2

晚期融合方法

。

。

晚期融合方法也称为决策级融合方法,深度学

习模型先对不同模态进行训练,再融合多个模型输

因为该方法的融合过程与特征无关,且

出的结果

来自多个模型的错误通常是不相关的,因此该融合

目前,晚期融合方法主要采用

方法普遍受到关注

规则来确定不同模型输出结果的组合,即规则融合,

贝叶斯规则融合以及

例如最大值融合

平均值融合

、

、

]尝试将早

集成学习等规则融合方法[

]

。

期和晚期融合方法进行比较,发现当模态之间相关

性比较大时晚期融合优于早期融合,当各个模态在

很大程度上不相关时,例如维数和采样率极不相关,

因此,两种方法各有

采用晚期融合方法则更适合

优缺点,需要在实际应用中根据需求选择

文献[

。

55

56

。

2. 1. 3

混合融合方法

混合融合方法结合了早期和晚期融合方法,在

57

。

。

58

文献[

手势识别[

、

]等领域应用广泛

综合两者优点的同时,也增加了模型的结构复杂度

和训练难度

由于深度学习模型结构的多样性和灵

活性,比较适合使用混合融合方法,因此在多媒体

、

]

视觉问答

在视频和声音信号融合过程中,先进行仅基于视频

信号和声音信号的视听深度神经网络模型训练,分

别产生模型预测结果,再将视频信号和声音信号的

集成特征输入视听深度神经网络模型中产生模型预

测结果,最后采用加权方式整合各模型的预测结果,

获得最终识别结果

混合融合方法的组合策略的合

]利

理性问题是提高模型性能的关键因素

用混合融合方法实现多媒体事件检测的典型应用,

通过早期融合与晚期融合来捕捉特征关系和处理过

拟合问题,设计双融合的混合融合方案,达到

的准确率,是目前该领域取得的最优结果

文献[

88. 1%

。

。

42

。

。

综上,

3

种融合方法各有优缺点,早期融合能较

好地捕捉特征之间的关系,但容易过度拟合训练数

晚期融合能较好地处理过拟合问题,但不允许

据

尽管混合多模态融合方

分类器同时训练所有数据

法使用灵活,但研究人员针对当前多数的体系结构

需根据具体应用问题和研究内容选择合适的融合

方法

2. 2 基于模型的融合方法

基于模型的融合方法是从实现技术和模型的角

。

。

度解决多模态融合问题,常用方法包括

M KL、GM 、

方法等

。

NN

2. 2. 1

多核学习方法

59

]

。

是内核支持向量机(

,

MKL

Support Vector Machine

) 方法的扩展,其允许使用不同的核对应数据的

SVM

不同视图[

由于核可以看作各数据点之间的相

似函数,因此该方法能更好地融合异构数据且使用

灵活,在多目标检测[

]和多模

态情感分析[

文

献[

]使用

语义和社会学等数据中

进行音乐艺术家相似性排序,将异构数据集成到一

]等领域均具有非常广泛的应用

多模态情感识别[

、

从声学

M KL

。

60

、

]

45

43

44

�

6

计 算 机 工 程

2020

年

5

月

15

日

。

61

。

文献[

]在阿尔茨海默病分类中使用

统一的相似空间中,该方法较符合人类的感

个单一

、

知

进

行多模态融合,通过在高斯核上进行傅里叶变换,显

式计算映射函数,从而得到一个更简单的解决方案,

其是一种较新的多核学习框架

这两个研究成果都

具有可扩展性和易于实现的特点,并取得了非常出

色的学习性能

M KL

。

62

2. 2. 2

。

。

]等

M KL

除了核选择的灵活性外,

的另一个优势是

损失函数为凸,允许使用标准优化包和全局最优解

进行模型训练,可大幅提升深度神经网络模型性能

。

的主要缺点是在测试期间需要依赖训练数据,

M KL

且占用大量内存资源

。

图像模型方法

是一种常用的多模态融合方法,主要通过

GM

拼接和预测对浅层或深度图形进行融合,

图像分割

、

常见图像模型有联合概率

从而生成模态融合结果

生成模型和条件概率判别模型[

早期人们多

数使用生成模型进行多模态融合,如耦合和阶乘隐

动态贝叶斯网络等,这些模型充分利

马尔可夫模型

、

用联合概率的预测能力进行建模,但不利于实现数

近 期 提 出 的 条 件 随 机 场

据的 空 间 和 时 间 结 构

) 方法通过结合图

(

像描 述 的 视 觉 和 文本 信 息 ,可 以 更 好 地 分 割 图

像[

潜

、

连续版本的数据

多媒体分类任务

在变量模型[

拟合等方面都有较好的融合效果

方法利用回

归模型对多个连续版本的数据进行拟合,预测后续

版本数据的趋势,从而提高多媒体分类任务的性能

],并在多模态会议分割[

Conditional Random Fields

。

融合方法的优点是能够有效利用数据空间

和时间结构,适用于与时间相关的建模任务,还可将

人类专家知识嵌入到模型中,增强了模型的可解释

性,但是模型的泛化能力有限

多视点隐藏[

。GM

CRF

GM

,

。

、

、

、

]

]

]

65

63

66

64

。

30

67

]

]

。

2. 2. 3

NN

,

AVSR

手势识别[

、

Audio-Visual Speech Recognition

神经网络方法

是目前应用最广泛的方法之一,已用于各种

视觉和听觉双模语音识别

多模态融合任务中[

(

) 是最早使

用神经网络方法进行多模态融合的技术,目前神经

网络方法已在很多领域得到了应用,例如视觉和媒

]等,这些

体问答[

应用充分利用了神经网络方法较强的学习能力和分

近期神经网络方法通过使用循环神经网络

类性能

(

) 和长短期记忆网

) 来融合时间多

络(

模态信息,例如文献[

模型进行连续

50

多模态情感识别,相对于

方法表现出更

此外,神经网络多模态融合方法在图像

优的性能

字幕处理任务中表现良好,主要模型包括神经图像

RNN

,

Long Short-Term M emory

LSTM

]使用

Recurrent Neural Netw ork

]和视频描述生成[

LSTM

和

M KL

GM

,

。

。

68

69

71

70

]

]等

多视图模型[

、

神经网络方法在多

字幕模型[

模态融合中的优势是具备大数据学习能力,其分层

方式有利于不同模态的嵌入,具有较好的可扩展性,

但缺点是随着模态的增多,模型可解释性变差

。

。

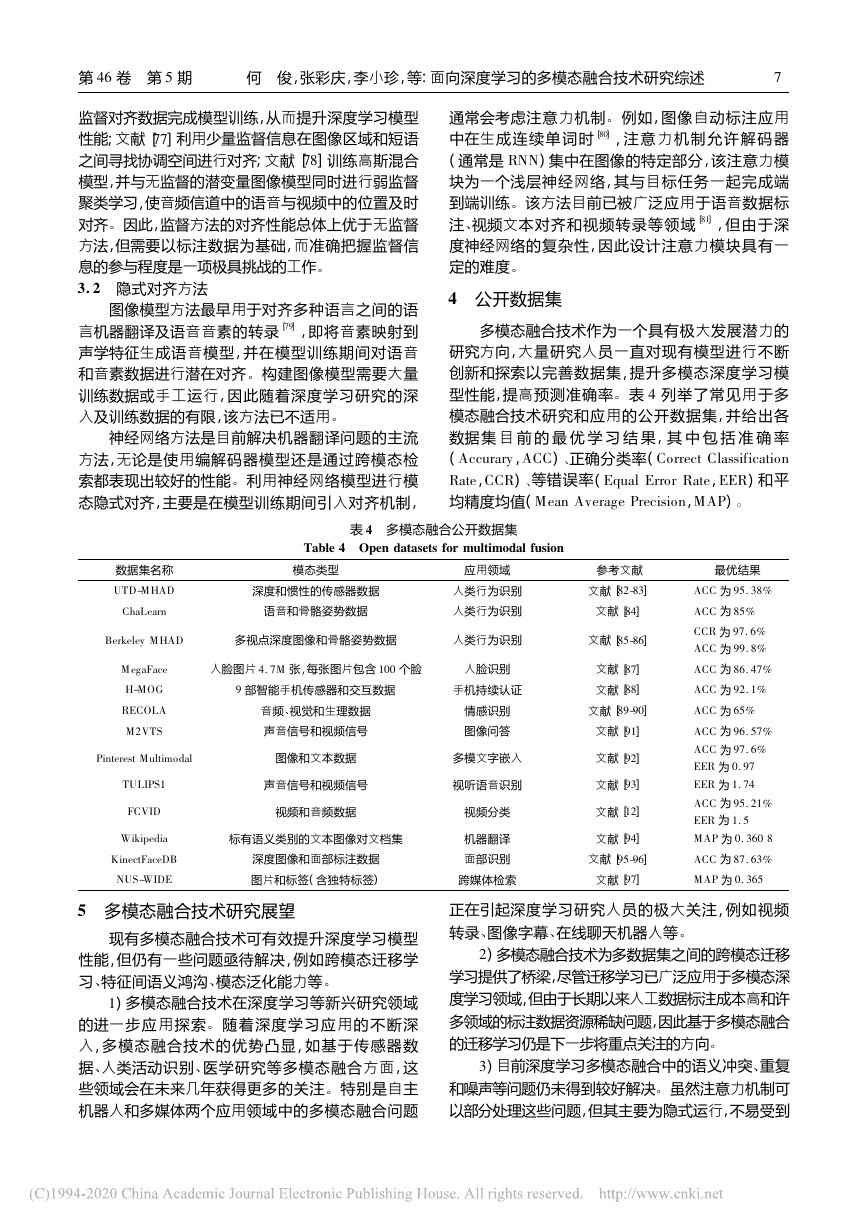

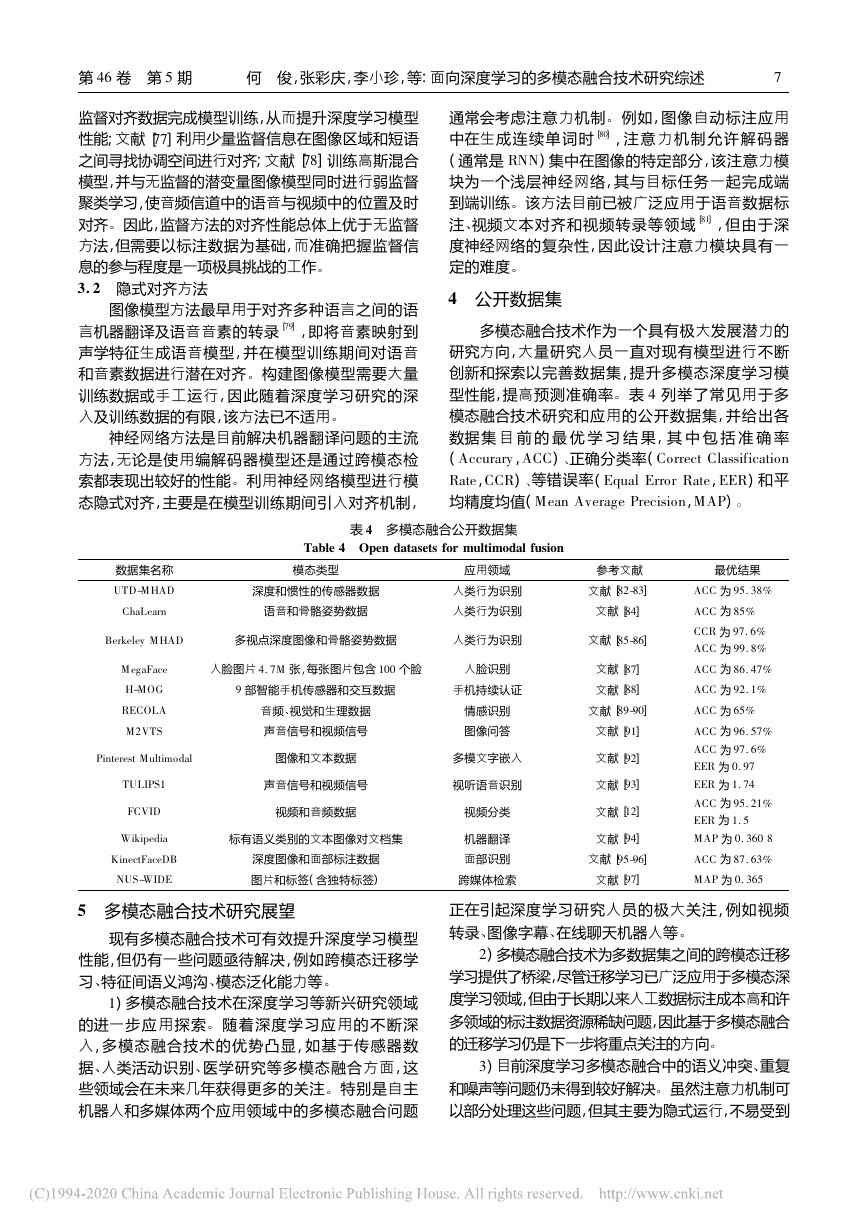

3 多模态对齐方法

。

多模态对齐是多模态融合的关键技术之一,指

从两个或多个模态中查找实例子组件之间的对应关

例如,给定一个图像和一个标题,需找到图像区

系

多模态对齐

域与标题单词或短语的对应关系[

显式对齐关注模态

方法分为显式对齐和隐式对齐

之间子组件的对齐问题,而隐式对齐则是在深度学

习模型训练期间对数据进行潜在对齐,如表

所示

。

。

]

72

3

。

表 3 多模态对齐方法

Table 3 Multimodal alignment methods

对齐方法

对齐类型

模态类型

参考文献

显示对齐

无监督方法

监督方法

文本 文献[

]

文本 文献[

]

视频

视频

视频

+

+

+

语音

图像

文本

+

文本

+

文本

文本

文献[

73-74

]

75

文献[

76-77

]

78

文献[

文献[

79

]

]

80

81

图像模型方法

语音

/

文本 文献[

]

隐式对齐

神经网络方法

图像

视频

+

+

3. 1 显式对齐方法

。

74

73

Dynamic Time Warping

无监督方法在不同模态的实例之间没有用于直

]提出的动态时间

接对齐的监督标签,例如: 文献[

扭曲(

) 方法是一种动

,

DTW

态规划的无监督学习对齐方法,已被广泛用于对齐

多视图时间序列; 文献[

]根据相同物体的外貌特

征来定义视觉场景和句子之间的相似性,从而对齐

电视节目和情节概要

上述两个研究成果都在没有

监督信息的前提下,通过度量两个序列之间的相似

性,在找到它们之间的最佳匹配后按时间对齐( 或插

入帧) ,实现字符标识和关键字与情节提要和字幕之

间的对齐

语音和

、

]使用动态贝

视频的多模态对齐任务,例如文献[

叶斯网络将扬声器输出语音与视频进行对齐

尽管

无监督对齐方法无需标注数据,可以节省数据标注

成本,但对实例的规范性要求较高,需具备时间一致

性且时间上没有较大的跳跃和单调性,否则对齐性

能会急剧下降

的方法用于文本

还有类似

DTW

75

。

。

。

监督方法是从无监督的序列对齐技术中得到启

发,并通过增强模型的监督信息来获得更好的性能,

通常可以将上述无监督方法进行适当优化后直接用

该方法旨在不降低性能的前提下,尽量

于模态对齐

减少监督信息,即弱监督对齐

]提出

一种类似于规范时间扭曲的方法,主要利用现有( 弱)

例如: 文献[

。

。

76

�

第

46

卷 第

期

5

何 俊,张彩庆,李小珍,等: 面向深度学习的多模态融合技术研究综述

7

78

77

。

监督对齐数据完成模型训练,从而提升深度学习模型

]利用少量监督信息在图像区域和短语

性能; 文献[

之间寻找协调空间进行对齐; 文献[

]训练高斯混合

模型,并与无监督的潜变量图像模型同时进行弱监督

聚类学习,使音频信道中的语音与视频中的位置及时

因此,监督方法的对齐性能总体上优于无监督

对齐

方法,但需要以标注数据为基础,而准确把握监督信

息的参与程度是一项极具挑战的工作

3. 2 隐式对齐方法

图像模型方法最早用于对齐多种语言之间的语

],即将音素映射到

言机器翻译及语音音素的转录[

声学特征生成语音模型,并在模型训练期间对语音

和音素数据进行潜在对齐

构建图像模型需要大量

训练数据或手工运行,因此随着深度学习研究的深

入及训练数据的有限,该方法已不适用

。

。

79

。

神经网络方法是目前解决机器翻译问题的主流

方法,无论是使用编解码器模型还是通过跨模态检

利用神经网络模型进行模

索都表现出较好的性能

态隐式对齐,主要是在模型训练期间引入对齐机制,

。

RNN

例如,图像自动标注应用

通常会考虑注意力机制

。

],注意力机制允许解码器

中在生成连续单词时[

80

( 通常是

) 集中在图像的特定部分,该注意力模

块为一个浅层神经网络,其与目标任务一起完成端

该方法目前已被广泛应用于语音数据标

到端训练

],但由于深

注

度神经网络的复杂性,因此设计注意力模块具有一

定的难度

视频文本对齐和视频转录等领域[

、

。

81

。

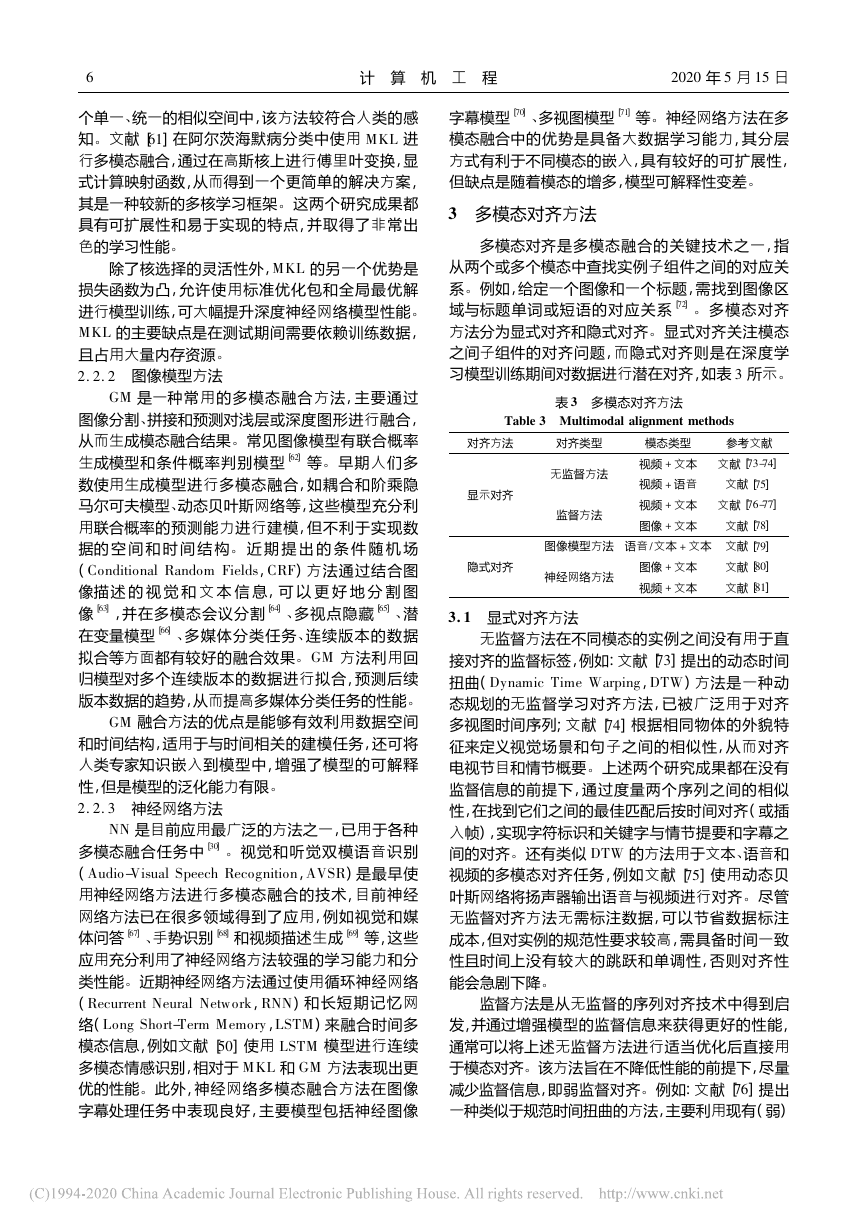

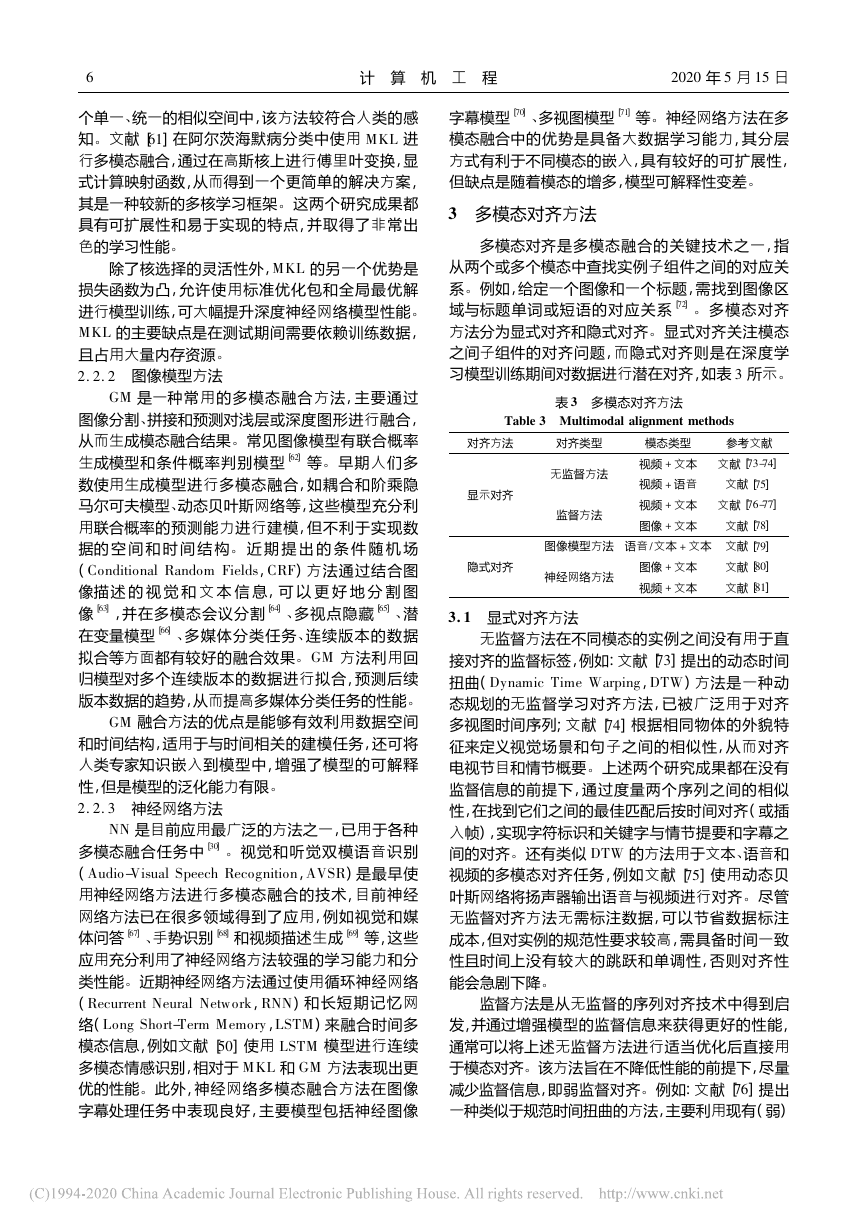

4 公开数据集

多模态融合技术作为一个具有极大发展潜力的

研究方向,大量研究人员一直对现有模型进行不断

创新和探索以完善数据集,提升多模态深度学习模

型性能,提高预测准确率

列举了常见用于多

模态融合技术研究和应用的公开数据集,并给出各

数据 集 目 前 的 最 优学 习 结 果 ,其 中 包 括 准 确 率

(

表

。

4

正确分类率(

、

)

,

ACC

)

等错误率(

、

Equal Error Rate

Correct Classification

) 和平

,

EER

)

。

,

M AP

Accurary

,

CCR

Rate

均精度均值(

M ean Average Precision

表 4 多模态融合公开数据集

Table 4 Open datasets for multimodal fusion

模态类型

深度和惯性的传感器数据

语音和骨骼姿势数据

应用领域

人类行为识别

人类行为识别

多视点深度图像和骨骼姿势数据

人类行为识别

人脸图片

张,每张图片包含

4. 7M

100

部智能手机传感器和交互数据

9

个脸

人脸识别

音频

视觉和生理数据

、

声音信号和视频信号

图像和文本数据

声音信号和视频信号

视频和音频数据

标有语义类别的文本图像对文档集

深度图像和面部标注数据

图片和标签( 含独特标签)

手机持续认证

情感识别

图像问答

多模文字嵌入

视听语音识别

视频分类

机器翻译

面部识别

跨媒体检索

数据集名称

UTD-M HAD

ChaLearn

Berkeley M HAD

M egaFace

H-M OG

RECOLA

M2VTS

Pinterest M ultimodal

TULIPS1

FCVID

Wikipedia

KinectFaceDB

NUS-WIDE

参考文献

最优结果

]

文献[

文献[

82-83

]

84

文献[

]

85-86

文献[

文献[

]

]

87

88

]

文献[

文献[

89-90

]

91

文献[

]

92

文献[

]

93

文献[

]

12

文献[

]

94

]

文献[

文献[

95-96

]

97

ACC

ACC

CCR

ACC

ACC

ACC

ACC

ACC

ACC

EER

EER

ACC

EER

M AP

ACC

M AP

为

为

为

为

为

为

为

为

为

为

为

为

为

为

为

为

95. 38%

85%

97. 6%

99. 8%

86. 47%

92. 1%

65%

96. 57%

97. 6%

0. 97

1. 74

95. 21%

1. 5

0. 360 8

87. 63%

0. 365

5 多模态融合技术研究展望

1

现有多模态融合技术可有效提升深度学习模型

性能,但仍有一些问题亟待解决,例如跨模态迁移学

习

模态泛化能力等

、

特征间语义鸿沟

、

) 多模态融合技术在深度学习等新兴研究领域

随着深度学习应用的不断深

的进一步应用探索

入,多模态融合技术的优势凸显,如基于传感器数

医学研究等多模态融合方面,这

据

、

些领域会在未来几年获得更多的关注

特别是自主

机器人和多媒体两个应用领域中的多模态融合问题

人类活动识别

、

。

。

。

2

在线聊天机器人等

、

正在引起深度学习研究人员的极大关注,例如视频

转录

图像字幕

、

) 多模态融合技术为多数据集之间的跨模态迁移

学习提供了桥梁,尽管迁移学习已广泛应用于多模态深

度学习领域,但由于长期以来人工数据标注成本高和许

多领域的标注数据资源稀缺问题,因此基于多模态融合

的迁移学习仍是下一步将重点关注的方向

。

3

) 目前深度学习多模态融合中的语义冲突

重复

、

虽然注意力机制可

和噪声等问题仍未得到较好解决

以部分处理这些问题,但其主要为隐式运行,不易受到

。

。

�

8

计 算 机 工 程

2020

年

5

月

15

日

。

。

解决该问题的一种有效方法为将逻辑推理

主动控制

能力集成到多模态融合技术中,深度学习与逻辑推理的

结合将赋予机器智能更多的认知能力

4

。

瞳孔扩张

、

) 多模态融合技术将在情感识别与分析领域发

挥更大作用

目前利用多模态融合进行情感识别研

究仍处于部分融合阶段,尚未建立一个情感分析的

综合数据库,下一步可将人体的所有特征包括面部

语言

体温等进行多模态

表情

、

、

融合,以获得更全面

身体运动

、

详细的情感识别结果

。

、

) 多模态融合中的特征间语义鸿沟

模态泛化

、

5

能力

多模态组合评价标准等关键问题仍将得到持

、

为解决多模态特征的语义鸿沟,实现各模

续关注

态信息的无障碍交流互通,需要探索更有效的语义

嵌入方法

模态泛化能力是将已有模态上学习的多

模态表示和模型推广到未知模态上,使机器具备高

效

规范

、

地组合模态是一个从理论到具体算法都亟待解决的

问题,并且还需设计一个更具普适性的评价标准来

判定组合形式的优劣

准确学习数据库外数据的能力

、

如何高效

。

。

。

。

6

) 多模态深度学习的目标函数通常为非凸优化

函数,目前的深度学习训练算法不能有效避开鞍点,

导致寻优过程失败,使得研究人员无法获知是优化

过程未找到最优解导致预测结果较差,还是其他模

针对该情况,需设

态融合和模态对齐中存在问题

。

计求解非凸优化问题的求解算法

。

6 结束语

。

3

2

融合方法

、

本文总结了深度学习领域多模态融合技术的研

究现状,对融合架构

模态对齐等进行重

、

融合架构按照特征融合方式的不同,分为

点分析

。

协同架构和编解码器架构

融合方法包

联合架构

、

括早期

种与模型无关的方法以及多

晚期

混合这

、

、

核学习

模态对

种基于模型的方法

图像模型这

、

齐是多模态融合技术的难点,其常用处理方式为显

示对齐和隐式对齐

近期在模态融合技术上的研究

促进了大量新型多模态算法的提出,并且拓展了多

模态学习的应用范围

这些模型和算法各有优缺

点,可在不同领域应用中发挥优势和作用

多模态

深度学习作为一种能使机器具有更多人类智能特性

的技术,有望在今后获得长足发展

后续将针对模

。

态语义冲突消解

多模态组合评价

跨模态转移学习

、

、

等问题进行深入研究,促进多模态融合技术在深度

学习等新兴领域的应用与发展

。

。

。

。

。

参考文献

]

[

1

RAMACHANDRAM D

learning

Signal Processing Magazine

a survey on recent advances and trends

96-108.

,

TAYLOR G W. Deep multimodal

. IEEE

,

2017

[

]

J

,

(

34

) :

6

:

]

[

2

]

[

3

]

[

4

]

[

5

]

[

6

]

[

7

]

[

8

]

[

9

[

]

10

[

]

11

[

]

12

[

]

13

[

]

14

[

]

15

:

:

(

1

) :

,

,

]

) :

2

[

J

,

15

,

(

41

ZHOU

[

]

J

,

2010

ACM Press

,

USA

Xiaoqing

cross-modal generative

[

]

.

J

1-13.

,

ANDRIAMONJE S

,

2019

,

ALTSTADT S

423-443.

,

:

QI Jinwei. CM-GANs

,

AHUJA C

a survey and taxonomy

,

MORENCY L P. Multimodal

BALTRUSAITIS T

:

. IEEE

machine learning

,

Transactions on Pattern Analysis and Machine Intelligence

2019

PENG Yuxin

adversarial networks for common representation learning

Multimedia

,

et al. A

LEDERER C

[

]

C

/ /

new approach to cross-modal multimedia retrieval

Proceedings of the 18th ACM International Conference on

Multimedia. New York

251-260.

LIU Yanan

Zhiguang.

FENG

M ultimodal video classification w ith stacked contractive

) :

autoencoders

761-766.

,

WU S

LUISIER F. Zeroshot event

detection using multi-modal fusion of weakly supervised

concepts

/ / Proceedings of 2014 IEEE Conference on

Computer Vision and Pattern Recognition. Washington D. C.

USA

HABIBIAN A

embeddings recognize events when examples are scarce

IEEE Transactions

,

(

Intelligence

39

LI Xia

multimodal dimension emotion prediction

(

Automation

李霞,卢 官 明,闫 静 杰,等

]

综述[

J

.

on Pattern Analysis

) :

10

,

,

LU Guanming

SNOEK C G M. Video2vec

[

]

J

.

and Machine

多 模 态 维 度 情 感 预 测

(

et al. A review of

. Journal of

2089-2103.

YAN Jingjie

,

MENSINK T

. Signal Processing

自动化学报,

BONDUGULA S

2665-2672.

2142-2159.

2142-2159.

IEEE Press

in Chinese

,

2014

,

2018

,

2017

[

]

J

.

,

44

,

44

[

C

2016

2018

120

,

,

,

,

]

,

) :

) :

12

12

1

(

)

(

:

:

,

,

:

(

1

,

,

s. n.

: [

25-42.

Sw eden

[

]

J

]

[

J

.

[

]

C

,

2015

2630-2636.

Intelligence. Stockholm

GUAN Ling. M ultimodal

,

HINTON G. Deep learning

) :

,

BENGIO Y

,

521

7553

,

WU Zuxuan

XIE Zhibing

information

fusion of audio emotion recognition based on kernel

[

]

. International Journal of

entropy component analysis

J

,

) :

,

(

7

2013

Semantic Computing

,

YUAN Yuxin. Cross-modal

QI Jinw ei

PENG Yuxin

bidirectional translation via reinforcement learning

/ /

Proceedings of the 27th International Joint Conference on

],

Artificial

2018

LECUN Y

Nature

,

JIANG Yugang

et al. Exploiting

feature and class relationships in video categorization with

. IEEE Transactions on

regularized deep neural networks

) :

Pattern Analysis and Machine Intelligence

352-364.

PORIA S

audio

from multimodal content

174

ZADEH A

et al. Multi-attention

recurrent network for human communication comprehension

[

]

the 32nd AAAI Conference on

C

,

et al. Fusing

visual and textual clues for sentiment analysis

,

436-451.

,

WANG Jun

. Neurocomputing

/ / Proceedings of

CAM BRIA E

50-59.

,

HOWARD N

LIANG P P

1-35.

,

AAAI Press

PARK D H

Artificial Intelligence. Palo Alto

2018

FUKUI A

et al. M ultimodal

compact bilinear pooling for visual question answ ering

and visual grounding

/ / Proceedings of Conference

on Empirical M ethods in Natural Language Processing.

Palo Alto

AAAI Press

,

2018

,

USA

,

2016

YANG D

[

]

J

PORIA S

457-468.

,

40

[

C

2016

USA

,

,

,

,

]

,

,

,

,

,

,

2

(

:

:

:

:

:

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc