基于机器视觉的智能导盲眼镜设计

基于机器视觉的智能导盲眼镜设计

提出一种基于机器视觉的智能导盲眼镜系统的设计方案。采用三星公司Cortex-A8架构的 S5PV210作为中央处

理器,搭载Linux系统,配备双目采集、GPS定位、语音播报、GSM短信、语音通话、无线传输六大核心功能模

块搭建智能导盲眼镜系统的硬件平台,结合深度学习算法在远程云服务器上完成了对目标场景的智能识别,最

后以语音的形式实时对盲人的行走作出准确引导。系统测试结果表明,该智能导盲眼镜系统在测试环境下不仅

能对盲人出行正确导航,还具有一定的目标识别能力,能帮助盲人进行简易物品归类。该系统还兼有GPS定

位、语音通话、GSM短信等多项辅助功能。

0 引言引言

据世界卫生组织统计,截至目前全球约有盲人7 800万,其中90%生活在发展中国家,中国现有盲人数量占据世界盲人总数

的18%,多达1 400万。盲人作为社会中的一种弱势群体,视力残疾、眼部疾病给其生活带来了诸多不便。另一方面,近年来

随着我国老龄化人口的持续增多,视力障碍者数量也在急剧上升,如何保障盲人群体及视障人士安全有效地出行显得尤为重

要。为此,本文设计了一种基于机器视觉[1]的智能导盲眼镜,旨在帮助盲人朋友在行走过程中,安全、有效地避开道路上的目

标障碍物,尽最大可能地保障其出行安全。相较于市场上导盲效率不理想的导盲手杖和价格昂贵的导盲犬,基于机器视觉的智

能导盲眼镜系统更具竞争力。

1 智能导盲眼镜控制系统的总体设计

智能导盲眼镜控制系统的总体设计

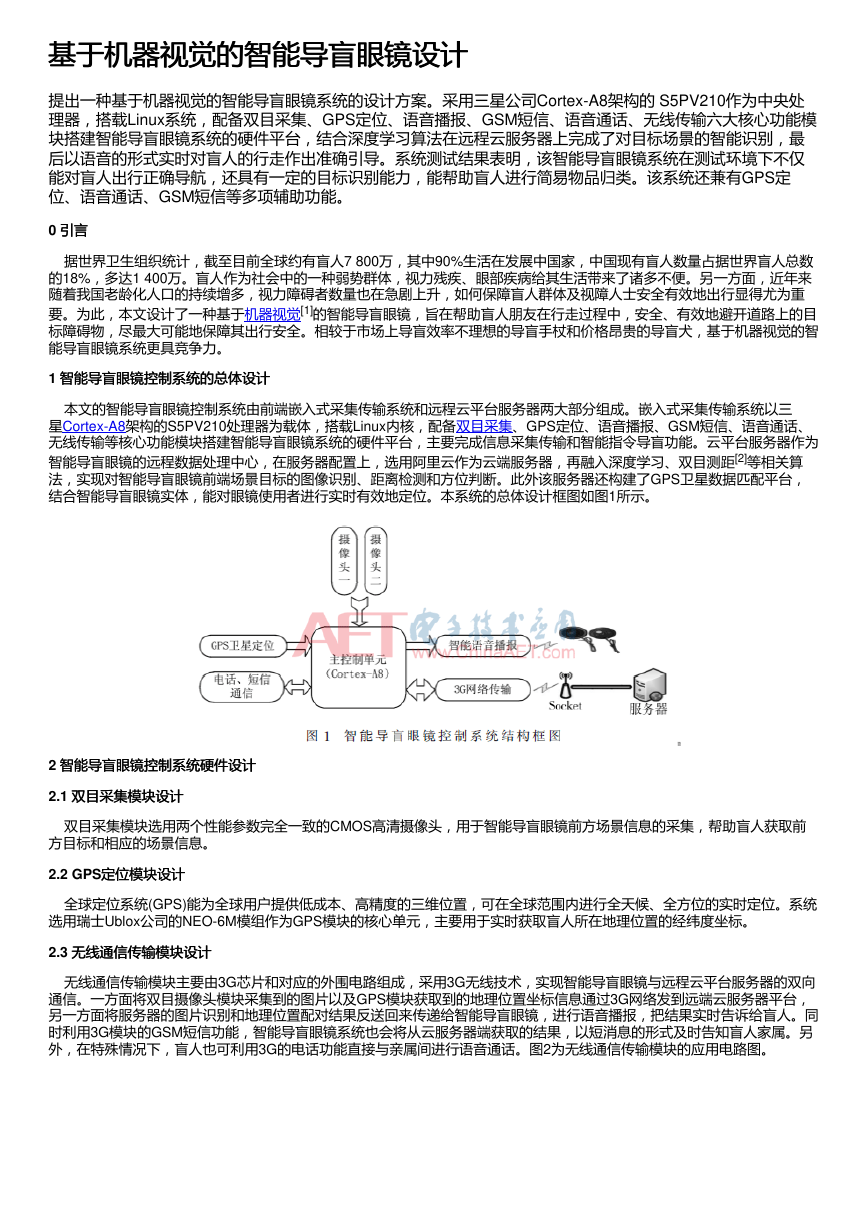

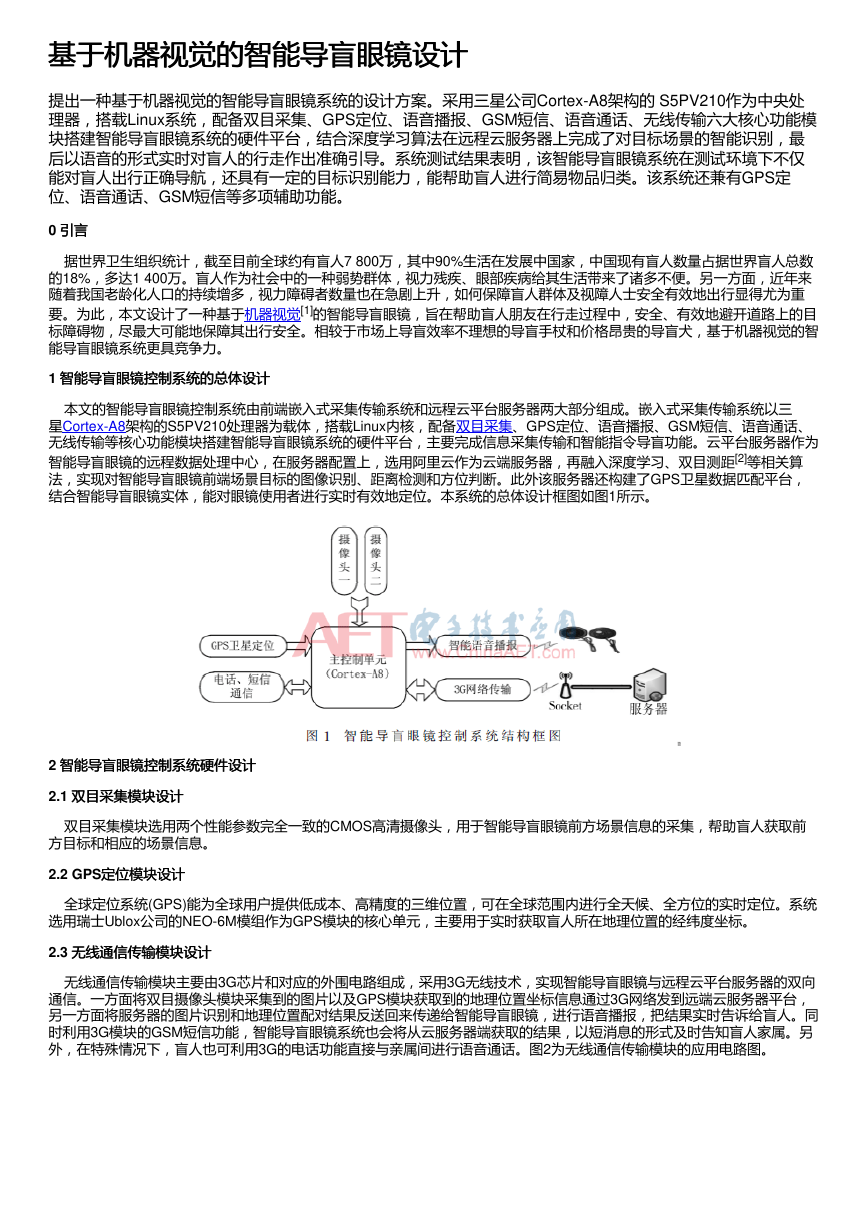

本文的智能导盲眼镜控制系统由前端嵌入式采集传输系统和远程云平台服务器两大部分组成。嵌入式采集传输系统以三

星Cortex-A8架构的S5PV210处理器为载体,搭载Linux内核,配备双目采集、GPS定位、语音播报、GSM短信、语音通话、

无线传输等核心功能模块搭建智能导盲眼镜系统的硬件平台,主要完成信息采集传输和智能指令导盲功能。云平台服务器作为

智能导盲眼镜的远程数据处理中心,在服务器配置上,选用阿里云作为云端服务器,再融入深度学习、双目测距[2]等相关算

法,实现对智能导盲眼镜前端场景目标的图像识别、距离检测和方位判断。此外该服务器还构建了GPS卫星数据匹配平台,

结合智能导盲眼镜实体,能对眼镜使用者进行实时有效地定位。本系统的总体设计框图如图1所示。

2 智能导盲眼镜控制系统硬件设计

智能导盲眼镜控制系统硬件设计

2.1 双目采集模块设计

双目采集模块设计

双目采集模块选用两个性能参数完全一致的CMOS高清摄像头,用于智能导盲眼镜前方场景信息的采集,帮助盲人获取前

方目标和相应的场景信息。

2.2 GPS定位模块设计

定位模块设计

全球定位系统(GPS)能为全球用户提供低成本、高精度的三维位置,可在全球范围内进行全天候、全方位的实时定位。系统

选用瑞士Ublox公司的NEO-6M模组作为GPS模块的核心单元,主要用于实时获取盲人所在地理位置的经纬度坐标。

2.3 无线通信传输模块设计

无线通信传输模块设计

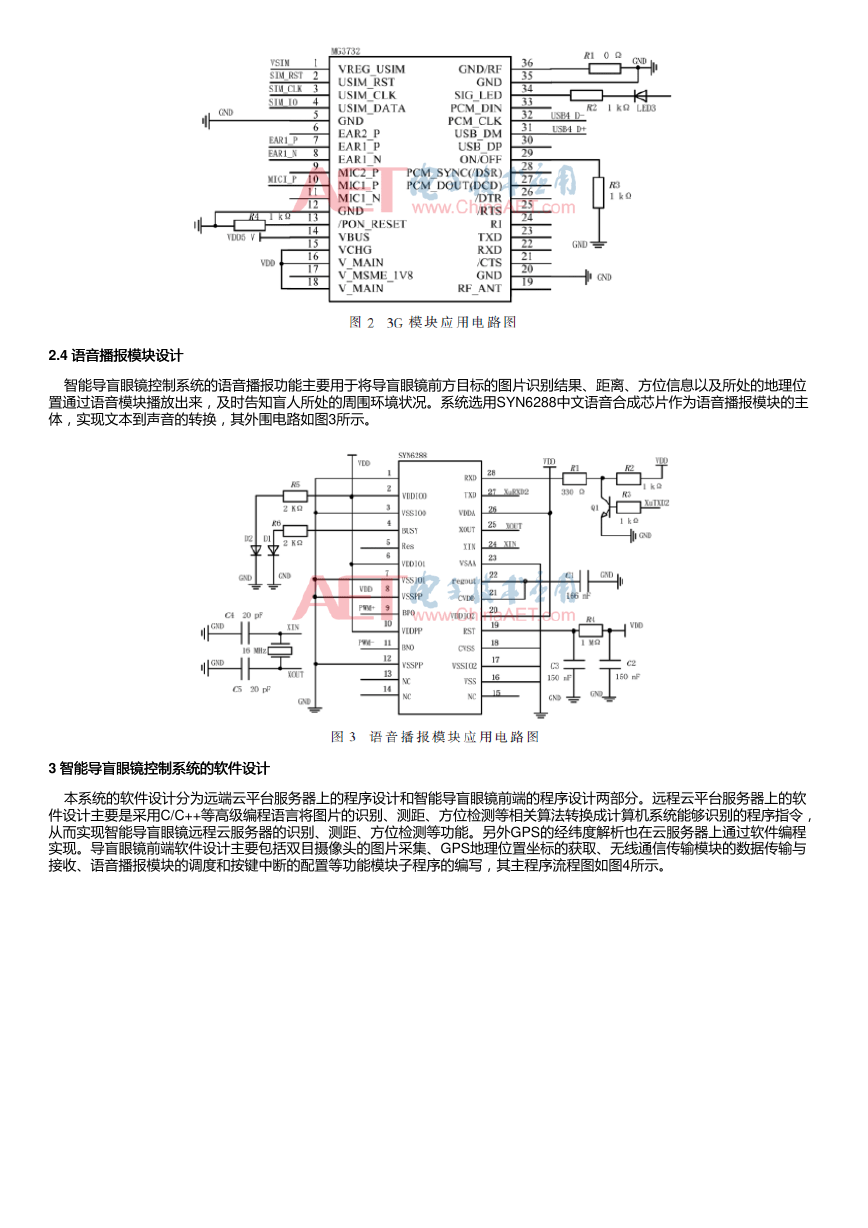

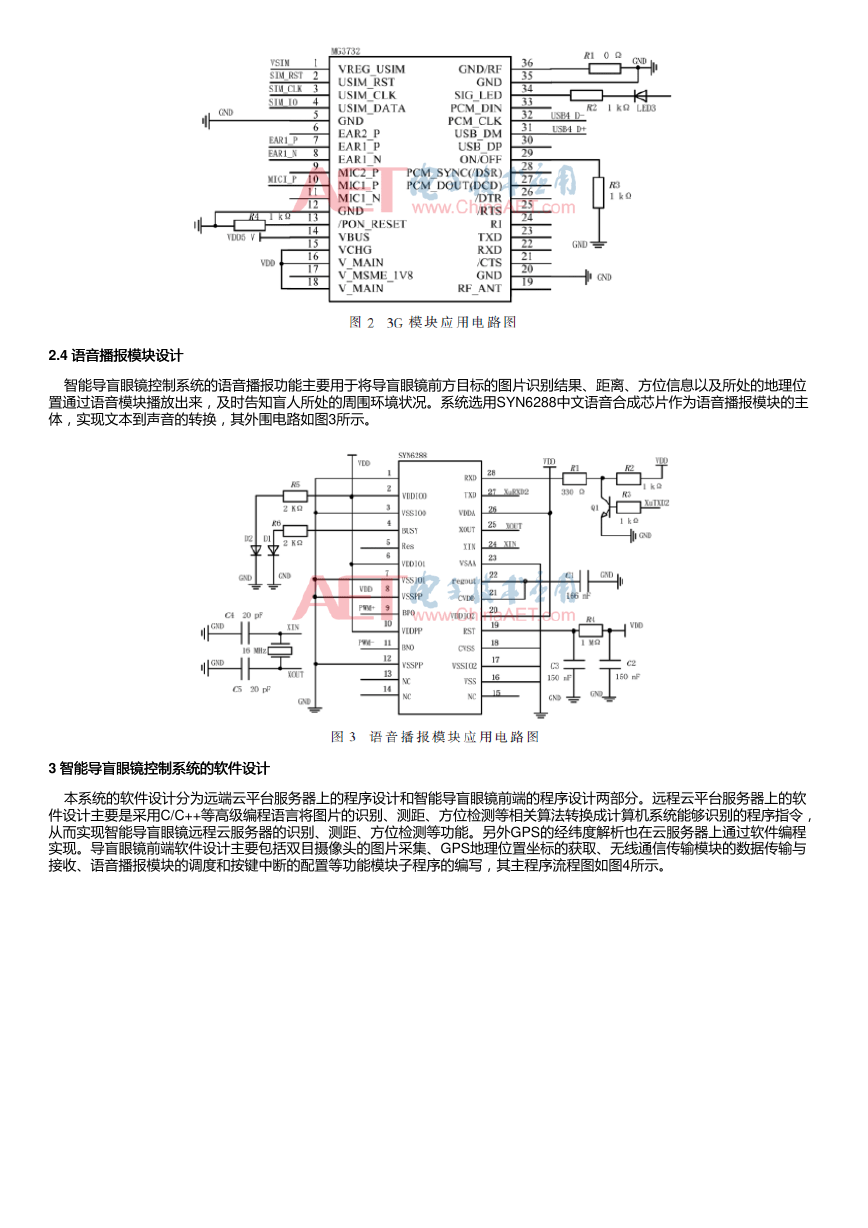

无线通信传输模块主要由3G芯片和对应的外围电路组成,采用3G无线技术,实现智能导盲眼镜与远程云平台服务器的双向

通信。一方面将双目摄像头模块采集到的图片以及GPS模块获取到的地理位置坐标信息通过3G网络发到远端云服务器平台,

另一方面将服务器的图片识别和地理位置配对结果反送回来传递给智能导盲眼镜,进行语音播报,把结果实时告诉给盲人。同

时利用3G模块的GSM短信功能,智能导盲眼镜系统也会将从云服务器端获取的结果,以短消息的形式及时告知盲人家属。另

外,在特殊情况下,盲人也可利用3G的电话功能直接与亲属间进行语音通话。图2为无线通信传输模块的应用电路图。

�

2.4 语音播报模块设计

语音播报模块设计

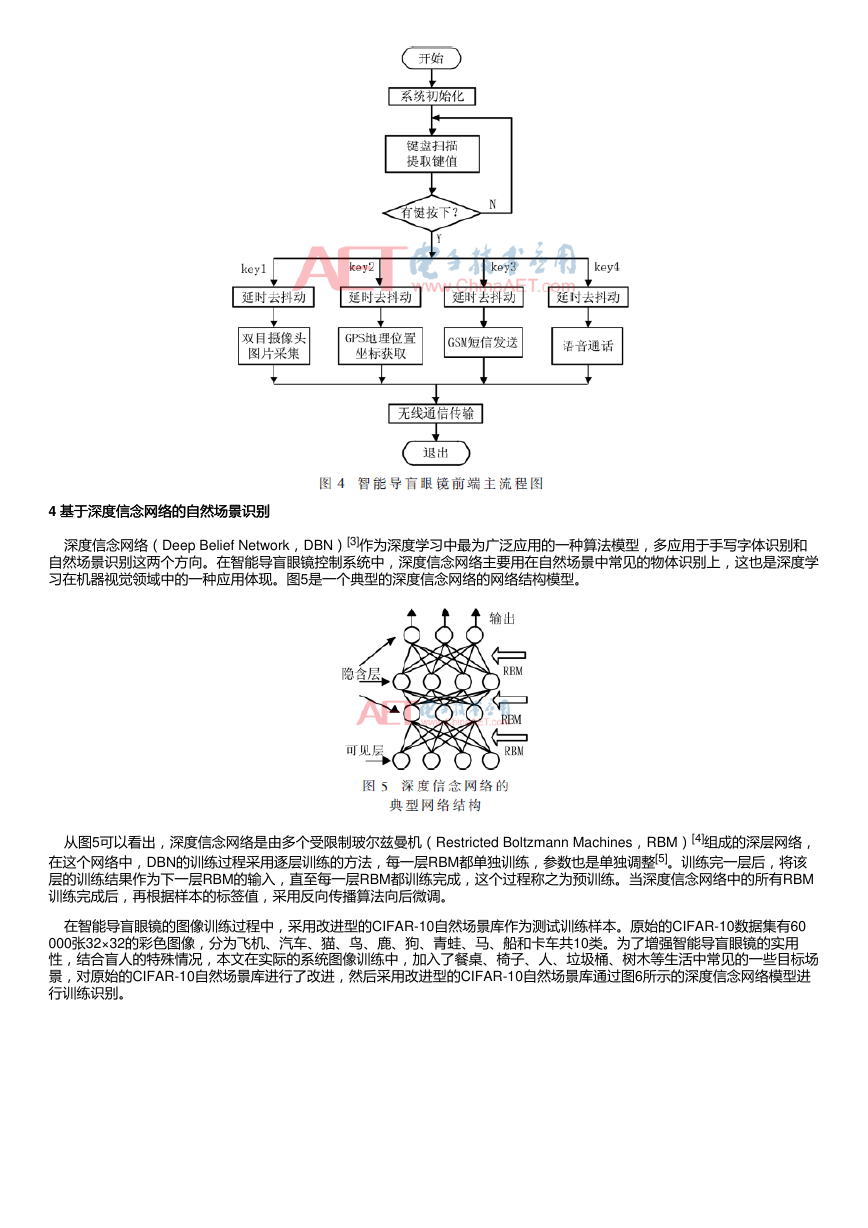

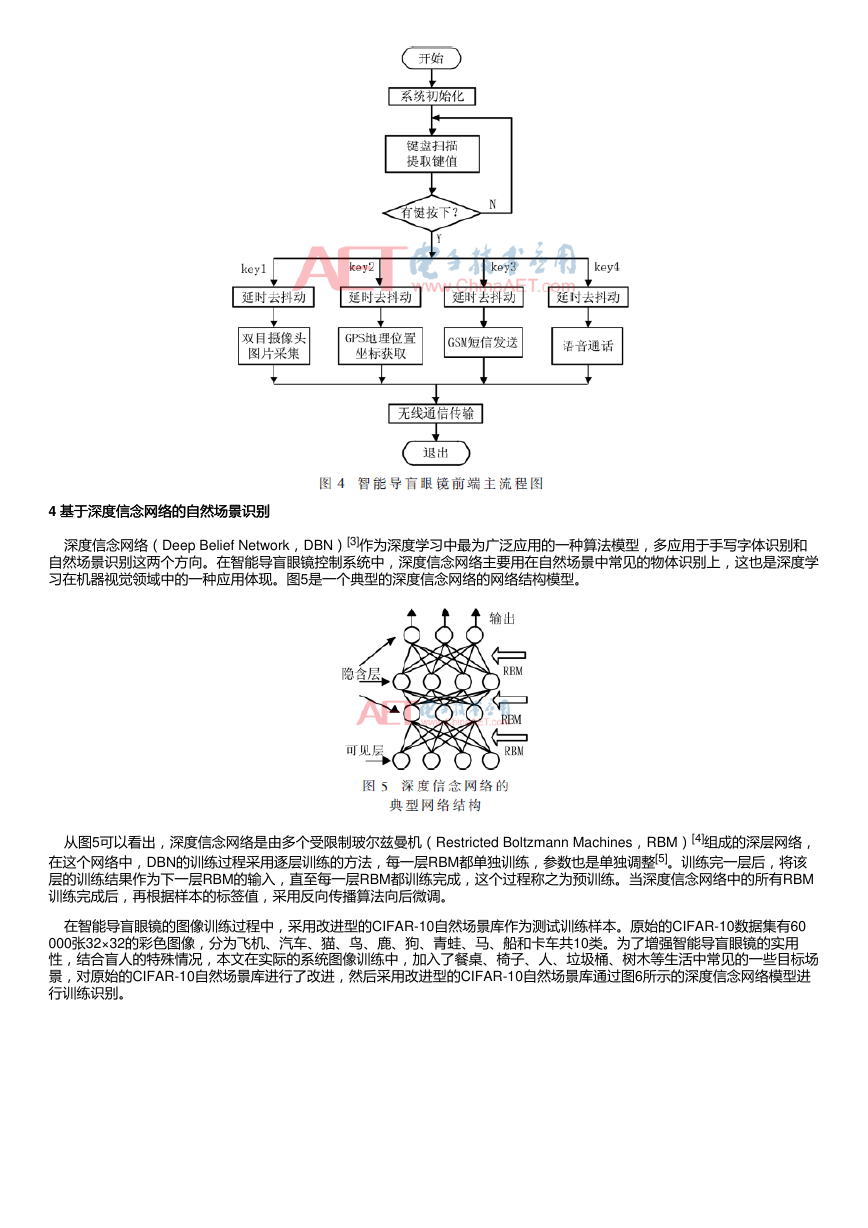

智能导盲眼镜控制系统的语音播报功能主要用于将导盲眼镜前方目标的图片识别结果、距离、方位信息以及所处的地理位

置通过语音模块播放出来,及时告知盲人所处的周围环境状况。系统选用SYN6288中文语音合成芯片作为语音播报模块的主

体,实现文本到声音的转换,其外围电路如图3所示。

3 智能导盲眼镜控制系统的软件设计

智能导盲眼镜控制系统的软件设计

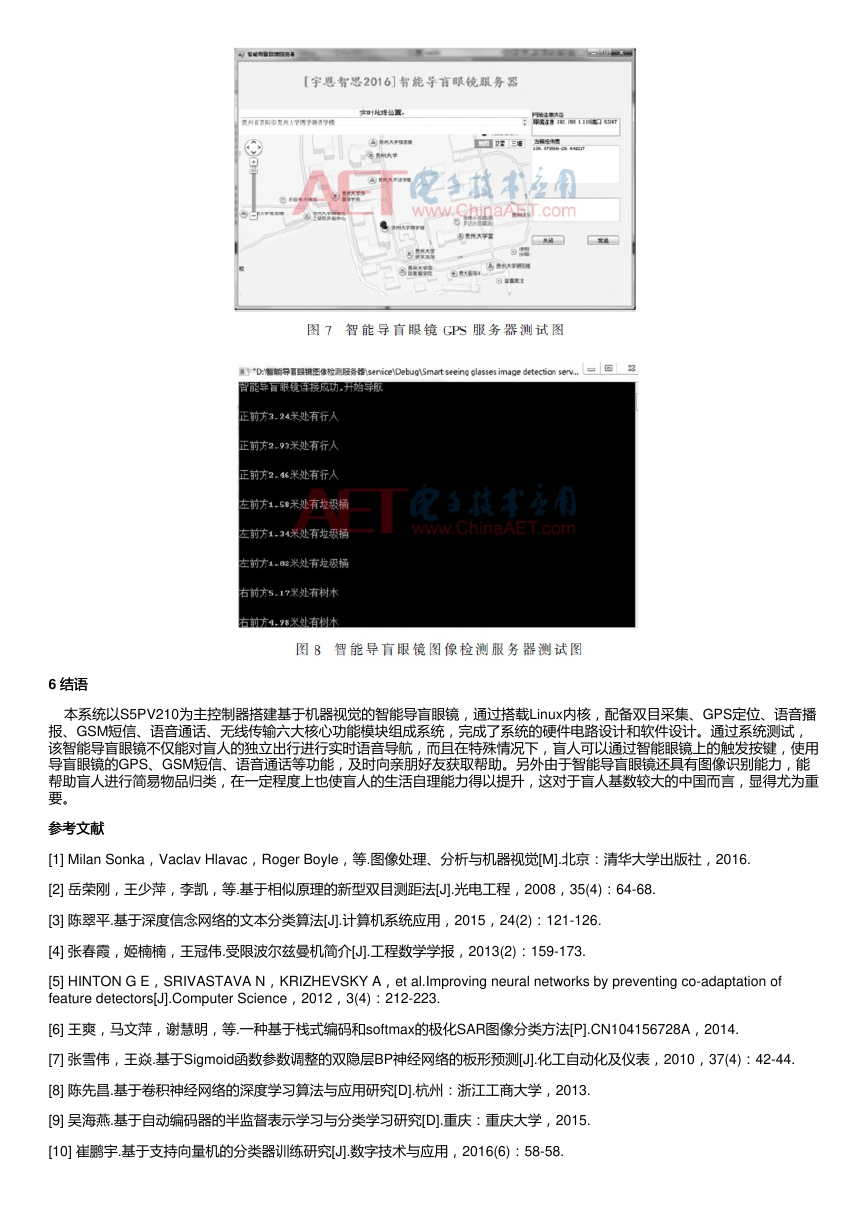

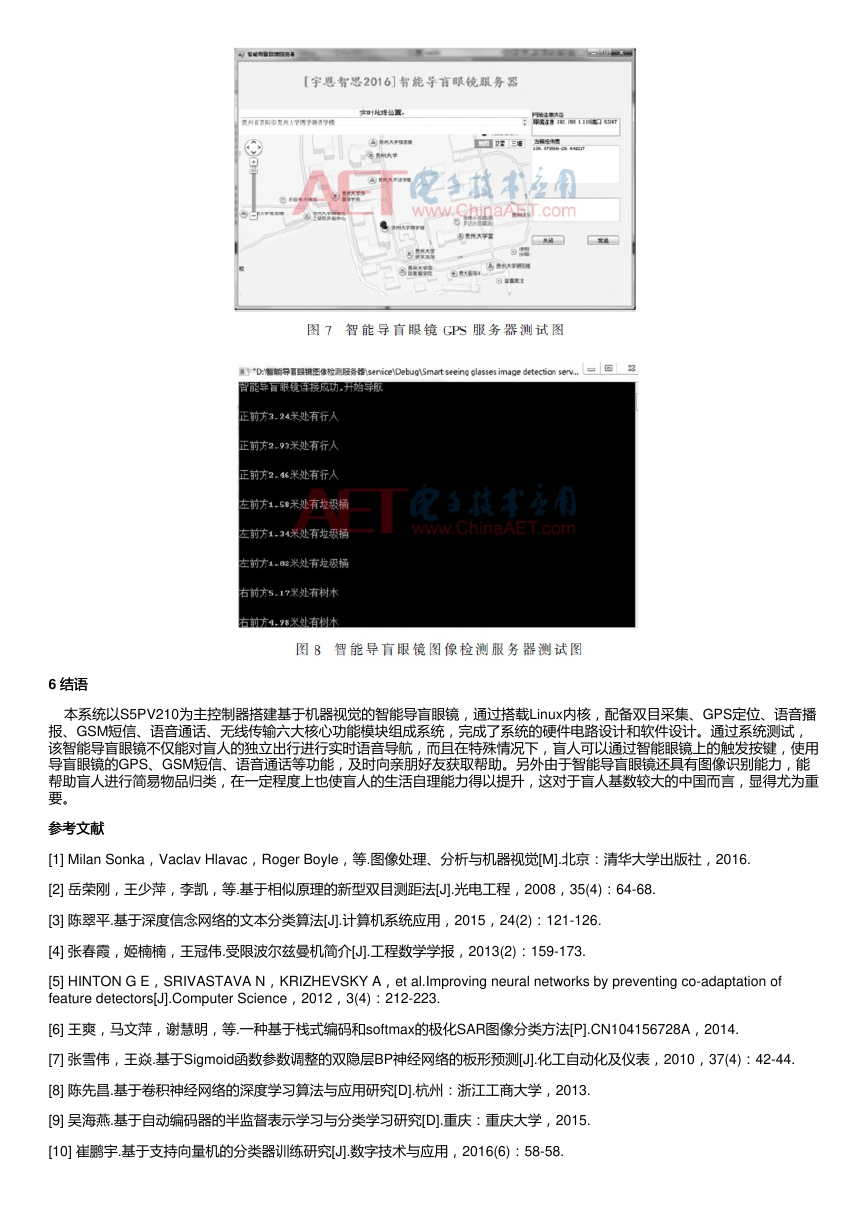

本系统的软件设计分为远端云平台服务器上的程序设计和智能导盲眼镜前端的程序设计两部分。远程云平台服务器上的软

件设计主要是采用C/C++等高级编程语言将图片的识别、测距、方位检测等相关算法转换成计算机系统能够识别的程序指令,

从而实现智能导盲眼镜远程云服务器的识别、测距、方位检测等功能。另外GPS的经纬度解析也在云服务器上通过软件编程

实现。导盲眼镜前端软件设计主要包括双目摄像头的图片采集、GPS地理位置坐标的获取、无线通信传输模块的数据传输与

接收、语音播报模块的调度和按键中断的配置等功能模块子程序的编写,其主程序流程图如图4所示。

�

4 基于深度信念网络的自然场景识别

基于深度信念网络的自然场景识别

深度信念网络(Deep Belief Network,DBN)[3]作为深度学习中最为广泛应用的一种算法模型,多应用于手写字体识别和

自然场景识别这两个方向。在智能导盲眼镜控制系统中,深度信念网络主要用在自然场景中常见的物体识别上,这也是深度学

习在机器视觉领域中的一种应用体现。图5是一个典型的深度信念网络的网络结构模型。

从图5可以看出,深度信念网络是由多个受限制玻尔兹曼机(Restricted Boltzmann Machines,RBM)[4]组成的深层网络,

在这个网络中,DBN的训练过程采用逐层训练的方法,每一层RBM都单独训练,参数也是单独调整[5]。训练完一层后,将该

层的训练结果作为下一层RBM的输入,直至每一层RBM都训练完成,这个过程称之为预训练。当深度信念网络中的所有RBM

训练完成后,再根据样本的标签值,采用反向传播算法向后微调。

在智能导盲眼镜的图像训练过程中,采用改进型的CIFAR-10自然场景库作为测试训练样本。原始的CIFAR-10数据集有60

000张32×32的彩色图像,分为飞机、汽车、猫、鸟、鹿、狗、青蛙、马、船和卡车共10类。为了增强智能导盲眼镜的实用

性,结合盲人的特殊情况,本文在实际的系统图像训练中,加入了餐桌、椅子、人、垃圾桶、树木等生活中常见的一些目标场

景,对原始的CIFAR-10自然场景库进行了改进,然后采用改进型的CIFAR-10自然场景库通过图6所示的深度信念网络模型进

行训练识别。

�

在上述训练模型中,改进型CIFAR-10自然场景库中每张图均为32×32的彩色图片,因此输入层大小为3 072个结点(3

072=32×32×3),两个隐含层节点数分别为1 000和200,在经过面向多元分类的Softmax分类器[6]后输出层为10个单元,系统

最终模型结构为3072-1000-200-10。在智能导盲眼镜系统实际的图像训练阶段,训练模型中的两层RBM的训练迭代次数都设

置为200,学习率都设置成0.1。训练完成后,将系统学习到的权重用于初始化神经网络,对网络参数进行参数微调, 并用

Sigmoid函数[7]激活神经网络。系统训练过程中,由于样本繁多,数据繁杂,隐含层需要相对较多的节点数才能学习到较好的

特征,加之图片本身信息量大,需要较多次的迭代,整个训练过程平均历时10个小时,这与深度学习中的卷积神经网络[8]以及

自动编码模型[9]相比,训练时间大幅度缩短,并且还具有较为理想的识别率,这也是本系统选用深度信念网络作为识别训练模

型的主要原因。

5 系统测试结果与分析

系统测试结果与分析

采用上述的深度信念网络训练模型先对改进型CIFAR-10库中的10 000张测试图片随机进行了示范性测试,表1所示为各类

样本的识别率和平均识别率。

从表1可以看出改进型CIFAR-10库中的10类测试样本通过导盲眼镜系统的深度信念网络训练模型后,其平均识别率为

82.9%,与基于支持向量机[10]训练识别模型的识别率相比,其平均识别率超出了支持向量机模型的近10%,为进一步的智能

导盲眼镜整体系统测试奠定了基础。最后,针对盲人的生活需要,结合智能导盲眼镜的其他功能,对智能导盲眼镜控制系统在

实际场景中进行了系统联调,其中双目摄像头的采集帧率设置为3帧/s,语音导航频率设定为每两秒钟导盲一次,远程服务器

端测试结果如图7、图8所示。通过图7可以看出智能导盲眼镜的GPS功能能实时、准确地获取佩戴导盲眼镜用户的经纬度,并

通过无线通信传输模块送至远程服务器,进行地理位置的准确匹对。图8显示该智能导盲眼镜在实际场景中,不仅能较准确识

别出前方目标的类别,还能测出目标物体到导盲眼镜的距离,正确表示出障碍物的方位特征,并在眼镜端实时以语音导盲的形

式帮助盲人及时有效地避开障碍物,从而保障了盲人的安全出行。

�

6 结语结语

本系统以S5PV210为主控制器搭建基于机器视觉的智能导盲眼镜,通过搭载Linux内核,配备双目采集、GPS定位、语音播

报、GSM短信、语音通话、无线传输六大核心功能模块组成系统,完成了系统的硬件电路设计和软件设计。通过系统测试,

该智能导盲眼镜不仅能对盲人的独立出行进行实时语音导航,而且在特殊情况下,盲人可以通过智能眼镜上的触发按键,使用

导盲眼镜的GPS、GSM短信、语音通话等功能,及时向亲朋好友获取帮助。另外由于智能导盲眼镜还具有图像识别能力,能

帮助盲人进行简易物品归类,在一定程度上也使盲人的生活自理能力得以提升,这对于盲人基数较大的中国而言,显得尤为重

要。

参考文献

参考文献

[1] Milan Sonka,Vaclav Hlavac,Roger Boyle,等.图像处理、分析与机器视觉[M].北京:清华大学出版社,2016.

[2] 岳荣刚,王少萍,李凯,等.基于相似原理的新型双目测距法[J].光电工程,2008,35(4):64-68.

[3] 陈翠平.基于深度信念网络的文本分类算法[J].计算机系统应用,2015,24(2):121-126.

[4] 张春霞,姬楠楠,王冠伟.受限波尔兹曼机简介[J].工程数学学报,2013(2):159-173.

[5] HINTON G E,SRIVASTAVA N,KRIZHEVSKY A,et al.Improving neural networks by preventing co-adaptation of

feature detectors[J].Computer Science,2012,3(4):212-223.

[6] 王爽,马文萍,谢慧明,等.一种基于栈式编码和softmax的极化SAR图像分类方法[P].CN104156728A,2014.

[7] 张雪伟,王焱.基于Sigmoid函数参数调整的双隐层BP神经网络的板形预测[J].化工自动化及仪表,2010,37(4):42-44.

[8] 陈先昌.基于卷积神经网络的深度学习算法与应用研究[D].杭州:浙江工商大学,2013.

[9] 吴海燕.基于自动编码器的半监督表示学习与分类学习研究[D].重庆:重庆大学,2015.

[10] 崔鹏宇.基于支持向量机的分类器训练研究[J].数字技术与应用,2016(6):58-58.

�

作者信息:

何腾鹏,张荣芬,刘 超,房乐楠,刘宇红

(贵州大学 大数据与信息工程学院,贵州 贵阳550025)

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc