软件学报 ISSN 1000-9825, CODEN RUXUEW

Journal of Software, [doi: 10.13328/j.cnki.jos.006131]

©中国科学院软件研究所版权所有.

机器学习模型安全与隐私研究综述

研究综述

纪守领 1, 杜天宇 1, 李进锋 1, 沈 超 2, 李 博 3

E-mail: jos@iscas.ac.cn

http://www.jos.org.cn

Tel: +86-10-62562563

厄巴纳香槟 61822, 美国)

计算机科学与技术学院,浙江 杭州 310027)

西安交通大学电子与信息学部,陕西 西安 710049)

1(浙江大学网络空间安全研究中心 浙江大学计算机科学与技术学院

2(西安交通大学智能网络与网络安全教育部重点实验室 西安交通大学电子与信息学部

3(伊利诺伊大学香槟分校计算机科学学院,伊利诺伊 厄巴纳香槟

通讯作者: 纪守领, E-mail: sji@zju.edu.cn

强化学习以及分布式学习等理论和技术取得的突破性进展,为机器学习提供

摘 要: 在大数据时代下,深度学习、强化学习以及分布式学习等理论和技术取得的突破性进展

同时促进了机器学习的规模化和产业化发展.然而,尽管机器学习模型在现实应用

了数据和算法层面的强有力支撑,同时促进了机器学习的规模化和产业化发展

但其本身仍然面临着诸多的安全威胁.机器学习在数据层、模型层以及应用层面临的安全和隐

中有着出色的表现,但其本身仍然面临着诸多的安全威胁

私威胁呈现出多样性、隐蔽性和动态演化的特点.机器学习的安全和隐私问题吸引了学术界和工业界的广泛关注

机器学习的安全和隐私问题吸引了学术界和工业界的广泛关注,

一大批学者分别从攻击和防御的角度对模型的安全和隐私问题进行了深入的研究,并且提出了一系列的攻防方法.

一大批学者分别从攻击和防御的角度对模型的安全和隐私问题进行了深入的研究

在本综述中,我们回顾了机器学习的安全和隐私问题,并对现有的研究工作进行了系统的总结和科学的归纳

并对现有的研究工作进行了系统的总结和科学的归纳,同时明

确了当前研究的优势和不足.最后,我们探讨了机器学习模型安全与隐私保护研究当前所面临的挑战以及未来潜在

我们探讨了机器学习模型安全与隐私保护研究当前所面临的挑战以及未来潜在

的研究方向,旨在为后续学者进一步推动机器学习模型安全与隐私保护研究的发展和应用提供指导

旨在为后续学者进一步推动机器学习模型安全与隐私保护研究的发展和应用提供指导.

关键词: 机器学习;投毒攻击;对抗样例;模型隐私;人工智能安全

人工智能安全

中图法分类号: TP311

中 文 引 用 格 式 : 纪 守 领 , 杜 天 宇 , 李 进 锋 , 沈 超 , 李 博

http://www.jos.org.cn/1000-9825/6131.htm

英文引用格式: Ji SL, Du TY, Li JF, Shen C, Li B. Security and

Bao/Journal of Software, 2021 (in Chinese). http://www.jos.org.cn/1000

http://www.jos.org.cn/1000-9825/6131.htm

李 博 . 机 器 学 习 模 型 安 全 与 隐 私 研 究 综 述 . 软 件 学 报 ,2021.

Security and privacy of machine learning models: a survey. Ruan Jian Xue

Security and Privacy of Machine Learning M

Models: A Survey

JI Shou-Ling1, DU Tian-Yu1, LI Jin-Feng1, SHEN Chao

1(Institute of Cyberspace Research and College of Computer Science and Technology

Institute of Cyberspace Research and College of Computer Science and Technology, Zhejiang University, Hangzhou 310027, China)

2(Ministry of Education Key Laboratory for Intelligent Networks and Network

Ministry of Education Key Laboratory for Intelligent Networks and Network Security and Faculty of Electronic and Information

Engineering, Xi’an Jiaotong University, Xi’an 710049, China)

3(Department of Computer Science, University of Illinois at Urbana

Department of Computer Science, University of Illinois at Urbana–Champaign, Urbana-Champaign 61822, United States)

SHEN Chao2, LI Bo3

Abstract: In the era of big data, breakthroughs in theories and technologies

g data, breakthroughs in theories and technologies of deep learning, reinforcement learning, and distributed

support for machine learning at the data and the algorithm level, as well as have promoted the development

learning have provided strong support for machine learning at the data and

and industrialization of machine learning. However, though machine learning models have excellent performance in many

of scale and industrialization of machine learning. However, though machine learning model

and privacy threats at the data, model, and application levels, which could be

real-world applications, they still suffer many security and privacy

aracterized by diversity, concealment, and dynamic evolution. The security and privacy issues of machine learning have attracted

characterized by diversity, concealment, and dynamic evolution. The security and privacy issues of machine learning have attrac

extensive attention from academia and industry. A large number of researchers have conducted in-depth research on the security and

extensive attention from academia and industry. A large number of

privacy issues of models from the perspective of attack and defense, and proposed a series of

privacy issues of models from the perspective of attack and defense, and proposed a series of attack and defense methods. In this survey,

基金项目: 国家重点研发计划项目(2018YFB0804102);浙江省自然科学基金杰出青年项目

目(2019C01055);国家自然科学基金项目(61772466,U1936215,U1836202

Foundation item: National Key Research and Development

Science Foundation for Distinguished Young Scholars (LR19F020003)

China (2019C01055); National Natural Science Foundation of China (

浙江省自然科学基金杰出青年项目(LR19F020003);浙江省科技计划项

U1836202,61822309,61773310,U1736205)

ment Program of China (2018YFB0804102); Zhejiang Provincial Natural

(LR19F020003); Provincial Key Research and Development Program of Zhejiang,

National Natural Science Foundation of China (61772466,U1936215,U1836202,61822309,61773310,U1736205)

收稿时间: 2019-06-10; 修改时间: 2019-10-15; 采用时间:

2020-08-17; jos 在线出版时间: 2020-09-10

�

2

Journal of Software 软件学报

we review the security and privacy issues of machine learning, systematically and scientifically summarize existing research work, and

clarify the advantages and disadvantages of current research. Finally, we explore the current challenges and future research directions of

machine learning model security and privacy research, aiming to provide guidance for follow-up researchers to further promote the

development and application of machine learning model security and privacy research.

Key words: machine learning; poisoning attack; adversarial example; model privacy; artificial intelligence security

在大数据时代下,深度学习、强化学习以及分布式学习等理论和技术取得的突破性进展,为机器学习在计

算机视觉、自然语言处理以及语音识别等多个领域的蓬勃发展提供了数据和算法层面的强有力支撑,同时也促

进了机器学习技术在诸如自动驾驶、人脸识别、智慧医疗以及智能风控等多个场景中的落地应用并且取得了

巨大的成功.在许多任务中,当呈现自然发生的输入时,机器学习模型的表现甚至胜过了人类.

然而,大多数的机器学习模型在设计时并未考虑攻击者的存在.尽管在预测正常样本时模型能有优异的表

现,但在现实场景中,由于可能存在大量的恶意用户甚至是攻击者,机器学习模型在生命周期的各个阶段都可能

面临着不同程度的安全风险,导致模型无法提供正常的服务或者是泄露模型的隐私信息.例如,攻击者可能对模

型的训练数据和输入样本进行恶意篡改或是窃取模型参数,从而破坏模型的机密性、可用性和完整性,这就是

机器学习模型面临的安全与隐私问题.

为了构建安全可靠的机器学习系统,消除机器学习模型在实际部署应用中的潜在安全风险,保证机器学习

模型的机密性、完整性和可用性,一大批来自学术界和工业界的学者系统地研究了机器学习模型安全与隐私问

题,并且前瞻性地提出了一系列针对模型安全和隐私的对抗攻击和防御方法,涵盖了机器学习模型的整个生命

周期.然而,由于不同学者所处的研究领域不同,解决问题的角度不同,因而构建的威胁模型也不同,所提的攻击

或防御方法也各有侧重.因此,我们亟需要对现有的研究工作进行系统的整理和科学的归纳、总结、分析,以便

为后续学者了解或研究机器学习模型安全提供指导.

在本文中,我们首先详细地阐述了机器学习中的 CIA 模型.然后,我们从数据安全、模型安全以及模型隐私

三个角度对现有的攻击和防御研究进行系统的总结和科学的归纳,并讨论了相关研究的局限性.最后,我们讨论

了机器学习模型安全与隐私研究所面临的挑战以及未来可行的研究方向.

1 机器学习中的 CIA 模型

随着人工智能安全研究的进一步深入,机器学习模型安全与隐私问题逐渐引起了学术界的关注.Papernot

等人将机器学习模型安全需求总结为三个特性:机密性(Confidentiality)、完整性(Integrity)和可用性

(Availability),即机器学习中的 CIA 模型.机器学习模型机密性要求机器学习系统必须保证未得到授权的用户

无法接触到系统中的私密信息,即包括模型的训练数据,也包括模型的架构、参数等信息;完整性要求模型的

预测结果不能偏离预期;可用性则要求机器学习系统在面对异常输入甚至是恶意输入时仍能够提供正常服务.

然而,现有研究表明,在机器学习模型生命周期的各个阶段,机器学习的 CIA 三个特性都有可能被攻击破坏,所对

应的攻击方法分别称为机密性攻击、完整性攻击和可用性攻击.

机密性攻击. 机器学习即服务(Machine Learning as a Service, MLaaS)平台为大量非专业的数据持有者

训练模型提供了便利,但这同时也可能会泄漏数据持有者的隐私数据.文献[1]指出,MLaaS 平台上由第三方提供

的模型未必可信.当数据持有者使用 MLaaS 平台时,可能会选到由攻击者精心设计的恶意模型.例如,攻击者可

以将训练数据编码到模型参数中,然后通过解码参数窃取用户的隐私.此外,文献[2]中提出了一种基于解方程形

式窃取模型参数的攻击方法,在此基础上,攻击者可以基于模型逆向的方法生成与模型私密训练数据相似的数

据,从而对模型的机密性造成巨大威胁.

可用性攻击.由于模型推理阶段机器学习系统可能会接收并处理大量的异常输入甚至是恶意的输入,因而

机器学习模型的可用性也可以成为攻击者的攻击目标,以迫使系统无法提供正常的服务.例如,在无人驾驶领

域,如果攻击者把一个非常难以识别的东西放在车辆会经过的路边或者是对交通标志进行物理意义上的扰动,

就有可能迫使一辆自动驾驶汽车进入安全保护模式并停在路边,无法进行正常工作.

�

纪守领 等:机器学习模型安全与隐私

3

完整性攻击.完整性攻击发生在模型的训练阶段

即攻击者通过篡改训练数据或添加恶意数据来影响模型训练过程

段,最典型的攻击方式是对抗样例攻击,即攻击者通过在测试数据

出错的目的.

阶段或预测阶段.在训练阶段,最常见的攻击方式是投毒攻击[3],

影响模型训练过程,最终降低其在预测阶段的准确性.在预测阶

即攻击者通过在测试数据中添加精心构造的微小扰动达到让模型预测

2 数据安全风险与保护

机器学习模型除了预测阶段容易受到对抗样例攻击之外,其训练过程本身也可能遭到攻击者攻击.特别地,

机器学习模型除了预测阶段容易受到对抗样例攻击之外

例如 Yelp、Twitter 等)进行训练的话,攻击者很容易通过将

以达到改变模型行为和降低模型性能的目的[4-6].这种类型

它不仅在学术界受到广泛关注,在工业界也带来了严重危害.

用户交谈的聊天机器人,仅在 16 个小时后被关闭,只因为它在受到投毒攻击后

如果机器学习模型是根据潜在不可信来源的数据(例如

精心制作的样本插入训练集中来操纵训练数据分布,

的攻击被称为“数据投毒”(Data Poisoning)攻击,它不仅在学术界受到广泛关注

例如微软 Tay,一个旨在与 Twitter 用户交谈的聊天机器人

开始提出种族主义相关的评论.这种攻击令我们不得不重新思考机器学习模型的安全性

这种攻击令我们不得不重新思考机器学习模型的安全性.

2.1 投毒攻击

最早关于投毒攻击的研究可追溯到[7,8].Newsome

成.Nelson 等人[4]表明,通过在训练阶段学习包含正面词汇的垃圾邮件

推理阶段将合法电子邮件误分类为垃圾邮件.Rubinstein

训练的异常探测器.Xiao 等人[10]研究了 LASSO、岭回归

特征选择算法对投毒攻击的鲁棒性.在恶意软件检测任务上的结果表明

下可能会受到严重影响,例如毒害少于 5%的训练样本就可以将

选择的特征集.

Newsome 等人[8]设计了一种攻击来误导检测恶意软件中的签名生

通过在训练阶段学习包含正面词汇的垃圾邮件,可以误训练垃圾邮件过滤器,从而使其在

Rubinstein 等人[9]展示了如何通过注入干扰来毒害在网络传输上

岭回归(Ridge Regression)和弹性网络(Elastic Net)三种

在恶意软件检测任务上的结果表明,特征选择方法在受到投毒攻击的情况

的训练样本就可以将 LASSO 选择的特征集减弱到几乎等同于随机

Mei 等 人 [11] 证 明 了 最 优 投 毒 攻 击 可 以 表 述 为 一 个 双 层 优 化 问 题

证 明 了 最 优 投 毒 攻 击 可 以 表 述 为 一 个 双 层 优 化 问 题 , 并 且 对 于 某 些 具 有 库 恩 塔 克

(例如支持向量机、逻辑回归和线性回归),利用隐函数的

针对线性自回归模型提出了一个通用的数学框架,用于制定

ielski 等人[5]对线性回归模型的投毒攻击及其防御方法进行

并提出了一个特定于线性回归模型设计的理论基础优化框架.除了传统的机器学习模型之外,投毒

生物识别系统[15]以及推荐系统等[16][17].Muñoz-González 等人

大大降低了攻击复杂度.Suciu 等人[18]提出了 StringRay,这种

(Karush-Kuhn-Tucker,KKT)条件的机器学习算法(

梯度方法可以有效地解决这一问题.Alfeld 等人[12]针对线性自回归模型提出了一个通用的数学框架

各种目标、成本和约束条件下的投毒攻击策略.Jagielski

了系统研究,并提出了一个特定于线性回归模型设计的理论基础优化框架

攻击还被扩展至深度神经网络[13]、强化学习[14]、生物识别系统

[13]提出了一种基于梯度优化思想的投毒攻击算法,大大降低了攻击复杂度

方法不仅在四种分类任务上成功地实现了定向投毒攻击,同时能够绕过两种现有的防御机制[19,20].

方法不仅在四种分类任务上成功地实现了定向投毒攻击

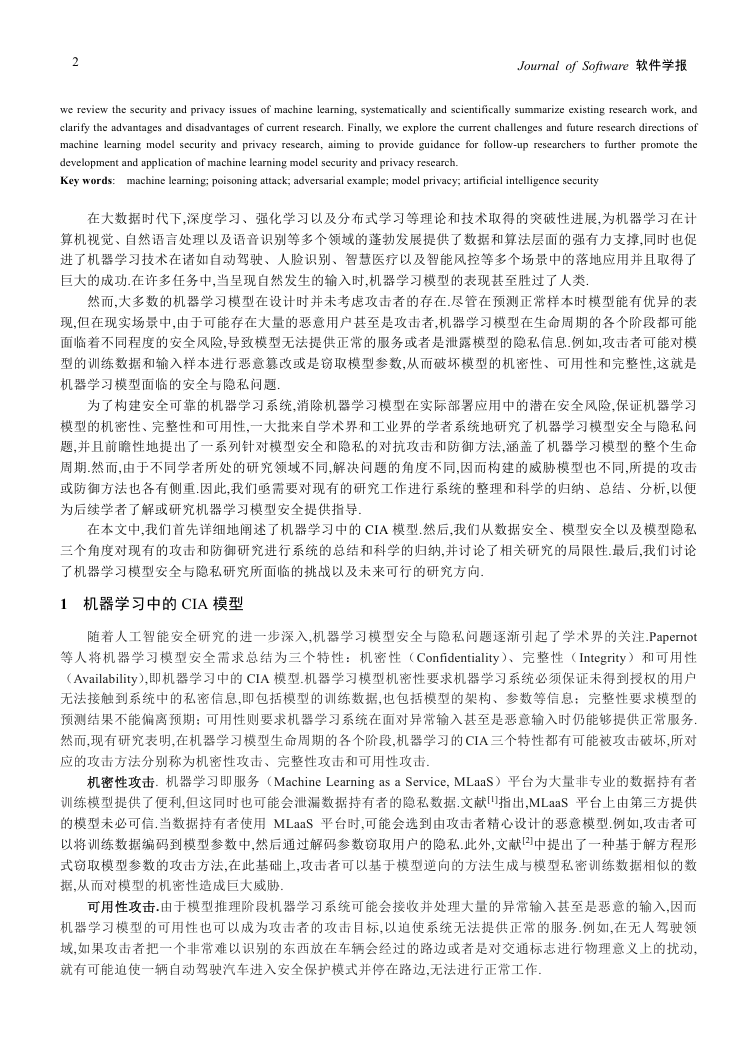

Fig.1 A stop sign and its backdoored versions using, from left to right, a sticker with a

A stop sign and its backdoored versions using, from left to right, a sticker with a yellow square, a bomb and

图 1 停车标志及其受后门攻击的版本,后门触发器

后门触发器(从左到右)为黄色方块、炸弹和花朵[21]

a flower as backdoors

a flower as backdoors

最近,备受学界关注的“后门攻击(Backdoor Attack

危害性更大的投毒攻击,它使攻击者能够将“后门”

触发器完成恶意攻击行为.被植入“后门”的深度神经网络在正常样本上表现很好

Backdoor Attack)”[21,22]或“木马攻击(Trojan Attack)”[23]就是一种

”或“木马”植入到模型中,并在预测阶段通过简单的后门

的深度神经网络在正常样本上表现很好,但会对具有特定后门触发

�

4

Journal of Software 软件学报

器的输入样本做出特定的错误预测.“后门”可以无限期地保持隐藏直到被带有特定后门触发器的样本激活,

隐蔽性极强,因而有可能给许多安全相关的应用(例如生物识别认证系统或自动驾驶汽车)带来严重的安全风

险[21-23].例如,Gu 等人[21]通过将带有特殊标签(即后门触发器)的“停车”标志图像插入训练集中并标记为“速

度限制”以在路标识别模型中生成后门.该模型虽然可以正确地分类正常街道标志,但会对拥有后面触发器的

恶意停车标志产生错误的分类.因此,通过执行此攻击,攻击者可以通过在模型上贴上标签来欺骗模型,将任何

停车标志归类为速度限制,从而给自动驾驶汽车带来严重的安全隐患.虽然后门攻击和对抗样例攻击都会导致

模型误分类,但对抗样例的扰动特定于输入和模型,而后门攻击则可以使攻击者能够选择最方便用于触发错误

分类的任何扰动(例如,在停止标志上贴标签).此外,后门攻击也可被用来给深度神经网络加上“水印”,将模

型识别为特定供应商的知识产权,以防止具有商业价值的模型被轻易复制[24].

2.2 防御方法

大多数针对投毒攻击的防御机制依赖于一个事实,即投毒样本通常在预期输入分布之外.因此,投毒样本

可被视为异常值,并且可以使用数据清理(即攻击检测和删除)[20]和鲁棒学习(即基于对边远训练样本本质上

不太敏感的鲁棒统计的学习算法)[5]来净化训练样本.

鲁 棒 学 习.Rubinstein 等人 [9]利用 稳健 统计 的知 识 构建 了 一个 基于 主成 分分 析 (Principal Component

Analysis, PCA)的投毒攻击检测模型.为了限制异常值对训练分布的影响,该检测模型约束 PCA 算法搜索一个

特定方向,该方向的投影最大化了基于鲁棒投影跟踪估计的单变量离散度量,而不是标准偏差.Liu 等人[25]假设

特征矩阵可以很好地用低秩矩阵来近似,并在此基础上集成了稳健低秩矩阵近似和稳健主成分回归方法用于

稳健回归.受稳健统计中利用修剪损失函数来提高鲁棒性这一做法的启发,Jagielski 等人[5]提出了一种名为

TRIM 的针对回归模型的防御方法,并提供关于其收敛的正式保证以及在实际部署时投毒攻击影响的上限.在

每次迭代中,TRIM 使用具有最低残差的子集计算修剪版的损失函数.本质上,这种方法是在对抗环境中应用经

过修正的优化技术进行正则化线性回归.

数据清理.Shen 等人[3]针对不能接触到所有训练数据的间接协作学习系统提出了相应的防御方法 Auror,

这种方法首先识别与攻击策略对应的相关掩蔽特征(Masked Features),然后基于掩蔽特征的异常分布来检测

恶意用户.Steindhardt 等人[26]尝试在训练模型之前检测并剔除异常值来防御投毒攻击,并在经验风险最小化的

情况下,得出了任意投毒攻击影响的近似上限.Baracaldo 等人[27]利用 tamper-free provenance 框架[28],提出利用

训练集中原始和变换后数据点的上下文信息来识别有毒数据,从而实现在潜在的对抗性环境中在线和定期重

新训练机器学习模型.Zhang 等人[29]提出一种利用一小部分可信样本来检测整个训练集中的恶意样本的算法

(DUTI).具体地,该方法寻求针对训练集标签的最小更改集,以便从该校正训练集学习的模型能正确地预测可

信样本的标签.最后,该方法将标签被更改的样本就被标记为潜在的恶意样本,以提供给领域专家人工审核.

后门攻击检测.模型后门攻击检测极具挑战性,因为只有当存在后门触发器时才会触发恶意行为,而后门

触发器在没有进一步分析的情况下通常只有攻击者知道.因此,无论是提供训练数据的用户还是提供预训练模

型的用户,都无法保证其基于机器学习模型的相关操作的安全性.为解决这一挑战,Chen 等人[30]提出了激活聚

类(Activation Clustering, AC)方法,用于检测被植入后门触发器的训练样本.该方法通过分析训练数据的神经

网络激活状态,以确定它是否遭受后门攻击以及哪些数据样本是恶意的.Wang 等人[31]提出了针对深度神经网

络后门攻击的检测系统,利用输入过滤、神经元修剪和 unlearning 等方法能够识别深度神经网络中是否存在“后

门”并重建可能的后门触发器,从而保证模型在实际部署应用中的安全性.

3 模型安全风险与保护

近年来,机器学习、深度学习等核心技术已被广泛应用于图像分类、语音识别、自动驾驶、垃圾邮件过滤

以及智能反欺诈等现实任务.研究表明,攻击者试图通过各种方法改变模型输入特征以绕过现实任务中的机器

学习模型的检测,或直接对模型进行攻击以破坏其完整性,从而达到对抗目的.其中,攻击者最常用的攻击手段

是通过向正常样例中添加精细设计的、人类无法感知的噪音来构造对抗性样例,从而达到不干扰人类认知而促

�

纪守领 等:机器学习模型安全与隐私

5

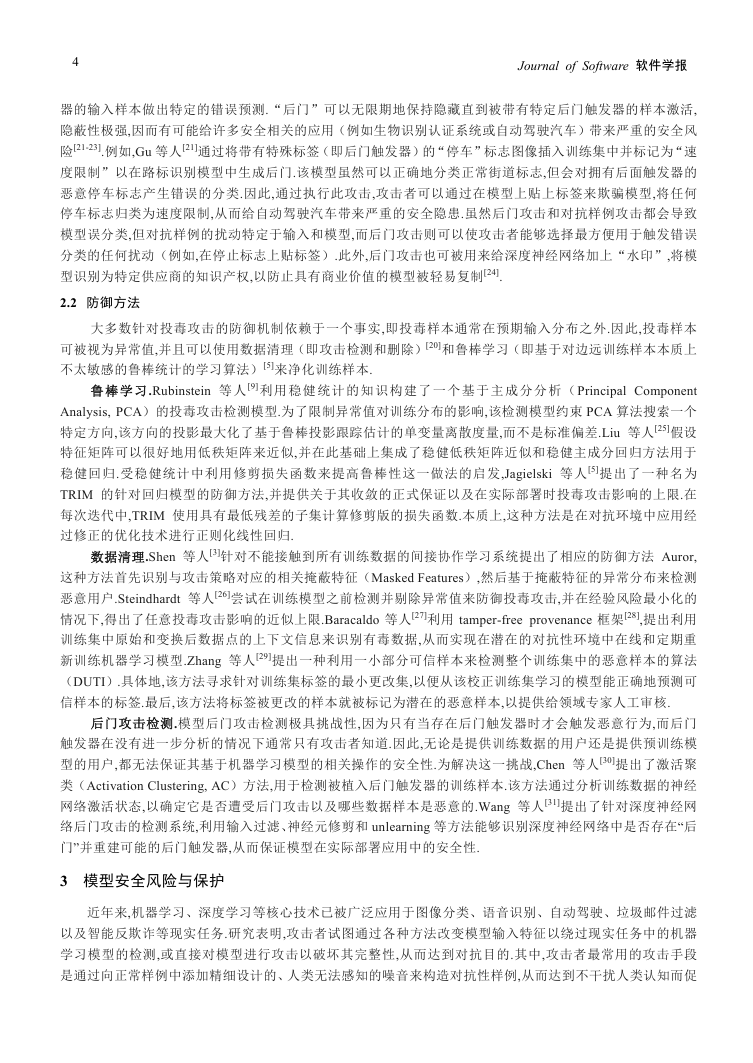

使机器学习模型对精心构造的对抗性样例作出错误判断的目的,这种攻击方法被称为“对抗攻击”或者是“对

使机器学习模型对精心构造的对抗性样例作出错误判断的目的

图片以 57.7%的置信度被图像分类模型识别为“熊猫”,而添

抗样例攻击”.以图像分类为例, 如图 2 所示,原始图片以

加细微扰动之后得到的对抗性图片则以 99.3%的置信度被错误

的置信度被错误地识别为“长臂猿”,然而对于人而言,对抗性图

片依然可以正常地被识别为大熊猫.由于这种细微的扰动

这种细微的扰动通常是人眼难以分辨的,因而使得攻击隐蔽性极强,但

其足以改变模型的预测结果,危害性极大,因而给现实场景中尤其是风险敏感场景中实际部署应用的机器学习

因而给现实场景中尤其是风险敏感场景中实际部署应用的机器学习

模型带来了巨大的安全威胁.

Fig.2 An example of

.2 An example of adversarial attack

图 2 对抗样例攻击示例

对抗样例攻击示例[32]

与其他攻击不同,对抗性攻击的核心在于如何构造能促使机器学习模型产生误分类的对抗样例

的核心在于如何构造能促使机器学习模型产生误分类的对抗样例,因而主要

攻击过程发生在对抗样例构造阶段.一旦构造完成,该对抗样例便如同正常样例一般被攻击者输入到目标攻击

该对抗样例便如同正常样例一般被攻击者输入到目标攻击

模型中以误导模型的决策过程,从而达到欺骗待攻击模型的目的

从而达到欺骗待攻击模型的目的.在对抗样例的构造过程中,根据攻击者所获取

到的目标模型具体信息的多少,对抗攻击可以分为白盒对抗攻击和黑盒对抗攻击

对抗攻击可以分为白盒对抗攻击和黑盒对抗攻击.

白盒攻击.白盒攻击假设攻击者可以完全获取目标模型的结构和参数等信息

白盒攻击假设攻击者可以完全获取目标模型的结构和参数等信息,因而在攻击过程中,攻击者

可以利用模型的完整信息求解目标模型的梯度信息,以指导对抗样例的生成过程.

可以利用模型的完整信息求解目标模型的梯度信息

黑盒攻击.与白盒攻击不同,黑盒攻击假设攻击者既无法得知目标模型采用训练数据和模型结构

黑盒攻击假设攻击者既无法得知目标模型采用训练数据和模型结构,也无法

只能获取模型的最终决策结果.在这种情况下,待攻击模型对于攻击者而言犹如一

获取模型的具体参数,只能获取模型的最终决策结果

个黑箱,攻击者只能通过操纵模型的输入和利用最终决策结果来探测目标模型的敏感性或对模型的梯度

攻击者只能通过操纵模型的输入和利用最终决策结果来探测目标模型的敏感性或对模型的梯度

信息进行数值估计,以进而指导对抗样例的构造过程

以进而指导对抗样例的构造过程.因而,相较于白盒攻击,黑盒攻击所利用的信息更少,

攻击的难度更大.

3.1 对抗样例理论研究

Szegedy 等人[33]在 MNIST 数据集上的实验表明

中学到符合正确决策结果的内在特征,并且这种现象具有普

试样本在整个分布中低概率出现时,这些模型就暴露出了

模型的高度非线性导致的输入与输出映射的不连续性

实验表明,在测试集上表现优秀的分类模型其实并没有从训练数据

并且这种现象具有普遍性.虽然这些模型在自然数据上表现优秀,但当测

这些模型就暴露出了缺陷.因此,Szegedy 认为对抗样例存在的原因之一是

输入与输出映射的不连续性,以及次优的模型平均和次优的正则化导致的过拟合.

然而,Goodfellow 认为对抗样例的存在是高维空间中的线性

据的多个微小变化叠加会导致输出的极大变化,即如果线性模型的输入维度

例攻击.对于深度神经网络等非线性模型,为了保证模型易于训练

是采用 Sigmoid 激活函数,通常也会让神经元尽可能处于

模型的完整性易受对抗样例攻击.

高维空间中的线性特质导致的[32].在高维线性模型空间中,输入数

如果线性模型的输入维度足够高,那么它就容易受到对抗样

为了保证模型易于训练,通常会选择 ReLU 等分段线性激活函数.即使

神经元尽可能处于非饱和的区域.因此,非线性模型中的线性行为也使得

最近的一项研究表明[34],对抗样例的产生可归因于非稳健特征的出现

的产生可归因于非稳健特征的出现:某些来自数据分布模式的特征对

同时,他们也对对抗样例的迁移性给出了解释:由于任意两

于人类来说是难以理解的,但它们具备高度预测性.同时

�

6

Journal of Software 软件学报

个模型可能同时学习到类似的非稳健特征,因此扰动此类特征的对抗样例可以对二者同时产生影响.

3.2 对抗样例攻击方法

作为破坏机器学习模型完整性最强有力的攻击方法,对抗样例攻击被广泛应用于诸如计算机视觉、自然

语言处理、音频处理以及图数据处理等各个领域.

3.2.1 计算机视觉

在计算机视觉领域,对抗攻击旨在通过向图片中添加人眼无法感知的噪音以欺骗诸如图像分类,目标识别

以及看图说话等多种机器学习模型.根据在攻击过程中是否依赖模型具体的结构和参数信息,针对计算机视觉

模型的对抗攻击方法可以分为白盒攻击和黑盒攻击.为了保证攻击的隐蔽性,无论是白盒攻击还是黑盒攻击均

需要限定所添加扰动的幅度,从而保证促使学习模型产生误分类的同时,不干扰人的识别.

3.2.1.1 白盒攻击

基于优化.Szegedy 等人[33]首次提出“对抗样例”这一概念,将寻找最小可能的攻击扰动定义为一个优化问

题,并用提出使用 L-BFGS 来解决这个问题.这种方法攻击成功率很高,但同时计算成本也较高.Carlini 等人[36]

进一步改进了 L-BFGS 方法,提出了攻击效果更好的目标函数,并通过改变变量解决边界约束问题,这一方法通

常被称为 C&W 攻击.Chen 等人[37]在 C&W 攻击的基础上结合弹性网(Elastic Net)正则思路提出了 EAD,该方

法生成的对抗样本相较于 C&W 生成的对抗样本具有更强的迁移性.Khrulkov 等人[38]提出了一种基于求解优化

问题的构造通用扰动的新算法,该算法主要基于深度神经网络特征映射的雅可比矩阵的(p,q)-奇异向量

(Singular Vectors).

基于梯度.为了降低计算成本,Goodfellow 等人[32]提出了快速梯度符号法 FGSM,这种方法假设在数据点附

近决策边界是线性的,因此沿着梯度的反方向添加扰动即可拉大对抗样例与原始样本的距离.这种方法虽然能

快速的生成对抗样例,但在实际情况中,由于线性假设往往不成立,这种方法无法很好的拟合模型;此外,FGSM

是一种单步(One-step)攻击方法,因此攻击成功率较低.为了进一步提升 FGSM 的攻击效果,Kurakin 等人[39]

提出了基本迭代方法 I-FGSM(或 BIM),使用贪婪法在每次迭代中将对抗样本沿梯度方向移动.然而,迭代方

法生成的对抗样本很容易过拟合到局部极值点,因此迁移性没有单步攻击生成的对抗样例强[40].为了解决这个

问题,Dong 等人[41]提出了基于梯度的动量迭代攻击方法 MI-FGSM,在稳定更新的方向时又能逃离局部极值点,

使得生成的对抗样本具有很高的可迁移性,进而使其具有强大的黑盒攻击能力.Xie 等人[42]在 MI-FGSM 的基础

上引入了输入转换(Input Diversity)并提出了 M-DI2-FGSM,进一步提高了对抗样本的迁移性.此外,Madry 等

人[43]发现 I-FGSM 可以通过ε范围球内的随机点开始而得到显著的改善,因此提出了一种名为 PGD 的攻击方法,

有效地提升了 I-FGSM 的攻击效果.Zheng 等人[44]将 PGD 推广至数据分布空间,使学 d 习得到的对抗样例分布

能最大程度地增加模型的泛化风险.Papernot 等人[45]提出了基于雅可比矩阵的 JSMA 方法,其主要思想是通过

添加稀疏噪音的方式来构造对抗样例.这种方法则是允许添加大的扰动,但是要求被扰动的像素点要尽可能的

少.

基于分类超平面.尽管 FGSM 等基于梯度的对抗样例攻击方法能快速地生成是原分类器产生误分类的对

抗 样 本, 但 这 类 攻 击 方 法 存 在 一 个 共 性 问 题, 即 无 法 控 制 达 到 攻 击 目 标 的 最 优 扰 动 规 模. 为 解 决 这 一 问

题,Moosavi-Dezfooli 等人[46]提出 Deepfool 算法,目的是寻找可以使分类器产生误判的最小扰动.在此基础

上,Moosavi-Dezfooli 等人[47]还提出了一种通用的、不依赖于某一特定样本的对抗扰动(Universal Adversarial

Perturbation,UAP)生成方法,能使所有被添加该扰动的所有图片都会被误分类为其他类别.相比于基于梯度信

息的对抗样本生成方法,基于分类超平面的方法所生成的扰动具有更强的泛化能力和更强的黑盒攻击能力.

基于生成模型.Baluja 等人[48]提出对抗性转换网络(Adversarial Transformation Network,ATN),它能够将

任何输入样本转换为使目标网络产生错误分类的对抗样例,同时对原始输入和目标网络输出的干扰最小.Song

等人[49]提出基于条件生成模型(Conditional Generative Models)的对抗样例生成方法,其主要思想是首先通过

�

纪守领 等:机器学习模型安全与隐私

7

训练辅助分类器生成对抗网络(AC-GAN)以对数据样本的条件分布进行建模

器的潜在空间上搜索被目标分类器错误分类的图像.为了生成感知上更真实的对

基于 GAN(Generative Adversarial Network)的对抗样例生成方法

别器用于确保生成的对抗样例是真实的.特别地,生成网络一旦训练完毕

不再需要查询目标模型.

以对数据样本的条件分布进行建模,然后以目标类别为条件,在生成

为了生成感知上更真实的对抗样本,Xiao 等人[50]提出一种

的对抗样例生成方法 AdvGAN,其中生成器用于产生对抗扰动,鉴

生成网络一旦训练完毕,就可以有效地为任何样本生成扰动而

对抗补丁.Brown 等人[51]放宽了“扰动必须是人眼不可察觉的

扰动必须是人眼不可察觉的”这一限制,提出“对抗补丁(Adversarial

使其加到任何图片上都可以让原图被识别为特定类别.Liu 等人[52]提出 PS-GAN,将 GAN 和

以训练一种更不易被发现但又拥有强攻击力的补丁.Thys[54]等人针

Patch)”生成算法,使其加到任何图片上都可以让原图被识别为特定类别

Grad-CAM[53]结合到对抗补丁的训练中去,以训练一种更不易被发现但又拥有强攻击力的补丁

对目标检测系统提出了一种对抗补丁生成算法,并且这种对抗补丁能够在

并且这种对抗补丁能够在真实世界中拥有物理攻击效果.

其他.Xiao 等人[55]首次提出了通过空域变换来生成对抗样本

首次提出了通过空域变换来生成对抗样本,即通过改变原始样本中像素点的位置来生成

方法在传统的对抗样本生成评价指标中和原图像会有较大的 Lp 距离,但是从人的视觉感官上

且更不容易被现有对抗攻击防御方法检测出来.从这项研究中我们可以得出一个新的结

似性度量不符合人的视觉感受机制.Su 等人[56]提出单像素攻

对抗样例.虽然该方法在传统的对抗样本生成评价指标中和原图像会有较大的

这种变换方式更真实,且更不容易被现有对抗攻击防御方法检测出来

论,即利用 L2 距离作为原始图像与对抗样例的相似性度量不符合人的视觉感受机制

击,即通过只改变一个像素点的值来使模型分类出错.

.

Fig.3 Different random poses of a 3D-

图 3 模型对 EOT 生成的 3D 打印乌龟的不同随机姿势进行分类

-printed turtle perturbed by EOT are classified

打印乌龟的不同随机姿势进行分类[57]

物理世界的实际攻击.大部分上述对抗样本在现实世界的危害有限

大部分上述对抗样本在现实世界的危害有限,因为数据会受变焦、相机噪声、角度

首次研究了物理世界的实际攻击方法,并讨论了通过摄像头实际拍摄给

对物理环境下的对抗攻击进行了更加深入的研究,探讨了 2D、3D 和物理

和有效性问题,并首次制作了能在各个角度下欺骗分类模型的真

提 出 一 种 通 用 的 对 抗 样 本 生 成 方 法 —— 变 换 期 望 算 法 ( Expectation Over

通过在优化过程中对不同干扰进行建模,使得该方法生成的对抗样本在模糊、旋转、缩

等人[58]提出了一种通用的攻击算法 RP2(Robust Physical

和距离等其他的影响.Kurakin 等人[39]首次研究了物理世界的实际攻击方法

对抗样本带来的影响.Athaly 等人[57]对物理环境下的对抗

世界 3D 这三种环境下的对抗样本的生成方法和有效性问题

实 3D 物 体 . 该 研 究 提 出 一 种 通 用 的 对 抗 样 本 生 成 方 法

Transformation,EOT),通过在优化过程中对不同干扰进行建模

放、光照等变换下都表现出很强的鲁棒性.Eykholt 等人

Perturbations),其能够在不同的物理条件下产生鲁棒的对抗扰动

其能够在不同的物理条件下产生鲁棒的对抗扰动.

3.2.1.2 黑盒攻击

由于在模型的实际部署应用中,我们通常无法获取模型的架构

我们通常无法获取模型的架构、参数等信息,只能操纵模型的输入和输出,

黑盒攻击更具有普遍性和现实意义.根据攻击时采用的策略的不同,现有的黑盒攻击方法主

因此在这种场景中,黑盒攻击更具有普遍性和现实意义

要分为基于迁移性的方法[59-63]、基于梯度估计的方法

基于梯度估计的方法[64-67]、基于决策的攻击方法[68]和基于采样的方法[69].

基于迁移性的方法.相关研究表明对抗样本具有迁移性

相关研究表明对抗样本具有迁移性(Transferability)[59],即针对目标模型生成的对抗

以不同训练集训练得到的模型出错.因此在黑盒场景下,攻击者可以在

样本同样有可能让其他具有不同结构、以不同训练集训练得到的模型出错

与黑盒目标模型相同或具有类似分布的数据集上训练自己的模型,然而针对自己训练的模型生成的对抗样本

与黑盒目标模型相同或具有类似分布的数据集上训练自己的模型

�

8

Journal of Software 软件学报

并利用其迁移性欺骗黑盒的目标模型.在攻击者无法获取训练数据的情况下,攻击者可以基于模型蒸馏的思想

利用目标模型对自己合成的数据打标签,并用合成数据来训练替代模型以近似目标黑盒模型,然后利用白盒攻

击方法针对替代模型生成对抗样本,并利用生成的对抗样例对目标模型进行黑盒迁移攻击[61].然而,这种方法虽

被证明适用于类内差异性较低的数据集(例如 MNIST),但尚未有研究证明它可以扩展到 CIFAR 或 ImageNet

等更复杂的数据集.随后,Papernot 等人[60]利用蓄水池算法(Reservoir Sampling)提高了替代模型的训练效

率,Ilyas 等人[62]针对查询次数有限、仅给出 top-k 类别概率和仅给出样本类别标签等条件更严格的情况对替代

模型攻击方法进行了改进,Shi 等人[63]提出的 Curls&Whey 攻击则从多样性、迁移性、噪声大小等方面进一步

优化了基于替代模型的攻击方法.

基于梯度估计的方法.Chen 等人[64]提出基于零阶优化的有限差分算法 ZOO 来直接估计目标深度学习模

型的梯度以生成对抗样例.实验结果表明 ZOO 攻击算法显著优于基于替代模型的黑盒攻击算法,并且与白盒算

法 C&W 攻击效果相当.然而,这种方法需要较多的查询次数且依赖于模型的预测值(例如类别概率或置信度),

因此无法应用于模型查询次数有限或模型仅给出类别标签的情况.针对模型查询次数有限的情况,Bhagoji 等人

[65]利用随机特征分组(Random Feature Grouping)和主成分分析(PCA)算法减少生成对抗样例所需的查询

模型的次数,Ilyas 等人[66]将梯度先验(Gradient Priors)与老虎机优化(Bandit Optimization)算法结合来克服

这一局限.Tu 等人[67]提出 AutoZOOM 框架,主要包括两个模块:1)为了平衡模型查询次数和失真度的自适应

随机梯度估计策略,和 2)用于提升攻击效率的用未标记数据离线训练的自编码器(Autoencoder)或双线性调

整操作,该框架应用于 ZOO 攻击算法时可在维持攻击效果不变的情况下大大减少所需模型查询次数.

基于决策的攻击方法.在真实世界的机器学习相关应用中,攻击者很少能够获得模型的预测值.针对目标

模型仅给出类别标签的情况,Brendel 等人[68]提出边界攻击(Boundary Attack)算法,其主要思想是将初始化的

图像或噪声逐渐向原始样本靠近直到找到决策边界,并在决策边界上找到与原始样本最近的对抗样本.与基于

迁移性的攻击相比,它们需要的模型信息更少、实现简单、实用性更强,但是需要巨大的查询次数.在梯度掩蔽、

内部随机性或对抗训练等防御方法存在的情况下,这种基于决策的攻击比其他类型的黑盒攻击更难以防御.

基于采样的方法.在 Ilyas 等人[66]提出的攻击方法中,为了使投影梯度法有效,梯度必须对梯度信息进行相

对 准 确地 估 计.然 而,由 于 部 分 神 经网 络 的 预 测 函数 是 不 平 滑 的,因 此用 自 然 进 化 策略 (Natural Evolution

Strategy, NES)进行梯度估计不够可靠.为了解决这一缺陷,Li 等人[69]使用有约束的 NES 公式作为目标函数,

并以正常输入样本为中心的ℓ�−����上定义的概率密度分布来平滑损失函数.如果能够找到一个损失很小的

分布,那么从该分布中采样的样本很可能就是对抗样例.该方法不再依赖于梯度估计,因此它不会受到深度神经

网络非平滑性的阻碍.

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc