YOLOV3:进一步的提升

Joseph Redmon, Ali Farhadi

University of Washington

摘要

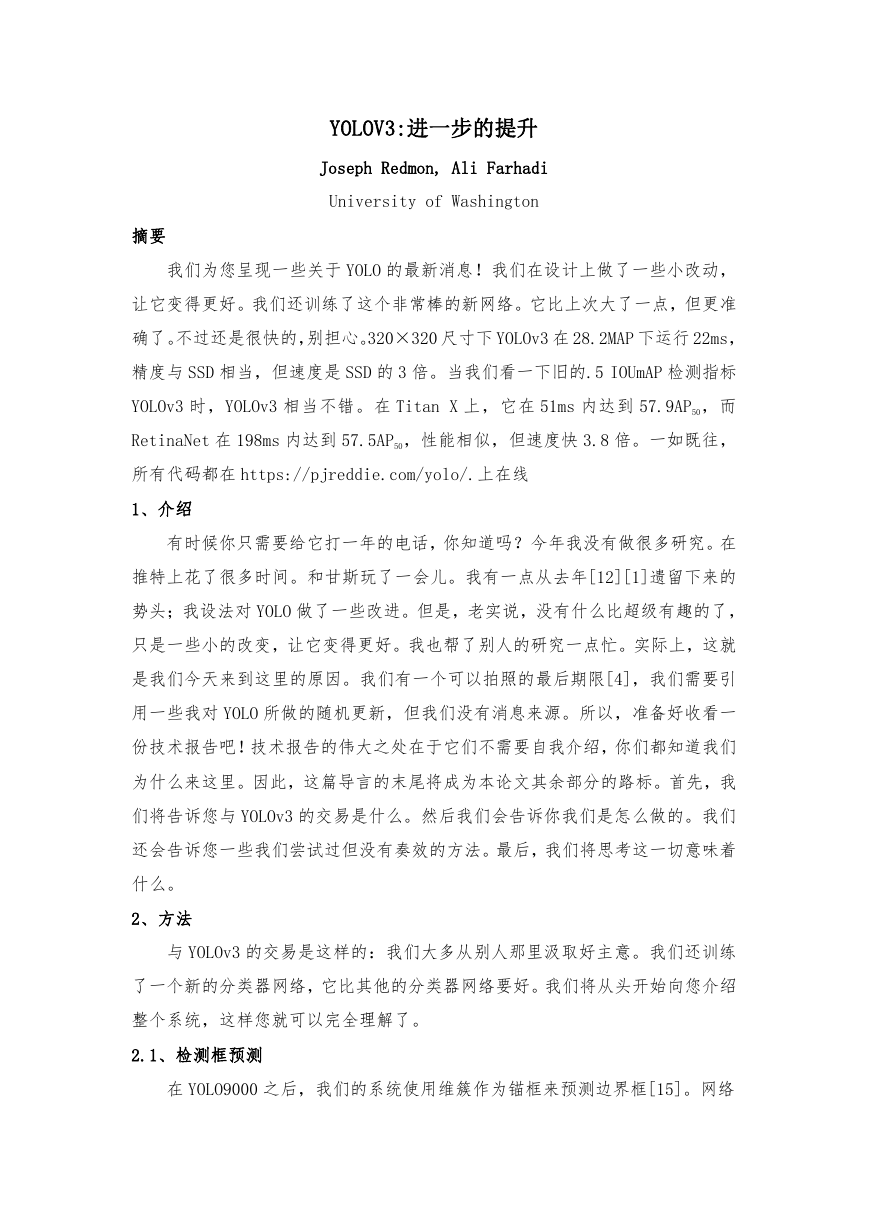

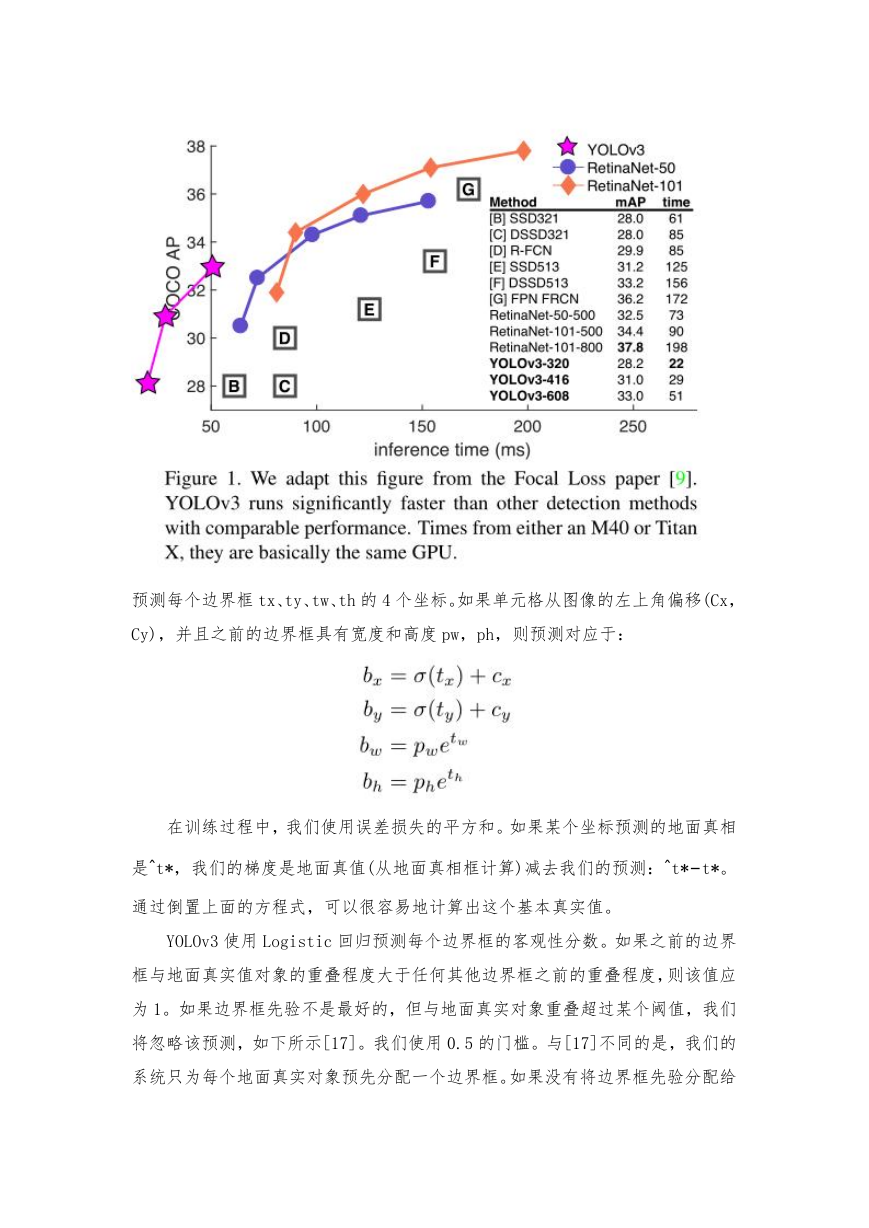

我们为您呈现一些关于 YOLO 的最新消息!我们在设计上做了一些小改动,

让它变得更好。我们还训练了这个非常棒的新网络。它比上次大了一点,但更准

确了。不过还是很快的,别担心。320×320 尺寸下 YOLOv3 在 28.2MAP 下运行 22ms,

精度与 SSD 相当,但速度是 SSD 的 3 倍。当我们看一下旧的.5 IOUmAP 检测指标

YOLOv3 时,YOLOv3 相当不错。在 Titan X 上,它在 51ms 内达到 57.9AP50,而

RetinaNet 在 198ms 内达到 57.5AP50,性能相似,但速度快 3.8 倍。一如既往,

所有代码都在 https://pjreddie.com/yolo/.上在线

1、介绍

有时候你只需要给它打一年的电话,你知道吗?今年我没有做很多研究。在

推特上花了很多时间。和甘斯玩了一会儿。我有一点从去年[12][1]遗留下来的

势头;我设法对 YOLO 做了一些改进。但是,老实说,没有什么比超级有趣的了,

只是一些小的改变,让它变得更好。我也帮了别人的研究一点忙。实际上,这就

是我们今天来到这里的原因。我们有一个可以拍照的最后期限[4],我们需要引

用一些我对 YOLO 所做的随机更新,但我们没有消息来源。所以,准备好收看一

份技术报告吧!技术报告的伟大之处在于它们不需要自我介绍,你们都知道我们

为什么来这里。因此,这篇导言的末尾将成为本论文其余部分的路标。首先,我

们将告诉您与 YOLOv3 的交易是什么。然后我们会告诉你我们是怎么做的。我们

还会告诉您一些我们尝试过但没有奏效的方法。最后,我们将思考这一切意味着

什么。

2、方法

与 YOLOv3 的交易是这样的:我们大多从别人那里汲取好主意。我们还训练

了一个新的分类器网络,它比其他的分类器网络要好。我们将从头开始向您介绍

整个系统,这样您就可以完全理解了。

2.1、检测框预测

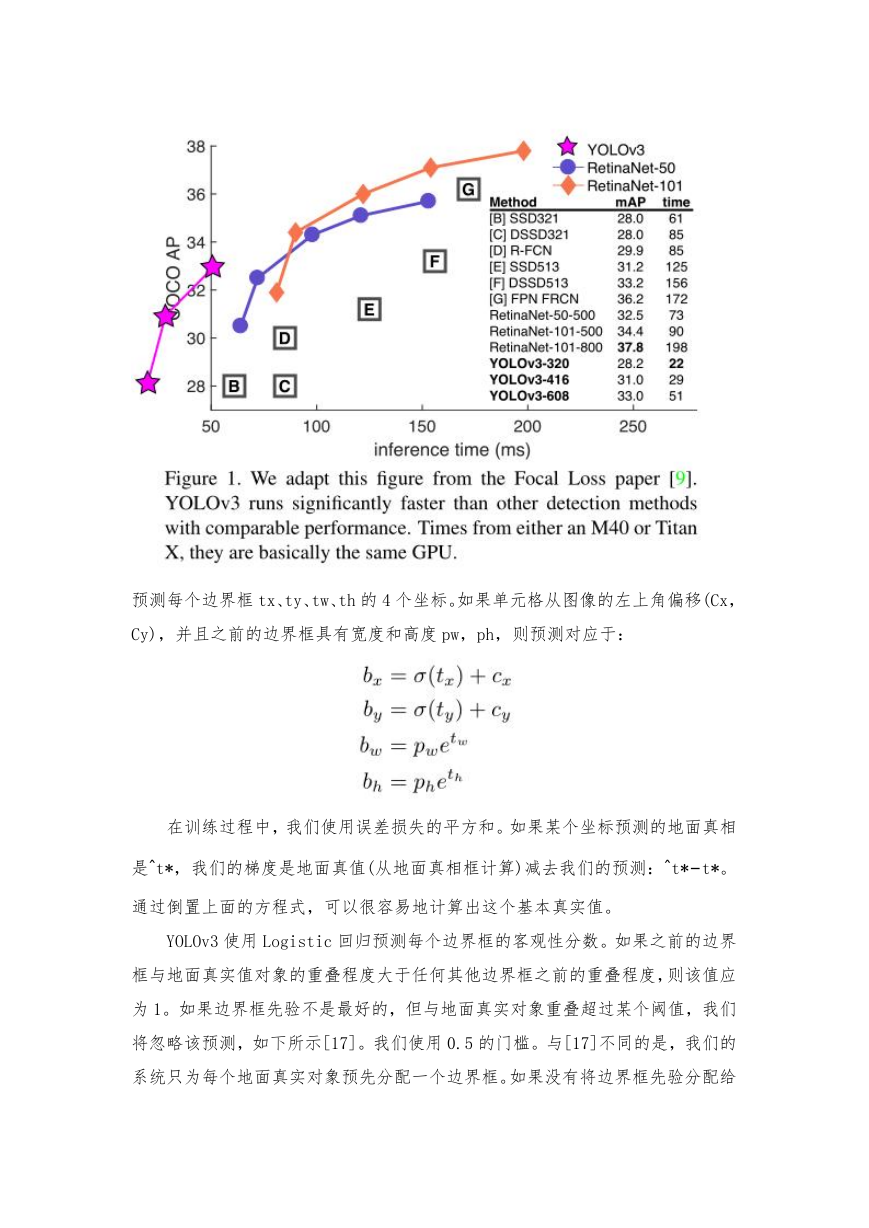

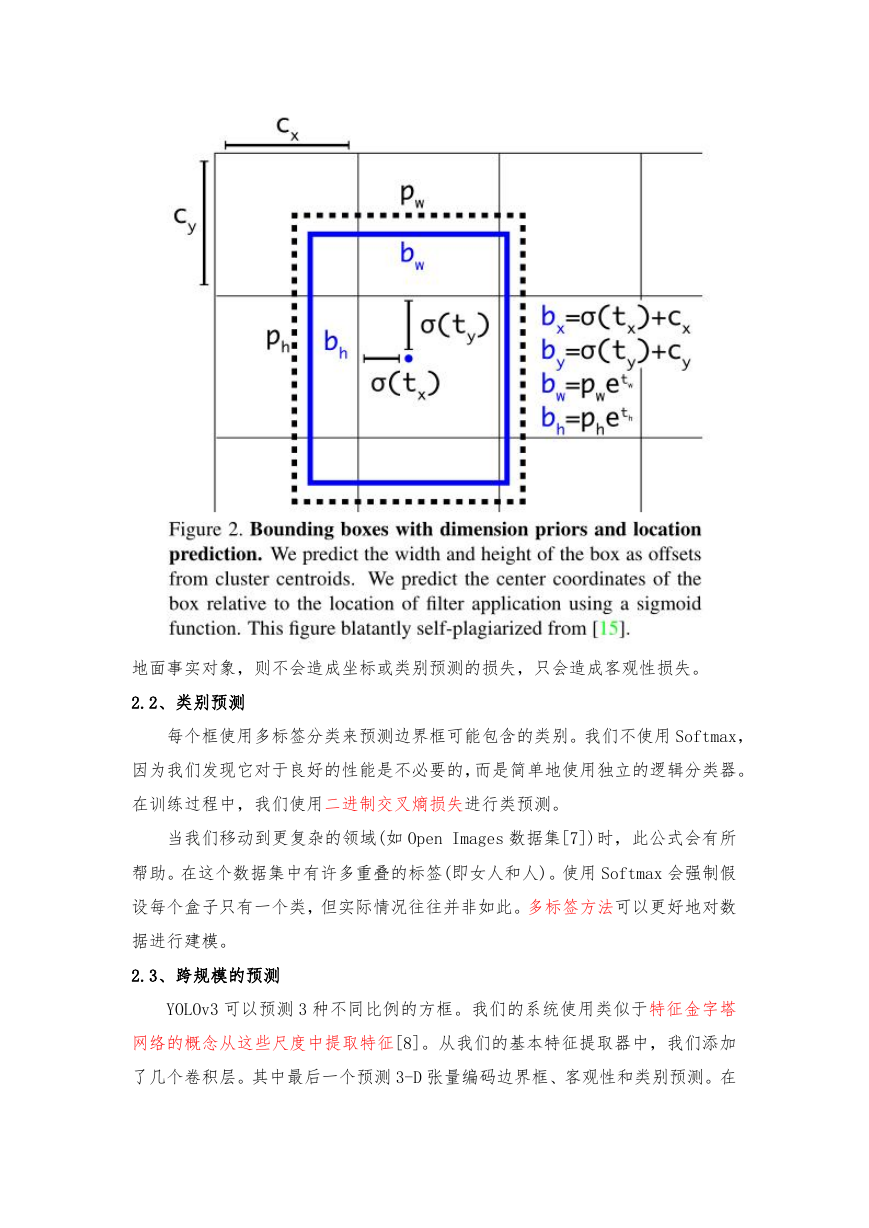

在 YOLO9000 之后,我们的系统使用维簇作为锚框来预测边界框[15]。网络

�

预测每个边界框 tx、ty、tw、th 的 4 个坐标。如果单元格从图像的左上角偏移(Cx,

Cy),并且之前的边界框具有宽度和高度 pw,ph,则预测对应于:

在训练过程中,我们使用误差损失的平方和。如果某个坐标预测的地面真相

是ˆt*,我们的梯度是地面真值(从地面真相框计算)减去我们的预测:ˆt*−t*。

通过倒置上面的方程式,可以很容易地计算出这个基本真实值。

YOLOv3 使用 Logistic 回归预测每个边界框的客观性分数。如果之前的边界

框与地面真实值对象的重叠程度大于任何其他边界框之前的重叠程度,则该值应

为 1。如果边界框先验不是最好的,但与地面真实对象重叠超过某个阈值,我们

将忽略该预测,如下所示[17]。我们使用 0.5 的门槛。与[17]不同的是,我们的

系统只为每个地面真实对象预先分配一个边界框。如果没有将边界框先验分配给

�

地面事实对象,则不会造成坐标或类别预测的损失,只会造成客观性损失。

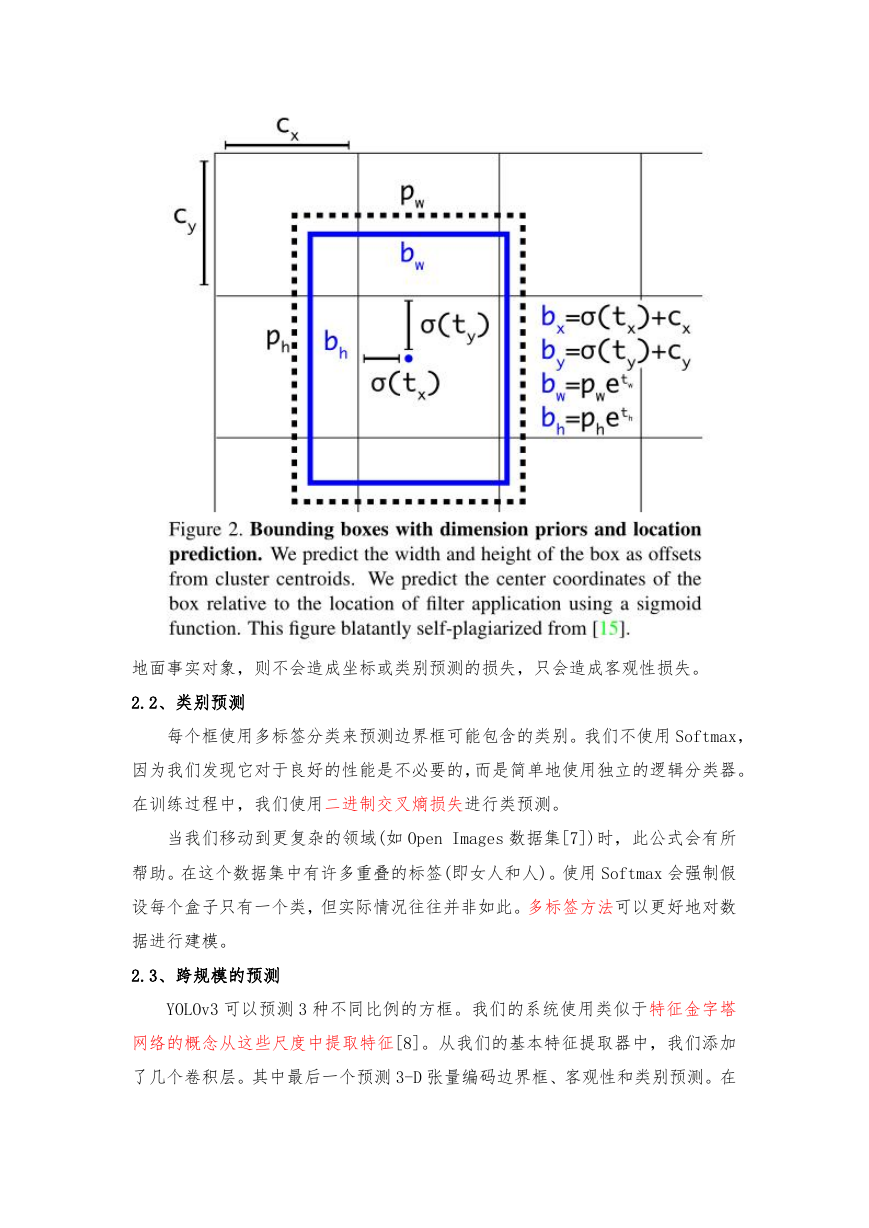

2.2、类别预测

每个框使用多标签分类来预测边界框可能包含的类别。我们不使用 Softmax,

因为我们发现它对于良好的性能是不必要的,而是简单地使用独立的逻辑分类器。

在训练过程中,我们使用二进制交叉熵损失进行类预测。

当我们移动到更复杂的领域(如 Open Images 数据集[7])时,此公式会有所

帮助。在这个数据集中有许多重叠的标签(即女人和人)。使用 Softmax 会强制假

设每个盒子只有一个类,但实际情况往往并非如此。多标签方法可以更好地对数

据进行建模。

2.3、跨规模的预测

YOLOv3 可以预测 3 种不同比例的方框。我们的系统使用类似于特征金字塔

网络的概念从这些尺度中提取特征[8]。从我们的基本特征提取器中,我们添加

了几个卷积层。其中最后一个预测 3-D 张量编码边界框、客观性和类别预测。在

�

我们使用 COCO[10]的实验中,我们在每个尺度上预测了 3 个框,因此张量为

N×N×[3∗(4+1+80)],用于 4 个边界框偏移、1 个客观性预测和 80 个类别预测。

接下来,我们从前面的两层中提取特征地图,并对其进行 2 倍的上采样。我

们还从网络中较早的位置获取一个要素地图,并使用拼接将其与我们的上采样要

素合并。该方法使我们能够从上采样的特征中获得更有意义的语义信息,并从早

期的特征地图中获得更细粒度的信息。然后,我们再添加几个卷积层来处理这个

组合的特征图,并最终预测一个类似的张量,尽管现在大小是原来的两倍。

我们再次执行相同的设计来预测最终比例的框。因此,我们对第三尺度的预

测得益于所有先前的计算以及网络早期的细粒度特征。

我们仍然使用 k-均值聚类来确定我们的包围盒先验。我们只是随意选择了 9

个簇和 3 个尺度,然后在尺度上均匀地划分这些簇。在 COCO 数据集中,9 个聚

类分别为:(10×13)、(16×30)、(33×23)、(30×61)、(62×45)、(59×119)、

(116×90)、(156×198)、(373×326)。

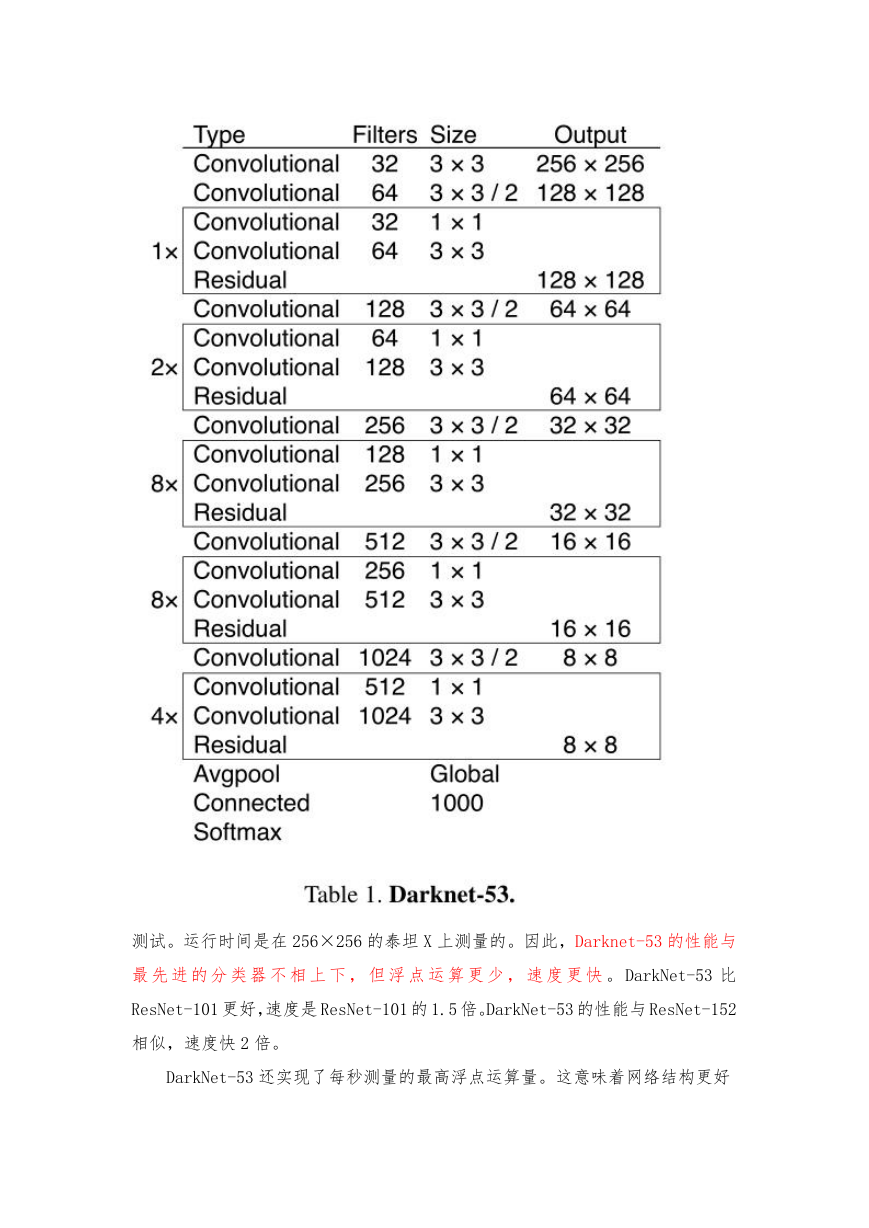

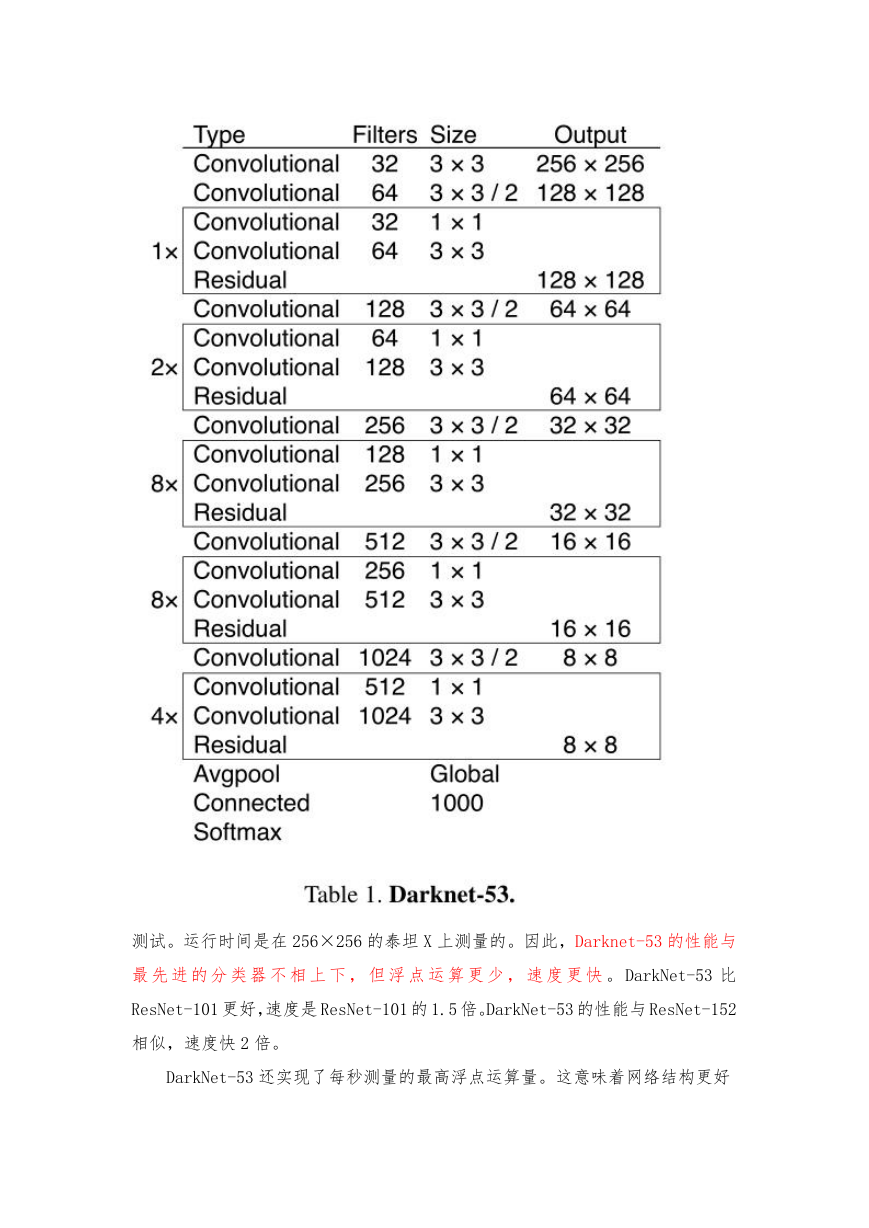

2.4、特征提取

我 们 使 用 一 种 新 的 网 络 进 行 特 征 提 取 。 我 们 的 新 网 络 是 在 YOLOv2 ,

Darknet-19 中使用的网络和新的剩余网络材料之间的混合方法。我们的网络使

用连续的 3×3 和 1×1 卷积层,但现在也有一些捷径连接,而且明显更大。它有

53 层卷积层,所以我们叫它.。等等……。Darknet-53!

这个新网络比 Darknet19 强大得多,但仍然比 ResNet-101 或 ResNet-152

更有效率。以下是 ImageNet 的一些结果:

每个网络都使用相同的设置进行训练,并在 256×256、单作物精度下进行

�

测试。运行时间是在 256×256 的泰坦 X 上测量的。因此,Darknet-53 的性能与

最 先 进 的 分 类 器 不 相 上 下 , 但 浮 点 运 算 更 少 , 速 度 更 快 。 DarkNet-53 比

ResNet-101 更好,速度是 ResNet-101 的 1.5 倍。DarkNet-53 的性能与 ResNet-152

相似,速度快 2 倍。

DarkNet-53 还实现了每秒测量的最高浮点运算量。这意味着网络结构更好

�

地利用了 GPU,使其评估效率更高,因此速度更快。这在很大程度上是因为 ResNet

的层数太多,效率不是很高

2.5、训练

我们仍然在完整的图像上进行训练,没有硬的负面挖掘或任何类似的东西。

我们使用多尺度训练,大量数据扩充,批量归一化,所有标准的东西。我们使用

Darknet 神经网络框架进行训练和测试[14]。

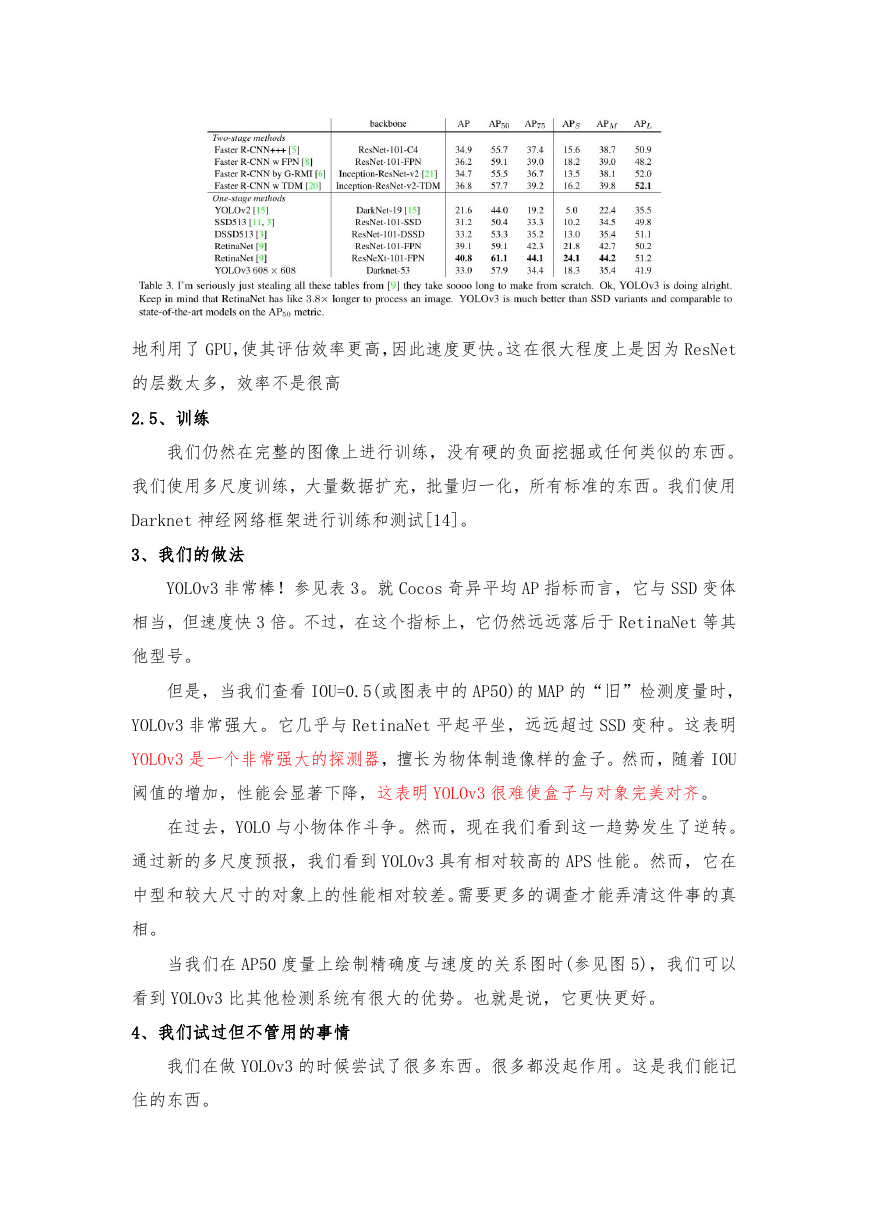

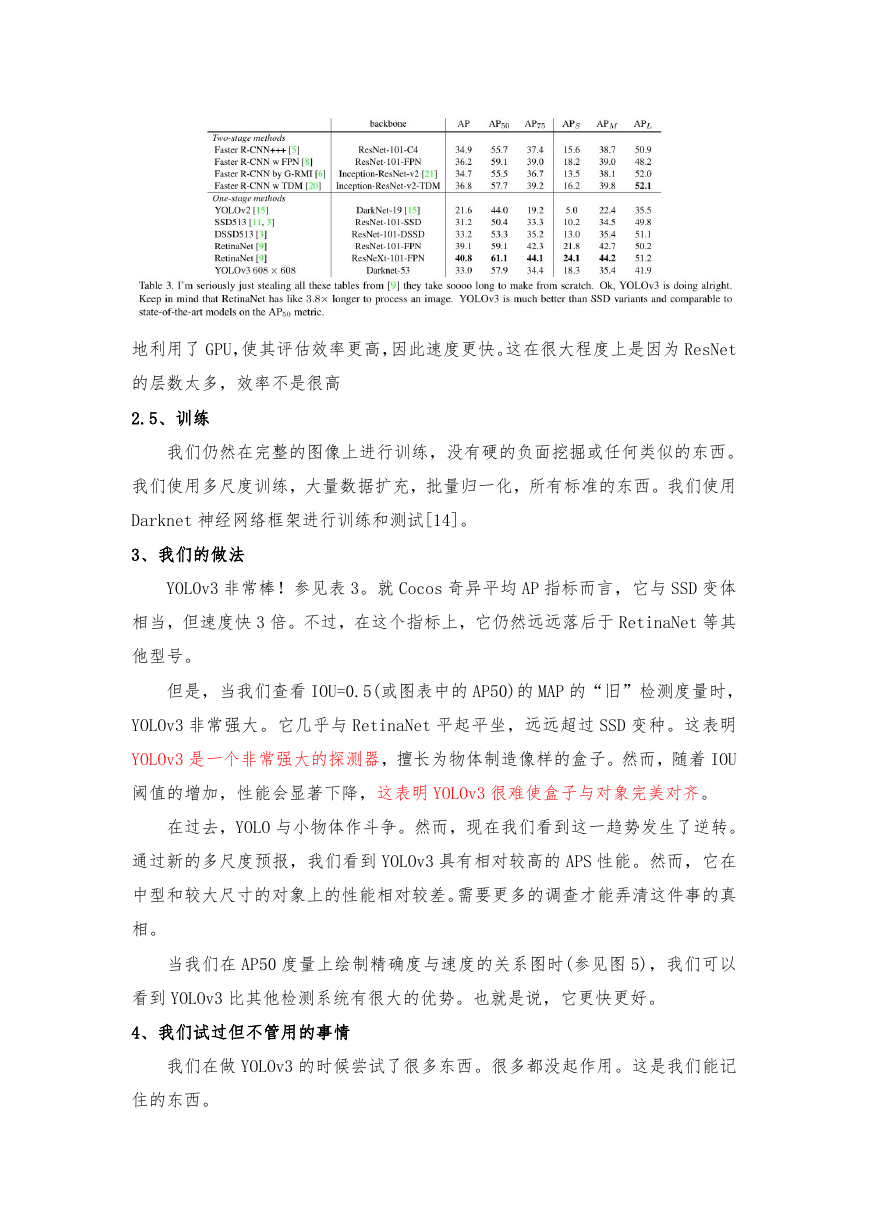

3、我们的做法

YOLOv3 非常棒!参见表 3。就 Cocos 奇异平均 AP 指标而言,它与 SSD 变体

相当,但速度快 3 倍。不过,在这个指标上,它仍然远远落后于 RetinaNet 等其

他型号。

但是,当我们查看 IOU=0.5(或图表中的 AP50)的 MAP 的“旧”检测度量时,

YOLOv3 非常强大。它几乎与 RetinaNet 平起平坐,远远超过 SSD 变种。这表明

YOLOv3 是一个非常强大的探测器,擅长为物体制造像样的盒子。然而,随着 IOU

阈值的增加,性能会显著下降,这表明 YOLOv3 很难使盒子与对象完美对齐。

在过去,YOLO 与小物体作斗争。然而,现在我们看到这一趋势发生了逆转。

通过新的多尺度预报,我们看到 YOLOv3 具有相对较高的 APS 性能。然而,它在

中型和较大尺寸的对象上的性能相对较差。需要更多的调查才能弄清这件事的真

相。

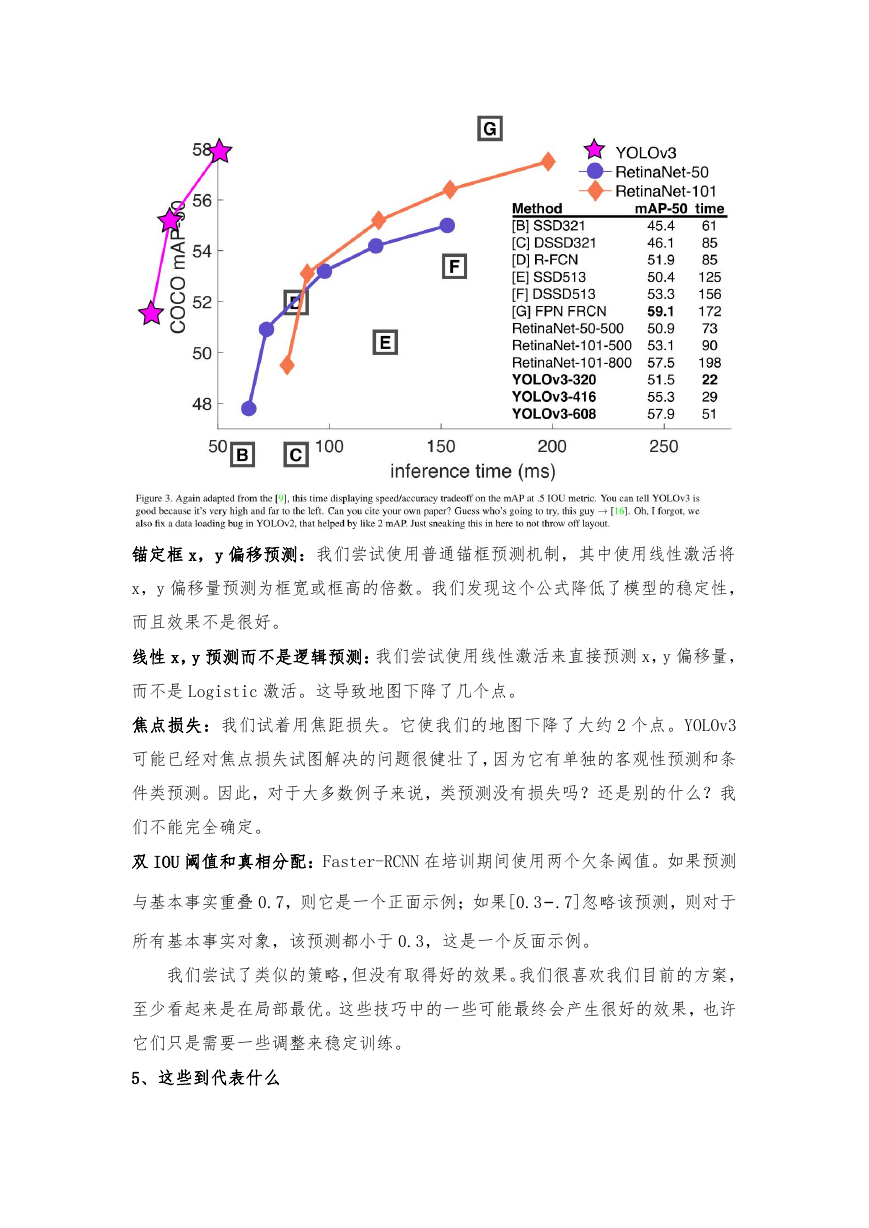

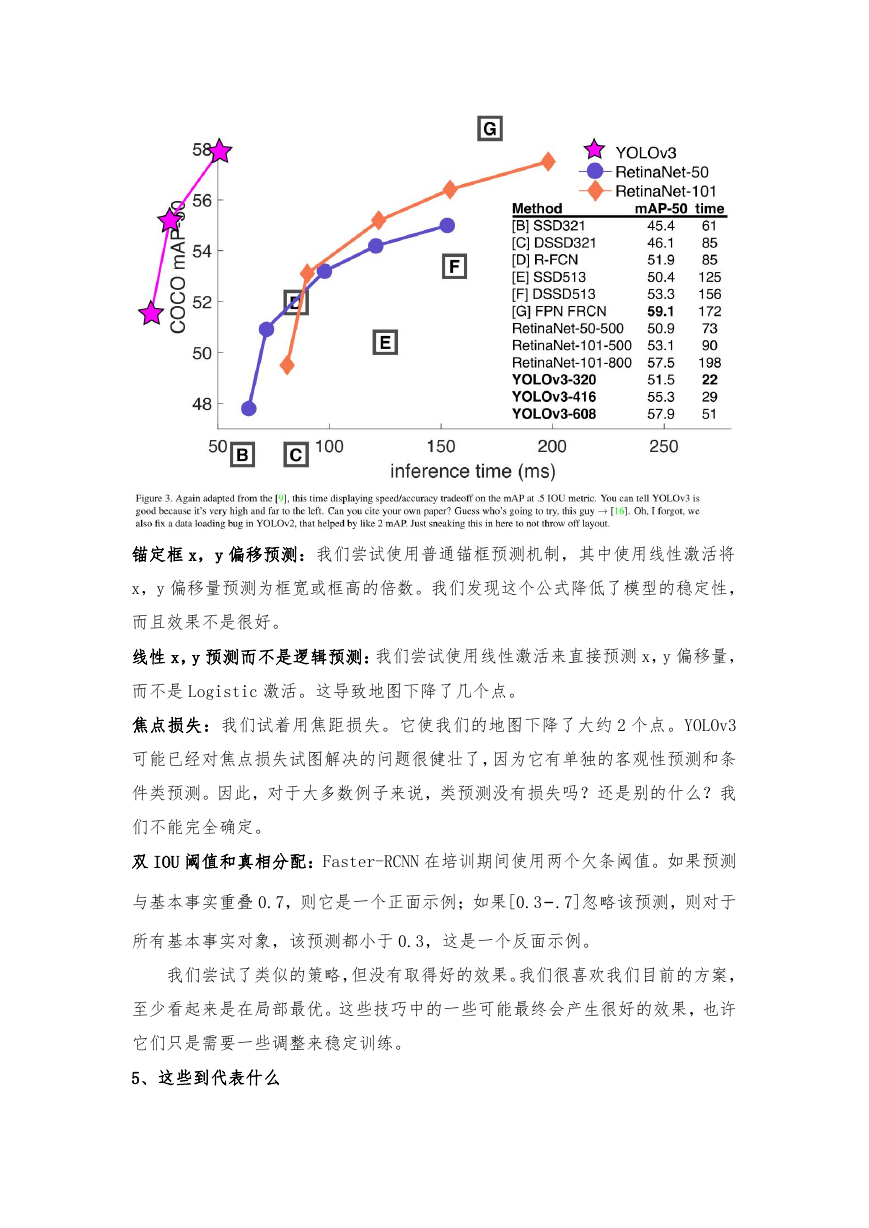

当我们在 AP50 度量上绘制精确度与速度的关系图时(参见图 5),我们可以

看到 YOLOv3 比其他检测系统有很大的优势。也就是说,它更快更好。

4、我们试过但不管用的事情

我们在做 YOLOv3 的时候尝试了很多东西。很多都没起作用。这是我们能记

住的东西。

�

锚定框 x,y 偏移预测:我们尝试使用普通锚框预测机制,其中使用线性激活将

x,y 偏移量预测为框宽或框高的倍数。我们发现这个公式降低了模型的稳定性,

而且效果不是很好。

线性 x,y 预测而不是逻辑预测:我们尝试使用线性激活来直接预测 x,y 偏移量,

而不是 Logistic 激活。这导致地图下降了几个点。

焦点损失:我们试着用焦距损失。它使我们的地图下降了大约 2 个点。YOLOv3

可能已经对焦点损失试图解决的问题很健壮了,因为它有单独的客观性预测和条

件类预测。因此,对于大多数例子来说,类预测没有损失吗?还是别的什么?我

们不能完全确定。

双 IOU 阈值和真相分配:Faster-RCNN 在培训期间使用两个欠条阈值。如果预测

与基本事实重叠 0.7,则它是一个正面示例;如果[0.3−.7]忽略该预测,则对于

所有基本事实对象,该预测都小于 0.3,这是一个反面示例。

我们尝试了类似的策略,但没有取得好的效果。我们很喜欢我们目前的方案,

至少看起来是在局部最优。这些技巧中的一些可能最终会产生很好的效果,也许

它们只是需要一些调整来稳定训练。

5、这些到代表什么

�

YOLOv3 是一个很好的探测器。它很快,很准确。这在 0.5 到 0.95 之间的可

可平均 AP 指标上并不是很好。但与 0.5IOU 的旧检测指标相比,这是非常好的。

我们为什么要交换指标呢?最初的 COCO 论文只有这样一句隐晦的话:“一

旦评估服务器完成,将添加对评估指标的全面讨论”。Russakovsky 等人报告说,

人类很难区分.3 和.5 的 IOU!“训练人类目测 IOU 为 0.3 的包围盒,并将其与

IOU 为 0.5 的包围盒区分开来,难度之大令人吃惊。”[18]如果人类很难分辨出

两者之间的区别,那又有什么关系呢?

但也许一个更好的问题是:“既然我们有了这些探测器,我们要怎么处理它

们呢?”很多做这项研究的人都在谷歌和 Facebook 工作。我想至少我们知道这

项技术掌握在很好的人手中,肯定不会被用来收集你的个人信息并将其出售

给……。等等,你是说这就是它要用来做的事??噢。

其他为视觉研究提供大量资金的人是军方,他们从来没有做过可怕的事情,

比如用新技术杀死很多人。哦,等等……

我非常希望大多数使用计算机视觉的人都在用它做一些快乐而有益的事情,

比如在国家公园里数斑马的数量[13],或者跟踪他们的猫在他们的房子里四处走

动[19]。但是,计算机视觉已经被用于可疑的用途,作为研究人员,我们有责任

至少考虑到我们的工作可能造成的危害,并考虑减轻它的方法。我们欠这个世界

很多。

最后,不要说“我”。(因为我最终退出了推特)。

参考文献:

[1] Analogy. Wikipedia, Mar 2018. 1

[2] M. Everingham, L. V an Gool, C. K. Williams, J. Winn, and A. Zisserman.

The pascal visual object classes (voc) challenge. International journal

of computer vision, 88(2):303– 338, 2010. 6

[3] C.-Y . Fu, W. Liu, A. Ranga, A. Tyagi, and A. C. Berg. Dssd:

Deconvolutional single shot detector. arXiv preprint arXiv:1701.06659,

2017. 3

[4] D. Gordon, A. Kembhavi, M. Rastegari, J. Redmon, D. Fox, and A. Farhadi.

Iqa: Visual question answering in interactive environments. arXiv

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc