中国科技论文在线

http://www.paper.edu.cn

基于深度学习模型的语音特征提取方法研

究

梁静,刘刚**

5

10

15

20

25

30

35

(北京邮电大学信息与通信工程学院,北京 100876)

摘要:随着移动互联网的发展,语音识别作为实现人机自由交互的关键技术越来越受到重

视。特别是目前已经进入大数据时代,海量语音数据的获取已经成为可能,如何有效利用

这些未经标注的原始数据成为当前语音识别领域的一个研究热点。与此同时,深度学习模

型凭借着其对海量数据所具备的强大建模能力,能够直接对这些未标注数据进行处理,与

语音识别的联系愈加紧密。本文在语音识别与深度学习理论相结合的基础上,针对如何利

用深度学习模型提取更为鲁棒的声学特征这一问题展开研究,分别采用了自动编码器和深

度神经网络两种模型通过无监督和有监督训练方法实现从原始语音特征中自动提取新特征。

基于上述 两种模型提取的新特征和原始 MFCC 相比, 在词识别正 确率方 面分别提高了

1.96%和 3.53%。

关键词:语音识别;深度神经网络;深度自动编码器;特征提取

中图分类号:TP181

Speech Feature Extraction Based on Deep Learning Models

LIANG Jing, LIU Gang

(School of Information and Telecommunication, Beijing University of Posts and

Telecommunications, Beijing 100876)

Abstract: With the rapid development of Mobile Internet, speech recognition which remains key

to human-machine interaction is attracting more and more attention. Especially in the era of big

data when access to large amount of speech data is possible, exploring ways to manipulate these

unlabeled data effectively has become the hot topic in the field of speech recognition. Meanwhile,

deep learning models find more opportunities in combination with speech recognition

technologies because of its outstanding performance in unlabeled speech corpus processing and

data modeling. This thesis is based on the combination of speech recognition and deep learning

theory, aims at extracting more robust acoustic features with application of deep models. In the

experiment, both Auto-Encoder and Deep Neural Network are constructed to extract new features

from mfcc, respectively through techniques of unsupervised and supervised feature learning.

Finally, the new features obtained from deep models mentioned above have increased the word

recognition accuracy by 1.96% and 3.53%, compared with mfcc features.

Key words: Speech Recognition; Deep Neural Network; Deep Auto-Encoder; Feature Extraction

0 引言

语音信号中包含有丰富信息,如何从中提取出有用部分对于语音识别系统的性能至关重

要。语音特征提取通过对原始信号进行分析处理,尽量去除与语音识别无关的冗余信息,保

40

留影响语音识别的关键信息。对非特定人语音识别来说,则是要求特征参数尽可能多反映其

内容信息,尽量减少说话人的个性部分。

目前主流的语音识别系统仍是采用 MFCC、PLP 等短时频谱特征作为声学特征输入,由

于模拟了人耳听觉感知机制,这些特征和 LPCC 等相比有效提高了系统的识别性能。但在信

噪比较低情况下,以 MFCC 等为声学特征的语音识别系统往往会在识别率方面产生较大下

作者简介:梁静(19890),男,工学硕士,主要研究方向:语音识别

通信联系人:刘刚(1973-),男,副教授,主要研究方向:语音信号处理. E-mail: liugang@bupt.edu.cn

- 1 -

�

中国科技论文在线

http://www.paper.edu.cn

45

降,一定程度上说明这些特征的抗噪性能欠佳;同时,MFCC 等特征本身就带有与语音内容

识别这一任务不相关的冗余信息,给识别带来负面影响。

进入 21 世纪,大数据时代的到来以及深度学习理论的兴起,为语音特征提取研究提供

了新的探索方向。与人工规则构造特征的方法相比,利用深度学习模型直接从大数据中学习

特征,更有利于描述数据本身的丰富内涵信息[1]。以多伦多大学以及微软研究院等为首的一

50

些研究机构已经开始将深度学习理论应用于语音高层特征提取和声学建模,发掘新的特征表

示方法[2,3],并取得了引人注目的成果。

本文主要从深度自动编码器(Deep Auto-Encoder, DAE)[4]以及深度神经网络(Deep

Neural Network, DNN)[5]的模型结构着手进行研究,通过与原始 MFCC 特征进行结合,分

别采取了无监督和有监督特征学习的方法,从而提取新的语音特征,最终通过实验证明基于

55

深度学习模型所提取的新特征在性能方面较之 MFCC 有明显提升。

1 相关技术

1.1 深度学习基本原理

2006 年多伦多大学的 Hinton 教授等人在《Science》杂志上发表了一篇关于深度信念网

络及其在数据降维以及特征抽取方面应用的文章[6],由此掀起了学术界和工业界对深度学习

60

理论及相关模型的研究热潮。

基于这种理论的网络模型在一定程度上模拟了人脑的信息处理机制,即外界原始输入信

息需要经过大脑的多重处理后,最终在人的意识中形成相应概念。深度学习的实质是通过构

建具有很多隐含层的网络模型,利用海量数据来训练网络,使得各个隐含层能学习到鲁棒性

更强的特征,从而提升分类或预测的准确性。简而言之,构建深度模型的终极目的是为了学

65

习更符合数据本身性质的特征分布。

1.2 深度模型训练方法

由于难以直接对深度网络进行训练,可以先采取深度信念网络(Deep Belief Network,

DBN)逐层预训练算法来初始化网络参数,然后按照反向传播算法(Back Propagation,BP)

调谐参数[7]。这种预训练算法把网络中任意相邻两层当作一个受限波尔茨曼机(Restricted

Boltzmann Machine, RBM)[8],并以下层 RBM 模型的输出作为上层 RBM 模型的输入,最

终实现逐层训练。

这里提到的 RBM 模型本质上是一种能量模型,由可见层 V 和隐含层 H 组成,可见层

和隐含层节点之间相互连接,层内节点间无连接。在 RBM 中,可见层节点 v 和隐含层节点

h 在给定模型参数 的条件下,其联合概率分布用能量函数表示为:

(1)

70

75

其中,Z 是归一化因子,满足:

对于 Bernoulli-Bernoulli RBM 模型,其能量函数定义为:

(2)

80

其中,v 代表可见层单元的状态矢量,h 表示隐含层单元的状态矢量, 表示可见层第

(3)

- 2 -

(,;)exp((,;))/pvhEvhZexp(-(,;)))vhZEvh1111(,;)= --VHVHijijiijjijijEvhwvhavhbiv�

中国科技论文在线

http://www.paper.edu.cn

i 个节点的状态, 表示隐含层第 j 个节点的状态, 为可见层节点 i 和隐层节点 j 的连接

权重, 和 分别代表两个节点的偏置量,V 和 H 是可见层和隐含层节点的个数。

85

给定可见层节点状态矢量 v 及模型参数 ,隐含层节点 j 的激活概率为:

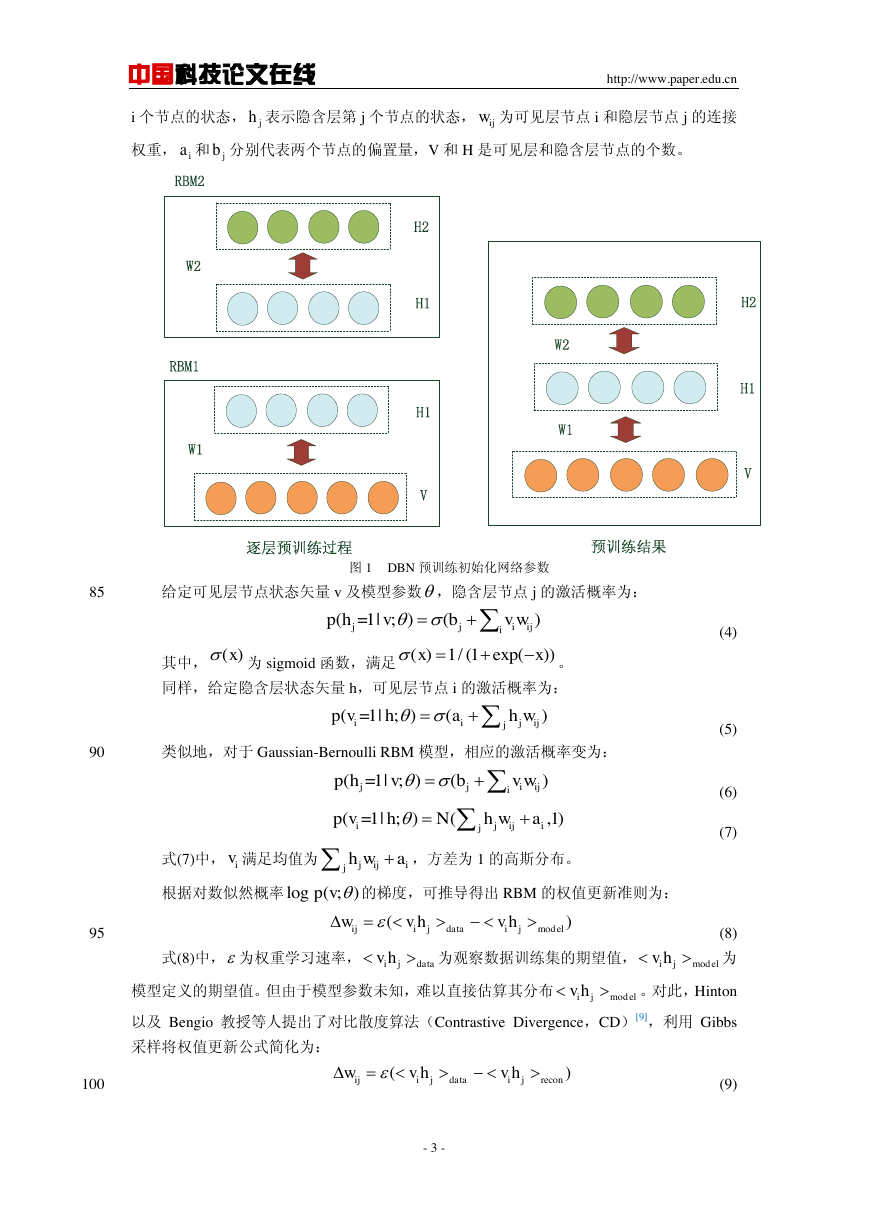

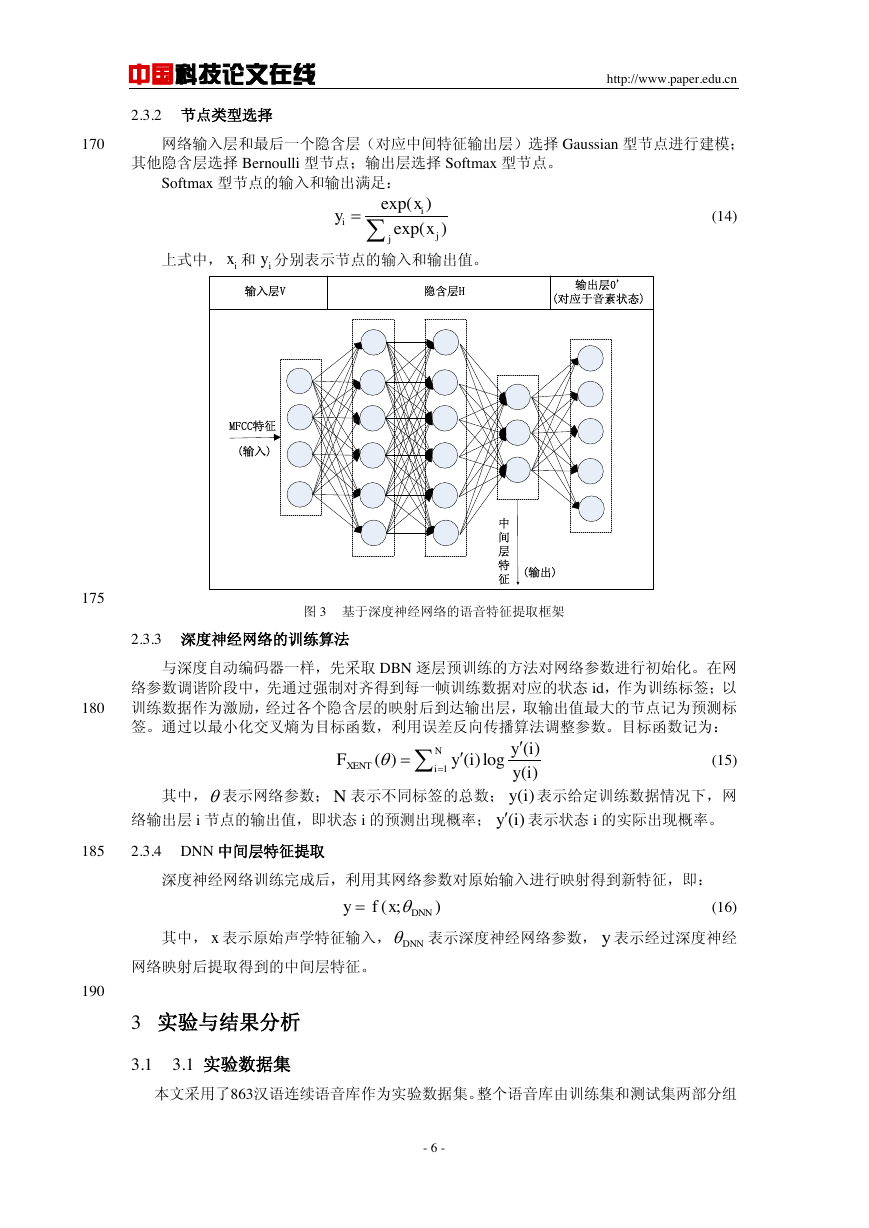

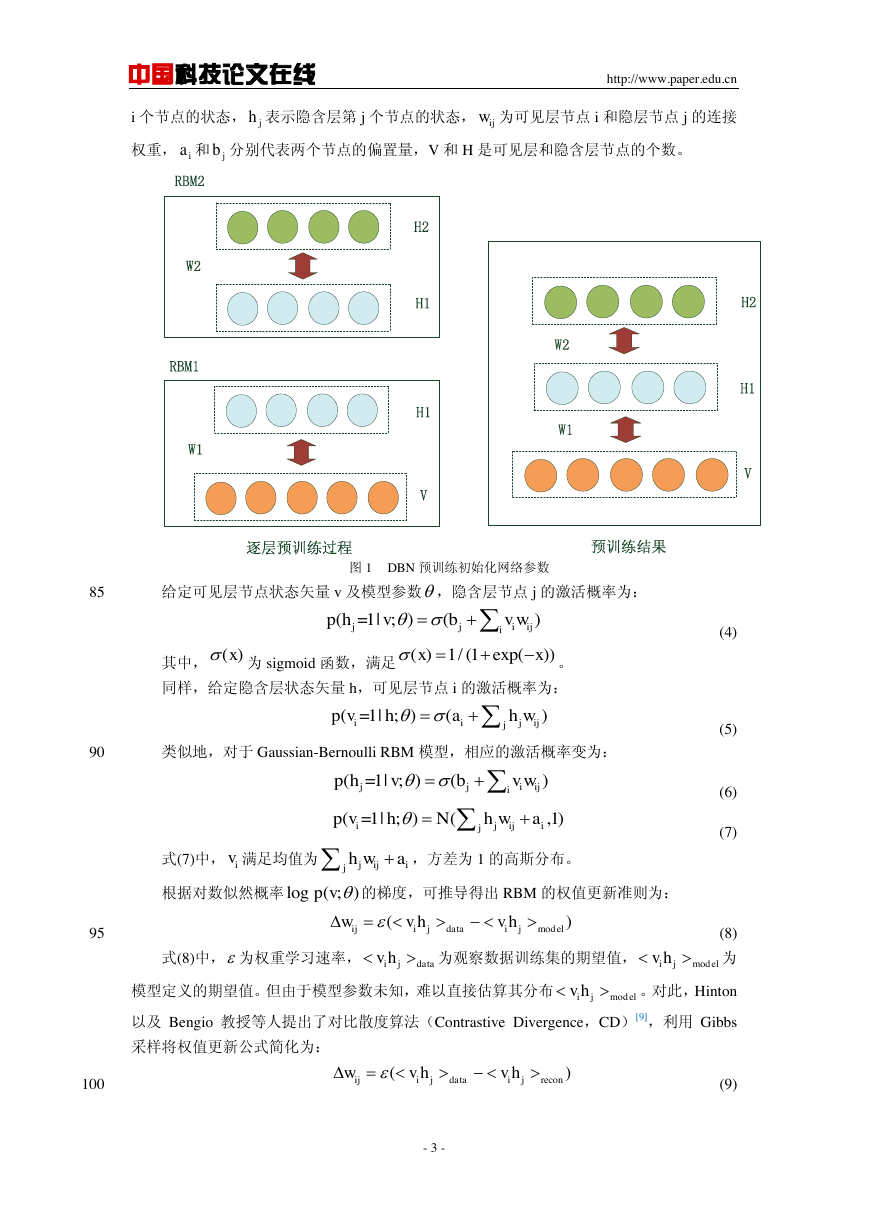

图 1 DBN 预训练初始化网络参数

其中,

为 sigmoid 函数,满足

。

同样,给定隐含层状态矢量 h,可见层节点 i 的激活概率为:

(4)

90

类似地,对于 Gaussian-Bernoulli RBM 模型,相应的激活概率变为:

(5)

(6)

(7)

式(7)中, 满足均值为

,方差为 1 的高斯分布。

根据对数似然概率

的梯度,可推导得出 RBM 的权值更新准则为:

95

100

式(8)中, 为权重学习速率,

为观察数据训练集的期望值,

为

模型定义的期望值。但由于模型参数未知,难以直接估算其分布

。对此,Hinton

以及 Bengio 教授等人提出了对比散度算法(Contrastive Divergence,CD)[9],利用 Gibbs

采样将权值更新公式简化为:

(8)

(9)

- 3 -

jhijwiajbRBM1RBM2W1W2W2W1逐层预训练过程预训练结果VH1H2VH1H1H2(=1|;)()jjiijiphvbvw()x()1/(1exp())xx(=1|;)()iijijjpvhahw(=1|;)()jjiijiphvbvw(=1|;)(,1)ijijijpvhNhwaivjijijhwalog(;)pvmodel()ijijdataijwvhvhijdatavhmodelijvhmodelijvhre()ijijdataijconwvhvh�

中国科技论文在线

http://www.paper.edu.cn

其中,

表示反向重构过程中可见层和隐含层的期望值。

通过数据集的多次迭代训练,RBM 达到稳态,此时即训练得到模型的初始参数 W。以

图 1 为例,采用 DBN 预训练方法对一个由可见层 V 和两个隐含层 H1 和 H2 组成的深度网

络初始化参数。具体步骤如下:先训练由可见层 V 和隐含层 H1 构成的最底层 RBM 模型,

105

记为 RBM1;训练完成后,将 RBM1 的隐含层输出 H1 作为下一个 RBM 模型的可见层输入,

继续训练由隐含层 H1 和 H2 构成的 RBM2 模型。最终把 RBM1 和 RBM2 模型层叠起来,

构成所需的深度模型。

2 基于深度学习模型的语音特征提取

2.1 深度网络的原始输入

110

由于语音信号具有短时平稳性质[10],在短时间内(10~30ms)其声学特性保持相对稳定,

因而目前绝大多数语音识别系统都采用了短时频谱特征如 MFCC、PLP 等作为声学特征。但

由于语音形成过程中往往伴随着“协同发音”现象,即当前语音会受到临近音的影响,考虑深

度模型具备强大的数据建模能力,能够挖掘这种丰富语言现象的内涵信息,因而可以考虑将

相邻的连续多帧短时特征拼接起来得到长时特征,构成网络的原始输入。

115

2.2 基于深度自动编码器模型的无监督特征提取方法

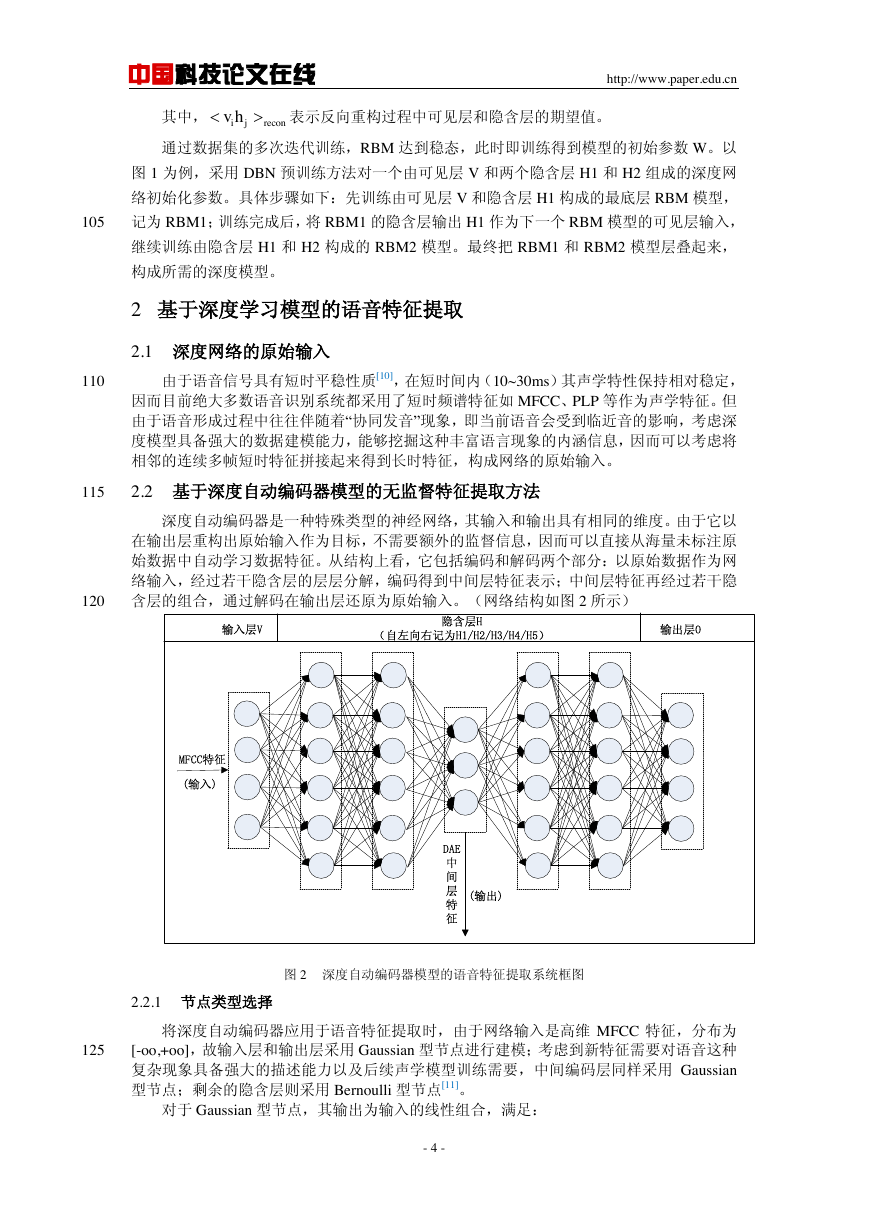

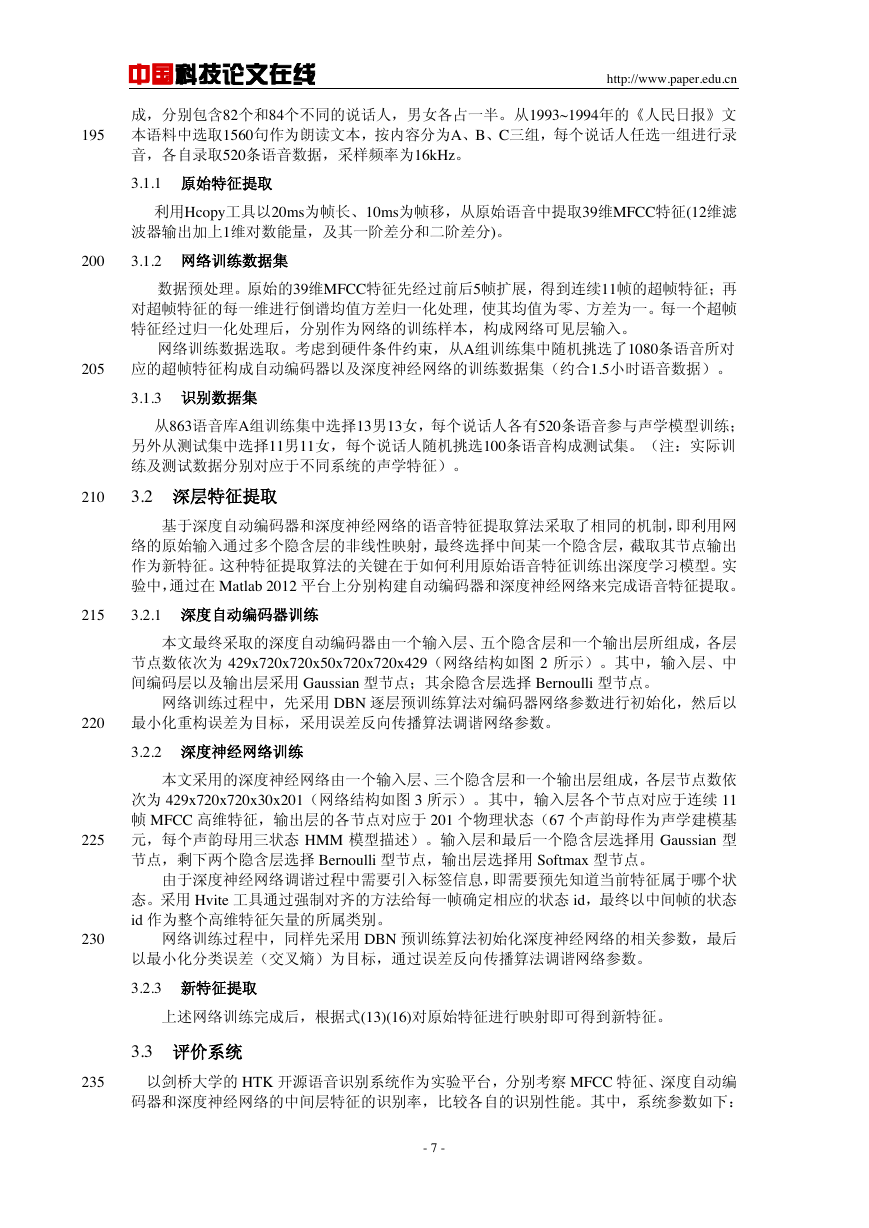

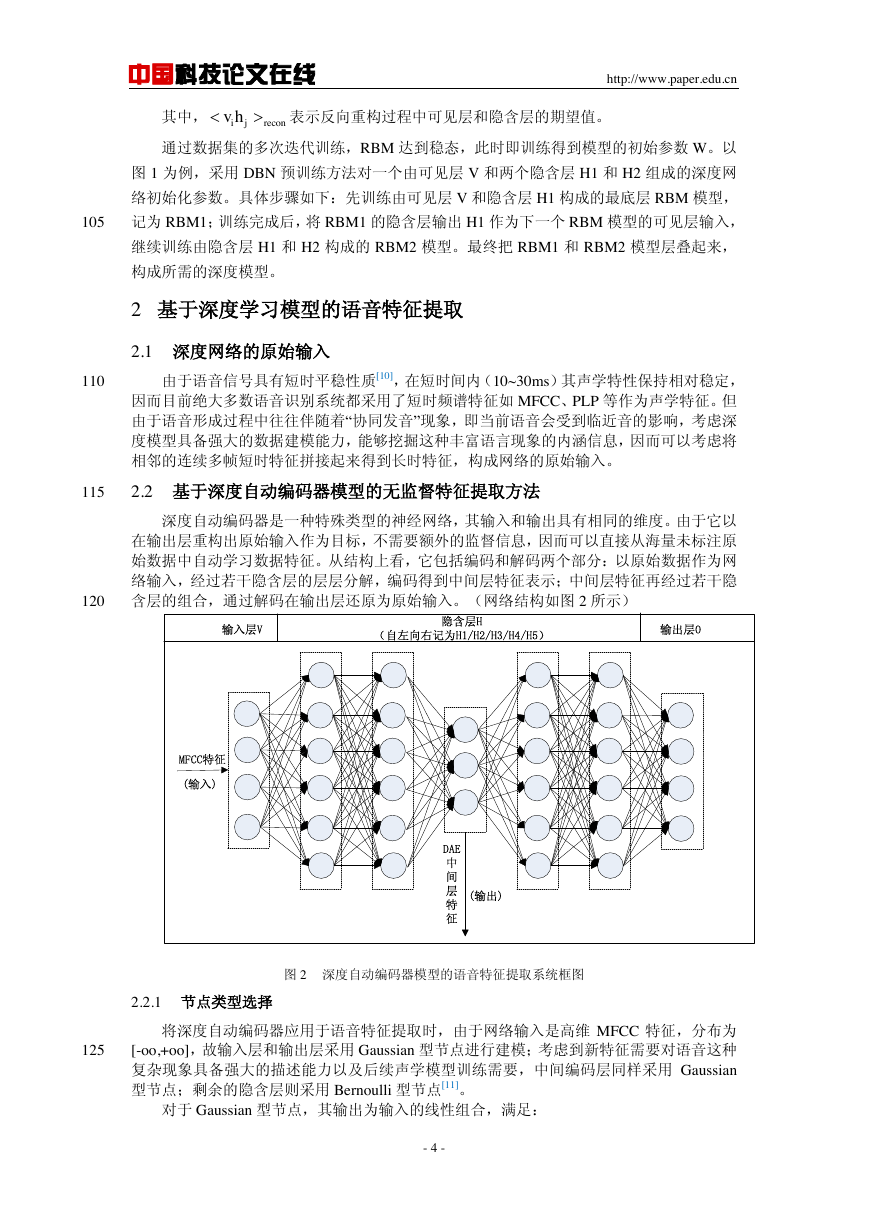

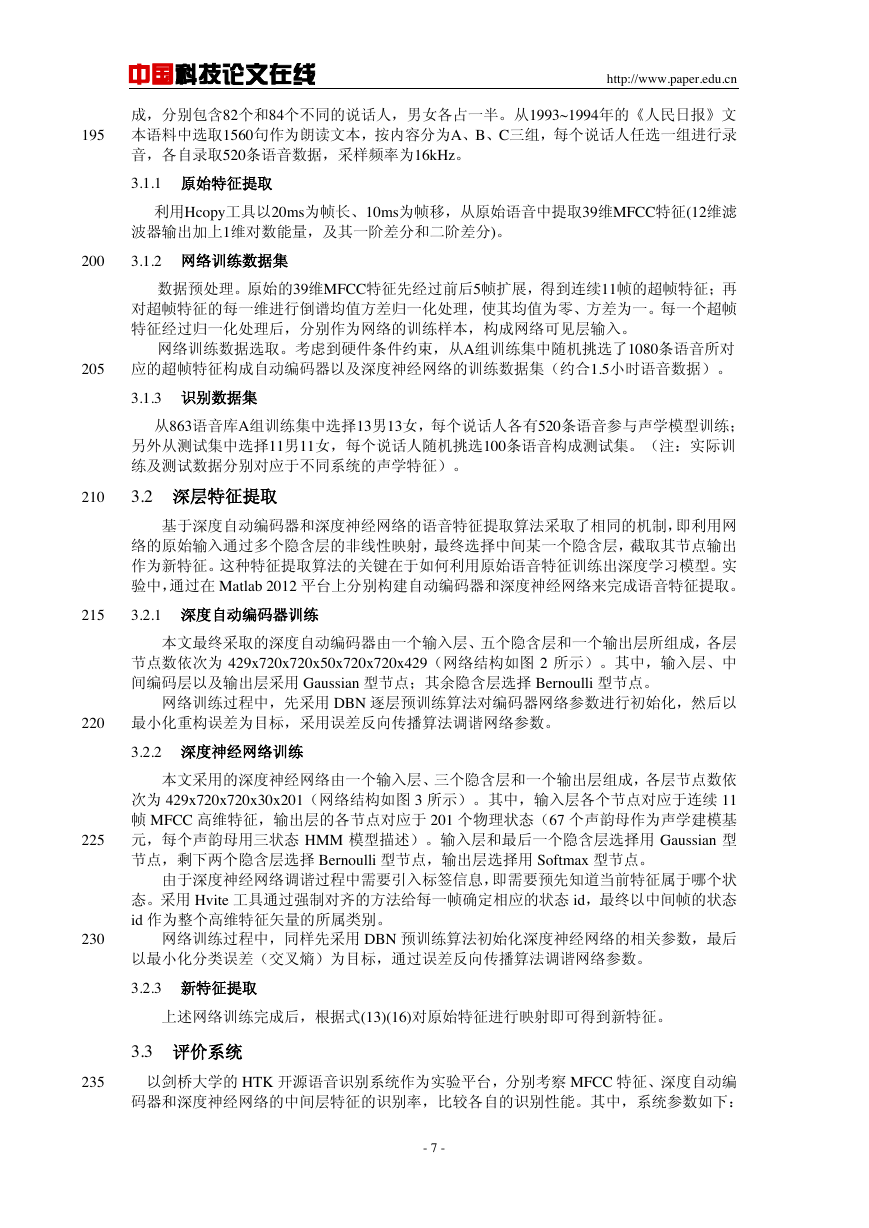

深度自动编码器是一种特殊类型的神经网络,其输入和输出具有相同的维度。由于它以

在输出层重构出原始输入作为目标,不需要额外的监督信息,因而可以直接从海量未标注原

始数据中自动学习数据特征。从结构上看,它包括编码和解码两个部分:以原始数据作为网

络输入,经过若干隐含层的层层分解,编码得到中间层特征表示;中间层特征再经过若干隐

含层的组合,通过解码在输出层还原为原始输入。(网络结构如图 2 所示)

120

图 2 深度自动编码器模型的语音特征提取系统框图

2.2.1 节点类型选择

125

将深度自动编码器应用于语音特征提取时,由于网络输入是高维 MFCC 特征,分布为

[-oo,+oo],故输入层和输出层采用 Gaussian 型节点进行建模;考虑到新特征需要对语音这种

复杂现象具备强大的描述能力以及后续声学模型训练需要,中间编码层同样采用 Gaussian

型节点;剩余的隐含层则采用 Bernoulli 型节点[11]。

对于 Gaussian 型节点,其输出为输入的线性组合,满足:

- 4 -

reijconvh输入层V隐含层H(自左向右记为H1/H2/H3/H4/H5)输出层OMFCC特征(输入)(输出)DAE中间层特征�

中国科技论文在线

http://www.paper.edu.cn

(10)

130

对于 Bernoulli 型节点,其输出为输入的 sigmoid 映射,满足:

(11)

式(10)(11)中, 和 分别表示第 l 层节点 i 的输入和输出, 表示节点的偏置值;

表示和下一层各节点的连接权重, 表示下一层节点的输出值。

2.2.2 自动编码器训练

135

140

网络预训练。采取 DBN 逐层预训练对深度自动编码器网络参数进行初始化。由于编码

和解码是可逆的过程,故预训练只需要初始化从网络输入层到中间编码层之间的编码部分网

络参数,剩下的解码部分网络参数可以通过镜像展开的方式进行初始化。以图 2 为例,编码

网 络 由 可 见 层 V 以 及 隐 含 层 H1/H2/H3 组 成 , 根 据 各 层 节 点 的 类 型 , 依 次 采 用

Gaussian-Bernoulli RBM、Bernoulli-Bernoulli RBM 以及 Bernoulli-Gaussian RBM 模型初始化

相邻两层的连接权重,权重记为 w1/w2/w3;解码网络由中间编码层 H3、隐含层 H4/H5 以

及输出层 O 组成,相邻两层连接权重记为 w4/w5/w6。依照镜像原理,满足 w4=w3’、w5=w2’、

w6=w1’。

网络参数调谐。深度自动编码器以最小化重构输入和原始输入之间的误差为目标函数,

通过后向误差传播(Back Propagation, BP)算法调整网络参数。目标函数记为:

145

(12)

其中, 表示网络参数, 表示训练样本个数, 表示网络的原始输入,

表示

网络的中间层编码输出,

表示中间层编码结果经过解码网络所重构的输入。

2.2.3 DAE 中间层特征提取

深度自动编码器训练完成后,利用编码层参数对原始输入进行映射得到新特征,即:

(13)

其中, 表示原始声学特征输入,

表示编码部分的网络参数, 表示基于深度自

动编码器提取的中间层特征。

2.3 基于深度神经网络的有监督特征提取方法

区分性训练[12]是当前声学建模研究中颇受关注的一种训练准则,其主要思想是综合考

虑不同类别的训练样本之间的相互影响,注重于调整不同模型间的分界面,从而增加声学建

模基元间的区分度。实际中,基于区分性准则的声学模型有效提高了系统识别性能;同样,

如果使得声学特征本身也具备一定的区分性,无疑将对识别率的提升产生积极影响。

深度自动编码器是一种无监督学习模型,由于网络训练过程中没有监督信息的指导,因

而在中间层输出的特征并不具备区分性信息。相对而言,深度神经网络能够把特征和其所属

类别直接关联起来,即利用其多层网络结构实现从输入层特征到其所属类别的映射。根据深

度学习的思想,即各层节点的输出可视为同一表示在不同特征空间的投影,显然从网络中间

截取的中间层特征也将具备一定的区分性。

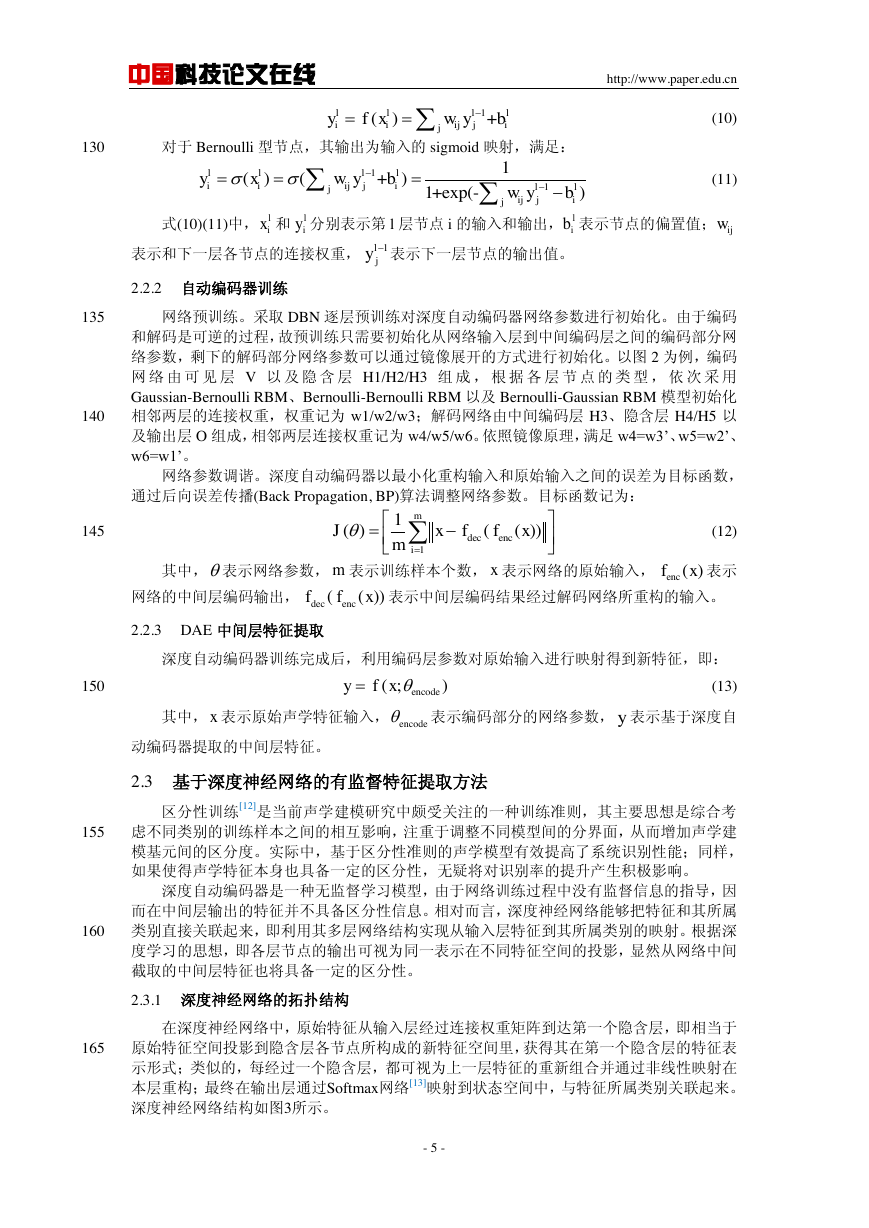

2.3.1 深度神经网络的拓扑结构

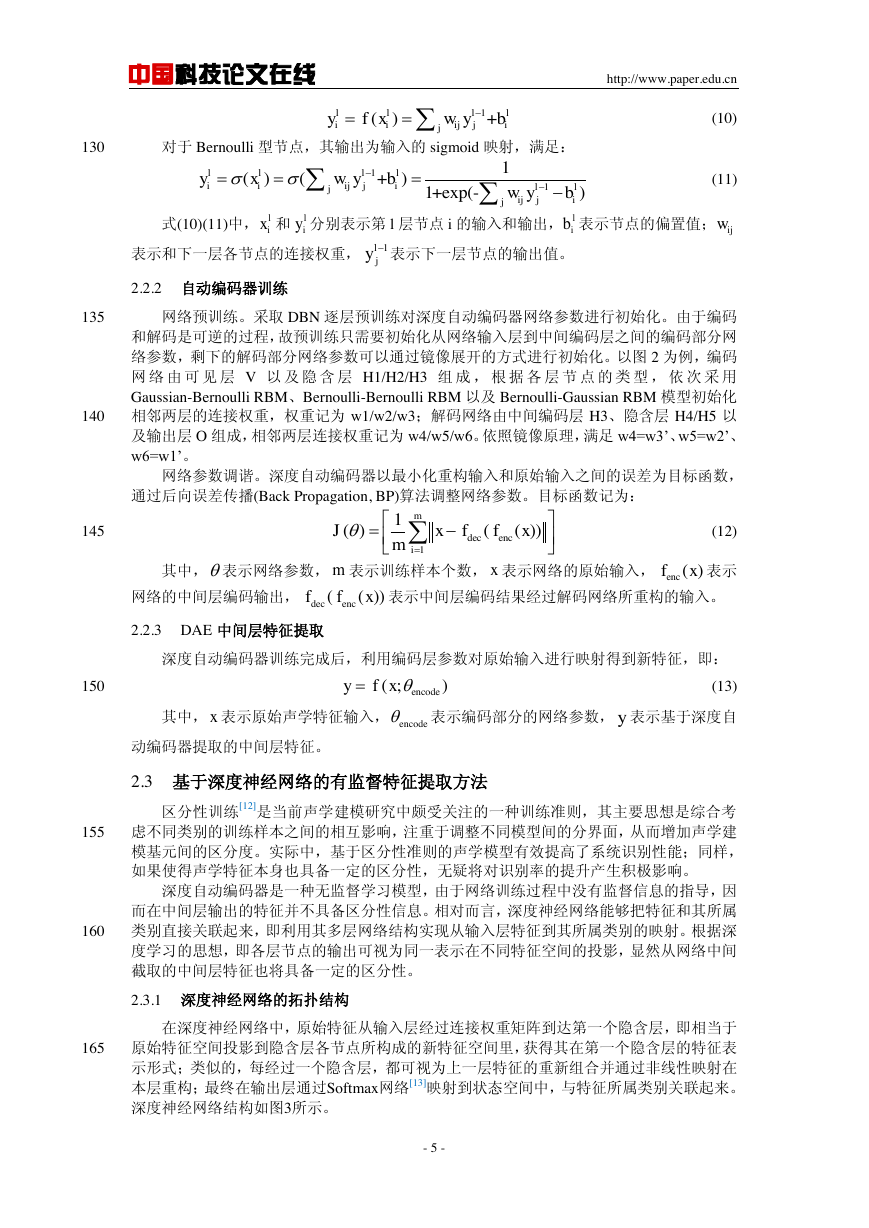

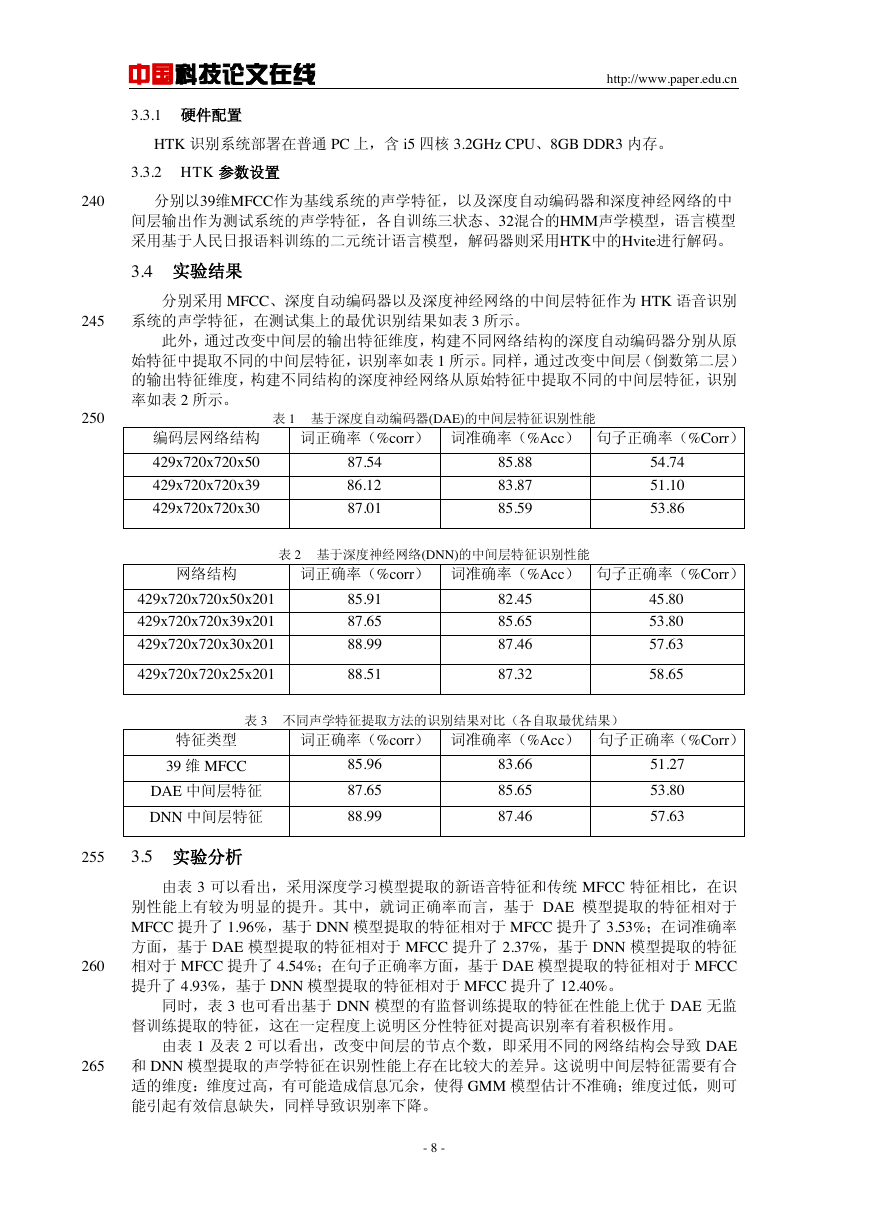

在深度神经网络中,原始特征从输入层经过连接权重矩阵到达第一个隐含层,即相当于

原始特征空间投影到隐含层各节点所构成的新特征空间里,获得其在第一个隐含层的特征表

示形式;类似的,每经过一个隐含层,都可视为上一层特征的重新组合并通过非线性映射在

本层重构;最终在输出层通过Softmax网络[13]映射到状态空间中,与特征所属类别关联起来。

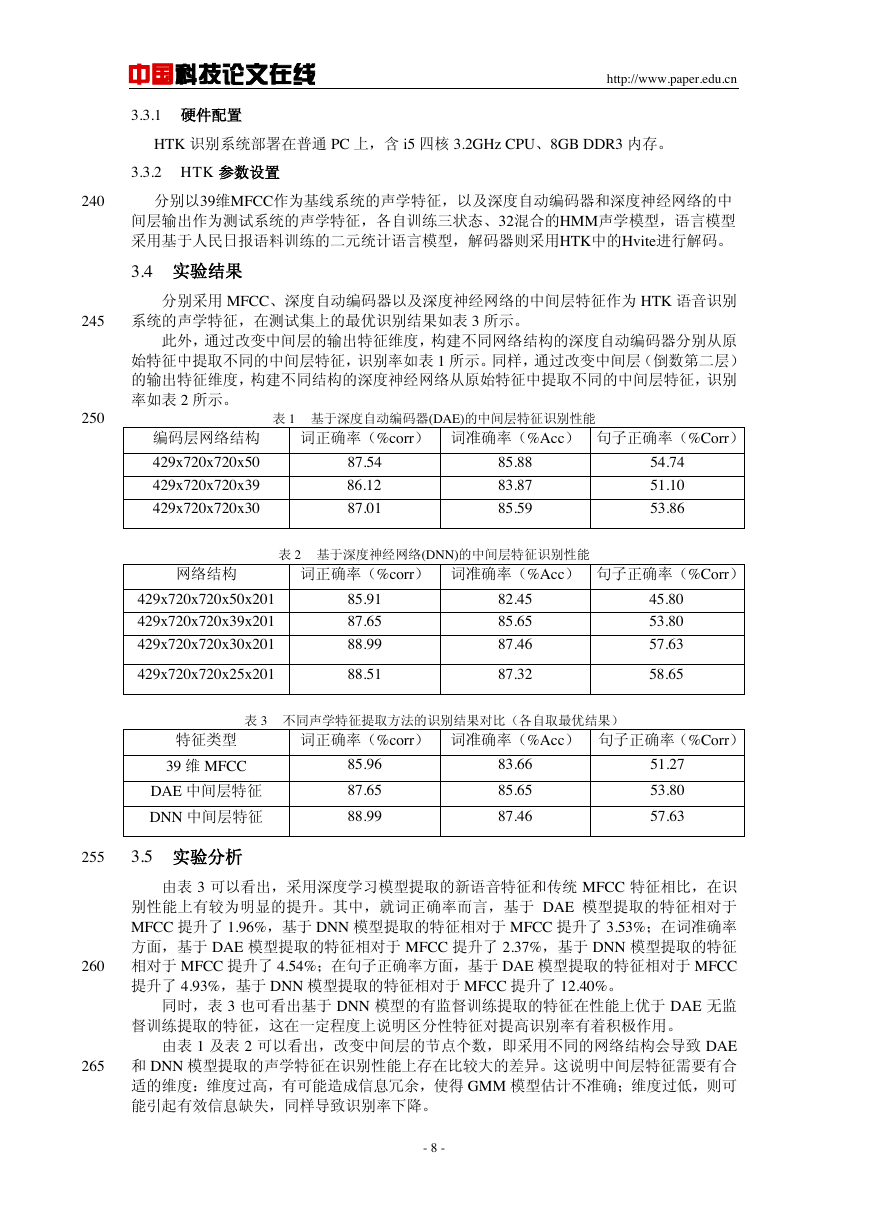

深度神经网络结构如图3所示。

150

155

160

165

- 5 -

1()+lllliiijjijyfxwyb111()(+)1+exp(-)lllliiijjilljijjijyxwybwyblixliylibijw1ljydecenc11()(())miJxffxmmxenc()fxdecenc(())ffxen(;)codeyfxxencodey�

中国科技论文在线

2.3.2 节点类型选择

http://www.paper.edu.cn

170

网络输入层和最后一个隐含层(对应中间特征输出层)选择 Gaussian 型节点进行建模;

其他隐含层选择 Bernoulli 型节点;输出层选择 Softmax 型节点。

Softmax 型节点的输入和输出满足:

(14)

上式中, 和 分别表示节点的输入和输出值。

175

180

图 3 基于深度神经网络的语音特征提取框架

2.3.3 深度神经网络的训练算法

与深度自动编码器一样,先采取 DBN 逐层预训练的方法对网络参数进行初始化。在网

络参数调谐阶段中,先通过强制对齐得到每一帧训练数据对应的状态 id,作为训练标签;以

训练数据作为激励,经过各个隐含层的映射后到达输出层,取输出值最大的节点记为预测标

签。通过以最小化交叉熵为目标函数,利用误差反向传播算法调整参数。目标函数记为:

其中, 表示网络参数; 表示不同标签的总数;

表示给定训练数据情况下,网

络输出层 i 节点的输出值,即状态 i 的预测出现概率;

表示状态 i 的实际出现概率。

(15)

185

2.3.4 DNN 中间层特征提取

深度神经网络训练完成后,利用其网络参数对原始输入进行映射得到新特征,即:

(16)

其中, 表示原始声学特征输入,

表示深度神经网络参数, 表示经过深度神经

网络映射后提取得到的中间层特征。

190

3 实验与结果分析

3.1 3.1 实验数据集

本文采用了863汉语连续语音库作为实验数据集。整个语音库由训练集和测试集两部分组

- 6 -

exp()exp()iijjxyxixiy中间层特征(输出)(输入)MFCC特征输入层V隐含层H输出层0'(对应于音素状态)1()()()log()NXENTiyiFyiyiN()yi()yi(;)DNNyfxxDNNy�

中国科技论文在线

http://www.paper.edu.cn

195

成,分别包含82个和84个不同的说话人,男女各占一半。从1993~1994年的《人民日报》文

本语料中选取1560句作为朗读文本,按内容分为A、B、C三组,每个说话人任选一组进行录

音,各自录取520条语音数据,采样频率为16kHz。

3.1.1 原始特征提取

利用Hcopy工具以20ms为帧长、10ms为帧移,从原始语音中提取39维MFCC特征(12维滤

波器输出加上1维对数能量,及其一阶差分和二阶差分)。

200

3.1.2 网络训练数据集

数据预处理。原始的39维MFCC特征先经过前后5帧扩展,得到连续11帧的超帧特征;再

对超帧特征的每一维进行倒谱均值方差归一化处理,使其均值为零、方差为一。每一个超帧

特征经过归一化处理后,分别作为网络的训练样本,构成网络可见层输入。

网络训练数据选取。考虑到硬件条件约束,从A组训练集中随机挑选了1080条语音所对

应的超帧特征构成自动编码器以及深度神经网络的训练数据集(约合1.5小时语音数据)。

205

3.1.3 识别数据集

从863语音库A组训练集中选择13男13女,每个说话人各有520条语音参与声学模型训练;

另外从测试集中选择11男11女,每个说话人随机挑选100条语音构成测试集。(注:实际训

练及测试数据分别对应于不同系统的声学特征)。

210

3.2 深层特征提取

基于深度自动编码器和深度神经网络的语音特征提取算法采取了相同的机制,即利用网

络的原始输入通过多个隐含层的非线性映射,最终选择中间某一个隐含层,截取其节点输出

作为新特征。这种特征提取算法的关键在于如何利用原始语音特征训练出深度学习模型。实

验中,通过在 Matlab 2012 平台上分别构建自动编码器和深度神经网络来完成语音特征提取。

215

3.2.1 深度自动编码器训练

本文最终采取的深度自动编码器由一个输入层、五个隐含层和一个输出层所组成,各层

节点数依次为 429x720x720x50x720x720x429(网络结构如图 2 所示)。其中,输入层、中

间编码层以及输出层采用 Gaussian 型节点;其余隐含层选择 Bernoulli 型节点。

网络训练过程中,先采用 DBN 逐层预训练算法对编码器网络参数进行初始化,然后以

220

最小化重构误差为目标,采用误差反向传播算法调谐网络参数。

3.2.2 深度神经网络训练

本文采用的深度神经网络由一个输入层、三个隐含层和一个输出层组成,各层节点数依

次为 429x720x720x30x201(网络结构如图 3 所示)。其中,输入层各个节点对应于连续 11

帧 MFCC 高维特征,输出层的各节点对应于 201 个物理状态(67 个声韵母作为声学建模基

元,每个声韵母用三状态 HMM 模型描述)。输入层和最后一个隐含层选择用 Gaussian 型

节点,剩下两个隐含层选择 Bernoulli 型节点,输出层选择用 Softmax 型节点。

由于深度神经网络调谐过程中需要引入标签信息,即需要预先知道当前特征属于哪个状

态。采用 Hvite 工具通过强制对齐的方法给每一帧确定相应的状态 id,最终以中间帧的状态

id 作为整个高维特征矢量的所属类别。

网络训练过程中,同样先采用 DBN 预训练算法初始化深度神经网络的相关参数,最后

以最小化分类误差(交叉熵)为目标,通过误差反向传播算法调谐网络参数。

225

230

3.2.3 新特征提取

上述网络训练完成后,根据式(13)(16)对原始特征进行映射即可得到新特征。

3.3 评价系统

235

以剑桥大学的 HTK 开源语音识别系统作为实验平台,分别考察 MFCC 特征、深度自动编

码器和深度神经网络的中间层特征的识别率,比较各自的识别性能。其中,系统参数如下:

- 7 -

�

中国科技论文在线

3.3.1 硬件配置

http://www.paper.edu.cn

HTK 识别系统部署在普通 PC 上,含 i5 四核 3.2GHz CPU、8GB DDR3 内存。

3.3.2 HTK 参数设置

240

分别以39维MFCC作为基线系统的声学特征,以及深度自动编码器和深度神经网络的中

间层输出作为测试系统的声学特征,各自训练三状态、32混合的HMM声学模型,语言模型

采用基于人民日报语料训练的二元统计语言模型,解码器则采用HTK中的Hvite进行解码。

3.4 实验结果

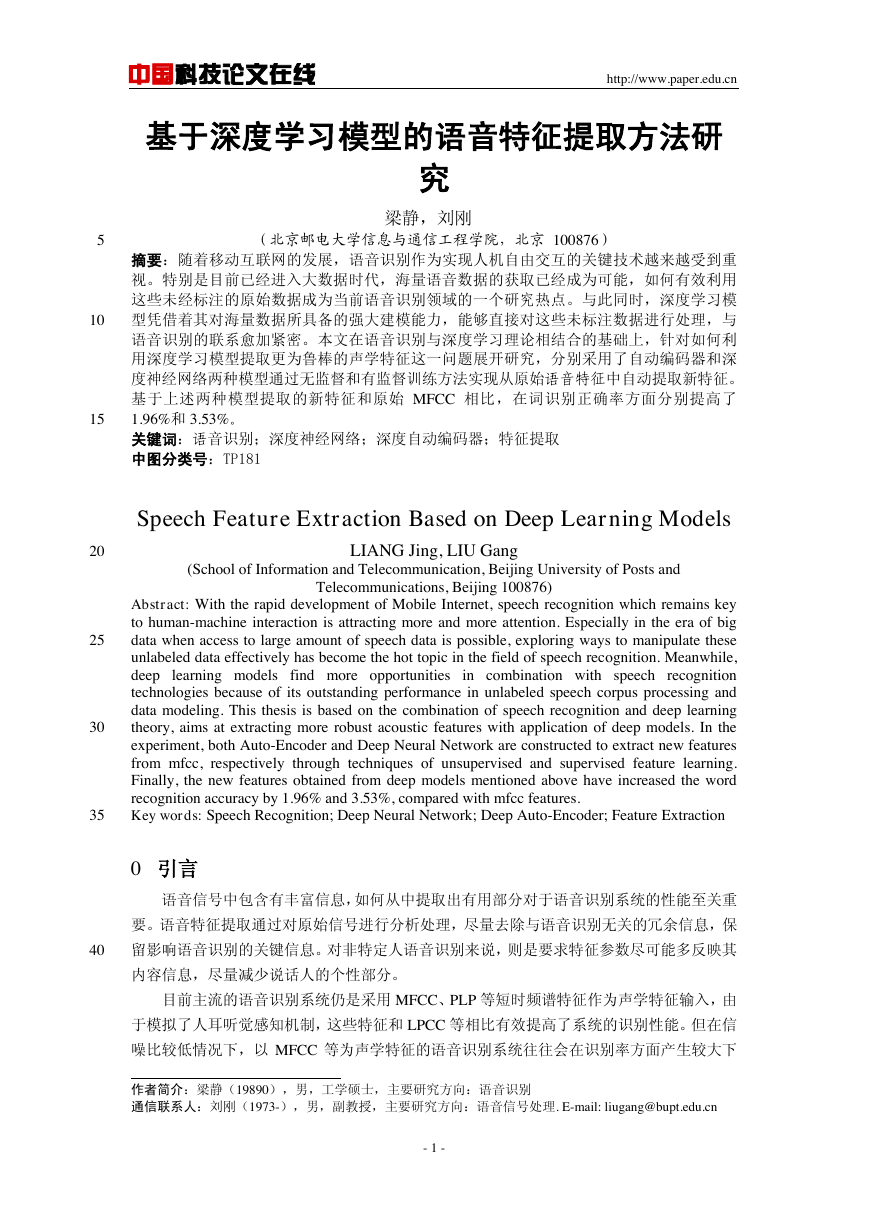

分别采用 MFCC、深度自动编码器以及深度神经网络的中间层特征作为 HTK 语音识别

系统的声学特征,在测试集上的最优识别结果如表 3 所示。

245

此外,通过改变中间层的输出特征维度,构建不同网络结构的深度自动编码器分别从原

始特征中提取不同的中间层特征,识别率如表 1 所示。同样,通过改变中间层(倒数第二层)

的输出特征维度,构建不同结构的深度神经网络从原始特征中提取不同的中间层特征,识别

率如表 2 所示。

250

表 1 基于深度自动编码器(DAE)的中间层特征识别性能

编码层网络结构

词正确率(%corr) 词准确率(%Acc) 句子正确率(%Corr)

429x720x720x50

429x720x720x39

429x720x720x30

87.54

86.12

87.01

85.88

83.87

85.59

54.74

51.10

53.86

表 2 基于深度神经网络(DNN)的中间层特征识别性能

网络结构

词正确率(%corr) 词准确率(%Acc) 句子正确率(%Corr)

429x720x720x50x201

429x720x720x39x201

429x720x720x30x201

429x720x720x25x201

85.91

87.65

88.99

88.51

82.45

85.65

87.46

87.32

45.80

53.80

57.63

58.65

表 3 不同声学特征提取方法的识别结果对比(各自取最优结果)

特征类型

词正确率(%corr) 词准确率(%Acc) 句子正确率(%Corr)

39 维 MFCC

DAE 中间层特征

DNN 中间层特征

85.96

87.65

88.99

83.66

85.65

87.46

51.27

53.80

57.63

255

3.5 实验分析

由表 3 可以看出,采用深度学习模型提取的新语音特征和传统 MFCC 特征相比,在识

别性能上有较为明显的提升。其中,就词正确率而言,基于 DAE 模型提取的特征相对于

MFCC 提升了 1.96%,基于 DNN 模型提取的特征相对于 MFCC 提升了 3.53%;在词准确率

方面,基于 DAE 模型提取的特征相对于 MFCC 提升了 2.37%,基于 DNN 模型提取的特征

相对于 MFCC 提升了 4.54%;在句子正确率方面,基于 DAE 模型提取的特征相对于 MFCC

提升了 4.93%,基于 DNN 模型提取的特征相对于 MFCC 提升了 12.40%。

同时,表 3 也可看出基于 DNN 模型的有监督训练提取的特征在性能上优于 DAE 无监

督训练提取的特征,这在一定程度上说明区分性特征对提高识别率有着积极作用。

由表 1 及表 2 可以看出,改变中间层的节点个数,即采用不同的网络结构会导致 DAE

和 DNN 模型提取的声学特征在识别性能上存在比较大的差异。这说明中间层特征需要有合

适的维度:维度过高,有可能造成信息冗余,使得 GMM 模型估计不准确;维度过低,则可

能引起有效信息缺失,同样导致识别率下降。

260

265

- 8 -

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc