第 18 周总结

姓名:徐玙璠

年级:硕士一年级

日期:2018 年 1 月 20 日

《 Unsupervised Monocular Depth Estimation with

Left-Right Consistency 》 这 篇 文 章 是 受 《 Unsupervised

Monocular Depth Estimation with Left-Right Consistency》这篇

文章启发,这周主要看的这篇文章。

《 Unsupervised Monocular Depth Estimation with

Left-Right Consistency》主要工作就是通过无监督学习,利用

单张图像来估计深度。训练的时候通过单张图像生成视差图,

并合成另一张图,损失函数是基于图像重建的误差。但是仅

用图像重建的误差,在图像重建时表现很好,但在深度估计

上表现的并不好。因此后来被改进为基于左右图像视差的一

致性的损失函数。

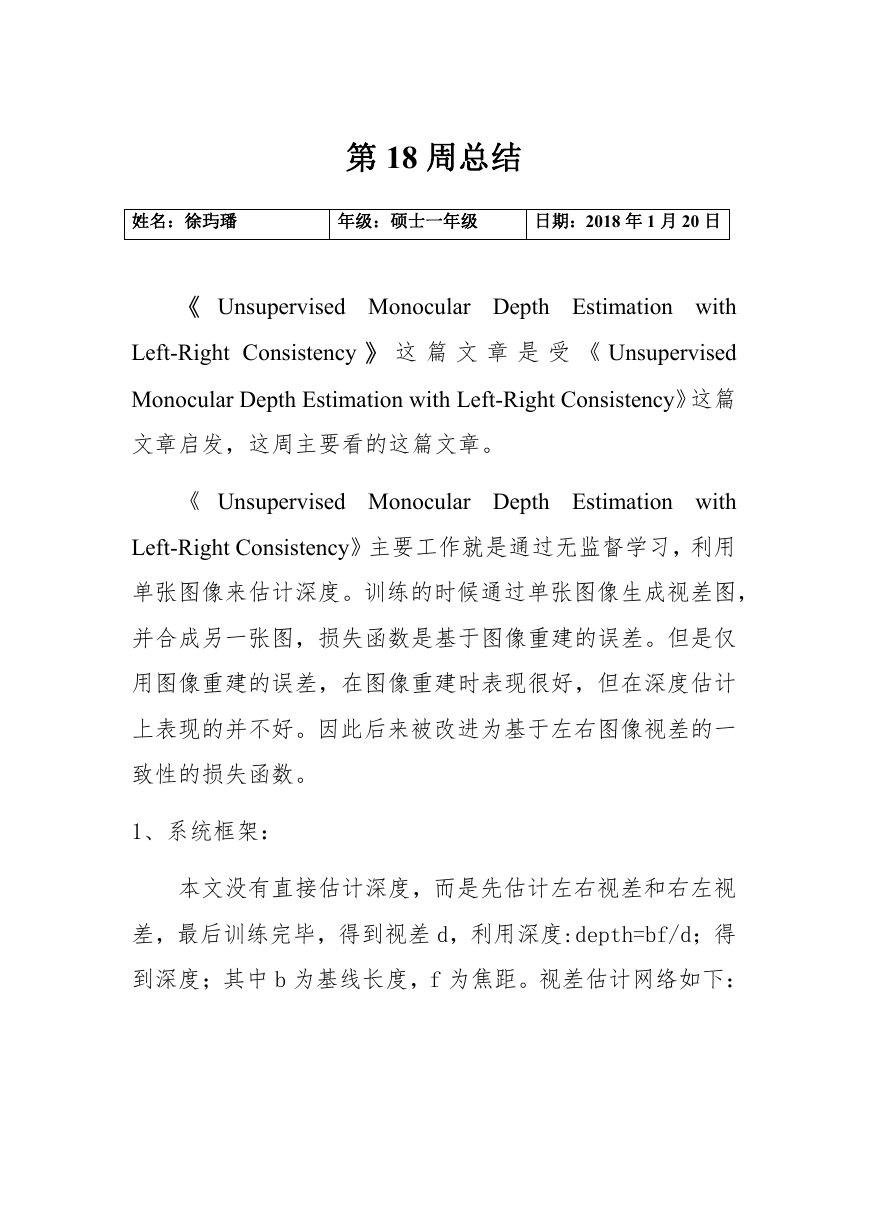

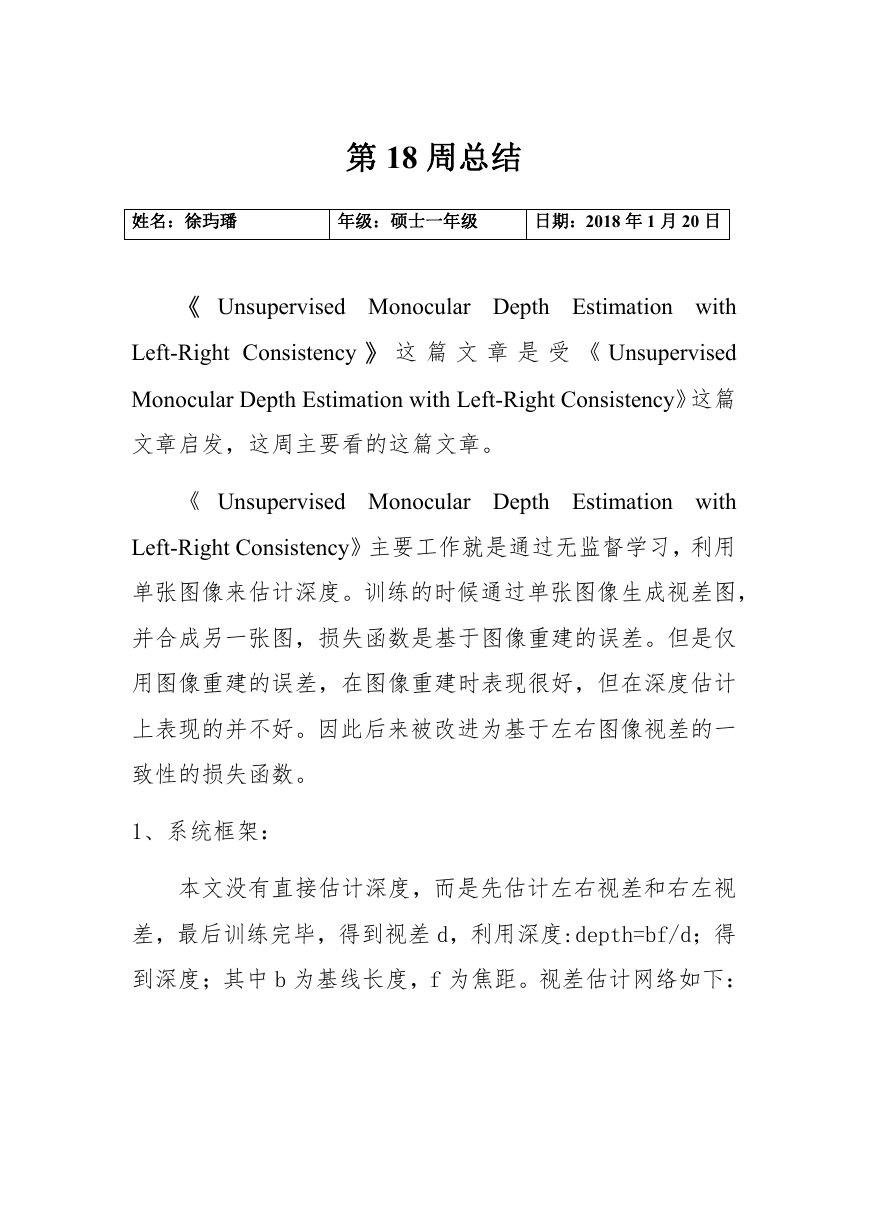

1、系统框架:

本文没有直接估计深度,而是先估计左右视差和右左视

差,最后训练完毕,得到视差 d,利用深度:depth=bf/d;得

到深度;其中 b 为基线长度,f 为焦距。视差估计网络如下:

�

2、网络框架:

作者的网络通过推测视差将左图弯曲来匹配右图。主要

的 insight 可以只用左图同时预测两个视差(左边到右边,

右边到左边),用左右一致性来增强它。作者的网络通过双

目反向匹配生成了预测图像,是一个完全可微的图像形成网

络。如图三所示,naive 一些的做法是从左图采样,生成与

目标右图对齐的视差图。然而作者想要从右图采样输出与左

图对齐的视差图。这样就是 NoLR 的方法。只是这么做的话,

被推断出来的视差图表现出“纹理拷贝”人工合成和深度

图连续性上面误差。作者通过从相反的输入图像采样训练网

络预测两个视角的视差图的方法解决这个问题。这样做也只

需要单个左图作为卷积神经网络的输入,右图只在训练时候

使用。用左右图一致性损失增强左右视差图的一致性可以让

结果更准确。

�

作者的全卷积架构是被 DipsNet 启发的,几个重要的修正让

作者不需要 ground truth 深度图训练。作者的网络主要由

两个部分组成:

1)编码器:从第一层卷积到第七层卷积 b

2)解码器:从反卷积 7

解码器是从编码器的激活块做 skip connections 的,

这样可以让它能够分解更高的分辨细节。作者输出视差预测

在不同的尺度(从 disp4 到 disp1),这样可以在不同字序列

尺度上的空间分辨率上加倍。虽然只用单张图作为输入,网

络在每个输出尺度预测两张视差图:左到右,右到左。

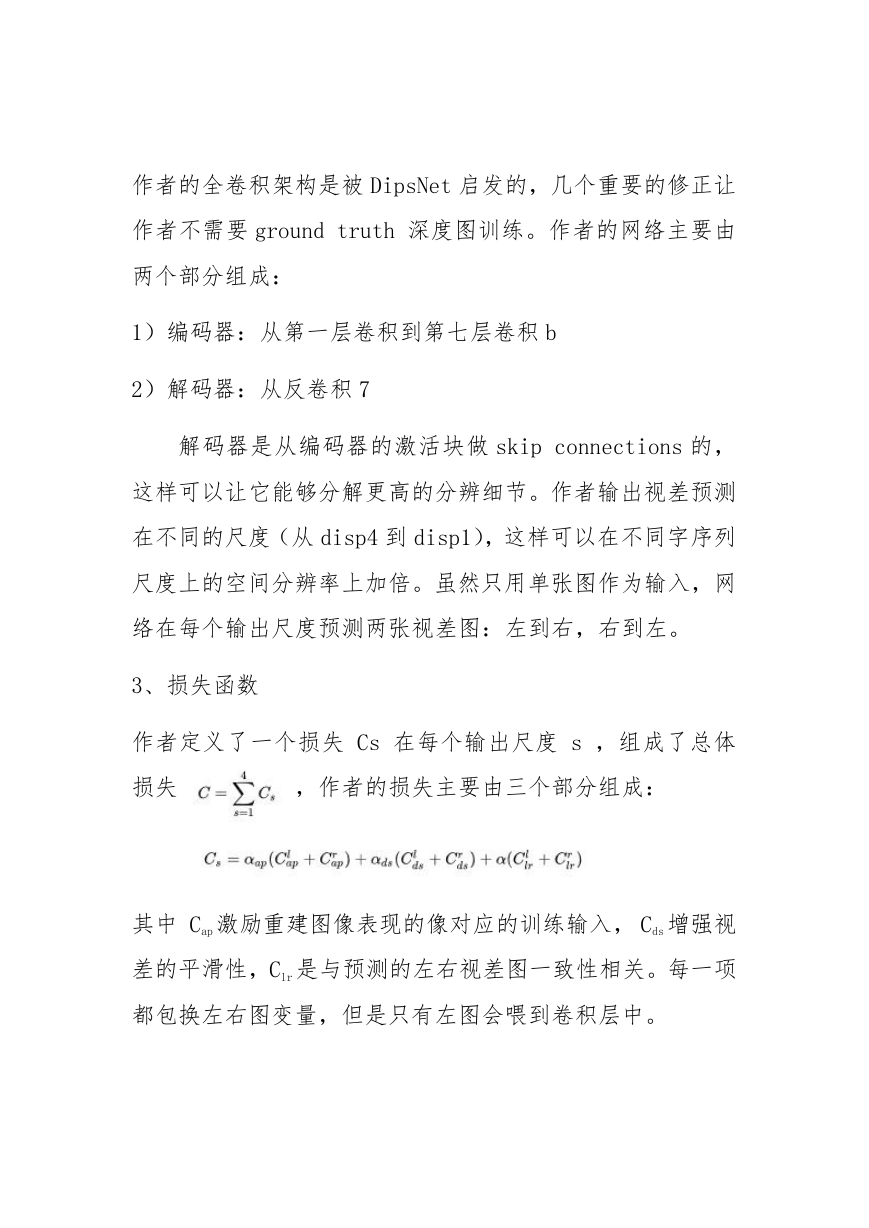

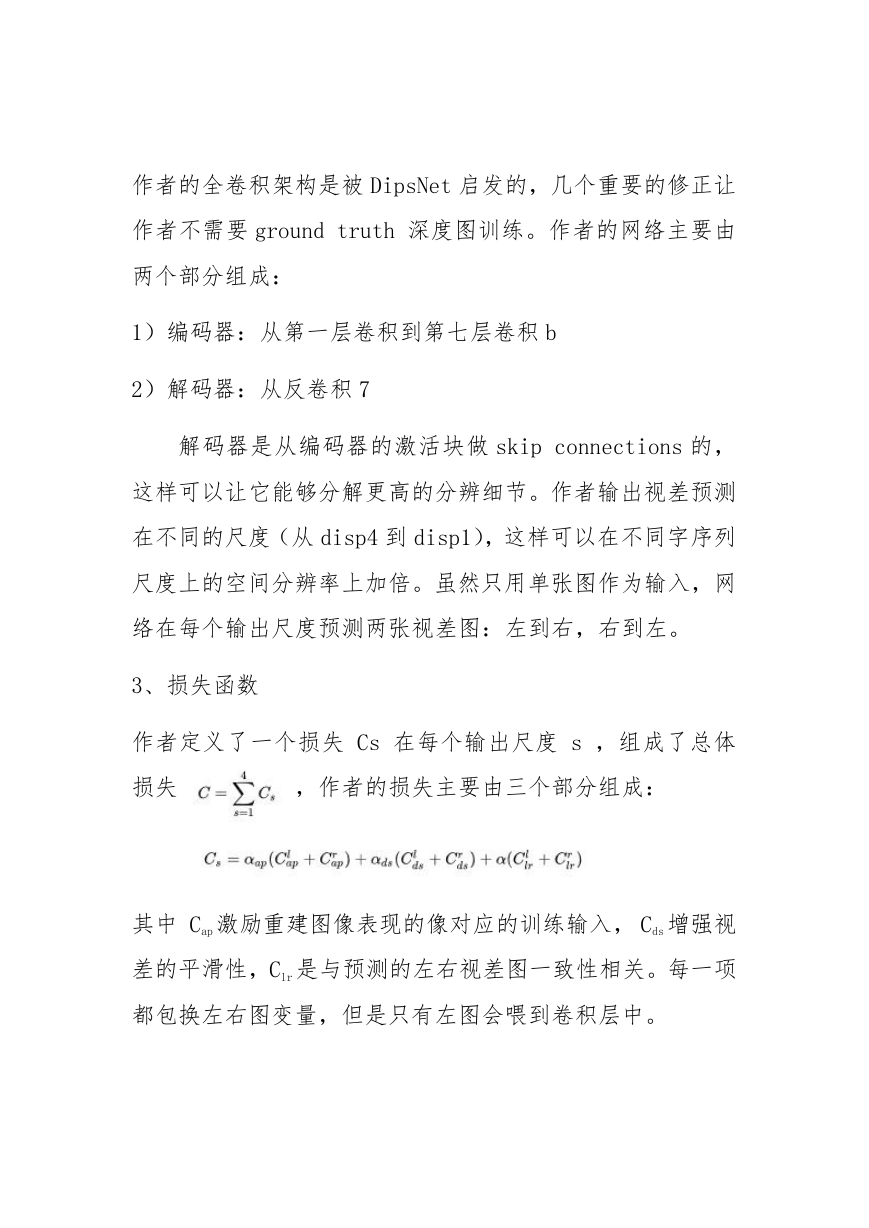

3、损失函数

作者定义了一个损失 Cs 在每个输出尺度 s ,组成了总体

损失

,作者的损失主要由三个部分组成:

其中 Cap 激励重建图像表现的像对应的训练输入, Cds 增强视

差的平滑性,Clr 是与预测的左右视差图一致性相关。每一项

都包换左右图变量,但是只有左图会喂到卷积层中。

�

下一步,要说损失函数的每一个部分在左图中,而对右图版

本来说需要交换左右图在另一个方向采样。

4、总结

作者展示了一个无监督深度神经网络用以单张图片深

度估计。作者不用对齐的 ground truth 这种稀少而且消耗

资源的方法,用了采集的双目立体数据。作者新颖的损失函

数增强了各个视角的预测深度图的一致性。

之后的工作,可以将模型延伸到视频上。现在的深度估

计每一帧都是独立的,加入时间连贯性之后,可能能提升结

果。

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc