生成模型和判别模型

理解对抗网络,首先要了解生成模型和判别模型。判别模型比较好理解,就

像分类一样,有一个判别界限,通过这个判别界限去区分样本。从概率角度分析

就是获得样本 x 属于类别 y 的概率,是一个条件概率 P(y|x).而生成模型是需

要在整个条件内去产生数据的分布,就像高斯分布一样,他需要去拟合整个分布,

从概率角度分析就是样本 x 在整个分布中的产生的概率,即联合概率 P(xy)。

具体可以参考博文 http://blog.csdn.net/zouxy09/article/details/8195017

对抗网络思想

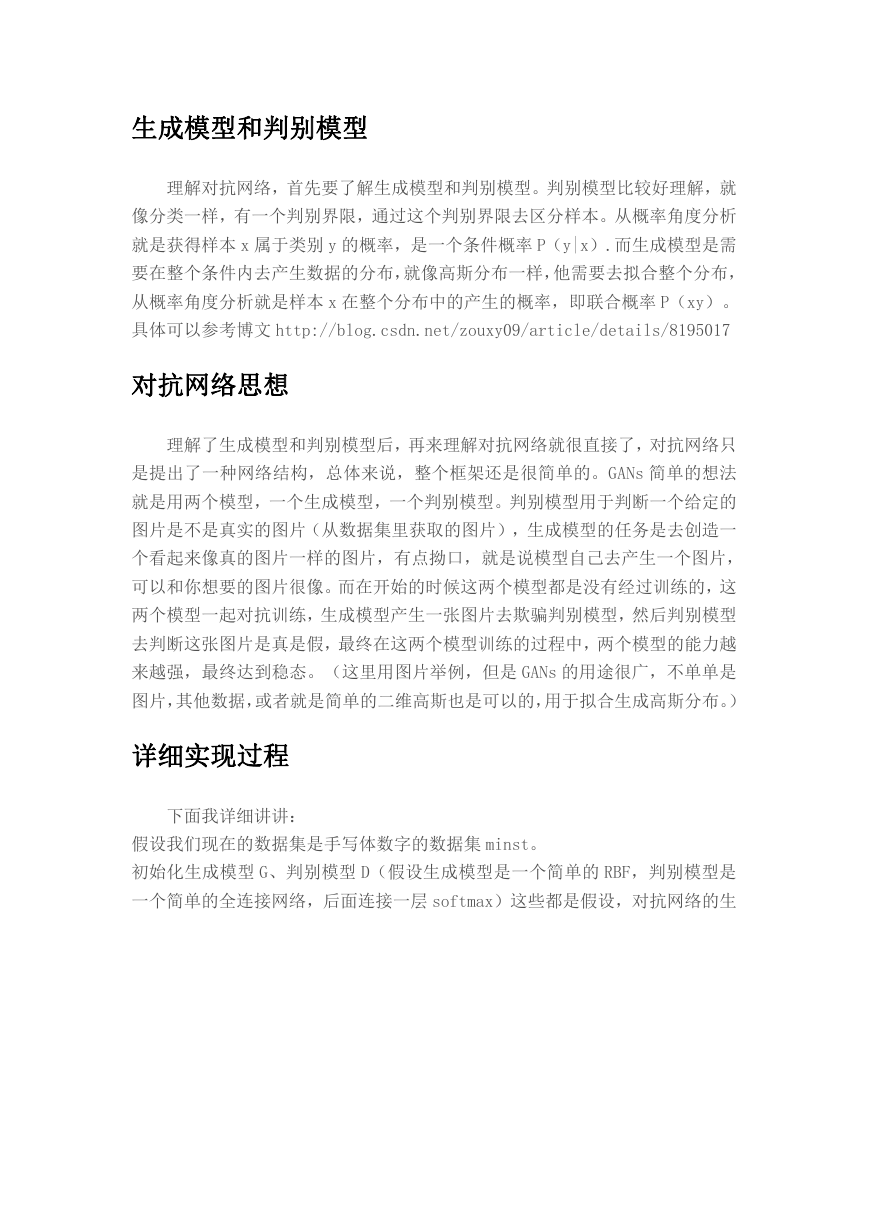

理解了生成模型和判别模型后,再来理解对抗网络就很直接了,对抗网络只

是提出了一种网络结构,总体来说,整个框架还是很简单的。GANs 简单的想法

就是用两个模型,一个生成模型,一个判别模型。判别模型用于判断一个给定的

图片是不是真实的图片(从数据集里获取的图片),生成模型的任务是去创造一

个看起来像真的图片一样的图片,有点拗口,就是说模型自己去产生一个图片,

可以和你想要的图片很像。而在开始的时候这两个模型都是没有经过训练的,这

两个模型一起对抗训练,生成模型产生一张图片去欺骗判别模型,然后判别模型

去判断这张图片是真是假,最终在这两个模型训练的过程中,两个模型的能力越

来越强,最终达到稳态。(这里用图片举例,但是 GANs 的用途很广,不单单是

图片,其他数据,或者就是简单的二维高斯也是可以的,用于拟合生成高斯分布。)

详细实现过程

下面我详细讲讲:

假设我们现在的数据集是手写体数字的数据集 minst。

初始化生成模型 G、判别模型 D(假设生成模型是一个简单的 RBF,判别模型是

一个简单的全连接网络,后面连接一层 softmax)这些都是假设,对抗网络的生

�

成模型和判别模型没有任何限制。

前向传播阶段

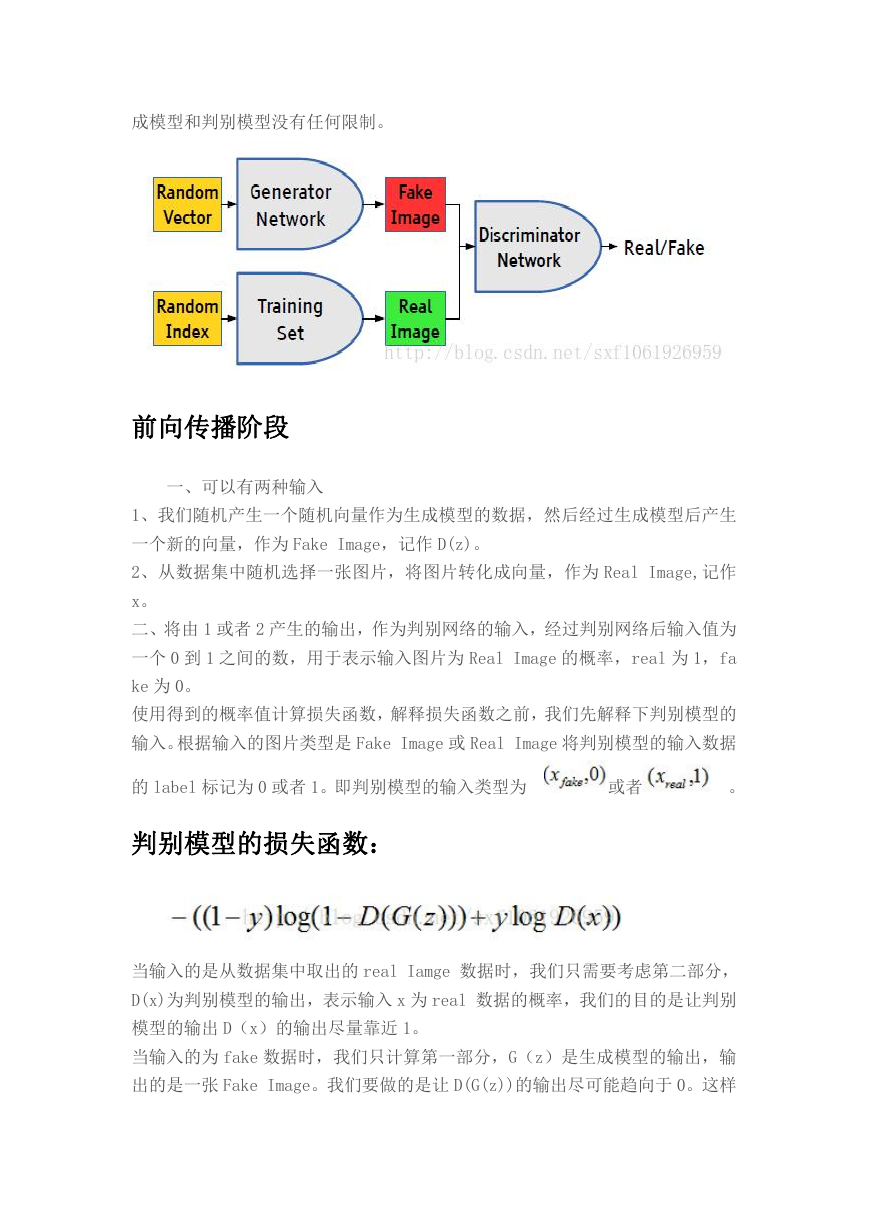

一、可以有两种输入

1、我们随机产生一个随机向量作为生成模型的数据,然后经过生成模型后产生

一个新的向量,作为 Fake Image,记作 D(z)。

2、从数据集中随机选择一张图片,将图片转化成向量,作为 Real Image,记作

x。

二、将由 1 或者 2 产生的输出,作为判别网络的输入,经过判别网络后输入值为

一个 0 到 1 之间的数,用于表示输入图片为 Real Image 的概率,real 为 1,fa

ke 为 0。

使用得到的概率值计算损失函数,解释损失函数之前,我们先解释下判别模型的

输入。根据输入的图片类型是 Fake Image 或 Real Image 将判别模型的输入数据

的 label 标记为 0 或者 1。即判别模型的输入类型为

或者

。

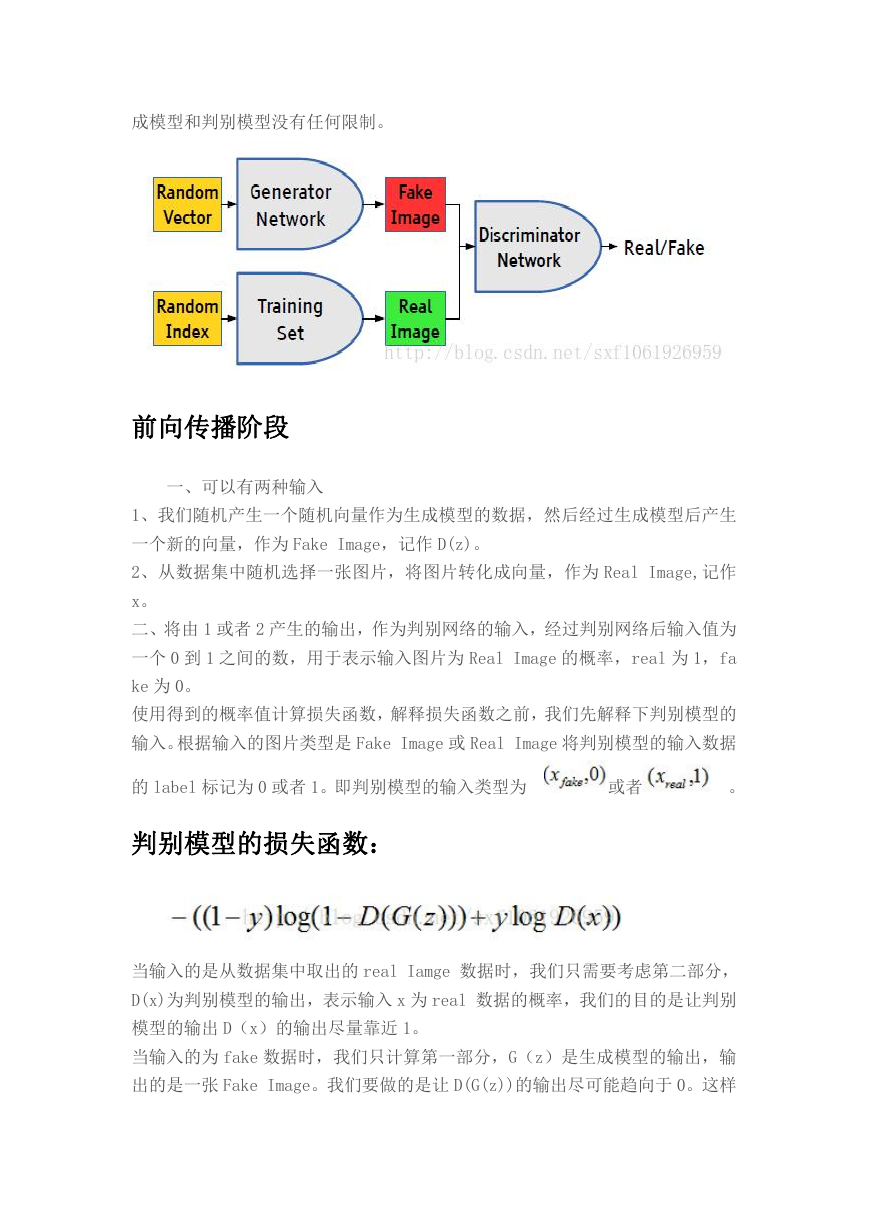

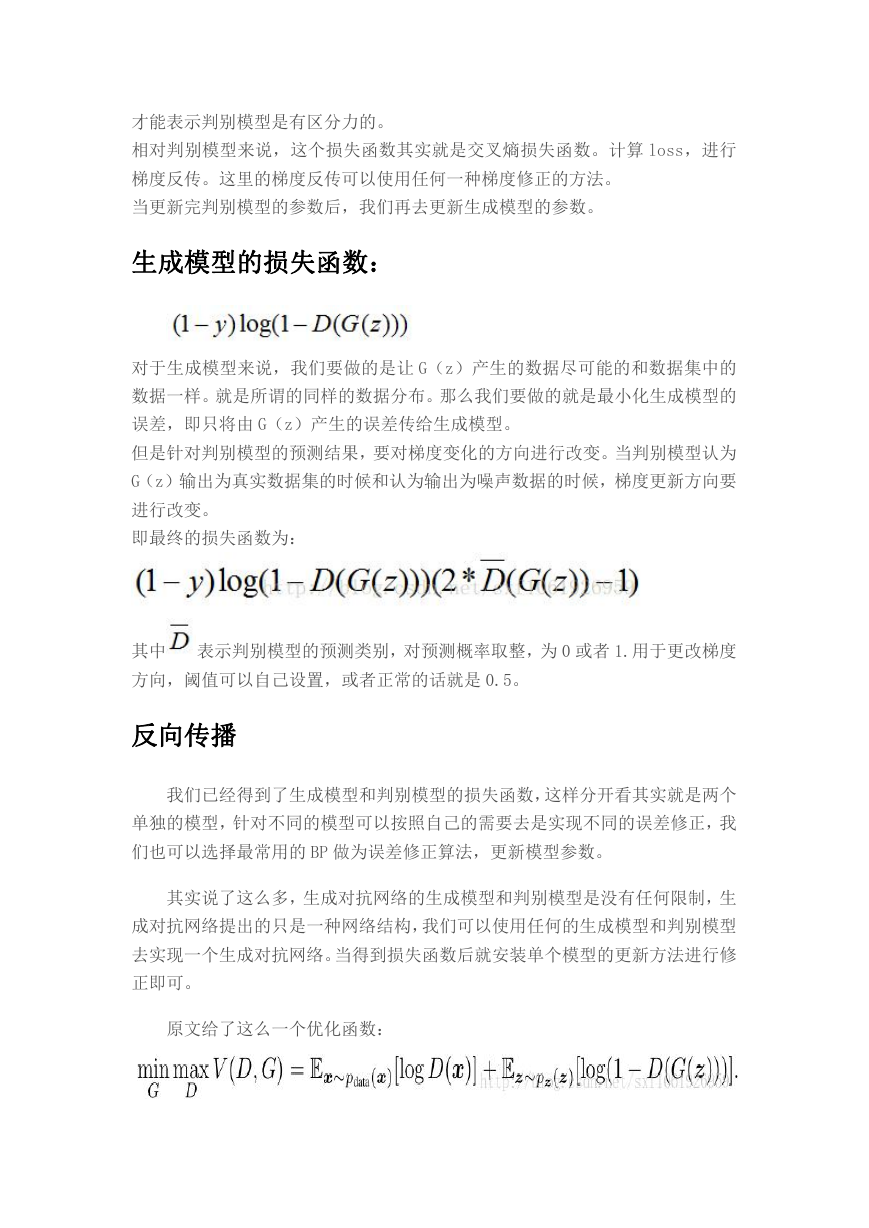

判别模型的损失函数:

当输入的是从数据集中取出的 real Iamge 数据时,我们只需要考虑第二部分,

D(x)为判别模型的输出,表示输入 x 为 real 数据的概率,我们的目的是让判别

模型的输出 D(x)的输出尽量靠近 1。

当输入的为 fake 数据时,我们只计算第一部分,G(z)是生成模型的输出,输

出的是一张 Fake Image。我们要做的是让 D(G(z))的输出尽可能趋向于 0。这样

�

才能表示判别模型是有区分力的。

相对判别模型来说,这个损失函数其实就是交叉熵损失函数。计算 loss,进行

梯度反传。这里的梯度反传可以使用任何一种梯度修正的方法。

当更新完判别模型的参数后,我们再去更新生成模型的参数。

生成模型的损失函数:

对于生成模型来说,我们要做的是让 G(z)产生的数据尽可能的和数据集中的

数据一样。就是所谓的同样的数据分布。那么我们要做的就是最小化生成模型的

误差,即只将由 G(z)产生的误差传给生成模型。

但是针对判别模型的预测结果,要对梯度变化的方向进行改变。当判别模型认为

G(z)输出为真实数据集的时候和认为输出为噪声数据的时候,梯度更新方向要

进行改变。

即最终的损失函数为:

其中 表示判别模型的预测类别,对预测概率取整,为 0 或者 1.用于更改梯度

方向,阈值可以自己设置,或者正常的话就是 0.5。

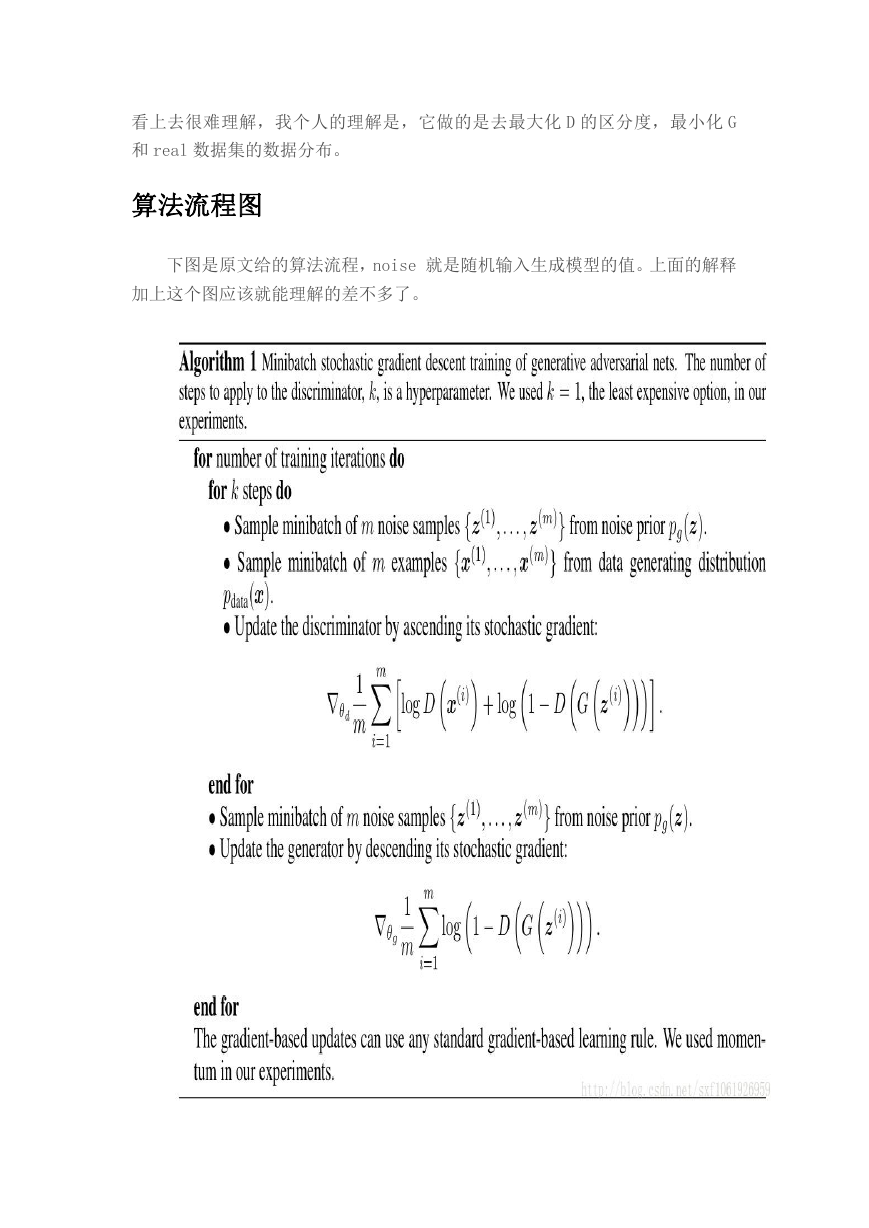

反向传播

我们已经得到了生成模型和判别模型的损失函数,这样分开看其实就是两个

单独的模型,针对不同的模型可以按照自己的需要去是实现不同的误差修正,我

们也可以选择最常用的 BP 做为误差修正算法,更新模型参数。

其实说了这么多,生成对抗网络的生成模型和判别模型是没有任何限制,生

成对抗网络提出的只是一种网络结构,我们可以使用任何的生成模型和判别模型

去实现一个生成对抗网络。当得到损失函数后就安装单个模型的更新方法进行修

正即可。

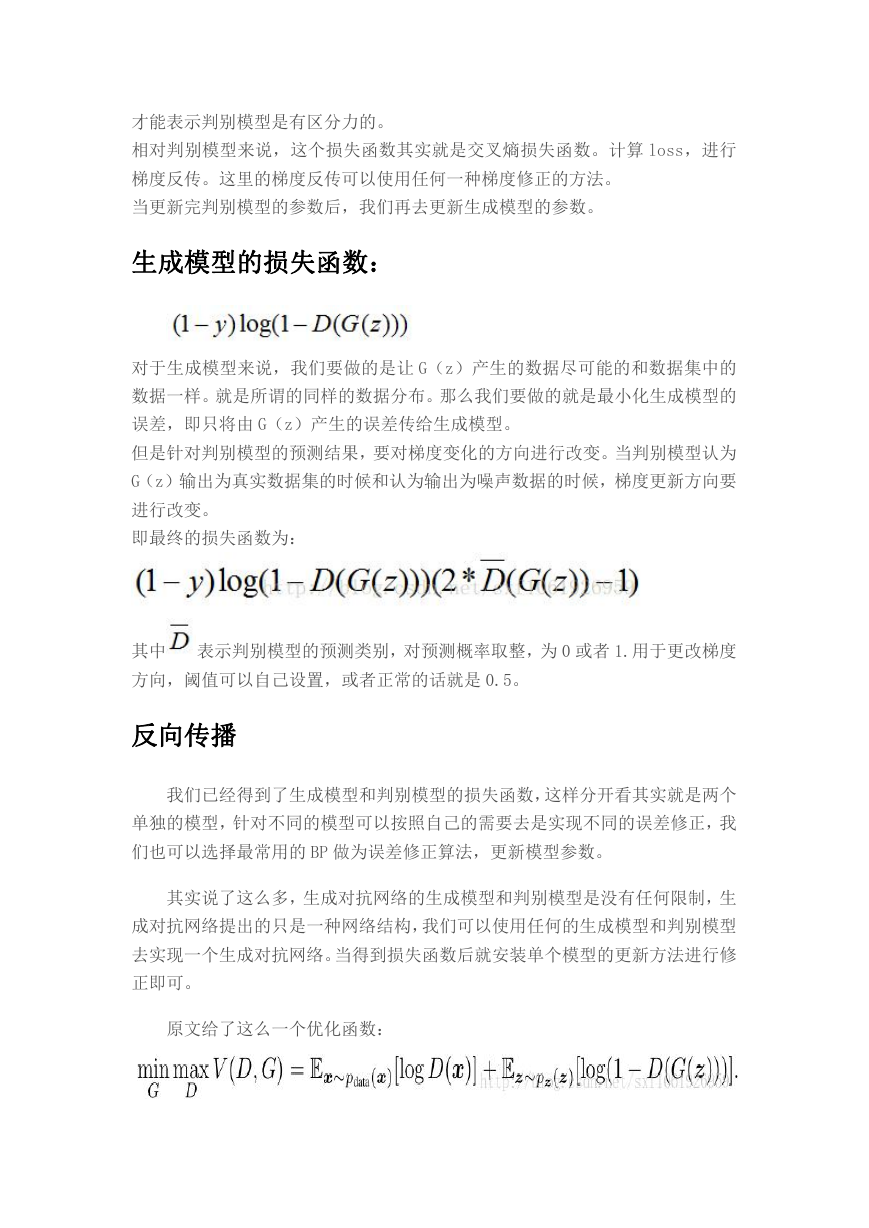

原文给了这么一个优化函数:

�

看上去很难理解,我个人的理解是,它做的是去最大化 D 的区分度,最小化 G

和 real 数据集的数据分布。

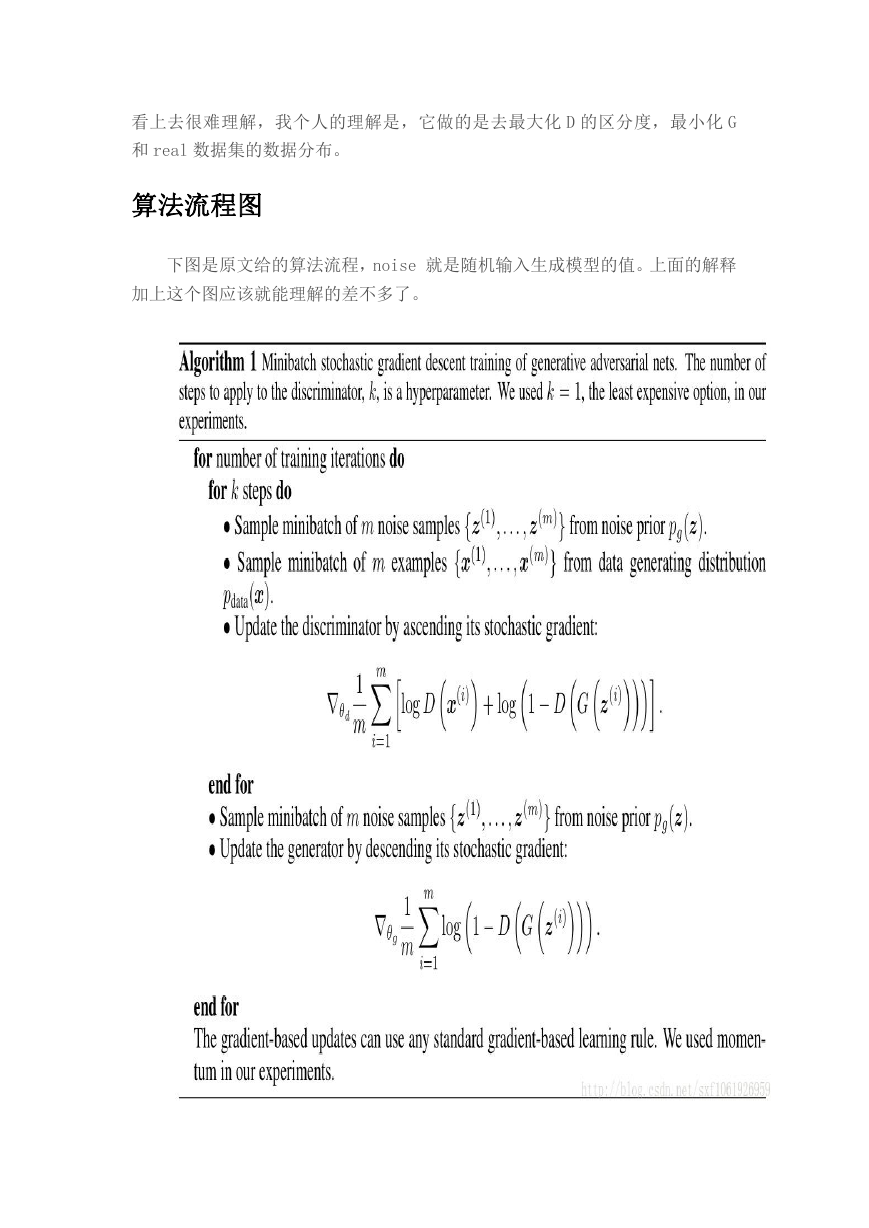

算法流程图

下图是原文给的算法流程,noise 就是随机输入生成模型的值。上面的解释

加上这个图应该就能理解的差不多了。

�

noise 输入的解释

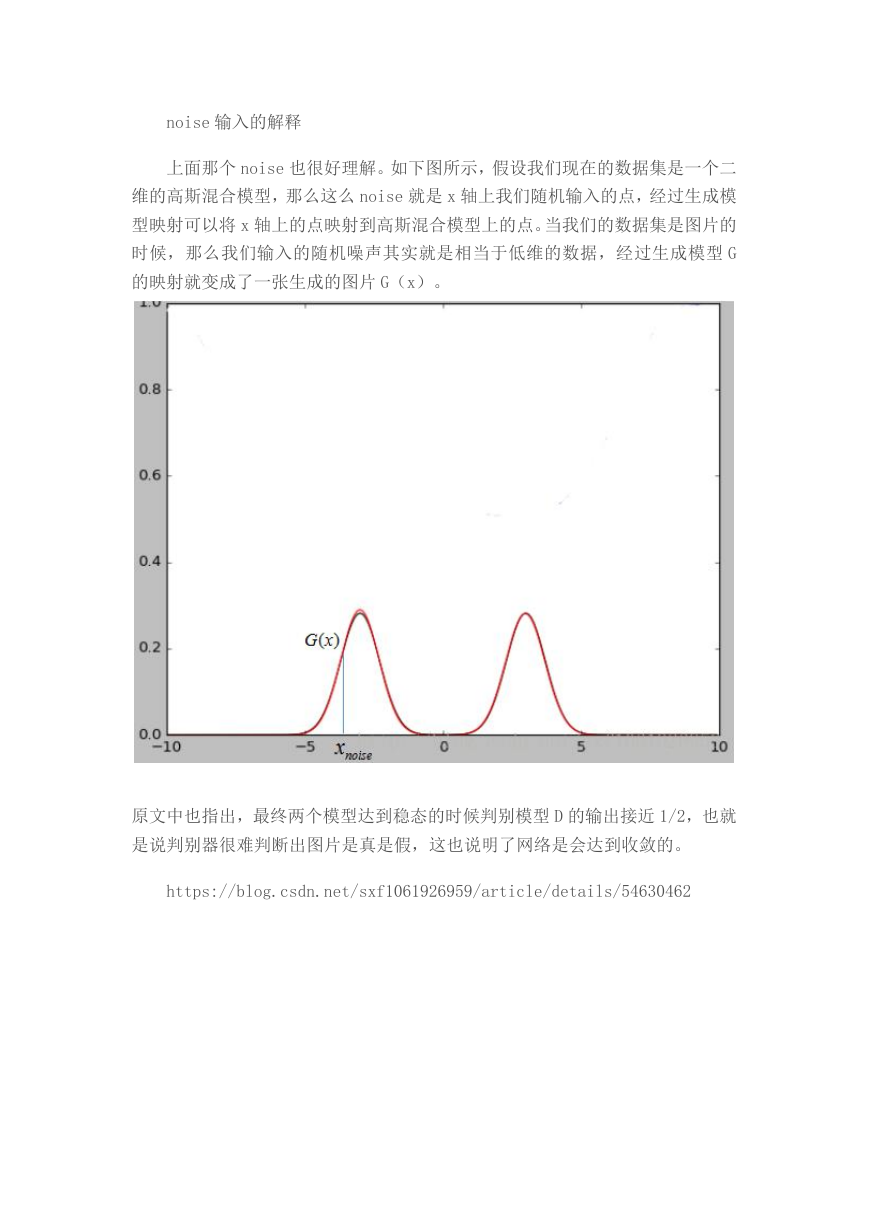

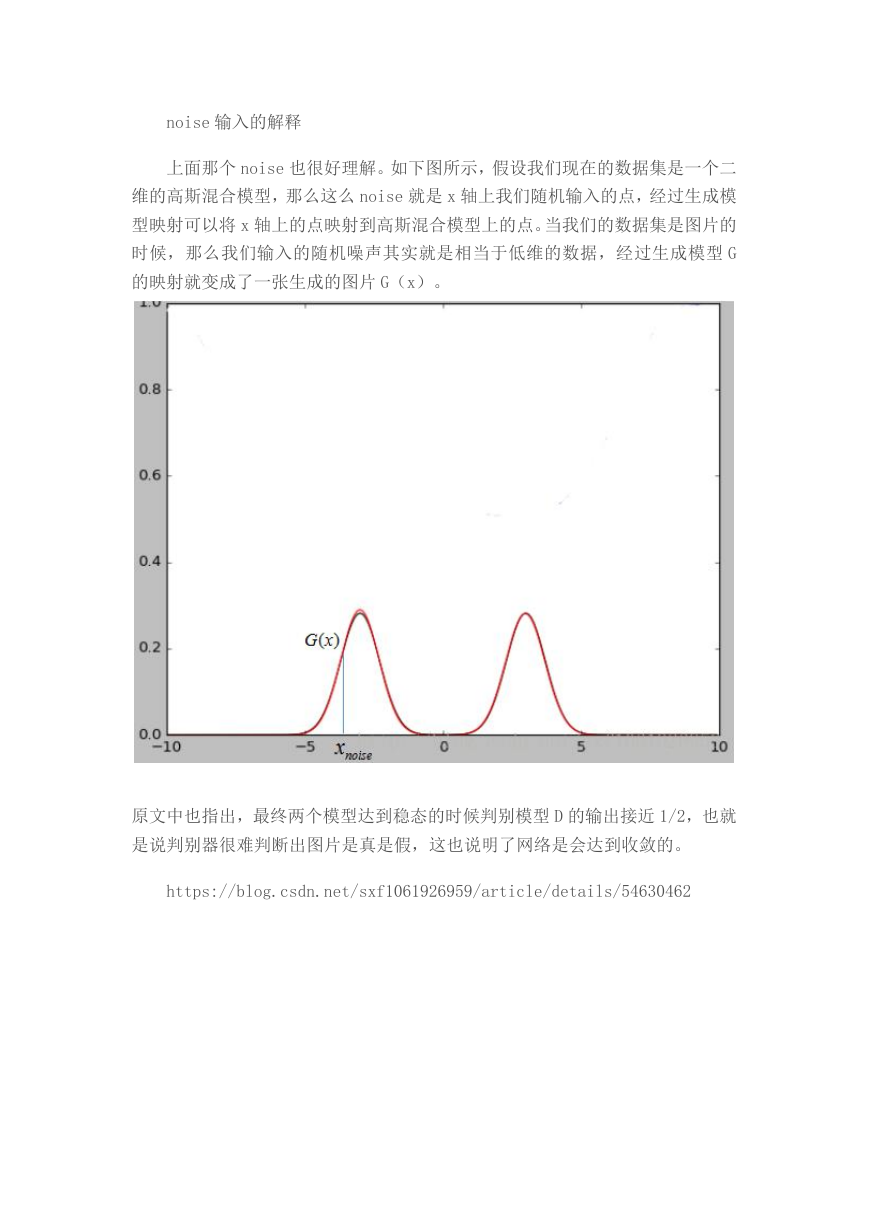

上面那个 noise 也很好理解。如下图所示,假设我们现在的数据集是一个二

维的高斯混合模型,那么这么 noise 就是 x 轴上我们随机输入的点,经过生成模

型映射可以将 x 轴上的点映射到高斯混合模型上的点。当我们的数据集是图片的

时候,那么我们输入的随机噪声其实就是相当于低维的数据,经过生成模型 G

的映射就变成了一张生成的图片 G(x)。

原文中也指出,最终两个模型达到稳态的时候判别模型 D 的输出接近 1/2,也就

是说判别器很难判断出图片是真是假,这也说明了网络是会达到收敛的。

https://blog.csdn.net/sxf1061926959/article/details/54630462

�

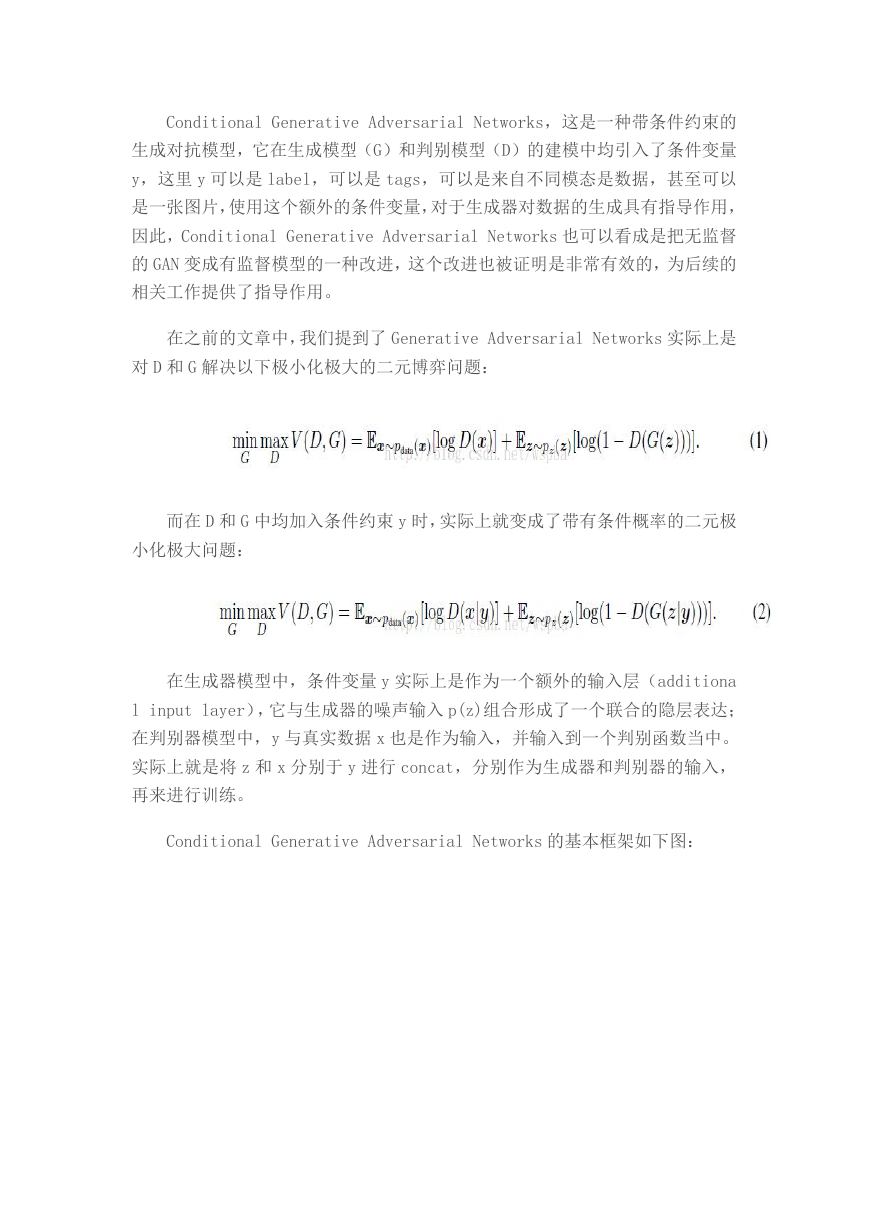

Conditional Generative Adversarial Networks,这是一种带条件约束的

生成对抗模型,它在生成模型(G)和判别模型(D)的建模中均引入了条件变量

y,这里 y 可以是 label,可以是 tags,可以是来自不同模态是数据,甚至可以

是一张图片,使用这个额外的条件变量,对于生成器对数据的生成具有指导作用,

因此,Conditional Generative Adversarial Networks 也可以看成是把无监督

的 GAN 变成有监督模型的一种改进,这个改进也被证明是非常有效的,为后续的

相关工作提供了指导作用。

在之前的文章中,我们提到了 Generative Adversarial Networks 实际上是

对 D 和 G 解决以下极小化极大的二元博弈问题:

而在 D 和 G 中均加入条件约束 y 时,实际上就变成了带有条件概率的二元极

小化极大问题:

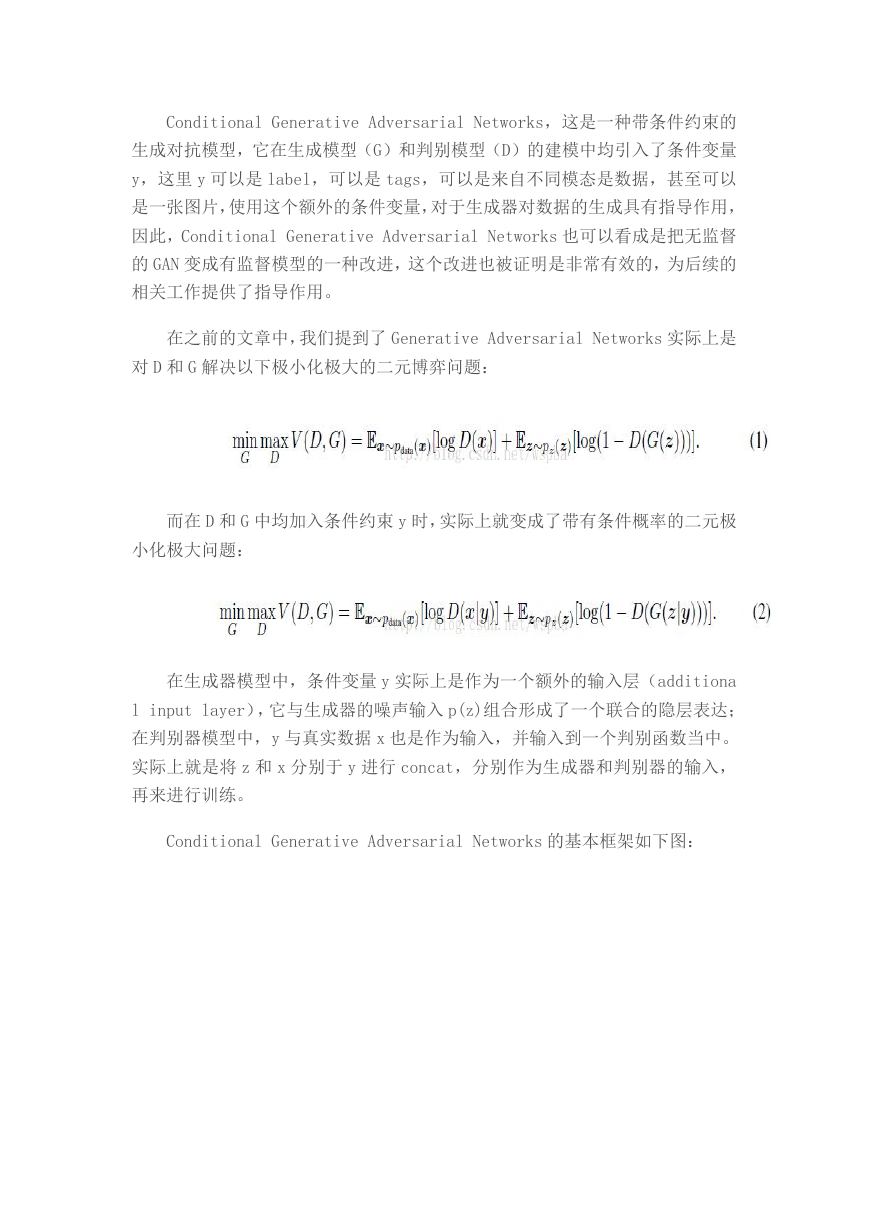

在生成器模型中,条件变量 y 实际上是作为一个额外的输入层(additiona

l input layer),它与生成器的噪声输入 p(z)组合形成了一个联合的隐层表达;

在判别器模型中,y 与真实数据 x 也是作为输入,并输入到一个判别函数当中。

实际上就是将 z 和 x 分别于 y 进行 concat,分别作为生成器和判别器的输入,

再来进行训练。

Conditional Generative Adversarial Networks 的基本框架如下图:

�

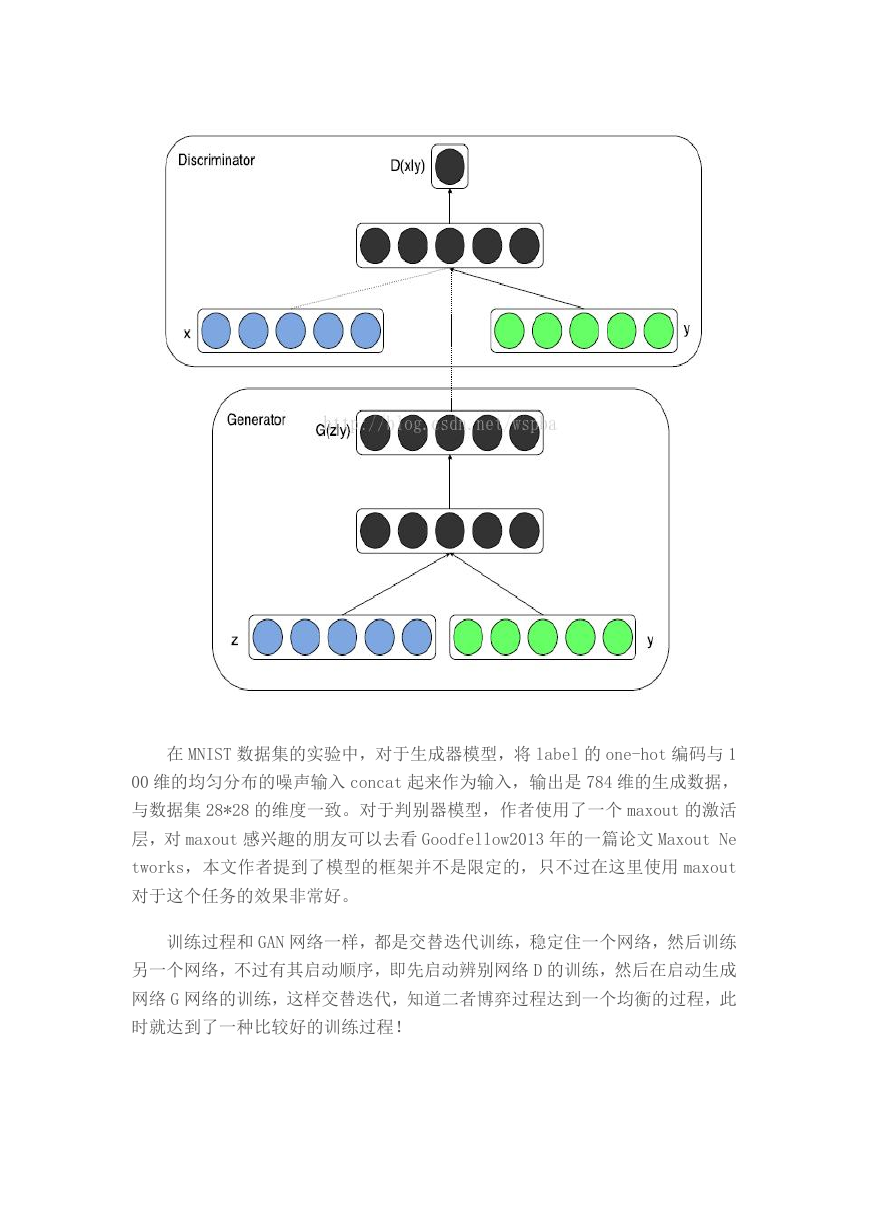

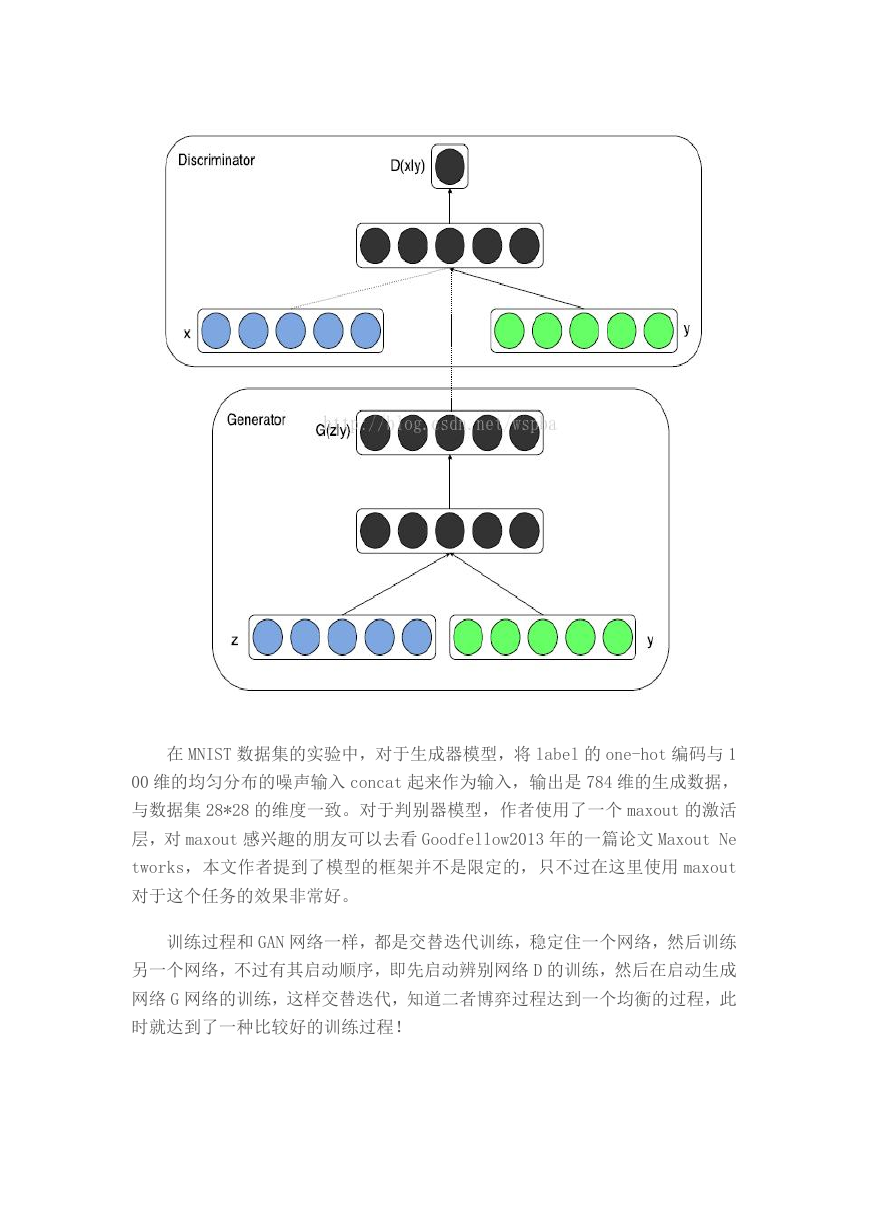

在 MNIST 数据集的实验中,对于生成器模型,将 label 的 one-hot 编码与 1

00 维的均匀分布的噪声输入 concat 起来作为输入,输出是 784 维的生成数据,

与数据集 28*28 的维度一致。对于判别器模型,作者使用了一个 maxout 的激活

层,对 maxout 感兴趣的朋友可以去看 Goodfellow2013 年的一篇论文 Maxout Ne

tworks,本文作者提到了模型的框架并不是限定的,只不过在这里使用 maxout

对于这个任务的效果非常好。

训练过程和 GAN 网络一样,都是交替迭代训练,稳定住一个网络,然后训练

另一个网络,不过有其启动顺序,即先启动辨别网络 D 的训练,然后在启动生成

网络 G 网络的训练,这样交替迭代,知道二者博弈过程达到一个均衡的过程,此

时就达到了一种比较好的训练过程!

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc