基于姿态估计的实时跌倒检测算法

于乃功, 柏德国

引用本文:

于乃功, 柏德国. 基于姿态估计的实时跌倒检测算法[J]. 控制与决策, 2020, 35(11): 2761-2766.

在线阅读 View online: https://doi.org/10.13195/j.kzyjc.2019.0382

您可能感兴趣的其他文章

Articles you may be interested in

基于强化学习的小型无人直升机有限时间收敛控制设计

Finite time control based on reinforcement learning for a small-size unmanned helicopter

控制与决策. 2020, 35(11): 2646-2652 https://doi.org/10.13195/j.kzyjc.2019.0328

基于行为流图的可信交互检测方法

Trustworthy interaction detection method based on user behavior flow diagram

控制与决策. 2020, 35(11): 2715-2722 https://doi.org/10.13195/j.kzyjc.2018.1618

基于不变网络模型和故障注入的分布式信息系统故障溯源方法

Fault source location algorithm for distributed information system based on invariant network and fault injection

控制与决策. 2020, 35(11): 2723-2732 https://doi.org/10.13195/j.kzyjc.2019.0214

一种新的基于标签传播的复杂网络重叠社区识别算法

A novel algorithm for overlapping community detection based on label propagation in complex networks

控制与决策. 2020, 35(11): 2733-2742 https://doi.org/10.13195/j.kzyjc.2019.0176

微型无人机集群低时延组网规划方法

A low delay networking planning method for micro UAV swarm

控制与决策. 2020, 35(11): 2696-2706 https://doi.org/10.13195/j.kzyjc.2018.1549

�

第 35 卷 第 11 期

2020 年 11月

控 制 与 决 策

Decision

Control

and

Vol.35 No.11

Nov. 2020

基于姿态估计的实时跌倒检测算法

于乃功y, 柏德国

(1. 北京工业大学 信息学部,北京 100124;2. 计算智能与智能系统北京重点

实验室,北京 100124;3. 数字社区教育部工程研究中心,北京 100124)

摘 要: 为了快速、准确地检测老年人跌倒事件的发生, 给出一种基于姿态估计的实时跌倒检测算法. 首先利用基

于深度学习的人体姿态估计算法得到人体关节点的坐标; 然后, 通过计算人体质心点的下降速度、跌倒后颈部关

节点的纵坐标值是否大于阈值、以及肩部和腰部关节点的相对位置关系来判断跌倒是否发生. 所给出的跌倒检测

算法利用单目相机进行检测, 便于以嵌入式方式应用于机器人. 实验结果表明, 所提出算法与当前先进方法相比

取得了较好的效果.

关键词: 跌倒实时检测;深度学习;人体姿态估计;单目相机;机器人;嵌入式

中图分类号: TP391

DOI: 10.13195/j.kzyjc.2019.0382

引用格式: 于乃功, 柏德国. 基于姿态估计的实时跌倒检测算法[J]. 控制与决策, 2020 , 35 (11 ): 2761-2766.

开放科学(资源服务) 标识码(OSID):

文献标志码: A

Real-time fall detection algorithm based on pose estimation

YU Nai-gongy, BAI De-guo

(1. Faculty of Information Technology,Beijing University of Technology,Beijing 100124,China;2. Beijing Key

Laboratory of Computational Intelligence and Intelligent System,Beijing 100124,China;3. Digital Community Ministry

of Education Engineering Research Center,Beijing 100124,China)

Abstract: In order to quickly and accurately detect the occurrence of falls in the elderly, this paper presents a real-time

fall detection algorithm based on pose estimation. Firstly, the human pose estimation algorithm based on deep learning

is used to obtain the coordinates of the joint point. Then, by calculating the falling speed of the centroid point when the

human body falls, whether the ordinate value of the neck joint point after the fall is greater than the threshold, and the

relative positional relationship of the shoulder-waist joint point in the image, whether the fall occurs is determined. The

algorithm uses a monocular camera to detect, which is easily used in an embedded way for robots. The experimental

results show that compared with the current advanced methods, the proposed algorithm has achieved good results.

Keywords: fall detection in real-time;deep learning;human pose estimation algorithm;monocular camera;robots;

embedding

0 言

在美国, 从 2007 年到 2016 年老年人因跌倒而死

亡的人数呈上升趋势, 并且在2016 年间, 年龄大于64

岁的美国老年人中有29 668 人因跌倒而死亡[1]. 在我

国, 2014 年全国伤害监测系统数据显示, 造成老年人

因非故意伤害就诊的首要原因是跌倒/坠落[2]. 如果

老年人跌倒后能够及时得到治疗, 则可以降低 80 %

的死亡风险和 26 % 的长期住院治疗风险[3], 所以根

据上述问题设计一套老年人跌倒实时检测系统很有

意义.

目前, 最常见的跌倒检测方法主要有 3 种: 基于

环境设备的检测方法、基于穿戴式传感器的检测方

法以及基于视觉识别的检测方法. 基于环境设备的

检测方法[4-6] 根据人体跌倒时形成的环境噪声进行

检测,这种方法通过感知物体压力和声音的变化检测

跌倒, 误报率较高, 实际生活中很少采用此方法. 基于

穿戴式传感器的方法[7-10] 利用加速度计和陀螺仪来

进行跌倒检测. 文献[9] 中利用加速度计和陀螺仪获

取信号, 通过SVM 分类器判断是否跌倒, 获得了93 %

的准确率. 文献 [11] 利用三轴加速度计获取信号, 通

过多种机器学习算法进行分类判断是否跌倒. 此方

法的缺点是长时间配戴传感器影响人的生活舒适度,

收稿日期: 2019-03-29;修回日期: 2019-07-27.

基金项目: 国家自然科学基金项目(61573029);国家重点研发计划项目(2017YFC0209905).

责任编委: 薛建儒.

y

通讯作者. E-mail: yunaigong@bjut.edu.cn.

�

2762

控 制 与 决 策

第35 卷

并且由于老年人记忆力不好容易忘记佩戴,从事复杂

活动时误报率较高. 基于视觉识别的检测方法从利

用传感器种类的角度可分为两类: 一类是使用 RGB

相机提供的二维信息进行检测[12-13]; 另一类使用深

度相机 Kinect 提供的骨架关节点[14-15] 进行检测. 文

献[16] 利用摄像头捕获视频, 然后通过帧差法、卡尔

曼滤波、光流法提取有效的背景信息并作为KNN 分

类器的输入, 实现了96 % 的精确率. 文献[17] 为了保

护老年人的隐私, 提出了一种光学匿名图像传感系

统,然后用卷积神经网络和自动编码器进行特征提取

和分类. 王君泽等[15] 利用 Kinect 提供的 6 个骨架点,

实时计算 6 个骨架点的空间位置等参数来判定人体

摔倒, 但相对于单目相机而言, 它的体积较大, 价格昂

贵,不适合嵌入式集成和批量使用.

当前,使机器人具备跌倒检测功能的研究工作较

少. 文献[18] 中利用电脑控制机器人并用Kinect 进行

跌倒检测, 精确率为80 %. 文献[19] 中利用单目相机

通过检测人体的外部轮廓获取轮廓比例,进行姿势标

注以判断跌倒事件的发生.

根据上述分析, 为了使跌倒检测方法具备实时

性, 并且做到跌倒检测设备能够嵌入式应用, 本文利

用普通单目相机, 从一个新的角度进行跌倒检测. 首

先利用人体姿态估计算法,实时计算得到人体的骨架

图和关节点坐标; 然后将得到的坐标结合提出的跌

倒检测算法进行检测. 实验结果表明了该方法的有

效性.

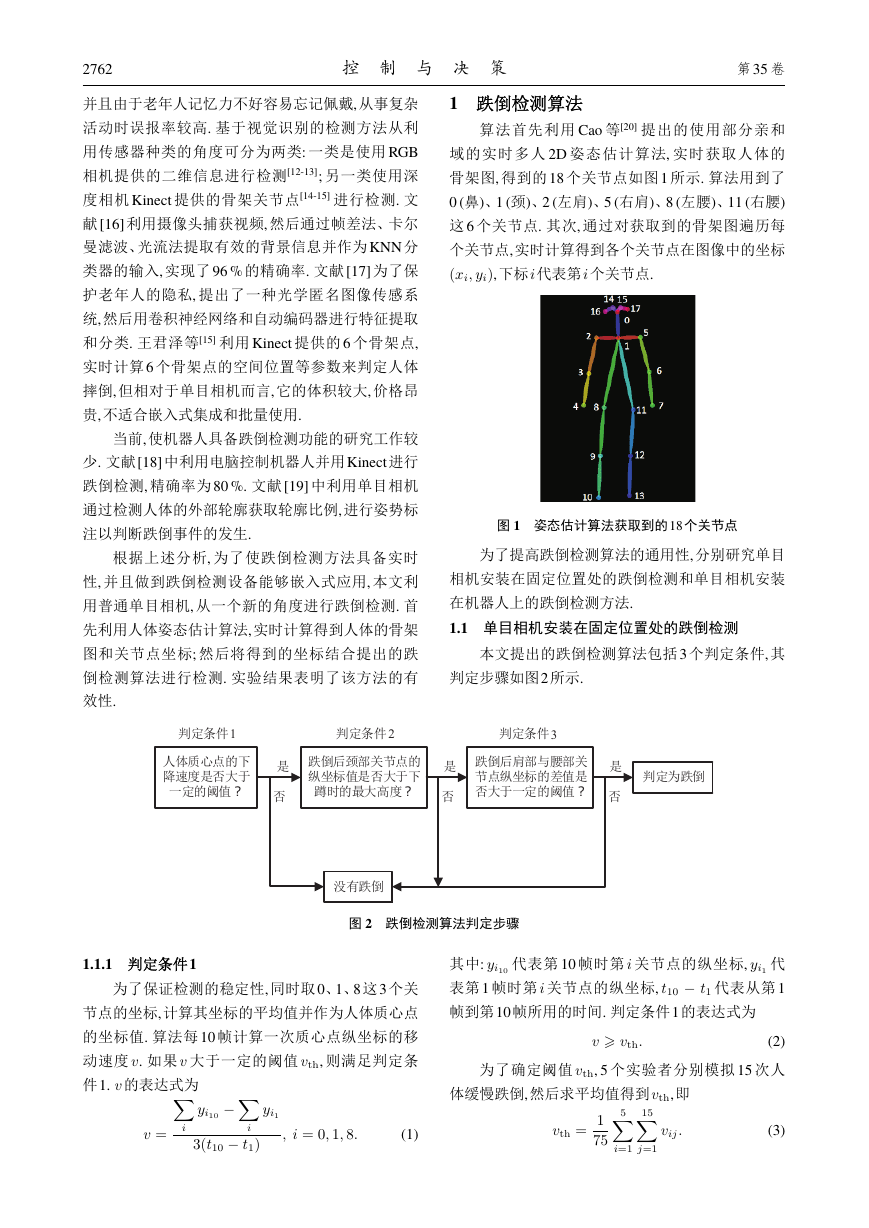

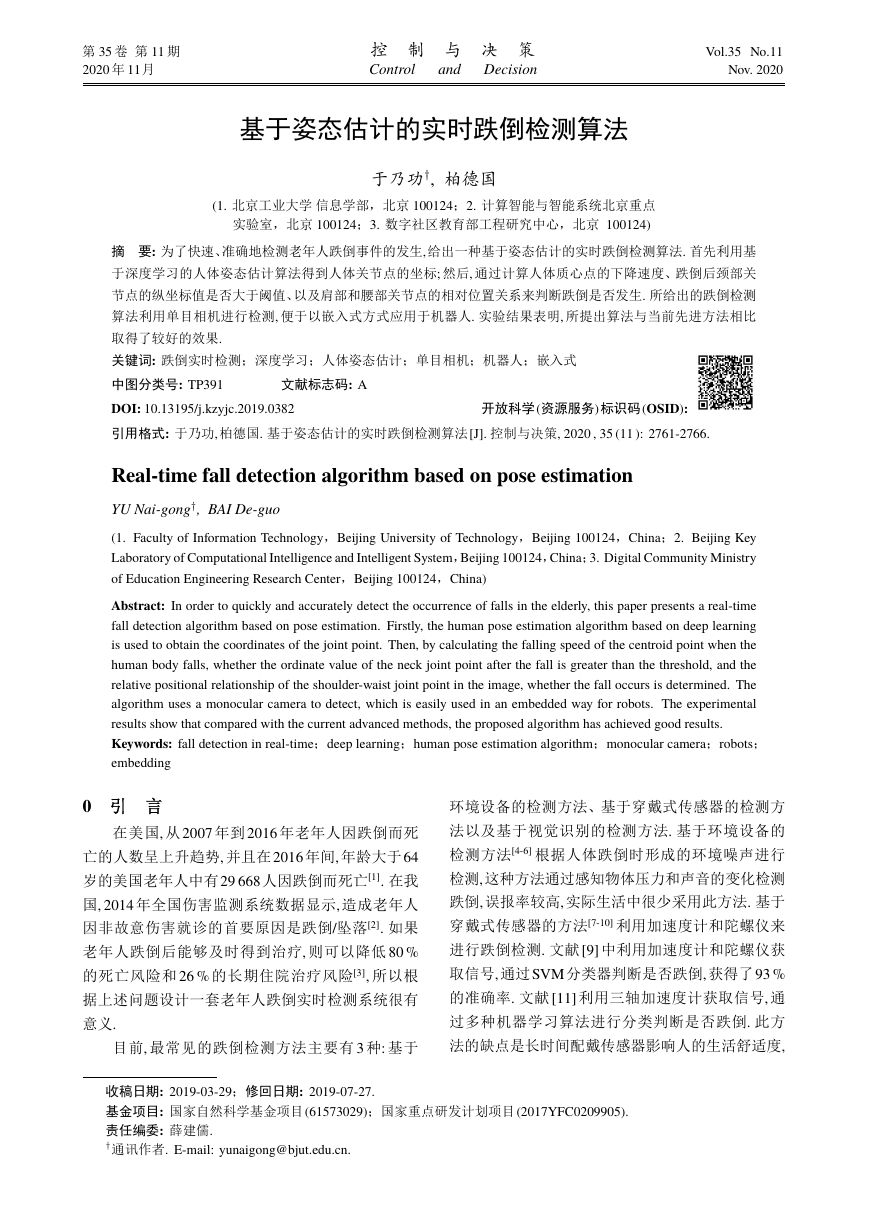

1 跌倒检测算法

算法首先利用 Cao 等[20] 提出的使用部分亲和

域的实时多人 2D 姿态估计算法, 实时获取人体的

骨架图, 得到的18 个关节点如图1 所示. 算法用到了

0 (鼻)、1 (颈)、2 (左肩)、5 (右肩)、8 (左腰)、11 (右腰)

这 6 个关节点. 其次, 通过对获取到的骨架图遍历每

个关节点,实时计算得到各个关节点在图像中的坐标

(xi; yi),下标i代表第i个关节点.

图 1 姿态估计算法获取到的18 个关节点

为了提高跌倒检测算法的通用性,分别研究单目

相机安装在固定位置处的跌倒检测和单目相机安装

在机器人上的跌倒检测方法.

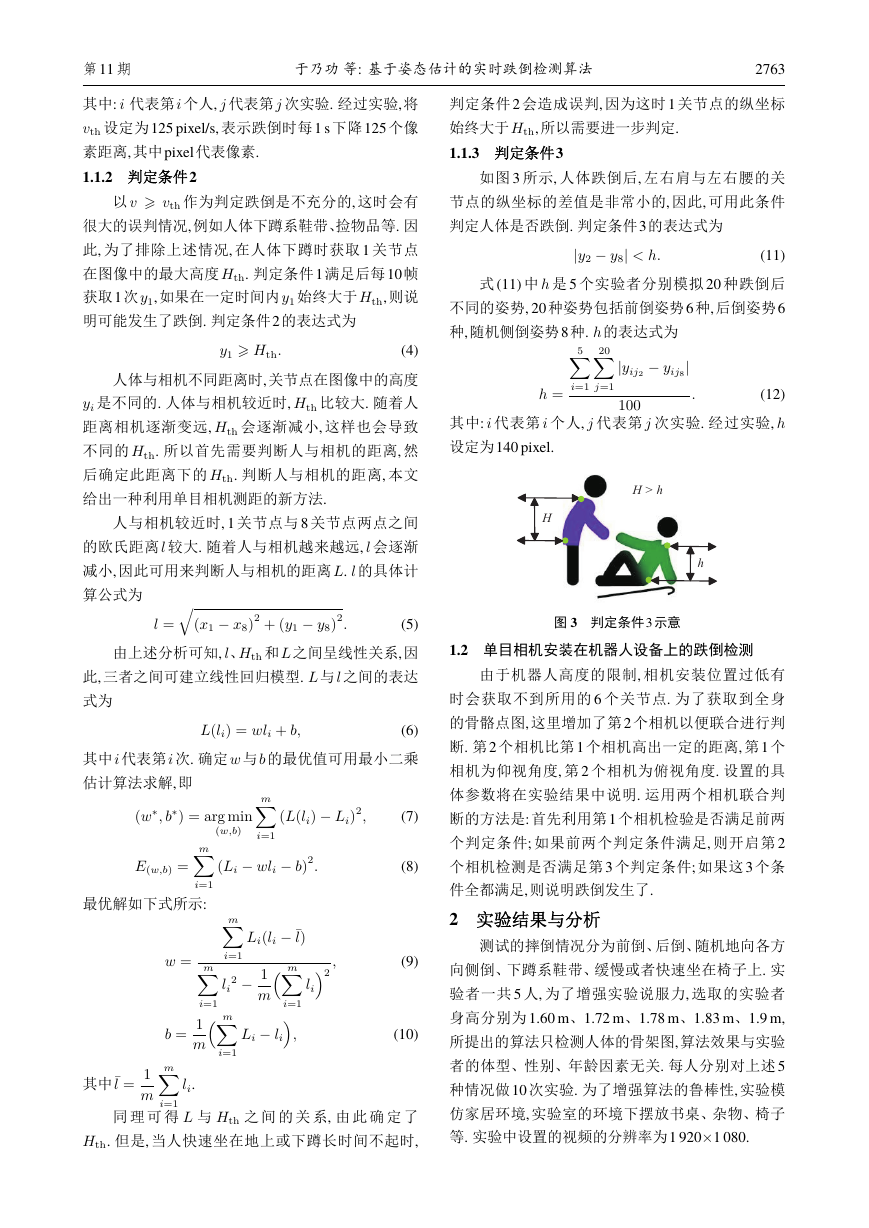

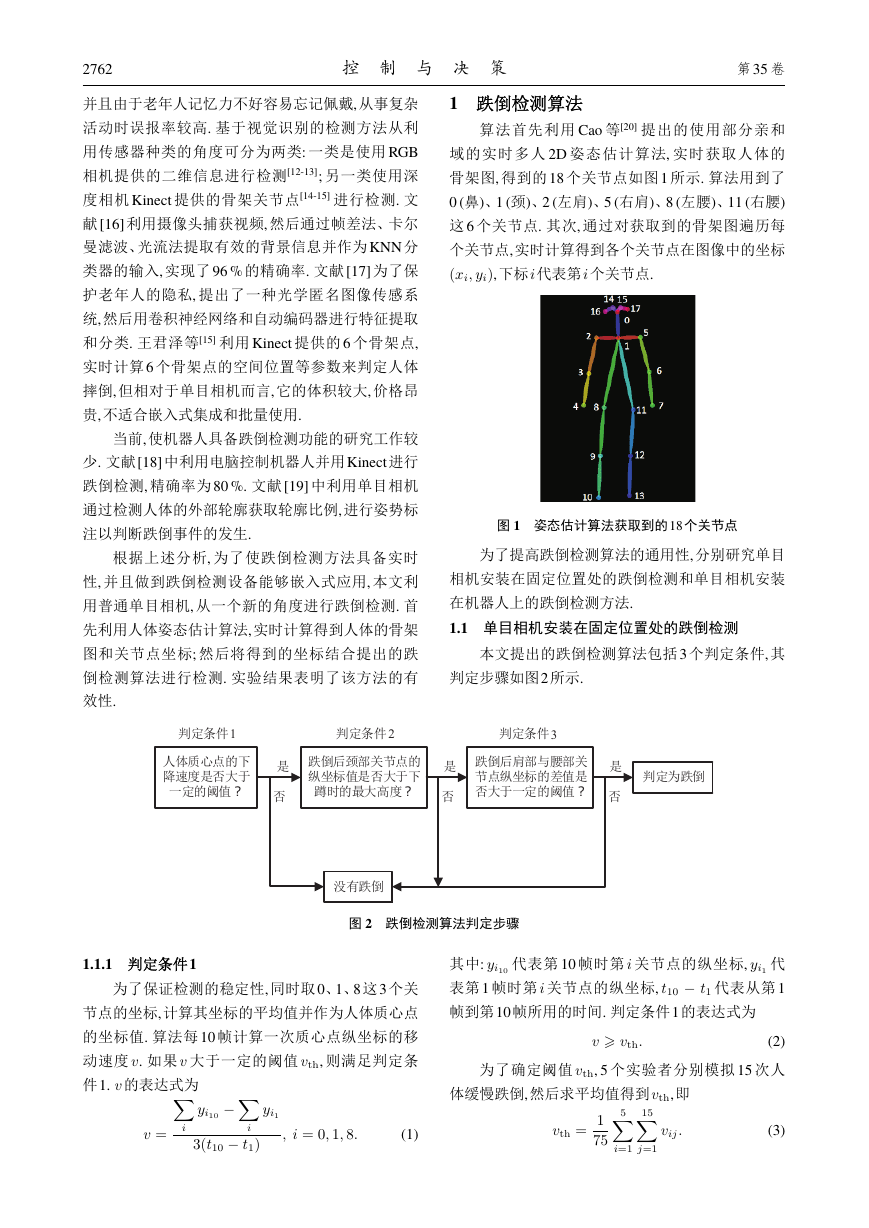

1.1 单目相机安装在固定位置处的跌倒检测

本文提出的跌倒检测算法包括3 个判定条件, 其

判定步骤如图2所示.

图 2 跌倒检测算法判定步骤

1.1.1 判定条件1

为了保证检测的稳定性, 同时取0、1、8 这3 个关

节点的坐标,计算其坐标的平均值并作为人体质心点

的坐标值. 算法每 10 帧计算一次质心点纵坐标的移

动速度 v. 如果 v 大于一定的阈值 vth, 则满足判定条

件1. v 的表达式为

∑

∑

yi10

3(t10 t1)

i

i

v =

yi1

; i = 0; 1; 8:

(1)

其中: yi10 代表第 10 帧时第 i 关节点的纵坐标, yi1 代

表第 1 帧时第 i 关节点的纵坐标, t10 t1 代表从第 1

帧到第10帧所用的时间. 判定条件1的表达式为

(2)

为了确定阈值 vth, 5 个实验者分别模拟 15 次人

v ⩾ vth:

体缓慢跌倒,然后求平均值得到vth,即

5∑

15∑

vth =

1

75

vij:

i=1

j=1

(3)

����FḄ�τ΅�ʖᔲᜧ���Ḅ█Ƿ?�᎔Ȝ⚠Zᐵ⁚FḄ�ᙶ᪗Ƿʖᔲᜧ���AḄᨬᜧ �?�᎔ȜPZ�ῪZᐵ⁚F�ᙶ᪗Ḅ�Ƿʖᔲᜧ���Ḅ█Ƿ?ᑨ���᎔�ᨵ�᎔ᑨ�ᩩ�1ᑨ�ᩩ�2ᑨ�ᩩ�3ʖᔲʖᔲᔲʖ�

第11 期

于乃功 等: 基于姿态估计的实时跌倒检测算法

2763

其中: i 代表第 i 个人, j 代表第 j 次实验. 经过实验, 将

vth 设定为125 pixel/s, 表示跌倒时每1 s 下降125 个像

素距离,其中pixel代表像素.

1.1.2 判定条件2

以 v ⩾ vth 作为判定跌倒是不充分的, 这时会有

很大的误判情况,例如人体下蹲系鞋带、捡物品等. 因

此, 为了排除上述情况, 在人体下蹲时获取 1 关节点

在图像中的最大高度 Hth. 判定条件1 满足后每10 帧

获取1 次 y1, 如果在一定时间内 y1 始终大于 Hth, 则说

明可能发生了跌倒. 判定条件2的表达式为

y1 ⩾ Hth:

(4)

人体与相机不同距离时,关节点在图像中的高度

yi 是不同的. 人体与相机较近时, Hth 比较大. 随着人

距离相机逐渐变远, Hth 会逐渐减小, 这样也会导致

不同的 Hth. 所以首先需要判断人与相机的距离, 然

后确定此距离下的 Hth. 判断人与相机的距离, 本文

给出一种利用单目相机测距的新方法.

人与相机较近时, 1 关节点与 8 关节点两点之间

的欧氏距离 l 较大. 随着人与相机越来越远, l 会逐渐

减小, 因此可用来判断人与相机的距离 L. l 的具体计

算公式为

√

(x1 x8)2 + (y1 y8)2:

(5)

由上述分析可知, l、Hth 和 L 之间呈线性关系, 因

此, 三者之间可建立线性回归模型. L 与 l 之间的表达

式为

l =

L(li) = wli + b;

(6)

其中 i 代表第 i 次. 确定 w 与 b 的最优值可用最小二乘

估计算法求解,即

m∑

; b

(w

) = arg min

(L(li) Li)2;

(7)

(8)

;

(9)

(10)

m∑

(w;b)

i=1

(Li wli b)2:

m∑

)2

li

i=1

m∑

( m∑

i=1

li

Li(li l)

( m∑

)

i=1

2 1

m

Li li

;

i=1

E(w;b) =

i=1

最优解如下式所示:

w =

1

m

b =

m∑

li.

i=1

其中l =

1

m

同 理 可 得 L 与 Hth 之 间 的 关 系, 由 此 确 定 了

Hth. 但是, 当人快速坐在地上或下蹲长时间不起时,

判定条件2 会造成误判, 因为这时1 关节点的纵坐标

始终大于Hth,所以需要进一步判定.

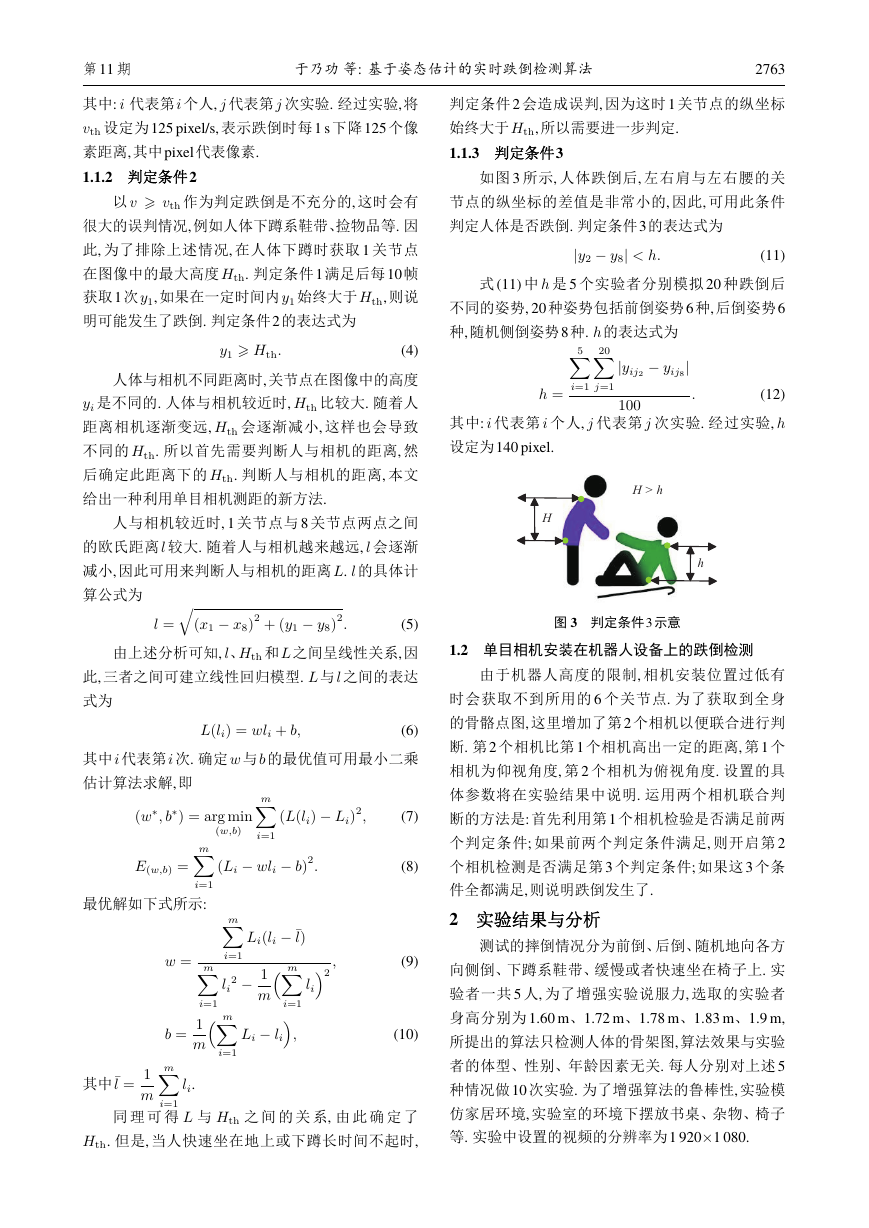

1.1.3 判定条件3

如图 3 所示, 人体跌倒后, 左右肩与左右腰的关

节点的纵坐标的差值是非常小的, 因此, 可用此条件

判定人体是否跌倒. 判定条件3的表达式为

jy2 y8j < h:

(11)

式 (11) 中 h 是 5 个实验者分别模拟 20 种跌倒后

不同的姿势, 20 种姿势包括前倒姿势6 种, 后倒姿势6

种,随机侧倒姿势8种. h的表达式为

yij8

5∑

20∑

jyij2

j

i=1

j=1

h =

(12)

其中: i 代表第 i 个人, j 代表第 j 次实验. 经过实验, h

设定为140 pixel.

100

:

图 3 判定条件3 示意

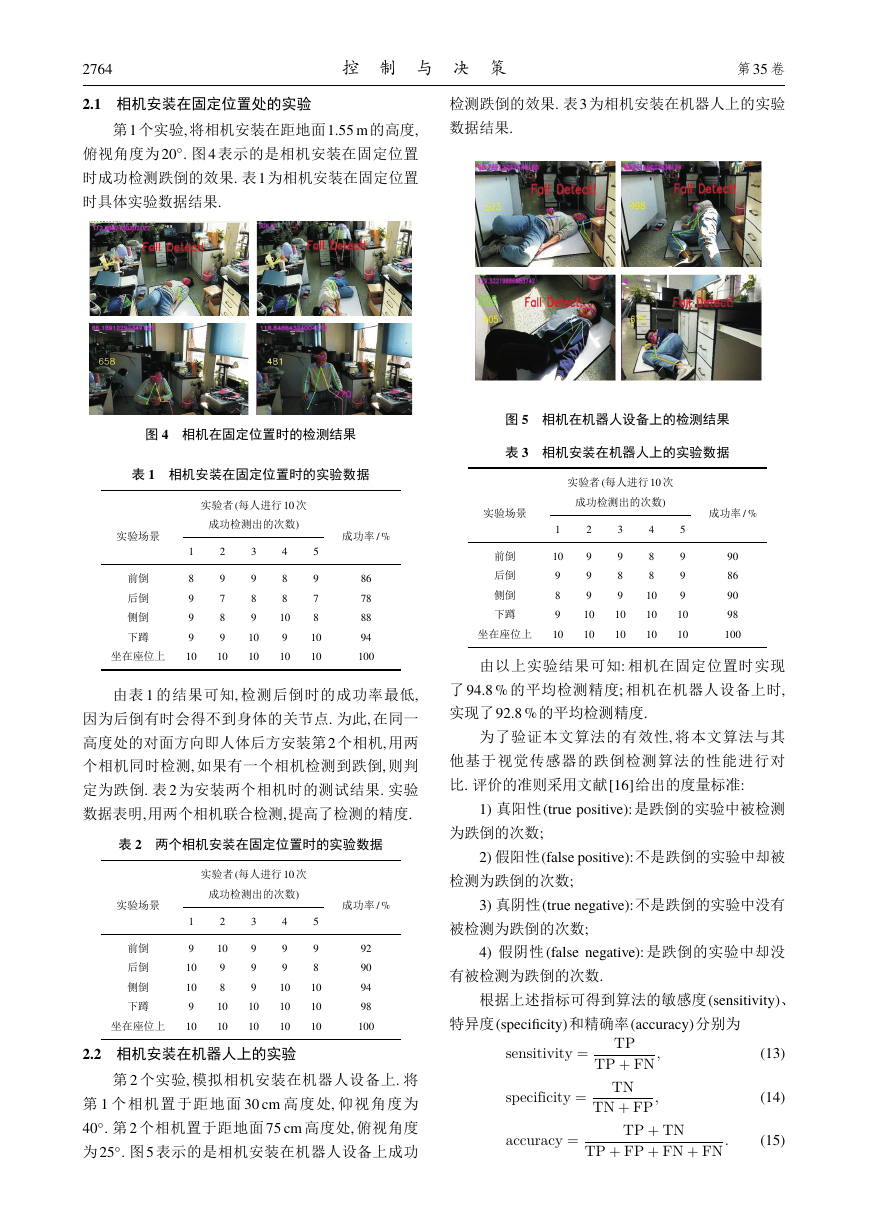

1.2 单目相机安装在机器人设备上的跌倒检测

由于机器人高度的限制, 相机安装位置过低有

时会获取不到所用的 6 个关节点. 为了获取到全身

的骨骼点图, 这里增加了第2 个相机以便联合进行判

断. 第2 个相机比第1 个相机高出一定的距离, 第1 个

相机为仰视角度, 第 2 个相机为俯视角度. 设置的具

体参数将在实验结果中说明. 运用两个相机联合判

断的方法是: 首先利用第1 个相机检验是否满足前两

个判定条件; 如果前两个判定条件满足, 则开启第 2

个相机检测是否满足第3 个判定条件; 如果这3 个条

件全都满足,则说明跌倒发生了.

2 实验结果与分析

测试的摔倒情况分为前倒、后倒、随机地向各方

向侧倒、下蹲系鞋带、缓慢或者快速坐在椅子上. 实

验者一共 5 人, 为了增强实验说服力, 选取的实验者

身高分别为 1.60 m、1.72 m、1.78 m、1.83 m、1.9 m,

所提出的算法只检测人体的骨架图,算法效果与实验

者的体型、性别、年龄因素无关. 每人分别对上述5

种情况做10 次实验. 为了增强算法的鲁棒性, 实验模

仿家居环境, 实验室的环境下摆放书桌、杂物、椅子

等. 实验中设置的视频的分辨率为1 9201 080.

HhH > h�

2764

控 制 与 决 策

第35 卷

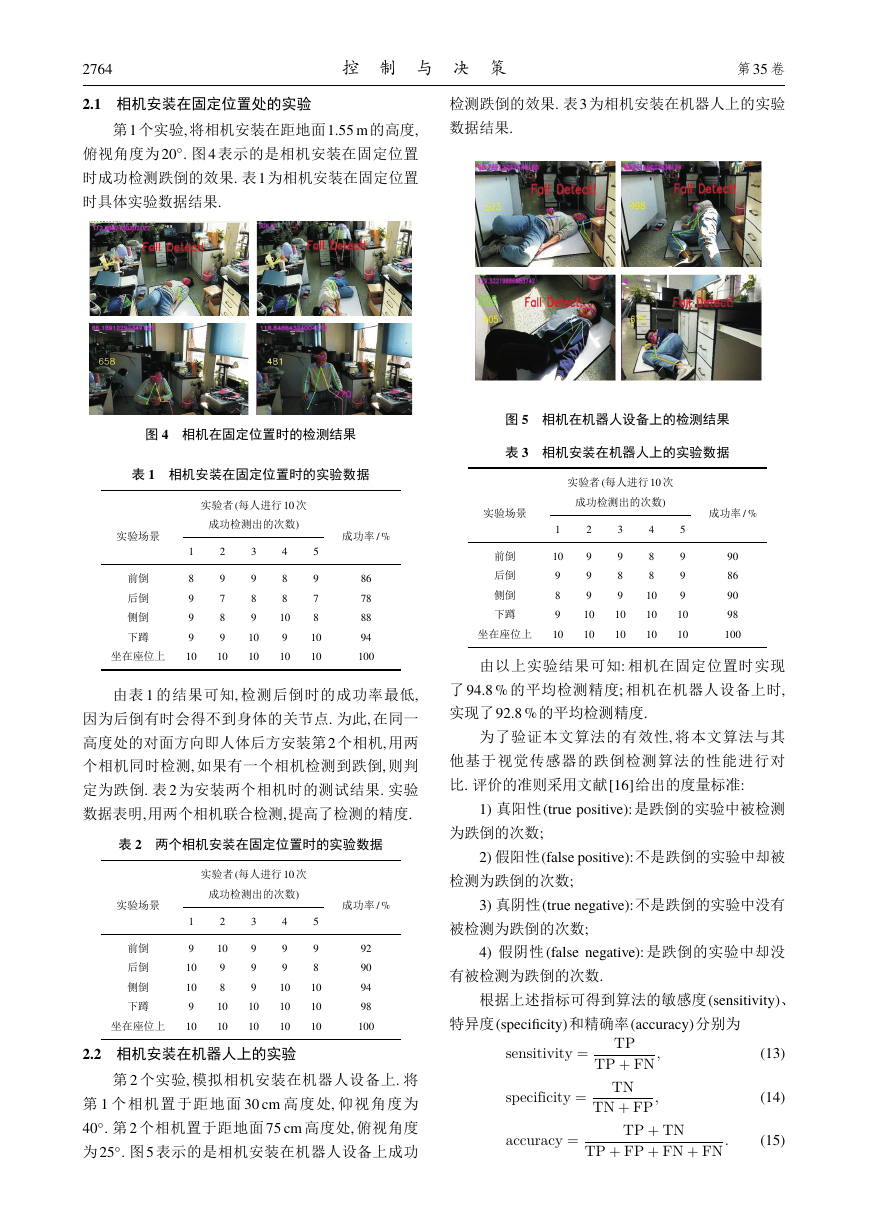

2.1 相机安装在固定位置处的实验

第1 个实验, 将相机安装在距地面1.55 m 的高度,

俯视角度为 20◦. 图4 表示的是相机安装在固定位置

时成功检测跌倒的效果. 表1 为相机安装在固定位置

时具体实验数据结果.

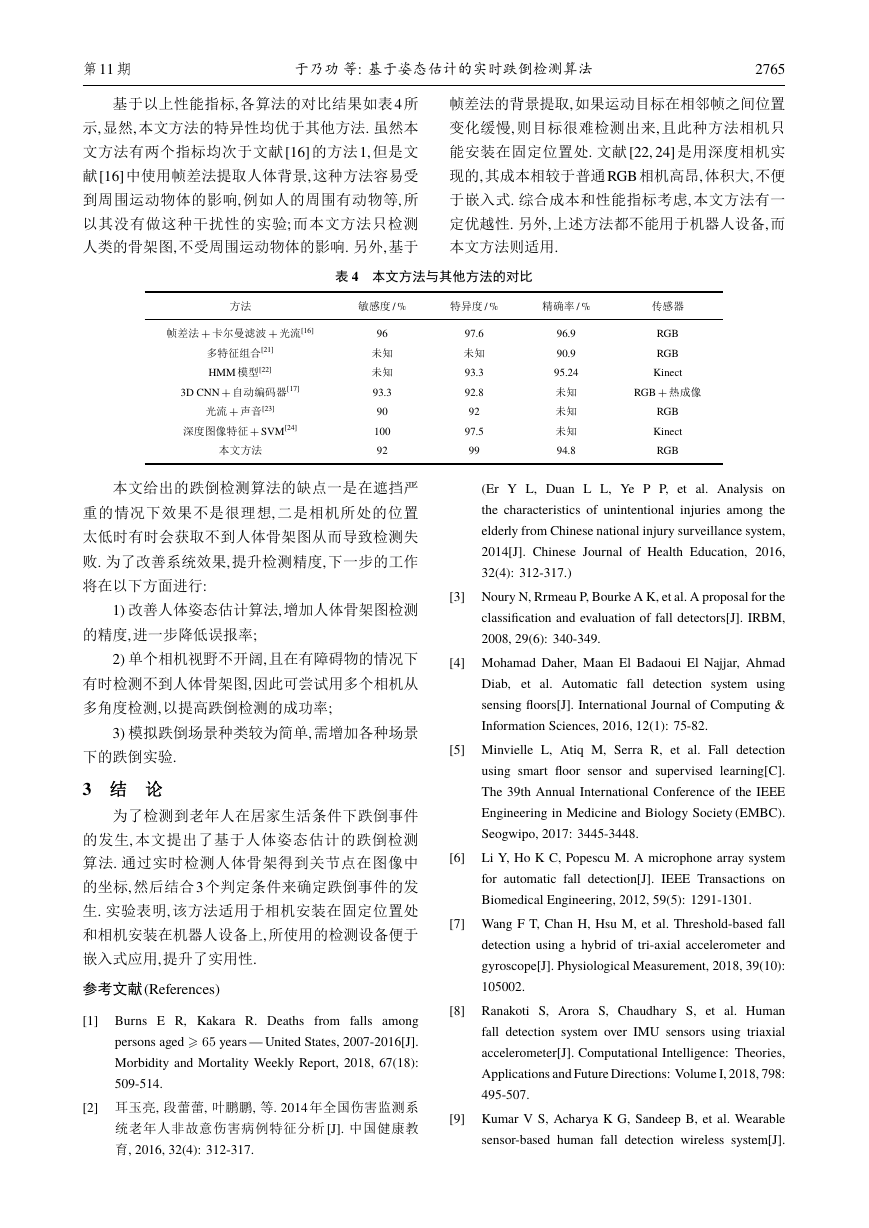

检测跌倒的效果. 表3 为相机安装在机器人上的实验

数据结果.

图 5 相机在机器人设备上的检测结果

表 3 相机安装在机器人上的实验数据

实验者(每人进行10 次

成功检测出的次数)

2

9

9

9

10

10

3

9

8

9

10

10

4

8

8

10

10

10

5

9

9

9

10

10

成功率 / %

90

86

90

98

100

实验场景

1

前倒

后倒

10

9

8

9

坐在座位上 10

侧倒

下蹲

由以上实验结果可知: 相机在固定位置时实现

了 94.8 % 的平均检测精度; 相机在机器人设备上时,

实现了92.8 %的平均检测精度.

为了验证本文算法的有效性, 将本文算法与其

他基于视觉传感器的跌倒检测算法的性能进行对

比. 评价的准则采用文献[16]给出的度量标准:

1) 真阳性(true positive): 是跌倒的实验中被检测

为跌倒的次数;

2) 假阳性(false positive):不是跌倒的实验中却被

检测为跌倒的次数;

成功率 / %

3) 真阴性(true negative):不是跌倒的实验中没有

图 4 相机在固定位置时的检测结果

表 1 相机安装在固定位置时的实验数据

实验者(每人进行10 次

成功检测出的次数)

2

9

7

8

9

10

3

9

8

9

10

10

4

8

8

10

9

10

5

9

7

8

10

10

成功率 / %

86

78

88

94

100

实验场景

1

后倒

前倒

8

9

9

9

坐在座位上 10

侧倒

下蹲

由表 1 的结果可知, 检测后倒时的成功率最低,

因为后倒有时会得不到身体的关节点. 为此, 在同一

高度处的对面方向即人体后方安装第2 个相机, 用两

个相机同时检测, 如果有一个相机检测到跌倒, 则判

定为跌倒. 表 2 为安装两个相机时的测试结果. 实验

数据表明,用两个相机联合检测,提高了检测的精度.

表 2 两个相机安装在固定位置时的实验数据

实验场景

实验者(每人进行10 次

成功检测出的次数)

1

2

3

4

侧倒

后倒

前倒

9

10

10

9

坐在座位上 10

9

9

10

10

10

2.2 相机安装在机器人上的实验

10

9

8

10

10

9

9

9

10

10

下蹲

5

9

8

10

10

10

92

90

94

98

100

第 2 个实验, 模拟相机安装在机器人设备上. 将

第 1 个相机置于距地面 30 cm 高度处, 仰视角度为

40◦. 第 2 个相机置于距地面 75 cm 高度处, 俯视角度

为25◦. 图5 表示的是相机安装在机器人设备上成功

被检测为跌倒的次数;

4) 假阴性 (false negative): 是跌倒的实验中却没

有被检测为跌倒的次数.

根据上述指标可得到算法的敏感度(sensitivity)、

特异度(specificity)和精确率(accuracy)分别为

sensitivity =

specificity =

TP

TP + FN ;

TN

TN + FP ;

accuracy =

TP + TN

TP + FP + FN + FN :

(13)

(14)

(15)

�

第11 期

于乃功 等: 基于姿态估计的实时跌倒检测算法

2765

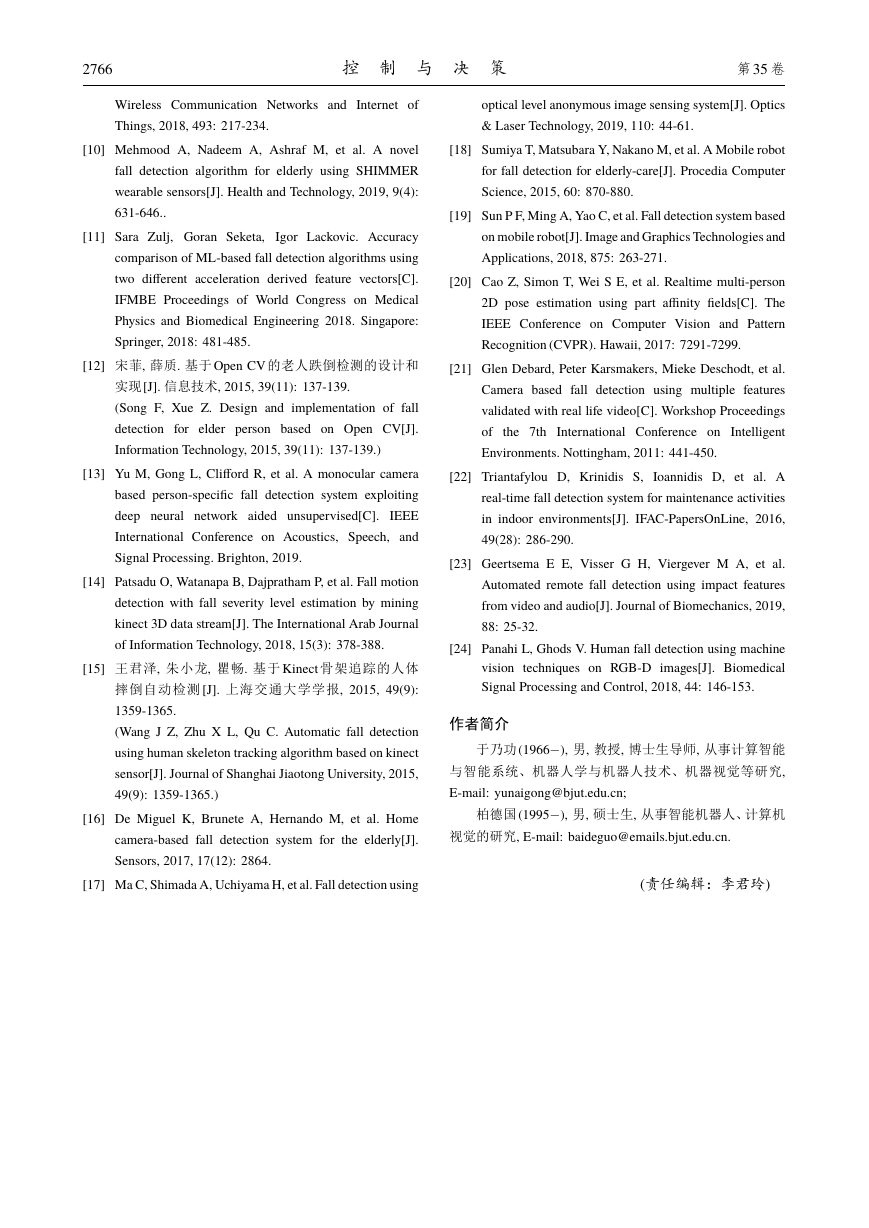

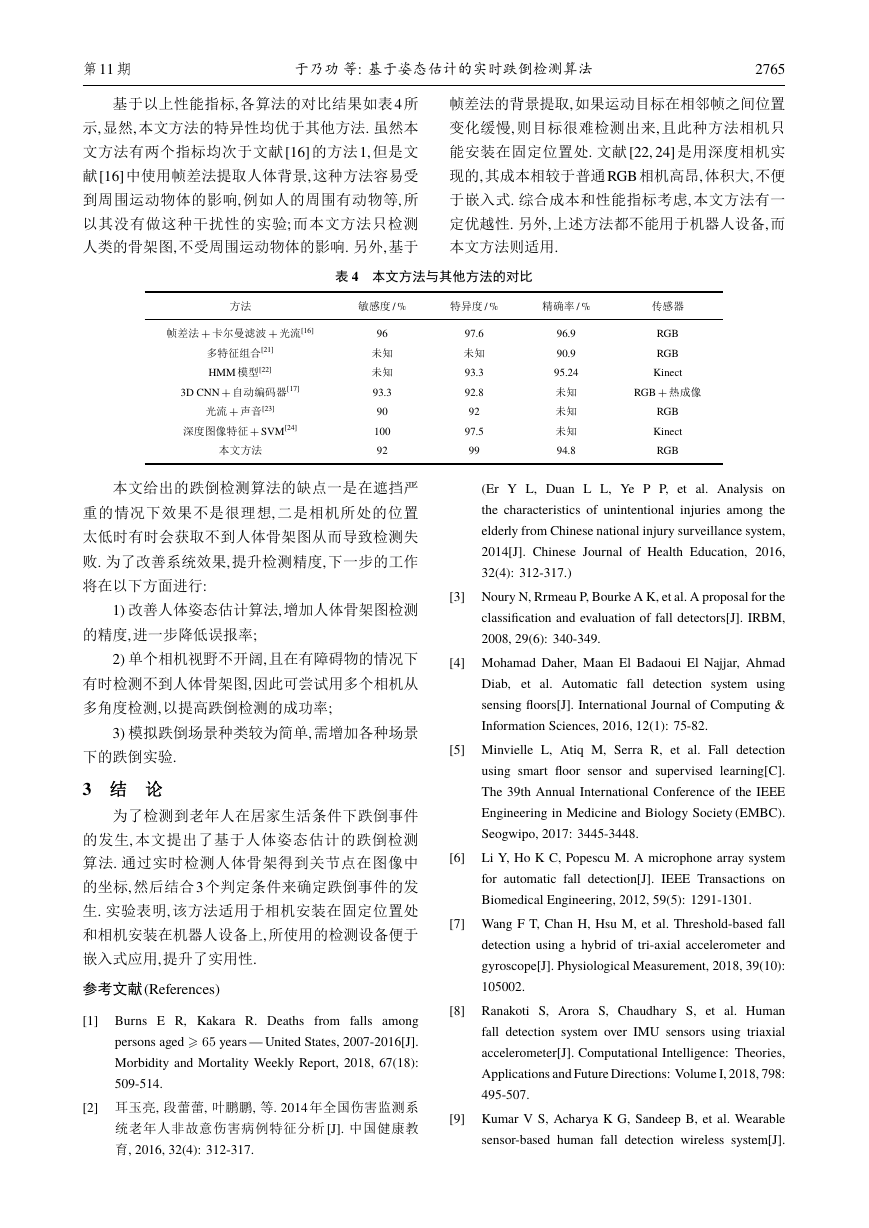

基于以上性能指标, 各算法的对比结果如表4 所

示, 显然, 本文方法的特异性均优于其他方法. 虽然本

文方法有两个指标均次于文献[16] 的方法1, 但是文

献[16] 中使用帧差法提取人体背景, 这种方法容易受

到周围运动物体的影响, 例如人的周围有动物等, 所

以其没有做这种干扰性的实验; 而本文方法只检测

人类的骨架图, 不受周围运动物体的影响. 另外, 基于

帧差法的背景提取,如果运动目标在相邻帧之间位置

变化缓慢, 则目标很难检测出来, 且此种方法相机只

能安装在固定位置处. 文献[22, 24] 是用深度相机实

现的, 其成本相较于普通RGB 相机高昂, 体积大, 不便

于嵌入式. 综合成本和性能指标考虑, 本文方法有一

定优越性. 另外, 上述方法都不能用于机器人设备, 而

本文方法则适用.

表 4 本文方法与其他方法的对比

方法

敏感度 / %

特异度 / %

精确率 / %

帧差法 + 卡尔曼滤波 + 光流[16]

多特征组合[21]

HMM 模型[22]

3D CNN + 自动编码器[17]

光流 + 声音[23]

深度图像特征 + SVM[24]

本文方法

96

未知

未知

93.3

90

100

92

97.6

未知

93.3

92.8

92

97.5

99

96.9

90.9

95.24

未知

未知

未知

94.8

传感器

RGB

RGB

Kinect

RGB + 热成像

RGB

Kinect

RGB

本文给出的跌倒检测算法的缺点一是在遮挡严

重的情况下效果不是很理想, 二是相机所处的位置

太低时有时会获取不到人体骨架图从而导致检测失

败. 为了改善系统效果, 提升检测精度, 下一步的工作

将在以下方面进行:

1) 改善人体姿态估计算法,增加人体骨架图检测

的精度,进一步降低误报率;

2) 单个相机视野不开阔,且在有障碍物的情况下

有时检测不到人体骨架图,因此可尝试用多个相机从

多角度检测,以提高跌倒检测的成功率;

3) 模拟跌倒场景种类较为简单,需增加各种场景

下的跌倒实验.

3 结

为了检测到老年人在居家生活条件下跌倒事件

的发生, 本文提出了基于人体姿态估计的跌倒检测

算法. 通过实时检测人体骨架得到关节点在图像中

的坐标, 然后结合3 个判定条件来确定跌倒事件的发

生. 实验表明, 该方法适用于相机安装在固定位置处

和相机安装在机器人设备上,所使用的检测设备便于

嵌入式应用,提升了实用性.

参考文献(References)

[1] Burns E R, Kakara R. Deaths from falls among

persons aged ⩾ 65 years — United States, 2007-2016[J].

Morbidity and Mortality Weekly Report, 2018, 67(18):

509-514.

[2] 耳玉亮, 段蕾蕾, 叶鹏鹏, 等. 2014 年全国伤害监测系

统老年人非故意伤害病例特征分析 [J]. 中国健康教

育, 2016, 32(4): 312-317.

(Er Y L, Duan L L, Ye P P, et al. Analysis on

the characteristics of unintentional injuries among the

elderly from Chinese national injury surveillance system,

2014[J]. Chinese Journal of Health Education, 2016,

32(4): 312-317.)

[3] Noury N, Rrmeau P, Bourke A K, et al. A proposal for the

classification and evaluation of fall detectors[J]. IRBM,

2008, 29(6): 340-349.

[4] Mohamad Daher, Maan El Badaoui El Najjar, Ahmad

Diab, et al. Automatic fall detection system using

sensing floors[J]. International Journal of Computing &

Information Sciences, 2016, 12(1): 75-82.

[5] Minvielle L, Atiq M, Serra R, et al. Fall detection

using smart floor sensor and supervised learning[C].

The 39th Annual International Conference of the IEEE

Engineering in Medicine and Biology Society (EMBC).

Seogwipo, 2017: 3445-3448.

Li Y, Ho K C, Popescu M. A microphone array system

for automatic fall detection[J]. IEEE Transactions on

Biomedical Engineering, 2012, 59(5): 1291-1301.

[6]

[7] Wang F T, Chan H, Hsu M, et al. Threshold-based fall

detection using a hybrid of tri-axial accelerometer and

gyroscope[J]. Physiological Measurement, 2018, 39(10):

105002.

[8] Ranakoti S, Arora S, Chaudhary S, et al. Human

fall detection system over IMU sensors using triaxial

accelerometer[J]. Computational Intelligence: Theories,

Applications and Future Directions: Volume I, 2018, 798:

495-507.

[9] Kumar V S, Acharya K G, Sandeep B, et al. Wearable

sensor-based human fall detection wireless system[J].

�

2766

控 制 与 决 策

第35 卷

Wireless Communication Networks and Internet of

Things, 2018, 493: 217-234.

optical level anonymous image sensing system[J]. Optics

& Laser Technology, 2019, 110: 44-61.

[10] Mehmood A, Nadeem A, Ashraf M, et al. A novel

fall detection algorithm for elderly using SHIMMER

wearable sensors[J]. Health and Technology, 2019, 9(4):

631-646..

[11] Sara Zulj, Goran Seketa,

Igor Lackovic. Accuracy

comparison of ML-based fall detection algorithms using

two different acceleration derived feature vectors[C].

IFMBE Proceedings of World Congress on Medical

Physics and Biomedical Engineering 2018. Singapore:

Springer, 2018: 481-485.

[12] 宋菲, 薛质. 基于Open CV 的老人跌倒检测的设计和

实现[J]. 信息技术, 2015, 39(11): 137-139.

(Song F, Xue Z. Design and implementation of fall

detection for elder person based on Open CV[J].

Information Technology, 2015, 39(11): 137-139.)

[13] Yu M, Gong L, Clifford R, et al. A monocular camera

based person-specific fall detection system exploiting

deep neural network aided unsupervised[C].

IEEE

International Conference on Acoustics, Speech, and

Signal Processing. Brighton, 2019.

[14] Patsadu O, Watanapa B, Dajpratham P, et al. Fall motion

detection with fall severity level estimation by mining

kinect 3D data stream[J]. The International Arab Journal

of Information Technology, 2018, 15(3): 378-388.

[15] 王君泽, 朱小龙, 瞿畅. 基于 Kinect 骨架追踪的人体

摔倒自动检测 [J]. 上海交通大学学报, 2015, 49(9):

1359-1365.

(Wang J Z, Zhu X L, Qu C. Automatic fall detection

using human skeleton tracking algorithm based on kinect

sensor[J]. Journal of Shanghai Jiaotong University, 2015,

49(9): 1359-1365.)

[16] De Miguel K, Brunete A, Hernando M, et al. Home

camera-based fall detection system for the elderly[J].

Sensors, 2017, 17(12): 2864.

[17] Ma C, Shimada A, Uchiyama H, et al. Fall detection using

[18] Sumiya T, Matsubara Y, Nakano M, et al. A Mobile robot

for fall detection for elderly-care[J]. Procedia Computer

Science, 2015, 60: 870-880.

[19] Sun P F, Ming A, Yao C, et al. Fall detection system based

on mobile robot[J]. Image and Graphics Technologies and

Applications, 2018, 875: 263-271.

[20] Cao Z, Simon T, Wei S E, et al. Realtime multi-person

2D pose estimation using part affinity fields[C]. The

IEEE Conference on Computer Vision and Pattern

Recognition (CVPR). Hawaii, 2017: 7291-7299.

[21] Glen Debard, Peter Karsmakers, Mieke Deschodt, et al.

Camera based fall detection using multiple features

validated with real life video[C]. Workshop Proceedings

of

the 7th International Conference on Intelligent

Environments. Nottingham, 2011: 441-450.

[22] Triantafylou D, Krinidis S,

Ioannidis D, et al. A

real-time fall detection system for maintenance activities

in indoor environments[J]. IFAC-PapersOnLine, 2016,

49(28): 286-290.

[23] Geertsema E E, Visser G H, Viergever M A, et al.

Automated remote fall detection using impact features

from video and audio[J]. Journal of Biomechanics, 2019,

88: 25-32.

[24] Panahi L, Ghods V. Human fall detection using machine

vision techniques on RGB-D images[J]. Biomedical

Signal Processing and Control, 2018, 44: 146-153.

作者简介

于乃功(1966), 男, 教授, 博士生导师, 从事计算智能

与智能系统、机器人学与机器人技术、机器视觉等研究,

E-mail: yunaigong@bjut.edu.cn;

柏德国(1995), 男, 硕士生, 从事智能机器人、计算机

视觉的研究, E-mail: baideguo@emails.bjut.edu.cn.

(责任编辑:李君玲)

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc