多模态情绪识别研究综述

潘家辉, 何志鹏, 李自娜, 梁艳, 邱丽娜

引用本文:

潘家辉, 何志鹏, 李自娜, 等. 多模态情绪识别研究综述[J]. 智能系统学报, 2020, 15(4): 633-645.

PAN Jiahui, HE Zhipeng, LI Zina, et al. A review of multimodal emotion recognition[J]. CAAI Transactions on Intelligent Systems,

2020, 15(4): 633-645.

在线阅读 View online: https://dx.doi.org/10.11992/tis.202001032

您可能感兴趣的其他文章

面向自动驾驶目标检测的深度多模态融合技术

Deep multi-modal fusion in object detection for autonomous driving

智能系统学报. 2020, 15(4): 758-771 https://dx.doi.org/10.11992/tis.202002010

基于级联宽度学习的多模态材质识别

Cascade broad learning for multi-modal material recognition

智能系统学报. 2020, 15(4): 787-794 https://dx.doi.org/10.11992/tis.201908021

语音情感识别研究综述

Review on speech emotion recognition research

智能系统学报. 2020, 15(1): 1-13 https://dx.doi.org/10.11992/tis.201904065

基于序列模型的音乐词曲匹配度智能评估算法

Music lyrics-melody intelligent evaluation algorithm based on sequence model

智能系统学报. 2020, 15(1): 67-73 https://dx.doi.org/10.11992/tis.202001006

触觉手势情感识别的超限学习方法

Extreme learning machine for emotion recognition of tactile gestures

智能系统学报. 2019, 14(1): 127-133 https://dx.doi.org/10.11992/tis.201804029

一种基于OCC模型的文本情感挖掘方法

OCC-model-based text-emotion mining method

智能系统学报. 2017, 12(5): 645-652 https://dx.doi.org/10.11992/tis.201312032

�

第 15 卷第 4 期

2020 年 7 月

智 能 系 统 学 报

CAAI Transactions on Intelligent Systems

Vol.15 No.4

Jul. 2020

DOI: 10.11992/tis.202001032

多模态情绪识别研究综述

潘家辉1,何志鹏1,李自娜2,梁艳1,邱丽娜1

(1. 华南师范大学 软件学院,广东 佛山 528225; 2. 华南师范大学 计算机学院,广东 广州 510641)

摘 要:本文针对多模态情绪识别这一新兴领域进行综述。首先从情绪描述模型及情绪诱发方式两个方面对

情绪识别的研究基础进行了综述。接着针对多模态情绪识别中的信息融合这一重难点问题,从数据级融合、特

征级融合、决策级融合、模型级融合4种融合层次下的主流高效信息融合策略进行了介绍。然后从多种行为表

现模态混合、多神经生理模态混合、神经生理与行为表现模态混合这3个角度分别列举具有代表性的多模态混

合实例,全面合理地论证了多模态相较于单模态更具情绪区分能力和情绪表征能力,同时对多模态情绪识别方

法转为工程技术应用提出了一些思考。最后立足于情绪识别研究现状的分析和把握,对改善和提升情绪识别

模型性能的方式和策略进行了深入的探讨与展望。

关键词:情绪识别;情绪描述模型;情绪诱发方式;信息融合;融合策略;情绪表征;模态混合

中图分类号:TP391.4 文献标志码:A 文章编号:1673−4785(2020)04−0633−13

中文引用格式:潘家辉, 何志鹏, 李自娜, 等. 多模态情绪识别研究综述[J]. 智能系统学报, 2020, 15(4): 633–645.

英文引用格式:PAN Jiahui, HE Zhipeng, LI Zina, et al. A review of multimodal emotion recognition[J]. CAAI transactions on in-

telligent systems, 2020, 15(4): 633–645.

A review of multimodal emotion recognition

PAN Jiahui1,HE Zhipeng1,LI Zina2,LIANG Yan1,QIU Lina1

(1. School of Software, South China Normal University, Foshan 528225, China; 2. School of Computer, South China Normal Uni-

versity, Guangzhou 510641, China)

Abstract: This paper reviews the emerging field of multimodal emotion recognition. Firstly, the research foundation of

emotion recognition is summarized from two aspects: emotion description model and emotion-inducing mode. Then,

aiming at the key and difficult problem of information fusion in multi-modal emotion recognition, some mainstream and

high-efficiency information fusion strategies are introduced from four fusion levels: data-level fusion, feature-level fu-

sion, decision-level fusion, and model-level fusion. By exemplifying representative multi-modal mixing examples from

three perspectives: the mixing of multiple external presentation modalities, the mixing of multiple neurophysiological

modalities, and the mixing of neurophysiology and external presentation modalities, it fully demonstrates that multi-

modality is more capable of emotional discrimination and emotional representation than single-modality. At the same

time, some thoughts on the conversion of multi-modal recognition methods to engineering technology applications are

put forward. Finally, based on the analysis and grasp of the current situation of emotion recognition research, the ways

and strategies for improving and enhancing the performance of the emotion recognition models are discussed and pro-

spected.

Keywords: emotion recognition; emotion description model; emotion inducing mode; information fusion; fusion

strategy; emotion representation; modality blend

收稿日期:2020−01−30.

基金项目:国家自然科学基金面上项目(61876067);广东省自

然科学基金面上项目(2019A1515011375);广州市科

技计划项目重点领域研发计划项目(202007030005).

通信作者:潘家辉,E-mail:panjh82@qq.com.

1 相关研究

1.1 背景与研究意义

情绪,是一系列主观认知经验的高度概括,由

�

·634·

智 能 系 统 学 报

第 15 卷

多种感觉、思想和行为等产生的生理心理状态。

人们在交流过程中无时无刻不传递着大量的情绪

信息。从认知神经科学角度来看,情绪也属于经

典认知的一种。情绪在人与人之间的沟通中意义

重大,而在人机交互中,情绪识别是实现人性化

必不可少的部分。

1995年,Picard等[1]提出了“情感计算”,情感

计算要赋予计算机像人一样的观察理解和生成情

感特征的能力,最终使得计算机像人一样进行自

然亲近和生动交互。情感计算逐渐演变成高级人

机交互的关键技术,而情感计算的子领域情绪识

别更是人工智能领域中日益受到重点关注的研究

方向。

情绪识别应用领域非常广阔,涉及日常生活

的方方面面。在医学领域[2-3],情绪识别能为精神

疾病的诊断治疗提供依据。比如在意识障碍的诊

断上,利用标准的行为量表不容易检测患者的意

识状态,而计算机辅助评估意识障碍患者的情绪

能帮助医生更好地做出诊断和治疗;在远程教育

领域[4-5],学生佩戴具有情绪识别功能的便携设

备,以便教师可以监控学生在远程授课过程中的

情绪状态,从而调整授课的进度和方式。在交通

领域中[6-7],对于那些需要高度集中注意力进行操

作的工作人员,例如宇航员、长途旅行客车司机、

飞行员等,他们的愤怒、焦虑、悲伤等负面情绪会

严重影响他们的专注度,导致操作水平下降,造

成交通事故的发生[8]。及时检测这类人员的情绪

状态是避免事故发生的一种有效手段。

1.2 研究现状

近年来,随着人工智能和便携无创人体传感

器技术的不断发展,多模态情绪识别已成为国内

外情感计算领域的研究热点。目前,多模态情绪

识别的研究主要集中于以下几个层面,基于多种

外在行为表现模态、基于多种神经生理模态、基

于神经生理状态和行为潜意识行为。我国在这些

层面的情绪识别研究均取得了初步成果。

基于行为表现方面,中国地质大学吴敏教授

情感计算团队在基于语音情感、人脸表情等基于

外在行为的多模态情绪识别方面开展了研究[9-10],

并在此基础上对多维度情感意图理解、人机情感

交互等领域也进行了较为深入的研究[11]。中国人

民大学多媒体计算实验室融合了视听两种模态,

采取条件注意融合策略进行连续维的情感预测研

究[12]。同时着力于探索多种信道交互信息的有效

替代、互补与干扰等融合机制,以实现人机交互

自然性[13]。

兰州大学普适感知与智能系统团队主要研究

基于人体生理信号和眼动、表情等行为表现模态

的多模态知识建模及应用[14]。通过对生理信号等

模态,组织与建模,研究适用于不同人群(抑郁症

患者、心理高压患者)的模型,为准确、客观、实时

地监控异常情感与心理状态变化。东南大学情感

信息处理团队开展了基于脑电、表情、语音、肢体

动作等模态的情绪分析研究[15-16],在情感分析的

基础探究和实践应用都取得了一定的成果。

基于神经生理信号的情绪识别的研究方面,

上海交通大学吕宝粮教授团队建立了公开情绪数

据集SEED[17],并且在情绪最相关的信号频段和脑

区、脑电的时间稳定性等基础研究方面做了不少

相关的探索[18-19]。另外,中国科学院自动化研究

所何晖光研究团队[20-21]和西南大学刘光远教授团

队[22-23]都对生理信号的情绪识别进行了较为深入

的研究。

2 情绪模型描述

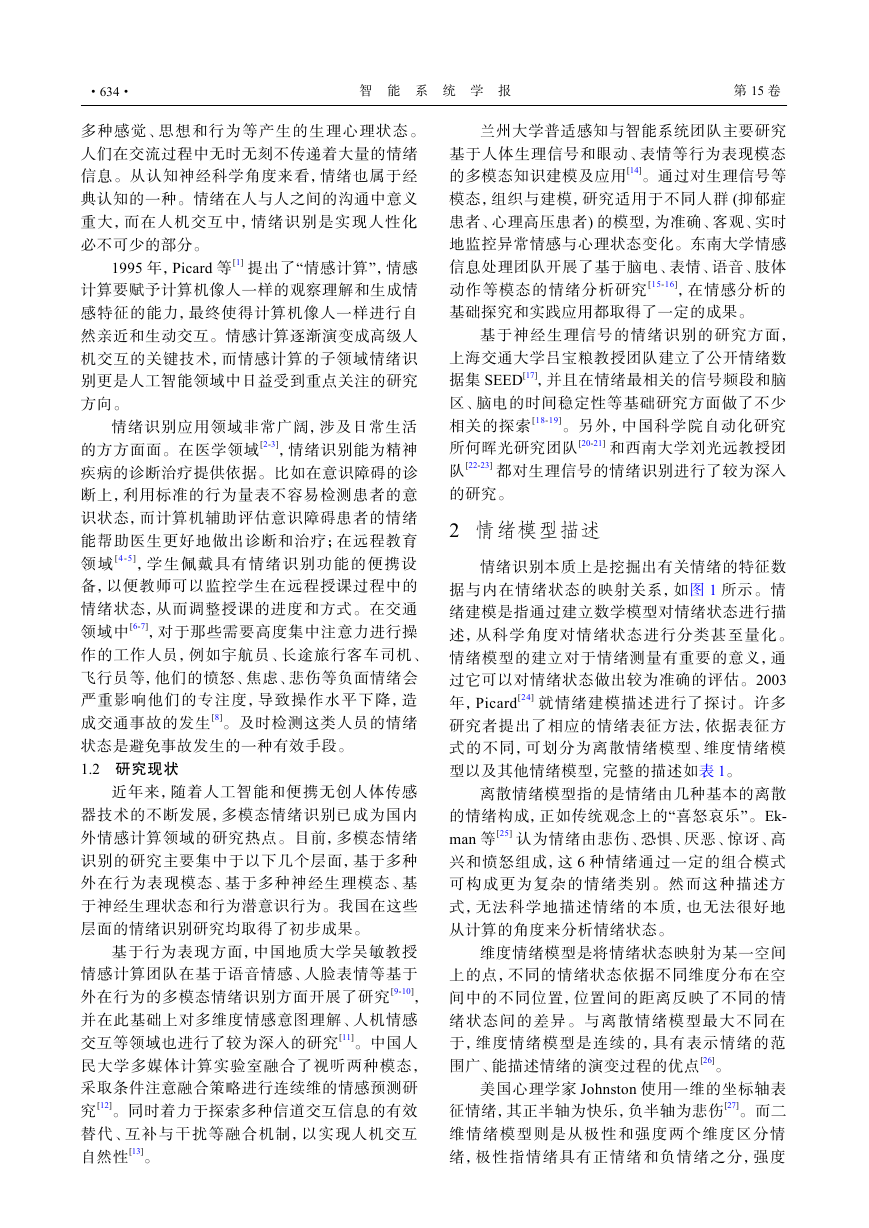

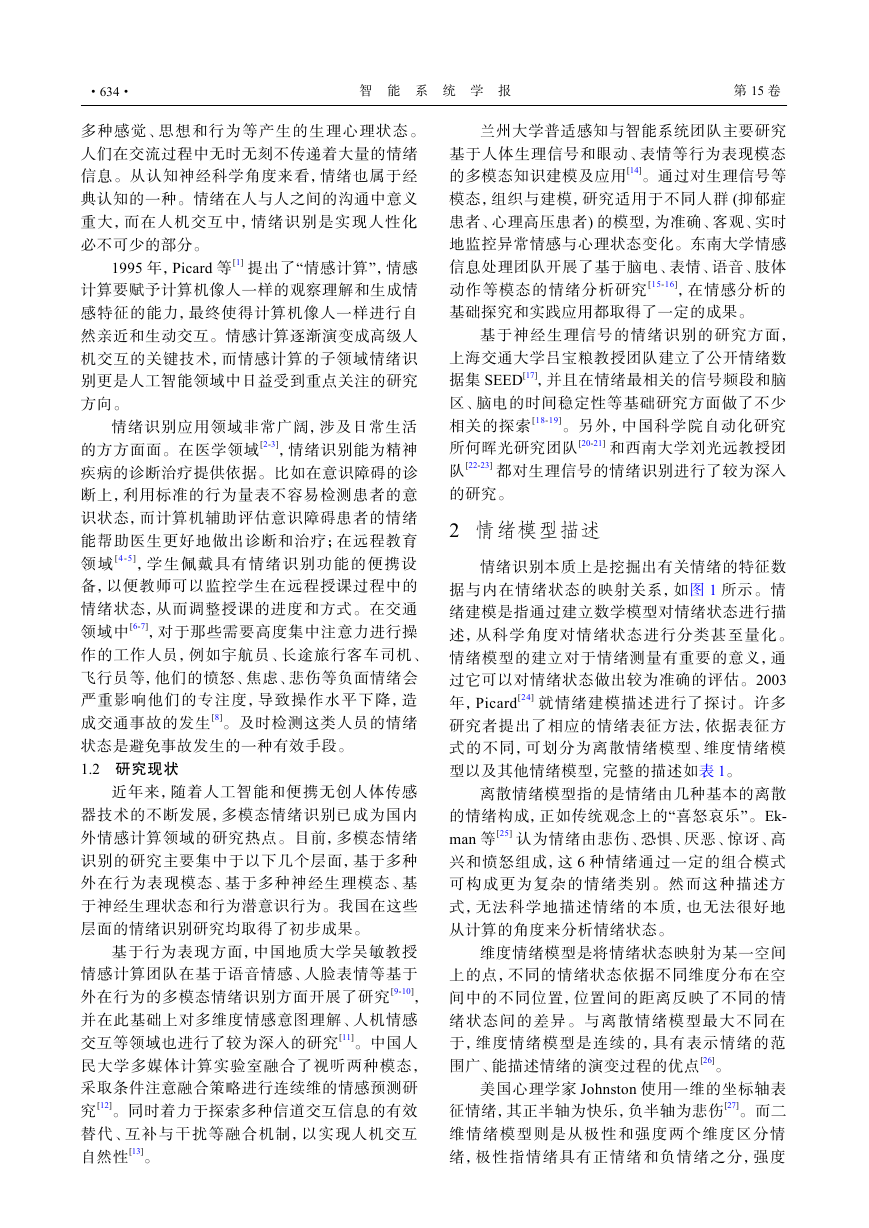

情绪识别本质上是挖掘出有关情绪的特征数

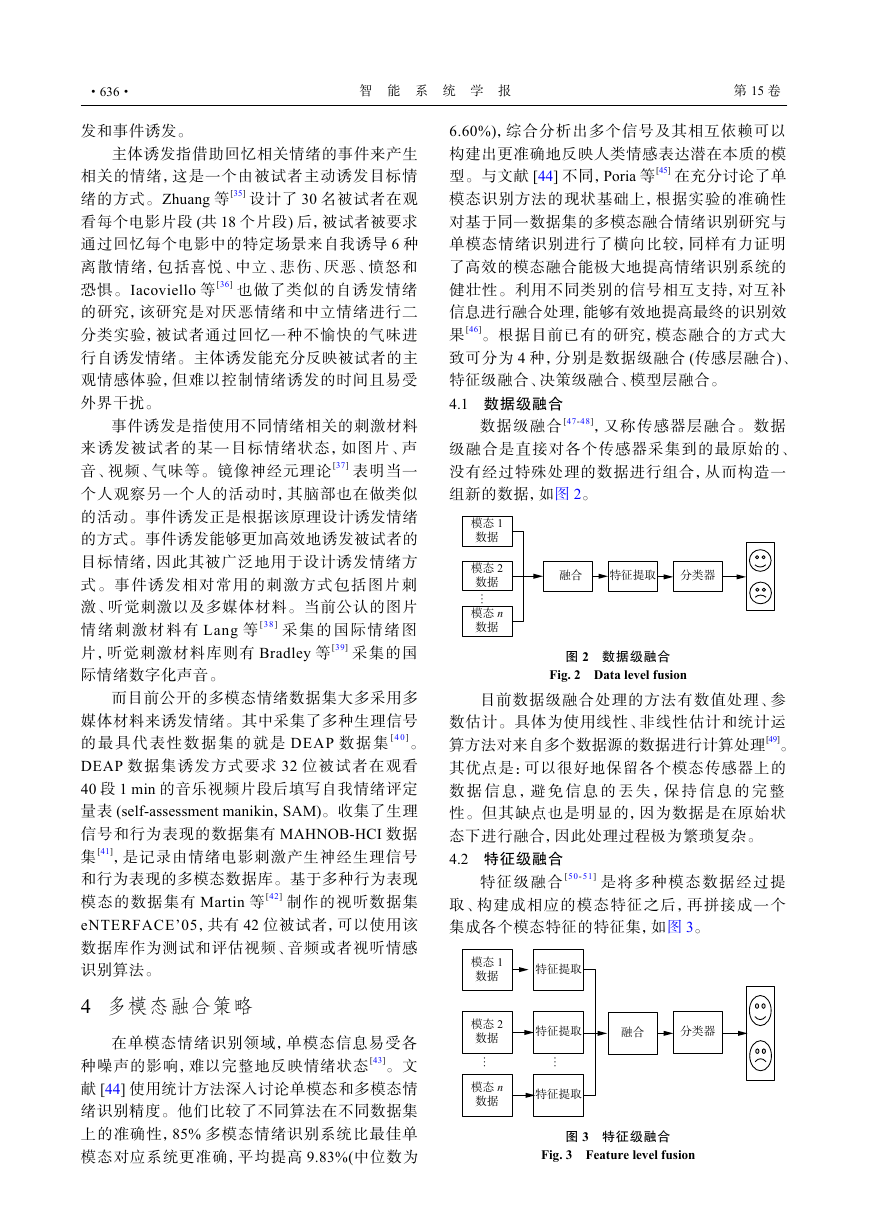

据与内在情绪状态的映射关系,如图1所示。情

绪建模是指通过建立数学模型对情绪状态进行描

述,从科学角度对情绪状态进行分类甚至量化。

情绪模型的建立对于情绪测量有重要的意义,通

过它可以对情绪状态做出较为准确的评估。2003

年,Picard[24]就情绪建模描述进行了探讨。许多

研究者提出了相应的情绪表征方法,依据表征方

式的不同,可划分为离散情绪模型、维度情绪模

型以及其他情绪模型,完整的描述如表1。

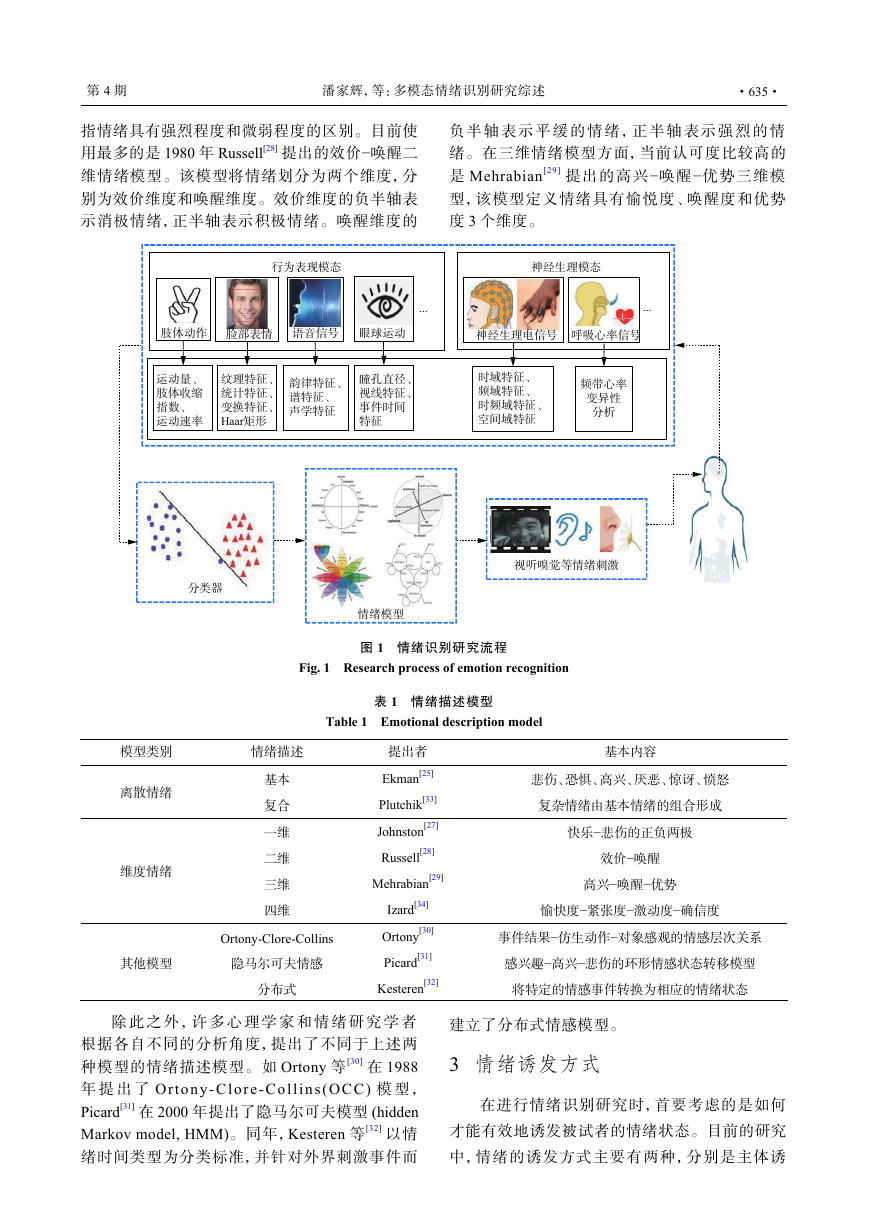

离散情绪模型指的是情绪由几种基本的离散

的情绪构成,正如传统观念上的“喜怒哀乐”。Ek-

man等[25]认为情绪由悲伤、恐惧、厌恶、惊讶、高

兴和愤怒组成,这6种情绪通过一定的组合模式

可构成更为复杂的情绪类别。然而这种描述方

式,无法科学地描述情绪的本质,也无法很好地

从计算的角度来分析情绪状态。

维度情绪模型是将情绪状态映射为某一空间

上的点,不同的情绪状态依据不同维度分布在空

间中的不同位置,位置间的距离反映了不同的情

绪状态间的差异。与离散情绪模型最大不同在

于,维度情绪模型是连续的,具有表示情绪的范

围广、能描述情绪的演变过程的优点[26]。

美国心理学家Johnston使用一维的坐标轴表

征情绪,其正半轴为快乐,负半轴为悲伤[27]。而二

维情绪模型则是从极性和强度两个维度区分情

绪,极性指情绪具有正情绪和负情绪之分,强度

�

第 4 期

潘家辉,等:多模态情绪识别研究综述

·635·

指情绪具有强烈程度和微弱程度的区别。目前使

用最多的是1980年Russell[28]提出的效价−唤醒二

维情绪模型。该模型将情绪划分为两个维度,分

别为效价维度和唤醒维度。效价维度的负半轴表

示消极情绪,正半轴表示积极情绪。唤醒维度的

负 半 轴 表 示 平 缓 的 情 绪 , 正 半 轴 表 示 强 烈 的 情

绪。在三维情绪模型方面,当前认可度比较高的

是Mehrabian[29]提出的高兴−唤醒−优势三维模

型,该模型定义情绪具有愉悦度、唤醒度和优势

度3个维度。

图 1 情绪识别研究流程

Fig. 1 Research process of emotion recognition

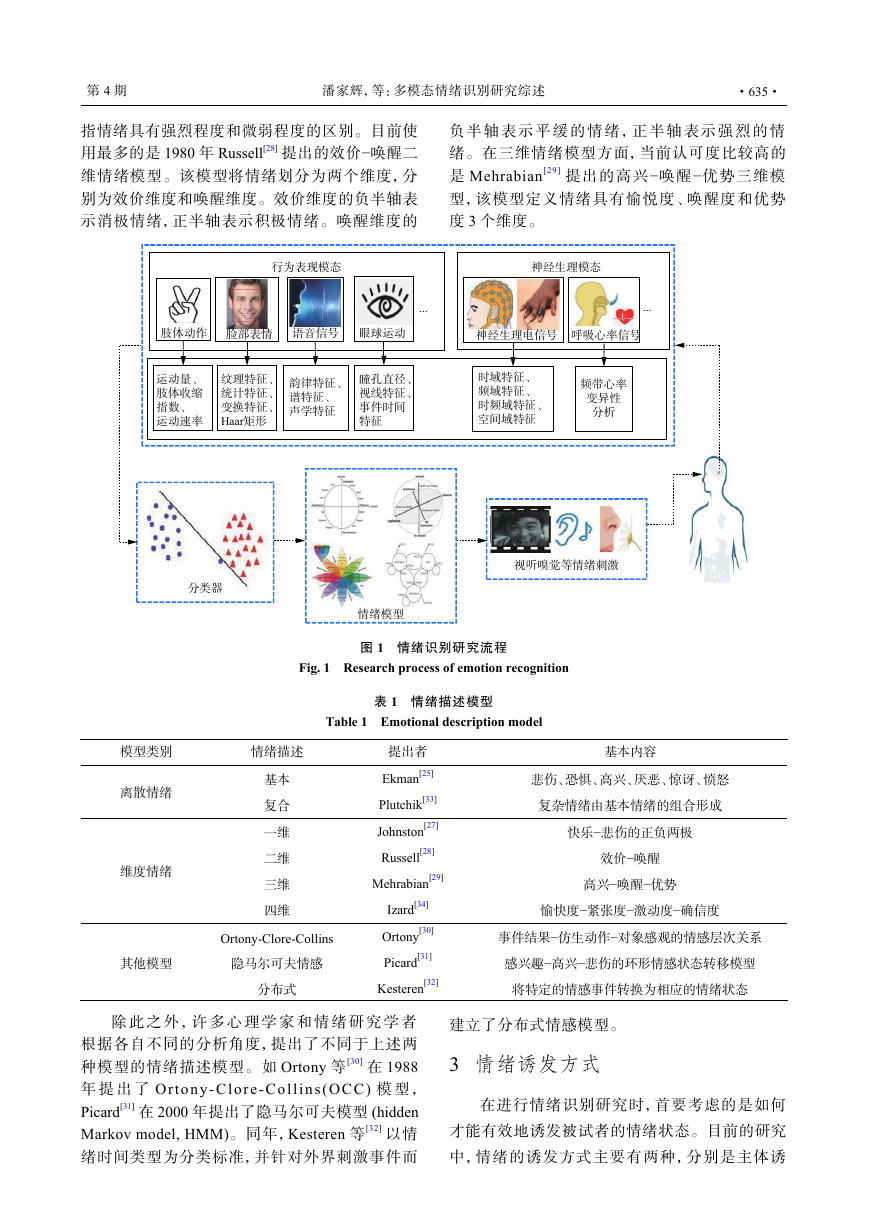

表 1 情绪描述模型

Table 1 Emotional description model

模型类别

情绪描述

离散情绪

维度情绪

基本

复合

一维

二维

三维

四维

Ortony-Clore-Collins

其他模型

隐马尔可夫情感

分布式

提出者

Ekman[25]

Plutchik[33]

Johnston[27]

Russell[28]

Mehrabian[29]

Izard[34]

Ortony[30]

Picard[31]

Kesteren[32]

基本内容

悲伤、恐惧、高兴、厌恶、惊讶、愤怒

复杂情绪由基本情绪的组合形成

快乐−悲伤的正负两极

效价−唤醒

高兴−唤醒−优势

愉快度−紧张度−激动度−确信度

事件结果−仿生动作−对象感观的情感层次关系

感兴趣−高兴−悲伤的环形情感状态转移模型

将特定的情感事件转换为相应的情绪状态

除 此 之 外 , 许 多 心 理 学 家 和 情 绪 研 究 学 者

根据各自不同的分析角度,提出了不同于上述两

种模型的情绪描述模型。如Ortony等[30]在1988

年 提 出了Ortony-Clore-Collins(OCC)模 型 ,

Picard[31]在2000年提出了隐马尔可夫模型(hidden

Markov model, HMM)。同年,Kesteren等[32]以情

绪时间类型为分类标准,并针对外界刺激事件而

建立了分布式情感模型。

3 情绪诱发方式

在进行情绪识别研究时,首要考虑的是如何

才能有效地诱发被试者的情绪状态。目前的研究

中,情绪的诱发方式主要有两种,分别是主体诱

频带心率变异性分析神经生理模态眼球运动呼吸心率信号神经生理电信号时域特征、频域特征、时频域特征、空间域特征脸部表情语音信号肢体动作行为表现模态纹理特征、统计特征、变换特征、Haar矩形韵律特征、谱特征、声学特征运动量、肢体收缩指数、运动速率瞳孔直径、视线特征、事件时间特征......情绪模型视听嗅觉等情绪刺激分类器�

·636·

发和事件诱发。

主体诱发指借助回忆相关情绪的事件来产生

相关的情绪,这是一个由被试者主动诱发目标情

绪的方式。Zhuang等[35]设计了30名被试者在观

看每个电影片段(共18个片段)后,被试者被要求

通过回忆每个电影中的特定场景来自我诱导6种

离散情绪,包括喜悦、中立、悲伤、厌恶、愤怒和

恐惧。Iacoviello等[36]也做了类似的自诱发情绪

的研究,该研究是对厌恶情绪和中立情绪进行二

分类实验,被试者通过回忆一种不愉快的气味进

行自诱发情绪。主体诱发能充分反映被试者的主

观情感体验,但难以控制情绪诱发的时间且易受

外界干扰。

事件诱发是指使用不同情绪相关的刺激材料

来诱发被试者的某一目标情绪状态,如图片、声

音、视频、气味等。镜像神经元理论[37]表明当一

个人观察另一个人的活动时,其脑部也在做类似

的活动。事件诱发正是根据该原理设计诱发情绪

的方式。事件诱发能够更加高效地诱发被试者的

目标情绪,因此其被广泛地用于设计诱发情绪方

式。事件诱发相对常用的刺激方式包括图片刺

激、听觉刺激以及多媒体材料。当前公认的图片

情绪刺激材料有Lang等[38]采集的国际情绪图

片,听觉刺激材料库则有Bradley等[39]采集的国

际情绪数字化声音。

而目前公开的多模态情绪数据集大多采用多

媒体材料来诱发情绪。其中采集了多种生理信号

的 最 具 代 表 性 数 据 集 的 就是DEAP数 据 集[4 0]。

DEAP数据集诱发方式要求32位被试者在观看

40段1 min的音乐视频片段后填写自我情绪评定

量表(self-assessment manikin,SAM)。收集了生理

信号和行为表现的数据集有MAHNOB-HCI数据

集[41],是记录由情绪电影刺激产生神经生理信号

和行为表现的多模态数据库。基于多种行为表现

模态的数据集有Martin等[42]制作的视听数据集

eNTERFACE’05,共有42位被试者,可以使用该

数据库作为测试和评估视频、音频或者视听情感

识别算法。

4 多模态融合策略

智 能 系 统 学 报

第 15 卷

6.60%),综合分析出多个信号及其相互依赖可以

构建出更准确地反映人类情感表达潜在本质的模

型。与文献[44]不同,Poria等[45]在充分讨论了单

模态识别方法的现状基础上,根据实验的准确性

对基于同一数据集的多模态融合情绪识别研究与

单模态情绪识别进行了横向比较,同样有力证明

了高效的模态融合能极大地提高情绪识别系统的

健壮性。利用不同类别的信号相互支持,对互补

信息进行融合处理,能够有效地提高最终的识别效

果[46]。根据目前已有的研究,模态融合的方式大

致可分为4种,分别是数据级融合(传感层融合)、

特征级融合、决策级融合、模型层融合。

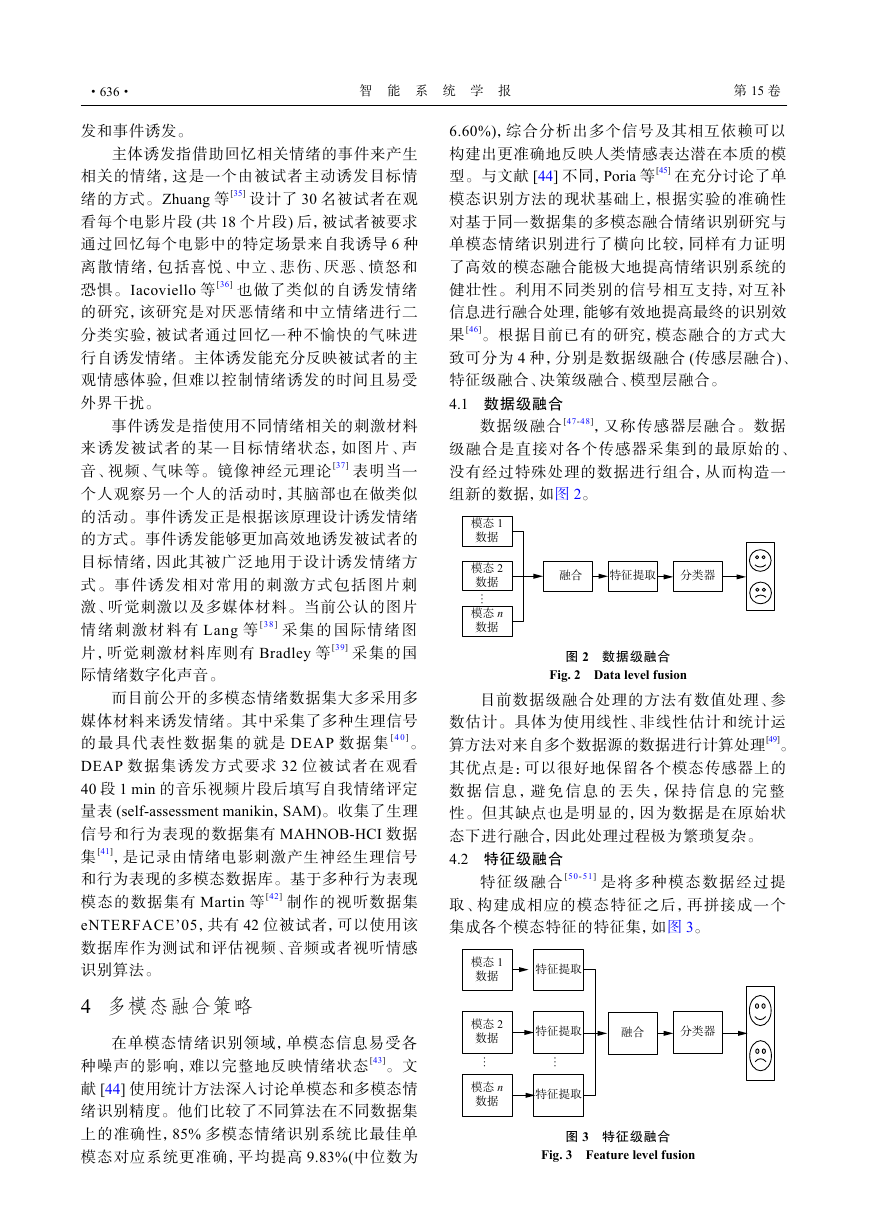

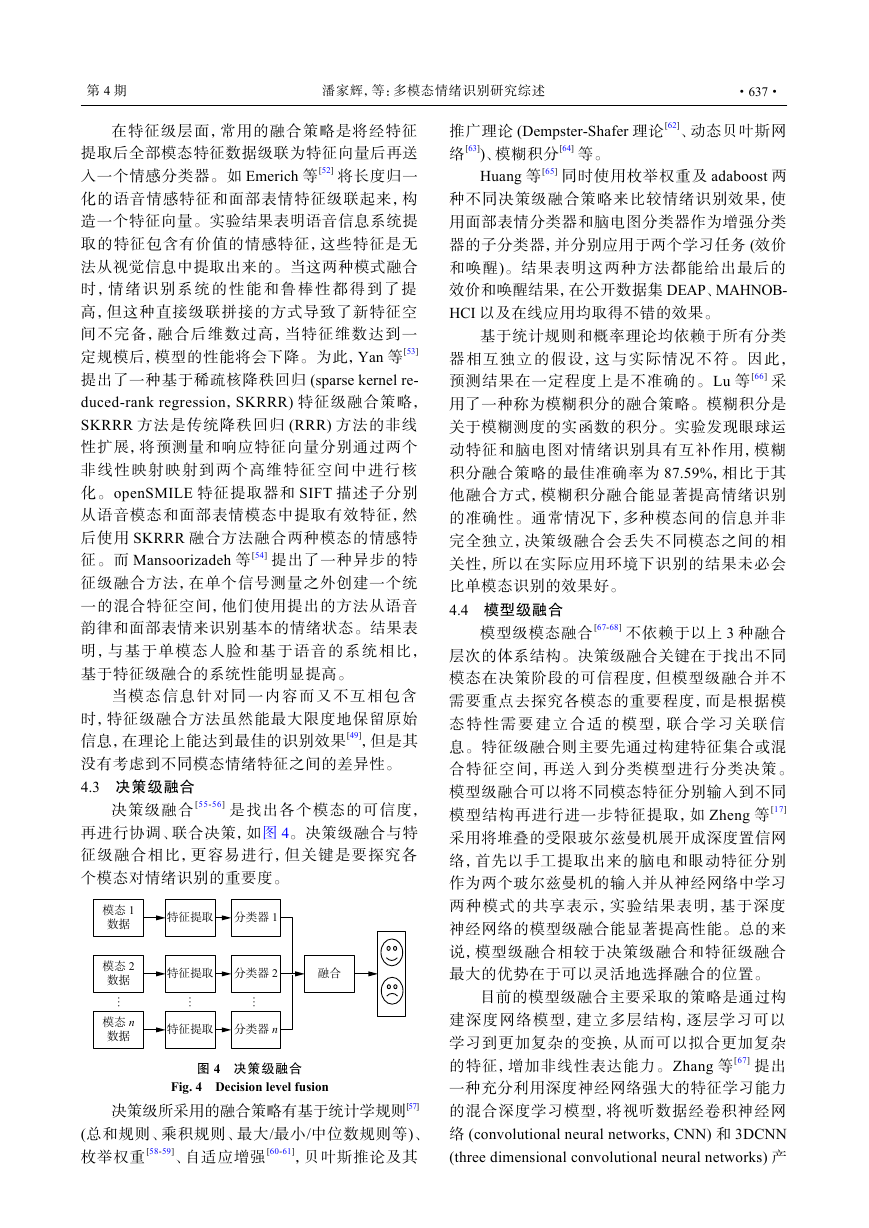

4.1 数据级融合

数据级融合[47-48],又称传感器层融合。数据

级融合是直接对各个传感器采集到的最原始的、

没有经过特殊处理的数据进行组合,从而构造一

组新的数据,如图2。

图 2 数据级融合

Fig. 2 Data level fusion

目前数据级融合处理的方法有数值处理、参

数估计。具体为使用线性、非线性估计和统计运

算方法对来自多个数据源的数据进行计算处理[49]。

其优点是:可以很好地保留各个模态传感器上的

数 据 信 息 , 避 免 信 息 的丟失 , 保 持 信 息 的 完 整

性。但其缺点也是明显的,因为数据是在原始状

态下进行融合,因此处理过程极为繁琐复杂。

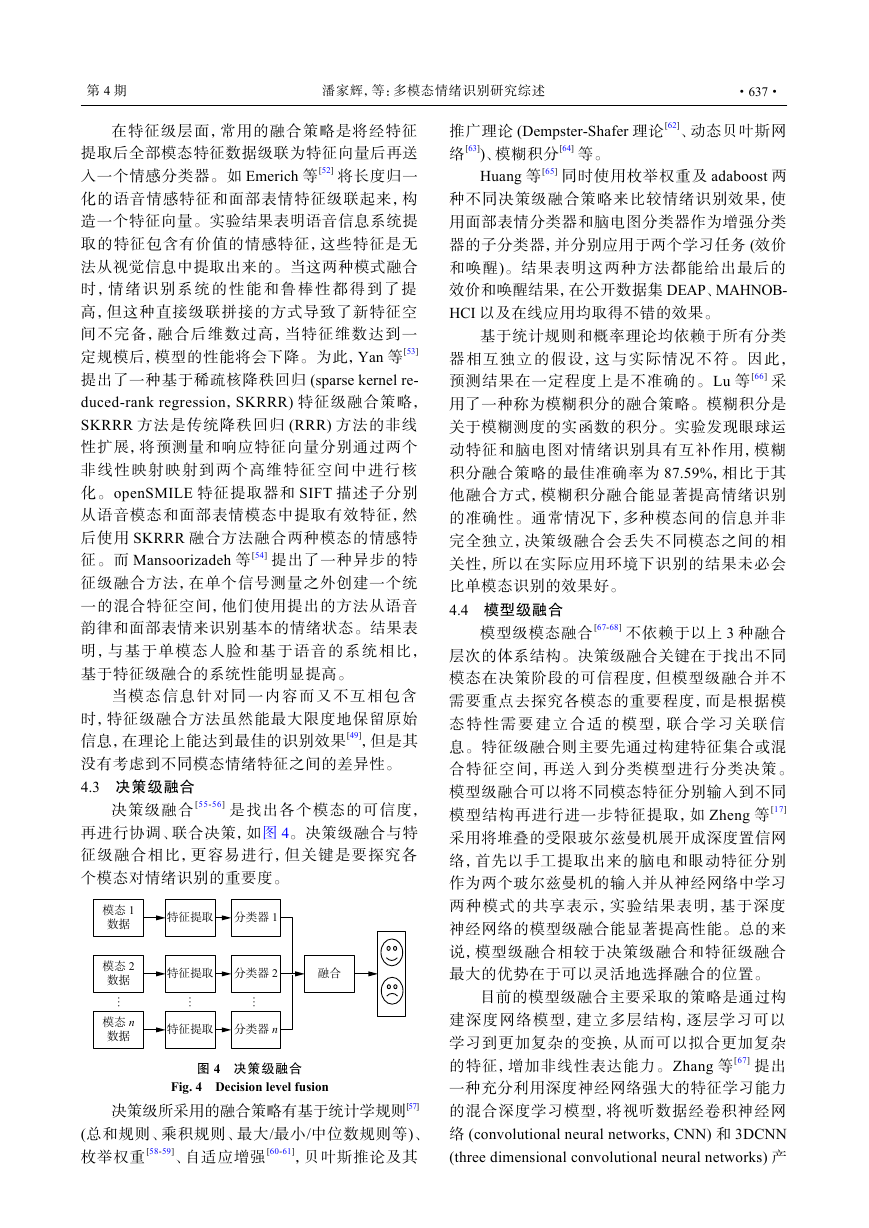

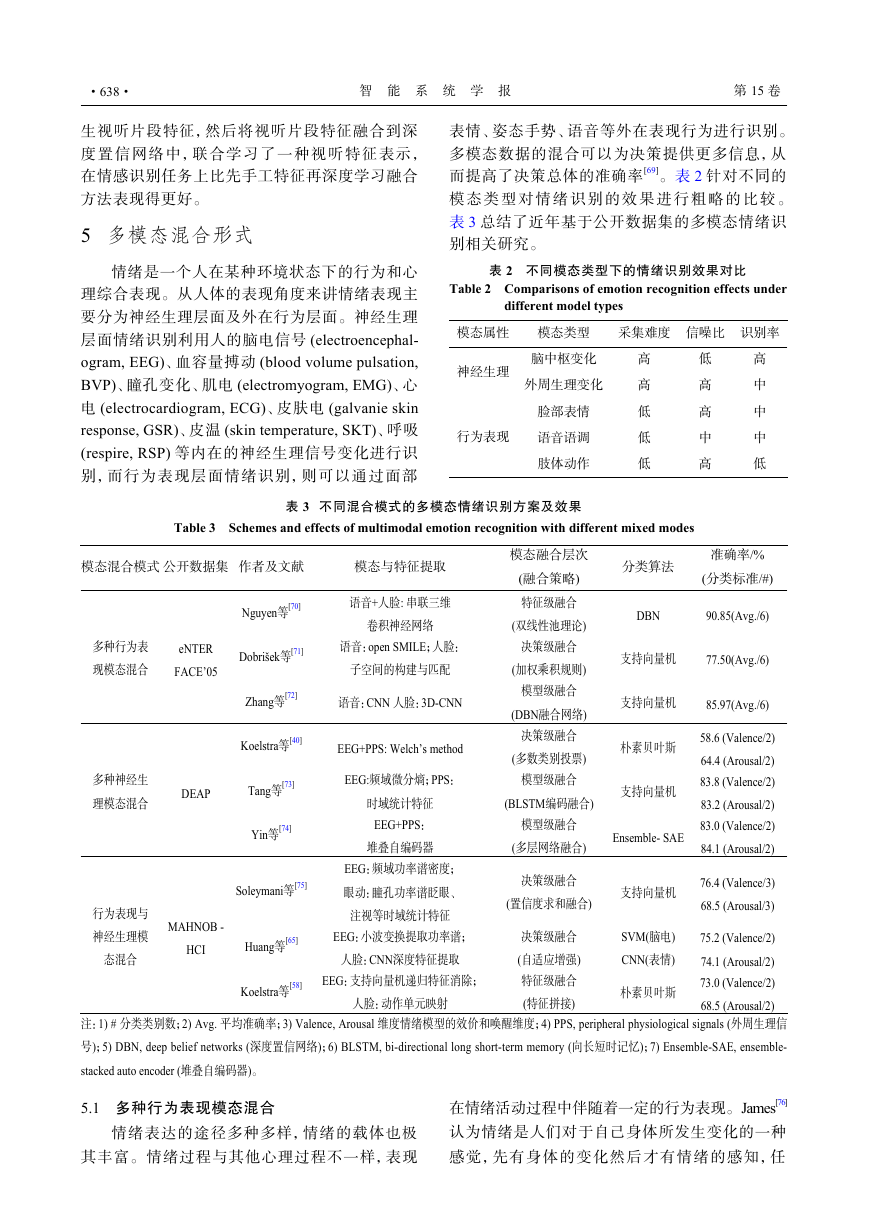

4.2 特征级融合

特征级融合[50-51]是将多种模态数据经过提

取、构建成相应的模态特征之后,再拼接成一个

集成各个模态特征的特征集,如图3。

在单模态情绪识别领域,单模态信息易受各

种噪声的影响,难以完整地反映情绪状态[43]。文

献[44]使用统计方法深入讨论单模态和多模态情

绪识别精度。他们比较了不同算法在不同数据集

上的准确性,85%多模态情绪识别系统比最佳单

模态对应系统更准确,平均提高9.83%(中位数为

图 3 特征级融合

Fig. 3 Feature level fusion

特征提取融合分类器…模态 1数据模态 2数据模态 n数据模态 1数据模态 2数据模态 n数据特征提取融合分类器特征提取特征提取……�

第 4 期

潘家辉,等:多模态情绪识别研究综述

·637·

在特征级层面,常用的融合策略是将经特征

提取后全部模态特征数据级联为特征向量后再送

入一个情感分类器。如Emerich等[52]将长度归一

化的语音情感特征和面部表情特征级联起来,构

造一个特征向量。实验结果表明语音信息系统提

取的特征包含有价值的情感特征,这些特征是无

法从视觉信息中提取出来的。当这两种模式融合

时 , 情 绪 识 别 系 统 的 性 能 和 鲁 棒 性 都 得 到 了 提

高,但这种直接级联拼接的方式导致了新特征空

间不完备,融合后维数过高,当特征维数达到一

定规模后,模型的性能将会下降。为此,Yan等[53]

提出了一种基于稀疏核降秩回归(sparse kernel re-

duced-rank regression,SKRRR)特征级融合策略,

SKRRR方法是传统降秩回归(RRR)方法的非线

性扩展,将预测量和响应特征向量分别通过两个

非线性映射映射到两个高维特征空间中进行核

化。openSMILE特征提取器和SIFT描述子分别

从语音模态和面部表情模态中提取有效特征,然

后使用SKRRR融合方法融合两种模态的情感特

征。而Mansoorizadeh等[54]提出了一种异步的特

征级融合方法,在单个信号测量之外创建一个统

一的混合特征空间,他们使用提出的方法从语音

韵律和面部表情来识别基本的情绪状态。结果表

明,与基于单模态人脸和基于语音的系统相比,

基于特征级融合的系统性能明显提高。

当模态信息针对同一内容而又不互相包含

时,特征级融合方法虽然能最大限度地保留原始

信息,在理论上能达到最佳的识别效果[49],但是其

没有考虑到不同模态情绪特征之间的差异性。

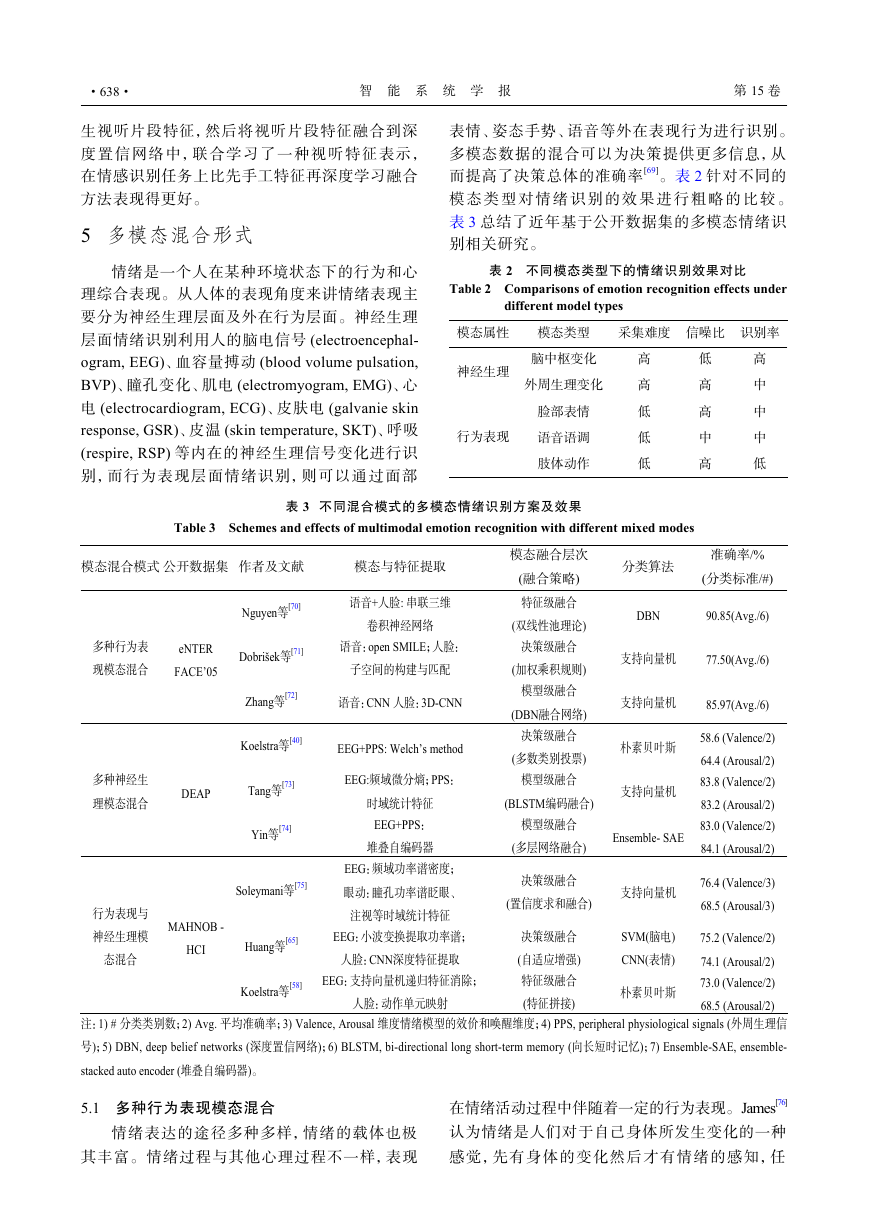

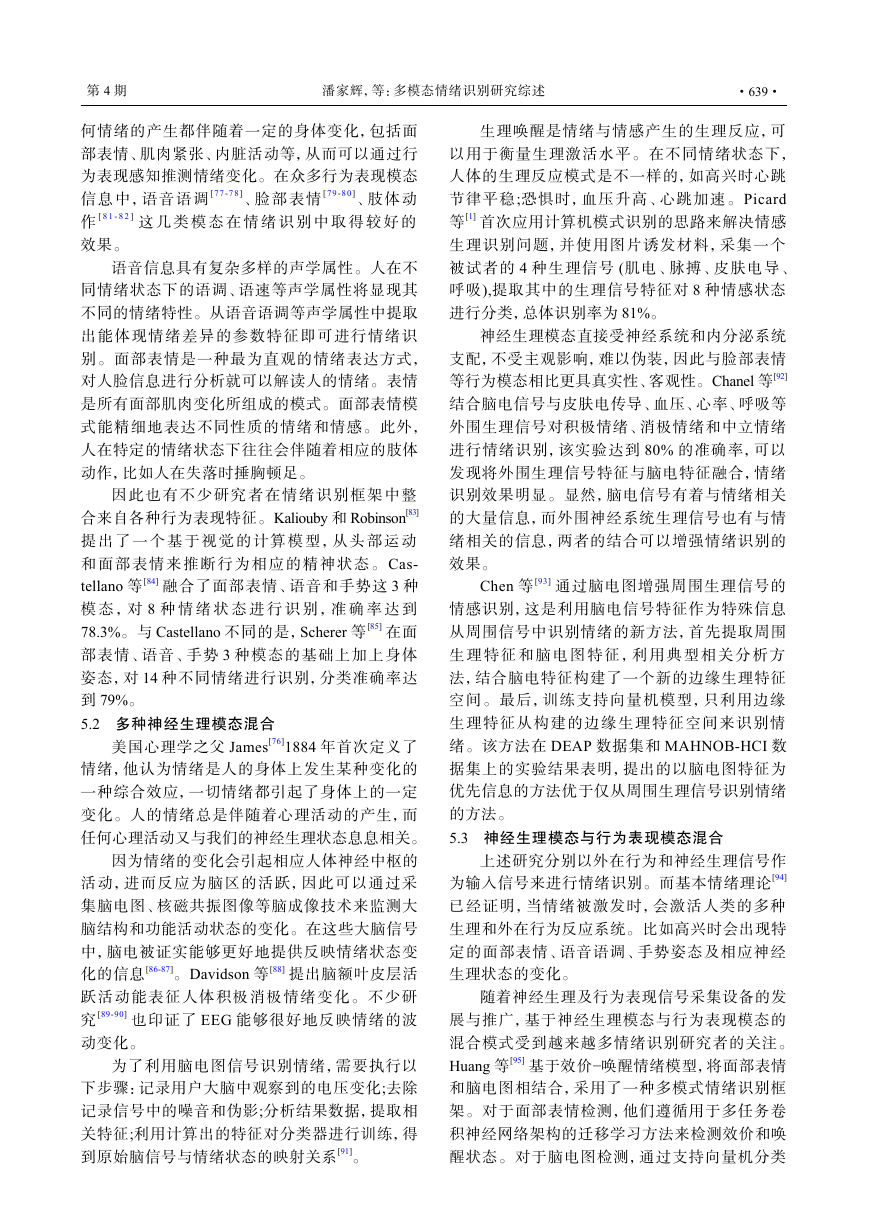

4.3 决策级融合

决策级融合[55-56]是找出各个模态的可信度,

再进行协调、联合决策,如图4。决策级融合与特

征级融合相比,更容易进行,但关键是要探究各

个模态对情绪识别的重要度。

图 4 决策级融合

Fig. 4 Decision level fusion

决策级所采用的融合策略有基于统计学规则[57]

(总和规则、乘积规则、最大/最小/中位数规则等)、

枚举权重[58-59]、自适应增强[60-61],贝叶斯推论及其

推广理论(Dempster-Shafer理论[62]、动态贝叶斯网

络[63])、模糊积分[64]等。

Huang等[65]同时使用枚举权重及adaboost两

种不同决策级融合策略来比较情绪识别效果,使

用面部表情分类器和脑电图分类器作为增强分类

器的子分类器,并分别应用于两个学习任务(效价

和唤醒)。结果表明这两种方法都能给出最后的

效价和唤醒结果,在公开数据集DEAP、MAHNOB-

HCI以及在线应用均取得不错的效果。

基于统计规则和概率理论均依赖于所有分类

器相互独立的假设,这与实际情况不符。因此,

预测结果在一定程度上是不准确的。Lu等[66]采

用了一种称为模糊积分的融合策略。模糊积分是

关于模糊测度的实函数的积分。实验发现眼球运

动特征和脑电图对情绪识别具有互补作用,模糊

积分融合策略的最佳准确率为87.59%,相比于其

他融合方式,模糊积分融合能显著提高情绪识别

的准确性。通常情况下,多种模态间的信息并非

完全独立,决策级融合会丢失不同模态之间的相

关性,所以在实际应用环境下识别的结果未必会

比单模态识别的效果好。

4.4 模型级融合

模型级模态融合[67-68]不依赖于以上3种融合

层次的体系结构。决策级融合关键在于找出不同

模态在决策阶段的可信程度,但模型级融合并不

需要重点去探究各模态的重要程度,而是根据模

态 特 性 需 要 建 立 合 适 的 模 型 , 联 合 学 习 关 联 信

息。特征级融合则主要先通过构建特征集合或混

合特征空间,再送入到分类模型进行分类决策。

模型级融合可以将不同模态特征分别输入到不同

模型结构再进行进一步特征提取,如Zheng等[17]

采用将堆叠的受限玻尔兹曼机展开成深度置信网

络,首先以手工提取出来的脑电和眼动特征分别

作为两个玻尔兹曼机的输入并从神经网络中学习

两种模式的共享表示,实验结果表明,基于深度

神经网络的模型级融合能显著提高性能。总的来

说,模型级融合相较于决策级融合和特征级融合

最大的优势在于可以灵活地选择融合的位置。

目前的模型级融合主要采取的策略是通过构

建深度网络模型,建立多层结构,逐层学习可以

学习到更加复杂的变换,从而可以拟合更加复杂

的特征,增加非线性表达能力。Zhang等[67]提出

一种充分利用深度神经网络强大的特征学习能力

的混合深度学习模型,将视听数据经卷积神经网

络(convolutional neural networks, CNN)和3DCNN

(three dimensional convolutional neural networks)产

模态 1数据模态 2数据模态 n数据特征提取融合分类器 1特征提取特征提取分类器 2分类器 n………�

·638·

智 能 系 统 学 报

第 15 卷

生视听片段特征,然后将视听片段特征融合到深

度置信网络中,联合学习了一种视听特征表示,

在情感识别任务上比先手工特征再深度学习融合

方法表现得更好。

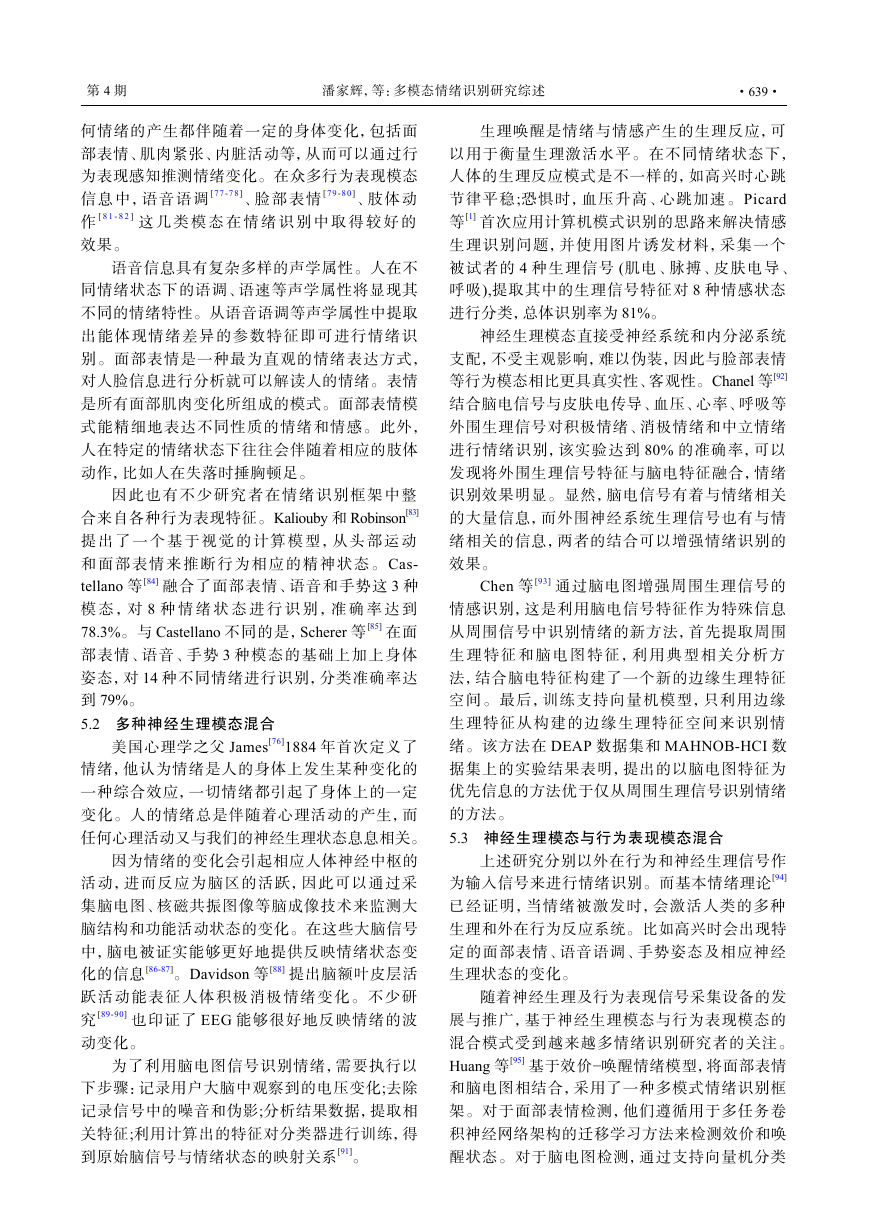

5 多模态混合形式

情绪是一个人在某种环境状态下的行为和心

理综合表现。从人体的表现角度来讲情绪表现主

要分为神经生理层面及外在行为层面。神经生理

层面情绪识别利用人的脑电信号(electroencephal-

ogram, EEG)、血容量搏动(blood volume pulsation,

BVP)、瞳孔变化、肌电(electromyogram, EMG)、心

电(electrocardiogram, ECG)、皮肤电(galvanie skin

response, GSR)、皮温(skin temperature, SKT)、呼吸

(respire, RSP)等内在的神经生理信号变化进行识

别,而行为表现层面情绪识别,则可以通过面部

表情、姿态手势、语音等外在表现行为进行识别。

多模态数据的混合可以为决策提供更多信息,从

而提高了决策总体的准确率[69]。表2针对不同的

模 态 类 型 对 情 绪 识 别 的 效 果 进 行 粗 略 的 比 较 。

表3总结了近年基于公开数据集的多模态情绪识

别相关研究。

表 2 不同模态类型下的情绪识别效果对比

Table 2 Comparisons of emotion recognition effects under

different model types

模态属性

模态类型

采集难度 信噪比 识别率

神经生理

脑中枢变化

外周生理变化

脸部表情

行为表现

语音语调

肢体动作

高

高

低

低

低

低

高

高

中

高

高

中

中

中

低

表 3 不同混合模式的多模态情绪识别方案及效果

Table 3 Schemes and effects of multimodal emotion recognition with different mixed modes

模态混合模式 公开数据集 作者及文献

模态与特征提取

多种行为表

现模态混合

eNTER

FACE’05

Nguyen等

[70]

Dobrišek等

[71]

语音+人脸: 串联三维

卷积神经网络

语音:open SMILE;人脸:

子空间的构建与匹配

Zhang等

[72]

语音:CNN 人脸:3D-CNN

Koelstra等

[40]

EEG+PPS: Welch’s method

多种神经生

理模态混合

DEAP

[73]

Tang等

[74]

Yin等

EEG:频域微分熵;PPS:

时域统计特征

EEG+PPS:

堆叠自编码器

行为表现与

神经生理模

态混合

MAHNOB -

HCI

Soleymani等

[75]

EEG:频域功率谱密度;

眼动:瞳孔功率谱眨眼、

Huang等

[65]

Koelstra等

[58]

注视等时域统计特征

EEG:小波变换提取功率谱;

人脸:CNN深度特征提取

EEG:支持向量机递归特征消除;

人脸:动作单元映射

模态融合层次

(融合策略)

特征级融合

(双线性池理论)

决策级融合

(加权乘积规则)

模型级融合

(DBN融合网络)

决策级融合

(多数类别投票)

模型级融合

(BLSTM编码融合)

模型级融合

(多层网络融合)

决策级融合

(置信度求和融合)

决策级融合

(自适应增强)

特征级融合

(特征拼接)

分类算法

准确率/%

(分类标准/#)

DBN

90.85(Avg./6)

支持向量机

77.50(Avg./6)

支持向量机

85.97(Avg./6)

朴素贝叶斯

支持向量机

Ensemble- SAE

支持向量机

SVM(脑电)

CNN(表情)

朴素贝叶斯

58.6 (Valence/2)

64.4 (Arousal/2)

83.8 (Valence/2)

83.2 (Arousal/2)

83.0 (Valence/2)

84.1 (Arousal/2)

76.4 (Valence/3)

68.5 (Arousal/3)

75.2 (Valence/2)

74.1 (Arousal/2)

73.0 (Valence/2)

68.5 (Arousal/2)

注:1) # 分类类别数;2) Avg. 平均准确率;3) Valence, Arousal 维度情绪模型的效价和唤醒维度;4) PPS, peripheral physiological signals (外周生理信

号);5) DBN, deep belief networks (深度置信网络);6) BLSTM, bi-directional long short-term memory (向长短时记忆);7) Ensemble-SAE, ensemble-

stacked auto encoder (堆叠自编码器)。

5.1 多种行为表现模态混合

情绪表达的途径多种多样,情绪的载体也极

其丰富。情绪过程与其他心理过程不一样,表现

在情绪活动过程中伴随着一定的行为表现。James[76]

认为情绪是人们对于自己身体所发生变化的一种

感觉,先有身体的变化然后才有情绪的感知,任

�

第 4 期

潘家辉,等:多模态情绪识别研究综述

·639·

何情绪的产生都伴随着一定的身体变化,包括面

部表情、肌肉紧张、内脏活动等,从而可以通过行

为表现感知推测情绪变化。在众多行为表现模态

信息中,语音语调[77-78]、脸部表情[79-80]、肢体动

作[8 1-8 2]这 几 类 模 态 在 情 绪 识 别 中 取 得 较 好 的

效果。

语音信息具有复杂多样的声学属性。人在不

同情绪状态下的语调、语速等声学属性将显现其

不同的情绪特性。从语音语调等声学属性中提取

出能体现情绪差异的参数特征即可进行情绪识

别。面部表情是一种最为直观的情绪表达方式,

对人脸信息进行分析就可以解读人的情绪。表情

是所有面部肌肉变化所组成的模式。面部表情模

式能精细地表达不同性质的情绪和情感。此外,

人在特定的情绪状态下往往会伴随着相应的肢体

动作,比如人在失落时捶胸顿足。

因此也有不少研究者在情绪识别框架中整

合来自各种行为表现特征。Kaliouby和Robinson[83]

提 出 了 一 个 基 于 视 觉 的 计 算 模 型 , 从 头 部 运 动

和 面 部 表 情 来 推 断 行 为 相 应 的 精 神 状 态 。Cas-

tellano等[84]融合了面部表情、语音和手势这3种

模 态 ,对8种 情 绪 状 态 进 行 识 别 , 准 确 率 达到

78.3%。与Castellano不同的是,Scherer等[85]在面

部表情、语音、手势3种模态的基础上加上身体

姿态,对14种不同情绪进行识别,分类准确率达

到79%。

5.2 多种神经生理模态混合

美国心理学之父James[76]1884年首次定义了

情绪,他认为情绪是人的身体上发生某种变化的

一种综合效应,一切情绪都引起了身体上的一定

变化。人的情绪总是伴随着心理活动的产生,而

任何心理活动又与我们的神经生理状态息息相关。

因为情绪的变化会引起相应人体神经中枢的

活动,进而反应为脑区的活跃,因此可以通过采

集脑电图、核磁共振图像等脑成像技术来监测大

脑结构和功能活动状态的变化。在这些大脑信号

中,脑电被证实能够更好地提供反映情绪状态变

化的信息[86-87]。Davidson等[88]提出脑额叶皮层活

跃活动能表征人体积极消极情绪变化。不少研

究[89-90]也印证了EEG能够很好地反映情绪的波

动变化。

为了利用脑电图信号识别情绪,需要执行以

下步骤:记录用户大脑中观察到的电压变化;去除

记录信号中的噪音和伪影;分析结果数据,提取相

关特征;利用计算出的特征对分类器进行训练,得

到原始脑信号与情绪状态的映射关系[91]。

生理唤醒是情绪与情感产生的生理反应,可

以用于衡量生理激活水平。在不同情绪状态下,

人体的生理反应模式是不一样的,如高兴时心跳

节律平稳;恐惧时,血压升高、心跳加速。Picard

等[1]首次应用计算机模式识别的思路来解决情感

生理识别问题,并使用图片诱发材料,采集一个

被试者的4种生理信号(肌电、脉搏、皮肤电导、

呼吸),提取其中的生理信号特征对8种情感状态

进行分类,总体识别率为81%。

神经生理模态直接受神经系统和内分泌系统

支配,不受主观影响,难以伪装,因此与脸部表情

等行为模态相比更具真实性、客观性。Chanel等[92]

结合脑电信号与皮肤电传导、血压、心率、呼吸等

外围生理信号对积极情绪、消极情绪和中立情绪

进行情绪识别,该实验达到80%的准确率,可以

发现将外围生理信号特征与脑电特征融合,情绪

识别效果明显。显然,脑电信号有着与情绪相关

的大量信息,而外围神经系统生理信号也有与情

绪相关的信息,两者的结合可以增强情绪识别的

效果。

Chen等[93]通过脑电图增强周围生理信号的

情感识别,这是利用脑电信号特征作为特殊信息

从周围信号中识别情绪的新方法,首先提取周围

生 理 特 征 和 脑 电 图 特 征 , 利 用 典 型 相 关 分 析 方

法,结合脑电特征构建了一个新的边缘生理特征

空间。最后,训练支持向量机模型,只利用边缘

生理特征从构建的边缘生理特征空间来识别情

绪。该方法在DEAP数据集和MAHNOB-HCI数

据集上的实验结果表明,提出的以脑电图特征为

优先信息的方法优于仅从周围生理信号识别情绪

的方法。

5.3 神经生理模态与行为表现模态混合

上述研究分别以外在行为和神经生理信号作

为输入信号来进行情绪识别。而基本情绪理论[94]

已经证明,当情绪被激发时,会激活人类的多种

生理和外在行为反应系统。比如高兴时会出现特

定的面部表情、语音语调、手势姿态及相应神经

生理状态的变化。

随着神经生理及行为表现信号采集设备的发

展与推广,基于神经生理模态与行为表现模态的

混合模式受到越来越多情绪识别研究者的关注。

Huang等[95]基于效价−唤醒情绪模型,将面部表情

和脑电图相结合,采用了一种多模式情绪识别框

架。对于面部表情检测,他们遵循用于多任务卷

积神经网络架构的迁移学习方法来检测效价和唤

醒状态。对于脑电图检测,通过支持向量机分类

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc