中国科技论文在线

http://www.paper.edu.cn

多自动编码器文本分类模型设计#

5

10

苏峰1,2,王旭2,管仁初2,梁艳春2**

(1. 内蒙古民族大学数学学院,通辽 028043;

2. 吉林大学计算机科学与技术学院,长春 130012)

摘要:在文本挖掘研究中,通常采用向量空间模型。然而,向量空间模型带来的高维稀疏矩

阵运算是影响文本分类准确率的重要因素之一。近年来,由于深度学习算法能很好地建立从

底层信号到高层语义的映射关系,因此在语音识别和图像识别等领域获得了巨大的成功。本

文将深度学习中自动编码器引入到文本分类中,构造了多自动编码器文本分类模型。使该模

型能够通过非线性映射解决高维稀疏矩阵运算问题,提高文本分类算法的准确率。同时,以

20Newsgroup 语料为例,讨论了新模型的具体应用方法。

关键词:机器学习;自动编码器网络;文本分类;玻尔兹曼机

中图分类号:TP181(自动推理、机器学习), O235(模式识别理论)

15

Design of A Multi-Autoencoders Model for Text

Classification

SU Feng1,2, WANG Xu2, GUAN Renchu2, LIANG Yanchun2

(1. College of Mathematics,Inner Mongolia University for the Nationalities,TongLiao 028043;

20

2. College of Comupter Science and Technology, Jilin University, 130012)

Abstract: For text mining research, the Vector Space Model is often employed. However, this

model is accompanied by the high-dimensional and sparse matrix computing which plays an

important role in text classification. Recently, because it is good at mapping from normal features

to higher semantic space, deep learning succeeds in speech recognition and image recognition. In

this paper, the autoencoder as one of the typical deep learning algorithms is introduced in text

classification. Then, the Muti-autoencoder Text Classification model is proposed. The new model

can solve the problem of high-dimensional and sparse matrix computing by non-linear mapping. It

could improve the classification accuracy. In addition, we take 20 Newsgroup as examples, and

show the application of the new model.

Key words: Machine Learning; Autoencoder Network; Text Classification; Boltzmann Machine

25

30

0 引言

随着数字信息产业的发展,各行业都面临着大数据的到来,人们可获得的信息量日益增

多。面对这些海量的信息数据,如何能够快速、准确并全面的管理及应用这些信息已是当前

35

大数据研究的热点。近年来,基于机器学习和统计理论的方法在数据挖掘领域取得了令人瞩

目的进展。其中,文本分类技术就是其中一个重要的研究方向,但在实际应用时仍存在很多

挑战[1]。

文本分类算法的效果在很大程度上会受到文本特征维数的影响,为了提高分类的精度,

对文本进行有效的特征分析处理是十分必要的。常用的特征选择和特征抽取方法有信息增益

40

(Information Gain,简称 IG)、文档词频(Document Frequency,简称 DF)、 互信息(Mutual

Information,简称 MI)、 统计(Chi-square Statistic,简称 CHI)、主成分分析(Principal

基金项目:高等学校博士学科点专项科研基金(No. 20120061110094);吉林省科技发展计划青年科研基金

(No.201201048)

作者简介:苏峰(1986- ),女,硕士研究生,主要研究方向:模式识别和文本挖掘

通信联系人:梁艳春(1953- ),男,教授,博士生导师,机器学习,生物信息学,计算智能. E-mail:

ycliang@jlu.edu.cn

- 1 -

2�

中国科技论文在线

http://www.paper.edu.cn

Component Analysis)等等,这些都已经有实验证明它们的有效性,但高维特征空间的样本分

布 往 往 是 非 线 性 的 复 杂 结 构 , 因 此本 文 中 选 择一 种 新 型 特征 提 取 算 法 — 自 编 码 网 络

(AutoEncoder Network)。

45

1 自编码网络的产生

自编码网络(Auto-encoder Network),也称为自编码神经网络是由 Hinton 等人于 2006 年

在《SCIENCE》杂志上提出的一种新型深度神经网络模型[2]。深度神经网络的优点是可以

用较少的参数来实现复杂的函数表示[3]。作为训练多层神经网络的经典算法—BP 算法对较

少层神经网络的训练已呈现出较高的复杂性[4],而对于非凸的目标函数则易陷入局部极小,

50

这是传统神经网络无法取得突破的主要原因。例如:基于梯度下降的 BP 算法对多层网络参

数的训练存在困难,首先伴随着网络层数的增多,BP 算法计算偏导数困难且误差需要层层

递传,误差校正的能力越来越弱;其次,BP 算法是有监督的学习,训练数据必须要有类标

签。然而,标记样本的获取通常需要耗费大量的人力和物力。为了从海量无标记样本中获取

信息和知识,Hinton 等人首先在文献[5]中提出了深度信念网(Deep Belief Nets, DBN)并引

55

出了的逐层训练算法—限制波尔兹曼机算法,解决了多层深度结构参数优化难题,引起了学

术界与工业界的广泛关注。同年,Hinton 教授及其研究团队在深度信念网的基础上又发表了

深度学习中最为著名的算法—自编码神经网络。该算法在手写体识别和人脸识别中取得了良

好的效果。

2 自编码网络结构

60

自动编码网络是一个包含多个隐层的生成性深度网络,整个网络由编码(encoder)与

解码(decoder)两部分网络构成。编码网络属于数据降维部分,高维数据通过多层的网络

结构后维数降到较低维度的核心结构上。解码网络属于重构数据部分,可以看做是编码网络

的逆过程,将核心结构上的数据还原为高维数据。编码网络与解码网络共享一个核心结构,

是两个网络的的交叉部分,称之为“代码层”(code layer)。核心代码层是整个自动编码

65

网络的重要结构,能够表示输入高维数据的本质特征,描述数据的内部本质高阶相关性。

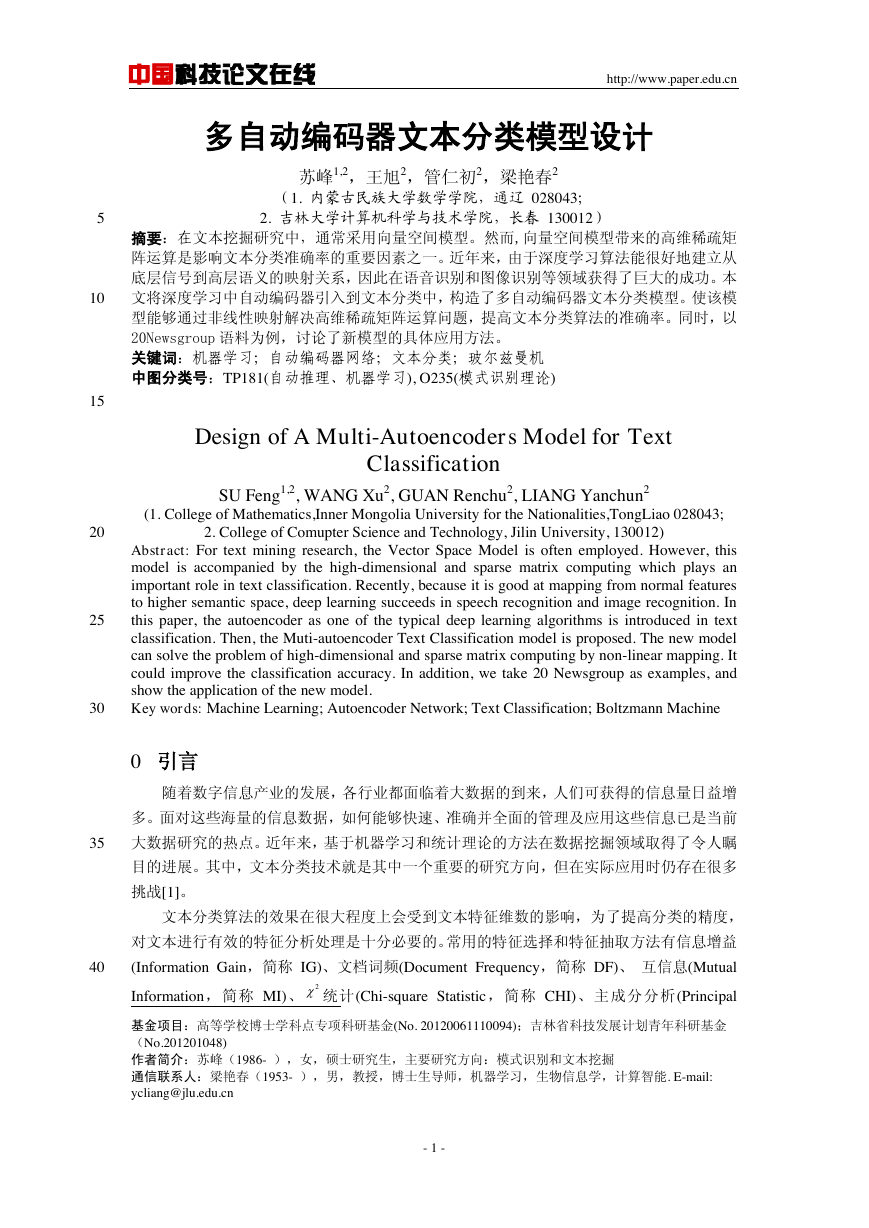

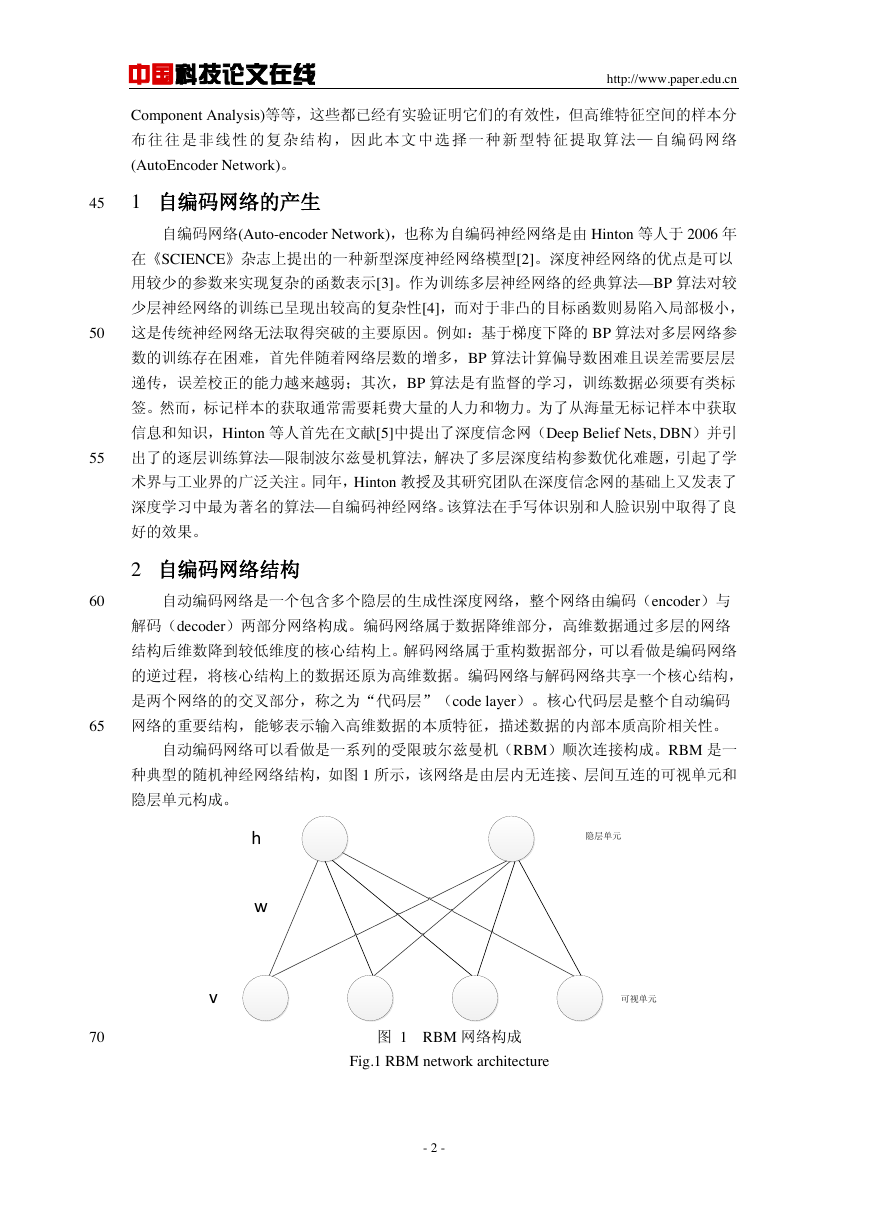

自动编码网络可以看做是一系列的受限玻尔兹曼机(RBM)顺次连接构成。RBM 是一

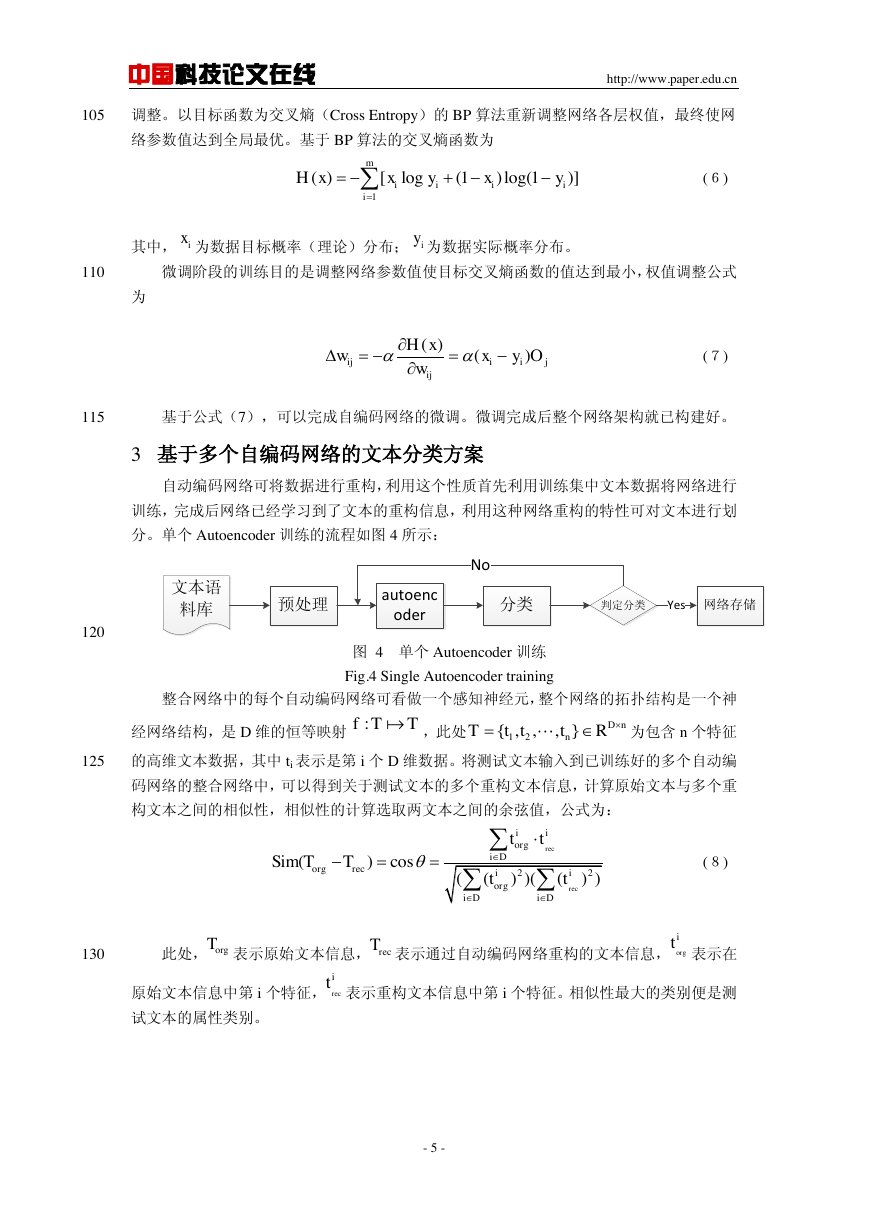

种典型的随机神经网络结构,如图 1 所示,该网络是由层内无连接、层间互连的可视单元和

隐层单元构成。

70

图 1 RBM 网络构成

Fig.1 RBM network architecture

- 2 -

可视单元隐层单元hvw�

中国科技论文在线

2.1 预训练(Pre-training)

http://www.paper.edu.cn

自编码网络的预训练是通过无监督学习方式初始化网络参数的过程,用贪婪学习算法逐

层优化训练 RBM。首先,训练第一层 RBM。RBM 是一个能量模型,其可视单元 与隐层

75

单元 之间的关系可用能量函数表示[6]:

其中

(1)

为 RBM 的参数, 表示可视单元 与隐层单元 间的连接权重,

表示可视单元 的偏置(bias), 表示隐层单元的偏置。模型可视单元的联合概率分布

80

为[7]:

(2)

是归一化因子或称为配分函数(partition function)。可视单元与隐层单

元之间的条件概率计算:

85

(3)

(4)

上面两个式中

为 sigmoid logistic 函数。通过求概率对数

的偏

导,可以得到该层 RBM 的权重更新公式

90

(5)

其中 是学习率,

表示数据集的期望,

表示模型数据的期望。实际中要

取得数据的无偏样本较难,在训练 RBM 的过程中多采用对比散度(Contrastive Divergence,

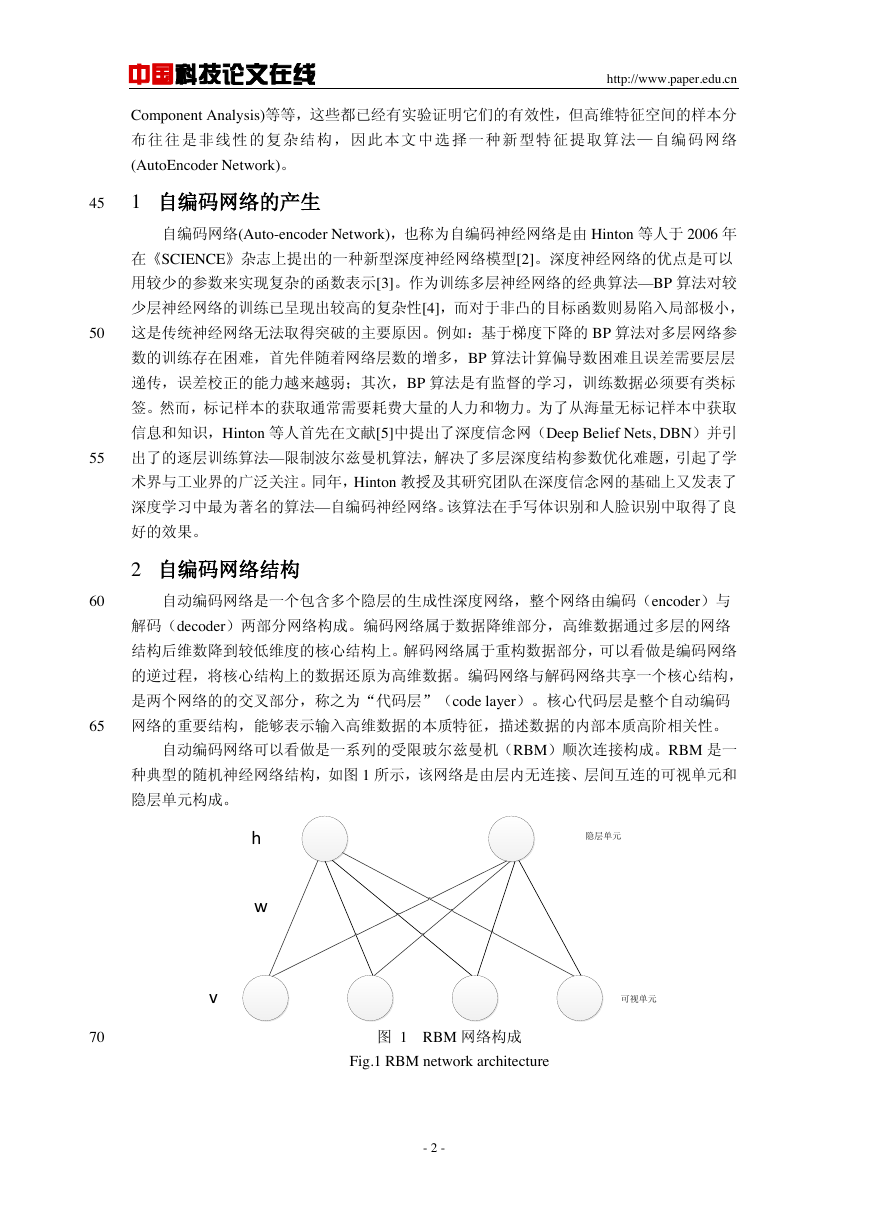

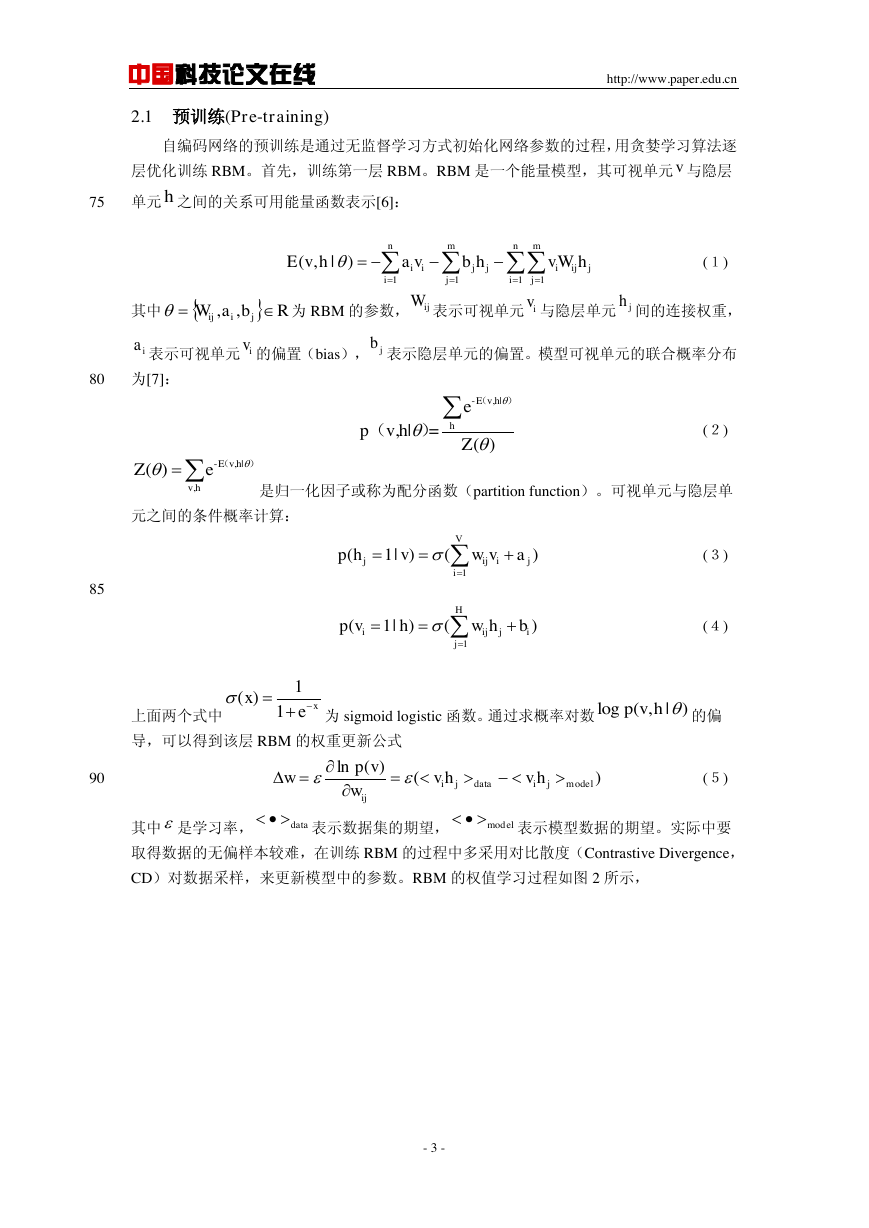

CD)对数据采样,来更新模型中的参数。RBM 的权值学习过程如图 2 所示,

- 3 -

vh1111(,|) nmnmiijjiijjijijEvhavbhvWhRbaWjiij,,ijWivjhiaivjb-v,h|epv,h|=()EhZ()()-v,h|v,h()eEZ()1(1|)()Vjijijiphvwva1(1|)()Hiijjijpvhwhb1()1xxelog(,|)pvh)()(lnmodeljidatajiijhvhvwvpwdatamodel�

中国科技论文在线

http://www.paper.edu.cn

95

图 2 RBM 的训练过程

Fig.2 RBM's training process

2.2 网络展开(Unrolling)

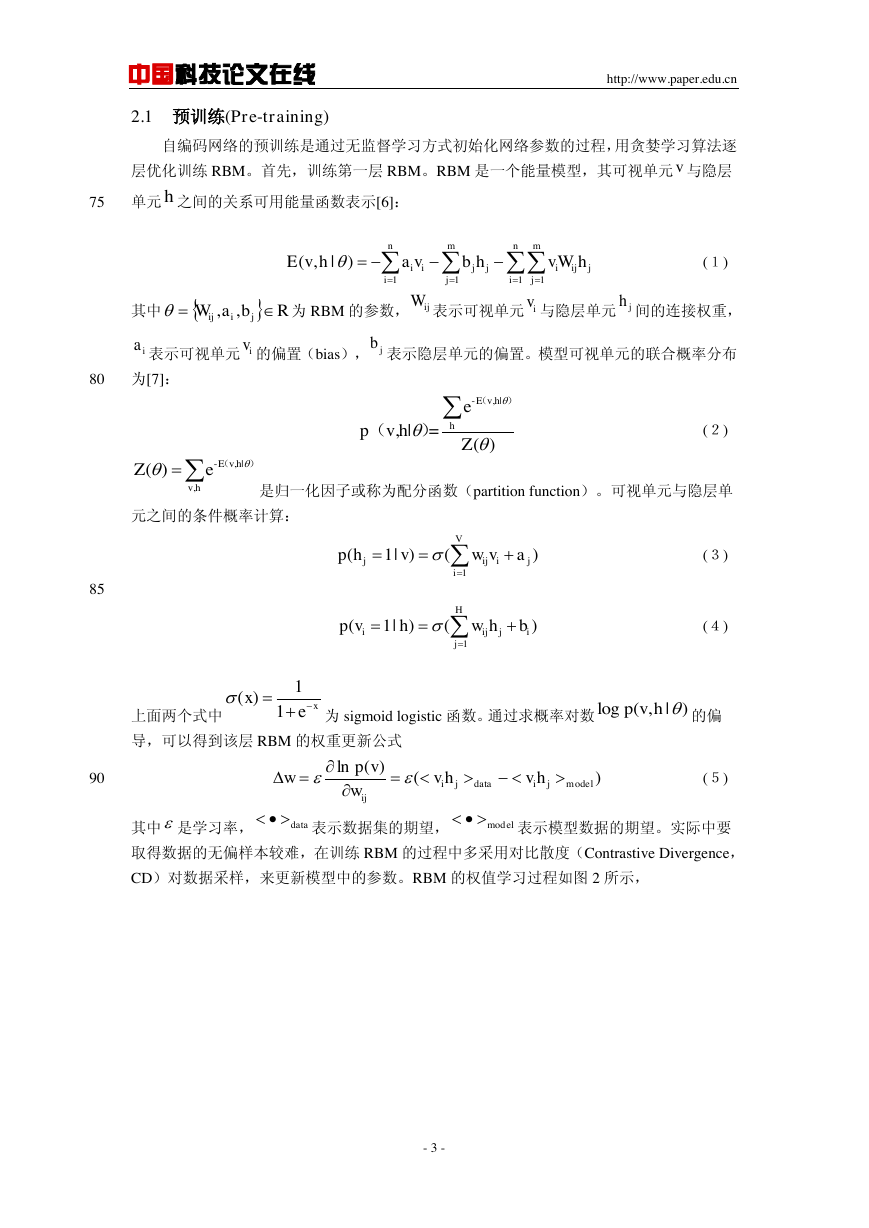

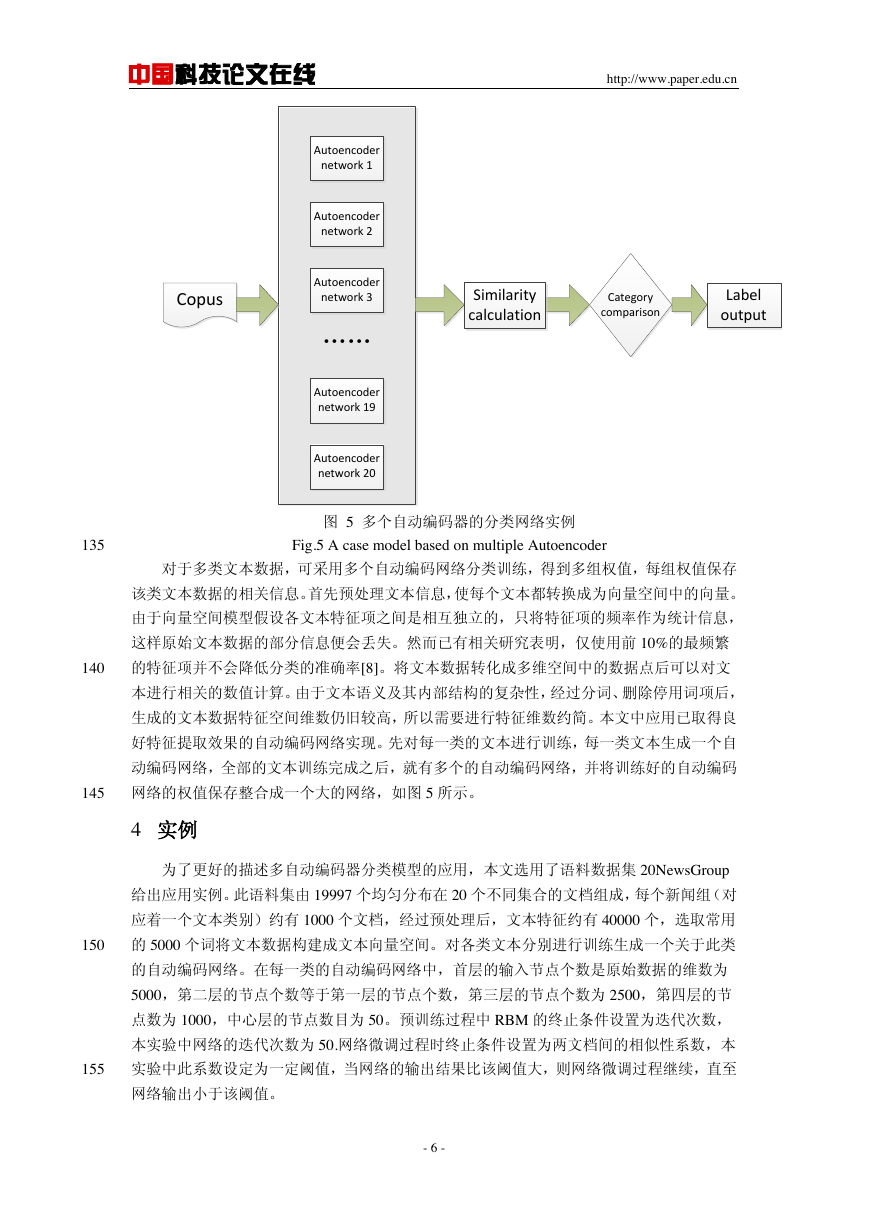

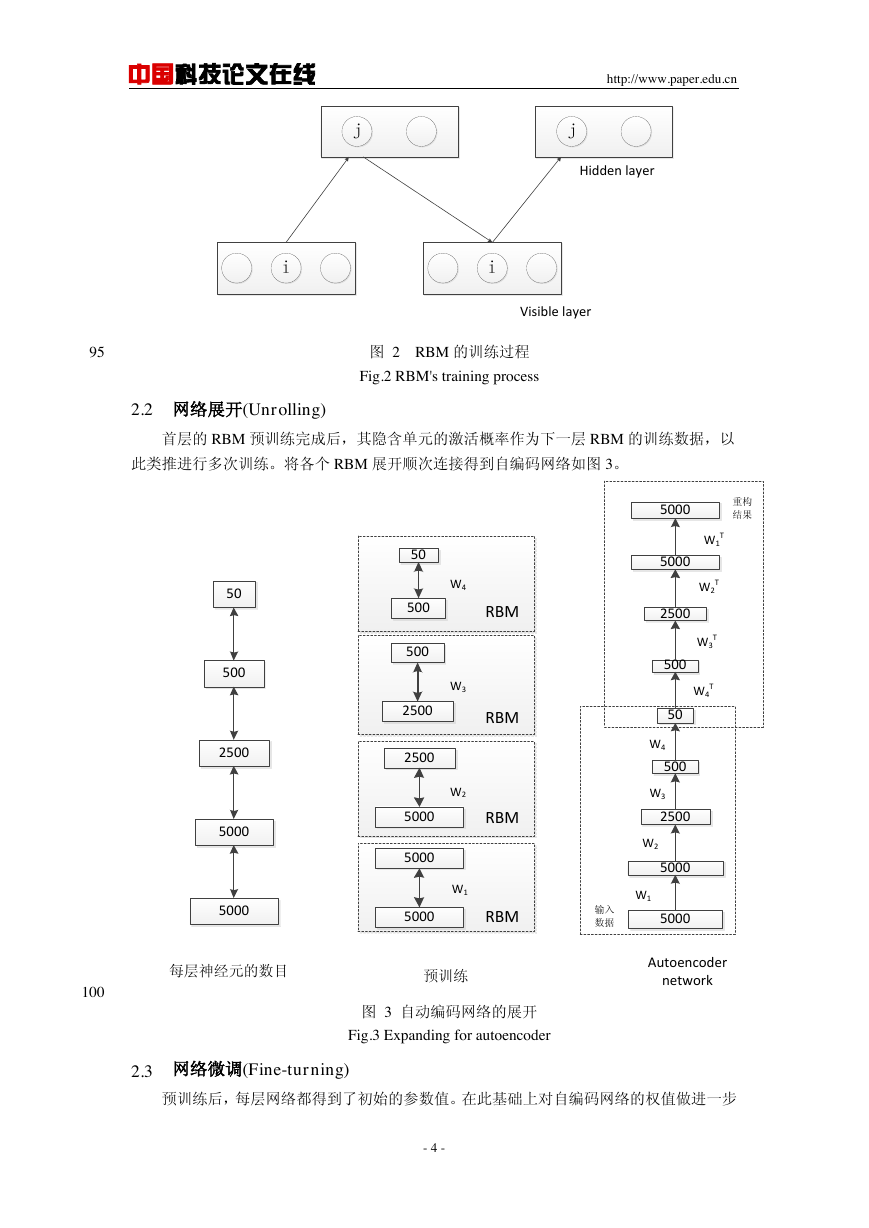

首层的 RBM 预训练完成后,其隐含单元的激活概率作为下一层 RBM 的训练数据,以

此类推进行多次训练。将各个 RBM 展开顺次连接得到自编码网络如图 3。

100

图 3 自动编码网络的展开

Fig.3 Expanding for autoencoder

2.3 网络微调(Fine-turning)

预训练后,每层网络都得到了初始的参数值。在此基础上对自编码网络的权值做进一步

- 4 -

ijijHidden layer Visible layer50005000250050050500050025005000505002500500050005000500050002500250050050050RBMW1RBMRBMRBMW2W3W4每层神经元的数目预训练Autoencoder networkW1W2W3W4W4TW3TW2TW1T输入数据重构结果�

中国科技论文在线

http://www.paper.edu.cn

105

调整。以目标函数为交叉熵(Cross Entropy)的 BP 算法重新调整网络各层权值,最终使网

络参数值达到全局最优。基于 BP 算法的交叉熵函数为

(6)

其中, 为数据目标概率(理论)分布; 为数据实际概率分布。

110

微调阶段的训练目的是调整网络参数值使目标交叉熵函数的值达到最小,权值调整公式

为

(7)

115

基于公式(7),可以完成自编码网络的微调。微调完成后整个网络架构就已构建好。

3 基于多个自编码网络的文本分类方案

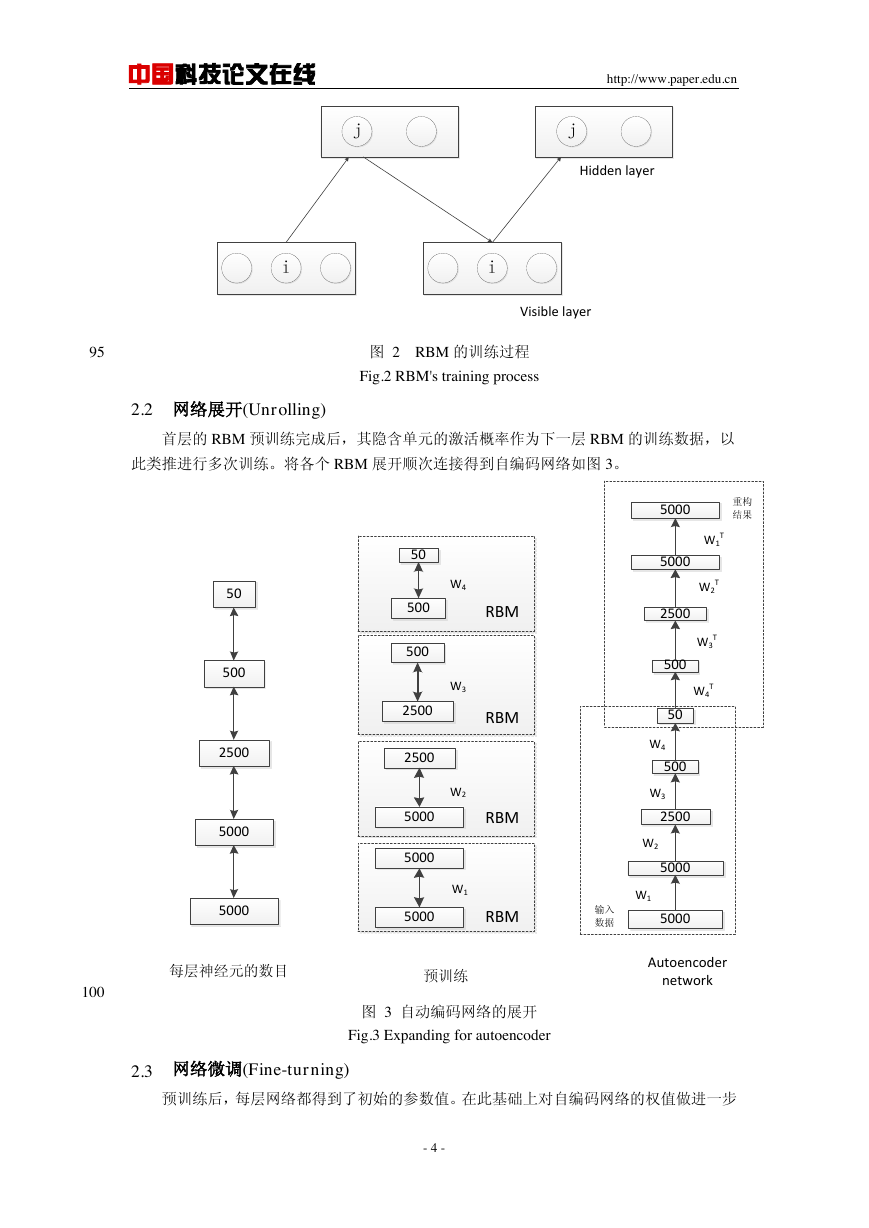

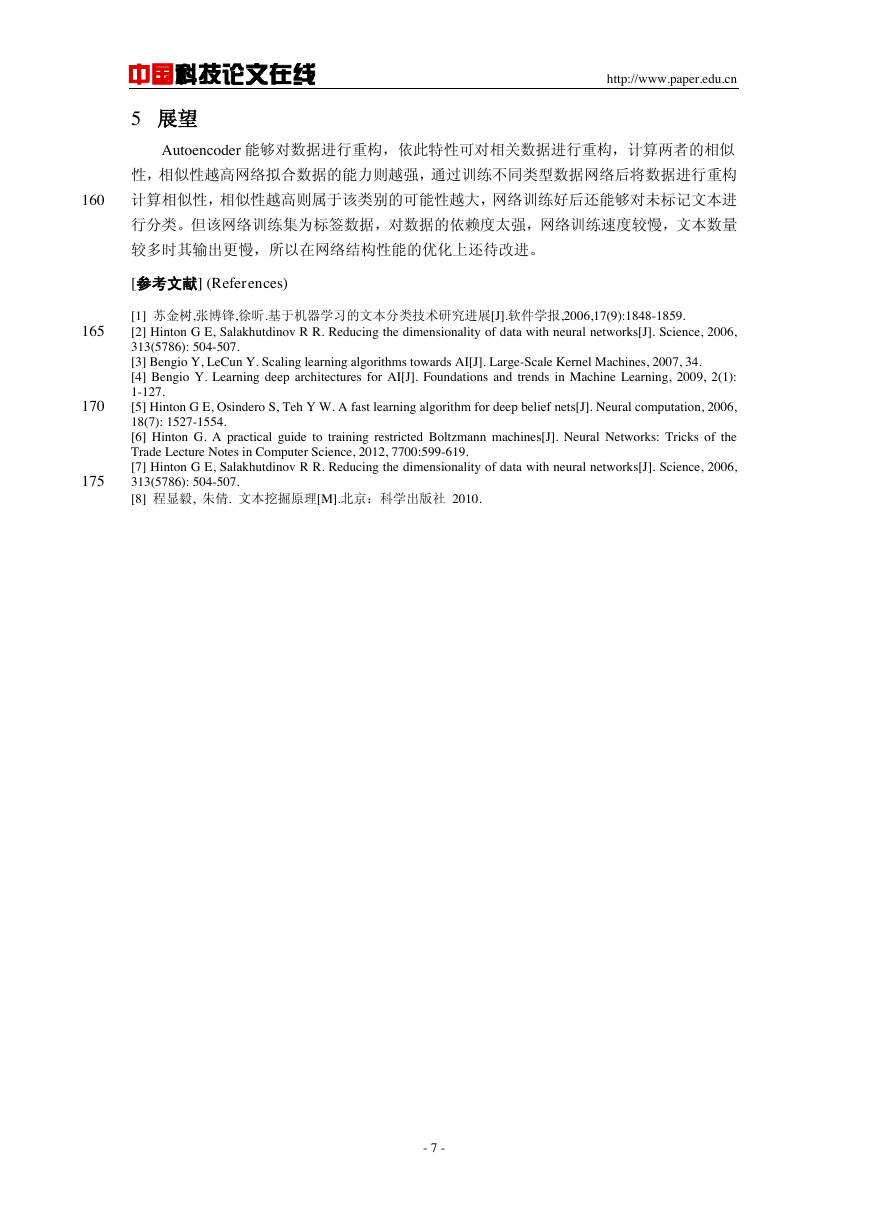

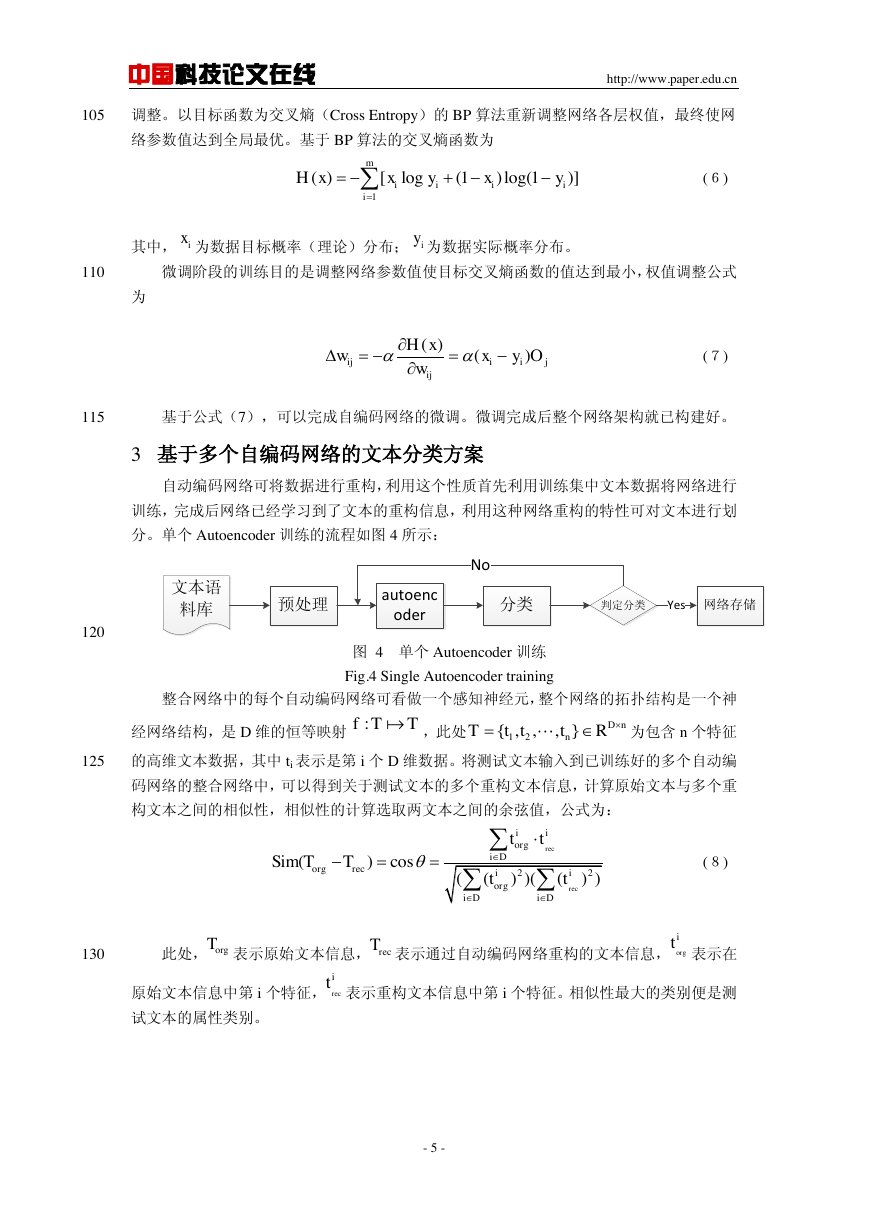

自动编码网络可将数据进行重构,利用这个性质首先利用训练集中文本数据将网络进行

训练,完成后网络已经学习到了文本的重构信息,利用这种网络重构的特性可对文本进行划

分。单个 Autoencoder 训练的流程如图 4 所示:

120

图 4 单个 Autoencoder 训练

Fig.4 Single Autoencoder training

整合网络中的每个自动编码网络可看做一个感知神经元,整个网络的拓扑结构是一个神

经网络结构,是 D 维的恒等映射

,此处

为包含 n 个特征

125

的高维文本数据,其中 ti 表示是第 i 个 D 维数据。将测试文本输入到已训练好的多个自动编

码网络的整合网络中,可以得到关于测试文本的多个重构文本信息,计算原始文本与多个重

构文本之间的相似性,相似性的计算选取两文本之间的余弦值,公式为:

(8)

130

此处, 表示原始文本信息, 表示通过自动编码网络重构的文本信息, 表示在

原始文本信息中第 i 个特征, 表示重构文本信息中第 i 个特征。相似性最大的类别便是测

试文本的属性类别。

- 5 -

1()[log(1)log(1)]miiiiiHxxyxyixiyjiiijijOyxwxHw)()(文本语料库预处理autoencoder分类判定分类No网络存储Yes:fTTnDnRtttT},,,{2122()cos(())(())recreciiorgiDorgreciiorgiDiDttSimTTttorgTrecTorgitrecit�

中国科技论文在线

http://www.paper.edu.cn

135

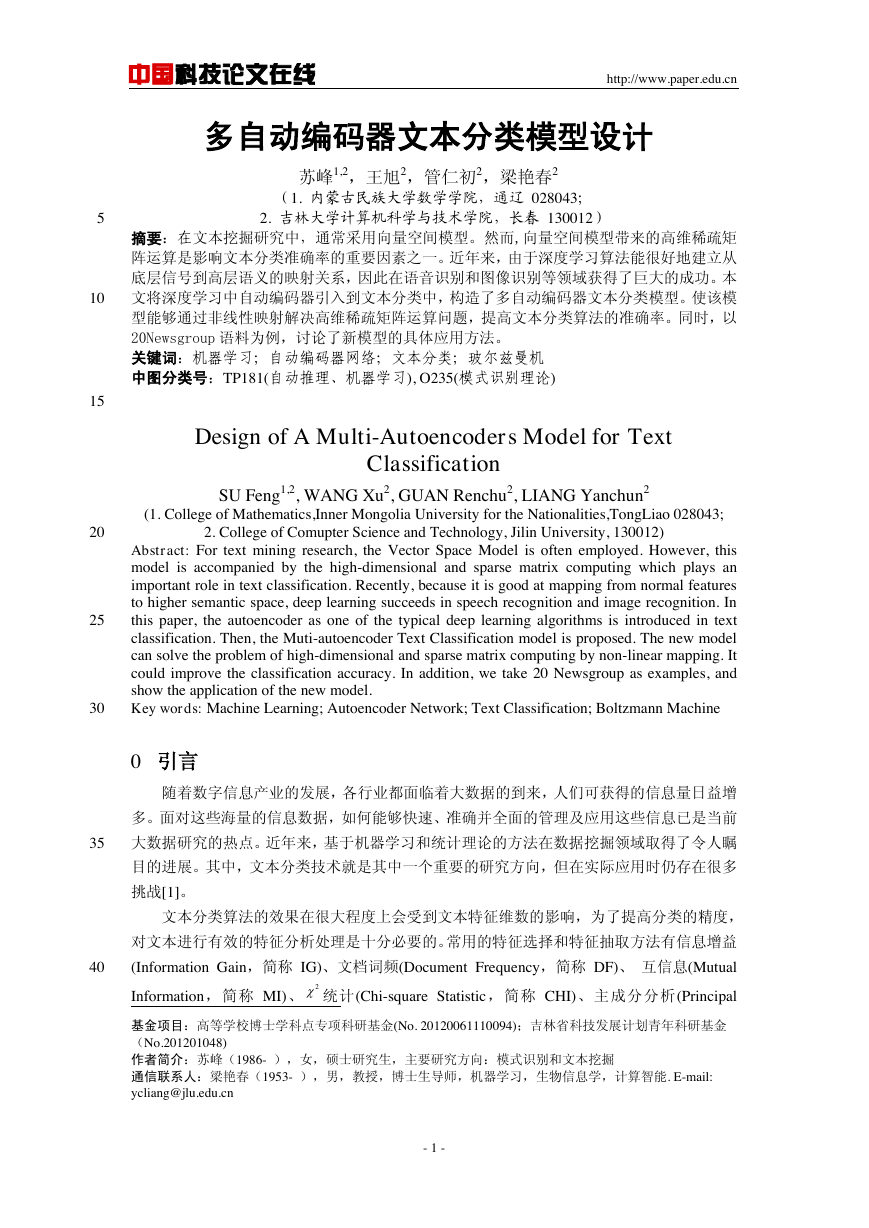

Fig.5 A case model based on multiple Autoencoder

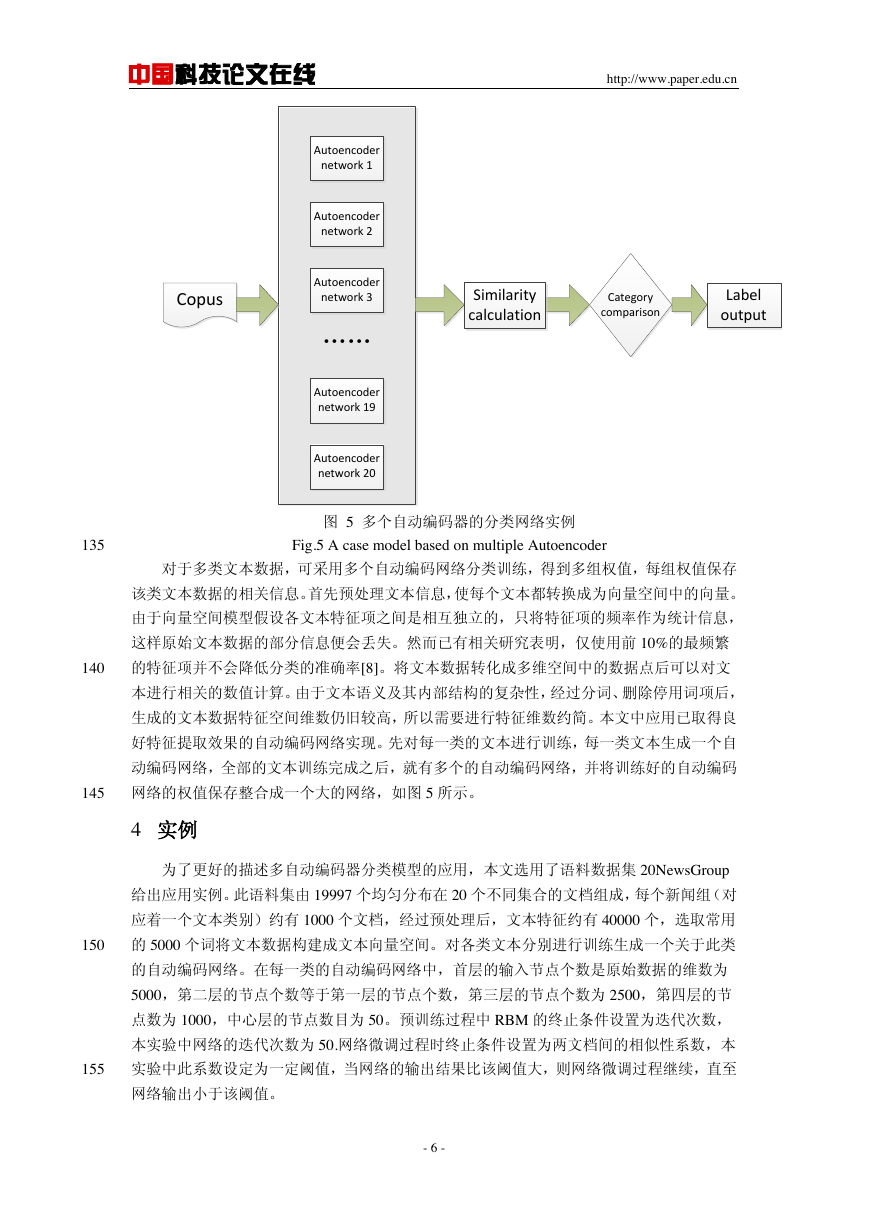

图 5 多个自动编码器的分类网络实例

对于多类文本数据,可采用多个自动编码网络分类训练,得到多组权值,每组权值保存

该类文本数据的相关信息。首先预处理文本信息,使每个文本都转换成为向量空间中的向量。

由于向量空间模型假设各文本特征项之间是相互独立的,只将特征项的频率作为统计信息,

这样原始文本数据的部分信息便会丢失。然而已有相关研究表明,仅使用前 10%的最频繁

140

的特征项并不会降低分类的准确率[8]。将文本数据转化成多维空间中的数据点后可以对文

本进行相关的数值计算。由于文本语义及其内部结构的复杂性,经过分词、删除停用词项后,

生成的文本数据特征空间维数仍旧较高,所以需要进行特征维数约简。本文中应用已取得良

好特征提取效果的自动编码网络实现。先对每一类的文本进行训练,每一类文本生成一个自

动编码网络,全部的文本训练完成之后,就有多个的自动编码网络,并将训练好的自动编码

145

网络的权值保存整合成一个大的网络,如图 5 所示。

4 实例

为了更好的描述多自动编码器分类模型的应用,本文选用了语料数据集 20NewsGroup

给出应用实例。此语料集由 19997 个均匀分布在 20 个不同集合的文档组成,每个新闻组(对

应着一个文本类别)约有 1000 个文档,经过预处理后,文本特征约有 40000 个,选取常用

150

的 5000 个词将文本数据构建成文本向量空间。对各类文本分别进行训练生成一个关于此类

的自动编码网络。在每一类的自动编码网络中,首层的输入节点个数是原始数据的维数为

5000,第二层的节点个数等于第一层的节点个数,第三层的节点个数为 2500,第四层的节

点数为 1000,中心层的节点数目为 50。预训练过程中 RBM 的终止条件设置为迭代次数,

本实验中网络的迭代次数为 50.网络微调过程时终止条件设置为两文档间的相似性系数,本

155

实验中此系数设定为一定阈值,当网络的输出结果比该阈值大,则网络微调过程继续,直至

网络输出小于该阈值。

- 6 -

CopusAutoencoder network 1Autoencoder network 2Autoencoder network 3Autoencoder network 19Autoencoder network 20„„Category comparisonSimilarity calculationLabel output�

中国科技论文在线

http://www.paper.edu.cn

5 展望

Autoencoder 能够对数据进行重构,依此特性可对相关数据进行重构,计算两者的相似

性,相似性越高网络拟合数据的能力则越强,通过训练不同类型数据网络后将数据进行重构

160

计算相似性,相似性越高则属于该类别的可能性越大,网络训练好后还能够对未标记文本进

行分类。但该网络训练集为标签数据,对数据的依赖度太强,网络训练速度较慢,文本数量

较多时其输出更慢,所以在网络结构性能的优化上还待改进。

[参考文献] (References)

165

170

175

[1] 苏金树,张博锋,徐昕.基于机器学习的文本分类技术研究进展[J].软件学报,2006,17(9):1848-1859.

[2] Hinton G E, Salakhutdinov R R. Reducing the dimensionality of data with neural networks[J]. Science, 2006,

313(5786): 504-507.

[3] Bengio Y, LeCun Y. Scaling learning algorithms towards AI[J]. Large-Scale Kernel Machines, 2007, 34.

[4] Bengio Y. Learning deep architectures for AI[J]. Foundations and trends in Machine Learning, 2009, 2(1):

1-127.

[5] Hinton G E, Osindero S, Teh Y W. A fast learning algorithm for deep belief nets[J]. Neural computation, 2006,

18(7): 1527-1554.

[6] Hinton G. A practical guide to training restricted Boltzmann machines[J]. Neural Networks: Tricks of the

Trade Lecture Notes in Computer Science, 2012, 7700:599-619.

[7] Hinton G E, Salakhutdinov R R. Reducing the dimensionality of data with neural networks[J]. Science, 2006,

313(5786): 504-507.

[8] 程显毅, 朱倩. 文本挖掘原理[M].北京:科学出版社 2010.

- 7 -

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc